Robots txt для wordpress в плагине All in One SEO

Эта статья поможет вам создать и изменить файл robots txt для wordpress с помощью плагина All in One SEO…

По умолчанию WordPress создаёт динамический файл роботс тхт, а модуль «инструмент» в плагине All in One SEO позволяет создавать, управлять этим файлом и менять значение по умолчанию.

Генерируя динамический robots.txt файл с помощью All in One SEO, как и WordPress вы создадите инструкции поисковикам о сайте. При этой настройке на сервере отсутствует статический файл robots.txt, а динамический хранится в базе данных WordPress и отображается в веб-браузере по адресу https://ваш сайт/robots.txt.

Чтобы начать работу в меню All in One SEO, нажмите на «Инструменты» и в редакторе включите ползунок «пользовательский robots.txt», при этом добавятся правила WordPress по умолчанию.

Если вы решите изменить правила, добавленные по умолчанию, то вам можно будет создать файл robots. txt в корневой папке WordPress с добавлением собственных правил.

txt в корневой папке WordPress с добавлением собственных правил.

Как это делается, мы рассмотрим далее в статье…

При создании пользовательского правила я придерживаюсь директивы User-agent от Яндекс. Например, боты Яндекс руководствуются правилами User-agent: Yandex и User-agent: * и запись User-agent: Yandex при этом в приоритете перед записью User-agent: *. Можно понимать так, если даны указания роботам Яндекс, то будет использоваться директива User-agent: Yandex, а User-agent: * будет игнорироваться.

Например, на моих сайтах роботс.тхт настроен так (см. ниже), а вы можете настроить по своим предпочтениям.

Правила роботс.тхт на моих сайтах

User-agent: Yandex # разрешил роботам Яндекс сканировать сайт Allow: /wp-admin/admin-ajax.php Allow: /wp-content/uploads/ Allow: /*favicon.ico* Allow: /*.css Allow: /*.js Disallow: /wp-admin/ Disallow: /readme.html Disallow: /xmlrpc.php Disallow: /trackback/ Disallow: /wp-json/ Disallow: /author/ Disallow: /type/ Disallow: /page/ Disallow: /?s=* User-agent: * # разрешил всем роботам сканировать сайт Allow: /*.css Allow: /*.js Allow: /*favicon.ico* Allow: /wp-content/uploads/ Allow: /wp-admin/admin-ajax.php Disallow: /wp-content/uploads/wpo-plugins-tables-list.json Disallow: /wp-admin/ Disallow: /readme.html Disallow: /xmlrpc.php Disallow: /trackback/ Disallow: /wp-json/ Disallow: /type/ Disallow: /author/ Disallow: /page/ Disallow: /?s=* Sitemap: https://Ваш сайт/sitemap.xml

Если нет никаких записей, то считается, что роботам нет ограничений для этого сайта…

Итак, при нажатии кнопки «Добавить правило» у вас выйдет примерно такой роботс по умолчанию от Вордпресс (см. фото).

Как говорилось выше в статье мы создадим свой статический файл robots.txt и сделаем его динамическим с помощью SEO плагина и бесплатного FTP-клиента FileZilla. Скачайте и установите на компьютер, кстати, отличная программа для работы с сайтами.

- Через программу FTP-клиент открываем корневую папку на сервере своего хостинга.

- Далее создается новый пустой файл с названием robots.

txt.

txt.

Выделяете созданный файл мышкой, нажимаете на Просмотр/Правка и открываете файл редактором Notepad++. Здесь прописываете директивы, которые должны работать, как часы без ошибок на вашем сайте.

- Затем прописываете свой роботс.тхт и нажимаете сохранить.

Далее нужно зайти в админку Вордпресс и в плагине Aloseo открыть модуль Инструменты и, тут нажать кнопку Импорт и Удаление.

После этого создается динамический роботс.тхт, который можно здесь редактировать, удалять и добавлять другие правела.

В инструментах ВебМастер.Яндекс нужно проверить результаты анализа robots.txt…

Вот и всё, остаётся ждать, когда изменения роботс.тхт вступят в силу, на это может уйти 2-3 недели или больше и поэтому отнеситесь к его составлению серьёзно. Через пару дней после настройки плагина в All in One SEO проверьте соответствие кодов ответа в панели ВебМастер Яндекс → Статистика обход → Все страницы.

Шаблон файла Robots.txt для WordPress

Шаблон robots.txt для WordPress

Подробная инструкция

Практически каждый этап и элемент играет не последнюю роль в создании и дальнейшей оптимизации сайта в поисковой системе, но, одним из наиболее важных считается Robots.txt. Это небольшой файл, в котором прописываются правила индексирования для поисковых роботов.

В этой статье я расскажу о том, как правильно настроить Robots.txt для WordPress. Помимо этого, поделюсь с вами вариантами, которые лично использую на своих проектах. Время на чтение 2 минуты 633

Содержание

Robots.txt, что это такое?

Подробнее о Clean-param

Базовый вид Robots. txt для WP

Вам будет интересно

Расширенная версия Robots.txt. для WP

Заключение

txt для WP

Вам будет интересно

Расширенная версия Robots.txt. для WP

Заключение

Robots.txt, что это такое?

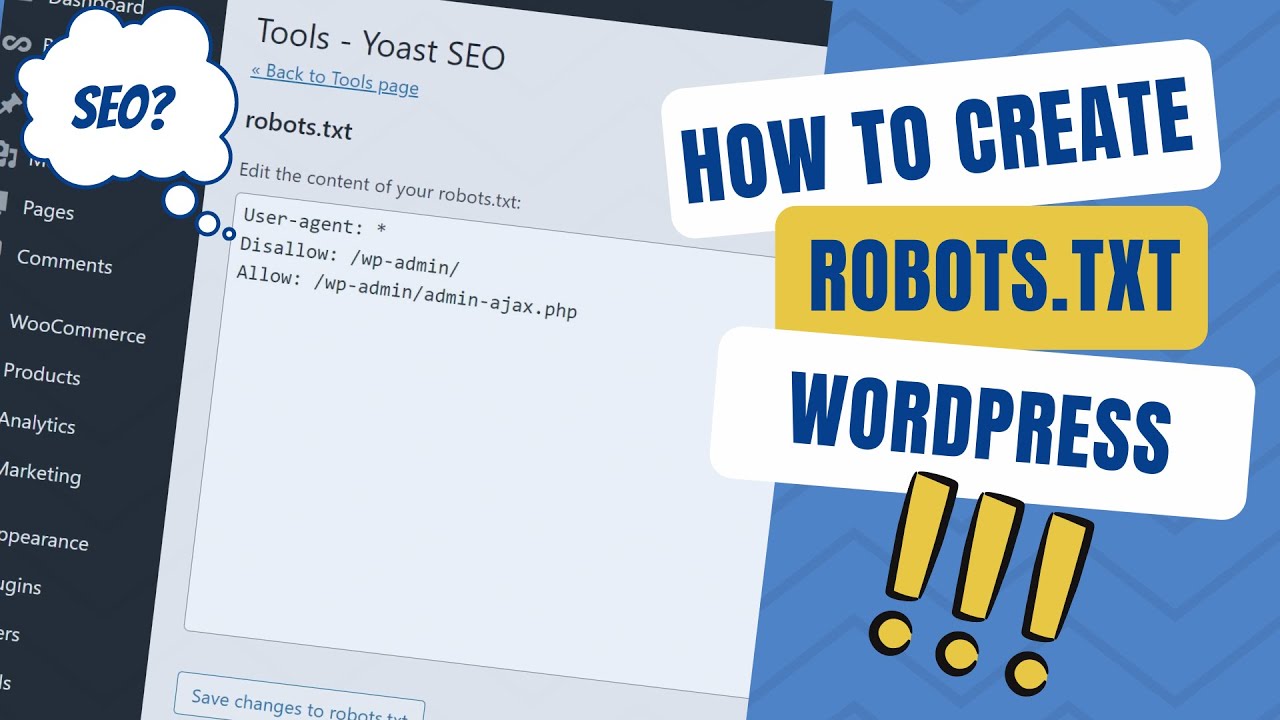

Как говорилось выше, это ничто иное как текстовый файл с прописанными в нем правилами для поисковых систем. Обратите внимание, стандартный Robots.txt для WordPress выглядит именно так:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Вот в таком виде, плагин Yoast SEO создает файл. Многие пользователи ошибочно полагают, что этого вполне достаточно, возможно в каких-то случаях это работает. Но, мое мнение таково: если хочешь хороших показателей роста, стандартные приемы стоит забыть. Если ты со мной согласен, и считаешь что необходима детальная проработка файла, давай глубже разбираться в вопросе. Для начала, мы разберемся в основных директивах:

Как вы успели заметить, сложного здесь ничего нет.

| Директива | Значение | Пояснение |

|---|---|---|

| User-agent: | Yandex, Googlebot и т.д. | Указываем к какому работу обращаемся |

| Disallow: | Относительная ссылка | Выписываем ссылки, которые будут игнорироваться |

| Allow: | Относительная ссылка | Выписываем ссылки, которые будут проиндексированы |

| Sitemap: | Абсолютная ссылка | Указываем ссылки на XML-карту сайта. Если их не прописать в файле, то в дальнейшем придется добавлять карту в ручную через Яндекс.Вебмастер |

| Crawl-delay: | Время в секундах | Указываем таймаут между посещениями роботов. Это необходимо в тех |

Как вы успели заметить, сложного здесь ничего нет.

Подробнее о Clean-param

Как правило, параметры используются в динамических сайтах. Проблема в том, что они могут дублироваться и передавать поисковым системам лишнюю информацию. Во избежании этого, как раз и прописывается директива Clean-param в Robots.txt.

Во избежании этого, как раз и прописывается директива Clean-param в Robots.txt.

Рассмотрим такой пример: site.ru/statia?uid=32 — site.ru/statia — это ссылка, а все что находится после знака “?” является параметром. В данном случае, uid=32 является динамическим параметром, это значит что он может принимать другое значения.

Например, uid=33, uid=34 и так далее. Закрываем индексацию, ведь этот параметр может меняться до бесконечности. Приводим директиву вот в такой вид:

Clean-param: uid /statia # все параметры uid для statia будут закрыты

Базовый вид Robots.txt для WP

Буквально на днях, я стал обладателем плагина Clearfy Pro, в котором есть огромное разнообразие функций. Сейчас мы рассмотрим одну из них, а именно, функции для создания идеального файла Robots.txt. На сколько же он идеален? Все очень просто, я не знаю! Нет однозначного ответа на этот вопрос.

Люди делятся на два лагеря, одни делают более короткую версию, в которой прописывают правила для всех роботов сразу, другие же расписывают правила для каждого поисковика в отдельности.

Что из этого правильно а что нет, ответа также нет. Вы можете поделиться своими мыслями в комментариях. А сейчас, я вам дам для ознакомления базовую версию Robots.txt. для WordPress, которую я немного подредактировал. Я указал директиву Sitemap и удалил директиву Host.

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /xmlrpc.php

Disallow: /readme.html

Disallow: /*?

Disallow: /?s=

Allow: /*.css

Allow: /*.js

Sitemap: https://site.ru/sitemap.xml

Не возьмусь утверждать, что это самый лучший вариант. Но, он однозначно лучше того, что предлагает нам Yoast SEO.

Вам будет интересно

Расширенная версия Robots.txt. для WP

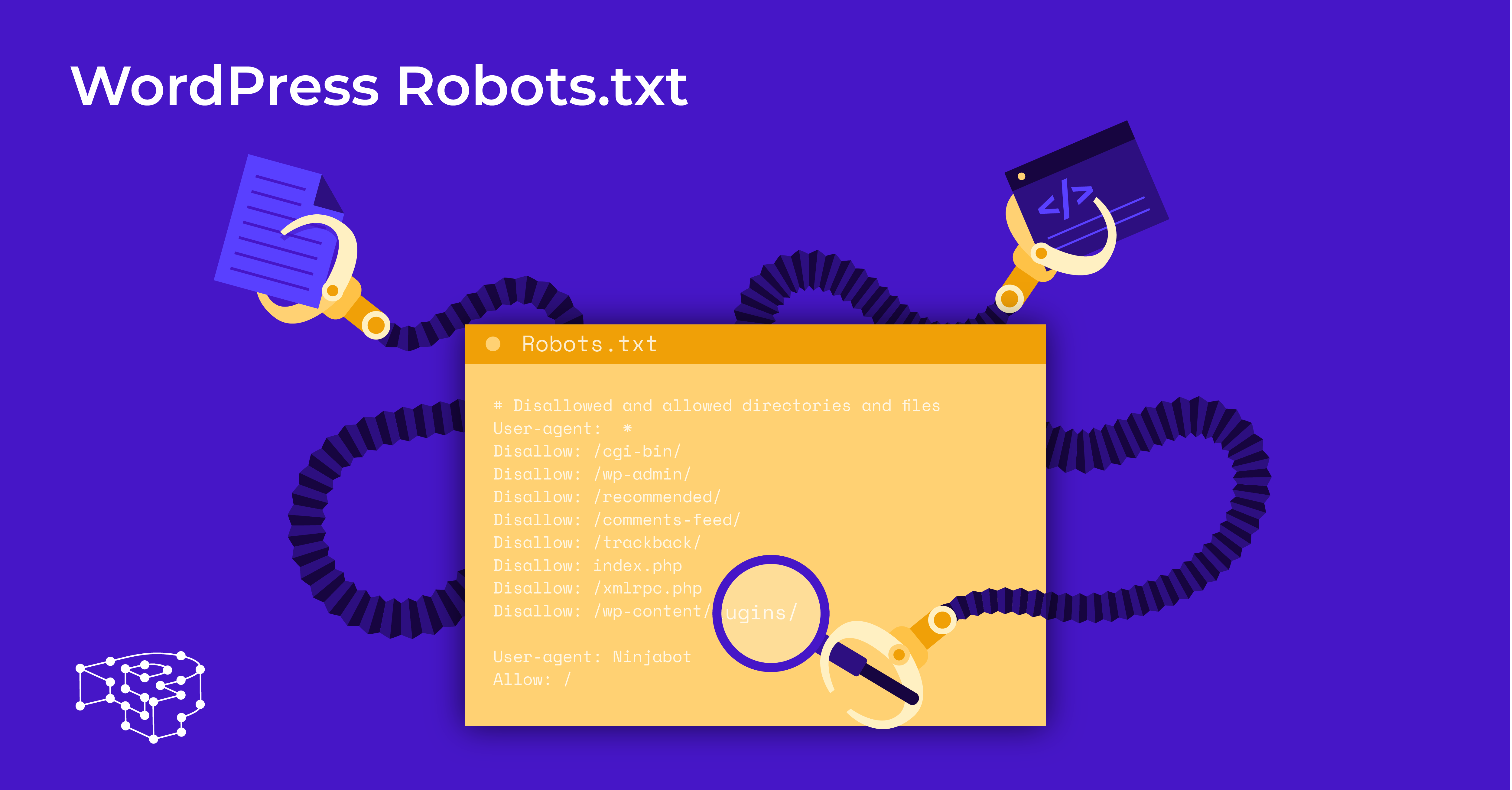

Для вас наверняка не будет откровением то, что все сайты на WP имеют единую структуру. Этот факт, позволяет специалистам разрабатывать наиболее оптимальные варианты robots.

Этот факт, позволяет специалистам разрабатывать наиболее оптимальные варианты robots.

Я, не стал исключением. За долго подбирал для себя тот вид роботса, который мог бы полностью меня удовлетворить. И сейчас я хочу с вами им поделиться.

User-agent: * # Для всех поисковых систем, кроме Яндекса и Гугла

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: *utm=

Disallow: *openstat=

Disallow: /tag/ # Закрываем метки

Disallow: /readme.html # Закрываем бесполезный мануал по установке WordPress (лежит в корне)

Disallow: *?replytocom

Allow: */uploads

User-agent: GoogleBot # Для Гугла

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.

php

Disallow: *utm=

Disallow: *openstat=

Disallow: /tag/ # Закрываем метки

Disallow: /readme.html

Disallow: *?replytocom

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

User-agent: Yandex # Для Яндекса

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: /tag/ # Закрываем метки

Disallow: /readme.html

Disallow: *?replytocom

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.

jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign

Clean-Param: openstat

Sitemap: https://site.com/sitemap_index.xml # Карта сайта, меняем site.com на нужный адрес.

Ранее, в Robots.txt. использовалась директива Host, которая указывала на главное зеркало сайта. Сейчас в этом нет нужды, так как это делается при помощи редиректа.

Sitemap с протоколом https указывается по причине того, что большая часть сайтов использует защищенное соединение. Если у вас нет SSL, просто измените протокол на http.

Хочу заострить ваше внимание на том, что я закрываю теги, ведь они создают огромное количество дублей, что плохо сказывается на SEO. В том случае, если вы хотите их открыть, тогда вам необходимо удалить строку disallow: /tag/ из файла.

Заключение

Собственно, вы наглядно познакомились с тем, как выглядит Robots. txt. “здорового человека” для WP. Берите в пользование и ни в чем себе не отказывайте.

txt. “здорового человека” для WP. Берите в пользование и ни в чем себе не отказывайте.

P.S. данный вариант подходит для стандартных информационных сайтов. В иных случаях, вам придется индивидуально прорабатывать файл.

Оцените статью

- 5

- 4

- 3

- 2

- 1

Нам очень важно знать ваше мнение,

чтобы писать о том что вам интересно.

Как использовать файл robots.txt с WordPress

Не знаете, как использовать файл robots.txt? Хотите верьте, хотите нет, но это один из самых важных файлов с точки зрения SEO. Вам нужно использовать файл, чтобы указать, какие разделы вашего сайта должны и какие не должны быть доступны для поисковых систем. Например, вам не нужно, чтобы каталог wp-admin сканировался и индексировался поисковыми системами, потому что он предназначен только для внутреннего использования. Robots.txt — это обычный текстовый (.txt) файл, который следует поместить в корневой каталог на вашем сервере, что означает, что вам нужно поместить его в ту же папку, где находятся файлы и папки вашего веб-сайта на сервере. Вам нужно специально назвать его robots.txt . В противном случае это не сработает.

Вам нужно специально назвать его robots.txt . В противном случае это не сработает.

Виртуальный файл robots.txt в WordPress

WordPress использует виртуальный файл robots.txt. Это означает, что вы не найдете его на своем ftp-сервере, если попытаетесь получить к нему доступ для редактирования, потому что он создается динамически каждый раз, когда пользователь посещает ваш сайт. Хотя он виден, если вы добавите /robots.txt к URL-адресу своего сайта, он будет недоступен на вашем сервере, если вы попытаетесь найти его с помощью ftp-менеджера, такого как CuteFTP, FileZilla или CyberDuck.

Как редактировать robots.txt с помощью WordPress

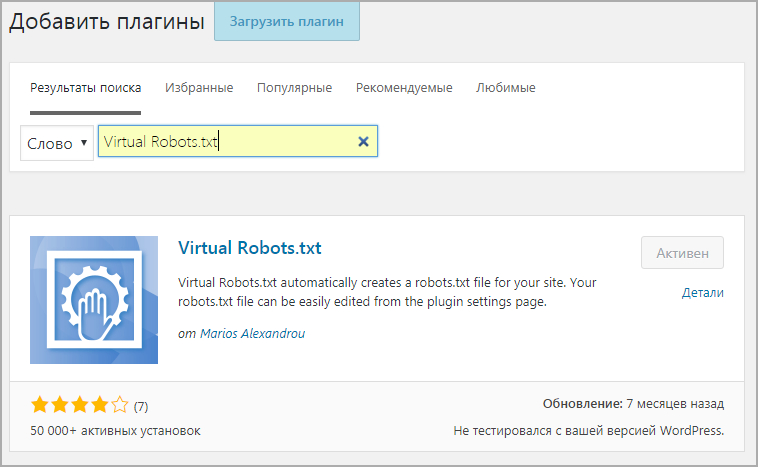

Если вы хотите иметь возможность редактировать файл robots.txt вручную, вам следует установить плагин WP Robots.txt. Это позволит вам редактировать файл robots.txt прямо в панели управления WordPress. Итак, давайте установим плагин и посмотрим, как он работает.

Как установить плагин WP Robots.txt

- Находясь в панели инструментов WordPress, перейдите в «Плагины» и выберите «Добавить новый».

- Введите WP Robots.txt в текстовое поле «Поиск» и нажмите кнопку «Поиск плагинов».

- Найдя подключаемый модуль, просто нажмите ссылку «Установить сейчас». Теперь у вас должно появиться всплывающее окно, которое дважды проверяет, действительно ли вы хотите установить плагин. Просто нажмите ОК.

- Теперь нажмите «Активировать плагин».

- На этом этапе вы можете просто развернуть раскрывающееся меню «Настройки» и выбрать «Чтение».

- Теперь просто найдите текстовое поле Robots.txt Content. Поле содержит содержимое вашего фактического файла Robots.txt.

Содержимое вашего файла WordPress Robots.txt

У вас должен быть аналогичный контент по умолчанию:

User-agent: *

Запретить: /wp-admin/

Запретить: /wp-includes/

Таким образом, приведенный выше код просто запрещает всем поисковым роботам просматривать каталоги /wp-admin/ и /wp-includes/ на вашем сервере.

Улучшенный контент для вашего файла robots.

txt

txtХотя настройки по умолчанию также работают, лучше всего с точки зрения поисковой оптимизации WordPress немного изменить их, чтобы ваш файл robots.txt выглядел следующим образом:

Агент пользователя: *

Запретить: /кормить/

Запретить: /трекбэк/

Запретить: /wp-admin/

Запретить: /wp-контент/

Запретить: /wp-includes/

Запретить: /xmlrpc.php

Запретить: /wp-

Разрешить: /wp-content/uploads/

Карта сайта: http://example.com/sitemap.xml

Первая строка показывает, какой именно ползающий робот или роботы вы хотите нацелить. * означает, что вы нацелены на всех роботов. Другими словами, вы говорите: «Эй, все вы, поисковые роботы, действуйте следующим образом».

В качестве альтернативы вы можете указать определенные поисковые роботы, такие как Googlebot, Rogerbot и т. д. Вы хотите сделать это, если использование звездочки * по той или иной причине не нацелено на конкретный поисковый робот.

У меня лично была такая проблема с Роберботом. Вам также может потребоваться указать его явно. Итак, вместо:

Вам также может потребоваться указать его явно. Итак, вместо:

User-agent: *

Вы можете выбрать конкретно Moz Rogerbot:

User-agent: Rogerbot

Большая часть приведенного выше кода просто запрещает доступ к указанным каталогам (/trackback/, /wp-admin/ и т. д.), поскольку содержимое этих каталогов не представляет интереса ни для посетителей вашего сайта, ни для поисковых систем.

Запретить: /канал/

Запретить: /трекбэк/

Запретить: /wp-admin/

Запретить: /wp-контент/

Запретить: /wp-includes/

Запретить: /xmlrpc.php

Запретить: /wp-

Поскольку вы хотите иметь возможность ранжироваться в поисковых системах с контентом, который находится в каталоге загрузки (например, изображения и тому подобное), предпоследняя строка разрешает доступ к каталогу /wp-content/uploads/ .

Разрешить: /wp-content/uploads/

И последняя строка просто указывает на расположение вашего файла sitemap. xml, который Google и другие поисковые системы используют для правильного сканирования вашего сайта.

xml, который Google и другие поисковые системы используют для правильного сканирования вашего сайта.

Карта сайта: http://example.com/sitemap.xml

Опасный файл

Неправильная конфигурация файла robots.txt может привести к тому, что он будет полностью невидим для поисковых систем. Наихудшей конфигурацией будет следующая:

Disallow: /

Приведенный выше код запрещает доступ ко всем вашим сайтам. Таким образом, поисковые системы не будут индексировать НИЧЕГО. Просто имейте в виду, что вы не хотите, чтобы это правило было в вашем файле robots.txt.

Шутка для SEO-ботаников

Взгляните на эту SEO-ботанику шутку. Понятно? Это действительно здорово! 🙂

Эта телка запрещает парню все. Эта шутка может помочь вам лучше понять, как работает disallow: /. Хорошо, давайте двигаться дальше.

Как выполнить точную настройку синтаксиса robots.txt

Если вы хотите точно настроить параметры файла robots. txt, вам может понадобиться знать следующее.

txt, вам может понадобиться знать следующее.

Чтобы указать конкретный каталог, просто заключите его имя в косую черту. например /wp-контент/.

Запретить: /wp-content/

Чтобы указать конкретный файл, вам просто нужно указать путь к этому файлу вместе с его именем:

Запретить: /wp-content/your-file.php

Вы можете указать таким образом все типы файлов:

Запретить: /wp-content/your-file.html

Запретить: /wp-content/your-file.png

Запретить: /wp-content/your-file.jpeg

Запретить: /wp-content/your-file.css

Отключить динамическое индексирование URL

Скорее всего, вы столкнетесь с этой очень распространенной проблемой. Возможно, вам потребуется отключить динамическую индексацию URL-адресов. Динамический URL — это тот, который содержит ? вопросительный знак. Такие URL-адреса могут вызывать всевозможные проблемы SEO (дублированный контент, повторяющийся заголовок страницы и т. д.), и вы хотите запретить поисковым системам индексировать страницы с такими URL-адресами. Это легко сделать с помощью файла robots.txt. Просто добавьте следующую строку:

д.), и вы хотите запретить поисковым системам индексировать страницы с такими URL-адресами. Это легко сделать с помощью файла robots.txt. Просто добавьте следующую строку:

Запретить: /*?

Скринкаст о Robots.txt для пользователей WordPress

Этот скринкаст — образец курса SEO, над которым я сейчас работаю. Курс называется SEO Crash Course для пользователей WordPress. Если вы хотите быть в курсе, когда он будет запущен, обязательно подпишитесь на мою рассылку в конце поста.

Полезные ссылки

Robots.txt: Полное руководство

Заключение

Вы просто не можете называть себя оптимизатором или интернет-маркетологом, если вам не нравится файл robots.txt, потому что он определяет, как поисковые системы видят ваш сайт. Обязательно редактируйте файл robots.txt, только если вы знаете, что делаете. В противном случае ваш сайт может просто исчезнуть из Интернета, и вы даже не узнаете почему.

В противном случае ваш сайт может просто исчезнуть из Интернета, и вы даже не узнаете почему.

Существует множество плагинов WordPress, которые позволяют обрабатывать ваш файл robots.txt. Знаете ли вы что-нибудь, что работает лучше, чем плагин WP Robots.txt, о котором я рассказал в этом посте?

Как легко изменить или удалить robots.txt с веб-сайта

Хотите отредактировать или удалить файл robots.txt для своего веб-сайта?

Бывают случаи, когда боты поисковых систем не могут проиндексировать веб-сайт из-за неправильно настроенного файла robots.txt.

Если ваша веб-страница проиндексирована в Google и вы хотите срочно удалить ее, вам необходимо обновить/добавить файл robots.txt в корневой каталог вашего домена или поддоменов.

Используя robots.txt, вы можете запретить/разрешить индексацию страницы веб-сайта поисковой системой. В этом кратком руководстве я покажу вам, как редактировать и удалять файл robots. txt из WordPress .

txt из WordPress .

User-agent: *

Disallow: /wp-admin/

Разрешить: /wp-admin/admin-ajax.php

* после User-agent означает, что файл robots.txt предназначен для всех веб-ботов, посещающих ваш сайт.

Disallow: /wp-admin/ указывает ботам не посещать вашу страницу wp-admin.

Что делает robots.txt ?Robots.txt можно использовать для управления трафиком поисковых роботов на вашем веб-сайте и предотвращения индексации определенных файлов поисковыми системами. Он также указывает местоположение карты сайта. Вы также можете использовать файл robots.txt для блокировки таких ресурсов, как неважные изображения, файлы стилей или скрипты.

Однако, если отсутствие этих ресурсов затрудняет понимание вашей веб-страницы поисковым роботом Google, вам не следует их блокировать.

Все в одном SEO (AIOSEO) — один из лучших SEO-плагинов для WordPress что может использоваться для редактирования файла robots.txt. Он дает вам контроль над вашим сайтом и настраивает файл robots.txt, который заменит файл WordPress по умолчанию.

AIOSEO — это SEO-плагин для WordPress, который поможет вам повысить рейтинг вашего сайта в поиске, чтобы вы могли развивать свой бизнес и получать максимальный трафик.

Чтобы отредактировать файл robots.txt, нажмите «Инструменты» в меню «Все в одном SEO». Затем вам нужно нажать на вкладку «Редактор Robots.txt».

AIOSEO создаст динамический файл robots.txt . Содержимое файла хранится в вашей базе данных WordPress, и вы можете просмотреть его в своем веб-браузере.

После входа в редактор Robots.txt, Включить пользовательский файл robots. txt.

txt.

После этого вы увидите раздел «Предварительный просмотр Robots.txt», в котором показаны правила WordPress по умолчанию, которые вы можете перезаписать. Правила по умолчанию предписывают ботам не сканировать ваши файлы WordPress.

Вы можете добавить свои собственные правила с помощью конструктора правил.

Конструктор правил помогает указать, какие страницы должны сканировать боты, а какие нет.

Например, , если вы хотите добавить правило, которое блокирует всех ботов из временного каталога, вы можете использовать для этого конструктор правил.

Чтобы добавить правило, вы должны ввести пользовательский агент в поле «Пользовательский агент». Вы можете использовать *, чтобы применить правило ко всем пользовательским агентам.

Теперь вам нужно выбрать, хотите ли вы «Запретить» или «Разрешить» поисковым системам сканировать.

После этого введите путь к каталогу или имя файла в поле «Путь к каталогу».

Правило будет автоматически применено к вашему файлу robots.txt. Нажмите кнопку « Добавить правило », чтобы добавить другое правило.

Вы можете продолжать добавлять правила, пока не создадите идеальный формат robots.txt.

Кроме того, ваши пользовательские правила будут выглядеть так.

Когда вы закончите, нажмите кнопку «Сохранить изменения».

Способ 2. Редактирование файла robots.txt вручную с помощью FTPЧтобы отредактировать файл robots.txt с помощью этого метода, используйте FTP-клиент FTP клиент.

Внутри вы можете увидеть файл robots.txt в корневой папке вашего сайта.

Если вы этого не видите, у вас нет файла robots.txt. В этом случае вам придется создать его

Вы можете загрузить Robots.txt на свой компьютер и отредактировать его с помощью обычного текстового редактора, такого как TextEdit или Блокнот.

После сохранения изменений загрузите их в корневую папку вашего сайта.

Чтобы удалить robots.txt с веб-сайта WordPress, следуйте этим инструкциям.

Перейдите к настройкам вашего WordPress и посмотрите, установлен ли этот флажок:

Если да, снимите его, и robots.txt изменится на

User-agent: *Как создать файл robots.txt, если вы хотите вернуть его после удаления?

Disallow:

Вы можете использовать SEOToolr Robot.txt Generator для создания файла робота, если хотите вернуть его после удаления.

- Выберите вариант из раскрывающегося списка и введите URL-адрес вашей карты сайта. Вы можете сделать это, вставив ссылку на карту сайта вашего сайта. Оставьте поле пустым, если у вас его нет.

- После этого введите каталог файла, который вы хотите запретить.

- Наконец, нажмите кнопку «Создать robots txt», и будет создан файл robots.txt.