Поисковые алгоритмы Яндекса с 2007 по 2022 год

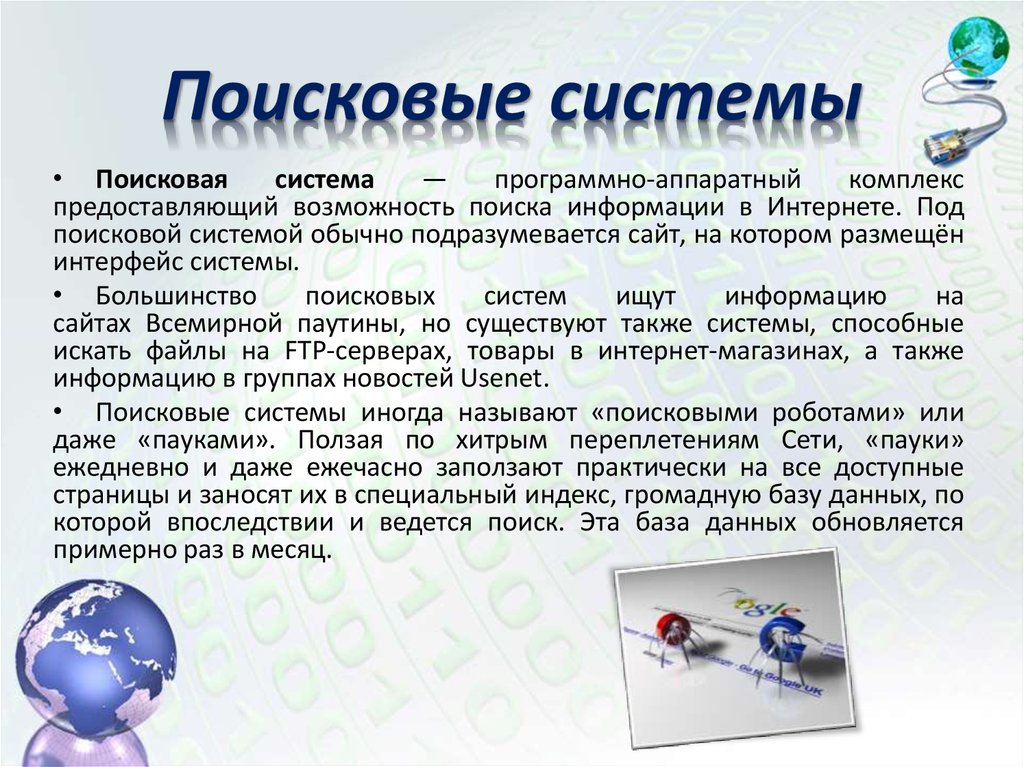

Алгоритмы — это набор формул и факторов, по которым поисковая система определяет релевантность страниц в соответствии с введенным запросом пользователя. Говоря простым языком, это совокупность определенных параметров, которые учитывает поисковик при распределении мест в выдаче на заданный запрос пользователя.

Когда я еще не была знакома с SEO, мне было интересно, как поисковик составляет рейтинг веб-страниц, как решает, какой сайт попадет в ТОП, какому место на 10-ой, 25-ой или 100-ой странице поисковой выдачи. Так вот, за это отвечают поисковые алгоритмы. У Яндекса начиналось все с того, что поисковик учитывал количество ключевых запросов и их расположение на странице. Достаточно было высчитать число ключей в текстах конкурентов и добавить больше у себя, и вы были бы на вершине выдачи. Но такая стратегия не устроила разработчиков поисковика, ведь результаты должны быть более объективными. С этого и началась активная работа над поисковыми алгоритмами.

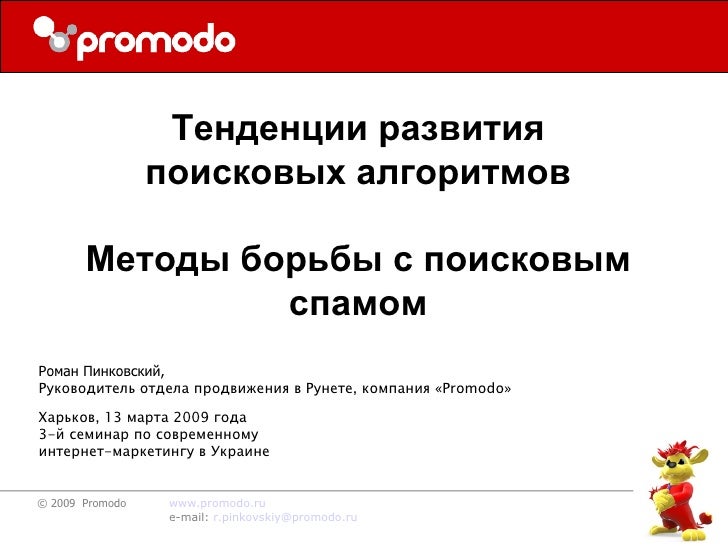

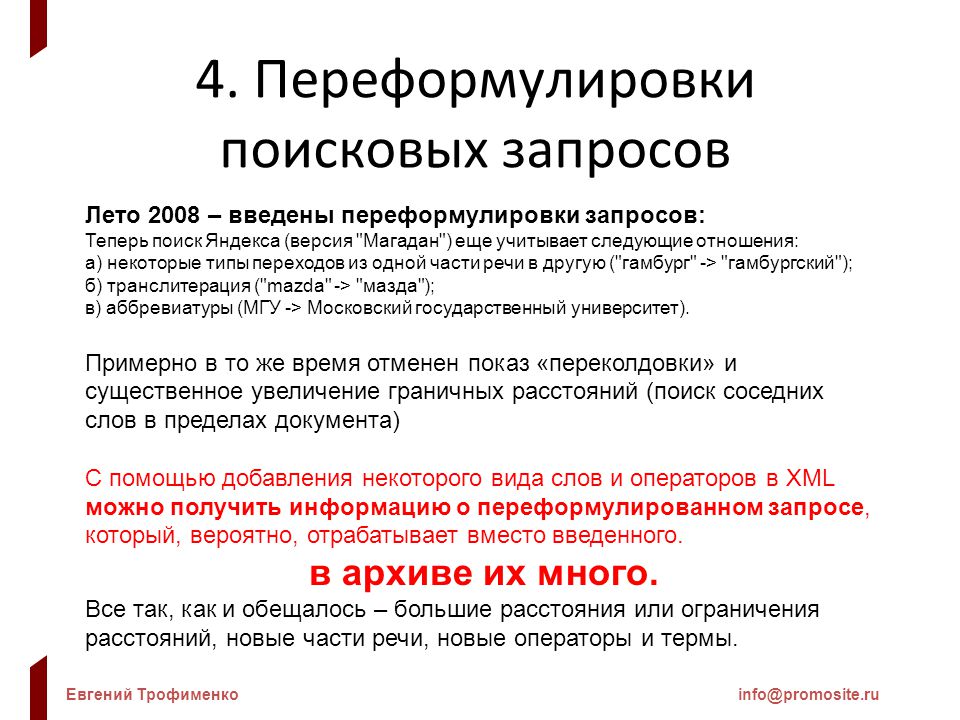

Стоит отметить, что у каждого поисковика свои алгоритмы, и они отличаются друг от друга. Регулярно Яндекс, Google или другая система обновляет алгоритмы, совершенствует их, выпускает новые. Предлагаю воспроизвести хронологию поисковых алгоритмов Яндекса с самого первого. В нашем блоге вы уже могли познакомиться с Королевым, Палехом, Минусинском, Баден-Баденом и многими другими. В этой же статье я постараюсь кратко рассказать про все алгоритмы российской поисковой системы Яндекс по порядку с указанием названия, даты анонса и описанием смысла. Но для начала сводная таблица:

| Дата выпуска | Название алгоритма |

|---|---|

| 2 июля 2007 года | Версия 7 |

| декабрь 2007- январь 2008 гг | «Версия 8» и «Восьмерка SP1» |

| 16 мая 2008 год, 2 июля 2008 года | Магадан и Магадан 2.0 |

| 11 сентября 2008 года | Находка 7 |

| Анонс был выпущен 10 апреля 2009 года, далее в течение года было проведено 5 обновлений алгоритма | Арзамас/Анадырь 7 |

| 17 ноября 2009 года | Снежинск 7 |

| 22 декабря 2009 года | Конаково 7 |

| 10 марта 2010 года | Конаково 1. |

| сентябрь 2010 года | Обнинск |

| 15 декабря 2010 года | Краснодар |

| 17 августа 2011 года | Рейкьявик |

| 12 декабря 2012 года | Калининград |

| 30 мая 2013 года | Дублин |

| 12 марта 2014 года | Без ссылок |

| 5 июня 2014 года | Острова |

| 1 апреля 2015 года | Объектный ответ |

| 15 мая 2015 года | Минусинск |

| 14 сентября 2015 года | |

| 2 февраля 2016 года | Владивосток |

| 2 ноября 2016 года | Палех |

| 23 марта 2017 года | Баден-Баден |

| 22 августа 2017 года | Королев |

| 19 ноября 2018 года | Андромеда |

| 17 декабря 2019 года | Вега |

| сентябрь 2020 | YATI |

| 10 июня 2021 | Y1 |

| 5 августа 2022 | Мимикрия |

Таблица 1.

Версия 7 (2 июля 2007 года)

До этой даты про внутреннюю работу системы Яндекс было мало что известно. Нововведения появлялись постоянно: стали учитываться ссылки, поисковик научился индексировать изображения, мета-теги, PDF и RTF документы и другие форматы, появился ТИЦ, стал учитываться региональный поиск и еще много всего.

Но началом истории алгоритмов считается Версия 7, когда 2.07.2007 г. господин Садовский на специальном форуме для Вебмастеров сделал анонс, что Яндекс представил новую формулу ранжирования. Предполагалось, что по ряду запросов релевантность станет лучше.

«Версия 8» и «Восьмерка SP1» (декабрь 2007— январь 2008 гг)

Одни из самых первых алгоритмов Яндекса, после появления которых авторитетные и трастовые ресурсы получили огромное преимущество в ранжировании. Также был внедрен фильтр «Прогонов», который боролся с накруткой ссылочных факторов.

Далее Яндекс стал внедрять новые алгоритмы с периодичностью 1-2 раза в год, что интересно, названия алгоритмам присваивались по принципу игры в города. Каждому новому алгоритму разработчики давали имя города первая буква, которого была последней в названии предшествующего. Самым первым стал Магадан.

Каждому новому алгоритму разработчики давали имя города первая буква, которого была последней в названии предшествующего. Самым первым стал Магадан.

Магадан и Магадан 2.0 (16 мая 2008 год, 2 июля 2008 года)

Этот алгоритм имел особую значимость, его можно считать своего рода революцией поисковой выдачи. Выделю основные изменения:

- Факторы ранжирования были увеличены в 2 раза.

- Была расширена база аббревиатур, синонимов, транслитераций. Яндекс стал переводить слова, индексировать сайты на других языках и представлять в выдаче ресурсы на английском, немецком и других языках. Стали учитываться переведенные или транслитерованные адреса страниц.

- Расширены классификаторы документов. Яндекс стал лучше различать одни типы страниц и ссылок от других.

- Добавлены факторы, которые отслеживали контент на уникальность.

- Добавлены факторы, классифицирующие коммерческие и геозависимые запросы. С появлением алгоритма, к примеру, пользователям из Новосибирска реже стали попадаться ресурсы из Уфы и других городов.

- Анализ текстов и семантического ядра стал более тщательным.

С приходом Магадана выдача стала значительно чище, а вот продвигать сайты и выводить их в ТОП стало гораздо труднее.

Находка (11 сентября 2008 года)

С анонсом можно ознакомиться здесь. Основные особенности алгоритма:

- Учет стоп-слов (знаков препинаний, местоимений, междометий и т.д.) в ключевых запросах, качество выдачи по таким поисковым запросам значительно выросло.

- Внедрен абсолютно новый подход к машинному обучению.

- Заметно был расширен тезаурус (словари Яндекса), к примеру, поисковик научился понимать слова, обозначающее одно и то же при слитном и раздельном написании. К примеру, «сельхоз техника» и «сельхозтехника» стало считаться равносильным запросом.

Арзамас/Анадырь (анонс был выпущен 10 апреля 2009 года, далее в течение года было проведено 5 обновлений алгоритма)

Основные изменения:

- Снятие омонимии.

Было улучшено ранжирование по запросам, имеющим несколько значений. К примеру, пользователь вводил запрос «фото львов», при этом не понятно, что именно ему требовалось фотографии животных или изображения города Львов. Яндекс усовершенствовал выдачу многозначных слов, учитывая историю других пользователей и частотность слов.

Было улучшено ранжирование по запросам, имеющим несколько значений. К примеру, пользователь вводил запрос «фото львов», при этом не понятно, что именно ему требовалось фотографии животных или изображения города Львов. Яндекс усовершенствовал выдачу многозначных слов, учитывая историю других пользователей и частотность слов. - Стал учитываться регион пользователя, результаты выдачи у пользователей из разных городов отличались. Было определено 19 регионов, в которые не входили Москва, Санкт-Петербург и Екатеринбург.

- Запросы стали разделяться на геозависимые и независимые от географии пользователя. Определяя зависимость запроса от его нахождения, применялась новая формула ранжирования. К примеру, если пользователь вводил «недорогое кафе», в выдаче показывались ресурсы с учетом города, если же запрос общий геонезависимый, то принципы ранжирования не менялись.

Так ресурсам был присвоен регион, который определялся исходя из IP хостинга, контактов на сайте или данных из Яндекс. Каталога.

Каталога.

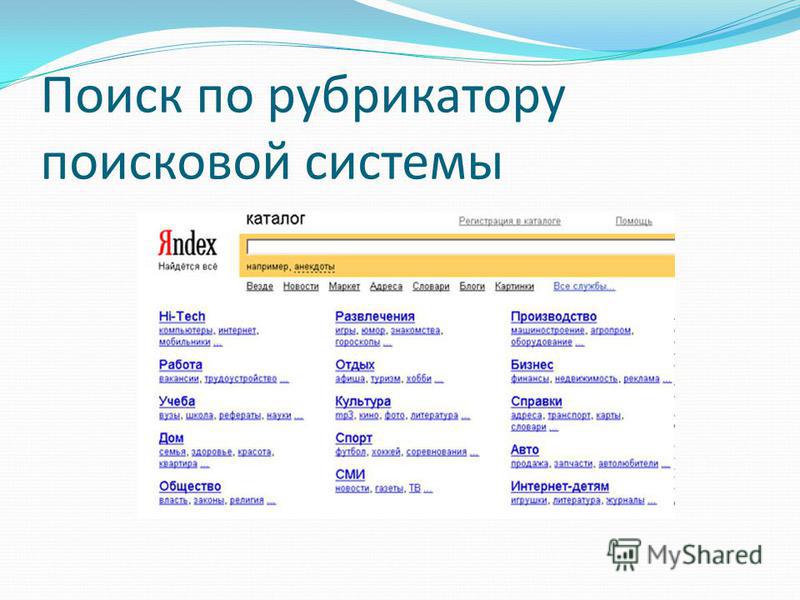

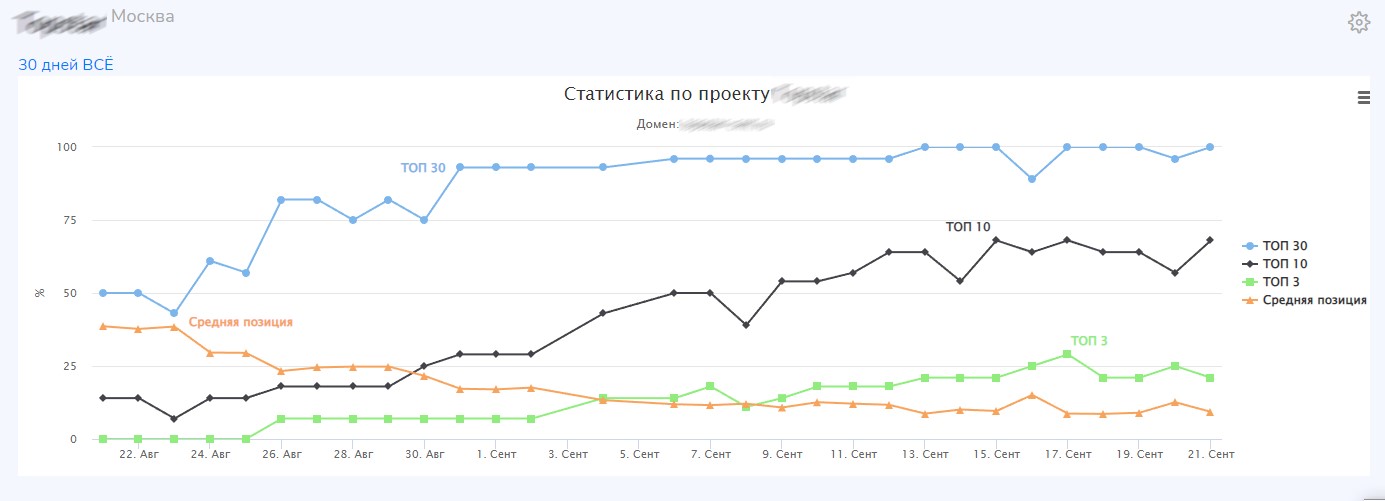

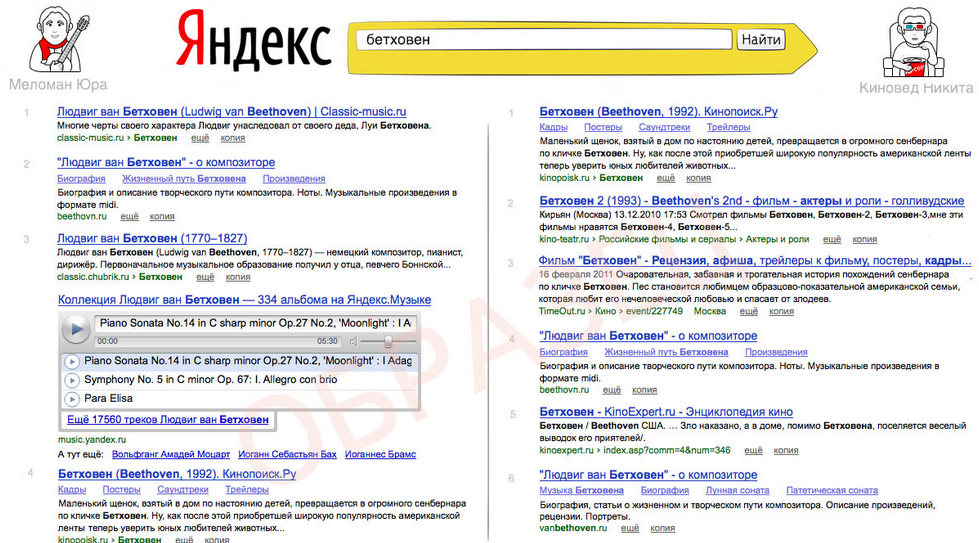

Рис.1. Региональная формула ранжирования

Кроме того, нововведения коснулись popunder, clickunder рекламы, к которым после прихода Арзамаса поисковик стал относиться очень негативно, наличие такой рекламы отрицательно влияло на ранжирование. Также была усовершенствована формула ранжирования сайтов по запросам, которые включают много слов.

Снежинск (17 ноября 2009 года)

Алгоритм, в рамках которого впервые был запущен новый метод машинного обучения Matrixnet. Он во много раз увеличил количество факторов ранжирования, тем самым улучшив качество поиска.

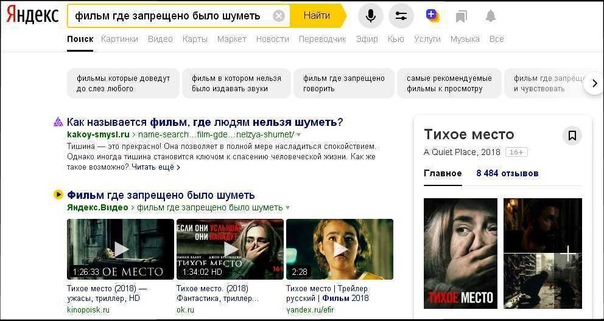

Рис.2. Матрикснет

С запуском Снежинска поисковая выдача была сильно изменена. Внедрили дополнительные региональные факторы ранжирования, стали работать фильтры АГС. Кроме того, были понижены в выдаче страницы, содержащие объемные тексты с высокой плотностью ключевых запросов.

Конаково, 22 декабря 2009 года

Расширен учет геофактора — теперь региональное ранжирование стало не только для 19 крупнейших регионов, которые изначально были определены при алгоритме Арзамас, но еще и для 1250 российских городов.

Конаково 1.1 (он же Снежинск 1.1), 10 марта 2010 года

Была улучшена формула ранжирования для геонезависимых запросов. Значительный рост после запуска алгоритма Снежинск 1.1 был у информационных некоммерческих ресурсов. Выросли позиции у энциклопедий, интернет-журналов, сайтов с обзорами и прочих инфоресурсов.

Обнинск, сентябрь 2010 года

Основная цель Обнинска — улучшение ранжирования по геонезависимым запросам, которых, по данным Яндекса, до 70 % от общего количества.

Рис.3. Анонс алгоритма «Обнинск»

Основные изменения:

- Перенастройка формулы, повышение производительности и совершенствование факторов ранжирования для геонезависимых запросов.

- Сложность формулы ранжирования достигла 280 МБ (в сравнении с 2006 годом она составляла 0,02 килобайта, в июле 2010 года — 120 Мбайт).

- Снижено влияние на ранжирование искусственных SEO-ссылок.

- ыл расширен словарь транслитерации, улучшилось качество выдачи на запросы, введенные на английском языке.

- Появилась возможность определять авторство текстов.

Краснодар (15 декабря 2010 года)

Главным внедрением алгоритма стала технология «Спектр», которая могла классифицировать запросы под разные потребности и разделять на разные категории. Всего было выделено 60 категорий.

Рис.4 Технология «Спектр»

Так, например, по запросу пользователя «Наполеон» нельзя было понять, что он хочет найти рецепт торта или узнать информацию о великом французском полководце. Исходя из истории других пользователей, поисковик определял, что 70 процентов искали биографию и все, что касается Наполеона Бонапарта; 30 процентов — рецепты торта. Поэтому в результатах выдачи выдавалось 7 страниц о полководце Наполеоне и 3 о приготовлении тортов.

Среди основных нововведений:

- Распределение запросов по категориям (товары, фильмы, поэты, города и пр.).

- Улучшение ранжирования по поисковым запросам, зависимым от региона.

- Впервые Яндекс проиндексировал соцсеть Вконтакте.

- Внедрение расширенных сниппетов для определенных видов организаций.

Рейкьявик, 17 августа 2011 г

Первый шаг к персонализированной выдаче. Основным новшеством стал учет языковых предпочтений пользователей. Так, поисковая система стала изучать, что чаще выбирает пользователь при вводе запроса на латинском, страницы на английском или же отечественные сайты. Если ранее он предпочитал в основном англоязычные ресурсы в сравнение с русским контентом, то в будущем система стала выдавать ему такие сайты чаще.

Дополнительные нововведения в Рейкьявике:

- Появилась новая формула для поисковых запросов с опечатками, появилась выдача по запросам с исправлением и в неизменном варианте с опечаткой.

- В Яндекс.Вебмастере был запущен инструмент, позволяющий закрепить права на авторство текстов. В нем можно было сразу добавить свой текст и указать, что именно ваш ресурс является первоисточником.

- Появилась возможность добавления информации об организации в Яндекс.

Справочник

Справочник - Появились колдунщики (математический, онлайн-игр).

Калининград, 12 декабря 2012 года

Глобальные перемены в поиске, значительная персонализация выдачи для поисковых подсказок и запросов.

Поисковая система стала учитывать историю и интересы пользователя и выдавать предпочтительные для пользователя варианты как в подсказках, так и в результатах поиска. Так, например, при вводе запроса «Гарри Поттер», любителям кино — предлагались фильмы о Гарри Поттере, а вот тем, кто любит читать — книги Джоан Роулинг.

Рис.5. Персонализация выдачи по запросу «Сталкер»

Такой подход значительно усложнил работу оптимизаторов, ведь выдача стала уникальной для каждого пользователя. Теперь в продвижении начали учитываться многие факторы: ссылочный профиль, контент, оптимизация под ключевые запросы, дизайн и юзабилити ресурса, работа с социальными платформами.

Дублин, 30 мая 2013 года

Разработчики Яндекса не остановили работу над совершенствованием персонализации выдачи, и если при Калининграде учитывались долгосрочные интересы пользователей, то после внедрения Дублина система стала учитывать его предпочтения в режиме реального времени. Т.е. выдача формировалась на основе текущей сессии, исходя из сиюминутных поисковых запросов.

Т.е. выдача формировалась на основе текущей сессии, исходя из сиюминутных поисковых запросов.

Рис.6. Учет сиюминутных запросов пользователей

Далее игра в «Города» Яндексом прекращается, и алгоритмам присваиваются названия без определенной последовательности, хотя наименования населенных пунктов еще встречаются.

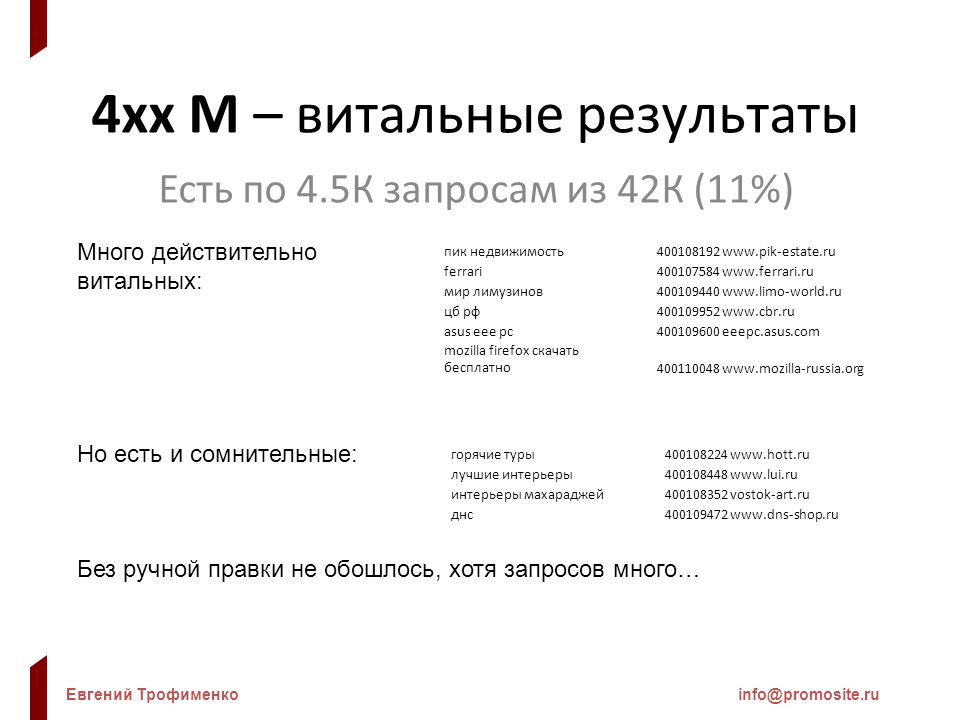

Без ссылок, 12 марта 2014 года

Заложен фундамент по отмене ссылочного продвижения. Ряд ссылочных факторов перестал учитываться для определенных запросов в Москве. Пока алгоритм задел только ресурсы, работающие в области недвижимости, туризма, электроники и бытовой техники.

Острова, 5 июня 2014 года

Был обновлен дизайн поисковой выдачи, появились так называемые «острова». Они представляли собой интерактивные ответы, появляющиеся прямо на странице результатов выдачи — пользователь мог воспользоваться ими без перехода на сам сайт. С помощью островных сервисов можно было узнать прогноз погоды, найти авиабилеты, узнать курс валют и не только.

Позже инструмент был признан неуспешным и закрыт. Сейчас же «острова» действуют для сервисов самого Яндекса.

Рис.7. Пример «острова» в поисковой выдаче Яндекса

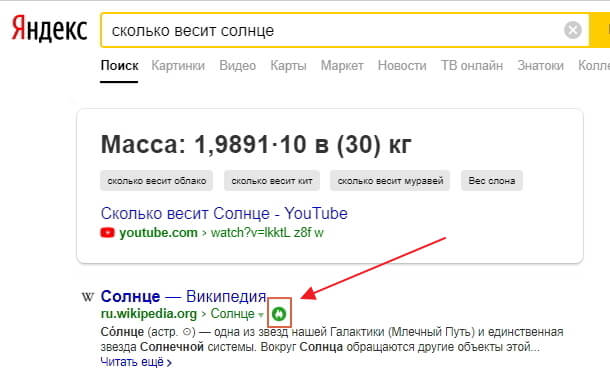

Объектный ответ, 1 апреля 2015 года

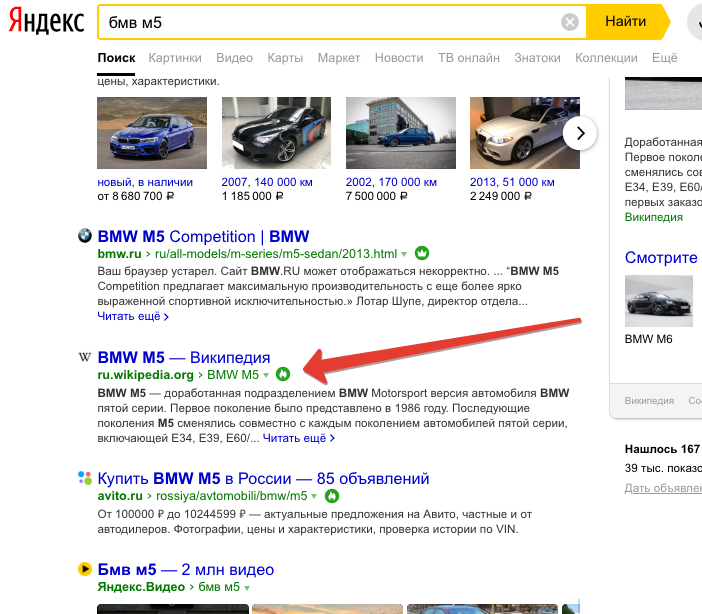

Снова изменения пришлись на дизайн страницы выдачи. Справа от основных результатов по запросу стала показываться карточка (блок) с информацией о запрашиваемом объекте. Яндекс сформировал собственную базу, в которой хранится свыше нескольких десятков миллионов объектных карточек.

Рис.8. Объектный ответ в поисковой выдаче Яндекса

Минусинск, 15 мая 2015 года

Пессимизация сайтов с большим количеством SEO-ссылок с некачественной ссылочной массой. После запуска данного алгоритма многие сайты, занимающие высокие позиции в поиске, значительно «просели», был наложен фильтр, который владельцы сайтов могли снять путем удаления ссылок, но после снятия фильтра редко у кого получалось восстановить прежние позиции.

Рис.9. Падение трафика после наложения фильтры Минусинск

После запуска Минусинска SEO-отрасль подверглась большим изменениям. Биржи SEO-ссылок практически остались без работы. Теперь в продвижении нужно было делать упор на внутреннюю оптимизацию (тех.параметры, качество контента, дизайн, юзабилити и пр.). Что касается ссылок, то они по-прежнему учитываются в продвижении, но речь идет исключительно о естественных ссылках.

Биржи SEO-ссылок практически остались без работы. Теперь в продвижении нужно было делать упор на внутреннюю оптимизацию (тех.параметры, качество контента, дизайн, юзабилити и пр.). Что касается ссылок, то они по-прежнему учитываются в продвижении, но речь идет исключительно о естественных ссылках.

Покупные — табу, которое приведет к очень негативным последствиям со стороны Яндекса. К естественным ссылкам стоит относить ссылки с ресурсов, схожих по тематике, путем размещения статей, ссылки с каталогов сайтов, с отзовиков, блогов, форумов и т.д.

О том, какие ссылки являются естественными и безопасными для Минусинска, мы уже рассказывали в одной из наших статей.

Многорукие бандиты Яндекса, 14 сентября 2015 года

Экспериментальный алгоритм, в рамках которого была проведена рандомизация поисковой выдачи. Так в ТОП попадали сайты, которые ранее были на низких позициях, к трастовым ресурсам, занимавшим первые позиции, подмешивались сайты-новички. Стратегия была введена с целью анализа поведенческих особенностей.

Владивосток, 2 февраля 2016 года

Доля мобильного трафика стала значительно расти, пользователей, которые искали информацию через планшеты, смартфоны или другие девайсы, становилось с каждым днем все больше. Яндекс запустил алгоритм, выявляющий сайты на мобилопригодность. В анонсе говорилось, что теперь адаптация ресурса под мобильную выдачу стала еще одним важным фактором в ранжировании. Кстати, об алгоритме Владивосток мы тоже упоминали в своем блоге.

Рис.10. Проверка сайта на адаптацию под мобильные устройства в Яндексе

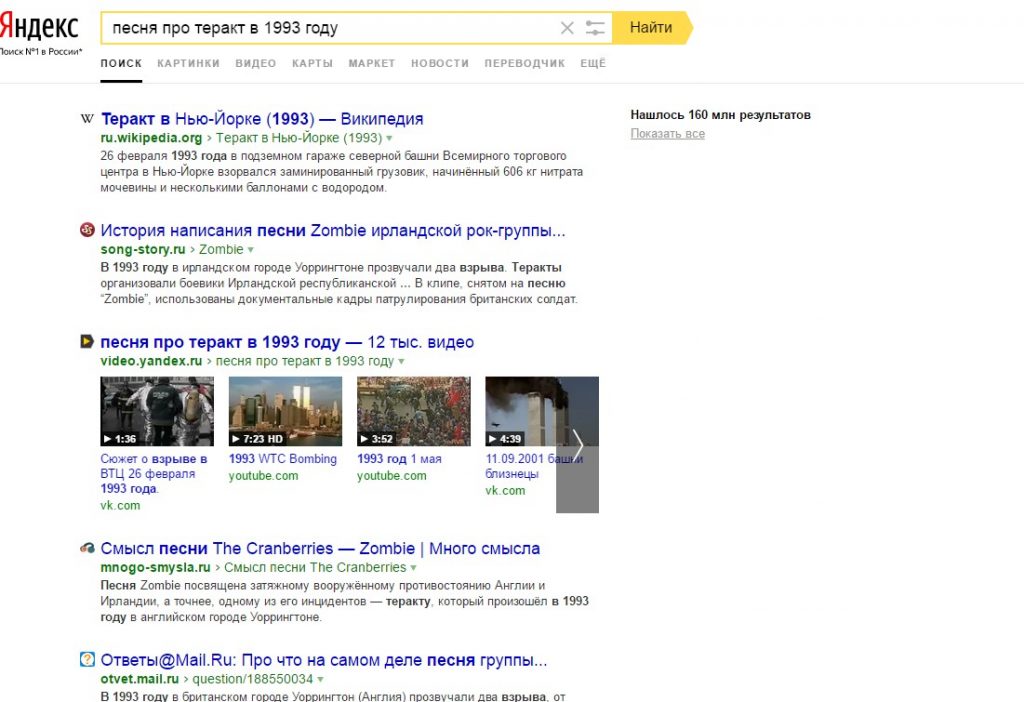

Палех, 2 ноября 2016 года

После внедрения алгоритма Яндекс научился понимать сложные запросы пользователей. При этом поиск стал проводиться не формально по словам, входящих в состав запроса, а по смыслу запроса и заголовка (Title) страницы. Т.е. теперь Яндекс мог находить нужные ответы на запрос пользователя, даже если на странице совсем не содержалось соответствующих ключевых слов. Теоретически понять немного трудно, попробую привести пример.

Допустим, вы введете запрос «фильм про Джека Воробья», поисковая система по смыслу найдет соответствующие результаты:

Рис.11. Пример результата выдачи при Палехе

Более развернуто мы уже рассказывали о Палехе.

Именно после запуска Палеха многие оптимизаторы поняли, что акцент нужно в первую очередь делать не на вхождении ключевых запросов, а на смысловую и техническую уникальность текста. Чтобы не роботы видели оптимизированные тексты, а пользователи с интересом изучали контент.

Баден-Баден, 23 марта 2017 года

Алгоритм Яндекса, запущенный в целях борьбы с переоптимизированным контентом. Поисковик стал понижать страницы или полностью сайты, в которых обнаруживал тексты с избытком ключевых слов, со скрытым контентом, мелким шрифтом. Такой контент поисковая система не считала полезным для пользователей, а написанным только для влияния на ранжирование. О том, как не попасть под Баден-Баден, как правильно писать тексты на сайт. мы писали много раз. Чтобы понять основную суть алгоритма, рекомендую к прочтению одну из таких статей.

Чтобы понять основную суть алгоритма, рекомендую к прочтению одну из таких статей.

Рис.12. Пример переоптимизированного текста, представленный Яндексом

Королев, 22 августа 2017 года

Усовершенствованный алгоритм Палеха, который научился давать ответы на сложные и многозначные запросы. Ориентируясь на смысловую составляющую запроса, поисковик стал сопоставлять не только заголовки, как это было при его предшественнике Палехе, но и в целом содержимое всей страницы. Система искусственного интеллекта стала учитывать поисковую статистику, мнение ассесоров и толокеров, а также оценки самих пользователей.

Допустим, вы введете запрос «фильм, в котором все кладут телефоны на стол». Вуаля — Яндекс сразу же выдает название фильма, при этом на страницах с описанием нет ключевых фраз «фильм, в котором все кладут телефоны на стол». Всё просто, искусственный интеллект. Так можно задавать сложные запросы, уточнять то, что-то в формате разговорной речи.

Рис. 13. Применение Королева при вводе сложного запроса

13. Применение Королева при вводе сложного запроса

Подробная статья о Королеве в нашем блоге, в ней мы рассказывали, как стал работать алгоритм, пояснили разницу между Королевым и Палехом, привели примеры.

Андромеда, 19 ноября 2018 года

Глобальный алгоритм от Яндекса, который внедрил множество интересных и весьма нужных нововведений. Был запущен новый алгоритм ранжирования Яндекс Proxima. Большая часть изменений коснулась колдунщиков и Яндекс-сервисов.

Итак, изучим основные модернизации:

-

Появились специальные значки качества, которые стали влиять на место в поисковой выдаче.

Рис.14. Примеры знаков качества в Яндексе

-

Улучшился сервис быстрых ответов Яндекса, который позволяет оперативно решать нужные задачи пользователей.

Рис. 15. Пример быстрых ответов

-

Появление Яндекс.Коллекций — инструмента, позволяющего сохранять в одном место все необходимое пользователю.

Это лишь краткий обзор алгоритма Андромеда, с более подробным можно ознакомиться в нашей статье.

Вега, 17 декабря 2019 года

Яндекс Вега – важное нововведение, касающееся пользовательских запросов, в рамках которого произошли следующие изменения:

- Если ранее по алгоритму Палех поисковик мог определять запросы по словам и по смыслу, то теперь при Веге будут выявляться близкие по смыслу страницы. Поисковая выдача формируется на смысловых кластерах.

- Внедрена технология пререндеринга SERP по запросу, что ускорит выдачу результатов поиска.

- Добавлена экспертность в ассесорские оценки с целью улучшения выдачи по тематикам.

- Улучшена гиперлокальность. Теперь результаты поиска будут формироваться не только на уровне города, но и микрорайона.

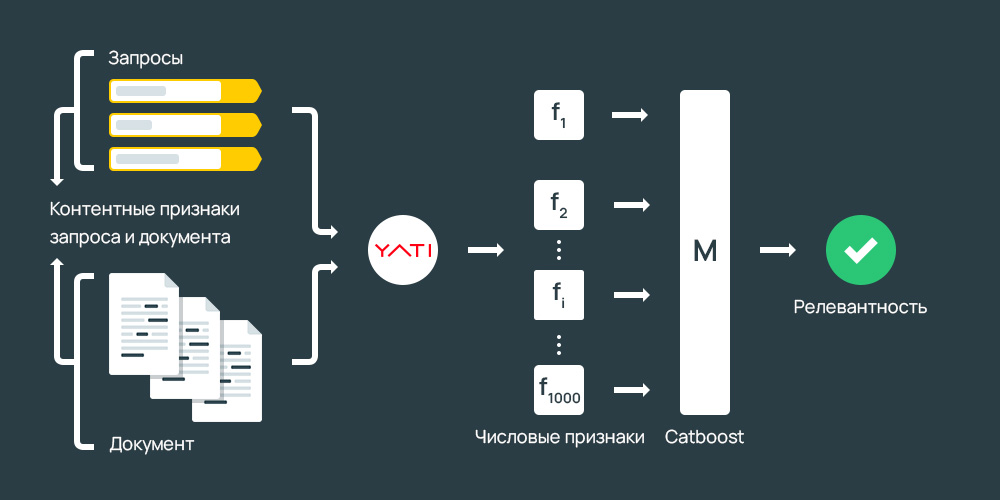

Yati, сентябрь 2020 года

Новая технология оценки текстов от Яндекс – YATI (Yet Another Transformer with Improvements), в основу которой легли алгоритмы «Палех» и «Королев». Более подробно о взаимосвязи с предшественниками можно ознакомиться в статье.

Более подробно о взаимосвязи с предшественниками можно ознакомиться в статье.

YATI – «архитектура нейросетей-трансформеров». Главная задача алгоритма – повысить точность выдачи. Теперь поисковые роботы учитывают до 10 предложений целиком, а именно:

- Смысл заголовков

- Фрагменты текста

- Структуру текста

- Контекст

Это все сопоставляется со смыслом запроса пользователя и отдается предпочтение наиболее релевантному сайту.

Сейчас необходимо уделить внимание семантическому ядру и качеству текста на сайте, поскольку неинтересные для поиска страницы будут снижать релевантность действительно важных страниц сайта.

В результате нововведений алгоритмы стали лучше сопоставлять смысловую связь между запросами пользователей и текстовыми документами. По словам специалистов Яндекс, технология показала рекордный уровень в качестве поиска.

Y1, 10 июня 2021 года

Завершает хронологию поисковых алгоритмов – Y1. Это большое обновление поиска (+2000 улучшений) с использованием технологий YaTI и YaLM на основе нейросетей-трансформеров. Главная задача обновления – сэкономить время пользователя.

Это большое обновление поиска (+2000 улучшений) с использованием технологий YaTI и YaLM на основе нейросетей-трансформеров. Главная задача обновления – сэкономить время пользователя.

Основные изменения:

Яндекс порадовал пользователей существенным апгрейдом, выкатив обновленные функции.

- Быстрые ответы – теперь имеют более широкую направленность, да и самих ответов в поисковой выдаче стало больше.

- Поиск фрагментов видео – основная суть в том, что поисковая система анализирует видео и включает видео ролик с момента, где начинается ответ на запрос пользователя.

- Оценка по отзывам – алгоритмы самостоятельно анализируют отзывы, а пользователю сразу показывают визуальную шкалу оценок.

- Поиск с помощью камеры – умная камера Яндекс, которая распознает различные объекты

Мы уже развернуто писали об изменениях в выдаче после внедрения Y1. Самый важный вывод – стандартных работ по SEO уже недостаточно, для продвижения необходимо тщательно прорабатывать контент на сайте, а также применять комплексный подход (омниканальность).

Самый важный вывод – стандартных работ по SEO уже недостаточно, для продвижения необходимо тщательно прорабатывать контент на сайте, а также применять комплексный подход (омниканальность).

Мимикрия, 5 августа 2022 года

Пока еще мало известно о новом алгоритме «Мимикрия», но суть ее проста: Яндекс понижает позиции тех сайтов, кто копирует текстовый или графический контент с известных ресурсов.

Оценка происходит по нескольким критериям:

- текстовый контент,

- оптимизация страниц под навигационные запросы

- и, естественно, визуальная составляющая

Если ваш сайт использует логотип, фавикон, сниппет и фирменный стиль одного из популярных сайтов, он в зоне риска. Подробнее о новом алгоритме читайте в этой статье.

Вывод

В этой статье собрана вся хронология алгоритмов поисковой системы. Зачем я это сделала? Чтобы вы понимали, как ведется работа поисковика. А самое главное, чтобы вы знали, как правильно продвигать свои сайты, на что смотрит поисковик, что появилось нового, а что уже в далеком прошлом. Теперь вы знаете, что написать оптимизированные тексты и «навешать» внешних ссылок совсем недостаточно, а скорее и вовсе во вред. Если же вникать в процесс продвижения вам совсем некогда, а попасть в ТОП выдачи все же хочется, обращайтесь к нашим специалистам.

Теперь вы знаете, что написать оптимизированные тексты и «навешать» внешних ссылок совсем недостаточно, а скорее и вовсе во вред. Если же вникать в процесс продвижения вам совсем некогда, а попасть в ТОП выдачи все же хочется, обращайтесь к нашим специалистам.

# алгоритмы яндекса # минусинск # оптимизация сайта # продвижение сайта # продвижение ссылками # региональное продвижение # яндекс

| Яндекс | |

| Алгоритмы, анализирующие качество контента | |

Флорида (Florida) Запуск: ноябрь, 2003 г. Особенности:

| Магадан Запуск: май, июль, 2008 г. Особенности:

|

Остин (Austin) Запуск: январь, 2004 г. Особенности:

| АГС-17, АГС-30, АГС-40 Запуск: сентябрь, декабрь, 2009 г., ноябрь, 2012 г. Особенности:

|

Панда (Panda) Запуск: февраль, 2011 г. Особенности:

| Снежинск Запуск: ноябрь, 2009 г. Особенности:

|

Колибри (Hummingbird) Запуск: сентябрь, 2013 г. Особенности:

| Краснодар Запуск: декабрь, 2010 г. Особенности:

|

Пират (Pirate) Запуск: октябрь, 2014 г. Особенности:

| Баден-Баден Запуск: март, 2017 г. Особенности:

|

Фред (Fred) Запуск: март, 2017 г. Особенности:

| |

| Алгоритмы, анализирующие качество ссылок | |

PageRank Запуск: впервые в 1998 г. С тех пор было несколько обновлений. Особенности:

| 8 SP1 Запуск: январь, 2008 г. Особенности:

|

Кассандра (Cassandra) Запуск: апрель, 2003 г. Особенности:

| Обнинск Запуск: сентябрь, 2010 г. Особенности:

|

Хилтоп (Hilltop) Запуск: декабрь, 2010 г. Особенности:

| Минусинск Запуск: май, 2015 г. Особенности:

|

Пингвин (Penguin) Запуск: апрель, 2012 г. Особенности:

| |

| Алгоритмы, анализирующие пригодность сайта для мобильных устройств | |

Mobile friendly Запуск: апрель, 2015 г. Особенности:

| Владивосток Запуск: февраль, 2016 г. Особенности:

|

| Алгоритмы, работающие со сложными и редкими запросами | |

Орион (Orion) Запуск: 2006 г. Особенности:

| Палех Запуск: ноябрь, 2016 г. Особенности:

|

RankBrain Запуск: октябрь, 2015 г. Особенности:

| Королев Запуск: август, 2017 г. Особенности:

|

| Алгоритмы, учитывающие интересы пользователя (персонализация) | |

Персональный поиск Запуск: июнь, 2005 г. Особенности:

| Рейкьявик Запуск: август, 2011 г. Особенности:

|

Search Plus Your World Запуск: январь, 2012 г. Особенности:

| Калининград Запуск: декабрь, 2012 г. Особенности:

|

Дублин Запуск: май, 2013 г. Особенности:

| |

| Алгоритмы, направленные на улучшение качества ранжирования в целом | |

Кофеин (Caffeine) Запуск: июнь, 2010 г. Особенности:

| Находка Запуск: сентябрь, 2008 г. Особенности:

|

| Алгоритмы, отвечающие за региональное ранжирование | |

Опоссум (Possum) Запуск: сентябрь, 2016 г. Особенности:

| Арзамас / Анадырь Запуск: первая версия — апрель, 2009 г.; затем еще несколько версий в июне, августе и сентябре 2009 г. Особенности:

|

Конаково Запуск: декабрь, 2009 г., март 2010 г. Особенности:

| |

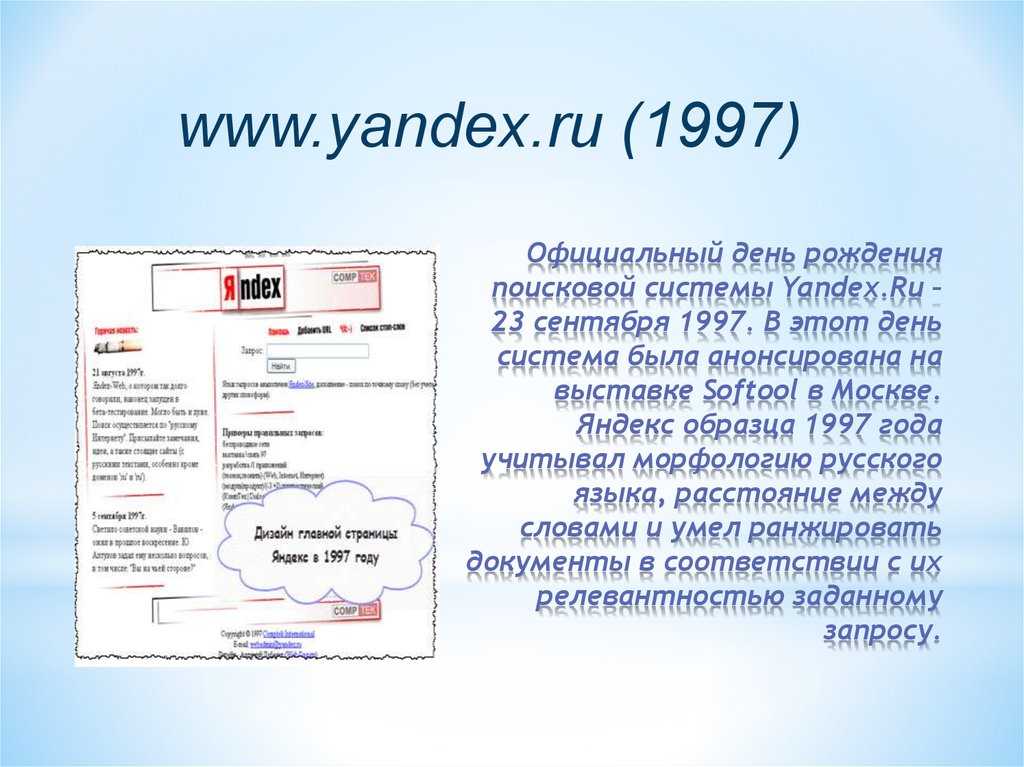

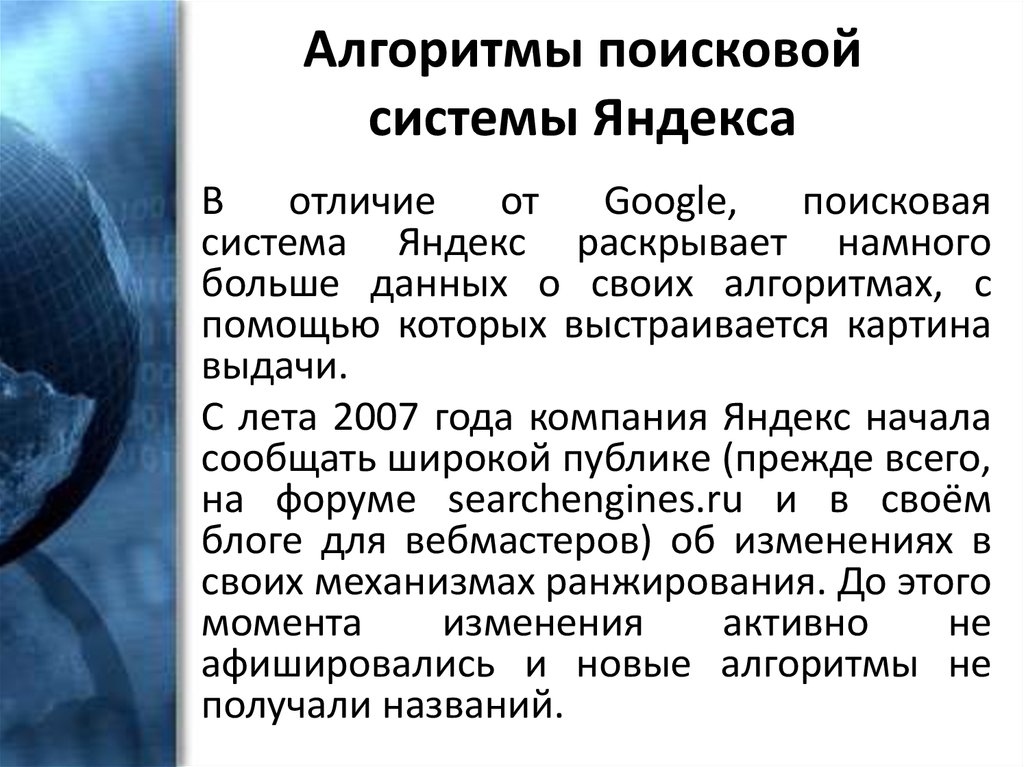

История развития алгоритмов ранжирования Яндекс

Долгое время специалисты компании Яндекс предпочитали не информировать пользователей о сменах алгоритмов ранжирования. Лишь в 2007 году сотрудники стали анонсировать введение новшеств в поисковую машину, слегка облегчив продвижение сайтов вебмастерам. В начале 2008 года Яндекс анонсировал выход нового алгоритма 8PS1, пообещав в дальнейшем придумывать своим новшествам более благозвучные названия. Начиная с мая 2008 года, Яндекс в названиях своих алгоритмов начинает играть в «Города» (каждый новый алгоритм начинается с последней буквы предыдущего).

Нововведения Яндекса

16 мая 2008 года – алгоритм «Магадан»

- Яндекс начал индексировать зарубежные веб-ресурсы

- Распознаются аббревиатуры, транслитерации, перевод запроса

- Увеличена скорость обработки информации по запросам, содержащихся в большом количестве документов

- Добавляются классификаторы ссылок

- Добавляются классификаторы контента

- Количество факторов, влияющих на ранжирование, увеличилось в 2 раза

- Увеличено расстояние между ключевыми словами, содержащимися в запросе. В документе они могут находиться на расстоянии в несколько слов друг от друга

- Оптимизирован «колдунщик» — улучшилось качество выдачи информации по запросу пользователя между поисковой строкой и ТОП-1.

В июльский апдейт алгоритма были добавлены очередные факторы ранжирования страниц, относящие контент к определенным категориям и тематикам, учитывающие процент уникальности контента и исправлены ошибки первой версии алгоритма Магадан.

11 сентября 2008 года – алгоритм «Находка»

- Машинное обучение вышло на новый уровень

- Подмешивание информационных сайтов в коммерческую выдачу

- Улучшение ранжирования по запросам со стоп-словами

- Расширение словарей Яндекса

- Санкции к сайтам с редиректом

- Оптимизаторы заметили, что новые сайты на старых доменах стало проще продвигать в ТОП-10Б

В апдейт алгоритма в поисковую строку добавились подсказки.

10 апреля 2009 года – алгоритм «Арзамас»

- Появление в выдаче сервиса «Яндекс-картинки»

- Происходит разделение на геозависимые и геонезависимые запросы

- Яндекс стал различать омонимы (ключ – к замку, родник)

Алгоритм совершенствовался 4 раза: с мая 2009 по сентябрь 2010. С этого периода Яндекс стал предупреждать пользователей о вредоносных сайтах, строже стал относиться к сайтам запрещенных тематик (порно), ужесточил меры к сайтам с рекламой, открывающейся при заходе на сайт (поп-апы и пр).

Так же алгоритм существенно понизил влияние SEO-ссылок как основного фактора ранжирования. Обнаруженное несовершенство алгоритма (можно было продвигать страницу, повлияв на выдачу огромным текстом в 15 000-30 000 знаков, перенасытив кючевыми фразами) напомнило вебмастерам и оптимизаторам, что тексты на сайты пишутся для людей и переспамленные ключевыми словами огромные тексты сильно понизились в результатах поисковой выдачи.

17 ноября 2009 года – алгоритм «Снежинск»

- Появление поведенческих факторов – полезность страницы определяется пользователем, а не поисковой машиной

- Проседание коммерческих сайтов по геонезависимым запросам и взлет в ТОП информационных

- Для каждого запроса определяется собственная формула ранжирования (для разных запросов доминирующими становятся разные факторы)

В апдейт алгоритма для новостных сайтов появляется свой «новостной» поисковый робот и фильтр АГС. Сайты, попавшие под АГС, практически полностью исчезают из поисковой выдачи.

Алгоритм «Снежинск» явился последним новым алгоритмом. Все последующие алгоритмы являются, по сути, дополнениями к «Снежинску». Обусловлено это введением Матрикснет – самообучающимся алгоритмом.

6 августа 2010 года – алгоритм «Обнинск»

- Искусственно проставленные (покупные) ссылки ограничили влияние на ранжирование

- Для пользователей России было улучшено ранжирование по геонезависимым запросам, составляющих 70% от количества всех запросов россиян

В этом же году Яндекс проиндексировал социальную сеть «Вконтакте» и заключил договор с Facebook.

15 декабря 2010 года – алгоритм «Краснодар»

- Появление в выдаче спектра похожих на запрос пользователя поисковых запросов

- Оптимизировано ранжирование по геозависимым запросам

- Увеличилось влияние поведенческих факторов

- Происходит классификация и разделение запросов на категории (товары, книги, писатели и тп) и объекты (имена, марки, бренды и тп)

Выход «Краснодара» обусловлен появлением технологии «Спектр» — нового подхода к результатам поисковой выдачи.

С 24 декабря 2010 года по 15 августа 2011 года происходили следующие изменения:

- Яндекс приобрел WebVisor – технологию, с помощью которой стало возможно анализировать действия пользователя на сайте. технология доступна пользователям Яндекс-Метрики.

- Поисковые подсказки стали региональными.

- Яндекс учитывает атрибут rel=»canonical».

- Появляется сервис – защита авторского контента – ввод оригинального текста перед публикацией.

- Санкции за накрутку поведенческих факторов. Сайты, замеченные в злоупотреблении, были значительно понижены в поисковой выдаче.

- Санкции за «неудобные для пользователя тексты». Сайты, на которых располагались неформатированные (не разбитый на абзацы, без подзаголовков) «простынный» тексты, были пессимизированы.

17 августа 2011 года – алгоритм «Рейкьявик»

Яндекс стал учитывать запросы пользователя, заданные на английском языке и начал показывать в результатах выдаче англоязычные ресурсы, отфильтровывая запросы латиницей, запросы, заданные в другой раскладке клавиатуры, транслит и тд.

23 ноября 2011 года – безымянная надстройка

Асессоры (люди, оценивающие соответствие поисковой выдачи поисковому запросу) вооружаются дополнительными параметрами оценки сайта: дизайн сайта, качество предоставляемой на сайте услуги, ассортимент, удобство выбора и степень доверия пользователя. Иными словами, отныне самостоятельно можно определить вероятность повышения или понижения сайта в поисковой выдаче на основе вышеперечисленных параметров.

Что хорошо для российского коммерческого сайта

- Наличие на видном месте (в шапке сайта) городских телефонных номеров и бесплатных номеров, начинающихся с 8-800.

- Наличие нескольких офисов по стране или в пределах региона (области, города).

- Узнаваемость бренда в интернет-пространстве: поисковые запросы по названию фирмы, упоминание в документах.

- Большой ассортимент товаров\услуг

- Гибкая ценовая политика

- Несколько способов оплаты

- Акции, специальные предложения, скидки, распродажи.

- При совершении транзакции (процесса покупки-оплаты) редирект на протокол https.

- Положительные отзывы клиентов, портфолио, рейтинги, сервисы, обзоры.

- Доступность товра\услуги в 1-2 клика с любой страницы сайта.

- Удобный поиск: по категории товара, по наименованию, по бренду.

- Наличие e-mail, соответствующего доменному имени (например, [email protected])

- Стилистически, орфографически, пунктуационно грамотный текст.

- Качественные уникальные фото.

Что плохо для российского коммерческого сайта

- Отсутствие контактных данных либо указание только мобильного телефона.

- Отсутствие адреса офиса.

- Негативные отзывы о бренде (фирме, продукте и пр).

- Отсутствие цены товара\услуги.

- Реклама сторонних ресурсов (ссылки, баннеры, контекстная реклама).

- Запутанная сложная форма заказа.

- Невалидный код, ошибки кода, таблицы стилей (CSS) находятся не в отдельном файле.

- Незаполненные страницы с товаром, ошибочная классификация товара.

Все эти параметры не являются руководством к действию и носят рекомендательный характер.

Как будет работать поиск в 2021? YATI – новый алгоритм ранжирования Яндекс — SEO на vc.ru

В конце минувшего года Яндекс запустил новый алгоритм поискового ранжирования YATI, действие которого основано на нейросетях-трансформерах. Эта нейросетевая архитектура опирается на смысловую составляющую, обеспечивая совершенно новый подход, который устанавливает наилучшее семантическое единение между намерением пользователя, запросом и документом.

18 485 просмотров

YATI (Yet Another Transformer with Improvements) в переводе означает «Ещё один трансформер с улучшениями»

По заверениям специалистов по машинному обучению в Яндекс – внедрение YATI рекордным образом улучшило ранжирование и стало наиболее значимым событием для отечественного поисковика за последние 10 лет, со времен внедрения Матрикснета.

Совместный эффект Палеха и Королёва оказали меньшее влияние на поиск, чем новая модель на трансформерах. Вместе с тем, следует понимать, что нейросети не отменяют тысячи ранее заложенных правил в общую поисковою формулу. Однако значимость YATI ярко прослеживается в факте, свидетельствующем о том, что если убрать из общей формулы все прочие факторы и оставить только новую модель, то качество ранжирования, как заявил руководитель группы нейросетевых технологий в поиске Яндекс Александр Готманов, по основной офлайн-метрике упадёт лишь на 4-5%.

Как было раньше?

Система поиска всегда определяла релевантность выдачи путем сопоставления множества разнообразных факторов, намекающих на семантическую связь между поисковым запросом и материалом, изложенном на отдельной веб-странице. То есть, в упрощенном представлении, если статья и запрос имели множество одинаковых слов, то роботом данная страница воспринималась наиболее приоритетной. Разумеется, учитывался и расчет количества фраз, объем материала, поведенческие факторы, поисковая история пользователей и многое другое, но робот при этом никогда не понимал сути документа.

Алгоритмы Яндекс на 2015 год

Так происходило вплоть до 2016 года, пока не появились такие алгоритмы как Палех и Королев. Тогда Яндекс впервые публично заявил о применении нейросетей, обозначив, меж тем, что дальнейшее развитие поиска им видится в том, чтобы в финале получить модель, которая сможет всякий раз понимать любые запросы на уровне, сопоставимом с человеческим. Технология YATI являет собой еще один значительный шаг к этому, а Палех и Королев являлись важнейшими вехами развития поиска на пути к YATI.

Палех

Палех обеспечил возможность понимания сложных запросов пользователей. То есть поиск стал проводиться не строго по словам, которые написал пользователь, но также по смыслу запроса и заголовка страницы. Так, Яндекс научился находить требуемые ответы даже при отсутствии ключевых слов.

Выдача при Палехе стала формироваться по смыслу, а не по точным вхождениям

С этого момента точное вхождение ключевых запросов стало менее значимым фактором при ранжировании и акцент при SEO-продвижении стал смещаться в сторону смысловой и технической уникальности текста, мотивируя к созданию более полезного и содержательного контента.

Королев

Более совершенной вариацией Палеха стал Королев. Он еще лучше научился обрабатывать сложные и многозначные запросы, ориентируясь при этом не только на сопоставление заголовков, но и на содержимое страницы в целом. Алгоритм также стал учитывать поисковую статистику, мнение ассесоров и толокеров, а также оценки самих пользователей.

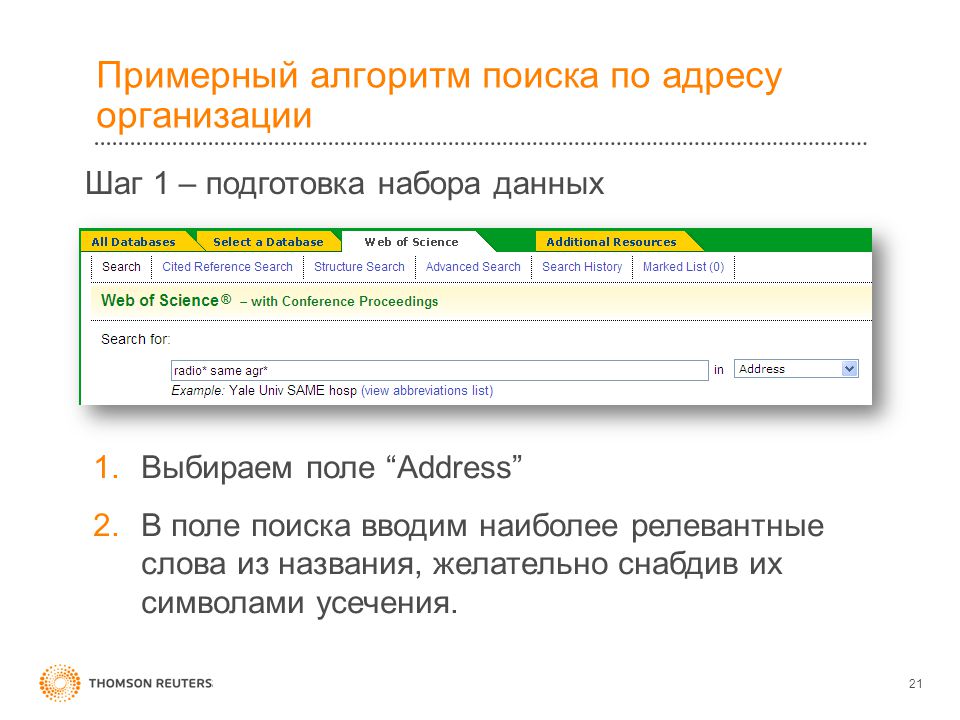

Например, пользователь вводит запрос «фильм, в котором нельзя шуметь». В этом случае Яндекс сразу выведет название фильма, при этом ключевых фраз в Title и Description не будет.

Работа Королева при сложном запросе

Таким образом, стало возможным задавать поисковой системе сложные вопросы в формате разговорной речи и получать на это корректные ответы.

Существенным преимуществом Королева также стала возможность его применения к существенно большему количеству страниц без ущерба ко времени выдачи результатов по запросу. Палех был относительно тяжелым алгоритмом и использовался исключительно на поздних стадиях ранжирования, приблизительно к 150 лучшим страницам из отфильтрованного по старым правилам списка.

О трансформерах

Палех и Королев позволили Яндексу не просто находить совпадения, а понимать суть вопроса, значительно улучшили процесс ранжирования, но всё же справлялись с этим неидеально. Лишь с момента ввода YATI факторы смысла стали превосходить факторы вхождений по мНЧ-фразам.

Путь Яндекса к YATI

Прежде, чем мы начнем подробнее говорить о YATI, следует отдельно пояснить что такое трансформеры.

Говоря простыми словами, трансформерами в данном случае называют сверхбольшие и сверхсложные нейросети, способные легко справляться с разнообразными задачами в сфере обработки естественного языка, будь то перевод или создание текста.

Скрываются за этим огромные вычислительные мощности. Причем стремительно нарастающие. Так, до применения трансформеров, используемая в Яндексе нейросеть, обучалась только на одном графическом ускорителе Tesla v100. Уходило на такое обучение не более одного часа. А вот обучение нейросети-трансформера на таком ускорителе заняло бы около 10 лет. Потому внедрение новых технологий потребовало использования около сотни похожих ускорителей с быстрой передачей данных между друг другом. Для этого Яндекс построил специальный кластер, предназначенный для вычислений, с распределенным обучением внутри него.

Потому внедрение новых технологий потребовало использования около сотни похожих ускорителей с быстрой передачей данных между друг другом. Для этого Яндекс построил специальный кластер, предназначенный для вычислений, с распределенным обучением внутри него.

То есть переход на новый алгоритм YATI был довольно сложной задачей с инженерной точки зрения. Множество ускорителей объединили в кластеры, связали в сеть и разработали для получившихся серверов мощную систему охлаждения. Но даже с такими мощностями на обучение модели сейчас уходит около месяца.

Классическая техника обучения трансформеров предполагает демонстрацию им неструктурированных текстов. То есть берется текст, в нем маскируется определенный процент слов, а перед трансформером ставится задача угадывать данные слова. Для YATI задача была усложнена: ему показывался не просто текст отдельного документа, а действительные запросы и тексты документов, которые видели пользователи. YATI угадывал, какой из документов понравился пользователям, а какой нет. Для этого использовалась экспертная разметка асессоров, которые оценивали релевантность каждого документа запросу по сложной шкале.

Для этого использовалась экспертная разметка асессоров, которые оценивали релевантность каждого документа запросу по сложной шкале.

После этого Яндекс брал массив полученных данных и дообучал трансформер угадывать экспертную оценку, обучаясь, таким образом, ранжировать. В результате поисковой алгоритм был существенно улучшен и Яндекс вышел на рекордный уровень в качестве поиска.

Преимущества YATI и трансформеров

В отличие от предшествующих нейросетевых алгоритмов Яндекса Палех и Королёв, YATI умеет предсказывать не клик пользователя, а экспертную оценку, что являет собой фундаментальную разницу.

Кроме этого, преимущества трансформеров заключаются в следующем:

- поиск работает не только с запросами и заголовками, но и способен оценивать длинные тексты;

- присутствует «механизм внимания», выделяющий в тексте наиболее значимые фрагменты;

- учитывается порядок слов и контекст, то есть влияние слов друг на друга.

Теперь, к примеру, когда вы будете искать билеты на самолет из Екатеринбурга в Москву, поисковик поймет, что вам нужно именно из Екатеринбурга в Москву, а не наоборот. Помимо того, Яндекс стал лучше распознавать опечатки.

YATI намного лучше предшественников работает со смыслом запроса, алгоритм направлен на более глубокий анализ текста, понимание его сути. Это значит, что поисковик будет точнее понимать, какая информация является наиболее релевантной запросу пользователя.

Говоря о ранжировании, можно спрогнозировать, что смысловая нагрузка контента возымеет более значимую роль. То есть экспертные тексты, полностью раскрывающие ответ на запрос пользователя, будут всё больше и чаще попадать в ТОП.

Особенности YATI:

1. Переформулирование запросов и «пред-обучение на клик». Яндекс имеет базу из 1 млрд. переформулированных запросов: [1 формулировка] → без клика → [2 формулировка]. Так, модель учится предсказывать вероятность клика.

2. Оценки на Яндекс.Толоке. Использование оценок толокеров.

3. Оценки асессоров. Использование экспертных оценок релевантности.

4. Данные, которые подаются на вход:

- текст запроса;

- расширение запроса;

- «хорошие» фрагменты документа;

- стримы для документа: анкор-лист, запросный индекс для документа.

YATI и Google Bert

Одним из последних обновлений главного конкурента в области поиска Яндекса Google стало внедрение алгоритма BERT. Эта нейронная сеть также, как и YATI, решает задачу анализа поисковых запросов и их контекста, а не отдельный анализ ключевых запросов. То есть BERT анализирует предложение целиком.

И YATI, и BERT ориентированы на лучшее понимание смысла поискового запроса. Однако, как утверждают специалисты Яндекс, алгоритм YATI лучше справляется со своими задачами, поскольку кроме текста запроса анализирует еще и тексты документов, а также учится предсказывать клики.

Ниже в таблице представлено сравнение качества алгоритмов, основанных на нейронных сетях, в задаче ранжирования, где “% NDCG” – нормированное значение метрики качества DCG по отношению к идеальному ранжированию на датасете Яндекс. 100% здесь означает, что модель располагает документы в порядке убывания их настоящих офлайн-оценок.

Вместе с тем, требуется отметить, что BERT решает существенно большее количество задач, среди которых распознавание «смысла» текста лишь одна из множества других. На BERT базируется большое семейство языковых моделей:

С точки же зрения компьютерной лингвистики, BERT и YATI – довольно похожие алгоритмы.

Как изменится ранжирование в условиях действия Яндекс YATI

Владельцев ресурсов, а также всех, кто занимается продвижением сайта, очевидно, должен интересовать вопрос, как YATI повлияет на способы оптимизации. Если исходить из утверждения, что новый алгоритм обеспечивает более 50% вклада в ранжирование, то можно предположить, что «смысл» окончательно победил возможности SEO-специалистов в проработке текстов, а значит оптимизировать ничего не нужно. А также можно решить, что такие факторы, как «точное вхождение», «Title» и «добавить ключей» больше не имеют влияния.

А также можно решить, что такие факторы, как «точное вхождение», «Title» и «добавить ключей» больше не имеют влияния.

Данные суждения будут поспешны и ошибочны. Новый алгоритм не отменяет старые факторы ранжирования, а лишь дополняет их более качественным анализом текстов. Дело в том, что изначально для улучшения распределения, поиск Яндекс обучался на редких запросах, где документов и без того недостаточно. И когда речь идет о 50%-ом вкладе в ранжирование, то имеются ввиду именно редкие запросы. Борьба между «смыслом» и «вхождением», где «смысл» начал побеждать, видна именно на них.

А вот ситуация по ВЧ-запросам, по средне- и низкочастотным не претерпела значительных изменений. Это означает, что техническую оптимизацию, привлечение естественных ссылок и улучшение поведенческих факторов как на поиске, так и на сайте – забрасывать не нужно.

Исследования независимых специалистов показывают, что значимость фактора «точное вхождение в тексте» по НЧ-запросам после запуска YATI ничуть не ослабла, а, напротив, увеличила свою значимость. А вот тут ситуация с точным вхождением поменялась – явного влияния в ТОП-10 теперь нет, хотя вне его оно сохраняется.

А вот тут ситуация с точным вхождением поменялась – явного влияния в ТОП-10 теперь нет, хотя вне его оно сохраняется.

Среднее значение ключевого фактора ТОП-10 и вне его:

Среднее значение фактора здесь находится в районе единицы. То есть, если имеется одно вхождение, значит этого вполне достаточно.

Фактор «наличие всех слов из запроса в тексте» также не потерял своего значения. Выборка коммерческих запросов в Яндексе демонстрирует, что существенной разницы между НЧ и СЧ+ВЧ запросами нет. Тем не менее, наблюдается взаимосвязь между попаданием в ТОП и наличием всех слов запроса в документе. Значение этого фактора составляет 0.8, то есть, работает это для 80% сайтов.

Проверка фактора «слова в Title» после YATI показывает рост среднего значения этого фактора. То есть в выдаче стали чаще встречаться документы, Title которых содержит все слова в запросе, но вместе с тем, здесь наблюдается заметное понижение взаимосвязи с позицией.

Практические советы

Итак, перейдем к конкретным рекомендациям по оптимизации сайта в условиях работы алгоритма YATI:

- Адаптируйтесь под YATI.

Увеличивайте количество слов, встречаемых в контексте со словами из запроса. К таковым могут относиться слова из подсветки выдачи, а также слова, задающие тематику и встречаемые у конкурентов, но отсутствующие на продвигаемой странице.

Увеличивайте количество слов, встречаемых в контексте со словами из запроса. К таковым могут относиться слова из подсветки выдачи, а также слова, задающие тематику и встречаемые у конкурентов, но отсутствующие на продвигаемой странице. - Расставляйте акценты в тексте и форматируйте его. В текстах свыше 12-14 предложений обязательно требуется использовать заголовки, выносить в них и в выделенные фрагменты тематические и ключевые слова.

- Выполняйте анализ и оптимизацию запросного индекса и для документов, и для сайта в целом в Яндекс.Вебмастере. Проверяйте релевантность запросов, по которым были как переходы на заданный URL, так и только показы без переходов. Данные всего сайта, как и прежде, также сказываются на факторах для заданной страницы. Поэтому проверки имеют смысл в разрезе всего сайта, а не только URL.

- Расширяйте семантическое ядро для продвижения в сторону НЧ-запросов. Синонимичные и, так называемые, вложенные запросы помогают в продвижении по более общим и близким по смыслу.

- Выполняйте конкурентный анализ. Анализируйте показы страниц конкурентов по запросам. Изучайте чужие тексты: какие тематические слова и фразы в них используются, какова структура и т.п.

- Проводите классическую оптимизацию: текст, точные вхождения, слова в Title.

Заключение

Трансформеры значительно улучшили качество поиска в Яндексе и вывели его на новый рекордный уровень. Применение тяжелых моделей, основанных на работе нейронных сетей, способных приближать структуру естественного языка и лучше учитывать семантические связи между словами в тексте, помогает пользователям все чаще встречаться с эффектом «поиска по смыслу», а не по словам.

Тем не менее несмотря на то, что YATI преподносится и по праву считается прорывной технологией, принципы работы поиска в Яндексе всегда формируются эволюционным, а не революционным образом. То есть, его обновление выполняется путем последовательного добавления новых факторов ранжирования к старым, а не радикальной сменой всех основ. Это означает, что поисковая оптимизация с приходом YATI не потеряла своей актуальности, а лишь требует некоторых корректировок ряда своих методов.

Это означает, что поисковая оптимизация с приходом YATI не потеряла своей актуальности, а лишь требует некоторых корректировок ряда своих методов.

Управляющий директор группы компаний Яндекс Тигран Худавердян о внедрение алгоритма YATI в интервью на конференции YaС 2020

YATI безусловно изменит поисковую выдачу Яндекса, но поскольку система требует обучения, то для этого потребуется время. Поэтому сейчас у вас есть хорошая возможность внести необходимые изменения на сайте и доработать SEO-тексты устаревшего формата, сохранив тем самым свои позиции и улучшив их к тому моменту, когда поиск окончательно перестроится на новый формат. С оптимизацией вам могут помочь советы, изложенные в этой статье, а также наша компания ADVIANA.

Заметим, что мы никогда не гнались за некачественными и серыми методами оптимизации и всегда много внимания уделяли описаниям на сайте, а также всем видам текста. Для наших проектов переход на новый алгоритм не был болезненным, так как все они уже соответствовали новым требованиям. Кроме того, мы постоянно следим за изменениями в мире digital-маркетинга в целом и SEO-оптимизации в частности, что позволяет нам использовать в своей работе только актуальные методы продвижения по понятной цене и с прогнозируемым результатом.

Кроме того, мы постоянно следим за изменениями в мире digital-маркетинга в целом и SEO-оптимизации в частности, что позволяет нам использовать в своей работе только актуальные методы продвижения по понятной цене и с прогнозируемым результатом.

Желаем всем высоких позиций в поиске!

В статье используются графические иллюстрации из вебинара Дмитрия Севальнева («Пиксель Тулс»).

Поисковые алгоритмы Google и Yandex 🚀 хронология

Содержание

- 1 Яндекс: виды алгоритмов с зачатия до сегодня

- 1.1 Магадан

- 1.1.1 Особенности

- 1.1.2 Результаты

- 1.2 Находка

- 1.2.1 Особенности

- 1.2.2 Результаты

- 1.3 Арзамас

- 1.3.1 Особенности

- 1.3.2 Результаты

- 1.4 Снежинск

- 1.4.1 Особенности

- 1.4.2 Результаты

- 1.5 Обнинск

- 1.5.1 Особенности

- 1.5.2 Результаты

- 1.6 Краснодар

- 1.6.1 Особенности

- 1.6.2 Результаты

- 1.

7 Рейкьявик

7 Рейкьявик- 1.7.1 Особенности

- 1.7.2 Результаты

- 1.8 Калининград

- 1.8.1 Особенности

- 1.8.2 Результаты

- 1.9 Дублин

- 1.9.1 Особенности

- 1.9.2 Результаты

- 1.10 Острова

- 1.10.1 Особенности

- 1.10.2 Результаты

- 1.11 Минусинск

- 1.11.1 Особенности

- 1.11.2 Результаты

- 1.12 Владивосток

- 1.12.1 Особенности

- 1.12.2 Результаты

- 1.1 Магадан

- 2 Google: история создания и развития алгоритмов

- 2.1 Кофеин

- 2.1.1 Особенности

- 2.1.2 Результаты

- 2.2 Panda (Панда)

- 2.2.1 Особенности

- 2.2.2 Результаты

- 2.3 Page Layout (Пейдж Лайот)

- 2.3.1 Особенности

- 2.3.2 Результаты

- 2.4 (Венеция)

- 2.4.1 Особенности

- 2.4.2 Результаты

- 2.5 (Пингвин)

- 2.5.1 Особенности

- 2.5.2 Результаты

- 2.6 Pirate (Пират)

- 2.

6.1 Особенности

6.1 Особенности - 2.6.2 Результаты

- 2.

- 2.7 HummingBird (Колибри)

- 2.7.1 Особенности

- 2.7.2 Результаты

- 2.8 (Голубь)

- 2.8.1 Особенности

- 2.8.2 Результаты

- 2.9 (Дружелюбный к мобильным устройствам)

- 2.9.1 Особенности

- 2.9.2 Результаты

- 2.1 Кофеин

- 3 Резюме

Все мы не понаслышке знаем о существующих алгоритмах поисковых систем Яндекс и Google. Именно для соблюдения их «постоянно обновляемых» правил все оптимизаторы ломают свой мозг все новыми и новыми способами попасть в ТОП выдачи поиска. Из последних новшеств, которые ощутили на себе владельцы сайтов со стороны ПС — это требования к мобильности интернет-ресурсов и понижение в поиске тех площадок, которые не умеют покупать ссылки. Какие алгоритмы до этого времени, внедренные в поиск, существенно повлияли на ранжирование сайтов? На самом деле, не все оптимизаторы знают, какие технологии, когда и зачем были созданы, чтобы максимально справедливо дать позицию каждому сайту в поиске и очистить выдачу от «хлама». Историю создания и развития поисковых алгоритмов мы и рассмотрим в этой статье.

Историю создания и развития поисковых алгоритмов мы и рассмотрим в этой статье.

Яндекс: виды алгоритмов с зачатия до сегодня

Алгоритмы не создавались все в один день, и каждый из них проходил много этапов доработки и преобразования. Основная масса названий алгоритмов Яндекса состоит из названий городов. Каждый из них имеет свои принципы работы, точки взаимодействия и уникальные функциональные особенности, гармонично дополняющие друг друга. Какие алгоритмы есть у Яндекса и как они влияют на сайты, рассмотрим далее.

Помимо информации о поисковых алгоритмах полезной будет и статья про новые фишки в Яндекс Директ. Советы по созданию качественного SEO-контента подходящего для поисковиков Гугл и Яндекс я предлагаю вам прочесть по этой ссылке.

Магадан

Алгоритм «Магадан» распознает аббревиатуры и отожествляет существительные с глаголами. Был впервые запущен в тестовом режиме в апреле 2008, а вторая постоянная версия вышла в свет в мае того же года.

Особенности

«Магадан» выдает пользователю, который написал аббревиатуру, сайты и с расшифровками. Например, если в поисковой строке вбили запрос МВД, то кроме площадок с таким ключевым словом в списке будут присутствовать и те, у кого аббревиатуры нет, но есть расшифровка «Министерство внутренних дел». Распознавание транслитерации дало пользователям возможность не думать на каком языке правильно писать названия, к примеру, Mercedes или Мерседес. Ко всему этому Яндекс включил в список индексирования почти миллиард зарубежных сайтов. Распознавание частей речи и признание их равноценными поисковыми запросами выпустили в один поиск сайты с разными ключевыми фразами. То есть теперь по ключевику «оптимизация сайтов» в выдаче выводятся и площадки с вхождением словосочетания «оптимизировать сайт».

Результаты

После запуска алгоритма «Магадан» стало труднее, в основном, малоавторитетным сайтам. В ранжировании понизились позиции по релевантным запросам малопосещаемые и молодые ресурсы, а на первые места выдвинулись авторитетные, даже с некачественным контентом, учитывая при этом морфологию и разбавленность ключевиков. Из-за учета транслитерации в ТОП Рунета вышли и зарубежные ресурсы. То есть оптимизированный текст по теме мог оказать на второй странице, только потому, что, якобы, по этой же тематике есть более посещаемый сайт или аналогичный зарубежный. Из-за этого резко возросла конкуренция по низкочастотным ключевикам и иностранным фразам. Подорожала и реклама — ставки возросли, потому что ранее сайты конкурировали только по одному конкретному запросу, а теперь и с «коллегами» с морфологическими фразами, транслитерацией, переходящими в другую часть речи словами.

Из-за учета транслитерации в ТОП Рунета вышли и зарубежные ресурсы. То есть оптимизированный текст по теме мог оказать на второй странице, только потому, что, якобы, по этой же тематике есть более посещаемый сайт или аналогичный зарубежный. Из-за этого резко возросла конкуренция по низкочастотным ключевикам и иностранным фразам. Подорожала и реклама — ставки возросли, потому что ранее сайты конкурировали только по одному конкретному запросу, а теперь и с «коллегами» с морфологическими фразами, транслитерацией, переходящими в другую часть речи словами.

Находка

Алгоритм «Находка » — расширенный тезаурус и внимательное отношение к стоп-словам. Выпущен «на ринг» сразу после «Магадана». Ранжирует основную выдачу с сентября 2008.

Особенности

Это инновационный подход к машинному обучению — ранжирование стало четче и корректней. Расширенный словарь связей и внимательность к стоп-словам в алгоритме «Находка» очень сильно повлияли на поисковую выдачу. К примеру, запрос «СЕО оптимизация» теперь ассоциировался и с ключем «сеооптимизация», а коммерческие сайты разбавлялись информационными порталами, в том числе в списке появились развернутые сниппеты с ответами, по особенному отображалась Википедия.

Результаты

Коммерческие сайты сделали больший акцент на продажные запросы, так как конкуренция увеличилась по информационным не конкретным фразам в несколько раз. В свою очередь, информационные площадки смогли расширить свою монетизацию с помощью страниц рекомендаций, участвуя в партнерских программах. Топовые инфосайты, продвинутые по коммерческим запросам стали продавать ссылки на заказ. Конкуренция ужесточилась.

Арзамас

Алгоритм «Арзамас» — внедрена лексическая статистика поисковых запросов и создана географическая привязка сайта. Первая версия «Арзамаса» (апрель 2009) без геозависимости выпущена сразу в основную выдачу, а «Арзамас 2» с классификатором по привязке сайта к региону анонсирован в августе 2009.

Особенности

Снятие привязки к омонимам облегчила пользователю жизнь, ведь теперь по фразе «американский пирог» выдавались только сайты на тему фильмов, без всяких там рецептов десертов, как могло быть раньше. Привязка к региону совершила прорыв, сместив ключевые фразы с добавкой города на несколько пунктов вниз. Теперь пользователь мог просто ввести слово «рестораны» и увидеть в лидерах только сайты из города его местонахождения. Если помните, раньше нужно было бы ввести более конкретную фразу, например «Рестораны в Санкт-Петербурге», иначе Яндекс мог выдать ответ «уточните запрос — найдено слишком много вариантов». Геонезависимые ключевые слова выдавали только релевантные запросу сайты из любых регионов, без привязки.

Теперь пользователь мог просто ввести слово «рестораны» и увидеть в лидерах только сайты из города его местонахождения. Если помните, раньше нужно было бы ввести более конкретную фразу, например «Рестораны в Санкт-Петербурге», иначе Яндекс мог выдать ответ «уточните запрос — найдено слишком много вариантов». Геонезависимые ключевые слова выдавали только релевантные запросу сайты из любых регионов, без привязки.

Результаты

Ура! Наконец-то сайты из небольших регионов перестали конкурировать с крупными мегаполисами. Выйти в ТОП по своему региону теперь намного проще. Именно в этот период времени была предложена услуга «региональное продвижение». Алгоритм «Армазас» дал возможность мелким компаниям быстрее развиваться в своей местности, но подвох все равно остался. Яндекс не мог определить геолокацию у всех площадок. И как вы сами понимаете — без привязки ресурсы оставались, мягко говоря, в одном не очень приятном месте. Рассмотрение заявки на геозависимость могло длиться несколько месяцев, а молодые сайты без трафика и ссылочной массы (было ограничение по ТИЦ), вообще, не могли подать запрос на присвоение им региональности. Палка о двух концах.

Палка о двух концах.

Снежинск

Алгоритм «Снежинск» — усиление геозависимости и уточнение релевантности запросов к выдаче с помощью технологии машинного обучения «Матрикснет». Анонс состоялся в ноябре 2009, а улучшенная модель под именем «Конаково» заработала в декабре того же года.

Особенности

Поисковая выдача стала более точной к вводимым вопросам. Особую роль теперь играет привязка по геолокации — коммерческие сайты не ассоциировались у алгоритма «Снежинск» с регионами, поэтому выпадали из выдачи. Ключевые слова, не привязанные к местности, отожествляются с информационными ресурсами. Сложная архитектура подсчета релевантности сильно усложнила жизнь оптимизаторов, которые заметили, что при малейшем изменении одного из показателей, позиция сайта в выдаче моментально изменялась.

Результаты

На тот момент было отмечено, что закупка внешних ссылок на молодые сайты влияла на показатели новых ресурсов слишком вяло, если сравнить аналогичную закупку на площадку, давненько находящуюся на интернет-рынке. Новые методы определения релевантности контента к поисковым запросам выбрасывали из выдачи сайты, тексты которых были перенасыщены ключевыми фразами. Началась новая эра качественного текста, где во всем должна была быть мера, без нее площадка могла просто попасть под санкции за спам. Коммерческие ресурсы забили панику, потому что выйти по геонезависимым ключевым словам в ТОП (а они были самые высокочастотные) было практически нереально. В связи с этим на блоге Яндекса была опубликована запись, что в идеале хотелось бы видеть на первых страницах коммерческие организации, которые не пишут красиво, а выполняют свою работу хорошо, но для этого придется научить алгоритмы оценивать качество предлагаемых услуг. Так как на данный момент это оказалось непосильной задачей, репутация коммерческих интернет-ресурсов играла ключевую роль в выдаче, как в онлайне так и в оффлайне.

Новые методы определения релевантности контента к поисковым запросам выбрасывали из выдачи сайты, тексты которых были перенасыщены ключевыми фразами. Началась новая эра качественного текста, где во всем должна была быть мера, без нее площадка могла просто попасть под санкции за спам. Коммерческие ресурсы забили панику, потому что выйти по геонезависимым ключевым словам в ТОП (а они были самые высокочастотные) было практически нереально. В связи с этим на блоге Яндекса была опубликована запись, что в идеале хотелось бы видеть на первых страницах коммерческие организации, которые не пишут красиво, а выполняют свою работу хорошо, но для этого придется научить алгоритмы оценивать качество предлагаемых услуг. Так как на данный момент это оказалось непосильной задачей, репутация коммерческих интернет-ресурсов играла ключевую роль в выдаче, как в онлайне так и в оффлайне.

Обнинск

Алгоритм «Обнинск» — улучшение ранжирования и расширения базы географической принадлежности интернет-площадок и снижение влияния на показатели сайта искусственных СЕО-ссылок. Запущен в сентябре 2010.

Запущен в сентябре 2010.

Особенности

Падает популярность закупки ссылочных масс, появляется понятие «ссылочного взрыва», которого теперь боялись все. Конкуренты могли навредить друг другу возможностью введения алгоритма в заблуждение, закупив на «коллегу» огромное количество ссылок с «плохих источников». После этого конкурент выпадал из поисковой выдачи и долго не мог туда попасть. Геозависимые слова чаще добавляются на разные страницы коммерческих сайтов, чтобы обратить внимание робота на работу с этим регионом.

Результаты

Коммерческие сайты теперь тщательней относятся к своей репутации, что не может не радовать, но многие все равно прибегали к грязным методам (искусственно завышали посещаемость и покупали отзывы). После выпуска алгоритма «Обнинск» более популярной стала закупка вечных ссылок и статей, обычная покупка ссылок уже так не влияла на ранжирование, как раньше, а в случае попадания источника бэклинка под санкции могла потянуть за собой цепную реакцию. Качественные СЕО-тексты — обязательный атрибут любого ресурса. Молодой сайт с уникальным и правильно оптимизированным контентом мог попасть в ТОП.

Качественные СЕО-тексты — обязательный атрибут любого ресурса. Молодой сайт с уникальным и правильно оптимизированным контентом мог попасть в ТОП.

Краснодар

Алгоритм «Краснодар» — внедрение технологии «Спектр» для разбавления поисковой выдачи, расширения сниппетов и индексация социальных сетей. Запуск состоялся в декабре 2010 года.

Особенности

Технология «Спектр» была создана для классификации запросов по категориям и использовалась в случаях ввода не конкретизированных ключевых фраз. «Краснодар» разбавлял поисковую выдачу, предлагая такому пользователю больше разнообразных вариантов. Например, при фразе «фото Москвы» в поиске можно было увидеть не только общие пейзажи, но и фотографии по категориям типа «достопримечательности», «карты», «рестораны». Был сделан акцент на уникальные названия чего-либо (сайтов, моделей, товаров) — конкретика стала выделяться. Расширенные сниппеты дали возможность сразу в поисковой выдаче показывать пользователям контакты и другие данные организаций.

Результаты

Сильно изменилось ранжирование коммерческих сайтов, особое внимание уделяется деталям (карточкам товаров, разделением короткого описания от общего). Социальная сеть в ВК начала индексироваться и профили участников равноценно теперь видны прямо в поисковой выдаче. Сообщения в форумах могли занимать первые позиции, если имели более расширенный ответ на вопрос пользователя, чем другие сайты.

Рейкьявик

Алгоритм «Рейкьявик» — создана персонализация поисковой выдачи и добавлена технологи «Колдунщики» для отображения предварительных итогов запроса. Улучшена формула подсказок при вводе. Алгоритм запущен в августе 2011 года.

Особенности

Девизом персонализированного поискового результата — «Каждому пользователю — своя выдача». Система запоминания интересов ищущих работала через куки, поэтому если запросы пользователя чаще были связаны, например, с зарубежными ресурсами, в следующий раз в лидерах поисковой выдачи отображались именно они. Подсказки в поисковой строке обновляются каждый час, тем самым расширяя возможности конкретизированного поиска. Конкуренция по высокочастотным запросам возрастает с неимоверной силой.

Конкуренция по высокочастотным запросам возрастает с неимоверной силой.

Результаты

Авторитетные новостные сайты чаще попадают в ТОП из-за расширенного семантического ядра (наличие огромного количества разных низкочастотных ключевых запросов). Увеличение количества страниц под конкретные поисковые запросы на информационных сайтах стала играть одну из главных ролей после выпуска алгоритма «Рейкьвик». Каждая площадка пыталась попасть в закладки пользователя, чтобы стать частью системы персонализации, для этого использовались методы подписки на RSS ленту, всплывающие баннеры-подсказки для занесения сайта в закладки. Интернет-ресурсы начали больше уделять внимания индивидуальному подходу, а не давить на массы.

Калининград

Алгоритм «Калининград» — глобальная персонализация поиска и поисковой строки, упор на поведенческие факторы. Запуск «Калининграда» в декабре 2012 существенно повысил стоимость seo услуг.

Особенности

Интересы пользователя перевернули с ног на голову всю поисковую выдачу — владельцы сайтов, ранее не заботившиеся о комфорте пребывания посетителя на сайте, стали терять трафик с молниеносной скоростью. Теперь Яндекс делил интересы на краткосрочные и долговременные, обновляя свои шпионские базы раз в сутки. Это означало, что сегодня и завтра по одному и тому же запросу одному и тому же пользователю могла показываться совершенно иная выдача. Интересы теперь играют особую роль и пользователю, который ранее интересовался поездками, вбивая фразу такси — показываются услуги такси, а тому, кто постоянно смотрит фильмы — получит в результатах поиска все о кинокомедии «Такси». В поисковой строке каждого «страждущего найти информацию» теперь на первых позициях отображаются подсказки по предыдущим интересам.

Теперь Яндекс делил интересы на краткосрочные и долговременные, обновляя свои шпионские базы раз в сутки. Это означало, что сегодня и завтра по одному и тому же запросу одному и тому же пользователю могла показываться совершенно иная выдача. Интересы теперь играют особую роль и пользователю, который ранее интересовался поездками, вбивая фразу такси — показываются услуги такси, а тому, кто постоянно смотрит фильмы — получит в результатах поиска все о кинокомедии «Такси». В поисковой строке каждого «страждущего найти информацию» теперь на первых позициях отображаются подсказки по предыдущим интересам.

Результаты

Оптимизаторы стали охватывать все больше способов задержать пользователя: улучшалось юзабилити, дизайн, контент создается более разнообразный и качественный. При выходе могли всплывать окна типа «вы уверены, что хотите покинуть страницу» и в пользователя впивалась грустная рожица какого-то существа. Хорошо продуманная перелинковка страниц и всегда доступное меню улучшали показатели активности пользователей, чем повышали позиции сайтов в поисковой выдаче. Малопонятные широкому кругу интернет-пользователей сайты сначала просто понижались в позициях, а после и вообще болтались в конце списка предложенных результатов.

Малопонятные широкому кругу интернет-пользователей сайты сначала просто понижались в позициях, а после и вообще болтались в конце списка предложенных результатов.

Дублин

Алгоритм «Дублин» — улучшена персонализация с помощью определения текущих целей. Это модернизированная версия «Калининграда» вышла в мир в мае 2013.

Особенности

В технологию внедрена функция слежения за изменчивыми интересами пользователей. То есть при наличии двух совершенно разных поисковых взглядов за определенный период времени, алгоритм предпочтет последний и включит его в поисковую выдачу.

Результаты

Для сайтов практически ничего не изменилось. Продолжается борьба не просто за трафик, а за улучшение поведенческих показателей. Старые макеты сайтов начинают забрасываться, потому что проще делать новый, чем пытаться исправить что-то на старом. Предложение услуг шаблонов сайтов увеличивается, начинается конкуренция за удобные и красивые макеты вебресурсов.

Острова

Алгоритм «Острова» — внедрена технология показа интерактивных блоков в поисковой выдаче, позволяя взаимодействовать пользователю с сайтом прямо на странице Яндекс поиска. Алгоритм был запущен в июле 2013 года, с предложением к вебмастерам активно поддержать бета-версию и использовать шаблоны создания интерактивных «островов». Сейчас технология тестируется в закрытом режиме.

Алгоритм был запущен в июле 2013 года, с предложением к вебмастерам активно поддержать бета-версию и использовать шаблоны создания интерактивных «островов». Сейчас технология тестируется в закрытом режиме.

Особенности

Теперь пользователю при поиске информации, которую можно узнать сразу из поиска предлагались «острова» — формы и другие элементы, с которыми можно работать, не посещая сайт. Например, вы ищете конкретный фильм или ресторан. По фильму в поиске и справа от него отобразятся блоки с обложкой фильма, его названием, составом актеров, часами прохождения сеансов в кинотеатрах в вашем городе и формой покупки билетов. По ресторану будет показано его фото, адрес, телефоны, форма бронирования столика.

Результаты

Ничего существенного в ранжировании сайтов сначала не изменилось. Единственное, что стало заметным — это появление вебресурсов с интерактивными блоками на первом месте и справа от поисковой выдачи. Если бы количество площадок, принимавших участие в бета-тестировании было значительным, они могли бы вытеснить обычные сайты за счет своей привлекательности и броскости для пользователей. Оптимизаторы задумались об улучшении видимости своего контента в поисковых результатах, добавляя больше фото, видео, рейтинги и отзывы. Лучше живется интернет-магазинам — корректно настроенные карточки товара могут быть отличным интерактивным «островком».

Оптимизаторы задумались об улучшении видимости своего контента в поисковых результатах, добавляя больше фото, видео, рейтинги и отзывы. Лучше живется интернет-магазинам — корректно настроенные карточки товара могут быть отличным интерактивным «островком».

Минусинск

Алгоритм «Минусинск» — при определении SEO-ссылок как таковых, которые были куплены для искажения результатов ранжирования поиска, на сайт ложился фильтр, который существенно портил позиции сайта. Анонсирован «Минусинск» в апреле 2015, полностью вступил в свои права в мае этого же года. Именно с этим алгоритмом и связана знаменитая Санта Барбара Яндекс.

Особенности

Перед выходом «Минусинска» Яндекс в 2014 для тестирования отключил влияние SEO-ссылок по множеству коммерческих ключей в Москве и проанализировал результаты. Итог оказался предсказуемым — покупная ссылочная масса все еще используется, а для поисковой системы — это спам. Выпуск «Минусинска» знаменовался днем, когда владельцы сайтов должны были почистить свои ссылочные профили, а бюджет, который тратится на ссылочное продвижение, использовать для улучшения качества своего интернет-ресурса.

Результаты

«Авторитетные» сайты, которые добились ТОПа благодаря массовой закупке ссылок, вылетели из первых страниц, а некоторые получили санкции за нарушения правил. Качественные и молодые площадки, не наглеющие по бэклинкам, внезапно оказались в ТОП 10. «Попавшие под раздачу» вебсайты, нежелающие долго ждать, создавали новые площадки, перенося контент и ставя заглушку на старые, либо хитро шаманили с редиректом. Примерно через 3 месяца нашли дыру в алгоритме, позволяющую почти моментально снимать данный фильтр.

Массово начинает дорабатываться юзабилити и улучшаться контент. Ссылки закупаются с еще большей осторожностью, а контроль за бэклинками становится одной из функциональных обязанностей оптимизатора.

По данным на сегодня — при неумелой закупке ссылок — даже за 100 ссылок можно получить фильтр. Но если ссылочную массу правильно разбавлять, то смело можно покупать тысячи ссылок как и в старые добрые. То-есть, по сути — сильно выросли ссылочные бюджеты на это самое разбавление, в роли которого выступил крауд и упоминания.

Владивосток

Алгоритм «Владивосток» — внедрение в поиск технологии проверки сайта на полную совместимость с мобильными устройствами. Полный старт проекта произошел в феврале 2016 года.

Особенности

Яндекс сделал очередной шаг навстречу к мобильным пользователям. Специально для них был разработан алгоритм «Владивосток». Теперь для лучшего ранжирования в мобильном поиске сайт обязан соответствовать требованиям мобилопригодности. Чтобы опередить своих конкурентов в поисковой выдаче интернет-ресурс должен корректно отображаться на любом web-устройстве, включая планшеты и смартфоны. «Владивосток» проверяет отсутствие java и flash плагинов, адаптивность контента к расширению экрана (вместимость текста по ширине дисплея), удобство чтения текста и возможность комфортно нажимать на ссылки и кнопки.

Результаты

К запуску алгоритма «Владивосток» мобилопригодными оказались всего 18% сайтов — остальным пришлось быстренько избавляться от «тяжести» на страницах, которая не отображается или мешает корректно отображаться контенту на смартфонах и планшетах. Основным фактором, который влияет на понижение вебсайта в мобильной выдаче — это поведение мобильного пользователя. Во всяком случае, пока. Ведь идеально мобилопригодных сайтов не так уж много, поэтому свободные места в поиске занимают те, кто способен предоставить пользователю максимально комфортные условия, пусть даже не полностью. Из мобильного поиска неадаптированные к мобильным устройствам сайты не выбрасываются, а просто ранжируются ниже тех, кто достиг в улучшении качества предоставления услуг для смартпользователей лучших результатов. На данный момент самый популярный вид заказов макетов сайтов — адаптивные, а не мобильные, как можно было подумать. Прошедшие все требования алгоритма сайты получают максимальное количество мобильного трафика в своей нише.

Основным фактором, который влияет на понижение вебсайта в мобильной выдаче — это поведение мобильного пользователя. Во всяком случае, пока. Ведь идеально мобилопригодных сайтов не так уж много, поэтому свободные места в поиске занимают те, кто способен предоставить пользователю максимально комфортные условия, пусть даже не полностью. Из мобильного поиска неадаптированные к мобильным устройствам сайты не выбрасываются, а просто ранжируются ниже тех, кто достиг в улучшении качества предоставления услуг для смартпользователей лучших результатов. На данный момент самый популярный вид заказов макетов сайтов — адаптивные, а не мобильные, как можно было подумать. Прошедшие все требования алгоритма сайты получают максимальное количество мобильного трафика в своей нише.

Google: история создания и развития алгоритмов