Создаем правильный robots.txt для сайта на WordPress

Здравствуйте, в сегодняшней статье мы продолжим тему базовых настроек. В данной статье мы с вами затронем тему настройки файла robots.txt.

Давайте для начала проанализируем, зачем нам нужен этот файл и нужен ли он нам вообще.

Robots.txt – это текстовый файл предназначенный специально для роботов поисковых систем, с помощью которого можно контролировать все процессы индексации на сайте. Если говорить еще проще с помощью этого файла мы можем закрыть от индексации любой раздел нашего сайта, включая ссылки и системные файлы WordPress.

Зачем что-то закрывать с помощью robots.txt, разве WordPress сам не создает все, что ему нужно при установке? Ответ – нет. Вы, как вебместер или блогер, должны сами контролировать все процессы на сайте. В первую очередь в robots.txt скрываются от индексации системные папки, такие как wp-admin, wp-login и прочие. Также, один и тот же материал сайта построенного на WordPress может размещаться под разными урлами (ссылками), что в свою очередь влечет за собой создание дублей. За наличие большого количества дублей поисковые системы могут наложить санкции на ваш проект, а выйти из под них не так уж и легко. Так что старайтесь исправить эту ситуацию еще в самом начале создания сайта.

Так какой же он правильный robots.txt для WordPress?

Если вы только начинаете свой путь вебмастера, то вам наверняка неизвестны понятия директив: dissalow, allow и других. Сейчас мы с вами пройдемся по основных директивах для того чтобы вы осознанно создавали собственный robots.txt и не писали туда ничего лишнего.

«User—agent:»

Итак, обычно файл robots.txt начинается с того что задается директива – «User-agent:». Эта директива указывает на имя поискового робота. Так, как вам известно, каждая поисковая система имеет своего робота, а в большинстве случаев их несколько.

Для того чтобы задать директивы для Яндекса, стоит писать:

User-agent: YandexДля Google она будет иметь следующий вид:

User-agent: GooglebotВ интернете вы можете найти названия роботов и других поисковых систем, если они вдруг вам понадобятся, а так обычно мимо приведенных выше директив, указывается директива:

User-agent: *В которой * — означает любой текст. То есть, таким образом, мы указываем настройки для всех остальных поисковых роботов. Зачастую этого вполне достаточно.

«Disallow:»

Это директива, которая запрещает поисковому роботу индексировать какую либо часть вашего сайта.

Давайте, для того чтобы было бы более понятно рассмотрим несколько примеров ее применения.

Для того чтобы закрыть какую либо папку в дистрибутиве WordPress от индексирования достаточно прописать:

Disallow: /имя вашей папкиДля вложенных папок ситуация таже:

Disallow: /имя вашей папки/имя вложенной папкиИдем дальше, закрывать от индексации можно и по определенным символам, например «?».

Disallow: /*?*Таким способом закрываются все ссылки, где встречается «?». В WordPress такие ссылки формируются по умолчанию.

?post=1Суть, я думаю, понятна. Таким способом можно закрыть комментарии, ленты новостей и прочие разделы сайта.

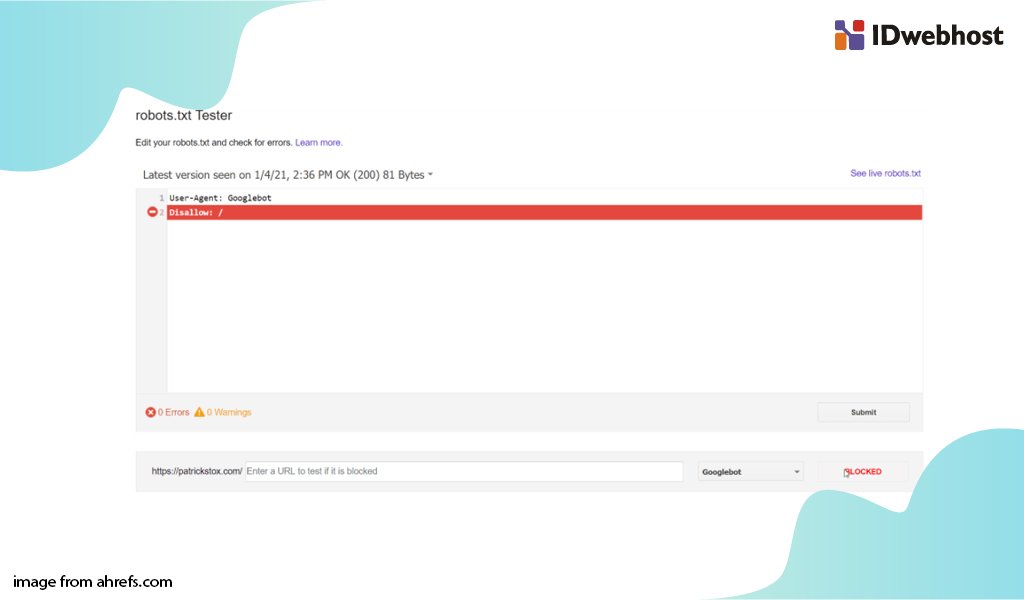

Будьте внимательны! Если прописать:

Disallow: /То это полностью закроет ваш сайт от индексации.

«Allow:»

Эта директива имеет суть совершенно противоположную приведенной выше. Как вы поняли, с помощью нее, вы можете разрешить к индексированию какой либо раздел сайта, например:

Как вы поняли, с помощью нее, вы можете разрешить к индексированию какой либо раздел сайта, например:

Allow: / имя вашей папки«Host:»

Директива хост задается для указания основного зеркала вашего сайта, то есть с www или без, например.

Host: www.вашсайт.comЗачастую она задается для Яндекса.

И последняя директива, которую мы рассмотрим — «Sitemap:».

Она указывает для поискового робота путь к карте сайта в формате .xml. Пример использования:

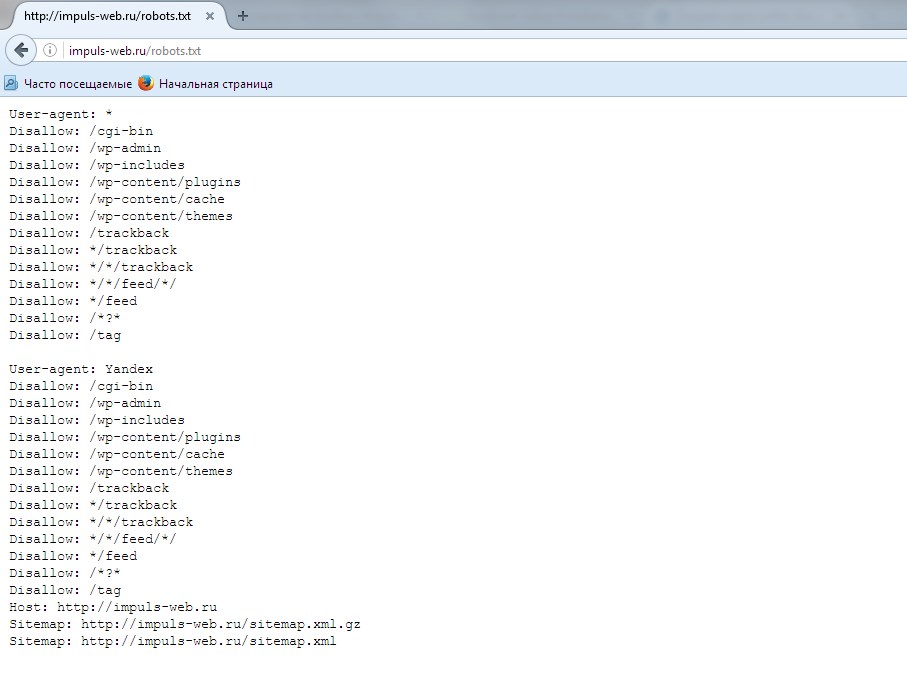

Sitemap: http://вашсайт.com/sitemap.xmlИтак, я приведу вам пример файла robots.txt для WordPress, которым пользуюсь я сам. Но под различные проекты я все же его немного изменяю.

User-agent:* Allow: */uploads Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /webstat/ Disallow: /feed/ Disallow: /page/ Disallow: /trackback Disallow: */trackback Disallow: */feed Disallow: */comments Disallow: /*?* Disallow: /*? Disallow: /category/*/* Disallow: /wp-content/ Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /comments User-agent: Yandex Allow: */uploads Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /webstat/ Disallow: /feed/ Disallow: /page/ Disallow: /trackback Disallow: */trackback Disallow: */feed Disallow: */comments Disallow: /*?* Disallow: /*? Disallow: /category/*/* Disallow: /wp-content/ Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /comments Host: вашсайт.com Sitemap: http://вашсайт.com/sitemap.xml

Для справки. Файл robots.txt лежит в открытом доступе на любом сайте. Заходите и проверяйте его на популярных блогах, делайте свои выводы, но смотрите не переборщите!

До следующих уроков.

Файл robots.txt для WordPress. Создание и правильная индексация

В интернете можно найти много статей какой robots.txt для WordPress лучше использовать, но безусловно администратор сайта должен самостоятельно определить, что необходимо отдавать ботам для индексации, а что запрещать.

Я как и многие другие потратив приличное количество времени на поиск оптимального шаблона robots.txt уяснил только одно, что конкретного варианта нет. Вы можете экспериментировать, никто вам этого не запрещает.

Создаем robots.txt для WordPress

Ниже представлен код одного из моих проектов про технологии и гаджеты, посещаемость ресурса более 7500 уникальных посетителей в сутки.

User-agent: * #Для всех ботов, кроме Яндекса и Google Allow: /wp-content/plugins/*.js #Разрешаем js-скрипты в папке плагинов Allow: /wp-content/plugins/*.css #Разрешаем css файлы в папке плагинов Allow: /wp-content/plugins/*.jpg #Разрешаем картинки в папке плагинов Allow: /wp-content/plugins/*.jpeg #Разрешаем картинки в папке плагинов Allow: /wp-content/plugins/*.png #Разрешаем картинки в папке плагинов Allow: /wp-includes/*.js #Разрешаем js-скриты в главной папке WordPress Allow: /wp-includes/*.css #Разрешаем css в главной папке WordPress Allow: /wp-content/themes/*.js #Разрешаем js-скриты в теме Allow: /wp-content/themes/*.css #Разрешаем css файлы в теме Allow: /wp-content/uploads/*.jpg #Разрешаем индексировать загруженные картинки Allow: /wp-content/uploads/*.jpeg #Разрешаем индексировать загруженные картинки Allow: /wp-content/uploads/*.gif #Разрешаем индексировать загруженные картинки Allow: /wp-content/uploads/*.png #Разрешаем индексировать загруженные картинки Disallow: /xmlrpc.php #Запрещаем файл интеграции WordPress API Disallow: /cgi-bin #Запрещаем папку со скриптами Disallow: /wp-admin #Запрещаем файлы в административной части WordPress Disallow: /wp-includes #Запрещаем файлы в ядре WordPress Disallow: /wp-content/plugins #Запрещаем файлы плагинов Disallow: /wp-content/cache #Запрещаем кеш, отдаем только актуальные файлы Disallow: /wp-content/themes #Запрещаем файлы тем Disallow: /trackback #Запрещаем уведомления о ссылках Disallow: */feed #Запрещаем фиды Disallow: */comment #Запрещаем комментарии Disallow: *comments #Запрещаем комментарии Disallow: */attachment #Запрещаем вложения Disallow: /author/* #Запрещаем страницы авторов и пользователей Disallow: /page/ #Запрещаем индексировать страницы пагинации Disallow: *page #Запрещаем индексировать страницы пагинации Disallow: /*? #Запрещаем индексировать страницы поиска User-agent: GoogleBot #Только для Google Allow: /wp-content/plugins/*.js Allow: /wp-content/plugins/*.css Allow: /wp-content/plugins/*.jpg Allow: /wp-content/plugins/*.jpeg Allow: /wp-content/plugins/*.png Allow: /wp-includes/*.js Allow: /wp-includes/*.css Allow: /wp-content/themes/*.js Allow: /wp-content/themes/*.css Allow: /wp-content/uploads/*.jpg Allow: /wp-content/uploads/*.jpeg Allow: /wp-content/uploads/*.gif Allow: /wp-content/uploads/*.png Disallow: /xmlrpc.php Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */feed Disallow: */comment Disallow: *comments Disallow: */attachment Disallow: /author/* Disallow: /page/ Disallow: *page Disallow: /*? User-agent: Yandex #Только для Яндекса Allow: /wp-content/plugins/*.js Allow: /wp-content/plugins/*.css Allow: /wp-content/plugins/*.jpg Allow: /wp-content/plugins/*.jpeg Allow: /wp-content/plugins/*.png Allow: /wp-includes/*.js Allow: /wp-includes/*.css Allow: /wp-content/themes/*.js Allow: /wp-content/themes/*.css Allow: /wp-content/uploads/*.jpg Allow: /wp-content/uploads/*.jpeg Allow: /wp-content/uploads/*.gif Allow: /wp-content/uploads/*.png Allow: /feed/dzen/ #Разрешаю Яндекс Дзен (моя ссылка) Allow: /feed/turbo/ #Разрешаю Янжекс Турбо (моя ссылка) Disallow: /xmlrpc.php Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */feed Disallow: */comment Disallow: *comments Disallow: */attachment Disallow: /author/* Disallow: /page/ Disallow: *page Disallow: /*? Host: https://woohelp. ru #Ссылка на сайт Sitemap: https://woohelp.ru/sitemap.xml #Карта сайта Sitemap: https://woohelp.ru/sitemap.xml.gz #Сжатая карта сайта

Правильный Robots.txt для WordPress. Подведём итоги

Сегодня файл robots.txt не влияет на индексацию вашего сайта. Я видел у конкурентных мне сайтов (по категории технологии) совершенно открытый robots.txt ко всем ресурсам и многие из них находятся в топе по ключевым запросам.

Благодаря правильному файлу robots.txt вы можете уменьшить количество мусора в поисковике. Представьте если бы индексировали комментарии на форуме или в статье, то был бы прямо говоря бардак.

Правильный robots.txt для wordpress | Клуб WordPress

Правильный robots.txt для wordpress указывает поисковым роботам на правила индексации вашего блога, т.е. что индексировать, а на что закрывать «глаза».Ведь именно этот файл проверяют в первую очередь поисковые машины, заходя на ваш сайт.О том что такое robots.txt в сети можно найти очень много информации, в т.ч. как этот файл правильно прописать, но все эти статьи либо некорректные либо скопированные друг у друга.

На досуге наткнулся я на пост «Дублированный контент и параметр replytocom», перепроверил файл robots.txt, оказалось, что он требует корректировки.

В свою очередь, спешу поделиться с Вами, дорогие читатели, с правильным robots.txt для wordpress от Студии-ГОСТ.

Где находится файл robots.txt?

Файл размещается в корневой директории сайта. На примере нашего клуба:

http://clubwp.ru/robots.txt

Настройки robots.txt

1. User-Agent

Это имя поискового робота, к которому применяются нижеследующие правила вплоть до конца абзаца(не допускается пустое значение)

2. Allow и Disallow

Разрешает и, соответственно, запрещает индексацию указанных разделов блога. Allow воспринимают только Гугл и Яндекс, остальные поисковики его не видят.

Сначала нужно использовать директиву Allow, а только после нее Disallow. Также между ними не ставятся пустые строки – иначе так робот поймет, что инструкция закончилась. После директивы User-Agent также не допускаются пустые строки.

Также между ними не ставятся пустые строки – иначе так робот поймет, что инструкция закончилась. После директивы User-Agent также не допускаются пустые строки.

3. Host

Указывает какое зеркало сайта считать главным для избежания попадания под фильтр. Сайт доступен по нескольким адресам минимум с www и без www, и для избежания полного дублирования страниц.

4. Sitemap

Указывает роботу наличие и адрес карты сайта в формате XML

Правильный robots.txt для wordpress

User-agent: *

Allow: */uploads

Disallow: /cgi-bin

Disallow: /wp-

Disallow: */feed

Disallow: /search

Disallow: /xmlrpc.php

Disallow: /tag

Disallow: /category

Disallow: /archive

Disallow: */trackback

Disallow: /*?*

Host: clubwp.ru

Sitemap: http://clubwp.ru/sitemap.xmlПроверка robots.txt в инструментах Яндекс и Google

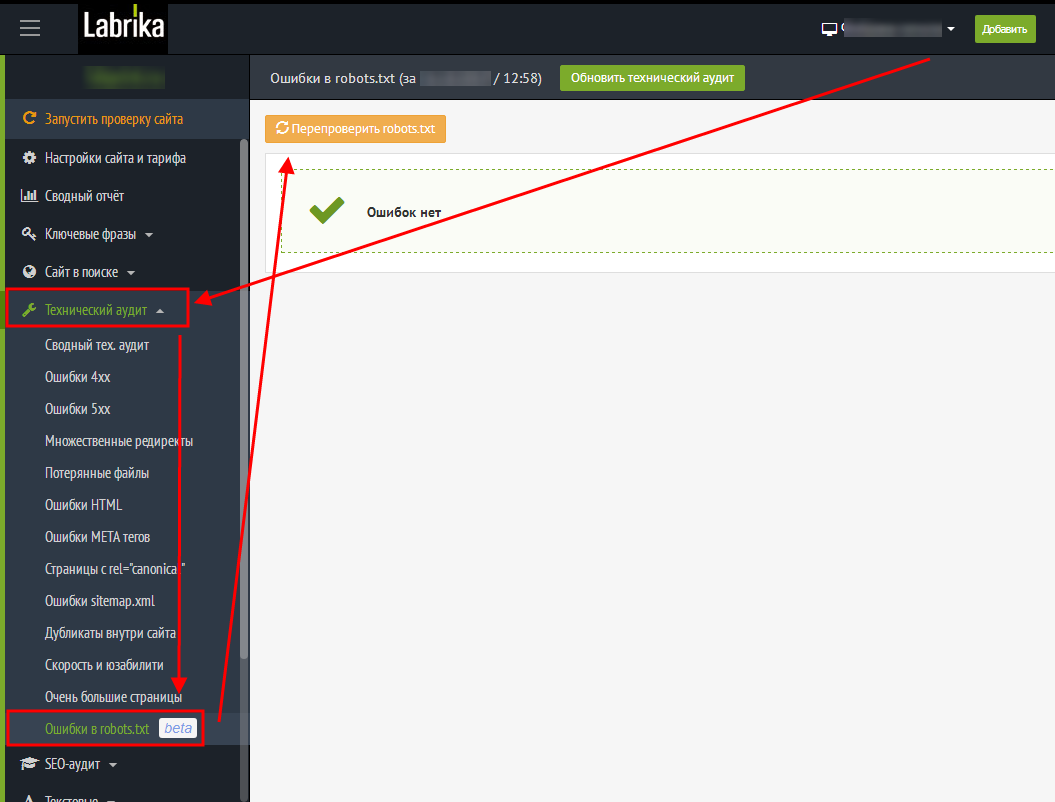

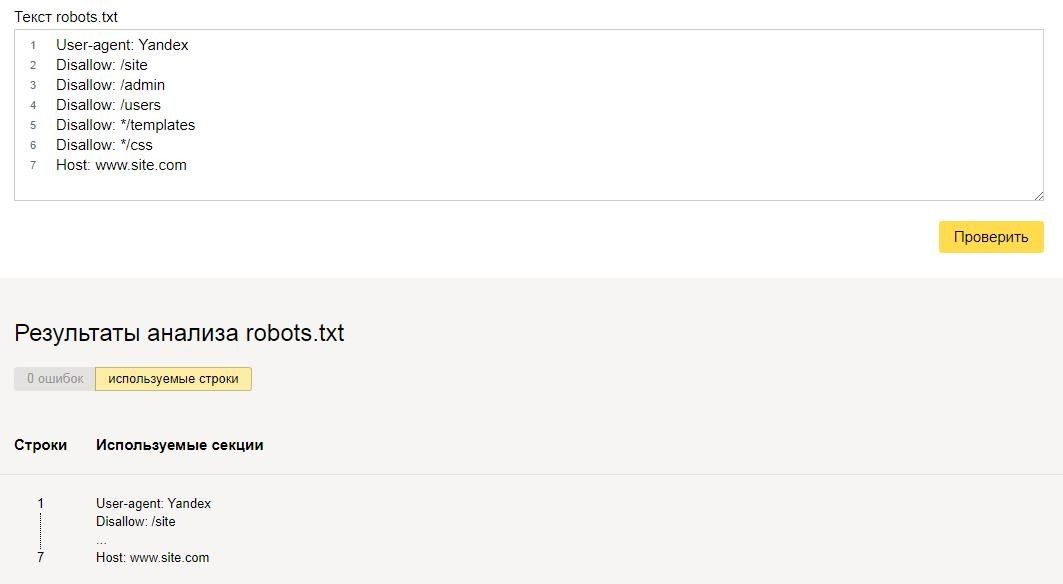

Работоспособность своего файла robots.txt вы всегда можете проверить в вебмастерских разделах поисковиков. При редактировании своего файла я всегда проверяю его на корректность.

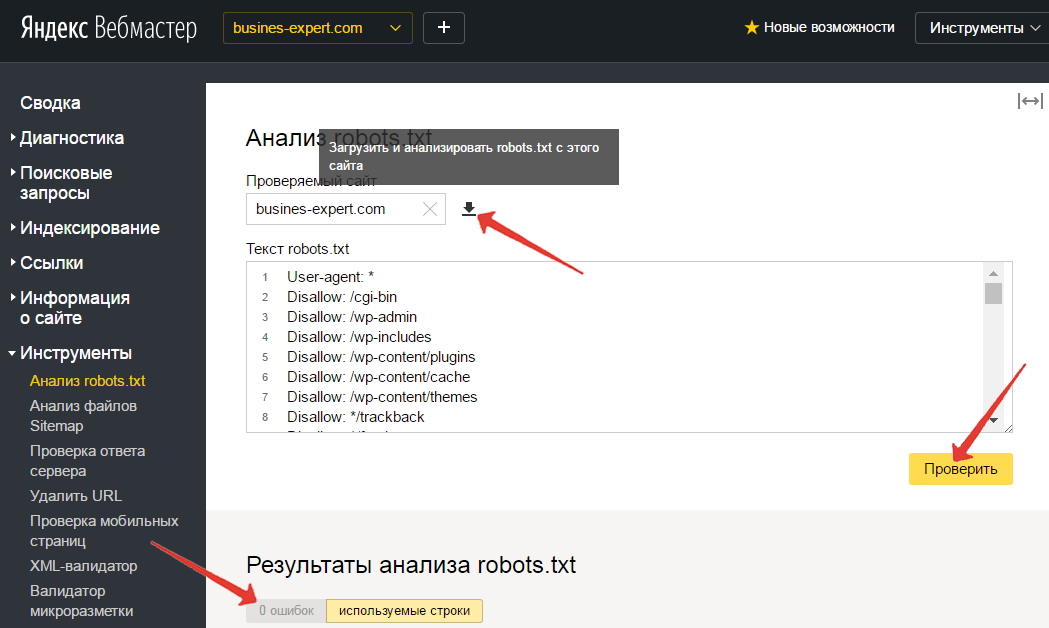

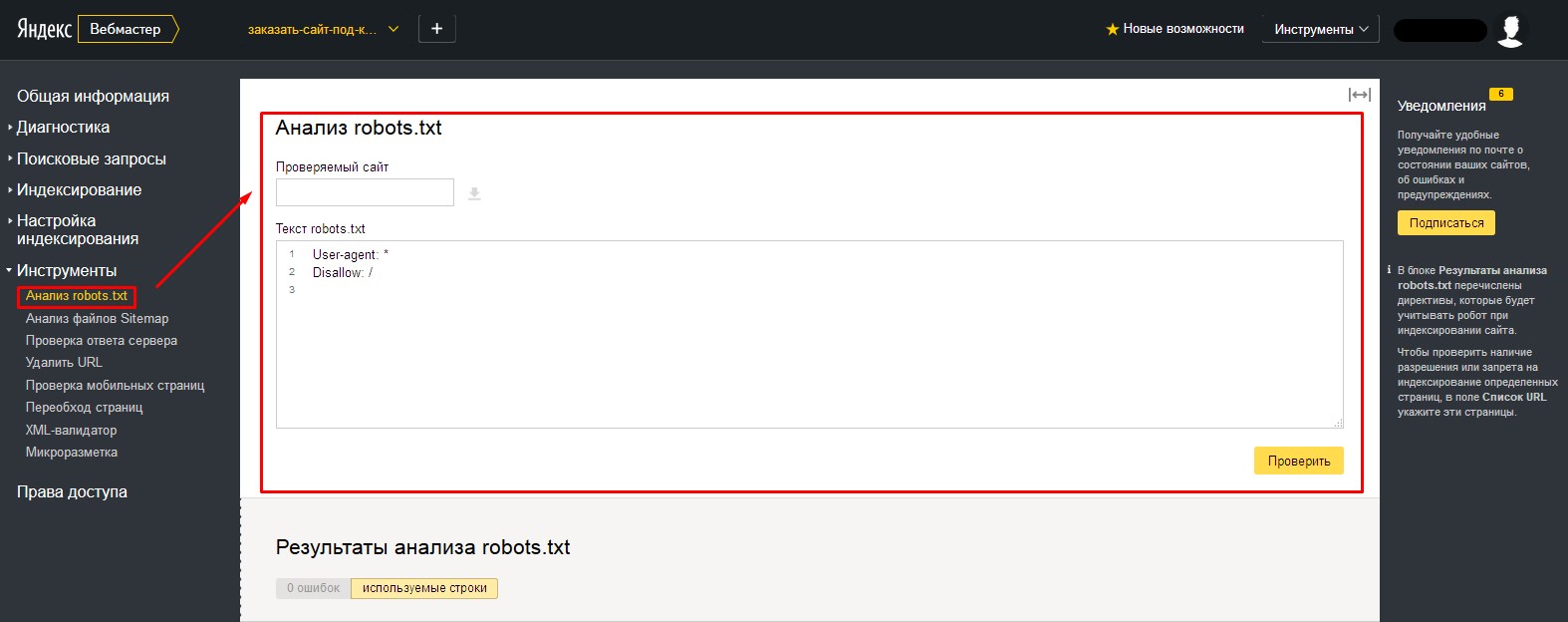

I. Вебмастер яндекс

У Яндекса (Для просмотра ссылки Войди илиЗарегистрируйся) раздел находится в «Инструменты->Анализ Robots.txt».

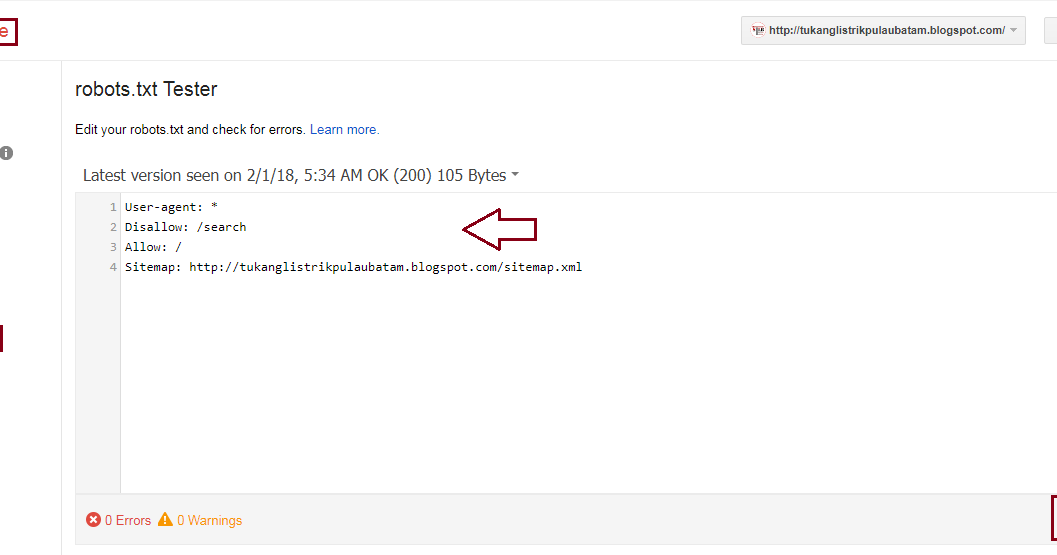

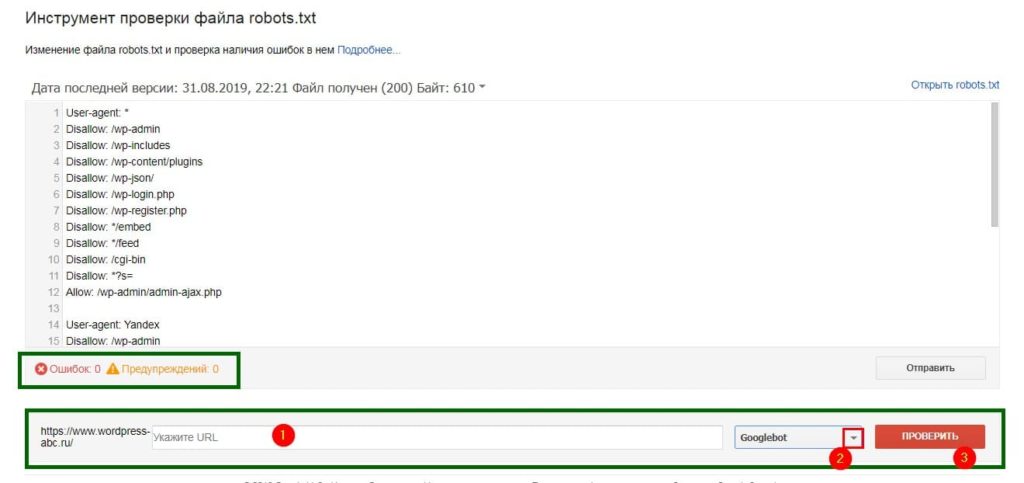

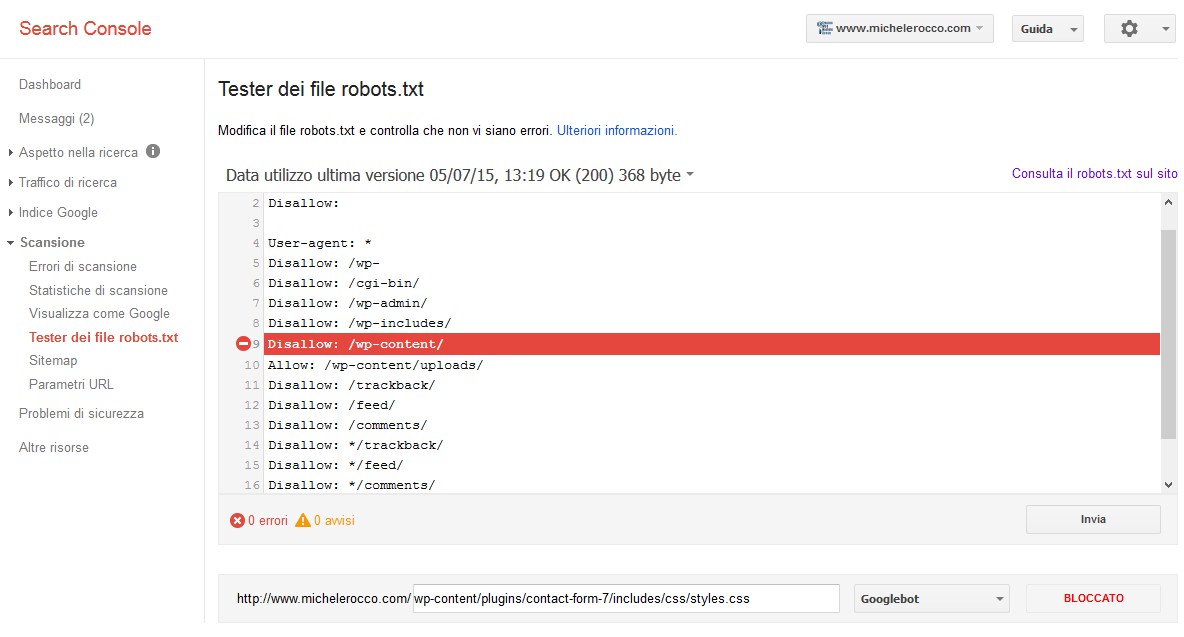

II. Вебмастер google

У Google (Для просмотра ссылки Войди илиЗарегистрируйся) раздел «Сканирование->Инструмент проверки файла robots.txt».

Напоследок хочу напомнить, что изменения в robots.txt на уже рабочем блоге будут заметны только спустя 1-3 месяца.

PS Если кто еще знает как можно улучшить Robots.txt пишите в комментариях.

Зачем вам нужен robots.

txt

txtПочти в каждом материале по разработке и продвижению мы упоминаем robots.txt. Сегодня не будем упоминать, а всю статью будем рассказывать про него, про правильный robots.txt в 2021 году.

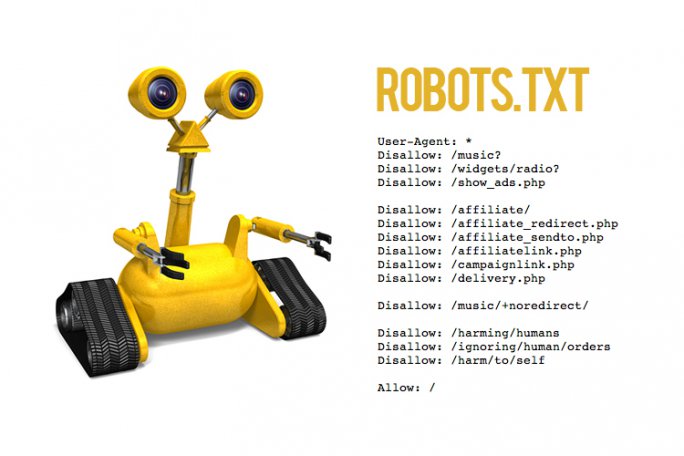

Вот так выглядит robots.txt Google. Примерно так же выглядит и robots.txt вашего сайта. По сути, это текстовый файл со списком исключений для поисковых роботов. Исключения запрещают индексировать одни разделы сайта и разрешают другие. Это необходимо, чтобы защитить конфиденциальную информацию, административные файлы или страницы, которые в силу требований SEO не должны попасть в поиск.

Инструкции

Поисковые роботы законопослушны. Они четко следуют инструкциям robots.txt и сканируют только те ссылки, которые разрешены. Инструкции в файле называются директивами, и в дальнейшем мы будем употреблять именно этот термин.

Директива User-agent для разграничения команд

Все robots.txt начинаются с user-agent. Это своеобразный маршрутизатор, который определяет адресата последующих команд. К ботам Яндекса и Гугла user-agent обращается по-разному — User-agent:Yandex и User-agent:GoogleBot, соответственно. User-agent из файла Google начинается с символа * и это значит, что дальнейшие команды относятся ко всем поисковым ботам.

Сразу отвечаем на закономерно возникающий вопрос: «Зачем указывать отдельные директивы для Яндекса и Гугла, если можно сделать универсальный список?». Поисковых ботов несколько. У одного только Гугла их семь: анализатор рекламы на десктопах и мобильных, индексатор картинок и видео, новостной сканер, бот по оценке рекламы для приложений на Android. Подставляя в user-agent имя нужного бота, можно определить список директив именно для него. Например, запретить индексацию картинок. Плюс у поисковых ботов разный подход к сканированию. Так, команду clean-param воспринимает только Яндекс и бесполезно указывать ее в блоке указаний для Гугла — не поймет.

Для больших сайтов с разными стратегиями продвижения имеет смысл прописывать директивы под конкретных ботов. Маленьким несложным ресурсам мы обычно рекомендует обращаться сразу ко всем индексаторам и использовать User-agent с символом *.

Директива disallow

Disallow — команда запрета. Она запрещает индексировать отдельные файлы, страницы или целые разделы. Обычно, disallow закрывают страницу входа в панель администрирования, документы PDF, DOC, XLS, формы регистрации, корзины, страницы с персональными данными клиентов и пр.

В robots.txt для Bitrix, например, disallow выглядит так:

User-agent: *

Disallow: /wp-admin/

Это в случае, когда мы закрываем доступ к панели управления.

Или так:

User-agent: *

Disallow: /images/

Такая комбинация запретит боту индексировать иллюстрации.

В структуре команды символ / обозначает, что нужно закрыть от индексации, а знак * боты понимают как «любой текст».

Важно! Disallow закрывает доступ поисковым роботам, но не людям, поэтому конфиденциальную информацию на сайте рекомендуем обязательно защищать аутентификацией.

Директивы allow и sitemap

Allow разрешает все, что не запрещает disallow. Это может показаться странным, ведь бот и без того может индексировать все, что не закрыто от сканирования. На самом деле allow нужна для выборочной индексации файлов или документов в закрытом разделе. Допустим, у вас есть закрытый с помощью disallow раздел для дистрибьюторов:

User-agent: *

Disallow: /distributoram/

Он будет выглядеть так, когда вы полностью закрываете индексацию раздела. Но допустим, в закрытом каталоге есть страница или файл, который имеет смысл показать пользователям. Вот тут на сцену выходит allow. Получается так:

Но допустим, в закрытом каталоге есть страница или файл, который имеет смысл показать пользователям. Вот тут на сцену выходит allow. Получается так:

User-agent: *

Disallow: /distributoram/

Allow: /distributoram/usloviya.html

При такой расстановке боты поймут, что из всего раздела distributoram они могут сканировать только контент страницы usloviya.html.

Sitemap одновременно и карта сайта, и директива. Про карту сайта в другой раз, а в роли директивы sitemap используется во всех случаях, когда вы хотите направить роботов на определенные разделы сайта.

Директиву sitemap поисковые боты воспринимают как указатель на приоритетные разделы, но если Яндекс понимает ее как рекомендацию, то GoogleBot как обязательное требование. Само собой, используя в robots.txt команду sitemap, саму карту в корневом каталоге необходимо поддерживать в актуальном состоянии.

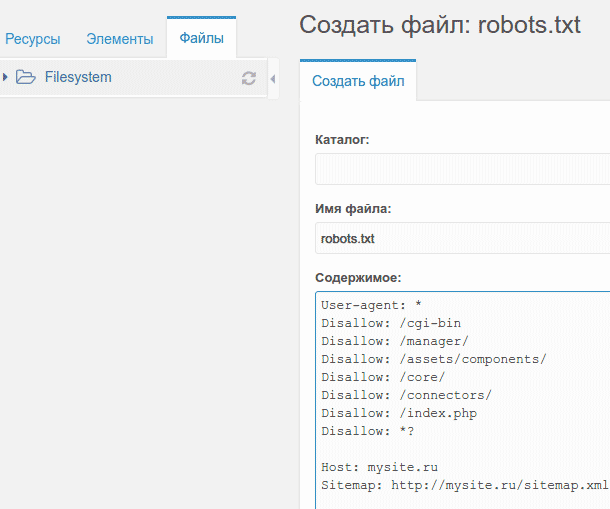

Создаем и проверяем robots.txt

Для создания файла подойдет любой текстовый редактор, тот же «Блокнот». На первое место ставим адресную директиву user-agent, потом блоками вносим disallow и allow. Примеры и руководства есть у обоих поисковиков. У Яндекса в разделе «Помощь вебмастеру». У Google в Центре Google Поиска.

Чтобы прописать robots.txt на сайте, файл сохраняем в текстовом формате и загружаем в корень. После загрузки проверьте правильность установки — robots.txt должен открываться по адресу вашсайт/robots.txt. Для проверки работоспособности вставьте ссылку на сайт и код файла в специальные поля сервиса https://webmaster.yandex.ru/tools/robotstxt/ Яндекса и выберите подтвержденный ресурс в https://www.google.com/webmasters/tools/robots-testing-tool в Google.

Зачем проверять robots.txt

В случае с robots ошибки проводят к выпадению из индекса одного раздела и попаданию в выдачу другого, совершенно лишнего и абсолютно ненужного. Кроме того, поисковые системы регулярно меняют правила индексации и добавляют/убирают отдельные директивы. Так, с 22 февраля 2018 года Яндекс перестал учитывать crawl-delay, но у многих сайтов в robots.txt она до сих пор есть и SEO-менеджеры до сих пор уверены, что управляют скоростью обхода.

Кроме того, поисковые системы регулярно меняют правила индексации и добавляют/убирают отдельные директивы. Так, с 22 февраля 2018 года Яндекс перестал учитывать crawl-delay, но у многих сайтов в robots.txt она до сих пор есть и SEO-менеджеры до сих пор уверены, что управляют скоростью обхода.

Держите руку на пульсе и не пренебрегайте базовыми правилами защиты сайта. Тем более, что с маленьким фалом robots.txt это совсем несложно.

Правильный Robots.txt для WordPress

Всем привет! Сегодня статья о том, каким должен быть правильный файл robots.txt для WordPress. С функциями и предназначением robots.txt мы разбирались несколько дней назад, а сейчас разберём конкретный пример для ВордПресс.

С помощью этого файла у нас есть возможность задать основные правила индексации для различных поисковых систем, а также назначить права доступа для отдельных поисковых ботов. На примере я разберу как составить правильный robots.txt для WordPress. За основу возьму две основные поисковые системы — Яндекс и Google.

В узких кругах вебмастеров можно столкнуться с мнением, что для Яндекса необходимо составлять отдельную секцию, обращаясь к нему по User-agent: Yandex. Давайте вместе разберёмся, на чём основаны эти убеждения.

Яндекс поддерживает директивы Clean-param и Host, о которых Google ничего не знает и не использует при обходе.

Разумно использовать их только для Yandex, но есть нюанс — это межсекционные директивы, которые допустимо размещать в любом месте файла, а Гугл просто не станет их учитывать. В таком случае, если правила индексации совпадают для обеих поисковых систем, то вполне достаточно использовать User-agent: * для всех поисковых роботов.

При обращении к роботам по User-agent важно помнить, что чтение и обработка файла происходит сверху вниз, поэтому используя User-agent: Yandex или User-agent: Googlebot необходимо размещать эти секции в начале файла.

Пример Robots.txt для WordPress

Сразу хочу предупредить: не существует идеального файла, который подойдет абсолютно всем сайтам, работающим на ВордПресс! Не идите на поводу, слепо копируя содержимое файла без проведения анализа под ваш конкретный случай! Многое зависит от выбранных настроек постоянных ссылок, структуры сайта и даже установленных плагинов. Я рассматриваю пример, когда используется ЧПУ и постоянные ссылки вида /%postname%/.

WordPress, как и любая система управления контентом, имеет свои административные ресурсы, каталоги администрирования и прочее, что не должно попасть в индекс поисковых систем. Для защиты таких страниц от доступа необходимо запретить их индексацию в данном файле следующими строками:

Disallow: /cgi-bin

Disallow: /wp-Директива во второй строке закроет доступ по всем каталогам, начинающимся на /wp-, в их число входят:

- wp-admin

- wp-content

- wp-includes

Но мы знаем, что изображения по умолчанию загружаются в папку uploads, которая находится внутри каталога wp-content. Разрешим их индексацию строкой:

Allow: */uploadsСлужебные файлы закрыли, переходим к исключению дублей с основным содержимым, которые снижают уникальность контента в пределах одного домена и увеличивают вероятность наложения на сайт фильтра со стороны ПС. К дублям относятся страницы категорий, авторов, тегов, RSS-фидов, а также постраничная навигация, трекбеки и отдельные страницы с комментариями. Обязательно запрещаем их индексацию:

Disallow: /category/

Disallow: /author/

Disallow: /page/

Disallow: /tag/

Disallow: */feed/

Disallow: */trackback

Disallow: */commentsДалее хотелось бы уделить особое внимание такому аспекту как постоянные ссылки. Если вы используете ЧПУ, то страницы содержащие в URL знаки вопроса зачастую являются «лишними» и опять же дублируют основной контент. Такие страницы с параметрами следует запрещать аналогичным образом:

Такие страницы с параметрами следует запрещать аналогичным образом:

Disallow: */?Это правило распространяется на простые постоянные ссылки ?p=1, страницы с поисковыми запросами ?s= и другими параметрами. Ещё одной проблемой могут стать страницы архивов, содержащие в URL год, месяц. На самом деле их очень просто закрыть, используя маску 20*, тем самым запрещая индексирование архивов по годам:

Disallow: /20*Для ускорения и полноты индексации добавим путь к расположению карты сайта. Робот обработает файл и при следующем посещении сайта будет его использовать для приоритетного обхода страниц.

Sitemap: https:В файле robots.txt можно разместить дополнительную информацию для роботов, повышающую качество индексации. Среди них директива Host — указывает на главное зеркало для Яндекса:

Host: webliberty.ruПри работе сайта по HTTPS необходимо указать протокол:

Host: https:С 20 марта 2018 года Яндекс официально прекратил поддержку директивы Host. Её можно удалить из robots.txt, а если оставить, то робот её просто игнорирует.

Подводя итог, я объединил всё выше сказанное воедино и получил содержимое файла robots.txt для WordPress, который использую уже несколько лет и при этом в индексе нет дублей:

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-

Disallow: /category/

Disallow: /author/

Disallow: /page/

Disallow: /tag/

Disallow: */feed/

Disallow: /20*

Disallow: */trackback

Disallow: */comments

Disallow: */?

Allow: */uploads

Sitemap: https:Постоянно следите за ходом индексации и вовремя корректируйте файл в случае появления дублей.

От того правильно или нет составлен файл зависит очень многое, поэтому обратите особо пристальное внимание к его составлению, чтобы поисковики быстро и качественно индексировали сайт. Если у вас возникли вопросы — задавайте, с удовольствием отвечу!

Если у вас возникли вопросы — задавайте, с удовольствием отвечу!

Правильный файл robots.txt под Яндекс и Google для WordPress, Joomla, uCoz

Далеко не все современные вебмастеры умеют работать с HTML-кодом. Многие даже не знают, как должны выглядеть функции, прописанные в ключевых файлах CMS. Внутренности вашего ресурса, такие как файл robots.txt, являются интеллектуальной собственностью, в которой владелец должен быть, как рыба в воде. Тонкая настройка сайта позволяет повысить его поисковые рейтинги, вывести в топ и успешно собирать трафик.

Файл robots.txt — один из основных элементов подгонки ресурса под требования поисковых систем. Он содержит техническую информацию и ограничивает доступ к ряду страниц поисковым роботам. Ведь далеко не каждая написанная страница должна непременно оказаться в выдаче. Раньше для создания файла robots txt был необходим доступ через FTP. Равитие CMS открыло возможность получить к нему доступ прямо через панель управления.

Для чего нужен файл robots.txt

Этот файл содержит ряд рекомендаций, адресованных поисковым ботам. Он ограничивает их доступ к некоторым частям сайта. Из-за размещения этого файла в корневом каталоге, боты никак не смогут его пропустить. В результате, попадая на ваш ресурс, они сначала читают правила его обработки, а уже только после этого начинают проверку.

Таким образом, файл указывает поисковым роботам, какие директории сайта разрешены для индексирования, и какие этому процессу не подлежат.

Учитывая, что на процесс ранжирования наличие файла напрямую не влияет, много сайтов не содержат robots.txt. Но путь полного доступа нельзя считать техически правильным. Рассмотрим преимущества robots.txt, которые он дает ресурсу.

Можно запретить индексирование ресурса целиком или частично, ограничить круг поисковых роботов, которые будут иметь право на проведение индексирования. Приказывая robots.txt запретить все, вы сможете полностью изолировать ресурс на время ремонта или реконструкции.

Кроме того, файл роботс ограничивает доступ на ресурс всевозможных спам-роботов. Их основная цель — сканирование сайта на наличие электронных адресов, которые потом будут использоваться для рассылки спама. Не будем останавливаться на том, к чему это может привести — и так понятно.

От индексирования можно скрыть разделы сайта, предназначенные не для поисковых машин, а для определенного круга пользователей, разделы, содержащие приватную и прочую подобную информацию.

Как создать правильный robots.txt

Правильный robots легко написать вручную, не прибегая к помощи различных конструкторов. Процесс сводится к прописыванию нужных директив в обычном файле блокнота, который, после внесения всех данных, сохраняется под названием «robots». Вам остаётся только закачать его в корневую директорию собственного ресурса. Для одного сайта нужен только один такой файл. В нем можно прописать инструкции для ботов всех нужных поисковых систем. То есть, делать отдельный файл под каждый поисковик не понадобится. Полноценный robots.txt пример может выглядеть так:

Теперь поговорим о том, что должно находиться внутри robots.txt. Обязательно употребление двух директив: User-agent и Disallow. Первая определяет, какому боту адресовано данное послание. Вторая показывает, какую страницу или директорию ресурса запрещено индексировать.

Чтобы задать одинаковые правила для всех ботов, можно в директиве User-agent вместо названия прописать символ: * (звездочку).

Файл robots.txt в таком случае будет выглядеть следующим образом:

Как можно догадаться, /file.html — это название конкретного файла, индексация которого запрещена. /papka/ — название директории, на содержимое которой не будет распространятся индексация.

Если нужно снять ограничения и разрешить индексацию всех страниц, файл следует изменить так:

Особенности настройки robots.txt для Яндекс и Google

Файл robots.txt для Яндекса раньше должен был содержать обязательную директиву host. Это позволяло избежать проблем с индексированием зеркала ресурса или иных дублей его страниц.

Это позволяло избежать проблем с индексированием зеркала ресурса или иных дублей его страниц.

Host — директива, которую понимал только бот Яндекса. Поэтому, при создании файла robots.txt одновременно для Яндекса, Гугла и других поисковых систем, следовало разделить директивы.

Безвременная кончина этой директивы произошла в марте 2018. Так что больше её использовать не нужно.

Создание файла robots.txt Google ничем не отличается от процесса, описанного выше. В директиве User-agent нужно прописать название бота поисковика: Googlebot, Googlebot-Image (для ограничения индексаций изображений),Googlebot-Mobile (для версий сайтов, рассчитанных на мобильные приложения) и т.п.

Желательно указать в файле путь к карте сайта — директива robots.txt sitemap. Благодаря этому робот будет быстрее ориентироваться на страницах ресурса, что значительно ускорит процесс индексации.

Кстати, разработчики Гугл неоднократно напоминали веб-мастерам, что файл robots.txt не должен превышать по размерам 500 Кб. Это непременно приведет к ошибкам при индексации. Если создавать файл вручную, то «достичь» такого размера, конечно, нереально. Но вот некоторые CMS, автоматически формирующие содержание robots.txt, могут значительно его перегрузить.

Простое создание файла для любого поисковика

Если вы боитесь заниматься тонкой настройкой самостоятельно, её можно провести автоматически. Существуют конструкторы, собирающие подобные файлы без вашего участия. Они подходят людям, которые только начинают своё становление в качестве вебмастеров.

Как видно на изображении, настройка конструктора начинается с введения адреса сайта. Далее вы выбираете поисковые системы, с которыми планируете работать. Если вам не важна выдача той или иной поисковой системы, то нет необходимости создавать под неё настройки. Теперь переходите к указанию папок и файлов, доступ к которым планируете ограничить. В данном примере вы сможете указать адрес карты и зеркала вашего ресурса.

Robots.txt generator будет заполнять форму по мере наполнения конструктора. Всё, что в дальнейшем от вас потребуется — это скопировать полученный текст в txt-файл. Не забудьте присвоить ему название robots.

Как проверить эффективность файла robots.txt

Для того, чтобы проанализировать действие файла в Яндексе, следует перейти на соответствующую страницу в разделе Яндекс.Вебмастер. В диалоговом окне укажите имя сайта и нажмите кнопку «загрузить».

Система проанализирует файл robots.txt проверка покажет, будет ли поисковый робот обходить страницы, запрещенные к индексации. Если возникли проблемы, директивы можно отредактировать и проверить прямо в диалоговом окне. Правда после этого вам придётся скопировать отредактированный текст и вставить в свой файл robots.txt в корневом каталоге.

Аналогичную услугу предоставляет сервис «Инструменты для веб-мастеров» от поисковика Google.

Создание robots.txt для WordPress , Joomla и Ucoz

Различные CMS, получившие широкую популярность на просторах Рунета, предлагают пользователям свои версии файлов robots.txt. Некоторые из них не имеют таких файлов вовсе. Зачастую эти файлы либо слишком универсальны и не учитывают особенностей ресурса пользователя, либо имеют ряд существенных недостатков.

Опытный специалист может вручную исправить положение (при недостатке знаний так лучше не делать). Если вы боитесь копаться во внутренностях сайта, воспользуйтесь услугами коллег. Подобные манипуляции, при знании дела, занимают всего пару минут времени. Например, robots.txt WordPress может выглядеть таким образом:

Файл robots.txt для Ucoz предоставляется автоматически. Он имеет оптимальные настройки. Единственный его недостаток — система создаст файл, спустя примерно месяц, после конструирования ресурса. Если неохота ждать, можно написать файл самостоятельно. Выглядеть он будет так:

Joomla позволяет нескольким URL ссылаться на одну и ту же страницу. Поисковые системы примут такие настройки за дублирование контента. Избежать этого поможет установка robots.txt для Joomla следующего содержания:

Поисковые системы примут такие настройки за дублирование контента. Избежать этого поможет установка robots.txt для Joomla следующего содержания:

В последних двух строчках, как несложно догадаться, нужно прописать данные собственного ресурса.

Заключение

Есть ряд навыков, обязательных для освоения любым вебмастером. И самостоятельная настройка и ведение сайта — один из них. Начинающие сайтостроители могут таких дров наломать во время отладки ресурса, что потом не разгребёшь. Если вы не хотите терять потенциальную аудиторию и позиции в выдаче из-за структуры сайта, подходите к процессу её настройка основательно и ответственно.

Примеры robots.txt WordPress для Яндекса и Google. Как правильно составить robots.txt

В сегодняшнем видео уроке по WordPress SEO я расскажу и покажу на примерах особенности создания и использования файла robots.txt для WordPress, этот урок не планировался как исчерпывающее руководство по robots.txt, но он должен дать вам хорошее представление о том что это за файл и что туда добавлять для минимизации попадания ненужных файлов в индекс поисковых систем и как его использовать для управления тем как поисковые роботы Google и Яндекс индексируют ваш сайт. Если у вас возникнут вопросы — пишите в комметариях, ниже привожу текстовый транскрипт видео, на тот случай если у вас возникнут вопросы или будет нужен фрагмент кода в текстовом виде.

Текстовый транскрипт видео:

Здравствуйте,

Меня зовут Дмитрий, и в этом видео вы узнаете о том, как контролировать индексирование вашего сайта поисковыми системами с помощью файла robots.txt. Плюс в качестве примера мы разберем robots.txt для WordPress, который минимизирует индексирование ненужных файлов поисковыми системами. Итак, приступим.

Итак, приступим.

Для чего нужен файл robots.txt

Файл robots.txt – это текстовый файл, находящийся в корневой директории сайта, в котором записываются специальные инструкции, запрещающие посещение и индексирование отдельных разделов сайта. robots.txt предназначен для использования ботами, в качестве примера ботов можно назвать поисковых роботов Яндекса и Google или ботов архиваторов, как например робот Web Archive.

Для создания robots.txt воспользуйтесь любым текстовым редактором, заполните его в соответствии с вашими пожеланиями и примерами в этом видео и сохраните как просто тест без форматирования, расширение файла должно быть .txt. После этого необходимо загрузить файл в корневой каталог вашего сайта.

Используйте файл robots.txt для ограничения поисковых роботов от индексации отдельных разделов вашего сайта. Вы можете указать параметры индексирования своего сайта как для всех роботов сразу, так и для каждой поисковой системы в отдельности, используя директиву User-Agent. Для списка роботов популярных поисковых систем перейдите по ссылке в описании этого видео.

Пример robots.txt для WordPress

В качестве примера robots.txt для WordPress, который минимизирует индексирование ненужных файлов поисковыми системами, вы можете использовать следующий шаблон:

User-Agent: * Disallow: /wp-content/plugins/ Disallow: /wp-content/themes/ Disallow: /wp-admin/ Disallow: /*.swf Disallow: /*.flv Disallow: /*.pdf Disallow: /*.doc Disallow: /*.exe Disallow: /*.htm Disallow: /*.html Disallow: /*.zip Allow: /

Давайте разберем по порядку, что здесь написано. Строчка User-Agent: * говорит, что это относится к любым агентам, к любым поисковым системам, к любым ботам, которые посещают сайт. Строчки, начинающиеся с Disallow: — это директивы, запрещающие индексирование какой-либо части сайта. Например, строчка Disallow: /wp-admin/ запрещает индексирование папки /wp-admin/, любых файлов, которые находятся в папке /wp-admin/. Сейчас у нас запрещены к индексированию папки – плагины, темы и wp-admin (/plugins/ /themes/ /wp-admin/). Директива Disallow: /*. и расширение файла запрещает к индексированию определенный тип файлов. В данный момент запрещены к индексированию .swf, *.flv, *.pdf, *.doc, *.exe, *.js, *.htm, *.html, *.zip. Последняя строчка Allow: / разрешает индексирование любых других частей сайта и любых других файлов.

Например, строчка Disallow: /wp-admin/ запрещает индексирование папки /wp-admin/, любых файлов, которые находятся в папке /wp-admin/. Сейчас у нас запрещены к индексированию папки – плагины, темы и wp-admin (/plugins/ /themes/ /wp-admin/). Директива Disallow: /*. и расширение файла запрещает к индексированию определенный тип файлов. В данный момент запрещены к индексированию .swf, *.flv, *.pdf, *.doc, *.exe, *.js, *.htm, *.html, *.zip. Последняя строчка Allow: / разрешает индексирование любых других частей сайта и любых других файлов.

Если вы используете плагин кеширования, который генерирует статичные версии ваших страниц или структуру постоянных ссылок, оканчивающуюся .htm/.html, уберите строчки

Disallow: /*.htm Disallow: /*.html

В общем, если в адресной строке браузера адреса ваших страниц заканчиваются на .htm или .html, то уберите эти две строчки из robots.txt, иначе вы запретите к индексированию большую часть вашего сайта. Если вы хотите открыть все разделы сайта для индексирования всем роботам, то можете использовать следующий фрагмент:

User-agent: * Disallow:

Так как помимо полезных ботов (например, роботы поисковых систем, которые соблюдают директивы указанные в robots.txt) ваш сайт посещается вредными ботами (спам боты, скрейперы контента, боты которые ищут возможности для инъекции вредоносного кода), которые не только не соблюдают правила, указанные в robots.txt, а, наоборот, посещают запрещенные папки и файлы с целью выявления уязвимостей и кражи пользовательских данных. В таком случае если вы не хотите явно указывать адрес папки или файла, запрещенного к индексированию, вы можете воспользоваться директивой частичного совпадения. Например, у вас есть папка /shop-zakaz/, которую вы хотите запретить к индексированию. Для того, чтобы явно не указывать адрес этой папки для скрейперов и ботов шпионов вы можете указать часть адреса:

Disallow: *op-za*

или

Disallow:*zakaz*

Символ * заменяет произвольное количество символов, тогда любые папки и файлы, содержащие в своем названии эту комбинацию, будут запрещены к индексированию. Старайтесь выбирать часть адреса, который уникален для этой папки, потому что если эта комбинация встретится в других файлах и папках, вы запретите их к индексированию.

Старайтесь выбирать часть адреса, который уникален для этой папки, потому что если эта комбинация встретится в других файлах и папках, вы запретите их к индексированию.

Для того, чтобы случайно не запретить к индексированию нужную часть сайта всегда имеет смысл проверить, как поисковые системы воспринимают правила, указанные в вашем robots.txt. Если вы — подтвержденный владелец сайта в инструментах вебмастера Google или Яндекс — вы можете воспользоваться встроенными инструментами для проверки правил robots.txt.

Для того, чтобы проверить robots.txt в Google Webmaster Tools перейдите в секцию «Crawl>Blocked URLs», здесь вы можете воспользоваться текущей версией robots.txt или же отредактировать ее, чтобы протестировать изменения, затем добавьте список URL, которые вы хотите протестировать и нажмите на кнопку «Проверить». Результаты теста покажут, какие из указанных URL разрешены к индексированию, а какие запрещены.

Проверка robots.txt в Яндекс ВебмастерДля того, чтобы проверить robots.txt в Яндекс Вебмастер перейдите в секцию «Настройка индексирования>Анализ robots.txt», при необходимости внесите изменения в robots.txt, добавьте список URL и нажмите кнопку «Проверить». Результаты теста покажут, какие из указанных URL разрешены к индексированию, а какие запрещены.

Редактируя правила составьте файл robots.txt, подходящий для вашего сайта. Помните, что файл на сайте при этом не меняется. Для того, чтобы изменения вступили в силу, вам потребуется самостоятельно загрузить обновленную версию robots.txt на сайт.

ЗаключениеНу, вот мы и осветили основные моменты работы с robots.txt. Если вам нужны фрагменты и примеры файлов robots.txt, которые я использовал в этом видео, перейдите по ссылке, которая указана в описании этого видео. Спасибо за то, что посмотрели это видео, мне было приятно его для вас делать, буду вам благодарен, если вы поделитесь им в социальных сетях)) Ставьте «палец вверх» и подписывайтесь на новые видео.

Если у вас возникли проблемы с просмотром – вы можете посмотреть видео «Уроки WordPress — правильный файл robots.txt WordPress для Яндекса и Google» на YouTube.

Что такое файл robots.txt и как им пользоваться — Хостинг

Robots.txt — Общая информацияRobots.txt и SEO

Исправления и обходные пути

Robots.txt для WordPress

Robots.txt — Общая информация

Роботы.txt — это текстовый файл, расположенный в корневом каталоге веб-сайта, в котором указывается, какие страницы и файлы веб-сайта вы хотите (или не хотите) посещать сканерам поисковых систем и паукам. Обычно владельцы сайтов хотят, чтобы их заметили поисковые системы; однако бывают случаи, когда в этом нет необходимости. Например, если вы храните конфиденциальные данные или хотите сэкономить трафик за счет отказа от индексации (за исключением страниц с тяжелыми изображениями).

Поисковые системы индексируют веб-сайты, используя ключевых слов и метаданные , чтобы предоставить пользователям Интернета наиболее релевантные результаты, которые ищут что-то в Интернете.Достижение вершины списка результатов поиска особенно важно для владельцев интернет-магазинов. Клиенты редко просматривают дальше первых нескольких страниц из предложенных в поисковой системе страниц.

Для индексирования используются так называемые пауки или краулеры . Это боты, которые компании поисковых систем используют для получения и индексации содержимого всех открытых для них веб-сайтов.

Когда сканер обращается к веб-сайту, он сначала запрашивает файл с именем / robots.txt . Если такой файл найден, сканер затем проверяет его на соответствие инструкциям по индексации веб-сайта . Бот, который не находит никаких директив, имеет собственный алгоритм действий, который в основном все индексирует. Это не только перегружает веб-сайт ненужными запросами, но и само индексирование становится намного менее эффективным.

ПРИМЕЧАНИЕ : может быть только один файл robots.txt для веб-сайта. Файл robots.txt для доменного имени дополнения необходимо поместить в соответствующий корень документа.Например, если ваше доменное имя www.domain.com , его нужно найти по адресу https://www.domain.com/robots.txt .

Также очень важно, чтобы ваш файл robots.txt на самом деле назывался robots.txt. Имя чувствительно к регистру, поэтому убедитесь, что вы написали правильно, иначе оно не сработает.

Официальная позиция Google по файлу robots.txt

Файл robots.txt состоит из строк, содержащих два поля:

- Имя агента пользователя (сканеры поисковых систем).Найдите здесь список имен всех пользовательских агентов.

- . Строка (строки), начинающиеся с директивы Disallow : для блокировки индексации.

Robots.txt должен быть создан в текстовом формате UNIX. Такой файл .txt можно создать прямо в диспетчере файлов cPanel. Более подробные инструкции можно найти здесь .

Основы синтаксиса robots.txt

Обычно файл robots.txt содержит такой код:

User-agent: *

Disallow: / cgi-bin /

Disallow: / tmp /

Disallow: / ~ different /

В этом примере три каталога: / cgi-bin /, / tmp / и / ~ different / исключены из индексации.

ОБРАТИТЕ ВНИМАНИЕ:

- Каждый каталог записывается в отдельной строке . Вы не должны записывать все каталоги в одну строку или разбивать одну директиву на несколько строк. Вместо этого используйте новую строку, чтобы отделить друг от друга директивы.

- Звездочка (*) в поле User-agent означает «любой поисковый робот». Следовательно, такие директивы, как Disallow: * .gif или User-agent: Mozilla * , не поддерживаются. Обратите внимание на эти логические ошибки, поскольку они самые распространенные.

- Другой распространенной ошибкой является случайная опечатка: каталоги с ошибками, пользовательские агенты, пропущенные двоеточия после User-agent и Disallow и т.

Д. ошибка, чтобы проскользнуть, поэтому есть некоторые инструменты проверки , которые пригодятся.

Д. ошибка, чтобы проскользнуть, поэтому есть некоторые инструменты проверки , которые пригодятся.

Примеры использования

Вот несколько полезных примеров использования robots.txt:

Пример 1

Запретить индексацию всего сайта всеми поисковыми роботами:

User-agent: * Запретить: /

Такая мера, как полная блокировка сканирования, может потребоваться, когда веб-сайт находится под большой нагрузкой запросов или если контент обновляется и не должен появляться в результатах поиска.Иногда настройки SEO-кампании слишком агрессивны, поэтому боты по сути перегружают сайт запросами к его страницам.

Пример 2

Разрешить всем поисковым роботам индексировать весь сайт:

User-agent: * Запретить:

На самом деле нет необходимости сканировать весь сайт. Маловероятно, что посетители будут искать условия использования или страницы входа, например, через Google Поиск. Исключение некоторых страниц или типов контента из индексации было бы полезно для безопасности, скорости и релевантности в рейтинге данного веб-сайта.

Ниже приведены примеры того, как контролировать, какой контент индексируется на вашем веб-сайте.

Пример 1

Запретить индексацию только нескольких каталогов:

User-agent: *Пример 2

Disallow: / cgi-bin /

Запретить индексацию сайта определенным поисковым роботом:

User-agent: *

Disallow: / page_url

Страница обычно идет без полного URL-адреса, только по имени, которое следует за http: // www.yourdomain.com/ . При использовании такого правила любая страница с совпадающим именем блокируется от индексации. Например, будут исключены как / page_url , так и / page_url_new . Чтобы этого избежать, можно использовать следующий код:

User-agent: *

Disallow: / page_url $

Пример 3

Предотвратить индексацию веб-сайта конкретным поисковым роботом . :

:

User-agent: Bot1

Disallow: /

Несмотря на список, некоторые идентификаторы могут со временем измениться.Когда нагрузка на веб-сайт очень высока, и невозможно определить точного бота, чрезмерно использующего ресурсы, лучше временно заблокировать их все.

Пример 4

Разрешить индексацию для определенного поискового робота и запретить индексацию для других:

Агент пользователя: Opera 9

Запретить: Пользовательский агент: * Запретить: /

Пример 5

Запретить индексацию всех файлов, кроме одного.Существует также директива Allow :.Это , но не распознается всеми поисковыми роботами и может быть проигнорирован некоторыми из них. В настоящее время его поддерживают Bing и Google. Следующий пример правила о том, как разрешить только один файл из определенной папки, следует использовать на свой страх и риск:

User-agent: *

Allow: /docs/file.jpeg

Disallow: / docs /

Вместо этого вы можете переместить все файлы в определенный подкаталог и предотвратить его индексацию, за исключением одного файла, который вы разрешаете индексировать:

User-agent: *

Disallow: / docs /

Для этой настройки требуется определенная структура веб-сайта .Также возможно создать отдельную целевую страницу, которая будет перенаправлять на настоящую домашнюю страницу пользователя. Таким образом, вы можете заблокировать фактический каталог с веб-сайтом и разрешить только страницу целевого индекса. Лучше, чтобы такие изменения выполнял разработчик веб-сайта, чтобы избежать проблем.

Вы также можете использовать онлайн-генератор файлов robots.txt здесь . Имейте в виду, что он выполняет настройку по умолчанию, которая не принимает во внимание сложные структуры веб-сайтов с пользовательским кодом.

Файл robots.txt по умолчанию в некоторых версиях CMS настроен так, чтобы исключить папку с изображениями.

Эта проблема не возникает в последних версиях CMS, но более старые версии необходимо проверять.

Эта проблема не возникает в последних версиях CMS, но более старые версии необходимо проверять. Это исключение означает, что ваши изображения не будут проиндексированы и включены в Поиск картинок Google. Изображения, появляющиеся в результатах поиска, — это то, что вам нужно, так как они повышают ваш рейтинг в SEO. Однако вам нужно обратить внимание на проблему, называемую «хотлинкинг». Когда кто-то репостит изображение, загруженное на ваш сайт в другом месте, ваш сервер загружается с запросами.Чтобы предотвратить хотлинкинг, прочтите соответствующую статью базы знаний . Если вы хотите изменить это, откройте файл robots.txt и удалите строку, которая гласит:

Disallow: / images /

Если на вашем веб-сайте много личного содержания или файлы мультимедиа не хранятся постоянно, а загружаются и удаляются ежедневно, лучше исключить изображения из результатов поиска. В первом случае это вопрос личной жизни. Последнее касается возможной перегрузки активности сканеров, когда они снова и снова проверяют каждое новое изображение.

карта сайта: http: //www.domain.com/sitemap.xmlНе забудьте заменить путь http://www.domain.com/sitemap.xml своей фактической информацией.

Чтобы узнать, как создать sitemap.xml для вашего веб-сайта, вы, , можете найти их здесь .

Разные примечания

- Не блокируйте CSS, Javascript и другие файлы ресурсов по умолчанию. Это мешает роботу Googlebot правильно отображать страницу и понимать, что ваш сайт оптимизирован для мобильных устройств.

- Вы также можете использовать этот файл для предотвращения индексации определенных страниц, таких как страницы входа или страницы 404, но это лучше сделать с помощью метатега robots.

- Добавление операторов запрета в файл robots.txt не приводит к удалению содержимого. Он просто блокирует доступ паукам. Если есть контент, который вы хотите удалить, лучше использовать мета-ноиндекс.

- Как правило, файл robots.txt никогда не должен использоваться для обработки повторяющегося содержания. Есть лучшие способы, такие как тег Rel = canonical, который является частью HTML-заголовка веб-страницы.

- Всегда помните, что файл robots.txt должен быть точным, чтобы ваш веб-сайт мог правильно индексироваться поисковыми системами.

Включение индексации URL-адресов в ‘noindex’

Мета-тег noindex предотвращает индексацию всей страницы поисковой системой. Это может быть нежелательной ситуацией, так как вы хотите, чтобы URL-адреса на этой странице индексировались и отслеживались ботами для лучших результатов. Чтобы это произошло, вы можете отредактировать заголовок своей страницы с помощью следующей строки:

Эта строка предотвратит индексирование самой страницы поисковой системой, но из-за части кода follow размещенные ссылки на этой странице все равно будет извлекаться.Это позволит пауку перемещаться по веб-сайту и связанному с ним контенту. Преимущество этого типа интеграции называется Link Juice — это связь между разными страницами и соответствие их содержания друг другу.

Если добавлено nofollow , поисковый робот остановится, когда достигнет этой страницы, и не перейдет к взаимосвязанному контенту:

С точки зрения SEO это не рекомендуется, но решать вам. Некоторые страницы могут быть удалены с веб-сайта навсегда, поэтому они больше не имеют реальной ценности. Любой устаревший контент должен быть удален из robots.txt, и. htaccess файлов. Последний может содержать перенаправления для страниц, которые больше не актуальны.

Простая блокировка просроченного контента неэффективна. Вместо этого 301 редирект следует применять либо в файле . htaccess, либо через плагины. Если для удаленной страницы нет адекватной замены, она может быть перенаправлена на домашнюю страницу.

htaccess, либо через плагины. Если для удаленной страницы нет адекватной замены, она может быть перенаправлена на домашнюю страницу.

Лучше запретить проиндексированные страницы с конфиденциальными данными на них. Наиболее распространенные примеры:

- Страницы входа

- Область администрирования

- Информация о личных счетах

- Тот факт, что этот URL-адрес отображается в результатах поиска, не отображается. означают, что любой человек без учетных данных может получить к нему доступ. Тем не менее, вы можете захотеть иметь настраиваемую административную панель и URL-адресов для входа в систему , которые известны только вам.

- Рекомендуется не только исключить определенные папки, но и защитить их паролем .

- Если определенный контент на вашем веб-сайте должен быть доступен только зарегистрированным пользователям , обязательно примените эти настройки к страницам. Доступ только по паролю можно настроить , как описано здесь . Примерами являются веб-сайты с премиум-членством, на которых определенные страницы и статьи доступны только после входа в систему.

- Файл robots.txt и его содержимое можно проверить онлайн .Вот почему рекомендуется избегать ввода каких-либо имен или данных, которые могут дать нежелательную информацию о вашей компании.

User-agent: *

Disallow: / profiles /

Не только в качестве меры безопасности, но и для экономии ресурсов вашего хостинга, вы можете исключить нерелевантного контента для посетителей вашего веб-сайта из результатов поиска. Например, это могут быть темы и фоновые изображения, кнопки, сезонные баннеры и т. Д.Использование директивы Disallow для всего каталога / theme не рекомендуется.

Например, это могут быть темы и фоновые изображения, кнопки, сезонные баннеры и т. Д.Использование директивы Disallow для всего каталога / theme не рекомендуется.

Некоторые поисковые системы слишком стремятся проверять содержание при малейшем обновлении.Они делают это слишком часто и создают большой нагрузки на сайте. Никто не хочет, чтобы его страницы загружались медленно из-за голодных поисковых роботов, но полная их блокировка каждый раз может быть слишком экстремальной. Вместо этого их можно замедлить с помощью следующей директивы:

crawl-delay: 10

В этом случае для поисковых роботов существует 10-секундная задержка.

Robots.txt для WordPress

WordPress создает виртуальный файл robots.txt, как только вы публикуете свой первый пост с помощью WordPress.Хотя, если у вас уже есть настоящий файл robots.txt, созданный на вашем сервере, WordPress не добавит виртуальный.

Виртуальный файл robots.txt не существует на сервере, и вы можете получить к нему доступ только по следующей ссылке: http://www.yoursite.com/robots.txt

По умолчанию на нем будет Google Медиабот разрешен, множество спам-ботов запрещены, а некоторые стандартные папки и файлы WordPress запрещены.

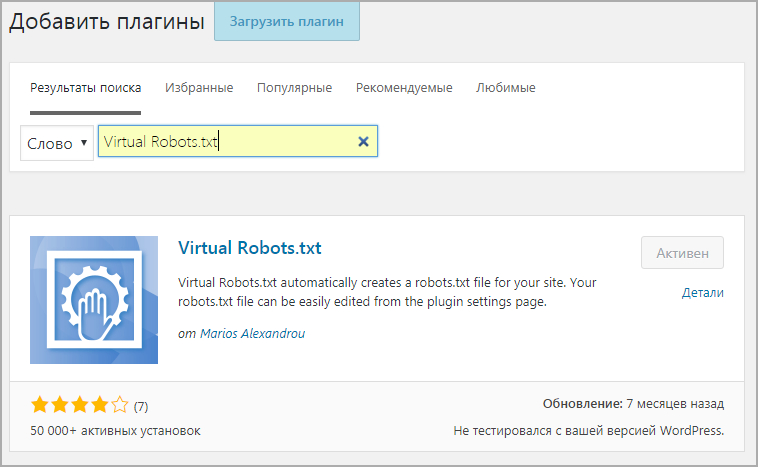

Итак, если вы еще не создали настоящий robots.txt, создайте его с помощью любого текстового редактора и загрузите его в корневой каталог своего сервера через FTP.Лучше всего вы также можете использовать один из множества предлагаемых плагинов для SEO. Самые последние и надежные плагины можно найти в официальном руководстве WordPress по SEO .

Блокировка основных каталогов WordPress

В каждой установке WordPress есть 3 стандартных каталога — wp-content, wp-admin, wp-includes , которые не нужно индексировать.

Не выбирайте запретить всю папку wp-content, поскольку она содержит подпапку «uploads» с медиафайлами вашего сайта, которые вы не хотите блокировать.Вот почему вам нужно действовать следующим образом:

Disallow: / wp-admin /

Disallow: / wp-includes /

Disallow: / wp-content / plugins /

Disallow: / wp-content / themes /

Блокировка на основе структуры вашего сайта

Каждый блог может быть структурирован по-разному:

а) По категориям

б) На основе тегов

c) На основе обоих

— ни один из этих

d) На основе архивов по дате

a) Если ваш сайт структурирован по категориям, вам не нужно индексировать архивы тегов.Найдите свою базу тегов на странице Permalinks options в меню Settings . Если поле оставить пустым, база тегов будет просто тегом:

Запретить: / tag /

б) Если ваш сайт имеет теговую структуру, вам необходимо заблокировать архивы категорий. Найдите свою базу категорий и используйте следующую директиву:

Disallow: / category /

c) Если вы используете и категории, и теги, вам не нужно использовать какие-либо директивы.Если вы не используете ни один из них, вам необходимо заблокировать их оба:

Disallow: / tags /

Disallow: / category /

d) Если ваш сайт структурирован на основе архивов на основе даты, вы можете заблокировать их следующими способами:

Запрещено: / 2010/

Запрет: / 2011/

Запрет: / 2012/

Disallow: / 2013 /

ПОЖАЛУЙСТА, ОБРАТИТЕ ВНИМАНИЕ: Вы не можете использовать здесь Disallow: / 20 * /, так как такая директива будет блокировать каждое сообщение в блоге или страницу, начинающуюся с цифры «20».

Проблемы с дублированием контента в WordPress

По умолчанию WordPress имеет дублирующиеся страницы, которые не влияют на ваш рейтинг в SEO. Чтобы исправить это, мы бы посоветовали вам не использовать robots.txt, а вместо этого пойти более тонким способом: тег rel = canonical , который вы используете для размещения единственного правильного канонического URL в разделе вашего сайта. Таким образом, поисковые роботы будут сканировать только каноническую версию страницы.

Более подробное описание от Google того, что такое канонический тег и почему вы должны его использовать , можно найти здесь .

Чтобы исправить это, мы бы посоветовали вам не использовать robots.txt, а вместо этого пойти более тонким способом: тег rel = canonical , который вы используете для размещения единственного правильного канонического URL в разделе вашего сайта. Таким образом, поисковые роботы будут сканировать только каноническую версию страницы.

Более подробное описание от Google того, что такое канонический тег и почему вы должны его использовать , можно найти здесь .

Вот и все!

Нужна помощь? Свяжитесь с нашей службой поддержки

Идеальный файл robots.txt для WordPress? — Ошибка сервера

. Идеальный файл robots.txt для WordPress? — Ошибка сервераСеть обмена стеков

Сеть Stack Exchange состоит из 176 сообществ вопросов и ответов, включая Stack Overflow, крупнейшее и пользующееся наибольшим доверием онлайн-сообщество, где разработчики могут учиться, делиться своими знаниями и строить свою карьеру.

Посетить Stack Exchange- 0

- +0

- Авторизоваться Зарегистрироваться

Server Fault — это сайт вопросов и ответов для системных и сетевых администраторов. Регистрация займет всего минуту.

Регистрация займет всего минуту.

Кто угодно может задать вопрос

Кто угодно может ответить

Лучшие ответы голосуются и поднимаются наверх

Спросил

Просмотрено 827 раз

Я поискал в Интернете идеальных роботов.txt для размещенного блога WordPress. Я нашел несколько вариантов, например здесь и здесь.

Я подумал, что это будет хороший вопрос для ServerFault: для «простого» блога поверх WordPress, какой файл robots.txt будет идеальным?

В настоящее время у меня есть следующий файл robots.txt, который я нашел в другом месте в Интернете:

Агент пользователя: *

Disallow: / cgi-bin

Запретить: / wp-admin

Disallow: / wp-includes

Запретить: / wp-content / plugins

Запретить: / wp-content / cache

Запретить: / wp-content / themes

Запретить: / trackback

Disallow: / feed

Запретить: / комментарии

Запретить: / категория / * / *

Disallow: * / trackback

Disallow: * / feed

Disallow: * / комментарии

Disallow: / *? *

Disallow: / *?

Разрешить: / wp-content / uploads

# Google Image

Пользовательский агент: Googlebot-Image

Запретить:

Позволять: /*

# Google AdSense

Пользовательский агент: Mediapartners-Google *

Запретить:

Позволять: /*

# Интернет-архиватор Wayback Machine

Пользовательский агент: ia_archiver

Запретить: /

# digg зеркало

Пользовательский агент: duggmirror

Запретить: /

Спасибо

Создан 26 авг.

26611 золотых знаков22 серебряных знака1010 бронзовых знаков

1Не бывает «идеальных» роботов.txt, хотя найдется вариант, который вам больше всего подходит. Просто определитесь, что вы хотите, чтобы боты видели, и создайте файл robots.txt, который запрещает все остальное. Нет необходимости в строках «разрешить», поскольку роботы анализируют эти файлы, чтобы определить, на что вы не хотите, чтобы они смотрели, а затем предполагают, что все остальное — честная игра. например Часть моего собственного файла robots.txt, которая применяется к wordpress:

Запретить: /blog/wp-*.php

Запретить: / blog / wp-admin /

Запретить: / blog / wp-includes /

Запретить: / blog / wp-content /

Создан 26 авг.

Джон ГарденерсДжон Гарденерс26.7k1111 золотых знаков5151 серебряный знак108108 бронзовых знаков

1 Я никогда раньше не рассматривал возможность использования файла robots.txt с wordpress — я просто убеждаюсь, что права доступа к файлам, которые не должны запускать случайные пользователи (например, установщик или программа обновления), верны.

Создан 09 сен.

Warrenwarren 16. 5k2222 золотых знака7676 серебряных знаков130130 бронзовых знаков

5k2222 золотых знака7676 серебряных знаков130130 бронзовых знаков

Ваша конфиденциальность

Нажимая «Принять все файлы cookie», вы соглашаетесь с тем, что Stack Exchange может хранить файлы cookie на вашем устройстве и раскрывать информацию в соответствии с нашей Политикой в отношении файлов cookie.

Принимать все файлы cookie Настроить параметры

Лучший robots.txt веб-сайта WordPress

Текстовый файл называется robots.txt, который вы размещаете на своем веб-сайте, чтобы сообщить сканерам, какие страницы вы хотите, чтобы они посещали, а не посещали. Поисковые системы подчиняются тому, чего просят не делать, но robots.txt для них не является обязательным. Robot.txt не является брандмауэром или паролем для поисковых систем. Это также не мешает поисковой системе сканировать ваш сайт. Если у вас действительно есть какие-либо данные, которые вы не хотите отображать в результатах поиска, вам никогда не нужно доверять robots.txt, чтобы он не индексировался и не отображался в результатах поиска.

robots.txt должен находиться в основном каталоге. Поисковые системы могут обнаружить его в основном каталоге, только если он находится в любом другом месте, кроме того, что поисковые системы не ищут его по всему сайту и не могут его найти. Поисковые системы Сначала просматривают его в основном каталоге, и, если он не существует, поисковые системы предполагают, что файл robots.txt не существует на веб-сайте. Таким образом, если файл robots.txt размещен не в нужном месте, поисковая система отображает все, что находит.

Есть много поисковых систем и много разных файлов, которые вы хотите запретить. Синтаксис файла robots.txt следующий: —

Агент пользователя: * Disallow: /Сканеры поисковой системы

записываются в пользовательский агент, а список каталогов и файлов, которые вы не хотите отображать или сканировать, записываются перед Disallow.

Вы также можете добавить строку комментария, используя знак решетки (#) в начале строки.

Например: —

Агент пользователя: * Запрещение: / temp /

В приведенном выше примере показано, что User-agent: * означает, что он включает всех сканеров поисковой системы, а Disallow: / temp / означает, что он запрещает отображение имени файла temp.

Важные вещи для лучшего robots.txt веб-сайта WordPress

Если вы имеете дело с WordPress, вы хотите, чтобы ваши страницы и сообщения отображались поисковыми системами, но вы не хотите, чтобы поисковые системы сканировали ваши основные файлы и каталоги WordPress, а также обратные ссылки и каналы.Содержимое файла robots.txt варьируется от сайта к сайту по-разному. Вам необходимо создать файл robots.txt в корневом каталоге вашего веб-сайта. Для WordPress не существует стандартизированного файла robots.txt, но следующие моменты дадут вам четкое представление о лучшем файле robots.txt для веб-сайта WordPress.

1. Вещи, которые всегда следует блокировать

На сайте WordPress есть некоторые файлы и каталоги, которые следует каждый раз блокировать. Каталоги, которые вы должны запретить в роботе.txt — это каталог cgi-bin и стандартные каталоги WP. Некоторые серверы не позволяют получить доступ к каталогу cgi-bin, но вы должны включить его в свою директиву disallow в файле robot. txt, и он не будет быть вредным, если вы это сделаете.

txt, и он не будет быть вредным, если вы это сделаете.

Стандартные каталоги WordPress, которые вы должны заблокировать: wp-admin, wp-content, wp-includes. В этих каталогах нет данных, которые изначально были бы полезны для поисковых систем, но есть исключение, то есть подкаталог с именем «uploads» существует в каталоге wp-content.Этот подкаталог должен быть разрешен в robot.txt, потому что он включает все, что вы загружаете с помощью функции загрузки мультимедиа WP. Итак, вы должны разблокировать его.

Директивы, использованные выше, приведены ниже: —

Агент пользователя: * Disallow: / cgi-bin / Запретить: / wp-admin / Запретить: / wp-includes / Запретить: /xmlrpc.php Запретить: / wp-content / plugins / Запретить: / wp-content / cache / Запретить: / wp-content / themes / Запретить: / trackback / Запретить: / feed / Запретить: / комментарии / Запретить: / категория / Запретить: / trackback / Запретить: / feed / Запретить: / комментарии / Disallow: / *? Разрешить: / wp-content / uploads /

2.Что нужно заблокировать в зависимости от конфигурации WP

Вы должны знать, что ваш сайт WordPress использует теги или категории для структурирования контента или использует как категории, так и теги или не использует ни один из них. Если вы используете категории, вам необходимо заблокировать архивы тегов от поисковых систем и наоборот. Сначала проверьте базу, просто перейдите в панель администратора > Настройки> Постоянные ссылки.

По умолчанию базой является тег, если поле пустое. Вы должны запретить теги в роботе.txt, как указано ниже:

Disallow: / tag /

Если вы используете категорию, вам необходимо заблокировать категорию в файле robot.txt, как показано ниже:

Disallow: / category /

Если вы используете и категории, и теги, ничего делать в файле robot.txt не нужно.

Если вы не используете ни теги, ни категории, заблокируйте их оба в файле robot. txt, как указано ниже:

txt, как указано ниже:

Disallow: / category / Disallow: / tag /

3. Файлы для отдельной блокировки

В WordPress используются разные файлы для отображения содержимого.Все эти файлы не должны быть доступны для поисковых систем. Так что вы также должны заблокировать их. Различные файлы, в основном используемые для отображения содержимого, — это файлы PHP, файлы JS, файлы INC, файлы CSS.

Вы должны заблокировать их в robot.txt, как указано ниже:

Disallow: /index.php # отдельная директива для основного файла сценария WP Запретить: /*.php$ Запретить: /*.js$ Запретить: /*.inc$ Disallow: /*.css$

Символ «$» соответствует концу строки URL.

Имейте в виду, что не рекомендуется блокировать файлы, которых нет в каталоге загрузок.

4. Что не блокировать

Есть много вещей, которые вы не хотите блокировать, в зависимости от вашего выбора. Здесь я не хочу блокировать изображения из поиска изображений Google, поэтому я должен разрешить это в файле robot.txt, как указано ниже:

Агент пользователя: Googlebot-Image Запретить: Allow: / # Это нестандартное использование этой директивы, но Google предпочитает ее

Вы можете добавить вещи, которые не хотите блокировать, как написано в приведенном выше примере.

Как разблокировать Robots.txt и удалить тег noindex

Устранение неполадок, связанных с индексированием и сканированием: с чего начать

Прежде всего, давайте попробуем сузить проблему. Для этого войдите в Google Search Console. Затем скопируйте и вставьте URL-адрес главной страницы своего веб-сайта в тестер robots.txt и нажмите «Отправить». (На данный момент этот инструмент существует только в старой версии Google Search Console.) Если он «ЗАБЛОКИРОВАН», см. Проблему № 1, если «РАЗРЕШЕН», см. Проблему № 2 ниже.

Проблема №1: домен или URL-адрес заблокированы роботами.txt

Если строка запрета горит красным и вы видите слово «ЗАБЛОКИРОВАНО» в поле в правом нижнем углу, как на скриншоте ниже, виновником является файл robots. txt. Чтобы отменить это, вам потребуется доступ к файлу robots.txt и его редактирование * для своего веб-сайта.

txt. Чтобы отменить это, вам потребуется доступ к файлу robots.txt и его редактирование * для своего веб-сайта.

* Если вы не тот человек, который обычно играет в серверной части вашего веб-сайта, я настоятельно рекомендую вам обратиться к разработчику вашего веб-сайта, ИТ-специалисту или кому-либо еще, кто занимается обслуживанием веб-сайта.

В приведенном выше примере происходят две вещи, одна хорошая и одна плохая, в зависимости от нашего текущего затруднительного положения. Этот URL-адрес, / wp-admin / , намеренно запрещен, поскольку мы не хотим, чтобы серверная часть нашего веб-сайта сканировалась какой-либо из поисковых систем. Это должно остаться.

Однако проблема в строке Disallow: / . Эта строка, или лучше сказать косая черта, блокирует сканирование вашего веб-сайта всеми поисковыми системами… ну, и все это.Итак, чтобы разблокировать robots.txt, эту часть необходимо удалить из файла robots.txt.

Буквально достаточно одного персонажа, чтобы бросить гаечный ключ в вещи. После внесения в файл необходимых изменений верните URL-адрес домашней страницы в тестер robots.txt, чтобы проверить, приветствует ли ваш сайт поисковые системы. Если что-то идет не так, как надо, в поле в правом нижнем углу зеленым цветом будет указано «РАЗРЕШЕНО», и поисковые системы теперь могут начать сканирование сайта.

Это исправление должно успешно разблокировать robots.txt по всему сайту (или, по крайней мере, для любой страницы, которая специально не обозначена как запрещенная, например, с / wp-admin / URL-адресом выше), но не стесняйтесь копировать и вставлять пару дополнительных страниц сайта в инструмент тестера, чтобы убедиться, что проблема были разрешены не только для вашей домашней страницы.

Если вы хотите узнать больше об этой конкретной марке ботов, ознакомьтесь с полным руководством по Robots.txt на Yoast.com.

Проблема № 2: Удаление метатега «noindex» в WordPress.

Если проблема не в том, что беспокоит ваш веб-сайт, поскольку во всем, что происходит «РАЗРЕШЕНО» (как и должно быть), есть еще одна распространенная причина, по которой ваш веб-сайт WordPress не отображаться в поиске — надоедливый тег noindex.

Чтобы проверить, так ли это, вернитесь к новой версии Search Console, вставьте любой URL-адрес в поле поиска «Проверить любой URL-адрес в…» вверху страницы и нажмите Enter.

Если в отчете о проверке URL отображается следующее сообщение: Нет: в метатеге robots обнаружен «noindex» , это единственный флажок в серверной части WordPress, который вызывает всю эту шумиху.

Чтобы разблокировать поисковые системы от индексации вашего веб-сайта, выполните следующие действия:

- Войдите в WordPress

- Перейдите в «Настройки» → «Чтение»

- Прокрутите страницу вниз до места, где написано «Видимость для поисковых систем».

- Снимите флажок рядом с чтобы «Не рекомендовать поисковым системам индексировать этот сайт»

- Нажмите кнопку «Сохранить изменения» ниже

Если вы используете плагин Yoast SEO — WordPress, также проверьте настройки сообщений в блоге, чтобы убедиться, что они установлены аналогичным образом. чтобы разрешить индексацию.

Как только это будет завершено, вернитесь в Search Console и повторно отправьте URL-адрес, который вы пробовали ранее. Если ваши настройки настроены правильно, все должно петь другую мелодию. Теперь, когда вы отправляете URL-адрес, в отчете о проверке URL-адресов не должно быть всех предупреждений и сообщений об ошибках, по крайней мере, тех, которые связаны с индексированием и возможностью сканирования, и вы сможете «Запросить индексирование», что, как я полагаю, было вашей целью с самого начала. .

Я надеюсь, что это поможет, но если описанные выше шаги не помогли решить вашу текущую проблему, я рекомендую прочитать эту статью поддержки веб-мастеров Google о «noindex», чтобы узнать больше.

Очевидная, но важная часть SEO — добиться того, чтобы ваш сайт отображался в результатах поиска. Для этого вам необходимо убедиться, что ваш веб-сайт можно сканировать и проиндексировать, что означает удаление тега «noindex» и разблокировку robots.txt из общедоступных частей вашего сайта. Эти настройки необходимы для успеха, поэтому сделайте себе одолжение и не игнорируйте предупреждения Search Console или нестабильное поведение, устраняйте эти проблемы с помощью советов и ресурсов, приведенных выше.

Почему это важно и как его использовать

Повышение узнаваемости вашего сайта за счет хорошего ранжирования на страницах результатов поисковых систем (SERP) — это цель, к которой стоит стремиться.Однако на вашем сайте, вероятно, есть несколько страниц, на которые вы бы предпочли направлять трафик , а не , например, ваша промежуточная зона или повторяющиеся сообщения.

К счастью, на вашем сайте WordPress есть простой способ сделать это. Использование файла robots.txt уведет поисковые системы (и, следовательно, посетителей) от любого контента, который вы хотите скрыть, и даже может помочь усилить ваши усилия по поисковой оптимизации (SEO).

В этом посте мы поможем вам понять, что такое robots.txt и его отношение к SEO вашего сайта. Затем мы покажем вам, как быстро и легко создать и отредактировать этот файл в WordPress с помощью плагина Yoast SEO. Давайте нырнем!

Введение в файл

robots.txtВкратце, robots.txt — это простой текстовый файл, который хранится в основном каталоге веб-сайта. Его функция состоит в том, чтобы давать инструкции сканерам поисковых систем, прежде чем они изучат и проиндексируют страницы вашего веб-сайта.

Чтобы понять robots.txt , вам нужно немного узнать о сканерах поисковых систем. Это программы (или «боты»), которые посещают веб-сайты, чтобы узнать об их содержании. От того, как сканеры индексируют страницы вашего сайта, зависит, попадут ли они в поисковую выдачу (и насколько высоко они ранжируются).

Когда сканер поисковой системы заходит на веб-сайт, первое, что он делает, это проверяет наличие файла robots.txt в основном каталоге сайта. Если он его найдет, он примет к сведению приведенные в нем инструкции и будет следовать им при изучении сайта.

Если файл robots.txt отсутствует, бот просто просканирует и проиндексирует весь сайт (или всю его часть, которую он сможет найти). Это не всегда проблема, но — это ситуаций, в которых это может оказаться вредным для вашего сайта и его SEO.

Почему

robots.txt Имеет значение для SEOОдно из наиболее распространенных применений файла robots.txt — скрытие содержимого веб-сайта от поисковых систем. Это также называется «запретом» ботам сканировать определенные страницы.Есть несколько причин, по которым вы можете захотеть это сделать.

Первая причина — защитить свой рейтинг в поисковой выдаче. Дублированный контент обычно сбивает с толку сканеров поисковых систем, поскольку они не могут указать все копии в результатах поиска и поэтому должны выбирать, какой версии отдать приоритет. Это может привести к тому, что ваш контент будет конкурировать с самим собой за высокие рейтинги, что контрпродуктивно.

Еще одна причина, по которой вы можете захотеть скрыть контент от поисковых систем, — это запретить им отображать разделы вашего веб-сайта, которые вы хотите сохранить конфиденциальными, например, вашу промежуточную область или частные форумы только для членов.Встреча с этими страницами может сбивать с толку пользователей и отвлекать трафик от остальной части вашего сайта.

Помимо запрета ботам исследовать определенные области вашего сайта, вы также можете указать «задержку сканирования» в файле robots.txt . Это предотвратит перегрузку сервера, вызванную загрузкой ботов и сканированием сразу нескольких страниц вашего сайта. Это также может сократить количество ошибок Connection timed out (), что может очень расстроить ваших пользователей.

Как создавать и редактировать

robots.txt в WordPress (за 3 шага)К счастью, плагин Yoast SEO упрощает создание и редактирование файла robots.txt вашего сайта WordPress. Следующие шаги предполагают, что вы уже установили и активировали Yoast SEO на своем сайте.

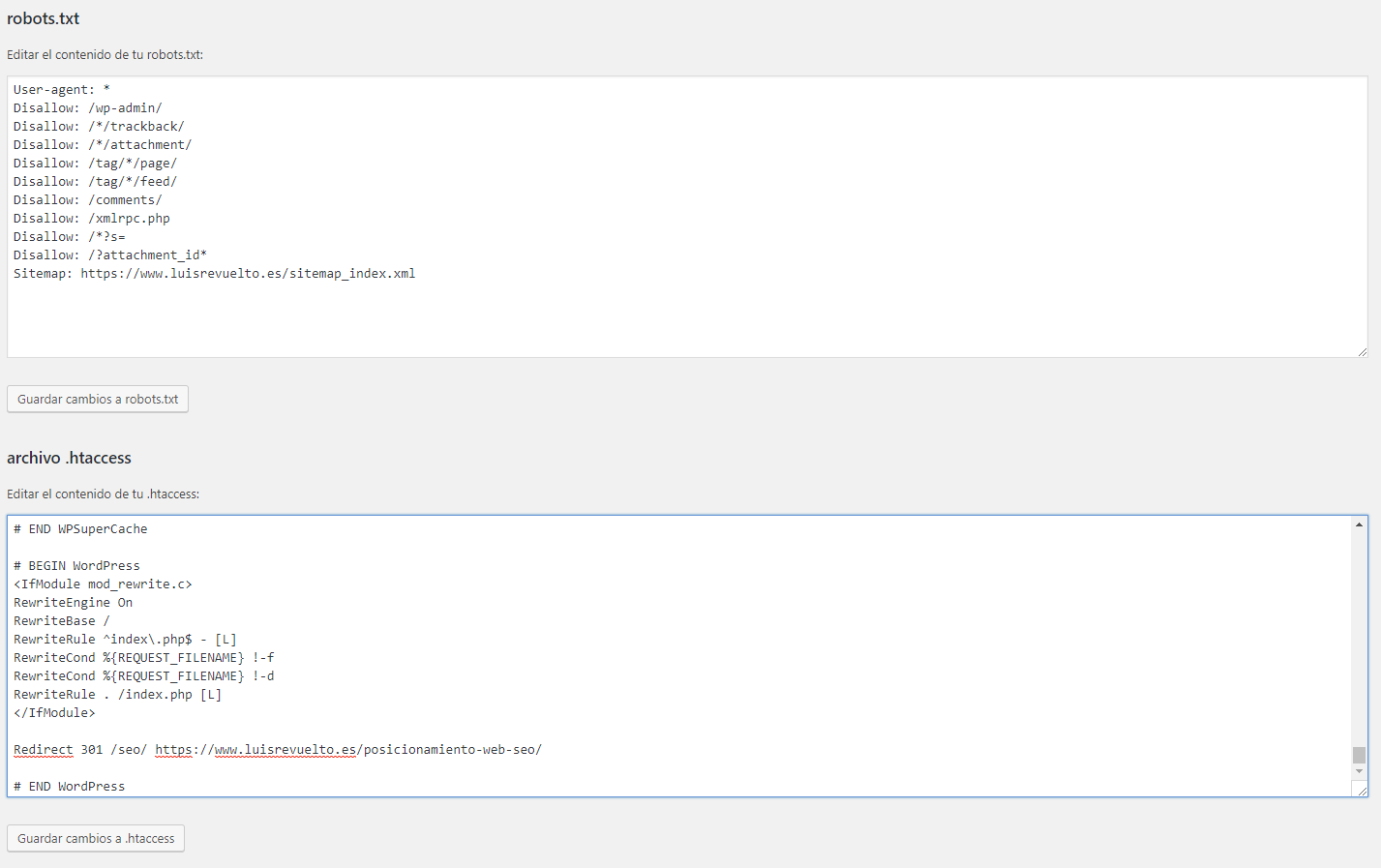

Шаг 1. Доступ к редактору файлов Yoast SEO

Один из способов создать или отредактировать файл robots.txt — использовать инструмент Yoast File Editor. Чтобы получить к нему доступ, посетите панель администратора WordPress и перейдите к Yoast SEO> Инструменты на боковой панели:

На появившемся экране выберите File Editor из списка инструментов:

Если у вас уже есть файл robots.txt , откроется текстовый редактор, в котором вы можете внести в него изменения. Если у вас нет файла robots.txt , вместо него вы увидите эту кнопку:

Нажмите на него, чтобы автоматически создать файл robots.txt и сохранить его в основном каталоге вашего веб-сайта. Такая настройка файла robots.txt дает два преимущества.

Во-первых, вы можете быть уверены, что файл сохранен в нужном месте, что необходимо для того, чтобы сканеры поисковых систем могли его найти.Файл также будет назван правильно, в нижнем регистре. Это важно, поскольку сканеры поисковых систем чувствительны к регистру и не распознают файлы с такими именами, как Robots.txt .

Шаг 2. Отформатируйте файл

robots.txtЧтобы эффективно взаимодействовать со сканерами поисковых систем, вам необходимо убедиться, что ваш файл robots.txt имеет правильный формат. Все файлы robots.txt и содержат «пользовательский агент», а затем «директивы», которым должен следовать этот агент.

Пользовательский агент — это специальный сканер поисковой системы, которому вы хотите дать инструкции. К наиболее распространенным из них относятся: bingbot, googlebot, slurp (Yahoo) и яндекс. Директивы — это инструкции, которым должны следовать сканеры поисковых систем. В этом посте мы уже обсуждали два типа директив: запретить и задержка сканирования .

Директивы — это инструкции, которым должны следовать сканеры поисковых систем. В этом посте мы уже обсуждали два типа директив: запретить и задержка сканирования .