Как настроить Robots.txt для WordPress

robots.txt — это текстовый файл, который используется для того, чтобы запретить роботам (в частности ботам поисковых систем) индексацию и «обход» определенных частей вашего сайта. Без этого файла боты смогут свободно гулять по вашему сайту, что не очень то и хорошо.

По-умолчанию WordPress не создает файл robots.txt, поэтому его необходимо создать самостоятельно и настроить тоже самому.

Общий смысл запрета доступа к определенным частям вашего сайта в том, чтобы сфокусировать внимание роботов на важном контенте.

Что произойдет, если у вас не будет файла robots.txt?

Вкратце, будет индексироваться все подряд.

Для WordPress это означает следующее:

- /cgi-bin

- /wp-admin

- /wp-includes

- /wp-content/themes

- /wp-content/plugins/

Как вы уже, наверное, догадались, ничего из вышеперечисленного не является релевантным контентом для SEO и может даже навредить вашему сайту. Google разрешает только определенное количество «ссылочного мусора», поэтому имеет смысл сконцентрировать усилия на контенте и страницах.

Google разрешает только определенное количество «ссылочного мусора», поэтому имеет смысл сконцентрировать усилия на контенте и страницах.

Как можно контролировать индексацию своего сайта?

Решение очень простое.

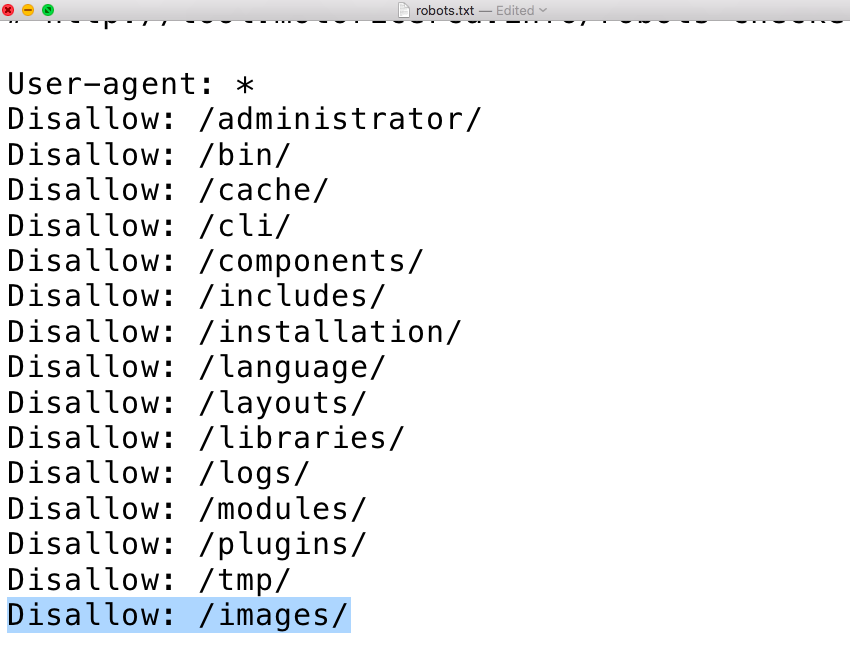

Создайте текстовый файл, используя ваш любимый текстовый редактор, или же, если на хостинге у вас установлена Cpanel, то создайте новый файл в файловом менеджере и назовите его robots.txt.

Скопируйте и вставьте в него следующее:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/themes Disallow: /wp-content/plugins/ Allow: /wp-content/uploads Allow: /feed*

Сохраните файл. Если же вы создали его вне сервера, то просто загрузите в корневую директорию сайта. Это та же директория, где расположены папки wp-admin, wp-includes и wp-content.

Вот и все. Теперь вы заметите, что некоторые ссылки сайта станут выпадать из поиска в течение нескольких дней или даже недель.

Если вы захотите добавить другие файлы, просто добавьте правило вроде этого:

Allow: /путь_к/папке

Обратите внимание, что мы пропускаем домен сайта, а добавляем путь к папке начиная с прямого слеша (/).

За несколько лет работы с WordPress мы собрали для себя оптимальный «набор» правил для robots.txt. Ниже приводим его содержание. Его можно взять за основу, однако стоит разобраться что именно вы закроете от индексации. Некоторые вебмастера предпочитают закрывать рубрики и теги, другие же — наоборот, оставляют открытыми для ботов.

# All User-agent: * Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /page* Disallow: /page Disallow: /author/* Disallow: /20* Disallow: /feed Disallow: /*/feed Disallow: */comme Disallow: */feednt-page-* Disallow: */trackback Disallow: /trackback Disallow: /*?* Disallow: /*? Disallow: /*.php$ Disallow: /*.js$ Disallow: /*.inc$ Disallow: /*.css$ Disallow: /search/*/feed Disallow: /search/*/* Disallow: /tag/ Disallow: */*?replytocom* Disallow: */*/feed/*/ Disallow: */feed Allow: /wp-content/uploads/ Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Google Image User-agent: Googlebot-Image Disallow: Allow: /* # Google AdSense User-agent: Mediapartners-Google* Disallow: Allow: /* # Yandex User-agent: Yandex Host: site.ru Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: /cgi-bin Disallow: /page* Disallow: /page Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /20* Disallow: /feed Disallow: /author/* Disallow: */comme Disallow: */feednt-page-* Disallow: */trackback Disallow: /trackback Disallow: /*?* Disallow: /*? Disallow: /*. php$ Disallow: /*.js$ Disallow: /*.inc$ Disallow: /*.css$ Disallow: /search/*/feed Disallow: /search/*/* Disallow: /tag/ Disallow: */*?replytocom* Disallow: */*/feed/*/ Disallow: */feed Allow: /wp-content/uploads/ Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # YandexBlog User-agent: YandexBlog Disallow: Allow: /*

Rating: 5.0/5 (3 votes cast)

Как правильно настроить robots.txt для блога на WordPress

Сегодня расскажем о первичных настройках для продвижения блога на WordPress.

Итак, когда ваш блог WordPress впервые выходит в свет, то его сразу начинают сканировать поисковые роботы. Как вы думаете с чего они начинают?

Первым делом в корневой директории поисковики ищут файл robots.txt

Они же роботы — вот и файл для них так назван 🙂

В файле robots.txt мы можем написать поисковым роботам некий план обхода нашего сайта.

Мы можем явно сказать какие директории смотреть и какие исключать из индексации.

С первым пунктом понятно, а вот со вторым у новичков возникают вопросы.

Зачем намеренно исключать страницы и целые папки из индексации?

Вопрос справедливый и понятный. Давайте разбираться по порядку.

Дело в том, что при индексации поисковики стараются отбирать уникальные страницы, чтобы давать им больший приоритет, поскольку любая уникальная информация более ценная, чем бесконечно дублируемая, верно?

Все CMS, включая и WordPress, так или иначе дублируют часть контента.

Например интересующий нас движок для блоггеров дублирует начало каждого последнего поста (обычно до 10 шт) на стартовой странице, а также на каждой странице категорий, тегов, поиска и т. д.

Для того чтобы поисковики индексировали то что хотим мы, нам и нужно разобраться с файлом robots.txt.

Итак, вот основные особенности моего видения Грамотного Блога и правильной настройки под него файла robots. txt с целью защиты от дублирования контента.

txt с целью защиты от дублирования контента.

Морду блога делаем статичной и продвигаем своими запросами

Обязательно посвящаем ее раздаче чумовой бесплатности за подписку.

Сами статьи блога (посты) при этом уходят на вложенную страницу и создают как раз дублирование мета-тегов, а именно: заголовок, описание главной страницы и ее ключевые слова.

Кроме того, страница с последними постами блога создает дублирование контента за счет того, что выводит весь текст последних постов до тега more (благодаря этому тегу избегается дублирование контента на 100%).

А вот страницы категорий, в свою очередь, снова дублируют контент постов, но уже ориентируясь на количество символов и исключая форматирование и картинки. Это, кстати, тоже дает более низкий процент дублирования.

В обычной ситуации, когда стартовая страница динамична и выводит последние посты блога, страницы категорий закрывают в файле robots.txt

Чтобы избежать дублирования, нам выгодней в случае со статичной стартовой страницей блога закрыть именно страницу с перечнем последних постов.

Так мы уберем дублирование названия стартовой страницы, его описания и ключевых слов в сравнении со страницей перечня постов.

А несколько страниц по категориям при этом могут преспокойно себе индексироваться, т.к. у каждой из них есть свое описание с индивидуальными ключами. Это более выгодно для продвижения той же главной страницы.

Тем не менее, бывают случаи, когда выгодно закрыть некоторые из категорий с целью избежания дублирования.

Как добавить robots.txt в WordPress без использования плагина

WordPress в настоящее время является одним из самых популярных решений CMS, большинство блогов и веб-сайтов используют его. Это, в частности, очень дружественная к SEO платформа, которую вы можете использовать для достижения больших результатов в любое время в любой день. Вот краткие советы о том, как вы можете легко добавить лучшую конфигурацию / настройки robots.txt на свой веб-сайт или блог cms на базе wp.

Это одна из наиболее игнорируемых частей большинством пользователей wp, которые только что возлагали надежду на тот факт, что WordPress является почти идеальным решением CMS, которое работает с дружественными для поисковых систем показателями и, как таковое, не нуждается в какой-либо форме. SEO-настройки для лучшего обслуживания. Это своего рода менталитет, который я изначально лелеял, когда начинал на платформе wp, пока не наткнулся на настройки robots.txt старого mashable.com, которые подняли мое личное любопытство на идеальные настройки wordpress robots.txt . После поиска до 2013 года я понял, что не существует такой вещи, как идеальной конфигурации robots.txt для любого веб-сайта вообще , независимо от платформы, на которой он построен, поскольку каждый веб-сайт необходимо настраивать индивидуально в зависимости от того, как мы хотим, чтобы они индексировались поисковыми системами. . Добавление рабочего файла robots.txt в любой блог/веб-сайт, в том числе на платформе WordPress, значительно улучшит производительность сайта в любой популярной поисковой системе, поскольку вы будете давать поисковым системам инструкции о том, как индексировать блог/веб-сайт. для моего мнения по этому поводу я авторитетно объясню это как один из тех WordPress SEO настройки производительности , которые вы не хотели бы пропустить.

SEO-настройки для лучшего обслуживания. Это своего рода менталитет, который я изначально лелеял, когда начинал на платформе wp, пока не наткнулся на настройки robots.txt старого mashable.com, которые подняли мое личное любопытство на идеальные настройки wordpress robots.txt . После поиска до 2013 года я понял, что не существует такой вещи, как идеальной конфигурации robots.txt для любого веб-сайта вообще , независимо от платформы, на которой он построен, поскольку каждый веб-сайт необходимо настраивать индивидуально в зависимости от того, как мы хотим, чтобы они индексировались поисковыми системами. . Добавление рабочего файла robots.txt в любой блог/веб-сайт, в том числе на платформе WordPress, значительно улучшит производительность сайта в любой популярной поисковой системе, поскольку вы будете давать поисковым системам инструкции о том, как индексировать блог/веб-сайт. для моего мнения по этому поводу я авторитетно объясню это как один из тех WordPress SEO настройки производительности , которые вы не хотели бы пропустить.

Как добавить настройки/конфигурацию robots.txt в блог/веб-сайт WordPress:

Это очень легко реализовать любому, не имеет значения, являетесь ли вы новичком в wordpress или пользователем pr0-wp, все, что вам нужно сделать, это этот;

- открыть пустой блокнот

- скопируйте и вставьте в него эту простую конфигурацию robots.txt, имея в виду, что каждый сайт должен быть настроен индивидуально в зависимости от того, как вы хотите, чтобы они индексировались в поисковых системах

вот текстовые конфиги, которые нужно скопировать для блога wordpress

User-agent: IRLbot Задержка сканирования: 3600 Агент пользователя: Alexibot Запретить: / Пользовательский агент: Aqua_Products Запретить: / Агент пользователя: asterias Запретить: / Пользовательский агент: b2w/0.1 Запретить: / Агент пользователя: BackDoorBot/1.0 Запретить: / Пользовательский агент: BlowFish/1.0 Запретить: / User-agent: Инструмент поиска по закладкам Запретить: / Агент пользователя: BotALot Запретить: / Агент пользователя: BotRightHere Запретить: / Агент пользователя: BuiltBotTough Запретить: / Пользовательский агент: Bullseye/1.введите URL своего мобильного сайта [агент пользователя: Googlebot-Mobile0 Запретить: / Агент пользователя: BunnySlippers Запретить: / Агент пользователя: CheeseBot Запретить: / Агент пользователя: CherryPicker Запретить: / Агент пользователя: CherryPickerElite/1.0 Запретить: / Агент пользователя: CherryPickerSE/1.0 Запретить: / Агент пользователя: Copernic Запретить: / Агент пользователя: CopyRightCheck Запретить: / Пользовательский агент: космос Запретить: / Агент пользователя: Crescent Internet ToolPak HTTP OLE Control v.1.0 Запретить: / Агент пользователя: Полумесяц Запретить: / Агент пользователя: DittoSpyder Запретить: / Агент пользователя: EmailCollector Запретить: / Агент пользователя: EmailSiphon Запретить: / Агент пользователя: EmailWolf Запретить: / Агент пользователя: EroCrawler Запретить: / Агент пользователя: ExtractorPro Запретить: / Агент пользователя: Клиент FairAd Запретить: / Агент пользователя: Flaming AttackBot Запретить: / Агент пользователя: Foobot Запретить: / Агент пользователя: Gaisbot Запретить: / Агент пользователя: GetRight/4. 2 Запретить: / Агент пользователя: Harvest/1.5 Запретить: / Агент пользователя: hloader Запретить: / Пользовательский агент: httplib Запретить: / Пользовательский агент: HTTrack 3.0 Запретить: / Агент пользователя: Humanlinks Запретить: / Агент пользователя: InfoNaviRobot Запретить: / Агент пользователя: Iron33/1.0.2 Запретить: / Агент пользователя: JennyBot Запретить: / Агент пользователя: Kenjin Spider Запретить: / Пользовательский агент: Плотность ключевого слова/0,9Запретить: / Агент пользователя: larbin Запретить: / Агент пользователя: LexiBot Запретить: / Агент пользователя: libWeb/clsHTTP Запретить: / Агент пользователя: LinkextractorPro Запретить: / Агент пользователя: LinkScan/8.1a Unix Запретить: / Агент пользователя: LinkWalker Запретить: / Агент пользователя: LNSpiderguy Запретить: / Пользовательский агент: lwp-тривиальный/1.34 Запретить: / Пользовательский агент: lwp-тривиальный Запретить: / Агент пользователя: Мата Хари Запретить: / Агент пользователя: Microsoft URL Control — 5. 01.4511 Запретить: / Агент пользователя: Microsoft URL Control — 6.00.8169Запретить: / Агент пользователя: Microsoft URL Control Запретить: / Агент пользователя: MIIxpc/4.2 Запретить: / Агент пользователя: MIIxpc Запретить: / Агент пользователя: Мистер PiX Запретить: / Пользовательский агент: moget/2.1 Запретить: / Агент пользователя: moget Запретить: / Агент пользователя: Mozilla/4.0 (совместимый; BullsEye; Windows 95) Запретить: / Агент пользователя: MSIECrawler Запретить: / Агент пользователя: NetAnts Запретить: / Агент пользователя: NICErsPRO Запретить: / Агент пользователя: Offline Explorer Запретить: / Агент пользователя: Openbot Запретить: / Пользовательский агент: сборщик данных Openfind Запретить: / Агент пользователя: Openfind Запретить: / Агент пользователя: Oracle Ultra Search Запретить: / Агент пользователя: PerMan Запретить: / Агент пользователя: ProPowerBot/2.14 Запретить: / Агент пользователя: ProWebWalker Запретить: / Агент пользователя: psbot Запретить: / Пользовательский агент: Python-urllib Запретить: / Пользовательский агент: Метапоиск QueryN Запретить: / Агент пользователя: Radiation Retriever 1.

1 Запретить: / Агент пользователя: RepoMonkey Bait & Tackle/v1.01 Запретить: / Агент пользователя: RepoMonkey Запретить: / Агент пользователя: RMA Запретить: / Агент пользователя: searchpreview Запретить: / Агент пользователя: SiteSnagger Запретить: / Агент пользователя: SpankBot Запретить: / Агент пользователя: гаечный ключ Запретить: / Агент пользователя: suzuran Запретить: / Агент пользователя: Szukacz/1.4 Запретить: / Агент пользователя: Телепорт Запретить: / Агент пользователя: TeleportPro Запретить: / Агент пользователя: Телесофт Запретить: / Пользовательский агент: Интраформант Запретить: / Агент пользователя: TheNomad Запретить: / Агент пользователя: TightTwatBot Запретить: / Агент пользователя: toCrawl/UrlDispatcher Запретить: / Агент пользователя: True_Robot/1.0 Запретить: / Агент пользователя: True_Robot Запретить: / Агент пользователя: turingos Запретить: / Агент пользователя: TurnitinBot/1.

5 Запретить: / Агент пользователя: TurnitinBot Запретить: / Пользовательский агент: контроль URL Запретить: / Агент пользователя: URL_Spider_Pro Запретить: / Пользовательский агент: Предупреждение URLy Запретить: / Агент пользователя: VCI WebViewer VCI WebViewer Win32 Запретить: / Агент пользователя: VCI Запретить: / Пользовательский агент: сборщик веб-изображений Запретить: / Агент пользователя: WebAuto Запретить: / Агент пользователя: WebBandit/3.50 Запретить: / Агент пользователя: WebBandit Запретить: / Агент пользователя: WebCapture 2.0 Запретить: / Пользовательский агент: WebCopier v.2.2 Запретить: / Агент пользователя: WebCopier v3.2a Запретить: / Агент пользователя: WebCopier Запретить: / Агент пользователя: WebEnhancer Запретить: / Агент пользователя: WebSauger Запретить: / Пользователь-агент: Веб-сайт Quester Запретить: / Агент пользователя: Webster Pro Запретить: / Агент пользователя: WebStripper Запретить: / Агент пользователя: WebZip/4.

0 Запретить: / Агент пользователя: WebZIP/4.21 Запретить: / Агент пользователя: WebZIP/5.0 Запретить: / Агент пользователя: WebZip Запретить: / Пользовательский агент: Wget/1.5.3 Запретить: / Пользовательский агент: Wget/1.6 Запретить: / Агент пользователя: Wget Запретить: / Агент пользователя: wget Запретить: / Агент пользователя: WWW-Коллектор-E Запретить: / Пользовательский агент: Xenu's Link Sleuth 1.1c Запретить: / Агент пользователя: Xenu's Запретить: / Агент пользователя: Зевс 32297 Вебстер Про V2.9 Win32 Запретить: / Агент пользователя: Zeus Link Scout Запретить: / Агент пользователя: Зевс Запретить: / Агент пользователя: Adsbot-Google Запретить: Агент пользователя: Googlebot Запретить: Агент пользователя: Mediapartners-Google Запретить: Пользовательский агент: * Запретить: /cgi-bin/ Запретить: /wp-admin/ Запретить: /wp-includes/ Запретить: /wp-content/plugins/ Запретить: /wp-content/cache/ Запретить: /wp-content/themes/ Запретить: /wp-login.

php Запретить: /wp-register.php Запретить: /кормить/ Запретить: /комментарии/ Запретить: /автор/ Запретить: /архив/ Запретить: /20* Запретить: /трекбэк/ Карта сайта: http://myblogurl.com/index.xml

Разрешить: /] после последнего / здесь, если он отличается от URL вашего родительского блога. например, [Агент пользователя: Googlebot-Mobile

Разрешить: /] изменен на [Агент пользователя: Googlebot-Mobile

Разрешить: /?mobile], используя мой в качестве примера.

вы можете удалить строки, где у вас есть;

Запретить: /archives/

Запретить: /author/

Запретить: /feed/

Запретить: /20*

Запретить: /images*

Если вы хотите, чтобы они были проиндексированы поисковыми системами, они были добавлены в для предотвращения дублирования содержимого в результатах поиска . Для других, которые хотят, чтобы поисковые системы индексировали только их темы сообщений и содержание, вы можете добавить другие строки в свой robots. txt, чтобы предотвратить это, например.

txt, чтобы предотвратить это, например.

Запретить: /tag/

Запретить: /category/

Запретить: /next/

Для тех, у кого нагрузка на сервер страдает, и поэтому они хотят уменьшить скорость или частоту, с которой поисковая система посещает их блог, вы можете настроить это строки

User-agent: IRLbot

Crawl-delay: 3600

с любой цифрой по вашему выбору в секундах. Обратите внимание, что 3600 равно 1 часу, поэтому вы можете просто использовать этот формат, чтобы либо уменьшить частоту, либо увеличить ее до дней, недель, месяцев и т. д., в зависимости от того, как часто обновляется ваш блог.

вот текстовые конфиги, которые нужно скопировать для веб-сайта WordPress CMS:

Агент пользователя: IRLbot Задержка сканирования: 3600 Пользовательский агент: * Запретить: /cgi-bin/ Запретить: /wp-admin/ Запретить: /wp-includes/ Запретить: /wp-content/plugins/ Запретить: /wp-content/themes/ Запретить: /wp-content/cache/ Запретить: /wp-login.настроить соответственно после предыдущих упоминаний выше. Также обратите внимание, что вы можете загружать свои изображения в две папки для сайтов, на которых есть частные изображения, и те, которые должны быть проиндексированы, добавляя папку, содержащую частные изображения, в список запрещенных.php Запретить: /wp-register.php Карта сайта: http://mywbsiteurl.com/index.xml

- Сохраните содержимое блокнота как robots.txt

- войдите в свою панель управления и найдите файловый менеджер ==> загрузите содержимое блокнота в корневой каталог, где у вас установлен wordpress

- закройте и наслаждайтесь новыми активными настройками robots.txt

Не забудьте заменить карту сайта: http://myblogurl.com/index.xml на текущую ссылку на карту сайта вашего блога/веб-сайта.

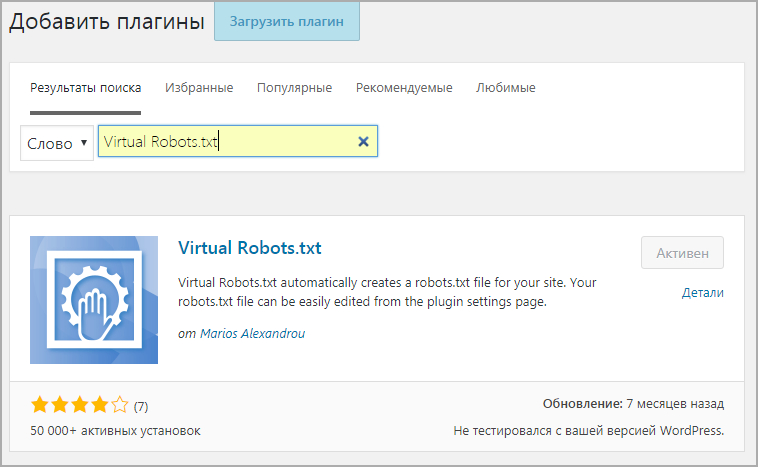

Если у вас нет доступа к вашей cpanel и вы хотите добавить настройки robots.txt в свой блог или веб-сайт WordPress CMS с помощью плагина WordPress, вы можете легко сделать это, посетив репозиторий плагинов WordPress для WP Robots. Txt , который дает вам суперпривилегию добавлять и редактировать конфигурацию wp robots.txt с панели администратора WordPress.

Txt , который дает вам суперпривилегию добавлять и редактировать конфигурацию wp robots.txt с панели администратора WordPress.

См. также:

- Зачем пропускать установку этих 7 наиболее важных плагинов WordPress? и

- Как добавить числовую нумерацию страниц в тему Mobilepress по умолчанию

Как редактировать robots.txt в WordPress с плагином Yoast

Содержание

Основной элемент (h3)Подэлемент 1 (h4)Подпункт 2 (h5)Подпункт 3 (H5)

Подпункт 4 (H6) )

Не знаете, что такое robots.txt и что он делает для вашего сайта? Вам действительно нужно знать, что это такое и как его использовать? В этой статье мы поговорим о том, что такое robots.txt и как установить robots.txt на WordPress с бесплатным плагином, таким как Yoast SEO, или без него.

Первое, что я должен сказать, это то, что по умолчанию WordPress автоматически создает файл robots.txt по умолчанию для вашего сайта. Поэтому, даже если вы и пальцем не пошевелите, на вашем сайте уже должен быть файл WordPress robots. txt.

txt.

Но, если вы это знали, вы, вероятно, здесь, потому что хотите узнать больше или добавить больше функций (инструкций) в этот файл.

С этой целью…

…Вы новичок в robots.txt и чувствуете себя совершенно потерянным?

Возможно, кто-то из вашей команды поручил вам позаботиться о чем-то в файле robots.txt, например, «Убедиться, что то-то и то-то добавлено/заблокировано в robots.txt».

В любом случае, я притворюсь, что вы ничего не знаете о robots.txt, и быстро расскажу вам все, что вам нужно знать, чтобы начать работу с этим важным текстовым файлом.

Прежде чем мы начнем, я должен сказать, что эта статья охватывает большинство установок WordPress (которые находятся в корне домена). В редких случаях, когда у вас установлен WordPress во вложенной папке или поддомене, способ и место установки robots.txt может отличаться от описанного ниже. Тем не менее, эти же принципы и ключевые идеи по-прежнему применимы.

Что такое robots. txt?

txt? Вы, наверное, знаете, что существуют поисковые роботы, которые посещают сайты и, возможно, индексируют данные, найденные на этих сайтах. Их еще называют роботами. Это любой тип бота, который посещает и сканирует веб-сайты в Интернете. Наиболее распространенным типом роботов являются боты поисковых систем или сканеры поисковых систем, такие как Google, Bing и т. Д. Они сканируют страницы и помогают поисковым системам индексировать страницы и ранжировать их в поисковой выдаче.

Говорят, что по прибытии на сайт одним из первых файлов, которые поисковые роботы должны искать, является файл robots.txt.

Файл robots.txt — это простой текстовый файл, который содержит инструкции для сканеров поисковых систем и веб-сканеров. Он был создан в середине 90-х из-за желания контролировать взаимодействие роботов со страницами. Это позволяет владельцам веб-сайтов и веб-разработчикам контролировать взаимодействие роботов с сайтом. Вы можете запретить роботам доступ к определенным областям вашего сайта, показать им, где можно получить доступ к вашей карте сайта, или вызвать задержку при сканировании вашего сайта.

Таким образом, если есть некоторые разделы вашего сайта, которые вы не хотите сканировать, файл robots.txt может дать указание постоянным агентам пользователя не посещать эти папки.

Некоторые краулеры были разработаны для злонамеренных целей, и эти краулеры могут не соблюдать стандарты, установленные Протоколом исключения роботов.

Тем не менее, если у вас есть конфиденциальная информация об определенной части вашего сайта, вы можете принять дополнительные меры для ограничения доступа к этим данным, например, установить систему паролей.

Где находится файл robots.txt?Для большинства установок WordPress файл robots.txt находится в корневом домене. То есть для большинства сайтов WordPress (которые устанавливаются в корневой каталог домена) файл robots.txt можно найти в /robots.txt.

Так, например, этот сайт (seointel.com) имеет установку WordPress в корне своего домена. Итак, его файл robots.txt можно найти по адресу /robots. txt (https://seointel.com/robots.txt)

txt (https://seointel.com/robots.txt)

Если у вас нет файла robots.txt или если у вас есть файл WordPress по умолчанию, поисковые роботы могут сканировать все страницы вашего веб-сайта, и они не будут знать, какие области им не следует сканировать. Это должно быть хорошо для тех, кто только начинает вести блог или сайты, на которых мало контента. Однако для сайтов с большим количеством контента и сайтов, обрабатывающих личную информацию, потребуется файл robots.txt.

Для сайтов с большим объемом контента рекомендуется настроить файл robots.txt, в котором указывается, какие сайты не сканировать. Почему? Это связано с тем, что боты поисковых систем обычно имеют квоту сканирования, скорость сканирования или бюджет сканирования для каждого веб-сайта. Боты могут сканировать только определенное количество страниц за сканирование, и если они не закончат сканирование всех ваших страниц, они возобновят их сканирование в следующих сеансах сканирования. Это означает, что для больших сайтов сканирование сайта может быть медленнее и привести к более медленному индексированию нового или обновленного контента. Эту проблему можно решить, запретив сканерам сканировать несущественные страницы вашего сайта, такие как страницы администратора, файлы плагинов и папку тем.

Это означает, что для больших сайтов сканирование сайта может быть медленнее и привести к более медленному индексированию нового или обновленного контента. Эту проблему можно решить, запретив сканерам сканировать несущественные страницы вашего сайта, такие как страницы администратора, файлы плагинов и папку тем.

Сделав это, вы сможете оптимизировать свой сайт и убедиться, что роботы сканируют только важные страницы вашего сайта, а новые страницы сканируются и индексируются как можно быстрее.

Бывают также случаи, когда невозможно избежать дублирования контента на сайте. Некоторые предпочитают добавлять страницу в robots.txt, чтобы дубликаты страниц не сканировались.

Другой случай, когда на вашем сайте наблюдается высокий трафик ботов, который может повлиять на использование вашего сервера или его производительность. Вы можете запретить определенным ботам сканировать ваш сайт или установить задержку сканирования. Это помогает улучшить производительность вашего сайта.

Добавление карты сайта в файл robot.txt также помогает боту Google находить вашу карту сайта и сканировать страницы на вашем сайте, хотя это часто больше не добавляется, поскольку карты сайта можно настроить в Google Search Console.

Команды robots.txtФайл robots.txt содержит две основные команды. User-agent и директива disallow.

- User-agent это то, что боты используют для идентификации себя, и эта команда позволяет нацеливаться на определенных ботов.

- Команда Disallow запрещает роботам доступ к определенной области вашего сайта.

Помимо этих двух общих команд, есть также команда Разрешить , которая говорит сама за себя и по умолчанию все на вашем сайте помечено как Разрешить, поэтому ее не обязательно использовать. Однако ее можно использовать, когда Вы запрещаете доступ к родительской папке, но разрешаете доступ к подпапкам или дочерней папке.

Существуют также команды для Crawl-delay и Карта сайта .

Также бывают случаи, когда вы не хотите, чтобы страница индексировалась, и лучшим решением может быть не просто запрет в текстовом файле robots. Команда Disallow отличается от тега noindex . Хотя команда disallow блокирует сканирование сайта поисковыми роботами, она не обязательно останавливает индексацию страницы. Если вы хотите, чтобы страница не индексировалась и не отображалась в результатах поиска, лучше всего использовать тег noindex.

robots.txt ПримерыВозможно, лучший пример — это ваш собственный пример. Поскольку вы читаете это, вероятно, у вас есть сайт на WordPress. Перейдите к реальному файлу robots.txt этого сайта — добавьте /robots.txt к своему корневому домену. (Если у вас еще нет сайта WordPress, просто следуйте приведенным ниже примерам.)

Что вы видите?

robots.txt Пример №1: Пустой файл robots. txt

txt Вы можете увидеть пустой файл или пустой файл, что не очень хорошо, но технически в этом нет ничего плохого. Это просто означает, что поисковые роботы могут идти туда, куда они могут.

robots.txt Пример #2: Простой файл robots.txt User-agent: *

Allow: /

Таким образом, инструкция robots.txt работает так, что есть веб-краулер или выноска user-agent (это может быть для всех пользовательских агентов или специально названных), за которым в следующей строке следует определенная инструкция (обычно либо разрешить, либо запретить определенные папки или файлы).

Звездочка (*) подразумевает все, то есть все пользовательские агенты, а косая черта (/) означает домен. Таким образом, эти две строки кода фактически говорят: «Все пользовательские агенты разрешены везде в этом домене».

Хотите верьте, хотите нет, но это имеет точно такие же последствия, как и пустой файл robots.txt, и часто является файлом robots. txt по умолчанию.

txt по умолчанию.

Давайте рассмотрим немного более сложный…

robots.txt Пример №3: Все боты запрещены для wp-admin User-agent: *

Disallow: /wp-admin/

звездочка (*) означает всех ботов/краулеров/юзер-агентов.

Папка wp-admin запрещена.

Итак, это выноска (инструкция) не дает поисковикам и прочим ботам сканировать и проходить через папку wp-admin. (Это понятно, потому что папка wp-admin обычно является безопасной областью установки WordPress, предназначенной только для входа.)

robots.txt Пример № 4: Возможно, самый практичный пример: защита ваших платных областей от индексацииЕсли у вас есть платная область доступа, страница загрузки или личные файлы, которые не защищены паролем, страницу загрузки может посетить кто-то, использующий браузер Chrome, что, как я подозреваю, предупредит робота Googlebot, сказав: «Эй, этот человек оставил свою платную область широко открытой».

Затем может появиться робот Googlebot и по незнанию проиндексировать ваш платный раздел.

Вероятность того, что кто-то найдет вашу зону платного доступа с помощью поиска Google, невелика… если, возможно, они не знакомы с операторами поисковых систем и не знают, что искать.

robots.txt Пример #5: Все боты запрещены для wp-admin, определенные боты запрещены полностью / User-agent: NCBot

Disallow: /

Ранее мы знали, что всем ботам приказано не проходить через папку wp-admin. Но у нас также есть дополнительные инструкции для поля user-agent — Exabot и user-agent NCBot.

Это означает, что вы ограничиваете доступ бота к этим двум конкретным пользовательским агентам.

Обратите внимание, что для Exabot и NCBot, несмотря на то, что инструкции запрета идентичны, они по-прежнему связаны с любой из двух.

И обратите внимание на пустую строку после инструкции (запретить) для всех юзер-агентов, пустую строку после инструкции (запретить) для Exabot и, предположительно, пустую строку после инструкции (запретить) для NCBot.

Это потому, что в правилах для robots.txt указано, что если у вас есть инструкция для определенных пользовательских агентов, то эти пользовательские агенты должны иметь свою собственную выноску (иметь конкретное имя), а в следующей строке (строках) перечислить инструкции для этого пользовательского агента.

Другими словами, вы не можете группировать определенные пользовательские агенты или вообще назначать инструкции группе определенных пользовательских агентов. Вы можете использовать звездочку (*) для вызова всех пользовательских агентов, но в противном случае вы не можете сгруппировать определенные пользовательские агенты без использования приведенного выше примера callout-next-line-instruction.

Таким образом, в основном должна быть пустая строка после последней инструкции для одного (или всех) пользовательских агентов, за которой следует вызов другого пользовательского агента (за которым следует инструкция на следующей строке).

robots.txt Пример №6: Все пользовательские агенты, несколько инструкций wp-snapshotsDisallow: /trackback

Таким образом, все пользовательские агенты запрещены в wp-admin, за исключением того, что им разрешено сканировать определенный файл в wp-admin (admin-ajax. php) и запрещено с любого URL-адреса, который начинается с корня с wp-моментальными снимками или обратной связью.

php) и запрещено с любого URL-адреса, который начинается с корня с wp-моментальными снимками или обратной связью.

Агент пользователя: *

Запретить: /wp-admin/

Разрешить: /wp-admin/admin-ajax.php

Запретить: /wp-snapshots

Запретить: /trackback

Карта сайта: https://example .org/sitemap.xml

Карта сайта: https://example.org/sitemap.rss

Этот пример является продолжением примера, использованного в предыдущем примере, с двумя добавленными строками, сообщающими поисковым ботам (или веб-сканерам) путь к файлам карт сайта RSS и XML.

С robots.txt можно сделать немного больше, но я думаю, что этих примеров достаточно для начала работы.

Как установить (или отредактировать) файл robots.txt на сайте WordPress Итак, как я упоминал ранее, на вашем сайте WP уже может быть файл robots. txt, который был добавлен во время установки (просто проверьте yoursite. com/robots.txt).

txt, который был добавлен во время установки (просто проверьте yoursite. com/robots.txt).

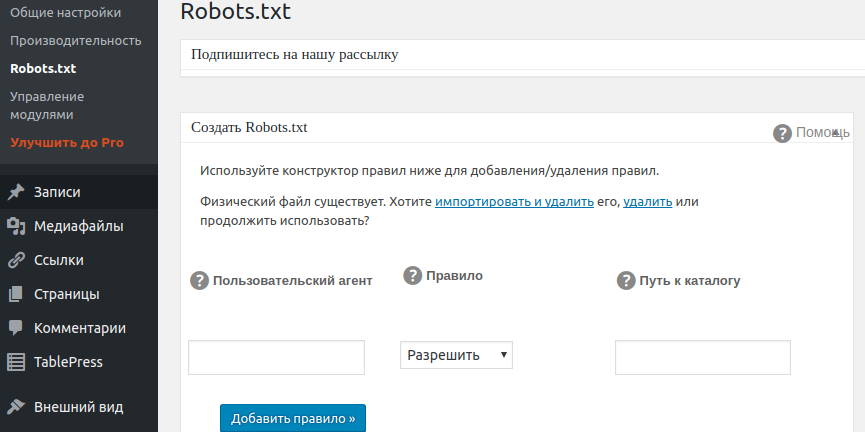

Тем не менее, вы можете настроить его или добавить некоторые функции. Как правило, есть 2 способа установить (или отредактировать) файл robots.txt в установке WordPress — один с использованием плагина, а другой без использования плагина:

- Возможно, проще всего использовать плагин (который можно получить бесплатно). Первый вариант, который приходит на ум, — это бесплатная версия плагина Yoast SEO, который представляет собой мощный инструмент SEO, который вы можете установить на свой сайт. Некоторые другие плагины инструментов SEO, такие как All In One SEO (AISEO), также могут редактировать (или добавлять) файл robots.txt. Есть много полезных инструментов, которые вы можете использовать, чтобы помочь вам в этом.

- Если вы не хотите использовать SEO-плагины, вы можете вручную создать физический файл для вашего файла robots.txt через систему управления файлами вашего хоста или сервера.

(Это может быть cPanel, FTP-клиент или другой вариант, предоставленный вашим хостом.)

(Это может быть cPanel, FTP-клиент или другой вариант, предоставленный вашим хостом.)

- Во-первых, определитесь, какой плагин вы хотите установить. В этом случае мы предположим, что вы хотите установить Yoast SEO.

- Войдите в свою область wp-admin или wp-login.

- Перейдите в раздел Плагины > Добавить новый.

- Вы должны увидеть окно поиска, в которое можно ввести название подключаемого модуля (или ключевые слова, относящиеся к определенным функциям). Введите Yoast SEO, затем нажмите Enter.

- Затем вы увидите страницу результатов. Нажмите на результат, который вы хотите установить.

- После установки нажмите Активировать.

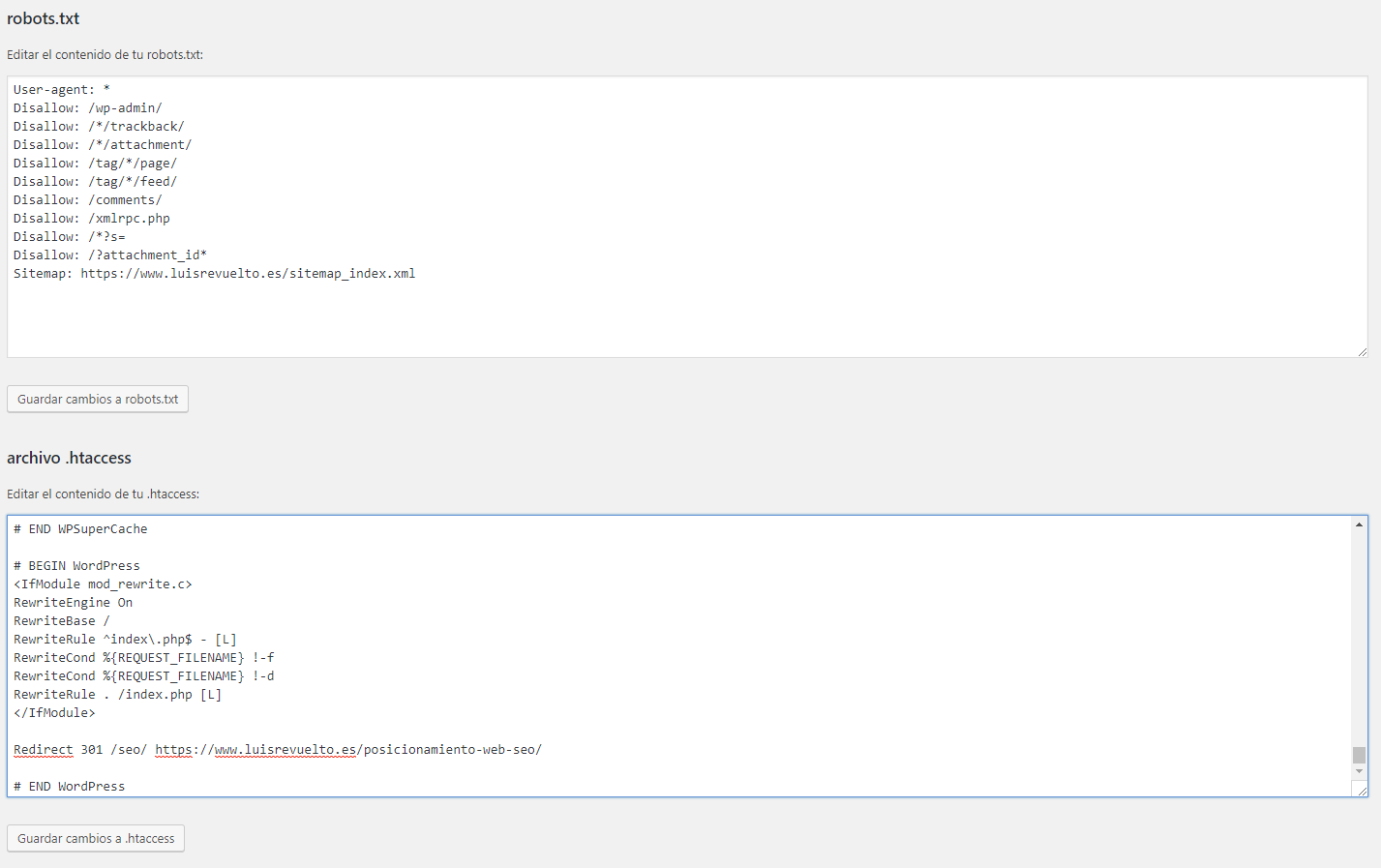

Теперь, когда у вас установлен Yoast SEO, вот шаги, которые вы можете предпринять, чтобы отредактировать или установить файл robots. txt. (Примечание: если Yoast изменился с тех пор, как я пишу это, некоторые из приведенных ниже шагов могут быть другими, но я полагаю, что Yoast SEO по-прежнему будет иметь функцию robots.txt.)

txt. (Примечание: если Yoast изменился с тех пор, как я пишу это, некоторые из приведенных ниже шагов могут быть другими, но я полагаю, что Yoast SEO по-прежнему будет иметь функцию robots.txt.)

Шаг 1: Узнайте, какие изменения вас г хотел бы сделать

Это понятно: вы хотите изменить/отредактировать (или добавить) файл robots.txt с определенными инструкциями. Обязательно узнайте, что это такое.

Шаг 2: Важно! Сделайте резервную копию файла robots.txt (если он есть)

Это просто: просто перейдите к файлу robots.txt (site.com/robots.txt) и сохраните его в ваш компьютер, нажав Ctrl + S (или любую другую комбинацию на клавиатуре для сохранения файла).

Конечно, это делается на случай ошибки.

Шаг 3: Войдите на свой сайт WordPress.

Шаг 4: Нажмите SEO в левой части панели инструментов. (См. изображение ниже.)

Шаг 5: Нажмите «Инструменты» в настройках SEO.

Шаг 6: Включите редактирование файла и нажмите на редактор файлов.

Этот параметр не будет отображаться, если он отключен.

Шаг 7. Внесите изменения в файл robots.txt.

Вы можете сделать это, следуя приведенным выше примерам или используя любые другие конкретные инструкции, которые вы хотите использовать.

Шаг 8: Сохраните эти изменения.

Так и должно быть! Перейдите к разделу ниже, посвященному проверке и тестированию файла robots.txt.

Как отредактировать (или добавить) файл robots.txt через FTP, cPanel или систему управления файлами вашего хоста/сервераПомните, что при установке WordPress, вероятно, создал виртуальный файл robots.txt. Ищите это, когда заходите в папки своего сайта.

Шаг 1. Убедитесь, что вы знаете, какие изменения вы хотели бы внести или что вы хотите в файле robots.txt.

Шаг 2. Важно! Сделайте резервную копию файла robots. txt. Просто перейдите к файлу robots.txt (site.com/robots.txt) и сохраните его на свой компьютер. Сделав это, если позже вы совершите ошибку, у вас будет предыдущая версия, к которой можно вернуться.

txt. Просто перейдите к файлу robots.txt (site.com/robots.txt) и сохраните его на свой компьютер. Сделав это, если позже вы совершите ошибку, у вас будет предыдущая версия, к которой можно вернуться.

Шаг 3. Используя протокол передачи файлов (FTP), файл cPanel или другое решение для управления файлами, войдите в корень своего домена (корневую папку) и отредактируйте (или создайте) файл robots.txt.

(В качестве альтернативы вы можете просто использовать текстовый редактор для создания текстового файла на локальном компьютере, вставить нужные инструкции, сохранить его как robots.txt, а затем загрузить.)

Сохраните этот файл под именем: robots.txt

Шаг 3. Если вы создали этот файл robots.txt на своем компьютере, загрузите его в корень домена.

Шаг 4. Убедитесь, что файл robots.txt существует. Вы можете сделать это, перейдя на yoursite.com/robots.txt

Проверка, тестирование или проверка вашего файла robots.txt Когда дело доходит до кодирования, здесь нет места ошибкам, иначе роботы победили не выполнять инструкции, которые вы хотите.

Вот почему вам нужно подтвердить или проверить ваш файл.

Вы можете просто выполнить поиск в Google для проверки или проверки robots.txt. Доступен ряд бесплатных опций.

Добавление инструкций в файл robots.txtЧтобы добавить инструкции в файл robots.txt, выполните описанные выше действия (с помощью подключаемого модуля или FTP).

Не забудьте выполнить окончательный тестКогда все будет готово, проведите окончательный тест с помощью валидатора или средства проверки robots.txt.

Чувствуете себя лучше при работе с WordPress robots.txt?В начале этой статьи я спросил, не чувствуете ли вы себя потерянным из-за файла robots.txt на сайтах WordPress. Надеюсь, вам стало немного понятнее. Помните: robots.txt — это всего лишь простой текстовый файл, который сообщает поисковым ботам (агентам пользователя), куда они могут и не должны идти.

Хотя robots.txt, вероятно, уже находится в вашей установке WordPress, вы можете редактировать его с помощью плагина WordPress (например, Yoast SEO) или через систему управления файлами вашего хоста, и я надеюсь, что, несмотря на мою статью, у вас есть лучшее представление о том, как сделать это на вашем сайте.