Как ускорить индексацию сайта в Яндексе и Google

Что такое индексация сайта поисковыми системами?

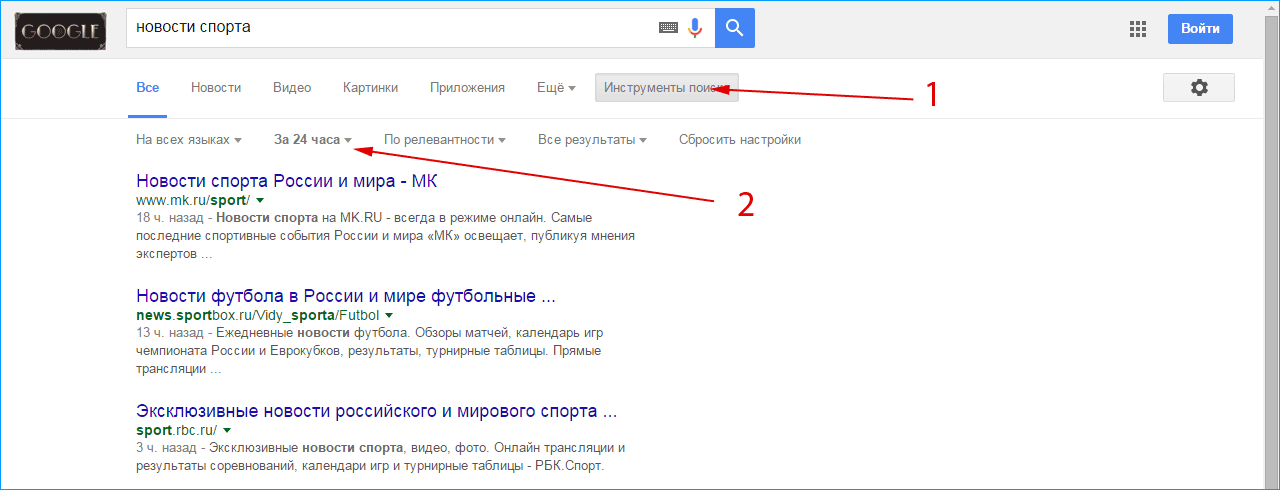

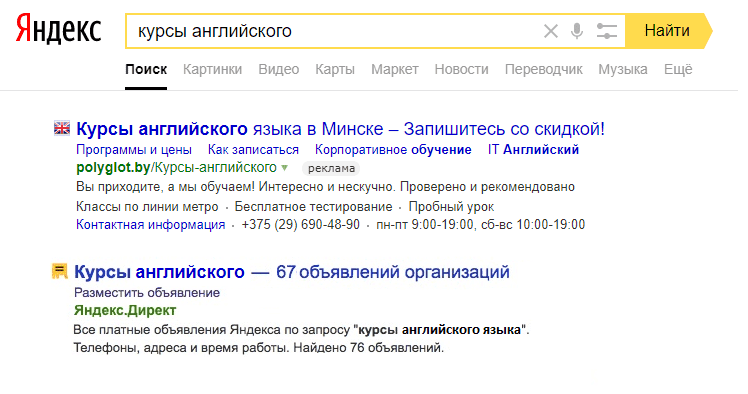

Индексация в поисковых системах – добавление сведений о сайте в базу данных, которая используется при выводе результатов поиска информации. Результаты поиска:

Индексацию выполняет робот поисковой машины.

Для чего необходимо ускорить индексацию сайта в Яндексе и Google

Увеличение скорости индексации защищает сайт от воровства статей. Проблема возникнет, когда текст опубликуют на ресурсе, который индексируется быстрее. Из-за этого пользователи чаще увидят информацию оттуда, а поисковая система решит, что все остальные копии — заимствование текста.

Скорость индексации важна при торговле ссылками и для увеличения трафика. Чем быстрее пройдет индексация, тем раньше на страницу будут выходить системы поиска.

Обычно страницы попадают в индекс с запозданием в 3-15 дней. Понятно, что для новостных и событийных ресурсов это – огромная проблема. Часто Вас интересуют новости двухнедельной давности?

Часто Вас интересуют новости двухнедельной давности?

От скорости индексации косвенно зависит позиция сайта в списке результатов поиска и количество посетителей ресурса.

Скорость загрузки сайта и его аптайм также влияет на индексацию — мы предлагаем скоростной и надежный виртуальный хостинг и VPS SSD хостинг в России.

Особенности ускоренной индексации сайтов поисковыми системами

Существуют отличия в процессе индексации сайтов разными поисковыми системами. Обычно получается, что Google индексирует новую страницу раньше, чем Yandex.

Индексация Гуглом занимает 2 или 3 суток. Страница попадает в индекс и становится доступной для пользователей.

Чтобы увидеть, в какую сторону развивать сайт для его быстрой индексации гуглом – достаточно посмотреть результаты поиска за последние 24 часа по Вашей тематике.

Индексация Яндексом происходит иначе. Страницы попадают в индекс при обновлении поисковой выдачи. Есть система «быстробот», с помощью которой страница может оказаться в поисковой выдаче буквально в течение дня.

Если это произошло, то можно не ждать обновления выдачи Яндекса.

Способы и советы по ускорению индексации сайта

Есть ряд способов, с помощью которых ускоряют индексацию сайта.

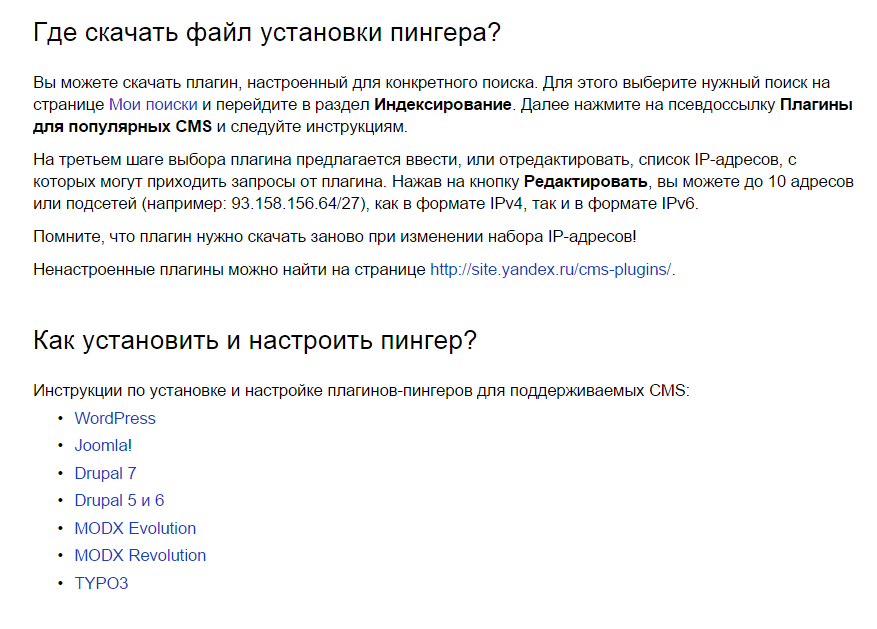

Регистрация в панелях для Вебмастеров поисковых систем

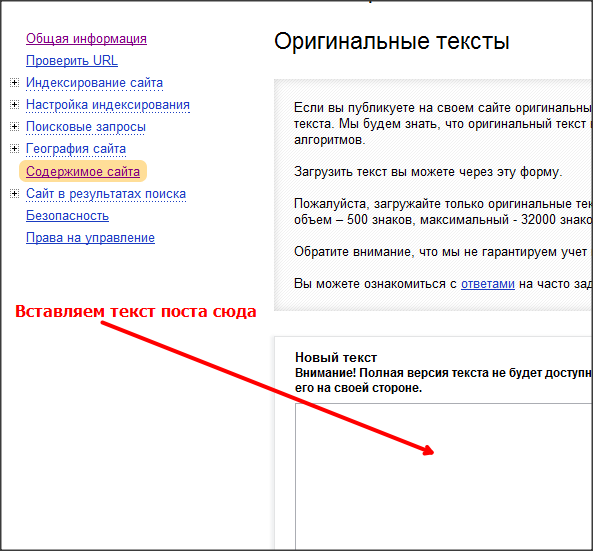

Специальные сервисы созданы для ведения истории сайтов – их индексации, анализа ключевых слов и переходов. Добавление сайта в «Яндекс Вебмастер» и «Вебмастер Google» позволяет выполнить много полезных для ускорения индексации действий.

Панели для вебмастеров расположены по адресам https://webmaster.yandex.ru для Яндекса и https://www.google.com/webmasters/tools для Google. Для работы с сервисами Google требуется регистрация Гугл-аккаунта (для Яндекса соответственно – аккаунта в системе Яндекс).

Полезно зарегистрироваться для работы с панелями разных систем поиска – Рамблер, Yahoo, Апорт и других.

Добавление новой страницы в Аддурилки поисковых систем

После опубликования страницы её надо внести в add url поисковых систем. Через некоторое время после этого робот зайдет на новую страницу. Это действие выполнится и автоматически, но через больший промежуток времени.

Через некоторое время после этого робот зайдет на новую страницу. Это действие выполнится и автоматически, но через больший промежуток времени.

Аддурилка Яндекса:

Аддурилка Гугла:

Добавление в add url Яндекса возможно по адресу https://webmaster.yandex.ru/addurl.xml. Для внесения адреса в add url Google надо перейти по ссылке https://www.google.com/webmasters/tools/submit-url.

Внесение страницы в Add Url – единственный рекомендованный Яндексом путь ускорения индексации.

Популярные международные домены COM, NET, BIZ, INFO, ORG — проверка и регистрация.

Создание правильного файла robots.txt

В документ «robots.txt» заносят правила индексации сайта и ссылок. Такой файл возможно сделать самостоятельно, но для этого есть и специальные сервисы.

Готового рецепта тут нет, т.к. в зависимости от используемого движка сайта нужно закрывать «лишние» файлы и папки. Вот пример robots.txt для интернет магазина на OcStore (русская ветка OpenCart)

Готовый файл помещают в корневую папку сайта. После этого файл также проверяется сервисами для вебмастеров.

После этого файл также проверяется сервисами для вебмастеров.

Если, например, не указать параметры сортировки – это может повлечь за собой попадание в индекс сотен и тысяч одинаковых страниц. В итоге поисковая система сочтет их дублями и «выкинет» из индекса все, кроме одной. Шанс, что эта одна и будет максимально отвечать на вопрос пользователя – минимален.

Поэтому найдите для своего движка сайта рекомендуемый robots.txt с пояснениями что и почему закрывается. Очень важно – не добавляйте туда что попало. Например, одна-единственная директива «Disallow /» без указания конкретной страницы запретит к индексации весь сайт. То есть, ни одна страница Вашего сайта не будет показываться в результатах поиска.

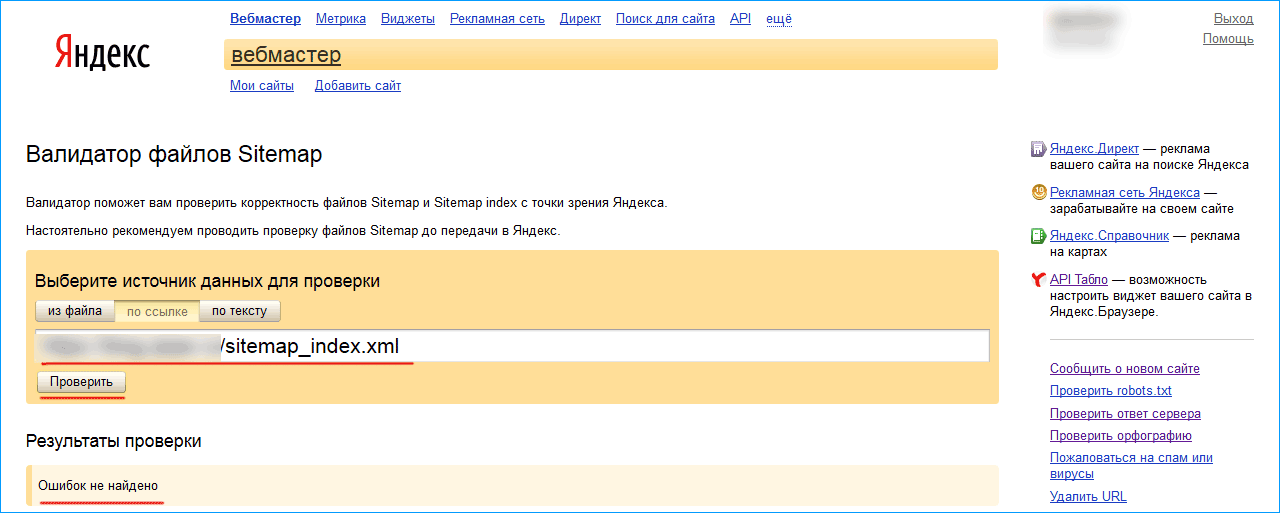

Создание карты сайта в формате sitemap.xml

Файл «Sitemap.xml» создается специально для поисковых систем. В нем содержится список страниц для индексации. Каждую новую статью надо внести в карту sitemap.xml.

Для создания файла подходят онлайн-ресурсы, например, http://www. web-site-map.com/.

web-site-map.com/.

Карта формата xml должна быть проверена на правильность перед загрузкой в инструменты для вебмастеров.

Создание карты сайта в формате html

Карта требуется для всех ресурсов. Хорошо, если на ней обозначены все страницы сайта.

Когда на сайте появилась новая статья, её нужно сразу внести в карту html. Файл создается для индексации и удобства пользователей.

Качество и частота написания уникального контента для сайта

От частоты появления новых статей зависит, как часто робот будет посещать сайт. Регулярное добавление новой информации в разы увеличивает скорость индексации. Считается полезным создание жесткого графика появления новой информации – 1 раз в 3 дня или 2 раза в неделю. Робот будет заходить на сайт по этому расписанию и искать новые статьи.

Поэтому новостные ресурсы публикуют десятки страниц в день – это залог того, что робот поисковых систем будет посещать такой сайт ежедневно. По этим же причинам очень быстро в результатах поиска появляются записи в соцсетях.

Контент низкого качества негативно влияет на индексацию. Не рекомендуется допускать:

- копирования чужих статей;

- публикации текста с большим количеством ошибок;

- добавления статей с высокой плотностью ключевых фраз.

Объем статьи тоже влияет на скорость индексации. Желательно публиковать информацию длиной не менее 1500 символов и уникальностью выше 80 – 90%. Полезно добавить к статье хотя бы одну картинку.

Использование социальных сетей

Публикация ссылок на страницах социальных сетей ускоряет индексацию. Рекомендуется завести аккаунты в нескольких сетях и добавлять там ссылки на новые страницы. После этого роботы поисковых систем обнаружат их гораздо быстрее.

Минимум, который можно и нужно делать – кросспостинг в соцсети. Т.е. материалы сайта размещаются либо полностью, либо частично в социальных сетях.

Поисковые системы следят за появлением новой информации в сервисах социальных закладок – Toodoo, БобрДобр, МоеМесто, Delicious. Для увеличения скорости индексирования страницы можно оставлять там ссылки на неё. Популярность закладок минимальна, но способ еще работает.

Для увеличения скорости индексирования страницы можно оставлять там ссылки на неё. Популярность закладок минимальна, но способ еще работает.

Размещение внешних ссылок на новые статьи сайта

Кроме самостоятельного добавления ссылок из социальных сетей, можно заказывать их. Они быстро индексируются и помогают в этом другим сайтам. Недорого можно заказывать можно ссылки из ЖЖ.

На сегодняшний день зависимость скорости индексации от появления внешних ссылок минимальна. С учетом высокой стоимости таких ссылок на «крутых» сайтах – дешевле ежедневно публиковать свой тематический контент на своем сайте.

Добавление сайта в различные рейтинги

Наличие сайта в каталогах и рейтингах увеличивает его индексацию.

Среди рейтингов известны «Рамблер Топ 100», «Рейтинг LiveInternet», «Рейтинг Mail.ru».

Чтобы поднять авторитет сайта среди поисковых систем, нужно добавить его в каталоги. Бесплатно и сразу попасть в некоторые из них нельзя, но стоит подать заявки в каталоги Mail. ru, ЯК, DMOZ или Rambler.

ru, ЯК, DMOZ или Rambler.

Российские национальные домены со скидкой — RU, SU и РФ.

Перелинковка страниц сайта

Перелинковка сайта улучшает результаты выдачи и ускоряет индексацию. Суть метода – связь всех статей ссылками. Особенно это важно для молодых сайтов.

Пример перелинковки на нашем сайте:

Популярный способ – создание виджета в садбаре последних статей. Наличие ссылки на новую информацию на всех страницах сайта ускоряет скорость реакции робота на появление новой информации на сайте.

Другие способы ускорения индексации

- Создание RSS-трансляции на сайте. Существует способ распространения ссылки на новую страницу по базе сайтов. Для этого подходит программа Pingxpetfree и другие rss-ленты. Рекомендуется создать аккаунт в Feedburner и транслировать записи туда.

- Использование «правила трех кликов». Для улучшения индексации и поведенческих факторов сайта рекомендуется распределить страницы таким образом, чтобы до них было не более трех переходов от главной.

- Анонсирование новых статей. Регулярное анонсирование новых статей в блогах и социальных сетях привлекает на сайт робота. Скорость индексации растет из-за ссылок из Twitter, ВКонтакте, LiveJournal, LiveInternet. Успех применения метода зависит и от популярности страницы в социальной сети или блогплатформе.

- Общение на форумах Сообщения и комментарии на форумах и в блогах подходят для индексации нового сайта. Чтобы использовать этот метод, стоит обратить внимание на популярные и хорошо индексируемые ресурсы. Для привлечения робота к каждой записи использовать такой способ не стоит.

- Добавление кнопок социальных сетей на сайт.

Как видите, существует множество способов ускорить индексацию сайта в Яндексе и гугле, причем часть из них помимо индексации способны привести к Вам на сайт заинтересованную аудиторию.

iPipe – надёжный хостинг-провайдер с опытом работы более 15 лет.

Мы предлагаем:

- Виртуальные серверы с NVMe SSD дисками от 299 руб/мес

- Безлимитный хостинг на SSD дисках от 142 руб/мес

- Выделенные серверы в наличии и под заказ

- Регистрацию доменов в более 350 зонах

Что такое индексация сайта и как проиндексировать свой сайт в поисковых системах?

Что такое индексация и как проходит этот процесс в поисковых системах

Любой сайт — будь то корпоративный блог или магазин в e-commerce — проходит несколько важных этапов «рождения». После создания и первичного наполнения контентом, важно проиндексировать сайт поисковыми системами (далее — ПС). Как это происходит:

-

Роботы ПС «видят», что создан новый сайт (или страница).

-

Планируют его «осмотр».

Запрашивают контент сайта и анализирует его по ряду параметров.

-

Если все соответствует требованиям — сайт/страница попадает в индекс (своего рода «реестр» ПС), и включается в поисковую выдачу.

Когда пользователь вводит в поисковике запрос, сервис сверяет его с проиндексированными данными и выдает максимально релевантные страницы. Но если при индексации сайта были обнаружены проблемы (ошибки, низкая уникальность текстов, и др.) — ПС могут наложить «санкции» и понизить позиции сайта в выдаче. А то и вовсе исключить его из списка рекомендованных в поиске.

Технологии и алгоритмы индексации сайтов в поисковиках

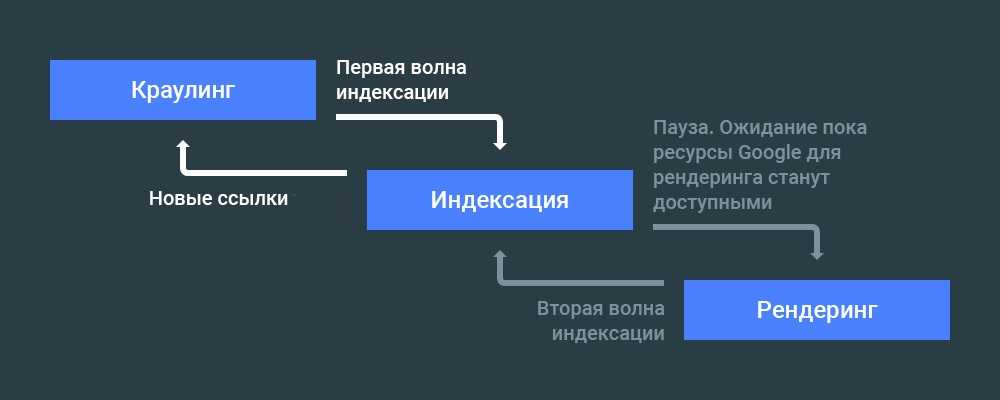

Технология индексации сайта в Google

Google и Яндекс могут проиндексировать сайты по-разному. У Google действует правило

Поэтому если она проигрывает десктопной, содержит ошибки или не обладает полным функционалом — на нее могут быть наложены ограничения.

Поэтому если она проигрывает десктопной, содержит ошибки или не обладает полным функционалом — на нее могут быть наложены ограничения.

На частоту проверки сайта краулерами и на индексацию сайта в Гугл влияет так называемый «краулинговый бюджет»: чем он больше — тем чаще и быстрее проверяют сайт. Считается, что возраст сайта и частота обновления контента положительно влияют на размер «краулингового бюджета».

Технология индексации сайта в Яндекс

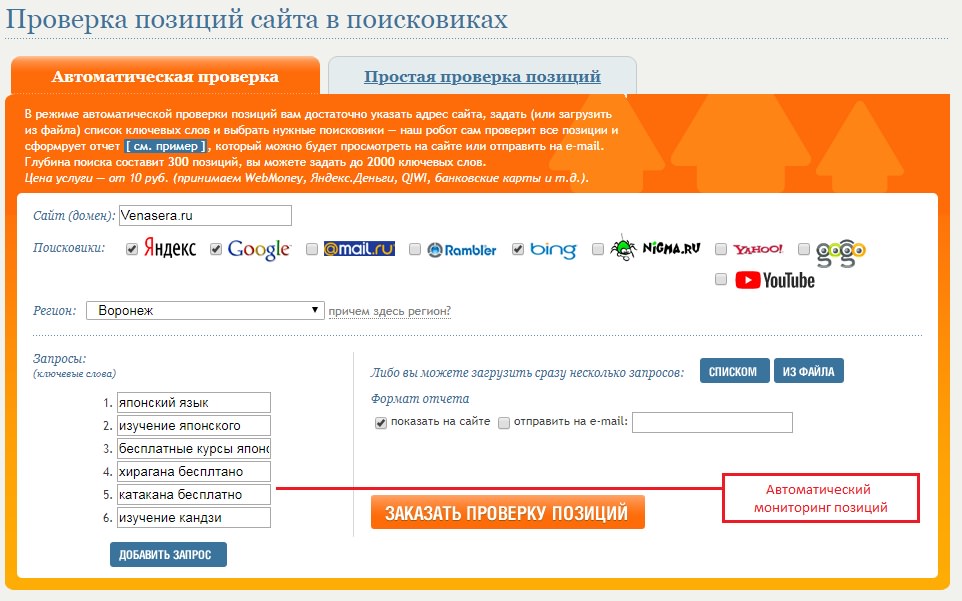

Как проверить индексацию сайта?

Существует несколько способов проверить индексацию страниц вашего сайта:

-

С помощью плагинов проверки (SEO Magic, RDS bar и др.

-

Через специальные сайты-сервисы проверок: Netpeak Spider, Screaming Frog Seo Spider, Se Ranking, arsenkin.ru, serphunt.ru, raskruty.ru и др.

Факторы индексирования и их влияние на поисковые системы

На индексирование страниц и контента вашего сайта влияют несколько факторов:

-

Файл robots.txt. В нем содержатся «подсказки» для краулеров: какие страницы на сайте можно индексировать, а какие — нет. Влияние на индексацию этого файла зависит от типа ПС, но основные — Google и Яндекс, его все же учитывают.

-

Метатег <meta name=“robots” содержит (и при желании — позволяет настроить) команды для поисковых роботов, указывая им как лучше проиндексировать страницы.

-

В серверном программном обеспечении сайта можно добавить в заголовки X-Robots-Tag HTTP-ответы, содержащие настройки, указанные в файлах .

htaccess и httpd.conf. Прописанные в них команды будут выполняться всеми краулерами.

htaccess и httpd.conf. Прописанные в них команды будут выполняться всеми краулерами.

-

Тег <noindex> запрещает индексировать определенный контент — например, текст, при помощи пары тегов <noindex>…</noindex> (работает только для поисковой системы Яндекс).

-

Вывод контента Ajax. Если версия, отображаемая для пользователей, отличается от того, что находится в сохраненной копии, при этом в текстовой версии или коде сохраненной копии отсутствует контент, то это первый признак, что контент страницы может не индексироваться роботами ПС.

Что делать, если сайт не индексируется?

Если ваш интернет-сайт не индексируется продолжительное время — возможно, существуют проблемы с оптимизацией и стоит проверить некоторые аспекты:

1) Не закрыт ли сайт для индексации через:

- файл Robots.txt,

- метатег <meta name=“robots”,

- в файлах .

htaccess и httpd.conf.,

htaccess и httpd.conf., - X-robots-tag.

2) Если в указанных местах доступ не закрыт — стоит проверить, нет ли ошибок в теге rel canonical.

3) Проблемы могут возникать и на хостинге (например, слишком долгое время ответа сервера, или сервер дает неверный ответ на запрос ПС).

4) На сайте содержится неуникальный или контент низкого качества.

И только после проверки всех этих факторов можно искать причины в неверной работе самих ПС. Редко, но иногда сбои происходят именно на стороне поисковиков, но такая информация, как правило, быстро становится общедоступной.

Как ускорить индексацию сайта

Что можно предпринять для более быстрой индексации сайта поисковыми системами? Способов много, перечислим самые очевидные и действенные.

-

Установите автоматическое обновление карты сайта (sitemap). Особенно, если вам нужно быстро проиндексировать страницу в Google — эта ПС обращается к карте в первую очередь, в отличие от Яндекса, которая вначале «смотрит» на файл robots.

-

Тщательно проверьте страницы и размещенный контент. Сайт не должен содержать дубли страниц и контент с низким процентом уникальности. Эти аспекты «воруют» краулинговый бюджет, в результате чего роботы ПС могут просто не добраться до новых страниц, которым нужно индексироваться.

-

Проверьте, нет ли на сайте битых ссылок и каково количество внутренних редиректов. От первых нужно избавиться вовсе, количество вторых — свести к минимуму. Каждый из них также расходует бюджет поисковых роботов.

-

Еще раз проверьте, не закрыты ли добавленные страницы для индексации через robots.txt. Это важно для их дальнейшего продвижения.

-

Проверьте скорость загрузки страниц сайта при помощи PageSpeed Insight. И время ответа сервера, и скорость загрузки отдельных страниц должны быть минимальными (сервис сам измеряет эти показатели и выдаст вам рекомендации по устранению технических недостатков).

-

Проверьте качество внутренней перелинковки. Краулеры «путешествуют» по внутренним ссылкам так же, как и посетители, автоматически ускоряя скорость индексации страниц.

-

Выводите «превью» свежего контента на главную страницу — будь то текстовый материал или карточка с новым товаром. Так ваш контент окажется «на поверхности» сайта и будет быстрее замечен краулерами.

-

Следите за регулярностью обновления контента на сайте. Это относится не только к вновь публикуемым статьям, но и обновлению/корректировке старых.

|

Статью подготовил Сергей Лысенко, ведущий спикер Webcom Academy. |

Поделиться с друзьями:

Индексация сайта в поисковых системах

Привет, Друзья! В этой статье разберём такое понятие, как индексация сайта в поисковых системах и как она проходит в поисковиках Яндекс и Google.

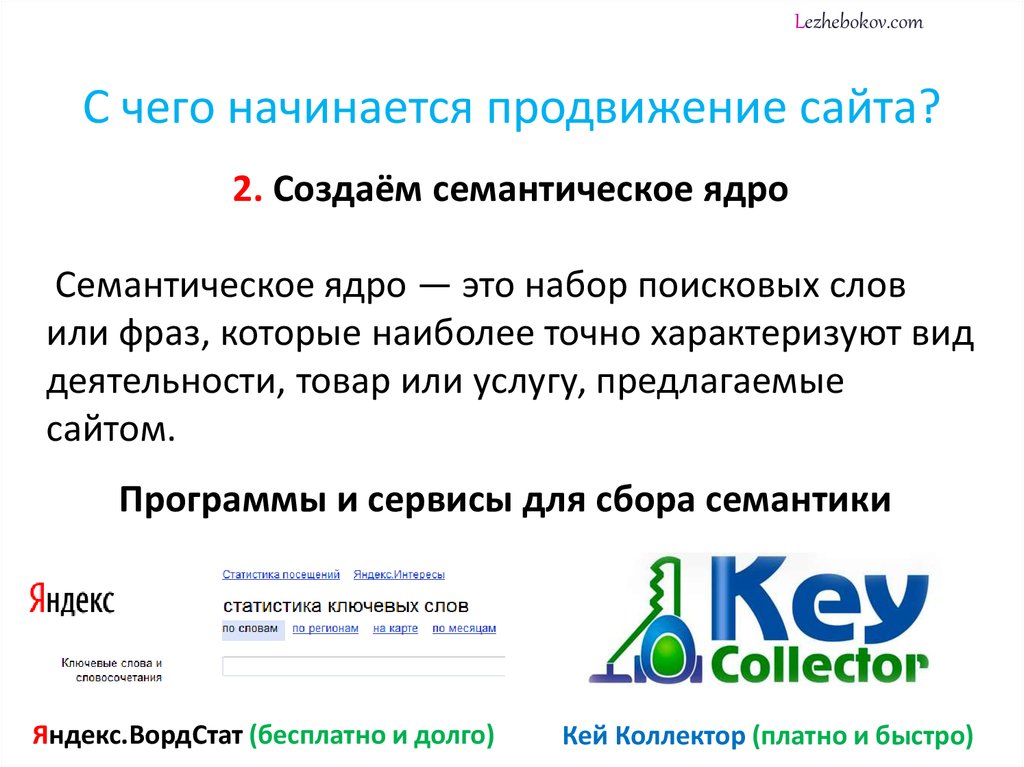

Как происходит индексация сайта поисковыми системами

SEO-продвижение сайта, то есть его раскрутка, привлечение клиентов и покупателей, невозможно без оптимизации. Оптимизация сайта выполняется в несколько шагов. Каждый несовершенно выполненный шаг влияет на общий результат в целом и может привести к замедлению или частичной индексации каждой отдельной страницы сайта.

Индексация сайта — это обработка сайта роботами-поисковиками, то есть программами, сканирующими сайт и заполняющими базы данных поисковиков результатами для поисковых запросов. Если индексация выполнена верно, то пользователь легко найдет нужные страницы сайта.

В противном случае веб-ресурс не будет отображаться в поисковых системах, проще говоря, его не увидят пользователи и не приобретут товар, не воспользуются услугой и так далее.

Как ускорить процесс индексации сайта и продвинуть его в поисковых системах

Одним из способов является добавления созданного веб-ресурса в популярные поисковики, такие как Google и Yandex. Для этого необходимо построить карту сайта и указать файл с ней sitemap.xml в сервисе вебмастеров поисковика. Карта сайта — это список ссылок в формате XML на все страницы, которые содержит сайт.

Для этого необходимо построить карту сайта и указать файл с ней sitemap.xml в сервисе вебмастеров поисковика. Карта сайта — это список ссылок в формате XML на все страницы, которые содержит сайт.

Проиндексировать новый веб-ресурс можно с помощью добавления различных страниц сайта в социальные сети и популярные закладки (twitter.com, vkontakte.ru, bobrdobr.ru, memori.ru и так далее).

Ссылки к страницам индексируемого сайта будет полезно разместить в блоге на livejournal.com, blogs.mail.ru и других популярных блогерских площадках.

Как только на сайте появляются новые страницы, ссылки на них нужно добавлять в блог или соцсеть. Это значительно улучшит индексацию сайта.

Кроме того, можно зарегистрироваться на LiveInternet или Рамблер ТОП100. ТОПы известных каталогов и рейтингов часто посещаются роботами, что также ускоряет индексацию сайта.

Еще один действенный метод улучшить индексацию — комментировать блоги и вставлять ссылки в комментарии. Поисковые роботы часто отслеживают популярные блоги и ответы к записям, но при этом не стоит навязчиво сыпать ссылками, они должны быть уместными и размещаться в специально предназначенных для этого местах, иначе комментарий будет удален как спам за нарушение правил ведения блога.

Поисковые роботы часто отслеживают популярные блоги и ответы к записям, но при этом не стоит навязчиво сыпать ссылками, они должны быть уместными и размещаться в специально предназначенных для этого местах, иначе комментарий будет удален как спам за нарушение правил ведения блога.

По такому же принципу увеличивается индексация через форумы, в них ссылки вставлять разрешается, главное, чтобы они соответствовали теме форума. Чем больше посещаемость такого форума пользователями, тем чаще его сканируют боты.

Сервис Subscribe.ru позволяет сделать рассылку с приглашением перейти по ссылке большому количеству пользователей, что также улучшает индексацию.

Если есть время и ресурсы, можно разместить как можно больше статей, содержащих ссылки. Этот процесс трудоемкий, поскольку нужно много актуальных и интересных текстов, которые пользователи хотели бы посмотреть, но при этом статьи на сторонних сайтах играют роль каталогов ссылок, легко считываемых поисковыми роботами.

Требования к сайту для улучшения индексации

Дабы наиболее эффективно индексировать сайт, его нужно грамотно структурировать. Если внутренние ссылки будут перенаправлять пользователя с одной страницы на другую, то поисковым ботам будет проще работать с таким ресурсом. Поисковый робот передвигается последовательно от страницы к странице.

Если внутренние ссылки будут перенаправлять пользователя с одной страницы на другую, то поисковым ботам будет проще работать с таким ресурсом. Поисковый робот передвигается последовательно от страницы к странице.

На сайтах с большим количеством страниц бот не всегда доходит до крайних страниц и, как следствие, не считывает их, ухудшая индексацию. Избежать этого можно разбив сайт на подразделы, так чтобы страница была удалена от главной не более, чем на три клика. Далее, нужно собрать подразделы, они же ответвления, в древообразную структуру.

Ссылки на отдельные не проиндексированные страницы можно разместить на сторонних ресурсах, так боты не будут пропускать их.

Что касается интернет-магазинов, то у каждого представленного товара или категории товаров должна быть своя страница на веб-ресурсе. На каждой из страниц размещаются ссылки на другие страницы с похожими товарами, что увеличивает скорость индексации всего интернет-магазина.

Для более эффективной индексации нужно, чтобы поисковые боты посещали страницы сайта, для этого необходимо как можно чаще обновлять страницы веб-ресурса и наполнять их уникальными статьями на популярные темы.

Существует метод индексации, при котором ключевые слова или ссылки вписываются в фон сайта одним с ним цветом. Следует помнить, что сайты с неуникальным контентом, а также с так называемыми черными методами продвижения сразу исключаются поисковыми ботами из индексации.

Вместо заключения

Хотите выйти в ТОП10 Яндекс и долго там оставаться? Продвигайте свои сайты и интернет-магазины исключительно белыми SEO методами! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы по SEO обучению, которые я провожу индивидуально, в режиме онлайн по скайпу.

Записаться на SEO обучение

SEO продвижение сайта по России:

Рейтинг моего сайта в Яндекс:

ускорение и проверка индексации сайта в поисковых системах

Индексация сайта – это процесс сканирования Вашего сайта поисковыми роботами (Яндекс, Google, Rambler и др. ) с целью включения их в поисковый индекс. То есть статьи, только что написанная, сразу не попадает в результаты поиска поисковых систем, а появится “там” только после индексации этой самой статьи.

) с целью включения их в поисковый индекс. То есть статьи, только что написанная, сразу не попадает в результаты поиска поисковых систем, а появится “там” только после индексации этой самой статьи.

Для начала, когда Ваш сайт или блог еще новый, Вам нужно, чтобы поисковики проиндексировали сам сайт в целом. Для этого Вы можете воспользоваться уроком, где показывается то, как добавлять блог в Яндекс, Google и другие поисковые системы.

Как запретить индексацию сайта

Сразу хочу отметить, что в некоторых повторяющихся страницах блога нужно запретить индексацию. Для чего? Да все для ради той же любви от поисковиков, которую мы просто обязаны получить. Яндекс, Гугл и др. не любят дублирование страниц. Чтобы закрыть от индексации “ненужные вещи” пользуйтесь robots.txt. Я, к примеру, использую вот такой robots.txt, который меня ни разу не подводил и я полностью доволен им. Если Вы не знаете, что такое robots.txt и куда его “засунуть”, просмотрите вот этот урок.

Как ускорить индексацию сайта

Многие вебмастера ищут и придумывают все более изощренные способы ускорения индексации сайта. Честно, я за этим не гонюсь. Почему? Почему я не хочу увеличить скорость индексации страниц моего блога? Ведь, если статья сразу появляется в результате выдачи поискового запроса, значит ради привлечения дополнительных посетителей выгодно туда попасть? Почему мне это не нужно?

Честно, я за этим не гонюсь. Почему? Почему я не хочу увеличить скорость индексации страниц моего блога? Ведь, если статья сразу появляется в результате выдачи поискового запроса, значит ради привлечения дополнительных посетителей выгодно туда попасть? Почему мне это не нужно?

Ответ прост: мои статьи этого блога индексируются поисковиками в течении нескольких минут! Как? Ответ ниже.

- Если Вы хотите, чтобы статьи индексировались как можно быстрее, просто пишите чаще. Вот примерное поведение поисковой системы: I день: заходит на Ваш поисковый сайт, сканирует его добавляет необходимое в поисковую выдачу, заходит к примеру завтра, опять сканирует, но ничего нового не находит (если не происходило изменений), и следующий раз он уже зайдет к Вам не послезавтра, а где-то а через 3 дня (все сроки условные, постарался объяснить процесс индексации).

Таким образом, можно сделать вывод, что чем чаще обновляется сайт (блог), тем чаще на него заходят поисковые роботы.

- После написании статьи, сразу же, в обязательном порядке, сами же нажимайте на кнопку Retweet своего блога (Как вставить кнопку Retweet?). Таким образом, поисковик “проникнет” на Ваш блог через Twitter и др.

- Если Вы наберете, например, в Яндексе, поисковый запрос “как ускорить индексацию сайта”, Вы прочтете много статей, которые будут советовать Вам добавлять в пункт “Сервисы обновления” новые сервисы, на которые будут идти оповещения, после того, как Вы опубликуете статью.Я тоже раньше этим занимался, добавлял туда более 30 сервисов. Но это дополнительная нагрузка на блог, и, как я заметил, и без этих >30 сервисов, мой блог отлично индексируется. В списках сервисы обновлений у меня всего стандартных 3 сервиса (Вы можете посмотреть это зайдя в админку Настройки –> Написание –> Сервисы обновления):

- Создайте карту сайта с помощью плагина Google XML Sitemaps.

- Также крайне желательно создание “человеческой” карты сайта (тот, что выше – для поисковых роботов), к примеру с помощью плагина Dagon Design Sitemap Generator.

С его помощью Ваша статья будет находится “на глубине” от главной странице не более чем на 2-3 клика, что тоже есть плюс для поисковиков.

С его помощью Ваша статья будет находится “на глубине” от главной странице не более чем на 2-3 клика, что тоже есть плюс для поисковиков. - Поставьте на блог RSS-подписку.

- Грамотно перелинковывайте внутренние страницы. Помните: внутренняя перелинковка необходима блогу, как рыбе вода. Если, конечно же, Вы не хотите, чтобы у Вас было 2-3 читателя.

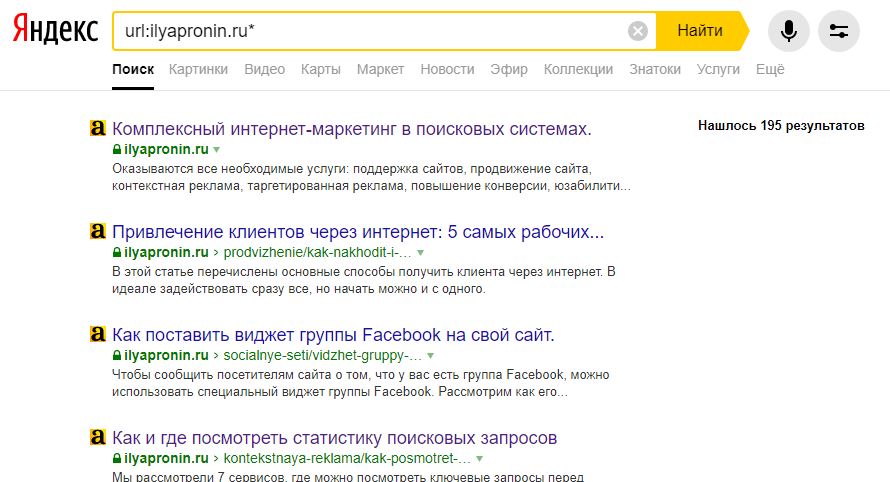

Как проверить индексацию сайта в Яндексе, Google и др. поисковых системах

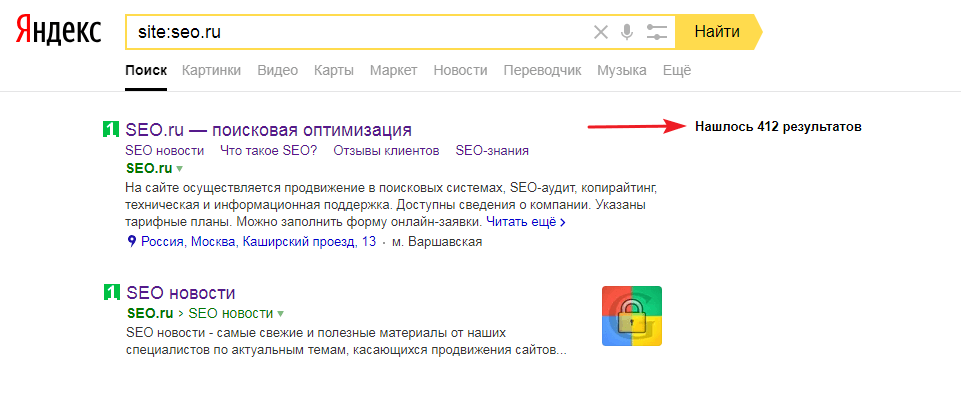

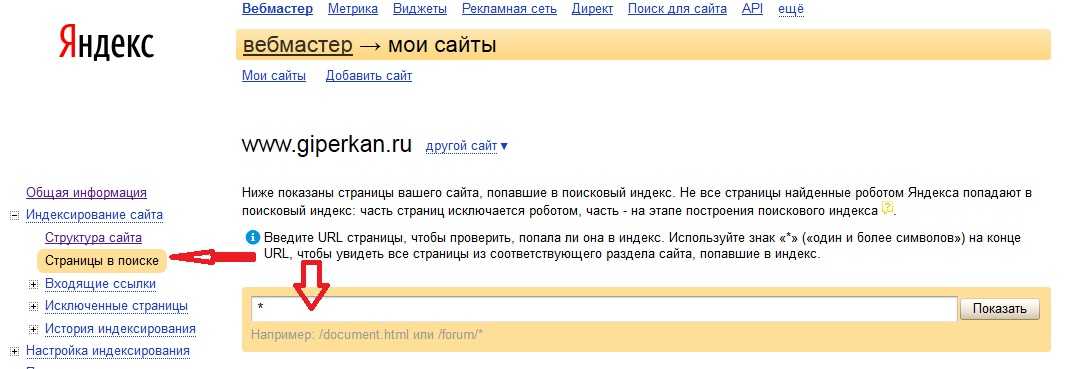

Если Вы хотите просто узнать, сколько страниц у Вас проиндексировано в Яндексе (пример), Вы просто можете зайти на панель вебмастера Яндекса. Там Вы найдете всю необходимую информацию (количество проиндексированных страниц показано в графе “Страниц в поиске”):

Как добавлять блог или сайт в панель вебмастера Яндекса, я писал тут.

Количество проиндексированных статей Вы можете просмотреть с помощью SeoBar для Opera (более подробно о нем здесь):

Также проверить индексацию сайта в Яндексе или др. поисковых систем можно с помощью этого сервиса: http://be1.ru/stat/. В начале вводите адрес сайта:

поисковых систем можно с помощью этого сервиса: http://be1.ru/stat/. В начале вводите адрес сайта:

Здесь Вы можете видеть “кнопочки”, при нажатии на которых, будут показываться проиндексированные страницы:

Кстати, кроме проверки индексации сайта в Гугле, Яндексе и других поисковиках, данный сервис обладает довольно интересным и полезным функционалом. Не поленитесь, уделите полчасика своего внимания, возможно, Вы найдете что-то стоящее для себя.

На сегодня все. До встречи на следующих уроках. Всего доброго!

Рекомендую для чтения: Сможет ли Ваш сайт попасть в Яндекс Каталог?

Проверка индексации страниц сайта в поисковых системах Яндекс и Google в 2022 году

Статья обновлена 12.07.2022

Как проходит индексация сайта

Как только появилась глобальная Cеть, поисковые системы обзавелись фильтрацией результатов запросов. В те времена и появилась индексация сайта по ключевым словам. Проверка индексации страниц сайта делалась просто — чем больше ключей находил на нем поисковик, тем выше был ресурс в выдаче. Для ускорения индексации сайта и его продвижения на топовые позиции достаточно было добавить туда побольше популярных фраз. Такой метод оценки привёл к тому, что на первых строках результатов поиска появлялись совершенно бесполезные страницы, сплошь и рядом заполненные необходимыми словоформами. И это был текст не для клиентов, а для роботов. Ведь живой человек просто закроет такой «продвинутый» сайт и пойдёт искать ресурс, где информация читабельна и понятна.

Для ускорения индексации сайта и его продвижения на топовые позиции достаточно было добавить туда побольше популярных фраз. Такой метод оценки привёл к тому, что на первых строках результатов поиска появлялись совершенно бесполезные страницы, сплошь и рядом заполненные необходимыми словоформами. И это был текст не для клиентов, а для роботов. Ведь живой человек просто закроет такой «продвинутый» сайт и пойдёт искать ресурс, где информация читабельна и понятна.

С тех пор многое изменилось. Поисковые роботы научились оценивать сайты не только по ключевикам, но и по другим параметрам для получения наиболее релевантных данных и ранжирования в выдаче.

Сегодня процесс индексирования сайта состоит из трех этапов: сканирование, анализ и выдача результатов.

- Сканирование: поисковая система запускает программу, называемую «пауком», для поиска контента в Сети.

- Анализ: поисковая система анализирует найденный контент, чтобы определить, о чем он. Затем упорядочивает его.

- Выдача: когда пользователь вводит запрос, поисковая система делает проверку индексации сайта по ключевым словам. Затем на основе этого составляется список результатов индексации, который и отображается на странице результатов поиска.

Так алгоритмы поисковиков составляют индекс и ищут только нужные страницы.

Алгоритм отвечает за то, как проверить индексацию сайта, и анализирует ряд уникальных характеристик каждой индексируемой веб-страницы. Это помогает поисковикам отображать наиболее релевантные страницы в ответ на запрос пользователя.

Мало кто знает реальные алгоритмы поисковых систем. Основной механизм держится в секрете, иначе работа поисковиков может быть парализована. И в ответ на запрос пользователя будут выдаваться результаты, далекие от того, что человек действительно ищет. Поэтому нет волшебных рецептов, как узнать тонкости индексации сайта и как гарантированно вывести страницы на первые места в выдаче.

Главное, что нужно знать: позиция отображения ресурса зависит исключительно от его качества. Для улучшения индексации большинству русскоязычных сайтов достаточно учесть особенности алгоритмов двух основных поисковиков: Google и Яндекс. Рассмотрим самые распространённые вопросы о прохождении индексации.

Для улучшения индексации большинству русскоязычных сайтов достаточно учесть особенности алгоритмов двух основных поисковиков: Google и Яндекс. Рассмотрим самые распространённые вопросы о прохождении индексации.

Как происходит автоматическая проверка

Индексирование — процесс, с помощью которого поисковый робот обнаруживает новые и обновленные страницы для добавления в индекс. Если робот не может просканировать страницу, то проверить индексацию сайта не получится.

Автоматическая индексация сайта в поисковых системах происходит при помощи механизмов, которые самостоятельно находят ресурс и анализируют его контент, релевантность информации, ссылки, трафик, время визитов пользователей и многое другое. Началу прохождения такой проверки способствует наличие ссылок на сайт на других ресурсах.

Проверка уровня индексации вашего сайта в поисковых системах

Проверить индексацию страницы можно:

1. При помощи поисковой строки, добавив к домену сайта символы «site:».

2. Специальными сервисами, например RDS Bar или XSEO.in.

Также проверить индексирование сайта можно встроенными инструментами Яндекс.Вебмастер и Google Search Console. Они помогают провести проверку индексации страницы в Яндексе и Гугле в полуавтоматическом режиме.

- В Google Search Console — это инструмент тестирования URL Inspection Tool. С его помощью можно просмотреть HTML-код целевой страницы и убедиться, что поисковый робот Googlebot может получить доступ к содержанию. Это полезно для тестирования страниц, генерируемых JavaScript, если ваш сайт построен на платформе JS. Инструмент предоставит моментальный снимок того, как отображается страница, и сообщит обо всех ошибках, которые могут отрицательно повлиять на возможность сканирования.

- В Яндекс.Вебмастере есть схожий сервис тестирования «Проверить статус URL». Находится он в меню «Индексирование». Задав нужный сайт, можно увидеть полный отчет по нему — от статуса в поиске до последнего посещения робота.

Сколько времени индексируется новый сайт

Сколько занимает проверка — зависит от поисковой системы. Google является скоростным лидером в данном процессе, управляясь с индексацией примерно за одну неделю. Время индексации в Яндексе может быть больше — до двух-трех недель.

Скорость, с которой поисковик заметит ресурс зависит от множества параметров, поэтому указанные сроки весьма условны. Например, дополнительные страницы уже проиндексированного сайта рассматриваются быстрее.

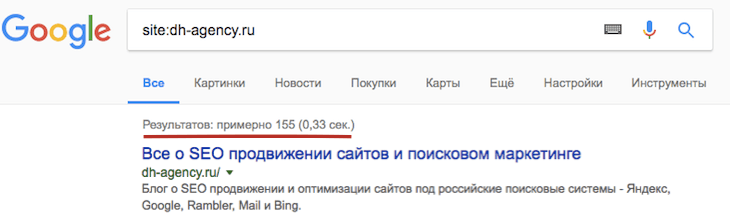

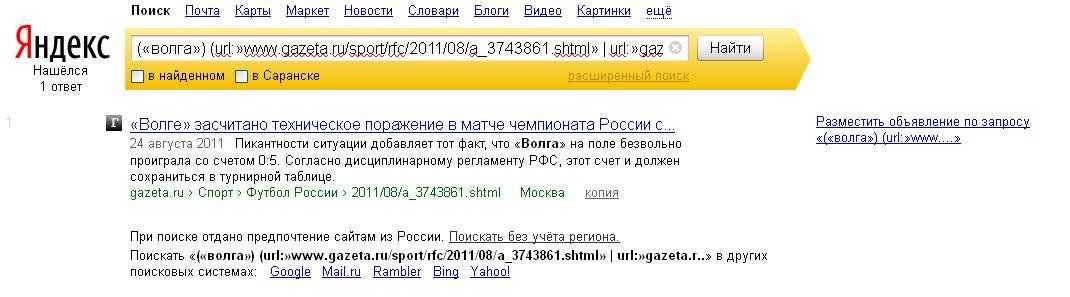

Как проверить количество страниц в индексе

Чтобы узнать, сколько страниц сайта проиндексировано Яндексом, перейдите по ссылке. Для аналогичного мониторинга в Google необходимо ввести в поисковую строку значение site: домен сайта. Например, site:moisait.ru

Что значит переиндексация сайта

Переиндексация — это повторный анализ страниц, который проводят роботы поисковых систем. Как часто происходит данный процесс? Во многом это зависит от регулярности обновлений. Чем чаще на сайте появляется новая информация, тем с большим вниманием поисковик рассматривает ресурс. О прочих лайфхаках для ускорения индексации поговорим далее.

Чем чаще на сайте появляется новая информация, тем с большим вниманием поисковик рассматривает ресурс. О прочих лайфхаках для ускорения индексации поговорим далее.

Как проверить сайт на запрет индексации

При индексации сайта могут возникнуть проблемы, которые требуют оперативного устранения. Это нужно для успешного прохождения проверки и отображения в поиске.

Яндекс.Вебмастер и Search Console содержат разделы, в которых можно посмотреть проблемы, найденные на ресурсе. Например, система может сделать запрет на индексацию страниц за нарушение правил безопасности или за отсутствие подтверждённого домена.

Последствия запрета индексации части сайта отразятся на показах этих страниц. Пользователь просто не увидит их, когда введёт в поисковик целевой запрос.

Как открыть сайт для индексации, скрыв отдельные страницы

Однако иногда часть страниц требуется закрыть от индексации преднамеренно, прописав их в файле robots.txt. Вот для каких страниц это может пригодиться:

- Дублированные страницы.

- Страницы, находящиеся в разработке.

- Технические разделы, которые необходимо скрыть.

Во-первых, запретить индексацию специально можно путём указания имени нужного файла или папки в файле robots.txt:

User-agent: *

Disallow: /folder/file.ph

Disallow: /folder/

Системы не смогут проверить noindex и nofollow, поэтому второй вариант скрытия ненужного контента — это указание данных тегов.

Как запретить индексацию сайта полностью

Иногда требуется полностью удалить сайт из базы данных поисковых систем. Для это необходимо прописать в robots.txt значение:

User-agent: *

Disallow: /

Если же сайт не индексируется, когда нужно, стоит в первую очередь проверить этот же файл. Возможно, во время проведения каких-то работ на ресурсе его временно скрыли от посторонних взглядов. И забыли вернуть все как было.

Индексация Яндекс и Google: что важно учесть

Помимо регистрации в Яндекс.Вебмастер и Search Console необходимо проверить карту сайта — sitemap. xml, а также указать необходимые параметры индексации в файле robots.txt.

xml, а также указать необходимые параметры индексации в файле robots.txt.

По регистрации в системах часто встречаются 2 основных вопроса: индексация сайта в Google, как это сделать вручную, и почему Яндекс не индексирует сайт.

Чтобы ускорить процесс проверки, необходимо внести ресурс в сервис Google Search Console. Остальное система сделает сама.

Яндекс сканирует ресурсы медленнее, чем Google. Для получения заветной отметки в базе данных нужно зарегистрироваться в Яндекс.Вебмастер.

Как ускорить индексацию

Индексирование сайта — это целый ряд процессов, повлиять на которые возможно, улучшив качество ресурса. Как проверить, достаточно ли хорош сайт с точки зрения поисковых роботов и ускорить индексацию сайта в Яндексе и Гугле? Основные 2 правила: проведите индексацию сайта так, чтобы там был качественный контент, и обеспечьте удобство ресурса для пользователей.

Также возьмите на вооружение ниже перечисленные пункты — применив их на практике, вы обеспечите видимость сайта в поисковых системах.

- Публикуйте новости регулярно, так как поисковые боты ценят частое обновление контента.

- Корректно заполните файл sitemap.xml. Перечислите в нем все страницы сайта, чтобы поисковые системы могли их найти.

- Проверьте файл robots.txt. Там не должно быть блокировок поисковых систем от сканирования страниц сайта, в частности тегов noindex и nofollow.

- Включите внутреннюю перелинковку и добавьте внешние ссылки. Ведь индексация ссылок — краеугольный камень SEO.

- Проверьте сайт на так называемые страницы-«сироты». Если на странице нет никаких внутренних ссылок, это затрудняет ее поиск пользователями и роботами.

- Проведите проверку индексации сайта в Яндекс и Гугл с помощью инструментов для веб-мастеров и устраните все выявленные проблемы.

- Проверьте контент сайта и включите в него ключевые слова, по которым необходимо отображаться.

Отдельным пунктом оптимизации для индексирования стоит выделить дубли. Это наиболее частый источник проблем. Дублированный контент — когда на сайте есть несколько страниц с одинаковым или похожим содержанием, не менее 70% совпадений. Когда поисковые системы обнаруживают такой контент, это создает путаницу в отношении того, какую версию страницы индексировать. В конечном итоге поисковая система выбирает вариант, который, по ее мнению, является лучшим. И отфильтровывает остальные. Таким образом 2 похожие страницы на сайте конкурируют между собой за одни и те же поисковые запросы.

Дублированный контент — когда на сайте есть несколько страниц с одинаковым или похожим содержанием, не менее 70% совпадений. Когда поисковые системы обнаруживают такой контент, это создает путаницу в отношении того, какую версию страницы индексировать. В конечном итоге поисковая система выбирает вариант, который, по ее мнению, является лучшим. И отфильтровывает остальные. Таким образом 2 похожие страницы на сайте конкурируют между собой за одни и те же поисковые запросы.

Существует несколько способов решения и предотвращения проблем с дублированным контентом. Вот самые распространенные:

- Тег «rel=canonical» в HTML-коде нужной страницы, чтобы показать, какая версия является предпочтительной.

- Редирект 301 на «вторичной» странице, чтобы перенаправить посетителей на предпочтительную версию.

- Только одна версия сайта — с www либо без www в адресе, но не обе сразу. Использование обеих создает дубликат всего веб-сайта.

- Уникальные URL-адреса, поскольку линки с разными регистрами написания считаются повторяющимся содержимым.

Чтобы найти дублированный контент на своем сайте, можно использовать специальные сервисы, например, Siteliner.

Последнее, на что нужно обратить внимание для ускорения индексации сайта, это протокол передачи данных, который использует сайт. Поисковые системы, особенно Google, стремятся к созданию более безопасного веб-интерфейса для пользователей. Поэтому рекомендуют веб-мастерам использовать шифрование HTTPS вместо привычного протокола передачи данных HTTP. На него можно перейти, установив действующий сертификат безопасности сайта SSL. Для Google это особенно хорошо работает, так как система повышает скорость индексации и рейтинг сайтов, использующих HTTPS. При этом страницы с HTTP помечаются как «небезопасные», чтобы предупреждать пользователей.

Подпишитесь на рассылку ROMI center: Получайте советы и лайфхаки, дайджесты интересных статей и новости об интернет-маркетинге и веб-аналитике:

Вы успешно подписались на рассылку. Адрес почты:

Адрес почты:

Читать также

Как увеличить продажи в несколько раз с помощью ROMI center?

Закажите презентацию с нашим экспертом. Он просканирует состояние вашего маркетинга, продаж и даст реальные рекомендации по её улучшению и повышению продаж с помощью решений от ROMI center.

Запланировать презентацию сервиса

Попробуйте наши сервисы:

Импорт рекламных расходов и доходов с продаж в Google Analytics

Настройте сквозную аналитику в Google Analytics и анализируйте эффективность рекламы, подключая Яндекс Директ, Facebook Ads, AmoCRM и другие источники данных за считанные минуты без программистов

Попробовать бесплатно

Импорт рекламных расходов и доходов с продаж в Яндекс Метрику

Настройте сквозную аналитику в Яндекс.

Метрику и анализируйте эффективность рекламы, подключая Facebook Ads, AmoCRM и другие источники данных за считанные минуты без программистов

Метрику и анализируйте эффективность рекламы, подключая Facebook Ads, AmoCRM и другие источники данных за считанные минуты без программистовПопробовать бесплатно

Система сквозной аналитики для вашего бизнеса от ROMI center

Получайте максимум от рекламы, объединяя десятки маркетинговых показателей в удобном и понятном отчете. Отслеживайте окупаемость каждого рекламного канала и перестаньте сливать бюджет.

Попробовать бесплатно

Сквозная аналитика для Google Analytics позволит соединять рекламные каналы и доходы из CRM Получайте максимум от рекламы, объединяя десятки маркетинговых показателей в удобном и понятном отчете. Отслеживайте окупаемость каждого рекламного канала и перестаньте сливать бюджет.

Подробнее → Попробовать бесплатно

Сквозная аналитика для Яндекс.

Метрики позволит соединять рекламные каналы и доходы из CRM Получайте максимум от рекламы, объединяя десятки маркетинговых показателей в удобном и понятном отчете. Отслеживайте окупаемость каждого рекламного канала и перестаньте сливать бюджет.

Метрики позволит соединять рекламные каналы и доходы из CRM Получайте максимум от рекламы, объединяя десятки маркетинговых показателей в удобном и понятном отчете. Отслеживайте окупаемость каждого рекламного канала и перестаньте сливать бюджет.Подробнее → Попробовать бесплатно

Сквозная аналитика от ROMI позволит высчитывать ROMI для любой модели аттрибуции Получайте максимум от рекламы, объединяя десятки маркетинговых показателей в удобном и понятном отчете. Отслеживайте окупаемость каждого рекламного канала и перестаньте сливать бюджет.

Подробнее → Попробовать бесплатно

Как переиндексировать сайт в поисковиках

Индексация сайта позволяет отобразить его страницы в поисковой системе. За такую работу отвечают специальные алгоритмы – роботы. Они сканируют всю информацию на сайте: картинки, фотографии, видео и так далее. Если все прошло успешно, то веб-страницы добавляются в базу и начинают появляться в поисковике при релевантных запросах пользователей.

Они сканируют всю информацию на сайте: картинки, фотографии, видео и так далее. Если все прошло успешно, то веб-страницы добавляются в базу и начинают появляться в поисковике при релевантных запросах пользователей.

Как сказать роботу, чтобы он просканировал сайт и отправил его в поисковую систему? Об этом и многом другом поговорим в сегодняшней статье.

Как работает индексирование

Поисковый робот сканирует страницу, и она попадает в Google, Яндекс или другую систему. Но между этими процессами протекают еще и внутренние. После обхода страницы вся полученная информация отправляется в базу данных – индекс, которая хранится в поисковике. Следующим этапом данные распределяются по двум путям: для выстраивания ранжирования (сортировки сайта в поисковой выдаче) и для служебных целей.

При сканировании работы исследуют не только видимую для пользователей текстовую информацию, но и другие параметры: атрибуты документа, информацию из тегов alt, title и description, скрипты.

И даже если робот обошел весь сайт, не факт, что он окажется в топе. На это влияет уникальность страницы и полезность контента. Если робот посчитает, что информация не соответствует действительности либо недостаточно уникальна, он может не добавить ее в индекс.

Процесс индексации в Google и Яндекс происходит немного по-разному.

Как оно работает в Google

Первым делом стоит сказать, что точные алгоритмы индексирования страниц засекречены. Как работают Google и Яндекс, знают только сотрудники компаний, но поговорить о базовых принципах можно.

В Google используется технология Mobile-first, которая в первую очередь сканирует мобильную версию сайта. Таким образом, если десктопная версия отлично проработана и заслуживает внимания, а про мобильную версию забыли, то вероятность индексирования будет крайне мала.

Другая особенность Гугла – проверка краулингового бюджета – регулярности и объема посещения сайта роботом. Чем выше этот показатель, тем быстрее будут проходить индексацию новые страницы. Как именно он рассчитывается, неизвестно, но многие специалисты предполагают, что это связано с возрастом сайта и частотой его обновлений.

Как именно он рассчитывается, неизвестно, но многие специалисты предполагают, что это связано с возрастом сайта и частотой его обновлений.

Как оно работает в Яндекс

В отличие от Гугла, Яндекс не берется в первую очередь за мобильную версию – он изучает, как устроена десктопная версия сайта. С краулинговым бюджетом все наоборот – по крайне мере, официально. Индексирование происходит вне зависимости от траста и других показателей ресурса.

На попадание в поисковик может влиять количество страниц в сети, которые выкладываете вы и другие пользователи. А чтобы добиться высоких результатов в выдаче, сайт должен быть популярным. Чем больше пользователей его посещают, тем лучше.

И еще одна особенность – поисковик не сканирует на сайте файлы размером больше 10 Мб. Это следует учитывать, если вы собираетесь покорять Яндекс.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

Подписаться

Как настроить индексацию сайта

Чаще всего индексация сайта происходит автоматически. Для настройки индексации сайта нам потребуется файл robots.txt. Обычно он генерируется CMS и выглядит примерно так:

Для настройки индексации сайта нам потребуется файл robots.txt. Обычно он генерируется CMS и выглядит примерно так:

Может показаться, что в файле написано что-то сложное и непонятное, но не переживайте – сейчас во всем разберемся. Вот на что стоит обратить внимание:

- user-agent – показывает, для какого поисковика настраивается индексирование;

- disallow – показывает, какие страницы не должны попасть в индекс.

Теперь поговорим о другом файле под названием sitemap.xml. Уже из названия понятно, что это карта сайта. Она показывает некую иерархию – как устроена структура ресурса. Это необходимо для упрощения считывания данных поисковыми роботами. В файл вносятся все страницы, которые должны быть проиндексированы.

Такой файл, как правило, создается всего в несколько кликов с помощью плагинов CMS. Например, на WordPress можно воспользоваться AIOSEO. В настройках плагина достаточно перевести ползунок в режим «Включено».

Чтобы сайт максимально быстро индексировался, следует обеспечить внутреннюю перелинковку. Тогда поисковый робот без проблем будет переходить по страницам и быстро найдет новый документ.

Тогда поисковый робот без проблем будет переходить по страницам и быстро найдет новый документ.

После этого вам останется пройти базовую настройку в Google Search Console и Яндекс.Вебмастере. Там нет ничего сложного – интерфейс сам подскажет, что нужно делать.

Можно ли ускорить индексирование

Как таковой заветной кнопки для ускорения индексирования не существует, но можно «поторопить» робота. Это будет полезно, если индексация страницы идет слишком долго, например, из-за какого-то сбоя.

Сделать это можно через личный кабинет Яндекс.Вебмастера. Первым делом необходимо перейти в раздел «Переобход страниц».

После этого вводим адрес той страницы, которую нужно проиндексировать, и нажимаем «Отправить».

Так можно поступать не только с новыми страницами, но и при редактировании старых. Важное замечание – количество отправок в сутки ограничено, причем все зависит от возраста и траста сайта.

У Google ускорение индексации состоит из двух этапов – сначала переходим в Search Console и в верхней части вводим необходимый адрес. Затем нажимаем на клавишу «Enter».

Затем нажимаем на клавишу «Enter».

На отразившейся странице будет доступна информация по данной странице. Чтобы ее проиндексировать, достаточно нажать на кнопку:

Как удалить страницу из результатов поисковой системы

Существует три способа удаления страницы: использование тега robots, добавление запрещающей директивы в системный файл robots.txt и использование специальных инструментов Google или Яндекс.

Первый способ подразумевает добавление тега в <head> страницы:

<meta name="robots" content="noindex, follow"/>

Чтобы добавить запрещенную директиву, необходимо прописать «пожелания» для робота. Они могут быть не выполнены, но чаще всего срабатывают. Для этого в файле robots.txt прописываем:

User-agent: Google или Yandex Disallow: /указывается ссылка на желаемую страницу, которую нужно удалить из выдачи

И последний, пожалуй, самый простой способ – воспользоваться Google Search Console или Яндекс. Вебмастером. В настройках сервисов есть отдельная вкладка, позволяющая удалить любую страницу сайта. Вот так это выглядит в Вебмастере:

Вебмастером. В настройках сервисов есть отдельная вкладка, позволяющая удалить любую страницу сайта. Вот так это выглядит в Вебмастере:

Чтобы попасть на эту страницу, необходимо в личном кабинете перейти в «Инструменты» и выбрать «Удаление страниц из поиска».

Как понять, что страница есть в поисковике

Один из самых простых способов понять, проиндексировалась ли страница – это ввести запрос в поисковую систему. Выглядит он как ссылка на страницу, например: https://timeweb.com/ru/community/articles/luchshie-rossiyskie-servisy-email.

Если мы введем такой запрос в гугле, то увидим эту страницу в выдаче:

Соответственно, если бы страница не проиндексировалась, то по данному запросу мы ее не увидели.

Также мы можем посмотреть все страницы, которые были добавлены в поисковик. Для этого необязательно сотню раз вводить адреса страниц. Достаточно воспользоваться простой формулой:

site:адрес сайта

При таком запросе будет отображен список всех страниц, которые есть в данном поисковике. Вот, например, как это выглядит в Гугле:

Вот, например, как это выглядит в Гугле:

Также вы можете посмотреть индексацию страниц через Яндекс.Вебмастер в разделе «Индексирование» -> «Страницы в поиске».

Почему проиндексированная страница пропала из выдачи?

Этому может способствовать множество различных причин. Вот одни из самых распространенных:

- запрашиваемая страница выдает 301 код ошибки;

- запрашиваемая страница выдает 400 и 500 коды ошибок;

- в файле robots.txt стоит запрет на индексирование;

- на странице есть дублирующий контент;

- наложены санкции за покупные ссылки, некачественный или устаревший контент.

При любых сложностях с индексированием в первую очередь следует смотреть рассмотренные выше файлы – robots.txt и sitemap.xml. Если там все в порядке, то необходимо проверить, нет ли каких-либо ограничивающих фильтров. Если и с ними все хорошо, то лучше всего обратиться к администратору хостинга.

Выводы

Индексация страниц в поисковиках – это один из важнейших этапов успешного SEO-продвижения. Если вы хотите, чтобы ваши страницы посещали другие пользователи, то необходимо регулярно контролировать синхронизацию с популярными поисковыми системами.

Если вы хотите, чтобы ваши страницы посещали другие пользователи, то необходимо регулярно контролировать синхронизацию с популярными поисковыми системами.

Главное правило – это качественный контент, который ценится людьми и ботами. Старайтесь, чтобы сайт был хорошим для пользователей не только в плане контента, но и удобства использования. Все это может повлиять на индексацию как с позитивной, так и с негативной стороны.

Как работают поисковые системы? (Объяснение сканирования, индексирования и ранжирования!)

Ежедневно в Google выполняются миллиарды поисковых запросов, но задумывались ли вы когда-нибудь о том, как эти полезные алгоритмы работают в поисковых системах и как вы можете использовать их в своих интересах?

На базовом уровне поисковые системы выполняют 3 основные функции:

- Сканирование Интернета в поисках новых веб-страниц и документов

- Помещение этого контента в гигантский индекс/базу данных

- Ранжирование контента по различным факторам

В этой главе мы разберем каждый из этих процессов, чтобы вы могли понять, как работают поисковые системы, что это означает для SEO и что использование механизмов поисковых систем может сделать для вашего бизнеса!

Сканирование: как поисковая система сканирует Интернет?

Сканеры — это компьютерные программы, создающие ботов, которые находят новый контент, такой как веб-страницы, файлы PDF, видео и изображения, переходя по ссылкам на веб-страницах.

Поисковые роботы — это в основном крошечные исследователи, которые путешествуют по Интернету, чтобы найти самые лучшие результаты поисковых систем для каждого поискового запроса. Поисковые системы обнаруживают релевантный контент, отправляя поисковых роботов или поисковые роботы. Они всегда ищут лучшие ссылки для показа пользователям.

У Google есть собственный основной сканер под названием Googlebot. Существуют и другие сканеры поисковых систем, такие как DuckDuckBot, YandexBot и Slurp для Yahoo. У Bing также есть поисковый робот BingBot. Эти роботы позволяют вашему веб-сайту занимать высокие позиции в поисковой выдаче или занимать первые места в поисковых системах. На самом деле около 93% всего веб-трафика приходится на поисковую систему.

Выяснение того, как работает поиск Google и как получить максимальную отдачу от взаимодействия с пользователем, является одним из первых шагов к пониманию того, как ранжировать и привлекать трафик для вашего бизнеса. Ранжирование жизненно важно для бизнеса, исследования показывают, что рейтинг лучших результатов поиска в Google составляет 37,1%.

Эти поисковые роботы могут очень быстро посещать веб-страницы, что позволяет алгоритму Google обнаруживать новые веб-сайты, страницы и другой контент.

При создании нового контента ссылка на него с существующих страниц вашего сайта или с другого сайта — это хороший способ обеспечить его обнаружение поисковыми системами. Этот процесс называется созданием обратных ссылок, и это жизненно важный шаг к стратегии SEO и оптимизации.

Поисковые роботы также чаще посещают популярные веб-сайты, создающие новый контент, чем более мелкие неизвестные веб-сайты. Получение ссылки с популярного веб-сайта может привести к более быстрому обнаружению вашего контента.

Отличный способ сделать это без рекламы — использовать метод неработающих ссылок. Этот метод включает в себя поиск неработающих ссылок в записи блога или на странице контента и предложение веб-мастеру заменить их вашей собственной ссылкой. Это часто может привести к обратной ссылке, которую любят сканеры!

Создание карты сайта также помогает поисковым системам сканировать ваш сайт. Хорошая карта сайта будет ссылаться на каждую страницу вашего сайта.

Хорошая карта сайта будет ссылаться на каждую страницу вашего сайта.

Регистрация учетной записи Google Search Console — хороший шаг, если вы хотите видеть больше данных о страницах, просканированных Google. Вы также можете увидеть любые ошибки сканирования, которые могли произойти.

Некоторые проблемы, из-за которых страницы могут не сканироваться, включают плохую структуру навигации, циклы перенаправления и ошибки сервера.

В прошлом было популярно «отправлять» ваш сайт в поисковые системы, но в этом больше нет необходимости, поскольку они стали гораздо более продвинутыми в обнаружении релевантных результатов из нового контента, публикуемого в Интернете. Ваш веб-сайт должен развиваться и улучшать техническое SEO с помощью технологий, чтобы конкурировать с вашими конкурентами!

Что такое краулинговый бюджет? Теперь, когда вы понимаете, что такое сканеры, давайте углубимся и объясним, что такое бюджет сканирования. Бюджеты сканирования также иногда называют пространством сканирования или временем сканирования. Эти условия называются количеством страниц, которые поисковые системы просматривают на веб-сайте в течение определенного периода времени.

Эти условия называются количеством страниц, которые поисковые системы просматривают на веб-сайте в течение определенного периода времени.

Поисковые системы назначают краулинговые бюджеты веб-сайтам, потому что поисковые системы не имеют неограниченных ресурсов. У них есть только так много сканеров, которые могут получить доступ к веб-сайту в любой момент. Таким образом, поисковые системы должны расставлять приоритеты для своих сканеров.

Таким образом, эти краулинговые бюджеты назначаются несколькими способами. Эти факторы основаны на нагрузке хоста и спросе на сканирование.

Нагрузка на хост является важным фактором, потому что в основном это просто предпочтение веб-сайта относительно того, как часто сканер обращается к его странице. Это также может зависеть от того, часто ли хост может обрабатывать усилия сканирования.

Спрос на сканирование — важный фактор, поскольку от него зависит, стоит ли вообще сканировать веб-сайт. Эти факторы основаны на популярности и частоте обновления веб-сайта или URL-адресов.

Бюджеты сканирования используются не только для страниц, но и для любого документа, который сканируют поисковые системы. Например, файлы JavaScript, файлы CSS, файлы PDF и многое другое.

Давайте объясним, почему краулинговые бюджеты важны и почему вам нужно понимать, как они работают, чтобы вы могли включить это в успешную стратегию SEO.

Поисковые системы должны найти как можно больше ваших индексируемых страниц. Вы также хотите, чтобы они сделали это как можно быстрее. Когда вы создаете новую страницу и обновляете уже размещенный контент, вы хотите, чтобы поисковые системы находили вашу информацию как можно быстрее. Чем быстрее сканеры смогут индексировать, тем быстрее вы сможете извлечь из этого пользу.

Как убедиться, что ваш веб-сайт правильно сканируется Если вы не уверены, правильно ли ваш веб-сайт сканируется поисковыми системами, давайте посмотрим, что вы можете сделать, чтобы узнать и убедиться, что эти маленькие роботы-пауки делают свою работу.

Вот лучшие способы убедиться, что ваш сайт сканируется:

- Создать карту сайта

- Создать файл robots.txt

- Создание внутренних ссылок

- Зарабатывайте обратные ссылки

- Обмен в социальных сетях

Создание правильной карты сайта жизненно важно для целей SEO. Карта сайта или XML (расширяемый язык разметки) — это просто способ отображения информации на веб-сайте.

Они являются технической частью SEO, что может сделать их немного пугающими, но не слишком сложными для владельца бизнеса, который хочет учиться.

Вам нужна карта сайта для Google, чтобы робот Googlebot мог просканировать ваш веб-сайт, поместить его в свой индекс, а затем отправить своих пользователей на ваш веб-сайт. Файлы Sitemap просто облегчают работу Google.

Следующим шагом является просмотр вашей карты сайта, проверка ее на оптимизацию, как я уже говорил выше, когда-то было время, когда вам нужно было отправить карту сайта в Google. В этом больше нет необходимости, поскольку с тех пор поисковые роботы Google развились. Сканеры теперь могут сканировать ваш сайт без отправки.

В этом больше нет необходимости, поскольку с тех пор поисковые роботы Google развились. Сканеры теперь могут сканировать ваш сайт без отправки.

Одна интересная причина, по которой Googlebot так важен для сканирования, заключается в том, что вы можете положиться на другие поисковые системы; однако Google приносит 92% трафика поисковых систем. Таким образом, ранжирование в Google имеет решающее значение для развития вашего бизнеса.

Добавьте свой сайт в корень и robots.txt. Этот шаг может показаться немного сложным, поэтому позвольте мне немного разбить его. Вы также можете передать эту часть веб-мастеру или одному из наших экспертов, чтобы помочь вам.

Вам необходимо найти корневую папку вашего веб-сайта и добавить файл карты сайта в эту папку. Сделав это, вы также добавите страницу своего веб-сайта. Это есть на большинстве веб-сайтов, и это основная часть технического SEO.

Вы также должны закодировать карту сайта в свой URL-адрес, добавив к нему «/sitemap. xml». Добавив файл карты сайта в корневую папку, вы также захотите добавить его и в файл robots.txt. Вы можете найти его в той же области, где находятся ваши корневые папки.

xml». Добавив файл карты сайта в корневую папку, вы также захотите добавить его и в файл robots.txt. Вы можете найти его в той же области, где находятся ваши корневые папки.

Это дает поисковым роботам правильные направления на ваш веб-сайт, чтобы они могли проиндексировать его и поделиться им со своими пользователями. Сканеры жизненно важны для ранжирования, поэтому очень важно убедиться, что на вашем веб-сайте есть не только ключевые слова, ссылки и актуальный контент. Ваш веб-сайт должен иметь оптимизированный веб-сайт, который включает в себя лучшие методы, чтобы сканеры поисковых систем не могли получить доступ к вашему бизнес-контенту.

Получение обратных ссылок и распространение своего контента в социальных сетях также является отличным способом заработать рейтинг в SEO, а также показывает поисковым роботам, что ваш контент важен для других веб-сайтов, что дает вам увеличение трафика и потенциальных клиентов.

Индексирование: как поисковая система считывает и хранит информацию о веб-сайте?

Когда сканеры достигают страниц, они собирают данные и сохраняют информацию в индексе. Возможно, вы слышали о метатегах и метаданных. Эти поисковые роботы собирают эту информацию с веб-страницы, где она хранится в индексе поисковой системы, а затем используется при получении запроса пользователя на поиск этой информации. Затем он отображается на странице результатов поисковой системы для любого данного пользователя.

Возможно, вы слышали о метатегах и метаданных. Эти поисковые роботы собирают эту информацию с веб-страницы, где она хранится в индексе поисковой системы, а затем используется при получении запроса пользователя на поиск этой информации. Затем он отображается на странице результатов поисковой системы для любого данного пользователя.

Вот почему оптимизация для поисковых систем, правильные заголовки, альтернативный текст и правильные метаданные на вашем сайте так важны. Эти поисковые роботы берут лучшую, наиболее популярную информацию и отправляют ее обратно в поисковую систему, которая затем ранжирует страницы на основе релевантной и точной информации.

Вы можете думать об индексе как об очень большой базе данных, содержащей все веб-страницы в Интернете, найденные поисковой системой. Поисковые системы будут анализировать и извлекать контент из своего индекса, когда искатели вводят поисковый запрос.

По умолчанию поисковые системы будут сканировать и пытаться проиндексировать каждую страницу вашего сайта, которую они смогут найти.

Однако, если у вас есть страницы, которые вы не хотите, чтобы веб-поисковики могли найти с помощью поисковых систем, например, частные страницы только для членов, тогда использование метатегов Robots поможет.

Отличный совет для защиты страницы от поисковых роботов — исключить страницы, которые бесполезны, например страницы тегов и категорий в WordPress.

Эти частные страницы иногда называют «темной сетью». Название звучит пугающе, но в большинстве случаев поисковые роботы не могут найти просто частные страницы, которые не нужны или не важны для результатов поиска, ранжирования и цифрового маркетинга.

Если вы тратите краулинговый бюджет впустую, значит, вы оставляете незамеченными важные части вашего веб-сайта. Что не является эффективным методом для вашего SEO-рейтинга. Если сканеры не знают о страницах, они не могут сканировать и индексировать их для пользователей.

Рейтинг: Как поисковая система ранжирует веб-сайты?

Поисковые системы используют алгоритмы для анализа веб-сайтов и принятия решения о том, как ранжировать их по различным поисковым запросам. Алгоритмы ранжирования поисковых систем основываются на высококачественных обратных ссылках, релевантном контенте, популярности и информации.

Алгоритмы ранжирования поисковых систем основываются на высококачественных обратных ссылках, релевантном контенте, популярности и информации.

На ранжирование в поисковых системах влияют два основных фактора:

- Факторы на странице

- Факторы вне страницы

Факторы на странице функционируют на веб-страницах таким образом, чтобы сайт был оптимизирован для поисковых систем и использовал основные ключевые слова для ранжирования. Факторы на странице очень важны для каждого сайта, чтобы он мог ранжироваться в поисковых системах. Факторы на странице также включают метаданные, такие как теги alt и метаописания, написанные в HTML.

Внешние факторы — это факторы, которые помогают повысить рейтинг веб-сайта за пределами самого бизнеса. Этот тип контента отображается в социальных сетях или гостевых блогах. Его также можно рассматривать как обратные ссылки и другой контент вне страницы, например, статьи, ссылающиеся на целевую страницу.

Эти алгоритмы присваивают баллы различным факторам ранжирования, а затем ранжируют релевантные страницы с лучшими баллами от самого высокого до самого низкого. RankBrain также считается основным фактором ранжирования при рассмотрении поисковых систем и их фактической работы.

RankBrain — это часть алгоритма Google, который использует машинное обучение для определения лучших результатов поиска. Rankbrain — главная причина, по которой SEO стало таким сложным понятием. Rankbrain учитывает множество различных факторов, таких как местоположение, история поиска, персонализация и ключевые слова, чтобы найти наилучшие результаты.

Алгоритмы поисковых систем также меняются со временем, чтобы улучшить результаты поиска. Имейте в виду, что цель поисковых систем — предоставлять качественный контент, чтобы их пользователи были довольны результатами поиска и продолжали использовать свою поисковую систему.

Как работают поисковые системы Подведение итогов Поисковые системы являются важной частью повседневной жизни. Независимо от того, занимаетесь ли вы бизнесом, пытаясь улучшить свой SEO-рейтинг, или просто пытаетесь найти лучший суши-ресторан рядом с вами.

Независимо от того, занимаетесь ли вы бизнесом, пытаясь улучшить свой SEO-рейтинг, или просто пытаетесь найти лучший суши-ресторан рядом с вами.

Поисковые системы и современные технологии упрощают поиск лучшей, наиболее точной и актуальной информации.

Если вы чувствуете себя лягушкой, как насчет того, чтобы перейти к следующему разделу и узнать, какие факторы используют поисковые системы для определения того, какой контент занимает первое место?

Мы обсудим самые важные факторы в следующей главе!

Правильное предотвращение индексации вашего сайта • Yoast

Мы уже говорили это когда-то, но повторим: нас продолжает удивлять, что до сих пор есть люди, использующие только файлы robots.txt , чтобы предотвратить индексацию своего сайта в Google или Bing. В результате их сайт все равно отображается в поисковых системах. Знаете, почему это продолжает удивлять нас? Потому что robots.txt на самом деле не делает последнего, хотя и предотвращает индексацию вашего сайта. Позвольте мне объяснить, как это работает, в этом посте.

Позвольте мне объяснить, как это работает, в этом посте.

Чтобы узнать больше о robots.txt, прочитайте robots.txt: полное руководство. Или найдите рекомендации по работе с robots.txt в WordPress.

Существует разница между тем, чтобы быть проиндексированным и включенным в список Google. содержимое страницы на сервер поисковика, тем самым добавляя его в свой «индекс».

Отображение сайта на страницах результатов поиска (он же SERP).

Подробнее: Что такое индексация в отношении Google? »

Таким образом, в то время как наиболее распространенный процесс идет от индексации к списку, сайт не обязательно должен быть проиндексирован , чтобы попасть в список. Если ссылка указывает на страницу, домен или что-то еще, Google переходит по этой ссылке. Если файл robots.txt в этом домене препятствует индексированию этой страницы поисковой системой, он все равно будет отображать URL-адрес в результатах, если сможет получить данные из других переменных, на которые, возможно, стоит обратить внимание.

В прежние времена это мог быть DMOZ или каталог Yahoo, но я могу представить, как Google использует, например, данные о вашем бизнесе в наши дни или старые данные из этих проектов. Больше сайтов резюмируют ваш сайт, правильно.

Теперь, если приведенное выше объяснение не имеет смысла, посмотрите это видео-объяснение бывшего сотрудника Google Мэтта Каттса из 2009 года:

. Если у вас есть причины запретить индексирование вашего веб-сайта, добавьте этот запрос на нужную страницу. блокировать, как говорит Мэтт, все еще правильный путь.

Но вам нужно сообщить Google об этом метатеге robots. Таким образом, если вы хотите эффективно скрыть страницы от поисковых систем, вам нужно их проиндексировать эти страницы. Хотя это может показаться противоречивым. Есть два способа сделать это.

ваше периодическое напоминание о том, что поисковые роботы, подчиняющиеся robotstxt, не увидят директиву noindex на странице, если указанная страница запрещена для сканирования.

по запросу https://t.co/i7ouMoqNT6, на который ответил @patrickstox pic.twitter.com/98NLF2twz1

— Гэри 鯨理/경리 Illyes (@methode) 25 марта 2021 г.

Запретите размещение вашей страницы в списке, добавив метатег robots

Первый способ предотвратить включение вашей страницы в список — это использовать метатеги robots. У нас есть исчерпывающее руководство по метатегам роботов , которое является более подробным, но в основном сводится к добавлению этого тега на вашу страницу:

Если вы используете Yoast SEO, это очень просто! Нет необходимости добавлять код самостоятельно. Узнайте, как добавить тег noindex с помощью Yoast SEO, здесь.

Однако проблема с таким тегом заключается в том, что вы должны добавлять его на каждую страницу.

Управление метатегами robots упрощено в Yoast SEO Чтобы упростить процесс добавления метатега robots на каждую страницу вашего сайта, поисковые системы придумали HTTP-заголовок X-Robots-Tag. Это позволяет указать HTTP-заголовок с именем

Это позволяет указать HTTP-заголовок с именем X-Robots-Tag и установить значение, аналогичное значению метатегов robots. Самое классное в этом то, что вы можете сделать это для всего сайта. Если ваш сайт работает на Apache и включена функция mod_headers (обычно так и есть), вы можете добавить следующую единственную строку в свой .htaccess file:

Header set X-Robots-Tag "noindex, nofollow"

Это приведет к тому, что весь сайт может быть проиндексирован. Но никогда не будет отображаться в результатах поиска.

Итак, избавьтесь от этого файла robots.txt с Disallow: / в его. Вместо этого используйте X-Robots-Tag или мета-тег robots!

Продолжайте читать: Полное руководство по тегу мета роботов »

Йост де Валк

Йост де Валк является основателем Yoast. После продажи Yoast он перестал быть активным на постоянной основе и теперь выступает в качестве советника компании. Он интернет-предприниматель, который вместе со своей женой Марике активно инвестирует и консультирует несколько стартапов. Его основная специализация — разработка программного обеспечения с открытым исходным кодом и цифровой маркетинг.

Он интернет-предприниматель, который вместе со своей женой Марике активно инвестирует и консультирует несколько стартапов. Его основная специализация — разработка программного обеспечения с открытым исходным кодом и цифровой маркетинг.

Далее!

- Событие

Выставка электронной коммерции Лондон

28 — 29 сентября, 2022 г. Команда Yoast посещает выставку eCommerce Expo London, нажмите здесь, чтобы узнать, будем ли мы там, кто будет там и многое другое! Узнайте, где вы можете найти нас дальше » - SEO-вебинар

Новостной вебинар Yoast SEO — 27 сентября 2022 г.

27 сентября 2022 г. Наш глава SEO, Джоно Алдерсон, будет держать вас в курсе всего, что происходит в мире SEO и WordPress. Все вебинары Yoast SEO »

Сколько времени занимает индексация и 11 способов ускорить размещение ваших страниц в списке

Сколько времени требуется Google для индексации нового веб-сайта в 2019 году?

Хотя это может быть разным, Google может пройти от 4 дней до 6 месяцев, прежде чем Google просканирует сайт и присвоит полномочия домену. Когда вы публикуете новую запись в блоге, страницу сайта или веб-сайт в целом, существует множество факторов, которые определяют, как быстро он будет проиндексирован Google. Например, популярность сайта, возможность сканирования контента и общая структура сайта.

Когда вы публикуете новую запись в блоге, страницу сайта или веб-сайт в целом, существует множество факторов, которые определяют, как быстро он будет проиндексирован Google. Например, популярность сайта, возможность сканирования контента и общая структура сайта.

Google — это много разных вещей для разных людей.

Для студентов это незаменимый ресурс, для стартапов — источник вдохновения, а для таких маркетологов, как я… ну, это загадка .

Каждые несколько месяцев, когда Google выпускает новое обновление алгоритма, авторы контента и эксперты по поисковой оптимизации сразу же пытаются понять это и сохранить или даже улучшить свои позиции в поиске.

Но когда на эту тему так много написано, часто бывает трудно отличить заслуживающее доверия от ненадежного.

Вместо того, чтобы публиковать то же исследование поисковой оптимизации, которое вы, вероятно, уже видели на других сайтах, мы решили предоставить вам информацию непосредственно от самого Google и перевести ее в термины, понятные даже новичку.

Бесплатное руководство: Руководство специалиста по внутреннему маркетингу по поисковой оптимизации прогнозы или гарантии относительно того, когда и будут ли ваши URL-адреса сканироваться или индексироваться.0008 При просмотре индексации сайта в Search Console убедитесь, что у вас проверены как версии с www, так и без www (например, www.example.com и example.com), и установлен предпочтительный домен. Имейте в виду, что хотя файл карты сайта может помочь нам узнать о вашем сайте, он не гарантирует индексацию или повышение рейтинга вашего сайта.

У нас есть несколько статей Справочного центра, объясняющих эти процессы:

- Основы Google — объясняет, как работает сканирование, индексирование и ранжирование

- Мой сайт плохо работает в поиске — поясняет распространенные вопросы и проблемы

- Удобные для Google сайты — содержит некоторую информацию о том, как создать веб-сайт, чтобы его можно было легко сканировать и индексировать

- Руководство Google для веб-мастеров — содержит технические рекомендации, рекомендации по содержанию и качеству для веб-мастеров .

- Добавление сайта в Google – конкретные советы и дополнительные советы

- Ваш сайт в индексе Google — несколько простых способов проверить индексацию вашего сайта

В общем, наиболее распространенная причина того, что сайт не индексируется, заключается в том, что он слишком новый — наберитесь терпения (и попросите Google просканировать и проиндексировать его)!. Вот другие распространенные причины, по которым веб-сайт или его части могут быть еще не проиндексированы:

- Веб-сайт может быть плохо подключен через несколько ссылок с других сайтов в Интернете.

- Дизайн веб-сайта может затруднить сканирование и индексирование. Может быть, сам сайт даже явно блокирует сканирование или индексацию?

- Возможно, он был временно недоступен, когда мы пытались сканировать? В этом случае вы можете найти ошибки сканирования в Search Console.

- Убедитесь, что веб-сайт соответствует нашему Руководству для веб-мастеров и не был взломан или иным образом изменен третьей стороной.

- В очень редких случаях причиной проблем может быть контент, ранее размещенный на доменном имени. В этом случае вы можете отправить запрос на пересмотр с подробным описанием изменения содержания и владельца.

- Если веб-сайт недавно переехал на другой адрес, убедитесь, что вы следуете нашим рекомендациям по перемещению сайта.

- Возможно, предыдущий владелец или другой пользователь, имеющий доступ к веб-сайту, запросил удаление через Search Console. Вы можете отменить эти запросы, выбрав «Конфигурация сайта» / «Доступ для сканера» / «Удалить URL» в своей учетной записи Search Console».

Проще говоря, индексирование и ранжирование в Google не является точной наукой.

На самом деле нет установленного графика того, как быстро ваша новая страница будет проиндексирована Google или как высоко она поднимется, но, эй, с быстро развивающимся бизнесом Google AdWords, вы не можете ожидать, что они просто отдадут секретный соус.

(Примечание: Эта статья может помочь вам настроить вашу первую кампанию Google AdWords , если вам интересно. )