Полное руководство по настройке плагина All in One SEO Pack

Время чтения: 11 мин.

Прошлая статья получилась действительно большой. Но никак по-другому все пункты описать не получилось. В данной статье мы завершим рассмотрение настройки плагина All in One SEO Pack и Вы поймете для чего предназначены те или иные функции, чтобы Вы могли произвести именно правильную настройку плагина All in One SEO Pack.

Для тех, кто попал сразу на данную статью, обязательно изучите предыдущую статью по настройке плагина All in One SEO Pack:

Но для тех, кому этот плагин не сильно понравился, то Вы можете посмотреть в сторону аналогичного плагина Yoast SEO. А с помощью следующих 2-х статей Вы сможете его настроить:

Как обычно, в конце статьи обязательно пройдите небольшой тест и закрепите изученный материал.

Если возникли трудности при установке плагина для WordPress All in One SEO Pack…

Для самых начинающих владельцев сайтов я сделал небольшую видео инструкцию, где продемонстрировал установку плагина. Благодаря ей, Вы с легкостью сможете его установить на свой сайт:

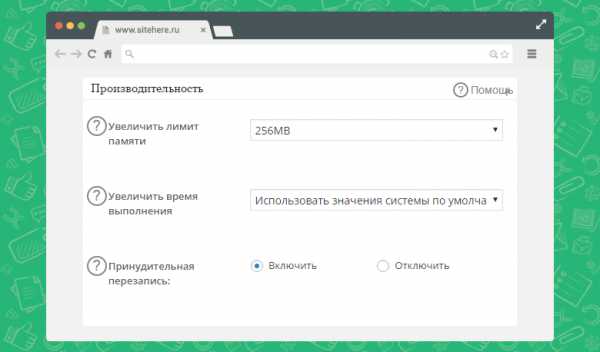

Вкладка «Производительность» при настройке All in One SEO Pack

Этот пункт необходимо включить при дальнейшей настройке плагина All in One SEO Pack. Для этого необходимо перейти в раздел «Управление модулями» и активировать модуль «Производительность». Делать это необязательно, но так как я решил рассмотреть данный плагин очень подробно, то я включу этот модуль и расскажу что с помощью него Вы можете сделать:

Пойдем по пунктам, потому что их здесь действительно немало:

Следующем блоком идет «О системе». Здесь можно узнать технические характеристики Вашего сервера/хостинга, а также некоторые настройки PHP. Разработчики сделали вынесли некоторые функции на управление обычных пользователям, чтобы не искать файлы с конфигурацией на сервере.

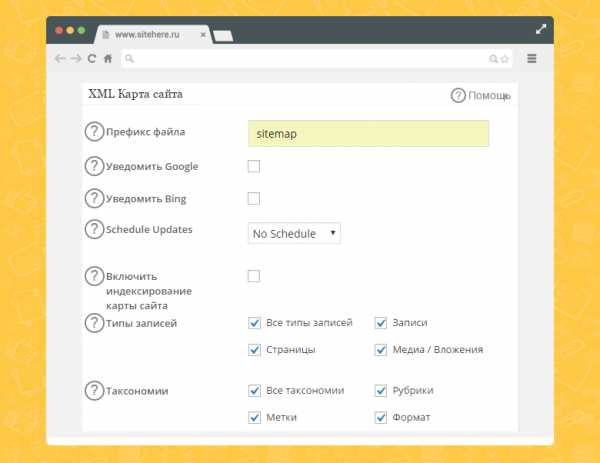

Вкладка «XML карта сайта» при настройке плагина All in One SEO Pack

Переходим к пункту меню «XML карта сайта«. Этот модуль также необходимо активировать при дальнейшей настройке карты в плагине All in One SEO Pack, чтобы в дальнейшем работать с ним. Первый блок «XML карта» разобьем на 2 части и рассмотрим подробно. Итак, первая часть блока:

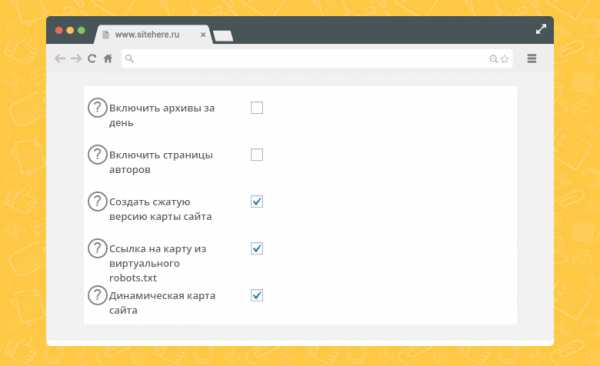

Переходим ко второй части первого пункта «XML карта сайта» в настройках плагина All in One SEO Pack:

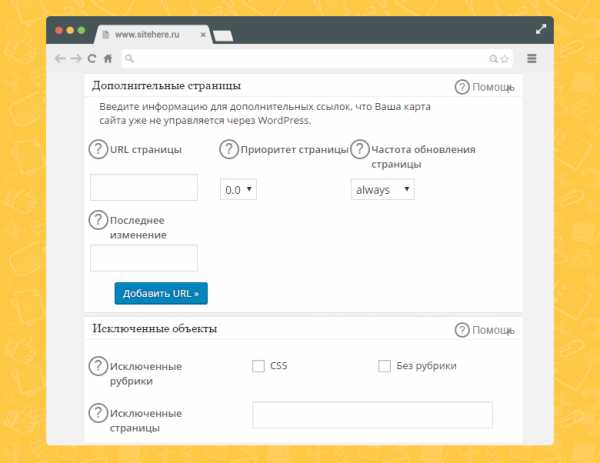

Движемся далее по правильной настройке плагина All in One SEO Pack, и рассмотрим сразу два блока: «Дополнительные страницы» и «Исключенные объекты«. Итак, вот данные два блока:

Некоторые страницы сайта, могут быть созданы вручную. То есть можно создать HTML страницу и загрузить ее через ФТП на хостинг. А затем на сайте ссылаться на нее. Но это не появится автоматически в XML карте сайта. А вот если Вы хотите добавить эту страницу в карту сайта и отправить поисковикам, то для этого предназначен данный блок.

А сейчас быстро пробежимся по блоку «Исключенные объекты«, который позволяет исключить определенные страницы и рубрики из XML карты сайта:

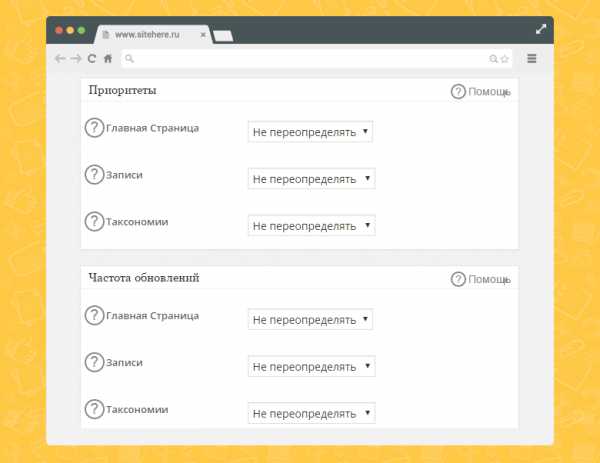

Идем дальше по основным настройкам плагина All in One SEO Pack, к блока «Приоритеты» и «Частота обновлений«:

Начнем с блока «Приоритеты»

В этих пунктах лучше оставить по умолчанию все настройки и не трогать ничего.

Перейдем к блоку «Частота обновлений«. Здесь Вы можете посоветовать поисковому роботу периодичность посещения следующих страниц:

После чего жмем кнопку «Обновить карту сайта».

Вкладка «Социальные мета» при настройке плагина All in One SEO Pack

Переходим к следующему большому элементу меню «Социальные мета«. Его также необходимо отдельно включить в разделе с модулями. Этот пункт отвечает за Open Graph микроразметку Ваших страниц на сайте. Более подробно об этой микроразметке читайте данной статье:

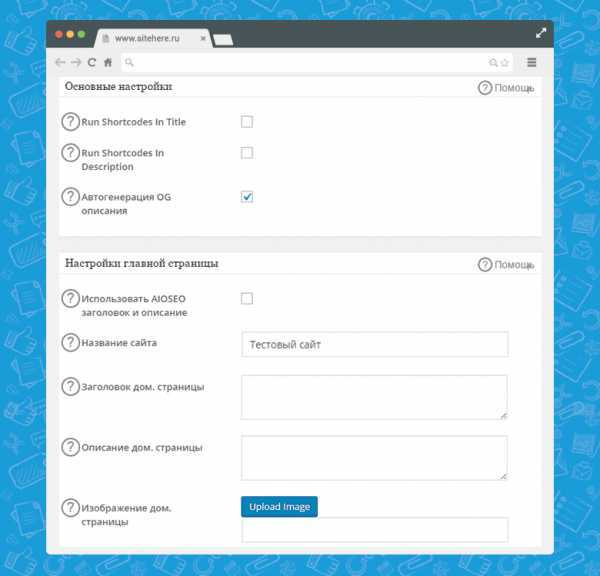

Здесь также очень много пунктов, поэтому разобьем на несколько частей. Рассмотрим первые 2 блока «Основные настройки» и «Настройки главной страницы«:

Начнем с блока «Основные настройки» и как выставить настройки для правильного функционирования плагина All in One SEO Pack:

А сейчас рассмотрим блок «Настройки главной страницы«:

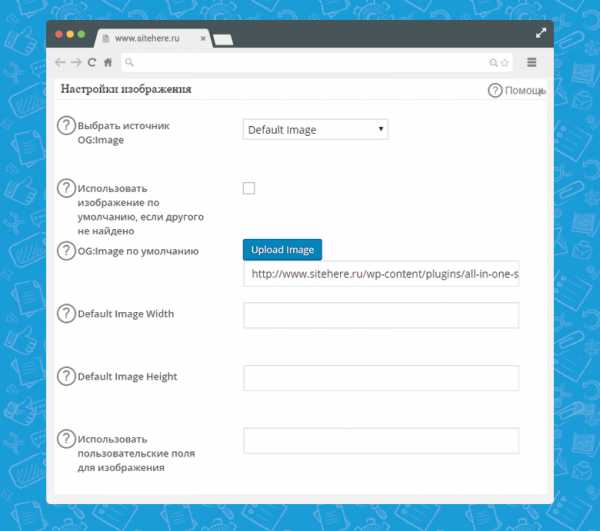

Переходим к следующему блоку «Настройки изображения«:

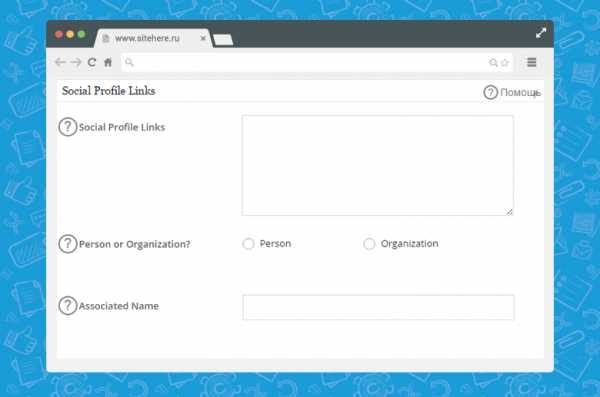

Мы уже рассмотрели достаточно много параметров по настройке каждого пункта в плагине All in One SEO Pack. Осталось не так много. На очереди блок «Social Profile Links«:

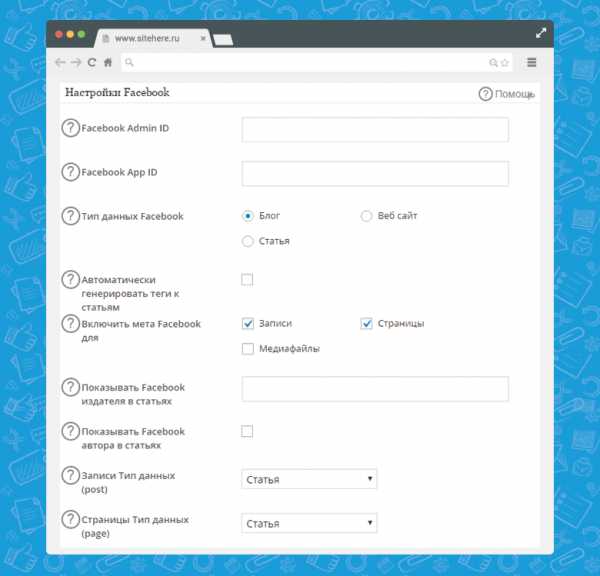

Следующий блок по настройке плагина All in One SEO Pack — это «Настройки Facebook«. Он содержит большое количество разнообразных настроек, которые посвящены социальной сети Facebook. Правильно настроив, можно узнать на какие из статей больше всего кликают, и какие кнопки по дизайну наиболее кликабельны:

Чтобы не переходить в другую тему, я не буду рассматривать в данной статье процесс подключения Facebook API для своего сайта, я лишь опишу настройки, которые необходимо вписать в данный плагин:

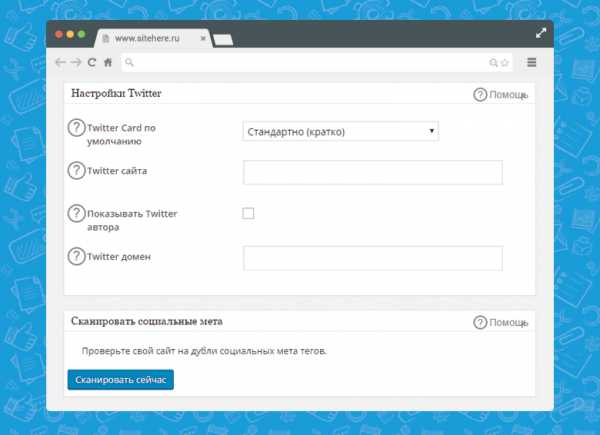

Остались 2 блока в данном элементе меню: «Настройки Twitter» и «Сканировать социальные мета«. Как обычно, начнем с первого блока:

На сайте могут быть дубли мета тегов. Потому что мета теги могут быть созданы с помощью темы или просто с помощью других плагинов. С помощью кнопки «Сканировать сейчас» можно проверить нет ли дублей. Если же дубли есть, то лучше использовать один плагин, а другой отключить. Если мета теги прописаны в шаблоне, то их можно оттуда удалить и использовать лишь данный плагин.

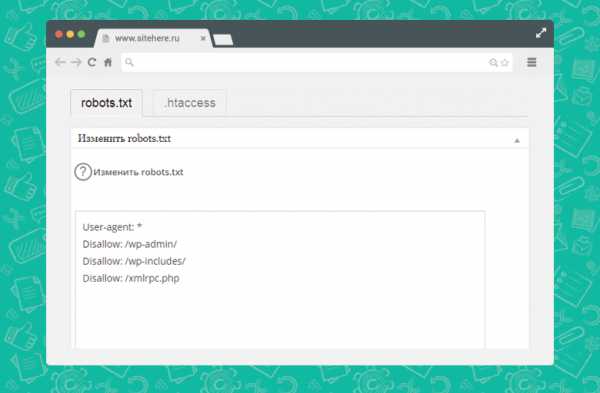

Вкладка «Robots.txt» при настройке плагина All in One SEO Pack

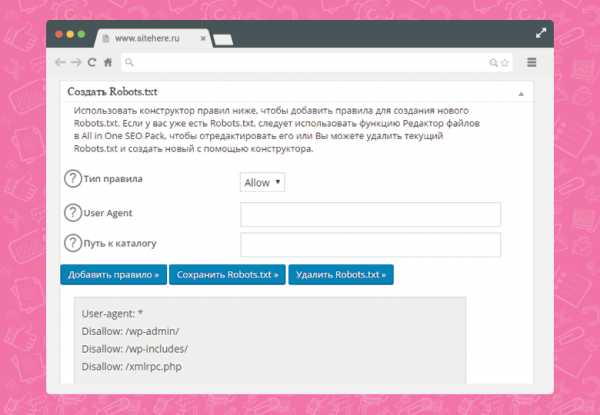

Следующий пункт меню, который также необходимо разобрать в плагине All in One SEO Pack — это «Robots.txt«. По сравнению с предыдущими блоками он не такой объемный. Как Вы могли догадаться из его названия, он отвечает за настройку файла Robots.txt. Намного удобнее работать с файлом прямо из панели управления сайтом. Итак, вот основные настройки этого пункта меню:

С помощью данной функции можно добавлять правила, которые разрешают или запрещают индексирование отдельных частей Вашего сайта. Давайте рассмотрим какие параметры необходимо ввести, чтобы добавить новое правило в Robots.txt:

После чего необходимо нажать на кнопку «Добавить правило», а затем «Сохранить Robots.txt». Также есть кнопка «Удалить Robots.txt». Немного ниже идет блок, в котором можно оптимизировать Ваш Robots.txt. Возможно, что Вы ввели одинаковые параметры но не заметили этого, для этого можно проверить с помощью этого пункта Ваш файл настроек и он сразу даст рекомендации по исправлению.

Вкладка «Редактор файлов» при настройке плагина All in One SEO Pack

Но в пункте меню «Robots.txt» нет возможности отредактировать файл по-своему желанию. Для этого предназначена следующий пункт «Редактор файлов«:

В сравнении с прошлым пунктом, здесь можно делать все что угодно с Вашими файлами robots.txt и .htaccess. Это очень удобно, опять же, потому что не нужно заходить через FTP протокол, а все можно сделать из панели управления. Особенно полезна данная функция для начинающих веб-мастеров, которые боятся навредить своему сайту неправильными действиями. А так как разработчики внедрили данную функцию, то то стало большим плюсом при настройке плагина All in One SEO Pack прямо из панели управления.

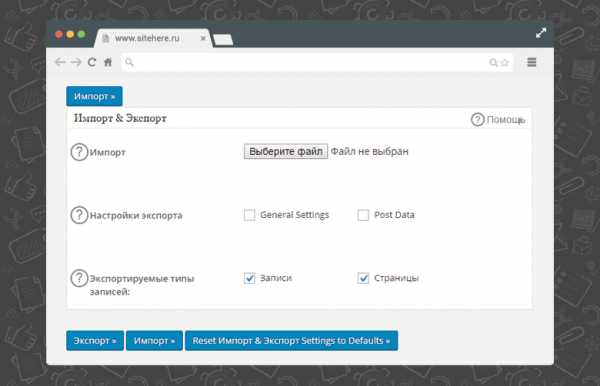

Вкладка «Импорт & Экспорт» при настройке плагина All in One SEO Pack

Далее пункт меню «Импорт & Экспорт«:

Если у Вас несколько сайтов, то нет необходимости настраивать каждый раз плагин заново. Настройки можно экспортировать, а затем импортировать на новом сайте. Для этого предназначен данный модуль. Его также необходимо включить в управлении модулями. Потому что по умолчанию он отключен.

Кликая на кнопку «Экспорт» Вы создадите файл экспорта с данными, которые выбрали выше.

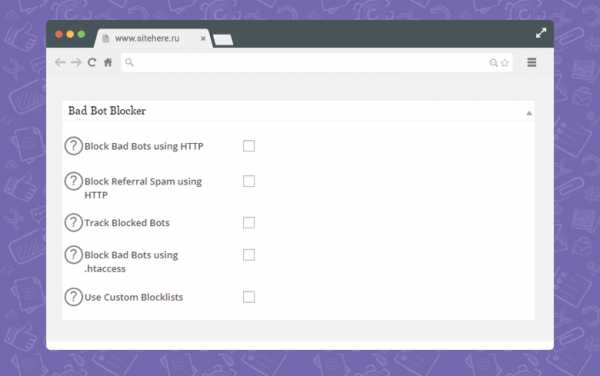

Вкладка «Bad Bot Blocker» при настройке All in One SEO Pack

И последний модуль «Bad Bot Blocker«:

Данный модуль применяется для блокировки нежелательных ботов на Вашем сайте, которые в автоматическом порядке заполняют формы на сайте и отправляют ненастоящие данные. Этот модуль нуждается в тестировании именно на Вашем сайте. Ниже я лишь опишу пункты настроек этого модуля:

Тест на закрепление материала статьи по настройке плагина All in One SEO Pack

Ваш результат:

Оценка:

Вконтакте

Поделитесь своим результатом с друзьями

с помощью кнопок социальных сетей выше!

Содержание статьи «Вторая часть настройки плагина All in One SEO Pack»

Вывод по статье «All in One SEO Pack правильная настройка — Часть 2»

Сейчас Вы можете полноценно настроить плагин All in One SEO Pack и использовать его по максимуму. Внимательно уделите внимание модулям. Я описал все модули, но Вы должны самостоятельно решить именно для своего сайта какой именно модуль Вам подходит больше всего и затем включать его. У этого плагина есть классная возможность отключения неиспользуемых модулей, таких как «Импорт & Экспорт» и так далее.

Успехов!

С Уважением, Юрий Немец

sitehere.ru

31 сервис для оценки качества текстов и SEO-оптимизации сайтов

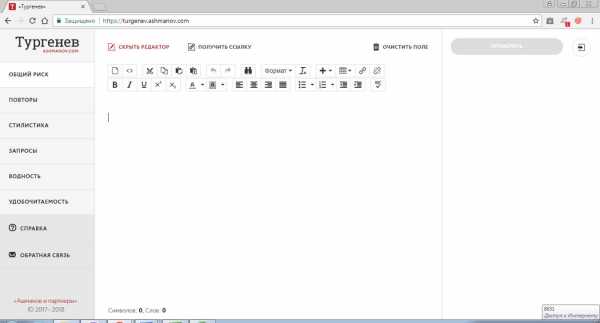

Больше всего экспертов волнуют уникальность текстов, орфография и грамматика, составление ТЗ и проверка соответствия требованиям ТЗ, технические параметры (тошнотность, водность и др.). «Прорывом года» можно назвать сервис «Тургенев».

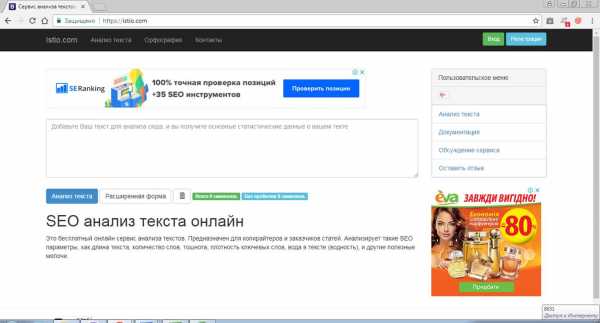

Более или менее регулярно анализируют семантику текстов при помощи этого сервиса 25% наших респондентов. Онлайн-программа высчитывает тошноту, водность, заспамленность и другие важные для текстовой оптимизации параметры. Визуально оценить, где скопилось больше всего неподходящих слов, можно на специальной карте (они выделяются цветом).

Оксана Артюшенко, SEO-специалист студии «Импульс-дизайн»:

«На Istio.com (для тошноты текстов) перепроверяю, если у меня есть сомнения в копирайтере или визуально кажется, что какие-то слова постоянно повторяются. Такое обычно наблюдается в тематиках, где нет синонимов, типа: окна. Читаешь текст, а там слово «окно» в каждом предложении, а тебе нужно пройти формальный барьер, например, на бирже Miralinks. (В Миралинкс есть формальные требования по статьям, которые нужно пройти, включая перетошноту. Там порой, даже если на вкус обывателя текст ОК, для прохождения минимального порога приходится уменьшать тошноту слов чисто формально). Им же можно измерить длину текста, если это критично».

Елена Колесник, SEO-специалист в компании Penguin-team:

«Сервисы, которыми постоянно пользуюсь при проверке качества текстов: https://content-watch.ru/text/, https://text.ru/, http://istio.com/».

Кристина Дзюба, контент-менеджер OdesSeo:

«Istio порадует и копирайтеров, и SEO-специалистов, т.к. при кажущейся простоте он позволяет комплексно оценить текст, высчитать тошноту, водность, количество знаков с пробелами и без, заспамленность и т.д. Также здесь есть такая интересная вещь, как карта слов, позволяющая визуально оценить количество ключевых слов в тексте».

Олег Скрып, руководитель Apollon.Guru, ментор SEO-материалов vc.ru:

«http://istio.com/rus/text/analyz – сервис, который позволяет определить ряд параметров: количество символов, переспам, проверка орфографии и т.д.».

Александр Демидов, CEO & Founder Sparkle Design:

«В основном мы пользуемся 3 инструментами для анализа: istio.com, сервис от miratex и advego. Обычно этого хватает для понимания того, насколько сам текст хорош, но, естественно, дополнительно прогоняем по задачам самого проекта и его ядру».

Инструментами текстовой оптимизации от Пиксель Тулс пользуются 14% наших респондентов. После регистрации пользователи сервиса могут оценивать качество оптимизации, анализировать структуру проектов, проверять тексты на соответствие ТЗ, в том числе по количеству вхождений ключевых фраз, анализировать SEO для списка URL, пользоваться визуальным HTML-редактором, проверять тексты на уникальность и генерировать технические задания для копирайтеров.

Евгения Перебейносова, руководитель группы поискового продвижения агентства RACURS (ГК «Риалвеб»):

«Для определения дополнительных параметров прибегаем к сервису «Оценка текста» от Пиксель Тулс. Наибольшую практическую значимость имеют проценты вхождений ТОП-10 слов по частоте и биграмм по частоте. Эти показатели позволяют сделать выводы о плотности ключевых запросов и количестве вхождений, а также сопоставить с конкурентами из ТОП-10 поисковой выдачи».

Светлана Ищенко, SEO-специалист компании Raskrutka.com.ua:

«Кроме всем известных сервисов advego.ru, text.ru и content-watch.ru для проверки уникальности, дополнительно используем istio.com для проверки тошноты и Пиксель Тулс для выявления естественных словоформ и синонимических фраз. А для проверки морфологических и синтаксических ошибок используем MS Word, Главред и languagetool.org».

Дмитрий Севальнев, руководитель департамента SEO и рекламы «Пиксель Плюс»:

«Активно используем сервисы оценки текстов:

Инструменты Google Analytics предоставляют SEO-мастерам аналитические решения, сопутствующие продукты, сборники статистики, отчеты, мобильные решения, приложения и бизнес-инструменты, которые помогают продвигать сайты в выдаче этой поисковой системы.

Иван Легенченко, руководитель агентства интернет-маркетинга Digital-market.pro:

«Меня как маркетолога интересует прежде всего результат, который можно достичь при публикации определенного текста. Поэтому для меня главные сервисы (в т.ч. по анализу качества контента): ПС Google, ПС Yandex, Google Analytics, Yandex Metrica, Webvisor. Ведь не существует более мощных программ по анализу контента, чем у самих поисковых систем, так что нужно пользоваться».

Yandex Metrica – бесплатный интернет-сервис, который помогает оценивать посещаемость сайта, анализировать поведение пользователей, измерять конверсию интернет-рекламы, сайта. При этом нежелательные переходы не учитываются. Инструмент Webvisor дает возможность просматривать данные о поведении пользователей в видеоформате. Отчеты можно обновлять каждые 5 минут.

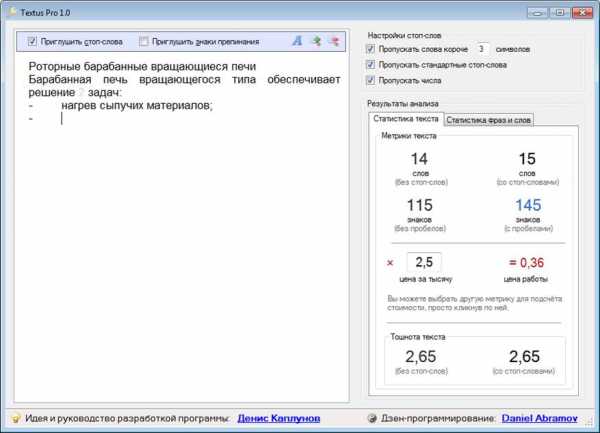

5. Textus Pro

Textus Pro помогает копирайтерам и их заказчикам анализировать тексты – высчитывает статистику использования ключевых слов, тошноту текста, помогает рассчитать стоимость работы. Программу нужно устанавливать на компьютер.

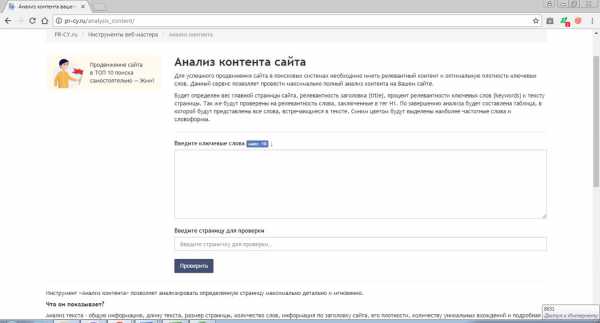

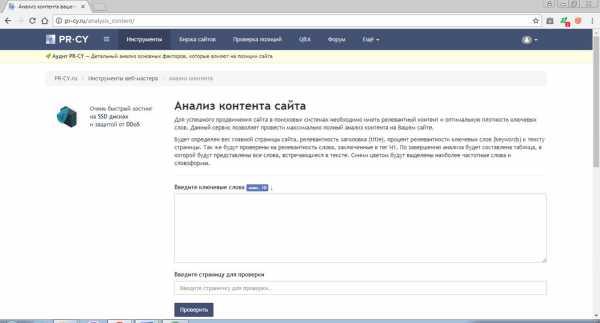

Функционал pr-cy.ru считает плотность ключевых слов, определяет вес главной страницы сайта, релевантность тегов Н1, выделяет цветом самые частотные слова, предлагает другие инструменты для анализа контента.

Сервис предназначен для мониторинга и контроля продвижения веб-проектов. С его помощью можно отслеживать позиции сайта в выдаче поисковых систем, координировать работы, контролировать выполнение сроков. Система мониторинга позиций дает возможность перепроверять запросы с течением времени (например, несколько раз в день).

Татьяна Аборонок, исполнительный директор группы компаний SEOWAVE:

«В своей работе используем https://text.ru/; https://content-watch.ru/; https://advego.com/plagiatus/; https://www.antiplagiat.ru/; http://plagiarisma.ru/; http://www.majento.ru/».

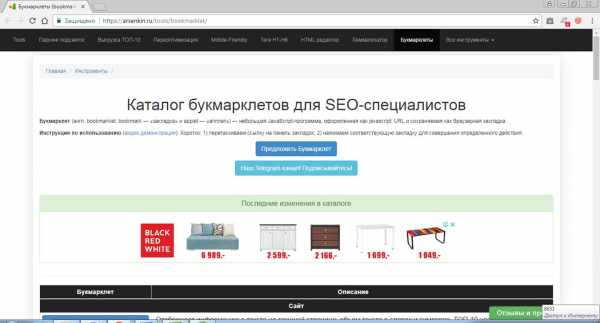

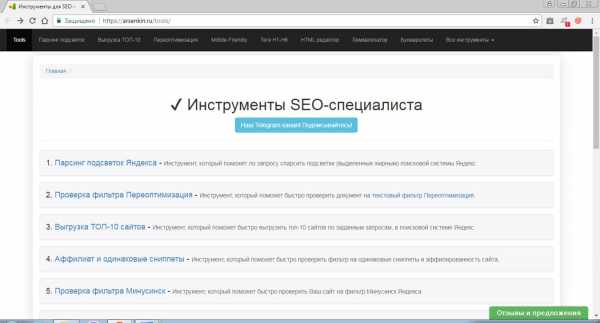

Букмарклеты – это небольшие JavaScript-программки, сохраняемые в виде браузерных закладок. Их используют для повышения удобства работы с текстом, например, для подсветки фрагментов, работы с cookie, подчеркивания ссылок, автоперевода, проверки индексации сайта и др. На https://arsenkin.ru/tools/bookmarklet/ собраны десятки таких удобных программок.

Евгения Перебейносова, руководитель группы поискового продвижения агентства RACURS (ГК «Риалвеб»):

«Для экспресс-анализа контента на сайте удобны букмарклеты. Добавив, например, text info на панель закладок, можно оперативно оценить первоначальную текстовую оптимизацию страницы по ключевым запросам – от объема текста до оптимизации изображений и внутренних ссылок».

«Тургенев» выявляет неестественные, переоптимизированные, заспамленные тексты, которые с высокой долей вероятности будут заблокированы Яндексом. Пользуются или пользовались сервисом 11% опрошенных нами специалистов в области SЕО. Некоторые респонденты отмечают, что программу еще нужно дорабатывать.

Мария Чумак, контент-редактор IT-компании TrendLine:

«Пару месяцев тестировали сервис «Тургенев», но нашли много несоответствий. Например, текст, который программа определяла как проблемный, занимал первые позиции в Яндексе. Надеемся, что через полгода-год сервис доработают, «заточат» для проверки различных типов контента (коммерческого, информационного), тогда и включим его в список программ для проверки качества текстов, которым можно доверять».

Юлия Лисова, SEO-копирайтер GUSAROV:

«В работе используем Advego Plagiatus – программа (не онлайн-версия), SEO-анализ на Text.ru, Istio (переспам), Главред, «Тургенев», https://content-watch.ru/text/».

Читабельность текстов помогает оценить бесплатный сервис PlainRussian. Проверяются уже размещенные на сайтах тексты (по ссылке) и тексты, которые еще только планируется размещать. Удобство чтения определяется по 5 формулам. Возможна автоматизированная проверка текстов по API.

Онлайн-сервисы http://1y.ru/ проверяют, насколько естественен составленный копирайтером текст. Это помогает проверить тексты на переспам ключевыми словами и выяснить, сколько ключевых слов нужно убрать для того, чтобы текст стал легче восприниматься читателями.

Евгения Перебейносова, руководитель группы поискового продвижения агентства RACURS (ГК «Риалвеб»):

«Если ваша профессиональная деформация достигла того предела, когда 3 вхождения запроса «купить недорого межкомнатные двери в спб» на 300 знаков вы считаете нормой, стоит обратиться к суровой статистике частоты слов в естественной речи людей. В данном случае будет интересен сервис 1y.ru, который проанализирует контент по закону Ципфа».

Два наших респондента указали, что пользуются функцией бесплатного подсчета ключевых фраз на сервисе Семён Ядрён. Он создан для разработки семантических ядер сайтов любых размеров, но это уже платная услуга.

Оксана Артюшенко, SEO-специалист студии «Импульс-дизайн»:

«Инструмент Подсчет количества фраз у Семена Ядрина (б/п, но доступен только после регистрации) помогает узнать, все ли запросы разместил копирайтер в тексте. Причем находит он их даже в склонениях. Это не совсем качество, но важно с точки зрения SEO – чтобы не искать десятки слов в тексте (особенно в больших)».

Олег Скрып, руководитель Apollon.Guru, ментор SEO-материалов vc.ru:

«Для проверки наличия всех ключевых фраз в тексте используем Семён Ядрён. Прежде, чем использовать этот сервис, нужно пройти простую бесплатную регистрацию».

Англоязычный сервис SEO Tools предоставляет в распоряжение пользователей десятки удобных инструментов для работы с текстом, изображениями, ключевыми словами, обратными ссылками, управления сайтами и их отслеживания, работы с прокси, доменами, мета-тегами, паролями, онлайн PDF.

Назарий Мазур, Product Manager N-iX (https://www.n-ix.com):

«В основном я работаю на за рубеж, и, как по мне, эти 3 сервиса – лучшее, что есть на рынке: smallseotools, grammarly, ahrefs».

14. Ahrefs (ahrefs.com/ru)

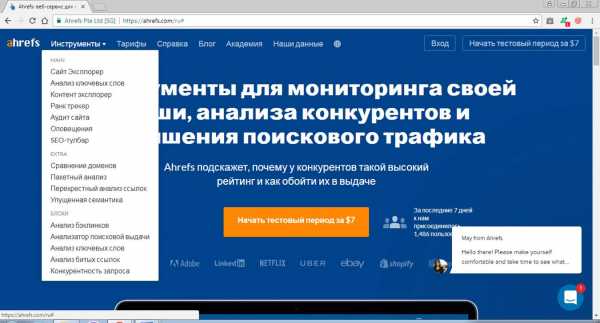

Платный русскоязычный сервис Ahrefs предоставляет в распоряжение заказчиков инструменты для мониторинга собственных сайтов и ресурсов конкурентов. Сервисы сайта дают возможность анализировать ключевые слова, бэклинки, контент, позиции, заниматься веб-мониторингом и предпринимать другие действия по улучшению поискового трафика.

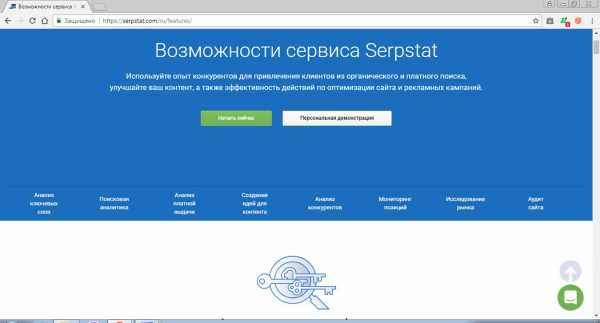

Многофункциональная SEO-платформа Serpstat позволяет анализировать ключевые слова, платную выдачу, сайты конкурентов, предоставляет инструменты для поисковой аналитики, мониторинга позиций, исследований рынка, проведения аудита сайта, дает возможность создавать идеи для контента. Начинать работу с системой можно после регистрации и оплаты.

Алексей Данилин, Product Manager в Serpstat, блогер:

«Для проверки соответствия текстов выдаче поисковых систем можно использовать текстовые анализаторы. У нас в Serpstat есть модуль «Текстовая аналитика», который решает такую задачу. Аналоги есть в Just-Magic и Rush Analytics. На выходе вы получаете статистику по ТОПу и можете подстроить свой текст под него. Тут стоит понимать, что со временем выдача может меняться. Кроме того, при формировании выдачи учитываются не только текстовые факторы. Поэтому результаты работы текстовых анализаторов стоит принимать во внимание, а не считать безоговорочным руководством к действию».

Михаил Шакин, автор блога http://shakin.ru/:

«Чтобы дооптимизировать текст, я проверяю страницы ведущих конкурентов по продвигаемым запросам на сервисе Serpstat.com. С помощью Серпстата я нахожу те запросы, по которым страницы конкурентов получают целевой трафик, и стараюсь органично добавить их в текст, чтобы не испортить его читабельность и привлекательность».

Пользователям предоставлены десятки полезных SEO-инструментов, в том числе парсинг подсветок, выгрузка ТОП-10 Яндекса, средство поиска переоптимизированных текстов, проверка тегов Н1−Н6 и Mobile-Frendly, HTML-редактор, лемматизатор, набор букмарклетов.

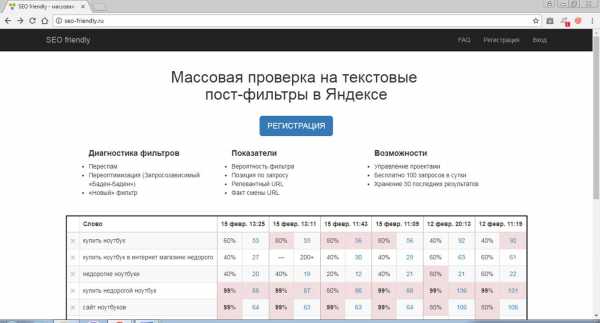

На основе попарного сравнения с сайтами, расположенными выше в ТОП выдачи, сервис определяет вероятность попадания проверяемого сайта под фильтры. Зарегистрировавшись в сервисе, можно проверять в среднем по 100 запросов в день (выдается 600 лимитов).

Алексей Чеканов, руководитель отдела SEO в компании Webline Promotion:

«Пользуемся http://seo-friendly.ru/, https://turgenev.ashmanov.com/, https://text.ru/seo, http://spell-checker.ru/, https://glvrd.ru/, https://content-watch.ru/text/, https://orfogrammka.ru/, https://arsenkin.ru/tools/filter/, https://tools.pixelplus.ru/tools/reoptimization».

Инструментарий англоязычного сервиса SEMrush позволяет выполнять технический SEO-аудит сайтов, автоматизировать рабочие SEO-процессы, отслеживать позиции собственного сайта и сайтов конкурентов, создавать семантические ядра на основе предложенных коллекций, а также предоставляет идеи для повышения траффика.

Юлия Рамьялг, SEO-оптимизатор в MobiDev, фрилансер в http://seowest.org/:

«Поскольку я работаю под западный сегмент, то основной инструмент при составлении ТЗ – SEMrush. С его помощью нахожу ТОПовые статьи у конкурентов, анализирую их семантику. Инструмент SEO Content Template дает базовое понимание необходимых параметров будущего текста, анализирует SEO-факторы сайтов в ТОП-10 по заданному ключевому слову».

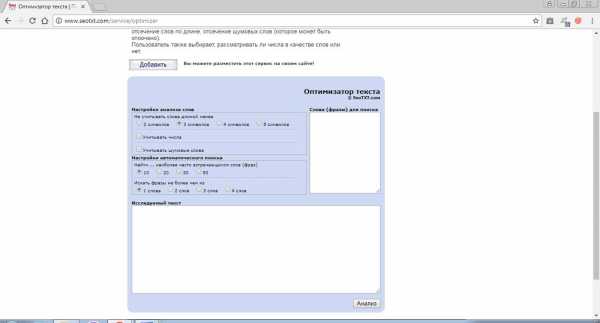

Seotxt.com используется для определения плотности в тексте ключевых слов и фраз. Помимо оптимизатора текста, сервис предлагает пользователям инструменты для анализа страниц и 3 разновидности генераторов ключевых слов (обычный, exp и pro).

Евгения Кривко, SEO Team Lead компании CyberShark (Днепр, Украина):

«Для проверки качества текстов используем много инструментов, для проверки плотности ключевых слов – seotxt.com/service/optimizer/».

Иван Жданович, руководитель в seo-house.com:

«Вхождение ключей в текст иногда проверяю http://www.seotxt.com/service/optimizer/».

Инструментарий cy-pr.com позволяет проводить комплексный анализ сайтов. Сервис предоставляет информацию об описании, названии, ключевых словах, скорости работы, текущем статусе домена, сведения о регистрации и регистраторе, истории, кэше сайта проверяет валидность кодов, выполняет другие полезные для оптимизаторов действия.

Евгения Кривко, SEO Team Lead компании CyberShark (Днепр, Украина):

«Контент анализируем на http://pr-cy.ru/analysis_content/ и https://www.cy-pr.com/tools/analyzer/ для проверки страницы с опубликованным текстом – здесь подсчитывается вес слов на странице, а также показываются заголовки h2-h6, что позволяет быстро понять, насколько хорошо структурирован текст».

Назначение сервиса – анализ контента сайта по ключевым словам, определение веса главной страницы, релевантности заготовка, тега Н1, естественности текста, других важных для SEO-оптимизации параметров. Сервис умеет работать с новыми текстами длиной от 100 до 15 тыс. символов и уже существующими веб-страницами.

Алексей Славгородский, интернет-маркетолог, руководитель проекта Performance SEO:

«Порадовал http://pr-cy.ru/zypfa/. Сам сервис мы много лет использовали при базовых SEO-аудитах, теперь же есть раздел, анализирующий текст по закону Ципфа. Это то, что нужно с учетом актуальных требований поисковиков к естественности текста».

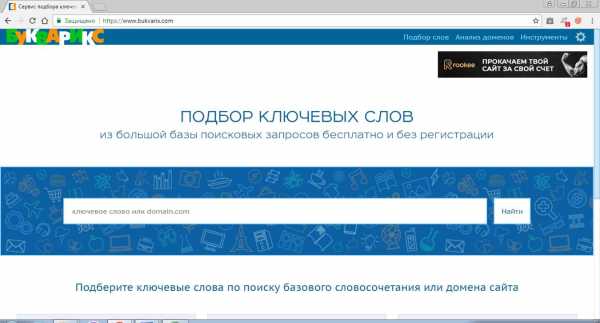

Бесплатный сервис Букварикс помогает выбирать подходящие ключевые слова из базы поисковых запросов, анализировать сайты конкурентов, выделять семантические ядра и суперядра. Ключевые слова подбираются по базовому словосочетанию или домену. Все функции сервиса доступны без регистрации.

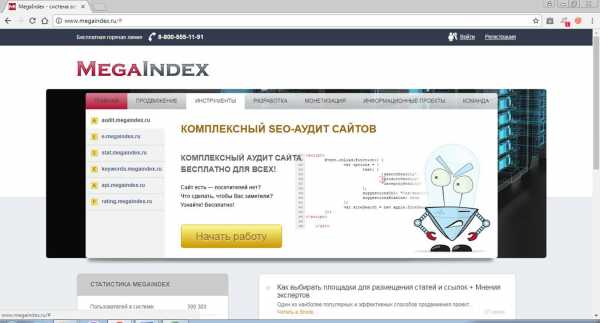

Бесплатный сервис предлагает SEO-мастерам инструменты, необходимые для комплексного аудита и продвижения сайтов. Есть полезные решения для разработчиков и предложения по монетизации ресурсов.

Платный сервис Just-magic.org предлагает набор инструментов, которые помогут автоматизировать работу SEO-специалиста, существенно сэкономив его время и силы. Система подбирает семантику, выполняет текстовый анализ страниц, кластеризует запросы, составляет списки LSI-слов.

Еще один платный сервис, функционал которого также автоматизирует работу SEO-оптимизаторов. Система самостоятельно проверяет позиции сайтов в Яндекс и Google, кластеризует до 10 тыс. ключевых слов, собирает ключевые слова со скоростью 200 подсказок в секунду, собирает данные Wordstat, проверяет индексацию со скоростью до 100 тыс. URL в час. Текстовый анализатор проверяет страницу целиком.

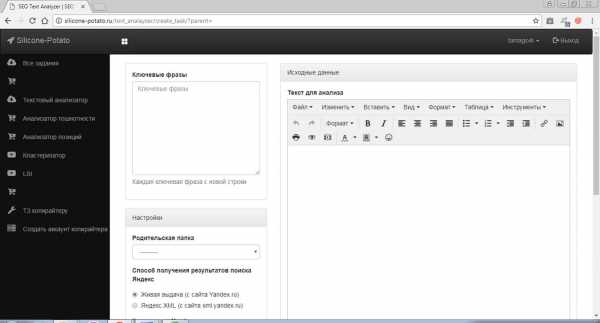

Бесплатный сервис предоставляет в распоряжение пользователей текстовый анализатор, проверку текстов на наличие и плотность ключевых слов, тошнотность, дает возможность анализировать их позиции, кластеризует ключевые слова, подбирает LSI-слова. Есть опция составления технических заданий.

Платная программа предназначена для изучения индексации сайта. Она сканирует все страницы сайта, собирает адреса проиндексированных Яндексом и Google страниц, важную информацию об индексации каждой из них. Бесплатная демо-версия программы обрабатывает первые 150 результатов выдачи или 150 страниц и не обновляется автоматически.

Валерий Сыщук, CEO WebForBiz:

«Проверяю уникальность на https://advego.com/antiplagiat/, стилистику – на https://glvrd.ru/. Основные теги для SEO-title, h2 и decsription проверяю анализатором Comparser».

Наши респонденты назвали еще несколько сервисов, которые облегчают работу с текстами:

Сервис помогает обрабатывать текстовые данные десятками разных способов. Например, за секунды выполнит онлайн-транслитерацию, перевернет его вверх ногами или задом наперед, подсчитает символы и слова, изменит регистр букв, удалит дубликаты строк и даже сгенерирует фразу или текстовый блок.

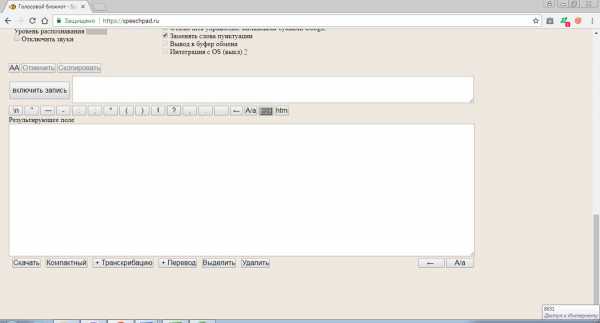

Сервис голосового ввода дает копирайтерам и их заказчикам возможность работать с текстами даже тогда, когда руки заняты чем-то (или кем-то) другим. Он распознает речь на 12 языках, работает в режиме онлайн или встраивается в браузер Chrome в качестве приложения, распознает аудиотексты в формате html5 и записи на Youtube. Работает функция синхронного перевода.

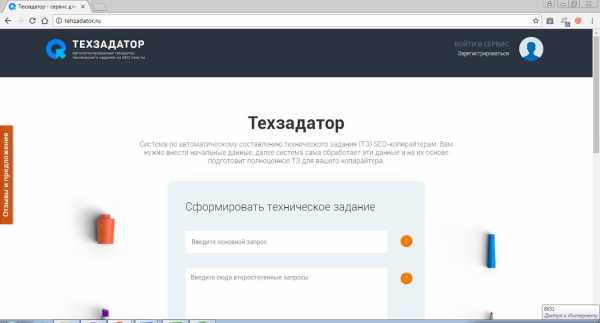

Правильно составленное техническое задание – один из ключевых аспектов хорошего текста. Автоматизировать процесс нашим респондентам помогает сервис http://tehzadator.ru/. После ввода исходных данных система их обрабатывает и выдает полноценное ТЗ, которое остается просто переслать копирайтеру.

Евгения Кривко, SEO Team Lead компании CyberShark (Днепр, Украина):

«Важная деталь для SEO-спецов/контент-маркетологов: одним из ключевых параметров качества текста является дотошно составленное ТЗ. Чем дотошнее, тем лучше. Если получился плохой текст, в первую очередь проверьте техническое задание, которое вы выдали копирайтеру».

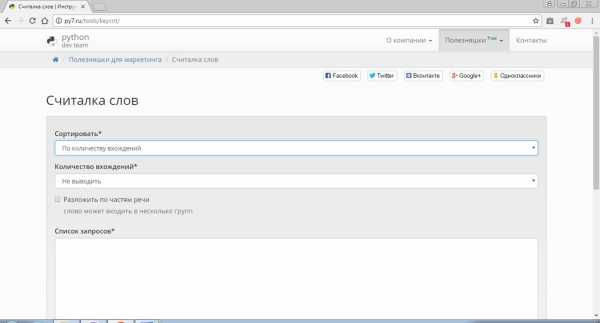

Бесплатный сервис Python помогает рассортировывать слова по количеству вхождений, алфавиту, частям речи.

Какие из ваших любимых сервисов мы упустили?

wordfactory.ua

|

whois.uanic.name

|

whois.uanic.name

|

whois.uanic.name

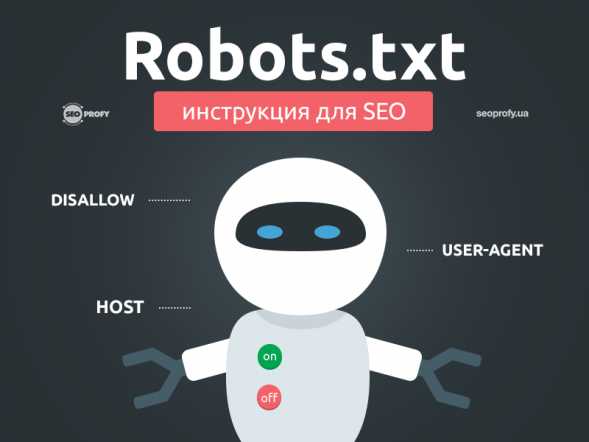

Robots.txt — инструкция для SEO

Файл robots.txt предоставляет важную информацию для поисковых роботов, которые сканируют интернет. Перед тем как пройтись по страницам вашего сайта, поисковые роботы проверяют данный файл.

Это позволят им с большей эффективностью сканировать сайт, так как вы помогаете роботам сразу приступать к индексации действительно важной информации на вашем сайте (это при условии, что вы правильно настроили robots.txt).

Но, как директивы в robots.txt, так и инструкция noindex в мета-теге robots являются лишь рекомендацией для роботов, поэтому они не гарантируют что закрытые страницы не будут проиндексированы и не будут добавлены в индекс.

Если вам нужно действительно закрыть часть сайта от индексации, то, например, можно дополнительно воспользоваться закрытие директорий паролем.

Основной синтаксис

User-Agent: робот для которого будут применяться следующие правила (например, «Googlebot»)

Disallow: страницы, к которым вы хотите закрыть доступ (можно указать большой список таких директив с каждой новой строки)

Каждая группа User-Agent / Disallow должны быть разделены пустой строкой. Но, не пустые строки не должны существовать в рамках группы (между User-Agent и последней директивой Disallow).

Символ хэш (#) может быть использован для комментариев в файле robots.txt: для текущей строки всё что после # будет игнорироваться. Данные комментарий может быть использован как для всей строки, так в конце строки после директив.

Каталоги и имена файлов чувствительны к регистру: «catalog», «Catalog» и «CATALOG» – это всё разные директории для поисковых систем.

Host: применяется для указание Яндексу основного зеркала сайта. Поэтому, если вы хотите склеить 2 сайта и делаете постраничный 301 редирект, то для файла robots.txt (на дублирующем сайте) НЕ надо делать редирект, чтобы Яндекс мог видеть данную директиву именно на сайте, который необходимо склеить.

Crawl-delay: можно ограничить скорость обхода вашего сайта, так как если у вашего сайта очень большая посещаемость, то, нагрузка на сервер от различных поисковых роботов может приводить к дополнительным проблемам.

Регулярные выражения: для более гибкой настройки своих директив вы можете использовать 2 символа

- * (звездочка) – означает любую последовательность символов

- $ (знак доллара) – обозначает конец строки

Основные примеры использования robots.txt

Запрет на индексацию всего сайта

User-agent: *

Disallow: /

Эту инструкцию важно использовать, когда вы разрабатываете новый сайт и выкладываете доступ к нему, например, через поддомен.

Очень часто разработчики забывают таким образом закрыть от индексации сайт и получаем сразу полную копию сайта в индексе поисковых систем. Если это всё-таки произошло, то надо сделать постраничный 301 редирект на ваш основной домен.

А такая конструкция ПОЗВОЛЯЕТ индексировать весь сайт:

User-agent: *

Disallow:

Запрет на индексацию определённой папки

User-agent: Googlebot

Disallow: /no-index/

Запрет на посещение страницы для определенного робота

User-agent: Googlebot

Disallow: /no-index/this-page.html

Запрет на индексацию файлов определенного типа

User-agent: *

Disallow: /*.pdf$

Разрешить определенному поисковому роботу посещать определенную страницу

User-agent: *

Disallow: /no-bots/block-all-bots-except-rogerbot-page.html

User-agent: Yandex

Allow: /no-bots/block-all-bots-except-Yandex-page.html

Ссылка на Sitemap

User-agent: *

Disallow:

Sitemap: http://www.example.com/none-standard-location/sitemap.xml

Нюансы с использованием данной директивы: если у вас на сайте постоянно добавляется уникальный контент, то

- лучше НЕ добавлять в robots.txt ссылку на вашу карту сайта,

- саму карту сайта сделать с НЕСТАНДАРТНЫМ названием sitemap.xml (например, my-new-sitemap.xml и после этого добавить эту ссылку через «вебмастерсы» поисковых систем),

так как, очень много недобросовестных вебмастеров парсят с чужих сайтов контент и используют для своих проектов.

Статья в тему: Создаем sitemap для Google и Яндекс

Что лучше использовать robots.txt или noindex?

Если вы хотите, чтобы страница не попала в индекс, то лучше использовать noindex в мета-теге robots. Для этого на странице в секции <head> необходимо добавить следующий метатег:

<meta name=”robots” content=”noindex, follow”>.

Это позволит вам

- убрать из индекса страницу при следующем посещение поискового робота (и не надо будет делать в ручном режиме удаление данной страницы, через вебмастерс)

- позволит вам передать ссылочный вес страницы

Через robots.txt лучше всего закрывать от индексации:

- админку сайта

- результаты поиска по сайту

- страницы регистрации/авторизации/восстановление пароля

Как и чем проверить файл robots.txt?

После того, как вы окончательно сформировали файл robots.txt необходимо проверить его на ошибки. Для этого можно воспользоваться инструментами проверки от поисковых систем:

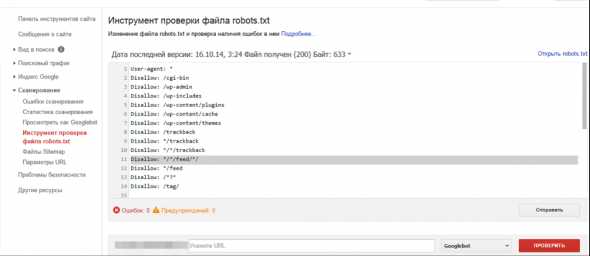

Google Вебмастерс: войти в аккаунт с подтверждённым в нём текущим сайтом, перейти на Сканирование -> Инструмент проверки файла robots.txt.

В данном инструменте вы можете:

- сразу увидеть все свои ошибки и возможные проблемы,

- прямо в этом инструменте провести все правки и сразу проверить на ошибки, чтобы потом уже перенести готовый файл себе на сайт,

- проверить правильно ли вы закрыли все не нужные для индексации страницы и открыты ли все нужные страницы.

Яндекс Вебмастер: чтобы воспользоваться данным инструментом просто перейдите по этой ссылке http://webmaster.yandex.ru/robots.xml.

Этот инструмент почти аналогичный предыдущему с тем небольшим отличием, что:

- тут можно не авторизоваться и нет необходимости в подтверждении прав на сайт, а поэтому, можно сразу приступать к проверке вашего файла robots.txt,

- для проверки сразу можно задать список страниц, а не вбивать их по одному,

- точно убедиться, что Яндекс правильно понял ваши инструкции.

В заключение

Создание и настройка robots.txt является в списке первых пунктов по внутренней оптимизации сайта и началом поискового продвижения.

Важно его настроить грамотно, чтобы нужные страницы и разделы были доступны к индексации поисковых систем. А не нужные были закрыты.

Но главное помнить, что robots.txt не гарантирует того, что страницы не будут проиндексированы. Как когда-то сказала наша коллега Анастасия Пареха:

Robots.txt — как презерватив, вроде защищает, но вероятность всегда есть)

Хорошие статьи в продолжение:

— 301 редирект – самое полное руководство

— Пагинация для SEO – пошаговое руководство

— Ответы сервера – практичная методичка

А что вы думаете про настройку robots.txt на сайте?

Оцените статью

Загрузка…seoprofy.ua