как узнать, что вы попались?

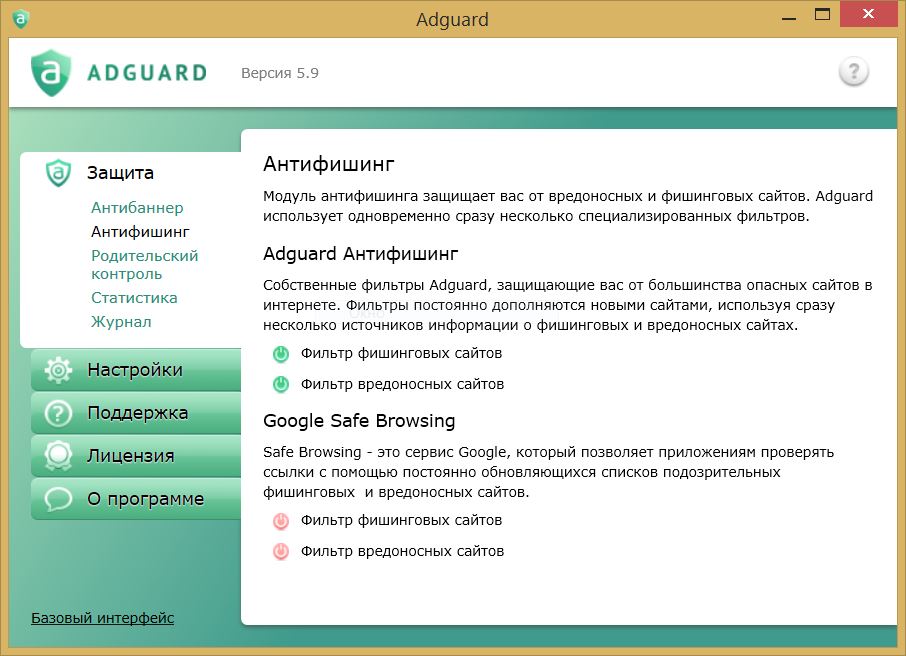

Под санкции Google или Яндекса попадают не только сайты, чьи владельцы увлекаются черным SEO. Проблема может возникнуть и из-за неопытности специалиста по продвижению. Не застрахован от фильтра и качественный ресурс, который находится в руках опытного сеошника. О том, как обнаружить проблему, рассказываем в статье.

Когда начинать беспокоиться?

Главные признаки того, что сайт попал под фильтр, — это снижение позиций в поисковой выдаче, полное выпадение из нее или уменьшение посещаемости. Если вы заметили изменения, попробуйте проанализировать ситуацию и найти фильтр, под который попал сайт.

Трафик проверяют с помощью Яндекс.Метрики, Google Analytics или другой подключенной системы. Если график посещений резко просел и это не связано с сезонными колебаниями или прочими органическими причинами, скорее всего, сайт попал под фильтр. Косвенные свидетельства санкций — это медленная или неполная индексация новых страниц, а также падение в выдаче по витальным запросам (поисковым фразам, которые содержат только название бренда или компании без дополнительных уточнений).

Совет. Не забывайте, что почти во всех проверках нужно сравнивать предыдущие и текущие показатели. Поэтому рекомендуется следить за позициями в выдаче и количеством пользователей регулярно. Это позволит вовремя заметить изменения.

Когда паниковать не стоит?

Чаще всего о попадании под фильтр говорит резкое снижение трафика или выпадение страниц из выдачи — более 30 % от общего количества. Такую ситуацию стоит отличать от органической динамики. В последнем случае позиции в поиске или посещаемость будут меняться постепенно. Если изменения небыстрые, искать фильтр нет необходимости. Лучше позаботиться о том, чтобы сделать ресурс более интересным и удобным для пользователей.

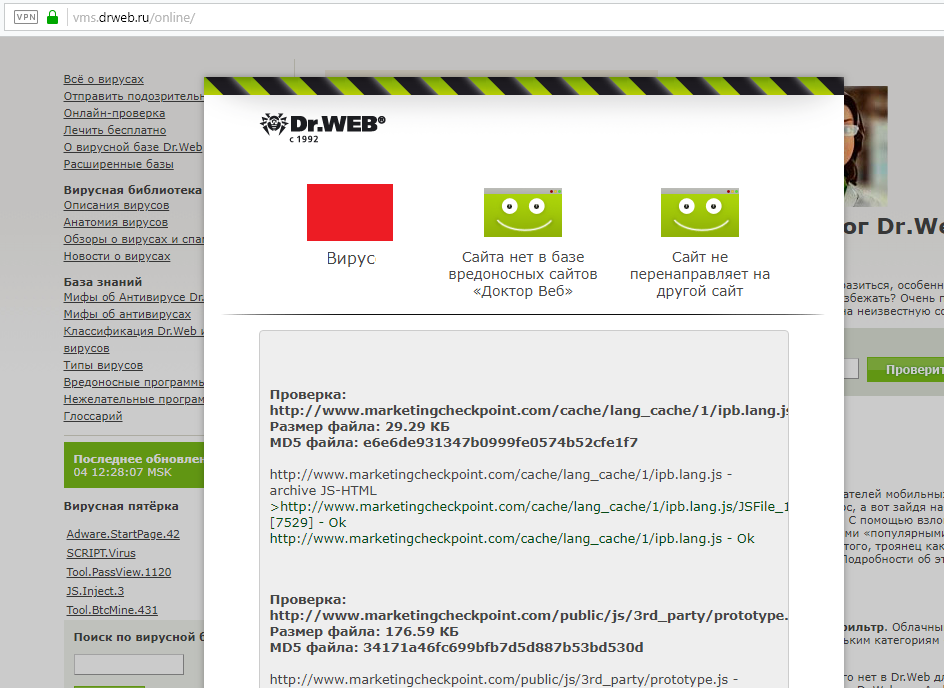

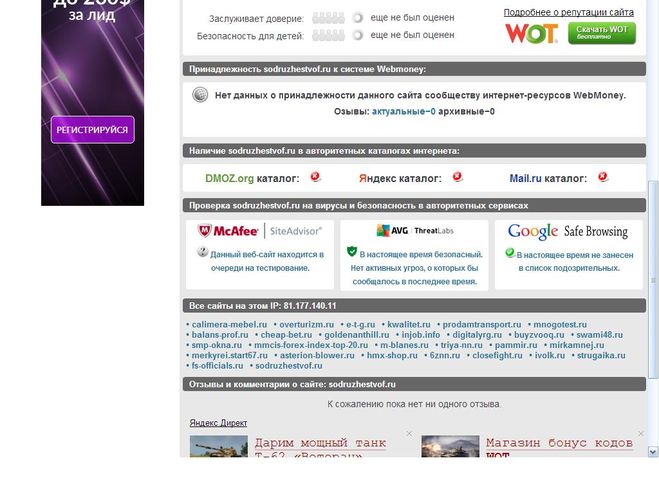

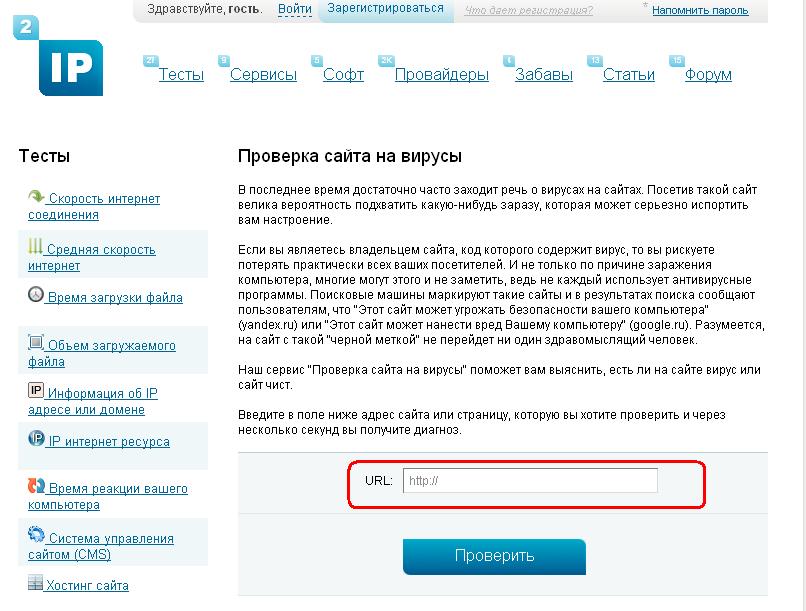

Кроме того, не забывайте, что ухудшить позиции могут не только фильтры. Частые причины падения посещаемости — это вирусы или взломы, запрет индексации сайта или страниц, временная недоступность для роботов и т. п. Перед тем как пенять на фильтр, убедитесь, что этих проблем нет. Даже если вы попали под санкции — паниковать не стоит. С такими ситуациями сталкиваются многие владельцы ресурсов, в том числе и те, кто точно соблюдает требования поисковиков к качеству.

Даже если вы попали под санкции — паниковать не стоит. С такими ситуациями сталкиваются многие владельцы ресурсов, в том числе и те, кто точно соблюдает требования поисковиков к качеству.

Уведомления в панели вебмастеров

С этого источника обычно начинают поиск. К другим проверкам переходят только, если данных в панелях веб-мастера нет или недостаточно.

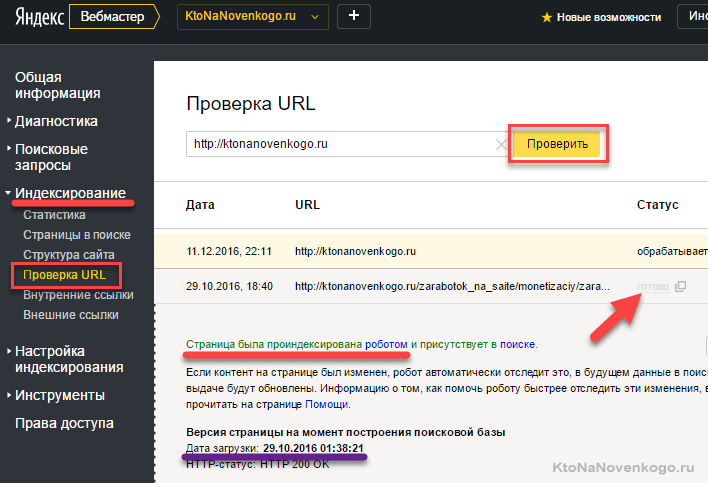

Яндекс.Вебмастер

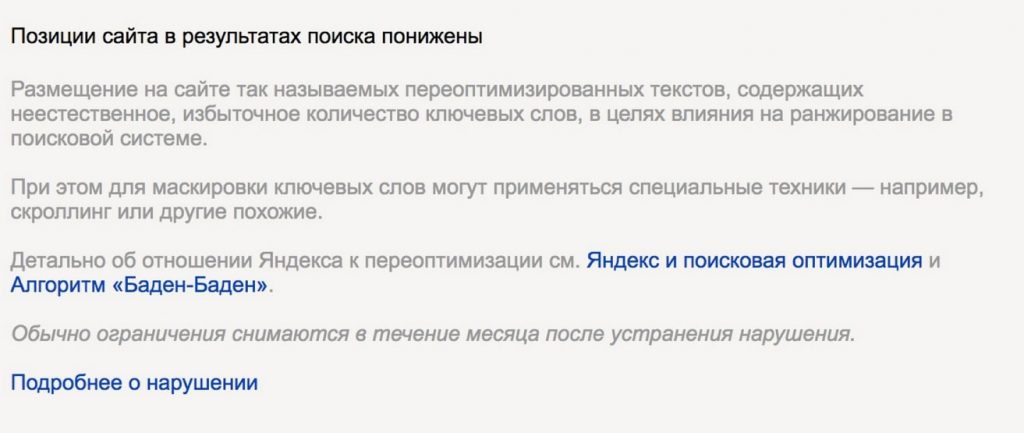

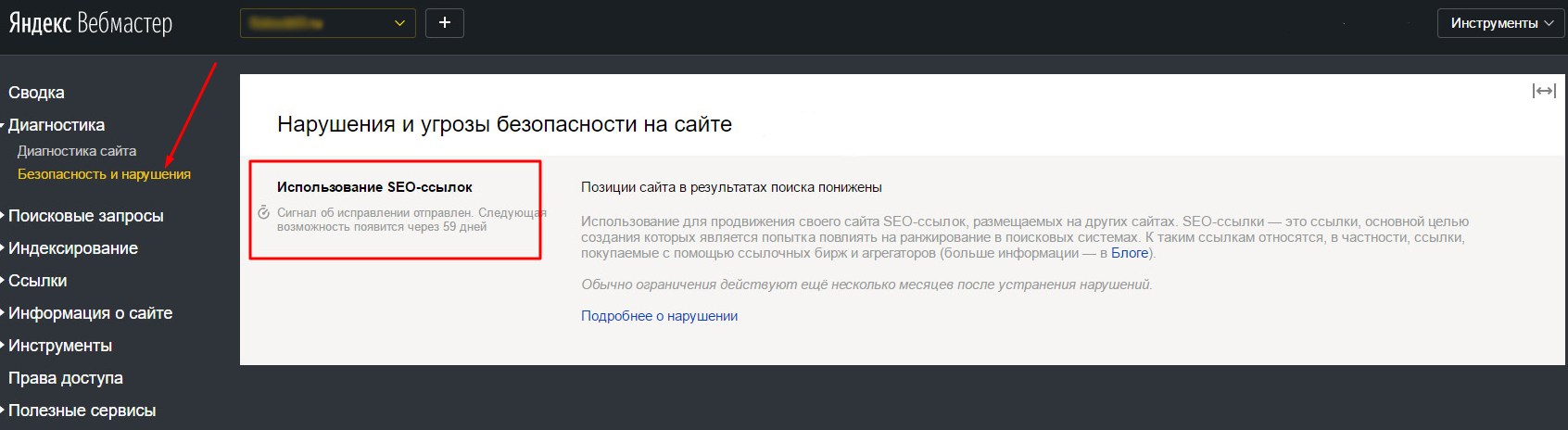

Фильтр в этой поисковой системе может быть наложен в ручном или автоматическом режиме. В первой ситуации сообщение о причине санкций будет в уведомлениях, во второй — его нужно искать в разделе с ошибками. Для этого перейдите на вкладку «Диагностика» и найдите подраздел с фатальными ошибками в сфере безопасности.

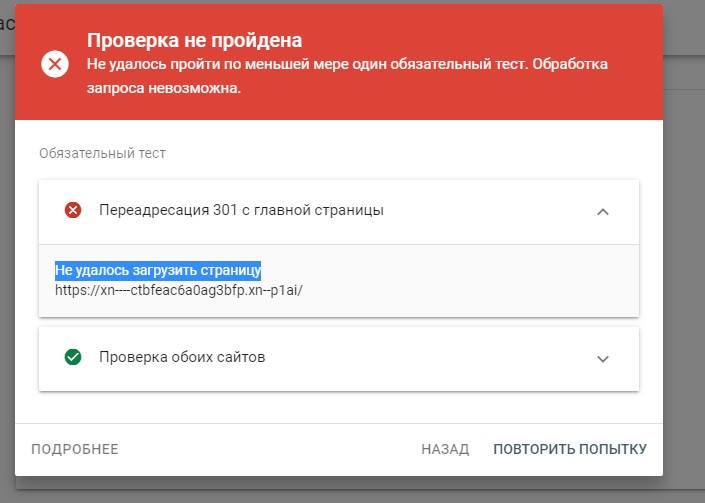

Google Search Console

Веб-служба Google информирует только о ручных фильтрах. Сообщение об ограничениях можно найти в «Проблемы безопасности и меры…», подраздел — «Меры, принятые вручную». В уведомлении будет указана причина попадания под фильтр и рекомендации по устранению проблемы. После исправления ошибок запросите повторную проверку, нажав на соответствующую кнопку в письме. Если все сделано правильно, то через некоторое время позиции восстановятся.

После исправления ошибок запросите повторную проверку, нажав на соответствующую кнопку в письме. Если все сделано правильно, то через некоторое время позиции восстановятся.

Если трафик просел после обновления поискового алгоритма, придется искать и устранять причину, руководствуясь общими правилами и интуицией.

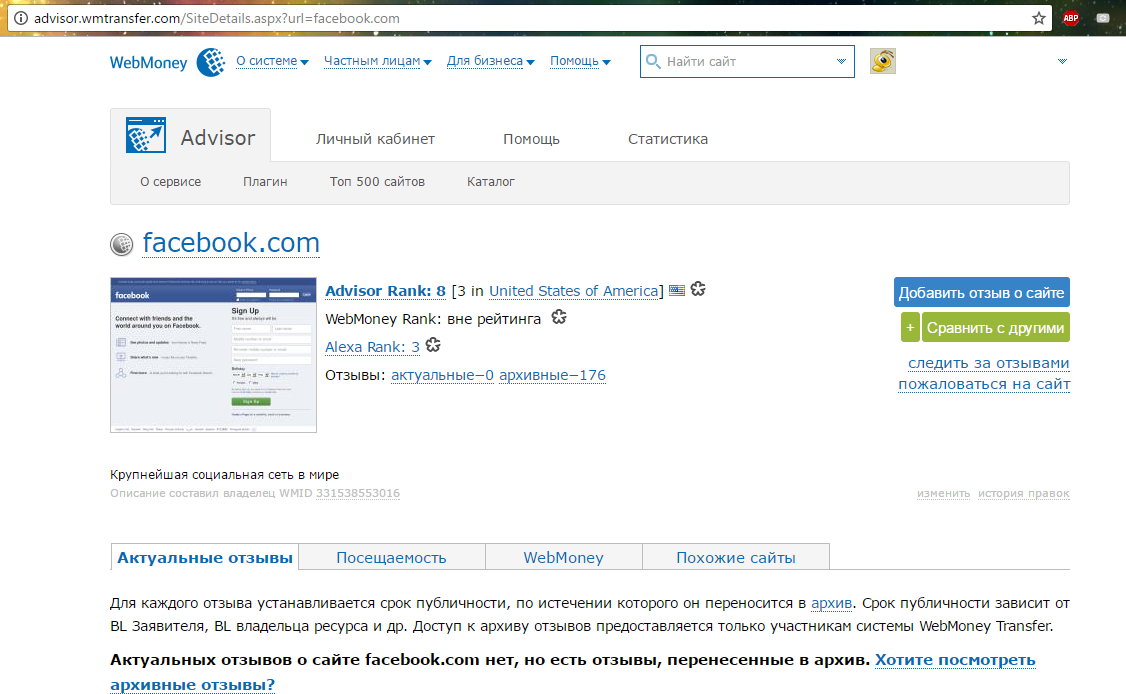

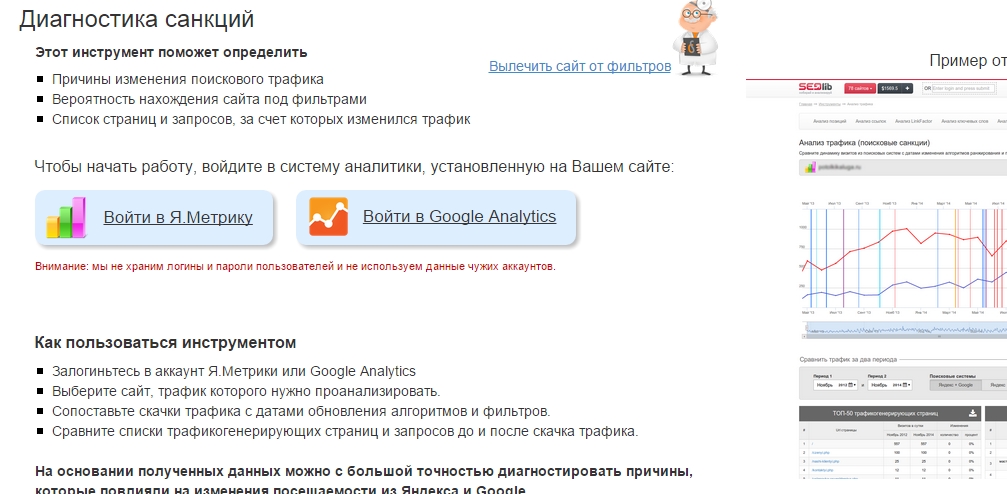

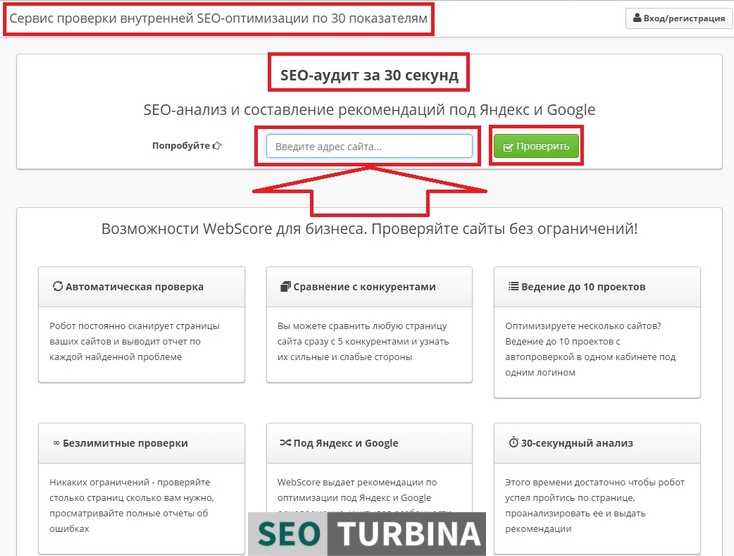

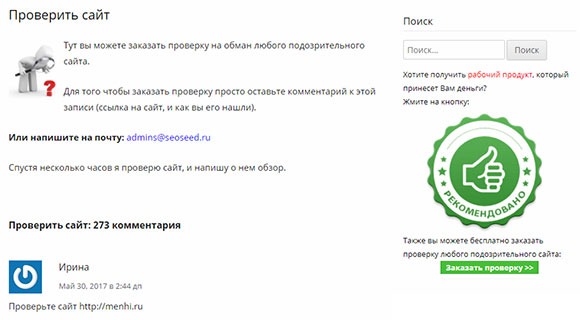

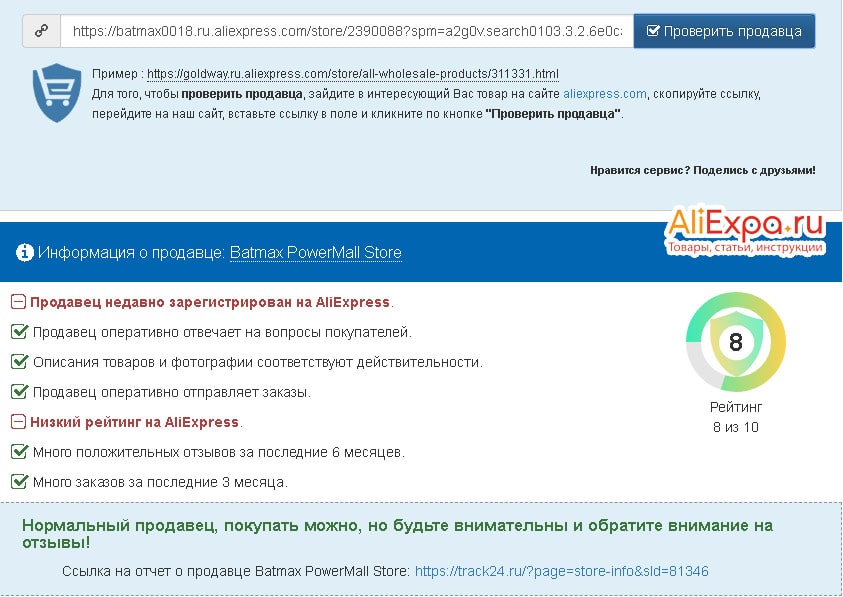

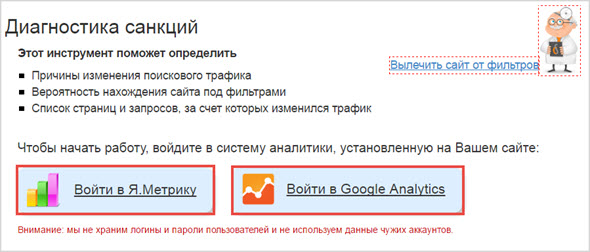

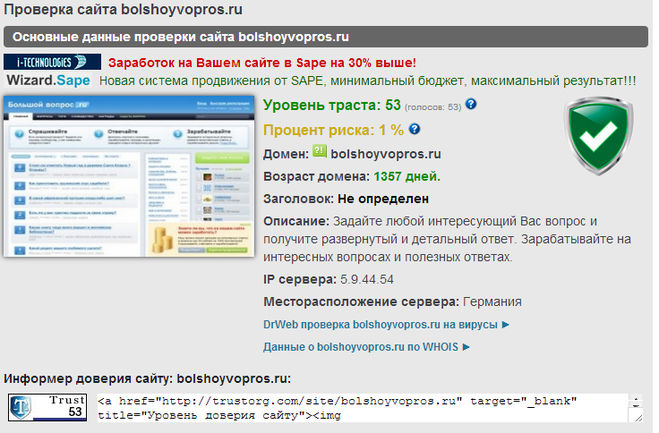

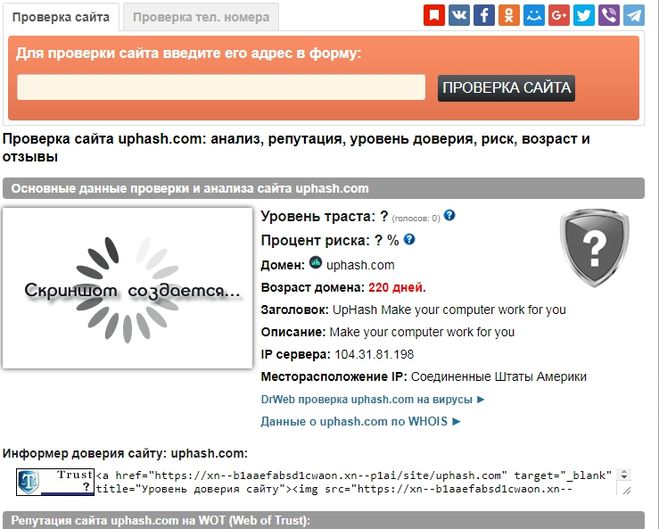

Онлайн-сервисы для проверки на фильтры

Еще один способ ответить на вопрос о том, попал ли сайт под фильтр, — специальные инструменты, которые анализируют не только активные санкции, но и оценивают вероятность их наложения. Многие из этих программ основаны на простом принципе. Они объединяют на одном графике информацию о посещаемости ресурса по датам и данные об обновлении фильтров поисковых систем. Это позволяет найти источник проблемы. Впрочем, есть и программы с другими алгоритмами.

Вот список нескольких популярных инструментов этого типа, однако он не исчерпывающий, и вы можете выбрать что-то другое:

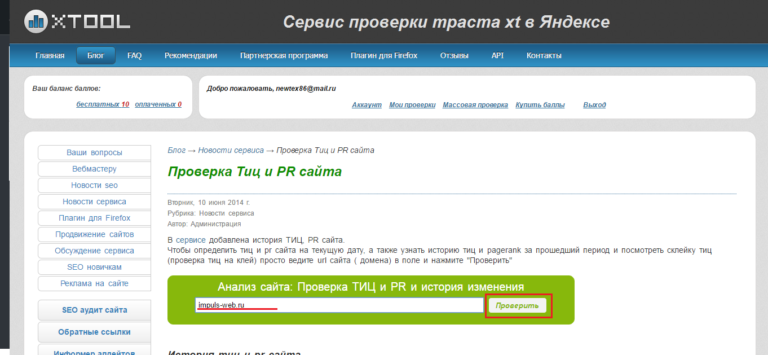

- Xtool.ru, он отлично работает с АГС, «Минусинском» и прочими фильтрами Яндекса;

- pr-cy.

ru, сервис определяет АГС от Яндекса;

ru, сервис определяет АГС от Яндекса; - инструменты barracuda.digital, программы находят «Панду», «Пингвина» и другие фильтры Google;

- SEOLib, он анализирует позиции сайта в Google и Яндексе;

- Website Penalty Indicator и Google Penalty Checker, эти программы ищут фильтры Google;

- SEMRush Sensor, инструмент подходит для анализа нестабильности позиций сайта в Google.

При использовании этих инструментов помните, что их надежность ниже, чем информация о фильтрах от самих поисковых систем. Ведь ни Яндекс, ни Google не раскрывают полные алгоритмы работы, поэтому все сторонние программы основаны на личном опыте их создателей.

Проверяем позиции и количество страниц в индексе

Заметить, что сайт попал под фильтр, можно не только по изменению количества посетителей, но и по позициям или числу страниц в индексе.

Совет. Не забывайте переходить в режим инкогнито перед тем, как делать запросы в поисковой строке. Это позволит получить неискаженные результаты выдачи.

Быстрая проверка

Количество страниц в индексе можно узнать, набрав в поисковике: site: адрес.сайта, например, site:artisan-team.ru. Если число страниц сильно изменилось с прошлого раза, возможно, сайт попал под фильтр.

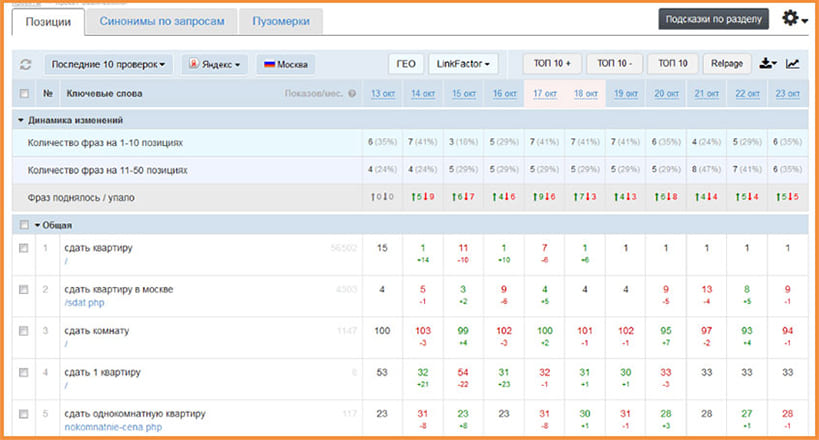

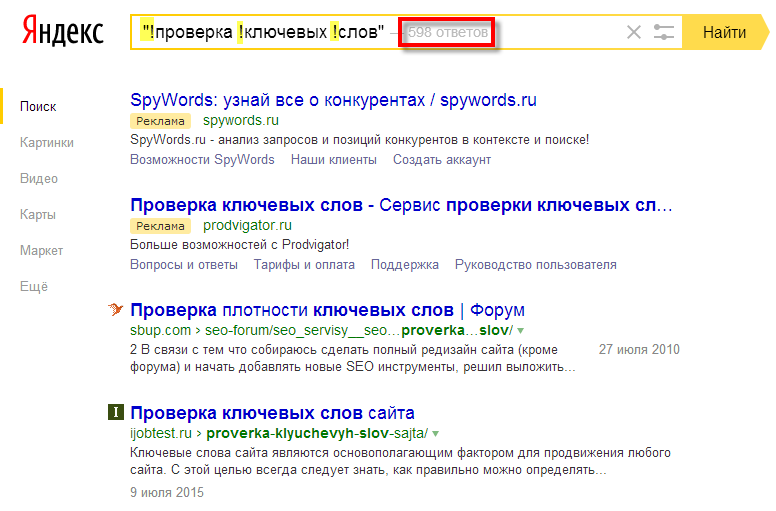

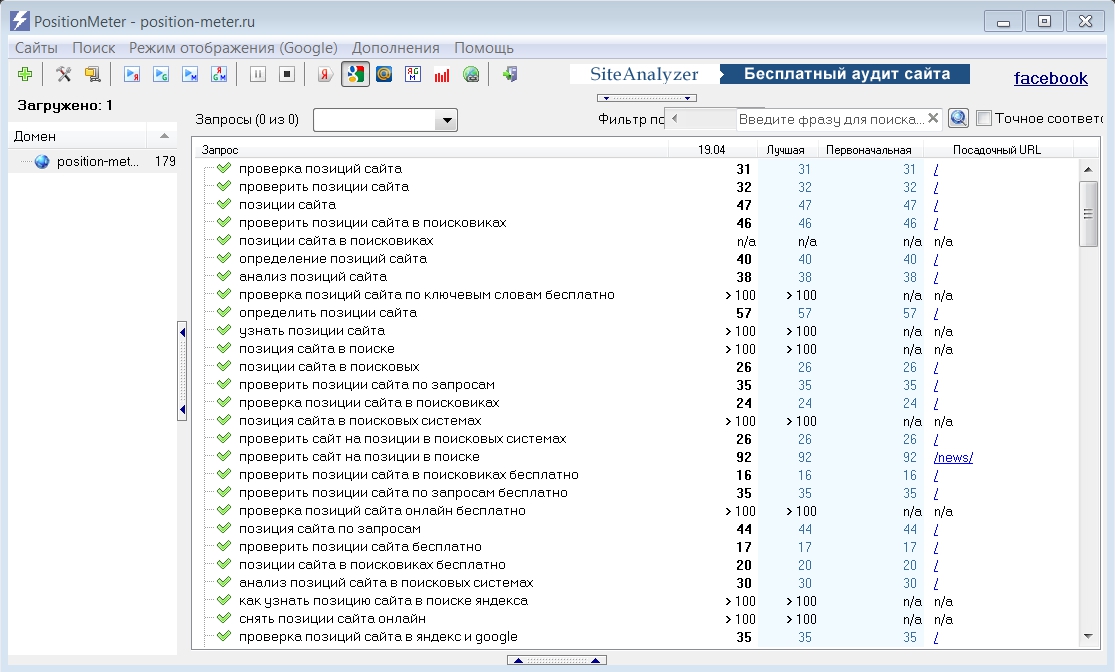

Проверка позиций в выдаче

При подозрении на фильтр следует посмотреть, как изменились позиции сайта в выдаче. Проверку по одному-двум запросам можно проводить вручную, но лучше пользоваться специальными инструментами, которые охватывают большее число ключей: arsenkin.ru, be1.ru, serphunt.ru и др.

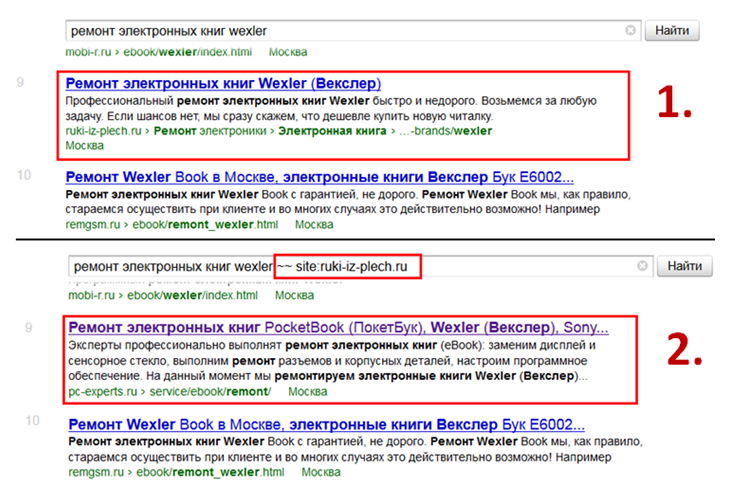

Чекинг по брендовому запросу

Для этой проверки введите в поисковик адрес сайта без точки, например, так: artisan-team ru. Первым результатом в выдаче должна быть главная страница сайта, если этого не происходит, значит, что-то идет не так.

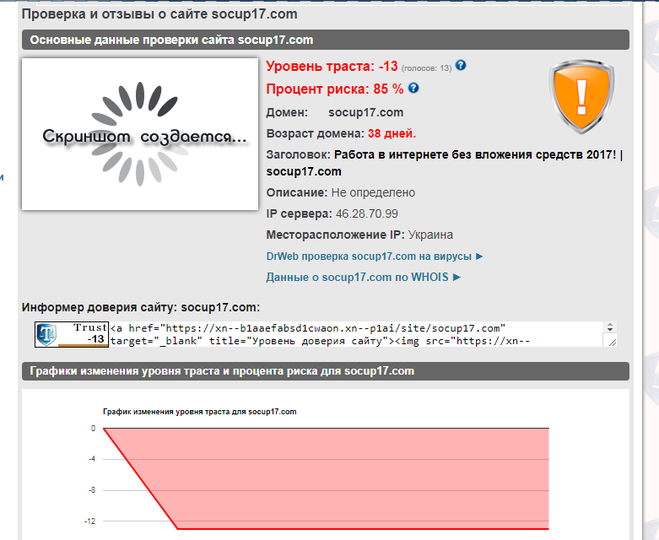

Уточняем ИКС в Яндексе

Если сайт попал под фильтр АГС, то его индекс качества будет обнулен. Чтобы посмотреть ИКС, набираем название сайта в Яндексе → в сниппете нажимаем кнопку → переходим на вкладку «Информация о сайте».

Вам также может быть интересно: Как прокачать ИКС и нужно ли это делать

Как определить, под какой фильтр попал сайт?

Если предыдущие проверки подтвердили, что вы попали под санкции, стоит установить причину проблемы. Проанализируйте свои последние действия, возможно, вы слишком активно размещали ссылки на свой ресурс или использовали другие методы продвижения, которые не понравились поисковым алгоритмам.

Если вашей вины не было, разберитесь, в каких именно позициях потерял сайт и соотнесите эту информацию с особенностями разных фильтров. Например, «Минусинск» обычно накладывают за массовое использование некачественных ссылок. В этом случае будет сильное падение сайта в выдаче. Кстати, этим алгоритмом иногда злоупотребляют конкуренты, намеренно размещая ссылки на ваш сайт на мусорных ресурсах. Другой фильтр Яндекса АГС — приводит к обнулению ИКС, под него обычно попадают за низкое качество контента.

Вам также может быть интересно:

Негативное SEO: что нужно знать, чтобы конкуренты не потопили ваш сайт

С аффилиат–фильтром Google часто сталкиваются при продвижении двух сайтов одной компании по похожим запросам. В этом случае в выдаче хорошие позиции будут только у одного из ресурсов. Но попадание под «Пингвин» и «Панду» внешне может ничем не отличаться. Обычно в этом случае наблюдают падение позиций, появление в дополнительных результатах, медленную индексацию. При этом причины санкций — разные. «Пингвин» анализирует уникальность контента, юзабилити, удобство расположения рекламы, а «Панда» — качество внешних ссылок.

В этом случае в выдаче хорошие позиции будут только у одного из ресурсов. Но попадание под «Пингвин» и «Панду» внешне может ничем не отличаться. Обычно в этом случае наблюдают падение позиций, появление в дополнительных результатах, медленную индексацию. При этом причины санкций — разные. «Пингвин» анализирует уникальность контента, юзабилити, удобство расположения рекламы, а «Панда» — качество внешних ссылок.

Вам также может быть интересно:

Penguin и «Минусинск»: сравнение антиссылочных алгоритмов

Не забывайте, что фильтров у поисковиков — много. Поэтому бывает непросто определить, какой из них привел к потерям клиентов или средств.

Что делать, если сайт попал под фильтр?

Если вы знаете причину снижение трафика, попробуйте устранить ее сами или обратитесь к специалистам. Компания «Артизан-Тим» уже 7 лет помогает сайтам развиваться. Наша команда имеет опыт диагностики и решения этих проблем. А также Artisan-Team можно доверить комплексное продвижение сайта, чтобы не подпадать под санкции в будущем. Мы используем только белые методы продвижения, которые дают устойчивый результат.

Мы используем только белые методы продвижения, которые дают устойчивый результат.

Как проверить, попал ли сайт под «Баден-Баден», и как выйти из-под фильтра

Представьте, что после очередного апдейта позиции вашего сайта в Яндексе вдруг сильно просели. Да и трафик упал до неприлично низких показателей. Неприятная ситуация, согласитесь. Одной из причин её возникновения может стать наложение со стороны Яндекса фильтра «Баден-Баден». Как понять, он ли всему виной? А если да, то как выйти из-под фильтра? Давайте разбираться прямо сейчас!

О своей неприязни к нашпигованным ключами текстам поисковые системы говорили много раз. Каноническим уже стал пост в Блоге Яндекса для вебмастеров от 13 сентября 2011 года. В нём поисковик ещё раз заявляет о своей позиции по данной теме: Яндекс «негативно относится к попыткам повышения релевантности страниц за счет чрезмерного употребления в текстах ключевых слов…». И называет данные действия «псеводооптимизацией», которая никак не способствует улучшению сайта. В этом же посте Яндекс информирует читателей, что вот-вот введёт новый алгоритм. Он сможет анализировать контент на проиндексированных страницах и выявлять те страницы, что были созданы с целью влияния на выдачу нечестными методами. В связи с этим представители Яндекса советовали вебмастерам пересмотреть свой контент, ответив на вопросы, а интересен и удобен ли он пользователям.

В этом же посте Яндекс информирует читателей, что вот-вот введёт новый алгоритм. Он сможет анализировать контент на проиндексированных страницах и выявлять те страницы, что были созданы с целью влияния на выдачу нечестными методами. В связи с этим представители Яндекса советовали вебмастерам пересмотреть свой контент, ответив на вопросы, а интересен и удобен ли он пользователям.

Следующим мощным шагом на пути очищения выдачи от сайтов с переоптимизированным контентом стало введение алгоритма «Баден-Баден». Произошло это памятное для вебмастеров событие в марте 2017 года и наделало много шума в профессиональной среде.

Придя на работу в один прекрасный день, мы с коллегами увидели, что у некоторых проектов просели позиции по части запросов. Причина быстро обнаружилась – Яндекс запустил новый алгоритм. Нужно было оперативно реагировать. Мы начали с изучения вопроса: шерстили профильные форумы, собирали мнения и данные.

На тот момент первым и самым действенным шагом было закрытие текстов в noindex или вовсе удаление текстов со страниц с просевшими позициями. Спустя некоторое время мы увидели, что позиции стали потихоньку расти, а значит, мы все сделали тогда правильно. Уже очень скоро мы поняли, как мирно сосуществовать с «Баден-Баденом» и что делать, чтобы не попасть под новый фильтр. При постановке ТЗ на копирайтеров мы стали указывать меньшее количество запросов. Где-то результат давало изменение объёма текстов в сторону сокращения. Но тут всё индивидуально.

Спустя некоторое время мы увидели, что позиции стали потихоньку расти, а значит, мы все сделали тогда правильно. Уже очень скоро мы поняли, как мирно сосуществовать с «Баден-Баденом» и что делать, чтобы не попасть под новый фильтр. При постановке ТЗ на копирайтеров мы стали указывать меньшее количество запросов. Где-то результат давало изменение объёма текстов в сторону сокращения. Но тут всё индивидуально.

Принимать верные решения нам помогал качественный анализ контента сайтов из топа. Впрочем, в схожем формате мы работали и раньше. Помню, как особенно сильно в момент введения «Баден-Бадена» пострадал один из моих проектов – интернет-магазин, торгующий одеждой. Фильтр «задел» не все страницы – алгоритму не понравились тексты только на некоторых. В течение месяца удалось восстановить прежние позиции.

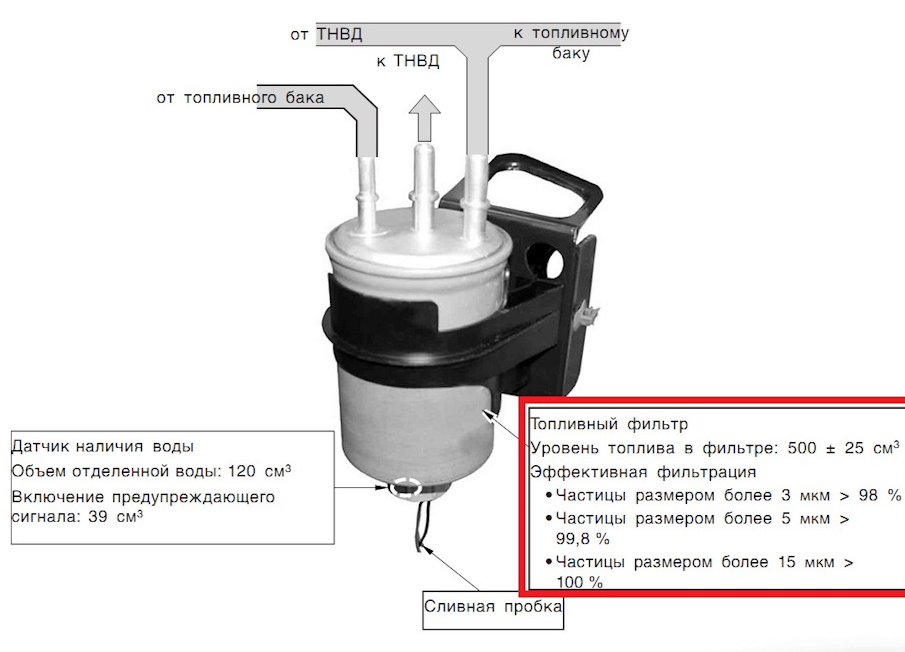

По традиции выход нового фильтра анонсировали в Блоге Яндекса. Задача нового фильтра была всё той же – отлавливать и понижать в выдаче переоптимизированные страницы.

Справка Яндекса об улучшении фильтра

По идее его создателей, «Баден-Баден» должен способствовать продвижению сайтов с качественным контентом, написанным для людей, а не для поисковых роботов. Практически сразу после выхода алгоритма начался следующий этап работ – определение на сайтах нарушения «Переоптимизация». Если такое нарушение будет выявлено, все страницы сайта начнут ранжироваться ниже. Чуть позже, первый этап работ назовут запуском запросозависимого (или постраничного) алгоритма, второй этап – введением хостового алгоритма.

Если вы хотите узнать о других поисковых фильтрах Яндекса, советуем почитать нашу свежую статью, посвящённую этой теме. В ней – ёмкий обзор всех основных алгоритмов Яндекса.

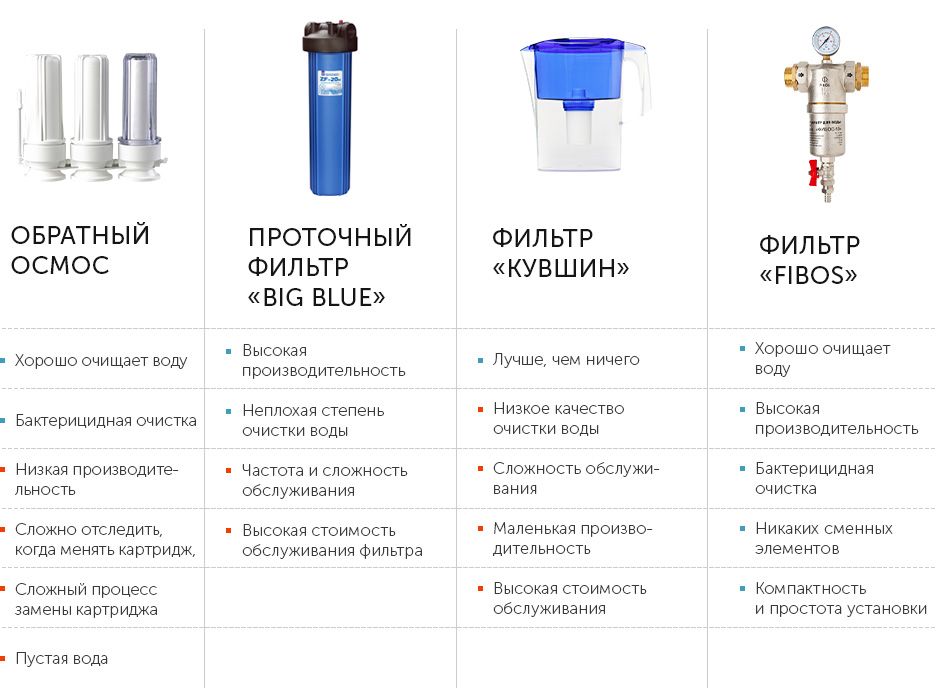

Сюрприз – не только за обилие ключевых слов и фраз, которые выглядят топорно. Спровоцировать недовольство со стороны поисковых машин может наличие:

- Больших «полотен» – объёмных текстов без оформления.

Такие тексты неудобно читать, ведь глазу не за что зацепиться. Пользователю сложно найти нужную информацию. Скорее всего, увидев перед собой подобную «портянку», он спешно закроет сайт и уйдёт на другой.

Такие тексты неудобно читать, ведь глазу не за что зацепиться. Пользователю сложно найти нужную информацию. Скорее всего, увидев перед собой подобную «портянку», он спешно закроет сайт и уйдёт на другой. - Текстов, спрятанных под спойлер. Поисковик может подумать, что такие тексты скрывают от пользователей неслучайно. Возможно, в них слишком много ключей. Пример с сайта детских товаров

- Повышенные показатели водности текста. То есть обилие бесполезных с точки зрения информативности стоп-слов, а также фраз, оборотов, соединительных слов, не несущих смысловой нагрузки. Откровенно Яндекс никогда не признавал, что накладывает фильтр на страницы за водность текстов, однако в профессиональной среде SEO-специалистов давно уловили эту взаимосвязь. А ещё научились определять предел этого значения и даже внедрили специальные сервисы оценки качества контента. Подробности – ниже в этой статье.

- Грамматически неверно составленные фразы, которые получились в результате использования прямого вхождения ключевика. «Детские бассейны Екатеринбург цена», «Купить настольная лампа дёшево»… Эти и подобные вхождения вызывают зубовный скрежет не только у обычных пользователей, но и у поисковых машин (а зубы у них наверняка есть, иначе чем они делают клац-клац в каждый апдейт).

Это просто, если ваш сайт угодил под хостовый фильтр, то есть если санкции будут наложены на весь сайт. Соответствующее оповещение отобразится в Яндекс.Вебмастере в разделе «Диагностика» – «Безопасность и нарушения». Это значит, что алгоритм прошёлся по всем страницам вашего сайта и на большинстве из них выявил нарушения.

Формально свидетельствовать о попадании сайта под хостовый фильтр «Баден-Баден» может просадка позиций ровно на 20 пунктов. В топе удастся удержаться лишь по витальным запросам: названию бренда или компании, URL сайта. Какие именно страницы не понравились Яндексу, нужно будет определять самостоятельно.

А вот в случае с наложением фильтра на отдельные страницы, ждать специального оповещения не приходится. Отсюда и проблемы с определением, что служит причиной обвала позиций и потери трафика. Неопытный оптимизатор будет долго анализировать факторы проседания страниц по отдельным вхождениям и, скорее всего, так и не докопается до истины. Сложность заключается еще и в том, что пониженные в топе по определенным запросам (если этих запросов слишком много) страницы могут сохранять свои позиции по другим запросам.

Косвенно о введении санкций может говорить проседание на 7-30 пунктов. Эта цифра напрямую зависит от конкурентности ключевых слов и того, какие позиции страницы занимали в топе до того, как залетели под фильтр.

Как понять, что причина проседания некоторых страниц в выдаче кроется в «Баден-Бадене»? Вот простой, проверенный алгоритм действий:

- Сначала составьте список всех страниц, на которых упал трафик и которые сильно просели по отдельным запросам;

- Разделите эти страницы на 2 части.

На страницах из первой половины поменяйте текстовый контент или удалите его. Страницы из второй части оставляем без изменений. Так вы сделаете две тестовые группы и сможете провести наглядный эксперимент.

На страницах из первой половины поменяйте текстовый контент или удалите его. Страницы из второй части оставляем без изменений. Так вы сделаете две тестовые группы и сможете провести наглядный эксперимент. - Исправив контент на страницах из первой группы, добавьте эти странички в переобход. Остается самое сложное – ждать. Чтобы увидеть, дали ли наши действия плоды, придется дождаться 2-3 апдейтов.

- В результате нужно оценить, выросли ли позиции и увеличился ли трафик на страницах, где мы меняли/удаляли контент. Если да, то делаем соответствующий вывод.

Такой способ определения «Баден или не Баден» SEO-специалисты используют уже давно. И ходят слухи, что идея родилась с подачи самого Яндекса. Мол, так тестировать страницы предложил Платон Щукин – чат-бот Яндекса, от лица которого поисковик переписывается с вебмастерами и владельцами сайтов. Однозначно утверждать не будем – с нами Платон никогда не был настолько разговорчивым и конкретным.

Обещанный обзор сервисов, определяющих содержание в текстах «воды».

«Тургенев»

Создан специально для того, чтобы оценивать, насколько текстовый контент отвечает требованиям фильтра Яндекса «Баден-Баден». Призван в целом сделать тексты лучше: показывает переспам, определяет содержание «воды», выискивает канцеляризмы, перегруженные обороты и другие проблемные места. Результат выдаёт в баллах – очень удобно.

Раньше доступ к «Тургеневу» был бесплатным. С 2019 года приходится платить за всё, кроме вкладки «Стилистика». Но она основная, поэтому многим пользователям и бесплатных опций сервиса оказывается достаточно.

Text.ru

Ещё один популярный сервис, определяющий водность текстов (правда не оценивающий риск попадания страниц под фильтр). Функциональный, простой в использовании. И уникальность с орфографией проверит, и SEO-анализ текста выполнит. Именно в рамках последнего text.ru делает подсчёт процента водности. В норме, если содержание «воды» в тексте не превышает 15%.

Функциональный, простой в использовании. И уникальность с орфографией проверит, и SEO-анализ текста выполнит. Именно в рамках последнего text.ru делает подсчёт процента водности. В норме, если содержание «воды» в тексте не превышает 15%.

Давайте вместе проверим в text.ru ещё один отрывок из нашей статьи.

Главред

Найти в тексте стоп-слова, то есть «воду» помогает и сервис «Главред». Убрав их, вы приведёте контент к информационному стилю. Сделаете тексты простыми и информативными.

Сервис бесплатный. Но сугубо утилитарный – проверить на нём пунктуацию и орфографию не получится.

Пропустим отрывок из нашей статьи через Главред. Сервис выделяет в основном личные местоимения и предлоги. Мы считаем, что их употребление оправдано, а итоговая оценка – достойная.

Это зависит от того, какой именно фильтр наложен на ваш сайт – постраничный или хостовый.

Обратите внимание: единого перечня жёстких мер нет. Все они носят рекомендательный характер. Любой опытный SEOшник скажет вам, что каждый проект уникален. А значит, нужно тестировать, подбирать решения под конкретную ситуацию.

Чтобы сайт скорее вышел из-под запросозависимого фильтра, производят следующие действия:

- Меняют контент с точки зрения содержания – делают тексты более информативным, убирают «воду».

- Большие тексты сокращают, избавляясь от 1/4 и даже от 1/3 объёма.

- Уменьшают количество ключевых вхождений – борются с переспамом.

- Форматируют текст – если надо, работают с заголовками и позаголовками, разбивают материал на абзацы поменьше, часть информации оформляют в виде списков или таблиц.

- Проверяют, соответствуют ли alt и title изображениям.

- Сомнительные куски контента «прячут» при помощи тега «noindex».

Чтобы вывести сайт из-под хостового фильтра «Баден-Баден», начните со следующих действий:

- Найдите на сайте переоптимизированные тексты, те, что содержат устаревшую информацию или криво употребленные ключевики.

Подкорректируйте контент. А ещё, если вы работаете с интернет-магазином, загляните в карточки товаров и проверьте, не слишком ли большие там описания.

Подкорректируйте контент. А ещё, если вы работаете с интернет-магазином, загляните в карточки товаров и проверьте, не слишком ли большие там описания. - Попробуйте вовсе удалить тексты, в которых сомневаетесь.

- Сократите тексты, удалив неинформативные и переоптимизированные фрагменты. Возможно, придётся убрать больше половины от исходного объёма контента.

- Просмотрите метатеги – нет ли в них ошибок и чрезмерного количества ключевиков.

- Свяжитесь с Платонами Яндекса и попросите их прислать ссылки на страницы, которые якобы нарушили требования поисковой системы.

Чтобы с минимальными потерями выйти из-под хостового фильтра «Баден-Баден», наш вам совет – сразу после получения уведомления начинайте менять свою стратегию продвижения. Приготовьтесь, придётся серьёзно поработать над контентом.

И запаситесь терпением. От момента нажатия вами кнопки «Я всё исправил» до выхода сайта из-под бана может пройти больше месяца.

Поэтому, как вы понимаете, лучше туда не попадать вовсе. Как это сделать? Соблюдайте следующие правила.

- Следите, чтобы метатеги отражали содержание страниц.

- Аккуратно используйте ключевые вхождения – не частите, используйте синонимы.

- Помните, что фильтр на отдельные страницы и весь сайт может накладываться за водность текстов. Поэтому избавляйтесь от неинформативных кусков, стоп-слов, канцеляризмов, сложных для восприятия оборотов.

- Форматируйте тексты – в них должны быть подзаголовки, абзацы, списки, таблицы. Никто не будет читать сплошное «полотно». Подобное оформление контента отпугивает посетителей сайт, что увеличивает количество отказов и провоцирует ухудшение поведенческий факторов. В результате страдают позиции.

- Прописывая alt к изображениям, старайтесь не допускать ошибок.

- Всегда держите в голове, что тексты должны быть полезными посетителям вашего сайта – информативными и понятными.

Больше фактов, меньше «воды».

Больше фактов, меньше «воды». - Время от времени возвращайтесь к раннее написанным текстам, проверяя, соответствуют ли они актуальным требованиям поисковых систем.

Подозреваете, что ваш сайт угодил под «Баден-Баден», но не знаете, как быстро снять фильтр? Мы готовы помочь вам «победить» санкции. Или взяться за ведение вашего проекта, минимизировав риск потенциального попадания под фильтр. Мы понимаем, какой контент нравится поисковым системам, а какой они не переваривают. И с учётом этого создаём ТЗ для своих копирайтеров. Те, в свою очередь, оперативно пишут качественные тексты – без «воды», неинформативных фрагментов и очевидных ошибок.

Если вы хотите оформить заявку на услуги Студии ЯЛ, позвоните нам по номерам 8 (383) 209-18-36 и 8-800-600-36-20 или оставьте свои контактные данные в специальной форме на сайте.

Другие материалы:

- Календарь инфоповодов на март 2022 года. Часть 2

- Как бизнесу отвечать на отзывы клиентов: показываем хорошие и плохие примеры, даем пошаговую инструкцию

- Как снизить риски в интернете в кризис? Рассказывает Студия ЯЛ

Все фильтры Google 2022: полный обзор

Google и «Яндекс» в 2021 году заботятся о том, чтобы пользователи получали качественный контент. Если раньше в топе выдачи были нечитаемые SEO-тексты, нашпигованные ключевиками всех мастей и смыслов, то сейчас поисковые системы строже следят за содержанием страниц.

Если раньше в топе выдачи были нечитаемые SEO-тексты, нашпигованные ключевиками всех мастей и смыслов, то сейчас поисковые системы строже следят за содержанием страниц.

С каждым новым алгоритмом Google совершенствует свои требования к сайтам: их контенту, ссылочным профилям, наполнению и содержанию. Раньше все это регулировалось отдельными фильтрами, сейчас входит в общий состав алгоритма поисковой системы. Сегодня мы рассмотрим сразу несколько вопросов:

- как определить наложение санкций от Google;

- точное выявление причин блокировки;

- как убрать ограничения со стороны ПС;

- как избежать ограничений в дальнейшем.

Во многом фильтры Google похожи на фильтры «Яндекса». Поэтому для большей полноты картины ознакомьтесь со статьей о фильтрах Yandex.

Как понять, что Google наложил фильтры на сайт

Для этого на сайт устанавливаем счетчик Google Analytics. Его можно ставить одновременно с «Яндекс.Метрикой», они друг другу не мешают. И нужно будет добавить сайт в сервисы для вебмастеров: «Яндекс.Вебмастер» и Google Search Console.

Его можно ставить одновременно с «Яндекс.Метрикой», они друг другу не мешают. И нужно будет добавить сайт в сервисы для вебмастеров: «Яндекс.Вебмастер» и Google Search Console.

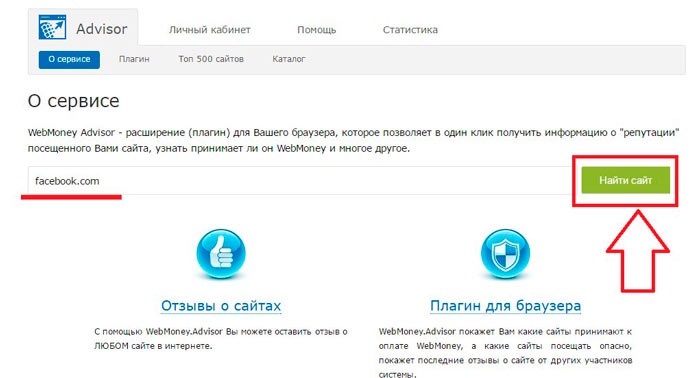

Проверка мер, принятых вручную

Проверить наложение фильтров можно в левом меню GSC, в разделе «Проблемы безопасности и меры, принятые вручную»:

Так выглядит окно отчета, если на сайте нет ограничений, наложенных вручную

Если здесь есть какие-то проблемы, то в окне отображается уведомление с описанием, что именно нужно исправить. После исправления можно запросить перепроверку и, если все сделано правильно, система снимет ограничения.

Анализ поискового трафика

Если в GA наблюдается резкое снижение трафика, это тоже может быть признаком наложения фильтров. Трафик может снижаться не только из-за фильтров: иногда в этом виноваты сезонность, уменьшение поискового спроса. Отличительная особенность падения, связанного с фильтрами — одномоментная потеря существенной части переходов.

Пример сезонного падения — снижение постепенное, а не скачкообразное

Если на графике видна конкретная дата, стоит сопоставить ее с обновлениями фильтров. Google анонсирует изменения на moz.com.

Проверка изменения числа страниц в индексе

Для оценки числа страниц в выдаче используется обычный поисковик. В строку поиска вводим «site:название сайта» и смотрим на количество.

Пример проверки количества страниц в индексе сайта

Если замечено существенное снижение количества страниц в индексе, нужно сверяться с датами обновления фильтров.

Читайте также:

Переход на Google Analytics 4 — установка, настройка, цели

Проверка позиций сайта с помощью сервисов

Существуют специальные SEO-инструменты, которые помогают быстро проверить позиции сайта в нужной ПС. Для этого нужно выгрузить список ключевых фраз, ввести имя домена и выбрать нужную поисковую систему. Эту проверку нужно проводить периодически, чтобы оперативно отследить возможные проблемы с трафиком и быстро их устранить.

Для этого нужно выгрузить список ключевых фраз, ввести имя домена и выбрать нужную поисковую систему. Эту проверку нужно проводить периодически, чтобы оперативно отследить возможные проблемы с трафиком и быстро их устранить.

Позиции упали, страницы не в индексе — что делать дальше?

Дальше нужно проверить, какие именно страницы выпадают из индекса. Для этого переходим в раздел «Покрытие» и смотрим исключенные страницы.

На первом экране отчета можно посмотреть количество исключенных страниц

Изучаем статусы и типы исключенных страниц:

Пример отчета по исключенным страницам

Вот это, например, страницы, которые, вероятнее всего, попали под алгоритм Panda: поисковый робот их обошел, признал контент недостаточно качественным и исключил страницу из поиска.

Если количество исключенных из индекса страниц растет, значит, нужно перерабатывать содержимое сайта. Если количество индексируемых страниц не меняется, но количество посетителей падает и уменьшается число сессий, стоит проверить ссылочный профиль и меры, принятые вручную.

Читайте также:

Индексация в поисковых системах: что это простыми словами

Все фильтры Google с 2016 года входят в основной алгоритм, поэтому отслеживать их по отдельности не получится. Регулярная проверка позиций сайта, анализ трафика помогут самостоятельно определить, какие именно санкции использовала ПС в отношении сайта.

Основные официальные фильтры Google: диагностика и лечение

Google не зря считается чемпионом в борьбе с «черными» методами продвижения — поисковая система каждые несколько месяцев создает новые алгоритмы и обновляет существующие, чтобы улучшить выдачу.

Начнем с основных фильтров, которые накладываются чаще всего.

Panda (Панда)

- Год выпуска: 2011.

-

Что отслеживает: качество контента.

- Аналоги у «Яндекса»: «АГС», «Баден-Баден».

В 2011 году ПС запустила фильтр, который начал понижать в выдаче и исключать из индекса сайты с недостаточно качественным содержимым. Мы подробно описали в одной из своих статей работу фильтра «Панда».

Фильтр Google Panda начал следить за качеством контента в 2011 году

Поймать этот фильтр сайт может по причинам, связанным с качеством содержимого:

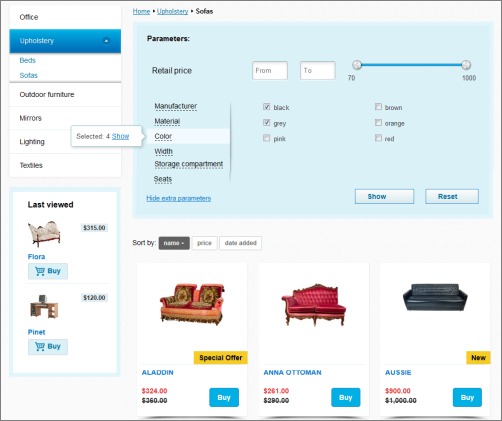

- Недостаточное количество контента. Это особенно актуально для интернет-магазинов — карточки с отсутствующими или недостаточно информативными описаниями могут полностью исключаться из индекса.

- Отсутствие четкой тематики. Если на ресурсе размещается информация о разных темах, никак не связанных друг с другом, «Панда» может посчитать его недостаточно качественным и исключить страницы из индекса.

-

Низкая ценность размещенной информации.

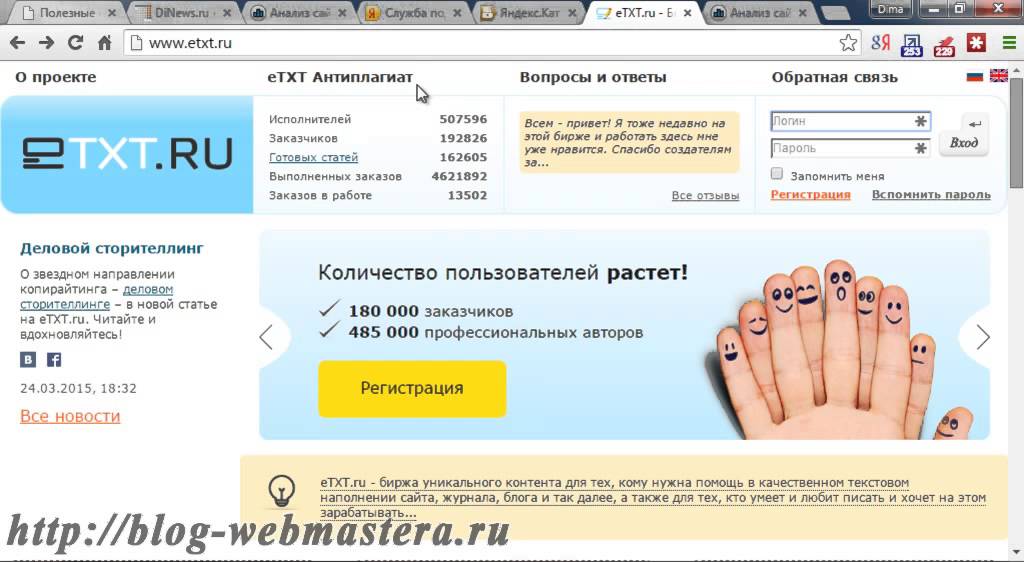

Не стоит делать контент, «чтобы был», и заказывать на биржах — за водянистые малоинформативные тексты можно тоже попасть под «Панду».

Не стоит делать контент, «чтобы был», и заказывать на биржах — за водянистые малоинформативные тексты можно тоже попасть под «Панду».

- Плохие поведенческие показатели. Сюда относится возврат на главную страницу выдачи после перехода на сайт. Если пользователь провел на сайте мало времени и вернулся к ПС, система получает информацию, что качество контента не удовлетворяет запросам пользователя, а потому понижает позиции ресурса. Тут же можно указать неработающий функционал — он тоже плохо сказывается на поведенческих факторах.

Продвижение товаров на маркетплейсах

- Оплата по дням нахождения в ТОП

- Средние сроки продвижения — 7 дней!

Есть еще часть фильтров и алгоритмов, которые были введены отдельно и появились задолго до «Панды», но позже официально вошли в ее состав.

Supplemental results (Дополнительные результаты)

Отсутствие оригинального контента, рерайт уже существующей информации могут привести к тому, что ПС посчитает ваш сайт недостаточно качественным. Он не уйдет из индекса полностью, но будет отображаться в разделе с дополнительными результатами, а потому трафик на страницу просядет.

Over Optimization (Переоптимизация)

Этот фильтр срабатывал в отношении заспамленных сайтов. Если в тексте страницы, тегах и метатегах есть переспам ключевых слов и фраз, контент признается переспамленным и его результаты в выдаче ухудшаются.

Duplicate content (Повторяющийся контент)

Создание страниц с идентичным наполнением тоже может наказываться «Пандой» — вот почему важно правильно кластеризовать семантику, а не создавать по новой странице под каждый запрос.

Как проявляется «Панда»:

- снижаются позиции в выдаче — как у отдельных страниц, так и у всего сайта;

- уменьшается количество переходов и число уникальных посетителей;

-

новые добавленные страницы долго не выходят в индекс.

С 2016 года «Панда» не является самостоятельным фильтром, а входит в часть алгоритма Google

Как проверить и вывести сайт из-под фильтра «Панда»:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Недостаточное качество или отсутствие информативного контента |

Выгрузить список исключенных из индекса страниц и наполнить их качественным содержимым |

Заполнять страницы до того, как они выйдут в индекс. Если этого сделать пока не получается, закрыть их тегом «noindex» |

|

Отсутствие четкой тематики |

Вручную отобрать и удалить страницы, которые не соответствуют общей тематике сайта |

Не добавлять страницы с тематиками, которые не соответствуют основной теме сайта |

|

Плохие поведенческие показатели |

Проанализировать страницы с самыми короткими сеансами — выгрузить их можно через Google Search Console |

Проверять заполненность страницы, работу всех кнопок, ссылок и форм до того как страница попадет в индекс |

|

Повторяющийся контент |

Выгрузить список страниц с похожим контентом и оптимизировать их — объединить или скрыть от индексации |

Проводить кластеризацию более глубоко — хорошо прорабатывать интент, проверять вручную после автоматических кластеризаторов |

|

Низкая уникальность контента |

Проверить весь сайт на уникальность и заменить статьи с низкой оригинальностью |

Использовать несколько сервисов перед размещением текстов на сайте |

Penguin (Пингвин)

-

Год выпуска: 2012.

- Что отслеживает: ссылочный профиль.

- Аналог у «Яндекса» «Минусинск».

Ссылочный профиль сайта все еще учитывается при ранжировании ресурсов в Google. За анализ внешних ссылок отвечает фильтр «Пингвин», который мы подробно разобрали в статье.

Фильтр Google Penguin отслеживает ссылочный профиль сайтов с 2012 года

Этот фильтр собирает в себе все факторы, связанные именно с внешним ссылочным профилем. В отличие от «Панды», он понижает только определенную страницу в выдаче — «Панда» может пессимизировать весь сайт.

За что можно получить наложение «Пингвина»:

- избыточное использование ключевых слов в ссылках;

- скрытые ссылки в сквозных блоках;

- много входящих ссылок с некачественных доноров;

-

наличие слов/текстов взрослой тематики.

Читайте также:

Внешняя оптимизация сайта: как продвигать сайт с помощью сторонних ресурсов

Как и в случае с «Пандой», есть фильтры, которые изначально вышли отдельно, но позже были официально включены в состав «Пингвина».

Too many links at once (Слишком много ссылок сразу)

В состав «Пингвина» также включили алгоритм, учитывающий равномерность прироста ссылок. При резком увеличении числа доноров сайт-акцептор тоже может попасть под фильтр, поэтому наращивать ссылочный вес нужно постепенно.

Co-citation linking filter (Социтирование)

Под этот фильтр сайт может попасть, если на него ссылаются нетематические ресурсы. Такое обычно происходит при некачественном подборе площадок-доноров, когда не учитывается их тематика.

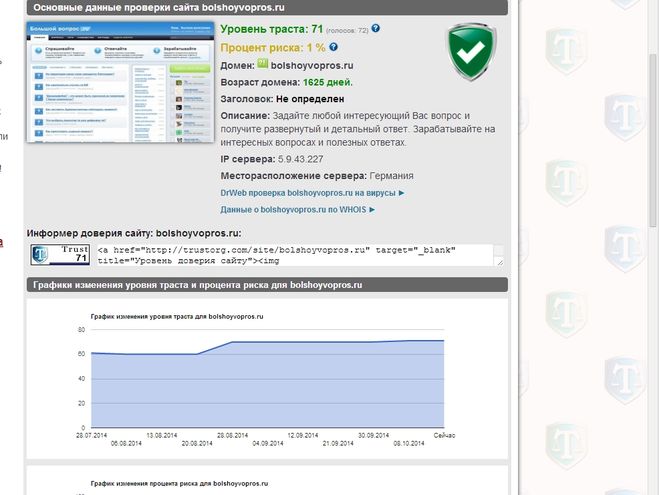

«Социтированием» могут наказать ресурс и за покупку ссылок на спамных сайтах, которые имеют низкий уровень траста и публикуют ссылки на разнонаправленные ресурсы.

Чтобы не попасть под этот фильтр, нужно покупать ссылки только на сайтах схожего направления. При этом прирост в месяц не должен составлять больше 20 % от текущего числа ссылок.

Как проверить и вывести сайт из-под фильтра «Пингвин»:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Быстрое увеличение числа внешних ссылок |

Экспорт внешних ссылок через сервисы и ручная проверка каждого донора через checktrust. Некачественные ссылки отключаем через инструмент Disavow Links. После отключения избыточных ссылок направить запрос на пересмотр санкций |

Сформировать корректный график прироста ссылочной массы |

|

Наличие донорских ссылок на спамных и некачественных сайтах |

Не покупать спамные ссылки и периодически проводить проверки существующего профиля. |

Дополнительные фильтры Google

Эти фильтры не столь существенно влияют на позиции сайта, как «Панда» или «Пингвин», но учитывать их все равно стоит — они тоже направлены на отслеживание качества ресурса.

Baby Panda

- Год выпуска: 2012.

- Что отслеживает: слишком много рекламы на первом экране.

Этот фильтр появился после официального анонса «Панды» и за схожесть с ним получил приставку «Baby». Под него попали сайты, главные экран которых перегружен рекламными объявлениями. ПС начала понижать такие сайты в выдаче.

Как проверить и вывести сайт из-под фильтра Baby Panda:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Много объявлений на главном экране |

Отключить Adblock и оценить, насколько много рекламных блоков есть на главном экране |

Снизить количество блоков с рекламой |

Exact Match Domain (EMD)

-

Год выпуска: 2012.

- Что отслеживает: прямое вхождение коммерческой ключевой фразы в домен.

Некоторые оптимизаторы считают, что дополнительное вхождение коммерческого ключа в домен может повысить позиции сайта в выдаче. Начиная с 2012 года эта хитрость не работает, сайт может потерять позиции. Если фильтр наложен сразу, то сайту будет тяжело попасть в топ выдачи. Если же EMD заметил уже существующий ресурс, он может просесть в выдаче, но полностью не уйдет, так как в ранжировании учитываются и другие факторы.

Читайте также:

Факторы ранжирования Google и «Яндекс»: что это и как работает

Как проверить и вывести сайт из-под фильтра EMD:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Точное вхождение одной или нескольких ключевых фраз с домен |

Менять домен с 301 редиректом |

При выборе доменного имени не использовать больше одного ключевого слова |

DMCA (Pirate, Пират)

-

Год выпуска: 2012.

- Что отслеживает: копирование информации с других сайтов.

Этот фильтр похож на Панду, но он регулируется законом об авторском праве и защищает от копирования информации с других ресурсов. Если на сайт поступают жалобы о нарушении авторства, придется удалять неуникальный контент и заменять его уникальным.

Как проверить и вывести сайт из-под фильтра DMCA:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Копирование информации: текстовой, графической и видео с другого ресурса |

Удалить авторский контент и заменить его собственным. Можно поставить ссылку на первоисточник — это тоже может сработать (но не всегда) |

Не копировать чужой контент |

Спам в микроразметке

-

Год выпуска: 2015.

- Что отслеживает: злоупотребление микроразметкой сниппета выдачи.

Качественная проработка сниппета сильно повышает шансы на переход — наличие оценок и звездочек рейтинга повышает доверие к ресурсу. Но некоторые специалисты этим злоупотребляют и размещают в разметке оценки и рейтинг на тех статьях, где это не предусмотрено функционалом.

Как проверить и вывести сайт из-под фильтра «Спам в микроразметке»:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Добавление в разметку сниппета несуществующих пунктов — оценок, звездочек рейтинга |

Проверить разметку в GSC и отправить запрос на переобход |

Не пытаться манипулировать переходами пользователей |

Читайте также:

Микроразметка Schema. org: полное руководство

org: полное руководство

Links (Ссылочная помойка)

- Год выпуска: неизвестен

- Что отслеживает: количество исходящих ссылок с сайта.

Фильтр направлен на борьбу с так называемыми ссылко-помойками. Так называют сайты, которые размещают слишком много исходящих ссылок в рамках одной страницы.

Как проверить и вывести сайт из-под фильтра Links:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Много ссылок на сторонние ресурсы |

Через Screaming Frog выгрузить список внешних ссылок, проверить и почистить |

Не добавлять ссылки на некачественных акцепторов, разнотематические ресурсы, не соответствующие тематике документа |

Broken links (Битые ссылки)

-

Год выпуска: неизвестен.

- Что отслеживает: количество страниц с кодом 404.

Этот фильтр направлен на определение качества сайта — он понижает в выдаче ресурсы, на которых слишком много страниц с кодом 404. Такое обычно возникает при удалении страниц, изменении названий разделов или подразделов. В этом случае существующие внутренние ссылки начинают вести на уже несуществующие страницы. Если их становится слишком много, общая оценка качества сайта снижается и он теряет позиции.

Как проверить и вывести сайт из-под фильтра Broken Links:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Много битых ссылок |

Выгрузить через панели вебмастеров или Screaming Frog. |

При изменении адресов страниц, настроить 301 редирект на новую. Регулярно проводить технический аудит сайта и удалять с него несуществующие ссылки и страницы |

Читайте также:

Битые ссылки — найти, проверить, исправить!

Неофициальные фильтры Google

Сюда относятся те ограничения, которые представители Google не подтвердили официально, но их наличие было замечено SEO-специалистами по всему миру.

-5, -30, -950

Падение в выдаче за использование методов «черного SEO». Отмечается уменьшение позиций на 5, 30, 950 пунктов. Применяется в отношении таких нарушений:

- клоакинг;

- дорвеи;

- использование SEO-ссылок;

-

применение скрытых редиректов.

Отличительная особенность фильтра состоит в том, что если нарушения не устранить, сайт сначала потеряет позиции, а после и вовсе вылетит из индекса.

Чек-лист: что нужно проверить перед запуском, чтобы не попасть под фильтры Google

Это универсальный список, который можно использовать как для систематических аудитов, так и для проверки новых сайтов. Он не является полной версией SEO-аудита: туда входит больше пунктов, в том числе и технических.

- Проверка уникальности размещенных текстов.

- Проверка текстов на естественность.

- Проверка текстов на заспамленность.

- Проверка полноты информации, которая опубликована на сайте.

- Выгрузка и анализ исключенных из индекса страниц.

-

Выгрузка и проверка внешних ссылок — исключение некачественных доноров.

- Оценка количества рекламных блоков на сайте.

- Проверка доменного имени на вхождение ключевой фразы.

- Проверка семантики и ее дополнение словами из подсветок и подсказок, правой колонки Wordstat.

- Проверка сниппета выдачи.

- Анализ внешних ссылок с ресурса — их количество и качество.

- Анализ количества страниц с кодом 404.

Продвижение сайтов

- Любой формат сотрудничества: позиции, лиды, трафик.

- Подбираем запросы, которые приводят реальных покупателей!

Как проверить, фильтруется ли ваш сайт, и как предсказать будущую фильтрацию с помощью Vision API

Для многих владельцев сайтов и оптимизаторов Безопасный поиск может быть запутанной темой. Например, понять, как работает Безопасный поиск, как выглядит фильтрация в действии и как она может повлиять на трафик из обычного поиска Google. Это особенно касается сайтов, которые находятся на тонкой грани между предоставлением неявного и явного контента (по крайней мере, в соответствии с алгоритмами Google).

Например, понять, как работает Безопасный поиск, как выглядит фильтрация в действии и как она может повлиять на трафик из обычного поиска Google. Это особенно касается сайтов, которые находятся на тонкой грани между предоставлением неявного и явного контента (по крайней мере, в соответствии с алгоритмами Google).

Недавно я работал над несколькими случаями, когда в игру вступал SafeSearch. Контент сайта отфильтровывался для пользователей с активным безопасным поиском, что влияло на видимость контента в поисковой выдаче и последующий трафик на сайт.

Но фильтруются не порносайты… На самом деле это далеко не так. Вместо этого сайты являются издателями, которые пишут на разные темы в своей нише. А иногда в этих статьях содержится контент и изображения, которые отключают фильтр безопасного поиска. Когда это происходит, эти URL-адреса и изображения отфильтровываются из результатов поиска, что снижает уровень трафика из Google.

И, чтобы уточнить, фильтрация применяется к изображениям, видео и веб-сайтам, так что речь идет не только о фильтрации стандартных органических результатов. Это также влияет на ваши СМИ.

Это также влияет на ваши СМИ.

Вот почему издателям стоит как можно лучше узнать о функции безопасного поиска Google, о том, как она работает, как проверить, не фильтруется ли ваш контент, и как тестировать новый контент, чтобы обеспечить безопасность вашего сайта в будущем.

Это потому, что если вы отключите фильтр, трафик может упасть в разной степени в зависимости от того, как применяется фильтр. Например, влияет ли Безопасный поиск только на определенные области сайта или на весь сайт? Это зависит от вашей настройки, вашего контента и того, насколько ваш контент пересекает черту.

Кроме того, помогая компаниям работать с фильтрацией SafeSearch, я получил много вопросов о том, как тестировать контент, чтобы увидеть, насколько он близок к срабатыванию фильтра SafeSearch. И если вы отключите фильтр, как вы узнаете, что вас фильтруют? А что делать, если вы неправильно фильтруете ? Можете ли вы связаться с Google, чтобы сообщить им об этом?

Все это важные вопросы, и я расскажу о некоторых из них в этом посте.![]()

Изображения и текст, а не только откровенные фотографии

Многие люди не знают об этом, но Мэтту Каттсу поручили создать первую версию SafeSearch. Подробнее об этом он рассказал во время недавнего интервью с Барри Шварцем (12:08 на видео). В том интервью Мэтт объяснил, что изначально Google использовал текст, чтобы понять, что нужно фильтровать. Поскольку первая версия SafeSearch появилась примерно в 2000 году, у Google не было алгоритмов машинного обучения, помогающих идентифицировать порнографические изображения. Поэтому он был в основном текстовым.

Безопасный поиск, несомненно, стал гораздо более сложным, и Google объяснила, что использует машинное обучение для обнаружения явного контента, который следует фильтровать. Подробнее об этом чуть позже, но я хотел убедиться, что вы понимаете, что учитываются как текст, так и изображения. Кроме того, в Google есть команда SafeSearch, которая занимается этой функцией. Это также важно понимать на случай, если у вас возникнут проблемы, например, если ваш сайт неправильно фильтруется.

В более раннем справочном документе Google, который я обнаружил, который теперь удален, объясняется, что SafeSearch просматривает «ключевые слова, ссылки и изображения», чтобы определить, что следует фильтровать. Итак, опять же, это не просто изображения.

Срабатывание фильтра безопасного поиска – что может произойти?

Когда сайт отключает фильтр безопасного поиска, Google будет фильтровать некоторые (или все) ваши страницы для пользователей, у которых активен безопасный поиск (опять же, для изображений, видео и веб-сайтов). Это параметр в ваших настройках поиска, поэтому некоторым людям приходится включать его вручную. Для других он может быть включен на более высоком уровне, например, школьным администратором, ИТ-отделом или даже родителем, управляющим компьютером ребенка.

Если это произойдет, ваши страницы не будут отображаться так, как обычно, для определенных запросов, ведущих на ваш сайт. Они будут отфильтрованы. Пуф, ушел. Об этом нет сообщения от Google, как и сообщение в GSC (по крайней мере, о котором я знаю). Вместо этого ваши страницы будут просто отфильтрованы в поисковой выдаче.

Вместо этого ваши страницы будут просто отфильтрованы в поисковой выдаче.

Как вы можете догадаться, некоторые сайты могут иметь более низкий уровень трафика в зависимости от целевой демографической группы. Например, если в вашу аудиторию входят люди, у которых включен безопасный поиск, фильтр может вызвать проблемы с трафиком. Если у большинства пользователей, посещающих сайт, не активен Безопасный поиск, вы можете даже не знать, что вас фильтруют. Это сложно.

Но давайте посмотрим правде в глаза, слово «хитрый» в SEO состоит из четырех букв. Как владелец сайта или оптимизатор, вы определенно хотите знать, фильтруется ли ваш контент безопасным поиском. Вам не нужны какие-либо неожиданности в будущем, такие как призрачные падения трафика, которые трудно понять. Это может быть очень неприятно. Вскоре я объясню, как проверить фильтрацию SafeSearch, но сначала несколько слов о структуре сайта и метаданных для взрослых.

Как структура сайта может помочь Google сфокусировать фильтрацию безопасного поиска

Компания Google объяснила, что вы можете помочь своим алгоритмам понять, какие разделы содержат контент для взрослых, используя определенную структуру URL для организации контента (см. раздел об оптимизации для безопасного поиска внизу этой страницы). Например, размещение всего контента для взрослых в определенном каталоге.

раздел об оптимизации для безопасного поиска внизу этой страницы). Например, размещение всего контента для взрослых в определенном каталоге.

Если вы это сделаете, то алгоритмы Google могут определить, что нужно фильтровать не весь сайт, а только определенный каталог. Это может спасти вас в будущем, поэтому я настоятельно рекомендую попытаться организовать свой контент таким образом, если вам по какой-то причине нужно публиковать контент для взрослых (или контент, который Google считает откровенным).

Теперь вам может быть интересно, что именно представляет собой «контент для взрослых». Это сложно… так как это определяется алгоритмически. Позже в этом посте я расскажу о том, как понять, как SafeSearch просматривает ваш контент.

Метатеги для взрослых

Google также объясняет, что лучший способ сообщить им, что на вашей странице есть контент для взрослых, — это использовать метаданные для взрослых. Они говорят, что это «самый сильный сигнал», который вы можете дать по этому поводу. Есть два метатега, которые вы можете использовать в своем коде для достижения этой цели (вам просто нужно включить один, но у вас есть выбор).

Есть два метатега, которые вы можете использовать в своем коде для достижения этой цели (вам просто нужно включить один, но у вас есть выбор).

Как проверить наличие фильтрации SafeSearch — Отключение фильтра

Ниже я расскажу о нескольких способах проверки того, активно ли фильтруется ваш контент SafeSearch. Вы будете проверять постфактум, то есть вас уже фильтруют. После того, как я расскажу об этих методах, я объясню, как провести профилактическую работу, чтобы убедиться, что вы не находитесь в опасной зоне. т. е. тестирование контента, который вы хотите опубликовать, чтобы увидеть, как безопасный поиск Google видит этот контент.

Прежде чем мы начнем, я считаю, что проще проверить фильтрацию SafeSearch, открыв два браузера. У одного будет включен Безопасный поиск, а у другого выключен. И если у вас есть два монитора, здорово иметь по одному браузеру на каждом дисплее.

1. Выполните команду сайта с активным Безопасным поиском

Сначала запустите браузер с Безопасным поиском на и выполните некоторые команды сайта (в том числе по каталогу). В крайних случаях вы увидите 0 результатов, когда весь ваш сайт помечен и отфильтрован.

В крайних случаях вы увидите 0 результатов, когда весь ваш сайт помечен и отфильтрован.

Для сайтов, которые не полностью отфильтрованы, я обнаружил, что запросы сайта немного схематичны. Иногда они показывают, что сайт частично отфильтрован, а иногда нет… Так что используйте это как быстрый способ проверить наличие фильтрации, но не полагайтесь на него на 100%. Опять же, для сайтов, полностью отфильтрованных безопасным поиском, это может быть полезно. Для частичной фильтрации этот процесс может быть ненадежным.

2. Определите запросы, подверженные риску, и выполните фактический поиск

Лучший способ проверить фильтрацию SafeSearch — запустить поиск с помощью двух настроек браузера, о которых я упоминал ранее. Сначала зайдите в GSC и экспортируйте кучу запросов, ведущих на ваш сайт. Найдите те, которые будут считаться рискованными с точки зрения безопасного поиска (либо на основе самого запроса, либо на основе контента, который у вас есть на целевых целевых страницах). А затем начать поиск.

А затем начать поиск.

Введите запрос в браузере с SafeSearch от , проверьте свой рейтинг, а затем выполните тот же поиск в браузере с безопасным поиском по . Вы можете быть удивлены тем, что вы найдете. Вы можете увидеть большие пробелы в поисковой выдаче, где раньше ранжировались ваши страницы. Если это так, да, вы отключили фильтр.

Я только что сделал это для клиента и нашел много запросов, которые привели к фильтрации SafeSearch для них. И фильтрация была сосредоточена на одном конкретном каталоге (что имело смысл, учитывая структуру сайта).

Помните, я говорил ранее о важности структуры URL для безопасного поиска? Что ж, они, к счастью, размещают весь опасный контент в одном каталоге. Это хорошая новость. Плохая новость заключается в том, что там также много неявного контента … Итак, некоторые страницы фильтруются SafeSearch, но, по крайней мере, фильтруется не весь сайт.

Повторите для других запросов и определите, какие запросы и целевые страницы фильтруются. Анализируя больше этих данных, вы можете начать понимать, что пересекает черту с точки зрения содержания. Это хороший переход к следующему разделу этого поста… как выявить проблемный контент до фильтруется.

Анализируя больше этих данных, вы можете начать понимать, что пересекает черту с точки зрения содержания. Это хороший переход к следующему разделу этого поста… как выявить проблемный контент до фильтруется.

Насколько далеко?… Войдите в Google Vision API

До этого момента я рассказывал, как проверить, активно ли вы фильтруетесь, но как насчет выполнения некоторых профилактических работ ДО того, как вас фильтруют? Это естественный вопрос для любой компании, попавшей под фильтр. Обычно они хотят, чтобы их сайт был ориентирован на будущее, и они не хотят, чтобы Google классифицировал этот сайт как сайт для взрослых (или сайт, на котором размещено или контента для взрослых).

Хорошо, у Google есть , частично покрытые, каламбур. 🙂 Войдите в Google Vision API, что довольно удивительно. Он использует машинное обучение для автоматической идентификации и классификации изображений. Вы можете больше узнать о Vision API на сайте, но я остановлюсь на том, как мы можем его использовать, на основе этого поста.

Одной из особенностей Vision API является то, что его можно использовать для обнаружения откровенного контента с помощью SafeSearch. Он может идентифицировать контент для взрослых, насилие и многое другое. Он также использует OCR для обнаружения текста на изображении, поэтому речь идет не только об изображениях на фотографии.

Кроме того, если у вас есть ресурсы для разработки, вы можете использовать API в масштабе, чтобы проверять изображения с помощью безопасного поиска. Если у вас нет ресурсов для разработки и вы не проверяете регулярно большое количество изображений, вы можете протестировать определенные изображения прямо на сайте. Есть возможность попробовать API для отдельных изображений.

После перетаскивания изображения в инструмент или выбора изображения на компьютере Google Vision API проанализирует эту фотографию и вернет кучу информации, включая разделы для лиц, объектов, меток, сущностей, веб-страниц, содержащих изображение, текст, свойства и… Безопасный поиск .

Да, есть специальный раздел для безопасного поиска, который обеспечивает вероятность того, что изображение является взрослым, пародией, медицинским изображением, насилием или пикантным. Это увлекательно.

При тестировании различных изображений с помощью API вы можете начать понимать, что выходит за рамки. Вот несколько примеров того, что API возвращает для SafeSearch. Первый вернул вероятность быть «колоритным», но не совсем «взрослым», в то время как второй пересек черту и вернул «весьма вероятно» как для «взрослого», так и для «колоритного».

Обратите внимание: несмотря на то, что вы получите полезную информацию от API, трудно сказать , что именно приведет к срабатыванию фильтра SafeSearch. Тем не менее, это, безусловно, дает вам более четкое представление о том, как работает SafeSearch. Если вы видите «Очень вероятно» как для взрослых, так и для расистских, то это явно изображение, которое вы хотите переосмыслить (если вы не хотите отключать безопасный поиск). Кроме того, вы не хотите, чтобы Google начал классифицировать ваш сайт или его части как материалы для взрослых.

Кроме того, вы не хотите, чтобы Google начал классифицировать ваш сайт или его части как материалы для взрослых.

Ложные срабатывания, уведомление Google о том, что ваш сайт неправильно помечен

Алгоритмы машинного обучения несовершенны, и иногда сайты ошибочно помечаются как содержащие контент для взрослых. Если вы столкнулись с такой ситуацией, вы должны сообщить об этом Google. Раньше существовала форма, которую вы могли заполнить, чтобы сообщить Google, что ваш сайт ошибочно помечен Безопасным поиском.

К сожалению, Google удалил эту форму и теперь отправляет владельцев сайтов на форумы для веб-мастеров, чтобы изложить свои доводы. Я не большой поклонник такого подхода, поскольку владельцы сайтов часто не хотят сообщать миру о том, что их сайт помечен Безопасным поиском (особенно если они не сосредотачиваются на контенте для взрослых…)

Итак, хорошая новость заключается в том, что вы можете публиковать сообщения на форумах и, надеюсь, получить свою информацию перед сотрудником Google из команды SafeSearch. Плохая новость заключается в том, что вы должны рассказать об этом миру, так как пост будет общедоступным.

Плохая новость заключается в том, что вы должны рассказать об этом миру, так как пост будет общедоступным.

Запрос функции: Требуется отчет о безопасном поиске в Google Search Console!

Помогая некоторым компаниям в этой ситуации, я думаю, что было бы здорово иметь уведомление в GSC или какой-либо отчет, который позволяет владельцам сайтов знать, помечен ли их контент безопасным поиском. И, возможно, там есть кнопка «запросить проверку» на случай, если сайт или разделы сайта будут неправильно помечены. Вот как это может выглядеть (подсказка, подсказка команде GSC). 🙂

Советы по закрытию: безопасный поиск, отключение алгоритма и защита сайта от будущих изменений . Использование методов и инструментов, перечисленных в этом посте, может помочь вам определить, подвергаетесь ли вы фильтрации в настоящее время, и понять, могут ли вас фильтровать в будущем. Ниже я приведу несколько заключительных советов и рекомендаций:

- Полностью осознайте свою текущую ситуацию.

Если вы считаете, что Безопасный поиск может влиять на ваш собственный сайт, проведите тщательное тестирование, чтобы убедиться, что вас не фильтруют. Затем составьте план атаки, если вы готовы. Используйте методы, которые я перечислил ранее, для тестирования запросов с выключенным и включенным безопасным поиском. Опять же, вы можете быть удивлены тем, что вы найдете.

Если вы считаете, что Безопасный поиск может влиять на ваш собственный сайт, проведите тщательное тестирование, чтобы убедиться, что вас не фильтруют. Затем составьте план атаки, если вы готовы. Используйте методы, которые я перечислил ранее, для тестирования запросов с выключенным и включенным безопасным поиском. Опять же, вы можете быть удивлены тем, что вы найдете. - Если вы предоставляете контент для взрослых (или любой тип контента, который может быть сочтен откровенным), начните обсуждение структуры сайта со своими отделами маркетинга и разработчиков. Помните, Google объяснил, что размещение всего контента для взрослых в определенном каталоге может помочь его алгоритмам понять, где на вашем сайте находится откровенный контент (и тогда Безопасный поиск может быть максимально детализированным).

- Используйте метатеги для взрослых, чтобы предоставить страницы с собственной пометкой, которые содержат явный контент. Google объяснил, что это самый сильный сигнал, который вы можете отправить им, что ваши страницы содержат контент для взрослых.

- При идентификации Безопасный поиск учитывает как изображения, так и текст. Это не просто содержание изображения.

- Если вас фильтруют, то эта фильтрация может применяться к веб-страницам, видео и изображениям. Речь идет не только о фильтрации в стандартных результатах органического поиска.

- Расскажите сотрудникам редакции о безопасном поиске и покажите им, как тестировать изображения с помощью Google Vision API. Это может помочь защитить ваш сайт в будущем, заставив сотрудников проводить профилактические проверки ДО того, как этот контент будет опубликован.

- И если вы считаете, что безопасный поиск неправильно помечает ваш сайт, вы, к сожалению, не можете отправить форму, чтобы сообщить об этом Google, как раньше. Вы должны пойти на форумы для веб-мастеров, чтобы предоставить подробную информацию. Мы надеемся, что это может попасть в поле зрения сотрудника Google из команды SafeSearch, но нет никаких гарантий.

Резюме – постарайтесь быть в безопасности с безопасным поиском

Я надеюсь, что эта статья помогла вам лучше понять функцию безопасного поиска Google, как протестировать свой собственный сайт, а затем как проводить профилактические проверки. Не позволяйте призрачному падению трафика создать запутанную ситуацию для вашей компании. Знайте, когда вас фильтруют, а затем составьте план действий в этой ситуации. Удачи и безопасных поисков 🙂

Не позволяйте призрачному падению трафика создать запутанную ситуацию для вашей компании. Знайте, когда вас фильтруют, а затем составьте план действий в этой ситуации. Удачи и безопасных поисков 🙂

GG

Что такое веб-фильтрация? | Фильтрация веб-содержимого

Защитите Интернет с помощью технологии веб-фильтрации Mimecast

Каждый 13-й веб-запрос приводит к вредоносным программам. Этот факт делает безопасность в Интернете важным бизнес-приоритетом для организаций любого размера. Интернет — и особенно DNS — участвует в 91% атак вредоносного ПО. Тем не менее, по необъяснимым причинам многие организации не полагаются на технологию веб-фильтрации для мониторинга своих уровней DNS. Некоторые организации застряли с устаревшими устаревшими системами, которые не могут справиться с задачей меняющегося ландшафта угроз, в то время как другим компаниям приходится иметь дело с автономными системами, которые являются дорогими, сложными и ресурсоемкими.

Проблема веб-фильтрации усугубляется меняющимся характером взаимодействия сотрудников с веб-ресурсами. Все чаще пользователи подключаются к корпоративной сети из дома, в дороге и из других мест на различных устройствах, не защищенных брандмауэрами и другими средствами защиты периметра.

Все чаще пользователи подключаются к корпоративной сети из дома, в дороге и из других мест на различных устройствах, не защищенных брандмауэрами и другими средствами защиты периметра.

Mimecast Web Security решает эту проблему с помощью экономичной облачной службы веб-фильтрации, которая обеспечивает безопасность и мониторинг на уровне DNS. С помощью системы интернет-безопасности Mimecast предприятия могут защитить веб-активность с помощью простых в использовании инструментов, которые останавливают вредоносные программы и другие вредоносные веб-активности до того, как они достигнут их сети или устройств.

Веб-фильтрация с помощью Mimecast

Mimecast Web Security — это служба 100% облачной безопасности, которая обеспечивает расширенную защиту, необходимую для защиты веб-активности, при минимальных затратах и сложности. Проверяя загрузку контента и файлов с помощью динамического прокси-сервера, эта служба веб-фильтрации может применять антивирус, проверку SSL, классификацию URL-адресов и статический анализ файлов для блокировки веб-угроз и обеспечения приемлемого использования сети.

С помощью Mimecast Web Security вы можете:

- Внедрение проактивной защиты для блокировки веб-угроз, доставляющих вредоносное ПО или являющихся частью фишинговых атак.

- Повысьте эффективность работы сотрудников в Интернете, заблокировав доступ к неподходящим для бизнеса веб-сайтам.

- Защитите удаленных и мобильных сотрудников и применяйте единую систему безопасности и контроля ко всем устройствам в сети и за ее пределами.

- Сократите использование теневых ИТ, отслеживая и блокируя неконтролируемое использование облачных приложений.

- Защитите пользователей гостевой сети Wi-Fi, заблокировав доступ к вредоносным и неприемлемым сайтам.

- Улучшите видимость и отчетность с помощью быстрой и простой визуализации ключевых показателей, таких как наиболее посещаемые домены, заблокированные домены и категории сайтов.

Как работает веб-фильтрация Mimecast

Добавляя безопасность и мониторинг на уровне DNS, Mimecast упрощает защиту от вредоносной веб-активности, инициированной действиями пользователя или вредоносного ПО. Когда пользователь щелкает ссылку или вводит адрес в браузере, DNS-запрос отправляется в Mimecast Web Security для проверки и разрешения. Mimecast сканирует целевой веб-сайт на наличие потенциально вредоносного контента и оценивает сайт на соответствие любым организационным политикам для приемлемого использования в Интернете. Если сайт кажется безопасным и приемлемым, пользователю предоставляется немедленный доступ к нему. И если сайт определяется как неприемлемый или подозрительный, Mimecast блокирует доступ пользователя к нему и предоставляет уведомление в браузере о том, почему сайт был заблокирован.

Когда пользователь щелкает ссылку или вводит адрес в браузере, DNS-запрос отправляется в Mimecast Web Security для проверки и разрешения. Mimecast сканирует целевой веб-сайт на наличие потенциально вредоносного контента и оценивает сайт на соответствие любым организационным политикам для приемлемого использования в Интернете. Если сайт кажется безопасным и приемлемым, пользователю предоставляется немедленный доступ к нему. И если сайт определяется как неприемлемый или подозрительный, Mimecast блокирует доступ пользователя к нему и предоставляет уведомление в браузере о том, почему сайт был заблокирован.

Добавление защиты электронной почты Mimecast для комплексной защиты

Веб-защита Mimecast — идеальное дополнение к проверенным службам защиты электронной почты Mimecast. Комбинируя технологию веб-фильтрации с широким спектром решений Mimecast для обеспечения безопасности электронной почты, вы можете добиться более надежной защиты от двух наиболее распространенных векторов кибератак: электронной почты и Интернета.

Mimecast Email Security включает Mimecast Secure Email Gateway с защитой от целевого фишинга, спама, вредоносных программ и атак нулевого дня. Mimecast также предлагает защиту от вредоносных URL-адресов и вооруженных вложений в электронных письмах, а также от атак с использованием олицетворения и внутренних угроз, связанных с электронной почтой, которые исходят из вашей собственной системы электронной почты.

Консолидация технологии электронной и веб-фильтрации в единой облачной службе обеспечивает надежную защиту, включая расширенные проверки сходства доменов и совместный список разрешений/блокировок для URL-адресов в службах электронной почты и веб-безопасности. Совместно используя источники разведданных в обеих службах, вы можете более эффективно защищаться от угроз. А с учетными записями пользователей, ролями и разрешениями, общими для электронной почты Mimecast и веб-безопасности, вы можете наслаждаться более простым опытом управления с единым поставщиком для выставления счетов и поддержки.

В дополнение к безопасности электронной почты и веб-служб Mimecast также предлагает обучение по вопросам безопасности и онлайн-технологии защиты бренда для комплексного решения для безопасности бизнеса в Интернете.

Часто задаваемые вопросы о веб-фильтрации

Что такое веб-фильтрация?

Веб-фильтрация — это технология безопасности, которая отслеживает веб-активность и предотвращает доступ пользователей к веб-сайтам с вредоносным содержимым или сайтам, которые считаются неприемлемыми для использования в бизнесе.

Как работает веб-фильтрация?

Когда пользователь запрашивает веб-ресурс, технология веб-фильтра сканирует запрошенный веб-сайт, прежде чем разрешить DNS-запрос. Если веб-сайт считается безопасным, веб-фильтр разрешит доступ к сайту. И если сканирование обнаружит вредоносный или подозрительный сайт, технология веб-фильтрации заблокирует доступ.

Почему важна веб-фильтрация?

Сеть является одним из основных векторов киберпреступности. Защита от веб-атак требует многоуровневого подхода к безопасности, включающего брандмауэры, многофакторную аутентификацию, антивирусное программное обеспечение и регулярные обновления и исправления для существующих приложений. Веб-фильтрация добавляет еще один высоконадежный уровень безопасности, помогающий остановить вредоносную активность до того, как она достигнет сети организации или пользовательских устройств.

Защита от веб-атак требует многоуровневого подхода к безопасности, включающего брандмауэры, многофакторную аутентификацию, антивирусное программное обеспечение и регулярные обновления и исправления для существующих приложений. Веб-фильтрация добавляет еще один высоконадежный уровень безопасности, помогающий остановить вредоносную активность до того, как она достигнет сети организации или пользовательских устройств.

Какие существуют типы веб-фильтрации?

Современные предприятия обычно внедряют решения веб-фильтрации для блокировки вредоносного или отвлекающего контента. Существуют различные типы веб-фильтрации, в том числе:

- Браузерные фильтры. Обычно такие веб-фильтры представляют собой расширения или надстройки для браузера. Эти фильтры легко внедрить, но компании обычно не используют эти веб-фильтры, поскольку они менее надежны.

- Фильтры поисковых систем – тип веб-фильтрации, блокирующий нежелательный контент от появления в результатах поисковой системы.

- Фильтры на стороне клиента. Эти типы веб-фильтров устанавливаются непосредственно на устройство конечного пользователя, что затрудняет масштабное использование этого решения для организаций.

- Интернет-провайдеры с ограниченным содержанием – тип веб-фильтрации, при котором поставщики интернет-услуг блокируют определенные веб-сайты для всех пользователей, подписавшихся на их услуги.

- Сетевые фильтры — решение для веб-фильтрации, которое защищает пользователей в масштабе, фильтруя вредоносные или отвлекающие веб-сайты по всей сети. Сетевые фильтры обычно управляются с единой консоли администратора.

тестирование — Как вы тестируете свой порно фильтр

Задавать вопрос

Спросил

Изменено 1 год, 9 месяцев назад

Просмотрено 40k раз

Для тестирования антивируса у нас есть EICAR, для спама у нас есть GTUBE.

Есть ли стандартный сайт, который включен или должен быть включен в черные списки, который вы можете использовать для тестирования вместо того, чтобы заходить на ваш любимый порносайт перед вашим боссом, генеральным директором или кем-то еще, кто считает, что просмотр такого сайта является оправдание для иска о сексуальных домогательствах?

Обновление

Это меньше касается получения разрешения на тестирование, хотя этот ответ полезен. У меня есть как разрешение, так и обязанность следить за тем, чтобы фильтр работал. Я могу проверить работу фильтра с помощью netcat.

Вместо этого я надеюсь, что существует стандартное доменное имя, которое блокируется большинством/всеми фильтрами для тестирования. Мне нужно иметь возможность поделиться этим с моим боссом и пользователями.

Мне нужно продемонстрировать, что происходит, когда кто-то переходит на отфильтрованную страницу. Мне нужен способ быстро доказать другим, что фильтр работает, не прося их перейти на какой-то сайт, который не вызовет огорчения, если по какой-то причине фильтр не работает.

Если для этой цели еще нет подходящего домена, мне, возможно, придется зарегистрировать домен самостоятельно, а затем добавить его во все фильтры, за которые я отвечаю.

- тестирование

- веб-фильтр

4

Если нет, то должен быть. RFC2606 резервирует несколько доменов верхнего уровня для целей тестирования с пониманием того, что они никогда не будут назначены. Он также резервирует три имени второго уровня для использования в примерах документации. Бронирование:

-

.test(тестирование кода, связанного с DNS) -

.example(документация и примеры) -

.invalid(известно и явно недействительно) -

.localhost(127.0.0.1 под любым другим именем) -

example.com,example.net,example.org(документация)

Исходя из описанного предполагаемого использования, для меня имеет смысл использовать что-то вроде pr0n. в качестве определенного положительного результата. Вы можете сделать так, чтобы это имя разрешалось во что-то безобидное (БАХ!), чтобы при сбое фильтра происходило что-то более интересное, чем просто неудачный поиск DNS.![]() test

test

2

Объясните своему боссу и отделу кадров, что вы либо должны надеяться, что порнофильтр работает, либо вам нужно проверить его, зайдя на неподходящие сайты. Обязательно сообщите им, когда вы проводите тест и сколько времени это займет, чтобы они знали, что вы не «тестируете» фильтр весь день каждый день. Затем они могут решить, хотят ли они позволить вам попробовать посетить такие сайты на работе или надеяться, что фильтры будут работать по умолчанию.

Второй вариант — установить его дома, не сказав сыну-подростку, и посмотреть, сколько времени потребуется ему, чтобы разозлиться и спросить, почему интернет не работает, как раньше.

1

У нас (в Smoothwall) есть «ежедневный» URL-адрес в списках для проверки фильтра — с датой списка в URL-адресе, чтобы вы могли сказать, что вы в курсе. Ваш поставщик может предоставить аналогичную функцию. Это вполне может быть не задокументировано — спросите у них!

Ваш поставщик может предоставить аналогичную функцию. Это вполне может быть не задокументировано — спросите у них!

В качестве альтернативы мне нравится playboy.com. Должна быть заблокирована, но домашняя страница всегда довольно безобидна — девушки в бикини и т. Д., Так что низкий фактор риска для HR, если вы просто нажмете /.

1

Сайт не для взрослых, но мы используем Poker Stars, чтобы проверить, работает ли наш фитинг. Мы блокируем азартные игры на том же уровне. Так что если Poker Stars заблокируют, значит система фильтрации работает.

Я добавлю здесь кое-что…

Все устройства веб-фильтрации, которые я использую, имеют функцию поиска, которая позволяет отправить URL-адрес, чтобы увидеть, как он будет классифицирован. Это делается без фактической инициализации подключения к сайту. Кроме того, на ту же базу данных контента можно ссылаться через онлайн-форму отправки.

Эти фильтры обладают более тонкой детализацией в наборах правил и могут различать что-то вроде нижнего белья и купальных костюмов, хардкорного порно и простого контента для взрослых.

Кроме того, прямо из устройства можно выполнить тест просмотра, чтобы имитировать то, что пользователь увидит во время сеанса просмотра.

3

Мы используем www.pornsite.com

Он должен быть заблокирован, но если это не так, домашняя страница содержит сообщение типа «Вам должно быть 18 лет или больше, чтобы продолжить» с только текстом и без изображений.

ОБНОВЛЕНИЕ: сейчас на www.pornsite.com МНОГО изображений…

В последнее время мы просто использовали www.playboy.com вместо него, но все еще ищем лучшую альтернативу.

3

сайт playboy является стандартом «де-факто» для этой цели. Это нормально, если вы говорите о фильтре URL. Ходят слухи, что некоторые фильтрующие программы имеют специальную процедуру для поиска «playboy» (и только «playboy») в любом месте URL-адреса, чтобы иметь возможность заблокировать его даже через анонимайзер.

Но если говорить о тестировании фильтра содержимого, то содержимое (строка) не определено.

И, конечно же, для «фильтра изображений» ответ — нет.

Тестирование фильтра pr0n должно быть достаточно простым. Воспользуйтесь playboy.com. Это известный сайт pr0n уже более десяти лет.

На предыдущей работе мы использовали sex.com и только sex.com. Это легко запомнить и настоящий порносайт. Если кто-то, кто не был администратором и тестировал изменение фильтра, появлялся в журнале для этого сайта, вы знали, что они просматривают его.

К сожалению, если есть проблема, вы будете подвергаться воздействию порно.

Служба, которую мы используем, предоставляет сайт поиска, на который мы можем перейти и посмотреть, как он классифицирует конкретный URL-адрес:

http://zvelo.com/test-a-site

Таким образом, мы можем зайти на безобидный рекламный сайт, чтобы убедиться, что фильтр работает в целом или для конкретной машины, и использовать поиск, чтобы убедиться, что определенные URL-адреса находятся в списке фильтров. На данный момент это сработало достаточно хорошо. Не нужно загружать неподходящие сайты только для тестирования.

На данный момент это сработало достаточно хорошо. Не нужно загружать неподходящие сайты только для тестирования.

Для совместного использования заблокированного домена с пользователями большинство систем позволяют создать собственный дополнительный черный список. Выберите что-нибудь, убедитесь, что оно есть в вашем черном списке, и поделитесь этим. Поддомен вашего собственного веб-сайта (например, filtertest.example.com) может даже работать, если у вас есть правильные записи DNS, чтобы он пытался пройти через ваш шлюз (в отличие от шпильки или более прямого маршрута).

Обычно мы пытаемся зайти на сайты www.whitehouse.com, www.hustler.com и www.playboy.com… и если наш охранник разозлится, он пойдет в Google и найдет свой любимый вид порно. и посмотрим, что произойдет 🙂

Лично я никогда не видел, чтобы фильтрующий продукт пропустил ни один из первых трех, и, честно говоря, если он сделал что-то не так, или программное обеспечение очень, очень, очень плохое.

Мы случайным образом выбрали малоизвестную доменную компанию, которая будет использоваться для этого.

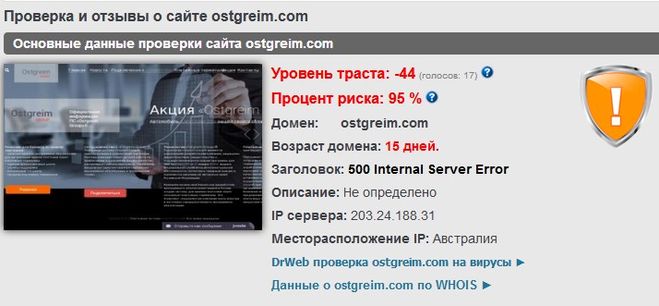

Проверять доноров до покупки ссылки