Почему не воспроизводится видео на YouTube в Яндекс.Браузере

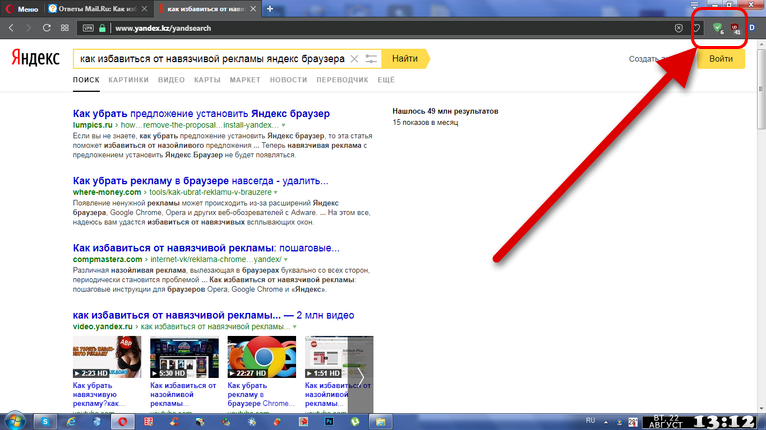

Почему Ютуб не показывает видео в Яндекс.Браузере? Вопросы такого плана стали весьма часто появляться в Сети. Пользователи не понимают, почему так случается. Мы попробуем ответить на данный вопрос и постараемся решить проблему.

Содержание

- Решение

- Чистка временных данных

- Борьба с вирусами

- Заключение

Решение

Чаще всего такое поведение YouTube вызвано проблемами в самом веб-обозревателе. Если их устранить, то все должно заработать нормально. Но для этого нужно знать, что делать. И мы расскажем все об этом.

Стоит отметить, что для начала нужно бы проверить скорость своего Интернет-соединения. Возможно, все дело в том, что видео попросту не хватает скорости. Если же с этим все нормально, то приступаем к настройке веб-обозревателя.

Чистка временных данных

Переполненный кэш Яндекс.Браузера вполне может стать причиной, из-за которой невозможно просмотреть видео на YouTube. Дело в том, что ролик должен кэшироваться для нормального просмотра. Но если в кэше места нет, то ничего не получится.

Дело в том, что ролик должен кэшироваться для нормального просмотра. Но если в кэше места нет, то ничего не получится.

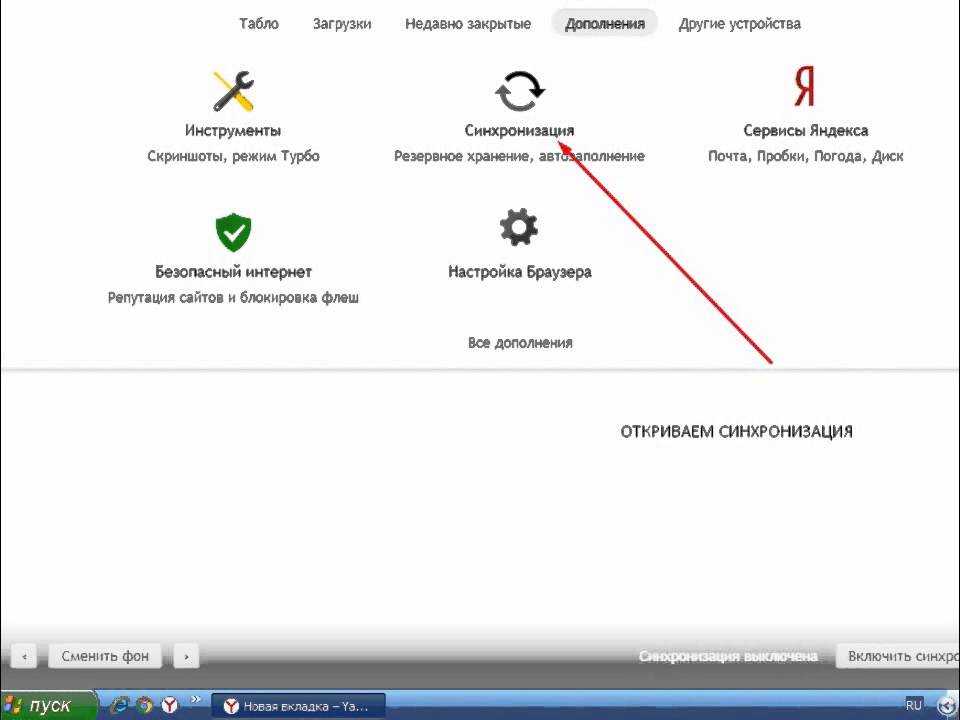

Вообще, это хранилище желательно чистить регулярно. Тогда и проблем таких не будет. Но большинство среднестатистических пользователей не знает, как это делать. Поэтому мы предоставим подробную инструкцию по этому поводу. Вот она.

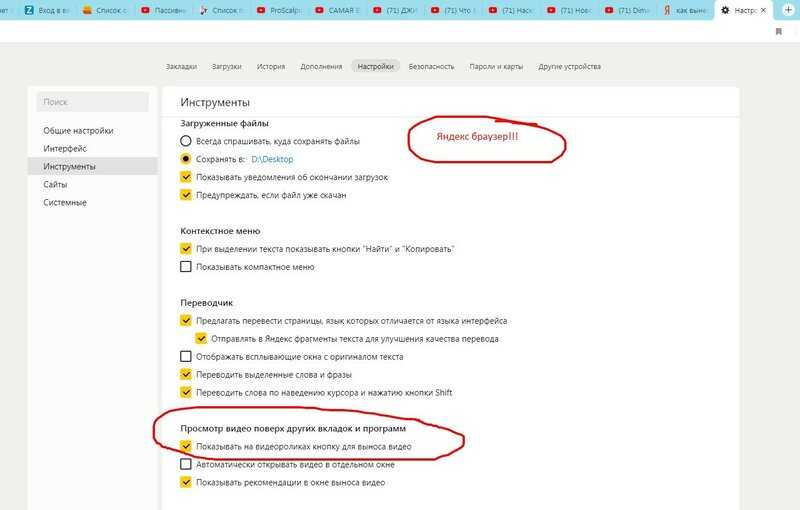

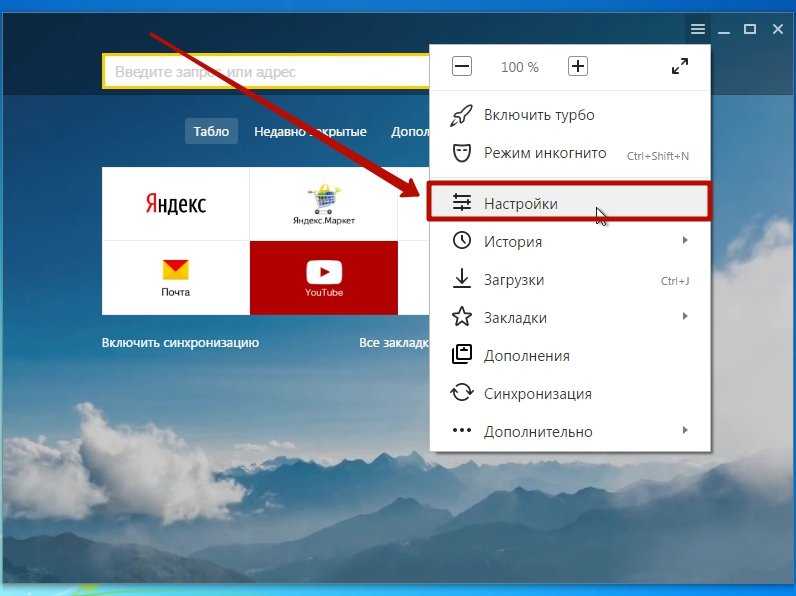

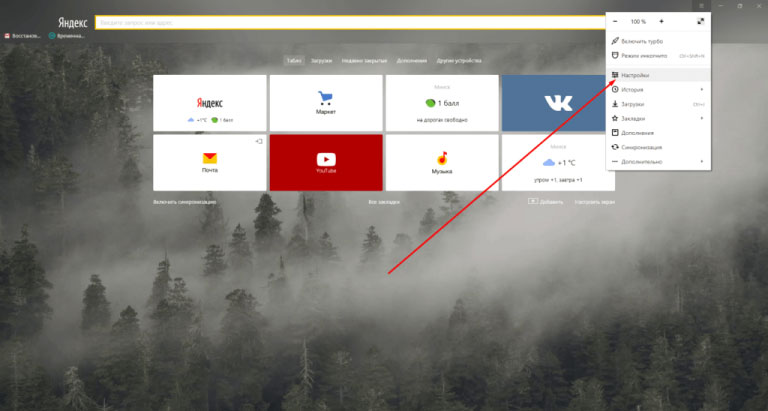

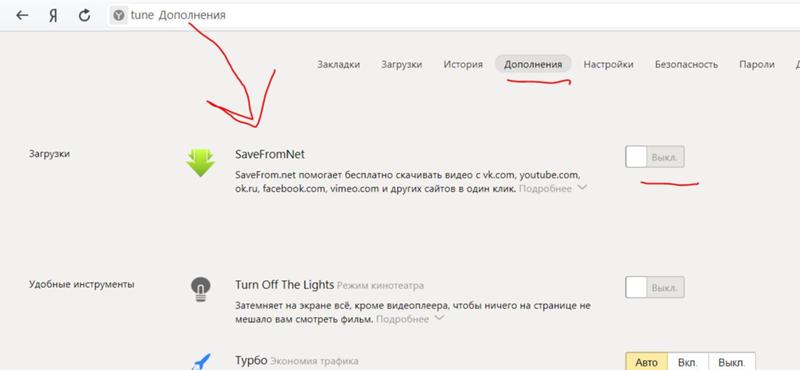

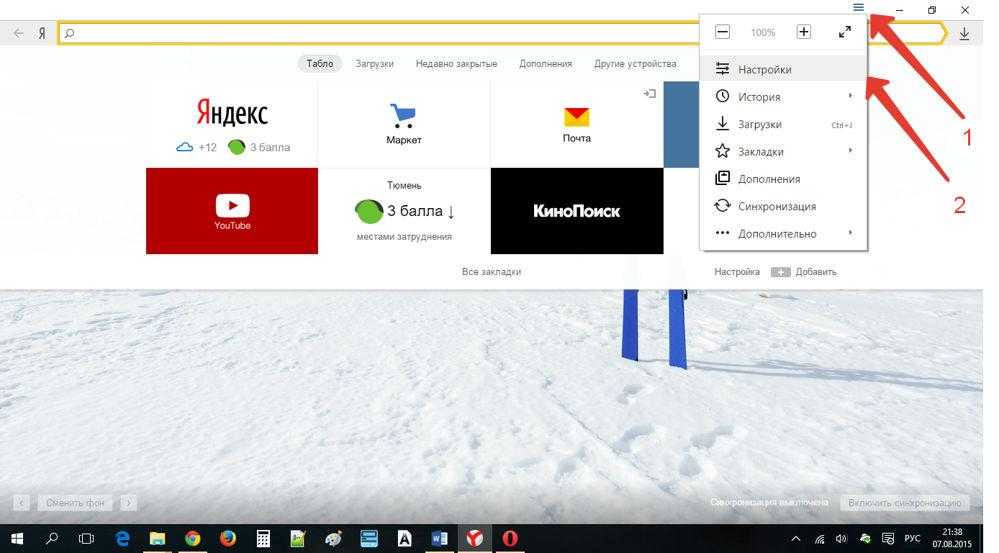

- Открываем Яндекс.Браузер и щелкаем по кнопке с изображением трех горизонтальных полос.

- Далее кликаем по пункту «Настройки».

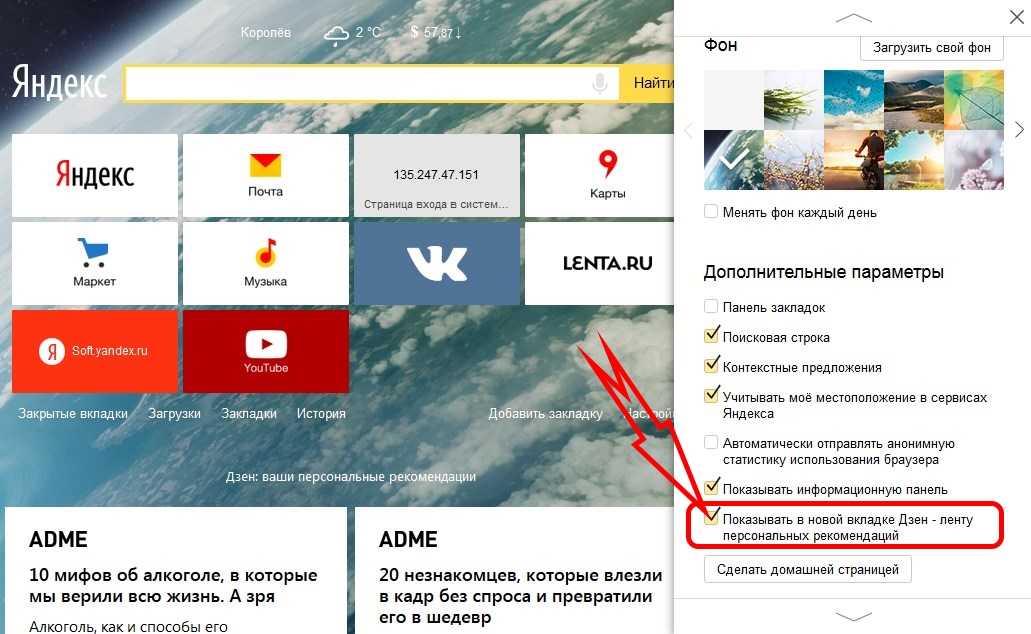

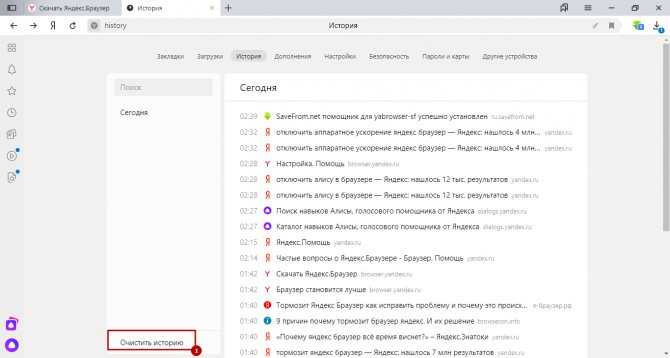

- Пролистываем содержимое страницы до самого низа.

- Здесь нам нужна опция с соответствующим названием – кликните по ней.

- Настройте все параметры, как это показано на картинке ниже.

- Нажмите на желтую кнопку.

Сам процесс очистки займет очень мало времени. После того, как процедура будет завершена, стоит перезапустить веб-обозреватель. После рестарта можно попробовать снова посетить YouTube и запустить какое-нибудь видео. Если ничего не изменилось, то переходим к следующей главе.

Борьба с вирусами

Часто вредоносные объекты тоже могут стать причиной неадекватного поведения браузера. Если исполняемый файл приложения заражен каким-нибудь червем, то он не будет нормально работать. А значит, от вирусов нужно избавляться.

Нам потребуется хороший антивирус. Неплохо себя показывает программа ESET NOD32. На ее примере мы и рассмотрим процесс удаления вирусов с компьютера. Нужно сделать следующее.

- Кликаем правой кнопкой мыши в системном трее по значку антивируса.

- В появившемся меню выбираем «Открыть…».

- Далее переходим на вкладку «Сканирование…».

- Кликаем на опцию запуска процедуры.

Процесс начнется и закончится автоматически. По ходу выполнения процедуры антивирус будет информировать пользователя о найденных и удаленных угрозах. После завершения сканирования можно запускать браузер и пробовать загружать ролик на YouTube.

Разумеется, подойдет и любой другой антивирус.

Заключение

А теперь подведем итоги. Если не загружается сайт Ютуб в Яндекс.Браузере или видео с этого сервиса, то есть два варианта: либо с самой программой что-то не так, либо вирусы постарались. Последнее, конечно, серьезнее.

Выше мы представили возможные варианты решения проблемы. Обычно они помогают. Но если этого не случилось, то остается только переустановить веб-обозреватель. Однако предварительно рекомендуется проверить систему на вирусы, дабы проблема не повторилась.

как работает и как его включить

Артем Мазанов

переведется все

Профиль автора

Нейросети «Яндекса» больше года переводят на русский язык и озвучивают видео. Они умеют различать разных спикеров в одном ролике и знают пять языков.

Прототип технологии машинного перевода видео и закадровой озвучки в реальном времени «Яндекс» представил в июле 2021 года. Тогда он работал только с отобранными видео на английском языке. Спустя полтора года эта функция — одна из самых полезных в «Яндекс-браузере». Технология позволяет переводить видео уже с пяти языков: английского, французского, испанского, немецкого и итальянского.

Технология позволяет переводить видео уже с пяти языков: английского, французского, испанского, немецкого и итальянского.

Расскажу, как активировать функцию, как она работает и какие проблемы пришлось преодолеть для создания качественной закадровой озвучки нейросетями.

Что вы узнаете из материала

- Зачем нужен закадровый перевод видео

- Как включить закадровый перевод видео

- Как включить перевод прямых трансляций

- Как именно нейросети переводят видео

- Как работает перевод прямых трансляций

Зачем нужен закадровый перевод видео

Контента на русском языке значительно меньше, чем на английском. В ноябре 2022 года во всем интернете насчитывалось больше 1,1 млрд сайтов. Из них на русском — меньше 10%. Англоязычных видео намного больше, чем русскоязычных.

На YouTube можно встретить целые проекты, которые занимаются озвучками иностранных роликов. Но это долго, много видео так не переведешь, к тому же переведенные ролики периодически удаляют за нарушение авторских прав. Англоязычные блогеры и образовательные проекты редко добавляют российскую озвучку — можно вспомнить разве что самого популярного ютубера в мире Mr.Beast. Закадровый перевод от «Яндекс-браузера» решает многие из этих проблем.

Англоязычные блогеры и образовательные проекты редко добавляют российскую озвучку — можно вспомнить разве что самого популярного ютубера в мире Mr.Beast. Закадровый перевод от «Яндекс-браузера» решает многие из этих проблем.

Некоторого полезного контента на русском языке нет вообще. Например, видеороликов, помогающих учиться, развиваться, решать рабочие и профессиональные задачи. Фотографы могут выбрать объектив после просмотра видео, а дизайнеры — графический планшет. Большинство обзоров техники сначала появляется как раз на английском языке.

Некоторые темы вообще трудно найти в русскоязычном сегменте YouTube. Я столкнулся с этим, когда искал сравнение двух фотоаппаратов моментальной печати Polaroid.

/list/youtube-classics/

Фейнман, Канеман и Ростропович: 13 образовательных плейлистов на «Ютубе»

Также в открытом доступе есть много уникального и полезного контента. Например, курсы или лекции от ведущих мировых университетов. Авторы редко переводят такие видео на русский язык. Обычно их можно смотреть максимум с субтитрами. Некоторые наиболее популярные лекции переводят энтузиасты. Но таких видео мало.

Например, курсы или лекции от ведущих мировых университетов. Авторы редко переводят такие видео на русский язык. Обычно их можно смотреть максимум с субтитрами. Некоторые наиболее популярные лекции переводят энтузиасты. Но таких видео мало.

Помогает смотреть видео в фоновом режиме. На том же YouTube неплохо обстоит ситуация с субтитрами: они даже генерируются автоматически, в том числе и русскоязычные. Но так сложнее воспринимать видео на незнакомом языке во время готовки или занятий спортом.

К тому же, согласно исследованию Morning Consult, 86% опрошенных россиян предпочитают смотреть контент на стриминговых платформах в дубляже, а не с субтитрами или полностью в оригинале. Это самый высокий показатель среди 15 стран — участниц опроса.

/films-without-dubbing-pros-cons/

За и против: стоит ли смотреть фильмы и сериалы в оригинале

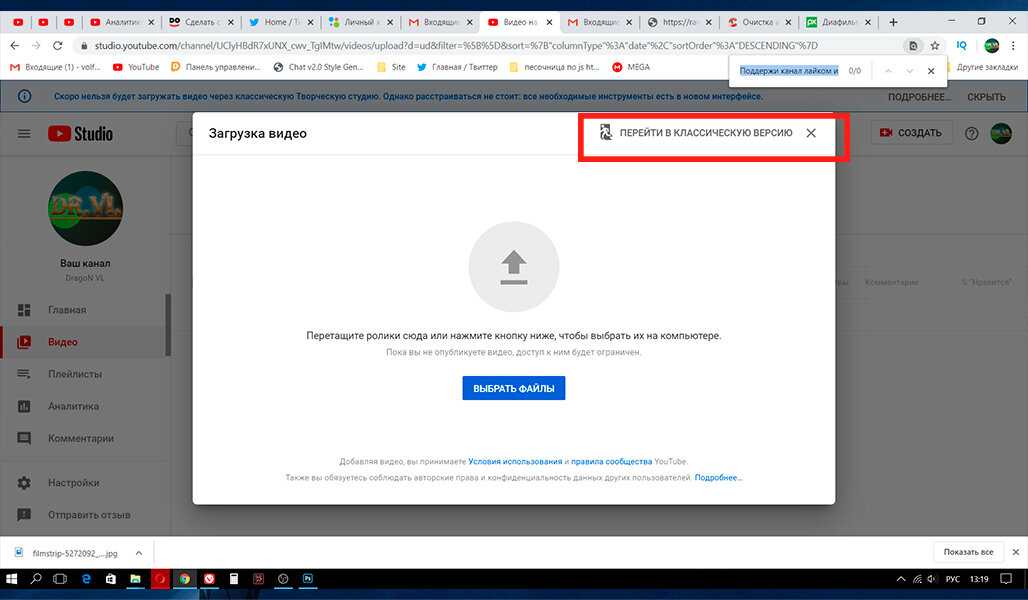

Как включить закадровый перевод видео

В «Яндекс-браузере» на компьютере. Работает сразу же на всех популярных площадках, включая YouTube, Vimeo, TikTok, Twitter, Facebook и «Вконтакте». Заходить на сайты не обязательно — ролики можно переводить прямо в поисковой выдаче. А недавно браузер научился делать закадровую озвучку для курсов на образовательной платформе Coursera.

Работает сразу же на всех популярных площадках, включая YouTube, Vimeo, TikTok, Twitter, Facebook и «Вконтакте». Заходить на сайты не обязательно — ролики можно переводить прямо в поисковой выдаче. А недавно браузер научился делать закадровую озвучку для курсов на образовательной платформе Coursera.

Соцсеть Facebook принадлежит Meta — организации, деятельность которой признана экстремистской и запрещена на территории РФ

Для пользователя процесс выглядит очень просто. Достаточно открыть ролик в браузере и навести курсор на видео — сразу появится кнопка с предложением активировать озвучку. Сгенерированный перевод можно включать и выключать на любом отрезке видео.

Иконка быстро пропадает и не мешает смотреть видео. Источник: youtube.comТехнология приглушает оригинальную озвучку и поверх накладывает сгенерированную речь. Мужские голоса озвучиваются мужским голосом, женские — женским. Технология умеет распознавать нескольких спикеров на одном видео, у каждого из них будет свой голос озвучки, чтобы зрители не запутались.

В настройках, которые доступны рядом с иконкой перевода, можно регулировать громкость оригинальной дорожки и включить субтитры. Некоторые видео технология переводит сразу же, потому что другие пользователи переводили их раньше. Для перевода других роликов придется подождать несколько минут. Когда ролик с русской озвучкой будет готов к просмотру, пользователю придет уведомление.

/my-smart-house-with-alice/

Сам написал код и распечатал гаджеты на 3D-принтере: как я организовал работу умного дома

Примерное время перевода видео указывается в плеере. Если этой информации нет, то видео уже перевелосьПродолжительность выбранного видео не должна превышать четыре часа. Перевод работает только на платформах, где не требуется лицензирование контента. Например, перевести сериал на «Нетфликсе» не получится.

В приложении «Яндекса» на смартфоне. Здесь все то же самое, что и на компьютере. Встроить закадровый перевод прямо в приложение YouTube нельзя, но ролик можно открыть в браузере «Яндекса».

Иконка с переводом появится сразу под видео, если пропадет — нажмите на ролик.

На смартфонах настроек меньше: например, нельзя регулировать громкость оригинальной дорожкиВ других браузерах на компьютере. Официально закадровый перевод «Яндекса» не поддерживается в других браузерах. Но есть неофициальные способы перенести функцию в Google Chrome или Safari.

Мы не приводим ссылки, так как скрипты разработаны третьими лицами — используйте на свой страх и риск.

Как включить перевод прямых трансляций

Перевод прямых трансляций запустили в августе 2022 года. Он работает в тестовом режиме: технология синхронного перевода и озвучки сложнее, чем в случае с готовыми роликами.

Переводить можно только стримы на некоторых ютуб-каналах. Например, запуски SpaceX и NASA, анонсы от Apple и выступления с конференций TED.

Для пользователя перевод прямых трансляций не отличается от перевода видео. Нужно нажать на ту же кнопку во всплывающем окне, и спикеры начнут разговаривать на русском языке.

Как именно нейросети переводят видео

Как именно работает технология и какие проблемы пришлось решать, мне рассказал руководитель перевода видео в «Яндекс-браузере» Сергей Корбан.

Когда началась работа над переводом видео, у браузера уже были нейросети, которые умеют переводить речь в текст и озвучивать текст с помощью синтеза речи. Они используются в других продуктах: например, голосовой помощник «Алиса» слушает человека и распознает его слова, а модуль для распознавания речи конвертирует слова в текст.

/yandex-station2-review/

Обзор «Яндекс-станции 2» с Алисой: пока что лучшей колонки для управления умным домом

Эти технологии и взяли за основу при разработке перевода видео. Но время работы над первой версией технологии команда столкнулась с некоторыми проблемами:

- Нейросети при переводе не очень хорошо улавливали контекст, поэтому их дополнительно обучали на корпусах текстов разных тематик. Первая версия лучше всего переводила экономические, литературные темы и научные статьи.

Сейчас технология хорошо справляется с биологией и физикой, но с другими темами периодически возникают сложности, например с игровыми стримами — в них особенная лексика.

Сейчас технология хорошо справляется с биологией и физикой, но с другими темами периодически возникают сложности, например с игровыми стримами — в них особенная лексика. - Нейросети умели только определять пол спикера — и то не всегда. В новой версии технология уже может распознавать голоса разных спикеров в одном видео и их пол. Благодаря этому несколько спикеров одного пола озвучиваются разными голосами. Это голоса реальных людей, на которых нейросеть научилась синтезировать озвучку.

- Перевод нужно было уместить на ту же звуковую дорожку, что и оригинал. При этом длина одной и той же фразы, произнесенной на разных языках, может различаться. Например, в русском языке фразы обычно длиннее, чем в английском. Чтобы озвучка попала в слова, нейросеть, которая отвечает за синтез речи, ускоряет или замедляет речь и делает паузы.

Все эти проблемы решены в текущей версии технологии перевода видео. За это отвечают сразу шесть нейросетей.

Первая нейросеть на стороне переводчика определяет язык спикеров. Если они говорят на языке, который поддерживается, браузер предложит перевести видео.

Вторая нейросеть переводит речь спикеров в текст. Модель получает аудиодорожку, из нее она должна вычистить все посторонние звуки. Модель умеет избавляться от слов-паразитов. После всех обработок остается последовательный набор слов — с ним будут работать другие нейросети.

/chatgpt/

Чат-нейросеть ChatGPT ведет диалог, пишет код и сочиняет стихи: как попробовать самому

Пример того, как нейросеть переводит речь в текст. Источник: «Яндекс»Третья нейросеть нормализует текст и расставляет знаки препинания. Нормализация — это преобразование текста в одну нормальную словарную форму.

Например, расшифровка сокращений. На этом этапе последовательность слов также нарезается в предложения. При их составлении модель должна сохранить изначальный смысл.

Четвертая нейросеть определяет, сколько спикеров на видео и какой у них голос — мужской или женский. Это нужно, чтобы на другом этапе каждому спикеру присвоить свой голос.

Определить пол можно по частоте голоса: у мужчин это 80—150 Гц, у женщин — 150—250 Гц. Также помогают и местоимения, которые произносит другой спикер.

Источник: «Яндекс»Пятая нейросеть переводит полученный текст на русский язык. Вместе с текстом модель получает информацию о спикерах, чтобы правильно расставить местоимения.

Шестая нейросеть синтезирует речь. На этом этапе нужно избежать рассинхрона, потому что перевод предложения может оказаться в несколько раз длиннее оригинала. Иногда помогают паузы спикеров, в эти моменты можно уложить перевод. Но иногда приходится ускорять речь.

Как работает речевой синтез. Источник: «Яндекс»

Источник: «Яндекс»Как работает перевод прямых трансляций

С точки зрения технологий перевод стрима и перевод записанного видео — две принципиально разные задачи. Перевод потоковых видео построен на другой архитектуре, но работает с теми же моделями.

Переводить потоковые видео сложнее. Нужно одновременно решать две противоречивые задачи — поддерживать качество перевода и не отставать от речи спикеров. При переводе обычных роликов нейросети получают аудиодорожку сразу целиком. У них есть время ее проанализировать, разбить речь на предложения и синтезировать озвучку на русском языке.

Во время работы с прямыми трансляциями такого запаса времени нет — технология работает почти как синхронный переводчик. Чтобы задержка в переводе была небольшой, на помощь приходит нейросеть, которая расставляет в тексте знаки препинания. Это помогает понять, где начинается и заканчивается предложение, найти составные части сложносочиненного предложения, вводные фразы, перечисления и так далее.

/video-support/

Какое видео вам нужно посмотреть прямо сейчас?

После того как знаки препинания расставлены, нейросеть выделяет из текста части, содержащие законченную мысль. Именно они отправляются на перевод, который затем синтезируется и накладывается поверх оригинальной аудиодорожки. Так браузер находит оптимальный баланс между скоростью перевода и его качеством.

Задержка перевода ютуб-трансляций составляет от 30 до 50 секунд. Также в переводе стримов пока используются только два голоса — мужской и женский. Поддержки мультивойса нет.

Что в итоге

- Перевод и закадровая озвучка видео в «Яндекс-браузере» — полезный инструмент для тех, кто плохо знает иностранные языки и не хочет смотреть видео с субтитрами, даже если они есть.

- Нейросеть генерирует закадровую озвучку для роликов на пяти языках и некоторых прямых трансляций на YouTube. Технология не только переводит речь, но и различает спикеров на видео, а также синтезирует разную озвучку для участников видео одного пола.

- Если смотреть на технологию изнутри, то озвучкой в «Яндекс-браузере» занимается не одна нейросеть, а целых шесть. Все они дополняют друг друга.

- Функция работает только в «Яндекс-браузере», но есть способы перенести ее в Chrome или Safari с помощью скрипта.

Мы постим кружочки, красивые карточки и новости о технологиях и поп-культуре в нашем телеграм-канале. Подписывайтесь, там классно: @t_technocult.

Перевод прямых трансляций через Яндекс Браузер: Принципы и отличия от озвучивания видео по запросу | Сергей Дуканов | Яндекс

Мы уже рассказывали о том, как работает автоматический перевод и озвучивание видео в Яндекс Браузере. Пользователи просмотрели 81 миллион видеороликов с озвученным переводом за первые десять месяцев после релиза. Механизм работает по запросу: как только пользователь нажимает на кнопку, нейросеть получает всю звуковую дорожку, а дублированный перевод на язык пользователя появляется через несколько минут.

Но этот способ не подходит для прямых трансляций, где нужно переводить практически в реальном времени. Именно поэтому мы просто запустили отдельный, более сложный механизм трансляции прямых трансляций в Яндекс.Браузере. Анонсы устройств, спортивные соревнования, вдохновляющие космические запуски — все это и многое другое теперь можно смотреть на целевом языке в прямом эфире. Производственная версия в настоящее время поддерживает перевод только на русский язык, а английский язык появится этой осенью. Также на данный момент озвучка доступна для ограниченного набора потоков YouTube: вы можете найти полный список в конце этой статьи. В будущем мы, конечно же, откроем эту функцию для всех прямых трансляций YouTube. Нам пришлось перестраивать всю архитектуру с нуля, чтобы адаптировать механизм трансляции для потоков.

Именно поэтому мы просто запустили отдельный, более сложный механизм трансляции прямых трансляций в Яндекс.Браузере. Анонсы устройств, спортивные соревнования, вдохновляющие космические запуски — все это и многое другое теперь можно смотреть на целевом языке в прямом эфире. Производственная версия в настоящее время поддерживает перевод только на русский язык, а английский язык появится этой осенью. Также на данный момент озвучка доступна для ограниченного набора потоков YouTube: вы можете найти полный список в конце этой статьи. В будущем мы, конечно же, откроем эту функцию для всех прямых трансляций YouTube. Нам пришлось перестраивать всю архитектуру с нуля, чтобы адаптировать механизм трансляции для потоков.

С инженерной точки зрения перевод и дублирование прямых трансляций — сложная задача. Здесь сталкиваются два противоречивых требования. С одной стороны, вам нужно скормить модели как можно больше текста за раз, чтобы нейронная сеть понимала контекст каждой фразы. С другой стороны, необходимо минимизировать задержку; иначе «прямой эфир» перестанет быть таковым. Поэтому мы должны начать переводить как можно скорее: не в режиме настоящего синхронного перевода, но очень близко к нему.

Поэтому мы должны начать переводить как можно скорее: не в режиме настоящего синхронного перевода, но очень близко к нему.

Мы разработали новую услугу на основе существующих алгоритмов для быстрого и качественного перевода и дублирования прямых трансляций. Новая архитектура позволила уменьшить задержку без потери качества.

Вкратце принцип работы прямой трансляции сводится к пяти моделям машинного обучения. Одна нейросеть отвечает за распознавание речи звуковой дорожки и преобразует ее в текст. Второй движок определяет пол говорящих. Третий разбивает текст на предложения, расставляя знаки препинания и определяя, какие части текста содержат законченные мысли. Четвертая нейросеть переводит полученные куски. Наконец, пятая модель синтезирует речь на целевом языке.

На бумаге все выглядит просто, но если копнуть глубже, можно обнаружить множество подводных камней. Давайте рассмотрим этот процесс более подробно.

На начальном этапе нужно точно понимать, о чем идет речь в эфире, и определить, когда произносятся слова. Мы не просто переводим речь, но и накладываем результат обратно на видео в нужные моменты.

Мы не просто переводим речь, но и накладываем результат обратно на видео в нужные моменты.

Глубокое обучение — идеальное решение проблемы ASR (автоматического распознавания речи). Архитектура нейронной сети должна допускать сценарий использования прямой трансляции, когда необходимо обрабатывать звук по мере его поступления. Такое ограничение может повлиять на точность предсказания, но мы можем применить модель с некоторой задержкой (несколько секунд), что придает модели некоторый контекст.

Видео могут содержать посторонние шумы и музыку. Кроме того, люди могут иметь разную дикцию или говорить с разным акцентом и скоростью. Говорящих может быть много, и они могут кричать, а не говорить на умеренной громкости. И, конечно же, нужно поддерживать богатый словарный запас, ведь возможных тем видео очень много. Таким образом, сбор данных, необходимых для обучения, играет ключевую роль.

На вход алгоритм получает последовательность звуковых фрагментов, берет N из них с конца, извлекает акустические признаки (спектрограмму MEL) и подает результат на вход нейронной сети. Он, в свою очередь, выдает набор последовательностей слов (так называемых гипотез), из которых языковая модель — текстовая часть нейронной сети — выбирает наиболее правдоподобную гипотезу. Когда поступает новый фрагмент аудио, процесс повторяется.

Он, в свою очередь, выдает набор последовательностей слов (так называемых гипотез), из которых языковая модель — текстовая часть нейронной сети — выбирает наиболее правдоподобную гипотезу. Когда поступает новый фрагмент аудио, процесс повторяется.

Полученную последовательность слов необходимо перевести. Качество пострадает, если вы будете переводить слово за словом или фразу за фразой. Если вы дождетесь длинной паузы, означающей конец предложения, произойдет значительная задержка. Поэтому необходимо группировать слова в предложения, чтобы избежать потери смысла или слишком длинных предложений. Одним из способов решения этих проблем является использование модели восстановления пунктуации.

С появлением трансформеров нейронные сети стали намного лучше понимать смысл текста, отношения между словами и закономерности языковых конструкций. Вам нужен только большой объем данных. Для восстановления пунктуации достаточно взять корпус текстов, подать текст без знаков препинания на вход нейронной сети и обучить сеть исправлять его обратно.

Текст поступает на вход нейросети в токенизированном виде; обычно это токены BPE. Такое разбиение не слишком мало, чтобы предотвратить удлинение последовательности, но и не слишком велико, чтобы избежать проблемы отсутствия словарного запаса, когда токен отсутствует в глоссарии. На выходе модели каждое слово имеет последующую метку, которая отмечает, какой знак препинания следует поставить.

Необходимо установить некоторый ограниченный контекст, чтобы обеспечить правильную работу в условиях прямой трансляции. Размер этого контекста должен найти компромисс между качеством и задержкой. Если мы не уверены, нужно ли разбивать предложения в данном конкретном месте, мы можем немного подождать, пока не появятся новые слова. Тогда мы либо лучше определим разбиение, либо превысим ограничение контекста и будем вынуждены разбиваться там, где мы только немного конечно.

Для корректного перевода и качественного озвучивания необходимо определить пол говорящего. Если вы используете классификатор пола на уровне предложения, в сценарии прямой трансляции не будет различий по сравнению со сценарием по запросу. Хранение истории голосовых линий каждого говорящего помогает нам более точно классифицировать половую принадлежность. Это снижает количество ошибок в полтора раза. Мы не только можем определить пол человека всего по одной фразе, но и рассматриваем результаты гендерной классификации по ранее сказанным фразам. Для этого нам нужно на лету определить, кому принадлежит линия, тем самым уточнив пол говорящего.

Хранение истории голосовых линий каждого говорящего помогает нам более точно классифицировать половую принадлежность. Это снижает количество ошибок в полтора раза. Мы не только можем определить пол человека всего по одной фразе, но и рассматриваем результаты гендерной классификации по ранее сказанным фразам. Для этого нам нужно на лету определить, кому принадлежит линия, тем самым уточнив пол говорящего.

С точки зрения машинного перевода ничего не изменилось по сравнению с переводом готовых видео, поэтому сейчас не будем в это углубляться. В прошлом мы рассмотрели внутреннюю работу перевода.

Базовая технология синтеза в Алисе, умном помощнике Яндекса, аналогична той, которую мы используем в видеопереводе. Разница в том, как осуществляется применение (вывод) этих нейронных сетей. Говорящий в ролике может очень быстро произнести реплику, либо перевод предложения может получиться в два раза длиннее оригинала. В этих случаях вам придется сжимать синтезированный звук, чтобы не отставать от времени. Этого можно добиться двумя способами: на уровне звуковой волны, например, с помощью PSOLA (Pitch Synchronous Overlap and Add) или внутри нейронной сети. Второй метод обеспечивает более естественное звучание речи, но требует возможности редактирования скрытых параметров.

Этого можно добиться двумя способами: на уровне звуковой волны, например, с помощью PSOLA (Pitch Synchronous Overlap and Add) или внутри нейронной сети. Второй метод обеспечивает более естественное звучание речи, но требует возможности редактирования скрытых параметров.

Важно не только доводить длительности синтезируемых фраз до нужной длины, но и разлагать их в нужные моменты. Не всегда будет идеально: придется либо ускорять запись, либо сдвигать тайминги — за это отвечает алгоритм стекирования. В прямом эфире нельзя изменить прошлое, поэтому может возникнуть ситуация, когда нужно озвучить фразу в два раза быстрее, чем она произносится в исходном видео. Для справки: ускорение более чем на 30% существенно влияет на человеческое восприятие.

Решение следующее: резервируем время заранее. Мы не торопимся складывать голосовые линии и можем дождаться новых, чтобы учесть их продолжительность. Мы также можем позволить накапливаться небольшому временному сдвигу, поскольку рано или поздно в видео будет несколько секунд тишины, и сдвиг будет сброшен до нуля.

Полученная звуковая дорожка разрезается на фрагменты и оборачивается аудиопотоком, который будет микшироваться локально в самом Браузер-клиенте.

При просмотре трансляции Браузер опрашивает стриминговый сервис (например, YouTube) на наличие новых фрагментов видео и аудио; если они есть, он загружает и воспроизводит их последовательно.

Когда пользователь нажимает на кнопку живого перевода, Яндекс.Браузер запрашивает ссылку на поток с переведенным звуком из своего бэкенда. Браузер накладывает этот трек поверх основного, соблюдая тайминги.

В отличие от готовых видео, прямая трансляция обрабатывается машинным переводом каждый момент своего существования. Stream Downloader считывает аудиопоток и отправляет его в конвейер обработки ML, компоненты которого мы разобрали выше.

Существует несколько способов организации взаимодействия между компонентами. Мы остановились на варианте с очередями сообщений, где каждый компонент оформлен как отдельный сервис:

- Запустить все модели на одной машине проблематично: они могут просто не помещаться в памяти или требовать очень специфической аппаратной конфигурации.

- Требуется для балансировки нагрузки и возможности горизонтального масштабирования. Например, сервисы машинного перевода и синтеза голоса имеют разную пропускную способность, поэтому количество фраз может отличаться.

- Службы иногда аварийно завершают работу (графическому процессору не хватает памяти, утечке памяти или отключению электроэнергии в центре обработки данных), а очереди предоставляют механизм повторных попыток.

Поток не привязан к одному экземпляру, но для обработки может потребоваться некоторый контекст (фон). Например, синтезатору необходимо хранить записи, которые еще не были помещены на окончательную звуковую дорожку. Следовательно, необходим глобальный репозиторий контекста для всех потоков. На схеме он обозначен как Global Context — по сути, это просто хранилище ключ-значение в памяти.

Наконец, полученный аудиопоток должен быть доставлен пользователю. Здесь за дело берется Stream Sender: он оборачивает аудиофрагменты в потоковый протокол, а клиент читает этот поток по ссылке.

В настоящее время мы предоставляем прямую трансляцию со средней задержкой 30–50 секунд. Иногда мы вылетаем из этого диапазона, но ненамного: стандартное отклонение около 5 секунд.

Основная трудность при переводе прямых трансляций заключается в обеспечении того, чтобы задержка не колебалась слишком сильно. Простой пример: вы открываете прямую трансляцию и через 15 секунд начинаете получать трансляцию. Если вы продолжите смотреть, рано или поздно одной из моделей понадобится больше контекста — например, если говорящий произносит длинное предложение без пауз, нейронный движок попытается получить его целиком. Тогда задержка увеличится, возможно, еще на десять секунд. Естественно, предпочтительна небольшая задержка в начале, чтобы этого не произошло.

Наша глобальная цель — сократить задержку примерно до 15 секунд. Это немного больше, чем в настоящем синхронном переводе, но достаточно для прямых трансляций, где ведущие взаимодействуют с аудиторией, например, на Twitch.

Пока полный доступ ко всем трансляциям YouTube находится в разработке, вот список каналов, где дублирование уже доступно:

— Apple

— Business Insider

— CNET Highlights

— English Speeches

— Freenvesting

— thegameawards

— Google Developers

— IGN

— NASA

— The Overlap

— SpaceX

— TechCrunch

— TED

— TEDx

Не работает автозапуск в фоновой вкладке — Help

1110001 1110881 1110881 1110881 (Флориан)1

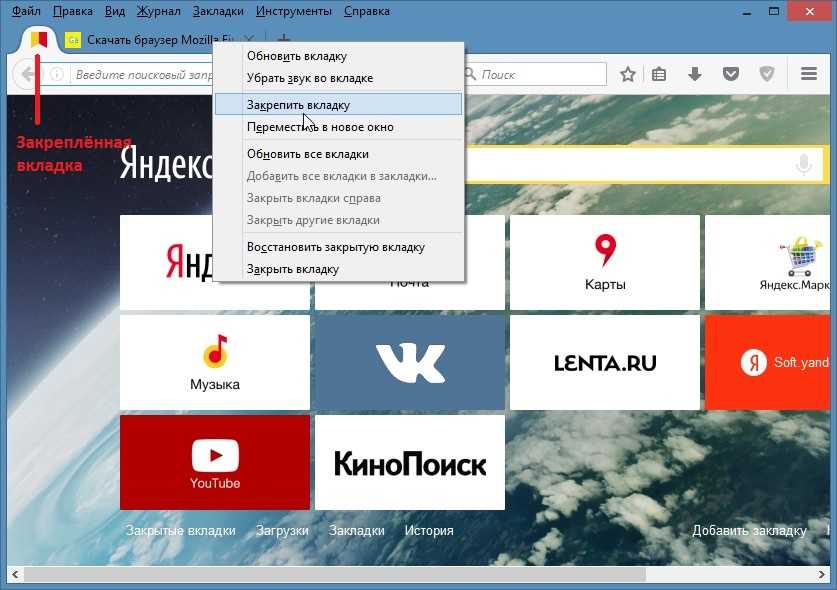

Воспроизведение видео может не начаться, когда Watch3Gether находится на вкладке браузера, которая в данный момент находится в фоновом режиме и не активна.

По сути, такое поведение вызвано ограничением браузера, ограничивающим автовоспроизведение на фоновых вкладках. При определенных обстоятельствах автовоспроизведение может работать, но трудно обеспечить единообразие на всех платформах, интегрированных в Watch3Gether.

При определенных обстоятельствах автовоспроизведение может работать, но трудно обеспечить единообразие на всех платформах, интегрированных в Watch3Gether.

В настоящее время мы оцениваем различные варианты улучшения этого. В качестве обходного пути вы можете запустить Watch3Gether в отдельном окне. Это окно может быть размещено в фоновом режиме или перекрываться другими окнами, и автозапуск должен работать.

Чтобы запустить Watch3Gether в отдельном окне, вы можете либо перетащить вкладку из меню вкладок браузера, либо выбрать «Новое окно» в главном меню браузера.

Для пользователей Firefox есть другой обходной путь (только для опытных пользователей). Введите about:config

2 лайка

user_95f53b7185f71fb (Флориан) Закреплено глобально

2

пользователь_103adff5414c299 (Натти)

3

Привет, просто хочу отметить, что я использую Opera, и проблема не возникала до обновления. Обходной путь тоже не работает. видео воспроизводится автоматически, но я не слышу звук, пока не нажму на вкладку или окно.

2 лайка

user_95f53b7185f71fb (Флориан)

Спасибо за отзыв. Возможно, он работает только тогда, когда нет другого развернутого окна. Раздражает — согласен. Буду искать другие варианты.

Раздражает — согласен. Буду искать другие варианты.

user_e006510f808baff (мпедалкин)

5

я использую самый популярный в России чем ФРГ или Америка «Яндекс.Браузер», до этого обновленного плеера такой проблемы не было.

мои товарищи используют такие же браузеры и у них такая же проблема. Может откатимся на предыдущую версию или шм?

пользователь_b79600b166c3810 (Ринсевент)

6

Обходной путь работает в Firefox, спасибо!

пользователь_b1ffa286ff6c069 (ЦЕБРА)

7

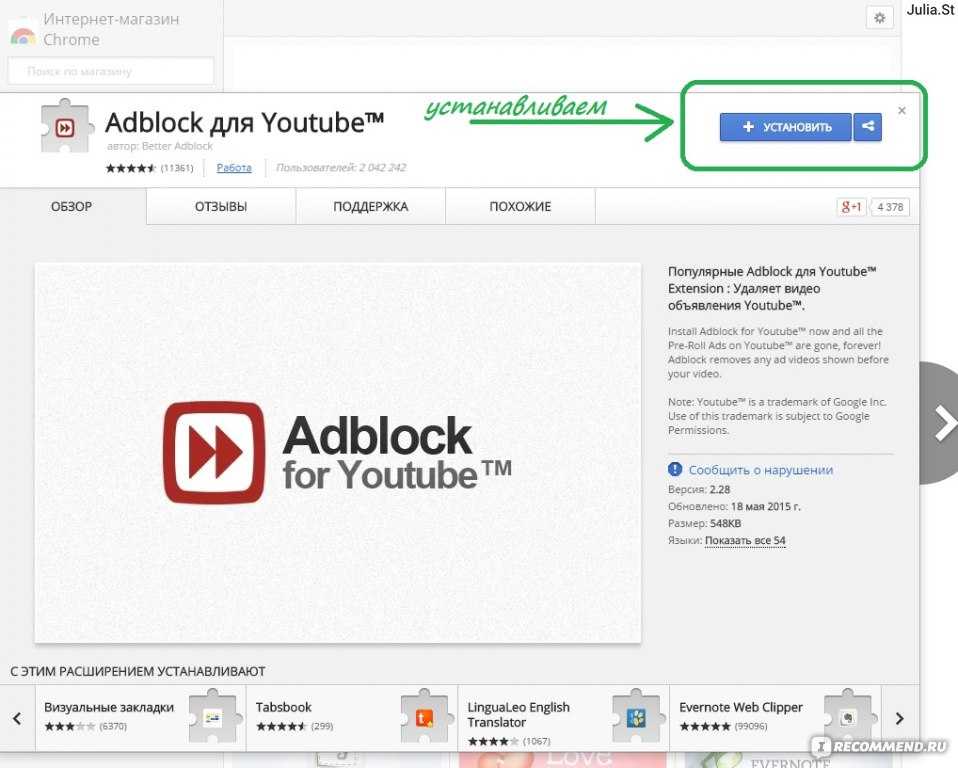

Я знаю что для ютуба есть расширение под названием «YouTube NonStop» может этот код можно интегрировать? В любом случае спасибо за отличный сервис, отличный сайт

пользователь_e268692aab5bf93 (Канеру)

Пробовал это без других развернутых окон. У меня не работает в Chrome…

user_63c4466b6ad33ae (Вдова)

9

Обходной путь не работает в Firefox 93. 0

0

user_ff664a7e7a2e6b5 (Разойтись)

10

Сообщаю, что у нас та же проблема, кажется, обходной путь работает.

Мы в браузере Vivaldi.

Однако я обнаружил, что новое воспроизведение также закрывает режим «Картинка в картинке» Вивальди, когда начинается новое видео.

пользователь_95f53b7185f71fb (Флориан)

11

Эта проблема должна быть решена. Пожалуйста, проверьте это и дайте мне знать, если это работает для вас!

пользователь_6d239606d56c9c3 (Хищники)

12

Кажется, теперь у меня работает.

пользователь_6d239606d56c9c3 (Хищники)

13

Неважно, это кажется довольно предварительным. Иногда песни продолжаются, а иногда застревают.

пользователь_21c5dac94ee7797 (Пульсирующая звезда)

14

Проигрыватель не инициализируется должным образом и не воспроизводит звук, пока он находится вне фокуса/вне табуляции, кажется исправленным, по крайней мере, в хроме. Firefox проверю позже, но молодец!

Firefox проверю позже, но молодец!

пользователь_21c5dac94ee7797 (Пульсирующая звезда)

15

Похоже, что это другая, старая проблема, из-за которой сложно проверить достоверность — иногда комната зависает на видео , заканчивающемся на , а проигрыватель останавливается в конце видео. Вот как это выглядит для вас?

Я предполагаю, что это проблема с системой комнаты/плейлиста, которая иногда возникает там, где проигрыватель заканчивается, и из-за ошибки соединения с одним из пользователей следующее видео не будет последовательно отправляться на проигрыватель. Обновление всех пользователей в комнате, кажется, исправляет это, а иногда кажется, что это исправляется само собой.

Редактировать: Неважно, другое поведение непоследовательно.