Как узнать частотность поисковых запросов в Яндекс и Гугл

Зная частотность ключевых слов, что это такое и как ее правильно применять, можно продвигать определенные страницы в выдаче поисковых систем. Такой навык полезен SEO-специалистам, интернет-маркетологам, SMM-специалистам и даже копирайтерам. О методах сбора запросов и классификации их по частотности расскажем далее.

Содержание

- Что такое частотность поискового запроса и зачем ее нужно знать

- Классификация запросов по частотности

- Определение частотностей с помощью сервисов

- Определение частотности по Яндекс.Вордстат

- Определение частотности по Google Ads

- Сбор частотностей программой Key Collector

- Заключение

Что такое частотность поискового запроса и зачем ее нужно знать

Частотностью запроса называют количество ввода конкретной фразы в поиск за определенный временной интервал (чаще всего за месяц). Эти данные фиксируют поисковые системы для оценки трафика и популярности фраз пользователей. Специалисты могут узнать сведения с помощью сервисов Google и Яндекс, а также сторонних программ.

Специалисты могут узнать сведения с помощью сервисов Google и Яндекс, а также сторонних программ.

Для SEO-специалиста знание частотности слов позволяет:

- спрогнозировать потенциальный трафик на сайт;

- составлять качественное семантическое ядро для сайта;

- подобрать фразы для быстрого продвижения конкретной страницы.

Имея данные по популярности фразы, можно с легкостью отфильтровать запросы-пустышки (имеющие нулевую или близкую к ней частотность). Это помогает сконцентрировать бюджет и ресурсы на наиболее важных фразах, заняться вплотную их продвижением.

Простой пример: вряд ли здравомыслящий сеошник будет продвигать страницу по запросу «купить круиз по Ангаре», да еще и зимой. Частотность этой фразы равна нулю.

Фраза «купить круиз по Волге» в этом плане для продвижения более привлекательна: общая частотность равна 301.

Классификация запросов по частотности

Чтобы сконцентрироваться на наиболее важных запросах, их группируют по частотности. Каждая группа называется по-своему:

Каждая группа называется по-своему:

- Низкочастотные фразы (НЧ) — запрашиваемые пользователями менее 150 раз в месяц. Чаще всего НЧ используется для продвижения конкретного товара, услуги, а также в блогах.

- Среднечастотные фразы (СЧ) — запрашиваются в поисковых системах до 1500 раз. Используются на разных страницах сайта, в том числе для продвижения рубрик (категорий).

- Высокочастотные фразы (ВЧ) — запрашиваются более 1500 раз за месяц. Эти фразы используют для продвижения главной страницы сайта.

Лучший результат достигается при комбинировании на одной странице фраз из разных групп. Например, низкочастотные слова помогут более полно раскрыть тему или рассказать о сайте, а потому могут быть и на главной странице.

Классификация условна и меняется в зависимости от ниши или региональности. Например, запрос «торт на заказ», используемый для сайта кондитера из Владимира, будет относиться к числу высокочастотных, хоть и имеет частоту 855 в месяц. Более популярного запроса в этом регионе и в этой нише нет.

В нишах с высокой конкуренцией даже фразы с частотностью 2000 могут считаться низкочастотными. Точно определить принадлежность к определенной категории можно с помощью сервиса, позволяющего оценить частотность поисковых запросов.

Определение частотностей с помощью сервисов

Популярность фраз анализируют поисковики, логичнее обратиться к ним для получения нужной информации. В России для этой цели используют сервисы Яндекс.Вордстат и Google Ads. Можно воспользоваться сторонними сервисами — Serpstat, Букварикс и другими, но они также будут обращаться к базам поисковых систем, а потому результат будет схожим.

Определение частотности по Яндекс.Вордстат

Сервис Яндекс.Вордстат служит для составления прогнозов количества показа рекламных объявлений по определенным запросам. Его же используют и для сбора поисковых фраз, определения их частотности, сезонности, региональности. Дополнительно тут используются специальные символы.

Перед тем, как узнавать частотность запросов в Яндексе, нужно авторизоваться в системе. После этого можно перейти на страницу Яндекс.Вордстат и начать работу.

После этого можно перейти на страницу Яндекс.Вордстат и начать работу.

Функционал сервиса простой, для описываемых задач понадобятся следующие функции:

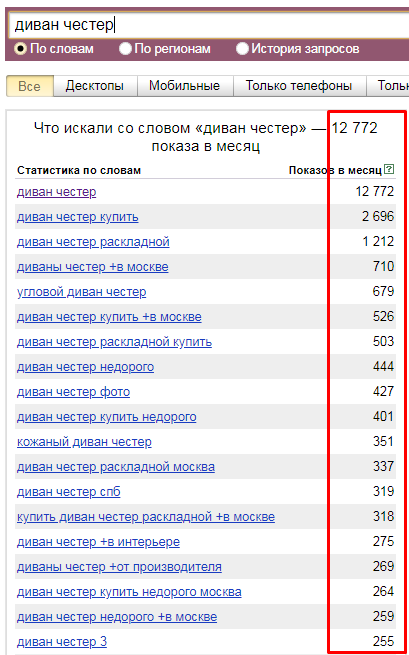

- «По словам» — включена по умолчанию, позволяет узнать популярность в Яндекс конкретного слова или фразы.

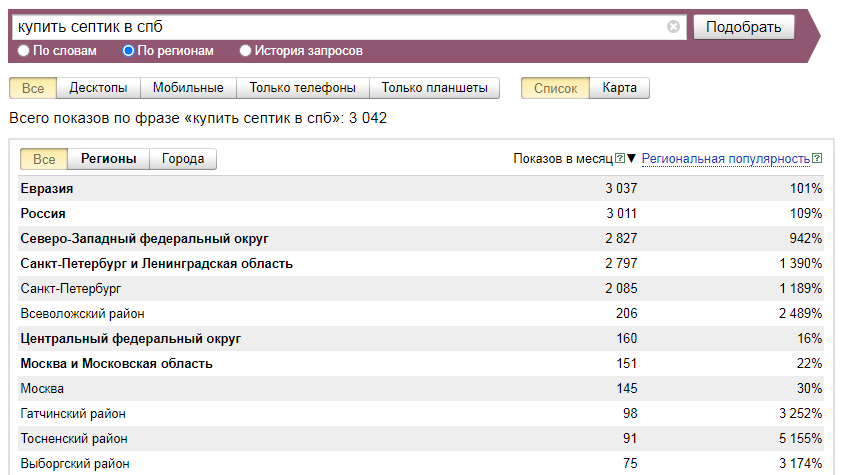

- «По регионам» — поможет узнать распределение популярности по заданным регионам.

- «Регион» — по умолчанию включены все регионы. Позволяет узнать частоту запросов в Яндексе для конкретного региона или населенного пункта.

Исследуемый запрос вводится в специальное поле, если нужно — сопровождается спецсимволами. Затем нужно нажать на кнопку «Подобрать» (4). Сервис генерирует результаты автоматически. Пример для запроса «купить экскаватор» на скриншоте.

В результатах в левой колонке можно увидеть общую частоту запроса (127 348). Тут учитываются все варианты фраз, которые вводили пользователи, желающие купить экскаватор. Эта частотность называется базовой, является неточной. На нашем примере она отражает запросы «купить б/у экскаватор», «купить новый экскаватор» и даже «купить игрушечный экскаватор на пульте управления». Использовать базовую частотность для составления стратегии продвижения веб-ресурса нельзя.

Использовать базовую частотность для составления стратегии продвижения веб-ресурса нельзя.

Для уточнения запроса в Яндекс.Вордстат используют специальные операторы. Например, с помощью оператора «»«» (кавычки) можно узнать фразовую частотность. Для этого фразу «купить экскаватор» нужно заключить в кавычки.

Фразовая частотность показывает, сколько раз вводили именно эту фразу, без других слов. На нашем примере базовая (1) и фразовая (2) частотности имеют существенную разницу. Тут уже не учитываются вариации покупки новой, подержанной техники, игрушечных экскаваторов и прочего.

Иногда нужно дать прогноз по частоте набора слов в точном виде, без учета различных окончаний и числа. На нашем примере нужно узнать, сколько раз пользователи вводили запрос «купить экскаватор», без учета «купить экскаваторы» и прочих вариантов. Для этого фразу заключить в кавычки, а перед каждым словом ставим оператор «!».

Мы видим точную частоту для запроса 2070. Она существенно отличается от базового значения и немного ниже фразового.![]() Применяя операторы, можно узнать точные значения в зависимости от заданных целей и более качественно составить прогноз по трафику.

Применяя операторы, можно узнать точные значения в зависимости от заданных целей и более качественно составить прогноз по трафику.

Определение частотности по Google Ads

Сервис Google Ads используется для составления рекламных объявлений в поисковой системе Google и расчета рекламного бюджета, но можно его использовать и для проверки частотности фраз. Для этого нужно войти в систему (необходим аккаунт в Google).

Перейдите в кабинет Google Ads, нажмите на «Инструменты».

В выпадающем списке найдите раздел «Планировщик ключевых слов».

Выберите блок «новые ключевые слова».

Введите исследуемые фразы. В нашем примере используем ту же фразу «купить экскаватор».

Сервис обработает ваши данные, после чего появится результат.

Тут можно узнать примерную частотность фразы «купить экскаватор» (от 100 до 1 тыс.), узнать уровень конкуренции, просмотреть варианты дополнительных ключевых слов (указаны в таблице в соответствующем разделе). В сравнении с Яндекс.Вордстат сервис имеет скудные возможности по изучению частоты запросов. Просматривать базовую, фразовую и точную частотности тут нельзя. В планировщике Google Ads можно получить лишь приблизительное представление о популярности слова или словосочетания.

В сравнении с Яндекс.Вордстат сервис имеет скудные возможности по изучению частоты запросов. Просматривать базовую, фразовую и точную частотности тут нельзя. В планировщике Google Ads можно получить лишь приблизительное представление о популярности слова или словосочетания.

Сбор частотностей программой Key Collector

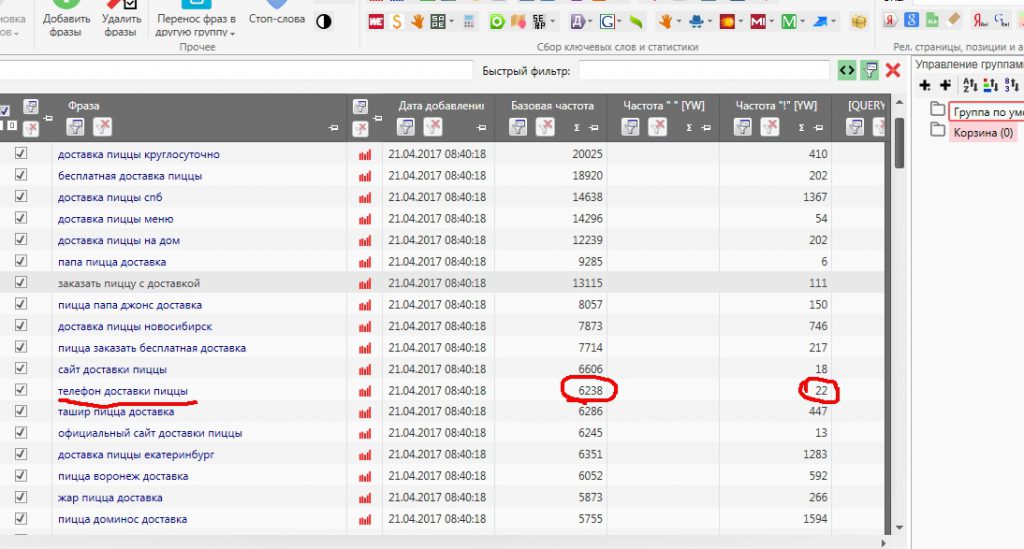

Сервисы изучения поисковых фраз Google и Яндекс хороши для проверки небольших семантических ядер и отдельных поисковых запросов. Если же нужно собирать частотности к большому семантическому ядру, лучше воспользоваться специальными программами, например, Key Collector.

Кей коллектор — это софт для автоматизированного парсинга ключевых фраз с учетом их частотностей, включая точную. Процесс сбора тут максимально упрощен. Для выяснения фразовой и точной частотностей не нужно использовать специальные символы, из заменяют функции программы. После настройки нужных параметров можно заняться другими делами — программа проанализирует все данные и выдаст результат самостоятельно.

Порядок работы по проверке частотности ключевых слов:

- Укажите исследуемые фразы. Для этого нажмите на иконку «сбор запросов из левой колонки Вордстат» или вызовете контекстное меню правой кнопкой мыши, затем выберете пункт «добавить фразы».

- Нажмите на кнопку «Директ» и задайте нужные параметры — сбор базовой, фразовой или точной частотности.

- Нажмите «Получить результаты».

Кей Коллектор обращается напрямую к Яндекс.Директ, потому результаты по частотностям будут получены быстро. Программа позволяет проверить частоту поисковых запросов в Яндексе, собрать фразы из Google, добавить поисковые подсказки. Результаты будут собраны в удобную таблицу, в дальнейшем можно удалить фразы-пустышки и сгруппировать оставшиеся словосочетания.

Key Collector — это платная программа с мощным функционалом. Для ограниченного числа задач можно установить ее бесплатный аналог «Словоёб» С его помощью также можно парсить ключевые слова и собирать к ним частотность. Процесс более медленный, потому для больших семантических ядер программа не подходит.

Процесс более медленный, потому для больших семантических ядер программа не подходит.

Заключение

Знание частотности ключевых слов поможет точнее прогнозировать трафик на сайт из поисковых систем, поможет в составлении семантического ядра и в продвижении определенных страниц. Чтобы получить нужные данные, можно воспользоваться сервисами Яндекс.Вордстат или Планировщиком ключевых слов Google Ads. Подойдут и программы для парсинга ключей, например Key Collector или Словоёб.

Подбирайте инструмент, исходя из конкретных целей и возможностей, не пренебрегайте сбором частотностей поисковых фраз. Только в этом случае можно быть уверенным в эффективности мероприятий по продвижению конкретной страницы или сайта в поиске.

Какую частотность Wordstat (Вордстат) использовать для продвижения сайта?

Редакция от 04 апреля 2022 года

Чем собрать частотность запросов всем известно, а вот вопрос какую частотность использовать — остается открытым. На этот счет существует множество мнений: кто то считает, что нужно оставлять запросы с частотностью не ниже 50 по «! «, а кто то работает с запросами частотностью от 1 по «! «. В данном руководстве мы подробно ответим на все вопросы, касающиеся данной темы.

На этот счет существует множество мнений: кто то считает, что нужно оставлять запросы с частотностью не ниже 50 по «! «, а кто то работает с запросами частотностью от 1 по «! «. В данном руководстве мы подробно ответим на все вопросы, касающиеся данной темы.

Пожалуй стоит начать с того, частотность каких запросов мы оцениваем. Прежде всего, это подсказки и запросы, полученные из «левой колонки» Wordstat. Разница в том, что в подсказках гораздо более «свежие» и «живые» запросы пользователей, в то время как в «левой колонке» Wordstat гораздо большее количество «накрученных» оптимизаторами и различным сервисами (например сервисами сбора позиций) запросов. Плюс Wordstat отдает данные на месяц назад от даты съема частотности. Подробнее о нашем парсере Wordstat>>

При сборе подсказок Яндекса существует проблема так называемых «фантомных» подсказок — подсказки которые Яндекс автоматические генерирует на основе персонализации или других данных. Наши алгоритмы эффективно находят такие подсказки и вырезают их, позволяя вам экономить множество времени и денег.

Что мы имеем в итоге:

- более частотные, но, часто накрученные, запросы из «левой колонки» Wordstat

- нетипичные для русского языка, накрученные запросы вроде «коляска детская москва купить»

- менее частотные, но реальные, живые запросы пользователей из поисковых подсказок

- *поисковые запросы из Яндекс Метрики и Google Analytics

* Такие запросы могут быть выгружены за большой период времени и в момент сбора частотности могут иметь нулевую частотность из-за сезонности или неактуальности запроса в момент сбора частотности.

Я собрал подсказки, но многие из них имеют небольшую частотность «!ws», стоит ли их использовать?

Безусловно стоит. Наш сервис призван найти как можно больше целевых ключевых слов, которые можно использовать и о которых не знают конкуренты. Большинство таких ключевых слов — низкочастотные и они приносят до 70% поискового трафика на веб-сайты в любой стране мира. Плюс, как уже было сказано выше, это живые запросы пользователей, которые актуальны в данный момент времени и могут (часто так и происходит) достаточно быстро набирать популярность, создавая новые семантические тренды и срезы.

Ключевые слова ниже какой частотности отбрасывать?

Здесь все зависит от тематики вашего сайта:

В тематиках, где поисковый спрос узкий (как пример — ремонт телефонов Vertu) — целесообразно использовать даже ключевые слова с частотностью «!» = 1 т.к. здесь важен каждый пользователь из поисковых систем — их в принципе немного.

Для электронной коммерции, например магазинов электроники/подарков/одежды, где очень большой поисковый спрос — можно отбрасывать все ключевые слова с частотностью менее «!» = 5, сконцентрировав усилия на более частотных запросах, а к совсем непопулярным НЧ вернуться позже, при второй итерации.

Для информационных сайтов, таких, как сайты рецептов, сайты кино-тематики, сайты рефератов, автомобильные порталы и для других аналогичных сайтов — можно отбрасывать все ключевые слова с частотностью менее «!» = 50 т.к. спрос в этих нишах просто огромный и физически нереально работать над всем семантическим ядром. Идите от самых популярных потребностей пользователей, к менее популярным. Работайте итерациями.

Работайте итерациями.

Как не потерять нужные запросы и не выкинуть лишнее?

Бывают такие ситуации и тематики, в которых:

- поискового спроса очень мало в принципе

- преобладают многословные запросы в различных словоформах и переформулировках

а) Первый вариант — оставлять запросы с частотностью от «!» = 1, как было сказано выше. Но не везде это возможно, в некоторых тематиках такие запросы или слишком конкретные (не имеют общих URL в SERP с другими запросами и не кластеризуются) и продвигать их нецелесообразно (нет смысла создавать отдельную страницу под такой низкий спрос) или не совсем целевые.

б) Второй вариант — использовать » «, вместо «!». Этот способ работает, когда в вашей семантике преобладают многословные запросы в различных словоформах и переформулировках. Дело в том, что «!» закрепляет конкретную словоформу, а так как многословный запрос может иметь огромное множество переформулировок, а «!» учитывает только одну конкретную, все остальные вы потеряете.

Не забываем про сезонность

Так же необходимо учитывать сезонность для некоторых запросов. Ее можно просмотреть в Яндекс Wordstat, если выбрать «История запросов» после ввода ключевого слова.

Так, например запросы связанные с Новогодними праздниками начинают увеличиваться в частотности с сентября, а с середины декабря уже падают.

Так же очень важно учитывать то, что Яндекс показывает данные за прошлый месяц. И если у вас новый запрос, такой, что только что появился, данных о нем может и не быть, либо будет низкая частотность. Или, возможен вариант, что вы снимаете частотность в «низкий сезон». Если вы имеете примерное представление о популярности запросов, но частотности по ним получились сильно меньше, чем вы ожидали, проверьте сезонность и не спешите отказываться от этих запросов! Начиная продвигать запросы в «низкий сезон», вы получите преимущество перед конкурентами, которые начнут продвигать те же запросы в «высокий сезон».

Была ли статья полезной?

5

0

Навигация по статье

- Я собрал подсказки, но многие из них имеют небольшую частотность «!ws», стоит ли их использовать?

- Ключевые слова ниже какой частотности отбрасывать?

- Как не потерять нужные запросы и не выкинуть лишнее?

- Не забываем про сезонность

Как составить семантическое ядро (СЯ) для сайта — программы и сервисы для сбора ядра

6 Января 2022

Наиболее эффективным источником привлечения трафика на сайт является органический поиск. Для обеспечения использования данного способа привлечения трафика необходимо определить в чем заключается интерес вашей аудитории и на основе этого составить семантическое ядро.

Для обеспечения использования данного способа привлечения трафика необходимо определить в чем заключается интерес вашей аудитории и на основе этого составить семантическое ядро.

Содержание

- Что такое семантическое ядро сайта?

- Задачи семантического ядра

- Что такое ключевые слова?

- Что такое частотность ключевого слова?

- Классификация ключевых слов

- По частотности

- По коммерческости

- По геозависимости

- По типу

- Как составить семантическое ядро?

- Шаг 1. Поиск (подбор) ключевых фраз

- Шаг 2. Поиск синонимов

- Шаг 3. Расширение ядра

- Шаг 4. Удаление лишних фраз

- Шаг 5. Определение точной частотности для фраз

- Шаг 6. Проверка конкурентности

- Итоговый чек-лист

- Пример семантического ядра интернет-магазина

- Что делать с семантическим ядром после составления?

- Кластеризация семантического ядра

- Сервисы для составления семантического ядра

- Key Collector

- SlovoEB

- Wordstat Яндекса

- Системы аналитики

- Анализ семантического ядра конкурентов

- Принцип работы сервисов

- Megaindex Premium Analytics

- Keys.

- Spywords.ru

- Бесплатные сервисы

- Заключение

Наиболее эффективным источником привлечения трафика на сайт является органический поиск. Для обеспечения использования данного способа привлечения трафика необходимо определить в чем заключается интерес вашей аудитории и на основе этого составить семантическое ядро.

Что такое семантическое ядро сайта

Семантическое ядро — это структурированное описание сайта, которое имеет вид списка слов и словосочетаний.

- Ядро отражает всю тематику сайта, учитывая пользовательский спрос и интересы.

- Ядро характеризуют услуги, товары или вид деятельности, предлагаемые сайтом.

Причины составления семантического ядра:

- лучшение видимости сайта роботами Google и Яндекса;

- правильность выдачи пользователям релевантных результатов в поисковиках;

- удобство поиска необходимой информации на странице сайта.

В выдачу поисковиков на первые местапопадают те сайты, которые поисковые системы считают наиболее подходящий сайт под конкретный запрос.

До составления семантического ядра нужно ответить на главный вопрос: какую именно информацию можно найти на сайте. Поэтому поисковые запросы из смыслового ядра важно распределять по конкретным страницам сайта. Работа с ядром позволяет определить какая именно страница подходит под конкретные фразы или группы поисковых запросов.

Задачи семантического ядра

- Определение структуры вашего ресурса. Поисковое ядро позволяет проработать и составить полную архитектуру разделов и страниц сайта, а также навигацию по ним. Наиболее упрощенная иерархия ресурса позволит пользователям и поисковым роботам ориентироваться по структуре сайта.

- Оптимизация страниц. Поисковые фразы позволяют на их основе правильно составить или скорректировать заголовки и метатеги страницы. Ключевые слова позволяют значительно повысить эффективность создания контента и наполнения страниц сайта.

- Контент-план. Поисковые запросы делают возможным составлять ассортимент ресурса или интернет-магазина, а также отталкиваться от них для создания необходимых сайту статей, видео, либо дать ответы на вопросы пользователей.

- Расширение ассортимента компании. Актуализация семантического поискового ядра позволяет изучить пользовательский спрос и их новые интересы, поэтому на основе этого стоит задуматься над расширением ассортимента ресурса, например, новыми услугами или товарами.

- Перелинковка разделов и страниц. Страницы ресурса должны иметь корректную перелинковку и тематически связываться ссылками с другими разделами для наиболее простой навигации по сайту и правильного распределения ссылочного веса между страницами.

- Запуск поисковой контекстной рекламы. Семантическое ядро позволяет корректно отразить потребности пользователей и точно настроить контекстную рекламу.

Что такое ключевые слова

Ключевые слова (фразы) — это поисковые запросы, которые используют пользователи поисковых систем для нахождения необходимой им информации. Пользователи, использующие ключевую фразу “купить носки”, непосредственно ищут интернет-магазины для покупки носков. А пользователи, которые вводят в поисковой строке ключевое слово “фотограф”, ищут сайты с услугами фотографов.

Пользователи, использующие ключевую фразу “купить носки”, непосредственно ищут интернет-магазины для покупки носков. А пользователи, которые вводят в поисковой строке ключевое слово “фотограф”, ищут сайты с услугами фотографов.

Что такое частотность ключевого слова

Частотность поискового запроса — это количественная величина числа обращений пользователей по конкретным ключевым фразам за определенный расчетный период времени. Другими словами — частотность ввода ключевых слов в поисковой строке.

Частота запроса выражает общую степень спроса или популярности той или иной фразы в течение месяца. Частотность, во-первых, зависит от тематики или направления бизнеса, а также от сезонности поискового спроса, конкретного региона поиска и алгоритмов расчета поисковых систем.

Определение частотности ключевых слов возможно при помощи полностью бесплатных сервисов Яндекс.Wordstat и Google AdWords. При этом есть и платные сервисы и программы, которые непосредственно используют поисковую выдачу Яндекса и Google: Key Collector, Serpstat, Букварикс и другие.

Классификация ключевых слов

Все ключевые слова можно условно классифицировать на несколько видов, работа с каждым из которых имеет свои особенности. Мы рассмотрим 4 основных типа параметров, по которым разделяются поисковые фразы.

По частотности

Все ключевые слова можно условно классифицировать на несколько видов, работа с каждым из которых имеет свои особенности. Мы рассмотрим 4 основных типа параметров, по которым разделяются поисковые фразы.

- Высокочастотные (ВЧ) – фразы, описывающие общую тему. Чаще всего посадочной для них является главная страница. ВЧ запросы стоит включать в семантическое ядро в том случае, если ваш сайт уже уверенно стоит в ТОПе по низкочастотным и среднечастотным запросам.

- Среднечастотные (СЧ) – отдельные направления в теме. Подходят для продвижения разделов, подразделов и каталожных страниц коммерческого сайта, а также для крупных информационных статей.

- Низкочастотные (НЧ) – запросы нацеленные на поиск конкретного ответа на вопрос.

Под такие фразы чаще всего оптимизируются карточки товаров или определенные статьи. С них часто начинается продвижение молодого сайта, у которого пока нет позиций и трафика.

Под такие фразы чаще всего оптимизируются карточки товаров или определенные статьи. С них часто начинается продвижение молодого сайта, у которого пока нет позиций и трафика. - Микронизкочастотные (МНЧ) – это фразы, которые спрашивают один раз в месяц (по данным Яндекс.Вордстат). Нет смысла включать такие запросы в семантическое ядро. По ним легко выйти в ТОП, но будучи на первых позициях вы не получите трафика.

Определить к какой группе по частотности относится та или иная ключевая фраза можно только после определения популярности тематики. Разница в частотности для разных тематик может значительно отличаться. Например, фраза “ключевые слова” будет иметь более частотные запросы, чем фраза “детский спортивный клуб”, поэтому будут и разными группы по частотности.

По коммерческости

Коммерческий запрос — фраза, которую пользователь вводит в поисковую строку с целью совершить покупку (купить самокат, велопрокат прайс).

Некоммерческий запрос — фраза, с помощью которой пользователь ищет информацию без осуществления покупки (станок характеристики, микроволновка отзывы).

Семантическое ядро интернет-магазинов и прочих продающих сайтов обязательно должно включать в себя коммерческие запросы и составлять его основу. Это не значит, что нельзя включать в СЯ некоммерческие запросы: они могут вести на страницы со статьями, советами, обзорами. Однако вы должны понимать, что такие запросы не принесут продаж.

По геозависимости

Геозависимые запросы — ключевые фразы, по которым результаты выдачи в поиске отличаются при смене региона. Например:

- мультфильм шрек в кино

- заказать пиццу

- ресторан морепродуктов

Если пользователь ищет «кинотеатры», находясь в Новосибирске, то ему не интересны кинотеатры в Москве, Санкт-Петербурге и других городах.

Геонезависимые — ключевые фразы, по которым результаты выдачи в поиске НЕ отличаются при смене региона. Например:

- мультфильм шрек оценки

- купить кровать в омске

- как приготовить кулич

Если в том же Новосибирске вводится запрос «кинотеатры в москве», то становится понятно, что нужны результаты по Москве, независимо от того, в каком городе пользователь находится.

По геонезависимым запросам намного тяжелее выйти в ТОП из-за большой конкуренции. Но коммерческие запросы редко бывают геонезависимыми — ведь чем ближе географически к пользователю расположена компания предлагающая услуги или товары, тем ему удобнее. Поэтому основная часть семантического ядра коммерческого сайта будет состоять из геозависимых запросов. Однако существуют исключения, все зависит от тематики сайта. Поэтому всегда проверяйте продвигаемые фразы на геозависимость.

По типу

- Информационные — запросы, с помощью которых осуществляется поиск полезной информации (как связать носки).

- Брендовые — запросы включающие в себя название определенной компании. Брендовыми также являются запросы с различными вариантами написания домена, в том числе на русском и с ошибками (алиэкспересс, али экспрес, ali express). Такие запросы можно брать в семантическое ядро, если только ваш бренд, марка или компания достаточно известны и пользователи ищут вас в сети.

- Транзакционные — фразы, которые используют для поиска товаров и услуг с дальнейшим желанием покупки или заказа. Транзакционные аналогичны коммерческим. По некоторым транзакционным запросам в ТОПе выдачи находится большое количество сайтов-агрегаторов. И для обычных интернет-магазинов остается 1-2 места, либо его вообще нет. Поэтому лучше подобрать более реальный запрос для продвижения.

- Навигационные — ключевые слова, по которым ищут какое-то место или событие (конференция сбербанк 2021).

Как составить семантическое ядро

Представление структуры сайта имеет схему в виде иерархии страниц. Структура решает следующие задачи: логическое расположение информации, соответствие требованиям поисковых систем и обеспечение юзабилити. Разберем основные этапы через которые нужно пройти для составления будущего семантического ядра.

Шаг 1. Поиск (подбор) ключевых фраз

Если у вас уже есть сайт, то нужно начать со сбора таких ключевых фраз, по которым на данный момент посетители уже приходят на сайт. Для этого можно использовать бесплатные инструменты аналитики, например, Яндекс.Метрика.

Для этого можно использовать бесплатные инструменты аналитики, например, Яндекс.Метрика.

Для нового ресурса определитесь что именно будет продавать ваш сайт, наметьте основные разделы товаров. Собирать семантическое ядро необходимо с учетом интересов аудитории сайта и собственных целей.

Для начала нужно собрать первичный список общих основных слов и словосочетаний, охватывающих тематику (ВЧ). Также такие запросы называются маркерами. Это могут быть названия направлений сайта (можно использовать названия разделов и подразделов).

При подборе маркерных фраз удобнее всего использовать Яндекс.Вордстат. Вбивая в него ключевую фразу, слева вы можете увидеть вариации этого словосочетания с использованием различных слов, а справа — похожие запросы, которые можно взять для дальнейшего расширения темы.

Также показывается базовая частотность фразы за месяц во всех словоформах и с добавлением любых слов. Но нам такая частотность в данный момент не нужна, ведь нас будет интересовать частота всех итоговых фраз ядра “в кавычках”, т. е. учитывается частота во всех словоформах, но без добавления дополнительных слов.

е. учитывается частота во всех словоформах, но без добавления дополнительных слов.

Представьте, что вы решили продвигать свой блог для сео, значит часть основных запросов будет примерно такая:

Для наглядности разберем как на каждом шагу происходит подбор фраз на основе маркерной фразы “семантическое ядро”, а для остальных тем всё можно сделать аналогично примеру.

Шаг 2. Поиск синонимов

Дополнять смысловое ядро нужно учитывая потребности посетителей, которые приходят на ваш сайт. Это могут быть такие слова, которые используют некоторую профессиональную терминологию, сокращения, жаргонные слова и слова на английском. Необходимо учитывать ваши преимущества для покупателя при заказе или покупке, а также качества непосредственно самого товара.

Пользователи при написании запроса в поисковой строке могут использовать слова близкие по смыслу. Чтобы максимально охватить ядро тематики нам нужно найти все возможные синонимы и словоформы к основным словам. Для этого можно воспользоваться следующим:

Для этого можно воспользоваться следующим:

- Мозговой штурм. Поставьте себя на место пользователя и подумайте какими другими словами вы могли бы сформулировать вопрос.

- Правый столбец в Яндекс.Вордстат.

- Запросы, сформулированные на кириллице (seo/сео, polaris/поларис).

- Аббревиатуры, сленговые фразы и различные термины, относящиеся к тематике.

- Подсказки в поисковой строке Яндекс и Google, а также фразы в блоке “Вместе с … ищут”.

После всех действий по выбранной теме получится подобный список фраз:

Шаг 3. Расширение ядра

Этот шаг удобно выполнять с помощью уже знакомого инструмента Wordstat. С помощью этого сервиса нужно провести анализ по всем фразам, которые были получены на прошлом этапе, и скопировать всё, что будет находиться в левой колонке в отдельный файл. Также иногда нужно поглядывать и на правую колонку, потому что иногда Яндекс будет предлагать вам и другие слова, которые вы могли пропустить ранее.

В результате выполнения этого шага у вас должен получиться список фраз из Yandex.Wordstat для каждого ключа, полученного на втором этапе.

Шаг 4. Удаление лишних фраз

Этот этап для вас будет самым долгим и трудозатратным, т. к. выполняется он вручную. Нужно внимательно просмотреть каждую поисковую фразу и удалить неподходящие по смыслу.

Рассмотрим примеры запросов, которые нужно сразу убирать из будущего ядра:

- ключи с названиями брендов конкурентов;

- ключи с названиями товаров или услуг, которые вы не предоставляете и не собираетесь с ними работать в дальнейшем;

- ключи с использованием неподходящих регионов и адресов;

- фразы написанные с ошибками и опечатками.

После удаления лишних фраз получится перечень запросов для маркерного ключа “семантическое ядро”. Далее рассмотрим ещё несколько шагов, в процессе которых будут вноситься корректировки в полученный список.

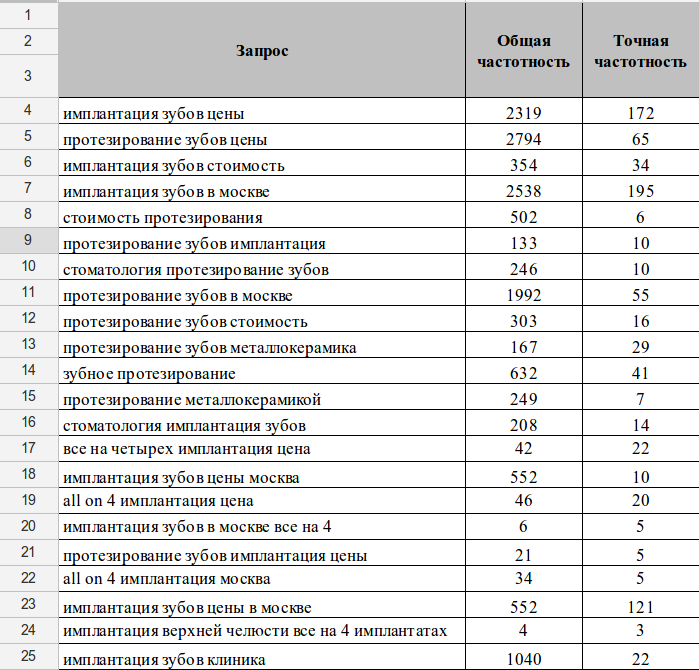

Шаг 5. Определение точной частотности для фраз

Для массового определения точной частотности “в кавычках” нужно воспользоваться сервисами, например, Key Collector или SlovoEB. Подробнее о них мы разберем в этой статье позже.

После определения точной частотности всех фраз, нужно удалить все нулевики, т. к. такие запросы в точности никто не вводит, а значит трафик они вам не принесут.

Шаг 6. Проверка конкурентности

Здесь нужно анализировать выдачу в ТОП-10 по запросам. Обратите внимание на количество главных страниц (морд сайтов), тип контента конкурентов (статья, товар или каталожная страница), вложенность адресов страниц и их формат, а также тип сайтов конкурентов (информационные, коммерческие, агрегаторы). После анализа выдачи вы сможете понять, насколько жесткая борьба за позиции по определенному запросу и на сколько велика вероятность попадания в ТОП вашего сайта. Если становится понятным, что ваш сайт не сможет составить конкуренцию в выдаче, то такие запросы нужно убирать из ядра.

Также возможно продолжить исследование сайтов компаний конкурентов, которые тесно связаны с тематикой вашего ресурса. Нахождение ключевых фраз на данном этапе заключается в поиске слов в текстах, которые имеют пересечения с вашим сайтом.

После прохождения всех шагов, представленных выше, для каждой базовой поисковой фразы, вы получите готовое ядро для сайта.

Также возможно продолжить исследование сайтов компаний конкурентов, которые тесно связаны с тематикой вашего ресурса. Нахождение ключевых фраз на данном этапе заключается в поиске слов в текстах, которые имеют пересечения с вашим сайтом.

Итоговый чек-лист

- Подбираем базовые запросы, которые описывают тематику. Берез за основу структуру сайта и типы предоставляемых товаров или услуг.

- Ищем синонимы ключевых слов с помощью Яндекс.Вордстат и парсинга подсказок поисковых систем.

- Расширяем ядро с помощью левой части в Wordstat.

- Очищаем список от лишних фраз.

- Определяем точную частотность для всех запросов и удаляем нулевики.

- Проверяем конкурентность запросов и проводим окончательную чистку семантического ядра.

Пример семантического ядра интернет-магазина

Здесь вы можете увидеть пример части семантического ядра интернет-магазина.

Такое представление помогает оценить всю ситуации продвижения, а также увидеть подобные проблемы:

- нет страницы, которая подходит для продвижения по данному запросу, нужно создать новую

- эффективность продвижения страниц сайта

- соответствуют ли посадочные и ранжируемые страницы

Что делать с семантическим ядром после составления?

Вы составили семантическое ядро для своего сайта, но затем возникают вопросы: “Что делать после сбора ядра?”, “Как размещать семантическое ядро на сайте?”. Давайте рассмотрим следующие шаги продвижения сайта:

- Кластеризация запросов и распределение их по посадочным страницам.

На данный момент ваше семантическое ядро является разрозненным списком фраз. Для дальнейшей работы вам необходимо провести их кластеризацию, т. е. объединить в группы по смыслу. А затем уже подобрать для каждой группы страницу продвижения (выбрать из существующих на сайте или создать новую).

На данный момент ваше семантическое ядро является разрозненным списком фраз. Для дальнейшей работы вам необходимо провести их кластеризацию, т. е. объединить в группы по смыслу. А затем уже подобрать для каждой группы страницу продвижения (выбрать из существующих на сайте или создать новую). - Составление оптимизированных заголовков и описаний для посадочных страниц. Используем самый высокочастотный запрос, описывающий содержимое страницы для заголовка h2. Менее частотные фразы добавляем в заголовок title и описание description с разбавлением дополнительными словами, не относящимися к тематике.

- Наполнение страницы контентом. Проанализируйте запросы, подобранные для продвигаемых страниц. Необходимо выявить потребности пользователей, которые вводят эти поисковые фразы. Какую информацию они хотят найти, перейдя на ваш сайт? Далее составляем план текста и пишем его сами, либо отправляем задание копирайтеру. Только после этого вбиваете основную поисковую фразу, продвигаемую на выбранную вами страницу, и смотрите наполняемость страниц конкурентов, чтобы сделать похожее.

Теперь ваши посадочные страницы оптимизированы под фразы из семантического ядра.

Кластеризация семантического ядра

Первым и важным шагом после сбора семантического ядра является разбиение всех запросов на кластеры, то есть — кластеризация.

Кластеризация запросов семантического ядра — это группировка ключевых запросов на основе поисковой выдачи. Запросы объединяются в группы для определения целевых страниц для дальнейшего продвижения. Есть несколько методов кластеризации запросов.

Ручной метод кластеризации запросов удобно использовать для значительно небольшого ядра, визуально осматриваемого, около 500 запросов. Здесь используем непосредственно способ группировки с вычислением определенного интента запросов. Поисковые фразы, для которых определение кластера затруднено, нужно анализировать поисковую выдачу в ТОП-10. Если выдача содержит одинаковую поисковую выдачу под разные запросы, то определяем данные запросы в один кластер.

Автоматический метод кластеризации может быть осуществлен при помощи популярных сервисов по кластеризации запросов. Основа алгоритма распределения по группам — это группировка запросов по ТОПу. Используя данные сервисы появляются неточности в данных кластеризаторов, поэтому всегда необходимо проверять вручную итоговые группы. Среди сервисов можно выделить:

- Coolakov.ru

- Stoolz.ru

- SERanking.ru

- Topvisor.com

- Just-magic.ru

Распределение запросов может быть разных уровней, то есть с большей или меньшей общей проработкой. Это могут быть как наиболее конкретные группы или что-то более обширное. Например, список ключевых фраз можно распределить на группу «Мужские серебрянные браслеты», либо выделить среди запросов отдельно две группы «Мужские серебрянные браслеты с камнями» и «Мужские серебрянные браслеты в Новосибирске».

Сервисы для составления семантического ядра

Есть большое количество онлайн сервисов, которые ускоряют и автоматизируют процесс сбора семантического ядра. Вы можете воспользоваться как платными, так и бесплатными программами. Рассмотрим несколько таких сервисов и их принцип работы.

Вы можете воспользоваться как платными, так и бесплатными программами. Рассмотрим несколько таких сервисов и их принцип работы.

Key Collector

Эта программа окажет вам непосильную помощь, если вы хотите собрать обширное ядро для большого сайта с достаточно разветвленной структурой. Список основных функций этого сервиса:

- Сбор ключевых слов через Яндекс.Вордстат.

- Парсинг подсказок поисковых систем.

- Удаление неподходящих слов с помощью стоп-слов.

- Определение базовой и точной частотности.

- Фильтрация запросов по различным показателям.

- Определение сезонности.

Сервис Key Collector платный. Все эти задачи можно выполнить и в бесплатных аналогах, но придется использовать несколько программ.

SlovoEB

Это бесплатный сервис от разработчиков Key Collector. Его основные функции — это сбор ключевиков через Wordstat, парсинг подсказок и определение частотности фраз.

Интерфейс будет достаточно понятен даже для людей, которые не имеют опыта работы с подобными сервисами. Для начала работы нужно создать новый проект, а затем на вкладке “Данные” перейти на “Добавить фразу”. Отметьте там предполагаемые фразы по которым пользователи могут найти ваш сайт, продукт или услуги на нем.

Сервис сам подберет ключевые фразы, а также поможет автоматизировать задачи для последующего анализа и очистки будущего ядра.

Wordstat Яндекса

Яндекс.Вордстат — сервис с помощью которого вы сможете бесплатно собрать и проанализировать семантическое ядро вашего сайта онлайн. Давайте немного подробнее рассмотрим функционал сервиса:

Предоставляет статистику показов в месяц по ключевому слову, а также поисковым фразам, которые включают указанное вами ключевое слово. Можно проанализировать общие данные или заострить внимание на запросах именно мобильной аудитории.

- Показывает данные по регионам

- Предоставляет историю показов фраз в динамике

- Предоставляет статистику запросов по определенным регионам

Этот сервис очень удобен для подборки ключевых фраз для семантического ядра, но дальше проводить анализ и группировать запросы придется вручную.

Системы аналитики

При сборе семантического ядра для уже существующего сайта можно воспользоваться такими системами аналитики, как Яндекс.Вебмастер, Яндекс.Метрика или Google Analytics. Там вы сможете найти с помощью каких фраз посетители находят ваш сайт и выбрать из них подходящие для продвижения.

Анализ семантического ядра конкурентов

Для сбора семантического ядра есть немного другой подход. Можно провести анализ семантического ядра конкурентов. В итоге вы получите список фраз, который можно использовать при продвижении сайта. В большинстве своем такие сервисы платные.

Принцип работы сервисов

Сервисы для анализа семантики конкурентов не имеют прямого доступа к статистике сайта. Алгоритм их работы основывается на периодическом сборе и анализе информации с поисковых систем. Информация записывается в базу и выдается пользователю инструмента по запросу. Следовательно, если база сервиса обновляется редко — есть шанс получить уже устаревшую, не актуальную и бесполезную информацию.

Megaindex Premium Analytics

Модуль «Видимость сайта» платформы Megaindex дает нам достаточно обширный набор инструментов для получения ключевых фраз конкурентов: можно посмотреть и выгрузить ключевые фразы по которым ранжируется сайт; найти схожие по семантике сайты, которые тоже могут быть использованы в качестве доноров. Сервис платный.

Keys.so

Был создан как инструмент для анализа семантики конкурентов. Необходимо ввести url интересующего нас сайта, отобрать доноров по количеству общих ключей, проанализировать их сайты и выгрузить ключи. Все делается быстро и без лишних телодвижений. Приятный, свежий интерфейс, только нужная информация.

Spywords.ru

Помимо анализа видимости предоставляет статистику по объявлениям в директе. Интерфейс немного перегружен, но если разобраться, то сервис свою задачу в целом решает. Можно проанализировать сайты конкурентов, посмотреть пересечения по семантическому ядру, выгрузить фразы по которым продвигаются конкуренты. К недостаткам можно отнести довольно слабую базу — всего 23 млн ключевых слов.

К недостаткам можно отнести довольно слабую базу — всего 23 млн ключевых слов.

Бесплатные сервисы

XTool – популярный сервис которым пользуется большое количество новичков. Он может показывать видимость сайтов в поисковых системах, их траст, а также некоторые другие данные. Количество проверок лимитировано. Стоимость каждой проверки, которая превышает этот лимит – 1 рубль.

Букварикс – бесплатно позволяет анализировать семантическое ядро чужих ресурсов, что в конечном итоге позволяет пользователям получать доступ к нужной информации, не заплатив ни копейки. Очень распространен среди фрилансеров на всевозможных биржах, т. к. даже бесплатный аккаунт позволяет пользоваться инструментом на достаточно приличном уровне.

Заключение

В этой статье мы рассмотрели все этапы по сбору качественного и полного семантического ядра для сайта, а также некоторые сервисы, которые помогут вам в этом деле. Выполняя каждый шаг в описанной выше инструкции вы сможете собрать ядро, которое будет максимально охватывать тематику вашего сайта, а это значит, что вы сможете составить правильную стратегию продвижения и быстро выбраться в ТОП выдачи поисковых систем.

определение единичной и массовой частотности

Содержание статьи

- Что такое частота ключевого слова

- Как проверить частотность запроса

- Wordstat (Яндекс)

- Mail.ru

- Rambler

- Как проверить массово частотность запросов

- Key Collector

- Rush Analytics

Очень важно убедиться, что запросы, по которым вы собрались продвигаться, вообще кто-то ищет. Если вы наберете «семантическое ядро», где все ключи будут с нулевой частотностью — то ваш сайт и будет нулём. Поэтому давайте не будем вола нагибать, а приступим.

Что такое частота ключевого слова

Очевидно, что различные запросы имеют разную популярность среди пользователей поисковых систем. Число ввода конкретного запроса в поисковик берется за один месяц. Таким образом, частота ключевых слов — это количество вводов запросов за месяц.

Вполне возможно, что даже тут есть запросы-пустышки

Для продвижения вашего сайта необходимо создавать оригинальный контент. Например, если вы пишете статьи, уникальность вашего текста должна быть, как правило, выше 90%. В теории, уникальный контент приносит высокий показатель посещаемости, состоящий в большей мере из переходов с Яндекса и Гугла. Однако в реальных условиях ранжирования написать уникальную статью — только половина успеха.

Например, если вы пишете статьи, уникальность вашего текста должна быть, как правило, выше 90%. В теории, уникальный контент приносит высокий показатель посещаемости, состоящий в большей мере из переходов с Яндекса и Гугла. Однако в реальных условиях ранжирования написать уникальную статью — только половина успеха.

Поисковые системы обращают внимание не только на уникальность текста, но и на содержания в нем ключевых запросов, соответствующих тематике статьи или любого другого текстового контента. Правильное распределение ключевых слов в статье называют текстовой оптимизацией. Уникальная, но не оптимизированная статья, содержащие неопределенные запросы, может и вовсе не привлечь на сайт посетителей. Такая ситуация будет означать зря потраченные время и ресурсы на создание контента.

Для оптимизаторов, частотность это критерий по выбору того или иного запроса для его использования в тексте. В зависимости от частотности, ключи разделяют на высокочастотные (ВЧ), среднечастотные (СЧ) и низкочастотные (НЧ) запросы. При оптимизации статьи, в первую очередь, обращают внимание на ВЧ и СЧ запросы. Однако с каждым годом продвижение новых сайтов становится все затруднительным, а оптимизация все тоньше. Сейчас считается, что использование НЧ ключей также может принести некоторый объем трафика.

При оптимизации статьи, в первую очередь, обращают внимание на ВЧ и СЧ запросы. Однако с каждым годом продвижение новых сайтов становится все затруднительным, а оптимизация все тоньше. Сейчас считается, что использование НЧ ключей также может принести некоторый объем трафика.

Как проверить частотность запроса

Частотность ключевых слов можно узнать с помощью соответствующих сервисов поисковых систем, а также специальных программ по составлению семантического ядра. Поисковики предоставляют свои сервисы с расчетом подбора запросов для контекстной рекламы.

Wordstat (Яндекс)

Wordstat — cервис Яндекса по определению статистики ключевых запросов. Вордстат использует большинство оптимизаторов не только в целях составления коммерческих запросов под рекламу, но и для добычи ключевых слов в рамках обычной текстовой оптимизации. У Вордстата выделяют три вида частотностей:

- Частотность WS — базовая частотность запроса в Вордстате.

- Частотность «» WS — частотность по точному вводу запроса.

Например, статистика по запросу [«автомобиль»] будет соответствовать запросу [автомобиль] без добавлений других слов.

Например, статистика по запросу [«автомобиль»] будет соответствовать запросу [автомобиль] без добавлений других слов. - Частотность «!» WS — частотность по точному вводу каждого слова в запросе, исключая склонения и т.п. Запрос [!китайский] означает, что будет выдана статистика по слову [китайский] без возможных склонений (китайская, китайское).

По запросу [автомобиль] текущая частотность превышает десять миллионов показов. Однако базовый показатель предполагает добавление всевозможных слов к ключевому слову, по которым будет ранжироваться статья.

Если заключить запрос в кавычки, то статистика сократится с десяти миллионов до 28 тысяч. Для оптимизатора может оказаться полезной правая колонка с похожими запросами, которые дополняют семантический сбор.

Вкладка «По словам» означает, что статистика приводится по общей сумме показов введенного запроса. На вкладке «по регионам» отображается статистика показов в разных регионах страны. А на «Истории запросов» можно отследить по графике изменение частотности запроса в течении месяца или недели, а также статистику по по запросам через ПК или мобильные устройства.

Сервис Google AdWords сам по себе более заточен под контекстную рекламу, нежели Вордстат. В разделе «Инструменты» можно подобрать необходимые ключи под нужный запрос. В колонке «Таргетинг» задается нужный регион показов и язык. Также можно указывать минус-слова.

В отличии от Вордстата, где указывается статистика за месяц, в AdWords можно выбирать месячный диапазон показов в колонке «Диапазон дат». Недостатком является усредненный число результатов. Сама статистика разделена на два блока:

- Ключевые слова — аналог частотности «» Вордстата;

- Ключевые слова (по релевантности) — аналог базовой частотности и похожих запросов WS.

Плюсами являются присутствие уровня конкурентности, а также возможность скачать подобранные слова в CSV-файл или на Гугл Диск.

Помимо AdWords, Гугл имеет еще один инструмент по анализу запросов под названием Google Trends. Данный сервис оценивает популярность введенного запроса на определенный период времени и представляет статистику в виде графика. Можно сравнивать несколько ключевых запросов между собой. Также отображается статистика по регионам.

Можно сравнивать несколько ключевых запросов между собой. Также отображается статистика по регионам.

Для графика используются не точные числа, а относительные, основанные в том числе на релевантных запросах.

Mail.ru

Mail.ru также имеет в сервисе для вебмастеров инструмент по статистике поисковых запросов. Помимо общих показов, в таблице представлены распределение запросов по полу и возрасту пользователей.

Не секрет, что Mail сотрудничает с Яндексом, так как поисковик размещает рекламу Яндекса.

Rambler

Rambler с каждым годом теряет свою популярность, однако их Wordstat может оказаться весьма полезным. Дело в том, что статистика запросов в Яндексе и Гугле не всегда может отображать реальное положение вещей. Многие компании могут вводить «в холостую» коммерческие запросы в целях слежки за конкурентами, т.е. для анализа ТОПа, тайтлов и т.д.

По причине низкой популярности Рамблера, статистика их Вордстата обладает меньшей заспамленностью и может внести некоторую ясность для оптимизаторов. В общем, в качестве дополнительного инструмента вполне сгодится.

В общем, в качестве дополнительного инструмента вполне сгодится.

Как проверить массово частотность запросов

Большинство оптимизаторов выбирают для сбора и анализа семантического ядра такие программы, как Key Collector или Slovoeb. Также существуют онлайн-сервисы по определению частотностей.

Key Collector

Получить необходимые ключи для семантического ядра и массово проверить их частотность можно при помощи десктопной программы Key Collector. Открываем Вордстат, в поле заносим основные ключи с новой строки по вашей тематике и нажимаем «Начать сбор».

В настройках можно задавать требуемый регион для сбора, а также стоп-слова. После того как ключи соберутся, определяем частотности через Директ.

В итоге у вас будет таблица с ключами и частотой показов. Сразу удаляем все ключи, у которых точная частотность «!» равна нулю. Для этого делаем фильтрацию в колонке «Частотность !». Кликаем на синюю иконку. Появится окно с фильтром. Выбираем «больше или равно» > «1» и жмем «Применить».

Для получения большего списка ключей можно собрать поисковые подсказки с Яндекса. Делаем новую группу (окно справа).

Прежде чем парсить подсказки, нужно настроить глубину их поиска. Заходим в настройки и выбираем вкладку «Подсказки» и в значение поля «Глубина парсинга» ставим «2».

Также убедитесь, что включена галка «Собирать только ТОП подсказок без перебора…». Теперь кликаем на созданную группу – откроется новая пустая вкладка. Жмем иконку сбора поисковых подсказок.

Включаем галку «Не добавлять фразу, если она уже есть в любой другой группе» — чтобы потом не было дублей ключей. Выбираем парсить с Yandex. В поле фраз вводим наши основные ключи.

После сбора фраз делаем то же самое, что и при парсинге Вордстата: снимаем частотности, убираем неподходящие по смыслу фразы и фразы, где частотность «!» равна нулю.

Аналогично с помощью Key Collector можно собрать ключи и частотности с Гугла.

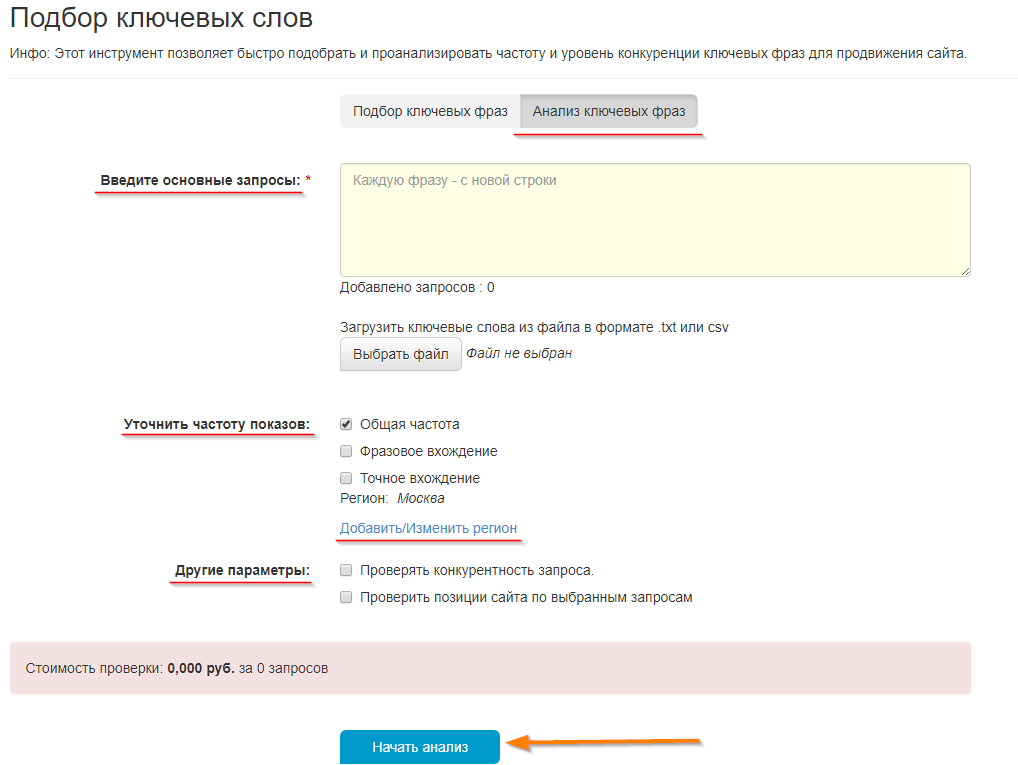

Rush Analytics

Сервис Rush Analytics является онлайн-альтернативой Key Collector. Плюсом инструмента по сбору ключей является отсутствие необходимости использовать прокси, антикапчу и т.п.

Плюсом инструмента по сбору ключей является отсутствие необходимости использовать прокси, антикапчу и т.п.

Для сбора частотности с Вордстата, необходимо перейти на вкладку «Сбор частотности» и поставить галочку напротив !ключевое слово, то есть точной частотности. Далее заносим ключевые слова. После того, как сервис посчитает затраты, нажимаем «Создать новый проект».

Как собрать семантическое ядро для продвижения сайта: инструкция от агентства интернет-маркетинга

Нравится статья?

Понравится и работать с нами.

Начать

- Что должно получиться в итоге

- Как оформить результат

- Порядок сбора ядра

- Каких ошибок избегать при сборе семантического ядра

- Что делать с семантическим ядром дальше

Семантическое ядро – это список ключевых запросов, по которым вы будете продвигать свой сайт в поисковых системах. Разберемся, в каком порядке его собирать, как расширять и каких ошибок избегать в работе с семантикой.

Разберемся, в каком порядке его собирать, как расширять и каких ошибок избегать в работе с семантикой.

Что должно получиться в итоге

Ваша цель – составить полный список ключевых запросов, по которым аудитория ищет ваши товары и услуги. Важно четко понимать, за какой информацией люди приходят на сайт и какие запросы вбивают в поисковую строку.

Критерии хорошего ядра:

- Содержит самые конверсионные (близкие к покупке) запросы.

- Общая и точная частотность, правильные формы слов. Например, общая частотность запроса «уборка офиса» – 17 000 в мес. – это все запросы, включающие любые формы слов«уборка» и «офис». Запросов, в которых используются только эти два слова в любых формах – 1 270. Точных запросов «Уборка офиса» – 274.

- Тематическая плотность – запросы плотно охватывают определенную тематику, а не надерганы из разных. Не упущены хорошие альтернативные запросы.

Как оформить результат

Удобнее всего собирать ядро в формате таблицы в любой привычной для вас программе. Какие колонки в ней должны быть:

Какие колонки в ней должны быть:

- Сами ключевые фразы и слова, каждая позиция отдельной строкой. Полезно также визуально разделить тематические группы – цветом, пустой строкой.

- Характеристика запроса – коммерческий или информационный. Коммерческие ключи содержат слово «купить / заказать / цена», а по информационным люди ищут полезные материалы в вашей сфере (например, «как рассчитать количество плитки для пола»).

- Место для URL страниц (пригодится,когда вы будете распределять запросы по сайту).

- Частотность запроса (количество упоминаний в поисковиках за месяц), чтобы в дальнейшем вам было проще разбить запросы на группы и распределить их по страницам. Частоту запросов удобно смотреть в сервисе Яндекс.Вордстат.

Яндекс.Вордстат. Вверху списка – самые высокочастотные запросы, они сортируются по убывающей.

Что еще почитать: Идеальный каталог для продвижения сайта

Когда таблица для работы готова, можно переходить к сбору семантического ядра. Очень советуем делать это, большей частью, вручную – никакой сервис не заменит здесь аналитические способности человека, знающего свой бизнес.

Очень советуем делать это, большей частью, вручную – никакой сервис не заменит здесь аналитические способности человека, знающего свой бизнес.

Порядок сбора ядра

Шаг 1 – находим базовые запросы

Начинаем с базовых запросов – это основа семантического ядра сайта, самые очевидные «ключи» в вашей тематике.

Откуда их брать:

- Буквально из головы – советуем устроить мозговой штурм и записать все слова и сочетания слов, которые описывают ваш бизнес. Например, для сайта автосервиса это могут быть запросы кузовной ремонт, шиномонтаж, замена масла, автосервис в Звенигородеи т.д. Тут может помочь и ваш прайс-лист со всеми товарами/услугами, но нужны также и общие запросы по сфере в целом. Запишите все идеи, позже вы сможете их проверить и отфильтровать.

- В сервисе Яндекс.Вордстат. Введите в поисковую строку любой ключ из базового списка, и сервис покажет, в каких сочетаниях и формах его используют реальные пользователи. А в дополнительной правой колонке вы увидите синонимичные и связанные запросы – обязательно скопируйте себе подходящие.

Примеры дополнительных запросов для сайта автосервиса – «ремонт автомобилей», «обслуживание автомобилей» и т.д.

- Из отчетов систем аналитики Яндекс.Метрика или Google Analytics – только если вы составляете семантическое ядро для уже действующего сайта. Зайдите в разделы «Анализ поисковых запросов» или «Популярные запросы», чтобы увидеть, по каким фразам вас находит реальная аудитория сайта.

Скорее всего, в списке ваших базовых запросов окажутся преимущественно ВЧ (высокочастотные) ключи, по которым в поисковиках большая конкуренция. Их нужно разбавить средне- и низкочастотными запросами, поэтому делаем следующий шаг.

Шаг 2 – расширяем смысловое ядро

Посмотрите на ключи в базовом списке – большинство из них будут состоять только из «тела», то есть, просто называть услуги, товары, сферу деятельности.

Чтобы семантическое ядро сайта получилось объемным, нужно нарастить на основные ключи:

- Слова-спецификаторы, которые выражают намерение – «купить», «заказать», «записаться» и пр.

- Так называемые «хвосты» – слова, которые уточняют запрос и делают его средне- и низкочастотным. Например, не просто «записаться к терапевту», а «записаться к терапевту в Новокосино» или «записаться к терапевту онлайн».

В результате на месте каждого базового запроса у вас получится целая группа ключей разной частотности.

Часть работы можно сделать вручную, но советуем использовать на этом этапе специальные сервисы. Так вы ускорите процесс и сразу проверите, какие запросы люди вводят в поисковиках на самом деле.

Кроме уже знакомого нам Яндекс.Вордстат, попробуйте и другие инструменты:

1. Планировщик ключевых словGoogle– сервис для тех, кто уже запускал контекстную рекламу в Google.Ads. Планировщик быстро подберет для вас связанные по смыслу ключевые запросы и проанализирует их.

Для начала работы нужно просто ввести любой ключ из вашего базового списка.

2.KeyCollector. Платная утилита, которая собирает семантику сразу из нескольких источников – не придется обращаться к каждому по отдельности.

Платная утилита, которая собирает семантику сразу из нескольких источников – не придется обращаться к каждому по отдельности.

3. Сервисы для конкурентного анализа. Например, SEMrush, Searchmetrics, SpyWords или Serpstat. Они покажут, по каким запросам продвигаются другие сайты в вашей нише – возьмите на заметку самые удачные идеи.

Кроме анализа конкурентов, некоторые из этих сервисов умеют подбирать связанные ключи к запросам из вашей базы. Например, так работает SpyWords

Что еще почитать: Чек-лист для анализа конкурентов в SEO

Шаг 3 – фильтруем список

На втором этапе мы с помощью сервисов собрали объемный список запросов, но часть из них не нужна в семантическом ядре сайта. Поэтому теперь снова включаемся в работу сами и вручную чистим список – убираем те фразы, которые не подходят для сайта по смыслу и могут привести нецелевую аудиторию. Подчеркнем еще раз: обращайте внимание именно на смысл, а не на частотность и другие численные характеристики.

Как понять, что ключевой запрос вам не подходит:

- В нем упоминается товар или услуга, которых нет в вашем ассортименте.

- Ключ дублирует другие запросы. Например, в списке могут оказаться одновременно «репетитор по русскому языку» и «русский язык репетитор» – одну из фраз убираем.

- В запросе есть упоминание компании-конкурента.

- В запросе упоминаются города и районы, с которыми вы не работаете.

- В запросе есть стоп-слова «бесплатно», «своими руками», «скачать» и прочие, которые не направлены на покупку.

Есть спорные категории ключей. Некоторые компании сразу отсекают запросы со словами «недорого / дешево», некоторым мы советуем их оставить. Так же и запросы с ошибками: самые частотные из них иногда можно использовать в текстах на неосновных страницах, но если сомневаетесь, тоже убирайте.

Далее, все запросы можно разделить на три типа:

- Витальные/брендовые – самые конверсионные запросы. Например, «куртка Bogner», «кроссовки Nike», «кафе Шоколадница».

- Транзакционные. Такие запросы набирают люди, которые имеют намерение приобрести товар или услугу. Признаки – слова «купить», «в Москве», «цена», «с доставкой» и т.д.

- Информационные. Например, «как выбрать подарок мужу».

Ядро должно состоять в первую очередь из первых двух категорий запросов, а информационные можно вынести отдельно – на основе них вы сможете в будущем писать статьи в блог и ответы на вопросы.

Каких ошибок избегать при сборе семантического ядра

- Отсеивать высокочастотные ключевые запросы. Да, по ним высокая конкуренция и сложнее продвигаться, но ведь ВЧ запросы и не рассматриваются, как основной источник трафика. Важно оставить их в семантическом ядре, потому что именно эти фразы описывают сферу вашей работы и ключевые услуги («бытовая техника», «фотостудия в Москве» и пр.).

- Отсеивать низкочастотные и микро-низкочастотные запросы – другая крайность. На самом деле, мы рекомендуем расширять семантическое ядро сайта именно за счет таких ключей.

Ведь «купить в Москве настольную лампу BM614» введет в поиске тот, кто, скорее всего, уже сделал выбор и готов заказать. К тому же, 60-80% всех запросов, которые вводят пользователи – низкочастотные.

Ведь «купить в Москве настольную лампу BM614» введет в поиске тот, кто, скорее всего, уже сделал выбор и готов заказать. К тому же, 60-80% всех запросов, которые вводят пользователи – низкочастотные. - Слишком долго и скрупулезно собирать смысловое ядро, если у вас пока небольшой бизнес. В этом случае важнее в принципе запустить сайт и начать продвижение, а расширить структуру и список запросов вы сможете в процессе. Для начала используйте 1-2 источника базовых запросов – Яндекс.Вордстат, Планировщик Google – а дополнительные каналы задействуете позже при необходимости.

- Собирать семантическое ядро раз и навсегда и больше к нему не возвращаться. На самом деле, список ключевых запросов нужно регулярно расширять и пересматривать: увеличивается ассортимент, растет ваш сайт – должно расти и смысловое ядро.

Что еще почитать: Гибкий подход Agile в разработке и продвижении сайтов

Что делать с семантическим ядром дальше

Когда семантическое ядро собрано, важно грамотно сгруппировать запросы по смыслу и распределить их по страницам сайта с помощью текстов и метатегов, причем чаще всего для этого нужно перекраивать и расширять всю структуру целиком. Для этого есть платные и бесплатные сервисы, но они могут только сократить время на кластеризацию – их результат всегда требует ручной доработки, поэтому лучше доверить продвижение сайта профессионалам.

Для этого есть платные и бесплатные сервисы, но они могут только сократить время на кластеризацию – их результат всегда требует ручной доработки, поэтому лучше доверить продвижение сайта профессионалам.

В «Эврике» за вашим проектом будет закреплен опытный SEO аналитик, который глубоко изучит ваш бизнес и разработает индивидуальную стратегию продвижения исходя из ваших целей.

Продвижение сайтов в «Эврике»

Технологии, кейсы, стоимость

Обсудить проект

Поделитесь с друзьями

Еще по теме

Чек-лист для анализа конкурентов в SEO

Основы SEO: зачем оглядываться на других и как это делать правильно

Как разработать стратегию SEO продвижения сайта

Основы SEO: что нужно сделать до начала любых работ по сайту

SEO продвижение сайта автосервиса

Особенности тематики и проверенные приемы от агентства интернет-маркетинга

SEO-продвижение В2В сайтов

Особенности продвижения продуктов для бизнеса в поисковых системах

SEO продвижение сайтов строительных компаний

Ключевые особенности тематики и проверенные приемы продвижения в поиске

SEO продвижение сайтов медицинской тематики

Особенности продвижения клиник и других сайтов в медицинской сфере

Подписаться

Отзывы клиентов

www.

energyc.ru

energyc.ruЭлектролаборатория

2 года эффективной работы

ООО «Комплексный Энерго Подряд» является клиентом ООО «Эврика» с 2016 г. Сотрудники вашей компании зарекомендовали себя как профессионалы своего дела. Всегда обеспечен быстрый ответ на интересующие вопросы. Работа ведется непрерывно и результативно, о чем свидетельствует обращение в нашу компанию новых заказчиков.

Читать полностью

www.gormed.su

Многопрофильная клиника

Результатами мы довольны

Раньше я платил за клики, не представляя, что клики и звонки – разные вещи. Работа с системой Calltouch поразила меня тем, насколько можно увеличить количество звонков. Не кликов, а именно звонков, уменьшив при этом расходы с помощью достаточно простых манипуляций. Результат впечатляющий.

Читать полностью

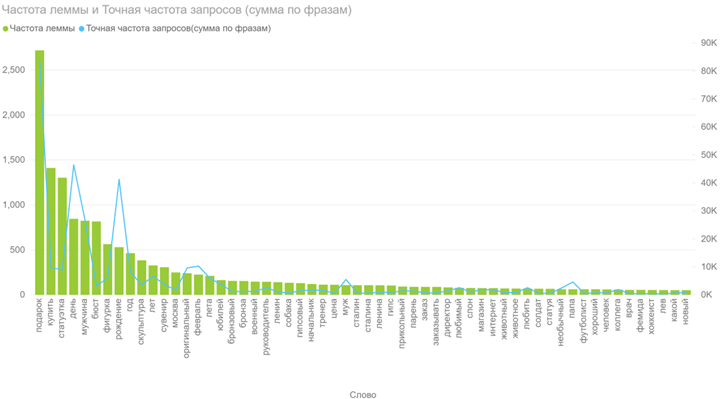

mir-nagrad.ru

Магазин наград

Благодаря «Эврике» не закрыл магазин

Я доволен своим интернет-магазином и уверен, что он полностью удовлетворяет запросы моих дорогих покупателей! Понравилось отношение ко мне и моему проекту, очень дружелюбное, и некоторые нюансы (правки по сайту, консультации по непонятной мне теме) проходят быстро, гладко, без нервов и без ударов по карману.

Читать полностью

eurotech-group.ru

Аэродромная техника

Рекомендуем!

Компания «ЕвроТэк» благодарит компанию «Эврика» за оказанные услуги и быстрый отклик на любую проблему. За период работы сайт eurotech-group.ru поднялся в ТОП по отрасли.

Читать полностью

www.seniorgroup.ru

Сеть пансионов для пожилых

Группа компаний Senior Group благодарит

рекламное агентство «Эврика» за ведение эффективных рекламных кампаний в Google Adwords, Яндекс.Директ и социальных сетях, а также ведение интернет-сайта www.seniorgroup.ru.

Читать полностью

Оставьте заявку

Ваше имя

Электронная почта

Телефон *

Нажимая на кнопку Отправить, я даю согласие на обработку персональных данныхКак проверить частотность точного запроса

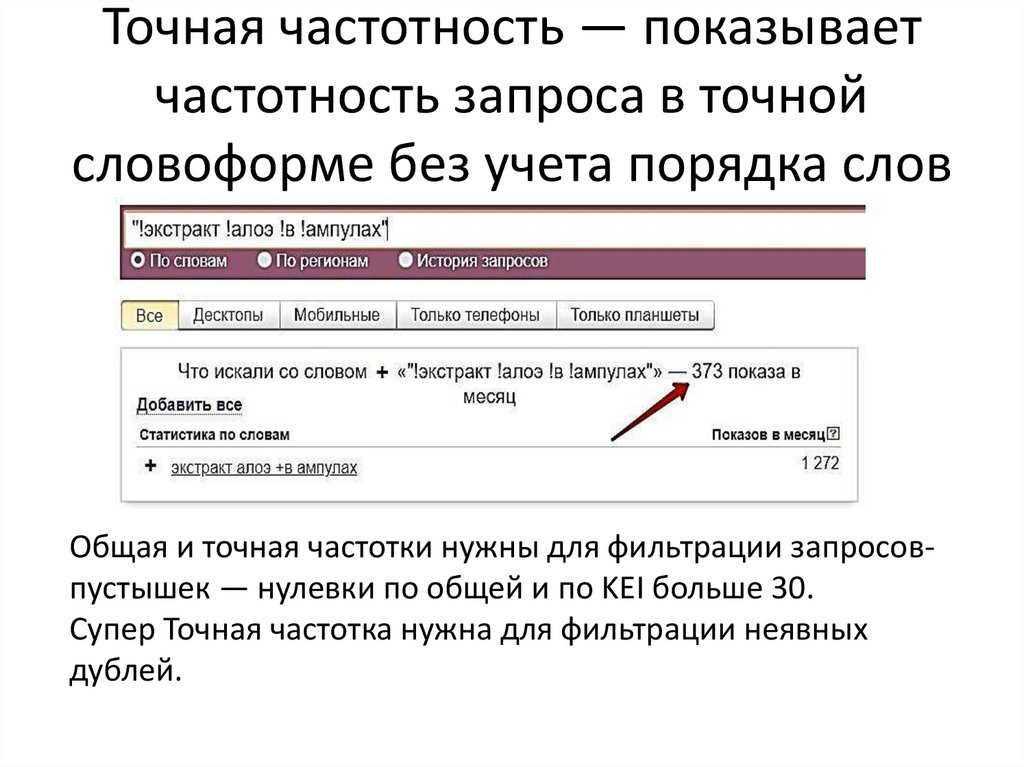

Для грамотной работы со статистикой поисковых запросов WordStat нам потребуется изучить и применить на практике два базовых и пять вспомогательных операторов. Данную статью можно рассматривать как инструкция по применению Яндекс.Вордстат.

Данную статью можно рассматривать как инструкция по применению Яндекс.Вордстат.

Известно, что если просто ввести интересующий нас запрос в статистику Яндекса по адресу https://wordstat.yandex.ru/ , то будет представлена частота, которая отражает общее число показов результатов выдачи за предыдущей отчетный период в ответ на все запросы с содержанием заданной фразы. Так, число рядом со словом «магазин» отражает суммарную частоту показов по всем запросам со словом «магазин» — «интернет-магазин», «магазин сотовой техники», «статистика магазина», «как правильно выбрать магазин для покупок» и так далее.

В большом числе случаев, это не очень информативные и не самые полезные данные и требуется применять ряд вспомогательных операторов и приёмов о которых и пойдет речь в данной статье.

Данные операторы используются для целого ряда задач — прогнозирования трафика из органического поиска и спецразмещения, прогнозирования отдачи от SEO и других.

К базовым операторам, без использования которых невозможно правильное понимание результатов работы статистики ВордСтат мы отнесем операторы «Кавычки» и «Восклицательный знак». Их определение и использование представлены ниже.

Их определение и использование представлены ниже.

Как видно из примера, с помощью оператора «Восклицательный знак» можно быстро найти запросы с нужной нам словоформой одного или нескольких слов из фразы.

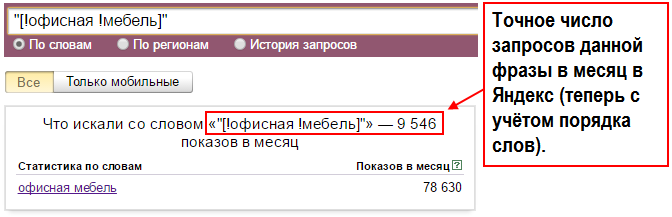

Совместное использование операторов «Кавычки» и «Восклицательный знак» позволяет получить так называемую «Точную частоту запроса» исходя из которой и строится прогноз трафика на сайт из контекста или органической выдачи. Требуется лишь верно предсказать показатель CTR (число кликов на 100 показов) для выбранной или занимаемой позиции.

Вспомогательные приёмы и операторы

Ещё большие возможности при работе с WordStat от Яндекса открываются с применением пяти дополнительных операторов. Это:

Оператор «Или» — задается символом «|» и полезен, когда требуется сравнить или «смещать» несколько фраз в статистике, а также для быстрого подбора семантики на страницу.

Оператор «Квадратные скобки» — задается символами «[]» между которым заключена фраза. Позволяет зафиксировать порядок следования слов в запросе. Важен для оценки популярности близких фраз, особенно по частотным запросам.

Позволяет зафиксировать порядок следования слов в запросе. Важен для оценки популярности близких фраз, особенно по частотным запросам.

Оператор «Плюс» — задается символом «+» и полезен, когда требуется найти поисковые запросы со стоп-словами (предлогами, союзами, частицами).

Оператор «Минус» — задается символом «-» и полезен, когда требуется исключить запросы с использованием ряда слов.

Оператор «Группировка» — задается символами скобки «()» и полезен, когда требуется сгруппировать использование описанных выше операторов.

Примеры использования

Приведем примеры использования каждого из операторов, код запроса в WordStat для самостоятельного задания и таблицу поисковых запросов до и после из применения.

Пример кода:

шпаклевка | шпатлевка

«Квадратные скобки» и получение точной частоты запроса

Пример кода:

«[!офисная !мебель]»

Пример кода:

дела +на

«Минус»

Пример кода:

окна -пластиковые

«Группировка» и более сложный запрос

Пример кода:

(ворд стат | вордстат | wordstat | word stat) (операторы | приёмы | +какие | фишки | правила | +как)

Дополнительные возможности

На иллюстрации выше, цифрами отмечены: 1 — сам запрос, 2 — дата обновления статистики Яндекса по данным фразам, 3 — суммарное число показов по фразам которые соответствуют запросу, 4 — общее число показов по фразе.

Здесь очень важно не путать общее число показов из колонки 4 и число точных запросов по фразе, которое можно получить с использованием операторов «Кавычки», «Восклицательный знак» и «Квадратные скобки».

К дополнительным возможностям WordStat отнесем изучение истории (сезонности) спроса в тематике, получение частоты в заданном регионе и анализ популярности фраз в мобильном поиске (планшеты, мобильные телефоны).

Данные функции часто оказываются полезны при планировании рекламных кампаний.

История запроса

Можно быстро понять, как меняется интерес к выходу новой модели «IPhone 6S». К сожалению, в текущий момент история запросов не поддерживает операторы («ИЛИ», «Группировка», «Квадратные скобки»).

Изучение динамики по запросу [Новый год]. Хорошо видны резкие сезонные всплески и провалы после наступления января.

Частота в заданном регионе

Отдельного упоминания заслуживает получение частоты запроса в заданном регионе. С помощью разделения общей частоты запроса по регионам можно оценить как частоту заданного запроса в интересующей нас регионе (Москва, Москва и область, Санкт-Петербург и т. д.), так и относительную популярность того или иного запроса в регионе.

д.), так и относительную популярность того или иного запроса в регионе.

Из примера приведенного ниже видно, что запросы со словами «купить» и «Казань» преимущественно задают жители г. Казань, что весьма очевидно. Использование данной функции на практике иногда открывает и более неожиданные закономерности.

Сбор (парсинг) запросов заданной длинны

На практике бывает полезным использовать приём парсинга запросов заданной длинны (из 2, 3, 4 слов и так далее) с вхождением ключевого слова. Данная возможность оказывается особенно актуальной, если вы работаете в популярной тематике и сбор первых 41 страниц не позволяет получить все поисковые фразы.

Для сбора всех фраз с длиной в 3 слова используется конструкция вида:

«IPhone IPhone IPhone»

Данный запрос позволяет собрать уже не просто 41 страницу поисковых фраз произвольной длины, а 41 страницу фраз из трёх слов с вхождением «IPhone». Последовательный анализ запросов с длиной от 2 до 7 слов позволяет существенно увеличить охват целевой аудитории.

Для ускорения сбора частот, быстрого парсинга Яндекс.Вордстат и хранения целевых ядер, рекомендуется использовать программы и онлайн-сервисы автоматизации, к числу которых можно отнести «Пиксель Тулс». После быстрой настройки параметров сбора, можно получить широкое семантического ядро в рамках тематики.

Анализ проведён с помощью инструментов в сервисе Пиксель Тулс.

Детальный анализ словоформ для ВЧ-запросов

Для ВЧ-запросов длиной в 2 и более слов может пригодиться анализ частоты встречаемости словоформ. Для этого требуется ввести исходную фразу, скажем, «продвижение сайтов» и далее последовательно исключать точные популярные написания с помощью комбинации операторов вида — -«[!продвижение !сайтов]», что приводит к исключению наиболее частотной формы написания из статистики и появлению второй по популярности версии. Далее процедуру можно повторить.

Выводы

Мы рассмотрели все основные функциональные возможности сервиса статистики WordStat. Теперь вам остается лишь правильно применить полученные знания на практике для своих проектов.

Теперь вам остается лишь правильно применить полученные знания на практике для своих проектов.

Мы оставим «в рукаве» ещё две интересных и скрытых возможности ВордСтат для наших подписчиков. Хотите узнать их? Тогда оформите подписку на обновления проекта «Продвижение самостоятельно». Удачи!

У нас иногда спрашивают:

«Почему мой сайт в ТОПе по такому на первый взгляд «жирному» запросу как «металлоконструкции», но трафика на сайт с этого ключевика совсем мало. Какие-то 50-100 человек в месяц! Но ведь частотность у этого запроса огромная, аж 250 тысяч в месяц! Почему такое происходит?»

И правда, если вбить в wordstat.yandex.ru такой запрос, то частотность он нам покажет довольно внушительную:

При такой частотности позиция даже на 10 месте в выдаче должна приносить много трафика, но на деле все происходит совершенно иначе. В чем же причина? Давайте разбираться по порядку. Здесь есть несколько моментов, которые нужно учитывать. Начнем с самых простых и далее – по нарастающей.

Регион

Первое, про что все часто забывают, – это выбор региона при съеме частотности. Ни один коммерческий сайт не может продвигаться сразу по всем регионам, если он, конечно, не имеет офисы в каждом из них. Поэтому частотность снимается именно по тому региону, где находится офис компании. Если регионов несколько – отмечаем их все.

Например, компания, которая специализируется на поставках металлоконструкций и металлопроката, имеет офис в Москве, который добавлен в Яндекс.Справочник. Таким образом, ни по каким другим регионам данный сайт ранжироваться не будет, поэтому и ориентироваться надо в первую очередь на посетителей из Москвы. Значит, в wordstat нужно выставить соответствующий регион: Москва.Ключевой момент – наличие организации в Яндекс.Справочнике, так как именно по нему происходит привязка региона сайту.

Иногда клиенты нам говорят:

«Я хочу продвигаться по всей России, мой интернет-магазин доставляет товар в любой регион».

И здесь мы вынуждены их разочаровать: к сожалению, даже внутри России интернет-магазин не может ранжироваться, если у него нет филиалов в соответствующих регионах. Под филиалами подразумевается привязанная в Яндекс.Справочнике карточка организации с подтвержденным офисом в регионе.Таким образом, при оценке спроса всегда нужно строго определять региональность.

Под филиалами подразумевается привязанная в Яндекс.Справочнике карточка организации с подтвержденным офисом в регионе.Таким образом, при оценке спроса всегда нужно строго определять региональность.

Виды частотности

После выбора региона сразу видно, что частотность значительно уменьшилась.

Однако все равно это не реальные цифры конкретных фраз и, чтобы точно определить частотность каждого ключевика, нужно использовать специальный синтаксис.

Базовая частотность

Пока что мы собрали так называемую «Базовую частотность». Такой частотностью называют ту, которую мы получаем при вводе запроса в wordstat без какого-либо синтаксиса, выбрав регион или нет. Такая частотность представляет собой сумму частотностей всех фраз, где встречаются слова из запроса в любых словоформах и в любом порядке. Например, в нашем случае запрос «Металлоконструкции» без указания региона имел частотность около 250 тыс. в месяц по всему миру и 33 тыс по Москве. В эту частотность вошли все фразы, которые содержат слово «металлоконструкции». Причем слово может иметь разные окончания, то есть сюда войдут фразы: «завод металлоконструкций», «сварные металлоконструкции», «купить металлоконструкции недорого» и т.п.

Причем слово может иметь разные окончания, то есть сюда войдут фразы: «завод металлоконструкций», «сварные металлоконструкции», «купить металлоконструкции недорого» и т.п.

Частотность в кавычках

Если мы хотим узнать частотность поискового запроса более точно, например, отсечь из нее те запросы, где присутствуют другие слова, то нужно брать запрос в кавычки. Иными словами, если вбить в wordstat запрос в таком виде – “металлоконструкции” – то получим следующую цифру:

Теперь мы видим, что отдельно слово «металлоконструкции» по Москве запрашивают в Яндексе только 948 человек. Однако сюда все равно еще подмешиваются словоформы, например, «металлоконструкций» «металлоконструкция». Чтобы их убрать, воспользуемся следующим видом частотности.

Частотность в кавычках и с восклицательным знаком (точная частотность)