Самый северный в мире дата-центр открыли в Норильске

#НОРИЛЬСК. «Таймырский телеграф» – Дата-центр, или ЦОД (центр обработки данных), должен будет отличаться высоким уровнем защиты, для чего его специально подготовили к работе на Крайнем Севере. Специалисты уверены: норильский дата-центр прослужит долго и не потребует дополнительных затрат.

Как пояснила «Таймырскому телеграфу» PR-директор международного инфраструктурного проекта BitCluster (главный офис находится в Швейцарии) Татьяна Арестова, при создании и вводе в эксплуатацию дата-центра в Норильске использовали опыт и стандарты построения современных дата-центров по всему миру. Она рассказала, что открытие пройдет в несколько этапов. Первая очередь электроэнергетической мощности составляет 11,2 МВт. В следующем году планируется увеличение мощности до 31 МВт.

Сейчас на площадке, которую оборудовали на территории ныне закрытого Никелевого завода, расположены модульные ЦОДы, предназначенные для размещения современных устройств типа Antminer S19.

«Дополнительно сконструирован навес для холодного коридора, в котором происходит подмес теплого воздуха, чтобы исключить попадание снега. В дальнейшем мы будем использовать еще цех, который находится в стадии ремонта», – сообщается на странице BitCluster в Instagram.

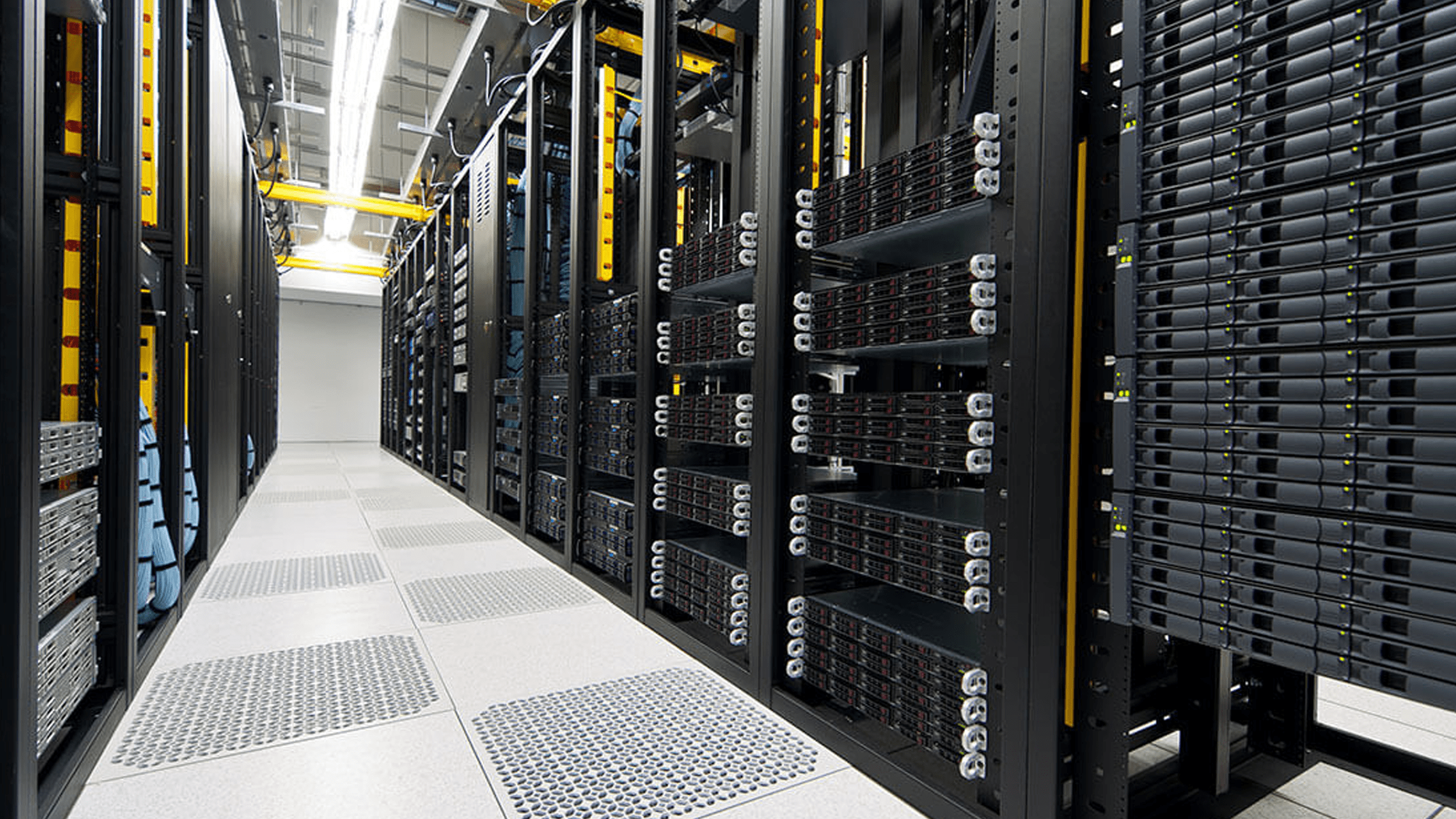

Внутри одного из ЦОДов. Центр обработки данных, или дата-центр, – это специализированное здание, в котором компании размещают свое серверное и сетевое оборудование

Специалисты сходятся во мнении: несмотря на то что Норильск – город с суровым климатом, холод – как раз то, что нужно для комфортной работы.

«Оборудование может сильно нагреваться при работе. Если снаружи будет жарко, то устройства гораздо раньше положенного выйдут из строя, что приведет к экономическим потерям. А вот прохладная температура увеличивает срок службы устройств. И при этом не требуется дополнительно платить за охлаждение — оно просто создано природой. Этот регион крайне важен, так как нет разницы в цене в часы пиковой нагрузки, что позволяет сделать работу устройств бесперебойной и эффективной 24 часа в сутки и семь дней в неделю. Ведь чем чаще отключается устройство, тем чаще оно выходит из строя», – пояснили в BitCluster.

Этот регион крайне важен, так как нет разницы в цене в часы пиковой нагрузки, что позволяет сделать работу устройств бесперебойной и эффективной 24 часа в сутки и семь дней в неделю. Ведь чем чаще отключается устройство, тем чаще оно выходит из строя», – пояснили в BitCluster.

В компании также сообщили, что самый важный показатель для эффективного майнинга – это цена за электроэнергию, которая в нашем регионе является одной из самых низких по стране. При этом электричество очень стабильно и надежно. «Мы заключили прямой договор с Норильско-Таймырской энергетической компанией», – рассказали в BitCluster.

За несколько минут, пока вы читаете этот текст, в интернете появятся полтора миллиона твитов, 160 тысяч фотографий в Instagram, будет отправлено 12 миллионов поисковых запросов в Google, просмотрено 15 миллионов роликов на YouTube. Триллионы гигабайтов музыки, текстов, видео и других данных надо где-то хранить и обрабатывать.

Председатель Норильского городского совета депутатов Александр Пестряков, который 14 лет отработал в сфере информационных и телекоммуникационных технологий и прекрасно разбирается в этой теме, высоко оценил потенциал дата-центра. По его словам, именно территории Арктики наиболее экономически выгодны для размещения центров обработки данных, о чем, к слову, он также говорил весной 2019 года, когда проводил переговоры с потенциальными инвесторами и предлагал Норильск в качестве площадки для строительства, выступив на Арктическом форуме в Санкт-Петербурге.

«Уверен, это только начало цифровой реальности Норильска. У нас есть ВОЛС, есть энергетические мощности, есть кадры, есть инфраструктура. Убежден, что любая власть должна мыслить на десятилетия вперед, прогнозировать развитие технологий и урбанистики. Только тогда города в Арктике будут развиваться по интенсивному пути. Строительство ЦОДов в Арктике позволит привлечь туда крупные инвестиции, что, несомненно, станет драйвером развития регионов», – сказал Александр Пестряков.

Сейчас новые дата-центры за Полярным кругом (в Швеции, Финляндии, Норвегии) активно строят крупнейшие мировые ИТ-корпорации, такие как Google и Facebook. Причины выбора таких локаций все те же: холодный климат, доступная электроэнергия и наличие площадей для строительства.

Михаил Туаев, пресс-служба BitCluster

15 октября, 2020

Последние новости

Похожие новости

Открытие дата-центра CloudDC Moscow 1

В Москве появился один их самых современных и высокотехнологичных дата-центров в России Cloud DC Moscow1, на базе которого будет создан новый IT-кластер для развития облачных технологий.

ЦОД работает по модели облачного провайдера IaaS-услуг, предоставляя клиентам защищенную инфраструктуру на базе комплекса уровня TIER III.

ЦОД Cloud DC Moscow 1 построен при участии авторитетной команды экспертов международной сертифицирующей организации Uptime Institute. Дата-центр Cloud DC Moscow 1 получил сертификат TIER III от Uptime Institute на проект и в настоящий момент проходит сертификация готового комплекса по стандарту Uptime Institute на следующий уровень, Facility.

«Мы спроектировали систему, которая не просто удовлетворяет стандартным требованиям Uptime Institute, но и отличается повышенной надежностью, способствуя снижению эксплуатационных затрат, составляющих самую значительную часть операционного бюджета и влияющих на ценообразование услуг», – говорит Георгий Гургенидзе, главный инженер ООО «Ай Эм Ти».

В дата-центре Cloud DC Moscow 1 реализован ряд энергоэффективных решений, которые не просто в разы снижают эксплуатационные затраты по сравнению с обычными дата-центрами, но и являются максимально экологичными.

Система технологического кондиционирования дата-центра Cloud DC Moscow 1 круглый год работает в режиме максимального использования холода наружного воздуха, без применения холодильных компрессоров. При экстремально высоких температурах наружного воздуха система подключает в работу адиабатный охладитель, позволяющий охлаждать наружный воздух фактически без затрат электроэнергии. Климатические условия России позволяют существенным образом оптимизировать операционные затраты на электроснабжение ЦОД. Система потребляет в 4 раза меньше электроэнергии в течении года, по сравнению с традиционными системами охлаждения. А используемое во всем дата-центре светодиодное освещение в 12-15 раз является более экономичным, нежели обычное.

Благодаря такой «зеленой» политике и новейшим разработкам компании Ayaks Engineering комплекс Cloud DC Moscow 1 обеспечивает линейную зависимость потребления энергии от загрузки дата-центра.

«При проектировании и строительстве мы сделали ставку на качество, надежность и резервирование всех систем комплекса. Сегодня мы с уверенностью утверждаем, что комплекс Cloud DC Moscow 1 является самым надежным дата-центром уровня TIER III в России.», – комментирует Сергей Кондратьев, генеральный директор ООО «Ай Эм Ти».

Используемые в дата-центре Cloud DC Moscow 1 дизель-роторные установки (DRUPS) обеспечивают бесперебойное питание не только для критического снабжения IT-нагрузки, но и для систем охлаждения, автоматики и контроля доступа. Это дополнительные меры безопасности, которые превосходят предписания уровня TIER III.

Заботясь о надежности IT-сервисов, в дата-центре Cloud DC Moscow 1 выстроена целая система, которая на разных уровнях защищает данные клиентов. При строительстве машинных залов использовались герметичные модули по 50 стоек, сделанные из сверхпрочных и пожароустойчивых материалов. К каждой серверной стойке подведена собственная система обнаружения пожара, при срабатывании которой для тушения подается особый газ, который не наносит вреда оборудованию и людям, оказавшимся в зале. Многоуровневая система доступа на объект, особые условия охраны и система видеонаблюдения гарантируют физическую защиту объекта.

К каждой серверной стойке подведена собственная система обнаружения пожара, при срабатывании которой для тушения подается особый газ, который не наносит вреда оборудованию и людям, оказавшимся в зале. Многоуровневая система доступа на объект, особые условия охраны и система видеонаблюдения гарантируют физическую защиту объекта.

Cloud DC Moscow 1 – уникальный ЦОД, спроектированный и построенный специально для облачной инфраструктуры, что делает его локомотивом развития облачных технологий на российском рынке. В то время как стандартом отрасли являются стойки мощностью 3-5 кВт, в дата-центре Cloud DC Moscow 1 используются стойки мощностью 11-22 кВт, что особо значимо для поставщика облачных сервисов. Ведь при использовании стоек мощностью менее 11 кВт себестоимость увеличивается в 2 раза, что делает оказание облачных услуг нецелесообразным или чрезвычайно дорогостоящим. Специально спроектированный под облачные вычисления дата-центр Cloud DC Moscow 1 не предназначен для размещения оборудования заказчиков. Высокая плотность оборудования стоек позволяет получить наивысшие показатели производительности, вычислительной мощности и объемов систем хранения.

Высокая плотность оборудования стоек позволяет получить наивысшие показатели производительности, вычислительной мощности и объемов систем хранения.

«Мы целиком сконцентрировались на облачных сервисах, потому что осознаем, что за «облаками» будущее IT-отрасли. Мы создадим бизнес-инкубатор на базе комплекса для развития облачных стартап-проектов. Команда разработчиков с хорошими идеями может придти к нам с рабочим прототипом или готовым продуктом и получить необходимую финансовую и маркетинговую поддержку, платформу для разработки, а также рабочие места в комфортном и высокотехнологичном офисе», – говорит Сергей Кондратьев, генеральный директор ООО «Ай Эм Ти».

На базе собственного R&D-центра специалисты Cloud DC вместе с партнерами из Microsoft и Mirantis готовы оказывать качественную поддержку облачной инфраструктуры на платформах Microsoft и Open Stack.

«Мы сделали ставку на такие платформы виртуализации, как Microsoft и Open Stack. Microsoft Azure – это надежные решения, которые уже используют тысячи клиентов по всему миру, а Open Stack – это открытая платформа, которая на сегодняшний день бурно развивается и ее используют крупнейшие мировые компании», – добавляет Олег Алексеенко, IT-директор ООО «Ай Эм Ти».

Перейти на облачную платформу Cloud DC очень просто, – достаточно обратиться в компанию с запросом, и вам будет предоставлен бесплатный тестовый период, а также квалифицированная поддержка специалистов.

1 PUE (Power Usage Effectiveness) – показатель, демонстрирующий эффективность использования электроэнергии центром обработки данных. Рассчитывается как отношение всей потребляемой объектом электроэнергии к количеству, расходуемому на работу вычислительных устройств.

Услуги датацентра

Как показывает наша практика, использование существующих у компании RadiusGroup ЦОД позволяет заказчику существенно сэкономить и вложиться в другие бизнес-процессы, забыв о проблемах с хранением и обработкой данных. Наши специалисты гибко подходят к решению проблемы Вашего бизнеса и предлагают уникальное решение, подходящее именно Вам.

Компания RadiusGroup предлагает Вам использование собственных современных площадок для хранения данных. Наличие собственных площадок обработки данных позволяет предложить стандартные услуги дата-центров по низким ценам. RadiusGroup постоянно расширяет список услуг, чтобы сформировать уникальное торговое предложение под любые нужды Вашего бизнеса.

Наличие собственных площадок обработки данных позволяет предложить стандартные услуги дата-центров по низким ценам. RadiusGroup постоянно расширяет список услуг, чтобы сформировать уникальное торговое предложение под любые нужды Вашего бизнеса.

ЦОД RadiusGroup является современным, оснащен новейшим серверным и инженерным оборудованием и имеет высокую категорию надежности (Tier III+).

На сегодняшний день Вы можете заказать следующие услуги:

- Недорогой хостинг – для сайтов со средней посещаемостью: сайты-визитки, блоги, информационные порталы, интернет-магазины.

- Аренда виртуального сервера (VDS) – для посещаемых сайтов с индивидуальными настройками веб-сервера и гарантированной производительностью.

- Аренда выделенного сервера – может использоваться для решения широкого вида бизнес задач: размещения сайтов, установки сервера баз данных (1С), терминального доступа т.д.

- Аренда стоек – предназначено для компаний с большим парком серверного оборудования.

- Colocation – размещение вашего сервера или оборудования в нашем дата-центре.

В 2014 году компания RadiusGroup согласилась предоставить свои ЦОДы, защищенные каналы передачи данных и все необходимые сертификаты и лицензии компании НИПК «Электрон», которая занимается разработкой и производством медицинского оборудования, комплексных и ИТ-услуг для здравоохранения.

Полный текст публикацииОбратитесь к нам и расскажите о Вашем проекте — мы поможем Вам объективно оценить ситуацию и найти оптимальное решение. За дополнительной информацией обращайтесь в RadiusGroup по телефону +7 (495) 6.410.410 или по электронной почте Этот адрес электронной почты защищён от спам-ботов. У вас должен быть включен JavaScript для просмотра.

Документация

Вычислительные мощности и сетевая инфраструктура, необходимые для работы системы, размещены в трех территориально распределенных облачных центрах обработки данных в России.

2 дата-центра DataLine

Расположены в Москве, сертифицированы по стандартам PCI DSS Level 1 и ISO/IEC 27001:2005.

Многоуровневая инфраструктура физической защиты ЦОД включают в себя систему газового пожаротушения, системы охранного телевидения и охранной сигнализации, систему контроля и управления доступом.

Ведется круглосуточное наблюдение и видеозапись обстановки в помещениях и прилегающих территориях. На входах организованы шлюзовые помещения, контролируемые службой охраны.

Электроснабжение ЦОД организовано с резервированием по схеме 2N — питание к каждой стойке в залах подается по 2 лучам. Источники бесперебойного питания внутри модулей ЦОД мощностью 500 кВт обеспечивают автономное питание в течение 5-6 минут — время с хорошим запасом для пуска ДГУ. Дизель-генераторные установки (ДГУ) в качестве источников резервного питания автоматически запускаются при отказе электросети «МосЭнерго». Масло и антифриз дизелей постоянно находятся в подогретом состоянии, благодаря чему ДГУ постоянно готовы к запуску (время пуска и выхода на режим — менее 1 минуты).

Топливные баки дизель-генераторов рассчитаны на 6 часов работы, при этом заключены договоры на оперативную доставку дизельного топлива, что позволит обеспечить работу ЦОД даже при долговременном отказе городской питающей сети.

Бесперебойный доступ к оборудованию, размещенному в ЦОД, осуществляется посредством резервированных высокоскоростных каналов передачи данных с шириной канала связи до 10 Гб. ЦОД объединены в волоконно-оптическое кольцо (с шириной канала связи до 40 Гб/с), включающие и точки присутствия ДатаЛайн на MMTC9 и ММТС10. Имеется 10 Гб/с канал до MSK-IX.

Дата-центр «Миран-1»

Дата-центр расположен в Санкт-Петербурге на охраняемой производственной территории. Здание дата-центра имеет встроенную энергетическую подстанцию мощностью 3,5 МВт. Общая площадь дата-центра составляет 500 м2. Внутри здания хостинг-центра размещены системы видеонаблюдения и записи изображения, пожарной и охранной сигнализации, поддержки климата и системы бесперебойного питания, обеспечивающие бесперебойную работу более 130 серверных шкафов, размещенных в 4 серверных залах, где предоставляются услуги ЦОД. «Миран-1» — первый коммерческий хостинг-центр в Северо-Западном регионе, прошедший сертификацию по стандарту PCI DSS.

Дата центр в Санкт-Петербурге — услуги ЦОД

Электроснабжение ЦОД осуществляется от собственной трансформаторной подстанции с двумя независимыми трансформаторами, подключенной к городским электрическим сетям распределения собственными высоковольтными кабелями. Главный распределительный щит объекта (производства ABB) выполнен с применением устройства автоматического ввода резерва на моторизованных автоматах.

Система бесперебойного электроснабжения дата-центра построена с применением четырех источников бесперебойного питания General Electric мощностью 250кВА каждый, с учетом резервирования всех компонентов источника, коммутационных аппаратов и питающих линий по схеме N+1. Время работы дата-центра на ИБП не менее 8 минут при полной нагрузке, включая систему охлаждения.

Первую особую категорию электропитания объекта, обеспечивает резервный источник питания – дизель-генераторная установка AC-703 AKSA POWER GENERATION/Cummins в зимнем исполнении. ДГУ эксплуатируется в режиме «горячего резерва», постоянно поддерживается оптимальный заряд стартовых аккумуляторов, а также обеспечивается подогрев масла в картере и охлаждающей жидкости в любое время года. Время выхода дизель-генераторной установки на рабочий режим не превышает 30 секунд, переключение вводов осуществляется в автоматическом режиме. Гарантированное время работы ДГУ без дополнительной заправки составляет 8 часов. Наличие дополнительной ёмкости топлива увеличивает время непрерывной работы в 2 раза.

ДГУ эксплуатируется в режиме «горячего резерва», постоянно поддерживается оптимальный заряд стартовых аккумуляторов, а также обеспечивается подогрев масла в картере и охлаждающей жидкости в любое время года. Время выхода дизель-генераторной установки на рабочий режим не превышает 30 секунд, переключение вводов осуществляется в автоматическом режиме. Гарантированное время работы ДГУ без дополнительной заправки составляет 8 часов. Наличие дополнительной ёмкости топлива увеличивает время непрерывной работы в 2 раза.

Каждый серверный шкаф запитан от двух независимых контуров электропитания, что позволяет подключить серверное оборудование с двумя блоками питания. Стандартное подключение при размещении серверов в ДЦ обеспечивается разъемом C13 (UPS), но, по техническому заданию клиента шкаф может быть оснащен разъемами C19.

Для подключения оборудования связи с питанием 48В постоянного тока предусмотрена выделенная электропитающая установка (ЭПУ) со встроенными аккумуляторами обеспечивающими до 9 часов автономной работы.

Дата центр, датацентр, дата центры Москва

Дата-центр – это сложное инженерное сооружение. Сегодня мы устроим виртуальную экскурсию по одному из дата-центров МногоБайт – дата-центру Sky-DC. Покажем вам, в том числе, те помещения, куда клиентам попасть нельзя. Комплексный подход в решении сложных задач позволяет нам с уверенностью сказать, что наши дата-центры – достойный выбор для ваших интернет проектов. Посмотрите сами:Электропитание

Электропитание всего оборудования дата-центра осуществляется от двух собсвенных трансформаторов 10кВ Трансформаторы запитаны от вводов от городской сетиС трансформаторов электропитание поступает на АВР — автомат ввода резерва После АВР, распределяющего питание с фидеров, стоит ещё один АВР, обеспечивающий передачу напряжения на распределительный щит по двум независимым лучам внутри здания (для избыточного резервирования)

Для обеспечения непрерывного элекропитания у нас установлено две (N+1) дизель-генераторные установки (ДГУ) FG Wilson Они находятся в теплом помещении и всегда готовы к работе.

При пропадании электропитания от города, через 30 секунд стартует одна из ДГУ

При пропадании электропитания от города, через 30 секунд стартует одна из ДГУ В отдельном помещении размещены распределительные электрические щиты и источники бесперебойного питания (ИБП) ИБП APC Galaxy 5000, от которых запитывается весь дата-центр, включены по схеме N+1

Электричество от города и от ДГУ подаётся на ИБП, а затем в дата-центр. Всё оборудование дата-центра работает через ИБП 100% времени При последней проверке и тестировании мы убедились, что время работы от батарей составляет более 15 минут при полной нагрузке

Внутри дата-центра установлены два щита гарантированного питания с автоматами защиты. Каждая стойка запитана от двух щитов Щит управления питанием кондиционеров дополнительно закрыт. Доступ к нему имеет только авторизованный персонал

Пожаротушение

Мы используем газовую систему пожаротушения во всех помещениях дата-центра (серверный зал, помещение ДГУ и помещение ИБП) Баллоны с газом находятся в подвешенном состоянии на специальных весах и, если вес баллона изменится, его статус в системе сразу поменяетсяТрубопроводы от системы пожаротушения находятся над каждым рядом стоек, как и противопожарные датчики Когда в серверном зале с оборудованием работают инженеры, автоматика пожаротушения отключаются для их безопасности

Контроль и автоматизация

Информация со всех инженерных систем дата-центра (охлаждение, электропитание, автоматика ДГУ и ИБП, пожаротушение. ..) сводится на пульт к дежурному

Сюда же выведена картинка с камер наблюдения и охранная система

..) сводится на пульт к дежурному

Сюда же выведена картинка с камер наблюдения и охранная системаОхлаждение

Ряд кондиционеров Uniflair Leonardo Evolution холодопроизводительностью 80кВт каждый. Кондиционеры подключены по схеме N+1 Охлажденный воздух подается к оборудованию через фальш-пол. На входе в оборудование мы поддерживаем комфортную температуру 20 +/-2 градуса по ЦельсиюМашинный зал дата-центра

Общий вид дата-центра Холодный коридор. Для размещения серверного оборудования мы используем 42U стойки производства английской компании Cannon Technologies

Это горячий коридор и два ряда стоек. Сверху проходят кабельные лотки и трубы системы газового пожаротушения Для размещения телекоммуникационного и кроссового оборудования используются удобные стойки 42U размером 800х1000мм другой английской фирмы – DataRacks

Стойки с двухпроцессорными серверами HP SL 230Gen8, которые вы можете арендовать у нас на сайте Стойки с colocation

Сетевая инфраструктура

В отдельном зале установлены коммутационные стойки, куда приходит несколько оптических кабелей из города, а также располагается оптическая коммутация внутри дата-центра В кроссовой стойке сосредоточено 384 оптических порта и предусмотрено место еще под 768 оптических портов

В качестве core-роутера мы используем Juniper MX960 3D, а для подключения клиентов на скорости 10Гбит/сек — коммутаторы Juniper серии EX Внутри дата-центров используются как 10Гбит/сек порты, так и 40Гбит/сек

В MX960 установлены новейшие коммутационные матрицы SCBE2-MX.

Благодаря ним мы можем маршрутизировать до 400Гбит/сек трафика на каждый слот роутера

Как видно, в роутере 11 слотов, то есть, максимум роутер справится с 4,4Тбит/сек трафика дата-центра

Благодаря ним мы можем маршрутизировать до 400Гбит/сек трафика на каждый слот роутера

Как видно, в роутере 11 слотов, то есть, максимум роутер справится с 4,4Тбит/сек трафика дата-центра Подключения на скоростях до 1Гбит/сек организовываются по «витой паре». Для этого каждая стойка соединена с коммутационной стойкой отдельной патч-панелью. Все кабели имеют индивидуальную маркировку Над стойками проходят распределительные слаботочные лотки для укладки оптических и медных кабелей

Клиентская комната

Для работы со своим оборудованием клиентам дата-центра предоставляется удобное оборудованое рабочее место в клиентской комнате Доступ в клиентскую комнату предоставляется круглосуточно по предварительной заявке

Дата-центр

Компания «Комлинк Телеком» предлагает вам свои услуги дата-центра: размещение абонентских серверов, аренду выделенных серверов и обслуживание ваших серверов, размещенных в нашем дата-центре. Дата-центр компании «Комлинк Телеком» — специализированное защищенное помещение, которое оборудовано:

Системой гарантированного электропитания

- Дата-центр подключен по 2-й категории электропитания к городским сетям распределения электроэнергии собственными кабелями.

- Система бесперебойного электроснабжения ЦОД построена с применением источников бесперебойного питания APC суммарной мощностью 50кВА, с учетом резервирования всех компонентов источника, коммутационных аппаратов и питающих линий по схеме N+1.

- Каждый серверный шкаф запитан от двух независимых контуров электропитания, что позволяет подключить серверное оборудование с двумя блоками питания.

Системой поддержки климата

- Система охлаждения серверных залов в дата-центре спроектирована с учетом резервирования компонентов N+1.

- Кондиционирование основного серверного зала выполнено на кондиционерах Mitsubishi Electric.

Структурированной кабельной сетью

- Универсальная высокоскоростная СКС построена на основе волоконно-оптических кабелей ОМ3 и медных кабелей UTP категории 5Е, что позволяет организовывать различные варианты построения вычислительных сетей в пределах дата-центра.

Системами безопасности

- Система видеонаблюдения обеспечивает запись движения и фиксирует изображение.

- Система контроля доступа и протоколирования событий позволяет гибко разграничить доступ сотрудников и клиентов в различные помещения дата-центра.

- Охранно-пожарная сигнализация.

Связью

- Дата-центр оснащен высокоскоростными каналами связи по собственным волоконно-оптическим линиям до точек обмена трафиком на Большой Морской ул.18, Боровой ул.57.

- Подключение серверов производится на скоростях до 1 Гбит/с.

Более подробную информацию вы можете получить в отделе корпоративных продаж или отделе обслуживания по телефону (812) 407-8-407

Франкфурт будет регулировать центры обработки данных

Франкфурт предложил план развития, призванный обеспечить рост центров обработки данных, не потребляя слишком много ресурсов в городе.

Поскольку центры обработки данных занимают 64 гектара (640 000 кв. М) во Франкфурте, в отчете местного магистрата на веб-сайте города предлагается, чтобы они были выше, чтобы занимать меньше места, а также использовать отходящее тепло, чтобы решить проблему потребление энергии.

Прочтите наше Дополнение по устойчивому развитию центров обработки данных

Хорошие соседи

Франкфурт — один из четырех крупнейших центров обработки данных в Европе (рынки FLAP — Франкфурт, Лондон, Амстердам и Париж), и предложения города имеют схожие черты. к тем, которые были приняты Амстердамом после годичного моратория на строительство нового центра обработки данных.Оба города заявили, что хотят найти баланс между получением экономических выгод от процветающей индустрии центров обработки данных и одновременным обеспечением того, чтобы она не потребляла слишком много места или ресурсов.

«Франкфурт является центром индустрии центров обработки данных в Германии, отчасти из-за спроса на быстрые данные со стороны сильной финансовой индустрии Франкфурта, а отчасти потому, что он является домом для одной из крупнейших точек обмена интернет-трафиком в мире: около тысячи международные сети сходятся в DE-CIX », — отмечают в статье Анна-Лена Кемпф и Лара-Кристина Виллемс из юридической фирмы Pinsent Masons.

В регионе более 60 колокационных площадок, и городским властям известно о многих других. Согласно сайту города Франкфурта: «Магистрату известно о нескольких проектах, находящихся на разных стадиях планирования и развития на следующие несколько лет с общей площадью еще около 27 гектаров, которые сосредоточены на предыдущих кластерах (например, Friesstrasse, Wilhelm-Fay-Strasse, Weismüllerstrasse), но также и в новых ключевых точках, таких как район Neckermann или в других промышленных зонах.«

Муниципалитет отмечает, что усиление оцифровки во время пандемии Covid-19 ускорило рост центров обработки данных с появлением новых кластеров по всему городу. Потребность в локальной обработке данных для обеспечения конфиденциальности также стимулировала развитие сектора.

Центры обработки данных Ожидается, что в будущем они вырастут в высоту, и все чаще они будут строиться в новых зданиях, а не в переоборудованных зданиях. «В то время как в 1990-х годах промышленность в основном осваивалась в существующих зданиях, особенно в офисных и логистических зданиях, вскоре были построены специализированные здания для соответствующего использования», говорит магистрат. «Функциональная архитектура высотой от 30 до 40 м, вытекающая из требований экономической эффективности и сертификации, недостаточно учитывает компонент городского планирования».

«Функциональная архитектура высотой от 30 до 40 м, вытекающая из требований экономической эффективности и сертификации, недостаточно учитывает компонент городского планирования».

Судья отмечает, что новым центрам обработки данных требуется много электроэнергии, обычно более 10 МВт подключенной нагрузки, а иногда и более 100 МВт. «Такая подключаемая нагрузка не может быть реализована повсеместно в городе. Помимо прочего, специальные подстанции для систем финансируются и строятся операторами.«

Но центры обработки данных, потребляющие столько энергии, ставят город под угрозу невыполнения своих климатических целей, поэтому магистрат просит отрасль найти способы экономии энергии, предполагая, что повторное использование отработанного тепла может несколько компенсировать потребность в электроэнергии.

« полученное отработанное тепло до сих пор выбрасывалось без дальнейшего использования «, — говорит судья, но предупреждает, что потребители этого отработанного тепла еще не ясны, а уровень температуры от 30 ° C до 40 ° C слишком низкий для сетей централизованного теплоснабжения. .В Скандинавии отработанное тепло центров обработки данных можно повысить с помощью электрических тепловых насосов. но «из-за высоких цен на энергоносители в Германии» во Франкфурте это неэкономично. «Соответственно, изучаются возможности использования отработанного тепла как в прежних, так и в будущих местах».

.В Скандинавии отработанное тепло центров обработки данных можно повысить с помощью электрических тепловых насосов. но «из-за высоких цен на энергоносители в Германии» во Франкфурте это неэкономично. «Соответственно, изучаются возможности использования отработанного тепла как в прежних, так и в будущих местах».

VMware назвала ветерана компании Рагху Рагурама своим следующим генеральным директором

ПравлениеVMware выбрало следующего генерального директора компании. Это будет Рагху Рагурам, в настоящее время исполнительный вице-президент и главный операционный директор центра разработки программного обеспечения.

Санджай Пунен, который, как сообщается, также боролся за первое место и которого несколько аналитиков считали очевидным выбором, покидает VMware, очевидно, из-за решения совета директоров. VMware объявила о его уходе и назначении Рагурама в том же пресс-релизе.

Связано: VMware Packages All Things VMware Cloud as Cloud Universal, подписка на услугу

1 июня Рагурам заменит Зейна Роу, финансового директора VMware, который исполнял обязанности главного исполнительного директора с тех пор, как Пэт Гелсингер покинул эту должность в феврале. встать у руля Intel.

встать у руля Intel.

Рагурам пришел в VMware в качестве директора по управлению продуктами в 2003 году и поднялся по карьерной лестнице до своей нынешней должности главного операционного директора по продуктам и облачным сервисам. Пунен присоединился к компании на десять лет позже, чем Рагурам, после семи лет работы в SAP, в том числе около четырех лет в качестве президента и корпоративного директора.

Связано: Nutanix и VMware, созданные как партнеры. Теперь они горькие соперники

«Я тепло поздравляю Рагху с повышением до генерального директора и знаю, что он выведет компанию на новый уровень», — говорится в заявлении Пунена.«Я буду радоваться успеху компании, когда начну свое следующее приключение».

Новый генеральный директор вступает в должность, поскольку VMware готовится к отделению от Dell Technologies, своей материнской компании примерно на пять лет. Он берет на себя ответственность за компанию, которая до сих пор успешно справлялась с масштабными отраслевыми сдвигами, которые имели все возможности оставить ее позади, как это сделали другие крупные поставщики корпоративных ИТ-технологий.

VMware использовала свои сильные инженерные возможности и присутствие своего программного обеспечения для виртуализации в большинстве корпоративных центров обработки данных, чтобы обеспечить себе роль связующего звена, связывающего собственную вычислительную инфраструктуру компаний с их общедоступными облачными ресурсами (в том числе на нескольких основных облачных платформах). .

Он также использовал те же самые сильные стороны, чтобы сформулировать и реализовать видение по превращению Kubernetes, крупнейшего события, произошедшего в корпоративных ИТ со времен облачных вычислений, неотъемлемой частью своей гибридной и мультиоблачной платформы.

VMware теперь работает над тем, чтобы представить все свои продукты в виде услуг на основе подписки — еще одна важная тенденция.

В своем заявлении Рагурам указал, что у него нет ближайших планов по существенному изменению текущего курса VMware. «У нас есть огромные возможности, у нас есть правильные решения, правильная команда, и мы продолжим работать с целеустремленностью, энтузиазмом и гибкостью», — сказал он.

В предварительных финансовых результатах, включенных в объявление, VMware заявила, что ожидает выручки в размере 2,99 миллиарда долларов за последний завершенный финансовый квартал, что почти на 10 процентов больше, чем в прошлом году.

Final Fantasy 14 добавляет новый дата-центр Oceania

ИгрокамFinal Fantasy 14 в Австралии и Новой Зеландии скоро не придется беспокоиться о сессиях с задержками, которые происходят с подключением в Северной Америке или Японии.

После раскрытия даты выхода Final Fantasy 14: Endwalker предполагалось, что программный доклад Final Fantasy 14 Digital Fan Festival будет завершен. Однако продюсер и режиссер FF14 Наоки Йошида приготовил еще одну хорошую новость для игроков со всего мира, особенно для тех, кто живет в Австралии и Новой Зеландии. Final Fantasy 14 будет стремиться добавить совершенно новый центр обработки данных, в котором будут размещаться игроки из региона Океании.

Йошида привел в пример сильное отставание, которое испытывали игроки из Океании при попытке сыграть в Final Fantasy 14 Online.К удивлению этих пользователей он объявил, что у них появится собственный центр обработки данных. Это будет дата-центр Final Fantasy 14 Online, который присоединится к центрам в Северной Америке, Европе и Японии. Центр обработки данных в Океании создается, чтобы предоставить игрокам из Австралии и Новой Зеландии более надежный сервер, а также снизить нагрузку на центры обработки данных в Северной Америке и Японии. Игроки из Северной Америки и Японии теперь в идеале должны иметь более дружелюбный онлайн-опыт.

Объявление о создании центра обработки данных в Океании завершило пространный доклад Йошиды. Он затронул несколько тем, в основном связанных с грядущим расширением Final Fantasy 14: Endwalker. Это включало новую работу, новые исследуемые регионы, новую расу, новые подробности истории и официальную дату выпуска.

Ожидается, что сервер данных Океании будет подключен к сети после запуска обновления Final Fantasy 14 6. 0 и расширения Endwalker, которые должны появиться 23 ноября.Это не конец Final Fantasy 14 Online в эти выходные. На оставшуюся часть Фестиваля цифровых фанатов Final Fantasy 14 запланированы два полных дня веселья FF14, включая новую информацию о дорожной карте между обновлениями 5.5 и 6.0, которые будут раскрыты в эту субботу. Держите его в Shacknews, так как у нас будет больше информации о Final Fantasy 14: Endwalker, когда она появится.

0 и расширения Endwalker, которые должны появиться 23 ноября.Это не конец Final Fantasy 14 Online в эти выходные. На оставшуюся часть Фестиваля цифровых фанатов Final Fantasy 14 запланированы два полных дня веселья FF14, включая новую информацию о дорожной карте между обновлениями 5.5 и 6.0, которые будут раскрыты в эту субботу. Держите его в Shacknews, так как у нас будет больше информации о Final Fantasy 14: Endwalker, когда она появится.

Оззи играет в видеоигры с тех пор, как в 5 лет взял в руки свой первый контроллер NES. С тех пор он увлекается играми, лишь ненадолго отстраняясь от него во время учебы в колледже.Но он вернулся после того, как провел годы в кругах QA и в THQ, и в Activision, в основном проводя время, помогая продвигать серию Guitar Hero на ее пике. Оззи стал большим поклонником платформеров, головоломок, шутеров и ролевых игр, если назвать несколько жанров, но он также большой любитель всего, за чем стоит хорошее, убедительное повествование. Что такое видеоигры, если вы не можете насладиться хорошей историей со свежей вишневой колой?

Nokia развертывает решение для коммутации центров обработки данных, чтобы подготовить OpenColo к растущим услугам колокации

Пресс-релиз

Nokia развертывает решение для коммутации центров обработки данных, чтобы подготовить OpenColo к растущим услугам колокации

Решение предоставляет OpenColo масштабируемое оборудование для коммутации центров обработки данных и открытая, программируемая NOS с набором инструментов NetOps

Позволяет OpenColo удовлетворять быстро растущие потребности клиентов и поддерживать будущие услуги 5G, AI и IoT

Nokia также развертывает свои IP и оптические решения для пиринга в Интернете и соединения центров обработки данных

13 мая 2021 г.

Эспоо, Финляндия — Nokia сегодня объявила о поставке маршрутизатора 7220 Interconnect Router (IXR) для платформ коммутации центров обработки данных и SR Linux, своей сетевой операционной системы (NOS), OpenColo, международному провайдеру колокации. .Развертывание решения Nokia дает OpenColo масштабируемую коммутацию центров обработки данных, необходимую для поддержки растущих операций по размещению и хостингу для поддержки будущих услуг 5G, AI и IoT.

Решение Nokia для коммутации центров обработки данных включает SR Linux, открытую ОС на базе Linux и набор инструментов разработки NetOps, который помогает автоматизировать операции сети центра обработки данных для повышения операционной эффективности при одновременном снижении рисков. Услуги, которые OpenColo поддерживает с помощью решения коммутации центров обработки данных Nokia, включают в себя «голые» и управляемые серверы, потоковую передачу данных в облаке и возможность подключения к центрам обработки данных.

OpenColo также использует коммутатор фотонных служб Nokia 1830 Photonic Service Switch (PSS) для соединения своих центров обработки данных с помощью двойных оптоволоконных соединений со скоростью 100 Гбит / с. OpenColo также установила сервисный маршрутизатор (SR) Nokia 7750, основанный на микросхеме Nokia FP4, для обеспечения IP-маршрутизации внутри и между своими центрами обработки данных, включая пиринг и соединение с несколькими поставщиками услуг.

SR Linux и 7750 SR используют одни и те же проверенные протоколы маршрутизации из операционной системы Nokia Service Router (SR OS).Это позволяет OpenColo предлагать своим клиентам более надежную и стабильную коммутацию центров обработки данных и подключение к Интернету, а также возможность обрабатывать будущие потребности центров обработки данных и пирингового трафика.

Скотт Брукшир, технический директор Energy Group Networks, материнской компании OpenColo, сказал: «Nokia и ее SR Linux были легким выбором. Нам нужно было расширяемое, открытое решение с поддержкой телеметрии и gNMI, которое было предоставлено компанией, которая преобразует сети как с аппаратной, так и с программной стороны.Более того, нам нужен партнер, который понимает наши потребности и может очень тесно сотрудничать с нами, чтобы переосмыслить нашу архитектуру и решить некоторые из наших самых больших проблем. Мы также ценили то, что Nokia создает и поддерживает свое оборудование, поэтому у нас есть единый поставщик, с которым мы можем работать и работать, если у нас когда-либо возникнут проблемы ».

Нам нужно было расширяемое, открытое решение с поддержкой телеметрии и gNMI, которое было предоставлено компанией, которая преобразует сети как с аппаратной, так и с программной стороны.Более того, нам нужен партнер, который понимает наши потребности и может очень тесно сотрудничать с нами, чтобы переосмыслить нашу архитектуру и решить некоторые из наших самых больших проблем. Мы также ценили то, что Nokia создает и поддерживает свое оборудование, поэтому у нас есть единый поставщик, с которым мы можем работать и работать, если у нас когда-либо возникнут проблемы ».

История продолжается

Стив Фогелсанг, технический директор и руководитель отдела стратегии Nokia в области IP и оптики, сказал: «Поставщикам услуг хостинга и колокации для центров обработки данных все чаще требуются открытые решения для коммутации центров обработки данных, которые масштабируются для поддержки растущих потребностей бизнеса и легко интегрируются в них. их существующие операции центра обработки данных. Кроме того, им нужна максимальная пропускная способность и стабильность сетей, чтобы предоставлять клиентам самые надежные услуги. Коммутационные, IP- и оптические возможности Nokia в центрах обработки данных обеспечивают инфраструктуру центра обработки данных OpenColo и обеспечивают сквозную пропускную способность, производительность и надежность, от которых зависят клиенты OpenColo, и которые необходимы для будущих услуг, таких как 5G, IoT и AI ».

Кроме того, им нужна максимальная пропускная способность и стабильность сетей, чтобы предоставлять клиентам самые надежные услуги. Коммутационные, IP- и оптические возможности Nokia в центрах обработки данных обеспечивают инфраструктуру центра обработки данных OpenColo и обеспечивают сквозную пропускную способность, производительность и надежность, от которых зависят клиенты OpenColo, и которые необходимы для будущих услуг, таких как 5G, IoT и AI ».

Ресурсы

Об OpenColo

OpenColo — это современный центр обработки данных площадью 71 000 квадратных футов в Санта-Кларе, Калифорния, специально спроектированный и управляемый Energy Group Networks (EGN).С 2003 года EGN предоставляет превосходные, экономичные и ориентированные на клиента услуги по выделению серверов и колокации.

OpenColo — это независимый от оператора связи объект, который также предлагает сочетание собственной полосы пропускания с надежной защитой от DDOS и несколькими подключениями 100G нескольким вышестоящим провайдерам для внутреннего и международного трафика. Для большего спокойствия в здании круглосуточно и без выходных работают техники центра обработки данных.

Для большего спокойствия в здании круглосуточно и без выходных работают техники центра обработки данных.

На объекте OpenColo EGN реализовала систему подачи питания на шину для нестандартных конфигураций питания и более быстрого обновления питания, охлаждения N + 1 и резервирования питания 2N, чтобы дополнить SLA 100% времени безотказной работы.

О Nokia

Мы создаем технологии, которые помогают миру действовать сообща.

Как надежный партнер для критически важных сетей, мы стремимся к инновациям и лидерству в технологиях в мобильных, фиксированных и облачных сетях. Мы создаем ценность с помощью интеллектуальной собственности и долгосрочных исследований, проводимых отмеченной наградами лабораторией Nokia Bell Labs.

Придерживаясь высочайших стандартов целостности и безопасности, мы помогаем создавать возможности, необходимые для более продуктивного, устойчивого и открытого для всех мира.

Linux

Зарегистрированный товарный знак Linux® используется в соответствии с сублицензией от Linux Foundation, эксклюзивного лицензиата Линуса Торвальдса, владельца знака во всем мире.

Запросы СМИ:

Nokia

Связь

Телефон: +358 10 448 4900

Электронная почта: [email protected]

План бомбардировок AWS вновь ставит акцент на физической безопасности центра обработки данных

Этот относительно хаотичный период заставил операторов центров обработки данных все больше беспокоиться о физической безопасности своих объектов.Это было правдой даже до того, как ФБР объявило о взрыве в центре обработки данных AWS, которое оно сорвало, арестовав предполагаемого будущего террориста.

Неясно, ведет ли их нынешнее чувство беспокойства операторов к каким-либо действиям. Понятно, что большинство из тех, с кем мы говорили, умалчивают о каких-либо конкретных мерах предосторожности, которые они, возможно, принимали помимо стандартных передовых методов безопасности.

Связано: Помешанный план взрыва центра обработки данных AWS вызывает новые вопросы для операторов

«Центры обработки данных всегда были чем-то вне поля зрения и из виду, но сегодня это не так», — Фред Бертон, бывший специалист по борьбе с терроризмом — сказал заместитель начальника и спецагент Службы дипломатической безопасности США. «Вы можете совершить потрясающее кибер-преследование».

«Вы можете совершить потрясающее кибер-преследование».

Бертон в настоящее время является исполнительным директором Ontic Center for Protective Intelligence, который предоставляет программную платформу, которая передает данные о физических угрозах группам безопасности организаций.

Связано: Персонал центра обработки данных AWS в режиме повышенной готовности после того, как компания отключила Parler

Руководитель отдела операций центра обработки данных с одним из крупнейших провайдеров колокации в США, который разговаривал с DCK на условиях анонимности, сказал, что запросы клиентов по поводу процессы безопасности компании после пандемии и инцидента с AWS повысились.

«Каждый раз, когда у вас есть какие-либо из этих национальных мероприятий для прессы, это вызывает повышенное внимание наших клиентов», — сказал он. «Это серьезная проблема для нашей клиентской базы».

Но компания не внесла никаких изменений в ответ. «Это просто подкрепляет нашу практику и работу, которую мы уже проделали по проектированию и эксплуатации, по непрерывному бурению, а также по отношениям, которые мы поддерживаем с местными и национальными правоохранительными органами», — сказал он.

Старший технический директор того же провайдера колокации, который также говорил на условиях анонимности, сказал, что безопасность сайта всегда была фактором при выборе места для новых центров обработки данных.

«Так было уже несколько десятилетий», — сказал он. «Это одна из вещей, на которую мы обращаем внимание при выборе сайта», помимо бизнес-потребностей, сетей и инфраструктуры электроснабжения.

Пандемия, социальные беспорядки и рост экономики

Более 70 процентов руководителей службы безопасности и лиц, принимающих решения в области физической безопасности, недавно опрошенных Ontic (размер выборки: 300), заявили, что с начала 2020 года активность физических угроз «резко возросла». Более трети респондентов заявили, что физическая защита предприятий данные были их самой большой проблемой безопасности, и примерно такой же процент заявили, что они обеспокоены сокращением штата сотрудников службы безопасности из-за экономики.

Тем не менее, 80 процентов заявили, что ожидают увеличения своего бюджета на физическую безопасность в этом году, большинство из них приписывают увеличение, по крайней мере, частично, пандемии. Помимо пандемии, были опасения, связанные с политическими волнениями, как из-за активизма за расовую справедливость, так и из-за протестов и нападений ультраправых.

Помимо пандемии, были опасения, связанные с политическими волнениями, как из-за активизма за расовую справедливость, так и из-за протестов и нападений ультраправых.

Чуть менее трети заявили, что растущее количество физических угроз и негативная реакция компаний, вызванная политическими волнениями, не давали им спать по ночам — до того, как появились новости о заговоре о взрыве в центре обработки данных AWS.

Даже если центр обработки данных не является политической целью, нынешний экономический кризис может усугубить регулярные угрозы физической безопасности, сказал Бертон DCK.

Ранее в этом месяце уволенный сотрудник службы безопасности в центре обработки данных Microsoft в Шайенне, штат Вайоминг, вернулся на объект с оружием. Сотрудникам было приказано спрятаться, и в конце концов они покинули здание. Бандит был арестован.

Burton советует менеджерам по безопасности центров обработки данных использовать этот момент повышенного беспокойства как возможность проверить физическую безопасность на своих объектах. «Вы хотите убедиться, что у вас хорошая физическая безопасность и вы активно ищите угрозы, которые могут повлиять на ваши объекты», — сказал он.

«Вы хотите убедиться, что у вас хорошая физическая безопасность и вы активно ищите угрозы, которые могут повлиять на ваши объекты», — сказал он.

Даже те, кто уже следует передовым практикам, могут найти способы стать более эффективными и наладить связь с такими группами, как InfraGard ФБР. Также разумно обратиться в местные правоохранительные органы.

«Вы можете попросить их об усиленном патрулировании вокруг ваших объектов», — сказал Бертон. «В зависимости от загруженности [полиции] в некоторых городах это может быть невозможно, но по моему опыту, если вы идете к ним и просите о помощи, вы, как правило, получаете эту помощь.И убедитесь, что вы используете локализованные репортажи об общих преступлениях и хаосе ».

По его словам, план взрыва центра обработки данных AWS является напоминанием об уязвимостях в секторе центров обработки данных.

«За свою карьеру я, к сожалению, испытал кровавую бойню, которая может быть вызвана, и это был тот инцидент, в котором вы хотели бы участвовать, наклонившись вперед», — сказал он. «Выявление информации об угрозах — тяжелая работа, и нейтрализация заговоров до того, как они начнутся, — одна из самых больших проблем в этой сфере.Итак, ФБР отлично справилось с работой ».

«Выявление информации об угрозах — тяжелая работа, и нейтрализация заговоров до того, как они начнутся, — одна из самых больших проблем в этой сфере.Итак, ФБР отлично справилось с работой ».

Момент обучения

Широкий резонанс в этой истории может открыть окно возможностей для менеджеров по безопасности, чтобы убедить высшее руководство «финансировать безопасность должным образом», — предположил Лео Таддео, директор по информационной безопасности компании Cyxtera Technologies.

«Вы хотите убедиться, что у вас есть как можно больше физической безопасности, более крупные силы охраны, располагая объект подальше от зон, которые могут быть использованы для проведения атак», — сказал Таддео DCK.

«Индустрия центров обработки данных может извлечь уроки из других секторов, таких как нефтяная промышленность.Бурение и разведка нефти проводятся в некоторых нестабильных регионах мира ».

Политически мотивированный заговор взрыва центра обработки данных AWS представляет собой новую эскалацию угрозы, сказал он. «В данном случае очевиден аспект внутреннего терроризма. Я думаю, что это в новинку. Я не слышал о чем-то подобном раньше».

«В данном случае очевиден аспект внутреннего терроризма. Я думаю, что это в новинку. Я не слышал о чем-то подобном раньше».

Другие типы критически важной инфраструктуры ранее были объектами внутренних террористических атак, сказал он. «Центры обработки данных, которые все более и более тесно связаны с инфраструктурой [сегодня], делают их мишенью для внутреннего террориста», — сказал он.

Физическая безопасность — часть работы центра обработки данных

Все существующие основные принципы физической безопасности по-прежнему применяются.

«Вы должны иметь надлежащие процедуры и следить за их соблюдением», — сказал Таддео. «У вас должны быть связи с правоохранительными органами». Операторы центров обработки данных должны быть готовы к протестам, активным стрелкам и обычным преступникам в качестве стандартной практики.

Он отказался сообщить, вносит ли Cyxtera какие-либо изменения в методы обеспечения физической безопасности своих центров обработки данных. «Мы бы предпочли не говорить об этом», — сказал он. «Мы относимся к этому серьезно, мы привержены этому. Но детали — это то, что мы не хотели бы [обсуждать]».

«Мы бы предпочли не говорить об этом», — сказал он. «Мы относимся к этому серьезно, мы привержены этому. Но детали — это то, что мы не хотели бы [обсуждать]».

По крайней мере, в США физические атаки на центры обработки данных со стороны иностранных держав или внутренних террористов не были обычным явлением. «Национальное государство не будет рисковать физическим присутствием в США для проведения физической атаки, поэтому, к счастью, эти атаки ограничились кибератаками», — сказал он.

Flexential, крупный поставщик центров обработки данных в США, постоянно оценивает угрозы и при необходимости адаптирует все это в рамках своей регулярной программы управления рисками, сообщил DCK Дэвид Кидд, старший вице-президент по корпоративному управлению, рискам и соответствию требованиям.

«В рамках нашей программы управления рисками мы постоянно оцениваем потенциальные угрозы для нашей деятельности и при необходимости адаптируемся к ним», — сказал он. «У нас есть отличная команда профессионалов, нацеленная на обеспечение безопасности наших операций и защиту ИТ-инфраструктуры наших клиентов».

Инциденты, такие как план бомбардировки AWS, а также взрыв бомбы в автомобиле в центре Нэшвилла (ФБР опубликовало отчет об инциденте два месяца назад) — это типы разведки угроз, которые Flexential рассматривает при реагировании на текущие изменения в сфере безопасности , он сказал.

«Центры обработки данных Flexential спроектированы, построены и эксплуатируются для обеспечения высокой доступности и безопасности», — добавил Кидд. «Доступ к центру обработки данных тщательно контролируется в координации с нашими клиентами, чтобы обеспечить проверенный доступ к информационным системам клиентов. Доступ к критически важному пространству инфраструктуры дополнительно ограничен, чтобы поддержать наше стремление к безотказной работе. Чтобы реагировать на потенциальные угрозы, Flexential внедрила основанный на рисках, многоуровневая программа безопасности от периметра объекта внутрь до отдельных ИТ-систем.«

Другие крупные поставщики центров обработки данных, с которыми DCK связались для этой статьи, включая Equinix, Digital Realty, CyrusOne, Switch, Iron Mountain и TierPoint, среди прочих, либо отказались от комментариев, либо не ответили.

Compass | Решения от ядра до периферии Центры обработки данных Compass

| Решения от ядра до края Клиентский портал Наведите указатель мыши на наши кампусы, чтобы получить краткий обзорПослушайте последнюю новость о Центре обработки данных Not Your Father: Talking Quantum Computing with Dr.Боб

Дата-центры, готовые к подъезду на заказ

В Compass мы создаем индивидуальные центры обработки данных, готовые к переезду, которые нужны вам сегодня и в будущем. У нас есть возможность поддержать ваш рост и гибкость для удовлетворения ваших потребностей.

Почему клиенты выбирают компас

Опыт, который мы приобрели в проектировании и строительстве центров обработки данных по всему миру на сумму более 4 миллиардов долларов, позволяет нам увидеть, какие требования к центрам обработки данных предъявляются сейчас и в будущем.Наши устойчивые, масштабируемые и готовые к въезду проекты центров обработки данных адаптированы к вашим конкретным требованиям. Наша гибридная модель Colo предлагает вам гибкость и оперативный контроль.

Наша гибридная модель Colo предлагает вам гибкость и оперативный контроль.

Индивидуальные центры обработки данных, готовые к подъезду, все под вашим контролем

Адаптивность определяет дизайн нашего центра обработки данных, чтобы вы могли контролировать свой объект.

Локальные, удаленные и пограничные центры обработки данных

EdgePointCompass — это центр обработки данных, необходимый для поддержки ваших локальных, удаленных и периферийных требований.

Учить больше >Корпоративные центры обработки данных

Индивидуальные готовые к переезду решения компанииCompass представляют собой безопасную альтернативу общедоступному облаку или колокации.

Учить больше >Compass U Полезные сведения и ресурсы

УПРАВЛЕНИЕ СПРОСОМ

Поскольку понимание строительства зданий большинством людей, похоже, находится в одном ряду с ядерной физикой, например, ИТ-директора традиционно позволяли «другим людям в команде» заниматься деталями проектов строительства центров обработки данных своей компании. Однако из-за новых технологических разработок и методов строительства настало время для более активного участия.

Однако из-за новых технологических разработок и методов строительства настало время для более активного участия.

ИНТЕРВЬЮ DATACENTER HAWK

Генеральный директорCompass Крис Кросби и Дэйв рассказывают о будущем направлении развития Compass и индустрии центров обработки данных.

Читать далее >ИСКУССТВЕННЫЙ ИНТЕЛЛЕКТ В ЦЕНТРЕ ДАННЫХ

Для операторов центров обработки данных критически важно 100-процентное время безотказной работы.Глобальная зависимость от данных быстро растет, а сложность внедрения технологий в центре обработки данных растет в геометрической прогрессии. На сегодняшний день искусственный интеллект был реализован в центрах обработки данных с целью оптимизации энергопотребления, но теперь Compass Datacenters и Litbit открывают новые возможности для использования искусственного интеллекта с целью снижения риска простоев.

Учить больше >10 САМЫХ РАСПРОСТРАНЕННЫХ ОШИБОК ПРИ ОХЛАЖДЕНИИ

В среднем центре обработки данных на охлаждение приходится почти 40% энергопотребления площадки, поэтому правильные или неправильные действия могут иметь серьезные финансовые последствия. Поскольку все мы знаем, что «вас интересуют мелочи», в этом техническом документе рассматриваются наиболее распространенные ошибки охлаждения, совершаемые операторами центров обработки данных.

Поскольку все мы знаем, что «вас интересуют мелочи», в этом техническом документе рассматриваются наиболее распространенные ошибки охлаждения, совершаемые операторами центров обработки данных.

Авторские права 2021 ©. Compass Datacenters® — зарегистрированная торговая марка. Политика конфиденциальности | Карта сайта

Google открывает двери в свой сверхсекретный центр обработки данных

Но теперь мы переходим на пол. Большой не стал его описывать. Стойки для серверов, кажется, тянутся до бесконечности. Джо Монтана в расцвете сил не мог бросить мяч на всю длину.

Во время моих интервью с гуглерами идея горячих и холодных коридоров была абстракцией, но на полу все проясняется. Холодный коридор относится к общей температуре в помещении, которая, по утверждению Кава, составляет 77 градусов. Горячий коридор — это узкое пространство между задними сторонами двух рядов серверов, плотно закрытое с торцов листовым металлом. Гнездо из медных спиралей поглощает тепло. Выше огромные вентиляторы, которые звучат как реактивные двигатели, подключенные к усилителям Marshall.

Гнездо из медных спиралей поглощает тепло. Выше огромные вентиляторы, которые звучат как реактивные двигатели, подключенные к усилителям Marshall.

Огромные вентиляторы звучат как реактивные двигатели, подключенные к усилителям Marshall.

Проходим между серверными рядами. Все кабели и вилки находятся спереди, поэтому никому не нужно взламывать листовой металл и выходить в горячий коридор, превращаясь в мясо для барбекю. (Когда кому-то нужно вернуться туда, серверы отключаются.) На каждом сервере есть наклейка с кодом, который идентифицирует его точный адрес, что полезно, если что-то пойдет не так.Рядом с серверами толстые черные батареи. Все единообразно и на своих местах — ничего похожего на спагетти из давней эры Exodus от Google.

Синие огни мигают, показывая … что? Веб-поиск? Чье-то сообщение Gmail? Мероприятие в стеклянном календаре, плывущее перед глазами Сергея? Это могло быть что угодно.

Время от времени появляется рабочий — длинноволосый чувак в шортах, передвигающийся на самокате, или женщина в футболке, которая толкает тележку с ноутбуком наверху и распределяет запасные части на серверы, как психиатрическая медсестра. лекарства.(Фактически, место на полу, где находится запасное оборудование, называется аптекой.)

лекарства.(Фактически, место на полу, где находится запасное оборудование, называется аптекой.)

Сколько серверов использует Google? Этот вопрос не дает покоя наблюдателям с тех пор, как компания построила свой первый дата-центр. Давно прижилось «сотни тысяч». (В день моего визита на заводе в Ленуаре работают 49 923 человека.) Позже я найду подсказку, когда загляну в центр исследований и разработок центра обработки данных Google в Маунтин-Вью. В безопасном месте к стене прикреплен ряд материнских плат — это знак почета многих поколений домашних серверов Google.Один из них находится на крошечной табличке с тиснением, на которой написано «9 июля 2008 г.» — миллионный сервер Google. Но руководители объясняют, что это совокупное число, не обязательно свидетельствующее о том, что у Google одновременно работает миллион серверов.

Бродя по холодным проходам Ленуара, я понимаю, что магическое число, если оно вообще возможно, бессмысленно. Сегодняшние машины с многоядерными процессорами и другими достижениями во много раз превосходят по мощности и полезности более ранние версии. Один сервер Google около 2012 года может быть эквивалентом 20 серверов предыдущего поколения.В любом случае Google мыслит категориями кластеров — огромного количества машин, которые действуют вместе, чтобы предоставлять услугу или запускать приложение. «Отдельный сервер ничего не значит», — говорит Хёльцле. «Мы отслеживаем мощность компьютера как абстрактный показатель». Это реализация концепции Hölzle и Barroso, сформулированной три года назад: центр обработки данных как компьютер.

Один сервер Google около 2012 года может быть эквивалентом 20 серверов предыдущего поколения.В любом случае Google мыслит категориями кластеров — огромного количества машин, которые действуют вместе, чтобы предоставлять услугу или запускать приложение. «Отдельный сервер ничего не значит», — говорит Хёльцле. «Мы отслеживаем мощность компьютера как абстрактный показатель». Это реализация концепции Hölzle и Barroso, сформулированной три года назад: центр обработки данных как компьютер.

Когда мы покидаем зал, я чувствую себя почти взлетевшим, заглянув во внутреннее святилище Google. Но несколько недель спустя, вернувшись в Googleplex в Маунтин-Вью, я понимаю, что срок хранения моих прозрений ограничен.Намерение Google состоит в том, чтобы сделать центр обработки данных, который я посетил, устаревшим. «Как только наши люди привыкнут к нашим зданиям и кластерам 2013 года, — говорит Хёльцле, — они начнут жаловаться на нынешние».

Отвечая на вопрос, в каких областях можно ожидать изменений, Хёльцле упоминает дизайн центра обработки данных и кластера, скорость развертывания и гибкость. Затем он останавливается. «Это одна вещь, о которой я не могу говорить, — говорит он, и на его бородатом лице появляется улыбка, — потому что мы потратили свою кровь, пот и слезы.Я хочу, чтобы другие тратили свою кровь, пот и слезы, делая те же открытия ». Возможно, Google стремится предоставить доступ ко всем данным в мире, но некоторую информацию он все еще хранит при себе. [email protected]) взяла интервью у Мэри Микер в номере от 20.10.

Затем он останавливается. «Это одна вещь, о которой я не могу говорить, — говорит он, и на его бородатом лице появляется улыбка, — потому что мы потратили свою кровь, пот и слезы.Я хочу, чтобы другие тратили свою кровь, пот и слезы, делая те же открытия ». Возможно, Google стремится предоставить доступ ко всем данным в мире, но некоторую информацию он все еще хранит при себе. [email protected]) взяла интервью у Мэри Микер в номере от 20.10.

Подробнее: [] https://www.wired.com/wiredenterprise/2012/10/data-center-easter-eggs/) Вы заметили штурмовика в центре обработки данных Google?

Пять главных секретов центров обработки данных Google (которые все еще остаются в секрете)

Загадочное устройство Google появляется в маленьком городке, штат Айова

Если Xerox PARC изобрела компьютер, Google изобрела Интернет

Познакомьтесь с человеком, который обновляет Google из the Inside Out

Google, Amazon и Microsoft Swarm China для Network Gear

Супер-секретный Google создает серверы в темноте

Также в этом выпуске

.