обзор фильтров и алгоритмов Гугл

2309

| SEO | – Читать 25 минут |

Прочитать позже

Роман Андреев

ИП Андреев Роман Андреевич

Shop-Express

Контакт пользователя с интернетом происходит с помощью поисковой системы. Мы ищем информацию о товарах и услугах, которыми хотим воспользоваться, читаем статьи и откапываем информацию о людях, которые нам интересны.

В этой статье мы разберем упрощенные принципы работы поисковика, разберем его основные известные алгоритмы и фильтры. И главное — попробуем систематизировать. Что стоит и чего не стоит делать для того, чтобы попасть в топ выдачи.

Содержание

- Как работает поисковая система Google

- Фильтры Google как наказание за манипуляцию алгоритмами

- Современные и новые фильтры Гугла — YMYL, BERT, Speed Update, etc

- Неофициальные алгоритмы и фильтры Гугла

Выводы. Как не попасть под фильтр Гугла и расти в выдаче

Как не попасть под фильтр Гугла и расти в выдаче

По данным сайта Statcounter Global Stats доля Google в январе 2022 года составляла 91,9%. На втором месте идет Bing от Microsoft (в основном за счет предустановки своего браузера во все операционные системы Windows) и на третьем — Yahoo.

Исходя из этих цифр, если вы планируете продвигать собственный бизнес в Сети — вам необходимо разобраться с тем, как работает поисковая машина Google. Даже если ваша целевая аудитория находится в Рунете — доля Яндекса колеблется в районе 45–50% последние годы.

Как работает поисковая система Google

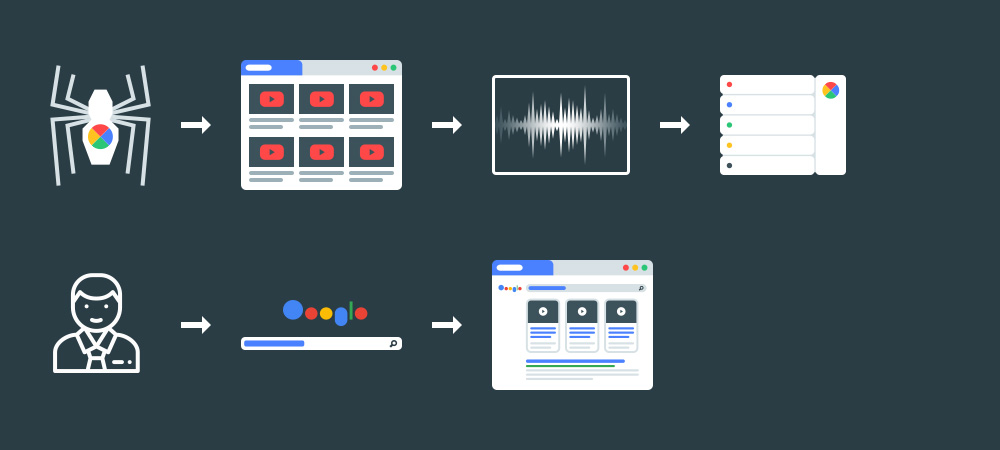

Чтобы разобраться, что такое алгоритмы и фильтры Google, нужно понять как работает поисковая машина. Принцип у всех поисковых систем схож, но сегодня будем разбирать самый крупный и популярный поисковик — Google.

Фактически Google это картотека, в которую вносятся сайты, и по запросу пользователя выдаются максимально релевантные. Те, что наиболее точно отвечают его запросу или были признаны максимально качественными. На пальцах процесс выглядит следующим образом:

Те, что наиболее точно отвечают его запросу или были признаны максимально качественными. На пальцах процесс выглядит следующим образом:

- Поисковый бот (googlebot) находит ваш сайт. Он может сделать это, перейдя по ссылке на другом, уже известном сайте, или при принудительном сканировании с вашей стороны. Для этого используют инструмент Search Console.

- Бот видит не динамическое изображение страницы, которые выводит браузер, но в первую очередь — код. Если вы хотите взглянуть на страницу как бот, попробуйте вбить в адресной строке браузера перед адресом сайта view—source:. Ранее такой инструмент был в Search Console, но с ростом количества сайтов его упростили до обычного запроса на сканирование.

- Далее Гугл Бот вносит ваш сайт в свой каталог, ассоциируя его с контентом, прописанным на сайте (об этом подробно чуть ниже).

- После каталогизации — поисковая машина оценивает качество вашего сайта в сравнении с конкурентами, смотрит на историю и качество домена, цитируемость (наличие ссылок), скорость загрузки и другие параметры.

- Если ваш сайт посчитался качественным, то при следующем запросе от пользователя он получит, в том числе, и ваш сайт в Google. Скорее всего — где-то на 20-30 странице.

При сканировании в картотеку, учитываются моменты, которые являются ключевыми для SEO :

- Title и Description страницы.

- Текстовый контент и ключевые слова в нем (фактически — почти каждый коммерческий сайт в интернете ранжируется по слову «Компания». Но релевантность 99% сайтов этому ключевому слову настолько низкая, что они не появляется в выдаче).

- Изображения и их описание — alt.

По такой схеме все сайты, открытые для индексации, вносятся в общую базу данных. Далее, чтобы именно ваш сайт показывался по нужным запросам в топ-10, нужно заниматься его оптимизацией.

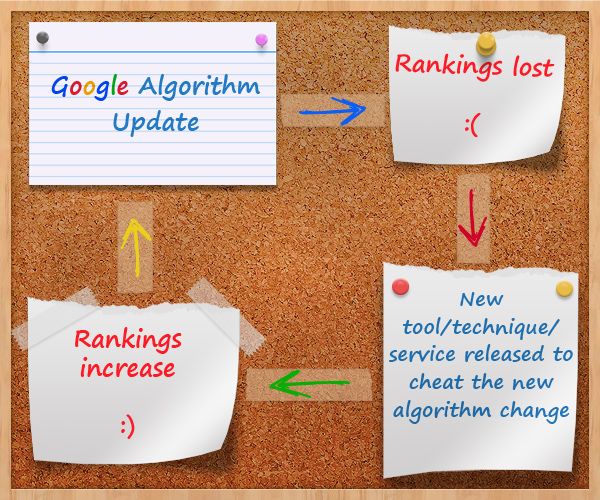

Поисковая оптимизация — это приведение сайта в соответствие поисковым алгоритмам. Иногда — манипуляция ими. Чтобы исключить вредные манипуляции, были придуманы фильтры Google, которые выбрасывают сайт из выдачи в случае несоответствия правилам.

Чтобы исключить вредные манипуляции, были придуманы фильтры Google, которые выбрасывают сайт из выдачи в случае несоответствия правилам.

Фильтры Google как наказание за манипуляцию алгоритмами

Поисковые алгоритмы это требования и рекомендации со стороны поисковой системы к сайтам. Они создаются для того, чтобы давать конечному пользователю — человеку, который вбивает поисковой запрос в строку — максимально качественный ответ на его вопрос. Чем меньше сайтов посетит пользователь в поисках ответа — тем качественнее работает поисковой механизм.

Фильтры же — это наказания за попытку манипулировать поисковой машиной. Так как фильтры накладываются за пренебрежение основными требованиями к сайту — разобрав основные мы поймем что требует поисковая система от владельца сайта.

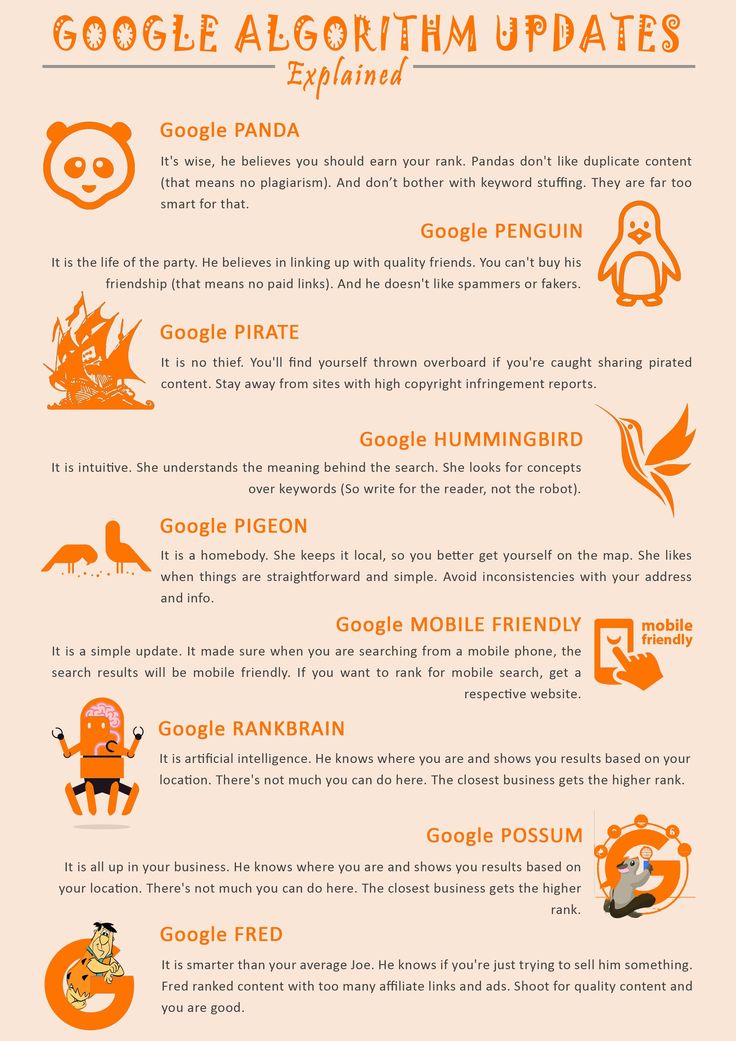

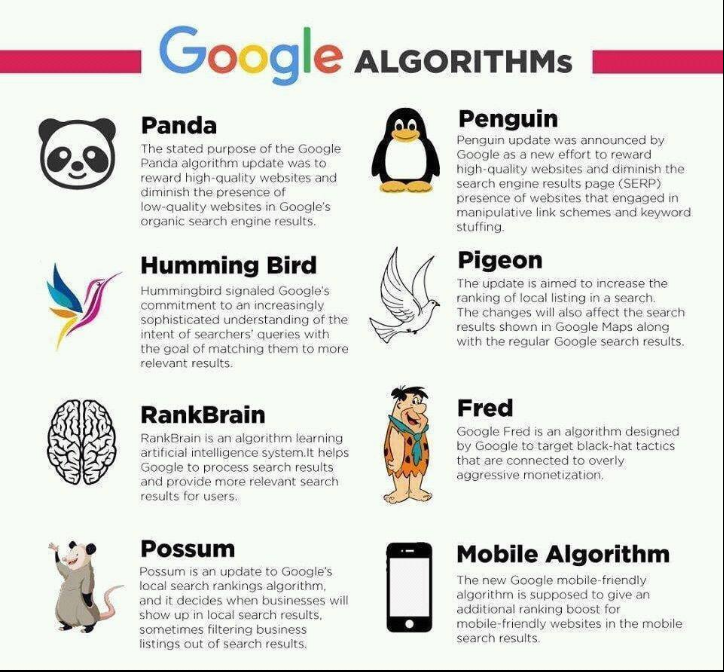

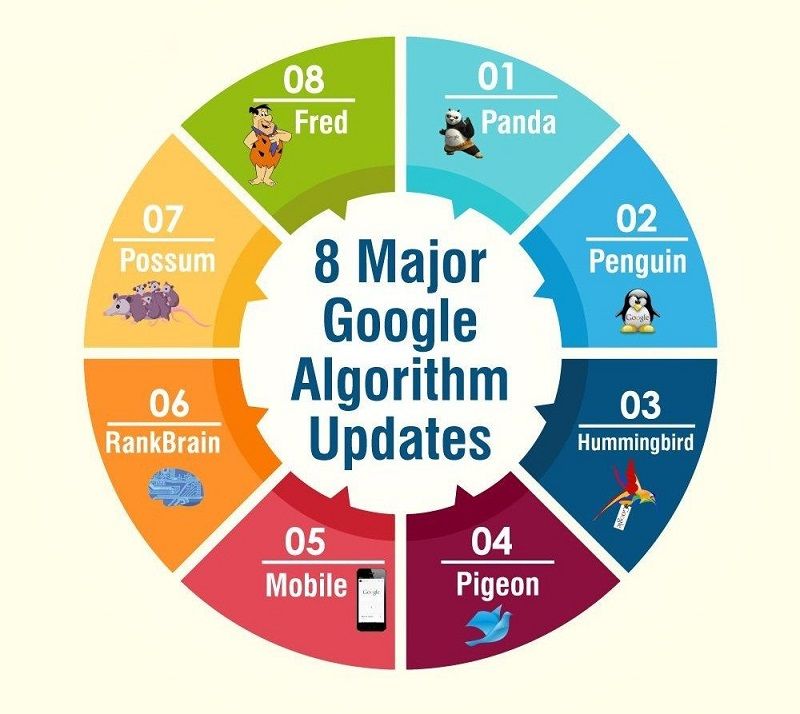

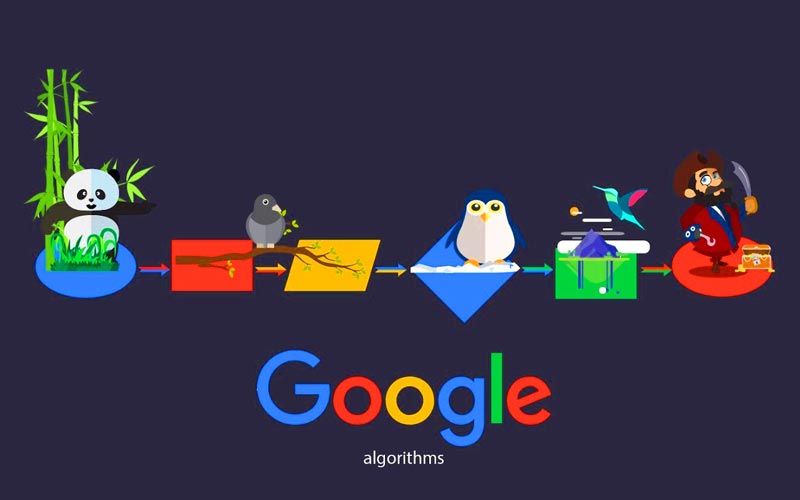

Панда — предвестник чистки интернета

Релиз поискового алгоритма Панда произошел в 2011 году, этот алгоритм действует до сих пор. Главная задача Панды — проверить качество контента на сайте. Контент должен быть:

Главная задача Панды — проверить качество контента на сайте. Контент должен быть:

- Полезным для пользователя — отвечать на его вопрос или корректно описывать услугу/товар, который продается на сайте.

- Структурированным — содержать списки, таблицы, разделы. Все для того, чтобы пользователю было удобно читать и воспринимать информацию.

- Четко соответствовать заявленной теме. Именно из-за этого структуры сайтов с каждым годом становятся все более сложными и многоступенчатыми — чтобы каждая статья и посадочная страница соответствовали узкой теме.

- Оригинальным. Тут учитывается как оригинальность внутренняя — между статьями на одном сайте, так и внешняя — контент не должен повторять уже написанный и размещенный на другом сайте.

При попадании под фильтр Панда, владельцу сайта приходится переписывать весь неуникальный контент и ждать до полугода, пока сайт начнет возвращать свои позиции в выдаче.

Панда придет – порядок наведет

Как выглядели сайты в топе до 2011 года? В основном это были страшненькие страницы, внизу которых огромным списком были вписаны ключевые слова, по которым сайт планировал получить трафик. Выделенные жирным, курсивом. Ключевые слова без связи между собой в заголовках страницы. Скрытые текст с еще большим ключевых слов.

Страх и ужас. Так что, Панда немного отрезвила вебмастеров. И дала много работы копирайтерам.

Пингвин — скажи мне, кто ссылается на тебя, и я скажу, кто ты

Если вы работали в SEO-агентстве в 2012 году, то наверняка помните Большую Миграцию Клиентов. Агентства теряли всех клиентов в течение месяца, но получали столько же тех, кто ушел из другого агентства. А через пару месяцев клиенты снова забирали проекты и уходили еще куда-то. Случилось это из-за выкатки фильтра Пингвин. Тексты + Ссылочное — вот два фактора, которые позволяли сайтам до 2012 года попадать в топ.

Если текстовой составляющей занялась Панда, то за ссылочное взялся Пингвин. До 2012 года вы могли попасть в топ Google за пару месяцев (в среднеконкурентных тематиках).

Все было просто:

- Создаем сайт.

- Заливаем на него тысячу не связанных между собой ключевых слов через запятую. А еще лучше — в несколько слоев верстки наложить их друг на друга и сделать прозрачным цветом (МРАК).

- Закупаем 10 тысяч арендных ссылок на SAPE за 150 долларов (нет, тут не пропущен нолик — они действительно столько стоили).

- И вуаля — вы в топе.

Такие схемы не способствовали появлению качественных сайтов в результатах поиска. Потому с приходом Панды и началась настоящая паника. Все арендные ссылки с некачественных площадок не просто переставали учитываться — они становились токсичными. Нашел Гугл Бот 100+ ссылок с таких сайтов — получите фильтр, распишитесь.

Пингвин ищет на дне самые некачественные ссылки

И начали массово падать все сайты, которые продвигались таким образом. Кто не успел попасть под фильтр — в срочном порядке отказывались от арендных ссылок, но тоже проседали. Ведь отказ от огромной ссылочной массы в момент — не приводит ни к чему хорошему.

Кто не успел попасть под фильтр — в срочном порядке отказывались от арендных ссылок, но тоже проседали. Ведь отказ от огромной ссылочной массы в момент — не приводит ни к чему хорошему.

Примерно полгода понадобилось выдаче, чтобы хоть как-то стабилизироваться по коммерческим запросам. И несколько лет понадобилось большинству доменных имен, чтобы «отстоятся» после фильтра.

Дополнительные фильтры Google

Пингвин и Панда — крупные фильтры, на основании которых большинство сайтов попадают под фильтр до сих пор. Но есть и небольшие апдейты к ним и отдельные алгоритмы, под санкции которых можно попасть только по незнанию или намеренно. Потому пройдемся по ним достаточно коротко.

Exact Match Domain. Этот алгоритм отслеживает специфический тип переспама ключевых слов — вхождение ключа в URL сайта. Например, если сайт занимается продажей кирпичей, то домен kirpich.com будет ок, а вот за доменное имя http://proizvodstvo-i-prodazha-kirpicha-nedorogo. com, вы, скорее всего, попадете под фильтр.

com, вы, скорее всего, попадете под фильтр.

DMCA. Этот фильтр очень медленно раскатывался в течении 2012—2015 годов и до сих пор многие умудряются его обходить. Ключевая задача — убрать из выдачи пиратский контент — от фильмов до программ и книг. Учитывая количество результатов поиска по запросу «популярный фильм смотреть онлайн и без регистрации» — эту битву поисковик пока что проигрывает.

Links. У настоящего, живого, сайта должны быть как входящие, так и исходящие ссылки. Ссылки с других ресурсов на ваш сайт показывают поисковой системе, что сайт важен и цитируем, а исходящие — что вы также готовы ссылаться в своем контенте на уважаемые источники. Однако, большое количество исходящих ссылок превращает домен в «ссылочную помойку». В основном сайты попадают под этот фильтр, когда беспорядочно продают ссылки через биржи, не занимаясь развитием собственного ресурса.

Битые ссылки. Актуальный алгоритм для интернет-магазинов, которые не пользуются услугами SEO специалистов. Когда товар заканчивается и не планируется к дальнейшей продаже — контент менеджеры часто удаляют страницу. Тогда по старой ссылке на товар пользователя встречает 404 ошибка. Если количество битых страниц достигает определенного порога — сайт начинает проседать в выдаче. Такие страницы важно отслеживать и делать с них 301 редирект на релевантную страницу (категории или другого товара).

Когда товар заканчивается и не планируется к дальнейшей продаже — контент менеджеры часто удаляют страницу. Тогда по старой ссылке на товар пользователя встречает 404 ошибка. Если количество битых страниц достигает определенного порога — сайт начинает проседать в выдаче. Такие страницы важно отслеживать и делать с них 301 редирект на релевантную страницу (категории или другого товара).

Современные и новые фильтры Гугла — YMYL, BERT, Speed Update, etc

Если базовые алгоритмы, которые мы рассмотрели в прошлом разделе были призваны вывести в топ самые качественные и релевантные ресурсы, то большинство рассмотренных в этой части продиктованы изменением пользовательского поведения.

Вы знали, что 80+% трафика в интернете в 2021 году пришлось на мобильные устройства? Эта цифра росла ежегодно с 2015 года и привела к Google к новой концепции оценки сайтов — Mobile First Index. Во главу угла ставится удобство сайта для мобильных устройств с разной диагональю и скоростью интернет-подключения.

До 2017 года была еще разница в выдаче — при запросе с мобильных и десктопов, пользователь мог получить разные сайты в топ-10. Сейчас же сайты, которые оптимизированы под мобайл, получают высокие позиции везде. Потому что — Mobile First.

В связи с этим появились новые алгоритмы оценки сайтов, которые нельзя игнорировать даже в узких нишах.

Mobilegeddon — кто в лес кто по дрова

Первым алгоритмом, который изменил правила игры стал Mobilegeddon в 2015 году. Тогда требования были простыми — сайт должен быть удобен для мобильных устройств. Оказалось, что достичь этого можно разными методами. Ключевыми стали:

- Мобильная версия сайта — m.site.com. Самый быстрый вариант в реализации. Создавался очень упрощенный клон сайта с минимумом верстки и удобства для пользователя. Главными минусами такого подхода были проблемы с SEO (часто соответствия настраивались неправильно и для поисковой системы мобильные страницы становились дублями), неудобство для пользователя и сложность в модерации.

На сегодняшний день эту практику почти не применяют.

На сегодняшний день эту практику почти не применяют. - AMP версия сайта. Актуально для новостных ресурсов. Accelerated Mobile Pages от Google предлагала создавать дубль страницы с контентом, но почти без стилей верстки, рекламных блоков и меню. Страница как будто существовала вне сайта. Для ранжирования в новостных фидах владельцы сайтов шли на внедрение AMP, но отсутствие рекламы на страницах делали подход не очень выгодным.

- Адаптивная верстка. Оптимальный, хоть и самый трудозатратный вариант, который на 2022 год считается стандартом де-факто. Страница имеет разное расположение блоков для разных разрешений устройств.

Переход на Mobile First стал с одной стороны выкручиванием рук всем вебмастерам. Хотите быть в выдаче — адаптируйте сайт. Но в перспективе это, конечно, верное решение.

Speed Update — черепахам тут не место

Первый апдейт, связанный со скоростью загрузки сайта появился в 2018 году. Тогда он вышел в формате рекомендации. Google просил веб-мастеров ускорять сайты, потому что пользователи мобильных устройств не готовы ждать даже 3 секунд для загрузки страницы.

Тогда он вышел в формате рекомендации. Google просил веб-мастеров ускорять сайты, потому что пользователи мобильных устройств не готовы ждать даже 3 секунд для загрузки страницы.

Каких-то жестких пессимизаций в выдаче не было до 2021 года. В прошлом году развернули Google Page Experience Update. Вот он уже неплохо потряс выдачу и тяжелые, неповоротливые сайты на плохих серверах или с визуальными украшательствами начали постепенно терять свои позиции.

Google дал максимум рекомендаций по ускорению сайта, но не всегда понятно как их внедрять

Алгоритм держится на трех китах, так называемых Core Web Vitals:

- LCP — скорость загрузки основного контента сайта. Считает сколько секунд нужно сайту, чтобы передать на устройство пользователя полностью загруженную страницу.

- FID — скорость загрузки до первого взаимодействия. Считает сколько секунд нужно сайту, чтобы передать на устройство пользователя первые части контента, с которыми можно взаимодействовать.

Причем в идеальном виде этот параметр должен составлять ⅕ секунды, что для многих хостингов стало невыполнимой задачей.

Причем в идеальном виде этот параметр должен составлять ⅕ секунды, что для многих хостингов стало невыполнимой задачей. - CLS — отвечает за статичность контента. Если пользователь прокручивает страницу вниз, то элементы не должны перестраиваться и менять свое расположение. Как загрузилось — так и должно оставаться. По поводу этого пункта много споров, что он не нужен, но на самом деле он крайне важен. Если сайт «застревает» между отображением для нескольких разрешений и вы не можете клацнуть на бургер меню или попасть по кнопке обратной связи — взаимодействие с сайтом становится настоящей мукой.

Page Experience Update не закончился в 2021 году и летом 2022 года нам обещают его улучшение и более масштабную развертку. Так что, если ваш сайт все еще не соответствует его требованиям — рекомендуем срочно подыскать команду пряморуких верстальщиков. Последствия игнорирования будут очень серьезными, вплоть до полного выпадения сайта из выдачи.

RankBrain и BERT — два брата-филолога

Алгоритм RankBrain был запущен в 2015 году. Он является лексическим алгоритмом, способным анализировать тексты на сайте не только по прямым вхождениям ключевых слов, но и находить их синонимы. Если в тематике мало сайтов-конкурентов, то благодаря RB пользователь мог получить релевантный сайт по своему запросу, даже если на самом сайте не было ключа, который он вводил.

Например, пользователь ввел запрос «Грумер в Киеве». И так оказалось (совершенно невероятная ситуация), что никто не предлагает услуги груминга в Киеве. Однако, есть сайты с услугой — Стрижка для собак в Киеве. И благодаря алгоритму, Google поймет о чем идет речь и выдаст пользователю собачьего парикмахера, который даже не подозревал, что он грумер.

Есть обоснованный страх, что BERT в будущем сможет превратиться в замену копирайтерам

BERT же — логичное продолжение этого алгоритма. Фактически это нейросеть, обрабатывающая запросы пользователей и анализирующая куда переходят пользователи, после ввода ряда запросов. Это искусственный интеллект, который будет понимать нас через несколько лет лучше, чем мы понимаем друг друга. Так как напрямую на эти два алгоритма вы повлиять никак не можете — нужно серьезно работать над контентом сайта.

Фактически это нейросеть, обрабатывающая запросы пользователей и анализирующая куда переходят пользователи, после ввода ряда запросов. Это искусственный интеллект, который будет понимать нас через несколько лет лучше, чем мы понимаем друг друга. Так как напрямую на эти два алгоритма вы повлиять никак не можете — нужно серьезно работать над контентом сайта.

Для оптимизации под BERT рекомендуют:

- Писать на сайт действительно полные и глубокие аналитические статьи, ориентируясь больше на всестороннее раскрытие темы, чем на ключевые слова.

- Максимально использовать синонимы в своих текстах. Если у вас существует список ключевых слов по которому вы пишите текст — обязательно соберите список синонимов, которые также нужно внедрить.

- Добавлять в текст больше естественных, разговорных оборотов в контексте ключевого слова.

- Использовать не только текстовый, но и аудиовизуальный контент.

Google YMYL (Your money — your life)

YMYL вызвал массовое падение сайтов в 2018 году. В медицинской, финансовой, юридической тематиках, сотни сайтов выпали из ТОПа буквально за ночь. К этому еще добавились новые правила рекламы Google Ads, запрещающие многие медицинские тематики для открытой рекламы.

В медицинской, финансовой, юридической тематиках, сотни сайтов выпали из ТОПа буквально за ночь. К этому еще добавились новые правила рекламы Google Ads, запрещающие многие медицинские тематики для открытой рекламы.

Так, если у вас был сайт в сфере лечения зависимостей — 2018 год вы наверняка запомните надолго. Но есть и позитивные стороны и их намного больше.

Алгоритм YMYL призван обезопасить пользователей в вопросах, которые касаются их здоровья и денег. Он актуален для таких услуг:

- Юридических

- Медицинских

- Финансовых

- Вопросов безопасности

- Коммерция (это не точно, но есть слухи, что алгоритм все чаще касается сайтов e-commerce)

Главный принцип, которым руководствуется алгоритм называется E-A-T. Экспертность, авторитетность, достоверность. Если вы публикуете контент в тематиках, затрагивающих здоровье или финансы пользователей — будьте добры побеспокоиться, чтобы он заслуживал доверия.

Потому для сайтов стало важно придерживаться ряда принципов в публикациях. И манипулировать этим почти невозможно, так как сайты проверяются вручную. Возникла должность асессора. Это внештатный сотрудник Google, который проверяет сайты согласно чек-листу. И если вы не придерживаетесь новых принципов — до свидания из топа.

Принципов несколько и им действительно несложно следовать:

- Авторство статьи. Если вы размещаете экспертный контент — у него должен быть указан автор. У автора — должна быть персональная страница на вашем сайте, где будет указано почему он эксперт, чем он может это подтвердить. В идеале — там же размещены ссылки на его социальные сети или профессиональные платформы.

- Отсылки к авторитетам. Приводя цитаты или заявления в статье — нужно отсылаться к общепринятым источникам, которым доверяют. Forbes, Lancet, Wikipedia — вы должны привести в тексте ссылку на ресурс из которого взята информация.

- Актуальность содержания. Если статья устарела (например, вы до сих пор рекомендуете лечить мигрени кровопусканием, ссылаясь на трактаты 12 века) — то ее следует удалить с сайта. Или указать, что эта информация неактуальна на сегодняшний день — в самом начале статьи.

YMYL выбил из топа многие качественные ресурсы в момент запуска, но туда же отправились и мошеннические сайты. По прошествию 4 лет можно констатировать, что качество сайтов в топ-10 действительно выросло.

Pigeon — голуби мигрируют, а бизнесы — нет

Голубь это небольшой, но очень полезный алгоритм, запущенный в 2014 году. Он призван помочь локальным бизнесам в продвижении. И что самое главное — он действительно работает. Принцип работы достаточно прост. Если вы ищете услугу или товар, которые имеют географическую привязку в запросе или типе услуги (это может быть стоматолог, клуб настольных игр или ресторан), то в первую очередь Google предложит вам не максимально «прокачанный» сайт в вашей стране, но тот, что привязан к местности возле вас.

Для оптимизации сайта под этот алгоритм необходимо:

- Указать на сайте точное месторасположение вашего магазина.

- Если магазинов или офисов несколько — указать их все.

- Создать Google My Business карточку под каждый филиал вашего бизнеса и оптимизировать ее.

- Если вы работаете по всему городу (или стране) — то создать отдельные страницы на сайте, заточенные под запрос «Услуга в Городе/Районе/Улице».

Неофициальные алгоритмы и фильтры Гугла

Кроме стандартных поисковых алгоритмов, о которых вы можете прочитать в Справке Google или услышать в открытых лекциях, существуют и неофициальные алгоритмы и фильтры. Кто-то считает, что это теория заговора и ничего такого нет. Другие же вебмастера, особенно те, кто регулярно запускают новые проекты — абсолютно уверены, что они существуют.

В этой статье мы упомянем несколько таких неофициальных фильтров, но стоит ли ориентироваться на них при продвижении вашего ресурса — решать только вам.

Sandbox — твой сайт пока слишком мал для взрослых игр

Песочница это алгоритм, который не дает возможности новосозданным сайтам занимать серьезные позиции или получать весомый трафик в течении 3-6 месяцев после запуска сайта.

Вылезти из зыбучих песков Песочницы поможет только время

Даже если вы запускаете отлично оптимизированный и наполненный контентом сайт в «голубом океане» — нише почти без конкуренции, то по своим супер низкочастотным ключевым словам вы не получите и 100-й позиции, пока не пройдет какое-то время. Чаще всего — не менее 3 месяцев.

Google в лице Джона Мюллера отрицают существование песочницы и списывают эффект на то, что новорожденный сайт медленно вноситься в базу данных Google. Мол, происходит долгий процесс каталогизации из-за чего, новенькие сайты бывают не видны. Однако, если на старом сайте запустить новый контент — он будет проиндексирован в течении минут, не часов. Что же мешает поисковой машине обнаружить новый сайт в течении долгих месяцев? Возможно, Песочница.

Что же мешает поисковой машине обнаружить новый сайт в течении долгих месяцев? Возможно, Песочница.

DomainAge — старый конь борозды не испортит

Этот алгоритм также связан с возрастом, но в обратную сторону. Google официально не указывает на то, что возраст домена является фактором ранжирования. Но практика показывает, что в топе намного больше сайтов с доменами 5-7 летней давности.

Теория гласит, что если у нас есть два сайта с одинакового качества контентом, одинаковым количеством страниц, одинаковым ссылочным весом и так далее — первым в топе будет стоять тот, у которого более старый домен. Само собой, это моделирование ситуации в вакууме. Но вебмастера часто покупают старые домены, у которых нет никакого веса, для новых проектов. Они верят, что это даст изначальный буст сайту. Ну и позволит обойти песочницу.

-5, -30, -950 я иду искать

Если бы он точно существовал, то это был бы самый честный алгоритм.

Идея в том, что сайты, которые используют при продвижении черные методы — не банятся сразу, а получают предупреждение. Несколько желтых и потом красную карточку.

Фильтр могут наложить за применение:

- дорвеев

- клоакинга

- построение сеток сайтов

- ссылочный спам

- скрытые от поисковой системы редиректы пользователя

Если поисковая машина обнаруживает какое-то из этих нарушений, сайт сначала получает -5 к позициям. Если нарушения не исправлены в кратчайшие сроки — еще минус 30. Потом минус 950 и в конце — красная карточка, домен навсегда попадает под санкции.

По поводу это алгоритма есть несколько сомнений, главное из которых следующее. Почему за прямое нарушение правил Google сайт настолько легко наказывают и дают возможность исправиться? Не очень-то похоже на диктаторский стиль Компании Добра.

Хотите узнать, как с помощью Serpstat оптимизировать сайт под требования Google?

Нажимайте на космонавта и заказывайте бесплатную персональную демонстрацию сервиса! Наши специалисты вам все расскажут! 😉

Выводы.

Как не попасть под фильтр Гугла и расти в выдаче

Как не попасть под фильтр Гугла и расти в выдаче Google — это коммерческая компания, которая предоставляет во всем мире мощнейший бесплатный инструмент — доступ к базе данных сайтов во всем мире. Их цель состоит в том, чтобы сделать результаты поиска максимально соответствующими запросам пользователей (и попутно — продать рекламы на миллиарды долларов).

Потому всем, кто хочет получить высокие позиции в поисковике — приходится играть по его правилам и придерживаться требований к сайтам. Очень важно знать какие алгоритмы Google существуют сегодня и следить за тем, какие будут выпущены завтра — только так вы сможете оставаться на позициях, приносящих трафик и продажи вашему бизнесу.

В 2022 году есть ряд требований, которые нужно обязательно выполнять, чтобы соответствовать требованиям поисковика:

- Пишите уникальный контент. Если он касается здоровья пользователя — руководствуйтесь формулой E-A-T, если не касается — пишите больше лонгридов, статей с учетом LSI ключей, синонимами и визуальным контентом.

- При наращивании ссылочной массы — выбирайте только качественные площадки. Да, стоимость одной ссылки на сегодня может доходить до 1000 долларов (в рунете). Но лучше купить одну хорошую, чем 100 плохих и улететь под фильтр.

- Старайтесь получать качественные ссылки на свой сайт за счет публикации экспертного контента на других площадках — платно и бесплатно.

- Оптимизируйте свой сайт по скорости загрузки. В 2022 году без этого никак — ваш сайт обязан летать.

- Следите за техническим состоянием сайта — регулярно делайте аудиты, внедряйте правки, следите какие фишки внедряют ваши конкуренты.

- Старайтесь сделать структуру максимально широкой. Есть возможность проработать фильтры — прорабатывайте. Есть возможность проработать их пересечения — обязательно прорабатывайте!

- Привязывайте сайт к вашему региону. Создавайте локальные страницы, пишите тексты на категории товаров и услуг с привязкой к региону.

Все это сыграет вам только на руку.

Все это сыграет вам только на руку. - Не ищите быстрых путей. В августе 2021 года в базе данных Google было 1,88 миллиарда сайтов. Не рассчитывайте на то, что окажетесь в топе через месяц после запуска проекта — рынок уже раскален.

И главное — следите за обновлениями. Проще подготовиться к новым требованиям за полгода, чем потом возвращать позиции, теряя клиентов и время.

Чтобы быть в курсе всех новостей блога Serpstat, подписывайтесь рассылку. А также вступайте в чат любителей Серпстатить и подписывайтесь на наш канал в Telegram.

Сэкономьте время на изучении Serpstat

Хотите получить персональную демонстрацию сервиса, тестовый период или эффективные кейсы использования Serpstat?

Оставьте заявку и мы свяжемся с вами 😉

Мнение авторов гостевого поста может не совпадать с позицией редакции и специалистов компании Serpstat.

Оцените статью по 5-бальной шкале

5 из 5 на основе 6 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

SEO

Алекcей Петриченко

Как стартапу привлечь брендовый трафик? 3 кейса

SEO

Алексей Файнгор

Что такое обратные ссылки и как быстро найти площадки-доноры для размещения беклинков?

SEO

Богдана Гайворонская

Как защитить свой домен от кражи: топ-5 рекомендаций

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

Алгоритмы Google — самые важные апдейты за последние года

Практически ежемесячно Google выкатывает апдейты алгоритмов (это только те, которые подтверждены официально!). Далеко не все из них оказывают существенное влияние на результаты поисковой выдачи и сегодня мы поможем вам разобраться, какие же алгоритмы внесли существенные изменения в результаты ранжирования за последние годы.

Возможно, какой-либо из них повлиял или повлияет на позиции и трафик вашего сайта. Прочитав эту статью, вы поймете на какие особенности контента, внутренней и внешней оптимизации стоит обратить пристальное внимание и как адаптировать свой сайт к новым требованиям для успешного ранжирования в Google.

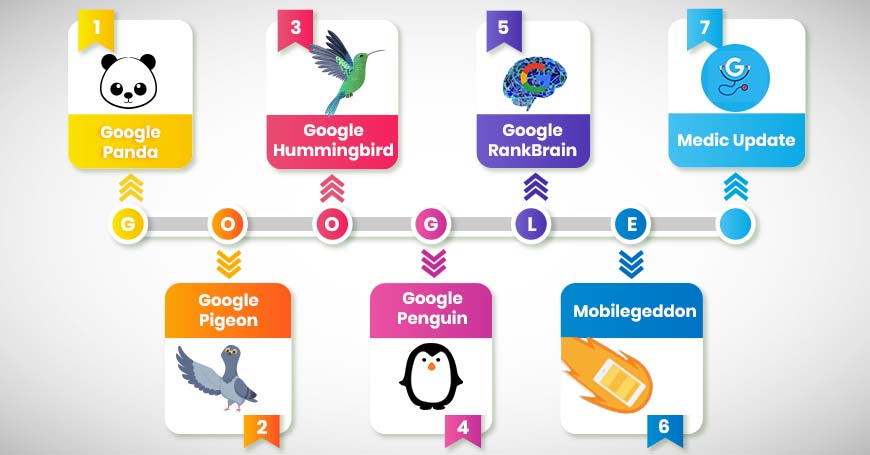

1. Панда

Запущен: 24 февраля 2011

Апдейты:~ ежемесячно

Цель: Понижает позиции сайтов с низкокачественным контентом

Алогоритм Google Panda используется для обнаружения страниц с неуникальным контентом, с контентом, наводненным ключевыми запросами, спамным или автоматически сгенерированным контентом. Алгоритм также может затрагивать сайты с дублирующейся на многих страницах этого же сайта информацией и сайты с недостаточным количеством контента. Такие страницы или сайты в целом понижаются в рейтинге ранжирования гугл.

Алгоритм также может затрагивать сайты с дублирующейся на многих страницах этого же сайта информацией и сайты с недостаточным количеством контента. Такие страницы или сайты в целом понижаются в рейтинге ранжирования гугл.

Первоначально, «Панда» не был частью основного алгоритма, а работал как фильтр Google, то есть затрагивал определенную долю сайтов при каждом своем апдейте. Но в январе 2016 года «Панда» был официально включен в основной алгоритм ранжирования. Это не значит, что алгоритм теперь работает буквально в реальном времени — все также существуют апдейты, которые затрагивают определенную долю выдачи. Просто теперь они стали настолько частыми, что не анонсируются компанией Google.

С одной стороны это увеличивает шансы сайтов из зоны риска быть быстрее пессимизированными «Пандой». С другой — позволяет владельцам сайтов, ранее пострадавшим от алгоритма, намного быстрее восстановить свои позиции и трафик.

За что наказывает алгоритм «Панда»?

— Неуникальный контент (плагиат)

— Дублированный контент на разных страницах одного сайта

— Автоматически сгенерированный контент

— Контент, переспамленный ключевыми запросами

— Спамный контент, сгенерированный пользователями (например, комментарии)

— Недостаточное количество контента на странице (по отношению к рекламным блокам, например)

— Плохой пользовательский опыт

Как обезопасить свой сайт?

— Проверьте сайт на уникальность контента

Даже если вы собственноручно пишете весь контент для сайта — не пренебрегайте периодической проверкой контента на уникальность, как это сделать мы подробно рассказывали в этой статье: Как проверить уникальность контента — обзор сервисов.

Интернет-магазинам стоит позаботиться о хотя бы частичной уникализации информации в карточках товаров. Пусть вы не в силах изменить специфическое техническое описание товара, но сделать уникальные фотографии и видео товара, стимулировать пользователей оставлять настоящие отзывы — вполне реально.

— Проверьте сайт на дублированный контент

Это одна из наиболее частых причин понижения позиций. В силу особенностей разных CMS систем один и тот же контент может быть доступен поисковикам по разным URL адресам, что приводит к появлению страниц-дублей в индексе. К сожалению, владелец сайта может даже не подозревать о таких подводных камнях в структуре своего ресурса. Обнаружить подобные страницы вам поможет специализированное ПО, например Screaming Frog SEO Spider. Просканируйте ваш сайт и обратите внимание на страницы с дублирующимся мета-тегом title и тегом h2, именно они — потенциальные кандидаты на наличие дублированного контента. Примите меры по их устранению либо закрытию от роботов поисковых систем — возможно использование тега canonical, 301 редиректа либо мета тега noindex.

— Проверьте соотношение контента на странице к исходящим ссылкам

Оцените свои страницы в разрезе исходящих ссылок. Возможно, на вашем проекте есть страницы с большим количеством исходящих. В этом случае очень важно добавить на них побольше уникального контента, что поможет избежать пристального внимания «Панды»

2. Пингвин (Google Penguin)

Запущен: 24 апреля 2012

Обновления: 25 мая 2012; 5 октября 2012; 22 мая 2013;4 октября 2013; 17 октября 2014; 27 сентября 2016; 6 октября 2016; сейчас в режиме реального времени

Цель: понижать в ранжировании сайты со спамными ссылочными профилями и сайты, манипулирующие ссылочной массой

Ссылки долго были решающим фактором в ранжировании в Google и алгоритм Пингвин был создан для обнаружения и применения санкций к сайтам с неестественной ссылочной массой. Этот алгоритм изменил само понимание продвижения сайтов под Google и стал страшным сном для многих сео-оптимизаторов. Пингвин стал началом конца эры арендованных ссылок как главной составляющей успешного продвижения. С осени 2016 года находится в свободном плавании — став частью основного алгоритма, увеличил в равной степени как шансы попасть под санкции, так и возможность для их снятия для ранее пострадавших сайтов.

Пингвин стал началом конца эры арендованных ссылок как главной составляющей успешного продвижения. С осени 2016 года находится в свободном плавании — став частью основного алгоритма, увеличил в равной степени как шансы попасть под санкции, так и возможность для их снятия для ранее пострадавших сайтов.

За что сайты попадают под санкции «Пингвина»:

— покупные ссылки

— ссылки, ведущие с низкокачественных спамных сайтов

— ссылки, ведущие с сеток сайтов, созданных специально как доноры для наращивания ссылочной массы

— неестественные анкоры ссылок

— ссылки, ведущие с абсолютно нерелевантных по содержанию страниц

Как обезопасить свой сайт?

— Мониторить изменения в ссылочном профиле

С помощью сервисов для анализа беклинков необходимо периодически отслеживать свой ссылочный профиль. Важно понимать, что за пару спамных ссылок шанс попасть под санкции Пингвина крайне мал, а вот резкое получение сотен ссылок с нерелевантных сайтов будет выглядеть крайне неестественно и может привлечь внимание алгоритма. Почаще смотрите на ссылочный график вашего сайта — любые резкие скачки должны быть внимательно разобраны.

Почаще смотрите на ссылочный график вашего сайта — любые резкие скачки должны быть внимательно разобраны.

— Избавляться от вредоносных ссылок

Вы проанализировали ссылочный профиль и обнаружили спамные ссылки? Теперь стоит задуматься о том, как от них избавиться. Идеальный вариант, если вам удалось связаться с владельцем/веб-мастером сайта и он удалит такую ссылку. Если же этот сценарий невозможен, то следует воспользоваться инструментом отклонения ссылок Google’s Disavow tool. Таким образом вы просите гугл игнорировать спамные ссылки при оценивании вашего ссылочного профиля.

3. Антипиратский апдейт (Google’s Pirate Update)

Запущен: август 2012

Апдейты: октябрь 2014

Цель: понижать в ранжировании сайты, которые регулярно получают жалобы за содержание пиратского (защищенного авторским правом) контента.

Этот алгоритм был разработан, чтобы сайты с многочисленными жалобами на пиратское содержание не имели возможности высоко ранжироваться в результатах поиска Google. Большинство из затронутых алгоритмом сайтов содержали фильмы, музыку или книги, доступные для скачивания или просмотра. К таким сайтам Google также отнес торрент-треккеры и сайты-агрегаторы ссылок на файлообменники, хотя формально они не хранят запрещенные файлы, но предоставляют информацию о том, как их скачать из сети. Точного количества необходимых жалоб для попадания под фильтр поисковик не озвучивает, но однозначно ясно, что работа данного алгоритма далека от идеала — многие сайты с сотнями DMCA жалоб успешно ранжируются в Топ-3.

Большинство из затронутых алгоритмом сайтов содержали фильмы, музыку или книги, доступные для скачивания или просмотра. К таким сайтам Google также отнес торрент-треккеры и сайты-агрегаторы ссылок на файлообменники, хотя формально они не хранят запрещенные файлы, но предоставляют информацию о том, как их скачать из сети. Точного количества необходимых жалоб для попадания под фильтр поисковик не озвучивает, но однозначно ясно, что работа данного алгоритма далека от идеала — многие сайты с сотнями DMCA жалоб успешно ранжируются в Топ-3.

За что накладывается?

Логично, что накладывается за содержание на сайте пиратского контента или информации о том, как получить такой контент в обход правообладателя.

Как обезопасить свой сайт?

Просто не добавлять подобный контент на свой сайт, другого пути нет. Если динамика поступления жалоб от правообладателей будет постоянной, то рано или поздно алгоритм затронет и ваш сайт.

4. Колибри (Hummingbird)

Запущен: 30 августа 2013

Апдейты: —

Цель: предоставлять более релевантные результаты, основываясь на смысловой составляющей поискового запроса

Алгоритм Колибри внес масштабные изменения в область интерпретации поисковиком запросов пользователя. С выходом этого алгоритма основной акцент стал делаться на предоставлении результатов, основанных на понимании намерений пользователя, а не на простом вхождении ключевых слов, как это было прежде. Именно благодаря «Колибри» Google улучшил понимание синонимов и разделение контента по тематикам. Только после выхода этого алгоритма стало возможным увидеть в результатах поиска страницу, на которой в принципе отсутствует поисковый запрос пользователя, но присутствуют его синонимы.

С выходом этого алгоритма основной акцент стал делаться на предоставлении результатов, основанных на понимании намерений пользователя, а не на простом вхождении ключевых слов, как это было прежде. Именно благодаря «Колибри» Google улучшил понимание синонимов и разделение контента по тематикам. Только после выхода этого алгоритма стало возможным увидеть в результатах поиска страницу, на которой в принципе отсутствует поисковый запрос пользователя, но присутствуют его синонимы.

Как «колибри» может затронуть ваш сайт?

Переспам конкретного поискового запроса (ключевого слова) в тексте без использования задающих тематику слов, синонимов и макисмального раскрытия темы увеличивают риск быть пониженным в ранжировании по этому запросу. Вам очень хотелось хорошо ранжироваться по конкретному запросу и поэтому упомянули его в тексте 100500 раз? После выхода «Колибри» вы рискуете получить абсолютно обратный эффект.

Как оставаться в безопасности?

Разнообразьте свой текстовый контент. Используйте подсказки гугл для понимания более длинных поисковых запросов для своей посадочной страницы. Структурируйте контент с помощью заголовков h2-h6, используйте максимально возможное количество синонимов и слов, относящихся к нужной тематике.

Используйте подсказки гугл для понимания более длинных поисковых запросов для своей посадочной страницы. Структурируйте контент с помощью заголовков h2-h6, используйте максимально возможное количество синонимов и слов, относящихся к нужной тематике.

Не используйте прямое вхождение вашего запроса в текст, если он делает его нечитабельным. Не нужно недооценивать сегодняшний уровень распознавания и понимания разговорного языка поисковыми системами. Прочитайте свой текст на продвигаемой странице. Насколько исчерпывающим был ответ на ваш поисковый запрос? Текст написан нормальным языком или в стиле «я-робот» специально для поисковика? Если ответы на эти вопросы вызывают у вас сомнения — смело переписывайте контент.

5. Голубь (Pigeon)

Запущен: 24 июля 2014

Апдейты: 22 декабря 2014

Цель: предоставлять более релевантные результаты локального поиска

Данный алгоритм повлиял на результаты выдачи, в которых имеет значение местонахождение пользователя. Несмотря на ожидания многих специалистов, в основном коснулся только англоязычного сегмента. После выхода этого алгоритма местонахождение пользователя и его расстояние до объекта, предлагаемого как результат выдачи, стали учитываться как факторы ранжирования.

Несмотря на ожидания многих специалистов, в основном коснулся только англоязычного сегмента. После выхода этого алгоритма местонахождение пользователя и его расстояние до объекта, предлагаемого как результат выдачи, стали учитываться как факторы ранжирования.

Алгоритм «Голубь» позволил локальным нишевым бизнесам (ресторанам, кафе, образовательным учреждениям) обойти в результатах выдачи большие раскрученные сайты и получать больше трафика.

Так что, если вы хотите лучше ранжироваться в конкретном регионе, стоит позаботиться о регистрации в Google My Business и упоминании своего сайта в каталогах и сайтах именно этого региона.

6. Mobile Friendly Update

Запущен: 21 апреля 2015

Апдейты: —

Цель: повышать оптимизированные для мобильных устройств страницы в результатах поиска на мобильном устройстве

Это изменение позволило дружественным к мобильным устройствам страницам ранжироваться выше в результатах мобильного поиска. На десктопную выдачу данный апдейт не повлиял. Призван предоставлять пользователю более удобные для мобильного устройства страницы — без необходимости масштабирования для чтения текста, без горизонтальной прокрутки, с удобными для клика элементами.

На десктопную выдачу данный апдейт не повлиял. Призван предоставлять пользователю более удобные для мобильного устройства страницы — без необходимости масштабирования для чтения текста, без горизонтальной прокрутки, с удобными для клика элементами.

Важно отметить, что действие алгоритма направлено именно на конкретную страницу, а не на сайт в целом. Так одна страница может быть признана оптимизированной для мобильных устройств и получить рост позиций, а другая страница наоборот быть пониженной в выдаче.

Как угодить алгоритму?

Сделать свой сайт удобным для использования на мобильном устройстве.

Звучит очень просто, но это самый верный путь.

Проходим mobile friendly test и понимаем, что понятие об удобстве использования у вас и у гугла может быть очень даже разное. Ваша задача найти компромисс — чтобы страница была действительно удобна пользователям и в то же время удовлетворяла требованиям Google.

7. RankBrain

Запущен: 26 октября 2015 (возможно, ранее)

Апдейты: —

Цель: предоставить пользователю лучшие результаты, основанные на релевантности и машинном обучении

RankBrain — это система машинного обучения, позволяющая Google лучше расшифровывать и понимать смысл запросов пользователей и предоставлять более релевантные результаты в зависимости от контекста запроса.

В широком смысле, алгоритм определяет тематику страницы и то, насколько релевантен контент запросу пользователя. Система машинного обучения позволяет по поведению посетителей сайта определить, насколько предоставленный контент был полезен, самообучиться и со временем предоставлять максимально полезные результаты.

Угрозы для вашего сайта:

— недостаток факторов, влияющих на релевантность страницы поисковому запросу

Хотите ранжироваться по определенному запросу, значит нужно повышать релевантность вашей посадочной страницы данному запросу. Как это сделать читайте здесь: 25 способов повысить релевантность контента на странице

— плохой пользовательский опыт

Проанализируйте свои страницы на предмет показателя отказов, времени посещения, определите точки выхода с сайта и постарайтесь улучшить взаимодействие пользователя с вашим сайтом. Также стоит определить страницы, отличающиеся этими метриками от средних по сайту и выяснить причину плохого пользовательского опыта.

Например, это может быть не лучшая сортировка товаров по умолчанию (от высокой цены к низкой) на странице категории интернет-магазина, что формирует у пользователя неверное впечатление о магазине.

Точно также вы можете найти и наиболее интересные пользователям страницы. Проанализируйте их контент и используйте эти знания при создании новых страниц, а также для оптимизации существующих.

Также не стоит забывать, что чем больше на странице разнообразного контента и интерактивных элементов, тем более высокие поведенческие показатели, как правило, она получает.

8. Опоссум (Possum)

Запущен: 1 сентября 2016

Апдейты:—

Цель: предоставлять лучшие, более релевантные результаты локальной выдачи, основываясь на местонахождении пользователя

Еще один представитель фауны из «зоопарка» Google, призванный улучшить результаты локального поиска. Благодаря этому алгоритму местонахождение пользователя стало еще более важным фактором для показа того или иного результата из Local Business — чем ближе пользователь к адресу компании, тем с большей вероятностью данный результат будет присутствовать в выдаче.

Алгоритм серьезно отфильтровал аффилированные организации, например, с одинаковыми номерами телефонов или адресами. Это позволило предоставлять более разнообразные результаты во избежание попыток узурпации локальной выдачи.

Еще одной особенностью алгоритма стала возможность лучшего ранжирования для компаний с физическим адресом за пределами определенного города. Так, если до выхода «опоссума» такие компании практически не показывались в локальных результатах по запросам с названием города, то после — получили неплохой рост по количеству показов и, соответственно, трафику.

9. Фред (Fred)

Запущен: 8 марта 2017

Апдейты:—

Цель: отфильтровывать низкокачественные страницы из результатов поиска, чьей целью является прибыль от размещения рекламы и ссылок на другие сайты

Последний из подтвержденных Гугл апдейтов основного алгоритма, Fred получил свое имя благодаря шутке сотрудника Google Гэри Илш (Gary Illyes), который предложил все последущие апдейты называть “Fred”. Представители поисковика подтвердили, что апдейт имел место быть, но в довольно обтекаемой форме объяснили принцип его работы. Так, по словам представителей Google, Fred наказывает сайты, нарушающие рекомендации для веб-мастеров. Такое утверждение не дало полезной информации сообществу seo-оптимизаторов, а вот практические исследования показали, что от Фреда страдают сайты с малоценным контентом, размещающие переоптимизированные ключевыми словами тексты, большое количество рекламы либо исходящих ссылок.

Представители поисковика подтвердили, что апдейт имел место быть, но в довольно обтекаемой форме объяснили принцип его работы. Так, по словам представителей Google, Fred наказывает сайты, нарушающие рекомендации для веб-мастеров. Такое утверждение не дало полезной информации сообществу seo-оптимизаторов, а вот практические исследования показали, что от Фреда страдают сайты с малоценным контентом, размещающие переоптимизированные ключевыми словами тексты, большое количество рекламы либо исходящих ссылок.

«Жертвы» Фреда:

— Сайты, злоупотребляющие баннерной, pop-up и другими видами рекламы

— Сайты со статьями написанными специально для роботов поисковых систем с целью генерации трафика

— Сайты с большим количеством исходящих ссылок

Как оставаться в безопасности?

— Поумерить свой пыл в плане монетизации проекта рекламными блоками

— Вместо унылых роботизированных seo-текстов писать релевантный полезный контент

Резюме:

Теперь Вы вооружены четко структурированными знаниями о принципах действия самых важных алгоритмов Google. Очень надеемся, что эта статья будет полезна вам как для продвижения в русскоязычном, так и в англоязычном сегменте. Если же ваш сайт потерял трафик и позиции и вы не можете четко определить из-за какого алгоритма это произошло, начните со статьи про возможные причины потери позиций, а если и это не внесет ясность — обращайтесь за аудитом в компанию Q-SEO!

Очень надеемся, что эта статья будет полезна вам как для продвижения в русскоязычном, так и в англоязычном сегменте. Если же ваш сайт потерял трафик и позиции и вы не можете четко определить из-за какого алгоритма это произошло, начните со статьи про возможные причины потери позиций, а если и это не внесет ясность — обращайтесь за аудитом в компанию Q-SEO!

Комментарии

Комментарии

Как работает Google Поиск? / Хабр

Как работает Google Поиск, основные алгоритмы обновлений

В наше время поисковые системы, в частности Google, напоминают «витрину» Интернета и являются наиболее важным каналом распространения информации в цифровом маркетинге. С помощью глобальной рыночной доли, которая составляет более 65% по данным за январь 2016 года, Google явно доминирует в поисковой индустрии. Хотя компания официально не раскрывает степень своего роста, к 2012 году было подтверждено, что их инфраструктура обслуживает около 3 миллиардов поисковых запросов в день.

Google.com глобально занял звание сайта номер 1 в Alexa Top 500 Global Sites. Учитывая эти цифры, владельцам собственных веб-страниц особенно важно иметь хорошую видимость своих сайтов поисковой системой.

Но не смотря на такую всеобщую популярность Google, знаете ли вы, как он действительно работает и что это за панды, пингвины, калибри?

Чем нужнее становится Google для современного маркетинга, тем важнее понимать функции поиска и алгоритмы обновлений, которые оказывают непосредственное влияние на ранжирование результатов. Moz предполагает, что Google изменяет свои алгоритмы по 600 раз за год. Многие из этих изменений и связанные с ними факторы ранжирования держатся в секрете. И только о крупных обновлениях объявляют публично.

В этой статье мы рассмотрим основы функциональности поисковой системы и объясним основные обновления алгоритма Google, начиная с 2011 года. Выведем также стратегии, следуя которым можно идти в ногу с изменениями поисковой системы. Так что читайте дальше…

Как работает Google?

Своим появлением поисковые системы напрочь изменили привычный для нас способ сбора информации. Интересует ли вас обновление данных фондового рынка или вы хотите найти лучший ресторан в районе, либо пишете академический отчет об Эрнесте Хемингуэе — поисковик даст ответ на все запросы. В 80 годы ответы на вопросы потребовали бы посещения местной библиотеки. Теперь же все решается в течении миллисекунды с использованием алгоритмических полномочий поисковика.

Интересует ли вас обновление данных фондового рынка или вы хотите найти лучший ресторан в районе, либо пишете академический отчет об Эрнесте Хемингуэе — поисковик даст ответ на все запросы. В 80 годы ответы на вопросы потребовали бы посещения местной библиотеки. Теперь же все решается в течении миллисекунды с использованием алгоритмических полномочий поисковика.

В этом отношении главная цель поисковой системы заключается в том, чтобы максимально быстро найти уместную и актуальную информацию, как ответ на введенные поисковые термины, также называемые ключевыми словами. Поэтому центральным аспектом для любой поисковой системы, желающей выдать действительно полезный результат, является понятие цели поиска, того, как именно люди ищут.

Результат работы Google можно сравнить с интернет-каталогом, отобранным с помощью рейтинговой системы на основе алгоритмов. Более конкретно алгоритм поиска можно описать как «нахождение элемента с заданными свойствами среди списка элементов».

Давайте теперь подробнее рассмотрим привлеченные процессы сканирования, индексирования и позиционирования.

Сканирование

Сканирование может быть описано, как автоматизированный процесс систематического изучения общедоступных страниц в Интернете. Проще говоря, во время этого процесса Google обнаруживает новые или обновленные страницы и добавляет их в свою базу. Для облегчения работы он использует специальную программу. «Googlebots» (можно встретить альтернативные названия: «боты» или «роботы») посещают список URL-адресов, полученных в процессе прошлого сканирования и дополненных данными карты сайта, которую предоставляют веб-мастера и анализируют их содержание. При обнаружении ссылок на другие страницы во время посещения сайта, боты также добавляют их в свой список и устанавливают систематические связи. Процесс сканирования происходит на регулярной основе в целях выявления изменений, изъятия «мертвых» ссылок и установления новых взаимосвязей. И это при том, что только по данным на сентябрь 2014 года насчитывается около миллиарда веб-сайтов. Можете себе представить сложность такой задачи? Тем ни менее, боты не посещают абсолютно каждый сайт.

Индексация

Индексация — процесс сохранения полученной информации в базе данных в соответствии с различными факторами для последующего извлечения информации. Ключевые слова на странице, их расположение, мета-теги и ссылки представляют особый интерес для индексации Google.

Для того чтобы эффективно хранить информацию о миллиардах страниц в базе данных поисковой системы, Google использует крупные центры обработки данных в Европе, Азии, Северной и Южной Америке. В этих центрах, как было подсчитано, на основе энергопотребления Google в 2010 году, работает около 900,000 серверов.

Основная цель процесса индексации: быстро реагировать на поисковой запрос пользователя. Его как раз мы и будем обсуждать на следующей стадии.

Обработка

Когда пользователь вводит запрос, Google производит в базе данных поиск, подходящий под условия и алгоритмически определяет актуальность содержания, что выводит к определенному рейтингу среди найденных сайтов.

Хотя Google и не выпустил официальных данных об этом, компания подтверждает, что использует более 200 факторов для определения релевантности и значимости конкретной страницы.

Естественно, всем веб-разработчикам важно знать, каковы факторы ранжирования, которые влияют на позицию страницы в поисковой выдаче. Иногда Google дает определенные намеки, объявив важные изменения в обновлениях своих алгоритмов.

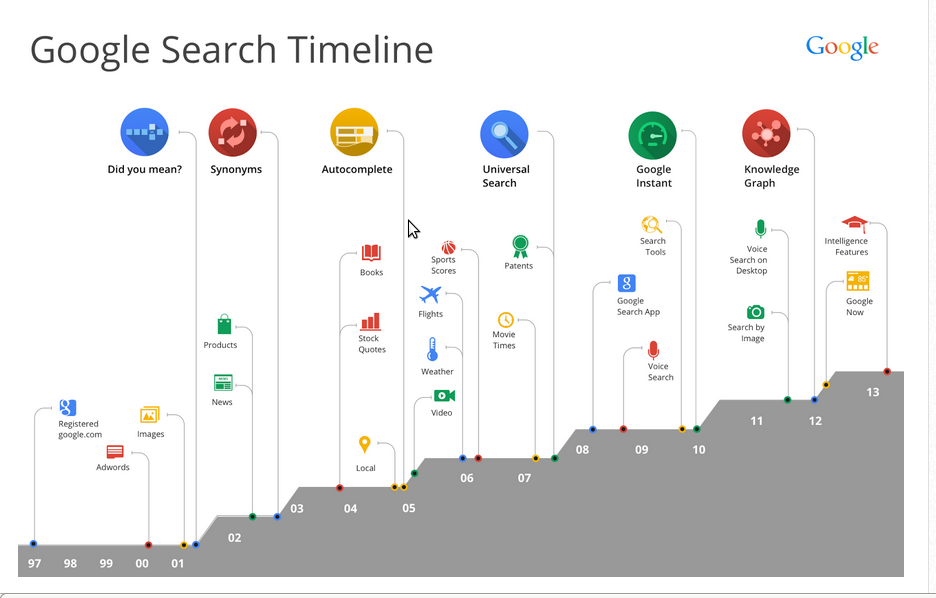

Все вышеописанные процессы сканирования, индексирования и позиционирования можно изобразить с помощью такой схемы:

Теперь, когда у вас есть базовое понимание того, как работает Google, рассмотрим основные обновления алгоритмов поиска, начиная с 2011 года.

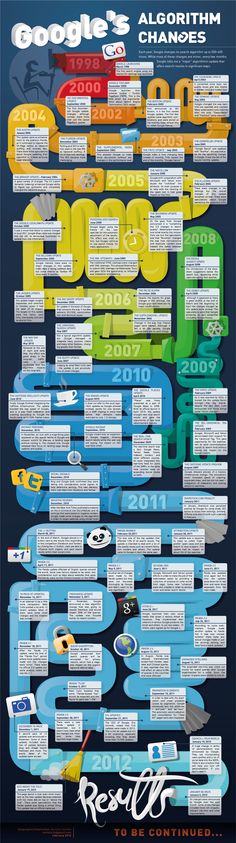

Обновление алгоритмов начиная с 2011

Как вы и сами понимаете, Google никогда не будет публично раскрывать свои алгоритмы поиска и факторы ранжирования результатов. Это было бы равносильно тому, чтоб компания Coca-Cola выкладывала рецепты своей знаменитой газировки в Интернет. Тем ни менее, Google желает улучшать уровень пользовательского опыта и обеспечивать самые лучшие результаты поиска. Для того, чтобы уменьшить внедряемый контент в результатах поиска, компания хочет проинформировать веб-мастеров о том, когда и как изменились главные стандарты качества отбора. Поэтому вполне вероятно, что перед проведением крупного обновления алгоритма, последует анонс на Google Webmaster Central Blog.

Это было бы равносильно тому, чтоб компания Coca-Cola выкладывала рецепты своей знаменитой газировки в Интернет. Тем ни менее, Google желает улучшать уровень пользовательского опыта и обеспечивать самые лучшие результаты поиска. Для того, чтобы уменьшить внедряемый контент в результатах поиска, компания хочет проинформировать веб-мастеров о том, когда и как изменились главные стандарты качества отбора. Поэтому вполне вероятно, что перед проведением крупного обновления алгоритма, последует анонс на Google Webmaster Central Blog.

Итак, давайте рассмотрим основные обновления, которые были осуществлены, начиная с 2011 года:

Panda

Обновление Panda впервые было представлено в конце февраля 2011 года. После было выпущено достаточно много его апдейтов, на данный момент текущая версия: 4.2. Обновление можно рассматривать, как значительное улучшение алгоритма поиска, потому что оно нацелено на повышение качества контента веб-сайтов.

- содержимое на странице должно иметь существенный объем. Больший объем информации статистически занимает место выше, чем содержащий меньше 1500 слов;

- информация, представленная на сайте должна быть оригинальной. Если вы просто копируете содержимое других веб-ресурсов, Google накажет за это;

- содержание сайта должно вносить что-то новое к теме. Мало кому будет интересно в сотый раз перечитывать одно и тоже. Для успешного продвижения контент должно быть то, чего нет на других сайтах;

- текст сайта должен быть орфографически и грамматически правильным и основываться на проверенных фактах;

- если вы собираетесь автоматически генерировать контент из базы данных, содержание должно соответствовать описанным стандартам.

Page Layout (Top Heavy)

Обновление, впервые выпущенное в январе 2012 года, предусматривает наказание сайтов, которые используют слишком много рекламы в верхней части страницы или делают ее чрезмерно агрессивной, отвлекающей от основного содержания. Это спровоцировано большим количеством жалоб от пользователей, которым бывало сложно найти нужную информацию и приходилось долго прокручивать страницу вниз. Данным обновлением Google призывает веб-мастеров размещать содержимое сайта в центре внимания. В этом отношении большое число рекламы мешает удобству усвоения информации.

Penguin

Был выпущен в апреле 2012 года. Новый алгоритм, направленный на борьбу с поисковым спамом. Сайты, которые использовали спам-методы, были значительно понижены в рейтинге или вовсе удалены из него.

Ещё одной особенностью Penguin является способность анализировать ссылочную массу.

Pirate

С обновлением Pirate, которое было введено в августе 2012 года, Google снизил рейтинг сайтов, нарушающих авторские права и интеллектуальную собственность. Для измерения этих нарушений, Google использует систему запросов о нарушении авторских прав, основанную на Digital Millenium Copyright Act. Правообладатели могут применять инструмент, чтобы сообщить и удалить содержание сайта плагиаторов из базы данных Google.

Для измерения этих нарушений, Google использует систему запросов о нарушении авторских прав, основанную на Digital Millenium Copyright Act. Правообладатели могут применять инструмент, чтобы сообщить и удалить содержание сайта плагиаторов из базы данных Google.

Exact Match Domain(EMD)

Выпущено в сентябре 2012 года и направлено на борьбу с доменами, похожими на MFA.

MFA(made-for-adsense) – домен, который создан специально для контекстно-медийной системы Google. Обычно такой домен предназначен для какого-то одного запроса (или семейства запросов) и на нем установлен Google Adsense. Пользователь, попавший на этот домен, не видит ничего, кроме рекламы и в итоге либо закрывает сайт, либо переходит дальше по контекстному объявлению. После выпуска алгоритма EMD, сайты, содержащие в доменном имени запрос, были изъяты или очень существенно понижены в рейтинге.

Payday Loan

Выпущен в июне 2013 года и направлен на уменьшение страниц, которые содержат переспамленные запросы. Такие запросы часто используются веб-мастерами для продвижения страниц определенной тематики.

Такие запросы часто используются веб-мастерами для продвижения страниц определенной тематики.

Обновление было запущенно в связи с многочисленными жалобами, в которых говорилось, что даже после внедрения Panda и Penguin чистота выдачи оставляла желать лучшего.

Рассмотрим это обновление на обычном примере. Допустим, вам нужно купить дверь. Если ввести запрос, Google выдаст фотографии дверей. Из них: 2-3 страницы, где непосредственно можно купить двери, 3-4 сайта компаний-производителей дверей и 2-3 сайта о том, как выбрать и поменять дверь. Если бы не было обновления Payday Loan, вы бы увидели 15-20 запросов на одну тематику (к примеру, где купить дверь).

Критерии, по которым происходит отбор таких сайтов, Google раскрывать не хочет, но данный алгоритм явно упростил жизнь пользователям поисковой системы.

Hummingbird

С сентября 2013 года Google реализовал замену алгоритма поиска, которая была названа Hummingbird. Основные обновления, как Panda и Penguin, были интегрированы с этим новым алгоритмом. Имя Hummingbird выбрали в качестве синонима для описания гибкости, точности и скорости нового обновления.

Имя Hummingbird выбрали в качестве синонима для описания гибкости, точности и скорости нового обновления.

Вместо того, чтобы возвращать точные ответы на запросы, используя введенные пользователем ключевые слова (как это было раньше), Google интерпретирует намерения и контекст поиска. Цель состоит в том, чтобы понять смысл поискового запроса пользователя и возвращать соответствующие результаты. Это означает, что точные совпадения ключевых слов становятся менее важными в пользу поиска намерения. В качестве примера: если вы вводите запрос «погода», то вряд ли ожидаете получить полное объяснение самого термина. Скорее в данном случае имеются в виду погодные условия. Что-то наподобие:

Pigeon

Обновление Pigeon впервые выпущено в июле 2014 года. Основное внимание в нем уделяется результатам геозависимого поиска. Расстояние и местоположение пользователя являются ключевыми параметрами ранжирования, чтобы обеспечить точность результата. Это обновление тесно связано с Google Maps. Например:

Это обновление тесно связано с Google Maps. Например:

Mobilegeddon

Было выпущено в апреле 2015 года. Это обновление влияет только на мобильный поиск, оно дает преимущество страницам, дружественным к мобильным устройствам.

В текущем состоянии, обновление не влияет на результаты поиска со стационарных компьютеров или планшетов. В отличие от Panda или Penguin, алгоритм работает в режиме реального времени.

Существует специальный тест, с помощью которого веб-мастера могут проверить совместимость своего сайта с мобильными устройствами. Также можно использовать отчеты о мобильном юзабилити в Google Webmaster Tools, только они могут работать с задержкой.

Как идти в ногу с изменениями алгоритмов?

Обсуждение основных обновлений алгоритмов за последние годы, вероятно ставит перед вами вопрос, как не отставать от этих изменений? Основная задача Google — постоянно двигаться в направлении обеспечения самого высокого качества и надежности ответов на пользовательские запросы. В то время как технические особенности могут модифицироваться, широкая стратегия вряд ли изменится.

В то время как технические особенности могут модифицироваться, широкая стратегия вряд ли изменится.

Поскольку поведение человека постоянно меняется, задача Google также адаптировать свои алгоритмы согласно изменениям. К примеру, «Mobilegeddon» было введено в качестве реакции на растущую тенденцию поисков с мобильных устройств.

Главное — это понимание того, кто ваши клиенты. Сосредоточенность на реальных потребностях этих клиентов имеет фундаментальное значение для того, чтобы идти в ногу с изменениями.

Итак, если вы — веб-программист, вам особенно важно быть в курсе изменений алгоритмов поиска Google. Вот подборка нескольких полезных ресурсов, которые могут помочь оставаться в курсе событий:

Google Webmaster Central Blog — ваш главный источник для официальных новостей и обновлений, на нем довольно часто впервые объявляли об алгоритмических изменениях.

Moz Google Algorithm Change History — в этой базе данных Moz опубликовал каждое из заметных изменений алгоритма и обновлений начиная с 2000 года.

Search Engine Land – один из наиболее важных онлайн журналов для SEO и SEM. В нем есть целый раздел об обновлениях алгоритмов Google с соответствующими статьями.

Search Engine Roundtable – также включает в себя интересный раздел об обновлениях алгоритмов.

Mozcast — это визуальное представление об изменениях алгоритмов в виде сводки погоды.

Algoroo — инструмент, который отслеживает результаты поиска колебания вокруг 17000 ключевых слов в связи с изменением алгоритма. Очень полезный сайт для обнаружения немедленных обновлений.

Сохраняя традицию. Вот тут можно найти первоисточник.

Обновления и изменения алгоритмов Google: полная история

Что такое алгоритмы Google?

Алгоритмы Google представляют собой сложную систему, используемую для извлечения данных из поискового индекса и мгновенного предоставления наилучших возможных результатов по запросу. Поисковая система использует комбинацию алгоритмов и многочисленных факторов ранжирования для предоставления веб-страниц, ранжированных по релевантности на страницах результатов поисковой системы (SERP).

В первые годы своего существования Google сделала лишь несколько обновлений своих алгоритмов. Теперь Google вносит тысячи изменений каждый год.

Большинство этих обновлений настолько незначительны, что остаются совершенно незамеченными. Однако время от времени поисковая система выпускает основные алгоритмические обновления, которые значительно влияют на результаты поисковой выдачи, такие как:

Ниже мы составили полный список запусков, обновлений и обновлений алгоритмов Google, которые были выпущены за эти годы, а также ссылки на ресурсы для SEO-специалистов, которые хотят разобраться в каждом из этих изменений.

Реклама

Выберите год ALL20222021202020192018201720162015201420132012201120200920052003

Все обновления

27 июля 2022

июля 2022 г. Обновление продукта 2723, что было объявлено Google. Обновленная в июле. 27 -е обновление в июле 27 -го года, который был объявил Google Google.

По обзоре в июле. Маркетологи электронной коммерции могут обратиться к документации Google Search Central о том, как писать качественные обзоры продуктов для получения дополнительной информации.

По обзоре в июле. Маркетологи электронной коммерции могут обратиться к документации Google Search Central о том, как писать качественные обзоры продуктов для получения дополнительной информации.Читать: Обновление алгоритма проверки продуктов Google за июль 2022 г. уже развернуто ⇾

22 мая 2022 г.

Май 2022 г. Базовое обновление

Компания Google объявила через Twitter о выпуске масштабного основного обновления, названного Май 2022 г. Базовое обновление. Это часть серии обновлений, которые Google вносит в общий процесс ранжирования в течение года. Это обновление началось 22 мая 2022 г. и было завершено 9 июня., 2022.

Читать: Google запускает обновление алгоритма Broad Core в мае 2022 года ⇾

Читать:

Обновление ядра Google за май 2022 г. завершено ⇾

завершено ⇾

23 марта 2022 г.

Март 2022 г. Обновление алгоритма продукта

Компания Google объявила в блоге Search Central об обновлении рейтинга обзоров продуктов, которое позволит им определять качественные обзоры. Обновление должно занять несколько недель.

Вы можете узнать больше о стремлении предоставлять более качественные обзоры продуктов для поисковых пользователей на The Keyword и получить совет Google о том, как писать качественные обзоры продуктов.

Читать: Новое обновление алгоритма Google для обзоров продуктов ⇾

1 декабря 2021 г.

Обновление обзора продукта за декабрь 2021 г.

Компания Google объявила через учетную запись Google Search Central в Твиттере, что сегодня началось развертывание обновления обзора продукта за декабрь 2021 г. для англоязычных страниц, и, по оценкам, это займет три недели. Они поделились ссылкой на сообщение в блоге об обновлениях обзоров продуктов и ваш веб-сайт для получения дополнительной информации.

для англоязычных страниц, и, по оценкам, это займет три недели. Они поделились ссылкой на сообщение в блоге об обновлениях обзоров продуктов и ваш веб-сайт для получения дополнительной информации.

Читать: Обновление обзора продукта Google за декабрь 2021 г. ⇾

30 ноября 2021 г.

Обновление локального поиска за ноябрь 2021 г.

Компания Google объявила через Twitter об обновлении локального поиска за ноябрь 2021 г., которое началось 30 ноября и завершилось 8 декабря. Google также предложил компаниям пересмотреть свои рекомендации по улучшению локального рейтинга.

Читать: Google подтверждает обновление результатов локального поиска ⇾

3 ноября 2021 г.

Обновление спама Google

Согласно сообщению Google Search Liasion, обновление спама было выпущено с 3 по 11 ноября 2021 г. в рамках их регулярной работы по улучшению результатов поиска. В своем объявлении они предложили веб-мастерам продолжать следовать Руководству для веб-мастеров.

в рамках их регулярной работы по улучшению результатов поиска. В своем объявлении они предложили веб-мастерам продолжать следовать Руководству для веб-мастеров.

Читать: Развертывание обновления Google Spam завершено ⇾

26 июля 2021 г.

Обновление алгоритма спама ссылок Google

Компания Google объявила о начале развертывания обновления алгоритма, направленного на выявление и нейтрализацию спама ссылок. Google предупредил, что любые сайты, участвующие в тактике ссылочного спама, могут увидеть изменения в рейтинге — спонсируемый, гостевой и партнерский контент, скорее всего, будет затронут. Google заявил, что обновление должно быть полностью развернуто «как минимум» через две недели и затронет несколько языков.

Читать: Обновление алгоритма Google Link Spam выйдет 26 июля ⇾

Читать: Обновление Google для ссылочного спама завершено ⇾

12 июля 2021 г.

Обновление ядра за июль 2021 г. Завершено

Представитель службы поиска Google подтвердил через Twitter, что развертывание обновления ядра за июль 2021 г. было фактически завершено 12 июля. Никаких дополнительных подробностей предоставлено не было.

Читать: Обновление Google за июль 2021 года завершено — что случилось? ⇾

1 июля 2021 г.

Основное обновление за июль 2021 г.

Представитель службы поиска Google объявил в Твиттере, что развертывается основное обновление за июль 2021 г., и его завершение займет от одной до двух недель. Руководство Google по основным обновлениям можно найти в блоге Google Search Central.

Читать: Начинается развертывание основного обновления Google за июль 2021 г. ⇾

28 июня 2021 г.

Обновление спама, часть 2

Представитель службы поиска Google объявил через Twitter, что вторая часть их обновления спама началась 28 июня и, вероятно, будет завершена в тот же день. Первоначальное объявление ссылалось на сообщение в центральном блоге Google Search, обновленное в апреле 2021 года, о том, как Google боролся со спамом в поиске в 2020 году.

Читать: Google объявляет об обновлении спама, часть 2 ⇾

23 июня 2021 г.

Июнь 2021 г. Обновление спама

Дэнни Салливан из Google объявил через Twitter об обновлении алгоритма, направленного на борьбу со спамом, которое внедряется в результаты поиска. Внедрение обновления должно было быть завершено в тот же день. Он добавил, что второе обновление спама последует в течение недели. Google не раскрыл конкретных подробностей о том, на что нацелено это обновление.

Читать: Google выпускает новое обновление алгоритма спама ⇾

10 июня 2021 г.

Защита известных жертв

10 июня Панду Наяк,

научный сотрудник Google и вице-президент по поиску, опубликовал сообщение в блоге The Keyword. В нем он рассказал о работе Google по улучшению алгоритма понижения рейтинга сайтов, которые «используют эксплуататорские методы удаления» и «хищнические методы». Он также поделился ссылкой, которую люди могут использовать, чтобы сообщить о домогательствах в Интернете.

Читать: Обновление алгоритма Google нацелено на клевету ⇾

2 июня 2021 г.

Обновление алгоритма Broad Core

Сотрудник службы поиска Google Дэнни Салливан объявил через Twitter, что скоро будет выпущено обновление алгоритма Broad Core. Салливан также отметил, что некоторые запланированные улучшения не были полностью готовы к этому обновлению, поэтому части, которые не были готовы, будут развернуты в рамках второго, связанного с ним общего обновления алгоритма, запланированного на июль.

Салливан также отметил, что некоторые запланированные улучшения не были полностью готовы к этому обновлению, поэтому части, которые не были готовы, будут развернуты в рамках второго, связанного с ним общего обновления алгоритма, запланированного на июль.

Читать: Обновление алгоритма Google Broad Core выходит 2 июня 2021 г. ⇾

10 февраля 2021 г.

Passage Ranking

Дэнни Салливан, представитель Google по связям с общественностью, объявил через Twitter, что Passage Ranking официально запущен для англоязычных запросов в США. Согласно Google: «Это изменение не означает, что мы индексируем отдельные отрывки независимо от страниц. Мы все еще индексируем страницы и рассматриваем информацию о целых страницах для ранжирования. Но теперь мы можем рассматривать и переходы со страниц как дополнительный фактор ранжирования…».

Читать: Что такое рейтинг Google Passage: 16 ключевых моментов, которые вы должны знать ⇾

3 декабря 2020 г.

Обновление основного алгоритма за декабрь 2020 г.

Google подтверждает, что обновление основного алгоритма за декабрь 2020 г. будет выпущено 3 декабря 2020 г. Это третье обновление основного алгоритма за календарный год. С момента последнего обновления ядра прошло довольно много времени по сравнению со средним временем между этими типами обновлений.

Подробнее об этом обновлении читайте ниже.

Читать: Что такое обновление алгоритма Google Broad Core? ⇾

Читать: Google о восстановлении обновления алгоритма Broad Core — 4 вывода ⇾

Читать: Восстановление после обновления основного алгоритма Google с помощью Lily Ray [PODCAST] ⇾

Читать: Google подтверждает выпуск обновления основного алгоритма ⇾

Читать:

Статистика основного обновления Google за декабрь 2020 г. ⇾

⇾

4 мая 2020 г.

Май 2020 г. Основное обновление

Сотрудник службы поиска Google Дэнни Салливан объявил через Twitter, что Google выпустит масштабное обновление основного алгоритма. Около 90 минут спустя он объявил, что обновление находится в стадии реализации, и для его полного развертывания потребуется 1-2 недели.

Читать: Google подтверждает выпуск обновления базового алгоритма за май 2020 года ⇾

13 января 2020 г.

Январь 2020 г. Основное обновление

Дэнни Салливан из Google объявил в Твиттере, что скоро будет выпущено широкое обновление основного алгоритма. Google снова предоставил те же рекомендации, что и для всех других недавних широких обновлений основного алгоритма.

Читать:

Обновление ядра Google за январь 2020 г. будет выпущено в ближайшее время ⇾

будет выпущено в ближайшее время ⇾

9 декабря 2019 г.

BERT (по всему миру)

Дэнни Салливан из Google написал в Твиттере, что BERT начинает свое всемирное развертывание и включает следующие языки: африкаанс, албанский, амхарский, арабский, армянский, азербайджанский, баскский, белорусский, болгарский, каталанский, китайский (упрощенный и тайваньский), хорватский, чешский, датский, голландский, английский, эстонский, фарси, финский, французский, галисийский, грузинский, немецкий, греческий, гуджарати, иврит, хинди, венгерский, исландский, индонезийский, итальянский, японский , яванский, каннада, казахский, кхмерский, корейский, курдский, киргизский, лаосский, латышский, литовский, македонский малайский (Бруней-Даруссалам и Малайзия), малаялам, мальтийский, маратхи, монгольский, непальский, норвежский, польский, португальский, пенджаби, румынский, Русский, сербский, сингальский, словацкий, словенский, испанский, суахили, шведский, тагальский, таджикский, тамильский, телугу, тайский, турецкий, украинский, урду, узбекский и вьетнамский.

Читать: Google BERT развертывается по всему миру ⇾

1 августа 2019 г.

Обновление избранных сниппетов

Компания Google объявила об обновлении алгоритма, влияющего на актуальность избранных сниппетов в результатах поиска. Это обновление позволит Google находить самые свежие избранные фрагменты для запросов, где текущая информация будет наиболее полезной.

Читать: Google объявляет об обновлении Featured Snippets ⇾ 13 февраля 2019 г. Однако, в отличие от других обновлений, в основном сообщалось о положительных изменениях в рейтингах.

Читать: Доказательства обновления алгоритма Google Valentine’s Day ⇾

16 апреля 2018 г.

Обновление алгоритма общего ядра

Компания Google подтвердила через Twitter выпуск еще одного обновления алгоритма общего ядра и указала, что оно похоже на обновление от 9 марта 2018 г., касающееся релевантности контента.

Читать: Google подтверждает, что обновление алгоритма выпущено 16 апреля ⇾

9 марта 2018 г.

Обновление алгоритма Broad Core

12 марта Google подтвердил через Twitter, что на прошлой неделе было выпущено «обширное обновление основного алгоритма». В то время как Google был немногословен в деталях, Google заявил, что изменения были предназначены для «улучшения страниц, которые ранее недооценивались», и посоветовал всем «продолжать создавать отличный контент».

Читать: Google подтверждает, что обновление алгоритма произошло на прошлой неделе ⇾

Читать: Изучено обновление алгоритма Google Broad Core ⇾

Читать: Google подтверждает, что мартовское обновление алгоритма касалось релевантности, а не качества ⇾

Читать: Что такое обновление алгоритма Google Broad Core? ⇾

12 декабря 2017 г.

Обновление Maccabees

Некоторые участники поискового сообщества сообщили, что их веб-сайты подверглись обновлению в период с 12 по 14 декабря. Google подтвердил несколько незначительных изменений в основном алгоритме в течение определенного периода времени, но преуменьшил значение этого периода. потока.

Читать: Обновление Maccabees: Google подтверждает новые изменения основного алгоритма ⇾

Читать: Анализ обновлений Google Maccabees: сайты, ориентированные на множество вариантов ключевых слов (круглый стол поисковых систем) ⇾

8 сентября 2017 г.

Fall Flux