Алгоритмы Google — самые важные апдейты за последние года

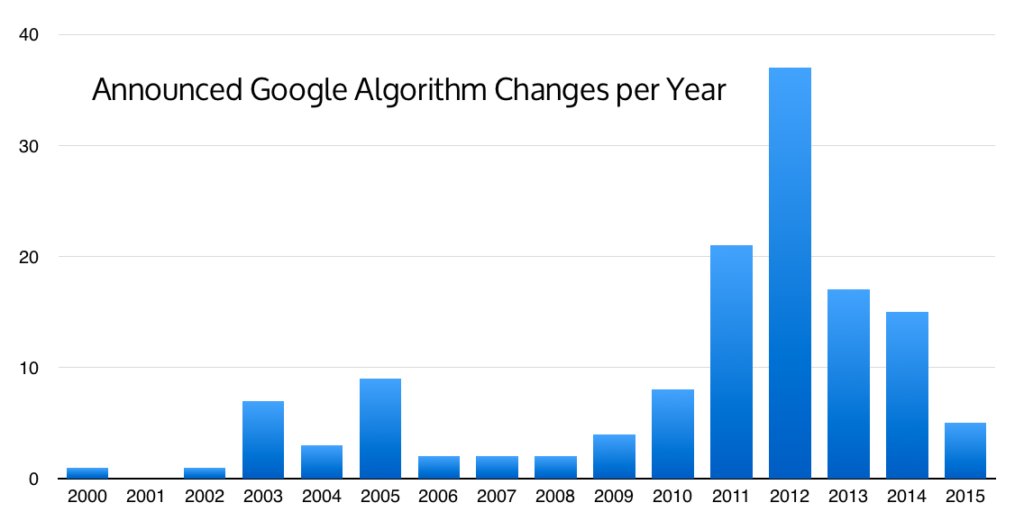

Практически ежемесячно Google выкатывает апдейты алгоритмов (это только те, которые подтверждены официально!). Далеко не все из них оказывают существенное влияние на результаты поисковой выдачи и сегодня мы поможем вам разобраться, какие же алгоритмы внесли существенные изменения в результаты ранжирования за последние годы.

Возможно, какой-либо из них повлиял или повлияет на позиции и трафик вашего сайта. Прочитав эту статью, вы поймете на какие особенности контента, внутренней и внешней оптимизации стоит обратить пристальное внимание и как адаптировать свой сайт к новым требованиям для успешного ранжирования в Google.

1. Панда

Запущен: 24 февраля 2011

Апдейты:~ ежемесячно

Цель: Понижает позиции сайтов с низкокачественным контентом

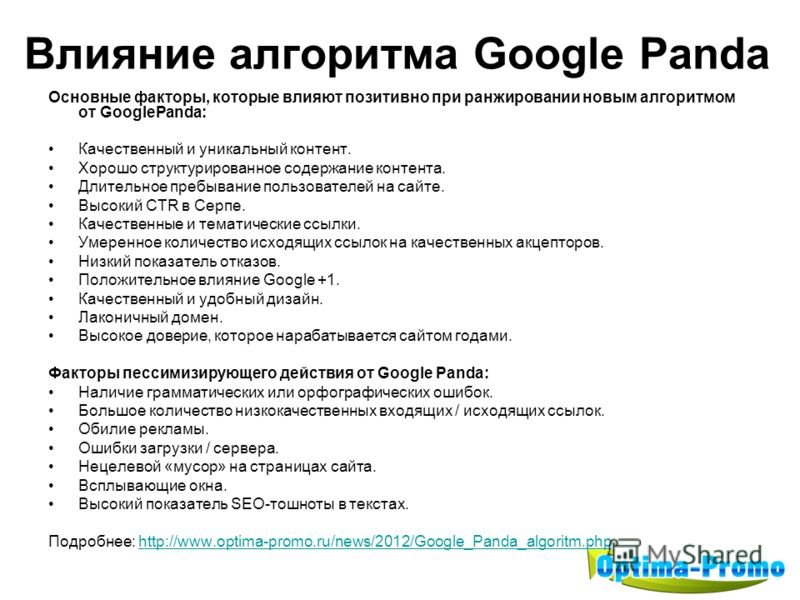

Алогоритм Google Panda используется для обнаружения страниц с неуникальным контентом, с контентом, наводненным ключевыми запросами, спамным или автоматически сгенерированным контентом. Алгоритм также может затрагивать сайты с дублирующейся на многих страницах этого же сайта информацией и сайты с недостаточным количеством контента. Такие страницы или сайты в целом понижаются в рейтинге ранжирования гугл.

Алгоритм также может затрагивать сайты с дублирующейся на многих страницах этого же сайта информацией и сайты с недостаточным количеством контента. Такие страницы или сайты в целом понижаются в рейтинге ранжирования гугл.

Первоначально, «Панда» не был частью основного алгоритма, а работал как фильтр Google, то есть затрагивал определенную долю сайтов при каждом своем апдейте. Но в январе 2016 года «Панда» был официально включен в основной алгоритм ранжирования. Это не значит, что алгоритм теперь работает буквально в реальном времени — все также существуют апдейты, которые затрагивают определенную долю выдачи. Просто теперь они стали настолько частыми, что не анонсируются компанией Google.

С одной стороны это увеличивает шансы сайтов из зоны риска быть быстрее пессимизированными «Пандой». С другой — позволяет владельцам сайтов, ранее пострадавшим от алгоритма, намного быстрее восстановить свои позиции и трафик.

За что наказывает алгоритм «Панда»?

— Неуникальный контент (плагиат)

— Дублированный контент на разных страницах одного сайта

— Автоматически сгенерированный контент

— Контент, переспамленный ключевыми запросами

— Спамный контент, сгенерированный пользователями (например, комментарии)

— Недостаточное количество контента на странице (по отношению к рекламным блокам, например)

— Плохой пользовательский опыт

Как обезопасить свой сайт?

— Проверьте сайт на уникальность контента

Даже если вы собственноручно пишете весь контент для сайта — не пренебрегайте периодической проверкой контента на уникальность, как это сделать мы подробно рассказывали в этой статье: Как проверить уникальность контента — обзор сервисов.

Интернет-магазинам стоит позаботиться о хотя бы частичной уникализации информации в карточках товаров. Пусть вы не в силах изменить специфическое техническое описание товара, но сделать уникальные фотографии и видео товара, стимулировать пользователей оставлять настоящие отзывы — вполне реально.

— Проверьте сайт на дублированный контент

Это одна из наиболее частых причин понижения позиций. В силу особенностей разных CMS систем один и тот же контент может быть доступен поисковикам по разным URL адресам, что приводит к появлению страниц-дублей в индексе. К сожалению, владелец сайта может даже не подозревать о таких подводных камнях в структуре своего ресурса. Обнаружить подобные страницы вам поможет специализированное ПО, например Screaming Frog SEO Spider. Просканируйте ваш сайт и обратите внимание на страницы с дублирующимся мета-тегом title и тегом h2, именно они — потенциальные кандидаты на наличие дублированного контента. Примите меры по их устранению либо закрытию от роботов поисковых систем — возможно использование тега canonical, 301 редиректа либо мета тега noindex.

— Проверьте соотношение контента на странице к исходящим ссылкам

Оцените свои страницы в разрезе исходящих ссылок. Возможно, на вашем проекте есть страницы с большим количеством исходящих. В этом случае очень важно добавить на них побольше уникального контента, что поможет избежать пристального внимания «Панды»

2. Пингвин (Google Penguin)

Запущен: 24 апреля 2012

Обновления: 25 мая 2012; 5 октября 2012; 22 мая 2013;4 октября 2013; 17 октября 2014; 27 сентября 2016; 6 октября 2016; сейчас в режиме реального времени

Цель: понижать в ранжировании сайты со спамными ссылочными профилями и сайты, манипулирующие ссылочной массой

Ссылки долго были решающим фактором в ранжировании в Google и алгоритм Пингвин был создан для обнаружения и применения санкций к сайтам с неестественной ссылочной массой. Этот алгоритм изменил само понимание продвижения сайтов под Google и стал страшным сном для многих сео-оптимизаторов. Пингвин стал началом конца эры арендованных ссылок как главной составляющей успешного продвижения. С осени 2016 года находится в свободном плавании — став частью основного алгоритма, увеличил в равной степени как шансы попасть под санкции, так и возможность для их снятия для ранее пострадавших сайтов.

Пингвин стал началом конца эры арендованных ссылок как главной составляющей успешного продвижения. С осени 2016 года находится в свободном плавании — став частью основного алгоритма, увеличил в равной степени как шансы попасть под санкции, так и возможность для их снятия для ранее пострадавших сайтов.

За что сайты попадают под санкции «Пингвина»:

— покупные ссылки

— ссылки, ведущие с низкокачественных спамных сайтов

— ссылки, ведущие с сеток сайтов, созданных специально как доноры для наращивания ссылочной массы

— неестественные анкоры ссылок

— ссылки, ведущие с абсолютно нерелевантных по содержанию страниц

Как обезопасить свой сайт?

— Мониторить изменения в ссылочном профиле

С помощью сервисов для анализа беклинков необходимо периодически отслеживать свой ссылочный профиль. Важно понимать, что за пару спамных ссылок шанс попасть под санкции Пингвина крайне мал, а вот резкое получение сотен ссылок с нерелевантных сайтов будет выглядеть крайне неестественно и может привлечь внимание алгоритма. Почаще смотрите на ссылочный график вашего сайта — любые резкие скачки должны быть внимательно разобраны.

Почаще смотрите на ссылочный график вашего сайта — любые резкие скачки должны быть внимательно разобраны.

— Избавляться от вредоносных ссылок

Вы проанализировали ссылочный профиль и обнаружили спамные ссылки? Теперь стоит задуматься о том, как от них избавиться. Идеальный вариант, если вам удалось связаться с владельцем/веб-мастером сайта и он удалит такую ссылку. Если же этот сценарий невозможен, то следует воспользоваться инструментом отклонения ссылок Google’s Disavow tool. Таким образом вы просите гугл игнорировать спамные ссылки при оценивании вашего ссылочного профиля.

3. Антипиратский апдейт (Google’s Pirate Update)

Запущен: август 2012

Апдейты: октябрь 2014

Цель: понижать в ранжировании сайты, которые регулярно получают жалобы за содержание пиратского (защищенного авторским правом) контента.

Этот алгоритм был разработан, чтобы сайты с многочисленными жалобами на пиратское содержание не имели возможности высоко ранжироваться в результатах поиска Google. Большинство из затронутых алгоритмом сайтов содержали фильмы, музыку или книги, доступные для скачивания или просмотра. К таким сайтам Google также отнес торрент-треккеры и сайты-агрегаторы ссылок на файлообменники, хотя формально они не хранят запрещенные файлы, но предоставляют информацию о том, как их скачать из сети. Точного количества необходимых жалоб для попадания под фильтр поисковик не озвучивает, но однозначно ясно, что работа данного алгоритма далека от идеала — многие сайты с сотнями DMCA жалоб успешно ранжируются в Топ-3.

Большинство из затронутых алгоритмом сайтов содержали фильмы, музыку или книги, доступные для скачивания или просмотра. К таким сайтам Google также отнес торрент-треккеры и сайты-агрегаторы ссылок на файлообменники, хотя формально они не хранят запрещенные файлы, но предоставляют информацию о том, как их скачать из сети. Точного количества необходимых жалоб для попадания под фильтр поисковик не озвучивает, но однозначно ясно, что работа данного алгоритма далека от идеала — многие сайты с сотнями DMCA жалоб успешно ранжируются в Топ-3.

За что накладывается?

Логично, что накладывается за содержание на сайте пиратского контента или информации о том, как получить такой контент в обход правообладателя.

Как обезопасить свой сайт?

Просто не добавлять подобный контент на свой сайт, другого пути нет. Если динамика поступления жалоб от правообладателей будет постоянной, то рано или поздно алгоритм затронет и ваш сайт.

4. Колибри (Hummingbird)

Запущен: 30 августа 2013

Апдейты: —

Цель: предоставлять более релевантные результаты, основываясь на смысловой составляющей поискового запроса

Алгоритм Колибри внес масштабные изменения в область интерпретации поисковиком запросов пользователя. С выходом этого алгоритма основной акцент стал делаться на предоставлении результатов, основанных на понимании намерений пользователя, а не на простом вхождении ключевых слов, как это было прежде. Именно благодаря «Колибри» Google улучшил понимание синонимов и разделение контента по тематикам. Только после выхода этого алгоритма стало возможным увидеть в результатах поиска страницу, на которой в принципе отсутствует поисковый запрос пользователя, но присутствуют его синонимы.

С выходом этого алгоритма основной акцент стал делаться на предоставлении результатов, основанных на понимании намерений пользователя, а не на простом вхождении ключевых слов, как это было прежде. Именно благодаря «Колибри» Google улучшил понимание синонимов и разделение контента по тематикам. Только после выхода этого алгоритма стало возможным увидеть в результатах поиска страницу, на которой в принципе отсутствует поисковый запрос пользователя, но присутствуют его синонимы.

Как «колибри» может затронуть ваш сайт?

Переспам конкретного поискового запроса (ключевого слова) в тексте без использования задающих тематику слов, синонимов и макисмального раскрытия темы увеличивают риск быть пониженным в ранжировании по этому запросу. Вам очень хотелось хорошо ранжироваться по конкретному запросу и поэтому упомянули его в тексте 100500 раз? После выхода «Колибри» вы рискуете получить абсолютно обратный эффект.

Как оставаться в безопасности?

Разнообразьте свой текстовый контент. Используйте подсказки гугл для понимания более длинных поисковых запросов для своей посадочной страницы. Структурируйте контент с помощью заголовков h2-h6, используйте максимально возможное количество синонимов и слов, относящихся к нужной тематике.

Используйте подсказки гугл для понимания более длинных поисковых запросов для своей посадочной страницы. Структурируйте контент с помощью заголовков h2-h6, используйте максимально возможное количество синонимов и слов, относящихся к нужной тематике.

Не используйте прямое вхождение вашего запроса в текст, если он делает его нечитабельным. Не нужно недооценивать сегодняшний уровень распознавания и понимания разговорного языка поисковыми системами. Прочитайте свой текст на продвигаемой странице. Насколько исчерпывающим был ответ на ваш поисковый запрос? Текст написан нормальным языком или в стиле «я-робот» специально для поисковика? Если ответы на эти вопросы вызывают у вас сомнения — смело переписывайте контент.

5. Голубь (Pigeon)

Запущен: 24 июля 2014

Апдейты: 22 декабря 2014

Цель: предоставлять более релевантные результаты локального поиска

Данный алгоритм повлиял на результаты выдачи, в которых имеет значение местонахождение пользователя. Несмотря на ожидания многих специалистов, в основном коснулся только англоязычного сегмента. После выхода этого алгоритма местонахождение пользователя и его расстояние до объекта, предлагаемого как результат выдачи, стали учитываться как факторы ранжирования.

Несмотря на ожидания многих специалистов, в основном коснулся только англоязычного сегмента. После выхода этого алгоритма местонахождение пользователя и его расстояние до объекта, предлагаемого как результат выдачи, стали учитываться как факторы ранжирования.

Алгоритм «Голубь» позволил локальным нишевым бизнесам (ресторанам, кафе, образовательным учреждениям) обойти в результатах выдачи большие раскрученные сайты и получать больше трафика.

Так что, если вы хотите лучше ранжироваться в конкретном регионе, стоит позаботиться о регистрации в Google My Business и упоминании своего сайта в каталогах и сайтах именно этого региона.

6. Mobile Friendly Update

Запущен: 21 апреля 2015

Апдейты: —

Цель: повышать оптимизированные для мобильных устройств страницы в результатах поиска на мобильном устройстве

Это изменение позволило дружественным к мобильным устройствам страницам ранжироваться выше в результатах мобильного поиска. На десктопную выдачу данный апдейт не повлиял. Призван предоставлять пользователю более удобные для мобильного устройства страницы — без необходимости масштабирования для чтения текста, без горизонтальной прокрутки, с удобными для клика элементами.

На десктопную выдачу данный апдейт не повлиял. Призван предоставлять пользователю более удобные для мобильного устройства страницы — без необходимости масштабирования для чтения текста, без горизонтальной прокрутки, с удобными для клика элементами.

Важно отметить, что действие алгоритма направлено именно на конкретную страницу, а не на сайт в целом. Так одна страница может быть признана оптимизированной для мобильных устройств и получить рост позиций, а другая страница наоборот быть пониженной в выдаче.

Как угодить алгоритму?

Сделать свой сайт удобным для использования на мобильном устройстве.

Звучит очень просто, но это самый верный путь.

Проходим mobile friendly test и понимаем, что понятие об удобстве использования у вас и у гугла может быть очень даже разное. Ваша задача найти компромисс — чтобы страница была действительно удобна пользователям и в то же время удовлетворяла требованиям Google.

7. RankBrain

Запущен: 26 октября 2015 (возможно, ранее)

Апдейты: —

Цель: предоставить пользователю лучшие результаты, основанные на релевантности и машинном обучении

RankBrain — это система машинного обучения, позволяющая Google лучше расшифровывать и понимать смысл запросов пользователей и предоставлять более релевантные результаты в зависимости от контекста запроса.

В широком смысле, алгоритм определяет тематику страницы и то, насколько релевантен контент запросу пользователя. Система машинного обучения позволяет по поведению посетителей сайта определить, насколько предоставленный контент был полезен, самообучиться и со временем предоставлять максимально полезные результаты.

Угрозы для вашего сайта:

— недостаток факторов, влияющих на релевантность страницы поисковому запросу

Хотите ранжироваться по определенному запросу, значит нужно повышать релевантность вашей посадочной страницы данному запросу. Как это сделать читайте здесь: 25 способов повысить релевантность контента на странице

— плохой пользовательский опыт

Проанализируйте свои страницы на предмет показателя отказов, времени посещения, определите точки выхода с сайта и постарайтесь улучшить взаимодействие пользователя с вашим сайтом. Также стоит определить страницы, отличающиеся этими метриками от средних по сайту и выяснить причину плохого пользовательского опыта.

Например, это может быть не лучшая сортировка товаров по умолчанию (от высокой цены к низкой) на странице категории интернет-магазина, что формирует у пользователя неверное впечатление о магазине.

Точно также вы можете найти и наиболее интересные пользователям страницы. Проанализируйте их контент и используйте эти знания при создании новых страниц, а также для оптимизации существующих.

Также не стоит забывать, что чем больше на странице разнообразного контента и интерактивных элементов, тем более высокие поведенческие показатели, как правило, она получает.

8. Опоссум (Possum)

Запущен: 1 сентября 2016

Апдейты:—

Цель: предоставлять лучшие, более релевантные результаты локальной выдачи, основываясь на местонахождении пользователя

Еще один представитель фауны из «зоопарка» Google, призванный улучшить результаты локального поиска. Благодаря этому алгоритму местонахождение пользователя стало еще более важным фактором для показа того или иного результата из Local Business — чем ближе пользователь к адресу компании, тем с большей вероятностью данный результат будет присутствовать в выдаче.

Алгоритм серьезно отфильтровал аффилированные организации, например, с одинаковыми номерами телефонов или адресами. Это позволило предоставлять более разнообразные результаты во избежание попыток узурпации локальной выдачи.

Еще одной особенностью алгоритма стала возможность лучшего ранжирования для компаний с физическим адресом за пределами определенного города. Так, если до выхода «опоссума» такие компании практически не показывались в локальных результатах по запросам с названием города, то после — получили неплохой рост по количеству показов и, соответственно, трафику.

9. Фред (Fred)

Запущен: 8 марта 2017

Апдейты:—

Цель: отфильтровывать низкокачественные страницы из результатов поиска, чьей целью является прибыль от размещения рекламы и ссылок на другие сайты

Последний из подтвержденных Гугл апдейтов основного алгоритма, Fred получил свое имя благодаря шутке сотрудника Google Гэри Илш (Gary Illyes), который предложил все последущие апдейты называть “Fred”. Представители поисковика подтвердили, что апдейт имел место быть, но в довольно обтекаемой форме объяснили принцип его работы. Так, по словам представителей Google, Fred наказывает сайты, нарушающие рекомендации для веб-мастеров. Такое утверждение не дало полезной информации сообществу seo-оптимизаторов, а вот практические исследования показали, что от Фреда страдают сайты с малоценным контентом, размещающие переоптимизированные ключевыми словами тексты, большое количество рекламы либо исходящих ссылок.

Представители поисковика подтвердили, что апдейт имел место быть, но в довольно обтекаемой форме объяснили принцип его работы. Так, по словам представителей Google, Fred наказывает сайты, нарушающие рекомендации для веб-мастеров. Такое утверждение не дало полезной информации сообществу seo-оптимизаторов, а вот практические исследования показали, что от Фреда страдают сайты с малоценным контентом, размещающие переоптимизированные ключевыми словами тексты, большое количество рекламы либо исходящих ссылок.

«Жертвы» Фреда:

— Сайты, злоупотребляющие баннерной, pop-up и другими видами рекламы

— Сайты со статьями написанными специально для роботов поисковых систем с целью генерации трафика

— Сайты с большим количеством исходящих ссылок

Как оставаться в безопасности?

— Поумерить свой пыл в плане монетизации проекта рекламными блоками

— Вместо унылых роботизированных seo-текстов писать релевантный полезный контент

Резюме:

Теперь Вы вооружены четко структурированными знаниями о принципах действия самых важных алгоритмов Google. Очень надеемся, что эта статья будет полезна вам как для продвижения в русскоязычном, так и в англоязычном сегменте. Если же ваш сайт потерял трафик и позиции и вы не можете четко определить из-за какого алгоритма это произошло, начните со статьи про возможные причины потери позиций, а если и это не внесет ясность — обращайтесь за аудитом в компанию Q-SEO!

Очень надеемся, что эта статья будет полезна вам как для продвижения в русскоязычном, так и в англоязычном сегменте. Если же ваш сайт потерял трафик и позиции и вы не можете четко определить из-за какого алгоритма это произошло, начните со статьи про возможные причины потери позиций, а если и это не внесет ясность — обращайтесь за аудитом в компанию Q-SEO!

Комментарии

Комментарии

История развития поисковых алгоритмов Google

Борьба за качество поиска продолжается на протяжении всего развития поисковой системы Google. C 2002 года регулярно выходили обновления, которые, с одной стороны, делали поиск лучше, а с другой, усложняли жизнь оптимизаторам и владельцам сайтов, вынуждая приспосабливаться под новые условия.

Предлагаем вспомнить, как развивался поисковик №1 в мире. Ниже представлены знаковые обновления алгоритмов, которые раз за разом приводили вебмастеров в замешательство, но все же делали поиск лучше. Во всяком случае, по мнению гугломенов.

Истоки

В 1996 году студенты Стэнфордского университета Ларри Пейдж и Сергей Брин начали работу над проектом BackRub, посвященным изучению ценности веб-страниц с точки зрения количества ссылающихся на них сайтов. В итоге разработали алгоритм PageRank.

В итоге разработали алгоритм PageRank.

Анализ поисковой выдачи на основе этого алгоритма показал более высокую релевантность результатов, чем в случае с существующими алгоритмами (на тот момент приоритет в выдаче получали страницы, на которых чаще встречалась ключевая фраза).

В 1998 году вышла статья «Анатомия системы крупномасштабного гипертекстового веб-поиска», в которой подробно описывался механизм расчета PageRank и работы новой поисковой системы Google. Поисковик, которым сегодня пользуется более 70 % населения планеты, в то время размещался на сайте Стенфорда и выглядел так:

В резюме к статье авторы написали:

«Google предназначен для эффективного сканирования и индексации интернета и обеспечения гораздо более удовлетворительных результатов поиска, чем существующие системы».

Эта философия до сих пор движет развитием поисковика. Сегодня для ранжирования документов в Google используется искусственный интеллект, а поисковая выдача стала персонализированной и зависит не только от качества, релевантности и авторитетности сайта, но и месторасположения пользователя, его интересов, образа жизни и прочих факторов.

Первый апдейт (01.09.2002)

Поначалу Google примерно 10 раз в год обновлял свои базы данных, что вызывало небольшие изменения в результатах поиска. Эти обновления в среде вебмастеров прозвали «Танец Гугла» («Google Dance»). На этот же раз изменения были намного заметней. Несмотря на то, что официального разъяснения от Google не последовало, именно это событие считается первым серьезным апдейтом алгоритма.

2003-й: обновления становятся чаще

Февраль: Бостон

Это первое официальное обновление алгоритма, представленное Google. Суть его в том, что текущие апдейты баз происходят не раз в месяц, как это было ранее, а намного чаще.

Июль: Фриц

Ежемесячный «Google Dance» окончательно уходит в прошлое — теперь Google обновляется каждый день.

Кроме этих официально подтвержденных апдейтов в 2003-м году вебмастера заметили еще несколько. Им были даны оригинальные названия:

- Кассандра (апрель) — под санкции попали сайты, на которые вели ссылки с PBN-доменов, а также страницы со скрытым текстом.

- Доминик (май) — не удалось связать этот апдейт с каким-то конкретным изменением в выдаче, но наблюдалась повышенная активность гуглоботов.

- Эсмеральда (июнь) — обновление подготовило пришествие Фрица и стало последним ежемесячным апдейтом основного алгоритма Google.

Начало борьбы с некачественным контентом

Дополнительный индекс («Supplemental Index»)

С целью повышения производительности с сентября 2003 года Google начал заносить некоторые страницы в дополнительный индекс. Это были страницы с малоинформативным, дублирующимся контентом. Они не отражались в основных результатах поиска, но Google знал об их существовании, и пользователи могли просмотреть дополнительные результаты поиска по конкретному сайту, кликнув по ссылке «Supplemental Results».

Вот как это выглядело в рунете.

В 2007 году ссылку убрали, но дополнительный индекс остался и еще долгое время вводил в заблуждение оптимизаторов. Сегодня Supplemental Index неактуален.

Флорида (01.11.2003)

Это знаковое обновление, которое серьезно повлияло на качество выдачи и сформировало новую индустрию — SEO-продвижение. Впервые в выдаче просели коммерческие сайты, которые использовали незамысловатые техники продвижения 90-х вроде размещения списков ключевых фраз на страницах сайта. С выходом этого апдейта начали массово появляться профессиональные SEO-оптимизаторы, которые отслеживали изменения алгоритмов и адаптировали сайты под новые требования.

Бренди (01.02.2004): появление LSI

Google ввел ряд изменений: расширил основной индекс, внедрил латентно-семантическое индексирование (LSI), повысил роль анкорного текста и ссылочного окружения. Благодаря LSI Google начал понимать синонимы и околотематические слова, что вывело работу с ключевыми запросами на новый уровень.

Подарок на Новый 2005-й год — nofollow-ссылки

С целью борьбы со спамными ссылками, в частности, с комментариев и форумов, Google, Yahoo и Microsoft совместно предложили использовать атрибут rel=»nofollow» для ссылок, которые нужно закрыть от индексации поисковыми роботами. Что и было реализовано 1 января 2005 года.

Что и было реализовано 1 января 2005 года.

Сегодня nofollow-ссылки не менее важны для SEO, чем dofollow, ведь они позволяют сделать ссылочный профиль естественным.

Персонализация поиска

Google и ранее персонализировал выдачу, но делал это на основе пользовательских настроек в профиле. С 1 июня 2005 года Google впервые начал использовать историю поиска для формирования выдачи на основе интересов и предпочтений. Несмотря на то, что поначалу влияние алгоритма было едва заметным, обновление дало толчок к развитию полноценного персонализированного поиска.

В этот же день Google позволил добавлять в Webmaster Tools (сегодня — Search Console) карты сайта в формате XML, что позволило ускорить и улучшить индексацию страниц.

Jagger: борьба с некачественными ссылками

С сентября по ноябрь 2005 года Google выкатил несколько обновлений, связанных со спамными ссылками, ссылочными фермами и биржами платных ссылок. Сильнее всего выдачу «тряхнуло» в октябре.

Google local: объединение данных карт и Local Business Center

Поисковик работает над тем, чтобы улучшить представление информации о местном бизнесе в локальном поиске. С этой целью в марте 2005 года он объединяет данные Google maps и Local Business Center (LBC).

С этой целью в марте 2005 года он объединяет данные Google maps и Local Business Center (LBC).

2007-й год: универсальный поиск

1 мая 2007 года Google в обычную выдачу начал «подмешивать» результаты из новостей, видео, карт, изображений и т. п. Таким образом, выдача стала более разнообразной. В то время результаты поиска выглядели так:

Универсальный поиск Google в 2007 году

Август 2008 года: поисковые подсказки

Потребовалось 4 года, чтобы протестировать и запустить инструмент Google Suggest для упрощения поиска. Пользователь начинал вводить запрос, и ему предлагался в выпадающем списке перечень связанных запросов:

Технология успешно работает по сей день, а сбор поисковых подсказок является одним из способов расширения семантического ядра сайта.

Февраль 2009-го: поддержка атрибута rel=»canonical»

Google, Microsoft и Yahoo начали поддержку атрибута rel=»canonical», который решает проблему дублей на сайте: страниц с разными адресами, но одинаковым содержимым. Сегодня с этим атрибутом знаком каждый SEO-специалист.

Сегодня с этим атрибутом знаком каждый SEO-специалист.

Декабрь 2009-го: поиск в реальном времени

В выдачу были интегрированы новости из Google news, актуальные твиты, посты в соцсетях, недавно проиндексированный контент. Это позволило пользователям получать свежую информацию в режиме real-time.

Развитие локального поиска: Google Адреса

Сервис Google Places с апреля 2010 года выходит из Google maps и становится самостоятельным. Результаты Адресов интегрируются в локальный поиск, появляются новые форматы местной рекламы.

Кофеин (01.06.2010): работа над «свежестью» результатов

Это не очередное обновление алгоритма, а принципиально новая система индексации. Раньше процесс был похож на слоеный пирог, когда индексация нижних слоев была невозможна без индексации верхних. «Кофеин» изменил подход — теперь обход страницы роботом и индексация не разорваны во времени. В результате Google увеличил «свежесть» индекса на 50 %.

Принцип работы системы индексации «Кофеин»

Панда (Фермер) — новый виток борьбы с некачественными страницами

Алгоритм «Панда» был анонсирован 23. 02.2011. Он появился в ответ на массовые жалобы со стороны пользователей на сайты в ТОПе с низкопробным «информационным» контентом, бесполезным по своей сути и зачастую неуникальным. «Панда» отсеивает из ТОПа подобные сайты. Отныне «штампование» статей сомнительного качества и копирование текстов с других сайтов не приводит к росту позиций.

02.2011. Он появился в ответ на массовые жалобы со стороны пользователей на сайты в ТОПе с низкопробным «информационным» контентом, бесполезным по своей сути и зачастую неуникальным. «Панда» отсеивает из ТОПа подобные сайты. Отныне «штампование» статей сомнительного качества и копирование текстов с других сайтов не приводит к росту позиций.

«Панда» обновлялся почти каждый месяц вплоть до 2013 года, отсеивая новые порции сайтов. После этого было только несколько обновлений. Последнее — 17.07.2015 года («Панда 4.2», 28-е по счету).

Поддержка Schema.org и дополнительные ссылки в выдаче

2 июня 2011 года три гиганта на тогдашнем рынке поиска — Google, Yahoo и Microsoft — объявили о едином подходе к структурированным данным. Разметка Schema.org до сих пор поддерживается Google. Ее использование позволяет пользователю узнать больше информации о странице и таким образом повышает CTR сниппета в выдаче.

Внедрили микроразметку, а rich snippet все равно не отображается? Мы рассказали о возможных причинах.

Проверьте свой сайт и сделайте все, что в ваших силах, чтобы исправить ситуацию.

В августе 2011 года Google выкатил еще одно обновление SERP: по брендовым запросам в сниппетах появились дополнительные ссылки. Поначалу их было 12, но вскоре поисковик ограничил количество шестью.

Так выглядит сниппет с дополнительными ссылками в 2020-м.

«Top Heavy»: борьба за юзабилити

19 января 2012 года алгоритм понижает в выдаче сайты с избытком рекламы в верхней части страницы. Кроме того, реклама не должна перекрывать текст и другой контент, а также доминировать на странице. Таким образом, Google начал борьбу за повышение юзабилити сайтов.

Пингвин — ужас ссылочных бирж

24 апреля 2012 года вышел один из важнейших алгоритмов, из-за которого пострадал рынок массовой закупки ссылок для продвижения в Google. «Пингвин» создан для борьбы с манипуляцией выдачей с помощью спамных техник (ссылки с неестественными анкорами, «ссылочный взрыв», переспам текстов ключевыми запросами и т. п.). В анонсе алгоритма указано:

п.). В анонсе алгоритма указано:

«Мы хотим, чтобы люди занимались «белой» поисковой оптимизацией (или вовсе ею не занимались) и могли сосредоточиться на создании привлекательных веб-сайтов».

Посыл вполне ясный: SEO — это меры, направленные на улучшение сайта, но не на поиск уязвимостей Google. Чтобы не попасть под очередное обновление «Пингвина», рекомендовалось разнообразить внешний ссылочный профиль: разбавить анкоры, добавить nofollow-ссылки и естественные ссылки с авторитетных доноров, постепенно снимать ссылки с нетематических сайтов, изменить вхождение ключей и т. п.

«Пингвин» обновлялся примерно раз в год. Последний раз — 27.09 и 06.10.2016 года (Penguin 4.0, Phase 1 и 2). В этот раз алгоритм не понижает сайты в выдаче, а просто не учитывает вес, передаваемый «плохими» ссылками. Иными словами, они становятся бесполезными, и сайт естественным путем теряет позиции.

Апдейтов «Пингвина» больше не будет — он становится частью основного поискового алгоритма и работает в непрерывном режиме.

Как узнать, что Google применил санкции к вашему сайту? Мы рассказали о 7 способах проверки на фильтры поисковых систем.

DMCA Penalty: борьба с пиратским контентом

Для борьбы с пиратством Google 10 августа 2012 года запустил алгоритм «DMCA Penalty», или «Pirate». Так как стало поступать много жалоб на его неэффективную работу, 21 октября 2014 года вышло обновление — «Pirate 2.0».

Проседание позиций было существенным — некоторые сайты теряли до 98% видимости. «Pirate 2.0» выбирает сайты для пессимизации путем анализа семантики на предмет наличия «пиратских» запросов (например, «скачать музыку бесплатно», «фильмы торренты скачать» и т. п.), а также учитывает жалобы от правообладателей в DMCA.

В 2020 году в выдаче Google по подобным запросам можно увидеть уведомление о скрытых результатах:

Колибри: учет пользовательского интента

В Google выявили, что запросы становятся все более «разговорными». Например, когда пользователь вводит запрос «какова высота Эвереста», он хочет получить конкретный ответ, а не найти страницу, на которой есть такой же вопрос. Для того чтобы Google понимал не только контекст вводимого запроса, но и пользовательский интент (намерение), в августе 2013 года запустили алгоритм «Колибри». Это масштабное обновление, которое затронуло 90% всех результатов поиска.

Для того чтобы Google понимал не только контекст вводимого запроса, но и пользовательский интент (намерение), в августе 2013 года запустили алгоритм «Колибри». Это масштабное обновление, которое затронуло 90% всех результатов поиска.

Голубь (Pigeon): обновление локального поиска

Алгоритм был анонсирован 24 июля 2014 года. Основная его направленность — улучшение выдачи по запросам, связанным с местоположением. Результатом обновления стала ротация сайтов в местной выдаче в зависимости от местоположения пользователя в момент запроса.

Преимущество сайтов с HTTPS/SSL

С 6 августа 2014 года сайты с SSL-сертификатами получают незначительное преимущество в выдаче. Интернет-магазины и прочие сайты, которые имеют дело с личными данными пользователей и онлайн-платежами, начали массовую миграцию на HTTPS.

В блоге PromoPult есть подробная инструкция по переходу на протокол HTTPS.

«Mobile-friendly» («Mobilegeddon»)

С апреля 2015 года в мобильной выдаче Google при прочих равных условиях приоритет отдается результатам, оптимизированным для просмотра на мобильных устройствах.

Для проверки мобилопригодности пройдите Mobile-Friendly Test. Если с сайтом есть проблемы, появится соответствующее сообщение с перечнем ошибок.

В мае 2016 года вышло обновление алгоритма — Mobile-Friendly 2.

RankBrain (26.10.2015)

RankBrain — это часть основного поискового алгоритма Google, работающая на принципах машинного обучения. Новый алгоритм создан для эффективного поиска релевантных страниц по поисковым запросам. Для SEO это означает бесповоротный уход от спамных техник в сторону создания качественных площадок и контента, который интересен целевой аудитории.

Intrusive Interstitial Penalty: санкции за межстраничные всплывающие объявления

С января 2017 года Google начал понижать позиции сайтов, которые показывают назойливые объявления, перекрывающие основной контент. Алгоритм касается:

- только мобильной выдачи и не затрагивает десктопную;

- сайтов, которые показывают объявления сразу после перехода пользователя из поисковой системы (то есть за объявления при переходе между страницами сайта санкций не будет).

Примеры назойливых объявлений

Увеличение длины сниппета

После почти двухлетнего тестирования длинных сниппетов в ноябре 2017 года Google увеличил длину описания почти в 2 раза — примерно до 300 символов. Через некоторое время (в мае 2018 года) поисковик отказался от этого эксперимента, но не во всех случаях.

Подробнее о длине description и о том, как часто Google игнорирует содержимое этого метатега, читайте в исследовании.

Mobile-First Index

После тестирования в течение многих месяцев 26 марта 2018 г. наконец было объявлено о внедрении Mobile-First Index. Наличие и работоспособность мобильной версии сайта отныне стало одним из важных факторов ранжирования в Google. Вебмастера стали получать уведомления в Google Search Console о том, что их сайты переведены на приоритетное мобильное индексирование.

С сентября 2020 года Google планировал применить Mobile-First ко всем сайтам. В связи с пандемией COVID-19 внедрение перенесено на март 2021 года.

Изучите руководство по Mobile First: часть 1, часть 2, часть 3.

Медицинский апдейт (Флорида) и EAT

С 2018 года Google регулярно анонсирует core updates — апдейты основного («корневого») алгоритма. Первым в этом ряду стал так называемый медицинский апдейт, который затронул сайты с контентом на медицинскую тематику и YMYL-сайты (Your Money Your Life): ecommerce, финансы, кредиты и т.д. Наибольший «шторм» в выдаче наблюдался 1 — 2 августа 2018 года.

Поисковик начинает оценивать сайты, которые влияют на здоровье, жизнь и финансовое состояние человека, по строгим критериям качества. На таких ресурсах должна быть достоверная информация из авторитетных источников.

Следующие апдейты основного алгоритма Google с сентября 2018 по сентябрь 2019 года в основном касались факторов, которые объединяют в аббревиатуру E-A-T, где:

- E (expertise) означает экспертный уровень автора контента. Все темы, которые касаются здоровья и благополучия пользователей, должны освещать специалисты в соответствующих областях.

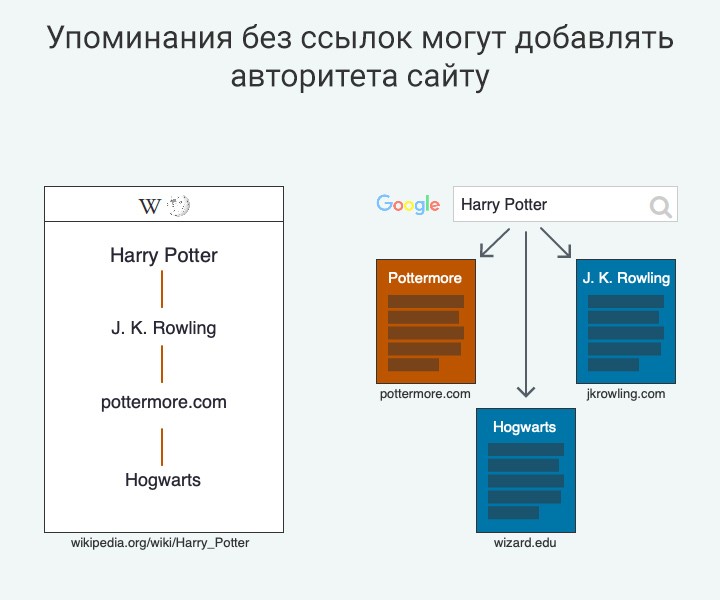

- A (authoritativeness) означает авторитетность автора или сайта в целом. Измеряется в цитируемости материалов конкретного эксперта или ресурса.

- T (trustworthiness) означает надежность сайта. Ресурс должен вызывать доверие посетителей за счет качественного контента, указания полной контактной информации, а также информации об оплате, доставке и гарантиях, если это необходимо.

С 2019 года для YMYL-сайтов началась новая эпоха. Чтобы выйти из-под апдейта алгоритма или не попасть под него, нужно позаботиться об авторитетном экспертном контенте.

Google BERT

22 октября 2019 Google анонсировал обновление алгоритма BERT (Bidirectional Encoder Representations from Transformers — двунаправленная нейронная сеть кодировщик). Суть обновления в том, что алгоритм на основе нейронной сети лучше понимает фразы на естественном языке. Этим поисковик заявляет о новом подходе к формированию выдачи на основе смысла запроса, а не значения конкретных ключевых слов. Учитываются: порядок слов, предлоги, контекст, интент запроса.

Учитываются: порядок слов, предлоги, контекст, интент запроса.

May 2020 Core Update

Обновление алгоритма было запущено 4 мая 2020 года и повлияло на сайты YMYL-тематики, а также некоторые другие сферы. Среди изменений в выдаче было замечено:

- более частое появление ссылок из соцсетей в SERP;

- монополизация выдачи крупными порталами, даже по средне- и низкочастотным запросам.

Как и всегда, представители Google довольно сдержанно комментируют суть обновлений. Чтобы проверить, соответствует ли сайт критериям качества, изучите асессорскую инструкцию Google и уделите внимание E-A-T-факторам.

Core Web Vitals: внедрение в 2021 году

Летом 2020 года Google анонсировал Core Web Vitals — комплекс факторов, которые определяют качество ресурса. Под этим же названием поисковик планирует объединить сервисы, которыми можно проверить производительность сайта, в один общий: Lighthouse, Chrome DevTools, PageSpeed Insights и Search Console’s Speed Report.

Ядро Core Web Vitals (CWV) составляют три фактора:

- Largest Contentful Paint (LCP) — время отрисовки браузером основного контента на странице в видимой области просмотра.

- First Input Delay (FID) — время ответа сервера после первого взаимодействия со страницей.

- Cumulative Layout Shift (CLS) — показатель смещения элементов на странице в процессе ее загрузки. Здесь важно обратить внимание, есть ли на странице рекламные блоки, которые сдвигают основной контент по мере загрузки и таким образом делают его менее доступным для пользователя.

Совокупность этих показателей говорит о качестве сайта и степени удовлетворенности пользователя от взаимодействия с ним.

CWV планируется полноценно внедрить в 2021 году.

Движение в сторону комплексного продвижения

Историю алгоритмов Google полезно знать не просто ради общего развития. Она дает понимание того, куда движется поисковая оптимизация. Современное SEO давно вышло за пределы чисто ссылочной или текстовой оптимизации — важна работа над комплексом внутренних и внешних факторов, иногда даже напрямую не связанных с вебом. Таких, например, как репутация бренда или специалиста.

Современное SEO давно вышло за пределы чисто ссылочной или текстовой оптимизации — важна работа над комплексом внутренних и внешних факторов, иногда даже напрямую не связанных с вебом. Таких, например, как репутация бренда или специалиста.

Именно поэтому PromoPult развивается в сторону комплексного маркетинга, автоматизируя работу с разными инструментами продвижения. Поисковая оптимизация сайта, контекстная реклама, реклама в соцсетях, управление репутацией, повышение конверсии на сайте доступны для всех зарегистрированных пользователей PromoPult.

Все, что вам нужно знать

Обновление Google Freshness Update было значительным изменением алгоритма ранжирования, которое представило тенденцию делать результаты поиска более точными и реагирующими на намерения пользователя.

Результатом обновления стала возможность добавлять время в качестве меры релевантности для поисковых запросов. Это позволило Google отображать контент, который находится в тренде, регулярно появляется (например, ежегодное событие) или часто обновляется (например, новые модели продуктов).

Обновление Freshness стало возможным благодаря изменениям инфраструктуры, внесенным в Caffeine Update, которые позволили Google масштабировать веб-индексацию в беспрецедентных масштабах, позволяя Google отображать самый актуальный контент, который буквально актуален. актуальная минута.

Об обновлении алгоритма было объявлено 3 ноября 2011 года.

В официальном сообщении в блоге Google говорилось, что изменение затронуло около 35% поисковых запросов и заметно повлияло примерно на 6–10% поисковых запросов.

Это существенное изменение в ранжировании веб-страниц.

Почему это называется алгоритмом свежести?

Название «свежесть» для этого обновления напрямую взято из официального объявления Google:

«Поиск Google использует алгоритм обновления, разработанный для предоставления вам самых последних результатов».

Что сделало возможным это обновление алгоритма

Причина, по которой Google выпустила обновление Freshness, заключалась в том, что новая система индексации Caffeine предоставила Google возможность быстрее обрабатывать больше веб-страниц.

Инфраструктура Caffeine позволила Google предоставлять свежие результаты с более высокой степенью релевантности, используя более детальное определение того, что означает свежесть.

В частности, Google определил, что некоторые запросы имеют три различных типа факторов релевантности, связанных со временем.

Существует три типа запросов, связанных со временем:

- Недавние события: Это поисковые запросы, относящиеся к тенденциям или текущим событиям, обычно связанным с новостями.

- Регулярно повторяющиеся события: В объявлении Google приводились примеры ежегодных событий, выборов, спортивных результатов, телешоу и отчетов о доходах корпораций.

- Частые обновления: Это запросы, связанные со временем, для тем, которые часто обновляются, но не являются событиями или популярными темами. Примерами являются поисковые запросы для продуктов, которые часто обновляются.

Актуальность актуальных тем и последних событий

Актуальные темы

Google показывает свежие результаты для определенных запросов, особенно если они находятся в тренде.

Вот пример с ключевым словом LIMoE, которое является названием алгоритма Google:

Скриншот из поиска [limoe], Google, июнь 2022 г.

Недавние события

Когда алгоритм был выпущен, не было такой вещи, как раздел новостей Top Stories для текущих событий.

Google просто показывал новости, связанные с недавними событиями, вверху результатов поиска.

Сегодня Google покажет раздел Top Stories , когда поисковый запрос имеет недавнее событие типа компонента релевантности.

Например, поисковый запрос для Украины дает следующий результат поиска:

Скриншот из поиска [украина], Google, июнь 2022 г.

Функция «Главные новости» отображается для последних событий, которые находятся в тренде. Это пример свежего результата типа «Недавние события».

Это пример свежего результата типа «Недавние события».

Свежесть для регулярно повторяющихся событий

Этот вид свежести относится к событиям, которые происходят регулярно, но не обязательно являются популярными.

Компания Google использовала пример поискового запроса, связанного со спортом, в качестве поискового запроса типа повторяющегося события.

Поиск НБА показывает недавние спортивные результаты:

Скриншот из поиска [nba], Google, июнь 2022 г.

Тип обновления повторяющихся событий необходимо будет регулярно обновлять. Спортивное событие должно обновляться ежедневно или еженедельно, когда спорт находится в сезоне.

Повторяющееся событие президентских выборов должно обновляться каждые четыре года.

Актуальность частых обновлений

Третий тип актуальности связан с поисковыми запросами по темам, которые всегда обновляются, например запросы, связанные с обзорами продуктов.

В идеале при поиске Samsung Galaxy Review лучшим результатом будут отзывы о последних моделях.

Это результат поиска по этому поисковому запросу:

Скриншот из поиска [обзор samsung galaxy], Google, июнь 2022 г. — связанные факторы ранжирования релевантности.

В 2007 году Амит Сингхал (в то время инженер Google и старший вице-президент) в интервью New York Times представил алгоритм Query Deserves Freshness (QDF).

В интервью New York Times он объяснил, что такое QDF:

Сингхал представил проблему свежести, объяснив, что простое изменение формул для отображения большего количества новых страниц в большинстве случаев приводит к более низкому качеству поиска.

Затем он представил решение своей команды: математическую модель, которая пытается определить, когда пользователям нужна новая информация, а когда нет.

(И да, как и все инициативы Google, у него было название: QDF, что означает «запрос заслуживает свежести».)

…Решение QDF основано на определении того, является ли тема «актуальной».

Если новостные сайты или сообщения в блогах активно пишут о теме, модель определяет, что это та тема, по которой пользователи, скорее всего, захотят получить текущую информацию. “

Разница между QDF и обновлением алгоритма свежести заключается в том, что алгоритм QDF более ограничен по объему и менее детализирован, чем алгоритм свежести.

В двух словах: разница между QDF и алгоритмом свежести- QDF изучал, находится ли тема в тренде среди новостных сайтов и блогов.

- Алгоритм свежести изучил поисковые запросы, чтобы определить, принадлежат ли они к одной из трех категорий запросов, требующих свежих результатов.

Как упоминалось ранее, система веб-индексации Caffeine, введенная за пять месяцев до Алгоритма свежести, предоставила Google возможность предоставлять результаты поиска, актуальные в минуту.

Факт, который следует помнить о QDF, заключается в том, что алгоритм Query Deserves Freshness 2007 года предшествовал алгоритму Freshness 2010 года.

Что может вызвать путаницу, так это то, что сотрудники Google продолжали ссылаться на концепцию о том, что запрос заслуживает свежести, даже после 2010 года. Таким образом, даже в 2012 году Мэтт Каттс ссылался на концепцию в видео Google для веб-мастеров о том, что определенные запросы заслуживают свежести.

Тем не менее, это два разных алгоритма, которые были представлены с разницей в три года и, по-видимому, выполняли разные функции, поскольку технология, которая сделала алгоритм свежести возможным в 2010 году (система веб-индексации Caffeine), не существовала в 2007 году.

Нужен ли свежий контент для ранжирования?

Не все поисковые запросы требуют свежих результатов. Многие поисковые запросы являются вечнозелеными.

Вечнозеленый в отношении информационных потребностей поисковых запросов означает, что ответы на некоторые запросы не сильно меняются, если вообще меняются.

Примером вечнозеленого контента является рецепт. Способ приготовления шоколадного печенья остается относительно неизменным уже много лет.

Иногда происходят культурные изменения, влияющие на вечнозеленый контент, например, тенденция к использованию печенья с низким содержанием жира или сахара, что может изменить способ изготовления печенья.

Но рецепт печенья по-прежнему актуален.

Алгоритм свежести срабатывает только тогда, когда поисковый запрос попадает в одну из следующих трех категорий:

- Недавние события.

- Регулярно повторяющиеся события.

- Частые обновления.

Миф о свежем контенте

Существует стратегия SEO, которая рекомендует менять дату публикации или дату изменения каждую неделю, месяц или год, потому что, согласно стратегии, «Google любит свежий контент».

Но правда всегда заключалась в том, что идея «Google любит свежий контент» — это миф.

Даже через три года после запуска алгоритма свежести Мэтт Каттс, инженер Google, все еще объяснял, что свежесть не всегда является сигналом ранжирования.

Мэтт объясняет это в видео 2013 года, где он отвечает, насколько важна свежесть для ранжирования.

«Насколько важна свежесть?

Таким образом, в этом вопросе есть небольшой интересный поворот: дело не только в том, что что-то часто обновляется … с точки зрения страниц в вашем блоге или на вашем сайте, вы автоматически должны занимать более высокое место в рейтинге.

Так что у меня не было бы такой интерпретации свежести. …не каждый запрос заслуживает свежести.

Так что, если это навигационная вещь, если это вечнозеленый контент, иногда люди ищут подробный контент или проводят дополнительные исследования, тогда свежесть не будет иметь такого значения.

… у нас есть более 200 сигналов, которые мы используем, и вещь, которую я бы не стал делать, ловушка, ловушка, в которую я бы не попал, это сказать, хорошо, у меня должен быть свежий контент, поэтому я собираюсь случайным образом изменить несколько слов на моих страницах каждый день, и я изменю дату автора, чтобы это выглядело так, будто у меня свежий контент.

Это не то, что с большей вероятностью приведет к более высокому рейтингу.

И если вы не в области новостей, если вы не находитесь в какой-то нише или тематической области, которая действительно заслуживает много свежего материала, то, вероятно, вам вообще не о чем беспокоиться.

… есть вечнозеленый контент, который выдерживает испытание временем. Может быть, лучше поработать над такими статьями…

… если вы пишете о видеоиграх, там много актуальных экстренных новостей, тогда хорошо стараться быть свежим и убедиться, что у вас есть, знаете ли, особенно актуальный контент».

Алгоритм «Кому нужно ранжироваться для свежести»

Регулярная публикация нового контента, как правило, является хорошей стратегией для многих типов веб-сайтов.

Тем не менее, публикация актуального контента для веб-сайтов по определенным темам особенно важна.

Веб-сайты, посвященные быстро меняющимся потребительским тенденциям, регулярно происходящим событиям и часто обновляемым продуктам, требуют постоянного потока свежего контента.

Преимущество публикации новостей и актуального контента заключается в том, что это может привести к высокому уровню трафика, иногда к огромному количеству трафика.

Недостатком является то, что через пару недель он может перестать быть свежим или релевантным для тех же поисковых запросов, которые вызывали массовый трафик, когда тема была в тренде.

Лучше всего понять, соответствуют ли темы вашего контента одной из трех категорий свежести, и если да, начните писать.

Если тема контента не вписывается в эти категории, то тема является вечнозеленой.

Неплохая идея сочетать как свежие, так и вечнозеленые темы, чтобы у посетителей, прибывающих за свежестью, была возможность остаться для вечнозеленых.

Информация об обновлении свежести по-прежнему полезна для разработки контент-стратегии, поскольку сегодня Google лучше понимает, какие запросы заслуживают обновления, что дает издателям возможность получить больше трафика.

Дополнительные ресурсы:

- Свежий контент как фактор ранжирования Google: что вам нужно знать

- Поможет ли замена свежего контента вашему SEO?

- Факторы ранжирования Google: правда или вымысел

Избранное изображение: А. Азарникова/Shutterstock

Азарникова/Shutterstock

Категория SEO

Что вам нужно знать

Есть много кроличьих нор, в которые можно попасть, когда дело доходит до обновлений алгоритма Google.

Один из моих фаворитов (после неразгаданной тайны Фреда) связан с обновлением алгоритма Google 2012 года для макета страницы и движения верхней части сгиба.

Как и в случае со скандалом с линкбилдингом в JCPenney, об этом обновлении алгоритма Google до сих пор говорит множество людей — вам просто нужно знать, у кого спросить. Но вам не нужно копаться в архивах, мы вас здесь прикроем.

В этом посте вы узнаете все, что вам нужно знать об алгоритме макета страницы Google, о том, как он развивался на протяжении многих лет и что он значит для вас сейчас.

Что такое алгоритм макета страницы Google?

Появление высококачественного пользовательского интерфейса и более сложного SEO на странице могло показаться преждевременным после обновлений Panda 2011 года, но Google официально объявил об этом 19 января 2012 года: алгоритм макета страницы был здесь.

Алгоритм макета страницы обновляет целевые веб-сайты со слишком большим количеством статической рекламы в верхней части страницы. Эти объявления заставят пользователей прокручивать страницу вниз, чтобы увидеть контент.

Google заявил, что этот алгоритм затронет менее 1 процента веб-сайтов. Но 1% затронутых сайтов были вынуждены улучшать пользовательский интерфейс.

В этом обновлении не было всплывающих окон и рекламных объявлений.

Макет страницы/Вверху страницы Хронология обновления алгоритма Google

Вот краткий снимок того, как алгоритм менялся с течением времени:

1. 19 января 2012 г .: Алгоритм макета страницы запущен

Google представил первую страницу обновление алгоритма макета, также известное как «Top Heavy» или вышеуказанное обновление алгоритма сгиба, влияющее на сайты, которые показывали слишком много рекламы в верхней части сгиба.

2. 9 октября 2012 г.: Обновление алгоритма макета страницы

Мэтт Каттс, в то время возглавлявший группу Google по борьбе с веб-спамом, объявил в Твиттере, что алгоритм макета страницы был обновлен. Это затронуло 0,7% англоязычных запросов. Обновление также дало возможность потенциально восстановиться веб-сайтам, пострадавшим от первого развертывания алгоритма Google.

Это затронуло 0,7% англоязычных запросов. Обновление также дало возможность потенциально восстановиться веб-сайтам, пострадавшим от первого развертывания алгоритма Google.

Небольшой отчет о погоде: обновление http://t.co/kcDiRUjc запускается сегодня. Заметно затронуто ~ 0,7% запросов на английском языке.

— Мэтт Каттс (@mattcutts) 9 октября, 2012

3. 6 февраля 2014 г .: Обновление алгоритма макета страницы

Компания Google выпустила обновление алгоритма макета страницы 6 февраля 2014 г. Каттс не упомянул о влиянии этого обновления на результаты поиска. сайты. Хотя это было обновление, оказалось, что Google просто перезапустил алгоритм и обновил свой индекс.

SEO-специалисты: мы недавно запустили обновление этого алгоритма: http://t.co/KKSXm8FqZW Доступен для внешнего мира ~ февр. 6-й.

— Matt Cutts (@mattcutts) 10 февраля 2014 г.

4. 1 ноября 2016 г., Automated Algorithm

Джон Мюллер из Google объявил в Google Webmaster Hangout на 48-й минуте:

«Это

». в значительной степени автоматический в том смысле, что это, вероятно, не живое, один к одному. Мы просто вспомнили бы об этом, поэтому точно знаем, как это выглядит. Но это то, что обновляется автоматически. И когда вы изменяете эти страницы, вам не нужно ждать какого-либо ручного обновления на нашей стороне, чтобы это было принято во внимание».

После комментария Мюллера стало ясно, что Google будет отслеживать изменения на вашем веб-сайте и автоматически корректировать рейтинг после сканирования вашего сайта.

Гэри Иллиес из Google также подтвердил, что алгоритм макета страницы по-прежнему имеет большое значение, в марте 2017 года:

да, это еще важно

— Гэри «鯨理» Иллиес (@methode) 14 марта 2017 г.

Веб-сайты, затронутые алгоритмом макета страницы

С четырьмя обновлениями алгоритма макета страницы это может показаться значительным изменением, но менее 1 процента сайтов были затронуты каждым из обновлений.

Эти изменения коснулись только тех, у кого было слишком много рекламы, до такой степени, что пользовательский опыт стал слабым, и их сайту может быть полезно переосмыслить свой веб-дизайн.

Каттс объяснил это дальше:

«Это изменение алгоритма не влияет на сайты, которые размещают рекламу вверху страницы в нормальной степени, но затрагивает сайты, которые заходят гораздо дальше, загружая верхнюю часть страницы рекламой до чрезмерного уровня. степени или которые затрудняют поиск фактического исходного контента на странице».

Как владелец веб-сайта, я понимаю, что могло расстроить некоторых людей. Когда это ваша страница с вашими объявлениями, вы думаете, что должны организовать ее так, как хотите, и не быть оштрафованными.

Кроме того, благодаря размещению рекламы многие из нас делают наши сайты прибыльными. Много заметных рекламных мест принесут больше дохода… Но какой ценой?

Некоторые участники форума WebmasterWorld заметили воздействие:

Один участник форума заявил, что они пострадали от первого обновления алгоритма 7 февраля 2012 г. и увидели 40-процентное падение трафика. Они поделились этим изображением:

и увидели 40-процентное падение трафика. Они поделились этим изображением:

Другой участник сказал, что им потребовалось два года, чтобы оправиться от первого обновления алгоритма.

Правда в том, что люди не захотят посещать сайт, если их ругают за рекламу. Они разочаруются и будут искать то, что искали — будь то идеи для вечеринки по случаю дня рождения или советы экспертов по гольфу — где-то еще.

Вместо этого компании размещали рекламу внизу страницы на популярном сайте (или боролись лишь за несколько мест вверху), а затем размещали ее как один из многих баннеров на сайте с низким трафиком.

Это изменение принесло пользу владельцам сайтов, рекламе и зрителям.

Восстановление алгоритма макета страницы

Что такого в обновлении алгоритма Google, которое выбрасывает все наши тщательно разработанные, проверенные и надежные стратегии SEO?

Легко попасть в массовую истерию по редизайну веб-сайтов и переписыванию контента, а через несколько месяцев получить штраф. Все из-за одного обновления алгоритма Google?

Все из-за одного обновления алгоритма Google?

Хотя пострадал только 1 процент, что, если бы вы были в этом 1 проценте? Давайте посмотрим, как правильно восстановить макет страницы после обновления алгоритма Google.

Во-первых, область верхней части страницы зависит от того, какое разрешение экрана использует ваша аудитория.

Например, пользователь на своем телефоне увидит другое пространство в верхней части сгиба, чем если бы вы смотрели со своего ноутбука.

Итак, прежде чем удалять рекламу в верхней части страницы, используйте расширение Screen Resolution Tester для Chrome. (Fold Tester — еще один бесплатный инструмент, который вы можете использовать для визуального тестирования макета на рабочем столе.)

Вы также можете просмотреть сообщение в блоге Google Code, в котором подробно рассказывается о тестах экрана в верхней части экрана.

Google также предоставляет изображение для отображения того, что ищет Google, в верхней части страницы:

Если вы получите штраф из-за слишком большого количества рекламы в верхней части страницы, вам придется подождать. чтобы робот Googlebot повторно просканировал ваш сайт. Хорошая новость заключается в том, что теперь Google делает обновления в режиме реального времени, вам больше не нужно ждать, пока произойдет следующее обновление алгоритма.

чтобы робот Googlebot повторно просканировал ваш сайт. Хорошая новость заключается в том, что теперь Google делает обновления в режиме реального времени, вам больше не нужно ждать, пока произойдет следующее обновление алгоритма.

Окончательное воздействие алгоритма макета страницы

Имея дело с изменением алгоритма Google, таким как обновление макета страницы, может показаться, что вы снова и снова падаете в пропасть постоянных изменений веб-дизайна. Хотя я буду первым, кто признает, что это обновление могло показаться резким, сообщение Google было ясным: они ценят пользовательский опыт.

Удаление рекламы вверху страницы не должно приводить к снижению вашего дохода. И, если я углублюсь в намерения этого обновления алгоритма, кажется, что Google закладывал основу для индекса только для мобильных устройств.

Компания Google поручила нам проверять рекламу в верхней части страницы на всех разрешениях экрана, в том числе на мобильных устройствах. При меньшем разрешении экрана на мобильных устройствах и большом количестве рекламы пользователям придется прокручивать страницу в 5–6 раз чаще, чем на настольных компьютерах.