Правильный robots.txt для WordPress

Правильно созданный файл robots.txt способствует быстрой индексации страниц сайта. Этот файл является служебным и призван улучшать поисковую оптимизацию сайта. Внутренняя оптимизация страниц сайта на WordPress также немаловажна для проекта и ею нужно заниматься.

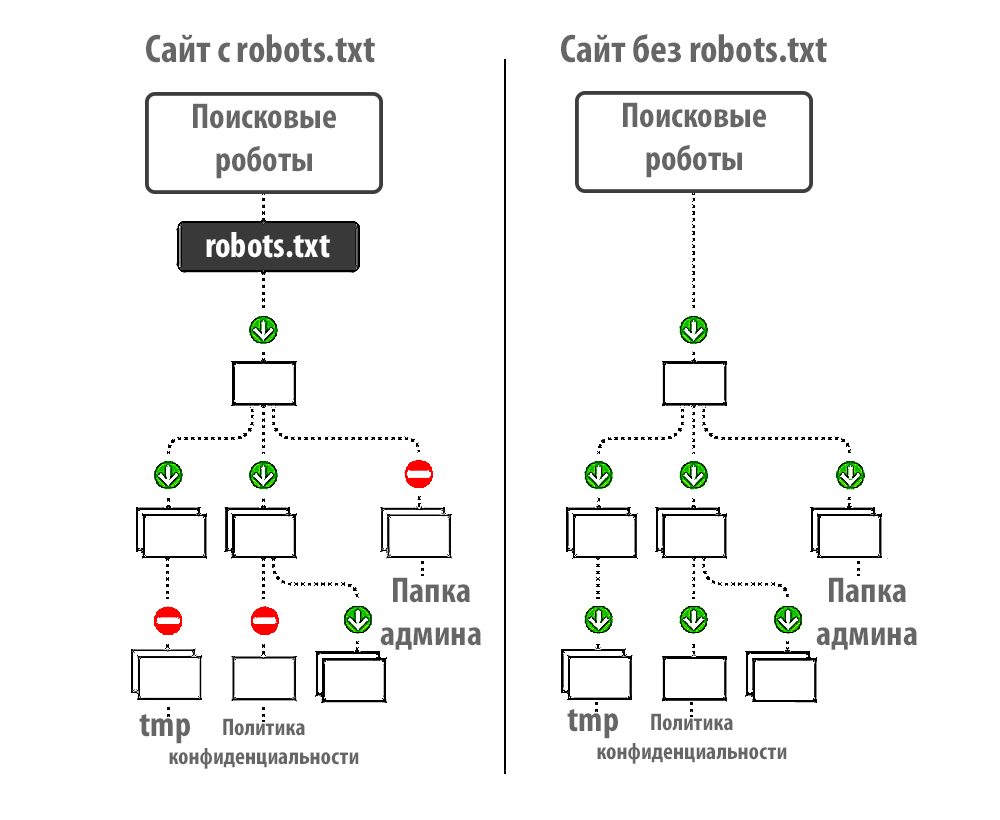

Файл robots.txt позволяет ограничить индексацию тех страниц, которые индексировать не нужно. Поисковые роботы обращают внимание на этот служебный файл с целью запрета показа страниц в поисковых системах, которые закрыты от индексации. Кстати, в файле также указываются карта сайта и его зеркало.

Как создать robots.txt для WordPress

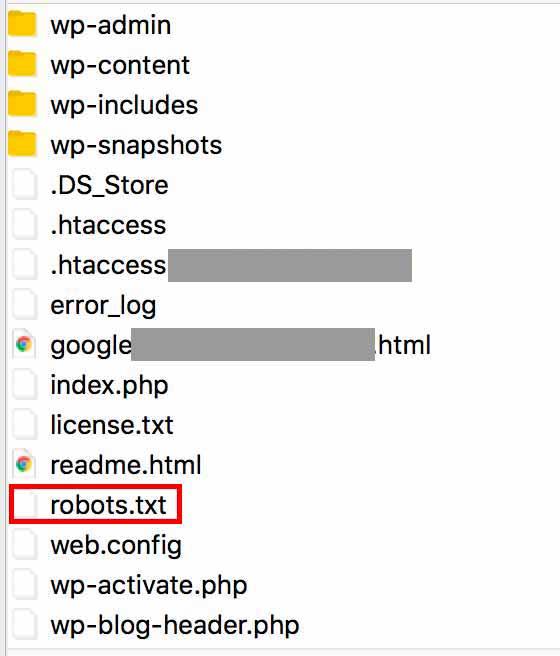

Чтобы приступить к созданию правильного файла, для начала давайте поймем, где находится robots.txt WordPress. Он располагается в корне сайта. Чтобы просмотреть корневые папки и файлы вашего проекта, необходимо воспользоваться любым FTP-клиентом, для этого просто нужно нажать на настроенное «Соединение».

Чтобы посмотреть содержимое нашего служебного файла, достаточно просто набрать в адресной строке после имени сайта robots. txt. Пример: https://mysite.com/robots.txt

txt. Пример: https://mysite.com/robots.txt

WordPress robots.txt где лежит вы знаете, осталось взглянуть, как должен выглядеть идеальный служебный файл для указанного выше движка.

- В первую очередь в файле необходимо указать пусть к карте сайта:

Sitemap: http://web-profy.com/sitemap.xml

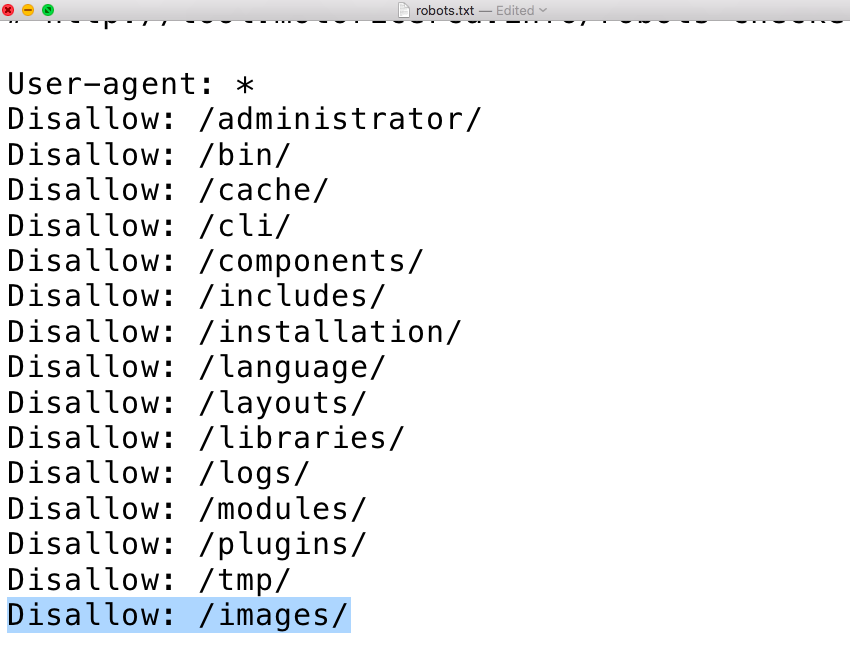

- А теперь непосредственно правильная структура файла robots.txt для WordPress:

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

User-agent: Yandex

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: mysite.

Sitemap: http://mysite.com/sitemap.xml.gz

Sitemap: http://mysite.com/sitemap.xml

Достаточно просто скопировать эти данные в свой файл. Так выглядит правильный robots.txt для WordPress.

Теперь рассмотрим, что означает каждая из строк в структуре служебного файла:

User-agent: * — строка, которая показывает, что все введенные ниже данные будут применимы относительно всех поисковых систем.

Однако для Яндекса правило будет выглядеть следующим образом: User-agent: Yandex.

Allow: — страницы, которые поисковые роботы могут индексировать.

Disallow: — страницы, которые поисковым роботам индексировать запрещено.

Host: mysite.com — зеркало сайта, которое нужно указывать в данном служебном файле.

Sitemap: — путь к карте сайта.

robots.txt для сайта WordPress, на котором не настроены ЧПУ

robots.txt для сайта WordPress, где находится список правил будет выглядеть несколько иначе в случае, если на сайте не настроены ЧПУ.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

Host: mysite. com

com

Sitemap: http://mysite.com /sitemap.xml.gz

Sitemap: http://mysite.com /sitemap.xml

Какие могут возникнуть проблемы на WordPress сайте, если нет настроены ЧПУ. Строка в служебном файле robots.txt Disallow: /*?* не позволяет индексировать страницы сайта, а именно так выглядят адреса страниц проекта при отсутствии настроек ЧПУ. Это может негативно отражаться на рейтинге интернет-проекта в поисковиках, поскольку нужный пользователям контент просто не будет им показываться в результатах выдачи.

Конечно, эту строку можно в файле можно легко удалить. Тогда сайт будет работать в нормальном режиме.

Как убедиться в том, что robots.txt составлен правильно

Сделать это можно при помощи специального инструмента от Яндекс — Яндекс.Вебмастер.

Необходимо зайти в Настройки индексирования — Анализ robots.txt

Внутри все интуитивно понятно. Необходимо нажать на «Загрузить robots. txt с сайта». Также вы можете каждую страницу отдельно просмотреть на наличие возможности ее индексации. В «Список URL» можно просто ввести адрес интересующих вас страниц, система покажет все сама.

txt с сайта». Также вы можете каждую страницу отдельно просмотреть на наличие возможности ее индексации. В «Список URL» можно просто ввести адрес интересующих вас страниц, система покажет все сама.

Не стоит забывать о том, что все изменения, которые вы вносите в файл robots.txt, будут доступны не сразу, а спустя лишь несколько месяцев.

Как правильно сохранять файл robots.txt

Чтобы наш служебный файл был доступен в такой поисковой системе, как Google, его необходимо сохранить следующим образом:

- Файл в обязательном порядке должен иметь текстовый формат;

- Разместить его необходимо корне вашего сайта;

- Файл должен иметь имя robots.txt и никакое другое больше.

Адрес, по которому поисковые роботы находят robots.txt должен иметь следующий вид — https://mysite.com/robots.txt

Делаем правильный robots.txt и sitemap.xml / Мастерская интернет-разработчика

29 мая 2009 г.

Задача состоит в том, чтобы запретить некоторые каталоги для индексации поисковым системам, для того, чтобы избавится от дублированного контента. Например, на одну и ту же статью можно попасть как с /tag/ так и с /category/.

Почему дублирующийся контент это плохо?

Вот, что говорит по этому поводу Google (перевод), можно так же найти информацию по поводу поисковой системы Яндекс, где говорится что их алгоритмы банят сайты с дублирующимся контентом. Не знаю так это или нет, я не специалист в области SEO (если есть спецы — отпишите в камменты), но на всякий случай прикрою дубляжи!

Не знаю так это или нет, я не специалист в области SEO (если есть спецы — отпишите в камменты), но на всякий случай прикрою дубляжи!

Воспользуйтесь поиском от Google или Яндекс и вы найдете море информации по этой теме.

UPD: Про дублирующийся контент в WordPress.

Robots.txt

robots.txt — файл ограничения доступа к содержимому роботам на http-сервере. Файл должен находиться в корне сайта (т.е. иметь путь относительно имени сайта /robots.txt). При наличии нескольких субдоменов файл должен располагаться в корневом каталоге каждого из них. Данный файл дополняет стандарт Sitemaps, который служит прямо противоположной цели: облегчать роботам доступ к содержимому.http://ru.wikipedia.org/wiki/Robots.txt

Также есть немного информации на форуме MasterTalk: Что такое robots.txt и для чего он нужен, а также есть сайт посвященный этому файлу — Все о файле robots.txt по-русски.

Вот еще эксперименты Дениса Болтикова по идеальному роботсу для WordPress: Идеальный robots.txt для WordPress и Идеальный robots.txt для WordPress — 2.

Мой Robots.txt

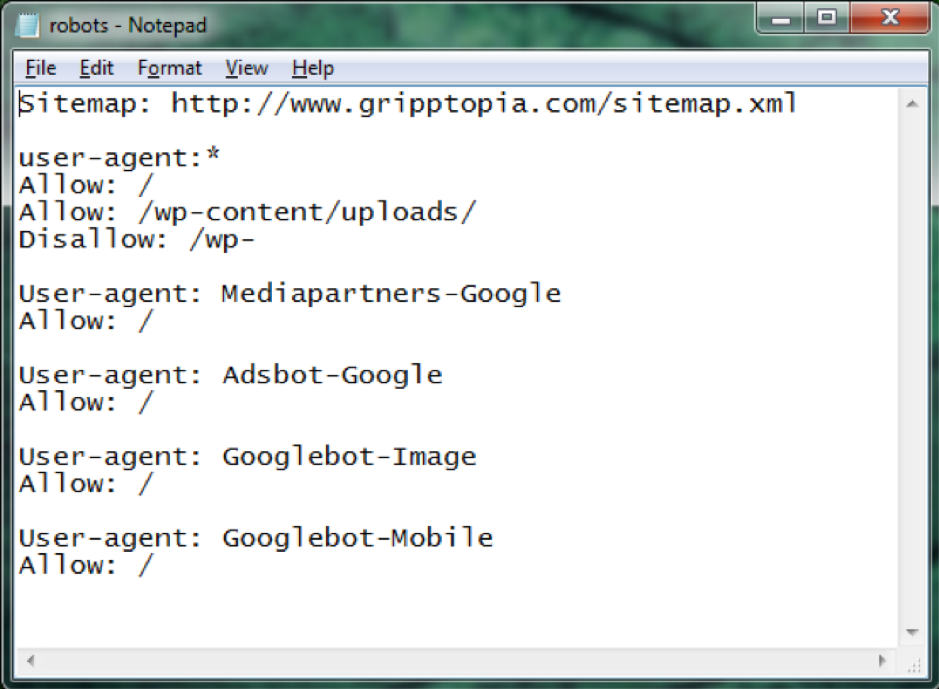

Так вот выглядит мой роботс:

User-agent: * Disallow: /wp- Disallow: /xmlrpc.php Disallow: /category/ Disallow: /page/ Disallow: /trackback/ Disallow: /feed Disallow: /comments/ Disallow: */trackback/ Disallow: */feed/ Disallow: */comments/ Disallow: /?feed= Disallow: /?s= Allow: /wp-content/uploads/ Sitemap: /sitemap.xml

Я разрешил поисковым ботам индексировать меня только по «Тегам» и «Архиву». Обратите внимание, я использую маску /wp-, для того чтобы URL’ы wp-login.php, wp-register.php, wp-admin и т.д. попали под запрет индексации (Disallow).

Также я разрешил индексировать мой «/wp-content/uploads/» для сервисов «Яндекс.Картинки» и «Google Картинки», так как там хранятся в основном картинки. И расшарил файл «sitemap.xml» для лучшей индексации.

И расшарил файл «sitemap.xml» для лучшей индексации.

Для проверки синтаксиса и структуры файла robots.txt существует ряд специализированных онлайн-служб:

- Служба Яндекса (выполняет только проверку синтаксиса)

- Google webmasters tools (позволяет проверить разрешения для каждой отдельной страницы)

Sitemaps

Так же следует не забыть о файле sitemap.xml

Sitemaps — это XML-файл с информацией для поисковых систем (таких как Google, Yahoo, Ask.com, MSN, Яндекс) о страницах веб-сайта, которые подлежат индексации. Sitemaps может помочь поисковикам определить местонахождение страниц сайта, время их последнего обновления, частоту обновления и важность относительно других страниц сайта для того, чтобы поисковая машина смогла более разумно индексировать сайт.http://ru.wikipedia.org/wiki/Sitemaps

Сайтмап не обязателен и поисковые системы не гарантируют его использование, он лишь помогает поисковым ботам проводить индексацию, однако я считаю что это очень полезным!

Для WordPress существует плагин — Google XML Sitemaps (другие полезные плагины для WordPress используемые мной). Этот плагин генерирует за вас файл sitemap.xml, в котором и содержится информация для поисковых ботов по индексации сайта. Вы сами можете его настроить и указать проценты приоритета для статей, страниц и т.д.

Этот плагин генерирует за вас файл sitemap.xml, в котором и содержится информация для поисковых ботов по индексации сайта. Вы сами можете его настроить и указать проценты приоритета для статей, страниц и т.д.

Центры веб-мастеров Google и Яндекс

Для ускорения индексации рекомендуется оповестить Google и Яндекс о ваших файлах robots.txt и sitemap.xml, для этого существуют специальные сервисы:

- Инструменты Google для веб-мастеров

- Яндекс.Вебмастер (после добавления сайта вы сможете прикрепить sitemap.xml)

Использование http-пингов для уведомления поисковых систем о обновлениях в sitemaps

Можно указать поисковым системам местонахождение файла Sitemap при помощи HTTP-запроса:

http://google.com/webmasters/sitemaps/ping?sitemap=<sitemap_location>Яндекс

http://webmaster.yandex.ru/wmconsole/sitemap_list.xml?host=<sitemap_location>

Yahoo!

http://search.yahooapis.com/SiteExplorerService/V1/updateNotification?appid=SitemapWriter&url=<sitemap_location>

http://search.yahooapis.com/SiteExplorerService/V1/ping?sitemap=<sitemap_location>Ask.com

http://submissions.ask.com/ping?sitemap=<sitemap_location>Live Search

http://webmaster.live.com/ping.aspx?siteMap=<sitemap_location>

Где <sitemap_location> необходимо заменить на полный URL файла Sitemap. Например, чтобы добавить файл http://www.example.com/sitemap.xml в поисковик Google, нужно отправить HTTP-запрос http://www.google.com/webmasters/sitemaps/ping?sitemap=http://www.example.com/sitemap.xml.

Информация по пингам взята с http://ru.wikipedia.org/wiki/Sitemaps

Google не рекомендует чаще чем раз в час его пинговать, вот пруфлинк.

Полный обзор WordPress Robots.txt — как его использовать?

Введение

Если вы являетесь веб-мастером, термин «robots.txt» наверняка попадался вам на глаза то здесь, то там. Вы когда-нибудь задумывались, что это значит? Как это применимо к вашему веб-контенту и какую роль оно играет?

Почти на каждом веб-сайте файл robots.txt является обязательным, но некоторые владельцы знают, для чего он используется. Цель написания этой статьи — предоставить вам необходимую информацию, чтобы вы могли использовать ее для дальнейшего повышения качества вашего сайта.

Приготовьтесь и пристегните ремни безопасности, потому что мы собираемся взять вас в интересное приключение о знании файла WordPress robots.txt . Вы также сможете лучше управлять доступом к своему сайту. Как только вы узнаете о функционировании файла, вам будет проще использовать его в своих интересах и выделиться из пула веб-сайтов

Что такое WordPress Robots.txt?

До начала останавливаться на термине Robots. txt WordPress , нам нужно понимать довольно широкий термин, то есть робот. В мире Интернета это слово используется в контексте любого вида «бота», который посещает веб-сайты.

txt WordPress , нам нужно понимать довольно широкий термин, то есть робот. В мире Интернета это слово используется в контексте любого вида «бота», который посещает веб-сайты.

Вы можете рассмотреть пример поисковых роботов Google, которые бродят по сети и помогают Google индексировать миллиарды веб-страниц с огромного количества веб-сайтов по всему миру.

Боты — удобный инструмент, и они довольно эффективно заменяют рабочую силу, необходимую для выполнения своих задач. Их можно назвать «цифровыми помощниками». Они имеют решающее значение для существования интернет-структуры и ее надлежащего функционирования.

Однако, если вы являетесь владельцем веб-сайта, вы не хотите, чтобы эти мошенники бродили по вашему веб-сайту для проверки качества. Вы хотите контролировать внешний вид и статистику вашего веб-сайта. Это непростой бизнес, который породил стандарт исключения роботов в конце 90-х.

Теперь, переходя к нашему предметному термину, то есть к файлу Robots.

Используя этот файл, вы можете регулировать и даже прекращать участие ботов на вашем сайте. Да, это стоит за той человеческой проверкой на многих веб-сайтах, которые вы так ненавидите, — тайна раскрыта.

Однако регулирование участия ботов не так просто контролировать. Боты «злых гениев» могут легко обойти файл robots.txt и все равно попасть на ваш сайт. И как только они вошли, их нельзя заставить взаимодействовать так, как вы хотите, даже с помощью robots.txt.

Кроме того, многие крупные предприятия не осознают преимущества добавления команд в robots.txt, которые даже не распознаются Google. Примите во внимание любые правила относительно количества ботов, которые могут войти на ваш сайт, и он не будет скомпрометирован. Однако, если вы все еще не можете справиться с этими озорными существами, вы можете воспользоваться онлайн-средством, доступным в Интернете.

Зачем беспокоиться о получении файла Robots.txt для вашего веб-сайта?

Как владелец веб-сайта, этот вопрос должен возникать у вас в голове. Зачем эти дополнительные усилия и инвестиции? Вы хотите, чтобы ваш бизнес работал максимально рентабельно, сто раз подумаете, прежде чем добавлять?

Вам может быть интересно, как останов вторжений ботов на веб-сайт изменит работу вашего веб-сайта. Ну, вы знаете, пока еще капля, и остался океан.

Но не волнуйтесь, мы здесь именно по этой причине. К концу этой статьи вы сможете сами увидеть, что лучше для вас. Короче говоря, Robots.txt WordPress помогает вашему сайту двумя способами:

- Оптимизация использования ресурсов за счет блокировки ботов. Эти посещения ботов приводят к ненужной трате полезных ресурсов.

- Улучшите ресурсы сканирования поисковых систем, дав им указание не тратить время на страницы, которые не нужно проверять на предмет индексации. Таким образом, вы можете контролировать свой сайт, индексируя только те страницы, которые считаете лучшими.

Следовательно, вы в конечном итоге достигнете лучшего рейтинга вашего веб-сайта, поскольку ваши результаты оптимизированы для того, чтобы они были такими, какими вы хотите их видеть. Это умное сотрудничество ума и технологий приводит к общей пользе вашего сайта. Любой здравомыслящий веб-мастер хотел бы этого.

- WordPress Robots.txt не предназначен специально для управления индексацией страниц.

Robots.txt на самом деле не мешает поисковым системам проверять определенные страницы вашего веб-сайта. Если это ваша основная цель, вам лучше выбрать метатег без индекса. Это более прямой способ решения этой конкретной проблемы.

Основная цель WordPress Robot.txt — не мешать поисковым системам индексировать страницу. Скорее это просто инструктирует ботов ползать. Хотя Google не сканирует отмеченную вами страницу напрямую, в нем четко указано, что внешняя ссылка на страницу позволит ему сканировать ее.

На это указал аналитик Google для веб-мастеров в видеовстрече Webmaster Central. Он воскликнул, что если люди хотят запретить ботам индексировать определенную страницу, им следует использовать неиндексирующий тег, а не файл robots.txt, поскольку внешние ссылки будут отображать движок, не зная, что страницы не нужно индексировать.

Он воскликнул, что если люди хотят запретить ботам индексировать определенную страницу, им следует использовать неиндексирующий тег, а не файл robots.txt, поскольку внешние ссылки будут отображать движок, не зная, что страницы не нужно индексировать.

Итак, если вы читаете эту статью, сделайте шаг назад, если вы планируете использовать файл для указанной выше цели. В конечном итоге это приведет к вашей потере, поскольку вы не получите того, что ожидаете.

- Как создать и отредактировать файл WordPress Robots.txt

Теперь, когда вы получили необходимые знания о том, что такое Robots.txt WordPress и как вы можете использовать его в своих интересах, вам должно быть интересно, как создать и редактировать файлы Robots.txt WordPress .

В WordPress вы получаете файл robots.txt с инициалами. Таким образом, несмотря на то, что вы не предпринимаете никаких внешних усилий для файла robots.txt в своем файле WordPress, он уже должен быть там. Чтобы проверить, есть ли он, можно использовать определенный метод тестирования. Введите «/robots.txt» в конце вашего домена и нажмите кнопку поиска.

Чтобы проверить, есть ли он, можно использовать определенный метод тестирования. Введите «/robots.txt» в конце вашего домена и нажмите кнопку поиска.

Поскольку файл по сути является виртуальным, его нельзя изменить. Если вы хотите изменить файл по своему усмотрению, вам придется создать документ на своем компьютере, который вы сможете редактировать по своему вкусу. Ознакомьтесь с тремя простыми способами сделать это:

Лучший в своем классе управляемый облачный хостинг WordPress с неограниченным количеством правок на уровне приложений.

Запустите свой первый сайт бесплатно

Зарегистрируйтесь

- С помощью Yoast SEO

Если вы используете известный плагин Yoast SEO, есть возможность спроектировать файл robots.txt для последующего редактирования просто из основного интерфейса. Для этого вам сначала нужно авторизовать расширенные функции Yoast SEO, выполнив путь 9.0011 SEO> Панель инструментов> Функции , а затем переключитесь на страницу дополнительных настроек .

После того, как вы выполнили указанную выше задачу, вам нужно перейти к SEO> Инструменты и нажать Редактор файлов . Расположение WordPress robots.txt обычно является корневой папкой сайта.

Предположим, что на вашем веб-сайте его еще нет. Yoast позволяет вам создать файл, используя его интерфейс:

После нажатия кнопки вы можете легко редактировать файл robots.txt WordPress легко из интерфейса.

Далее мы также обсудим, какие типы команд вы можете ввести в свой файл robots.txt, которые помогут вам сделать ваш веб-сайт более оптимизированным и регулируемым.

- Использование все в одном SEO

All in One SEO так же популярен среди пользователей, как и Yoast. Это достойная платформа. Если вы используете этот плагин, вы можете создавать и также отредактируйте файл robots.txt WordPress из его интерфейса.

Для выполнения этой задачи вам нужно перейти на страницу All in One SEO и выбрать диспетчер функций , а затем активировать функцию robots. txt.

txt.

После того, как вы активировали функцию файла, как вы видели на картинке выше, вы можете легко отредактировать ее, открыв All in One SEO> Robots.txt .

- Использование FTP

Если вы не используете ни один из вышеперечисленных плагинов, вам необходимо использовать стороннюю программу. Для этой задачи вам нужно знать, где находится файл robots.txt. Он должен находиться в корневой папке сайта. Для подключения к нему можно использовать FTP-клиент.

Для этого сначала создайте в папке текстовый файл, назовите его robots.txt.

Затем вам нужно будет подключиться к вашему веб-сайту с помощью SFTP и перенести документ в корневую папку сайта.

В файл также можно внести дополнительные изменения, используя SFTP или загрузив последние версии файла. Это один из хороших способов редактирования файла WordPress Robots.txt .

Что вы можете ввести в свой файл robots.txt?

Очень важно задать этот вопрос перед настройкой файла robots. txt WordPress . Вы должны четко осознавать, что вы делаете и как вы собираетесь это делать.

txt WordPress . Вы должны четко осознавать, что вы делаете и как вы собираетесь это делать.

У вас есть физический файл robots.txt в вашем WordPress, и теперь вы можете изменить его по своему желанию. Но вы должны знать домен, который вы должны указать в файле. Robots.txt управляет тем, как поисковые роботы ссылаются на веб-сайт, используя два метода:

- Метод Disallow , который специально используется, чтобы запретить роботам доступ к определенным определенным страницам вашего веб-сайта.

- Метод User-agent предназначен для нацеливания на определенный тип ботов. Боты используют пользовательские агенты, чтобы узнавать себя. С их помощью вы можете установить директиву, которая применяется к Yahoo, но не к Google.

Вы будете использовать команду «Разрешить» в своей нише. Все на сайте по умолчанию разрешено, и вам нужно только отменить выбор областей, которые вы хотите запретить. Вы можете заблокировать доступ к одной конкретной папке и ее подпапкам, разрешив при этом доступ к определенной подпапке.

В основном вы добавляете правила, сначала выбирая, какое правило пользовательского агента будет применяться, а затем выбирая, какие правила реализовать с помощью разрешения и запрета. Crawl-delay и sitemap — это второстепенные команды, которые также доступны. Они бесполезны для:

- крупных поисковых роботов, так как они их игнорируют.

- Такие инструменты, как консоль поиска Google, могут сделать их излишними.

Вы можете лучше понять упражнение, ознакомившись с особыми случаями:

- Использование файла Robots.txt WordPress для блокировки доступа ко всему сайту

Этот метод используется при условии, что на вашем веб-сайте не должно быть поисковых роботов. Полная блокировка поместит ваш сайт в принудительный карантин от внешних сканеров. Для этого вы можете написать следующий код в файле WordPress robots.txt :

User-agent: *

Disallow: /

Знак ‘*’ рядом с user agent дает сообщение файлу, что все пользовательские агенты должны быть заблокированы. «/» после запрета означает, что доступ ко всем страницам должен быть ограничен. Однако этот метод вряд ли применим на действующем сайте. Лучше применять для сайта разработки.

«/» после запрета означает, что доступ ко всем страницам должен быть ограничен. Однако этот метод вряд ли применим на действующем сайте. Лучше применять для сайта разработки.

- Блокировка конкретного бота на вашем сайте

Этот метод часто более желателен, чем рассмотренный выше, и чаще всего применяется. Рассмотрим пример, скажем, вы не хотите, чтобы Bing-bot ползал по вашему сайту.

Для того, чтобы заблокировать только Bing от входа на ваш сайт, вам нужно будет ввести этот код в файл:

User-agent: Bingbot

Disallow: /

Этот код сообщает robots.txt Файл WordPress , чтобы запретить только определенным ботам, имеющим пользовательский агент Bing-bot. этот метод будет очень полезен, когда вам нужен определенный жучок на ваших страницах. Посетите этот сайт, чтобы узнать об известных именах пользовательских агентов некоторых служб.

Лучший в своем классе управляемый облачный хостинг WordPress с неограниченным количеством правок на уровне приложений.

Запустите свой первый сайт бесплатно

Зарегистрируйтесь

- Блокировка входа в одну папку

Возможно, вы захотите запретить ботам блуждать по одной папке. В таком случае вы будете делиться знаниями из этого раздела. Допустим, вы хотите заблокировать доступ к этим папкам:

- Полная папка wp-admin

- wp-login.php

Используйте следующий код для этой команды:

User- агент: *

Запретить: / wp-admin/

Запретить: /wp-login.php

- Чтобы разрешить вход в определенную папку внутри заблокированной папки

Теперь перейдем к случаю, когда вы хотите остановить доступ ко всему документу, но внутри есть определенный файл, который вы хотите проиндексировать. Это время показа команды «Разрешить». Это очень полезно для WordPress.

Вы можете получить идеальную иллюстрацию этой команды с помощью виртуального файла WordPress Robotx.txt :

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax . php

php

Это означает, что вы блокируете доступ ко всей папке «wp-admin», но исключаете «admin-ajax.php» из списка. Это действительно очень полезная команда.

- Использование файла robots.txt для запрета ботам сканировать результаты поиска WordPress

Это привилегия для пользователей WordPress. Вы можете контролировать доступ ботов к результатам поиска на вашей веб-странице. Чтобы они не сканировали ваши страницы результатов поиска, WordPress по умолчанию использует параметр запроса, то есть «?S=». для этого вы можете добавить следующее правило в пользовательский агент:

User-agent: *

Запретить: /?s=

Запретить: /search/

Метод также полезен при программных ошибках 404. Это также ускорит ваши поиски в WordPress, что приведет к более качественным и оптимизированным страницам.

- Создание разных правил для разных ботов

Это более общий сценарий, в котором вы хотите реализовать различные команды для ряда ботов. Для этого вы добавите правила для каждого бота в пользовательском агенте и создадите правила для каждого из них отдельно. Предположим, вы хотите создать общее правило для всех ботов и специальные правила, которые должны применяться только к Bing-боту. Введите этот код:

Для этого вы добавите правила для каждого бота в пользовательском агенте и создадите правила для каждого из них отдельно. Предположим, вы хотите создать общее правило для всех ботов и специальные правила, которые должны применяться только к Bing-боту. Введите этот код:

Агент пользователя: *

Запретить: /wp-admin/

Агент пользователя: Bingbot

Запретить: /

С помощью этой команды вы заблокируете всех ботов от перехода к папке «wp-admin», но «Bing-bot» не будет разрешен на всем веб-сайте.

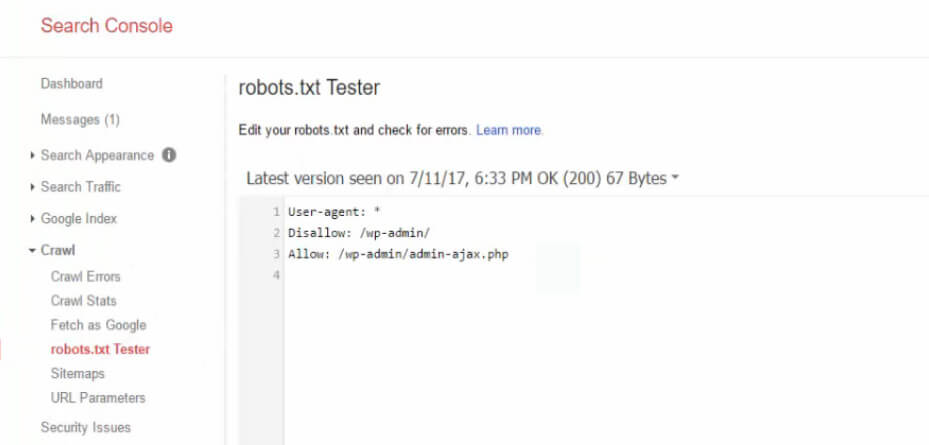

Проверка файла robots.txt

Небольшое техническое обслуживание всегда оказывается полезным и выгодным в долгосрочной перспективе. Частое тестирование обеспечивает максимальную производительность файла Robots.txt WordPress . Консоль поиска Google может выполнить проверку вашей папки.

Перейдите на сайт и нажмите «тестер robots.txt» под «Crawler». После этого вам нужно отправить URL-адрес страницы, на которой вы хотите протестировать файл. Если все доступно для сканирования, вы должны увидеть зеленое «разрешено». Вы также можете проверить заблокированные URL-адреса, чтобы убедиться, что они правильно заблокированы.

Если все доступно для сканирования, вы должны увидеть зеленое «разрешено». Вы также можете проверить заблокированные URL-адреса, чтобы убедиться, что они правильно заблокированы.

Берегите себя от спецификации UTF-8

Метка порядка байтов или спецификация по сути является невидимым символом, который иногда помещают в файлы из-за некоторых старых текстовых редакторов. Google не будет читать ваши WordPress Robots.txt файл правильно, если он является жертвой этого колдовства.

По этой причине вам следует часто проверять файлы на наличие ошибок для более качественной и своевременной диагностики. Возьмем пример, показанный ниже. В файле есть невидимый символ, из-за которого Google не может понять синтаксис.

Следовательно, первая строка вашего файла недействительна и вообще не годится. UTF-8 может стать кошмаром для многих.

Google Bot преимущественно базируется в США

Вы никогда не должны блокировать бота Google из Соединенных Штатов, даже если вы хотите нацелиться на местный регион, соседний с США. Иногда происходит локальное сканирование, но в основном оно происходит в США.

Иногда происходит локальное сканирование, но в основном оно происходит в США.

Как максимально эффективно использовать файл WordPress Robots.txt

Мы уверены, что к настоящему времени вы усвоили большой объем знаний и даже применили некоторые из них в свою пользу. Мы стремимся сделать ваш сайт больше и лучше с помощью наших информативных и всеобъемлющих статей.

В заключение, само собой разумеется, что вы всегда должны быть осторожны со своими действиями. В случае нашей нынешней проблемы вам нужно очень хорошо решить, какова ваша основная цель создания файла Robots.txt. Вы хотите запретить ботам заходить на ваш сайт? Тогда вы должны использовать неиндексный тег. Это лучшее решение для полного предотвращения индексации.

Если вы случайный пользователь WordPress, вы действительно не хотите изменять свой файл Robots.txt WordPress . Однако, если вы столкнулись с проблемами с ботом или хотите оптимизировать взаимодействие с поисковой системой, вам пригодится файл robots. txt.

txt.

Надеюсь, эта статья предоставила вам достаточно информации о файле Robots.txt. Вы можете связаться с нами в случае возникновения каких-либо вопросов. Пусть ваши усилия облегчатся.

Как оптимизировать ваш WordPress Robots.txt для SEO

В этом блоге мы узнаем несколько советов о том, как вы можете улучшить SEO вашего сайта, оптимизировав файл robts.txt.

На самом деле, файл Robots.txt играет важную роль с точки зрения SEO, потому что он сообщает поисковым системам, как можно сканировать ваш сайт. Именно по этой причине файлы Robot.txt считаются одним из самых мощных инструментов SEO.

Позже вы также узнаете, как создавать и оптимизировать WordPress Robots.txt для SEO.

Что вы подразумеваете под файлом robots.txt?

Текстовый файл, созданный владельцами веб-сайтов, чтобы сообщить роботам поисковых систем о том, как они могут сканировать свой веб-сайт и индексировать страницы, известен как Robots.txt

На самом деле в корневом каталоге хранится этот файл. Этот каталог также называется основной папкой вашего сайта. Ниже указан формат файла robots.txt

Этот каталог также называется основной папкой вашего сайта. Ниже указан формат файла robots.txt

Агент пользователя: [имя агента пользователя] Запретить: [строка URL не должна сканироваться] Агент пользователя: [имя агента пользователя] Разрешить: [строка URL для сканирования] Карта сайта: [URL вашего файла Sitemap в формате XML]

Чтобы разрешить или запретить определенные URL-адреса, у вас могут быть разные строки инструкций. Кроме того, вы также можете добавлять различные карты сайта. Боты поисковых систем будут считать, что им разрешено сканировать страницы, если разрешен URL-адрес.

Пример robots.txt приведен ниже

User-Agent: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Карта сайта: https://example.com/sitemap_index.xml

В приведенном выше примере мы разрешили сканировать страницы поисковым системам и получать индексные файлы в папке загрузок WordPress.

После этого мы запретили поисковым ботам сканировать и индексировать папки и плагины администратора WordPress.

Наконец, мы упомянули URL-адрес XML-карты сайта.

Требуется ли для вашего веб-сайта WordPress файл Robots.txt?

Поисковая система начнет сканировать и индексировать ваши страницы, даже если у вас нет текстового файла, например Robots.txt. Но, к сожалению, вы не можете сообщить своей поисковой системе, какую именно папку или страницу она должна сканировать.

Если вы только что создали веб-сайт или блог с меньшим содержанием, это не принесет никакой пользы или не окажет никакого влияния.

Однако, как только вы настроите свой веб-сайт с большим количеством контента и он начнет расти, вам потребуется контроль над просканированными и проиндексированными страницами вашего веб-сайта.

Первая причина указана ниже.

Для каждого веб-сайта у поисковых роботов есть квота сканирования.

Это явно означает, что во время сеанса обхода будет просканировано определенное количество страниц. Предположим, что сканирование на вашем веб-сайте осталось незавершенным, тогда оно вернется еще раз и возобновит сканирование в другом сеансе.

Из-за этого скорость индексации вашего сайта будет критической.

Вы можете решить эту проблему, запретив поисковым роботам сканировать такие страницы, которые не нужны. Некоторые неважные страницы могут включать в себя файлы плагинов, страницы администрирования WordPress и папки тем.

Квоту сканирования можно сохранить, запретив сканирование нежелательных страниц. Этот шаг будет более полезным, поскольку поисковые системы теперь будут сканировать страницы веб-сайта и смогут проиндексировать их как можно скорее.

Еще одна причина, по которой вам следует использовать и оптимизировать файл WordPress Robots.txt, приведена ниже.

Когда вам нужно запретить поисковым системам индексировать страницы или сообщения на вашем сайте, вы можете использовать этот файл.

На самом деле, это один из самых неправильных способов скрыть содержимое вашего веб-сайта от широкой публики, но он окажется лучшей защитой для их появления в результатах поиска.

Как появляется файл robots.

txt?

txt?Очень простой файл robots.txt используется большинством популярных блогов. Контент может отличаться от требований конкретного веб-сайта.

Агент пользователя: * Запретить: Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml Файл robots.txt разрешает всем ботам индексировать любой контент и предлагать ссылки на веб-сайт карты сайта в формате XML. В файлах robots.txt упоминаются следующие правила, которым необходимо следовать. Пользовательский агент: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Запретить: /readme.html Запретить: /см./ Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml

Это укажет боту индексировать все файлы и изображения WordPress. Это не позволит поисковым ботам индексировать область администрирования WordPress, файлы плагинов WordPress, партнерские ссылки и файл readme WordPress.

В файлы robots.txt можно добавить карты сайта, которые помогут роботам Google распознавать все страницы вашего сайта.

Теперь вы знаете, как выглядит файл robots.txt, теперь мы узнаем, как можно создать файл robots.txt в WordPress.

Как в WordPress создать файл robots.txt?

Существует множество способов создать файл robots.txt в WordPress. Некоторые из лучших методов перечислены ниже, вы можете выбрать любой из них, который лучше всего подходит для вас.

Метод 1: Использование All-in-One SEO, изменение файла Robots.txt

All-in-One SEO — это самый известный плагин WordPress для SEO на рынке, который используется более чем на 1 миллионе веб-сайтов.

Плагин All in One SEO очень прост в использовании и поэтому предлагает генератор файлов robotx.txt. Также полезно оптимизировать WordPress Robots.txt

Если вы еще не интегрировали этот SEO-плагин, сначала установите и активируйте его с панели инструментов WordPress. Бесплатная версия также доступна для начинающих пользователей, чтобы они могли использовать ее функции, не вкладывая денег.

После активации плагина вы можете начать использовать его для создания или изменения файла robots.txt непосредственно из области администрирования WordPress.

Чтобы использовать

- Перейти на All-in-One SEO

- Теперь, чтобы отредактировать файл robots.txt, нажмите на инструменты

- Теперь, нажав «включить пользовательский файл robots.txt», вы включите параметр редактирования

- В WordPress вы также можете создать собственный файл robots.txt с помощью этого переключателя.

- Теперь ваш существующий файл robots.txt будет отображаться плагином All in One SEO в разделе «Предварительный просмотр robots.txt». Это можно просмотреть в нижней части веб-экрана.

WordPress, правило по умолчанию, которое было добавлено, будет отображаться в этой версии

Правила по умолчанию, которые появляются, предлагают вашей поисковой системе, что им не нужно сканировать основные файлы WordPress, предлагают ссылку на веб-сайт карты сайта XML и разрешить ботам индексировать весь его контент.

Чтобы улучшить файл robots.txt для SEO, можно добавить новые собственные правила.

Добавить пользовательский агент в поле «Пользовательский агент», чтобы добавить правило. Правило будет применяться ко всем пользовательским агентам с помощью файла *.

Теперь выберите, хотите ли вы разрешить или запретить поисковой системе сканировать страницы.

Теперь добавьте путь к каталогу, имя файла в поле «Путь к каталогу».

К вашему файлу robots.txt правило будет применено автоматически. Нажмите кнопку «Добавить правило», чтобы добавить новое правило.

Если вы не создали идеальный формат robotx.txt, мы предлагаем вам добавить новые правила.

Пользовательские правила, добавленные вами, будут выглядеть так:

Чтобы сохранить изменения, не забудьте нажать «Сохранить изменения»

Способ 2: Измените файл Robots.txt вручную с помощью FTP

Другой способ оптимизации WordPress Robots.txt — использовать функции FTP-клиентов, чтобы начать изменение файла robots. txt

txt

. Вам просто нужно подключиться к своей учетной записи хостинга WordPress с помощью FTP-клиента

После входа в корневую папку сайта вы сможете просмотреть файл robots.txt.

Если вы не можете его найти, значит у вас нет файла robots.txt

В такой ситуации вам необходимо создать файл robot.txt.

Как упоминалось ранее, файл robots.txt обычно представляет собой простой текстовый файл, который можно загрузить на свой компьютер. Однако вы даже можете изменить его с помощью простого текстового редактора, такого как TextEdit, Блокнот или WordPad.

После внесения всех изменений пришло время их сохранить. Вы можете загрузить этот файл в корневую папку вашего сайта.

Как выполнить тестирование файла Robots.txt?

Вы можете выполнить тестирование с помощью инструмента для тестирования robots.txt.

В Интернете вы найдете множество инструментов для тестирования robots.txt. Одним из лучших является Google Search Console.

Для работы с этим инструментом сначала необходимо иметь веб-сайт, подключенный к поисковой консоли Google. После этого вы можете начать использовать его функции.

Из выпадающего списка вам просто нужно выбрать свою собственность.

Однако он автоматически выберет файл robots.txt вашего веб-сайта и выделит все предупреждения и ошибки. Это один из лучших инструментов, который поможет вам очень легко оптимизировать файл WordPress Robots.txt.

Заключение:

Основной девиз оптимизации этого файла robots.txt — защитить страницы от сканирования страниц. Например, страницы в папке администратора WordPress или страницы в папке wp-plugin.

Самый распространенный миф заключается в том, что вы можете улучшить скорость сканирования, ускорить индексацию и получить более высокий рейтинг, заблокировав категорию WordPress, страницы достижения и теги.

Но это не сработает, так как в соответствии с рекомендациями Google для веб-мастеров что-то пойдет не так.