Работа с файлом robots.txt на WordPress-сайте

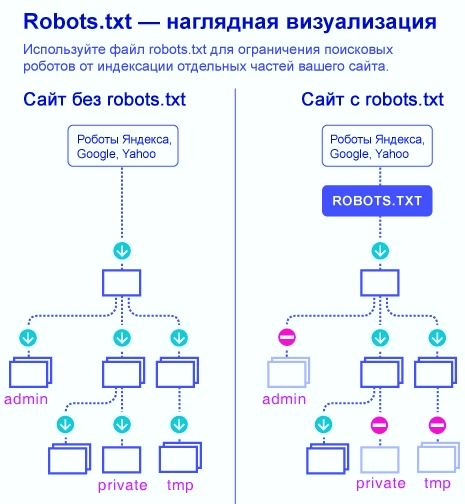

Необязательный в использовании файл, предназначенный для ограничения доступа поисковым роботам к содержимому сайта – это robots.txt. Появившийся более 20 лет назад, успел получить поддержку от большинства поисковых систем. Задает необходимые параметры индексации при помощи набора инструкций.

Основная информация и предназначение

Предоставляет поисковым системам путь для индексации важных элементов ресурса. Под этим подразумевается установка ограничений для директорий, страниц, а также указывается путь к зеркалу и карте сайта. Первым делом поисковая машина находит robots.txt (размещен в корневой папке) и после этого следует указанным директивам. При отсутствии этого файла – робот проводит полное сканирование сайта.

Отметим, что содержимое документа является рекомендацией, а не обязательной командой. Нет гарантий того, что скрытая страница не попадет в индекс.

Внимание! Все записи осуществляются латинскими символами.

При использовании доменного имени на кириллице, стоит воспользоваться сервисом кодирования Punycode.

Работа с файлом robots.txt позволяет сократить время обработки ресурса. Будут индексироваться только необходимые страницы – это существенно снизит нагрузку на сервер.

Обязательному запрету подлежат:

Основные директивы и спецсимволы

Основные директивы устанавливают правила и определяют, какой конкретно робот должен их выполнять.

- User-agent – указывает кому адресованы инструкции;

- Disallow – устанавливает запрет на индексацию указанной части ресурса;

- Allow – разрешает доступ поисковика к директории;

- Sitemap – адрес расположения карты сайта.

User-agent

Является своеобразным приветствием для поисковиков, после директивы указывается имя бота. Список часто используемых значений:

- Googlebot – основной бот Google;

- Googlebot-Image – для изображений;

- Yandex – основной робот Яндекс;

- YandexDirect – обработка информации для контекстной рекламы;

- YandexImages – для изображений;

- YandexMetrika – система статистики;

Чтобы обратиться ко всем роботам, необходимо после директивы указать звездочку: «-agent: *».

Будет интересно – “Настройка файла robots.txt для WordPress”

Disallow и Allow

Использование Disallow необходимо для запрета сканирования определенного каталога или страницы. Чтобы робот не индексировал весь сайт, необходимо использовать слеш:

User-agent: * Disallow: /

Для закрытия доступа к определенной директории, указывается ее название (слеш перед и после названия папки):

User-agent: * Disallow: /category/

Таким же образом происходит запрет на индексацию отдельных файлов:

User-agent: * Disallow: /category/samplepage.html

Если каталог заблокирован, а сканирование страницы, находящейся внутри обязательно – вносят следующие правки:

User-agent: * Disallow: /category/ Allow: /category/samplepage.html

Данная комбинация осуществляет запрет на индексацию файлов одного типа:

User-agent: * Disallow: /*.jpg$

Sitemap и Host

При наличии одной или нескольких карт сайта, указывается адрес каждой:

User-agent: * Sitemap: https://yoursite.com/sitemap1.xml Sitemap: https://yoursite.com/sitemap2.xml

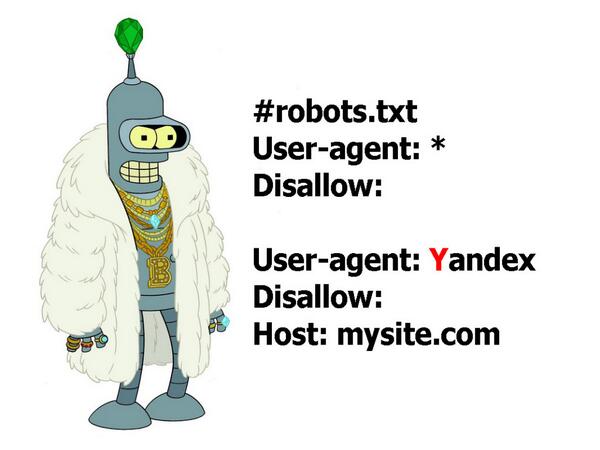

Директива Host предназначена только для Яндекса, указывает основное зеркало сайта.

User-agent: Yandex

Host: yoursite.com

Спецсимволы

Звездочка (*) используется для запрета всех url, в имени которых содержится указанное слово, к примеру, закрываем доступ к файлам, имеющих в названии «semki»:

User-agent: * Disallow: /*semki

Для отмены правила запрета, прописывается символ $ в конце строки. При этом, доступ закрыт только к указанной директории, ее содержимое будет доступно:

User-agent: * Disallow: /page$ #доступ к /page запрещен #доступ к /page.html открыт

Слеш указывается в каждой директиве, запрещает доступ к папке или вложенным страницам.

User-agent: * Disallow: /category/ #доступ к файлам директории /category/ запрещен Disallow: /category #запрещается доступ ко всем файлам, начинающимся с /category

Решетка служит для добавления комментариев, необходимых для личного удобства.

По теме –“Карта сайта для WordPress с помощью плагина Google XML Sitemaps”

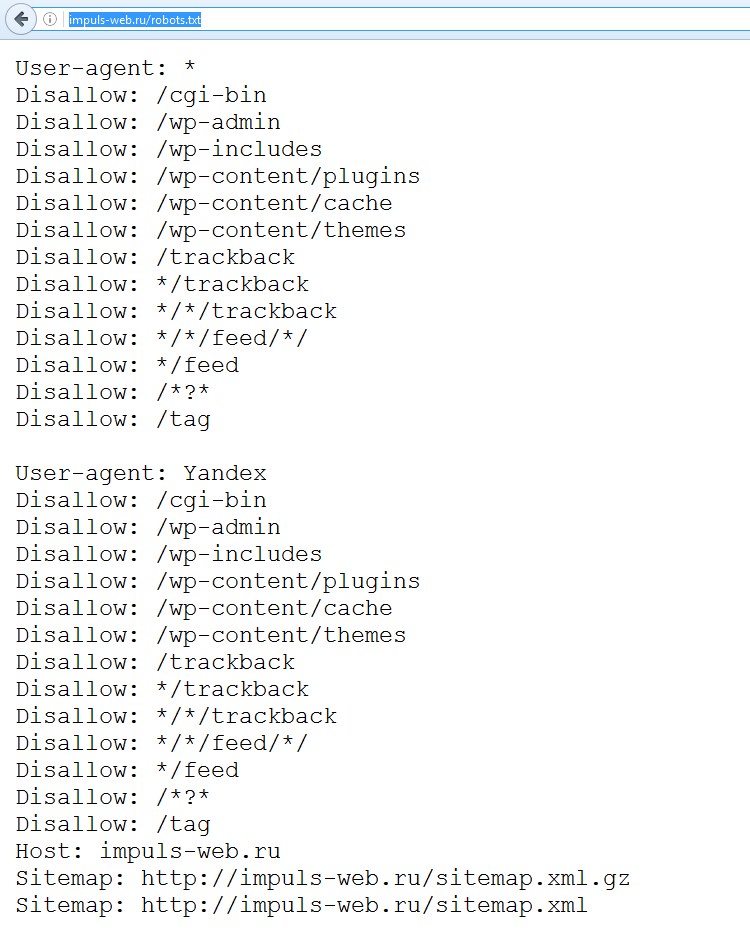

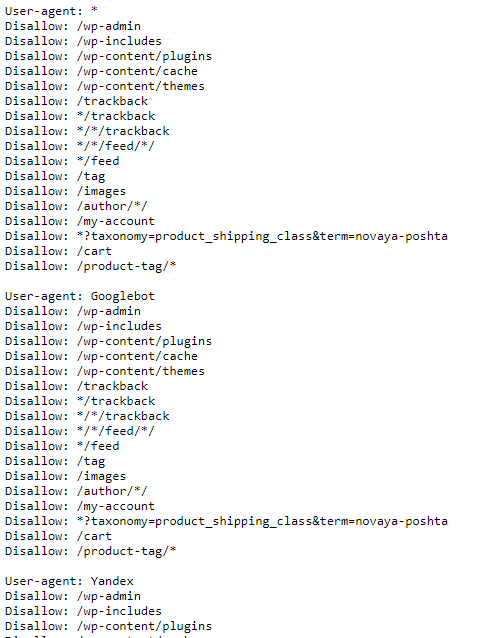

Стандартный robots.txt

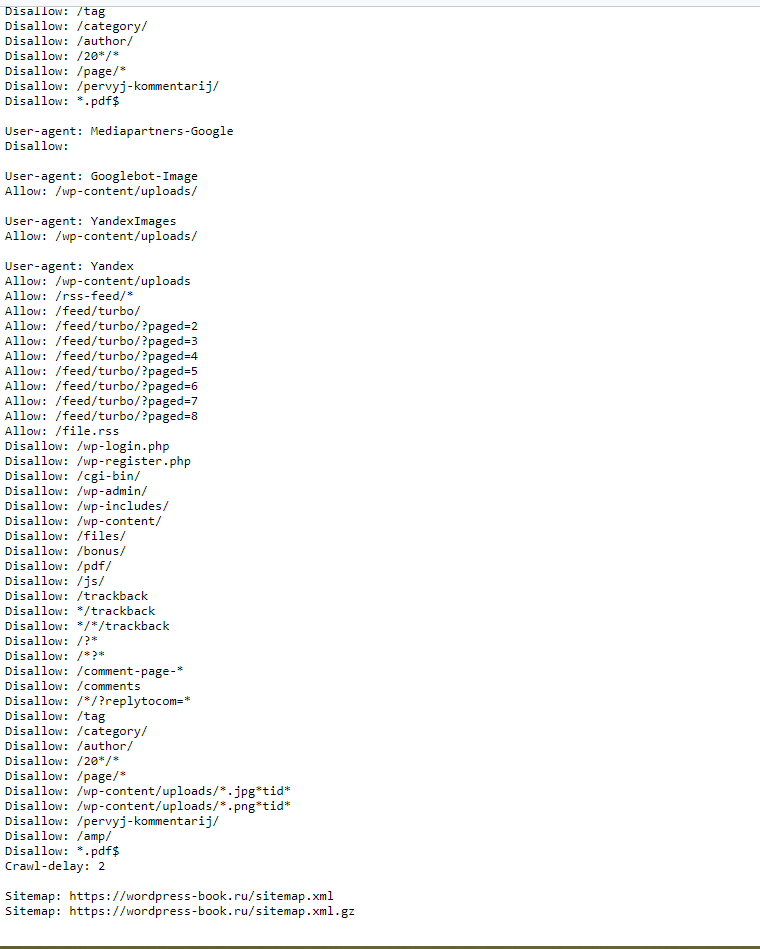

Работа с файлом robots.txt на WordPress-сайте может создавать некоторые путаницы для неопытных вебмастеров, поскольку рекомендуемый код, в некоторых строках, лишен логики. Для каждого ресурса требуются свои запреты и разрешения, все зависит от направления деятельности и предпочтений владельца ресурса. Рекомендуем к изучению стандартное содержимое robots.txt:

User-agent: * Disallow: /wp-admin Disallow: /wp-content Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: /xmlrpc.php Disallow: */feed Disallow: */author User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: YandexImages Allow: /wp-content/uploads/ host: yoursite.com Sitemap: http://yoursite.com/sitemap.xml

В приведенном примере, директива указывает правила для всех поисковых машин, следующие строки закрывают доступ к административной части и служебным папкам. Запрещаются для индексации авторские страницы и лента RSS. Далее открывается доступ к индексации медиафайлов для ботов изображений популярных поисковиков. В конце прописывается хост и карта сайта. Также рекомендуется добавить запрет на сканирование архивов и меток, если не используются SEO-плагины (Yoast SEO, All in One SEO Pack).

Запрещаются для индексации авторские страницы и лента RSS. Далее открывается доступ к индексации медиафайлов для ботов изображений популярных поисковиков. В конце прописывается хост и карта сайта. Также рекомендуется добавить запрет на сканирование архивов и меток, если не используются SEO-плагины (Yoast SEO, All in One SEO Pack).

Специально для вас – “Clearfy Pro: чистый код сайта на WordPress”

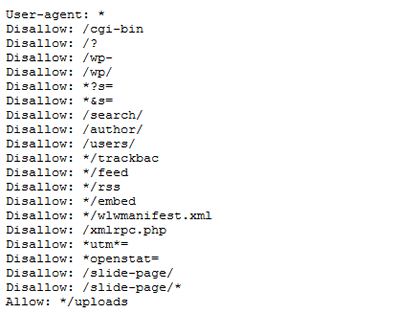

Данный код является наиболее сбалансированным и логичным, закрывает уязвимые файлы и директории:

User-agent: * Disallow: /cgi-bin # закрывает каталог скриптов на сервере Disallow: /? # все параметры запроса на главной Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: *?s= # поиск Disallow: *&s= # поиск Disallow: /search # поиск Disallow: /author/ # архив автора Disallow: *?attachment_id= # страница вложения. Вообще-то на ней редирект... Disallow: */feed # все фиды Disallow: */rss # rss фид Disallow: */embed # все встраивания Disallow: */page/ # все виды пагинации Allow: */uploads # открываем uploads Allow: /*/*.js # внутри /wp- (/*/ - для приоритета) Allow: /*/*.css # внутри /wp- (/*/ - для приоритета) Allow: /wp-*.png # картинки в плагинах, cache папке и т.д. Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д. Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д. #Disallow: /wp/ # когда WP установлен в подкаталог wp Sitemap: http://yoursite.com/sitemap.xml Sitemap: http://yoursite.com/sitemap2.xml # еще один файл #Sitemap: http://yoursite.com/sitemap.xml.gz # сжатая версия (.gz) Host: www.yoursite.com # для Яндекса

Первая строка указывает, что правила задействованы ко всем поисковым роботам.

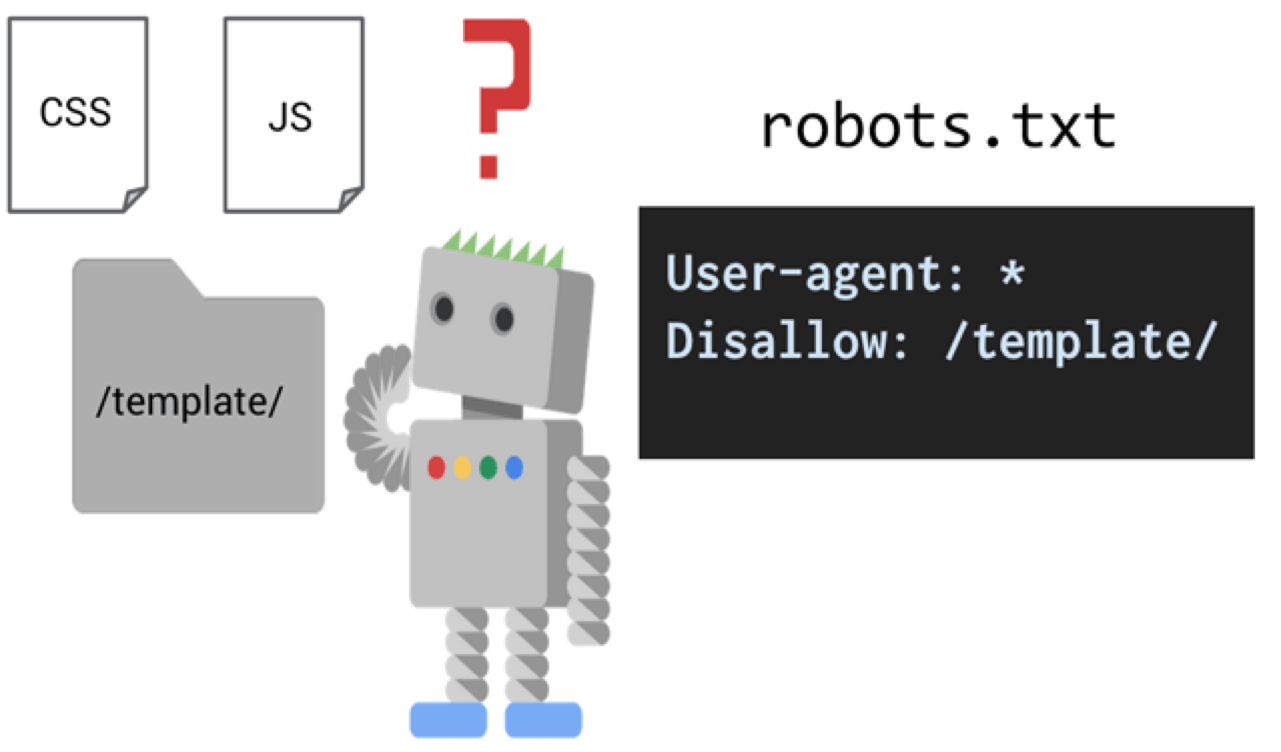

По последней информации, поисковики начали требовать открытие доступа к CSS и JS. Но, не стоит открывать весь каталог, ненужные скрипты и ресурсы страниц можно скрывать.

Создание и загрузка на сервер

Классический вариант – создать новый текстовый документ с именем robots, после чего внести данные при помощи редактора (рекомендуется Notepad+ или Alkepad). Добавляются рассмотренные вначале директивы, согласно требованиям администратора. Можно адаптировать готовые образцы, которые представлены на многих специализированных сайтах или блогах.

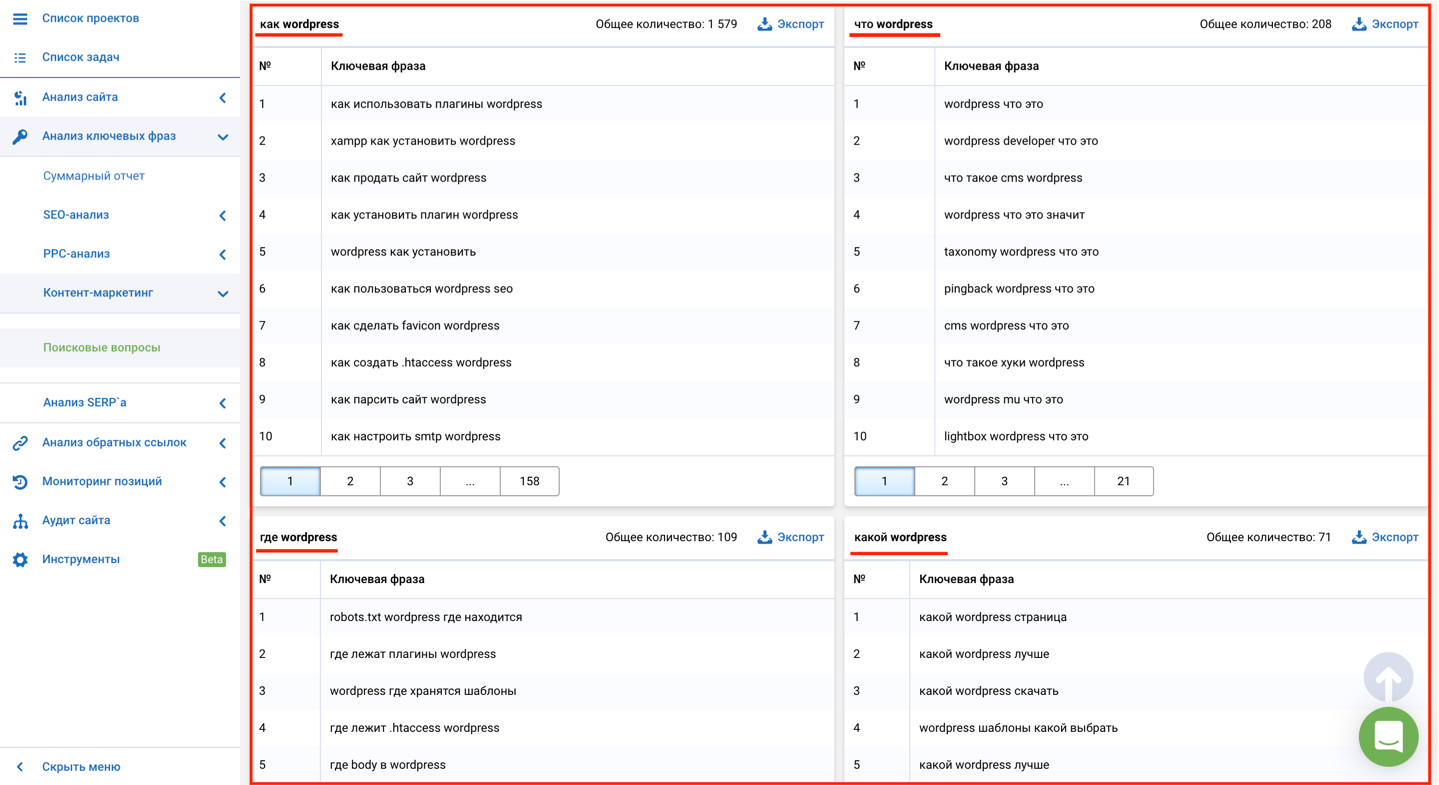

Еще один вариант – воспользоваться сервисами генерации robots.txt, к примеру: SeoLib, PR-CY, MediaSova, 4SEO. На этих ресурсах можно детально настроить правила индексирования, выбрать для каких роботов указываются инструкции, вписать конкретные страницы, папки и карту сайта. После этого, в окне результатов появится предпросмотр содержимого файла – если все устраивает, документ готов к сохранению.

Отобрано редакцией – “Установка и настройка CMS WordPress”

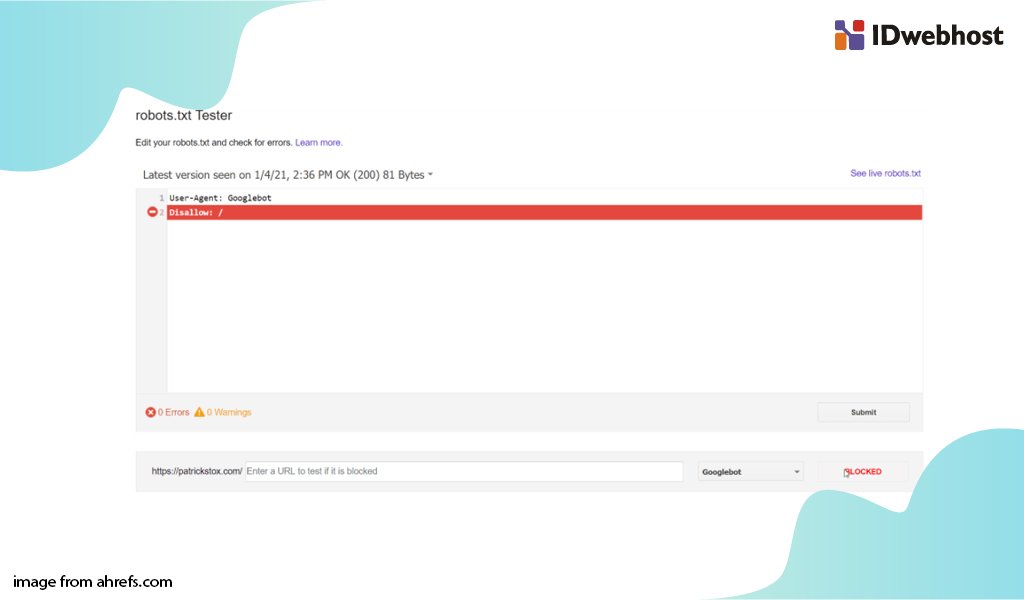

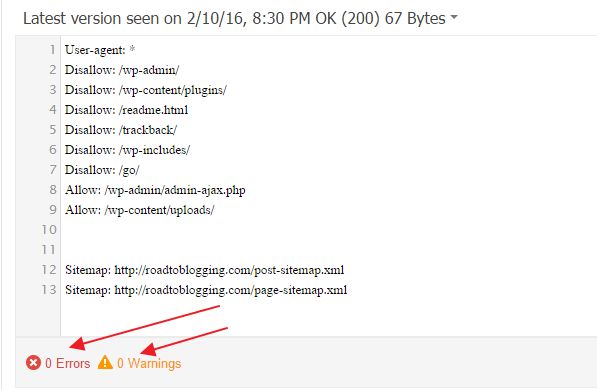

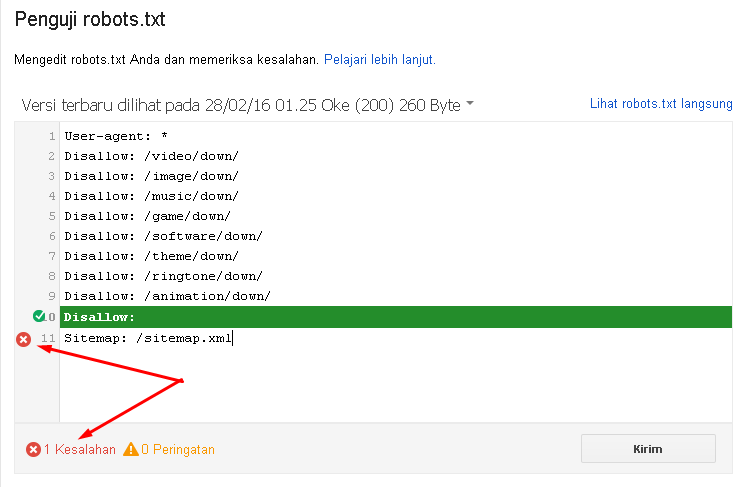

Инструмент Google:

- Позволяет проанализировать код на наличие ошибок.

- Все правки осуществляются прямо в панели проверки, после чего исправленный документ можно повторно загрузить на сервер.

- Указывает разрешения и запреты, как реагирует бот на внесенные правила.

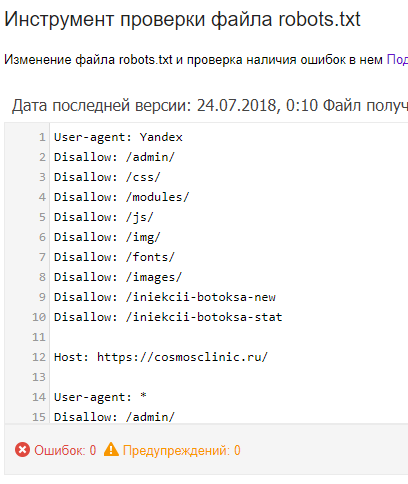

Инструмент Яндекс:

- После авторизации можно проверять robots.txt без подтверждения прав на сайт.

- Возможность пакетной обработки страниц.

- Демонстрируются все ошибки директив, которые неправильно обрабатываются ботом.

P.S.

Работа с файлом robots.txt на WordPress-сайте заключается в тщательном анализе каталогов, которые подлежат запрету или разрешению к индексации. Стоит внимательно изучить основные директивы и важность определенных каталогов для поисковых машин. Процесс создания не затруднит малоопытных вебмастеров, поскольку в сети присутствует множество примеров и специальных сервисов для их генерации. Есть 2 основных правила при самостоятельном написании кода: строки, относящиеся к одному роботу – не должны содержать пропусков, разделение правил для разных ботов осуществляется при помощи пустой строки.

Интересно и по теме – “10 лучших SEO плагинов и инструментов WordPress в 2017 году”

Редактируем Robots.

txt в WordPress с помощью плагина All in One SEO

txt в WordPress с помощью плагина All in One SEOФайл robots.txt – это мощный инструмент SEO, поскольку он работает как руководство по веб-сайту для роботов или роботов, выполняющих сканирование поисковых систем. Указание ботам не сканировать ненужные страницы может увеличить скорость загрузки вашего сайта и улучшить рейтинг в поисковых системах.

Несмотря на то, что однажды я уже создавал пост про этот важный файл для оптимизации работы сайтов, в этом мануале я более подробно расскажу вам, что такое файл robots.txt и почему он важен. А так же шаг за шагом покажу, как редактировать и как редактировать его в WordPress.

Что такое файл Robots.txt?

Файл robots.txt сообщает поисковым системам, как сканировать ваш сайт – где им можно это делать, а где нельзя.

Поисковые системы, такие как Google, используют этих поисковых роботов, иногда называемых веб-роботами, для архивирования и классификации веб-сайтов.

Большинство ботов настроены на поиск файла robots. txt на сервере до того, как он прочитает любой другой файл с вашего сайта. Это делается для того, чтобы увидеть, добавили ли вы особые инструкции по сканированию и индексированию вашего сайта.

txt на сервере до того, как он прочитает любой другой файл с вашего сайта. Это делается для того, чтобы увидеть, добавили ли вы особые инструкции по сканированию и индексированию вашего сайта.

Файл robots.txt обычно хранится в корневом каталоге, также известном как основная папка веб-сайта. URL-адрес может выглядеть так: http://www.example.com/robots.txt

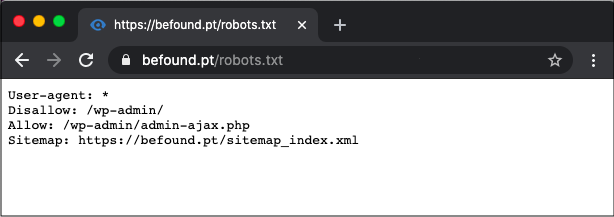

Чтобы проверить файл robots.txt на своем веб-сайте, просто замените http://www.example.com/ на свой домен и добавьте robots.txt в конце.

Сейчас же, давайте посмотрим, как выглядит основной формат файла robots.txt:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]Чтобы это имело смысл, сначала нужно объяснить, что означает User-agent.

По сути, это имя бота или робота поисковой системы, которому вы хотите заблокировать или разрешить сканировать ваш сайт (например, робот Googlebot).

Во-вторых, вы можете включить несколько инструкций, чтобы разрешить или запретить определенные URL-адреса, а также добавить несколько карт сайта. Как вы, наверное, догадались, опция запрета указывает роботам поисковых систем не сканировать эти URL-адреса.

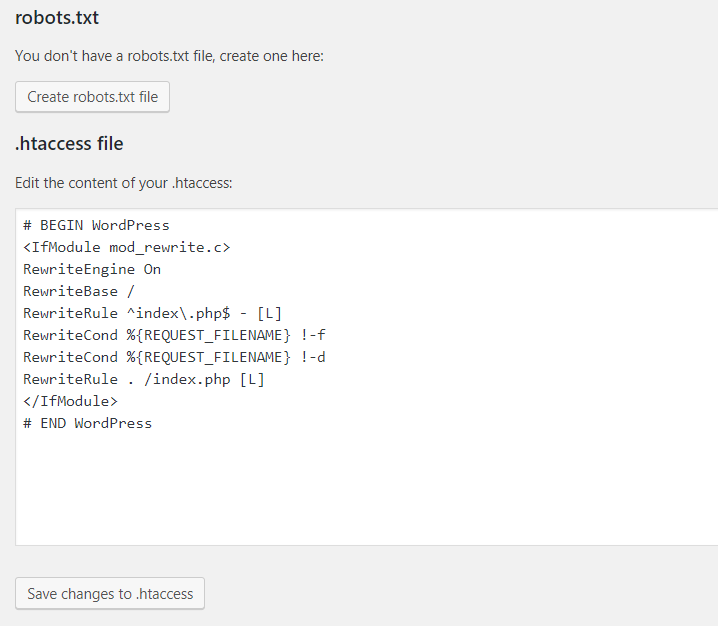

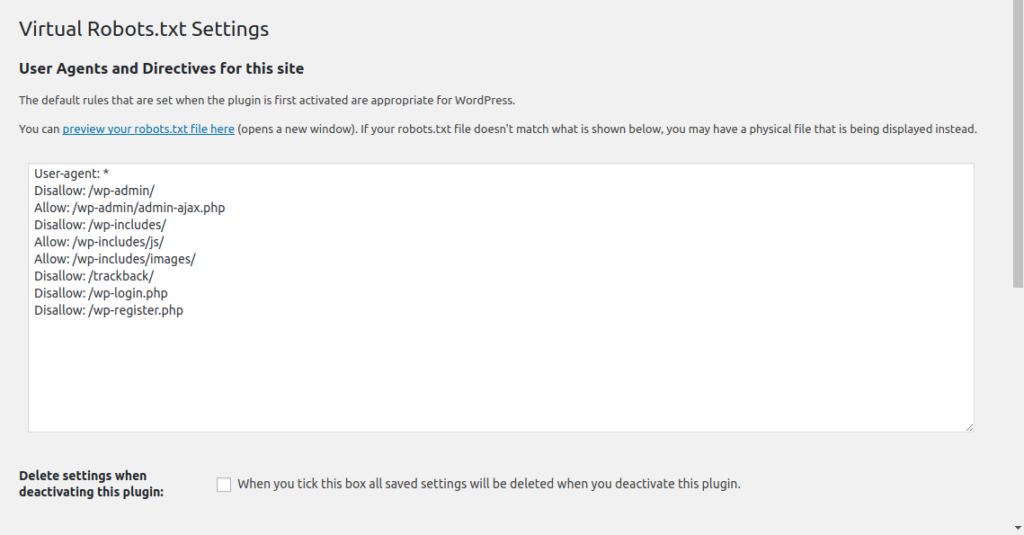

Файл Robots.txt по умолчанию в WordPress

По умолчанию WordPress автоматически создает файл robots.txt для вашего сайта. Так что, даже если вы не пошевелите пальцем, на вашем сайте уже должен быть файл robots.txt WordPress по умолчанию.

Но когда вы позже настроите его своими собственными правилами, содержимое по умолчанию будет заменено.

Стандартные файлы robots.txt выглядит так:

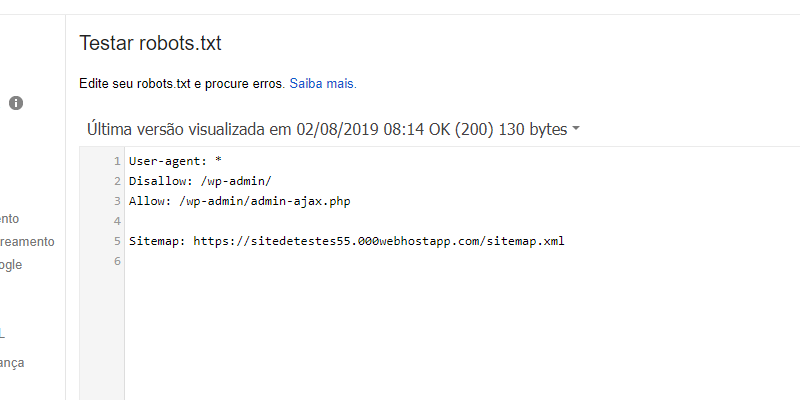

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpЗвездочка после User-agent: * означает, что файл robots.txt предназначен для всех веб-роботов, посещающих ваш сайт. И, как уже упоминалось, Disallow: / wp-admin / указывает роботам не посещать вашу страницу wp-admin.

Вы можете протестировать свой файл robots. txt, добавив /robots.txt в конце своего доменного имени. Например, если вы введете в адресную строку браузера запись https://aioseo.com/robots.txt , то в нем отобразится файл robots.txt для сайта плагина AIOSEO, который его разработчики настроили вот так:

txt, добавив /robots.txt в конце своего доменного имени. Например, если вы введете в адресную строку браузера запись https://aioseo.com/robots.txt , то в нем отобразится файл robots.txt для сайта плагина AIOSEO, который его разработчики настроили вот так:

Теперь, когда вы знаете, что такое файл robots.txt и основы его работы, давайте посмотрим, почему файл robots.txt имеет значение в первую очередь.

Почему важен файл Robots.txt?

Файл robots.txt важен, потому, что с помощью него вы:

1. Оптимизируйте скорость загрузки вашего сайта – указав ботам не тратить время на страницы, которые вы не хотите, чтобы они сканировали и индексировали, вы можете освободить ресурсы и увеличить скорость загрузки вашего сайта.

2. Оптимизируете использования сервера – блокировка ботов, которые тратят ресурсы впустую, очистит ваш сервер и уменьшит количество ошибок 404.

Когда использовать мета-тег Noindex вместо robots.txt

Однако, если ваша основная цель – предотвратить включение определенных страниц в результаты поисковых систем, правильным подходом является использование метатега noindex.

Это связано с тем, что файл robots.txt напрямую не говорит поисковым системам не индексировать контент – он просто говорит им не сканировать его.

Другими словами, вы можете использовать файл robots.txt для добавления определенных правил взаимодействия поисковых систем и других ботов с вашим сайтом, но он не будет явно контролировать, индексируется ли ваш контент или нет.

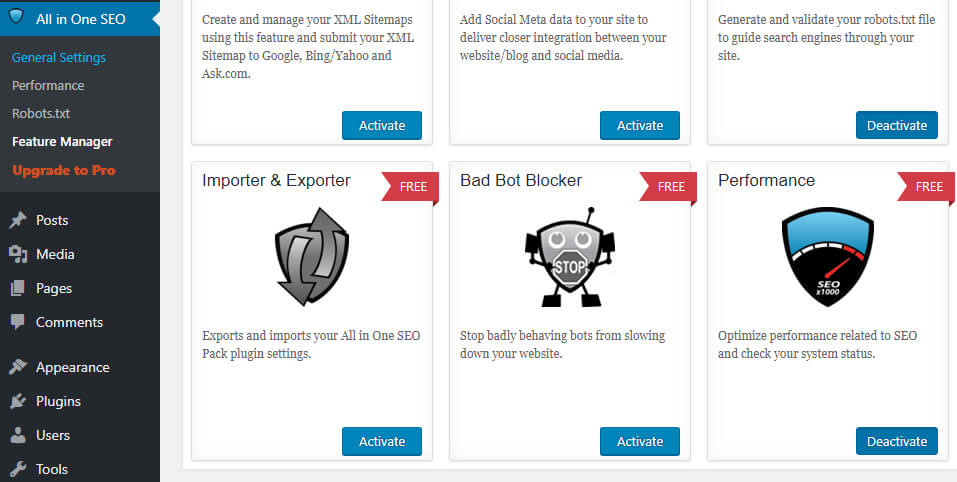

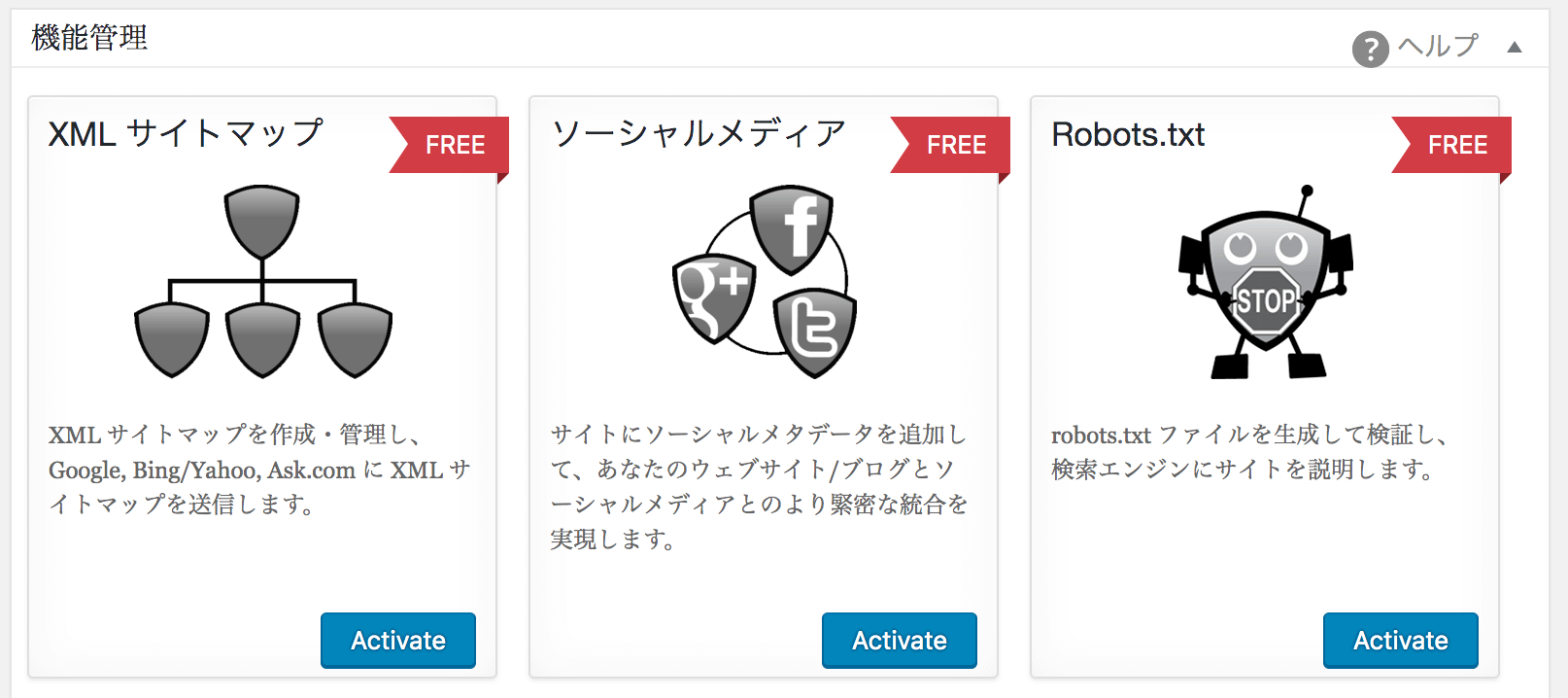

С учетом сказанного, давайте покажем вам, как легко шаг за шагом редактировать файл robots.txt в WordPress с помощью сео-плагина для WordPress – All in One SEO (AIOSEO)

Как редактировать файл Robots.txt в WordPress с помощью AIOSEO

Самый простой способ отредактировать файл robots.txt – использовать лучший плагин WordPress SEO All in One SEO (AIOSEO). Если вы его установили, то это позволит вам контролировать свой веб-сайт и настраивать файл robots.txt, который заменяет файл WordPress по умолчанию.

Если вы этого еще не знали, AIOSEO – это полноценный плагин WordPress для SEO,

который позволяет вам оптимизировать контент для поисковых систем и повысить рейтинг всего за несколько кликов. Ознакомьтесь с его мощными инструментами и функциями SEO здесь.

Ознакомьтесь с его мощными инструментами и функциями SEO здесь.

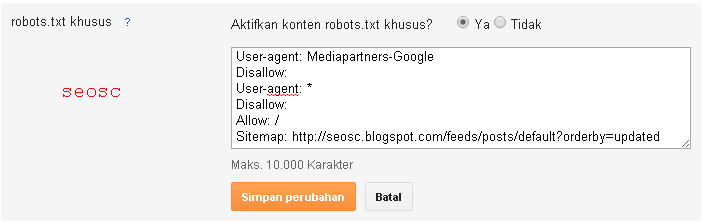

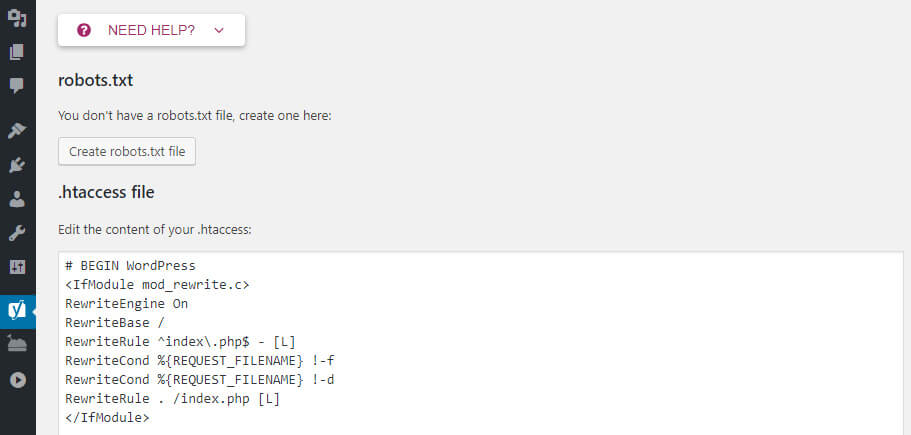

Включаем пользовательский файл Robots.txt

Чтобы приступить к редактированию файла robots.txt, с помощью уже установленного плагина AIOSEO, выберите в меню плагина строку «Инструменты». Таким образом вы откроете вкладку «Редактор Robots.txt». Далее приступаем к настройкам плагина.

Примечание* Если у вас уже был настроен файл и он вас вполне устраивает, вы можете просто импортировать его в AIOSEO.

Перевод страницы предупреждения и рекомендаций, если у вас уже был установлен файл: “AIOSEO обнаружила физический файл robots.txt в корневой папке вашей установки WordPress. Мы рекомендуем удалить этот файл, так как он может вызвать конфликт с динамически созданным файлом WordPress. AIOSEO может импортировать этот файл и удалить его, или вы можете просто удалить его”.Теперь на странице редактирования можно легко добавлять или удалять необходимые правила. Если вы пожелаете удалить ранее созданный файл-роботс – просто импортируйте и удалите его и пользуйтесь настройками по умолчанию. Но действовать нужно с осторожностью и не спешить удалять старый, несмотря на предупреждения плагина, а лучше используйте редактор.

Но действовать нужно с осторожностью и не спешить удалять старый, несмотря на предупреждения плагина, а лучше используйте редактор.

AIOSEO сгенерирует динамический файл robots.txt. Его содержимое хранится в вашей базе данных WordPress и может быть просмотрено в вашем веб-браузере.

После того, как вы вошли в редактор Robots.txt, вам необходимо включить Custom Robots.txt.

Кнопка включения окна редактирования файла robots.txtЗатем вы увидите раздел предварительного просмотра файла Robots.txt в нижней части экрана, в котором показаны правила WordPress по умолчанию, которые вы можете заменить своими собственными.

Правила по умолчанию предписывают роботам не сканировать ваши основные файлы WordPress (страницы администратора). Также не рекомендуется сканировать плагины и темы. Они не содержат релевантного содержания и не нужны поисковым системам для сканирования.

Теперь давайте перейдем к тому, как вы можете добавить (или редактировать уже созданные) свои собственные правила с помощью создателя правил.

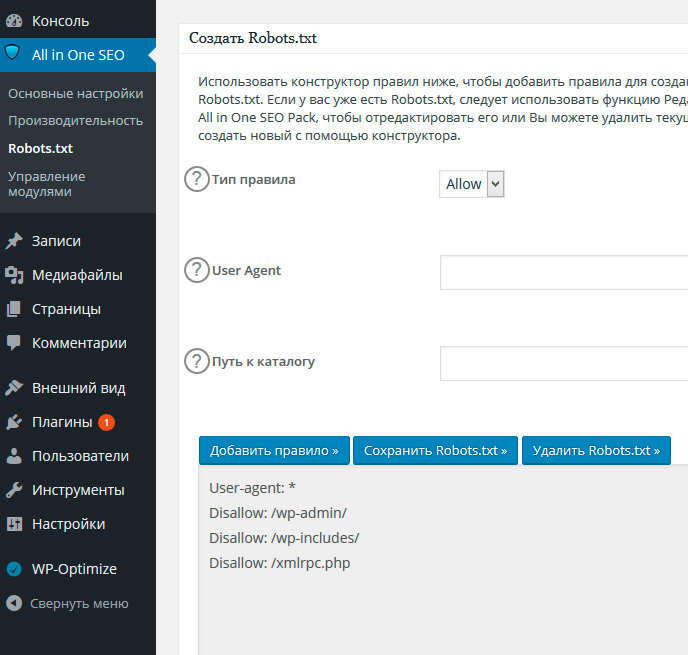

Добавление правил с помощью создателя правил

Конструктор правил используется для добавления ваших собственных правил для того, какие страницы роботы должны сканировать или нет.

Например, если вы хотите добавить правило, которое блокирует всех роботов из временного каталога (имеется в виду временная папка, например, на жестком диске), вы можете использовать для этого создатель правил.

Чтобы добавить собственное правило, просто введите User Agent (например, поисковый робот Googlebot) в поле User Agent. Или вы можете использовать символ *, чтобы ваше правило применялось ко всем пользовательским агентам (роботам).

Затем выберите «Разрешить» или «Запретить», или удалить (справа в таблице значок корзины), чтобы разрешить или заблокировать User Agent.

Или добавить новое правило:

По окончании редактирования и внесения изменений, вернитесь на верх страницы и осуществите просмотр файла в адресной строке браузера “Open Robots.txt”:

Что бы операция установки редактирования файла robots. txt была завершена, не забудьте сохранить изменения, кликнув на соответствующую кнопку в самом верху или внизу страницы редактирования.

txt была завершена, не забудьте сохранить изменения, кликнув на соответствующую кнопку в самом верху или внизу страницы редактирования.

Надеюсь, что это руководство показало вам, как легко редактировать файл robots.txt в WordPress. Теперь продолжайте и добавляйте свои собственные правила, и вы в кратчайшие сроки убедитесь, что ваш веб-сайт оптимизирован для достижения оптимальной производительности.

(Visited 1 times, 2 visits today)

Настройка robots.txt для WordPress, где находится и какой плагин использовать

06.04.2021 АлександрТеперь, когда вы выполнили первоначальную настройку и готовы приступить к наполнению сайта или решили запустить проект в работу, то самое время настроить файл robots.txt для WordPress и/или WooCommerce.

Где в WordPress robots.txt

Если вы самостоятельно установили свежую версию Вордпресс, то данный файл, необходимо создать и сохранить его в корневой папке сайта на хостинге. После этого, файл будет доступен по адресу https://домен вашего сайта/robots.txt или http://домен вашего сайта/robots.txt.

После этого, файл будет доступен по адресу https://домен вашего сайта/robots.txt или http://домен вашего сайта/robots.txt.

Если вам достался готовый и рабочий проект, то тут возможно два варианта:

- файл robots.txt уже настроен и находится в корневой папке сайта;

- его забыли создать.

Индексация сайта на момент разработки

Если проект находится в разработке, то желательно активировать функцию, которая в WordPress находится: «Настройки», «Чтение», «Видимость для поисковых систем», «Попросить поисковые системы не индексировать сайт» и нажмите кнопку «Сохранить изменения». А в файле robots.txt временно запретить доступ к корневой папке поисковым роботам.

Зачем это нужно? — спросите вы.

Дело в том, что при создании сайта/блога в виду множества причин, будут не раз меняться url страниц и файлов сайта (меняются расположение рубрик/страниц/записей/карточек товаров, подключается транслитерация кириллицы для страниц и загружаемых файлов, создаются тестовые страницы. ..).

..).

Чтобы «неправильные» адреса не попали в поисковую выдачу, необходимо сделать выше написанное. А когда все будет готово — то пункт «Видимость для поисковых систем» верните в исходное положение (убрать флажок в чекбоксе) и настройте правильный robots.txt для WordPress и/или WooCommerce.

Добавлять сайт в кабинет Яндекс Вебмастер и/или в Google Search Console – необходимо только тогда, когда будите готовы запустить проект в работу и на сайте будет настроен robots.txt и сформирована карта сайта в формате xml.

Настройка через хостинг и плагин

Если вы создаете файл самостоятельно, то для работы с ним рекомендуется использовать текстовый редактор, который не добавляет лишний код в разметку, например, Notepad++.

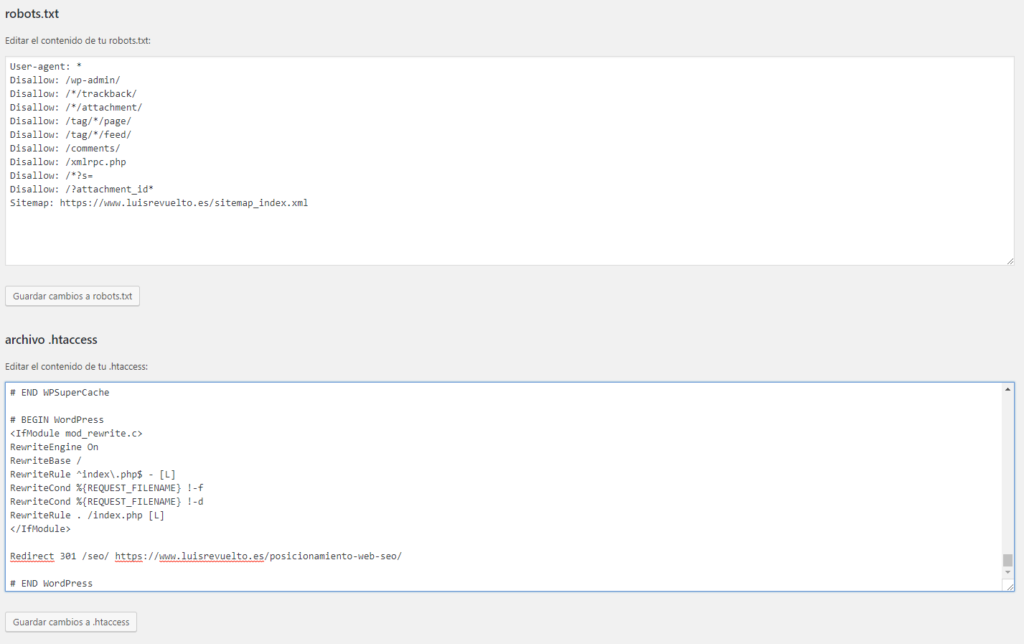

Основные директивы, которые понадобятся в настройке robots.txt через хостинг или плагин, например, Yoast SEO — выглядят следующим образом:

- User-agent: — указывает к каким поисковым роботам применяется правило, например, Yandex, * (роботы всех ПС), Googlebot;

- Disallow: — запрещает индексацию;

- Allow: — индексация разрешена;

- Sitemap: — указывает на расположение файла sitemap.

xml. В данном файле содержатся все страницы, предназначенные для индексирования;

xml. В данном файле содержатся все страницы, предназначенные для индексирования; - Host: — указывает на главное зеркало сайта, например, https://домен.ru/. В данный момент, директива Host не используется и прописывать ее в файле robots.txt — не надо.

Как запретить индексирование сайта в robots.txt

Чтобы запретить индексирование сайта в robots.txt для всех поисковых роботов, используйте следующую конструкцию:

User-agent: * Disallow: /

robots для блога/сайта на WordPress

Файл robots.txt для WordPress выглядит следующим образом:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Allow: */uploads Allow: *.js Allow: *.css Allow: *.png Allow: *.gif Allow: *.jpg User-agent: Yandex Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /tag Disallow: /*?* Allow: */uploads Allow: *.js Allow: *.css Allow: *.png Allow: *.gif Allow: *.jpg Sitemap: https://заменить на домен вашего сайта/sitemap.xml (если не используете плагин Yoast SEO) Sitemap: https://заменить на домен вашего сайта/sitemap_index.xml (если используете плагин Yoast SEO)

Для WooCommerce

Файл robots.txt для WooCommerce выглядит следующим образом:

User-agent: * Disallow: /cgi-bin Disallow: /wp- Disallow: /tag Disallow: /wp-admin Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: *?replytocom Disallow: *?* Disallow: /cart/ Disallow: /checkout/ Disallow: /*add-to-cart=* Disallow: /my-account/ Disallow: /wp-login.php Disallow: /wp-register.php Allow: */uploads Allow: *.js Allow: *.css Allow: *.png Allow: *.gif Allow: *.jpg User-agent: Yandex Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /tag Disallow: *?replytocom Disallow: *?* Disallow: /cart/ Disallow: /checkout/ Disallow: /*add-to-cart=* Disallow: /my-account/ Disallow: /wp-login.php Disallow: /wp-register.php Allow: */uploads Allow: *.js Allow: *.css Allow: *.png Allow: *.gif Allow: *.jpg Sitemap: https://заменить на домен вашего сайта/sitemap.xml (если не используете плагин Yoast SEO) Sitemap: https://заменить на домен вашего сайта/sitemap_index.xml (если используете плагин Yoast SEO)

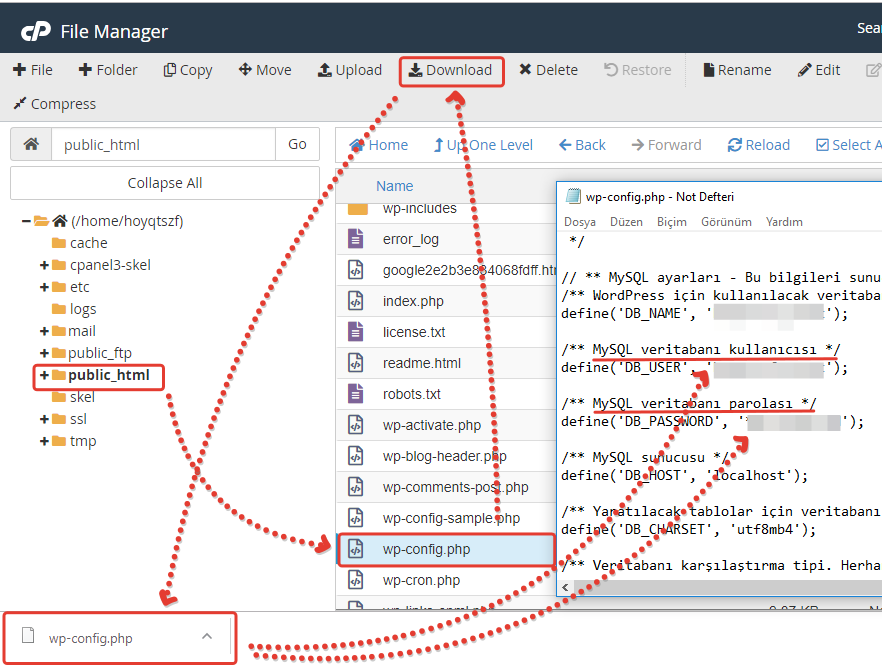

Готовый файл robots.txt загрузите на хостинг, в корень сайта или создайте его там через стандартный менеджер файлов и сохраните изменения.

Повторюсь, если редактируете robots.txt на компьютере или работаете с любым другим файлом, который содержит в себе код, то используйте для этого Notepad++.

Для примера, этот текст написан в OpenOffice и если его скопировать и вставить, например, в онлайн HTML-редактор, то увидите это:

Некоторые редакторы автоматически добавляют теги разметки в текст, а чтобы этого не происходило — используйте предназначенные для этого инструменты.

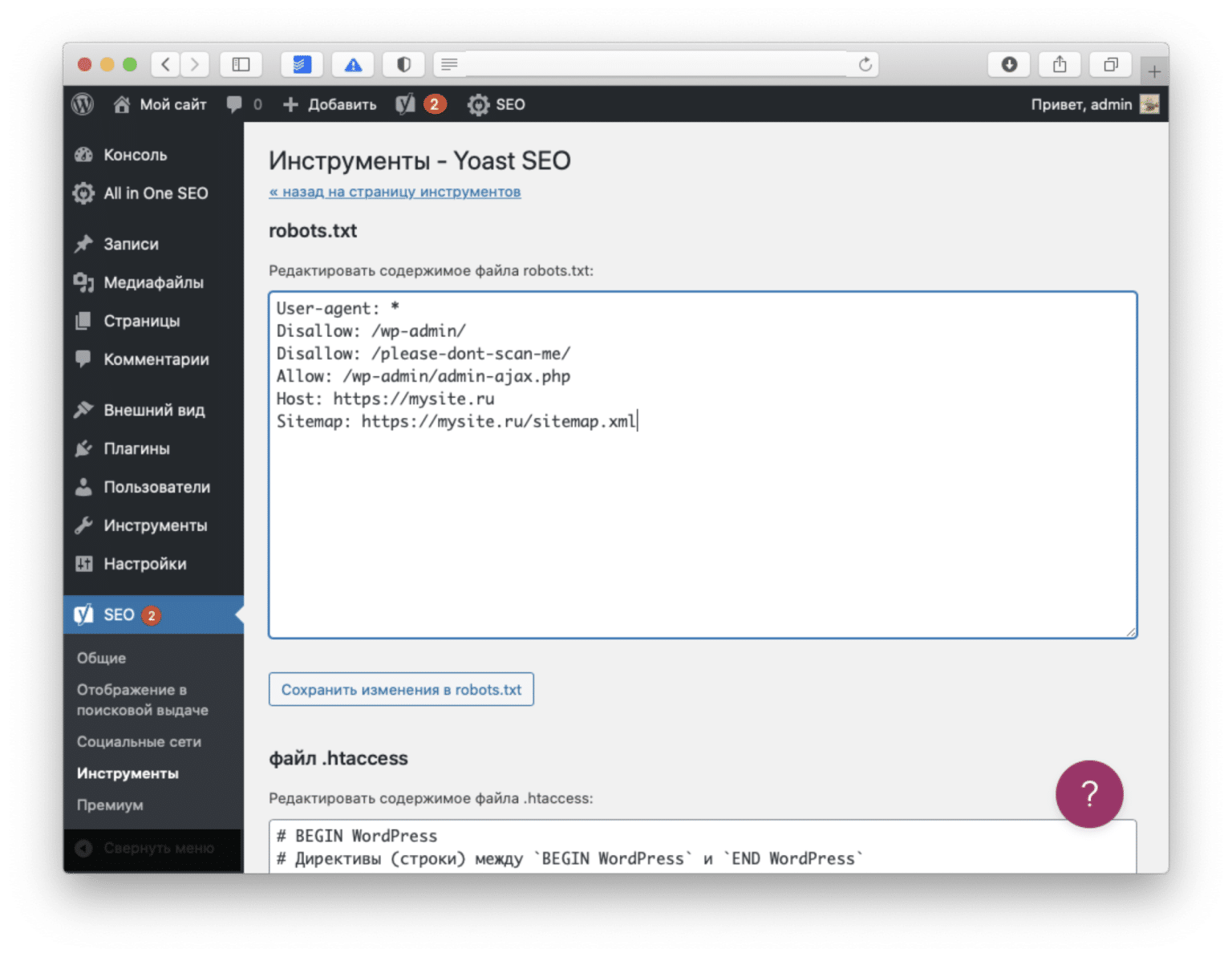

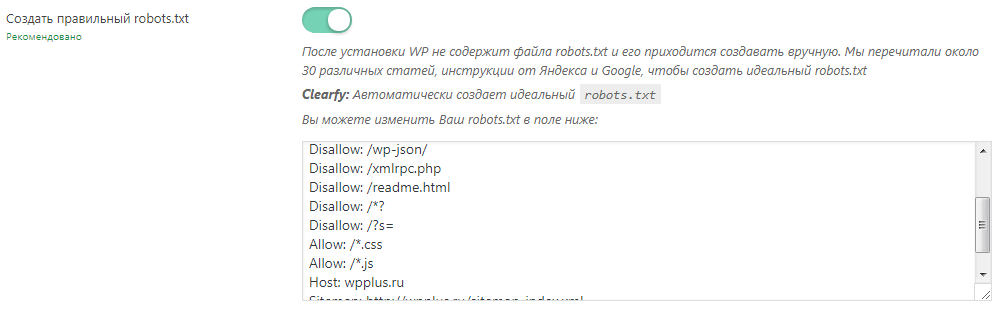

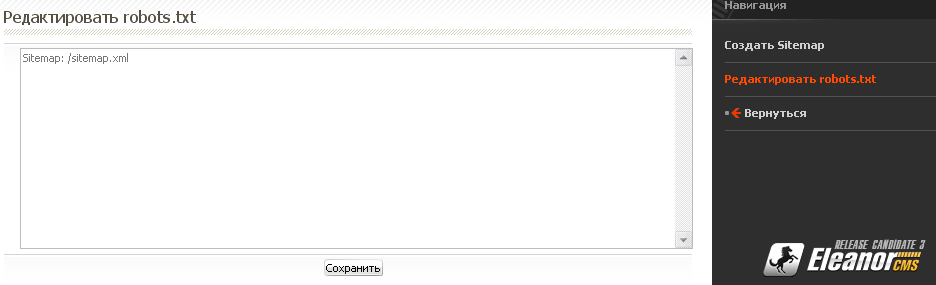

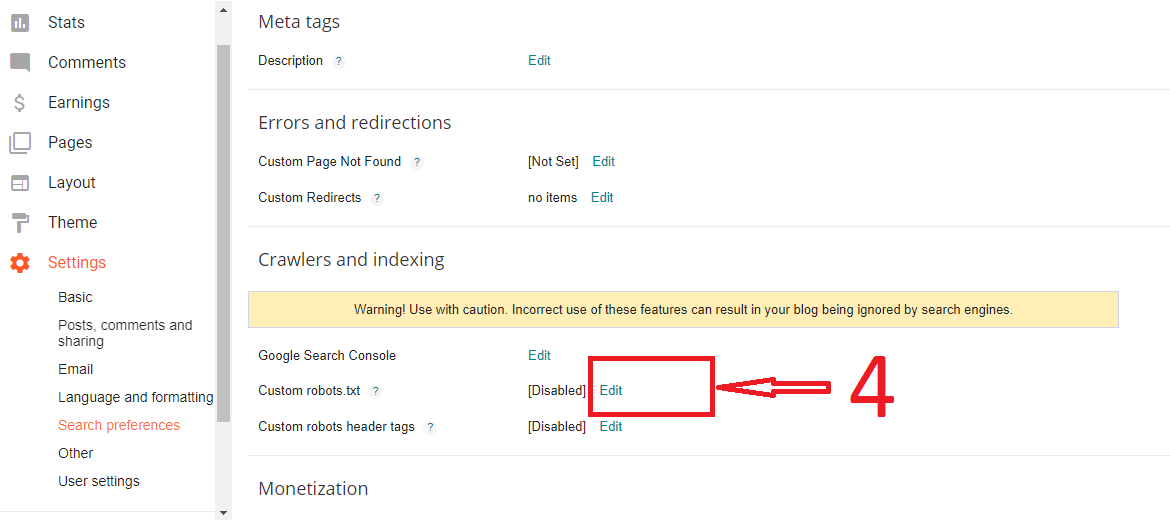

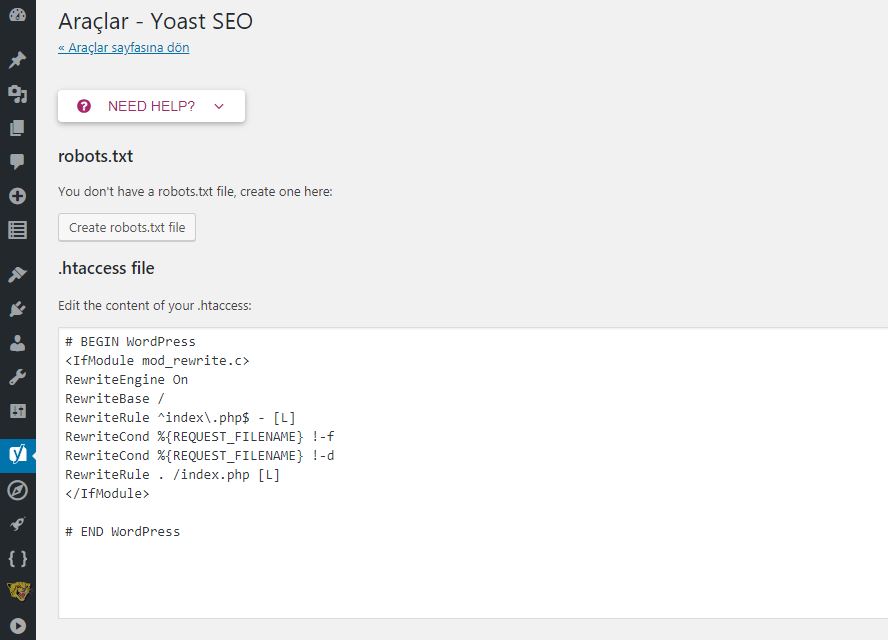

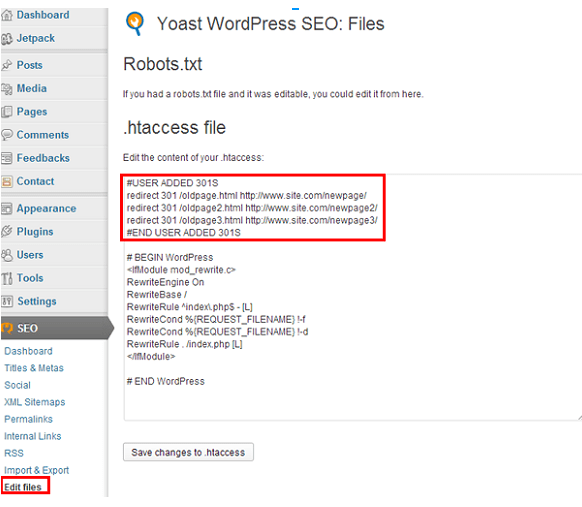

Настройка через плагин Yoast SEO

Если у вас установлен плагин Yoast SEO, то для создания и редактирования файла robots. txt в нем предусмотрена эта функция.

txt в нем предусмотрена эта функция.

Для того,чтобы создать или редактировать — перейдите в настройки «SEO» и выберите пункт «Инструменты».

Если файла нет, то плагин предложит создать его.

Для этого нажмите на соответствующую кнопку «Создать файл robots.txt». В поле ниже автоматически появятся следующие строки:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Если вы хотите запретить поисковым роботам индексировать сайт на момент разработки, то измените содержимое на:

User-agent: * Disallow: /

Если вы готовы запустить проект, то настройте содержимое файла через редактор плагина.

Не забудьте сохранить настройки.

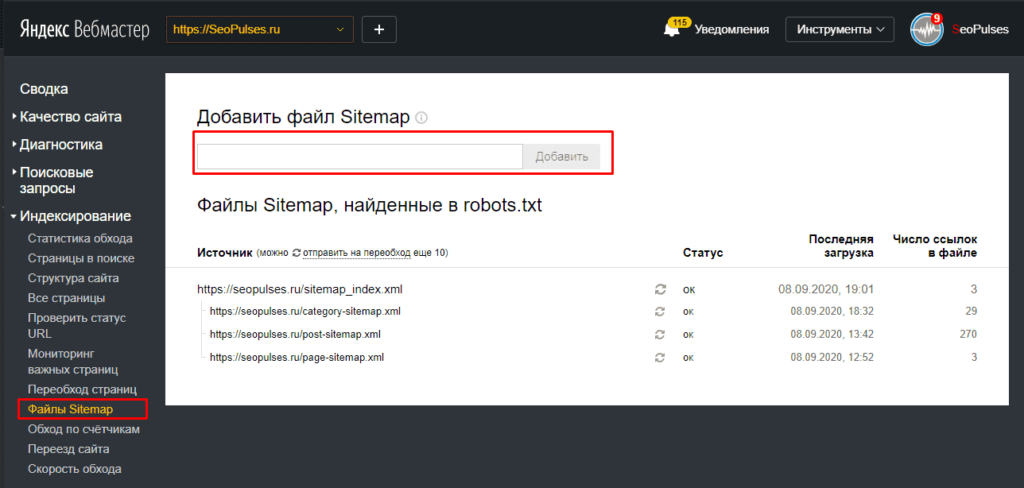

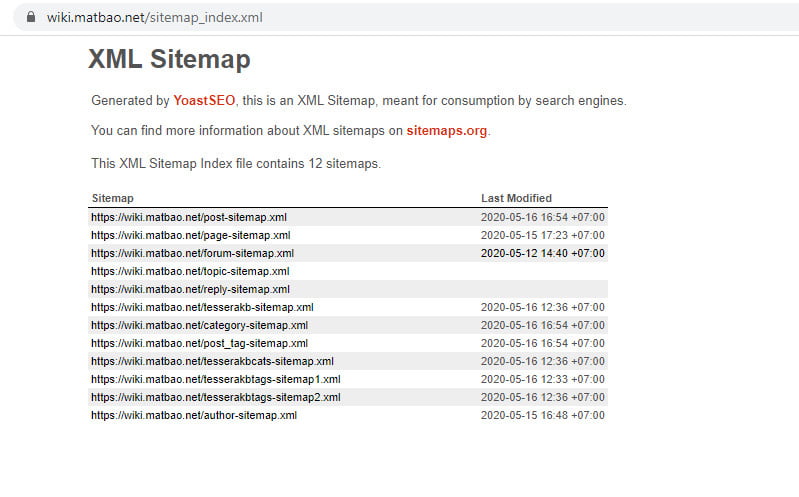

Как создать sitemap.xml для WordPress

Файл sitemap.xml для WordPress создает тот же плагин Yoast SEO автоматически и доступен по адресу: https://домен вашего сайта/sitemap_index.xml.

Данный плагин имеет всего две настройки xml-карты:

Чтобы активировать или выключить эту функцию, необходимо перейти в «SEO», «Общие», дополнительная вкладка «Возможности», пункт «XML-карта сайта» и установить в желаемое положение.

Здесь вы найдете и ссылку, перейдя по которой можно просмотреть карту сайта WordPress в формате xml.

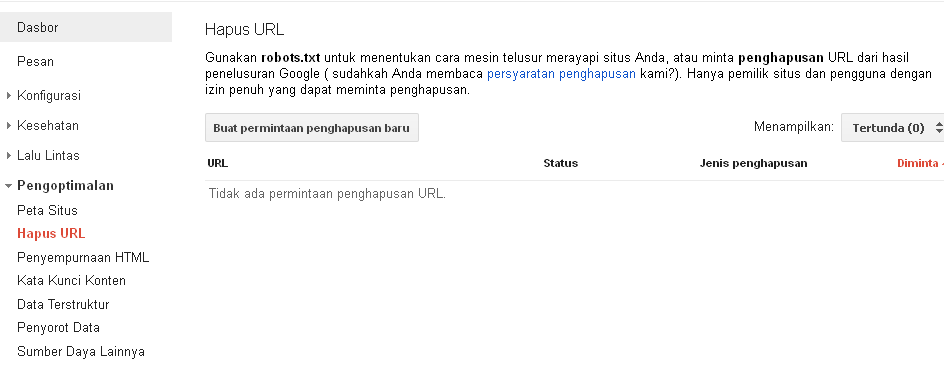

Закрыть от индексации отдельные страницы

Часто требуется закрыть технические страницы от индексации. И забегая вперед, отмечу, что не стоит закрывать от индексации страницы в robots.txt – в Google Search Console быстро появиться ошибка.

Как быть?

Для того, чтобы закрыть от индексации отдельно взятые страницы сайта собранного на WordPress, используйте плагин Yoast SEO, в котором предусмотренный эти настройки.

Для этого переходим в редактирование страницы, записи или карточки товара и спускаемся вниз, к SEO блоку Yoast.

Под вкладкой «Ключевое содержимое» находим вкладку «Дополнительно». В ней необходимо указать следующие настройки:

- Разрешить поисковым системам показывать тип записей «Страница» в результатах поиска? — Нет;

- Должны ли поисковые системы проходить по ссылкам в этой записи типа «Страница»? — No;

- Расширенная настройка тега Meta Robots – Не архивировать.

Затем нажмите в правом верхнем углу «Обновить».

Теперь данная страница не будет учитываться в результатах поиска, поскольку в исходном коде страницы будут прописаны атрибуты noindex и nofollow для Robots Tag.

Чтобы просмотреть исходный код страницы, нажмите сочетание клавиш ctrl + u.

На этом я завершаю и надеюсь, что настройка robots.txt для WordPress не вызовет у вас затруднений, после изучения данной статьи. Вы теперь знаете где он находится и какой плагин использовать для его редактирования через админку.

Александр

Пишу SEO-тексты, и наполняю ими страницы коммерческих сайтов и/или дорабатываю уже существующий контент.

Правильный файл Robots.txt для WordPress (Яндекс, Google)

Содержание статьи:

Здравствуйте! После того как мы разобрались с правильной структурой сайта настало время поговорить о robots.

txt, что это такое и с чем его едят. Кроме того, из данной статьи вы узнаете, каков он, идеально правильный robots.txt для WordPress, как с его помощью запретить индексацию сайта или разрешить всё.

txt, что это такое и с чем его едят. Кроме того, из данной статьи вы узнаете, каков он, идеально правильный robots.txt для WordPress, как с его помощью запретить индексацию сайта или разрешить всё.Robots.txt – что это такое?

Файл robots.txt – это файл, с помощью которого можно выставить запрет на индексацию каких-либо частей сайта или блога поисковым роботом.

Создается единый стандартный robots txt для Яндекса и для Google, просто вначале прописываются запреты для одной поисковой сети, а затем для другой. В принципе в нём можно прописать параметры для всех поисковых систем, однако, зачастую не имеет смысла это делать, т.к. конкретно для России основными считают Яндекс и Гугл, с остальных поисковых систем трафик настолько мал, что ради них нет необходимости прописывать отдельные запреты и разрешения.

Зачем он нужен?

Если вы сомневаетесь нужен ли robots txt вообще, то ответ однозначный – ДА. Данный файл показывает поисковым системам куда им ходить нужно, а куда нет. Таким образом, с помощью «Роботса» можно манипулировать поисковыми системами и не давать индексировать те документы, которые вы бы хотели оставить в тайне.

Таким образом, с помощью «Роботса» можно манипулировать поисковыми системами и не давать индексировать те документы, которые вы бы хотели оставить в тайне.

Важно! К файлу robots txt Яндекс относится, так сказать, с уважением, он всегда учитывает все нововведения и поступает так, как указано в файле. С Google ситуация сложнее, чаще всего поисковый гигант игнорирует запреты от «Роботса», но тем не менее лично я рекомендую всё равно прописывать все необходимые данные в этот файлик.

Зачем не пускать поисковики к каким-то файлам или директориям?

- Во-первых, некоторые директории (например теги в WordPress или страницы пагинации) оставляют много “мусора” в выдаче, что негативно сказывается на самом сайте.

- Во-вторых, быть может вы разместили неуникальный контент, но очень нужно, чтобы он был на сайте, с помощью robots.txt можно не дать поисковому роботу добраться до такого документа.

Где находится?

Файл robots.txt располагается в корне сайта, т. е. он всегда доступен по адресу site.ru/robots.txt. Так что если вы раньше не знали, как найти robots txt на сайте, то теперь вы с лёгкостью сможете посмотреть и возможно отредактировать его.

е. он всегда доступен по адресу site.ru/robots.txt. Так что если вы раньше не знали, как найти robots txt на сайте, то теперь вы с лёгкостью сможете посмотреть и возможно отредактировать его.

Зная, где находится данный файл, вы теперь без труда сможете заменить старый и добавить новый robots.txt на сайт, если в этом есть необходимость.

Robots txt для WordPress

Правильный robots.txt для WordPress вы можете скачать с моего блога, он располагается по адресу //vysokoff.ru/robots.txt . Это идеальный и правильно оформленный «Роботс», вы можете добавить его к себе на сайт.

После того как вы скачали мой robots.txt для WordPress, в нём необходимо будет исправить домен на свой, после этого смело заливайте файлик к себе на сервер и радуйтесь тому, как из поисковой выдачи выпадают ненужные «хвосты».

Кстати, не пугайтесь, если после 1-2 АПов Яндекса у вас вдруг резко сократится количество страниц в поисковой выдаче. Это нормально, даже наоборот – это отлично, значит ваш robots. txt начал работать и в скором времени вы избавитесь от не нужного хлама, который раньше висел в SERP’e.

txt начал работать и в скором времени вы избавитесь от не нужного хлама, который раньше висел в SERP’e.

Так что если вы не знаете, как создать robots txt для WordPress самостоятельно, то рекомендую просто скачать готовый вариант с моего блога, лучше вы вряд ли составите.

Теперь давайте поговорим о том, как полностью закрыть от индексации весь сайт с помощью данного чудо-файлика или наоборот, как разрешить всё, используя robots.txt.

Пример Robots.txt: disallow и allow, host и sitemap

Как было сказано выше, с помощью robots txt можно как запретить индексацию сайта, так и разрешить всё.

Disallow

Данной командой вы закроете весь сайт от индексации поисковых систем. Выглядеть это будет так:

User-agent: *

Disallow: /

Таким образом, вы полностью закроете сайт от индексации. Для чего это делать? Ну, например, как я рассказывал ранее, в статье про стратегию наполнения нового сайта. Изначально вы добавляете файл robots. txt в корень сайта и прописываете код, который указан выше.

txt в корень сайта и прописываете код, который указан выше.

Артём Высоков

Автор блога о SEO и заработке на сайтах — Vysokoff.ru. Продвигаю информационные и коммерческие сайты с 2013 года.

Задать вопрос Загрузка …Добавляете необходимое количество статей, а затем, скачав мой идеальный robots txt, открываете от индексации только необходимые разделы на сайте или блоге.

Чтобы в robots txt разрешить всё, вам необходимо написать в файле следующее:

User-agent: *

Disallow:

Т.е. убрав слэш, мы показываем поисковым системам, что можно индексировать абсолютно всё.

Кроме того, если вам необходимо закрыть какую-то конкретную директорию или статью от индексации, необходимо просто дописывать после слэша путь до них:

Disallow: /page.htm

Disallow: /dir/page2.htm

Allow

Данный параметр наоборот открывает для индексации какую-то конкретную страницу из закрытой Disallow директории. Пример:

Пример:

Disallow: /dir/

Allow: /dir/ page2.htm

Прописываем Host и карту сайта

В конце файла robots txt вам необходимо прописать два параметра host и sitemap, делается это так:

Host: www.site.ru

Sitemap: www.site.ru/sitemap.xml

Host указывается для определения правильного зеркала сайта, а второе помогает роботу узнать, где находится карта сайта.

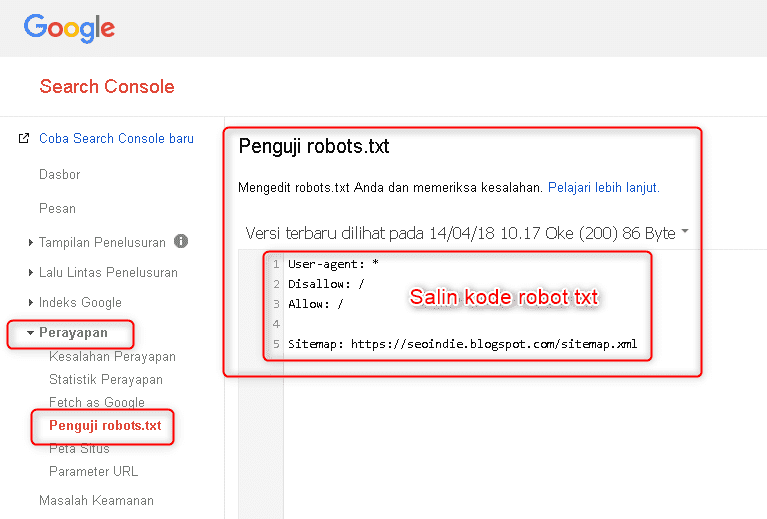

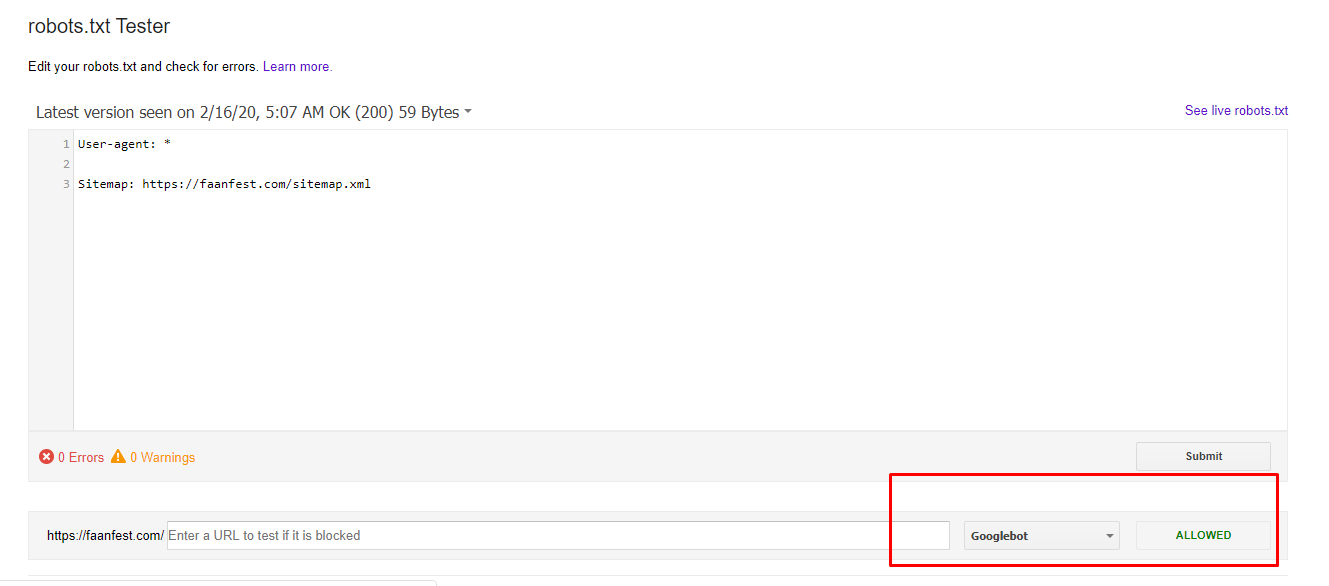

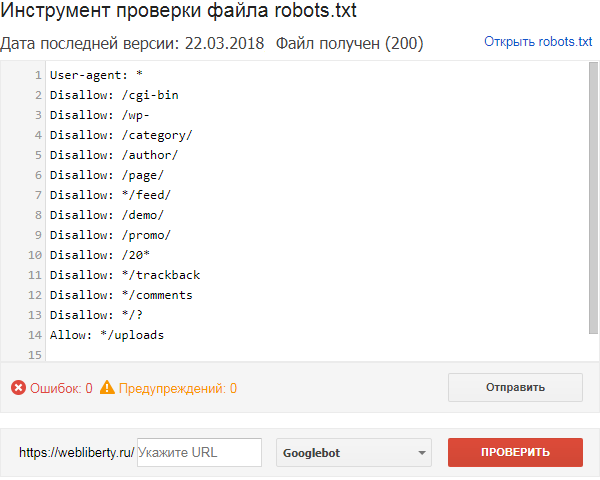

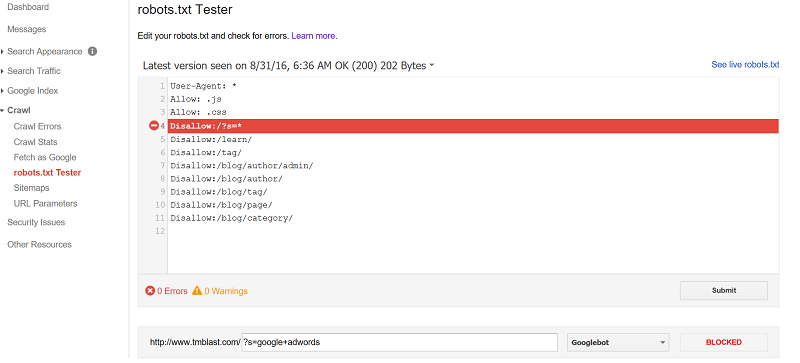

Проверка Robots.txt Яндексом и Google

После того как вы сделали правильный robots.txt и разместили его на сайте, вам необходимо добавить и проверить его в вебмастере Яндекса и Гугла, кстати, о том, как добавить сайт в вебмастеры этих поисковых систем я уже писал.

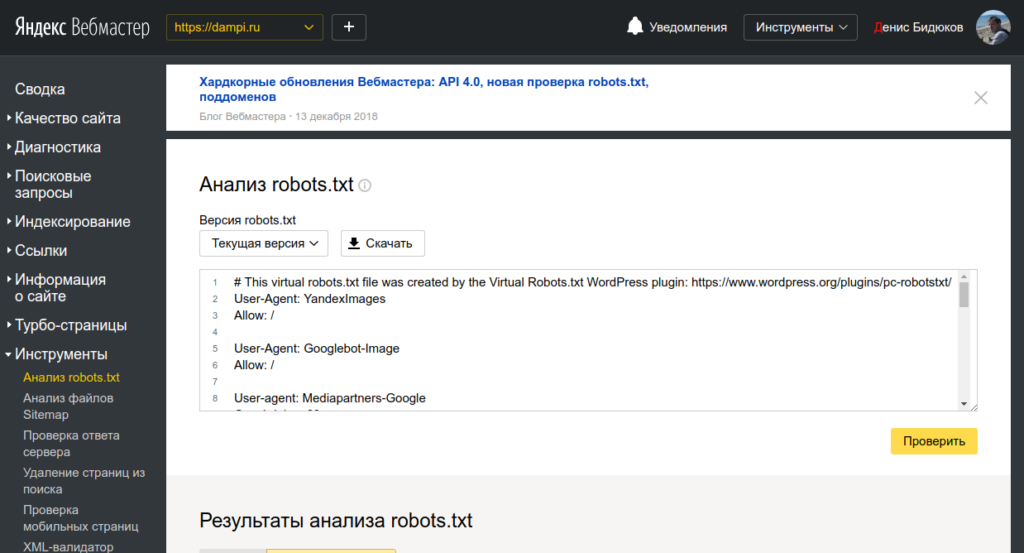

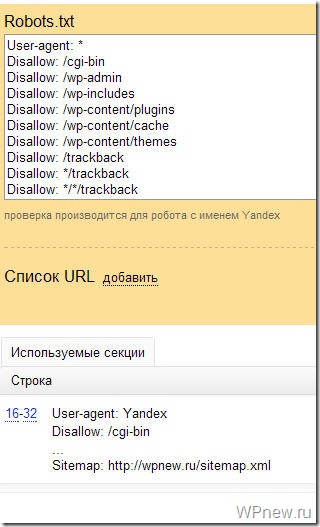

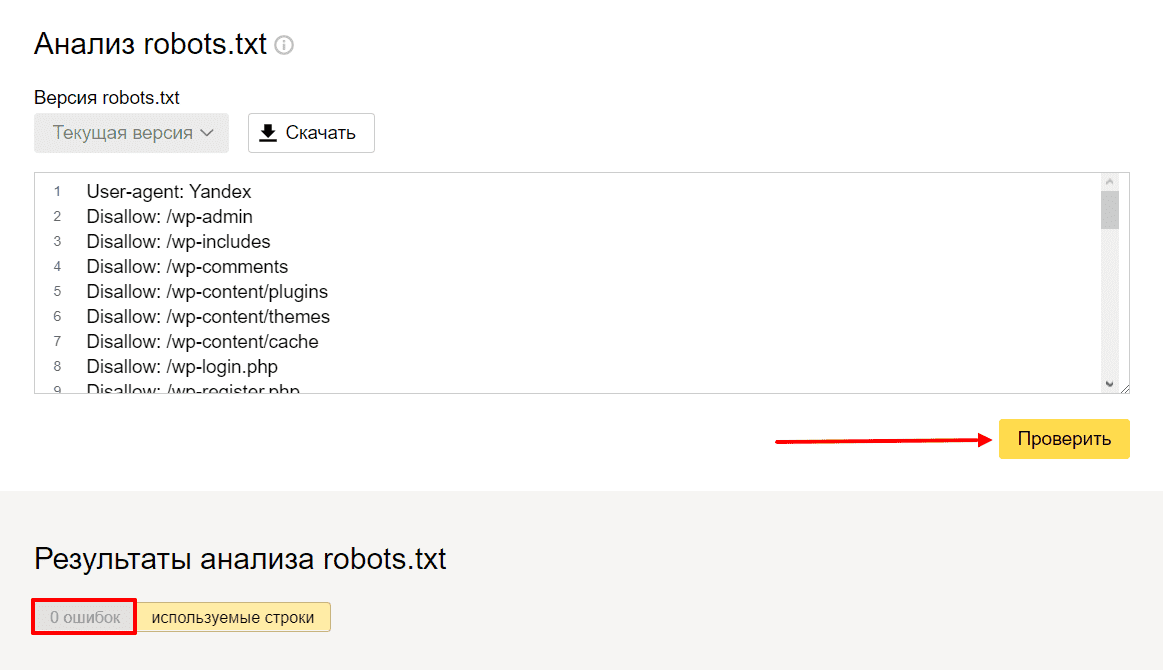

Чтобы проверить Robots.txt Яндексом необходимо зайти в https://webmaster.yandex.ru/ —> Настройка индексирования —> Анализ robots.txt.

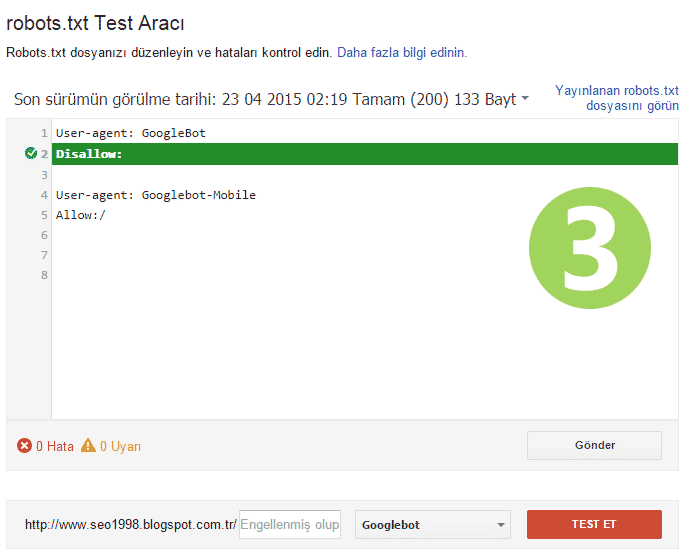

В Google заходим http://google.ru/webmasters —> Сканирование —> Инструмент проверки файла robots.txt

Таким образом вы сможете проверить свой robots. txt на ошибки и внести необходимые коррективы, если они есть.

txt на ошибки и внести необходимые коррективы, если они есть.

Резюме

Ну вот, думаю, мне удалось объяснить вам, что такое robots.txt, для чего он нужен. Кроме того, напоминаю, скачать файл robots txt вы можете здесь.

В следующий раз я расскажу вам о супер-плагине WordPress SEO by Yoast, без которого, я считаю, нельзя начинать успешное продвижение сайта.

Готовый robots.txt под WordPress — IT портал

В этой статье пример оптимального, на наш взгляд, кода для файла robots.txt под WordPress, который вы можете использовать в своих сайтах.

Для начала, вспомним зачем нужен robots.txt — файл robots.txt нужен исключительно для поисковых роботов, чтобы «сказать» им какие разделы/страницы сайта посещать, а какие посещать не нужно. Страницы, которые закрыты от посещения не будут попадать в индекс поисковиков (Yandex, Google и т.д.).

Вариант 1: оптимальный код robots.

User-agent: *

Disallow: /cgi-bin # классика...

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search # поиск

Disallow: /author/ # архив автора

Disallow: *?attachment_id= # страница вложения. Вообще-то на ней редирект...

Disallow: */trackback

Disallow: */feed # все фиды

Disallow: */embed # все встраивания

Disallow: */page/ # все виды пагинации

Allow: */uploads # открываем uploads

Allow: /*/*.js # внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т. д.

д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

#Disallow: /wp/ # когда WP установлен в подкаталог wp

Host: www.site.ru

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap2.xml

# Версия кода: 1.0

# Не забудьте поменять <code>site.ru на ваш сайт.

Разбор кода:

В строке User-agent: * мы указываем, что все нижеприведенные правила будут работать для всех поисковых роботов *. Если нужно, чтобы эти правила работали только для одного, конкретного робота, то вместо * указываем имя робота (User-agent: Yandex, User-agent: Googlebot).

В строке Allow: */uploads мы намеренно разрешаем индексировать ссылки, в которых встречается /uploads. Это правило обязательно, т.к. выше мы запрещаем индексировать ссылки начинающихся с /wp-, а /wp- входит в /wp-content/uploads.

Disallow: /wp- нужна строчка Allow: */uploads, ведь по ссылкам типа /wp-content/uploads/... у нас могут лежать картинки, которые должны индексироваться, так же там могут лежать какие-то загруженные файлы, которые незачем скрывать. Allow: может быть «до» или «после» Disallow:.

Остальные строчки запрещают роботам «ходить» по ссылкам, которые начинаются с:

Disallow: /cgi-bin — закрывает каталог скриптов на сервереDisallow: /feed — закрывает RSS фид блогаDisallow: /trackback — закрывает уведомленияDisallow: ?s= или Disallow: *?s= — закрыавет страницы поискаDisallow: */page/ — закрывает все виды пагинации

Правило Sitemap: http://site.ru/sitemap.xml указывает роботу на файл с картой сайта в формате XML. Если у вас на сайте есть такой файл, то пропишите полный путь к нему. Таких файлов может быть несколько, тогда указываем путь к каждому отдельно.

В строке Host: site.ru мы указываем главное зеркало сайта. Если у сайта существуют зеркала (копии сайта на других доменах), то чтобы Яндекс индексировал всех их одинаково, нужно указывать главное зеркало. Директива Host: понимает только Яндекс, Google не понимает! Если сайт работает под https протоколом, то его обязательно нужно указать в Host: Host: https://site.ru

Из документации Яндекса: «Host — независимая директива и работает в любом месте файла (межсекционная)». Поэтому её ставим наверх или в самый конец файла, через пустую строку.

Это важно: сортировка правил перед обработкой

Yandex и Google обрабатывает директивы Allow и Disallow не по порядку в котором они указаны, а сначала сортирует их от короткого правила к длинному, а затем обрабатывает последнее подходящее правило:

User-agent: *

Allow: */uploads

Disallow: /wp-

будет прочитана как:

User-agent: *

Disallow: /wp-

Allow: */uploads

Таким образом, если проверяется ссылка вида: /wp-content/uploads/file., правило  jpg

jpgDisallow: /wp- ссылку запретит, а следующее правило Allow: */uploads её разрешит и ссылка будет доступна для сканирования.

Чтобы быстро понять и применять особенность сортировки, запомните такое правило: «чем длиннее правило в robots.txt, тем больший приоритет оно имеет. Если длина правил одинаковая, то приоритет отдается директиве Allow.»

Вариант 2: стандартный robots.txt для WordPress

Не знаю кто как, а я за первый вариант! Потому что он логичнее — не надо полностью дублировать секцию ради того, чтобы указать директиву Host для Яндекса, которая является межсекционной (понимается роботом в любом месте шаблона, без указания к какому роботу она относится). Что касается нестандартной директивы Allow, то она работает для Яндекса и Гугла и если она не откроет папку uploads для других роботов, которые её не понимают, то в 99% ничего опасного это за собой не повлечет. Я пока не заметил что первый robots работает не так как нужно.

Вышеприведенный код немного не корректный.

1. Некоторые роботы (не Яндекса и Гугла) — не понимают более 2 директив: User-agent: и Disallow:;

2. Директиву Яндекса Host: нужно использовать после Disallow:, потому что некоторые роботы (не Яндекса и Гугла), могут не понять её и вообще забраковать robots.txt. Cамому же Яндексу, судя по документации, абсолютно все равно где и как использовать Host:, хоть вообще создавай robots.txt с одной только строчкой Host: www.site.ru, для того, чтобы склеить все зеркала сайта;

3. Sitemap: межсекционная директива для Яндекса и Google и видимо для многих других роботов тоже, поэтому её пишем в конце через пустую строку и она будет работать для всех роботов сразу.

На основе этих поправок, корректный код должен выглядеть так:

User-agent: Yandex

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-login. php

php

Disallow: /wp-register.php

Disallow: /comments

Disallow: */trackback

Disallow: */embed

Disallow: */feed

Disallow: /cgi-bin

Disallow: *?s=

Host: site.ru

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /comments

Disallow: */trackback

Disallow: */embed

Disallow: */feed

Disallow: /cgi-bin

Disallow: *?s=

Sitemap: http://site.ru/sitemap.xml

Дописываем под себя

Если вам нужно запретить еще какие-либо страницы или группы страниц, можете внизу добавить правило (директиву) Disallow:. Например, нам нужно закрыть от индексации все записи в категории news, тогда перед Sitemap: добавляем правило:

Disallow: /news

Оно запретить роботам ходить по подобным ссылками:http://site.ru**/news**

http://site. ru**/news**/drugoe-nazvanie/

ru**/news**/drugoe-nazvanie/

Если нужно закрыть любые вхождения /news, то пишем:

Disallow: */news

Закроет:http://site.ru**/news**

http://site.ru**/news**/drugoe-nazvanie/

http://site.ru/category**/news**letter-nazvanie.html

Проверка robots.txt

Проверить правильно ли работают прописанные правила можно по следующим ссылкам:

Яндекс: http://webmaster.yandex.ru/robots.xml.

В Google это делается в Search console. Нужна авторизация и наличия сайта в панели веб-мастера…

Сервис для создания файла robots.txt: http://pr-cy.ru/robots/

Сервис для создания и проверки robots.txt: https://seolib.ru/tools/generate/robots/

Источник

Вот и все, если Вы хотите «поблагодарить» наше IT сообщество — у вас есть такая возможность: справа есть варианты для пожертвований на развитие портала. Или поделитесь статьей в ваших соц.сетях через сервис ниже.

Похожие материалы:

Правильный файл robots.

txt для сайта на WordPress в 2021

txt для сайта на WordPress в 2021Файл robots.txt — это текстовый файл, в котором содержаться инструкции для поисковых роботов, в частности каким роботам и какие страницы допускается сканировать, а какие нет.

Пример правильного файла robots.txt для сайта на WordPress

- User-agent: *

- Disallow: /cgi-bin

- Disallow: /wp-admin/

- Disallow: /wp-includes/

- Disallow: /wp-content/plugins/

- Disallow: /wp-content/cache/

- Disallow: /wp-content/themes/

- Disallow: /wp-trackback

- Disallow: /wp-feed

- Disallow: /wp-comments

- Disallow: /author/

- Disallow: */embed*

- Disallow: */wp-json*

- Disallow: */page/*

- Disallow: /*?

- Disallow: */trackback

- Disallow: */comments

- Disallow: /*.php

- Host: https://seopulses.ru

- Sitemap: https://seopulses.ru/sitemap_index.xml

Где можно найти файл robots.txt и как его создать или редактировать

Чтобы проверить файл robots. txt сайта, следует добавить к домену «/robots.txt», примеры:

txt сайта, следует добавить к домену «/robots.txt», примеры:

https://seopulses.ru/robots.txt

https://serpstat.com/robots.txt

https://netpeak.net/robots.txt

Как создать и редактировать robots.txt

Вручную

Данный файл всегда можно найти, подключившись к FTP сайта или в файлом редакторе хостинг-провайдера в корневой папке сайта (как правило, public_html):

Далее открываем сам файл и можно его редактировать.

Если его нет, то достаточно создать новый файл.

После вводим название документа и сохраняем.

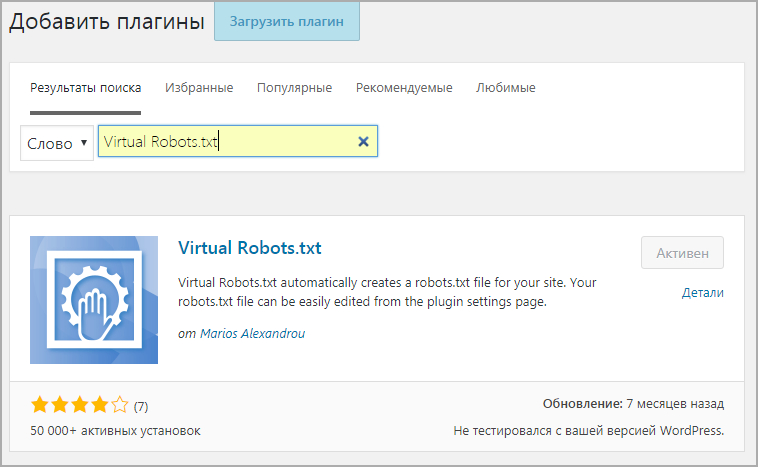

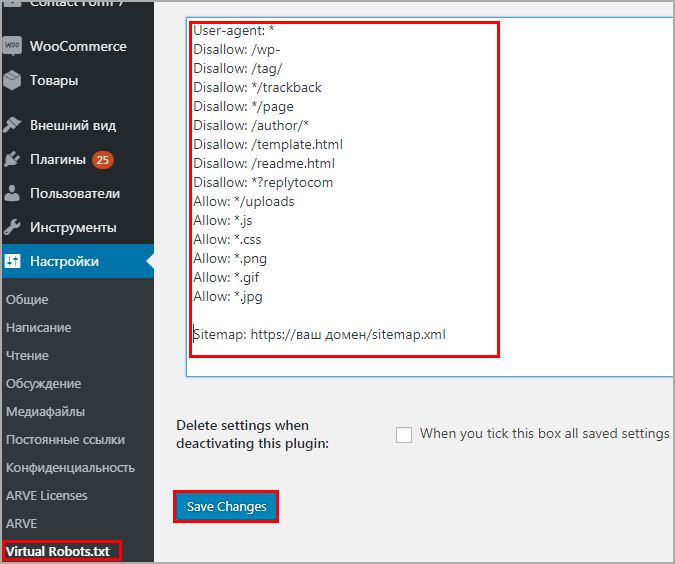

Через модули/дополнения/плагины

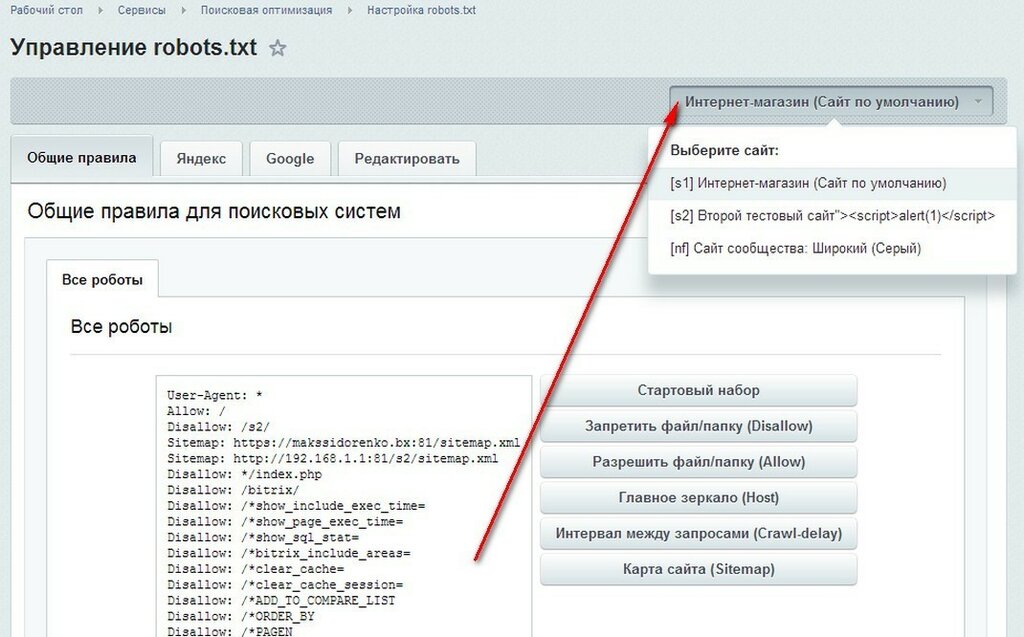

Чтобы управлять данный файлом прямо в административной панели сайта следует установить дополнительный модуль:

- Для 1С-Битрикс;

https://dev.1c-bitrix.ru/learning/course/?COURSE_ID=139&LESSON_ID=5814

Virtual Robots.txt

https://opencartforum.com/files/file/5141-edit-robotstxt/

https://support.webasyst.ru/shop-script/149/shop-script-robots-txt/

Инструкция по работе с robots.

В первую очередь записывается User-Agent, указывая на то, к какому роботу идет обращение, например:

- User-agent: Yandex — для обращения к поисковому роботу Яндекса;

- User-agent: Googlebot — в случае с краулером Google;

- User-agent: YandexImages — при работе с ботом Яндекс.Картинок.

Полный список роботов Яндекс:

https://yandex.ru/support/webmaster/robot-workings/check-yandex-robots.html#check-yandex-robots

И Google:

https://support.google.com/webmasters/answer/1061943?hl=ru

Синтаксис в robots.txt

- # — отвечает за комментирование;

- * — указывает на любую последовательность символов после этого знака. По умолчанию указывается при любого правила в файле;

- $ — отменяет действие *, указывая на то что на этом элементе необходимо остановиться.

Директивы в Robots.txt

Disallow

Disallow запрещает индексацию отдельной страницы или группы (в том числе всего сайта). Чаще всего используется для того, чтобы скрыть технические страницы, динамические или временные страницы.

Пример #1

# Полностью закрывает весь сайт от индексации

User-agent: *

Disallow: /

Пример #2

# Блокирует для скачивания все страницы раздела /category1/, например, /category1/page1/ или caterogy1/page2/

Disallow: /category1/

Пример #3

# Блокирует для скачивания страницу раздела /category2/

User-agent: *

Disallow: /category1/$

Пример #4

# Дает возможность сканировать весь сайт просто оставив поле пустым

User-agent: *

Disallow:

Важно! Следует понимать, что регистр при использовании правил имеет значение, например, Disallow: /Category1/ не запрещает посещение страницы /category1/.

Allow

Директива Allow указывает на то, что роботу можно сканировать содержимое страницы/раздела, как правило, используется, когда в полностью закрытом разделе, нужно дать доступ к определенному документу.

Пример #1

# Дает возможность роботу скачать файл site.ru//feed/turbo/ несмотря на то, что скрыт раздел site. ru/feed/.

ru/feed/.

Disallow: */feed/*

Allow: /feed/turbo/

Пример #2

# разрешает скачивание файла doc.xml

# разрешает скачивание файла doc.xml

Allow: /doc.xml

Sitemap

Директива Sitemap указывает на карту сайта, которая используется в SEO для вывода списка URL, которые нужно проиндексировать в первую очередь.

Важно понимать, что в отличие от стандартных директив у нее есть особенности в записи:

- Следует указывать полный URL, когда относительный адрес использовать запрещено;

- На нее не распространяются остальные правила в файле robots.txt;

- XML-карта сайта должна иметь в URL-адресе домен сайта.

Пример

# Указывает карту сайта

Sitemap: https://serpstat.com/sitemap.xml

Clean-param

Используется когда нужно указать Яндексу (в Google она не работает), что страница с GET-параметрами (например, site.ru?param1=2¶m2=3) и метками (в том числе utm) не влияющие на содержимое сайта, не должна быть проиндексирована.

Пример #1

#для адресов вида:

www.example1.com/forum/showthread.php?s=681498b9648949605&t=8243

www.example1.com/forum/showthread.php?s=1e71c4427317a117a&t=8243

#robots.txt будет содержать:

User-agent: Yandex

Disallow:

Clean-param: s /forum/showthread.php

Пример #2

#для адресов вида:

www.example2.com/index.php?page=1&sid=2564126ebdec301c607e5df

www.example2.com/index.php?page=1&sid=974017dcd170d6c4a5d76ae

#robots.txt будет содержать:

User-agent: Yandex

Disallow:

Clean-param: sid /index.php

Подробнее о данной директиве можно прочитать здесь:

https://serpstat.com/ru/blog/obrabotka-get-parametrov-v-robotstxt-s-pomoshhju-direktivy-clean-param/

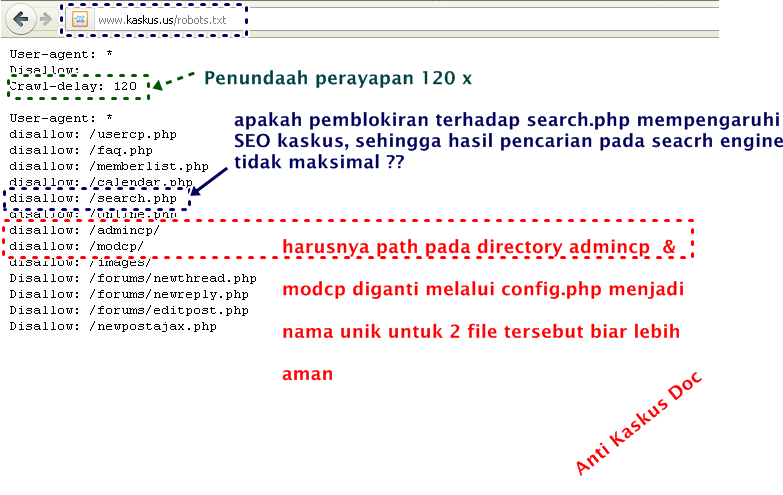

Crawl-delay

Важно! Данная директива не поддерживается в Яндексе с 22 февраля 2019 года и в Google 1 сентября 2019 года, но работает с другими роботами. Настройки скорости скачивания можно найти в Яндекс. Вебмастер и Google Search Console.

Вебмастер и Google Search Console.

Crawl-delay указывает временной интервал в секундах, в течение которого роботу разрешается делать только 1 сканирование. Как правило, необходима лишь в случаях, когда у сайта наблюдается большая нагрузка из-за сканирования.

Пример

# Допускает скачивание страницы лишь раз в 3 секунды

Crawl-delay: 3

Как проверить работу файла robots.txt

В Яндекс.Вебмастер

В Яндекс.Вебмастер в разделе «Инструменты→ Анализ robots.txt» можно увидеть используемый поисковиком свод правил и наличие ошибок в нем.

Также можно скачать другие версии файла или просто ознакомиться с ними.

Чуть ниже имеется инструмент, который дает возможно проверить сразу до 100 URL на возможность сканирования.

В нашем случае мы проверяем эти правила.

Как видим из примера все работает нормально.

Также если воспользоваться сервисом «Проверка ответа сервера» от Яндекса также будет указано, запрещен ли для сканирования документ при попытке обратиться к нему.

В Google Search Console

В случае с Google можно воспользоваться инструментом проверки Robots.txt, где потребуется в первую очередь выбрать нужный сайт.

Важно! Ресурсы-домены в этом случае выбирать нельзя.

Теперь мы видим:

- Сам файл;

- Кнопку, открывающую его;

- Симулятор для проверки сканирования.

Если в симуляторе ввести заблокированный URL, то можно увидеть правило, запрещающее сделать это и уведомление «Недоступен».

Однако, если ввести заблокированный URL в страницу поиска в новой Google Search Console (или запросить ее индексирование), то можно увидеть, что страница заблокирована в файле robots.txt.

Файл robots.txt для WordPress

Что же такое файл robots.txt? Файл robots.txt – это текстовый файл, находящийся в корневой директории сайта.

В нём записываются специальные инструкции для поисковых роботов. Эти инструкции могут запрещать к индексации некоторые разделы, или страницы на сайте, такие как “админ”, конфиденциальная информация клиентов сайта, и тому подобные.

Этот файл рекомендует поисковому роботу соблюдать определенный временной интервал, между скачиванием документов с сервера, и указывает путь к карте сайта sitemap.xml.

Последнее время его роль в SEO, несколько ослабла, и появляются всё новые рекомендации по его применению, но актуальности robots не потерял.

Чтоб быть в курсе всех изменений и рекомендаций, советую вступить в «Сообщество Google для веб-мастеров».

Ну а пока посмотрим, как создаётся, и что из себя представляет файл robots.txt.

Создать его можно двумя способами: вручную, если Вы пишете сайт самостоятельно, и при помощи плагина, если Вы используете CMS, хотя заполнять плагин всё равно приходится вручную.

Итак, для WordPress плагин называется WP Robots Txt. Вносим это название в строку “искать плагины”, находящуюся в консоль-плагины-добавить плагин, и устанавливаем на наш сайт.

Затем, “Активировать” плагин, и заходим в “Настройки – приватность (или конфиденциальность, у кого как)”. В ней нам откроется опция позволяющая редактировать плагин.

И вот тут, признаюсь, меня ждал очень интересный сюрприз.

И тем не менее, раз уж столько народа так настоятельно советуют создать файл robots.txt, думаю не стоит игнорировать общественное мнение. К тому же ничего сложного в этом нет, а дополнительные знания будут только на пользу.

Для того, чтобы настроить файл robots.txt, используются следующие директивы:

User-agent – указывает какому поисковому роботу адресована инструкция;

Disallow – запрещающая индексацию;

Allow – разрешающая индексацию;

Host – определяет какую страницу сайта считать главной;

Sitemap – указывает путь к карте сайта sitemar.txt;

В свете последних тенденций, поисковики рекомендуют делать файл robots.txt максимально открытым, поэтому

в общем и целом он выглядит так:

User-agent: *

Disallow: /wp-includes

Disallow: /wp-feed

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Host: starper55plys. ru

ru

Sitemap: https://starper55plys.ru/sitemap.xml

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: YandexImages

Allow: /wp-content/uploads/

Что же запрещается для индексирования. В первую очередь это ядро движка, кеш, файлы шаблона и плагинов, ленты rss в общем всю техническую часть сайта.

Если у Вас на сайте есть конфиденциальная информация посетителей, то её тоже нужно закрыть, но насколько это действенно, Вы уже убедились прочитав заметку при настройке плагина.

В общем, вносите все эти данные в окно редактирования плагина, и жмите “сохранить изменения”.

В дальнейшем, когда Вы перенесёте Ваш сайт с Денвера на реальный хостинг, нужно будет проверить, как работает файл robots.txt. Для этого просто пройдите по по ссылке проверка robots.txt.

Если же Вы не используете CMS, а пишете сайт на чистом HTML, то открываете HTML редактор (Notepad++), переписываете или копируете в него код файла, меняете адреса на свои, и сохраняете его с названием robots. txt, в директорию сайта.

txt, в директорию сайта.

Перемена

— Винтовка для солдата — лучший друг, не правда ли? — Не знаю, господин генерал! Вчера, когда я ее чистил, она выстрелила мне в ногу!

Приходит Сара к раввину.

— Ребе, я завтра замуж выхожу, посоветуйте, как лучше лечь в постель в первую ночь: в рубашке или без?

Тут подбегает Рабинович.

— Ребе, посоветуйте, куда лучше вложить деньги, в акции или ценные бумаги?

Ребе отвечает:

— Как ты, Сарочка, ни ляжешь, тебя все равно поимеют. К Вам, Рабинович, это тоже относится.

Администратор гостиницы говорит клиенту:

— Я могу поселить вас с этой женщиной, лишь тогда, когда вы докажите, — что она ваша жена.

Клиент отвечает:

— А если вы докажите обратное, я буду благодарен вам до самой смерти.

Во времена борьбы с пьянством — стоит около винного огромная очередь, к очереди подбегает мужик:

— Мужики! Пропустите меня, а?.. У меня машина стоит…

— Да пошел ты! «Машина стоит»… У нас заводы стоят!

Создание xml карты сайта на WordPress < < < В раздел > > > Оптимизация изображений

ботов и индексация в Pantheon

Боты являются частью жизненного цикла каждого общедоступного веб-сайта. Без них мы не смогли бы найти ничего в Интернете! Боты выполняют тяжелую работу, которая считается само собой разумеющейся, при просмотре множества проиндексированных результатов поиска из любой данной поисковой системы. В чужих руках боты могут стать раздражающими, замедляя или даже останавливая ваш сайт.

Без них мы не смогли бы найти ничего в Интернете! Боты выполняют тяжелую работу, которая считается само собой разумеющейся, при просмотре множества проиндексированных результатов поиска из любой данной поисковой системы. В чужих руках боты могут стать раздражающими, замедляя или даже останавливая ваш сайт.

Боты не просматривают страницы, как люди. Анализ шаблонов доступа в журнале nginx — один из самых быстрых способов определить наличие ботов.

Rapid Fire Requests / Duplicates

В приведенном ниже фрагменте журнала есть несколько запросов, поступающих по одному и тому же пути в быстрой последовательности. Отметка времени отражает 5 идентичных запросов в одну и ту же миллисекунду. Вам следует изучить эти запросы.

127.0.0.1 - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http: // www. mywebsite.com/node/545?page=399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "0. 848" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1, :: ffff: 127.0.0.1 "

unix: - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http://www.mywebsite.com/ node / 545? page = 399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.059" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1, :: ffff: 127.0.0.1 "

127.0.0.1 - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http: //www.mywebsite.com / node / 545? page = 399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.059" 195.200.54.200, 10.200.200.21, :: ffff: 127.0. 0.1, :: ffff: 127.0.0.1 "

unix: - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http://www.mywebsite.com/ node / 545? page = 399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.271" 195.200.54.200, 10.200.200.21, :: ffff: 127.

848" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1, :: ffff: 127.0.0.1 "

unix: - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http://www.mywebsite.com/ node / 545? page = 399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.059" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1, :: ffff: 127.0.0.1 "

127.0.0.1 - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http: //www.mywebsite.com / node / 545? page = 399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.059" 195.200.54.200, 10.200.200.21, :: ffff: 127.0. 0.1, :: ffff: 127.0.0.1 "

unix: - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http://www.mywebsite.com/ node / 545? page = 399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.271" 195.200.54.200, 10.200.200.21, :: ffff: 127. 0.0.1, :: ffff: 127.0.0.1 "

127.0.0.1 - - [11 / ноя / 2013: 19: 05: 24 +0000] «POST / index.php? q = comment / reply / 545 HTTP / 1.0 "500 588" http://www.mywebsite.com/node/545?page=399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.271" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1, :: ffff: 127.0.0.1 "

unix: \ xC8 \ xFB \ x7F - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http: // www.mywebsite.com/node/545?page=399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.481" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1, :: ffff: 127.0.0.1 "

127.0.0.1 - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http://www.mywebsite.com / node / 545? page = 399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.482" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1 , :: ffff: 127.

0.0.1, :: ffff: 127.0.0.1 "

127.0.0.1 - - [11 / ноя / 2013: 19: 05: 24 +0000] «POST / index.php? q = comment / reply / 545 HTTP / 1.0 "500 588" http://www.mywebsite.com/node/545?page=399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.271" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1, :: ffff: 127.0.0.1 "

unix: \ xC8 \ xFB \ x7F - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http: // www.mywebsite.com/node/545?page=399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.481" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1, :: ffff: 127.0.0.1 "

127.0.0.1 - - [11 / ноя / 2013: 19: 05: 24 +0000] "POST /index.php?q=comment/reply/545 HTTP / 1.0" 500 588 "http://www.mywebsite.com / node / 545? page = 399 "" Mozilla / 4.0 (совместимый; MSIE 6.0; Windows NT 5.1; SV1; MRA 4.3 (сборка 51720)) "1.482" 195.200.54.200, 10.200.200.21, :: ffff: 127.0.0.1 , :: ffff: 127. 0.0.1 "

0.0.1 " Боты сходятся на страницах с ошибками

Некоторые легитимные боты / сканеры / прокси (например, BingBot или AdsBotGoogle) идентифицируют себя.Поскольку поисковая индексация желательна для большинства сайтов, действуйте осторожно, чтобы не нанести ущерб поисковой оптимизации сайта. Тем не менее, могут быть случаи, когда сканеры / пауки сходятся на странице с ошибкой (502 в примере ниже). Эти повторяющиеся запросы могут увеличить проблемы с загрузкой страниц, увеличивая нагрузку на сервер. Немедленно исследуйте эти ошибки. Когда ошибка будет исправлена, боты / краулеры больше не будут зависать на пути предоставления.

127.0.0.1 - - [26 / июл / 2013: 15: 27: 38 +0000] "GET /index.php?q=shop/kits/shebang-kit HTTP / 1.0" 502 166 "-" "Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.188" 157.56.93.49, 10.183.252.21, 127.0.0.1,127.0.0.1 "

unix: - - [26 / июл / 2013: 15: 27: 38 +0000] "GET /index.php?q=shop/kits/shebang-kit HTTP / 1. 0" 502 166 "-" "Mozilla / 5.0 (совместимый ; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.476" 157.56.93.49, 10.183.252.21, 127.0.0.1,127.0.0.1 "

127.0.0.1 - - [26 / июл / 2013: 15: 27: 38 +0000] «GET / index.php? q = shop / kits / shebang-kit HTTP / 1.0 "502 166" - "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.477" 157.56 .93.49, 10.183.252.21, 127.0.0.1,127.0.0.1 "

127.0.0.1 - - [26 / июл / 2013: 15: 26: 37 +0000] "GET /index.php?q=gush/content/name-pimp-november-2008&page=17 HTTP / 1.0" 502 166 "- "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.722" 157.56.93.49, 10.183.252.21, 127.0.0.1,127.0.0.1 "

10.208.128.192 - - [26 / июл / 2013: 15: 26: 37 +0000] «GET / gush / content / name-pimp-november-2008? Page = 17 HTTP / 1.1 "502 166" - "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.999" 157.56.93.49, 10.183.252.21, 127.0.0.1,127.0. 0,1 "

unix: - - [26 / июл / 2013: 15: 26: 37 +0000] "GET /index.

0" 502 166 "-" "Mozilla / 5.0 (совместимый ; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.476" 157.56.93.49, 10.183.252.21, 127.0.0.1,127.0.0.1 "

127.0.0.1 - - [26 / июл / 2013: 15: 27: 38 +0000] «GET / index.php? q = shop / kits / shebang-kit HTTP / 1.0 "502 166" - "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.477" 157.56 .93.49, 10.183.252.21, 127.0.0.1,127.0.0.1 "

127.0.0.1 - - [26 / июл / 2013: 15: 26: 37 +0000] "GET /index.php?q=gush/content/name-pimp-november-2008&page=17 HTTP / 1.0" 502 166 "- "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.722" 157.56.93.49, 10.183.252.21, 127.0.0.1,127.0.0.1 "

10.208.128.192 - - [26 / июл / 2013: 15: 26: 37 +0000] «GET / gush / content / name-pimp-november-2008? Page = 17 HTTP / 1.1 "502 166" - "" Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm) "14.999" 157.56.93.49, 10.183.252.21, 127.0.0.1,127.0. 0,1 "

unix: - - [26 / июл / 2013: 15: 26: 37 +0000] "GET /index. php?q=gush/content/name-pimp-november-2008&page=17 HTTP / 1.0" 502 166 "-" "Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm)" 14.998 "157.56.93.49, 10.183.252.21, 127.0.0.1,127.0.0.1"

10.208.128.192 - - [26 / июл / 2013: 15: 31: 03 +0000] "GET / HTTP / 1.1" 500 109 "-" "check.panopta.com" 0.126 "5.63.145.72, 10.183.252.21, 127.0.0.1,127.0.0.1"

php?q=gush/content/name-pimp-november-2008&page=17 HTTP / 1.0" 502 166 "-" "Mozilla / 5.0 (совместимый; bingbot / 2.0; + http: //www.bing.com/bingbot.htm)" 14.998 "157.56.93.49, 10.183.252.21, 127.0.0.1,127.0.0.1"

10.208.128.192 - - [26 / июл / 2013: 15: 31: 03 +0000] "GET / HTTP / 1.1" 500 109 "-" "check.panopta.com" 0.126 "5.63.145.72, 10.183.252.21, 127.0.0.1,127.0.0.1" Важно отметить, что каждая среда вашего сайта имеет файл robots.txt , связанный с доменом платформы (например, dev- site-name.pantheonsite.io ) или пользовательский домен Vanity (например, dev-sites.myagency.com ), который содержит следующее:

# Документация Pantheon на robots.txt: https://pantheon.io / docs / bots-and-indexing /

Пользовательский агент: *

Запретить: /

Пользовательский агент: dotbot

Пользовательский агент: PetalBot

Пользовательский агент: PowerMapper

Пользовательский агент: RavenCrawler

Пользовательский агент: rogerbot

Пользовательский агент: SemrushBot

Пользовательский агент: SemrushBot-SA

Пользовательский агент: Swiftbot

Allow: / Кроме того, пограничный уровень Pantheon добавляет HTTP-заголовок X-Robots-Tag: noindex при обслуживании запросов от доменов платформы (например,грамм.

live-site-name.pantheonsite.io ). Это дает указание большинству ботов / поисковых роботов не индексировать страницу и предотвращает ее отображение в результатах поиска.

Индексирование перед запуском

Домены pantheonsite.io предназначены для использования в разработке и не могут использоваться в производственной среде. В то время как Drupal и WordPress по умолчанию генерируют свой собственный файл robots.txt , пользовательский или стандартный для CMS файл robots.txt будет работать только в Live-средах с пользовательским доменом.Добавление субдоменов (например, dev.example.com , test.example.com ) для DEV или TEST удалит только заголовок X-Robots-Tag: noindex , но по-прежнему будет обслуживать Pantheon robots.txt из домена платформы.

Для поддержки предварительного тестирования SEO и поиска по сайту мы разрешаем следующим ботам доступ к доменам платформы:

Некоторые инструменты (например, Siteimprove или ScreamingFrog) могут быть настроены так, чтобы игнорировать robots. при сканировании. Если вы тестируете ссылки или оптимизируете поисковую оптимизацию с помощью других инструментов, вы можете запросить добавление этого инструмента к нашим роботам  txt

txt .txt , обратившись в службу поддержки, чтобы создать запрос функции. В противном случае вы можете подключить собственный домен (например, seo.example.com ) к среде Live и протестировать свои ссылки, следующие за альтернативным доменом.

Если вы запускаете инструменты SEO локально, вы можете использовать запись файла / etc / hosts в вашем локальном окне разработки, чтобы подделать ваш производственный домен на Pantheon:

Обратите внимание, что для изменения файла hosts обычно требуются административные привилегии от ОПЕРАЦИОННЫЕ СИСТЕМЫ.

Расположение файла hosts и зависит от вашей операционной системы:

- MacOS / Linux:

/ etc / hosts - Windows:

C: \\ Windows \ System32 \ Drivers \ etc \ hosts

Добавьте строки в файл hosts вашей операционной системы в следующем формате:

203. 0.113.10 example.com

203.0.113.20 www.example.com

0.113.10 example.com

203.0.113.20 www.example.com В приведенном выше примере замените IP-адреса на те, которые предоставляет Pantheon, а домены на свои собственные.

Вы можете проиндексировать свой сайт в производственном домене после того, как он будет добавлен в среду Live. Существует множество вариантов модуля contrib для создания карт сайта для Drupal, включая XMLSiteMap и Site_Map. Пользователи WordPress могут установить Google XML Sitemaps или Yoast SEO плагины, которые будут поддерживать обновления карты сайта автоматически. Вы можете настроить расширения для работы по своему усмотрению. Pantheon не поддерживает модули Drupal или плагины WordPress.

Карты сайта создают белый экран смерти (WSOD)

Некоторые модули или плагины по умолчанию настроены на получение всех URL-адресов одновременно во время генерации карты сайта, что может привести к появлению пустой белой страницы (WSOD) из-за превышения лимита памяти PHP.Чтобы решить эту проблему, настройте плагин или конфигурацию модуля так, чтобы URL-адреса выбирались индивидуально, а не все сразу.

Например, если у вас есть сайт Drupal, использующий модуль XMLSiteMap, перейдите к admin / config / search / xmlsitemap / settings и снимите флажок Prefetch URL aliases во время создания карты сайта . Сохраните конфигурацию и очистите кеши для среды Live на панели управления Pantheon или через Terminus:

Props to Will Hall для выделения этого решения в соответствующем сообщении в блоге.

Отправка устаревших карт сайта Создание 404

Карты сайта можно (и нужно) отправлять непосредственно в Инструменты Google для веб-мастеров. Однако, если есть устаревшие заявки, генерирующие 404, вам необходимо перенаправить через PHP в пределах wp-config.php или settings.php . Например, сайты WordPress с плагином Yoast SEO могут использовать следующее:

if (($ _SERVER ['REQUEST_URI'] == '/sitemap.xml') &&

(php_sapi_name ()! = "cli")) {

заголовок ('HTTP / 1.0 301 Перемещено навсегда ');

заголовок ('Расположение: /sitemap_index. xml');

выход();

}

xml');

выход();

} Дополнительные примеры перенаправления через PHP см. В разделе «Настройка перенаправления».

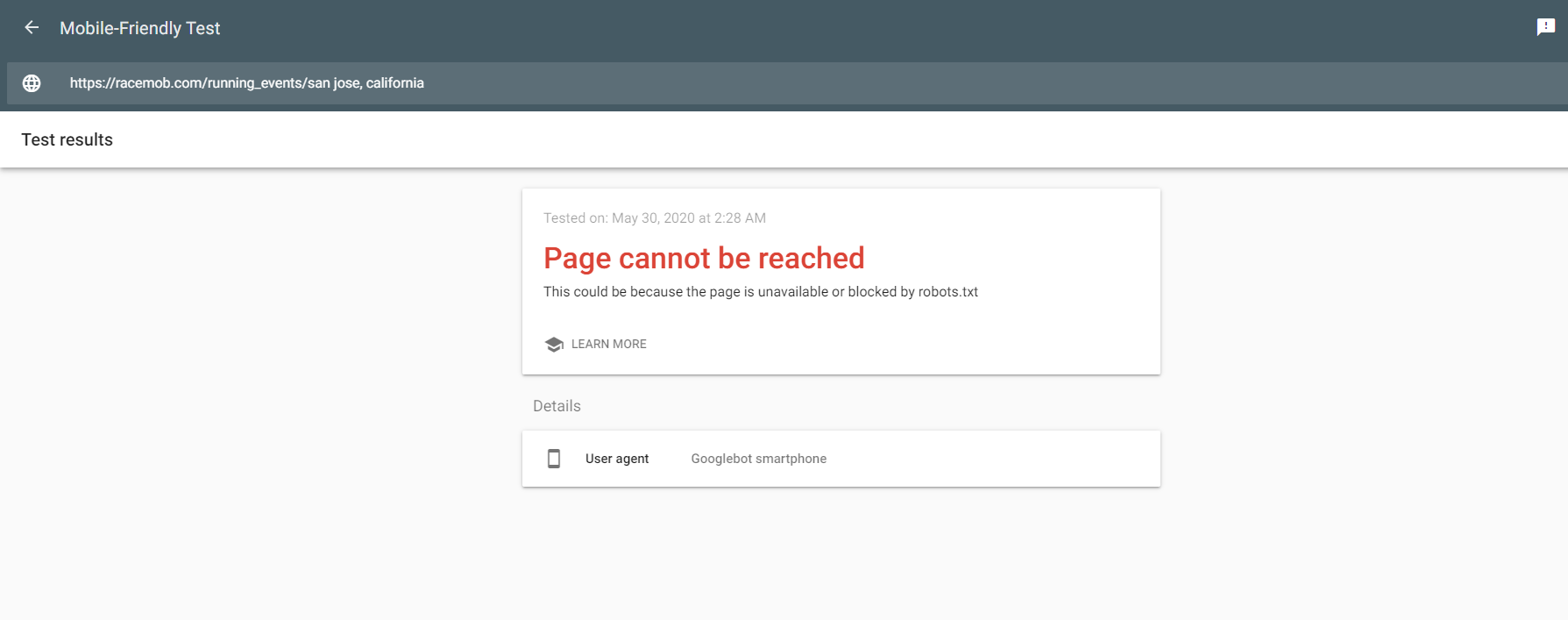

Неверный вывод robots.txt в WordPress

В WordPress не включайте Запретите поисковым системам индексировать этот сайт в средах разработки или тестирования. Этот параметр установлен в Settings > Reading > Search Engine Visibility на панели администратора WordPress.

Этот параметр создает встроенный файл robots.txt , который запрещает или блокирует поисковые роботы. Хотя файл, применяемый платформой, обычно переопределяет его, этого не происходит, если в конце URL-адреса есть косая черта, указывающая на robots.txt .

В качестве обходного пути вы можете переопределить вывод, создав собственный фильтр для robots_txt . Вы можете добавить это как собственный плагин или запись в файле вашей темы functions.php :

add_filter ('robots_txt', 'custom_robots_txt', 10, 2);

function custom_robots_txt ($ output, $ public) {

$ robots_txt = "Пользовательский агент: * \ n";

$ robots_txt. = "Карта сайта: https://www.example.com/sitemap_index.xml \ n";

$ robots_txt. = "Запретить: / secure /";

вернуть $ robots_txt;

}

= "Карта сайта: https://www.example.com/sitemap_index.xml \ n";

$ robots_txt. = "Запретить: / secure /";

вернуть $ robots_txt;

} Robot Txt File Учебное пособие для веб-сайта WordPress

Текстовый файл робота, более известный как robots.txt, представляет собой давно действующий веб-стандарт, который помогает предотвратить доступ Google и других поисковых систем к частям вашего сайта.

Почему вы хотите заблокировать Google для некоторых частей вашего сайта? Одна из важных причин - запретить Google индексировать страницы вашего сайта, которые являются дубликатами страниц других сайтов, например, страниц WordPress по умолчанию.Google наказывает сайты с дублированным контентом.

Еще одна важная причина - запретить Google ссылаться на незащищенный премиум-контент на вашем веб-сайте. Например, вы раздаете бесплатную электронную книгу людям, подписавшимся на ваш список рассылки. Вы не хотите, чтобы Google напрямую ссылался на эту электронную книгу, поэтому вы используете текстовый файл робота, чтобы Google не мог его проиндексировать.

Например, электронные книги могут храниться в папке в корневом домене под названием PDF. Это то, что вы сделали бы, чтобы заблокировать все поисковые системы.

User-Agent: *

Disallow: / PDF /

С другой стороны, если вы хотите, чтобы ваша бесплатная книга стала вирусной, не блокируйте доступ к книге поисковым системам.

Некоторым людям также нравится запрещать Google использовать их изображения в поиске Google или загружать большие файлы.

Кроме того, если у вас есть крупный сайт WordPress, Google может загружать одну и ту же страницу под несколькими разными именами, используя большую часть вашей пропускной способности и вычислительной мощности веб-сервера.Специальные шаблоны текстовых файлов роботов могут указывать Google на доступ к страницам только один раз.

Наконец, вы можете сообщить Google о своей XML-карте или текстовой карте сайта с помощью файла robots.txt, чтобы он индексировал новые страницы вашего сайта намного быстрее, чем просто ждал, пока он повторно просканирует ваш сайт.

Текстовый файл робота - это необязательный файл в корневом каталоге веб-сайта. Поскольку вы читаете это, я предполагаю, что у вас есть веб-сайт. Найдите минутку, чтобы проверить, есть ли у вас текстовый файл робота, перейдя по следующему URL-адресу: http: // example.com / robots.txt

(Замените example.com на свое доменное имя.)

Вот мое: Обратите внимание, это работа в стадии разработки. Недавно я изменил свою тему WordPress, что также потребовало, чтобы я сам редактировал текстовые файлы своего робота.

Robot Txt File Учебник для веб-сайта WordPress

Вы должны быть осторожны при редактировании этого файла, так как вы легко можете сделать ошибку и заблокировать доступ поисковых систем к вашему сайту.

Если вы получаете ошибку 404 File Not Found, у вас нет текстового файла робота.В противном случае вы увидите простой текстовый файл со строками User-Agent, Allow, Disallow и Sitemap, плюс пустые строки и строки комментариев («#»).

Что означает текстовый файл робота

• User-Agent означает пользовательский агент веб-браузера, посещающий ваш сайт. Текстовый файл робота предназначен только для роботов, также называемых пауками, которые сканируют ваш веб-сайт в поисках и других автоматизированных онлайн-инструментах. Робот-сканер Google называется Googlebot, хотя у Google также есть несколько других роботов для других инструментов поиска.

• Разрешить сообщает роботам, что им разрешено посещать URL-адреса, содержащие определенный путь. Большинство текстовых файлов роботов сообщают роботам, что корневой путь («/») можно сканировать.

• Disallow сообщает роботам, куда они не могут попасть. Большую часть времени редактирование файла robots.txt будет потрачено на создание запрещающих строк.

• Карта сайта указывает на карту вашего сайта (или на несколько карт сайта, если у вас большой сайт). Для этого вам понадобится карта сайта, для чего требуется что-то вроде плагина WordPress XML Sitemap Generator.

Следующие инструкции будут работать только в том случае, если вы используете WordPress для управления корневым каталогом своего веб-сайта. Это означает, что на главной странице вашего блога нет слов после имени домена.

Например, если ваша главная страница WordPress - http://example.com/, то WordPress, вероятно, управляет вашим файлом robots.txt. Но если ваша главная страница WordPress - http://example.com/blog, вероятно, WordPress не управляет вашими роботами.txt, и вам придется работать с ним напрямую, используя загрузку по FTP.

По умолчанию WordPress создает ограничительный файл robots.txt, если вы используете настройки WordPress, чтобы пометить свой блог как частный. У большинства людей есть общедоступные сайты, поэтому текстовый файл робота WordPress по умолчанию пуст.

Некоторые хостинговые компании предоставляют текстовый файл робота по умолчанию для WordPress, особенно если вы использовали установку WordPress в один клик. В этом случае вам может потребоваться отредактировать файл robots.txt с помощью загрузки по FTP.

В этом случае вам может потребоваться отредактировать файл robots.txt с помощью загрузки по FTP.

Но если ничего из вышеперечисленного не соответствует действительности, вы, вероятно, можете попросить WordPress сгенерировать для вас файл robots.txt.

Robots.txt Плагины WordPressНесколько плагинов SEO могут создавать файл robots.txt. Я был бы осторожен с их использованием, если вы занимаетесь чем-либо помимо ведения блога на своем сайте, потому что они могут помешать Google индексировать допустимые страницы. Это может быть одна из тех глупых ошибок, из-за которых рейтинг вашего сайта быстро падает.

Другой плагин, который автоматически создает текстовый файл робота, - XML Sitemap Generator.Он ничего не блокирует и не разрешает - он просто включает строку Sitemap, чтобы сообщить Google и другим поисковым системам, где найти вашу карту сайта.

Примером может быть:

Карта сайта: http://tips4pc.com/sitemap.xml

Есть также очень старый плагин WordPress, который позволяет редактировать текстовый файл вашего робота из WordPress. Я не использовал этот плагин, поэтому не знаю, работает ли он до сих пор.

Я не использовал этот плагин, поэтому не знаю, работает ли он до сих пор.

Если вам нужен собственный текстовый файл робота, вы можете создать его по старинке.Откройте Блокнот Windows, Mac OSX TextEdit или vi или emacs для Linux. Введите следующий текст:

User-Agent: *

Allow: /

В приведенном выше примере файла роботы будут действовать точно так же, как если бы у вас не было текстового файла робота, поэтому он ничего не сломает. твой сайт. Сохраните файл как robots.txt и загрузите его в корневой каталог своего веб-сервера с помощью инструмента FTP или онлайн-менеджера файлов вашей компании, предоставляющей услуги хостинга веб-сайтов.

(Корневой каталог - это тот же каталог, в который вы добавляете файл кода подтверждения веб-сайта Google, если вы это делали раньше.)

После загрузки файла откройте страницу http://example.com/robots.txt в своем веб-браузере (но вместо этого используйте свой домен). Вы должны увидеть только что загруженный файл. Если вы этого не сделаете, вам нужно будет обратиться за помощью к своей хостинговой компании.

Вы должны увидеть только что загруженный файл. Если вы этого не сделаете, вам нужно будет обратиться за помощью к своей хостинговой компании.

Текстовый файл робота может быть таким же простым, как приведенный выше пример, или намного сложнее. В общем, вы хотите заблокировать следующее: