Плагин отнесен в категорию robots

Virtual Robots.txt

(8 общий рейтинг)

Virtual Robots.txt automatically creates a robots.txt file for your site. Your robots.txt file can be…

Marios Alexandrou 50 000+ активных установок Протестирован с 5.9.4 Обновлен 7 месяцев назад

WP Robots Txt

(16 общий рейтинг)

WP Robots Txt Allows you to edit the content of your robots.txt file.

Christopher Davis 20 000+ активных установок Протестирован с 3.6.1 Обновлен 9 лет назад

Robots.txt Editor

(8 общий рейтинг)

Robots.txt для WordPress

Processby 20 000+ активных установок Протестирован с 5.6.9 Обновлен 2 года назад

WordPress Robots.txt optimization (+ XML Sitemap) – Website traffic, SEO & ranking Booster

(97 общий рейтинг)

All-in-One SEO plugin for WordPress Robots.

Pagup 10 000+ активных установок Протестирован с 6.0.2 Обновлен 4 месяца назад

Companion Sitemap Generator — HTML & XML

(44 общий рейтинг)

Creates and XML sitemap for search engines and allows you to add an HTML sitemap…

Papin Schipper 9 000+ активных установок Протестирован с 6.0.2 Обновлен 3 месяца назад

410 for WordPress

(21 общий рейтинг)

A plugin that sends HTTP 410 (Gone) responses to requests for articles that no longer…

Samir Shah 7 000+ активных установок Протестирован с 4.9.21 Обновлен 5 лет назад

Noindex Pages

Ask search engines not to index individual pages by checking an option in the publish…

Radley Sustaire 5 000+ активных установок Протестирован с 4.

4.28

Обновлен 7 лет назад

4.28

Обновлен 7 лет назадRobots.txt rewrite

(2 общий рейтинг)

Provide the easy managment of your robots.txt from admin side. It propose you the advanced…

Eugen Bobrowski 3 000+ активных установок Протестирован с 4.7.24 Обновлен 6 лет назад

Multipart robots.txt editor

Customize your site’s robots.txt and include remote content to it

Viktor Szépe 3 000+ активных установок Протестирован с 4.9.21 Обновлен 5 лет назад

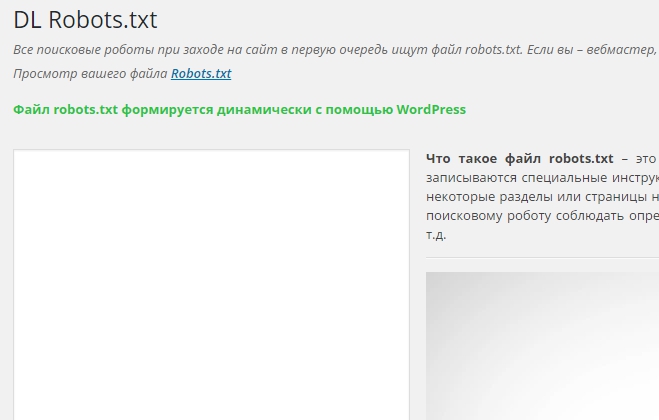

DL Robots.txt

(1 общий рейтинг)

DL Robots.txt Позволяет редактировать содержимое вашего файла robots.txt

Dyadya Lesha ([email protected]) 2 000+ активных установок Протестирован с 4.6.24 Обновлен 6 лет назад

Simple Noarchive

Adds the noarchive tag to all URLs

ArianaLashes 1 000+ активных установок Протестирован с 4.

8.20

Обновлен 4 года назад

8.20

Обновлен 4 года назадCryptex | E-Mail Address Protection

(4 общий рейтинг)

Cryptex transforms plain-text E-Mail-Addresses into Images — automatically — No scrapers. No harvesters. No spambots.…

Andi Dittrich 1 000+ активных установок Протестирован с 5.4.11 Обновлен 2 года назад

Noindex Attachment Pages

Add META ROBOTS NOINDEX to Attachment Pages in WordPress for better SEO

Jose A Ruiz 1 000+ активных установок Протестирован с 3.7.39 Обновлен 9 лет назад

mypace Custom Meta Robots

(0 общий рейтинг)

Description: This plugin allows you to edit the meta robots tag at every singular post(posts,…

Kei Nomura (mypacecreator) 1 000+ активных установок Протестирован с 5.

6.9

Обновлен 2 года назад

6.9

Обновлен 2 года назадMWS Noindex Attachment Pages

This plugin add meta tag noindex,nofolow to head of any attachment page().

ModernWebStudios 700+ активных установок Протестирован с 4.9.21 Обновлен 4 года назад

Robots & Sitemap

(3 общий рейтинг)

Плагин позволяет удобно генерировать sitemap.xml, создавать и редактировать robots.txt для вашего сайта (мультисайта).

VO3DA Team 700+ активных установок Протестирован с 5.6.9 Обновлен 2 года назад

WP-log-robots

(0 общий рейтинг)

WP-log-robots is a wordpress plugin, we could used it to loged the search engine robots…

netroby 600+ активных установок Протестирован с 3.1.4 Обновлен 12 лет назад

Block Archive.

org via WordPress robots.txt

org via WordPress robots.txt(1 общий рейтинг)

Blocks the archive.org bots through the WordPress virtual robots.txt file.

Apasionados, Apasionados del Marketing 400+ активных установок Протестирован с 6.0.2 Обновлен 1 неделя назад

Search engines blocked warning

(0 общий рейтинг)

Shows a warning in the WordPress administration header when the option «Search Engine Visibility: Discourage…

Apasionados 400+ активных установок Протестирован с 6.0.2 Обновлен 1 неделя назад

Robots.txt Quick Editor

Plugin to edit robots.txt file

Davide Airaghi 400+ активных установок Протестирован с 6.0.2 Обновлен 2 месяца назад

WordPress Robots.txt optimization (+ XML Sitemap) – Website traffic, SEO & ranking Booster — Плагин для WordPress

Better Robots. txt creates a WordPress virtual robots.txt, helps you boost your website SEO (indexing capacities, Google ranking,etc.) and your loading performance –Compatible with Yoast SEO, Google Merchant, WooCommerce and Directory based network sites (MULTISITE)

txt creates a WordPress virtual robots.txt, helps you boost your website SEO (indexing capacities, Google ranking,etc.) and your loading performance –Compatible with Yoast SEO, Google Merchant, WooCommerce and Directory based network sites (MULTISITE)

With Better Robots.txt, you can identify which search engines are allowed to crawl your website (or not), specify clear instructions aboutwhat they are allowed to do (or not) and define a crawl-delay (to protect your hosting server against aggressive scrapers). Better Robots.txt also gives you full control over your WordPress robots.txt content via the custom setting box.

Reduce your site’s ecological footprint and the greenhouse gas (CO2) production inherent to its existence on the Web.

Краткий обзор:

SUPPORTED IN 7 LANGUAGES

Better Robots. txt plugins are translated and available in: Chinese –汉语/漢語, English, French – Français, Russian –Руссɤɢɣ, Portuguese – Português, Spanish – Español, German – Deutsch

txt plugins are translated and available in: Chinese –汉语/漢語, English, French – Français, Russian –Руссɤɢɣ, Portuguese – Português, Spanish – Español, German – Deutsch

А вы знали…

- The robots.txt file is a simple text file placed on your web server which tells web crawlers (like Googlebot) whether they should access a file.

- The robots.txt file controls how search engine spiders see and interact with your web pages;

- This file and the bots they interact with are fundamental parts of how search engines work;

- Первое, что искатель поисковой системы просматривает, когда он посещает страницу, — это файл robots.txt;

Robots.txt является источником SEO-сока, ожидающего разблокировки. Попробуйте лучше Robots.txt!

О версии Pro (дополнительные функции):

1. Увеличьте свой контент в поисковых системах с помощью своей карты сайта!

Make sure your pages, articles, and products, even the latest, are taken into consideration by search engines !

The Better Robots.

If you want to add your own sitemap (or if you are using another SEO plugin), then you just have to copy and paste your Sitemap URL, and Better Robots.txt will add it into your WordPress Robots.txt.

2. Защитите свои данные и контент

Блокируйте плохих ботов со сбоев на вашем сайте и коммерциализации ваших данных.

The Better Robots.txt plugin helps you block most popular bad bots from crawling and scraping your data.

When it comes to things crawling your site, there are good bots and bad bots. Good bots, like Google bot, crawl your site to index it for search engines. Others crawl your site for more nefarious reasons such as stripping out your content (text, price, etc.) for republishing, downloading whole archives of your site or extracting your images. Some bots were even reported to pull down entire websites as a result of heavy use of broadband.

Others crawl your site for more nefarious reasons such as stripping out your content (text, price, etc.) for republishing, downloading whole archives of your site or extracting your images. Some bots were even reported to pull down entire websites as a result of heavy use of broadband.

The Better Robots.txt plugin protects your website against spiders/scrapers identified as bad bots by Distil Networks.

3. Скрыть и защитить свои обратные ссылки

Stop competitors from identifying your profitable backlinks.

Backlinks, also called “inbound links” or “incoming links” are created when one website links to another. The link to an external website is called a backlink. Backlinks are especially valuable for SEO because they represent a “vote of confidence” from one site to another. In essence, backlinks to your website are a signal to search engines that others vouch for your content.

If many sites link to the same webpage or website, search engines can infer that the content is worth linking to, and therefore also worth showing on a SERP. So, earning these backlinks generates a positive effect on a site’s ranking position or search visibility. In the SEM industry, it is very common for specialists to identify where these backlinks come from (competitors) in order to sort out the best of them and generate high-quality backlinks for their own customers.

So, earning these backlinks generates a positive effect on a site’s ranking position or search visibility. In the SEM industry, it is very common for specialists to identify where these backlinks come from (competitors) in order to sort out the best of them and generate high-quality backlinks for their own customers.

Учитывая, что создание очень выгодных обратных ссылок для компании занимает много времени (время + энергия + бюджет), позволяя вашим конкурентам легко идентифицировать и дублировать их, это чистая потеря эффективности.

Better Robots.txt поможет вам блокировать все поисковые роботы (aHref, Majestic, Semrush), чтобы ваши обратные ссылки были необнаружимыми.

4. Избегайте обратных ссылок спама

Bots populating your website’s comment forms telling you ‘great article,’ ‘love the info,’ ‘hope you can elaborate more on the topic soon’ or even providing personalized comments, including author name are legion. Spambots get more and more intelligent with time, and unfortunately, comment spam links can really hurt your backlink profile. Better Robots.txt helps you avoid these comments from being indexed by search engines.

Better Robots.txt helps you avoid these comments from being indexed by search engines.

5. Инструменты Seo

While improving our plugin, we added shortcut links to 2 very important tools (if you are concerned with your ranking on search engines): Google Search Console & Bing Webmaster Tool. In case you are not already using them, you may now manage your website indexing while optimizing your robots.txt ! Direct access to a Mass ping tool was also added, allowing you to ping your links on more than 70 search engines.

We also created 4 shortcut links related to the best Online SEO Tools, directly available on Better Robots.txt SEO PRO. So that, whenever you want, you are now able to check out your site’s loading performance, analyze your SEO score, identify your current ranking on SERPs with keywords & traffic, and even scan your entire website for dead links (404, 503 errors, …), directly from the plugin.

6. Будьте уникальным

We thought that we could add a touch of originality on Better Robots. txt by adding a feature allowing you to “customize” your WordPress robots.txt with your own unique “signature.” Most major companies in the world have personalized their robots.txt by adding proverbs (https://www.yelp.com/robots.txt), slogans (https://www.youtube.com/robots.txt) or even drawings (https://store.nike.com/robots.txt – at the bottom). And why not you too? That’s why we have dedicated a specific area on the settings page where you can write or draw whatever you want (really) without affecting your robots.txt efficiency.

txt by adding a feature allowing you to “customize” your WordPress robots.txt with your own unique “signature.” Most major companies in the world have personalized their robots.txt by adding proverbs (https://www.yelp.com/robots.txt), slogans (https://www.youtube.com/robots.txt) or even drawings (https://store.nike.com/robots.txt – at the bottom). And why not you too? That’s why we have dedicated a specific area on the settings page where you can write or draw whatever you want (really) without affecting your robots.txt efficiency.

7. Prevent robots crawling useless WooCommerce links

We added a unique feature allowing to block specific links («add-to-cart», «orderby», «fllter», cart, account, checkout, …) from being crawled by search engines. Most of these links require a lot of CPU, memory & bandwidth usage (on hosting server) because they are not cacheable and/or create «infinite» crawling loops (while they are useless). Optimizing your WordPress robots. txt for WooCommerce when having an online store, allows to provide more processing power for pages that really matter and boost your loading performance.

txt for WooCommerce when having an online store, allows to provide more processing power for pages that really matter and boost your loading performance.

8. Avoid crawler traps:

«Crawler traps” are a structural issue within a website that causes crawlers to find a virtually infinite number of irrelevant URLs. In theory, crawlers could get stuck in one part of a website and never finish crawling these irrelevant URLs. Better Robots.txt helps prevent crawler traps which hurt crawl budget and cause duplicate content.

9. Growth hacking tools

Today’s fastest growing companies like Amazon, Airbnb and Facebook have all driven breakout growth by aligning their teams around a high velocity testing/learning process. We are talking about Growth Hacking. Growth hacking is a process of rapidly experimenting with and implementing marketing and promotional strategies that are solely focused on efficient and rapid business growth. Better Robots. txt provide a list of 150+ tools available online to skyrocket your growth.

txt provide a list of 150+ tools available online to skyrocket your growth.

10. Robots.txt Post Meta Box for manual exclusions

This Post Meta Box allows to set «manually» if a page should be visible (or not) on search engines by injecting a dedicated «disallow» + «noindex» rule inside your WordPress robots.txt. Why is it an asset for your ranking on search engines ? Simply because some pages are not meant to be crawled / indexed. Thank you pages, landing pages, page containing exclusively forms are useful for visitors but not for crawlers, and you don’t need them to be visible on search engines. Also, some pages containing dynamic calendars (for online booking) should NEVER be accessible to crawlers beause they tend to trap them into infinite crawling loops which impacts directly your crawl budget (and your ranking).

11. Ads.txt & App-ads.txt crawlability

In order to ensure that ads.txt & app-ads.txt can be crawled by search engines, Better Robots. txt plugin makes sure they are by default allowed in Robots.txt file no matter your configuration. For your information, Authorized Digital Sellers for Web, or ads.txt, is an IAB initiative to improve transparency in programmatic advertising. You can create your own ads.txt files to identify who is authorized to sell your inventory. The files are publicly available and crawlable by exchanges, Supply-Side Platforms (SSP), and other buyers and third-party vendors. Authorized Sellers for Apps, or app-ads.txt, is an extension to the Authorized Digital Sellers standard. It expands compatibility to support ads shown in mobile apps.

txt plugin makes sure they are by default allowed in Robots.txt file no matter your configuration. For your information, Authorized Digital Sellers for Web, or ads.txt, is an IAB initiative to improve transparency in programmatic advertising. You can create your own ads.txt files to identify who is authorized to sell your inventory. The files are publicly available and crawlable by exchanges, Supply-Side Platforms (SSP), and other buyers and third-party vendors. Authorized Sellers for Apps, or app-ads.txt, is an extension to the Authorized Digital Sellers standard. It expands compatibility to support ads shown in mobile apps.

More to come as always …

Robots txt для WordPress 6.0.2 в 2022 году

Если вам интересно, как для улучшения SEO оптимизировать файл robots.txt WordPress, то вы попали в нужное место.

В этом кратком руководстве я объясню, что такое файл robots.txt, почему он важен для улучшения поискового рейтинга и как вносить в него изменения и отправлять в Google и Яндекс.

Давайте начнем!

Содержание

- Что такое файл robots.txt для WordPress?

- Что находиться в файле robots.txt?

- Как оптимизировать robots.txt WordPress для улучшения SEO

- Как выглядит идеальный файл robots.txt?

- Что разрешить и запретить в robots.txt?

- Как отправить файл WordPress robots.txt в Google?

- Как отправить файл WordPress robots.txt в Яндекс?

- Вывод

Что такое файл robots.txt для WordPress?

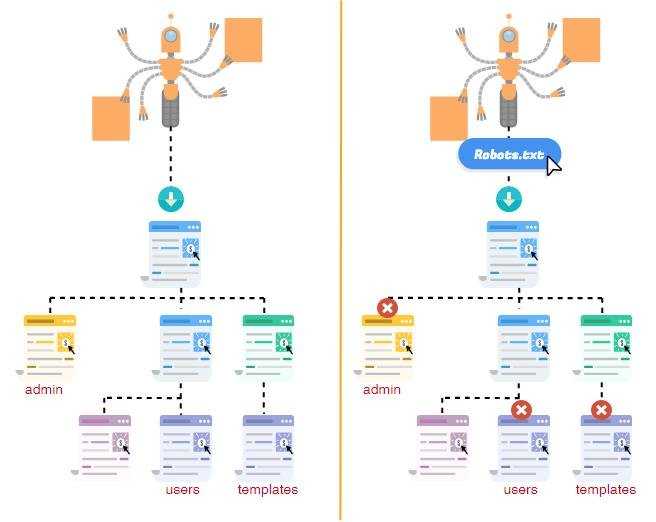

Файл robots.txt — это файл на вашем сайте, который позволяет запретить поисковым системам доступ к определенным файлам и папкам. Вы можете использовать его, чтобы заблокировать роботов Google (и других поисковых систем) от сканирования определенных страниц на вашем сайте.

Так как же отказ в доступе к поисковым системам на самом деле улучшает ваше SEO? Кажется контринтуитивным…

Это работает следующим образом: чем больше страниц на вашем сайте, тем больше страниц должны сканировать поисковые системы.

Например, если в вашем блоге много страниц категорий и тегов, эти страницы некачественные и не нуждаются в сканировании поисковыми системами. Они просто потребляют краулинговый бюджет вашего сайта (количество страниц, которые поисковые системы будет сканировать на вашем сайте в любой момент времени).

Бюджет сканирования важен, потому что он определяет, насколько быстро поисковые системы улавливают изменения на вашем сайте и, следовательно, как быстро вы занимаете высшее место в поиске. Это может особенно помочь с SEO электронной коммерции!

Будьте осторожны, так как это может повредить вашему SEO, если все сделать плохо. Вы потеряете позиции находясь в высококонкурентной нише с большими сайтами. Однако, если вы только начинаете свой первый блог, создание ссылок на ваш контент и создание большого количества высококачественных статей являются более важными приоритетами.

Что находиться в файле robots.txt?

Файл robots.txt состоит из одного или нескольких блоков кода, каждый из которых содержит инструкции для одного или нескольких ботов. Кодовый блок состоит из:

Кодовый блок состоит из:

- User-agent, который идентифицирует бота, на которого распространяется правило. Звездочкой (*), означает что применяется к любому пользовательскому агенту, который посещает веб-сайт. Однако вы можете настроить таргетинг на конкретного бота с помощью его пользовательского агента. Например, пользовательский агент Google — Googlebot.

- Disallow указывает ботам поисковых систем игнорировать указанный файл или файлы.

- Allow позволяет ботам поисковых систем получать доступ к указанному файлу или файлам. В этом нет необходимости, если только вы не хотите разрешить доступ к файлу или подкаталогу в запрещенном родительском каталоге.

- Crawl-delay указывает, сколько времени робот поисковой системы должен ждать между загрузками страницы. Он связан с числовым значением в секундах.

- Sitemap сообщает роботам, где находится ваша карта сайта. Эта строка не является обязательной. Я рекомендую вам отправлять карту сайта в поисковые системы с помощью специального инструмента, такого как Google Search Console.

Может включать один или несколько файлов Sitemap, каждый из которых связан с URL-адресом карты сайта.

Может включать один или несколько файлов Sitemap, каждый из которых связан с URL-адресом карты сайта.

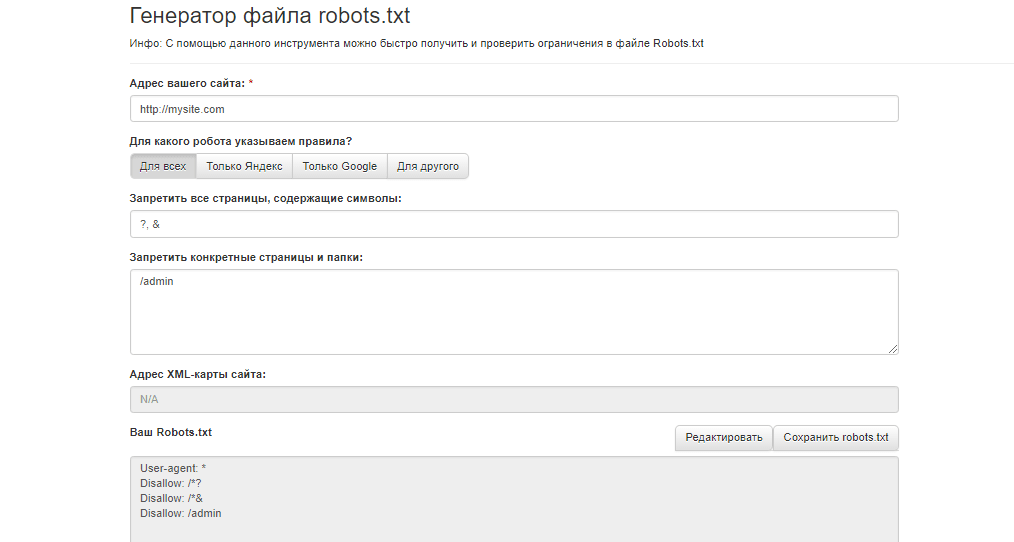

Как оптимизировать robots.txt WordPress для улучшения SEO

Теперь давайте обсудим, как на самом деле получить (или создать) и оптимизировать файл WordPress robots.txt.

Robots.txt обычно находится в корневой папке вашего сайта. Вам нужно будет подключиться к вашему сайту с помощью FTP-клиента или с помощью файлового менеджера cPanel для его просмотра. Это обычный текстовый файл, который можно открыть в любом текстовом редакторе.

Если у вас нет файла robots.txt в корневом каталоге вашего сайта, вы можете создать его. Все, что вам нужно сделать, это создать новый текстовый файл на вашем компьютере и сохранить его как robots.txt. Затем просто загрузите его в корневую папку вашего сайта.

Как выглядит идеальный файл robots.txt?

Формат файла robots.txt очень прост. Первая строка обычно называет пользовательский агент. Пользовательский агент — это имя поискового бота, с которым вы пытаетесь связаться. Например,

Например, Googlebotили Bingbot. Вы можете использовать звездочку *, чтобы проинструктировать всех ботов.

Следующая строка следует с инструкциями «Разрешить» или «Запретить» какие части вы хотите, чтобы они индексировали, а какие — нет.

Вот правильный robots.txt для WordPress:

User-agent: * # Предотвращено индексирование конфиденциальных файлов Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/cache Disallow: /trackback Disallow: /*.php$ Disallow: /*.inc$ Disallow: /*.gz$ # Не индексируем страницу входа (ненужный контент) Disallow: /wp-login.php Sitemap: https://mrwp.ru/sitemap_index.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 | User-agent: *

# Предотвращено индексирование конфиденциальных файлов Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/cache Disallow: /trackback Disallow: /*. Disallow: /*.inc$ Disallow: /*.gz$

# Не индексируем страницу входа (ненужный контент) Disallow: /wp-login.php

Sitemap: https://mrwp.ru/sitemap_index.xml |

Обратите внимание, что если вы используете такой плагин, как Yoast или All in One SEO, вам может не понадобиться добавлять раздел карты сайта, поскольку они делают это автоматически. Если это не удается, вы можете добавить его вручную, как в примере выше.

Что разрешить и запретить в robots.txt?

В руководстве Google для веб-мастеров советуют не использовать файл robots.txt для сокрытия некачественного контента. Таким образом, использование вашего файла robots.txt, чтобы запретить поисковым системам индексировать вашу категорию, дату и другие страницы архива, может быть неразумным выбором.

Помните, что файл robots.txt предназначен для того, чтобы проинструктировать ботов, что делать с контентом, который они сканируют на вашем сайте. Это не мешает им сканировать ваш сайт.![]()

Кроме того, вам не нужно добавлять страницу входа в WordPress, каталог администратора или страницу регистрации в robots.txt, потому что страницы входа и регистрации имеют тег noindex, автоматически добавленный WordPress.

Однако я рекомендую запретить файл readme.html в файле robots.txt.Этот файл readme может быть использован кем-то, кто пытается выяснить, какую версию WordPress вы используете. Если это человек, он может легко получить доступ к файлу, просто просмотрев его. Кроме того, размещение тега Disallow может блокировать вредоносные атаки.

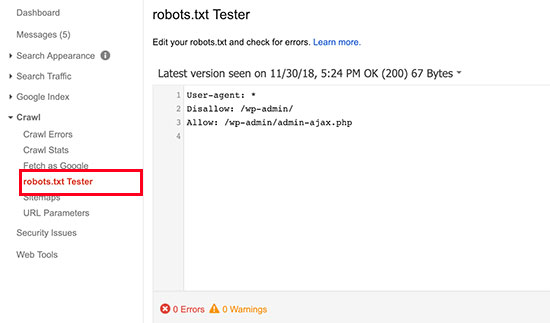

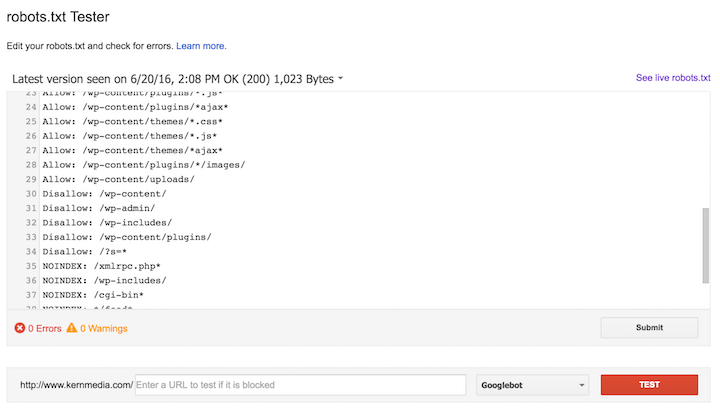

Как отправить файл WordPress robots.txt в Google?

После того как вы обновили или создали файл robots.txt, вы можете отправить его в Google с помощью Google Search Console.

Тем не менее, я рекомендую сначала протестировать его с помощью инструмента тестирования Google robots.txt.

Если вы не видите созданную вами версию здесь, вам придется повторно загрузить файл robots.txt, который вы создали, на свой сайт WordPress.

Как отправить файл WordPress robots.txt в Яндекс?

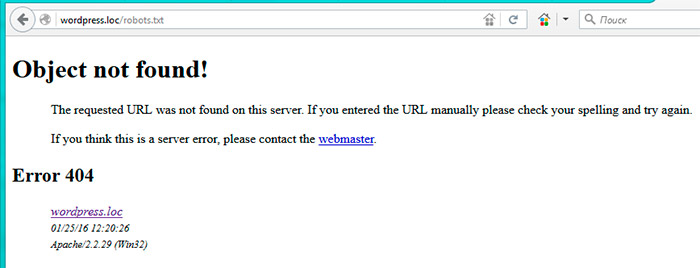

Автоматически Яндекс попробует загрузить файл по адресу https://ваш-домен.ru/robots.txt. Если вы вручную не создавали этот файл, то по-умолчанию будет использоваться встроенный в WordPress (физически он может отсутствовать на хостинге) и часто его хватает для работы.

Для того, чтобы проанализировать действие файла в Яндексе, следует перейти на соответствующую страницу в разделе Яндекс.Вебмастер. Заходим в раздел Инструменты –> Анализ robots.txt.

Как видите, никакого запрета на индексирование страницы со стороны robots.txt мы не видим, значит все в порядке :).

Вывод

Теперь вы знаете, как оптимизировать файл WordPress robots.txt для улучшения SEO.

Будьте осторожны при внесении каких-либо серьезных изменений на свой сайт с помощью файла robots.txt. Хотя эти изменения могут улучшить ваш поисковый трафик, они также могут принести больше вреда, чем пользы, если вы не будете осторожны.

У вас есть вопросы о том, как оптимизировать файл robots. txt WordPress? Какое влияние оказало изменение на ваш поисковый рейтинг? Дайте мне знать об этом в комментариях.

txt WordPress? Какое влияние оказало изменение на ваш поисковый рейтинг? Дайте мне знать об этом в комментариях.

Правильный Robots.txt для WordPress (базовый и расширенный) [2022]

Правильный Robots.txt для WordPress в 2022-м году. Несколько версий под разные нужды: простая базовая и расширенная — с проработкой под каждую поисковую систему.

Одной из важнейших вещей при создании и оптимизации сайта для поисковых систем считают Robots.txt. Небольшой файлик, где прописаны правила индексирования для поисковых роботов.

Если файл будет настроен неправильно, то сайт может неправильно индексироваться и терять большие доли трафика. Грамотная настройка наоборот позволяет улучшить SEO, и вывести ресурс в топы.

Сегодня мы поговорим о настройке Robots.txt для WordPress. Я покажу вам правильный вариант, который сам использую для своих проектов.

✅ Содержание

Что такое Robots.txt

Как я уже и сказал, robots.txt — текстовой файлик, где прописаны правила для поисковых систем. Стандартный robots.txt для WordPress выглядит следующим образом:

Стандартный robots.txt для WordPress выглядит следующим образом:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Именно в таком виде он создается плагином Yoast SEO. Некоторые считают, что этого хватит для правильной индексации. Я же считаю, что нужна более детальная проработка. А если речь идет о нестандартных проектах, то проработка нужна и подавно. Давайте разберемся в основных директивах:

| Директива | Значение | Пояснение |

| User-agent: | Yandex, Googlebot и т.д. | В этой директиве можно указать к какому конкретно роботу мы обращаемся. Обычно используются те значения, которые я указал. |

| Disallow: | Относительная ссылка | Директива запрета. Ссылки, указанные в этой директиве будут игнорироваться поисковыми системами. |

| Allow: | Относительная ссылка | Разрешающая директива. Ссылки, которые указаны с ней будут проиндексированы. |

| Sitemap: | Абсолютная ссылка | Здесь указывается ссылка на XML-карту сайта. Если в файле не указать эту директиву, то придется добавлять карту вручную (через Яндекс.Вебмастер или Search Console). Если в файле не указать эту директиву, то придется добавлять карту вручную (через Яндекс.Вебмастер или Search Console). |

| Crawl-delay: | Время в секундах (пример: 2.0 — 2 секунды) | Позволяет указать таймаут между посещениями поисковых роботов. Нужна в случае, если эти самые роботы создают дополнительную нагрузку на хостинг. |

| Clean-param: | Динамический параметр | Если на сайте есть параметры вида site.ru/statia?uid=32, где ?uid=32 — параметр, то с помощью этой директивы их можно скрыть. |

В принципе, ничего сложного. Дам дополнительные пояснения по директивам Clean-param (откройте вкладку).

Подробнее о Clean-param

Параметры, как правило, используются на динамических сайтах. Они могут передавать поисковым системам лишнюю информацию — создавать дубли. Чтобы избежать этого, мы должны указать в Robots.txt директиву Clean-param с указанием параметра и ссылки, к которой это параметр применяется.

В нашем примере site.ru/statia?uid=32 — site.ru/statia — ссылка, а все, что после знака вопроса — параметр. Здесь это uid=32. Он динамический, и это значит, что параметр uid может принимать другие значения.

Например, uid=33, uid=34…uid=123434. В теории их может быть сколько угодно, поэтому мы должны закрыть от индексации все параметры uid. Для этого директива должна принять такой вид:

Clean-param: uid /statia # все параметры uid для statia будут закрыты

Более подробно о том, что такое Robots.txt можно узнать из Яндекс.Помощи. Или из этого видеоролика:

Базовый Robots.txt для WordPress

Совсем недавно я приобрел плагин Clearfy Pro для своих проектов. Там очень много разных функций, и одна из них — создание идеального Robots.![]() txt. На самом деле насколько он идеален — я не знаю, вебмастера расходятся во мнениях.

txt. На самом деле насколько он идеален — я не знаю, вебмастера расходятся во мнениях.

Кто-то предпочитает делать более краткие версии роботса, указывая правила для всех поисковых систем сразу. Другие прописывают отдельные правила для каждого поисковика (в основном для Яндекса и Гугла).

Что из этого правильно — точно сказать не могу. Однако я предлагаю вам ознакомиться с базовой версией Robots.txt для WordPress от Clearfy Pro. Я немного подредактировал ее — указал директиву Sitemap. Удалил директиву Host.

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /*? Disallow: /?s= Allow: /wp-includes/*.css Allow: /wp-includes/*.js Allow: /wp-content/plugins/*.css Allow: /wp-content/plugins/*.js Allow: /*.css Allow: /*.js Sitemap: https://site.ru/sitemap.xml

Не могу сказать, что это лучший вариант для блогов на ВП. Но во всяком случае, он лучше, чем то, что нам предлагает Yoast SEO по умолчанию.

Но во всяком случае, он лучше, чем то, что нам предлагает Yoast SEO по умолчанию.

Расширенный Robots.txt для WordPress

Теперь посмотрим на расширенную версию Robots.txt для WordPress. Наверняка вы знаете, что все сайты на WP имеют одинаковую структуру. Одинаковые названия папок, файлов и т.д. позволяют специалистам выявить наиболее приемлемый вариант роботса.

Читайте также: Самые лучшие SEO-оптимизированные шаблоны для WordPress

В этой статье я хочу представить вам свой вариант Robots.txt. Его я использую как для своих сайтов, так и для клиентских. Вы могли видеть такой вариант и на других сайтах, т.к. он обладает некоторой популярностью.

Итак, правильный Robots.txt для WordPress выглядит следующим образом:

User-agent: * # Для всех поисковых систем, кроме Яндекса и Гугла Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ # Закрываем метки Disallow: /readme.html # Закрываем бесполезный мануал по установке WordPress (лежит в корне) Disallow: *?replytocom Allow: */uploads User-agent: GoogleBot # Для Гугла Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ # Закрываем метки Disallow: /readme.html Disallow: *?replytocom Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php User-agent: Yandex # Для Яндекса Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.

php Disallow: /tag/ # Закрываем метки Disallow: /readme.html Disallow: *?replytocom Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign Clean-Param: openstat Sitemap: https://site.com/sitemap_index.xml # Карта сайта, меняем site.com на нужный адрес.

Ранее в Robots.txt использовалась директива Host. Она указывала главное зеркало сайта. Теперь это делается при помощи редиректа. Подробнее об этом можно почитать в блоге Яндекса.

Комментарии (текст после #) можно удалить. Указываю Sitemap с https протоколом, т.к. большинство сайтов сейчас используют защищенное соединение. Если у вас нет SSL, то измените протокол на http.

Читайте также: Как правильно настроить WordPress

Обратите внимание на то, что я закрываю метки (теги). Делаю это потому, что они создают большое количество дублей. Это плохо сказывается на SEO, но если вы хотите открыть метки, тогда уберите строчку disallow: /tag/ из файла.

Это плохо сказывается на SEO, но если вы хотите открыть метки, тогда уберите строчку disallow: /tag/ из файла.

Заключение

В общем-то, вот так выглядит правильный Robots.txt для WordPress. Смело копируйте данные в файл и пользуйтесь. Отмечу, что этот вариант подходит только для стандартных информационных сайтов.

В других ситуациях может потребоваться индивидуальная проработка. На этом все. Спасибо за внимание. Буду благодарен, если вы подпишитесь на мой телеграм-канал и мою группу ВК.

Видео на десерт: Фермер Хотел Найти Воду, но То Что Случилось Удивило Весь Мир

( 30 оценок, среднее 5 из 5 )

Как создать правильный Robots txt для WordPress

Чтобы помочь поисковым системам правильно индексировать ваш блог, нужно сделать правильный файл Robots txt для WordPress. Посмотрим как его создать и чем наполнить.

Посмотрим как его создать и чем наполнить.

Что дает Robots.txt?

Он нужен для поисковых систем, для правильной индексации ими веб-ресурса. Содержимое файла “говорит” поисковому роботу, какие страницы нужно показывать в поиске, а какие скрыть. Это позволяет управлять контентом в поисковой выдаче.

Например, при запросе в Гугле “купить холодильник” конечному покупателю незачем попадать на страницу администрирования магазина. Ему важно перейти сразу в раздел “Холодильники”.

Наполнять robots.txt нужно уже на этапе разработки сайта. Его изменения вступают в силу не сразу. Может пройти неделя или несколько месяцев.

Где находится Robots?

Этот обычный тестовый файл лежит в корневом каталоге сайта. Его можно получить по адресу

https://site.ru/robots.txt

Движок изначально Роботс не создает. Это нужно делать вручную или пользоваться инструментами, которые создают его автоматически.

Не могу найти этот файл

Если по указанному адресу содержимое файл отображается, но на сервере его нет, то значит он создан виртуально. Поисковику все равно. Главное, чтобы он был доступен.

Поисковику все равно. Главное, чтобы он был доступен.

Из чего состоит

Из 4 основных директив:

- User-agent — правила поисковым роботам.

- Disalow — запрещает доступ.

- Allow — разрешает.

- Sitemap — полный URL-адрес карты XML.

Правильный robots.txt для ВордПресс

Вариантов много. Инструкции на каждом сайте отличаются.

Вот пример корректного robots.txt, в котором учтены все разделы сайта. Коротко разберем директивы.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /license.txt

Disallow: /readme.html

Disallow: /trackback/

Disallow: /comments/feed/

Disallow: /*?replytocom

Disallow: */feed

Disallow: */rss

Disallow: /author/

Disallow: /?

Disallow: /*?

Disallow: /?s=

Disallow: *&s=

Disallow: /search

Disallow: *?attachment_id=

Allow: /*. css

css

Allow: /*.js

Allow: /wp-content/uploads/

Allow: /wp-content/themes/

Allow: /wp-content/plugins/

Sitemap: https://site.ru/sitemap_index.xml

В первой строке указывается, что ресурс доступен для всех поисковых роботов (краулеров).

Allow разрешают добавлять в индекс скрипты, стили, файлы загрузок, тем и плагинов.

Последняя – это адрес XML-карты.

Как создать robots.txt для сайта

Рассмотрим несколько методов: вручную и с помощью WordPress-плагинов.

Вручную

Это можно сделать например, в Блокноте (если локальный сервер) или через FTP-клиент (на хостинге).

Вручную добавить robots.txt на сайт проще всего по FTP. Для этого необходимо создать сам файл в текстовом формате. Затем, воспользовавшись одним из FTP-клиентов (например, FileZilla), загрузить robots.txt в корневую папку сайта (рядом с файлами wp-config.php, wp-settings.php).

После успешной загрузки robots. txt, перейдите по адресу

txt, перейдите по адресу https://ваш_сайт.ru/robots.txt, чтобы посмотреть актуальное состояние файла.

С помощью плагинов

Для облегчения создания robots.txt в WordPress существуют специальные плагины. Некоторые из них: WordPress Robots.txt File, DL Robots.txt, Yoast SEO, All in One SEO Pack.

Clearfy Pro

Clearfy Pro создает виртуальный файл. Для этого:

- Перейдите в админ-меню Clearfy Pro.

- На вкладке SEO задействуйте опцию Создать правильный robots.txt.

- Он создастся автоматически. При желании отредактируйте в поле здесь же.

- Сохраните изменения.

Всегда можно отредактировать содержимое Robots. Просто измените/дополните его нужным содержимым и сохраните изменения.

Активировать промокод на 15%

Yoast SEO

Рассмотрим создание файла robots.txt на примере одного из самых мощных SEO-плагинов Yoast SEO.

Этот мощный СЕО-модуль для WP также решит задачу.

- Перейдите SEO > Инструменты.

- Нажмите Редактор файлов.

- Если в корневом каталоге этого файла нет, кликните Создать файл robots.txt. В редакторе вставьте вышеописанный код и нажмите Сохранить изменения в robots.txt.

Если есть, то откроется редактор для внесения изменений. - Нажмите Сохранить изменения в robots.txt.

All in One SEO Pack

Это решение тоже “умеет” работать с Robots. Для этого:

- Откройте All in One SEO > Модули.

- Выберите одноименное название модуля и нажмите Activate.

- Перейдите All in One SEO > Robots.txt.

- В полях добавьте директивы.

Настройка для интернет-магазинов (WooCommerce)

Для WordPress-ресурсов с использованием этого расширения просто добавьте эти правила:

Disallow: /cart/ Disallow: /checkout/ Disallow: /*add-to-cart=* Disallow: /my-account/

Нажмите, пожалуйста, на одну из кнопок, чтобы узнать понравилась статья или нет.

Настройка robots.txt для SEO [АйТи бубен]

Файл robots.txt или индексный файл — обычный текстовый документ в кодировке UTF-8, действует для протоколов http, https, а также FTP.

robots.txt — файл ограничения доступа к содержимому роботам на Методы и структура протокола HTTP- сервере. Файл должен находиться в корне сайта (т.е. иметь путь относительно имени сайта /robots.txt). При наличии нескольких субдоменов файл должен располагаться в корневом каталоге каждого из них. Данный файл дополняет стандарт Sitemaps, который служит прямо противоположной цели: облегчать роботам доступ к содержимому.

Обязательно ли использовать на сайте файл robots.txt? Использование файла добровольно. Когда робот Googlebot посещает сайт, сначала он пытается найти файл robots.txt. Отсутствие файла robots.txt, метатегов robots или HTTP-заголовков X-Robots-Tag обычно не влияет на нормальное сканирование и индексирование сайта.

Стандарт был принят консорциумом 30 января 1994 года в списке рассылки [email protected] и с тех пор используется большинством известных поисковых машин.

Файл robots.txt используется для частичного управления индексированием сайта поисковыми роботами. Этот файл состоит из набора инструкций для поисковых машин, при помощи которых можно задать файлы, страницы или каталоги сайта, которые не должны индексироваться. Файл robots.txt может использоваться для указания расположения файла и может показать, что именно нужно, в первую очередь, проиндексировать поисковому роботу.

Файл состоит из записей. Записи разделяются одной или более пустых строк (признак конца строки: символы CR, CR+LF, LF). Каждая запись содержит непустые строки следующего вида:

<поле>:<необязательный пробел><значение><необязательный пробел>

где поле — это либо User-agent, либо Disallow.

Сравнение производится методом простого поиска подстроки. Например, запись Disallow: /about запретит доступ как к разделу http://example.com/about/, так и к файлу http://example.com/about.php, а запись Disallow: /about/ — только к разделу http://example.com/about/.

Например, запись Disallow: /about запретит доступ как к разделу http://example.com/about/, так и к файлу http://example.com/about.php, а запись Disallow: /about/ — только к разделу http://example.com/about/.

На сайте может быть только один файл «/robots.txt». Например, не следует помещать файл robots.txt в пользовательские поддиректории – все равно роботы не будут их там искать. Что такое ссылка URL -ы чувствительны к регистру, и название файла «/robots.txt» должно быть написано полностью в нижнем регистре.

Запрет доступа всех роботов ко всему сайту в файле robots.txt — это и есть закрытие от индексирования сайта

User-agent: * Disallow: /

Но директивы которые прописываются в robots.txt это рекомендации поисковому роботу, а не строгие правила. Известны случаи когда сайт закрытый в robots.txt попадал в индекс.

Поэтому добавляем в мета-тег в раздел head.

<meta name="robots" content="noindex, nofollow"/>

Вот теперь мы точно закрыли сайт от индексирования! Удачно вам выпасть из индекса!

User-agent: googlebot Disallow: /private/

robots.

txt для DokuWiki и Яндекса

txt для DokuWiki и ЯндексаРазрешить доступ всех роботов ко всему сайту

- robots.txt

User-agent: * Allow: /

Официальное руководство Google рекомендует:

Для временной приостановки сканирования всех URL следует отобразить для них код ответа HTTP 503 (в том числе и для файла robots.txt). Робот Google будет периодически пытаться получить доступ к файлу robots.txt до тех пор, пока он не станет вновь доступен. Не рекомендуется запрещать сканирование путем внесения изменений в файл robots.txt.

Для проверки синтаксиса и структуры файла robots.txt существует ряд специализированных онлайн-служб.

Служба Яндекса (выполняет только проверку синтаксиса) (рус.)

Google webmasters tools (позволяет проверить разрешения для каждой отдельной страницы) (рус.)

Существует специализированная поисковая система BotSeer, которая позволяет осуществлять поиск по файлам robots. txt.

txt.

Он достаточно сложный и лучше его использовать в образовательных целях. Я обычно использую более простой вариант robots.txt.

Не забудьте заменить your_domen на имя вашего домена

- robots.txt

User-agent: * Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /wp-admin Disallow: /shop Disallow: /?s= Disallow: /cgi-bin Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */feed Disallow: */feed/* Disallow: /*?* Allow: /wp-content/uploads/ Allow: /wp-content/*.js$ Allow: /wp-content/*.css$ Allow: /wp-includes/*.js$ Allow: /wp-includes/*.css$ Allow: /wp-content/themes/*.css Allow: /wp-content/plugins/*.css Allow: /wp-content/uploads/*.css Allow: /wp-content/themes/*.js Allow: /wp-content/plugins/*.js Allow: /wp-content/uploads/*.js Allow: /wp-includes/css/ Allow: /wp-includes/js/ Allow: /wp-includes/images/ Allow: /wp-content/uploads/ Allow: /wp-admin/admin-ajax.php User-agent: Yandex Disallow: /wp-login.

php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /wp-admin

Disallow: /shop/

Disallow: /?s=

Disallow: /cgi-bin

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed

Disallow: */feed/*

Disallow: /*?*

Allow: /wp-content/uploads/

Allow: /wp-content/*.js$

Allow: /wp-content/*.css$

Allow: /wp-includes/*.js$

Allow: /wp-includes/*.css$

Allow: /wp-content/themes/*.css

Allow: /wp-content/plugins/*.css

Allow: /wp-content/uploads/*.css

Allow: /wp-content/themes/*.js

Allow: /wp-content/plugins/*.js

Allow: /wp-content/uploads/*.js

Allow: /wp-includes/css/

Allow: /wp-includes/js/

Allow: /wp-includes/images/

Allow: /wp-content/uploads/

Allow: /wp-admin/admin-ajax.php

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: YandexImages

Allow: /wp-content/uploads/

Host: https://your_domen/

Sitemap: https://your_domen/sitemap_index.xml

php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /wp-admin

Disallow: /shop/

Disallow: /?s=

Disallow: /cgi-bin

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed

Disallow: */feed/*

Disallow: /*?*

Allow: /wp-content/uploads/

Allow: /wp-content/*.js$

Allow: /wp-content/*.css$

Allow: /wp-includes/*.js$

Allow: /wp-includes/*.css$

Allow: /wp-content/themes/*.css

Allow: /wp-content/plugins/*.css

Allow: /wp-content/uploads/*.css

Allow: /wp-content/themes/*.js

Allow: /wp-content/plugins/*.js

Allow: /wp-content/uploads/*.js

Allow: /wp-includes/css/

Allow: /wp-includes/js/

Allow: /wp-includes/images/

Allow: /wp-content/uploads/

Allow: /wp-admin/admin-ajax.php

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: YandexImages

Allow: /wp-content/uploads/

Host: https://your_domen/

Sitemap: https://your_domen/sitemap_index.xml

Используешь WordPress? Я тебе рекомендую использовать этот супер-мега-функциональный плагин в том числе и для создания robots. txt

txt

Директива host уже не нужна! 12 марта 2018 года Яндекс в своем блоге для вебмастеров анонсировал скорое прекращение поддержки директивы Host, а уже 20 марта констатировал сей факт, сопроводив его новыми подробными инструкциями по переезду с помощью 301-го редиректа.

Яндекс наконец-то хоть как-то унифицирует свою деятельность, а то достал своими заморочками.

- robots.txt

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /*? Disallow: /?s= Allow: /*.css Allow: /*.js Sitemap: https://catsplanet.club/sitemap_index.xml

Файл robots.txt WordPress… Что это такое и для чего он нужен

Задумывались ли вы когда-нибудь, что такое файл robots.txt и для чего он? Robots.txt используется для связи с поисковыми роботами (известными как боты), используемыми Google и другими поисковыми системами. Он сообщает им, какие части вашего сайта индексировать, а какие игнорировать. Таким образом, файл robots.txt может помочь (или потенциально сломать!) ваши усилия по SEO. Если вы хотите, чтобы ваш веб-сайт хорошо ранжировался, важно хорошо понимать robots.txt!

Он сообщает им, какие части вашего сайта индексировать, а какие игнорировать. Таким образом, файл robots.txt может помочь (или потенциально сломать!) ваши усилия по SEO. Если вы хотите, чтобы ваш веб-сайт хорошо ранжировался, важно хорошо понимать robots.txt!

Где находится robots.txt?

WordPress обычно запускает так называемый «виртуальный» файл robots.txt, что означает, что он недоступен через SFTP. Однако вы можете просмотреть его основное содержимое, перейдя по адресу yourdomain.com/robots.txt. Вероятно, вы увидите что-то вроде этого:

User-agent: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

В первой строке указывается, к каким ботам будут применяться правила. В нашем примере звездочка означает, что правила будут применяться ко всем ботам (например, от Google, Bing и так далее).

Вторая строка определяет правило, запрещающее ботам доступ к папке /wp-admin, а третья строка указывает, что ботам разрешено анализировать файл /wp-admin/admin-ajax. php.

php.

Добавление собственных правил

Для простого веб-сайта WordPress правил по умолчанию, применяемых WordPress к файлу robots.txt, может быть более чем достаточно. Однако, если вы хотите больше контроля и возможность добавлять свои собственные правила, чтобы дать более конкретные инструкции роботам поисковых систем о том, как индексировать ваш веб-сайт, вам нужно будет создать свой собственный физический файл robots.txt и поместить его в корень. каталог вашей установки.

Есть несколько причин, по которым может потребоваться перенастроить файл robots.txt и определить, что именно этим ботам будет разрешено сканировать. Одна из основных причин связана со временем, затрачиваемым ботом на сканирование вашего сайта. Google (и другие) не позволяют ботам проводить неограниченное время на каждом веб-сайте… с триллионами страниц им приходится применять более тонкий подход к тому, что их боты будут сканировать, а что проигнорируют в попытке извлечь наиболее полезную информацию. о веб-сайте.

о веб-сайте.

Разместите свой сайт с Pressidium

60-ДНЕВНАЯ ГАРАНТИЯ ВОЗВРАТА ДЕНЕГ

ПОСМОТРЕТЬ НАШИ ПЛАНЫКогда вы разрешаете ботам сканировать все страницы вашего веб-сайта, часть времени сканирования тратится на страницы, которые не являются важными или даже релевантными. Это оставляет им меньше времени, чтобы проработать наиболее важные области вашего сайта. Запрещая доступ ботов к некоторым частям вашего веб-сайта, вы увеличиваете время, доступное ботам для извлечения информации из наиболее важных частей вашего сайта (которые, как мы надеемся, в конечном итоге будут проиндексированы). Поскольку сканирование происходит быстрее, Google с большей вероятностью повторно посетит ваш веб-сайт и обновит индекс вашего сайта. Это означает, что новые сообщения в блогах и другой свежий контент, скорее всего, будут индексироваться быстрее, что является хорошей новостью.

Примеры редактирования файла robots.txt

В файле robots.txt достаточно места для настройки. Поэтому мы предоставили ряд примеров правил, которые можно использовать для определения того, как боты индексируют ваш сайт.

Поэтому мы предоставили ряд примеров правил, которые можно использовать для определения того, как боты индексируют ваш сайт.

Разрешение или запрещение ботов

Во-первых, давайте посмотрим, как мы можем ограничить конкретного бота. Для этого все, что нам нужно сделать, это заменить звездочку (*) на имя пользовательского агента бота, который мы хотим заблокировать, например «MSNBot». Полный список известных пользовательских агентов доступен здесь.

Агент пользователя: MSNBot Disallow: /

Прочерк во второй строке ограничит доступ бота ко всем директориям.

Чтобы позволить только одному боту сканировать наш сайт, мы будем использовать двухэтапный процесс. Сначала мы бы сделали этого бота исключением, а затем запретили бы всех ботов следующим образом:

User-agent: Google Запретить: Пользовательский агент: * Disallow: /

Чтобы разрешить доступ всем ботам ко всему контенту добавляем эти две строчки:

User-agent: * Запретить:

Тот же эффект можно получить, просто создав файл robots. txt и оставив его пустым.

txt и оставив его пустым.

Блокировка доступа к определенным файлам

Хотите запретить ботам индексировать определенные файлы на вашем веб-сайте? Это просто! В приведенном ниже примере мы запретили поисковым системам доступ ко всем файлам .pdf на нашем веб-сайте.

Агент пользователя: * Disallow: /*.pdf$

Символ «$» используется для обозначения конца URL-адреса. Поскольку это чувствительно к регистру, файл с именем my.PDF все равно будет просканирован (обратите внимание на CAPS).

Сложные логические выражения

Некоторые поисковые системы, такие как Google, понимают использование более сложных регулярных выражений. Однако важно отметить, что не все поисковые системы могут понимать логические выражения в файле robots.txt.

Одним из примеров этого является использование символа $. В файлах robots.txt этот символ указывает на конец URL-адреса. Итак, в следующем примере мы заблокировали поисковым ботам чтение и индексацию файлов, оканчивающихся на . php

php

Это означает, что /index.php нельзя индексировать, но /index.php?p=1 можно. Это полезно только в очень специфических обстоятельствах и должно использоваться с осторожностью, иначе вы рискуете заблокировать доступ бота к файлам, которые вы не хотели!

Вы также можете установить разные правила для каждого бота, указав правила, которые применяются к ним индивидуально. Приведенный ниже пример кода ограничит доступ к папке wp-admin для всех ботов и в то же время заблокирует доступ ко всему сайту для поисковой системы Bing. Вам не обязательно это делать, но это полезная демонстрация того, насколько гибкими могут быть правила в файле robots.txt.

Агент пользователя: * Запретить: /wp-admin/ Агент пользователя: Bingbot Disallow: /

XML-карты сайта

XML-карты сайта действительно помогают поисковым роботам понять структуру вашего сайта. Но чтобы быть полезным, боту нужно знать, где находится карта сайта. «Директива карты сайта» используется для того, чтобы сообщить поисковым системам, что а) карта вашего сайта существует и б) где ее можно найти.

Карта сайта: http://www.example.com/sitemap.xml Пользовательский агент: * Disallow:

Вы также можете указать несколько местоположений карты сайта:

Карта сайта: http://www.example.com/sitemap_1.xml Карта сайта: http://www.example.com/sitemap_2.xml Пользователь-агент:* Disallow

Bot Crawl Delays

Еще одна функция, которую можно реализовать с помощью файла robots.txt, — указать ботам «замедлить» сканирование вашего сайта. Это может быть необходимо, если вы обнаружите, что ваш сервер перегружен высоким уровнем трафика ботов. Для этого вы должны указать пользовательский агент, который вы хотите замедлить, а затем добавить задержку.

Агент пользователя: BingBot Запретить: /wp-admin/ Задержка сканирования: 10

Цифра в кавычках (10) в этом примере означает задержку между сканированием отдельных страниц вашего сайта. Итак, в приведенном выше примере мы попросили бота Bing делать паузу в десять секунд между каждой страницей, которую он сканирует, тем самым давая нашему серверу немного передышки.

Единственная плохая новость об этом конкретном правиле robots.txt заключается в том, что бот Google его не соблюдает. Однако вы можете приказать их ботам замедлить работу из консоли поиска Google.

Примечания к правилам robots.txt:

- Все правила robots.txt чувствительны к регистру. Введите внимательно!

- Убедитесь, что перед командой в начале строки нет пробелов.

- Изменения, внесенные в robots.txt, могут быть отмечены ботами в течение 24-36 часов.

Как протестировать и отправить файл robots.txt для WordPress

Когда вы создали новый файл robots.txt, стоит проверить, нет ли в нем ошибок. Вы можете сделать это с помощью Google Search Console.

Во-первых, вам нужно будет указать свой домен (если у вас еще нет учетной записи Search Console для настройки веб-сайта). Google предоставит вам запись TXT, которую необходимо добавить в ваш DNS, чтобы подтвердить ваш домен.

После того, как это обновление DNS будет распространено (чувство нетерпения… попробуйте использовать Cloudflare для управления вашим DNS), вы можете посетить тестер robots. txt и проверить, есть ли какие-либо предупреждения о содержимом вашего файла robots.txt.

txt и проверить, есть ли какие-либо предупреждения о содержимом вашего файла robots.txt.

Еще одна вещь, которую вы можете сделать, чтобы проверить, дают ли установленные вами правила желаемый эффект, — это использовать тестовый инструмент robots.txt, такой как Ryte.

Вы просто вводите свой домен и выбираете пользовательский агент на панели справа. После отправки вы увидите свои результаты.

Заключение

Знание того, как использовать robots.txt, — еще один полезный инструмент в вашем наборе инструментов разработчика. Если единственное, что вы вынесете из этого руководства, — это возможность проверить, что ваш файл robots.txt не блокирует ботов, таких как Google (что вам вряд ли захочется делать), то это неплохо! Точно так же, как вы можете видеть, robots.txt предлагает целый ряд дополнительных средств контроля над вашим веб-сайтом, которые могут однажды пригодиться.

Разместите свой веб-сайт WordPress с помощью Pressidium!

Посмотреть наши тарифные планыКак получить доступ и изменить Robots.

txt в WordPress (Руководство)

txt в WordPress (Руководство)Обновлено: 10 августа 2022 г.

В этом кратком руководстве я покажу вам, как создавать, получать и изменить robots.txt в WordPress четырьмя простыми способами.

Если вы серьезно относитесь к своему веб-сайту (и особенно если у вас большой веб-сайт), вам обязательно нужно контролировать его файл robots.txt. К счастью, с веб-сайтами WordPress это довольно легко сделать.

Позвольте мне показать вам 4 простых способа доступа и изменения файла robots.txt в WordPress.

Основная информация о файле robots.txt

4 способа получить доступ к robots.txt в WordPress

#1: Используйте SEO-плагин

#2: Используйте специальный плагин robots.txt

#3: Доступ к robots.txt через cPanel на вашем хостинге

#4: Используйте FTP для доступа к robots. txt

txt

Как протестировать файл robots.txt на вашем сайте

Основная информация о файле robots.txt

Robots.txt — это файл, информирующий роботов поисковых систем о страницах или файлах, которые следует или не следует сканировать.

- Файл robots.txt предназначен для защиты веб-сайта от перегрузки запросами поисковых роботов (см. мое полное руководство по оптимизации краулингового бюджета ).

- Файл robots.txt не является способом заблокировать веб-страницы или файлы от индексации и появления в результатах поиска. Вот напоминание от Google:

- Сканеры поисковых систем всегда начинают сканирование вашего сайта с проверки директив в robots.txt .

- Поисковые системы должны, но не всегда, соблюдать директивы, содержащиеся в robots.txt (Google делает).

- Большинство сканеров веб-сайтов позволяют настроить их так, чтобы они либо игнорировали, либо учитывали файл robots.

txt.

txt.

Если вам нужно небольшое напоминание, вот некоторая основная техническая информация о robots.txt :

- Единственным правильным расположением robots.txt является корень (основной каталог) веб-сайта. Это относится к любому веб-сайту, независимо от того, является ли он веб-сайтом WordPress.

- Один веб-сайт (один домен) может иметь только один файл robots.txt .

- Единственным допустимым именем файла является robots.txt .

- Robots.txt должен быть текстовым файлом в кодировке UTF-8.

Имея это в виду, расположение robots.txt WordPress такое же, как и для любого другого веб-сайта. Это корень сайта.

В случае моего веб-сайта это https://seosly.com/robots.txt.

Так выглядит файл robots.txt WordPress по умолчанию.Имейте в виду, что:

- Если у вас есть веб-сайт, доступный на разных языках, и определенные языки помещаются в разные папки, например.

seosly.com/pl/ , тогда у вас будет один файл robots.txt для всех языковых версий.

seosly.com/pl/ , тогда у вас будет один файл robots.txt для всех языковых версий. - Если у вас есть разные поддомены или разные домены для разных языковых версий, например seosly.pl , то для каждой языковой версии будет свой файл robots.txt.

Преимущество WordPress в том, что он позволяет вам получить доступ к вашему robots.txt несколькими различными способами, даже если у вас нет FTP-доступа.

☝️ Если вы хотите узнать больше о файле robots.txt, о том, как он работает и что это такое, обязательно ознакомьтесь с введение в robots.txt в Google Search Central.

4 способа доступа к файлу robots.txt в WordPress

А вот четыре способа доступа и изменения файла robots.txt на вашем сайте WordPress

#1: Используйте плагин SEO

Существует множество плагинов SEO для WordPress но есть практически только два действительно важных:

- Rank Math

- Yoast SEO

Существует также All in One SEO , но я не большой поклонник этого плагина. Все эти SEO-плагины позволяют легко получать доступ к файлу robots.txt и изменять его.

Все эти SEO-плагины позволяют легко получать доступ к файлу robots.txt и изменять его.

Доступ к robots.txt с помощью Rank Math

Если вы используете Rank Math, вот что вам нужно сделать:

- Войдите в панель управления WordPress как администратор. Обратите внимание, что только администраторы могут изменять плагины.

- Перейти к Rank Math SEO .

- На левой боковой панели под Rank Math вы увидите различные настройки Rank Math. Нажмите Общие настройки с.

- Теперь вы увидите список общих настроек SEO. Нажмите Изменить robots.txt .

- Если вы ничего не сделаете, Rank Math автоматически обработает robots.txt, как показано на скриншоте ниже.

- Если вы хотите изменить robots.txt, просто начните вводить текст в текстовое поле и нажмите Сохранить изменения .

- Если вы не уверены, что вставить в robots.

txt или делаете что-то не так, просто нажмите Опции сброса .

txt или делаете что-то не так, просто нажмите Опции сброса .

Это все для Rank Math и robots.txt.

Доступ к robots.txt с помощью Yoast SEO

Вот что нужно делать, если вы используете Yoast SEO:

- Войдите в панель управления WordPress как администратор. Помните, что только администраторы могут изменять настройки плагина.

- Перейти к SEO .

- На левой боковой панели вы увидите пару настроек под SEO . Нажмите на Инструменты .

- Щелкните Редактор файлов.

- Теперь вы можете изменить файл robots.txt.

- Когда вы закончите, просто нажмите Сохранить изменения в robots.txt.

Для большинства веб-сайтов WordPress подойдут эти два метода с использованием этих двух плагинов SEO. Но есть и другие способы.

#2: Используйте специальный плагин robots.txt

Существует также множество различных плагинов WordPress, созданных специально для того, чтобы вы могли редактировать robots. txt.

txt.

Here are the most popular robots.txt WordPress plugins you might want to check:

- Virtual Robots.txt

- WordPress Robots.txt optimization

- Robots.txt Editor

Each one позволяет легко получать доступ к файлу robots.txt и изменять его. Ниже приведены быстрые шаги, которые необходимо предпринять для доступа к файлу robots.txt с помощью этих 3 плагинов WordPress.

❗ Обратите внимание, что некоторые плагины создают файл robots.txt, который помещается в корень вашего сайта, а другие создают его динамически. Если robots.txt создается динамически, то вы не найдете его в корневом каталоге вашего сайта (например, через FTP).

❗ Не используйте одновременно несколько плагинов robots.txt!

Virtual Robots.txt

Вот как использовать плагин Virtual Robots.txt:

- Установите и активируйте Virtual Robots.

txt .

txt .

- В панели инструментов WordPress перейдите к Настройки , а затем Virtual Robots.txt .

- Теперь вы можете просматривать файл robots.txt и изменять его. Когда закончите, нажмите Сохранить изменения .

Вот оно!

Better Robots.txt

Этот плагин robots.txt немного отличается от плагинов, которые я показал вам выше. С Better Robots.txt вы не изменяете текстовый файл, а просто настраиваете параметры на удобной панели внутри WordPress.

Вот что нужно:

- Установить и активировать Better Robots.txt. Плагин также называется Оптимизация WordPress Robots.txt.

- Предоставьте подключаемому модулю необходимые разрешения.

- Перейдите к Better Robots.txt . Плагин будет доступен на левой боковой панели.

- Теперь вы увидите множество полезных и удобных настроек.

- Плагин также позволяет вручную разрешать или запрещать определенные поисковые роботы.

- Вы также можете изменить некоторые настройки, чтобы защитить свои данные или оптимизировать скорость загрузки.

- Есть и другие интересные настройки, которые предлагает плагин. Я рекомендую проверить тех.

Better Robots.txt позволяет создать полностью настраиваемый файл robots.txt, не касаясь ни строчки кода.

Редактор Robots.txt

Вот как использовать редактор Robots.txt:

- Установите и активируйте Редактор Robots.txt .

- Перейти к Плагины > Установленные плагины в панели инструментов WordPress. Вы также можете получить доступ к файлу robots.txt, выбрав «Настройки» > « Чтение ».

- Щелкните Настройки в разделе Robots.txt Editor.

- Теперь вы можете получить доступ к файлу robots.

txt и редактировать его. Когда вы закончите, нажмите Сохранить изменения .

txt и редактировать его. Когда вы закончите, нажмите Сохранить изменения .

❗ Будьте осторожны и избегайте одновременного использования нескольких редакторов robots.txt. Это действительно может все испортить. Если вы используете SEO-плагин, вам следует использовать только его редактор robots.txt.

#3: Доступ к robots.txt через cPanel на вашем хостинге

Здесь я покажу вам, как загрузить robots.txt в WordPress без доступа по FTP.

Вы также можете использовать cPanel вашего хостинга для создания или изменения файла robots.txt.

Обратите внимание, что некоторые плагины, показанные выше, динамически создают файл robots.txt. Это означает, что вы не сможете найти файл в корневом каталоге вашего сайта.

❗ Если вы используете плагин для создания и управления robots.txt, вам не следует пытаться вручную добавить новый robots.txt с помощью cPanel или FTP (ниже).

Однако, если вы не полагаетесь на эти плагины, вы можете вручную создать и обновить файл robots. txt на своем веб-сайте WordPress.

txt на своем веб-сайте WordPress.

Вот как это сделать с помощью Bluehost:

- Войдите в cPanel на вашем хостинге.

- Развернуть секцию Дополнительно .

- Нажмите Файловый менеджер .

- Перейдите в корневой каталог вашего веб-сайта.

- Если вы не используете подключаемый модуль, динамически генерирующий robots.txt, вы должны увидеть файл robots.txt в корне.

- Щелкните файл robots.txt и выберите Изменить .

- Теперь вы можете редактировать содержимое файла robots.txt. Когда закончите, нажмите Сохранить изменение s.

Если на вашем сайте нет файла robots.txt, вам необходимо его создать и загрузить.

Вот что нужно сделать:

- Откройте редактор текстовых файлов, например Notepad или Notepad++.

- Создайте файл robots.txt.

- Загрузите файл в основной каталог вашего сайта.

В случае Bluehost вы просто нажимаете Загрузить в файловом менеджере. Просто убедитесь, что вы находитесь в корне.

В случае Bluehost вы просто нажимаете Загрузить в файловом менеджере. Просто убедитесь, что вы находитесь в корне.

Этот метод будет работать как для веб-сайтов WordPress, так и для веб-сайтов, отличных от WordPress.

#4: Используйте FTP для доступа к robots.txt

Здесь я покажу вам, как получить доступ к robots.txt через FTP.

Самый быстрый и самый «профессиональный» способ получить доступ к robots.txt — использовать FTP. Этот метод также работает для любого типа веб-сайтов, включая сайты WordPress.

❗ Я не рекомендую этот метод, если вы используете плагин для автоматического создания robots.txt для вас.

Этот метод аналогичен тому, что вы делаете с помощью cPanel на своем хостинге, за исключением того, что на этот раз вы используете FTP-клиент для доступа к своему веб-сайту.

Чтобы использовать этот метод, вам потребуется имя пользователя и пароль FTP, а также FTP-клиент, например Filezilla .

Вот что вам нужно сделать:

- Подключитесь к вашему сайту через FTP-клиент.

- Перейдите в корневой каталог вашего веб-сайта, если вы еще этого не сделали.

- Загрузите файл robots.txt, если он есть.

- Откройте файл robots.txt в текстовом редакторе, например Notepad++.

- При необходимости измените файл. Сохранить изменения.

- Загрузите файл в корневой каталог. Это перезапишет существующий файл robots.txt.

Если на вашем веб-сайте нет файла robots.txt, вы также можете создать и загрузить его.

Как протестировать файл robots.txt на вашем веб-сайте

Если вы внесли некоторые изменения в robots.txt, я настоятельно рекомендую вам протестировать файл robots.txt, чтобы убедиться, что файл правильный и действительно выполняет свои функции. делать.

Вот что нужно сделать:

- Прочитайте эту короткую статью о , как протестировать файл robots.

txt

txt - Используйте инструмент для тестирования robots.txt (часть Google Search Console) 90

23 90

696 Вот другие руководства, которые могут вас заинтересовать:

- Как проверить Google Search Console через WordPress (3 простых способа)

- Как найти карту сайта (8 разных способов)

- Как найти органический трафик в Google Analytics (и отфильтровать трафик спам-ботов)

- Как добавить и удалить пользователей в Google Search Console

- Как проверить, оптимизирован ли сайт для мобильных устройств (в 5 способов)

Как оптимизировать WordPress Robots.txt для SEO на примере

SEO является главным приоритетом для владельцев веб-сайтов. Поскольку первые пять результатов получают 75% кликов, гонка за более высокий рейтинг была сложной задачей. Существуют различные внестраничные и внутренние методы SEO, которые вступают в игру.

Оптимизация файла Robot.txt — один из тех приемов, которые могут усилить SEO вашего сайта.

Оптимизация файла Robot.txt — один из тех приемов, которые могут усилить SEO вашего сайта.Однако большинство новичков не знают, как оптимизировать WordPress Robots.txt для SEO. Некоторые могут даже не знать, что такое файл robots.txt.

К счастью, эта статья вам в помощь.

Здесь мы объясним, что такое файл robots.txt, как создать файл robots.txt и как оптимизировать файл robots.txt для SEO. Мы также добавили несколько часто задаваемых вопросов в конце. Так что убедитесь, что вы с нами до конца.

Теперь приступим!

Содержание

- Что такое файл robots.txt?

- Как выглядит файл robots.txt?

- Зачем вам нужен файл robots.txt в WordPress?

- Как создать файл robots.txt для вашего веб-сайта?

- Способ 1: Создание файла Robots.txt с помощью плагина Rank Math

- Способ 2: Создание файла Robots.txt с помощью FTP

- Куда поместить файл Robots.txt?

- Как проверить файл robots.txt?

- Плюсы файла robots.

txt

txt - Минусы файла robots.txt

- Часто задаваемые вопросы (FAQ)

- Что такое веб-сканирование?

- Что такое индексация?

- Что такое краулинговый бюджет?

- Заключение

Что такое файл Robots.txt?

Robots.txt в WordPress — это обычный текстовый файл, который информирует роботов поисковых систем, какие страницы вашего сайта следует сканировать и индексировать. Вы также можете отформатировать файл, чтобы исключить страницы из индексации.

Файл robots.txt хранится в корневом каталоге WordPress. Этот файл имеет базовый формат, который выглядит следующим образом:

Агент пользователя: [имя пользователя] Disallow: [URL строки, которую нельзя сканировать] Разрешить: [URL строки для сканирования] Карта сайта: [URL вашей карты сайта WordPress XML]

Как выглядит файл robots.txt?

Файл robots.txt — это всего лишь несколько строк текста, которые указывают поисковым системам, как и что сканировать на вашем сайте.

У вас есть несколько строк в этом файле, чтобы разрешить или ограничить определенные URL-адреса страниц. Вы также можете добавить несколько файлов Sitemap. Если вы запретите URL-адрес, боты поисковых систем не будут сканировать эту страницу.

У вас есть несколько строк в этом файле, чтобы разрешить или ограничить определенные URL-адреса страниц. Вы также можете добавить несколько файлов Sitemap. Если вы запретите URL-адрес, боты поисковых систем не будут сканировать эту страницу.Вот пример файла robots.txt:

User-Agent: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Карта сайта: https://URL/sitemap_index.xml

Теперь давайте узнаем об этих четырех основных терминах, которые вы можете найти в файле robots:

- User-agent : User-agent — это конкретный поисковый робот, к которому вы даете инструкцию обхода. Обычно это поисковая система.

- Разрешить : Разрешить — это команда, которая сообщает роботу Googlebot, что он может получить доступ к странице или вложенной папке, даже если эта вложенная папка или родительская страница могут быть запрещены.

- Disallow : Команда disallow указывает агенту пользователя не сканировать определенный URL-адрес.

Вы можете включить только одну строку «Disallow:» для каждого URL-адреса.

Вы можете включить только одну строку «Disallow:» для каждого URL-адреса.

- Карта сайта : Карта сайта используется для определения местоположения любой карты сайта в формате XML, связанной с этим URL-адресом. Эта команда поддерживается только Google, Bing, Ask и Yahoo.

В приведенном выше примере мы разрешили поисковым ботам сканировать и индексировать папку загрузок, но ограничили папку плагинов. В конце концов, мы разрешили индексацию XML-карты сайта.

Знак звездочки после User-Agent означает, что текст применим ко всем ботам поисковых систем. У каждой поисковой системы есть свой пользовательский агент для индексации сайтов. Вот некоторые пользовательские агенты некоторых популярных поисковых систем:

- Google: Googlebot

- Googlebot Images: Googlebot-Image

- Googlebot News: Googlebot-News

- Googlebot Video: Googlebot-Video

- Yahoo: Slurp Bot

- 6

- Bing: Bingbot

- Amazon Alexa: ia_archiver

- DuckDuckGo: DuckDuckBot

- Яндекс: YandexBot

- Baidu: Baiduspider

- Exalead: ExaBot

В настоящее время существует так много пользовательских агентов.

Если вы хотите сосредоточиться на конкретной поисковой системе, вы даже можете указать ее в файле robots.txt. То есть, чтобы настроить инструкции для робота Googlebot, вы можете написать первую строку файла robots.txt следующим образом:

Если вы хотите сосредоточиться на конкретной поисковой системе, вы даже можете указать ее в файле robots.txt. То есть, чтобы настроить инструкции для робота Googlebot, вы можете написать первую строку файла robots.txt следующим образом: Агент пользователя: Googlebot

Зачем вам нужен файл robots.txt в WordPress?

Поисковые роботы будут сканировать и индексировать ваш сайт, даже если у вас нет файла robots.txt. Итак, зачем вам это действительно нужно? Что ж, с помощью файла robots.txt вы можете указать поисковым системам расставлять приоритеты при индексации определенных страниц. Кроме того, вы можете исключить страницы или папки, которые не хотите индексировать.

Это не оказывает большого влияния, когда вы впервые начинаете вести блог и у вас мало контента. Однако после того, как ваш сайт разрастется и на нем будет много контента, вам может потребоваться установить приоритет индексации определенной страницы/записи/папки и отменить некоторые из них.

Видите ли, для каждого поискового бота есть квота на каждый сайт. Это означает, что боты сканируют определенное количество страниц за определенный сеанс сканирования. Если боты не завершают сканирование в этом конкретном сеансе, бот возвращается и возобновляет сканирование в следующем сеансе. Это замедляет индексацию вашего сайта.

Таким образом, с помощью файла robots.txt вы можете указать поисковым роботам, какие страницы, файлы и папки вы хотите проиндексировать, а какие включить. Тем самым вы сохраняете квоту сканирования. Возможно, это не самый безопасный способ скрыть ваш контент от общественности, но он предотвращает появление исключенного контента в поисковой выдаче.

Как создать robots.txt для вашего сайта?

Вы можете создать файл robots.txt двумя разными способами. Мы объясним эти методы ниже. Затем вы можете следовать методу, который, по вашему мнению, будет работать лучше всего для вас.

Способ 1. Создание файла robots.txt с помощью подключаемого модуля Rank Math

Здесь мы покажем вам, как создать файл robots.

txt с помощью популярного подключаемого модуля Rank Math.

txt с помощью популярного подключаемого модуля Rank Math.Rank Math — это SEO-плагин для WordPress, который упрощает оптимизацию контента вашего веб-сайта с помощью встроенных предложений, основанных на общепринятых передовых методах. С помощью этого удобного инструмента вы можете легко настроить важные параметры SEO и контролировать индексируемые страницы.

Чтобы создать файл robots.txt с помощью плагина Rank Math, сначала загрузите плагин, выбрав Плагины -> Добавить новый на панели администратора WordPress.

Теперь найдите Rank Math в строке поиска и нажмите кнопку Установить сейчас и Активировать после того, как найдете плагин.

После активации плагина перейдите на страницу Rank Math -> General Settings -> Edit robots.txt из панели управления WordPress.

Теперь введите следующий код или скопируйте код из предыдущего примера в пустое место и нажмите кнопку Сохранить изменения .

Ну вот! Вы успешно создали файл robots.txt с помощью подключаемого модуля Rank Math.

Способ 2. Создание файла robots.txt с использованием FTP

Второй метод заключается в создании файла robots.txt вручную на локальном компьютере, а затем его загрузке в корневую папку сайта WordPress.

Вам потребуется доступ к вашему хостингу WordPress с помощью FTP-клиента. После входа в FTP-клиент вы увидите файл robots.txt в корневой папке веб-сайта. Щелкните правой кнопкой мыши и выберите параметр Редактировать .

Теперь добавьте собственное правило в файл и сохраните изменения. Например:

Агент пользователя: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

Если вы не видите файл в корневой папке, вы можете создать его на локальном компьютере с помощью блокнота. Добавьте к нему свои правила, а затем загрузите его в корневую папку с помощью FTP.

Куда поместить файл robots.txt?

Файл robots.

txt всегда следует размещать в корневом каталоге вашего веб-сайта. Например, если ваш сайт domainname.com , то домен вашего файла robots.txt будет https://domainname.com/robots.txt.

txt всегда следует размещать в корневом каталоге вашего веб-сайта. Например, если ваш сайт domainname.com , то домен вашего файла robots.txt будет https://domainname.com/robots.txt. В дополнение к добавлению файла robots.txt в корневую директорию, вот несколько дополнительных советов: