WP Robots Txt — Плагин для WordPress

- Детали

- Отзывы

- Установка

- Разработка

Поддержка

WordPress, by default, includes a simple robots.txt file that’s dynamically generated from within the WP application. This is great! but maybe you want to change the content.

Enter WP Robots Txt, a plugin that adds an additional field to the «Reading» admin page where you can do just that.

Simply visit https://your-site.com/wp-admin/options-reading.php and you can control the contents of your https://your-site.com/robots.txt

Changelog

WP Robots Txt was originally developed by chrisguitarguy. The plugin has been adopted and updated by George Pattihis who will continue development.

- A view of the admin option

- Скачать плагин

- Unzip it

- Upload the unzipped folder to

wp-content/pluginsdirectory - Activate and enjoy!

Or you can simply install it through the admin area plugin installer.

I totally screwed up my `robots.txt` file. How can I restore the default version?

Delete all the content from the Robots.txt Content field and save the privacy options.

Could I accidently block all search bots with this?

Будьте осторожны! Тем не менее, robots.txt файлы — это предложения. На самом деле они не столько блокируют ботов, сколько предполагают, что боты не сканируют части сайта. Вот почему на странице настроек конфиденциальности указано «Попросить поисковые системы не индексировать этот сайт».

Where can I learn more about `robots.txt` files?

Here is a general guide by Google and here is the WordPress SEO documentation.

Ottimo ti basta attivar il plugin

Good code, nice interface.

It doesn’t have builtin dynamic replacement functionality (like, {siteurl}/sitemap_index. xml), but it can be added with a simple filter.

Thanks for the great plugin!

xml), but it can be added with a simple filter.

Thanks for the great plugin!

Simple plugin that helped me to fix a js. problem in Google search

I am using this plugin to overcome my robots.txt problem. This is very useful plugin. http://www.gemstonesprices.in Amethyst Stone

Посмотреть все 17 отзывов«WP Robots Txt» — проект с открытым исходным кодом. В развитие плагина внесли свой вклад следующие участники:

- chrisguitarguy

- George Pattihis

«WP Robots Txt» переведён на 4 языка. Благодарим переводчиков за их работу.

Перевести «WP Robots Txt» на ваш язык.

Заинтересованы в разработке?

Посмотрите код, проверьте SVN репозиторий, или подпишитесь на журнал разработки по RSS.

1.2

- Update the default robots.txt content

- Include sitemap reference

- Resolve code warnings/errors

- WP Coding Standards compliant

- Ensure Compatibility with WP v6

1.

1

1- Moved the settings field «officially» to the reading page

- General code clean up

1.0

- Initial version

Оценки

Посмотреть все- 5 звёзд 16

- 4 звезды 1

- 3 звезды 0

- 2 звезды 0

- 1 звезда 0

Войдите, чтобы оставить отзыв.

Участники

- chrisguitarguy

- George Pattihis

Поддержка

Решено проблем за последние 2 месяца:

1 из 1

Перейти в форум поддержки

Пожертвование

Would you like to support the advancement of this plugin?

Пожертвовать на развитие плагина

Robots txt для WordPress — воспитываем поисковые машины.

Здравствуйте дорогие читатели, мы продолжаем улучшать нашу CMS WordPress. Сегодня хочу затронуть ооочень важный файл, который играет огромную роль в продвижении блога. Как вы наверное уже догадались – это файл “Robots txt для wordpress”.

Все мы когда-нибудь становимся на путь истинный, то есть на начальный этап ведения своих интернет ресурсов, на пути часто встречаются не понятные термины, фразы, файлы и т.п., так вот, файл robots.txt – не исключение.

Когда я начинал вести блог, я понятия не имел, что этот файл собою представляет и зачем он нужен вообще, набравшись опыта, испробовав несколько вариантов настройки, я теперь могу делиться с Вами своим вариантом настройки.

Очень подробно про файл robots.txt можете прочесть в гигантской Википедии.

Robots txt для wordpress – это текстовый файл, который располагается в корневой директории блога, то есть по адресу: http://life-crazy.ru/robots.txt

Он указывает поисковым машинам, какие файлы и папки индексировать, а какие не включать в индекс, а также указывает на наличие файла sitemap. xml.

xml.

Если данного файла у Вас нет, тогда роботы будут индексировать «кушать» все, что попадается им на пути, в том числе и служебные файлы движка, которые в индексе вовсе не нужны, так и не дойдя до свеженького контента.

Можете ознакомиться со статьей «Как ускорить индексацию сайта» — в ней я описывал, зачем нужна быстрая индексация и как влияет robots txt на индексацию.

Давайте приступим непосредственно к созданию файла robots txt для wordpress. Итак, если у вас нет данного файла в корневой директории, не беда, в этом нет ничего страшно, так как вы сейчас все исправите.

Создавайте на рабочем столе обычный текстовый файл. Делается очень просто: жмите ПКМ (правая кнопка мыши) на пустом месте, на рабочем столе, выбирайте пункт «создать» — «текстовый документ» и давайте ему название robots.txt

Должен получиться такой текстовый документ.

Открывайте его двойным щелчком ЛКМ (левая кнопка мыши) и вставляйте следующее:

User-agent: * Disallow: /wp-login. |

Давайте заберем некоторые строки:

Host: — здесь нужно вписать адрес вашего сайта. Если вы пользуетесь адресом с www тогда так и нужно прописывать, если без www, соответственно без него, как показано в примере. Только не забудьте адрес сменить 😉

Если вы пользуетесь адресом с www тогда так и нужно прописывать, если без www, соответственно без него, как показано в примере. Только не забудьте адрес сменить 😉

В строке sitemap, также нужно прописать свой адрес к карте сайта в формате xml.

После внесения всех данных, сохраняйте и закидывайте в корневой каталог блога, еще раз напоминаю, у меня это адрес:

http://life-crazy.ru/robots.txt

Корневой каталог – это папка httpdocs или public_html в него и нужно поместить файл robots.txt.

Вот и все, вы настроили robots.txt для wordpress блога, теперь поисковики будут знать, куда совать нос, а куда нет 🙂

Как вам статья? Жду ваших комментариев.

P.S в связи стремительного развития алгоритмов поисковых систем, данный роботс является НЕ ВЕРНЫМ!!!

Подписывайтесь на обновления блога, и не пропустите выход свежей статьи на тему правильной настройки роботс.

С Уважением, Михед Александр.

WP Robot — лучший плагин для автоблогов WordPress

WP Robot — это плагин для автоблогов и курирования контента , который позволяет автоматически создавать высококачественные посты в блогах WordPress. Благодаря капельной подаче качественного контента, относящегося к любой нише, WP Robot гарантирует, что ваши сайты останутся свежими и обновленными. Даже когда ты спишь.

Благодаря капельной подаче качественного контента, относящегося к любой нише, WP Robot гарантирует, что ваши сайты останутся свежими и обновленными. Даже когда ты спишь.

Благодаря непревзойденной функциональности, отличной поддержке и регулярным обновлениям с момента своего выпуска в 2009 году WP Robot по праву заслужил звание лучший плагин автоблогинга для WordPress . Сегодня программное обеспечение используется на более чем 1 миллионе сайтов WordPress и до сих пор получает регулярные обновления.

Новинка : Выпущен WP Robot 5 — Узнайте больше о нашей последней версии →

Последние обновления 2023 года : Новый модуль OpenAI — используйте всю мощь ChatGPT на своих сайтах WordPress!

Как WP Robot может вам помочь

СОЗДАТЬ совершенно новых автоблога WordPress на PBN или в качестве спутниковых сайтов.

УЛУЧШИТЬ существующих сайта WordPress с помощью соответствующих изображений, видео и другого полезного контента.

МЕНЕТИЗИРУЙТЕ своих сайтов WordPress, публикуя целевые продукты аффилированного маркетинга.

КУРАТИРОВАТЬ привлекательный контент, который хорош для поисковой оптимизации и представляет интерес для ваших читателей.

ИМПОРТ ваших собственных PLR статей, дополняйте их соответствующими фотографиями и планируйте их.

ОБЪЕДИНИТЕ и отобразите отраслевые RSS-каналы, относящиеся к содержимому вашего веб-сайта.

Autopost All The Things

WP Robot поддерживает более 30 отличных источников контента. Все они полностью автоматические и могут смешиваться любым способом, чтобы создавать разнообразный и увлекательный контент на автопилоте. Наши самые популярные модули:

Наши самые популярные модули:

Перейдите сюда, чтобы найти более подробную информацию и просмотреть полный список источников автоблогинга в WP Robot.

Длинный список функций

Пролистайте наш полный список возможностей, если осмелитесь! Вот некоторые из наиболее важных фактов:

WP Robot работает со всеми темами WordPress . Мы создаем контент для вас, тема определяет, как он будет выглядеть в вашем блоге.

Найдите автоматический контент для любой ниши или ключевого слова по вашему выбору. Нет предела вашему творчеству!

Множество из вариантов использования: Независимо от того, хотите ли вы создать автоблог WordPress, публиковать специально подобранный контент или дополнить свой блог целевыми изображениями и рекламой, WP Robot поможет вам!

Капельная подача нового контента в ваш блог с заданными интервалами или массовое добавление множества новых статей одним щелчком мыши. Или сделайте оба!

Или сделайте оба!

Мощные шаблоны, автоматический перевод и интеграция с вращающимся программным обеспечением позволяют создавать автоматическое уникальное содержимое !

Благодаря нашей международной поддержке вы можете использовать WP Robot для автоблогов на немецком, испанском, китайском, русском и многих других языках!

WP Robot постоянно обновляется , и мы следим за тем, чтобы всегда работал с последней версией WordPress . С момента первого выпуска было выпущено более 80 крупных обновлений.

Идеальная команда

WP Robot был создан для идеальной совместной работы с CMS Commander , нашим продуктом для управления несколькими блогами WordPress. WP Robot создает контент для любого количества блогов. CMS Commander помогает вам контролировать, управлять, создавать резервные копии и обновлять все эти блоги.

WP Robot — это плагин для автоматического ведения блогов в собственных блогах WordPress. org . Мы также рекомендуем CMS Commander, если вы хотите вести автоблоги в блогах WordPress.com .

org . Мы также рекомендуем CMS Commander, если вы хотите вести автоблоги в блогах WordPress.com .

Отличный автоблоггинг WordPress

Вы можете подумать, что неоднократно называть WP Robot лучшим плагином автоблогинга — это смелое утверждение, но мы этого не выдумывали. Так нам сказали наши клиенты!

Я использую WP Robot с момента его создания и примерно в 15 различных блогах. Простота использования, обслуживание клиентов и функции, позволяющие экономить время, являются исключительными. Поверьте, я пробую их все, но WP Robot по-прежнему остается моим любимым плагином для автоконтента.

Tom Sunde

Перейдите сюда, чтобы узнать больше хороших отзывов наших пользователей о WP Robot .

Руководство по WordPress robots.txt: что это такое и как его использовать.

Если вы разработчик или имеете опыт работы с веб-сайтами, вы, вероятно, слышали о файле robots. txt .

txt .

robots.txt существует на большинстве веб-сайтов, и его функция состоит в том, чтобы выдавать инструкции для сканеров поисковых систем, таких как Googlebot Googlebot. Этот файл определяет, какие URL-адреса вашего веб-сайта будут сканироваться и индексироваться.

Научиться оптимизировать файл robots.txt вашего веб-сайта — отличный способ повысить общий SEO-рейтинг вашего веб-сайта. Самое приятное то, что вам не нужны глубокие знания в области веб-разработки, чтобы воспользоваться его преимуществами.

Эта статья будет введением в robots.txt. Вы узнаете следующее:

- Что такое robots.txt и каковы преимущества его оптимизации.

- Где находится файл robots.txt в вашей установке WordPress.

- Как редактировать robots.txt.

- Команды, которые вы можете ввести в robots.txt.

- Как проверить, правильно ли работает файл robots.txt.

- Ограничения файла robots.txt.

Давайте углубимся.

Что такое файл robots.

txt?

txt?Robots.txt — это текстовый файл, доступный в папках вашего сайта. Из файла robots.txt; вы можете давать команды, которые сообщают поисковым роботам, к каким ресурсам вашего сайта они могут получить доступ.

Robots.txt позволяет указать, какие каталоги, подкаталоги, URL-адреса или файлы не должны сканироваться поисковыми системами.

Каковы преимущества редактирования файла robots.txt в WordPress?

Основной причиной использования и оптимизации файла robots.txt является получение преимуществ SEO . Оптимизированный файл robots.txt может повысить общий SEO-рейтинг вашего сайта.

Если вы вообще не используете robots.txt, каждая страница вашего сайта может быть просканирована и проиндексирована. Для некоторых это может быть полезно, но на большинстве веб-сайтов есть по крайней мере несколько повторяющихся, пустых или других видов неблагоприятных для SEO страниц.

Рекомендуется предотвращать сканирование этих страниц и их отображение в результатах поиска. Однако robots.txt не мешает поисковому роботу Google (или любому другому) отображать страницы вашего сайта в результатах поиска. Даже если вы заблокируете сканирование страницы с помощью robots.txt, она все равно может отображаться в результатах поиска, если на них есть внутренние или внешние ссылки.

Однако robots.txt не мешает поисковому роботу Google (или любому другому) отображать страницы вашего сайта в результатах поиска. Даже если вы заблокируете сканирование страницы с помощью robots.txt, она все равно может отображаться в результатах поиска, если на них есть внутренние или внешние ссылки.

Если вы хотите, чтобы страница не отображалась в результатах поиска, вам необходимо запретить ее появление в файле robots.txt и вручную запретить ее появление в результатах поиска с помощью менеджера SEO, такого как Yoast SEO.

Оптимизация файла robots.txt поможет поисковым роботам более эффективно исследовать ваш веб-сайт, повысив его общую поисковую оптимизацию.

Оптимизация файла robots.txt улучшает бюджет сканирования

Бюджет сканирования – это количество времени и ресурсов, которые поисковый робот выделяет вашему веб-сайту. Чем выше бюджет, тем больше URL-адресов будет исследовать поисковый робот. Чем меньше бюджет, тем меньше URL-адресов он будет исследовать.

Сканирование и индексирование требует времени и вычислительной мощности, и то, и другое ограничено. В результате вы хотите, чтобы поисковые роботы исследовали только те страницы, которые вы хотите продвигать в поисковых системах, и игнорировали все страницы, которые вы не хотите продвигать.

Оптимизация файла robots.txt выделит высококачественный контент, уменьшит видимость низкокачественного контента (с точки зрения SEO) и предотвратит перегрузку ресурсов вашего сервера слишком большим количеством запросов.

Теперь, когда вы знаете основы файла robots.txt, давайте перейдем к его поиску и редактированию.

Где находится robots.txt в WordPress? Как получить к нему доступ?

WordPress автоматически создает файл robots.txt. Он расположен в корневом домене вашего каталога, и вы можете найти его, зайдя на свою домашнюю страницу и добавив «/robots.txt» в конце URL-адреса. Например, https://wcanvas.com/robots.txt .

Важно: Вы можете только визуализировать файл robots. txt в этом каталоге, но не редактировать его.

txt в этом каталоге, но не редактировать его.

Как редактировать и оптимизировать файл robots.txt в WordPress?

Существуют различные способы редактирования файла robots.txt. Наши разработчики всегда используют один из двух вариантов: использование плагина Yoast SEO или создание текстового файла под названием «роботы» и загрузка его в корневой каталог WordPress.

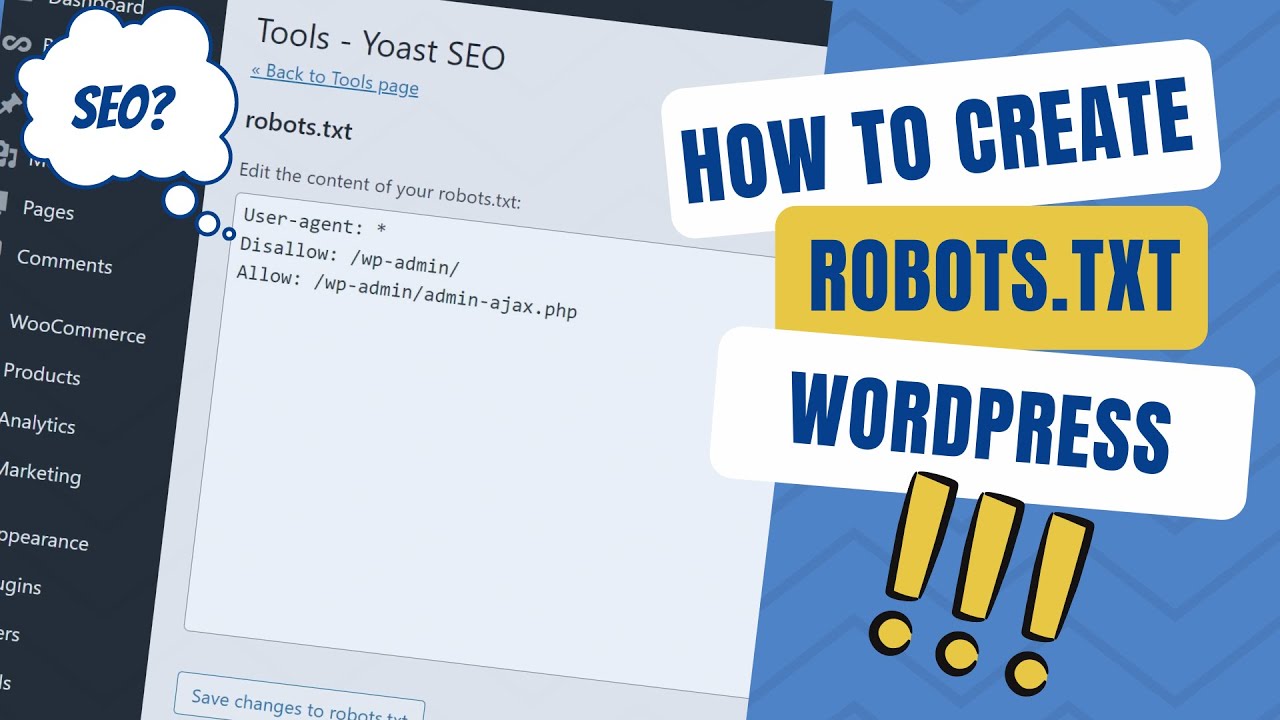

Использование Yoast SEO

Самый простой способ редактирования файла robots.txt — использование плагинов. Наш предпочтительный плагин для этой цели — Yoast SEO. Процесс быстрый и простой.

Во-первых, вы должны активировать расширенные функции плагина. Сделать это можно через админку: Yoast SEO → Особенности . На вкладке «Функции» включите параметр « страниц расширенных настроек ».

После того, как вы включили расширенные настройки, перейдите в Yoast SEO → Инструменты и нажмите Редактор файлов .

У вас будет возможность создать файл robots.txt, если у вас его еще нет.

Теперь вы можете свободно редактировать robots.txt и сохранять изменения.

Создайте файл «robots.txt» и загрузите его в корневой каталог WordPress

В тех редких случаях, когда у нас не было доступа к Yoast SEO, мы создали файл .txt под названием «роботы» и загрузили его в корневой каталог установки WordPress.

Откройте любой текстовый редактор и создайте файл с нужными директивами и синтаксисом.

Мы использовали два основных метода для его загрузки: файловый менеджер cPanel и приложения FTP.

Загрузка robots.txt с помощью cPanel

- Откройте файловый менеджер cPanel и перейдите к истории установки WordPress, обычно public_html .

- На верхней панели инструментов нажмите Загрузить , и теперь файл будет находиться в корневом каталоге.

Загрузка robots.txt с использованием FTP

- Подключитесь к веб-сайту своего веб-сайта с помощью FTP-приложения, например FileZilla.

- Перейдите в свой корневой каталог (опять же, это будет public_html ).

- Просто перетащите файл в корневой каталог.

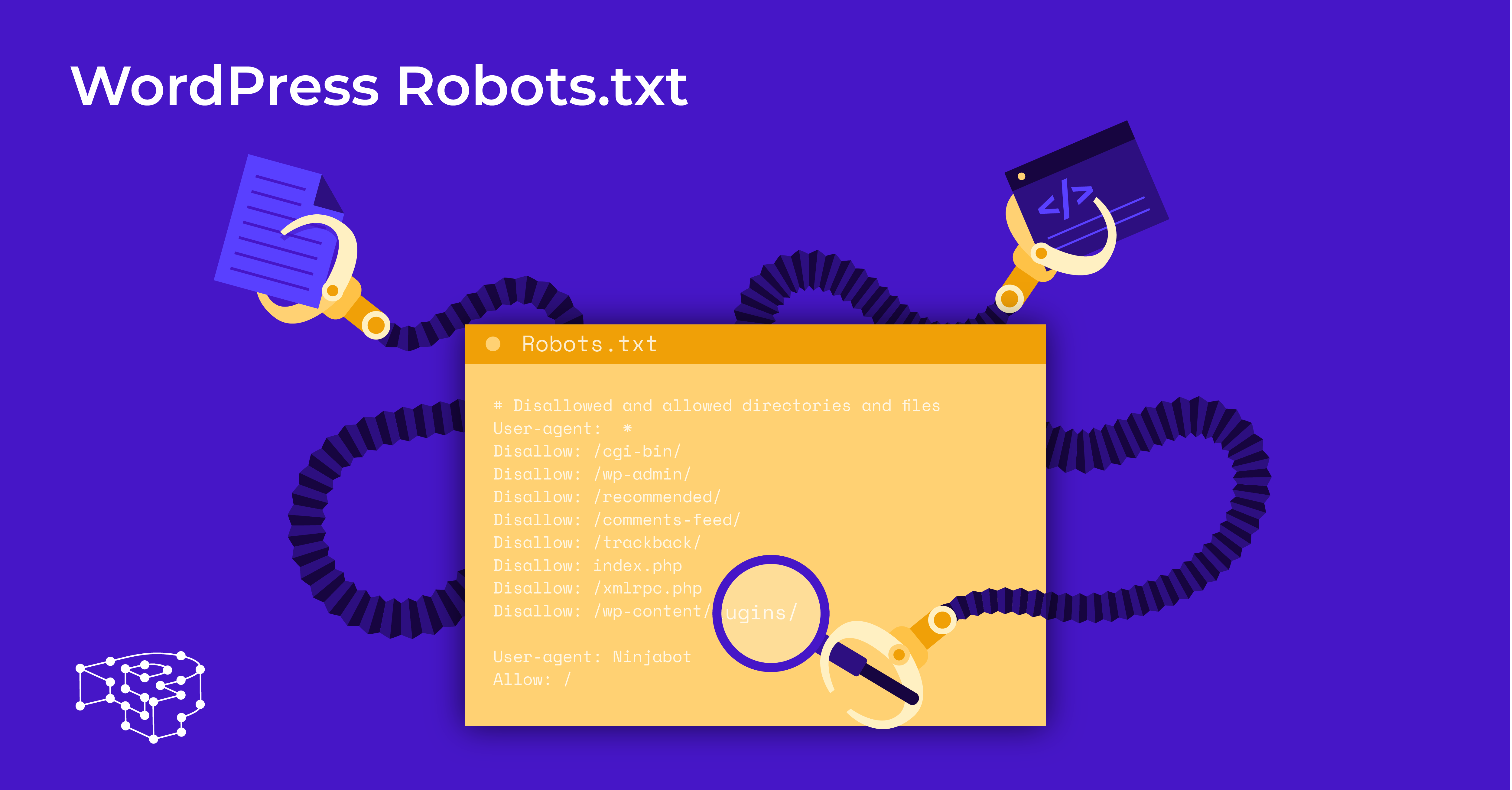

Команды robots.txt

Файл robots.txt содержит инструкции для поисковых роботов, чтобы узнать, какие части вашего сайта следует сканировать. Три основные команды:

- user-agent: относится к роулеру поисковых систем. Цель ваших команд robots.txt — направлять поисковые роботы. Вы можете давать команды, направленные на определенные искатели или на все искатели.

- disallow: указывает пользовательскому агенту не открывать, не сканировать и не индексировать определенный URL-адрес, каталог или подкаталог.

- разрешить: против запретить . Указывает, что контент должен быть доступен, просканирован и проиндексирован.

Помните, что команды allow и disallow будут применяться только к пользовательскому агенту, указанному в строке над ними. Для каждого пользовательского агента может быть включено несколько строк disallow .

Для каждого пользовательского агента может быть включено несколько строк disallow .

Наиболее часто используемые команды в robots.txt

Показания для конкретного бота:

Агент пользователя: [имя бота]

//Пример

Агент пользователя: Googlebot Показания для всех ботов:

User-agent: * Добавить звездочку (*). Любая команда в этой строке применяется ко всем поисковым роботам, которые переходят по ссылкам на вашем веб-сайте.

Разрешить полный доступ ко всем поисковым роботам:

Агент пользователя: *

Disallow: В противном случае это означало бы не использовать файл robots.txt или оставить его пустым.

Заблокировать сканирование и индексацию всего веб-сайта с помощью «/»:

Запретить: / Заблокировать каталог и его содержимое:

Запретить: /directory_name_here/ Заблокировать определенную веб-страницу:

Запретить: /page_address_here Заблокировать все изображения на сайте:

User-agent: *

Запретить: / Заблокировать определенное изображение:

Агент пользователя: Googlebot-Image

Запретить: /image/secret. jpeg

jpeg Заблокировать файл определенного типа:

Агент пользователя: *

Disallow: /*.png$ Изображения .png не будут сканироваться и индексироваться.

Заблокировать последовательность символов звездочкой:

Агент пользователя:

Disallow: /secret-directory*/ Блокировать URL-адреса, оканчивающиеся на определенный набор символов, добавляя символ «$» в конце:

User-agent: *

Disallow: /*.pdf Заблокировать определенного бота:

User-agent: [имя бота]

Disallow: / Разрешить сканирование для определенного бота, блокируя всех остальных:

User-agent: [имя бота]

Запретить:

Пользовательский агент: *

Disallow: / Как проверить корректно ли работает мой файл robots.txt для Google?

Вы можете проверить правильность настройки вашего файла с помощью инструмента тестирования robots.txt в Google Search Console. С помощью этого теста вы можете увидеть, как робот Googlebot прочитает его, что позволит вам обнаружить потенциальные ошибки.

С помощью этого теста вы можете увидеть, как робот Googlebot прочитает его, что позволит вам обнаружить потенциальные ошибки.

Чтобы использовать этот инструмент, перейдите к Crawl → robots.txt Tester на левой панели Google Search Console. Введите URL-адреса, которые вы хотите протестировать, в строке внизу.

Он покажет вам два результата: Разрешено (URL-адрес не заблокирован) или Заблокировано (и указать команду, блокирующую URL).

Ограничения файла robots.txt

Хотя этот файл может быть вам полезен, он также имеет некоторые ограничения, о которых вам следует знать.

- Этот файл не гарантирует, что заблокированный контент не будет проиндексирован, поскольку Google обнаруживает веб-страницы по ссылкам. Если есть внутренние ссылки на заблокированные страницы, они, скорее всего, будут просканированы и проиндексированы ботами. Вы должны заблокировать индексацию, включив тег noindex или защита страницы паролем для предотвращения индексации.

- Разные сканеры интерпретируют синтаксис файла robots.txt по-разному. Больше всего внимания уделяется Google, так как он чрезвычайно популярен. Тем не менее, вам может понадобиться изучить, как другие поисковые системы взаимодействуют с robots.txt, чтобы оптимизировать его для большинства возможных поисковых систем.

- Некоторые сканеры могут вообще не следовать командам в файле robots.txt.

Выводы

Если у вас есть определенный контент, который вы не хотите сканировать ботами или включать в результаты поиска, стоит настроить соответствующие команды в файле robots.txt вашего сайта.

Конечным преимуществом оптимизации файла robots.txt является сокращение краулингового бюджета вашего веб-сайта. Предотвращая сканирование и индексирование ненужных страниц, вы гарантируете, что у поисковых систем будет достаточно ресурсов для сканирования и индексации всех страниц, которые вы хотите повысить.

Наконец, помните, что, хотя (большинство) поисковых роботов будут следовать указаниям вашего файла, это не гарантирует, что контент не может быть проиндексирован другими способами.

php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: */comment-page-*

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /category/*/*

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-content/cache

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /comments

User-agent: Yandex

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: */comment-page-*

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /category/*/*

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-content/cache

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /comments

Disallow: /page/

Host: life-crazy.ru

Sitemap: http://life-crazy.ru/sitemap.xml

Sitemap: http://life-crazy.ru/sitemap.xml.gz

php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: */comment-page-*

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /category/*/*

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-content/cache

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /comments

User-agent: Yandex

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: */comment-page-*

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /category/*/*

Disallow: /wp-content/plugins

Disallow: /wp-content/themes

Disallow: /wp-content/cache

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /comments

Disallow: /page/

Host: life-crazy.ru

Sitemap: http://life-crazy.ru/sitemap.xml

Sitemap: http://life-crazy.ru/sitemap.xml.gz