Правильный robots.txt для wordpress, зачем нужен robots.txt, тэг more

Здравствуйте, дорогие читатели моего блога!

Сегодня я Вам расскажу о том, как составить правильный robots.txt для WordPress.

Многие новички в блоггинге совершают одну очень важную ошибку: они забывают составлять, или составляют неправильно очень важный файл, который называется robots.txt.

Зачем нужен robots.txt?

Платформа WordPress является очень удобной платформой, однако у нее имеется ряд недостатков. Самым главным из которых является дублирование контента.

Вот смотрите, если вы опубликовали статью, то она появляется сразу на нескольких страницах и может иметь разные адреса (урлы).

Статья появляется на главной странице, в архиве, в рубрике, в ленте RSS, в поиске и т.д.

Так вот, если на блоге появляется несколько статей с одинаковым содержанием и различными адресами, то это называется дублирование контента.

Это все равно, что скопировать контент с чужого блога и вставить на свой. Эти статьи будут неуникальными.

Эти статьи будут неуникальными.

За такие действия поисковые системы однозначно наложат на блог санкции в виде всеми любимого фильтра АГС.

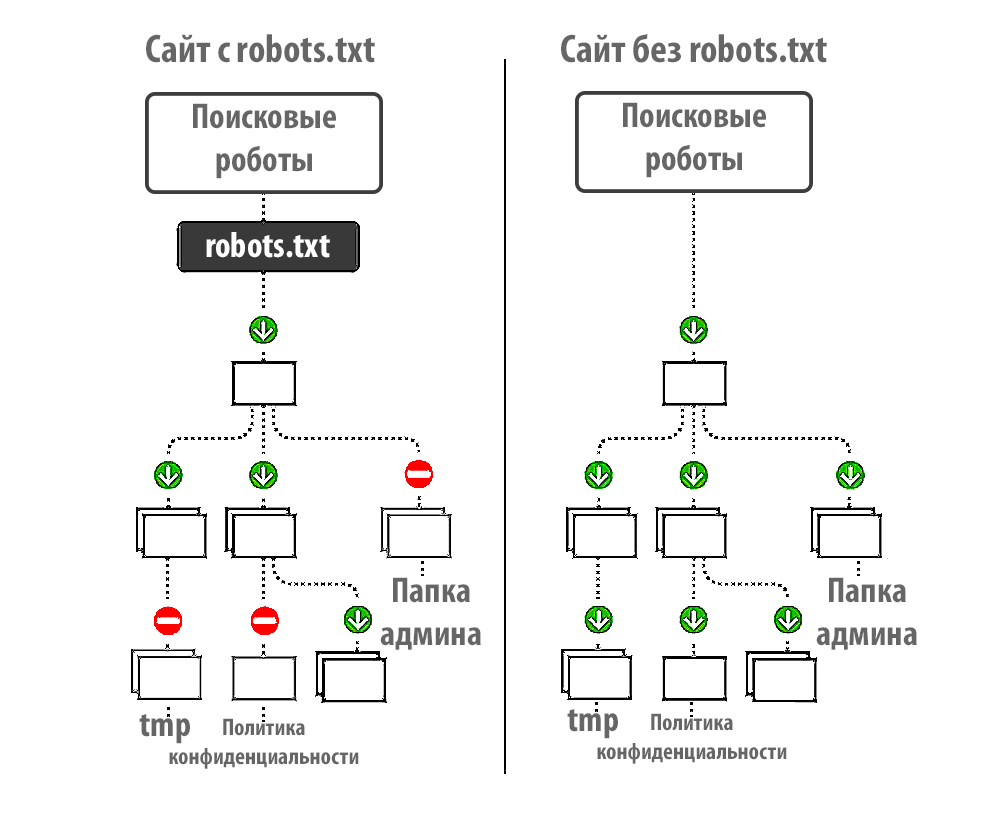

Чтобы избежать дублирования контента на платформе wordpress, необходимо использовать некоторые обязательные мероприятия. Одним из которых является запрет индексации поисковыми системами тех разделов блога, на которых дубли создаются ввиду особенностей самой платформы.

Как раз robots.txt позволяет нам исключить из индекса поисковиков подобные страницы.

Кроме этого в корне блога содержатся различные служебные каталоги (например, для хранения файлов), которые тоже желательно исключать из индекса.

Как составить правильный robots.txt для WordPress?

Перед тем как приступить к составлению этого файла, нам необходимо знать основные правила его написания – директивы.

1. Директива User-agent

Эта директива определяет, какому именно поисковому роботу следует выполнять команды, которые будут указаны далее.

Например, если Вы хотите запретить индексацию чего-либо поисковому роботу Яндекса, то следует для этой директивы задать следующий параметр:

User-agent: Yandex

Если Вы хотите дать указание всем без исключения поисковым системам, то директива будет выглядеть следующим образом:

User-agent: *

В случае с рунетом, особые указания необходимо задать для Яндекса, а для роботов остальных поисковых систем подойдут общие, которые мы зададим так:

User-agent: *

2. Следующими директивами являются «Allow» и «Disallow».

Следующими директивами являются «Allow» и «Disallow».

Allow – разрешает индексацию указанных в ней элементов.

Disallow – соответственно запрещает индексацию.

Правильный robots.txt должен обязательно содержать директиву «Disallow».

Если написать так:

User-agent: Yandex

Disallow:

То мы разрешим индексацию поисковому роботу Яндекса всего блога полностью.

Если написать так:

User-agent: Yandex

Disallow: /

То запретим Яндексу индексировать весь ресурс.

Таким образом, мы можем разрешать или запрещать индексацию своего блога отдельным или всем роботам.

Например:

User-agent: *

Disallow:

User-agent: Yandex

Disallow: /

Здесь мы разрешили индексирование всем поисковикам, а Яндексу запретили. Надеюсь, это понятно.

Теперь нам необходимо знать, что именно следует запретить для индексации в WordPress, то есть какие разделы могут содержать дубли страниц и другой мусор.

1. все системные и служебные файлы:

— wp-login.php

— wp-register.php

— wp-content/

— wp-admin/

— wp-includes/

Отдельно хочу сказать про каталог wp-content. В принципе, все содержимое в нем необходимо закрыть, за исключением папки «uploads» в которой располагаются изображения. Потому что, в случае запрета индексирования «uploads», ваши картинки на блоге индексироваться не будут.

Поэтому будем закрывать каталоги, размещенные внутри папки «wp-content» отдельно:

Disallow: /wp-content/themes

Disallow: /wp-content/plugins

Disallow: /wp-content/languages

Disallow: /wp-content/cache

Если в каталоге «wp-content» Вашего блога есть еще какие-либо папки, то можно (и даже нужно) их закрыть (за исключением «uploads»).

2. Дубли страниц в категориях:

— category/*/*

3. RSS ленту:

— feed

4. Дубли страниц в результатах поиска:

Дубли страниц в результатах поиска:

— *?*

— *?

5. Комментарии:

— comments

6. Трэкбэки:

— trackback

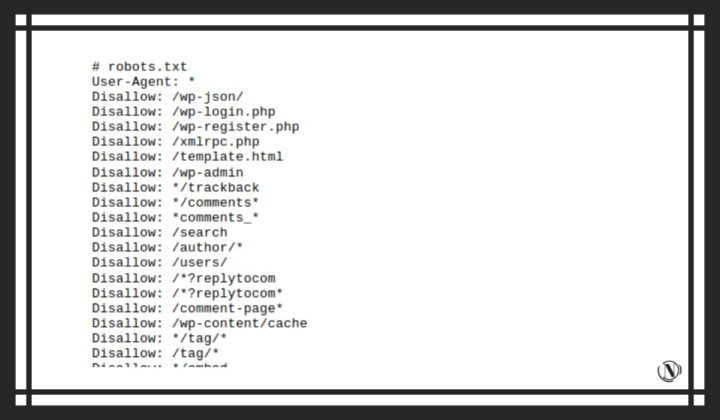

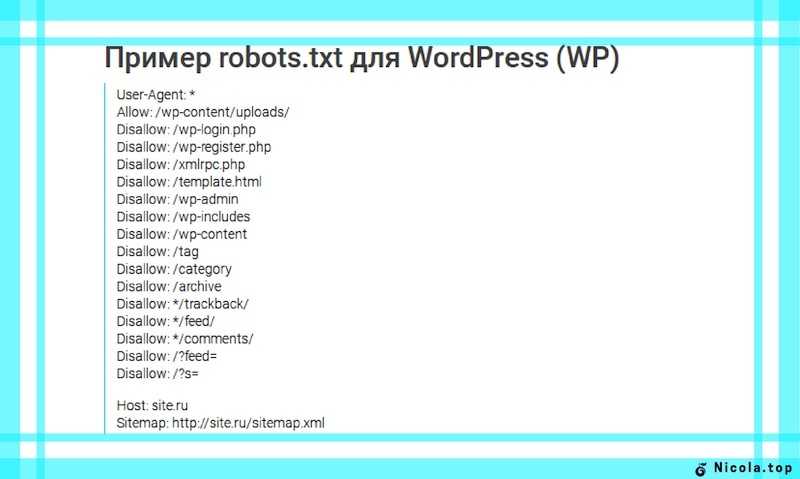

Я не буду описывать структуру WordPress, а выкладываю Вам свой файл robots.txt, который установлен на моем блоге. Я считаю, что он наиболее правильный. Если Вы найдете в нем какие-либо недочеты, то просьба написать об этом в комментариях.

User-agent: *

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /category/*/*

Disallow: /wp-content/themes

Disallow: /wp-content/plugins

Disallow: /wp-content/languages

Disallow: /wp-content/cache

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /comments

Здесь же нужно задать отдельные указания Яндексу:

User-agent: Yandex

Disallow: /wp-login. php

php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /webstat/

Disallow: /feed/

Disallow: /trackback

Disallow: */trackback

Disallow: */feed

Disallow: */comments

Disallow: /*?*

Disallow: /*?

Disallow: /category/*/*

Disallow: /wp-content/themes

Disallow: /wp-content/plugins

Disallow: /wp-content/languages

Disallow: /wp-content/cache

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /comments

Host: mysite.ru

Sitemap: http://mysite.ru/sitemap.xml

Sitemap: http:// mysite.ru/sitemap.xml.gz

Если Вы не составляли файл robots.txt или сомневаетесь в правильности его составления, советую Вам использовать этот.

Для этого необходимо создать обычный текстовый документ, скопировать весь текст, представленный выше, вставить его в свой файл. Затем сохранить его под именем: robots.txt (первая буква не должна быть заглавной).

Не забудьте поменять mysite.ru на свой.

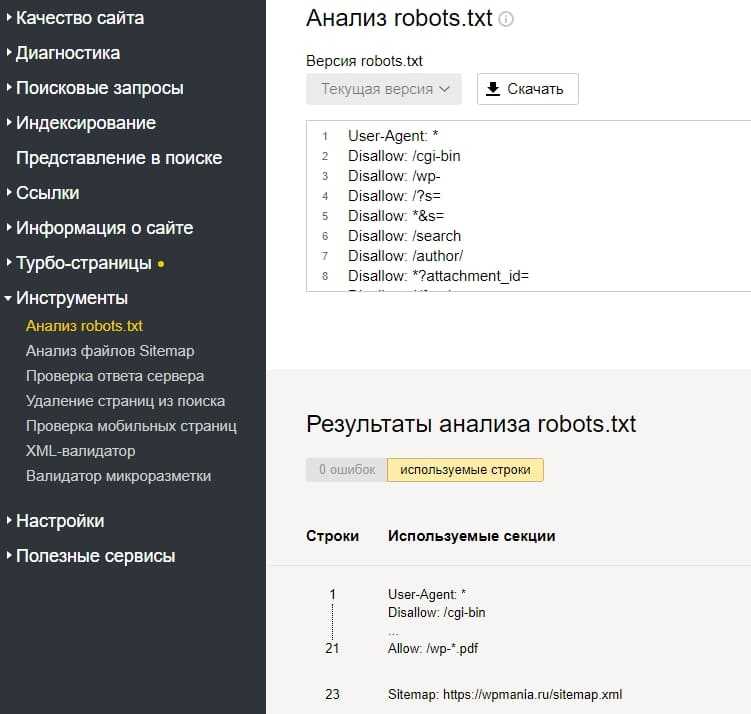

После создания файл robots. txt необходимо разместить в корне блога, затем добавить его в панель вебмастера Яндекса.

txt необходимо разместить в корне блога, затем добавить его в панель вебмастера Яндекса.

Рекомендую Вам посмотреть видео, посвященное дублированию контента:

Еще пару слов о дублировании контента. Тэг «More»

Дело в том, что у нас на главной странице блога (mysite.ru) тоже выводятся статьи.

При нажатии на заголовок поста, мы переходим на его страницу (mysite.ru/…./….html). Таким образом, часть поста (та, что на главной) является дублем такой же части текста основной статьи.

Закрыть от индексации здесь ничего нельзя. Поэтому рекомендую Вам выводить на главную страницу как можно меньше текста основной статьи.

А именно приветствие и небольшой анонс.

Пример Вы можете посмотреть у меня на главной странице (анонс к этой статье).

Для этого используется тэг more.

Проще говоря: набрали небольшой фрагмент (приветствие и анонс), который будет выведен на главную, перешли в редактор HTML и вставили следующий код:

<!- -more- ->

И продолжаете дальше писать статью.

Вся часть текста, расположенная перед тэгом more, будет выведена на главную страницу.

Рекомендую посмотреть видео: «Что такое Robots.txt?»:

На этом у меня все. Обязательно создайте правильный robots.txt для WordPress!

С уважением, Александр Бобрин

Поделись с друзьями:

Метки: Блог на WordPress

Обратите внимание:

Редактируем Robots.txt в WordPress с помощью плагина All in One SEO

Файл robots.txt — это мощный инструмент SEO, поскольку он работает как руководство по веб-сайту для роботов, выполняющих сканирование страниц сайтов. Указание ботам не сканировать ненужные страницы может увеличить скорость загрузки вашего сайта и улучшить рейтинг в поисковых системах.

Несмотря на то, что однажды я уже создавал пост про этот важный файл для оптимизации работы сайтов, в этом мануале я более подробно расскажу, что такое файл robots. txt и почему он важен. А так же шаг за шагом покажу, как редактировать и как редактировать его в WordPress.

txt и почему он важен. А так же шаг за шагом покажу, как редактировать и как редактировать его в WordPress.

ОГЛАВЛЕНИЕ

Что такое файл Robots.txt?

Файл robots.txt сообщает поисковым системам, как сканировать ваш сайт — где им можно это делать, а где нельзя.

Поисковые системы, такие как Google, используют этих поисковых роботов, иногда называемых веб-роботами, для архивирования и классификации веб-сайтов.

Большинство ботов настроены на поиск файла robots.txt на сервере до того, как он прочитает любой другой файл с вашего сайта. Это делается для того, чтобы увидеть, добавили ли вы особые инструкции по сканированию и индексированию вашего сайта.

Файл robots.txt обычно хранится в корневом каталоге, также известном как основная папка веб-сайта. URL-адрес может выглядеть так: https://www.example.com/robots.txt

Чтобы проверить файл robots.txt на своем веб-сайте, просто замените https://www.example.com/ на свой домен и добавьте robots.txt в конце.

Сейчас же, давайте посмотрим, как выглядит основной формат файла robots.txt:

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

Чтобы это имело смысл, сначала нужно объяснить, что означает User-agent.

По сути, это имя бота или робота поисковой системы, которому вы хотите заблокировать или разрешить сканировать ваш сайт (например, робот Googlebot).

Во-вторых, вы можете включить несколько инструкций, чтобы разрешить или запретить определенные URL-адреса, а также добавить несколько карт сайта. Как вы, наверное, догадались, опция запрета указывает роботам поисковых систем не сканировать эти URL-адреса.

Файл Robots.txt по умолчанию в WordPress

По умолчанию WordPress автоматически создает файл robots.txt для вашего сайта. Так что, даже если вы не пошевелите пальцем, на вашем сайте уже должен быть файл robots.txt WordPress по умолчанию.

Но когда вы позже настроите его своими собственными правилами, содержимое по умолчанию будет заменено.

Стандартные файлы robots.txt выглядит так:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Звездочка после User-agent: * означает, что файл robots.txt предназначен для всех веб-роботов, посещающих ваш сайт. И, как уже упоминалось, Disallow: / wp-admin / указывает роботам не посещать вашу страницу wp-admin.

Вы можете протестировать свой файл robots.txt, добавив /robots.txt в конце своего доменного имени. Например, если вы введете в адресную строку браузера запись https://aioseo.com/robots.txt , то в нем отобразится файл robots.txt для сайта плагина AIOSEO, который его разработчики настроили вот так:

Теперь, когда вы знаете, что такое файл robots.txt и основы его работы, давайте посмотрим, почему файл robots.txt имеет значение в первую очередь.

Почему важен файл Robots.txt?

Файл robots.txt важен, потому, что с помощью него вы:

1. Оптимизируйте скорость загрузки вашего сайта — указав ботам не тратить время на страницы, которые вы не хотите, чтобы они сканировали и индексировали, вы можете освободить ресурсы и увеличить скорость загрузки вашего сайта.

Оптимизируйте скорость загрузки вашего сайта — указав ботам не тратить время на страницы, которые вы не хотите, чтобы они сканировали и индексировали, вы можете освободить ресурсы и увеличить скорость загрузки вашего сайта.

2. Оптимизируете использования сервера — блокировка ботов, которые тратят ресурсы впустую, очистит ваш сервер и уменьшит количество ошибок 404.

Когда использовать мета-тег Noindex вместо robots.txt

Однако, если ваша основная цель — предотвратить включение определенных страниц в результаты поисковых систем, правильным подходом является использование метатега noindex.

Это связано с тем, что файл robots.txt напрямую не говорит поисковым системам не индексировать контент — он просто говорит им не сканировать его.

Другими словами, вы можете использовать файл robots.txt для добавления определенных правил взаимодействия поисковых систем и других ботов с вашим сайтом, но он не будет явно контролировать, индексируется ли ваш контент или нет.

С учетом сказанного, давайте покажем вам, как легко шаг за шагом редактировать файл robots.txt в WordPress с помощью сео-плагина для WordPress — All in One SEO (AIOSEO)

Как редактировать файл Robots.txt в WordPress с помощью AIOSEO

Самый простой способ отредактировать файл robots.txt — использовать лучший плагин WordPress SEO All in One SEO (AIOSEO). Если вы его установили, то это позволит вам контролировать свой веб-сайт и настраивать файл robots.txt, который заменяет файл WordPress по умолчанию.

Если вы этого еще не знали, AIOSEO — это полноценный плагин WordPress для SEO,

который позволяет вам оптимизировать контент для поисковых систем и повысить рейтинг всего за несколько кликов. Ознакомьтесь с его мощными инструментами и функциями SEO здесь.

Включаем пользовательский файл Robots.txt

Чтобы приступить к редактированию файла robots.txt, с помощью уже установленного плагина AIOSEO, выберите в меню плагина строку «Инструменты». Таким образом вы откроете вкладку «Редактор Robots. txt». Далее приступаем к настройкам плагина.

txt». Далее приступаем к настройкам плагина.

Примечание* Если у вас уже был настроен файл и он вас вполне устраивает, вы можете просто импортировать его в AIOSEO.

Перевод страницы предупреждения и рекомендаций, если у вас уже был установлен файл: «AIOSEO обнаружила физический файл robots.txt в корневой папке вашей установки WordPress. Мы рекомендуем удалить этот файл, так как он может вызвать конфликт с динамически созданным файлом WordPress. AIOSEO может импортировать этот файл и удалить его, или вы можете просто удалить его».Теперь на странице редактирования можно легко добавлять или удалять необходимые правила. Если вы пожелаете удалить ранее созданный файл-роботс — просто импортируйте и удалите его и пользуйтесь настройками по умолчанию. Но действовать нужно с осторожностью и не спешить удалять старый, несмотря на предупреждения плагина, а лучше используйте редактор.

AIOSEO сгенерирует динамический файл robots.txt. Его содержимое хранится в вашей базе данных WordPress и может быть просмотрено в вашем веб-браузере.

После того, как вы вошли в редактор Robots.txt, вам необходимо включить Custom Robots.txt.

Кнопка включения окна редактирования файла robots.txtЗатем вы увидите раздел предварительного просмотра файла Robots.txt в нижней части экрана, в котором показаны правила WordPress по умолчанию, которые вы можете заменить своими собственными.

Правила по умолчанию предписывают роботам не сканировать ваши основные файлы WordPress (страницы администратора). Также не рекомендуется сканировать плагины и темы. Они не содержат релевантного содержания и не нужны поисковым системам для сканирования.

Теперь давайте перейдем к тому, как вы можете добавить (или редактировать уже созданные) свои собственные правила с помощью создателя правил.

Добавление правил с помощью создателя правил

Конструктор правил используется для добавления ваших собственных правил для того, какие страницы роботы должны сканировать или нет.

Например, если вы хотите добавить правило, которое блокирует всех роботов из временного каталога (имеется в виду временная папка, например, на жестком диске), вы можете использовать для этого создатель правил.

Чтобы добавить собственное правило, просто введите User Agent (например, поисковый робот Googlebot) в поле User Agent. Или вы можете использовать символ *, чтобы ваше правило применялось ко всем пользовательским агентам (роботам).

Затем выберите «Разрешить» или «Запретить», или удалить (справа в таблице значок корзины), чтобы разрешить или заблокировать User Agent.

Или добавить новое правило:

По окончании редактирования и внесения изменений, вернитесь на верх страницы и осуществите просмотр файла в адресной строке браузера «Open Robots.txt»:

Что бы операция установки редактирования файла robots.txt была завершена, не забудьте сохранить изменения, кликнув на соответствующую кнопку в самом верху или внизу страницы редактирования.

Надеюсь, что это руководство показало вам, как легко редактировать файл robots.txt в WordPress. Теперь продолжайте и добавляйте свои собственные правила, и вы в кратчайшие сроки убедитесь, что ваш веб-сайт оптимизирован для достижения оптимальной производительности.

Пожертвуйте на развитие блога, пожалуйста.

(Visited 1 times, 2 visits today)

Что такое Robots.txt и нужен ли он вам?

В этой статье будет представлена информация о файле robots.txt и о том, для чего он в основном используется в WordPress.

Почему название Robots.txt?

Файл называется Robots.txt, что в основном происходит от слова «робот», которым может быть любой тип «бота», который посещает веб-сайты через Интернет. Другими словами, их называют сканерами поисковых систем, которые помогают индексировать ваш сайт в основных браузерах, таких как, например, Google. Сам файл играет ключевую роль в регулировании трафика, блокируя или разрешая доступ ботам к определенным частям вашего веб-сайта.

Для чего в WordPress используется файл Robots.txt?

Файл robots.txt — это простой текстовый файл, который помогает роботам поисковых систем и другим ботам понять, какие страницы или разделы веб-сайта следует сканировать или индексировать. В контексте веб-сайта WordPress этот файл можно использовать для блокировки конфиденциальной информации или автоматически сгенерированных страниц от индексации.

В контексте веб-сайта WordPress этот файл можно использовать для блокировки конфиденциальной информации или автоматически сгенерированных страниц от индексации.

Используя файл robots.txt в WordPress, вы можете управлять генерируемым сканирующим трафиком от различных ботов, что может помочь защитить ваш сайт и улучшить его SEO.

Можно ли сгенерировать файл Robots.txt с помощью плагина WordPress?

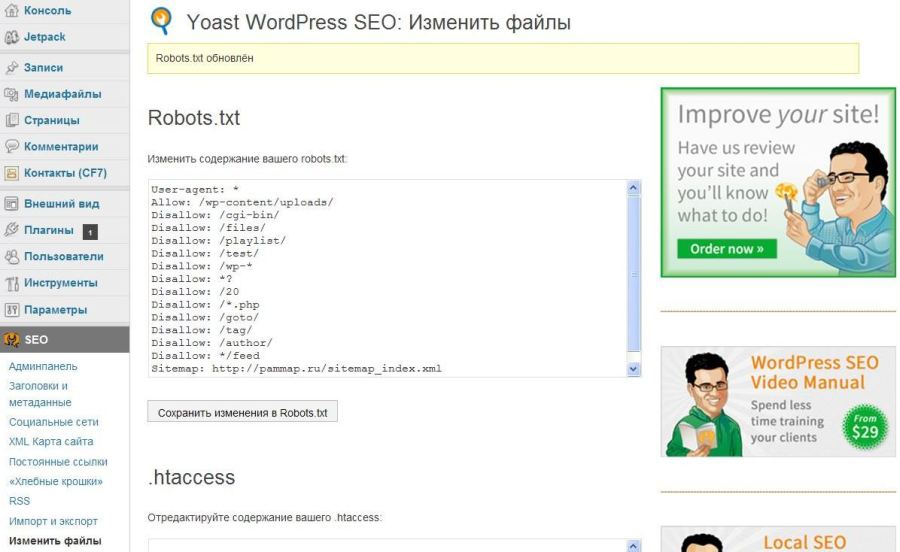

Самый простой способ создать или отредактировать файл robots.txt — использовать плагин, такой как Yoast SEO . Вам нужно будет войти на свой сайт WordPress.

После входа в систему администратора WP вы можете перейти к Плагины (1) → Добавить новый (2). Затем введите Yoast SEO в строку поиска (3), как показано на снимке экрана ниже. Нажмите на Установить сейчас 9Кнопка 0018 (4), чтобы начать установку плагина.

После установки плагина его необходимо Активировать .

После установки перейдите к Yoast SEO (1) и выберите Инструменты (2).

Вам потребуется выбрать параметр Редактор файлов , чтобы получить доступ к параметру создания файла robots.txt.

После выбора появится опция Создать файл robots.txt .

После создания вы сможете настроить файл robots.txt непосредственно в настройках плагина.

После внесения изменений вы можете выбрать Сохранить изменения в robots.txt .

Вам нужен Robots.txt?

Важно понимать, что вам не нужен файл Robots.txt для того, чтобы ваш веб-сайт работал и функционировал должным образом. Причина в том, что у вас есть веб-сайт с интенсивным трафиком и вы хотите контролировать сканирующий трафик, исходящий от ботов, что означает разрешение или блокировку определенных.

В других случаях, если у вас есть контент, который вы не хотите индексировать, вы можете использовать Robots. txt, чтобы запретить ботам сканировать эту конкретную часть вашего веб-сайта.

txt, чтобы запретить ботам сканировать эту конкретную часть вашего веб-сайта.

Имейте в виду, что файл robots.txt — это только запрос, а не требование для поисковых систем. Некоторые поисковые системы могут игнорировать инструкции в файле robot.txt, поэтому всегда рекомендуется защищать конфиденциальную информацию с помощью других методов, таких как защита паролем или права доступа к файлам.

В целом, вы должны быть осторожны при настройке Robots.txt, особенно без помощи веб-мастера или онлайн-генератора, с помощью которых вы можете избежать ошибок, таких как блокировка важных ботов и снижение вашего SEO-рейтинга и трафика в целом.

Если ваш веб-сайт простой и у вас нет большого количества входящего трафика, отчеты аналитики хорошие, то вам не нужно вмешиваться в расширенные регуляторы поисковых систем, такие как Robots.txt.

Если у вас есть другие вопросы по теме, не стесняйтесь обращаться в службу поддержки WPX через чат (используйте нижний правый виджет), и они ответят и помогут в течение 30 секунд или меньше.

Изучение WordPress Robots.txt: функции и правила

Если вы искали в Интернете информацию о SEO и других советах по оптимизации вашего веб-сайта, то вы наверняка где-то читали о robots.txt.

В этом руководстве я кратко объясню функцию файла robots.txt и какие правила вы можете ему задать. Естественно, я объясню методы того, как вы можете легко создать его на своем сайте.

Какова функция файла robots.txt WordPress?Файл robots.txt — это, по сути, файл на вашем веб-сайте, который сообщает поисковым системам, таким как Google, как сканировать страницы вашего сайта (например, ограничивать их доступ к некоторым страницам).

Это просто набор инструкций, хранящихся в корневом каталоге вашего сайта. Вот пример с techcrunch.com:

Файл robots.txt имеет два преимущества:

- Побуждает поисковые системы сосредоточить сканирование и индексирование на наиболее важных страницах (и не тратить время на страницы, которые вы не хотите индексировать)

- Блокирует ботов, которые трата ресурсов на оптимизацию использования сервера

Если ваш веб-сайт новый и у вас всего несколько страниц, создание файла robots. txt может не принести вам большой пользы.

txt может не принести вам большой пользы.

Однако для больших сайтов контроль над тем, как поисковые системы сканируют и индексируют ваши страницы, принесет вам пользу по одной единственной причине (которая делает преимущества более ранними понятными):

Боты поисковых систем имеют квоту или ограничение сканирования для каждого веб-сайта за один сеанс.

Возможно, они не смогут просканировать все ваши страницы сразу. Вот почему создание robots.txt может позволить сканерам поисковых систем сосредоточиться на страницах, которые вы хотите просканировать и проиндексировать.

Как создать файл robots.txt для WordPress?Существует несколько вариантов создания файла robots.txt для вашего веб-сайта.

Один из них — вручную создать свой собственный файл в автономном режиме (используя текстовый редактор, такой как Блокнот) и загрузить его на свой сервер.

Но если вы хотите создать его быстро, вы можете использовать Yoast или All In One SEO.

Если вы используете Yoast, просто перейдите на страницу « Инструменты » плагина и нажмите кнопку « Редактор файлов » на странице.

Создание файла robots.txt с помощью Yoast:

На следующей странице плагин сообщит вам, есть ли у вас уже файл robots.txt или нет.

Нажмите кнопку « Создать файл robots.txt », чтобы создать его.

После этого вы сможете редактировать содержимое файла robots.txt. Это то же самое место, которое вам нужно посетить позже, если вы хотите добавить в файл больше команд.

Сейчас нажмите « Сохранить изменения в robots.txt », чтобы наконец создать файл.

Создание файла robots.txt с помощью All In One SEO:

Если вы используете All In One SEO, перейдите на страницу « Инструменты » и вы увидите вкладку « Редактор Robots.txt ». сразу.

Щелкните ползунок « Enable Custom Robots. txt », чтобы активировать редактор.

txt », чтобы активировать редактор.

Как видите, здесь редактор Robots.txt проще в использовании и понимании. Вы можете напрямую добавлять новые правила, не зная самих кодов.

Но в любом случае нажмите « Сохранить изменения », чтобы наконец создать файл robots.txt вашего сайта.

Какие правила можно включить в файл robots.txt?Создать правило в файле robots.txt проще, чем вы можете себе представить.

Для начала вам нужно знать только две вещи:

- Агент пользователя

- Правило (разрешить или запретить)

Теперь, вместо того, чтобы рассказывать вам, как сформулировать свои собственные правила, я сразу же предоставлю вам некоторые правила, которые могут оказаться интересными или полезными:

Запретить всем поисковым роботам доступ к страницам вашего сайта :

User-agent: * Disallow: /

Это почти не происходит с работающим сайтом — но может помочь с сайтом, который все еще находится на стадии разработки.

Звездочка действует как код блокировки, который обращается ко всем пользовательским агентам или ботам, а косая черта в части «Запретить» означает запрет доступа ко всем страницам в домене.

Запретить определенному боту сканирование страниц вашего сайта:

Агент пользователя: baiduspider Disallow: /

Проверьте этот веб-сайт на наличие дополнительных строк пользовательского агента. Замена звездочки одним пользовательским агентом означает, что указанное ниже правило будет применяться только к этому пользовательскому агенту.

Запретить ботам доступ к определенной папке или файлу на вашем сайте:

Агент пользователя: * Запретить: /wp-admin/ Disallow: /wp-login.php

Правило явно означает запрет всем ботам сканировать wp-admin и wp-login.php. Когда вы включаете папку в правило, оно применяется ко всем ее вложенным папкам.

Разрешить ботам доступ к указанному файлу в папке с ограниченным доступом:

Агент пользователя: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-file.php

Фрагмент, следующий за «Разрешить», в основном освобождает admin-file.php от правила «Запретить».

Запретить ботам сканировать результаты поиска WordPress:

Агент пользователя: * Запретить: /?s= Disallow: /search/

«?s=» — это параметр запроса в WordPress. Использование этого параметра в параметре «Запретить» не позволяет роботам поисковых систем сканировать результаты запросов.

Создать разные правила для разных ботов:

User-agent: * Запретить: /wp-admin/ Агент пользователя: baiduspider Запретить: /

Вы можете смешивать и сочетать правила и создавать разные правила для разных ботов. Параметры будут применяться только к пользовательскому агенту, указанному выше.

Примечание . Использование команды «Запретить» не равнозначно использованию тега «noindex». По-прежнему существует вероятность того, что поисковые системы будут сканировать страницы или файлы, указанные вами в параметре «Запретить», если есть другие страницы, ссылающиеся на эти страницы и файлы.