Robots txt для wordpress в плагине All in One SEO

Эта статья поможет вам создать и изменить файл robots txt для wordpress с помощью плагина All in One SEO…

По умолчанию WordPress создаёт динамический файл роботс тхт, а модуль «инструмент» в плагине All in One SEO позволяет создавать, управлять этим файлом и менять значение по умолчанию.

Генерируя динамический robots.txt файл с помощью All in One SEO, как и WordPress вы создадите инструкции поисковикам о сайте. При этой настройке на сервере отсутствует статический файл robots.txt, а динамический хранится в базе данных WordPress и отображается в веб-браузере по адресу https://ваш сайт/robots.txt.

Чтобы начать работу в меню All in One SEO, нажмите на «Инструменты» и в редакторе включите ползунок «пользовательский robots.txt», при этом добавятся правила WordPress по умолчанию.

Если вы решите изменить правила, добавленные по умолчанию, то вам можно будет создать файл robots.txt в корневой папке WordPress с добавлением собственных правил.

Как это делается, мы рассмотрим далее в статье…

При создании пользовательского правила я придерживаюсь директивы User-agent от Яндекс. Например, боты Яндекс руководствуются правилами User-agent: Yandex и User-agent: * и запись User-agent: Yandex при этом в приоритете перед записью User-agent: *. Можно понимать так, если даны указания роботам Яндекс, то будет использоваться директива User-agent: Yandex, а User-agent: * будет игнорироваться.

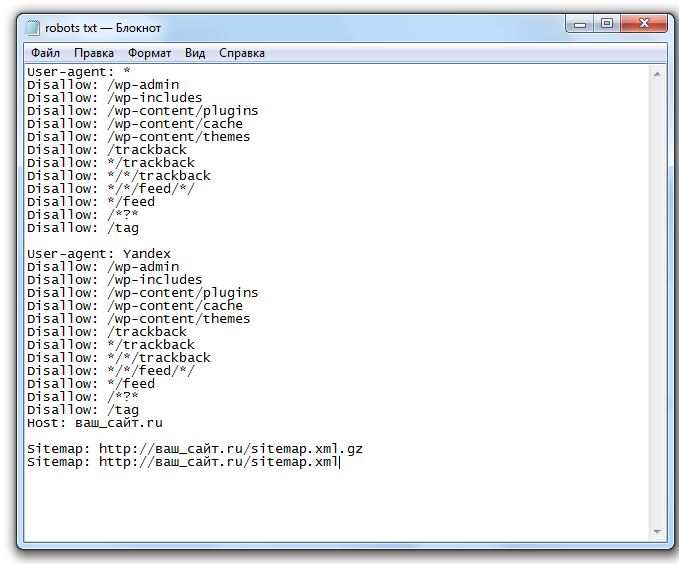

Например, на моих сайтах роботс.тхт настроен так (см. ниже), а вы можете настроить по своим предпочтениям.

Правила роботс.тхт на моих сайтах

User-agent: Yandex # разрешил роботам Яндекс сканировать сайт Allow: /wp-admin/admin-ajax.php Allow: /wp-content/uploads/ Allow: /*favicon.ico* Allow: /*.css Allow: /*.js Disallow: /wp-admin/ Disallow: /wp-content/uploads/wpo-plugins-tables-list.json Disallow: /readme.html Disallow: /xmlrpc.php Disallow: /trackback/ Disallow: /wp-json/ Disallow: /author/ Disallow: /type/ Disallow: /page/ Disallow: /?s=* User-agent: * # разрешил всем роботам сканировать сайт Allow: /*.css Allow: /*.js Allow: /*favicon.ico* Allow: /wp-content/uploads/ Allow: /wp-admin/admin-ajax.php Disallow: /wp-admin/ Disallow: /readme.html Disallow: /xmlrpc.php Disallow: /trackback/ Disallow: /wp-json/ Disallow: /type/ Disallow: /author/ Disallow: /page/ Disallow: /?s=* Sitemap: https://Ваш сайт/sitemap.xml

Если нет никаких записей, то считается, что роботам нет ограничений для этого сайта…

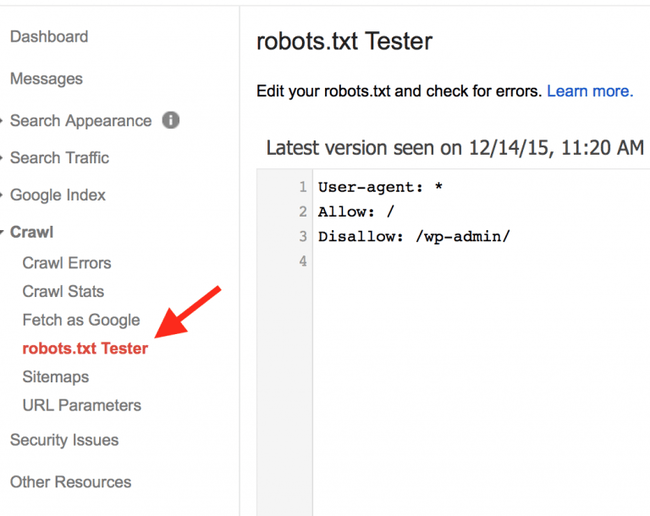

Итак, при нажатии кнопки «Добавить правило» у вас выйдет примерно такой роботс по умолчанию от Вордпресс (см. фото).

Как говорилось выше в статье мы создадим свой статический файл robots.txt и сделаем его динамическим с помощью SEO плагина и бесплатного FTP-клиента FileZilla. Скачайте и установите на компьютер, кстати, отличная программа для работы с сайтами.

- Через программу FTP-клиент открываем корневую папку на сервере своего хостинга.

- Далее создается новый пустой файл с названием robots.txt.

Выделяете созданный файл мышкой, нажимаете на Просмотр/Правка и открываете файл редактором Notepad++.

- Затем прописываете свой роботс.тхт и нажимаете сохранить.

Далее нужно зайти в админку Вордпресс и в плагине Aloseo открыть модуль Инструменты и, тут нажать кнопку Импорт и Удаление.

После этого создается динамический роботс.тхт, который можно здесь редактировать, удалять и добавлять другие правела.

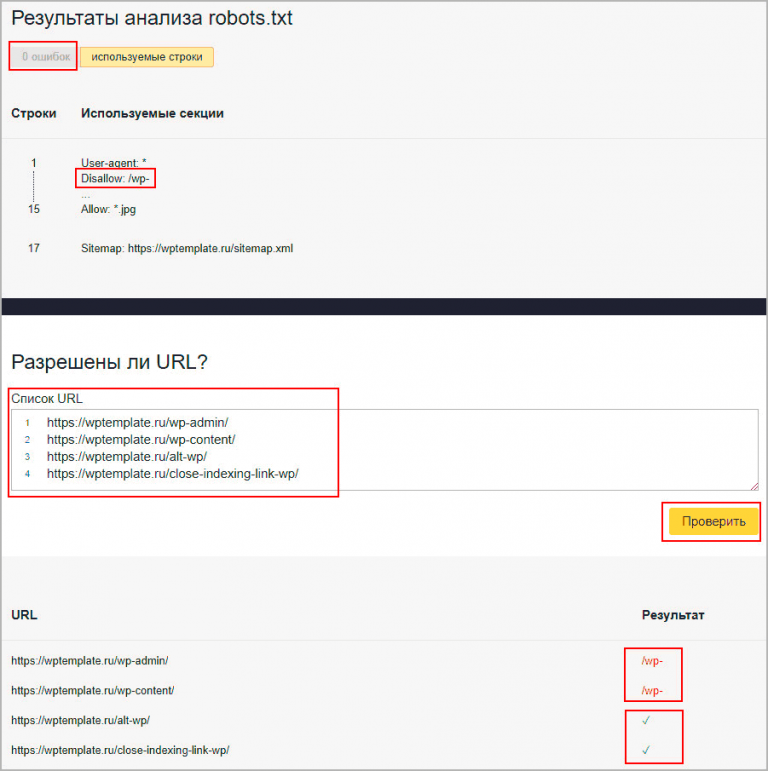

В инструментах ВебМастер.Яндекс нужно проверить результаты анализа robots.txt…

Вот и всё, остаётся ждать, когда изменения роботс.тхт вступят в силу, на это может уйти 2-3 недели или больше и поэтому отнеситесь к его составлению серьёзно. Через пару дней после настройки плагина в All in One SEO проверьте соответствие кодов ответа в панели ВебМастер Яндекс → Статистика обход → Все страницы.

Как создать файл robots.txt для WordPress. 4 способа

Всем, привет! Сегодня небольшой пост — как автоматически создать файл robots. txt для WordPress? Друзья, вы можете создать правильный robots.txt для WordPress в пару кликов, прочитав данное руководство. Создание правильного файла robots.txt для WordPress очень важно. Благодаря ему поисковые системы будут знать, какие страницы индексировать и показывать в поиске. То есть, результаты поиска будут именно такими, как вам нужно, без дублирования страниц WordPress.

txt для WordPress? Друзья, вы можете создать правильный robots.txt для WordPress в пару кликов, прочитав данное руководство. Создание правильного файла robots.txt для WordPress очень важно. Благодаря ему поисковые системы будут знать, какие страницы индексировать и показывать в поиске. То есть, результаты поиска будут именно такими, как вам нужно, без дублирования страниц WordPress.

Читайте, дамы и господа — WordPress robots.txt: лучшие примеры для SEO.

Файл robots.txt для WordPress

WordPress robots.txt где лежит/находится? По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Таким образом, даже если вы ни чего не делали, на вашем сайте ВордПресс уже должен быть файл robots.txt. Вы можете проверить, так ли это, добавив /robots.txt в конец вашего доменного имени. Например, так https://ваш сайт/robots.txt

Виртуальный файл robots.txt в WordPressПоскольку этот файл является виртуальным, вы не можете его редактировать. Однако, если вы хотите отредактировать свой файл robots.txt WordPress как надо, вам необходимо создать физический файл на вашем хостинге. Создайте свой правильный robots.txt для WordPress, который вы сможете легко редактировать по мере необходимости.

Однако, если вы хотите отредактировать свой файл robots.txt WordPress как надо, вам необходимо создать физический файл на вашем хостинге. Создайте свой правильный robots.txt для WordPress, который вы сможете легко редактировать по мере необходимости.

Как создать файл robots.txt для WordPress

Robots.txt — это текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем.

Файл robots.txt сообщает поисковым роботам, какие страницы или файлы на вашем сайте можно или нельзя обрабатывать.

Яндекс и Google

Для начала напомню вам, создать (и редактировать) файл robots.txt для WordPress можно вручную и с помощью плагина Yoast SEO

Друзья, имейте ввиду, что Yoast SEO устанавливает свои правила по умолчанию, которые перекрывают правила существующего виртуального файла robots.txt ВордПресс:

Редактирование robots.txt в плагине Yoast SEOЧто должно быть в правильно составленного robots. txt? Идеального файла не существует. Например, сайт Yoast SEO использует такой robots.txt для WordPress:

txt? Идеального файла не существует. Например, сайт Yoast SEO использует такой robots.txt для WordPress:

User-agent: *

И всё. Для большинства сайтов WordPress лучший пример. Вот даже скриншот сделал у Yoast SEO:

Правильный robots.txt на сайте yoast.comЧто это значит? Директива говорит что, все поисковые роботы могут свободно сканировать этот сайт без ограничений. Этого хватит для правильной индексации сайта WP. А наша SEO специалисты рекомендуют почти тоже самое. Пример, правильно составленного robots.txt для WordPress сайта:

User-agent: * Disallow: Sitemap: https://mysite.ru/sitemap.xml

Данная запись в файле роботс делает доступным для индексирования полностью сайт для роботов всех известных поисковиков. Здесь, также прописан путь к карте сайта XML.

Создать и редактировать файл также можно при помощи All in One SEO Pack прямо из интерфейса SEO плагина. Модуль robots.txt в SEO-пакете Все в одном позволяет вам настроить файл robots.txt для вашего сайта, который переопределит файл robots.

Вы сможете управлять своим файлом Robots.txt, в разделе All in One SEO Pack — Robots.txt. Сам официальный сайт плагина использует вот такой роботс:

Пример файла RobotsПравила по умолчанию, которые отображаются в поле Создать файл Robots.txt (показано на снимке экрана выше), требуют, чтобы роботы не сканировали ваши основные файлы WordPress. Для поисковых систем нет необходимости обращаться к этим файлам напрямую, потому что они не содержат какого-либо релевантного контента сайта.

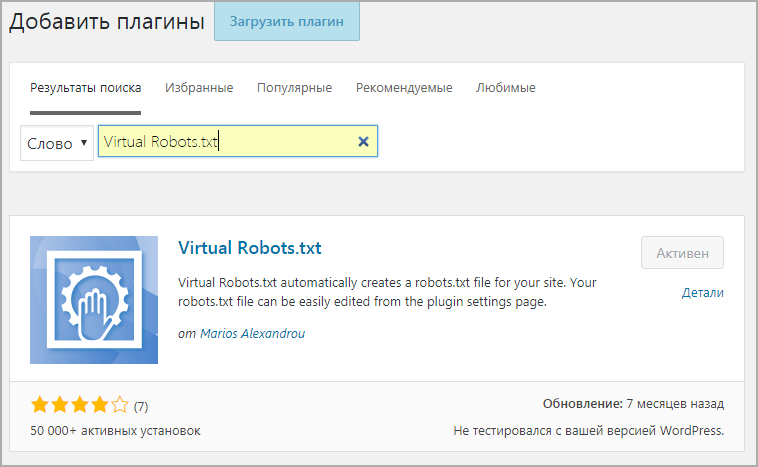

А если вы не используете данные SEO модули, то предлагаю вам воспользоваться специальным плагином — Robots.txt Editor.

Плагин Robots.txt Editor

Плагин Robots.txt для WordPress — создание и редактирование файла robots.txt для сайта ВордПресс. Очень простой, лёгкий и эффективный плагин.

WordPress плагин Robots.txt Editor Плагин Robots.txt Editor (редактор) позволяет создать и редактировать файл robots. txt на вашем сайте WordPress.

txt на вашем сайте WordPress.

Плагин Robots.txt возможности

- Работает в сети сайтов Multisite на поддоменах;

- Пример правильного файла robots.txt для WordPress;

- Не требует дополнительных настроек;

- Абсолютно бесплатный.

Как использовать? Установите плагин robots.txt стандартным способом. То есть, из админки. Плагины — Добавить новый. Введите в окно поиска его название — Robots.txt Editor:

Добавить плагин Robots.txt EditorУстановили и сразу активировали. Всё, готово. Теперь смотрим, что получилось. Заходим, Настройки — Чтение и видим результат. Автоматически созданный правильный файл robots.txt для WordPress со ссылкой на ваш файл Sitemap. Пример, правильный robots.txt для сайта ВордПресс:

Созданный файл robots.txt WordPressЕстественно, вы можете его легко отредактировать под свои нужды. А также просмотреть, нажав соответствующею ссылку — Просмотр robots.txt.

Как создать robots.txt вручную

Если вы не захотите использовать плагины, которые предлагают функцию robots. txt, вы все равно можете создать и управлять своим файлом robots.txt на своём хостинге. Как создать файл robots.txt самостоятельно?

txt, вы все равно можете создать и управлять своим файлом robots.txt на своём хостинге. Как создать файл robots.txt самостоятельно?

В текстовом редакторе создайте файл с именем robots в формате txt и заполните его:

Создать файл с именем robots.txtФайл должен иметь имя robots.txt и никакое другое больше. Сохраните данный файл локально на компьютере. А затем, загрузите созданный файл в корневую директорию вашего сайта.

Корневая папка (корневая директория/корневой каталог/корень документа) — это основная папка, в которой хранятся все файлы сайта. Обычно, это папка public_html (там где находятся файлы — .htaccess, wp-config.php и другие). Именно в эту папку загружается файл robots.txt:

Загрузите файл в корневую папку вашего сайтаЧтобы проверить, получилось ли у вас положить файл в нужное место, перейдите по адресу: https://ваш_сайт.ru/robots.txt

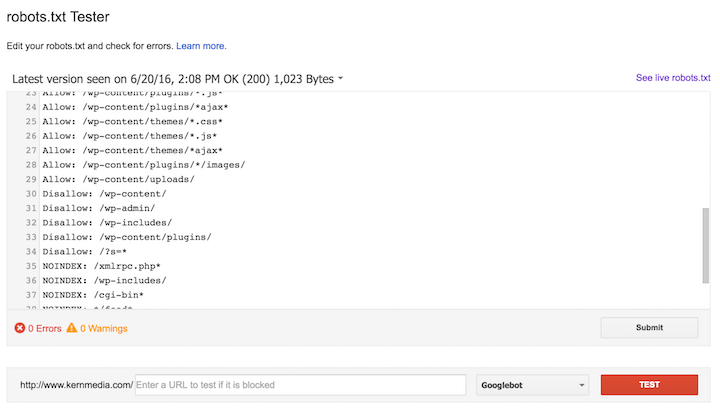

Теперь, когда ваш файл robots.txt создан и загружен на сайт, вы можете проверить его на ошибки.

Проверка вашего файла robots.

txt

txtВы можете проверить файл robots.txt WordPress в Google Search Console и Яндекс.Вебмастер, чтобы убедиться, что он правильно составлен.

Например, проверка файла robots.txt WordPress в Яндекса.Вебмастер. В блоке Результаты анализа robots.txt перечислены директивы, которые будет учитывать робот при индексировании сайта.

Анализ robots.txt в Яндекс.ВебмастерЕсли будет найдена ошибка, информация об этом будет показана вам.

В заключение

Для некоторых сайтов WordPress нет необходимости срочно изменять стандартный виртуальный файл robots.txt (по умолчанию). Но, если вам нужен физический файл robots.txt, то используйте плагины Robots.txt Editor, All in One SEO Pack или Yoast SEO. С ними можно легко редактировать файл прямо из панели инструментов WordPress, чтобы добавить свои собственные правила.

До новых встреч, друзья и я надеюсь, что вам понравилось это маленькое руководство. И не стесняйтесь, обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы по использованию файла robots. txt на сайте WordPress.

txt на сайте WordPress.

WordPress Robots.txt и описание мета-директив Robots

Ноябрьская распродажа: сэкономьте 50% в первые три месяца с кодом THANKFUL. Сейчас до 30 ноября.

Линдси Хэлси

Линдси Хэлси — соучредитель компании Pathfinder SEO. У нее более 10 лет опыта работы в области SEO с малым и крупным бизнесом. Линдси уделяет особое внимание обучению владельцев сайтов, фрилансеров и агентств тому, как найти их в Google с помощью пошагового подхода к SEO. Оставайтесь на связи в Твиттере — @linds_halsey.

Что такое файл robots.txt?

Прежде чем поисковые системы просканируют ваш веб-сайт, они проверяют инструкции в файле robots.txt. Robots.txt — очень мощный файл, поэтому будьте осторожны при его обновлении. Дважды проверьте, действительно ли вы сообщаете о своих намеченных целях.

Вы можете просмотреть файл robots.txt на странице www.mywebsite.com/robots.txt.

WordPress и Robots.txt

Разрабатываемые веб-сайты WordPress обычно используют файл robots. txt, чтобы запретить поисковым роботам индексировать веб-сайт. Код выглядит так:

txt, чтобы запретить поисковым роботам индексировать веб-сайт. Код выглядит так:

User-agent: *

Disallow: /

«User-agent:», за которым следует звездочка, адресует все поисковые роботы. «Запретить:», за которым следует косая черта, указывает сканерам не индексировать никакие страницы на веб-сайте.

Чтобы обновить файл robots.txt, перейдите к настройкам чтения на своем веб-сайте WordPress. Когда вы будете готовы к тому, что поисковые системы и люди будут посещать ваш сайт, перейдите в «Настройки» > «Чтение» в меню слева и снимите флажок «Запретить поисковым системам индексировать этот сайт».

Тогда ваш файл robots.txt будет выглядеть так:

User-Agent: *

Disallow:

Мы рекомендуем очень чистый файл robots.txt, так как помимо его страниц поисковые системы также любят сканировать JavaScript вашего сайта. , CSS и Ajax.

Должен ли я добавить свою XML-карту сайта в файл robots.txt?

Вместо добавления XML-карты сайта в файл robots.

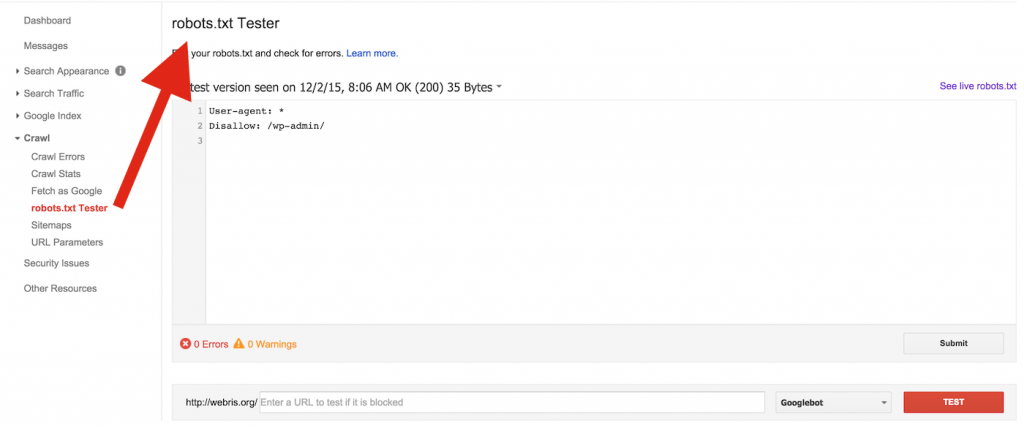

Как обновить файл robots.txt в WordPress?

Самый простой способ обновить файл robots.txt в WordPress — плагин Yoast SEO.

- Войдите на свой сайт WordPress.

- В левой панели навигации выберите Yoast > Инструменты и щелкните Редактор файлов.

- Обновите файл robots.txt.

Что такое метадирективы robots?

Метадирективы роботов содержат четкие подробные инструкции о том, как поисковые системы должны сканировать и индексировать содержимое отдельной страницы.

Наиболее распространенные значения содержимого:

- Nofollow — не переходить по ссылкам в содержании страницы.

- Follow — переходите по ссылкам в содержании страницы.

- Noindex — Не индексировать страницу.

- Индекс – Проиндексируйте страницу, пожалуйста.

Если вы хотите исключить страницу из результатов поиска, но хотите, чтобы сканеры переходили по ссылкам на этой странице, используйте:

Как добавить метадирективу robots в WordPress?

Yoast SEO упрощает обновление метадиректив роботов на уровне типа контента и таксономии.

- Войдите на свой веб-сайт WordPress и перейдите к плагину Yoast SEO в левой панели навигации.

- Выберите вид поиска.

- Чтобы изменить мета-директиву типа контента, переместите ползунок с «Да» на «Нет» в разделе «Показывать [тип контента] в результатах поиска?» раздел. Сохраните изменения.

В заключение

Мета-директивы роботов могут быть мощным инструментом SEO. Узнайте, как правильно их использовать, и вы сможете лучше управлять тем, как Google и Bing взаимодействуют с вашим сайтом.

Хотите узнать больше о WordPress SEO, ознакомьтесь с нашим Руководством по SEO.

Линдси Хэлси

Линдси Хэлси — соучредитель компании Pathfinder SEO. У нее более 10 лет опыта работы в области SEO с малым и крупным бизнесом. Линдси уделяет особое внимание обучению владельцев сайтов, фрилансеров и агентств тому, как найти их в Google с помощью пошагового подхода к SEO. Оставайтесь на связи в Твиттере — @linds_halsey.

Контакт

[email protected]

+1-970-924-0599

Социальное

Что такое файл robots.txt?

Файл robots.txt — это директива для сканеров поисковых систем относительно того, к каким URL-адресам на вашем сайте они могут получить доступ.

Файл robots.txt используется главным образом для управления бюджетом сканирования и предотвращения перегрузки сервера запросами. Однако он не защищает веб-страницу от Google. Для этого заблокируйте индексацию с помощью noindex или защитите страницу паролем.

Как robots. txt влияет на разные типы файлов?

txt влияет на разные типы файлов? 1. Веб-страницы

Файл robots.txt для веб-страниц (PDF, HTML или другие немедийные форматы, читаемые Google) может предотвратить перегрузку вашего сервера запросами сканера. Кроме того, файл robots.txt может предотвратить сканирование неважных или похожих страниц на вашем сайте.

Однако не рекомендуется использовать файл robots.txt для скрытия ваших страниц из результатов поиска Google. Если дополнительные страницы указывают на описательный текст на вашей странице, Google все равно может проиндексировать URL-адрес, не посещая страницу. Заблокируйте свою страницу из результатов поиска с помощью noindex или защиты паролем.

Обратите внимание: если вы заблокируете свою веб-страницу с помощью файла robots.txt, ее URL-адрес все равно может отображаться в результатах поиска. Однако результат не будет содержать описания, а мультимедийные файлы, такие как файлы видео и изображений, PDF-файлы и другие файлы, отличные от HTML, будут проигнорированы.

Тем не менее, пользователи или другие страницы могут ссылаться на ваши медиафайлы с других страниц. Если вы видите результаты поиска для своей страницы, исправьте это, удалив запись robots.txt, блокирующую страницу. Чтобы полностью скрыть страницу из Поиска, воспользуйтесь другим способом.

2. Файлы ресурсов

Если вы считаете, что ваши страницы загружены файлами ресурсов, такими как неважные сценарии, изображения или файлы стилей, файл robots.txt может их заблокировать. Тем не менее, убедитесь, что блокировка этих страниц не будет существенно затронута потерей. Например, не блокируйте их, если их отсутствие затруднит понимание страницы поисковым роботом Google; в противном случае Google не будет адекватно анализировать страницы, зависящие от этих ресурсов.

Каковы ограничения блокировки файла robots.txt?Не все поисковые системы поддерживают директивы файла robots.txt

Googlebot и другие уважаемые поисковые роботы соблюдают директивы файла robots.