Как создать файл robots.txt для WordPress. 4 способа

Всем, привет! Сегодня небольшой пост — как автоматически создать файл robots.txt для WordPress? Друзья, вы можете создать правильный robots.txt для WordPress в пару кликов, прочитав данное руководство. Создание правильного файла robots.txt для WordPress очень важно. Благодаря ему поисковые системы будут знать, какие страницы индексировать и показывать в поиске. То есть, результаты поиска будут именно такими, как вам нужно, без дублирования страниц WordPress.

robots.txt для сайта WordPressЧитайте, дамы и господа — WordPress robots.txt: лучшие примеры для SEO.

Файл robots.txt для WordPress

WordPress robots.txt где лежит/находится? По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Таким образом, даже если вы ни чего не делали, на вашем сайте ВордПресс уже должен быть файл robots.txt. Вы можете проверить, так ли это, добавив /robots. txt в конец вашего доменного имени. Например, так https://ваш сайт/robots.txt

txt в конец вашего доменного имени. Например, так https://ваш сайт/robots.txt

Поскольку этот файл является виртуальным, вы не можете его редактировать. Однако, если вы хотите отредактировать свой файл robots.txt WordPress как надо, вам необходимо создать физический файл на вашем хостинге. Создайте свой правильный robots.txt для WordPress, который вы сможете легко редактировать по мере необходимости.

Как создать файл robots.txt для WordPress

Robots.txt — это текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем.

Файл robots.txt сообщает поисковым роботам, какие страницы или файлы на вашем сайте можно или нельзя обрабатывать.

Яндекс и Google

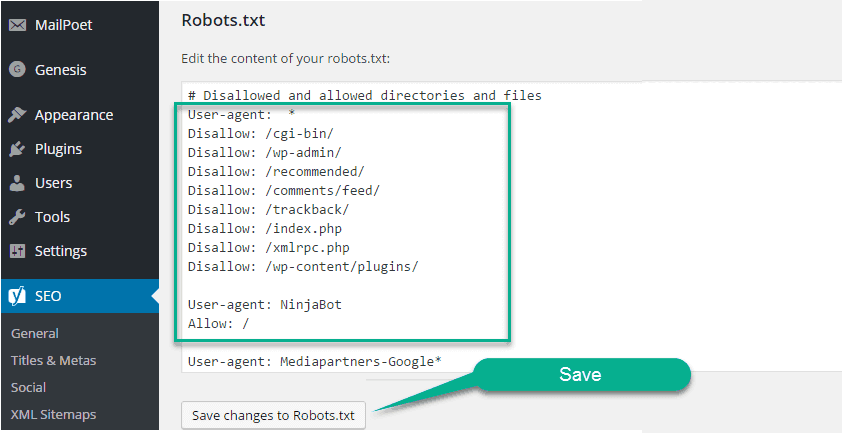

Для начала напомню вам, создать (и редактировать) файл robots.txt для WordPress можно вручную и с помощью плагина Yoast SEO

Создать файл robots.txtДрузья, имейте ввиду, что Yoast SEO устанавливает свои правила по умолчанию, которые перекрывают правила существующего виртуального файла robots. txt ВордПресс:

txt ВордПресс:

Что должно быть в правильно составленного robots.txt? Идеального файла не существует. Например, сайт Yoast SEO использует такой robots.txt для WordPress:

User-agent: *

И всё. Для большинства сайтов WordPress лучший пример. Вот даже скриншот сделал у Yoast SEO:

Что это значит? Директива говорит что, все поисковые роботы могут свободно сканировать этот сайт без ограничений. Этого хватит для правильной индексации сайта WP. А наша SEO специалисты рекомендуют почти тоже самое. Пример, правильно составленного robots.txt для WordPress сайта:

User-agent: * Disallow: Sitemap: https://mysite.ru/sitemap.xml

Данная запись в файле роботс делает доступным для индексирования полностью сайт для роботов всех известных поисковиков. Здесь, также прописан путь к карте сайта XML.

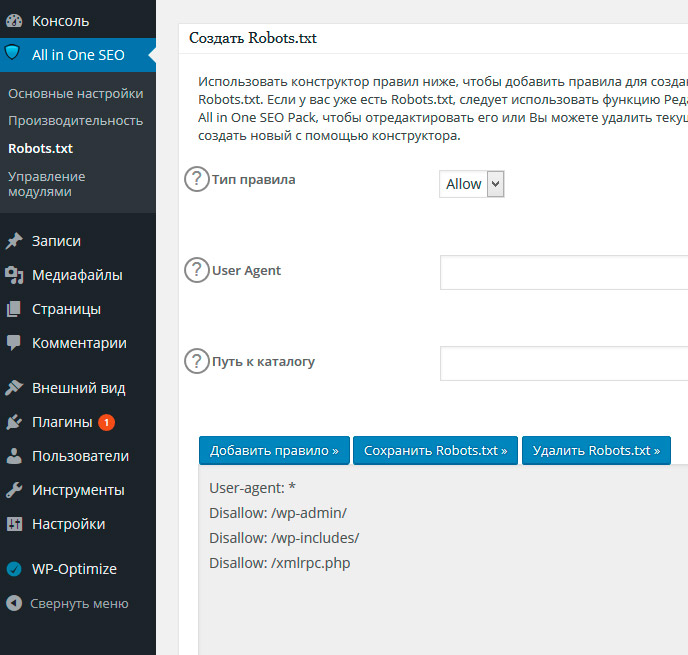

Создать и редактировать файл также можно при помощи All in One SEO Pack прямо из интерфейса SEO плагина.

Вы сможете управлять своим файлом Robots.txt, в разделе All in One SEO Pack — Robots.txt. Сам официальный сайт плагина использует вот такой роботс:

Пример файла RobotsПравила по умолчанию, которые отображаются в поле Создать файл Robots.txt (показано на снимке экрана выше), требуют, чтобы роботы не сканировали ваши основные файлы WordPress. Для поисковых систем нет необходимости обращаться к этим файлам напрямую, потому что они не содержат какого-либо релевантного контента сайта.

А если вы не используете данные SEO модули, то предлагаю вам воспользоваться специальным плагином — Robots.txt Editor.

Плагин Robots.txt Editor

Плагин Robots.txt для WordPress — создание и редактирование файла robots.txt для сайта ВордПресс. Очень простой, лёгкий и эффективный плагин.

Плагин Robots.txt Editor (редактор) позволяет создать и редактировать файл robots.txt на вашем сайте WordPress.

Плагин Robots.txt возможности

- Работает в сети сайтов Multisite на поддоменах;

- Пример правильного файла robots.txt для WordPress;

- Не требует дополнительных настроек;

- Абсолютно бесплатный.

Как использовать? Установите плагин robots.txt стандартным способом. То есть, из админки. Плагины — Добавить новый. Введите в окно поиска его название — Robots.txt Editor:

Добавить плагин Robots.txt EditorУстановили и сразу активировали. Всё, готово. Теперь смотрим, что получилось. Заходим, Настройки — Чтение и видим результат. Автоматически созданный правильный файл robots.txt для WordPress со ссылкой на ваш файл Sitemap. Пример, правильный robots.txt для сайта ВордПресс:

Созданный файл robots.txt WordPressЕстественно, вы можете его легко отредактировать под свои нужды. А также просмотреть, нажав соответствующею ссылку — Просмотр robots. txt.

txt.

Как создать robots.txt вручную

Если вы не захотите использовать плагины, которые предлагают функцию robots.txt, вы все равно можете создать и управлять своим файлом robots.txt на своём хостинге. Как создать файл robots.txt самостоятельно?

В текстовом редакторе создайте файл с именем robots в формате txt и заполните его:

Создать файл с именем robots.txtФайл должен иметь имя robots.txt и никакое другое больше. Сохраните данный файл локально на компьютере. А затем, загрузите созданный файл в корневую директорию вашего сайта.

Корневая папка (корневая директория/корневой каталог/корень документа) — это основная папка, в которой хранятся все файлы сайта. Обычно, это папка public_html (там где находятся файлы — .htaccess, wp-config.php и другие). Именно в эту папку загружается файл robots.txt:

Загрузите файл в корневую папку вашего сайтаЧтобы проверить, получилось ли у вас положить файл в нужное место, перейдите по адресу: https://ваш_сайт.ru/robots. txt

txt

Теперь, когда ваш файл robots.txt создан и загружен на сайт, вы можете проверить его на ошибки.

Проверка вашего файла robots.txt

Вы можете проверить файл robots.txt WordPress в Google Search Console и Яндекс.Вебмастер, чтобы убедиться, что он правильно составлен.

Например, проверка файла robots.txt WordPress в Яндекса.Вебмастер. В блоке Результаты анализа robots.txt перечислены директивы, которые будет учитывать робот при индексировании сайта.

Анализ robots.txt в Яндекс.ВебмастерЕсли будет найдена ошибка, информация об этом будет показана вам.

В заключение

Для некоторых сайтов WordPress нет необходимости срочно изменять стандартный виртуальный файл robots.txt (по умолчанию). Но, если вам нужен физический файл robots.txt, то используйте плагины Robots.txt Editor, All in One SEO Pack или Yoast SEO. С ними можно легко редактировать файл прямо из панели инструментов WordPress, чтобы добавить свои собственные правила.

До новых встреч, друзья и я надеюсь, что вам понравилось это маленькое руководство. И не стесняйтесь, обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы по использованию файла robots.txt на сайте WordPress.

И не стесняйтесь, обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы по использованию файла robots.txt на сайте WordPress.

что это такое и как его использовать в WordPress

Всем привет!

Сегодня я выношу на ваш суд полное руководство по файлу robots.txt для WordPress. Удачно оно или нет — решать вам. Но думаю многие почерпнут из него много интересных и нужных знаний.

Когда-нибудь слышали термин robots.txt и задавались вопросом, как он применяется к вашему сайту? Большинство веб-сайтов имеют файл robots.txt, но это не означает, что большинство веб-мастеров понимают его. В этом посте я надеюсь изменить это, предложив глубокое погружение в файл WordPress robots.txt, а также узнав, как он может контролировать и ограничивать доступ к вашему сайту. К концу вы сможете ответить на такие вопросы, как:

Оглавление

- Что такое WordPress robots.txt?

- Как robots.txt помогает моему сайту?

- Как я могу добавить robots.

txt в WordPress?

txt в WordPress? - Какие правила я могу добавить в robots.txt?

- Как я могу проверить мой файл robots.txt?

- Как большие и популярные сайты реализуют robots.txt?

Есть еще много чего, так что давайте начнем!

Ко мне часто поступают вопросы про хостинг, которым я пользуюсь и поэтому решил указать хостинг в статье https://sprinthost.ru. Вы можете попробовать попользоваться хостингом 30 дней бесплатно. Чтобы понять, как будет работать Ваш сайт на этом хостинге просто перенести свой сайт (в этом поможет поддержка хостинга бесплатно) и и таким образом сможете понять подходит хостинг Вам или нет. На этом хостинге находятся сайты с 20 000 тысяч посещаемость и сайты чувствуют себя отлично. Рекомендую! Да, если делать оплату на 1 год то получаете скидку 25%. И что мне нравится — тех. поддержка всегда помогает в технических вопросах, за что им спасибо. Как Вы понимаете не всегда проходит всё гладко и нет желания, чтобы сайт не был доступен тем самым страдал трафик и доход.

Что такое WordPress robots.txt?

Прежде чем мы сможем поговорить о файле robots.txt в WordPress, важно определить, что такое «robot» в этом случае. Роботы — это любой тип «бота», который посещает веб-сайты в интернете. Наиболее распространенный пример — поисковые роботы. Эти боты «ползают» по сети, чтобы помочь таким поисковым системам, как Яндекс и Google, и ранжировать миллиарды страниц в интернете.

Итак, боты, в общем, полезны для интернета … или, по крайней мере, необходимы. Но это не обязательно означает, что вы или другие веб-мастера хотите, чтобы боты бегали без ограничений. Желание контролировать взаимодействие веб-роботов с веб-сайтами привело к созданию стандарта исключения роботов в середине 1990-х годов. Robots.txt является практической реализацией этого стандарта — он позволяет вам контролировать, как участвующие боты взаимодействуют с вашим сайтом. Вы можете полностью блокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Эта «участвующая» часть важна. Robots.txt не может заставить бота следовать его директивам. А вредоносные боты могут и будут игнорировать файл robots.txt. Кроме того, даже авторитетные организации игнорируют некоторые команды, которые вы можете поместить в robots.txt. Например, Google будет игнорировать любые правила, которые вы добавляете в свой robots.txt, относительно того, как часто его сканеры посещают. Если у вас много проблем с ботами, вам может пригодиться решение для безопасности, такое как Cloudflare или Sucuri.

Почему вы должны заботиться о своем файле robots.txt?

Для большинства веб-мастеров преимущества хорошо структурированного файла robots.txt сводятся к двум категориям:

- Оптимизация ресурсов сканирования поисковых систем, сказав им не тратить время на страницы, которые вы не хотите индексировать. Это помогает поисковым системам сосредоточиться на сканировании страниц, которые вас интересуют больше всего.

- Оптимизация использования ваших исследований путем блокировки ботов, которые тратят ресурсы вашего сервера.

Robots.txt не касается конкретно того, какие страницы индексируются в поисковых системах

Robots.txt не является надежным способом контроля того, какие страницы индексируют поисковые системы. Если ваша основная цель состоит в том, чтобы не допустить включения определенных страниц в результаты поиска, правильный подход — использовать метатег «noindex» или другой аналогичный прямой метод.

Это потому, что ваш robots.txt прямо не говорит поисковым системам не индексировать контент — он просто говорит им не сканировать его. Хотя Google не будет сканировать отмеченные области внутри вашего сайта, Google сам заявляет, что если внешний сайт ссылается на страницу, которую вы исключаете в файле robots.txt, Google все равно может проиндексировать эту страницу.

Джон Мюллер, аналитик Google для веб-мастеров, также подтвердил, что, если на страницу есть ссылки, указывающие на нее, даже если она заблокирована файлом robots.txt, она все равно может быть проиндексирована. Вот что он хотел сказать в видеовстрече для веб-мастеров:

Вот что он хотел сказать в видеовстрече для веб-мастеров:

Здесь следует иметь в виду одну вещь: если эти страницы заблокированы файлом robots.txt, теоретически может случиться так, что кто-то случайным образом сделает ссылку на одну из этих страниц. И если они это сделают, то может случиться так, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован robots.txt. Таким образом, мы бы не знали, что вы не хотите, чтобы эти страницы были действительно проиндексированы.

Принимая во внимание, что если они не заблокированы robots.txt, вы можете поместить метатег «noindex» на эти страницы. И если кто-то ссылается на них, и мы случайно просматриваем эту ссылку и думаем, что здесь может быть что-то полезное, мы бы знали, что эти страницы не нужно индексировать, и мы можем просто пропустить их индексацию полностью.

Таким образом, в этом отношении, если на этих страницах есть что-то, что вы не хотите индексировать, не запрещайте их, используйте вместо этого тег «noindex».

Как создать и отредактировать файл robots.txt

По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Таким образом, даже если вы не поднимите палец для этого, на вашем сайте уже должен быть файл robots.txt по умолчанию. Вы можете проверить, так ли это, добавив «/robots.txt» в конец вашего доменного имени. Например, «https://zacompom.ru/robots.txt» вызывает файл robots.txt, который я используем здесь:

Пример файла robots.txt

Поскольку этот файл является виртуальным, вы не можете его редактировать. Если вы хотите отредактировать свой файл robots.txt, вам необходимо создать физический файл на вашем сервере, которым вы сможете манипулировать по мере необходимости. Вот три простых способа сделать это …

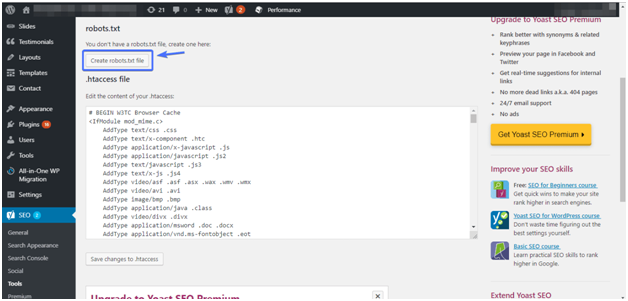

Как создать и отредактировать файл robots.txt с помощью Yoast SEO

Если вы используете популярный плагин Yoast SEO, вы можете создать (и отредактировать) свой файл robots.txt прямо из интерфейса Yoast. Однако прежде чем вы сможете получить к нему доступ, вам нужно включить расширенные функции Yoast SEO, перейдя в раздел «SEO — Панель инструментов — Функции» и переключиться на «Страницах» — «Дополнительные настройки»:

Как включить расширенные функции Yoast

После того, как это активировано, вы можете перейти к «SEO — Инструменты» и нажать на «Редактор файлов»:

Как получить доступ к редактору файлов Yoast

Предполагая, что у вас еще нет физического файла robots. txt, Yoast предложит вам «создать файл robots.txt»:

txt, Yoast предложит вам «создать файл robots.txt»:

Как создать robots.txt в Yoast

И после того, как вы нажмете эту кнопку, вы сможете редактировать содержимое файла robots.txt непосредственно из того же интерфейса:

Как редактировать robots.txt в Yoast

По мере того, как вы читаете дальше, мы более подробно рассмотрим, какие типы директив следует поместить в ваш файл robots.txt.

Как создать и отредактировать файл robots.txt в «All In One SEO»

Если вы используете плагин СЕО-пакета «All In One SEO» в формате Yoast, вы также можете создавать и редактировать файл robots.txt прямо из интерфейса плагина. Все, что вам нужно сделать, это зайти в «All In One SEO — Диспетчер по функциям» и активировать robots.txt функции:

Как создать robots.txt в All in One SEO Pack

Затем вы сможете управлять своим файлом robots.txt, перейдя в раздел «All in One SEO Pack — Robots.txt»:

Как редактировать robots.txt в All in One SEO Pack

Как создать и редактировать файл robots.

txt через FTP

txt через FTPЕсли вы не используете плагин SEO, который предлагает функциональность robots.txt, вы все равно можете создавать и управлять своим файлом robots.txt через SFTP. Сначала используйте любой текстовый редактор, чтобы создать пустой файл с именем «robots.txt»:

Как создать свой собственный файл robots.txt

Затем подключитесь к своему сайту через SFTP и загрузите этот файл в корневую папку вашего сайта. Вы можете внести дополнительные изменения в свой файл robots.txt, отредактировав его через SFTP или загрузив новую версию файла.

Что надо прописывать в ваш файл robots.txt

Хорошо, теперь у вас есть физический файл robots.txt на вашем сервере, который вы можете редактировать по мере необходимости. Но что вы на самом деле можете делать с этим файлом? Ну, как вы узнали из первого раздела, robots.txt позволяет вам контролировать взаимодействие роботов с вашим сайтом. Вы делаете это с помощью двух основных команд:

- User-agent — позволяет вам ориентироваться на конкретных ботов.

User-agent — это то, что боты используют для идентификации себя. С их помощью вы можете, например, создать правило, которое применяется к Яндекс, но не к Google.

User-agent — это то, что боты используют для идентификации себя. С их помощью вы можете, например, создать правило, которое применяется к Яндекс, но не к Google. - Disallow — эта директива позволяет вам запретить роботам доступ к определенным областям вашего сайта.

Также есть команда Allow, которую вы будете использовать в нишевых ситуациях. По умолчанию все на вашем сайте помечено как Allow, поэтому нет необходимости использовать команду Allow в 99% случаев. Но это очень удобно, когда вы хотите запретить (Disallow) доступ к папке и ее дочерним папкам, но разрешить (Allow) доступ к одной определенной дочерней папке.

Вы добавляете правила, сначала указывая, к какому User-agent должно применяться правило, а затем перечисляя, какие правила применять, используя Disallow и Allow. Есть также некоторые другие команды, такие как Crawl-delay и Sitemap, но они либо:

- Игнорируется большинством основных сканеров или интерпретируется совершенно по-разному (в случае задержки сканирования)

- Сделано избыточным с помощью таких инструментов, как Google Search Console (для файлов сайтов)

Давайте рассмотрим некоторые конкретные случаи использования, чтобы показать вам, как все это происходит вместе.

Как использовать robots.txt, чтобы заблокировать доступ ко всему сайту

Допустим, вы хотите заблокировать доступ всем сканерам к вашему сайту. Это вряд ли произойдет на живом сайте, но это пригодится для разработки сайта. Для этого вы должны добавить этот код в ваш файл WordPress robots.txt:

User-agent: *

Disallow: /

Что происходит в этом коде?

Звездочка (*) рядом с User-agent означает «все User-agent». Звездочка — это подстановочный знак, означающий, что он применяется к каждому агенту пользователя. Слэш (/) рядом с Disallow говорит, что вы хотите, чтобы запретить доступ ко всем страницам, которые содержат «yourdomain.com/» (каждую страницу на вашем сайте).

Как использовать robots.txt, чтобы заблокировать доступ одного сайта к вашему сайту

Давайте изменим это. В этом примере мы представим, что вам не нравится тот факт, что Bing сканирует ваши страницы. Вы — команда Google, и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать только Bing от сканирования вашего сайта, вы должны заменить звездочку (*) с Bingbot:

User-agent: Bingbot

Disallow: /

По существу, приведенный выше код говорит только применить правило Disallow для бота с именем «Bingbot».

Как использовать robots.txt, чтобы заблокировать доступ к определенной папке или файлу

В этом примере предположим, что вы хотите заблокировать доступ только к определенному файлу или папке (и всем подпапкам этой папки). Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

- Вся папка wp-admin

- wp-login.php

Вы можете использовать следующие команды:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-login.php

Как использовать robots.txt, чтобы разрешить доступ к определенному файлу в запрещенной папке

Хорошо, теперь давайте скажем, что вы хотите заблокировать всю папку, но вы по-прежнему хотите разрешить доступ к определенному файлу внутри этой папки. Вот где команда Allow пригодится. И это на самом деле очень применимо к WordPress. Фактически, виртуальный файл WordPress robots.

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Этот фрагмент кода блокирует доступ ко всей папки wp-admin, за исключением файла /wp-admin/admin-ajax.php.

Как использовать robots.txt, чтобы остановить роботов от сканирования результатов поиска WordPress

Один из специфических трюков WordPress, который вы можете захотеть сделать — запретить поисковым роботам сканировать страницу результатов поиска. По умолчанию WordPress использует параметр запроса «?S=». Таким образом, чтобы заблокировать доступ, все, что вам нужно сделать, это добавить следующее правило:

User-agent: *

Disallow: /?s=

Disallow: /search/

Это может быть эффективным способом остановки программных ошибок 404, если вы их получаете.

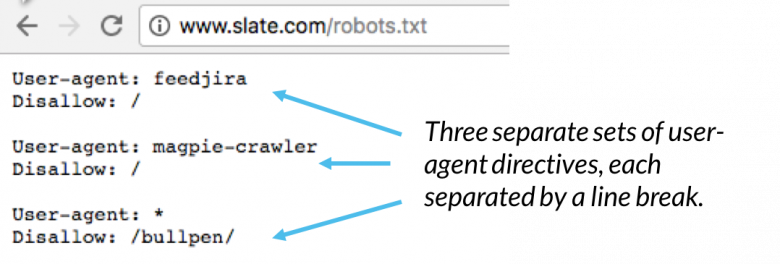

Как создать разные правила для разных ботов в robots.txt

До сих пор все примеры имели дело с одним правилом за раз. Но что, если вы хотите применить разные правила к разным ботам? Вам просто нужно добавить каждый набор правил в декларацию User-agent для каждого бота. Например, если вы хотите создать одно правило, которое применяется ко всем ботам, и другое правило, которое относится только к Bingbot, вы можете сделать это следующим образом:

Например, если вы хотите создать одно правило, которое применяется ко всем ботам, и другое правило, которое относится только к Bingbot, вы можете сделать это следующим образом:

User-agent: *

Disallow: /wp-admin/

User-agent: Bingbot

Disallow: /

В этом примере всем ботам будет заблокирован доступ к /wp-admin/, но Bingbot будет запрещен доступ ко всему сайту.

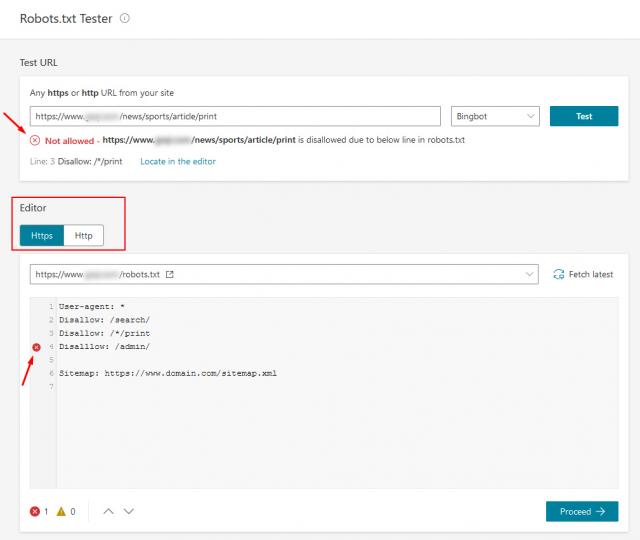

Тестирование вашего файла robots.txt

Вы можете проверить файл robots.txt в консоли поиска Google, чтобы убедиться, что он правильно настроен. Просто нажмите на свой сайт, и в разделе «Сканирование» нажмите «Тестировать robots.txt». Затем вы можете отправить любой URL, включая свою домашнюю страницу. Вы должны увидеть зеленый Allowed, если все можно сканировать. Вы также можете проверить заблокированные URL-адреса, чтобы убедиться, что они действительно заблокированы и/или Disallowed.

Тест файла robots.txt

Остерегайтесь спецификации UTF-8

Спецификация обозначает метку порядка байтов и в основном является невидимым символом, который иногда добавляется в файлы старыми текстовыми редакторами и т. п. Если это происходит с вашим файлом robots.txt, Google может не прочитать его правильно. Вот почему важно проверить ваш файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется, что синтаксис не понятен. Это фактически делает недействительной первую строку нашего файла robots.txt, что не очень хорошо! У Гленна Гейба есть отличная статья о том, как UTF-8 BOM может убить ваше СЕО.

п. Если это происходит с вашим файлом robots.txt, Google может не прочитать его правильно. Вот почему важно проверить ваш файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется, что синтаксис не понятен. Это фактически делает недействительной первую строку нашего файла robots.txt, что не очень хорошо! У Гленна Гейба есть отличная статья о том, как UTF-8 BOM может убить ваше СЕО.

UTF-8 BOM в вашем файле robots.txt

Googlebot в основном в США

Также важно не блокировать робота Google из США, даже если вы ориентируетесь на местный регион за пределами США. Иногда они выполняют локальное сканирование, ну а робот Google в основном базируется в США.

Что помещают в свои файлы robots.txt популярные сайты на WordPress

Чтобы фактически обеспечить некоторый контекст для пунктов, перечисленных выше, вот как некоторые из самых популярных сайтов на WordPress используют свои файлы robots.txt.

TechCrunch

В дополнение к ограничению доступа к ряду уникальных страниц TechCrunch особенно запрещает сканерам:

- /wp-admin/

- /wp-login.

php

php

Они также устанавливают специальные ограничения для двух ботов:

- Swiftbot

- IRLbot

В случае, если вам интересно, IRLbot является краулером исследовательского проекта Texas A&M University. Это странно!

The Obama Foundation

The Obama Foundation не сделал никаких специальных дополнений, решив исключительно ограничить доступ к папке /wp-admin/.

Angry Birds

Angry Birds имеет ту же настройку по умолчанию, что и The Obama Foundation. Ничего особенного не добавляется.

Drift

Наконец, Drift решает определить свои sitemap сайта в файле robots.txt, но в противном случае оставляет те же ограничения по умолчанию, что и The Obama Foundation и Angry Birds.

Используйте файл robots.txt правильно

Завершая свое руководство по robots.txt, я хотел бы еще раз напомнить вам, что использование команды Disallow в вашем файле robots.txt отличается от использования тега noindex. Robots.txt блокирует сканирование, но не индексирование. Вы можете использовать его для добавления определенных правил, чтобы определить, как поисковые системы и другие боты взаимодействуют с вашим сайтом, но он не будет явно контролировать, проиндексирован ли ваш контент или нет.

Вы можете использовать его для добавления определенных правил, чтобы определить, как поисковые системы и другие боты взаимодействуют с вашим сайтом, но он не будет явно контролировать, проиндексирован ли ваш контент или нет.

Для большинства случайных пользователей WordPress нет необходимости срочно изменять виртуальный файл robots.txt по умолчанию. Но если у вас проблемы с конкретным ботом или вы хотите изменить взаимодействие поисковых систем с определенным плагином или темой, которую вы используете, вы можете добавить свои собственные правила.

Я надеюсь, что вам понравилось это руководство, и обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы об использовании файла robots.txt в WordPress.

До скорых встреч!

Юрич:

Занимаюсь созданием сайтов на WordPress более 6 лет. Ранее работал в нескольких веб-студиях и решил делиться своим опытом на данном сайте. Пишите комментарии, буду рад общению.

Как оптимизировать файл WordPress Robots.

txt для SEO?

txt для SEO?Вы оптимизировали файл WordPress Robots.txt для SEO? Если нет, вы игнорируете важный аспект SEO, который играет важную роль

.Вы оптимизировали файл WordPress Robots.txt для SEO? Если вы этого не сделали, вы игнорируете важный аспект SEO. Файл robots.txt играет важную роль в SEO вашего сайта. Вам повезло, что WordPress автоматически создает для вас файл Robots.txt. Иметь этот файл — половина дела. Вы должны убедиться, что файл Robots.txt оптимизирован для получения всех преимуществ.

Файл Robots.txt сообщает роботам поисковых систем, какие страницы следует сканировать, а какие избегать. Этот пост покажет вам, как редактировать и оптимизировать файлы Robots.txt в WordPress.

Оптимизация файла WordPress Robots.txt для SEO

Как оптимизировать файл WordPress Robots.txt для SEO? Что такое файл robots.txt? Начнем с основ. Файл Robots.txt — это текстовый файл, который указывает ботам поисковых систем сканировать и индексировать сайт. Всякий раз, когда роботы поисковых систем заходят на ваш сайт, они читают файл robots.txt и следуют инструкциям. Используя этот файл, вы можете указать, какую часть вашего сайта следует сканировать, а какую функцию следует избегать. Однако отсутствие файла robots.txt не помешает роботам поисковых систем сканировать и индексировать ваш сайт.

Файл Robots.txt — это текстовый файл, который указывает ботам поисковых систем сканировать и индексировать сайт. Всякий раз, когда роботы поисковых систем заходят на ваш сайт, они читают файл robots.txt и следуют инструкциям. Используя этот файл, вы можете указать, какую часть вашего сайта следует сканировать, а какую функцию следует избегать. Однако отсутствие файла robots.txt не помешает роботам поисковых систем сканировать и индексировать ваш сайт.

Я уже говорил, что каждый сайт WordPress имеет файл robots.txt по умолчанию в корневом каталоге. Вы можете проверить файл robots.txt, перейдя по адресу http://yourdomain.com/robots.txt. Например, вы можете просмотреть наш файл robots.txt здесь: https://visualmodo.com/robots.txt

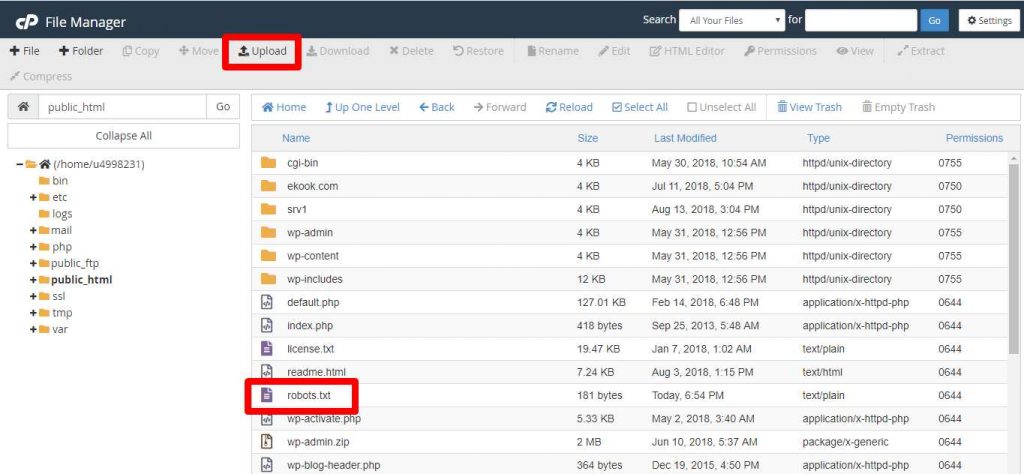

Если у вас нет файла robots.txt, вам придется его создать. Это очень легко сделать. Просто создайте текстовый файл на своем компьютере, сохраните его как robots.txt и загрузите в корневой каталог. Вы можете загрузить его через FTP-менеджер или файловый менеджер cPanel.

Вы можете загрузить его через FTP-менеджер или файловый менеджер cPanel.

Редактирование файлов

Теперь давайте посмотрим, как редактировать файл robots.txt.

Вы можете редактировать файл robots.txt с помощью диспетчера FTP или файлового менеджера cPanel. Но это долго и немного сложно.

Лучший способ редактировать файлы Robots.txt — использовать подключаемый модуль. Существует несколько плагинов WordPress robots.txt. Я предпочитаю Yoast SEO. Это лучший SEO-плагин для WordPress. Я уже рассказывал, как настроить Yoast SEO.

Yoast SEO позволяет вам изменять файл robots.txt из области администрирования WordPress. Однако, если вы не хотите использовать плагин Yoast, вы можете использовать другие плагины, такие как WP Robots Txt.

Видеоруководство

Установив и активировав плагин Yoast SEO, перейдите в Панель администратора WordPress > SEO > Инструменты.

Затем нажмите «Редактор файлов».

Во-вторых, нажмите «Редактор файлов».

Затем нужно нажать «Создать файл robots.txt».

Редактирование файла robots.txtПосле этого вы получите редактор файла Robots.txt. Здесь вы можете настроить файл robots.txt.

ФайлыПеред редактированием файла необходимо понять команды файла. В основном это три команды.

- User-agent — определяет имя ботов поисковых систем, таких как Googlebot или Bingbot. Вы можете использовать звездочку (*) для обозначения всех ботов поисковых систем.

- Запретить – указывает поисковым системам не сканировать и не индексировать некоторые части вашего сайта.

- Разрешить – указывает поисковым системам сканировать и индексировать, какие части вы хотите индексировать.

Вот пример файла Robots.txt.

Агент пользователя: * Запретить: /wp-admin/ Разрешить: /

Этот файл robots. txt указывает всем ботам поисковых систем сканировать сайт. Вторая строка указывает ботам поисковых систем не сканировать часть /wp-admin/. В 3-й строке он указывает ботам поисковых систем сканировать и индексировать весь веб-сайт.

txt указывает всем ботам поисковых систем сканировать сайт. Вторая строка указывает ботам поисковых систем не сканировать часть /wp-admin/. В 3-й строке он указывает ботам поисковых систем сканировать и индексировать весь веб-сайт.

Простая ошибка в настройке файла Robots.txt может привести к полной деиндексации вашего сайта поисковыми системами. Например, если вы используете команду «Запретить: /» в файле Robots.txt, ваш сайт будет деиндексирован поисковыми системами. Так что нужно быть осторожным при настройке.

Еще одна важная вещь — оптимизация файла Robots.txt для SEO. Прежде чем перейти к лучшим практикам SEO для Robots.txt, я хотел бы предупредить вас о некоторых плохих практиках.

- Не используйте файл Robots.txt для сокрытия некачественного контента. Лучше всего использовать метатеги noindex и nofollow. Вы можете сделать это с помощью плагина Yoast SEO.

- Не используйте файл Robots.

txt, чтобы запретить поисковым системам индексировать ваши категории, теги, архивы, страницы авторов и т. д. Вы можете добавить на эти страницы метатеги nofollow и noindex с помощью плагина Yoast SEO.

txt, чтобы запретить поисковым системам индексировать ваши категории, теги, архивы, страницы авторов и т. д. Вы можете добавить на эти страницы метатеги nofollow и noindex с помощью плагина Yoast SEO. - Не используйте файл Robots.txt для обработки повторяющегося содержимого. Есть и другие способы.

Теперь давайте посмотрим, как сделать файл Robots.txt оптимизированным для SEO.

- Во-первых, вам нужно определить, какие части вашего сайта не должны сканироваться роботами поисковых систем. Я предпочитаю запрещать /wp-admin/, /wp-content/plugins/, /readme.html, /trackback/.

- Во-вторых, добавление производных «Разрешить: /» в файл Robots.txt не имеет решающего значения, так как боты все равно будут сканировать ваш сайт. Но вы можете использовать его для конкретного бота.

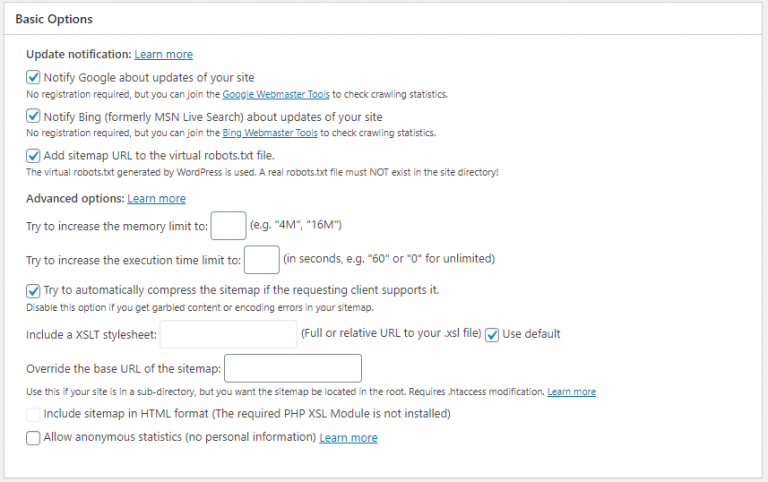

- Наконец, добавление файлов Sitemap в файл Robots.txt также является хорошей практикой. Читайте: Как создать карту сайта

Вот пример идеального файла Robots.

txt для WordPress.

txt для WordPress.Агент пользователя: * Запретить: /wp-admin/ Запретить: /wp-content/plugins/ Запретить: /readme.html Запретить: /трекбэк/ Запретить: /иди/ Разрешить: /wp-admin/admin-ajax.php Разрешить: /wp-content/uploads/ Карта сайта: https://roadtoblogging.com/post-sitemap.xml Карта сайта: https://roadtoblogging.com/page-sitemap.xml

Вы можете проверить файл Robots.txt RTB здесь: https://visualmodo.com/robots.txt

Тестирование файла Robots.txt в Инструментах Google для веб-мастеровПосле обновления файла Robots.txt вам необходимо протестируйте файл Robots.txt, чтобы проверить, влияет ли обновление на какой-либо контент.

Вы можете использовать консоль поиска Google, чтобы проверить, есть ли какие-либо «Ошибки» или «Предупреждения» для вашего файла Robots.txt. Просто войдите в Google Search Console и выберите сайт. Затем перейдите в Crawl > robots.txt Tester и нажмите кнопку «Отправить».

Google Search Console Появится всплывающее окно. Просто нажмите на кнопку «Отправить».

Просто нажмите на кнопку «Отправить».

Затем перезагрузите страницу и проверьте, обновлен ли файл. Таким образом, обновление файла Robots.txt может занять некоторое время.

Если он не был обновлен, вы можете ввести код файла Robots.txt в поле, чтобы проверить наличие ошибок или предупреждений. Более того, он покажет ошибки и предупреждения там.

Код файла robots.txtИтак, если вы заметили какие-либо ошибки или предупреждения в файле robots.txt, вы должны исправить их, отредактировав файл robots.txt.

Заключительные мыслиВ заключение, я надеюсь, что этот пост помог вам оптимизировать файл robots.txt WordPress. Если вы не уверены в этом, не стесняйтесь спрашивать нас в комментариях.

Однако, чтобы сделать ваш блог WordPress оптимизированным для SEO, вы можете прочитать нашу статью о том, как настроить плагин WordPress Yoast SEO.

Наконец, если вы найдете этот пост полезным, пожалуйста, помогите мне, поделившись этим постом на Facebook и Twitter.

Где находится robots.txt в WordPress? (Как получить доступ и изменить его)

Это руководство отвечает на вопрос «Где находится robots.txt в WordPress?»

В нем также объясняется, как получить доступ к файлу robots.txt в WordPress четырьмя различными способами, чтобы вы могли изменить файл для своего веб-сайта.

Считайте это вашим окончательным — и быстрым — руководством по поиску robots.txt в WordPress и легкому доступу к нему, чтобы контролировать, как поисковые роботы сканируют файлы, страницы и каталоги вашего веб-сайта.

Лучшие советы по SEO…

Включите JavaScript

Содержание

1

Где находится robots.txt в WordPress?

Robots.txt находится в корневой папке сайта в каталоге WordPress. Вы можете получить доступ к файлу robots.txt, перейдя по адресу yourdomain.com/robots.txt в веб-браузере, и управлять файлом на сервере с помощью FTP-клиента, плагина или cPanel.

Как получить доступ и изменить файл WordPress Robots.txt

1. Доступ к Robots.txt через cPanel (или альтернативу вашей хостинговой компании)

Первый способ получить доступ к вашему файлу robots.txt WordPress — использовать функцию диспетчера файлов, предлагаемую вашей хостинговой компанией.

Доступ к этому файловому менеджеру зависит от хоста. С хостинг-провайдером, таким как Bluehost, который использует популярный интерфейс cPanel, вы просто выбираете параметры Advanced , а затем Файловый менеджер .

С помощью хостинговых услуг, таких как Hostinger, вы обнаружите, что управление файлами WordPress доступно сразу же, как только вы войдете в свою панель управления, как показано на изображении ниже.

В диспетчере файлов вы найдете файл robots.txt веб-сайта в корневой папке установки WordPress, которая обычно помечается как public_html .

Затем вы можете загрузить файл robots.txt WordPress, изменить его в текстовом редакторе и повторно загрузить на веб-сайт.

2. Используйте плагин SEO

Если вы не хотите входить в свою учетную запись хостинга или управлять файлами непосредственно в корневом каталоге, вы можете получить доступ к файлу robots.txt непосредственно из WordPress с помощью плагина SEO, который вы можете уже установлены на вашем сайте.

Популярные SEO-плагины, такие как Yoast, AIOSEO и Rank Math, позволяют с легкостью редактировать файл robots.txt вашего веб-сайта из панели администратора WordPress.

Вот пример пошагового руководства по этому методу с использованием плагина Yoast SEO. После доступа к меню панели инструментов WordPress выберите Yoast SEO > Инструменты , как показано на изображении ниже.

На экране инструментов Yoast SEO выберите Редактор файлов .

Откроется файл robots.txt вашего сайта WordPress. Затем вы можете изменить его и сохранить изменения в WordPress.

Если вы используете альтернативный плагин SEO для WordPress, такой как Rank Math или AIOSEO, вы также сможете найти файл robots. txt в разделе General Settings в Rank Math и на вкладке Tools для AIOSEO.

txt в разделе General Settings в Rank Math и на вкладке Tools для AIOSEO.

3. Используйте специальный плагин robots.txt

Еще один способ получить доступ и изменить robots.txt в WordPress — использовать плагин, созданный специально для этой цели.

Бесплатный плагин Virtual Robots от Infolific — популярный и невероятно простой в использовании плагин.

После установки и активации плагина перейдите к Настройки > Virtual Robots.txt .

Откроется файл robots.txt WordPress, чтобы вы могли внести любые изменения. Просто не забудьте нажать кнопку «Сохранить», когда закончите, чтобы обновления вступили в силу.

Если вы новичок в WordPress и не знаете, как настроить различные команды и директивы в файле robots.txt, вы можете предпочесть более удобный для начинающих плагин, такой как Better Robots.Txt, который указан как «Оптимизация WordPress Robots.txt» в каталоге плагинов. См. изображение ниже.

Активируйте и установите этот плагин, как и любой другой. После установки он автоматически загружается на панель инструментов WordPress. Вы также можете вернуться к нему в любое время, выбрав Better Robots.txt в меню администрирования.

После установки он автоматически загружается на панель инструментов WordPress. Вы также можете вернуться к нему в любое время, выбрав Better Robots.txt в меню администрирования.

Внутри плагина у вас будет простой в использовании визуальный интерфейс для настройки различных параметров robots.txt, включая поисковые системы, которые могут сканировать ваш сайт, какие функции защиты от спама и данных включить, а также любые настраиваемые правила, которые вы хотите добавить. См. изображения ниже для подробного ознакомления со всеми этими вариантами WordPress.

4. Используйте FTP-клиент для WordPress

Другой способ получить доступ к файлу robots.txt WordPress и изменить его — использовать FTP-клиент, например FileZilla. Если у вас уже есть подобный FTP-клиент, настроенный для вашего веб-сайта, вы можете быстро найти файл robots.txt WordPress.

Начните с получения информации о вашей учетной записи FTP от вашего хостинг-провайдера. Скопируйте эту информацию, откройте Filezilla и вставьте данные в соответствующие поля, расположенные прямо под строкой меню программного обеспечения.

Затем нажмите «Быстрое подключение», и это подключит FTP-клиент к вашему хостинг-серверу, предоставив вам доступ ко всем вашим файлам WordPress.

Отсюда перейдите в корневой каталог, где вы должны найти файл WordPress robots.txt. Чтобы получить доступ к этому файлу, чтобы вы могли открыть и изменить его, щелкните правой кнопкой мыши и нажмите «Загрузить». Кроме того, вы можете выбрать файл и перетащить его на панель локального сервера в Filezilla. Смотрите скриншоты ниже.

Откройте файл robots.txt в текстовом редакторе и внесите необходимые изменения. Когда вы закончите, перейдите к местоположению файла на панели локального сервера, затем щелкните и перетащите файл на сервер удаленного сайта, чтобы загрузить его в WordPress.

Должно появиться всплывающее окно, информирующее вас о том, что целевой файл уже существует на сервере. Выберите действие по перезаписи, затем нажмите «ОК», чтобы успешно обновить файл robots.txt для вашего веб-сайта WordPress.

Robots.