Как создать правильный Robots txt для WordPress

Чтобы помочь поисковым системам правильно индексировать ваш блог, нужно сделать правильный файл Robots txt для WordPress. Посмотрим как его создать и чем наполнить.

Что дает Robots.txt?

Он нужен для поисковых систем, для правильной индексации ими веб-ресурса. Содержимое файла «говорит» поисковому роботу, какие страницы нужно показывать в поиске, а какие скрыть. Это позволяет управлять контентом в поисковой выдаче.

Например, при запросе в Гугле “купить холодильник” конечному покупателю незачем попадать на страницу администрирования магазина. Ему важно перейти сразу в раздел “Холодильники”.

Наполнять robots.txt нужно уже на этапе разработки сайта. Его изменения вступают в силу не сразу. Может пройти неделя или несколько месяцев.

Где находится Robots?

Этот обычный тестовый файл лежит в корневом каталоге сайта. Его можно получить по адресу

https://site.ru/robots.txt

Движок изначально Роботс не создает. Это нужно делать вручную или пользоваться инструментами, которые создают его автоматически.

Не могу найти этот файл

Если по указанному адресу содержимое файл отображается, но на сервере его нет, то значит он создан виртуально. Поисковику все равно. Главное, чтобы он был доступен.

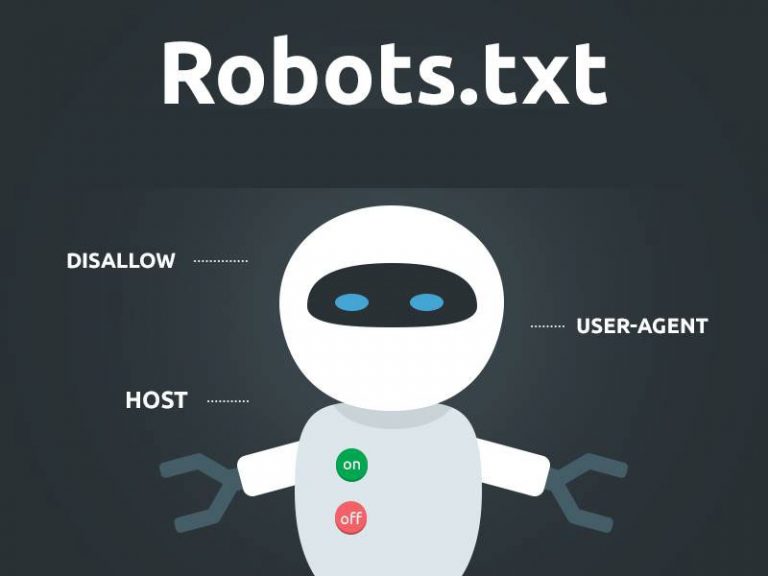

Из чего состоит

Из 4 основных директив:

- User-agent — правила поисковым роботам.

- Disalow — запрещает доступ.

- Allow — разрешает.

- Sitemap — полный URL-адрес карты XML.

Правильный robots.txt для ВордПресс

Вариантов много. Инструкции на каждом сайте отличаются.

Вот пример корректного robots.txt, в котором учтены все разделы сайта. Коротко разберем директивы.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc. php

php

Disallow: /license.txt

Disallow: /readme.html

Disallow: /trackback/

Disallow: /comments/feed/

Disallow: /*?replytocom

Disallow: */feed

Disallow: */rss

Disallow: /author/

Disallow: /?

Disallow: /*?

Disallow: /?s=

Disallow: *&s=

Disallow: /search

Disallow: *?attachment_id=

Allow: /*.css

Allow: /*.js

Allow: /wp-content/uploads/

Allow: /wp-content/themes/

Allow: /wp-content/plugins/

Sitemap: https://site.ru/sitemap_index.xml

В первой строке указывается, что ресурс доступен для всех поисковых роботов (краулеров).

Allow разрешают добавлять в индекс скрипты, стили, файлы загрузок, тем и плагинов.

Последняя — это адрес XML-карты.

Как создать robots.txt для сайта

Рассмотрим несколько методов: вручную и с помощью WordPress-плагинов.

Вручную

Это можно сделать например, в Блокноте (если локальный сервер) или через FTP-клиент (на хостинге).

Вручную добавить robots.txt на сайт проще всего по FTP. Для этого необходимо создать сам файл в текстовом формате. Затем, воспользовавшись одним из FTP-клиентов (например, FileZilla), загрузить robots.txt в корневую папку сайта (рядом с файлами wp-config.php, wp-settings.php).

После успешной загрузки robots.txt, перейдите по адресу https://ваш_сайт.ru/robots.txt, чтобы посмотреть актуальное состояние файла.

С помощью плагинов

Для облегчения создания robots.txt в WordPress существуют специальные плагины. Некоторые из них: WordPress Robots.txt File, DL Robots.txt, Yoast SEO, All in One SEO Pack.

Clearfy Pro

Clearfy Pro создает виртуальный файл. Для этого:

- Перейдите в админ-меню Clearfy Pro.

- На вкладке SEO задействуйте опцию Создать правильный robots.txt.

- Он создастся автоматически. При желании отредактируйте в поле здесь же.

- Сохраните изменения.

Всегда можно отредактировать содержимое Robots. Просто измените/дополните его нужным содержимым и сохраните изменения.

Активировать промокод на 15%

Yoast SEO

Рассмотрим создание файла robots.txt на примере одного из самых мощных SEO-плагинов Yoast SEO.

Этот мощный СЕО-модуль для WP также решит задачу.

- Перейдите SEO > Инструменты.

- Нажмите Редактор файлов.

- Если в корневом каталоге этого файла нет, кликните Создать файл robots.txt. В редакторе вставьте вышеописанный код и нажмите Сохранить изменения в robots.txt.

Если есть, то откроется редактор для внесения изменений. - Нажмите Сохранить изменения в robots.txt.

All in One SEO Pack

Это решение тоже «умеет» работать с Robots. Для этого:

- Откройте All in One SEO > Модули.

- Выберите одноименное название модуля и нажмите Activate.

- Перейдите All in One SEO > Robots.txt.

- В полях добавьте директивы.

Настройка для интернет-магазинов (WooCommerce)

Для WordPress-ресурсов с использованием этого расширения просто добавьте эти правила:

Disallow: /cart/ Disallow: /checkout/ Disallow: /*add-to-cart=* Disallow: /my-account/

Нажмите, пожалуйста, на одну из кнопок, чтобы узнать понравилась статья или нет.

Robots.txt для WordPress, идеальный вариант robots.txt для WP

Файл robots.txt это первоначальный, и один из главнейших инструментов для корректной индексации ваших сайтов и их контента. Отсутствие данного файла приведет к печальным последствиям которые тяжело будет исправить. От того как вы настроите robots.txt зависит что попадет в выдачу по запросам в поисковых системах. Сейчас рассмотрим правильный файл robots.txt для WordPress сайта.

- Для чего использовать robots.

txt?

txt?

Перед тем как приступать к созданию и наполнению давайте разберем саму суть данного файла.

Ваш сайт это набор файлов и папок, некоторые из которых нужно защитить от чтения от сторонних глаз, которыми являются так же и поисковые роботы, пришедшие прочитать и запомнить наш контент, для дальнейшей выдачи в поиске.

Чем занимается поисковой робот на сайте?

Итак, к примеру ваш сайт посетил поисковой робот, что он делает в первую очередь? Во-первых пытается найти уникальную информацию, которую сможет занести в свою базу данных. Если роботс отсутствует, а именно к нему в первую очередь обращается робот, тогда он начинает «читать» файлы находящиеся в корне сайта, что конечно же нам не очень понравиться, ведь он не только не найдет там нужную ему информацию, а и прочитает наши данные настроек, которые созданы для нашей личной цели. Именно для этого и существует robots.txt. Он дает указания роботу куда ходить нужно, а куда заглядывать не стоит.

Создание и размещение файла на сайте WordPress.

Для того что бы создать путеводитель для роботов, вам потребуется обычный блокнот windows, в котором вы будете прописывать нужные команды для поисковых роботов. После этого нужно сохранить файл в формате «txt», под названием «robots». На этом создание завершено, далее в статье мы рассмотрим какие же команды должны находиться в robots.txt для WordPress.

Где размещать?

Robots.txt размещается на вашем хостинге, непосредственно в корневой папке сайта, куда мы перенесли наш сайт. Теперь поисковой робот перед тем как лазить по нашему сайту, сначала спросит разрешение куда ему можно, а куда запрещено заходить.

Важно: при размещении документа в подкаталогах, роботы не смогут найти этот файл.

Зайдя к вам на сайт робот заходит смотрит предназначеную для него «инструкцию» и начинает его изучать. Изучив до конца он пойдет по выбранному вами пути индексации, и будет игнорировать те директории, папки и URL к которым вы запретили обращаться.

Изучив до конца он пойдет по выбранному вами пути индексации, и будет игнорировать те директории, папки и URL к которым вы запретили обращаться.

Что включает в себя роботс?

Robots.txt несет в себе информативные данные для поисковых роботов и включает в себя такие основные «команды»:

User-agent

Указывает на имя потенциального робота посетителя. Синтаксис «User-agent: *» будет означать что данным командам должны следовать все роботы. Варианты для отдельных роботов рассматривать не будем, их очень много. По этому для примера будет только два варианта (для всех роботов и отдельно для Яндекс).

Disallow

Команда для роботов, рассказывающая о том куда ходить не стоит, запрещает чтение указанных адресов и файлов.

Allow

Команда которая рекомендует «направление» на индексирования данного адреса или файла.

Host

Данная команда указывает роботу, какой из вариантов сайта будет нашим главным зеркалом сайта.

Sitemap

Место нахождения xml карты сайта по которой должен пробежаться посетивший нас робот, в той части за которой он пришел (контент сайта).

Правильный robots.txt для сайта на CMS WordPress.

Для того что бы правильно настроить файл robots.txt специально под «движок» WordPress нужно для начала понимать что ищут роботы и что им будет интересно.

А наши паучки ищут контент нашего ресурса, и им совершенно не нужно знать о всех остальных конфигурационных данных наших сайтов. Во первых они им приходятся не по вкусу, и от переедания таковых они могут покинуть наш сайт так и не найдя то что нам бы хотелось да еще и вынесут наши запрещенные для общего глаза данные на общее обозрение.

Говоря о требуемых размещения директорий в robots.txt для WordPress, нам нужно разобраться с главной (корневой) папкой нашего сайта, в которой мы обнаружим огромное количество стандартных файлов и папок. Роботам незачем их читать, они не найдут там то что ищут, по этому нужно запрещать индексировать по возможности весь «лишний мусор».

Роботам незачем их читать, они не найдут там то что ищут, по этому нужно запрещать индексировать по возможности весь «лишний мусор».

Подумайте сами чем может сулить нам например индексация нашего wp-config.php. Робот просто возьмет и «расскажет» всем о наших вводных данных к нашим базам данных, а это крайне плохо для нас.

Сейчас я покажу готовый вариант. Затем разберем каждую строчку в расширенном описании. Итак, правильный robots.txt для WordPress должен выглядеть так:

Disallow: /wp-

Disallow: */trackback

Disallow: /*?*

Disallow: /?s=*

Disallow: */author

Disallow: /2016

Disallow: /xmlrpc.php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Теперь посмотрим как мы смогли добиться такого короткого содержания файла robots.txt для WordPress, рассмотрим расширенную версию файла и постепенно уберем повторы:

Disallow: /wp-admin # Блокируем индексацию папки admin

Disallow: /wp-includes # папки includes

Disallow: /wp-content/languages # папки content/languages

Disallow: /wp-content/plugins # папки content/plugins

Disallow: /wp-content/cache # папки content/cache

Disallow: /wp-content/themes # папки content/themes

Disallow: /trackback # блокируем индекс всех возможных трекбеков

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed # блокируем индексацию фидов, новостных лент всех вариантов

Disallow: /feed/

Disallow: /?feed=

Disallow: */*/feed

Disallow: */*/feed/*/

Disallow: /*?* # запрет индекса всех ссылок (защита от дублей)

Disallow: /tag # каталоги находящихся в разных директориях ( метки, категории )

Disallow: /tag/*

Disallow: /?s=*

Disallow: /page/* # запрещаем лишние страницы в WP, создающие дубли

Disallow: /author # блокировка индексации автора

Disallow: /2015 # дублирование ссылок с архива # далее блокировка всех административных файлов

Disallow: /xmlrpc. php

php

Disallow: /wp-activate.php

Disallow: /wp-blog-header.php

Disallow: /wp-comments-post.php

Disallow: /wp-config.php

Disallow: /wp-cron.php

Disallow: /wp-links-opml.php

Disallow: /wp-load.php

Disallow: /wp-login.php

Disallow: /wp-mail.php

Disallow: /wp-register.php

Disallow: /wp-settings.php

Disallow: /wp-signup.php

Disallow: /wp-trackback.php

Disallow: /wp-config-sample.php

Allow: /wp-content/uploads/ # Разрешаем индексировать наши загруженные картинки

Host: site.ru # Указываем основное зеркало

Sitemap: http://site.ru/sitemap.xml # Направляем робота на наши страницы контента

Указанный выше пример заблокирует от индексации все ненужные для поисковой оптимизации файлы и ссылки и укажет на тот материал который должен быть проиндексирован.

Ну уж очень длинный у нас вышел пример, сейчас мы его будем упрощать. Для начала возьмемся за файлы и папки с префиксом «wp-« их все можно объединить воедино.

Disallow: /wp-

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed

Disallow: /feed/

Disallow: /?feed=

Disallow: */*/feed

Disallow: */*/feed/*/

Disallow: /*?*

Disallow: /tag

Disallow: /tag/*

Disallow: /?s=*

Disallow: /page/*

Disallow: /author

Disallow: /2015

Disallow: /xmlrpc.php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Значительно уменьшили, но это не предел, пойдем немножко дальше и постараемся еще сократить, да еще и проделать необходимые внутренние настройки.

Все дело в том что при таком варианте файла, Google все равно внесет запрещенные вами страницы в индекс, но выглядеть они будут иначе:

Это не столь опасно как открытые дубли, но все же лучше от этого избавляться. Для того что бы исправить данную ситуацию можно воспользоваться сразу несколькими методами. Я расскажу о самом быстром и простом — запрет индексирования страниц с помощью Google Webmasters Tools «Параметры URL». Кстати в рекомендациях для Яндекса лучше оставить параметр «feed» в указанном варианте.

Кстати в рекомендациях для Яндекса лучше оставить параметр «feed» в указанном варианте.

Избавились от feed с помощью Google, теперь для альтернативы запретим индексирование пагинации с помощью плагина, который скорее всего используется вами, если же это не так, тогда альтернативный так же подойдет. Речь идет о All in One SEO и его настройках тегов «robots» и «canonical».

Для того что бы запретить индексировать поисковикам не нужные нам страницы, такие как страницы пагинации всех видов (главной, рубрик и меток) нужно всего навсего поставить галочки в нужных местах.

Сперва включим канонические ссылки на главные страницы, для избежания их дублирования.

Что мы сделали? В общем все что было нужно, мы указали на страницах которые дублируют наш контент ссылку на основную страницу, что укажет роботу что именно нужно сканировать и считать за основной контент. Теперь добавим еще мета тег robots.

После проведенных настроек, снова обращаемся к нашему варианту файла и смотрим что получилось:

Disallow: /wp-

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: /*?*

Disallow: /?s=*

Disallow: /author

Disallow: /2015

Disallow: /xmlrpc. php

php

Allow: /wp-content/uploads/

Allow: *.js

Allow: *.css

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

По поводу меток и рубрик вопрос спорный, вы можете оптимизировать рубрики, и добиться результата с которым ваши страницы категорий будут не вредны, а наоборот принесут дополнительный трафик. Метки можно подогнать под поисковики аналогично рубрикам.

Если тема, которую вы установили использует картинки, тогда лучше открыть их для индекса:

Allow: /wp-content/themes/название вашей темы/images

Если вы проигнорируете это, у вас могут возникнуть проблемы с поисковиками, они не любят когда от них скрывают важную информацию.

Пример можно расширять, например добавлением запрета для индексации определенных ссылок на страницы, обычно это страницы повторы которые вредят нашей оптимизации.

В документе обычно не указывают конкретно для всех поисковых роботов по отдельности, а делаю два набора команд один для всех второй для Яндекса.

User-agent: *

Disallow: /wp-

…

User-agent: Yandex

Disallow: /wp-

…

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Host — нужно обязательно указывать, пренебрежение приведет к дублирования индексации ваших страниц между www.site.ru и site.ru, что рассеет ваш трафик и пагубно скажется на вашем сайте.

Как правильно создать карту сайта можно почитать в отдельных уроках по WordPress.

На этом урок по созданию файла robots.txt заканчивается, и помните что от этого по большей степени зависит судьба индексации ваших страниц.

Как добавить и оптимизировать файл robots.txt WordPress

Не каждая подстраница или все каталоги на вашем веб-сайте настолько важны, чтобы поисковые системы могли их сканировать. Используя robots.txt, вы можете определить, какие подстраницы WordPress должны учитываться поисковыми роботами, а какие нет. Таким образом, вы позиционируете свой веб-сайт более эффективно в онлайн-поиске . Читайте дальше, чтобы узнать, как robots.txt работает в WordPress и как его оптимизировать.

Читайте дальше, чтобы узнать, как robots.txt работает в WordPress и как его оптимизировать.

Contents

- Что такое robots.txt для WordPress?

- Для чего используется robots.txt в WordPress?

- Автоматизированный файл robots.txt в WordPress

- Что входит в файл robots.txt в WordPress?

- Настройте robots.txt в WordPress вручную

- Плагины для создания файла robots.txt в WordPress

- Как вы тестируете изменения?

- Резюме: robots.txt оптимизирует и защищает ваш веб-сайт

$1 Доменные имена

Зарегистрируйте отличные TLD менее чем за 1 доллар в первый год.

Зачем ждать? Получите свое любимое доменное имя сегодня!

Совпадающий адрес электронной почты

SSL-сертификат

Поддержка 24/7/365

Что такое robots.txt для WordPress?

Так называемые поисковые роботы осуществляют круглосуточный поиск веб-сайтов в Интернете. Эти боты отправляются поисковыми системами для просмотра как можно большего количества страниц и подстраниц, индексируя их, чтобы сделать их доступными для поиска. Чтобы поисковые роботы могли читать веб-сайт, они должны управляться. Владельцы веб-сайтов могут избежать индексации контента, который не имеет отношения к поисковым системам, и убедиться, что сканер читает только тот контент, который должен найти.

Эти боты отправляются поисковыми системами для просмотра как можно большего количества страниц и подстраниц, индексируя их, чтобы сделать их доступными для поиска. Чтобы поисковые роботы могли читать веб-сайт, они должны управляться. Владельцы веб-сайтов могут избежать индексации контента, который не имеет отношения к поисковым системам, и убедиться, что сканер читает только тот контент, который должен найти.

Чтобы исключить разделы вашего сайта, вы можете использовать robots.txt в WordPress и других CMS. По сути, текст определяет, какие области вашего веб-сайта могут быть обнаружены поисковыми роботами, а какие нет. Поскольку каждый домен имеет ограниченный «бюджет сканирования», тем более важно продвигать свои основные страницы и удалять второстепенные подстраницы из поисковых запросов.

Для чего используется robots.txt в WordPress?

Добавление файла robots.txt в WordPress определяет, какой контент индексируется, а какой нет. Например, хотя ваш веб-сайт должен иметь хороший рейтинг в результатах поиска, это, вероятно, не относится к выходным данным вашего сайта. Комментарии или архивы не дают никакой дополнительной ценности для поиска и могут даже плохо сказаться на вашем рейтинге, особенно когда поисковая система обнаруживает дублированный контент. С файлом robots.txt в WordPress вы можете исключить такие случаи и направить различные поисковые роботы на страницы вашего веб-сайта, которые должны быть найдены .

Комментарии или архивы не дают никакой дополнительной ценности для поиска и могут даже плохо сказаться на вашем рейтинге, особенно когда поисковая система обнаруживает дублированный контент. С файлом robots.txt в WordPress вы можете исключить такие случаи и направить различные поисковые роботы на страницы вашего веб-сайта, которые должны быть найдены .

Автоматизированный файл robots.txt в WordPress

WordPress автоматически создает файл robots.txt, закладывая некоторые основы. Однако это дополнение не является обширным и должно рассматриваться как отправная точка. Текст выглядит так:

User-agent: * Запретить: /wp-admin/ Disallow: /wp-includes/

« user-agent » в первой строке относится к поисковым роботам. «*» означает, что всем поисковым системам разрешено отправлять своих ботов на вашу страницу. Как правило, это рекомендуется, поскольку таким образом ваш веб-сайт будет найден чаще. Команда « robots.txt блокирует их для поисковых систем, потому что они не имеют отношения к вашим посетителям. Чтобы убедиться, что они доступны только вам, вы должны защитить их безопасным паролем.

robots.txt блокирует их для поисковых систем, потому что они не имеют отношения к вашим посетителям. Чтобы убедиться, что они доступны только вам, вы должны защитить их безопасным паролем.

Что входит в файл robots.txt в WordPress?

Поисковые системы, такие как Google, должны быть в состоянии найти ваш веб-сайт. Однако довольно вредные или сомнительные сервисы, такие как DuggMirror, не должны; вы можете исключить их с помощью robots.txt в WordPress. Кроме того, вы должны исключить темы, которые вы использовали, ваши выходные данные и другие страницы, которые имеют мало или вообще не имеет значения для индексации . Плагины также не следует индексировать — не только потому, что они не имеют отношения к широкой публике, но и по соображениям безопасности. Если плагин сталкивается с угрозой безопасности, ваш веб-сайт может быть обнаружен и поврежден злоумышленниками.

В большинстве случаев для полноценного использования файла robots. txt в WordPress будет достаточно двух упомянутых выше команд: «User-agent» определяет, к каким ботам следует обращаться . Таким образом, вы можете определить исключения для определенных поисковых систем или установить основные правила. «Запретить» запрещает поисковым роботам доступ к соответствующей странице или подстранице. Третья команда «Разрешить» в большинстве случаев не актуальна, т.к. доступ разрешен по умолчанию. Команда требуется только в том случае, если вы хотите заблокировать страницу, но разблокируете ее подстраницу .

txt в WordPress будет достаточно двух упомянутых выше команд: «User-agent» определяет, к каким ботам следует обращаться . Таким образом, вы можете определить исключения для определенных поисковых систем или установить основные правила. «Запретить» запрещает поисковым роботам доступ к соответствующей странице или подстранице. Третья команда «Разрешить» в большинстве случаев не актуальна, т.к. доступ разрешен по умолчанию. Команда требуется только в том случае, если вы хотите заблокировать страницу, но разблокируете ее подстраницу .

Настройте robots.txt в WordPress вручную

Для индивидуальных настроек вы можете расширить файл robots.txt в WordPress. Просто выполните следующие шаги:

Шаг 1: Сначала создайте пустой файл под названием «robots.txt» в любом текстовом редакторе.

Шаг 2: Затем загрузите это в корневой каталог вашего домена.

Шаг 3: Теперь вы можете редактировать файл через SFTP или загрузить новый текстовый файл .

Используя приведенные выше команды, вы определяете, какие правила и исключения применяются к вашему веб-сайту. Чтобы заблокировать доступ к определенной папке:

Используйте эту команду, чтобы заблокировать определенную папку для всех сканеров.А вот как вы можете запретить определенному боту доступ к вашему сайту:

Используйте эту команду, чтобы запретить определенному боту сканировать ваш сайт.Плагины для создания файла robots.txt в WordPress

Вы также можете создавать и изменять файл robots.txt в WordPress с помощью плагина SEO. В процессе используется панель инструментов, что делает его удобным и безопасным. Популярным плагином для этой цели является Yoast SEO.

Шаг 1: Во-первых, установите и активируйте плагин.

Шаг 2: Включите плагин для внесения расширенных изменений . Для этого перейдите в раздел «SEO» > «Панель инструментов» >, «Функции» и нажмите «Включено» в разделе «Страницы дополнительных настроек».

Для этого перейдите в раздел «SEO» > «Панель инструментов» >, «Функции» и нажмите «Включено» в разделе «Страницы дополнительных настроек».

Шаг 3: После активации внесите изменения на панели управления в разделе «SEO» > «Инструменты» > «Редактор файлов». Здесь вы можете создать и отредактировать новый файл robots.txt в WordPress. После этого изменения будут реализованы напрямую.

Как тестировать изменения?

Теперь, когда вы настроили свой сайт, установили правила и, по крайней мере теоретически, заблокировали сканеры, как вы можете быть уверены, что ваши изменения были внесены? Google Search Console помогает в этом. Здесь вы найдете «тестер robots.txt» с левой стороны в разделе «Сканирование». Введите свои страницы и подстраницы, а затем посмотрите, можно ли их найти или заблокировать. Зеленый « разрешено » внизу справа означает, что поисковые роботы находят страницу и принимают ее во внимание, красный « запрещено » означает, что страница не проиндексирована.

Резюме: robots.txt оптимизирует и защищает ваш веб-сайт

Файл robots.txt имеет номер настолько же эффективен, насколько и эффективен , чтобы определить, какие области вашего сайта WordPress должны быть найдены и кем. Если вы уже используете SEO-плагин, такой как Yoast, проще всего применить изменения. В противном случае файл можно создать и настроить вручную.

- Блоги

- Учебные пособия

- WordPress

Как установить сайт WordPress Stage.0159

Постановка WordPress относится к отдельной тестовой среде для установки WordPress, которая позволяет тестировать обновления, плагины и шаблоны WordPress на совместимость перед их интеграцией на работающий веб-сайт. Тестовые среды WordPress защищают разработчиков от нанесения вреда работающему сайту WordPress обновлениями или самописным кодом.

Как настроить перенаправления WordPress

- Блоги

Если вы измените домен, реструктурируете свой сайт или удалите сообщения, вы можете обнаружить, что некоторые URL-адреса больше не отвечают. Решение состоит в том, чтобы реализовать перенаправление. В WordPress вы можете настроить его вручную или использовать плагин WordPress для создания перенаправления. Прочтите нашу статью, в которой мы рассказываем, как перенаправить страницу в WordPress.

Как настроить переадресацию WordPressКак изменить постоянную ссылку в WordPress

- Блоги

Изменение постоянной ссылки WordPress для создания осмысленных URL-адресов имеет множество преимуществ. Например, боты поисковых систем считывают URL-адрес и тематически ранжируют его для соответствующих поисковых запросов. Посетители веб-сайта также часто используют URL-адреса, чтобы сориентироваться. Мы покажем вам, как быстро и легко изменить постоянную ссылку WordPress.

Посетители веб-сайта также часто используют URL-адреса, чтобы сориентироваться. Мы покажем вам, как быстро и легко изменить постоянную ссылку WordPress.

Шаблон WordPress robots.txt · GitHub

Этот файл содержит двунаправленный текст Unicode, который может быть интерпретирован или скомпилирован не так, как показано ниже. Для просмотра откройте файл в редакторе, который показывает скрытые символы Unicode. Узнайте больше о двунаправленных символах Unicode

Показать скрытые символы

| # Роботы рулят! — Иногда… # | |

| Агент пользователя: * | |

| Разрешить: / | |

| # Запретить эти каталоги, типы URL и типы файлов | |

| Запретить: /trackback/ | |

| Запретить: /wp-admin/ | |

| Запретить: /wp-content/ | |

| Запретить: /wp-includes/ | |

Запретить: /xmlrpc. | |

| Запретить: /wp- | |

| Запретить: /cgi-bin | |

| Запретить: /readme.html | |

| Запретить: /license.txt | |

| Запретить: /*?* | |

| Запретить: /*.php$ | |

| Запретить: /*.js$ | |

| Запретить: /*.inc$ | |

| Запретить: /*.css$ | |

| Запретить: /*.gz$ | |

| Запретить: /*.wmv$ | |

Запретить: /*. |