Как сделать robots.txt для WordPress.Создаем правильный robots.txt для сайта на WordPress

Приветствую, друзья! В этом уроке мы поговорим о создании файла robots.txt, который показывает роботам поисковых систем, какие разделы Вашего сайта нужно посещать, а какие нет.

Фактически, с помощью этого служебного файла можно указать, какие разделы будут индексироваться в поисковых системах, а какие нет.

Создание файла robots.txt

1. Создайте обычный текстовый файл с названием robots в формате .txt.

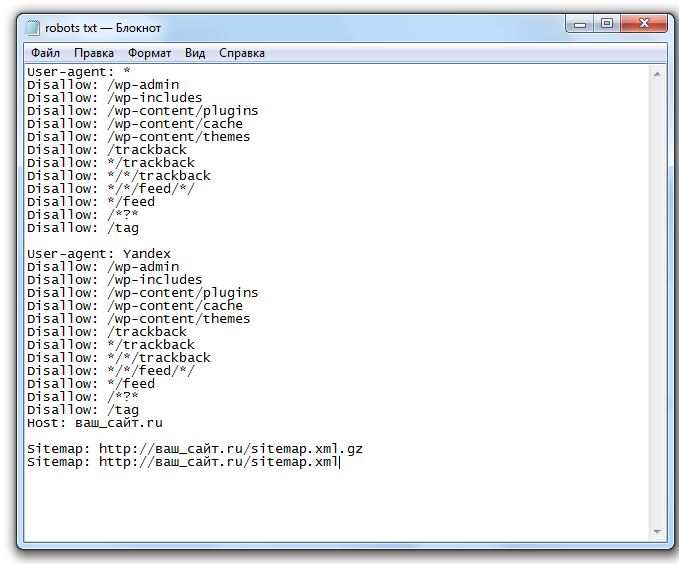

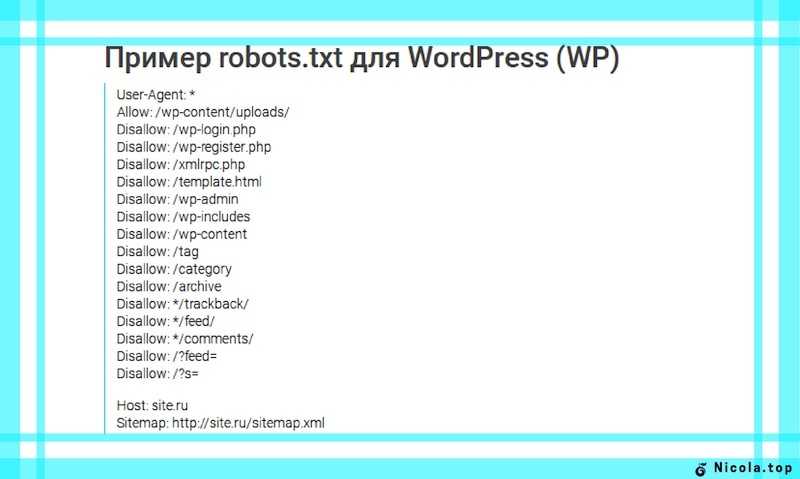

2. Добавьте в него следующую информацию :

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= Host: site.com Sitemap: http://site.com/sitemap.xml

3. Замените в в текстовом файле строчку site.com на адрес Вашего сайта.

4. Сохраните изменения и загрузите файл robots.txt (с помощью FTP) в корневую папку Вашего сайта.

5. Готово.

Для просмотра и скачки примера, нажмите кнопку ниже и сохраните файл (Ctrl + S на клавиатуре).

Скачать пример файла robots.txt

Разбираемся в файле robots.txt (директивы)

Давайте теперь более детально разберем, что именно и зачем мы добавили в файл robots.txt.

User-agent — директива, которая используется для указания названия поискового робота. С помощью этой директивы можно запретить или разрешить поисковым роботам посещать Ваш сайт. Примеры:

Запрещаем роботу Яндекса просматривать папку с кэшем:

User-agent: Yandex Disallow: /wp-content/cache

Разрешаем роботу Bing просматривать папку themes (с темами сайта):

User-agent: bingbot Allow: /wp-content/themes

Allow и Disallow — разрешающая и запрещающая директива. Примеры:

Примеры:

Разрешим боту Яндекса просматривать папку wp-admin:

User-agent: Yandex Allow: /wp-admin

Запретим всем ботам просматривать папку wp-content:

User-agent: * Disallow: /wp-content

В нашем robots.txt мы не используем директиву Allow, так как всё, что не запрещено боту с помощью Disallow — по умолчанию будет разрешено.

Host — директива, с помощью которой нужно указать главное зеркало сайта, которое и будет индексироваться роботом.

Sitemap — используя эту директиву, нужно указать путь к карте сайта. Напомню, что карта сайта является очень важным инструментом при продвижении сайта! Обязательно указывайте её в этой директиве!

Если остались какие-то вопросы — задавайте их в комментарий. Если же информации в этом уроке для Вас оказалось недостаточно, рекомендую почитать подробнее о всех директивах и способах их использования перейдя по этой ссылке.

Robots txt для WordPress 6.2 в 2023 году

Если вам интересно, как для улучшения SEO оптимизировать файл robots.txt WordPress, то вы попали в нужное место.

В этом кратком руководстве я объясню, что такое файл robots.txt, почему он важен для улучшения поискового рейтинга и как вносить в него изменения и отправлять в Google и Яндекс.

Давайте начнем!

Содержание

- Что такое файл robots.txt для WordPress?

- Что находиться в файле robots.txt?

- Как оптимизировать robots.txt WordPress для улучшения SEO

- Как выглядит идеальный файл robots.txt?

- Что разрешить и запретить в robots.txt?

- Как отправить файл WordPress robots.txt в Google?

- Как отправить файл WordPress robots.txt в Яндекс?

- Вывод

Что такое файл robots.txt для WordPress?

Файл robots.txt — это файл на вашем сайте, который позволяет запретить поисковым системам доступ к определенным файлам и папкам. Вы можете использовать его, чтобы заблокировать роботов Google (и других поисковых систем) от сканирования определенных страниц на вашем сайте.

Так как же отказ в доступе к поисковым системам на самом деле улучшает ваше SEO? Кажется контринтуитивным…

Это работает следующим образом: чем больше страниц на вашем сайте, тем больше страниц должны сканировать поисковые системы.

Например, если в вашем блоге много страниц категорий и тегов, эти страницы некачественные и не нуждаются в сканировании поисковыми системами. Они просто потребляют краулинговый бюджет вашего сайта (количество страниц, которые поисковые системы будет сканировать на вашем сайте в любой момент времени).

Бюджет сканирования важен, потому что он определяет, насколько быстро поисковые системы улавливают изменения на вашем сайте и, следовательно, как быстро вы занимаете высшее место в поиске. Это может особенно помочь с SEO электронной коммерции!

Будьте осторожны, так как это может повредить вашему SEO, если все сделать плохо. Вы потеряете позиции находясь в высококонкурентной нише с большими сайтами. Однако, если вы только начинаете свой первый блог, создание ссылок на ваш контент и создание большого количества высококачественных статей являются более важными приоритетами.

Что находиться в файле robots.txt?

Файл robots.txt состоит из одного или нескольких блоков кода, каждый из которых содержит инструкции для одного или нескольких ботов. Кодовый блок состоит из:

- User-agent, который идентифицирует бота, на которого распространяется правило. Звездочкой (*), означает что применяется к любому пользовательскому агенту, который посещает веб-сайт. Однако вы можете настроить таргетинг на конкретного бота с помощью его пользовательского агента. Например, пользовательский агент Google — Googlebot.

- Disallow указывает ботам поисковых систем игнорировать указанный файл или файлы.

- Allow позволяет ботам поисковых систем получать доступ к указанному файлу или файлам. В этом нет необходимости, если только вы не хотите разрешить доступ к файлу или подкаталогу в запрещенном родительском каталоге.

- Crawl-delay указывает, сколько времени робот поисковой системы должен ждать между загрузками страницы. Он связан с числовым значением в секундах.

- Sitemap сообщает роботам, где находится ваша карта сайта. Эта строка не является обязательной. Я рекомендую вам отправлять карту сайта в поисковые системы с помощью специального инструмента, такого как Google Search Console. Может включать один или несколько файлов Sitemap, каждый из которых связан с URL-адресом карты сайта.

Как оптимизировать robots.txt WordPress для улучшения SEO

Теперь давайте обсудим, как на самом деле получить (или создать) и оптимизировать файл WordPress robots.txt.

Robots.txt обычно находится в корневой папке вашего сайта. Вам нужно будет подключиться к вашему сайту с помощью FTP-клиента или с помощью файлового менеджера cPanel для его просмотра. Это обычный текстовый файл, который можно открыть в любом текстовом редакторе.

Если у вас нет файла robots.txt в корневом каталоге вашего сайта, вы можете создать его. Все, что вам нужно сделать, это создать новый текстовый файл на вашем компьютере и сохранить его как robots.txt. Затем просто загрузите его в корневую папку вашего сайта.

Затем просто загрузите его в корневую папку вашего сайта.

Как выглядит идеальный файл robots.txt?

Формат файла robots.txt очень прост. Первая строка обычно называет пользовательский агент. Пользовательский агент — это имя поискового бота, с которым вы пытаетесь связаться. Например, Googlebotили Bingbot. Вы можете использовать звездочку *, чтобы проинструктировать всех ботов.

Следующая строка следует с инструкциями «Разрешить» или «Запретить» какие части вы хотите, чтобы они индексировали, а какие — нет.

Вот правильный robots.txt для WordPress:

User-agent: * # Предотвращено индексирование конфиденциальных файлов Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/cache Disallow: /trackback Disallow: /*.php$ Disallow: /*.inc$ Disallow: /*.gz$ # Не индексируем страницу входа (ненужный контент) Disallow: /wp-login.php Sitemap: https://mrwp.ru/sitemap_index.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 | User-agent: *

# Предотвращено индексирование конфиденциальных файлов Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/cache Disallow: /*. Disallow: /*.inc$ Disallow: /*.gz$

# Не индексируем страницу входа (ненужный контент) Disallow: /wp-login.php

Sitemap: https://mrwp.ru/sitemap_index.xml |

Обратите внимание, что если вы используете такой плагин, как Yoast или All in One SEO, вам может не понадобиться добавлять раздел карты сайта, поскольку они делают это автоматически. Если это не удается, вы можете добавить его вручную, как в примере выше.

Что разрешить и запретить в robots.txt?

В руководстве Google для веб-мастеров советуют не использовать файл robots.txt для сокрытия некачественного контента. Таким образом, использование вашего файла robots.txt, чтобы запретить поисковым системам индексировать вашу категорию, дату и другие страницы архива, может быть неразумным выбором.

Помните, что файл robots.txt предназначен для того, чтобы проинструктировать ботов, что делать с контентом, который они сканируют на вашем сайте. Это не мешает им сканировать ваш сайт.

Кроме того, вам не нужно добавлять страницу входа в WordPress, каталог администратора или страницу регистрации в robots.txt, потому что страницы входа и регистрации имеют тег noindex, автоматически добавленный WordPress.

Однако я рекомендую запретить файл readme.html в файле robots.txt.Этот файл readme может быть использован кем-то, кто пытается выяснить, какую версию WordPress вы используете. Если это человек, он может легко получить доступ к файлу, просто просмотрев его. Кроме того, размещение тега Disallow может блокировать вредоносные атаки.

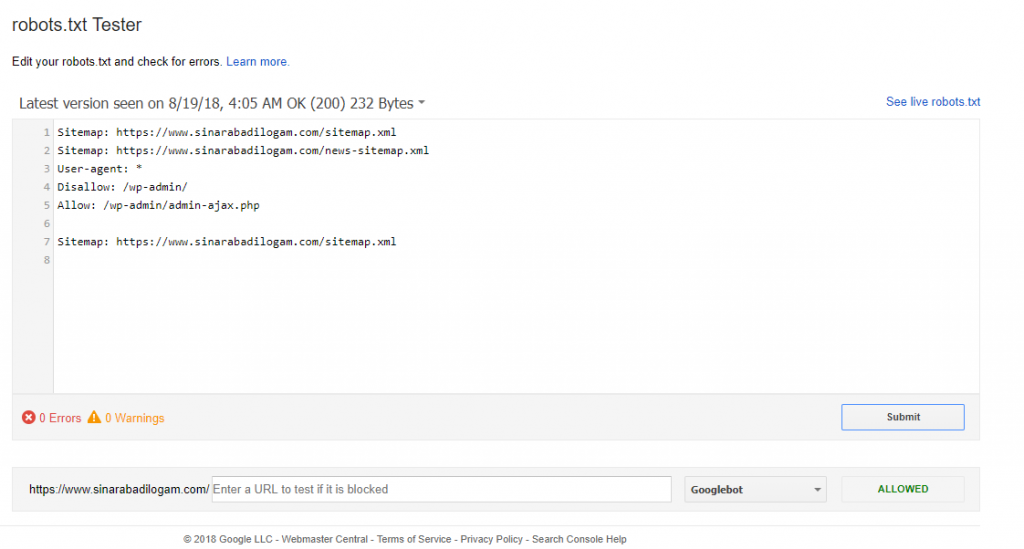

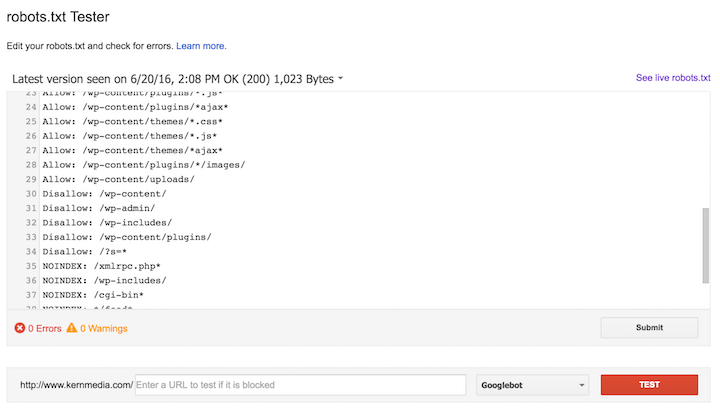

Как отправить файл WordPress robots.txt в Google?

После того как вы обновили или создали файл robots.txt, вы можете отправить его в Google с помощью Google Search Console.

Тем не менее, я рекомендую сначала протестировать его с помощью инструмента тестирования Google robots.txt.

Если вы не видите созданную вами версию здесь, вам придется повторно загрузить файл robots.txt, который вы создали, на свой сайт WordPress.

Как отправить файл WordPress robots.txt в Яндекс?

Автоматически Яндекс попробует загрузить файл по адресу https://ваш-домен.ru/robots.txt. Если вы вручную не создавали этот файл, то по-умолчанию будет использоваться встроенный в WordPress (физически он может отсутствовать на хостинге) и часто его хватает для работы.

Для того, чтобы проанализировать действие файла в Яндексе, следует перейти на соответствующую страницу в разделе Яндекс.Вебмастер. Заходим в раздел Инструменты –> Анализ robots.txt.

Как видите, никакого запрета на индексирование страницы со стороны robots.txt мы не видим, значит все в порядке :).

Вывод

Теперь вы знаете, как оптимизировать файл WordPress robots.txt для улучшения SEO.

Будьте осторожны при внесении каких-либо серьезных изменений на свой сайт с помощью файла robots.txt. Хотя эти изменения могут улучшить ваш поисковый трафик, они также могут принести больше вреда, чем пользы, если вы не будете осторожны.

У вас есть вопросы о том, как оптимизировать файл robots. txt WordPress? Какое влияние оказало изменение на ваш поисковый рейтинг? Дайте мне знать об этом в комментариях.

txt WordPress? Какое влияние оказало изменение на ваш поисковый рейтинг? Дайте мне знать об этом в комментариях.

Что такое robots.txt в WordPress?

акции 5 Делиться Твитнуть Делиться Facebook-мессенджер WhatsApp Электронная почта

Robots.txt — это текстовый файл, который позволяет веб-сайту давать инструкции роботам, сканирующим веб-страницы.

Поисковые системы, такие как Google, используют эти поисковые роботы, иногда называемые веб-роботами, для архивирования и категоризации веб-сайтов. Большинство ботов настроены на поиск файла robots.txt на сервере, прежде чем он прочитает любой другой файл с веб-сайта. Это делается для того, чтобы узнать, есть ли у владельца веб-сайта какие-либо специальные инструкции о том, как сканировать и индексировать его сайт.

Большинство ботов настроены на поиск файла robots.txt на сервере, прежде чем он прочитает любой другой файл с веб-сайта. Это делается для того, чтобы узнать, есть ли у владельца веб-сайта какие-либо специальные инструкции о том, как сканировать и индексировать его сайт.

Файл robots.txt содержит набор инструкций, которые требуют от бота игнорировать определенные файлы или каталоги. Это может быть сделано в целях конфиденциальности или потому, что владелец веб-сайта считает, что содержимое этих файлов и каталогов не имеет отношения к классификации веб-сайта в поисковых системах.

Если веб-сайт имеет более одного субдомена, для каждого субдомена должен быть свой файл robots.txt. Важно отметить, что не все боты поддерживают файл robots.txt. Некоторые вредоносные боты даже читают файл robots.txt, чтобы определить, какие файлы и каталоги им следует атаковать в первую очередь. Кроме того, даже если файл robots.txt предписывает ботам игнорировать определенные страницы на сайте, эти страницы все равно могут отображаться в результатах поиска, если на них есть ссылки с других сканируемых страниц.

Дополнительные показания

- Как добавить свой сайт WordPress в Google Search Console

- SEO

Акции 5 Делиться Твитнуть Делиться Facebook-мессенджер WhatsApp Электронная почта

О редакции

Редакция WPBeginner — это команда экспертов по WordPress под руководством Сайеда Балхи с более чем 16-летним опытом создания веб-сайтов на WordPress. Мы создаем учебные пособия по WordPress с 2009 года, и WPBeginner стал крупнейшим в отрасли сайтом с бесплатными ресурсами WordPress.

Мы создаем учебные пособия по WordPress с 2009 года, и WPBeginner стал крупнейшим в отрасли сайтом с бесплатными ресурсами WordPress.

Как редактировать robots.txt в WordPress

Обновлено: 7 апреля 2023 г.

4 простых способа.

Если вы серьезно относитесь к своему веб-сайту (и особенно если у вас большой веб-сайт), вам обязательно нужно контролировать его файл robots.txt. К счастью, с веб-сайтами WordPress это довольно легко сделать.

Позвольте мне показать вам 4 простых способа доступа и изменения файла robots.txt в WordPress.

Основная информация о файле robots.txt

4 способа получить доступ к robots.txt в WordPress

#1: Используйте SEO-плагин

#2: Используйте специальный плагин robots.txt

#3: Доступ к robots.txt через cPanel на вашем хостинге

#4: Используйте FTP для доступа к robots. txt

txt

Как протестировать файл robots.txt на вашем сайте

Основная информация о файле robots.txt

Robots.txt — это файл, информирующий роботов поисковых систем о страницах или файлах, которые следует или не следует сканировать.

- Файл robots.txt предназначен для защиты веб-сайта от перегрузки запросами поисковых роботов (см. мое полное руководство по оптимизации краулингового бюджета ).

- Файл robots.txt не является способом заблокировать веб-страницы или файлы от индексации и появления в результатах поиска. Вот напоминание от Google:

- Сканеры поисковых систем всегда начинают сканирование вашего веб-сайта, проверяя директивы в robots.txt .

- Поисковые системы должны, но не всегда, соблюдать директивы, содержащиеся в robots.txt (Google делает).

- Большинство сканеров веб-сайтов позволяют настроить их так, чтобы они либо игнорировали, либо учитывали файл robots.

txt.

txt.

В случае, если вам нужно небольшое напоминание, вот некоторая основная техническая информация о robots.txt :

- Единственным правильным расположением robots.txt является корень (основной каталог) веб-сайта. Это относится к любому веб-сайту, независимо от того, является ли он веб-сайтом WordPress.

- Один веб-сайт (один домен) может иметь только один файл robots.txt .

- Единственным приемлемым именем файла является robots.txt .

- Robots.txt должен быть текстовым файлом в кодировке UTF-8.

Имея это в виду, расположение robots.txt WordPress такое же, как и для любого другого веб-сайта. Это корень сайта.

В случае моего веб-сайта это https://seosly.com/robots.txt.

Так выглядит файл robots.txt WordPress по умолчанию.Имейте в виду, что:

- Если у вас есть веб-сайт, доступный на разных языках, и определенные языки помещаются в разные папки, например.

seosly.com/pl/ , тогда у вас будет один файл robots.txt для всех языковых версий.

seosly.com/pl/ , тогда у вас будет один файл robots.txt для всех языковых версий. - Если у вас есть разные поддомены или разные домены для разных языковых версий, например seosly.pl , то для каждой языковой версии будет свой отдельный файл robots.txt.

Преимущество WordPress в том, что он позволяет вам получить доступ к вашим robots.txt несколькими способами, даже если у вас нет FTP-доступа.

☝️ Если вы хотите узнать больше о файле robots.txt, о том, как он работает и что это такое, обязательно ознакомьтесь с введением в robots.txt в Google Search Central.

4 способа доступа к файлу robots.txt в WordPress

Вот четыре способа доступа и изменения файла robots.txt на вашем сайте WordPress

#1: Используйте плагин SEO

Существует множество плагинов SEO для WordPress но на самом деле имеют значение только два:

- Математика ранга

- Йоаст SEO

Существует также All in One SEO , но я не большой поклонник этого плагина. Все эти SEO-плагины позволяют легко получать доступ к файлу robots.txt и изменять его.

Все эти SEO-плагины позволяют легко получать доступ к файлу robots.txt и изменять его.

Доступ к robots.txt с помощью Rank Math

Если вы используете Rank Math, вот что вам нужно сделать:

- Войдите в панель управления WordPress как администратор. Обратите внимание, что только администраторы могут изменять плагины.

- Перейти к Rank Math SEO .

- На левой боковой панели под Rank Math вы увидите различные настройки Rank Math. Нажмите Общие настройки s.

- Теперь вы увидите список общих настроек SEO. Нажмите Изменить robots.txt .

- Если вы ничего не сделаете, Rank Math автоматически обработает robots.txt, как показано на скриншоте ниже.

- Если вы хотите изменить robots.txt, просто начните вводить текст в текстовое поле и нажмите Сохранить изменения .

- Если вы не знаете, что вставить в robots.

txt, или делаете что-то не так, просто нажмите Сбросить параметры .

txt, или делаете что-то не так, просто нажмите Сбросить параметры .

Вот и все для Rank Math и robots.txt.

Доступ к robots.txt с помощью Yoast SEO

Вот что нужно делать, если вы используете Yoast SEO:

- Войдите в панель управления WordPress как администратор. Помните, что только администраторы могут изменять настройки плагина.

- Перейти к SEO .

- На левой боковой панели вы увидите пару настроек под SEO . Щелкните Инструменты .

- Щелкните Редактор файлов.

- Теперь вы можете изменить файл robots.txt.

- Когда вы закончите, просто нажмите Сохранить изменения в robots.txt.

На большинстве веб-сайтов WordPress эти два метода с использованием этих двух плагинов SEO подойдут. Но есть и другие способы.

#2: Используйте специальный плагин robots.txt

Существует также множество различных плагинов WordPress, созданных специально для того, чтобы вы могли редактировать robots. txt.

txt.

Вот самые популярные плагины WordPress robots.txt, которые вы, возможно, захотите проверить:

- Virtual Robots.txt

- Оптимизация WordPress Robots.txt

- Редактор robots.txt

Каждый из них позволяет легко получить доступ к файлу robots.txt и изменить его. Ниже приведены быстрые шаги, которые необходимо предпринять для доступа к файлу robots.txt с помощью этих 3 плагинов WordPress.

❗ Обратите внимание, что некоторые плагины создают файл robots.txt, который помещается в корень вашего сайта, а другие создают его динамически. Если robots.txt создается динамически, то вы не найдете его в корневом каталоге вашего сайта (например, через FTP).

❗ Не используйте одновременно несколько плагинов robots.txt!

Virtual Robots.txt

Вот как использовать плагин Virtual Robots.txt:

- Установить и активировать Virtual Robots.

txt .

txt .

- В панели инструментов WordPress перейдите к Настройки , а затем Virtual Robots.txt .

- Теперь вы можете просматривать файл robots.txt и изменять его. Когда вы закончите, нажмите Сохранить изменения .

Вот оно!

Better Robots.txt

Этот плагин robots.txt немного отличается от плагинов, которые я показал вам выше. С Better Robots.txt вы не изменяете текстовый файл, а просто настраиваете параметры на удобной панели внутри WordPress.

Вот что нужно:

- Установить и активировать Better Robots.txt. Плагин также называется Оптимизация WordPress Robots.txt.

- Предоставьте плагину необходимые разрешения.

- Перейдите к Better Robots.txt . Плагин будет доступен на левой боковой панели.

- Теперь вы увидите множество полезных и удобных настроек.

- Плагин также позволяет вручную разрешать или запрещать определенные поисковые роботы.

- Вы также можете настроить некоторые параметры для защиты данных или оптимизации производительности загрузки.

- Есть и другие интересные настройки, которые предлагает плагин. Я рекомендую проверить тех.

Better Robots.txt позволяет создать полностью настроенный файл robots.txt, не касаясь ни строчки кода.

Редактор Robots.txt

А вот как использовать редактор Robots.txt:

- Установите и активируйте Редактор Robots.txt .

- Перейдите к Плагины > Установленные плагины на панели инструментов WordPress. Вы также можете получить доступ к файлу robots.txt, выбрав «Настройки» > « Чтение ».

- Щелкните Настройки в разделе Robots.txt Редактор.

- Теперь у вас есть доступ к файлу robots.txt и его редактирование. Когда вы закончите, нажмите Сохранить изменения .

❗ Будьте осторожны и избегайте одновременного использования нескольких редакторов robots.txt. Это действительно может все испортить. Если вы используете SEO-плагин, вам следует использовать только его редактор robots.txt.

#3: Доступ к robots.txt через cPanel на вашем хостинге

Здесь я покажу вам, как загрузить robots.txt в WordPress без доступа по FTP.

Вы также можете использовать cPanel вашего хостинга для создания или изменения файла robots.txt.

Обратите внимание, что некоторые плагины, показанные выше, динамически создают файл robots.txt. Это означает, что вы не сможете найти файл в корневом каталоге вашего сайта.

❗ Если вы используете плагин для создания и управления robots.txt, вам не следует пытаться вручную добавить новый robots.txt с помощью cPanel или FTP (ниже).

Однако, если вы не полагаетесь на эти плагины, вы можете вручную создать и обновить файл robots. txt на своем веб-сайте WordPress.

txt на своем веб-сайте WordPress.

Вот как это сделать с помощью Bluehost:

- Войдите в cPanel на вашем хостинге.

- Развернуть секцию Дополнительно .

- Нажмите Диспетчер файлов .

- Перейдите в корневой каталог вашего веб-сайта.

- Если вы не используете подключаемый модуль, динамически генерирующий robots.txt, вы должны увидеть файл robots.txt в корне.

- Щелкните файл robots.txt и выберите Изменить .

- Теперь вы можете редактировать содержимое файла robots.txt. Когда закончите, нажмите Сохранить изменение s.

Если на вашем сайте нет файла robots.txt, вам необходимо создать и загрузить его.

Вот что нужно сделать:

- Откройте редактор текстовых файлов, например Notepad или Notepad++.

- Создайте файл robots.txt.

- Загрузите файл в основной каталог вашего сайта.

В случае Bluehost просто нажмите Загрузить в диспетчере файлов. Просто убедитесь, что вы находитесь в корне.

В случае Bluehost просто нажмите Загрузить в диспетчере файлов. Просто убедитесь, что вы находитесь в корне.

Этот метод будет работать как для веб-сайтов WordPress, так и для веб-сайтов, отличных от WordPress.

#4. Используйте FTP для доступа к robots.txt

Здесь я покажу вам, как получить доступ к robots.txt через FTP.

Самый быстрый и самый «профессиональный» способ получить доступ к robots.txt — использовать FTP. Этот метод также работает для любого типа веб-сайтов, включая сайты WordPress.

❗ Я не рекомендую этот метод, если вы используете плагин для автоматического создания robots.txt для вас.

Этот метод аналогичен тому, что вы делаете с помощью cPanel на своем хостинге, за исключением того, что на этот раз вы используете FTP-клиент для доступа к своему веб-сайту.

Чтобы использовать этот метод, вам потребуется имя пользователя и пароль FTP, а также FTP-клиент, например Filezilla .

Вот что вам нужно сделать:

- Подключитесь к вашему сайту через FTP-клиент.

- Перейдите в корневой каталог вашего веб-сайта, если вы еще этого не сделали.

- Загрузите файл robots.txt, если он есть.

- Откройте файл robots.txt в текстовом редакторе, например Notepad++.

- При необходимости измените файл. Сохранить изменения.

- Загрузите файл в корневой каталог. Это перезапишет существующий файл robots.txt.

Если на вашем веб-сайте нет файла robots.txt, вы также можете создать и загрузить его.

Как проверить файл robots.txt на вашем веб-сайте

Если вы внесли некоторые изменения в robots.txt, я настоятельно рекомендую вам протестировать файл robots.txt, чтобы убедиться, что файл правильный и действительно выполняет свои функции. делать.

Что делать:

- Прочитайте эту короткую статью о как проверить файл robots.

php

Disallow: /wp-register.php

Disallow: */trackback

Disallow: */feed

Disallow: /cgi-bin

Disallow: /tmp/

Disallow: *?s=

Host: site.com

Sitemap: http://site.com/sitemap.xml

php

Disallow: /wp-register.php

Disallow: */trackback

Disallow: */feed

Disallow: /cgi-bin

Disallow: /tmp/

Disallow: *?s=

Host: site.com

Sitemap: http://site.com/sitemap.xml

php$

php$