Как настроить Robots.txt для WordPress

robots.txt — это текстовый файл, который используется для того, чтобы запретить роботам (в частности ботам поисковых систем) индексацию и «обход» определенных частей вашего сайта. Без этого файла боты смогут свободно гулять по вашему сайту, что не очень то и хорошо.

По-умолчанию WordPress не создает файл robots.txt, поэтому его необходимо создать самостоятельно и настроить тоже самому.

Общий смысл запрета доступа к определенным частям вашего сайта в том, чтобы сфокусировать внимание роботов на важном контенте.

Что произойдет, если у вас не будет файла robots.txt?

Вкратце, будет индексироваться все подряд.

Для WordPress это означает следующее:

- /cgi-bin

- /wp-admin

- /wp-includes

- /wp-content/themes

- /wp-content/plugins/

Как вы уже, наверное, догадались, ничего из вышеперечисленного не является релевантным контентом для SEO и может даже навредить вашему сайту. Google разрешает только определенное количество «ссылочного мусора», поэтому имеет смысл сконцентрировать усилия на контенте и страницах.

Google разрешает только определенное количество «ссылочного мусора», поэтому имеет смысл сконцентрировать усилия на контенте и страницах.

Как можно контролировать индексацию своего сайта?

Решение очень простое.

Создайте текстовый файл, используя ваш любимый текстовый редактор, или же, если на хостинге у вас установлена Cpanel, то создайте новый файл в файловом менеджере и назовите его robots.txt.

Скопируйте и вставьте в него следующее:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/themes Disallow: /wp-content/plugins/ Allow: /wp-content/uploads Allow: /feed*

Сохраните файл. Если же вы создали его вне сервера, то просто загрузите в корневую директорию сайта. Это та же директория, где расположены папки wp-admin, wp-includes и wp-content.

Вот и все. Теперь вы заметите, что некоторые ссылки сайта станут выпадать из поиска в течение нескольких дней или даже недель.

Если вы захотите добавить другие файлы, просто добавьте правило вроде этого:

Allow: /путь_к/папке

Обратите внимание, что мы пропускаем домен сайта, а добавляем путь к папке начиная с прямого слеша (/).

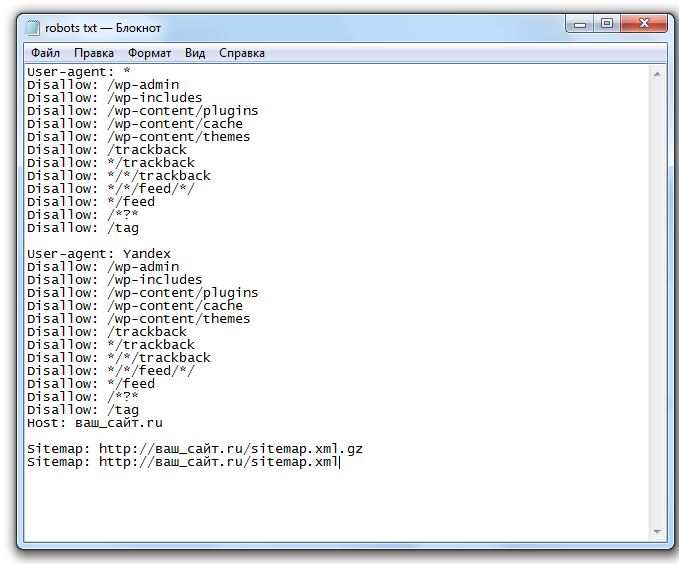

За несколько лет работы с WordPress мы собрали для себя оптимальный «набор» правил для robots.txt. Ниже приводим его содержание. Его можно взять за основу, однако стоит разобраться что именно вы закроете от индексации. Некоторые вебмастера предпочитают закрывать рубрики и теги, другие же — наоборот, оставляют открытыми для ботов.

# All User-agent: * Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /page* Disallow: /page Disallow: /author/* Disallow: /20* Disallow: /feed Disallow: /*/feed Disallow: */comme Disallow: */feednt-page-* Disallow: */trackback Disallow: /trackback Disallow: /*?* Disallow: /*? Disallow: /*.php$ Disallow: /*.js$ Disallow: /*.inc$ Disallow: /*.css$ Disallow: /search/*/feed Disallow: /search/*/* Disallow: /tag/ Disallow: */*?replytocom* Disallow: */*/feed/*/ Disallow: */feed Allow: /wp-content/uploads/ Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Google Image User-agent: Googlebot-Image Disallow: Allow: /* # Google AdSense User-agent: Mediapartners-Google* Disallow: Allow: /* # Yandex User-agent: Yandex Host: site.ru Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: /cgi-bin Disallow: /page* Disallow: /page Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /20* Disallow: /feed Disallow: /author/* Disallow: */comme Disallow: */feednt-page-* Disallow: */trackback Disallow: /trackback Disallow: /*?* Disallow: /*? Disallow: /*. php$ Disallow: /*.js$ Disallow: /*.inc$ Disallow: /*.css$ Disallow: /search/*/feed Disallow: /search/*/* Disallow: /tag/ Disallow: */*?replytocom* Disallow: */*/feed/*/ Disallow: */feed Allow: /wp-content/uploads/ Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # YandexBlog User-agent: YandexBlog Disallow: Allow: /*

Rating: 5.0/5 (3 votes cast)

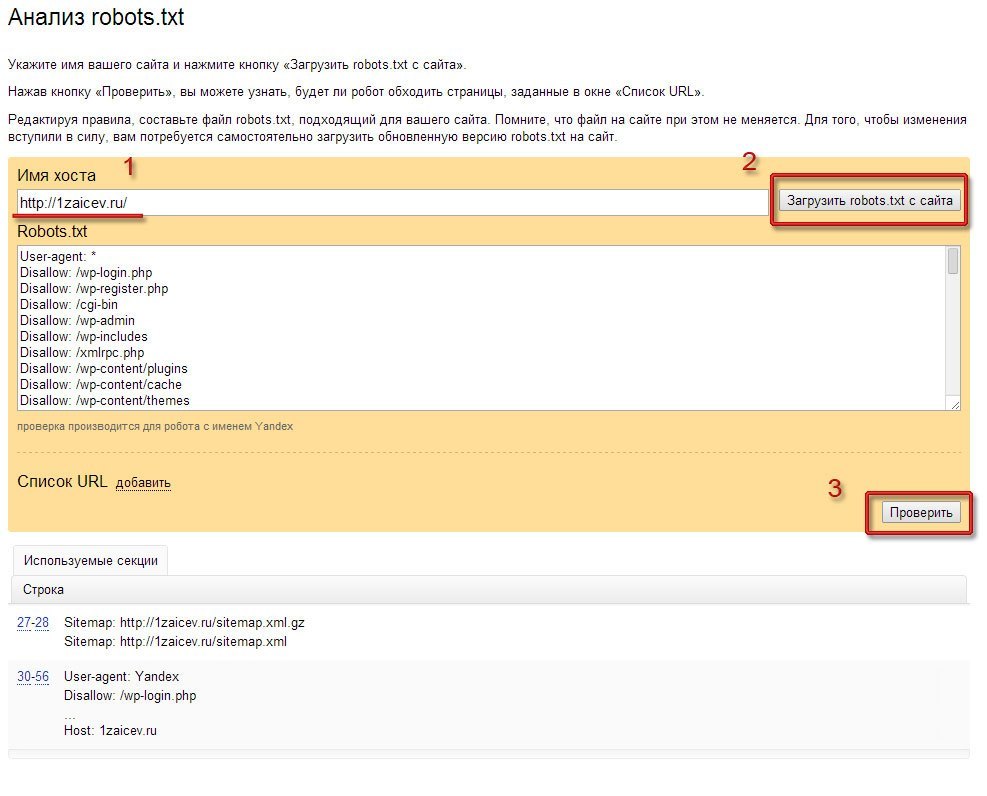

Настройка файла robots.txt для WordPress

Исторически сложилось так, что главным способом указать параметры для индексации сайта с помощью поисковых систем стал обычный текстовый файл robots.txt, размещаемый в корне веб-проекта. Именно на него ориентируются все поисковые боты, формирующие выдачу в Google, Yandex и в других системах. Поскольку этот файл заполняется по определённым правилам, очень важно знать все их «подводные камни». Небрежное отношение к его содержимому может стать причиной отсутствия в поиске или наоборот стать источником утечки конфиденциальной информации.

Зачем нужен robots.txt?

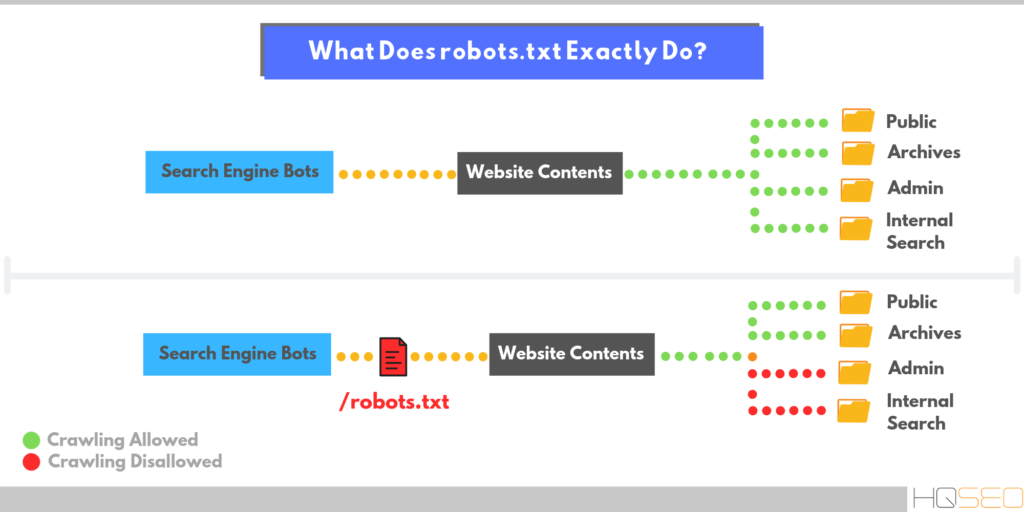

Структура любого сайта напоминает дерево папок на локальном компьютере, в которых хранятся отдельные файлы. Записи в файле robots.txt являются ничем иным, как директивами для поисковых ботов. С помощью специального синтаксиса им можно разрешать или запрещать доступ к отдельным частям вашего веб-проекта.

Поведение поискового бота на сайте

Типичный поисковый бот нацелен на обнаружение нового и уникального контента, который он индексирует, чтобы передать своей системе. Главное правило поискового робота — слушаться команд из robots.txt. Оказываясь на вашем сайте, он первым делом считывает информацию оттуда, а затем заглядывает только в те разделы, доступ к которым не был ограничен.

Рассмотрим ситуацию, когда этот файл отсутствует или является пустым. В этом случае бот начинает исследовать все уголки сайта, включая корневую директорию. Поскольку чаще всего именно там хранятся настройки вашего проекта, то они очень скоро могут стать достоянием всех пользователей интернета. Чтобы этого избежать, нужно проследить за тем, чтобы в файле с директивами содержались правильные записи.

Чтобы этого избежать, нужно проследить за тем, чтобы в файле с директивами содержались правильные записи.

Как создать и куда поместить robots.txt?

Поскольку файл с директивами является самым простым текстовым файлом, то для его создания подойдёт любой редактор. Важно лишь при сохранении дать ему правильное название, то есть «robots.txt». Каждая команда внутри представляет собой отдельную строку.

Готовый файл следует разместить в корневой директории сайта. Только в этом случае есть гарантия того, что он будет замечен и прочитан ботом. Если случайно перенести файл в другую папку, то поисковый механизм его просто не увидит, то есть останется бесконтрольным.

После чтения инструкций послушный бот заглянет только в те разделы, в которые ему разрешили доступ и проигнорирует все остальные.

Структура robots.txt

Файл с директивами состоит из отдельных блоков, о предназначении каждого из которых мы расскажем ниже.

Поскольку у каждого поисковика по сети путешествуют свои боты, иногда хорошей идеей является задать для каждого из них отдельные инструкции. Делается это с помощью директивы User-agent.

Делается это с помощью директивы User-agent.

Чтобы инструкциям из файла следовали абсолютно все поисковики, достаточно указать строку «User-agent: *». Из-за большого количества ботов сложно создать файл, учитывающий их все. На практике чаще всего раздельные правила индексирования требуется в явном виде разместить лишь для Google и Yandex.

Запрет на посещение определённых разделов сайта устанавливается с помощью команды Disallow. Обратной ей является директива Allow, которая наоборот открытым текстом даёт понять, что соответствующий раздел доступен для индексирования.

Для того, чтобы задать название главного хоста проекта, используйте команду Host.

Размещение карты сайта в формате xlm очень важно для полного и качественного индексирования сайта в поисковых системах. Указать его место положение можно с помощью ключевого слова Sitemap.

Полезно: лучший плагин для защиты от спама

Настраиваем robots.txt правильно

Прежде, чем мы расскажем о правильных настройках robots, необходимо ясно понимать, что главным для поисковых механизмов является полезная информация, которая будет востребована потенциальными посетителями вашего сайта. Если бот будет индексировать служебный контент, то пользы от его работы для вас нет. Даже наоборот — в открытый доступ могут попасть данные для доступа к сайту и его базе данных, чему очень порадуются злоумышленники.

Если бот будет индексировать служебный контент, то пользы от его работы для вас нет. Даже наоборот — в открытый доступ могут попасть данные для доступа к сайту и его базе данных, чему очень порадуются злоумышленники.

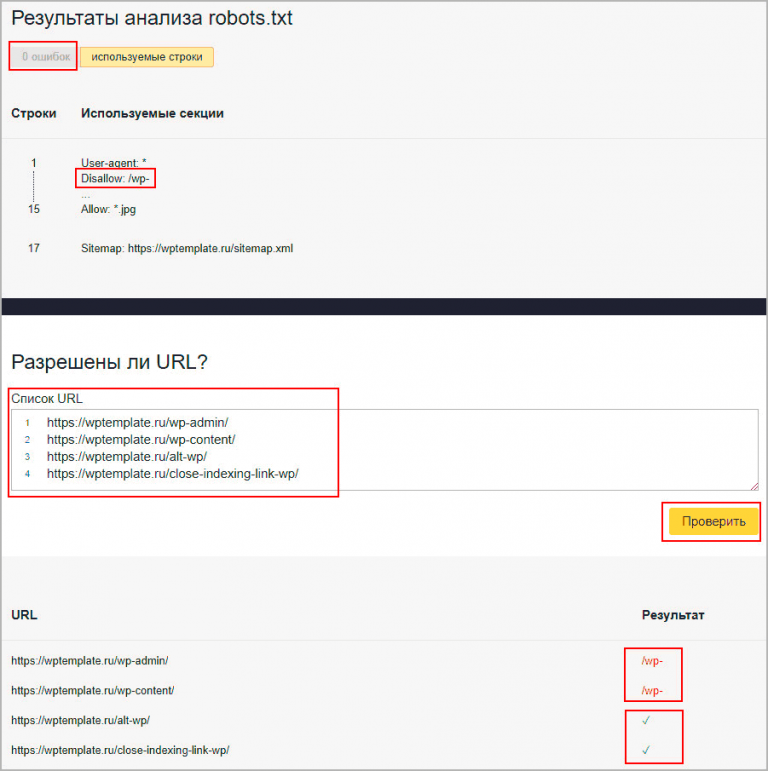

В корне любого сайта на WP располагается внушительное количество папок, содержимое которых лучше всего никому не показывать. Для этого явно запретим к ним доступ. Пример ниже.

Disallow: /wp- # Блокируем доступ к папкам, которые начинаются на wp- и содержат основные файлы для администрирования Disallow: */trackback Disallow: /*?* # Эта команда устанавливает запрет на индексирование всех ссылок, то есть защищает от дублирования Disallow: /?s=* Disallow: */author # Запрет на доступ к авторской папке Disallow: /2021 Disallow: /xmlrpc.php Allow: /wp-content/uploads/ Allow: *.js # Разрешаем индексировать скрипты Allow: *.css # Разрешаем индексировать стили Host: project.ru # Здесь указываем главное зеркало сайта Sitemap: http://project.ru/sitemap.xml # Указываем местоположение карты сайта

Если структура вашего сайта отличается от стандартной, то вышеприведённая последовательность команд может выглядеть иначе.

Как ещё можно улучшить robots?

Даже использование примера выше не гарантирует полного контроля за действиями поисковых машин. В отдельных случаях ссылки на чувствительные разделы всё равно могут появиться в выдаче, но уже без содержимого. В этом нет угрозы безопасности сайту, однако не помешало бы убрать и эти следы.

Здесь мы подошли к моменту, когда не получится дать универсальной рекомендации, которая подойдёт для всех поисковиков.

В случае с Google достаточно воспользоваться набором фирменных инструментов для администраторов сайтов — Google Webmaster Tools. Чтобы запретить индексацию всех ссылок, оканчивающихся на feed, добавьте необходимые параметры в панели и сохраните настройки. Кстати, в случае с Yandex повторять аналогичные настройки не рекомендуется.

Дополнительным методом оптимизации является запрет на индексацию пагинации. Легче всего этого добиться с помощью популярного плагина All in One SEO. Достаточно в его настройках активировать канонические ссылки, после чего включить запрет на их панагацию. Это позволит поисковым ботам без ошибок определять основное содержимое сайта, не отвлекаясь на дубликаты. Дополнительно здесь рекомендуется включить noindex для всех архивов, страницы поиска, 404-ой страницы, а также для страниц и записей с панагацией. Чтобы завершить настройку, также отметьте флажком использование nofollow для страниц с панагацией.

Это позволит поисковым ботам без ошибок определять основное содержимое сайта, не отвлекаясь на дубликаты. Дополнительно здесь рекомендуется включить noindex для всех архивов, страницы поиска, 404-ой страницы, а также для страниц и записей с панагацией. Чтобы завершить настройку, также отметьте флажком использование nofollow для страниц с панагацией.

Если для оформления сайта вы используете тему, то откройте поисковикам доступ к её картинкам. Если этого не сделать, вы рискуете столкнуться с исчезновением нужной информации из поисковой выдачи.

Другими методами улучшения качества индексации является оптимизация меток и рубрик. Дело в том, что рубрикация приводит к двоению контента, что дезориентирует поисковики. Следует обратить внимание, что простой запрет на индексацию в данном случае является лишь одной из стратегий. Альтернативным вариантом будет внесение небольших изменений в код, что позволит рубрикам обрести уникальность. Если всё сделать правильно, то вы получите больше посетителей.

Завершая настройку robots, не забудьте про команду Host. Если явно не указать основное зеркало, то внимание бота будет отвлечено на дублирующие страницы, а вы потеряете часть своих пользователей.

Настройка robots для 2 поисковиков

В случаях, когда требуется указать раздельные инструкции для различных поисковиков, очень важно соблюсти их порядок. Лучшим решением будет сначала прописать инструкции Allow и Disallow для всех поисковиков, а затем отдельный блок посвятить конкретному. Пример структуры роботс для этого случая приведён ниже.

User-agent: * Disallow: /feed … User-agent: Yahoo Disallow: /feed … Host: myproject.ru Sitemap: http://myproject.ru/sitemap.xml

Заключение

Очевидно, что редактирование файла с инструкциями для ботов поисковых систем не следует откладывать на потом. Сделайте это сразу после того, как будет определена структура сайта. Прежде всего стоит обеспокоиться тем, чтобы скрыть от посторонних глаз важную информацию, влияющую на безопасность ресурса. Далее важно указать ботам на наиболее привлекательные с точки зрения контента части вашего проекта. Это даст ему возможность присутствовать в поисковой выдаче на высоких позициях и получать органический трафик. В случае крупных изменений в структуре сайта, каждый раз заново просматривайте файл. При необходимости вносите в него правки.

Далее важно указать ботам на наиболее привлекательные с точки зрения контента части вашего проекта. Это даст ему возможность присутствовать в поисковой выдаче на высоких позициях и получать органический трафик. В случае крупных изменений в структуре сайта, каждый раз заново просматривайте файл. При необходимости вносите в него правки.

Robots.txt для WordPress: Настройка WordPress Robots.txt

Следование передовым методам поисковой оптимизации (SEO) имеет первостепенное значение, если вы хотите, чтобы ваш сайт занимал высокие позиции в результатах поиска и привлекал более квалифицированный трафик на ваши страницы. Несмотря на то, что в вашем списке есть десятки пунктов, вы не должны забывать об одном — создании файла robots.txt для WordPress. Но что такое файл robots.txt?

У нас есть ответ! На этой странице мы ответим на такие вопросы, как:

- Что такое файл robots.txt WordPress?

- Зачем мне нужен файл robots.txt для моего сайта WordPress?

- Как редактировать файл robots.

txt с помощью WordPress?

txt с помощью WordPress? - Как проверить файл robots.txt?

Продолжайте читать, чтобы узнать больше!

Что такое файл robots.txt WordPress?

WordPress robots.txt — это файл, который владельцы веб-сайтов создают, чтобы сообщить поисковым системам, как сканировать и индексировать их сайт. Он предоставляет поисковым системам, таким как Google, руководство по сканированию и индексированию, чтобы гарантировать, что наиболее ценные страницы будут проиндексированы и появятся в результатах поиска.

Зачем мне нужен файл robots.txt для WordPress?

Robots.txt для WordPress имеет решающее значение, поскольку он сообщает поисковым системам, какие страницы или папки им не следует сканировать.

Чтобы ваш сайт отображался в результатах поиска, Google должен просканировать ваши страницы и проиндексировать их. Если вы хотите, чтобы эти поисковые роботы эффективно сканировали ваш сайт, вы должны направлять их с помощью файла robots.txt. WordPress robots. txt не блокирует поисковые роботы от индексации определенных страниц на вашем сайте — для этого необходимо использовать метатег noindex.

txt не блокирует поисковые роботы от индексации определенных страниц на вашем сайте — для этого необходимо использовать метатег noindex.

Однако этот файл помогает отвлечь поисковых роботов от этих страниц и сосредоточиться на более важных страницах, которые необходимо проиндексировать, таких как страницы продуктов, страницы услуг или сообщения с контентом. Использование файла robots.txt для WordPress также помогает предотвратить замедление работы вашего сайта этими ботами. Без этого файла боты могут перегружать ваш сайт, пытаясь сканировать разные страницы, что в конечном итоге может привести к медленной загрузке.

Учитывая, что медленная загрузка сайтов обходится предприятиям в 2,6 миллиарда долларов в год, вы не хотите рисковать. В целом, использование файла WordPress robots.txt полезно для того, чтобы помочь вашему бизнесу повысить рейтинг наиболее важных страниц в результатах поиска, не замедляя при этом работу вашего сайта.

Как редактировать robots.txt с помощью WordPress

Теперь, когда вы знаете, почему файл robots. txt имеет решающее значение для отображения вашего сайта в результатах поиска, вы готовы принять меры, чтобы помочь вашему сайту сканироваться и индексироваться. Существует два подхода к созданию файла robots.txt.

txt имеет решающее значение для отображения вашего сайта в результатах поиска, вы готовы принять меры, чтобы помочь вашему сайту сканироваться и индексироваться. Существует два подхода к созданию файла robots.txt.

Вы можете использовать плагин WordPress robots.txt или сделать это вручную.

Плагин robots.txt для WordPress №1: All-in-One SEO

Первый вариант создания файла robots.txt — All-in-One SEO или AIOSEO. Этот плагин поставляется с генератором файлов robots.txt, который можно использовать для создания и редактирования файлов robots.txt. Чтобы отредактировать файл robots.txt с помощью этого плагина, выполните следующие действия:

- Войдите в панель управления WordPress

- Нажмите на Все в одном SEO

- Нажмите Диспетчер функций

- Прокрутите вниз до Редактор файлов и нажмите Активировать

- Вернуться в меню

- Щелкните вкладку txt

- Нажмите Редактировать

С этого момента вы можете ввести файл robots. txt WordPress, а затем сохранить изменения, чтобы они вступили в силу на вашем сайте!

txt WordPress, а затем сохранить изменения, чтобы они вступили в силу на вашем сайте!

Плагин WordPress robots.txt № 2: Yoast SEO

Еще один плагин WordPress robots.txt, который вы можете использовать, — это Yoast SEO.

Yoast SEO позволяет создавать и редактировать файл robots.txt на вашем веб-сайте. Чтобы использовать этот плагин для редактирования файла, выполните следующие действия:

- Перейдите на панель инструментов WordPress

- Нажмите на SEO

- Нажмите Инструменты

- Нажмите Редактор файлов

- Редактировать ваш файл robots.txt

После редактирования файла robots.txt вы можете добавить свой текст и сохранить его, чтобы он начал действовать.

WordPress robots.txt. manual option

Когда вы научитесь редактировать robots.txt с помощью WordPress, вы обнаружите, что можете выбрать ввод файла вручную вместо использования плагина.

Для этого вам понадобится протокол передачи файлов (FTP), такой как FileZilla. Чтобы создать файл robots.txt для WordPress таким образом, выполните следующие действия:

- Открыть текстовый редактор (например, Блокнот)

- Введите кодировку, которую хотите использовать

- Сохранить файл как текстовый файл типа

- Подключите свой сайт к FTP

- Перейти к общедоступной папке HTML

- Загрузите файл txt с вашего компьютера на сервер

Как протестировать файл robots.txt в WordPress

Теперь, когда вы знаете, как редактировать файл robots.txt в WordPress, вы можете добавить собственные правила и периметры для сканирования вашего сайта. Добавив файл robots.txt, вы хотите убедиться, что он работает и что поисковые системы могут сканировать ваш сайт.

Вы можете протестировать файл robots.txt для WordPress с помощью Google Search Console. Google Search Console предлагает инструмент для проверки robots. txt, который поможет вам определить, может ли Google сканировать ваш сайт. Вот как это можно проверить:

txt, который поможет вам определить, может ли Google сканировать ваш сайт. Вот как это можно проверить:

- Откройте инструмент txt tester

- Прокрутите код robots.txt, чтобы найти выделенные синтаксические предупреждения и логические ошибки

- Введите URL-адрес страницы вашего сайта в текстовое поле ниже

- Выберите пользовательский агент , который вы хотите имитировать, в раскрывающемся списке

- Нажмите кнопку Проверка

После того, как вы нажмете кнопку «Тест», появится сообщение «ПРИНЯТО» или «БЛОКИРОВАНО». Это уведомление сообщит вам, может ли Google сканировать вашу страницу или нет.

Как правило, вы хотите видеть «ПРИНЯТО», если только вы не тестируете URL-адрес страницы, которую Google не должен сканировать и индексировать. Если какой-либо URL-адрес отображается как «БЛОКИРОВАННЫЙ», который вы не хотите блокировать, вам придется вернуться в файл robots. txt, внести изменения, сохранить их и попробовать снова протестировать URL-адрес.

txt, внести изменения, сохранить их и попробовать снова протестировать URL-адрес.

Нужна помощь в редактировании файла robots.txt для WordPress?

Добавив файл robots.txt для WordPress, вы поможете Google более эффективно сканировать и индексировать ваш сайт, чтобы самые ценные страницы отображались в результатах поиска. Но если вы не знаете, как добавлять, редактировать и тестировать файл robots.txt в WordPress, вам может помочь WebFX.

В нашей команде более 450 специалистов по маркетингу, которые знают, как оптимизировать файлы robots.txt. Мы не только можем помочь вам с этим, но и внедрить другие передовые методы SEO, от интеграции ключевых слов до создания контента. Если вы готовы начать, свяжитесь с нами через Интернет или позвоните нам сегодня в 888-601-5359 , чтобы поговорить со стратегом о наших SEO-услугах WordPress!

Что такое Robots txt и как включить его на веб-сайтах?

Конечно, вы уже знаете, что Google использует ботов для поиска веб-страниц в Интернете, включая страницы вашего веб-сайта. По сути, роботы поисковых систем будут сканировать все страницы сайта. Однако он менее эффективен. Что ж, чтобы сделать поисковые роботы более эффективными, вам нужен файл robots txt.

По сути, роботы поисковых систем будут сканировать все страницы сайта. Однако он менее эффективен. Что ж, чтобы сделать поисковые роботы более эффективными, вам нужен файл robots txt.

Все еще не знакомы с robots txt? Расслабьтесь, мы подробно объясним в этой статье. Мы расскажем, что такое txt-робот, почему он важен и, конечно же, как настроить txt-роботов на вашем веб-сайте.

Что такое Robots txt?

Robots txt — это файл, содержащий инструкции, сообщающие роботам поисковых систем, какие страницы сканировать. Боты поисковых систем будут автоматически сканировать все веб-страницы. Он даже сканирует даже неважные страницы, такие как каталоги плагинов и тем.

Сканировать на эти страницы, конечно, не нужно, потому что это бесполезно. Кроме того, обход ненужных страниц также замедляет процесс сканирования вашего веб-сайта. Это связано с увеличением количества страниц, которые поисковые роботы должны сканировать.

Поэтому вам нужно настроить robots txt на своем сайте. Robots txt предписывает роботам поисковых систем сканировать только важные страницы. Таким образом, процесс сканирования на вашем сайте будет завершен быстрее.

Robots txt предписывает роботам поисковых систем сканировать только важные страницы. Таким образом, процесс сканирования на вашем сайте будет завершен быстрее.

Где хранится текстовый файл Robots и каковы правила?

Прежде чем научиться упорядочивать текстовый файл robots, вам нужно знать, где он хранится. Когда веб-сайт будет создан, он автоматически создаст файл robots.txt, который находится в основной папке сервера.

Например, имя вашего веб-сайта — www.mywebsite.com. Вы можете найти файл robots.txt по адресу www.mywebsite.com/robots.txt, например:

В файле robots.txt можно найти три общие команды. Три команды:

Агент пользователя: показывает роботов поисковых систем, на которые влияют команды из файла robots txt. Вы можете просто разобраться, какие боты затронуты. Но чтобы вам было легче, следует сразу поставить звездочку (). Звездочка () означает, что команда robots.txt затрагивает всех ботов. Disallow: команда, которая запрещает роботам поисковых систем сканировать определенные страницы. Разрешить: это команда, которая позволяет ботам поисковых систем сканировать определенные страницы. Как правило, вам не нужно использовать команду Разрешить. Потому что боты поисковых систем будут автоматически сканировать все веб-страницы. Таким образом, вы будете использовать команду Disallow гораздо чаще.

Разрешить: это команда, которая позволяет ботам поисковых систем сканировать определенные страницы. Как правило, вам не нужно использовать команду Разрешить. Потому что боты поисковых систем будут автоматически сканировать все веб-страницы. Таким образом, вы будете использовать команду Disallow гораздо чаще.

Как настроить txt для роботов в WordPress с помощью плагинов

Чтобы установить txt для роботов, вы можете использовать плагин. Есть два плагина, которые вы можете использовать, а именно Yoast SEO и All in One SEO Pack. Оба имеют одинаковую функцию. Вам просто нужно выбрать, какой из них больше подходит для вашего сайта.

Ах да, прежде чем приступить к приведенному ниже руководству, у вас уже должен быть список страниц, которые не нужно сканировать ботам поисковых систем. Так ваша работа будет выполнена быстрее.

Начнем с первого метода!

Плагин Yoast SEO

Yoast SEO — действительно бесплатный плагин SEO с полным набором функций. Yoast SEO полезен не только для анализа качества SEO на веб-сайте, но и для активации текстовых роботов и управления ими.

Вот шаги, чтобы включить текстовых роботов на вашем сайте с помощью Yoast SEO:

Во-первых, убедитесь, что у вас установлен Yoast SEO. Если вы еще не установили его на своем веб-сайте, вы можете установить его через каталог плагинов WordPress или скачать здесь.

Во-вторых, откройте панель инструментов WordPress и щелкните меню SEO > Инструменты > Редактор файлов. После этого вы можете создать текстовый файл robots, нажав Создать файл robot.txt.

В-третьих, на этом этапе вам нужно создать правило, соответствующее потребностям вашего веб-сайта. Введите любые страницы, которые нужны роботам поисковых систем и которые не нужно сканировать. После этого нажмите Сохранить изменения в robots.txt.

Готово, вы успешно создали текстовый файл robots с помощью Yoast SEO.

Все в одном плагине SEO Pack

Помимо плагина Yoast SEO, вы также можете использовать другие плагины. Одним из них является плагин All in One SEO Pack. Шаги немного отличаются от Yoast SEO. Однако функция остается прежней, а именно управление txt-файлом robots.

Однако функция остается прежней, а именно управление txt-файлом robots.

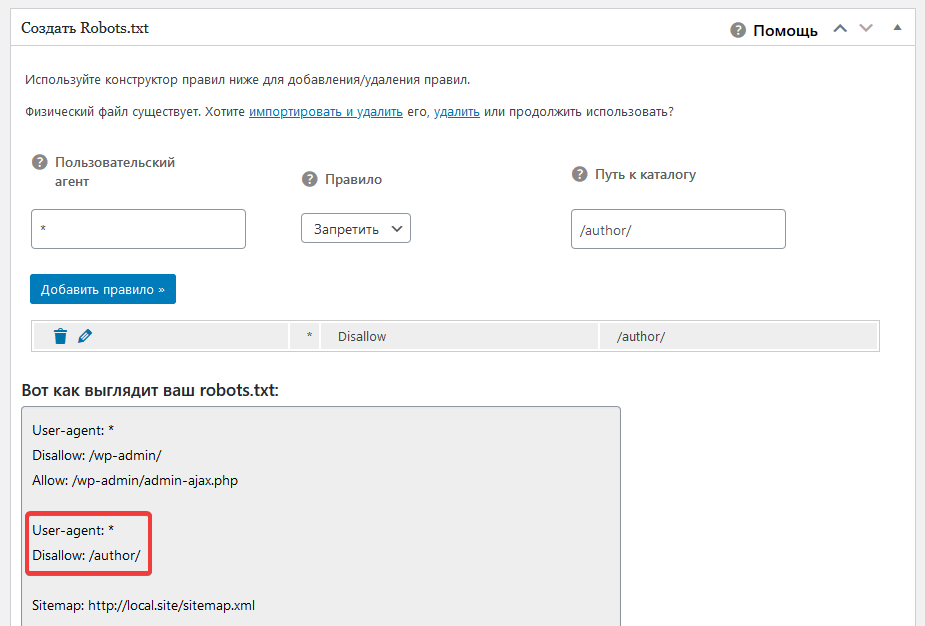

Выполните следующие шаги, чтобы включить txt-файл robots в WordPress с помощью All in One SEO Pack:

Во-первых, убедитесь, что у вас установлен плагин All in One SEO Pack. Если нет, вы можете установить его непосредственно через каталог плагинов в вашем WordPress или скачать здесь.

Во-вторых, откройте панель инструментов WordPress и нажмите All in One SEO > Feature Manager. Затем выберите меню Robots.txt и нажмите «Активировать».

В-третьих, после активации функции Robots txt вы найдете меню на панели инструментов All in One SEO Pack слева. Щелкните меню Robot.txt, и вы будете перенаправлены на страницу для создания файла robots txt.

В-четвертых, определите правила, которые вы хотите применить на веб-сайте. Выберите правило «Блокировать», чтобы заблокировать сканирование страницы, и выберите правило «Разрешить», чтобы разрешить сканирование страницы. Затем введите URL-адрес страницы, которую вы хотите заблокировать или разрешить сканирование.

Готово, вы успешно активировали текстовый робот в WordPress с помощью плагина All in One SEO Pack.

Как проверить txt-файл robots с помощью Google Search Console

После успешного создания файла robots.txt с помощью описанных выше действий его необходимо проверить. Если вы следовали приведенному выше руководству, на самом деле вероятность ошибки очень мала. Однако на всякий случай вам все равно следует проверять каждый раз, когда вы создаете или обновляете txt-файл robots.

Чтобы проверить, есть ли ошибка в созданном файле robots txt, вы можете использовать Google Search Console. Это просто. Откройте консоль поиска Google. Затем на панели инструментов Google Search Console вы найдете меню «Сканирование» > сканер robots.txt.

После этого вы увидите созданный ранее файл robots.txt и нажмите «Отправить». Если есть ошибка, Google Search Console сообщит вам об этом. Однако, как упоминалось ранее, вероятность ошибки очень мала. Так что вам не о чем беспокоиться.