Правильный robots.txt для WordPress | Как сделать robots.txt

Вебмастера и маркетологи знают насколько важна индексация сайта поисковыми системами. Именно поэтому они делают все возможное, чтобы помочь поисковикам типа Google и Yandex правильно сканировать и индексировать свои сайты.

Большое количество времени и ресурсов тратятся на внутреннюю и внешнюю оптимизацию, такую как контент, ссылки, теги, оптимизация изображений и структуры сайта.

Всё это играет огромную роль в продвижении. Однако если вы забыли сделать техническую оптимизацию сайта, если вы не слышали о файлах robots.txt и sitemap.xml могут возникнуть проблемы с правильным сканированием и индексацией вашего сайта.

В этой статье я объясню как правильно настраивать и использовать файл robots.txt и мета-тег robots. Итак, начнем!

Что такое robots.txt

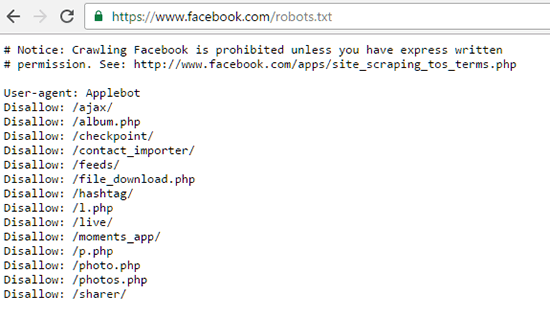

Robots.txt – это текстовый файл, который используется в качестве инструкции для роботов поисковых систем (также известных как сканеры, боты или пауки), как сканировать и индексировать страницы сайта.

Простыми словами, robots.txt говорит роботам, какие страницы или файлы сайта мы хотим видеть в поиске, а какие нет.

В идеале файл robots.txt размещается в корневом каталоге вашего веб-сайта (https://site.com/robots.txt), чтобы роботы могли сразу получить доступ к его инструкциям.

Если вы используете CMS WordPress, то вы сможете увидеть ваш файл по вышеуказанному адресу, однако вы не найдете сам файл в общей папке с вашим сайтом. Это потому что WordPress автоматически создает виртуальный файл robots.txt (с параметрами по-умолчанию), если не находит данный файл в корневом каталоге сайта.

Виртуальный файл robots.txt CMS WordPress не решает всех необходимых задач, в связи с этим крайне желательно написать свой.

Для чего нужен robots.txt

Файл robots.txt нужен, для того чтобы запретить поисковым роботам посещать определенные разделы вашего сайта, например:

- страницы пагинации;

- страницы с результатами поиска на сайте;

- административные файлы;

- служебные страницы;

- ссылки с utm-метками;

- данные о параметрах сортировки, фильтрации, сравнении;

- страница личного кабинета и т.

п.

п.

Важно! Файл robots.txt не является обязательным к исполнению поисковыми роботами. В связи с этим, если вы хотите на 100% быть уверенными в том что какая-либо из страниц вашего сайта не появится в поисковой выдаче – используйте мета-тег robots.

Если вы не хотите чтобы какая-то страница вашего сайта появилась в поиске вставьте в <head> страницы атрибут noindex:

<meta name=“robots” content=“noindex,nofollow”>

<meta name=“robots” content=“noindex,nofollow”> |

Как редактировать robots txt

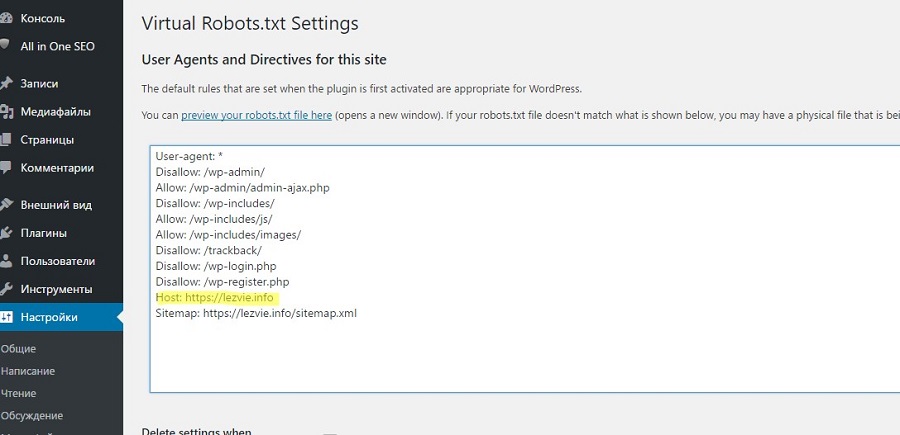

Редактировать файл robots.txt в CMS WordPress можно двумя способами. Добавить необходимый код в файл functions.php, или при помощи плагина.

Устанавливаем плагин Virtual Robots.txt из репозитория CMS WordPress, открываем его в админ. панеле во вкладке Настройки. В открывшееся поле плагина вносим необходимый код, жмем кнопку Save и вуаля – ваш файл robots.txt готов. к содержанию ↑

Правильный robots.txt для CMS WordPress

Взял с сайта seogio.ru и немного подкорректировал. Вот что получилось:

User-agent: * # общие правила для роботов всех поисковых систем

Disallow: /cgi-bin # служебная папка для хранения серверных скриптов

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск по сайту

Disallow: *&s= # поиск по сайту

Disallow: /search/ # поиск по сайту

Disallow: /author/ # архив автора

Disallow: /users/ # архив пользователей

Disallow: */trackback # трекбеки, уведомления в комментариях о ссылке на веб-документ

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 | User-agent: * # общие правила для роботов всех поисковых систем Disallow: /cgi-bin # служебная папка для хранения серверных скриптов Disallow: /? # все параметры запроса на главной Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет, # правило можно удалить) Disallow: *?s= # поиск по сайту Disallow: *&s= # поиск по сайту Disallow: /search/ # поиск по сайту Disallow: /author/ # архив автора Disallow: /users/ # архив пользователей Disallow: */trackback # трекбеки, уведомления в комментариях о ссылке на веб-документ Disallow: */feed # все фиды Disallow: */rss # rss фид Disallow: */embed # все встраивания Disallow: */wlwmanifest. # правило можно удалить) Disallow: /xmlrpc.php # файл WordPress API Disallow: *utm*= # ссылки с utm-метками Disallow: *openstat= # ссылки с метками openstat Allow: */uploads # открываем папку с файлами uploads Allow: /*/*.js # открываем файлы скриптов js Allow: /*/*.css # открываем фалы css Allow: /wp-*.png # разрешаем индексировать изображения Allow: /wp-*.jpg # разрешаем индексировать изображения Allow: /wp-*.jpeg # разрешаем индексировать изображения Allow: /wp-*.gif # разрешаем индексировать гифки Allow: /wp-admin/admin-ajax.php # разрешаем ajax

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS # то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал # Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают. Host: www.site.ru

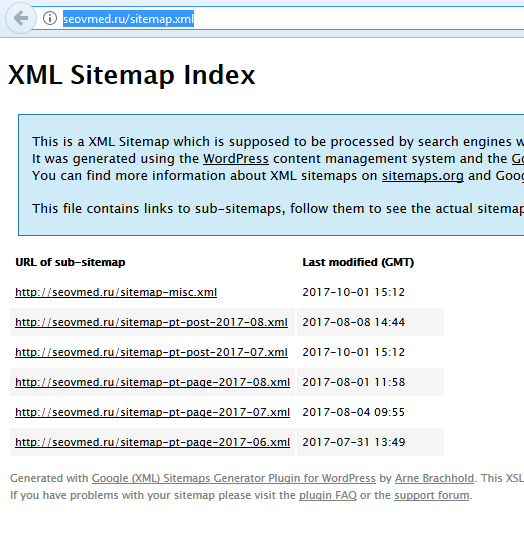

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent # не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже. Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz |

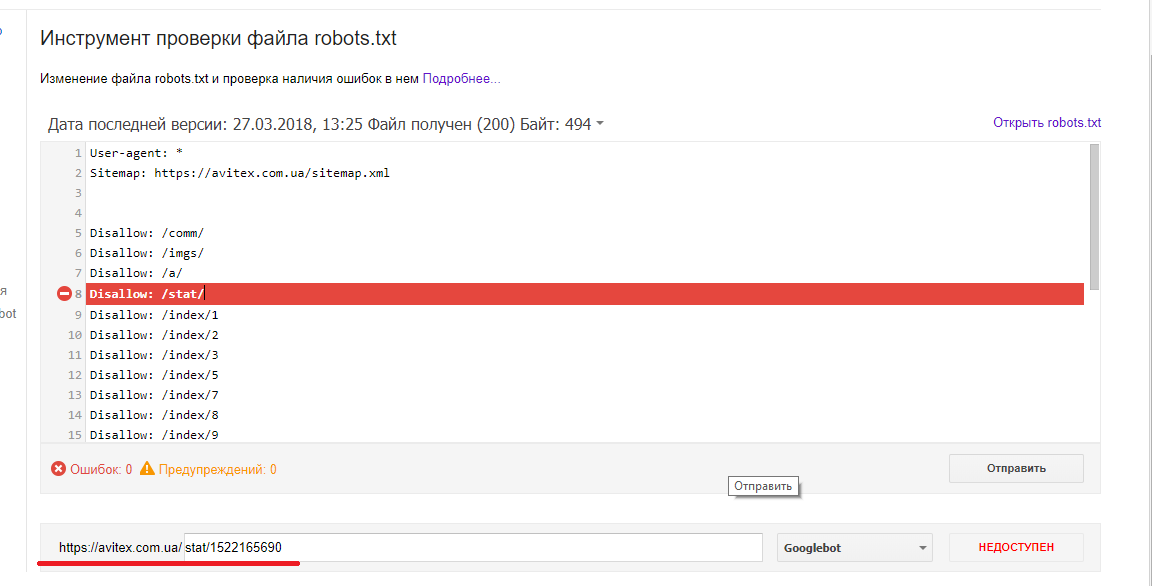

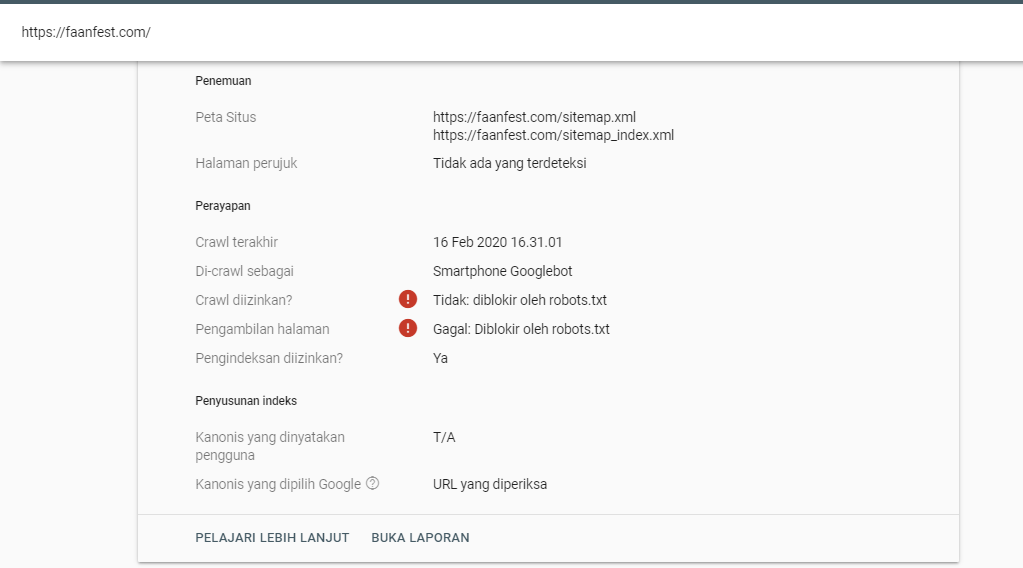

Проверка robots.txt

Если файл robots.txt настроен неправильно это может привести к множественным ошибкам в индексации сайта. Проверить правильность настройки вашего robots.txt можно с помощью бесплатного инструмента Google Robots Testing Tool

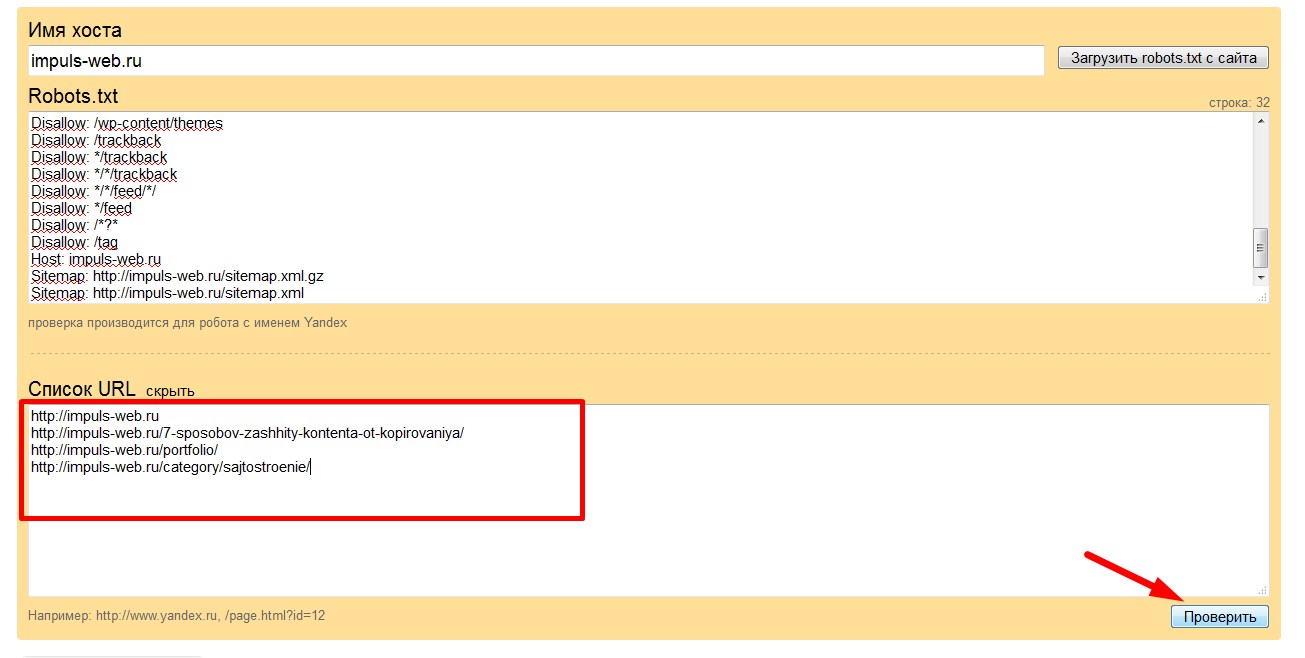

Выбираем наш сайт:

Вводим в строку путь к нашему файлу robots.txt и жмем кнопку Проверить:

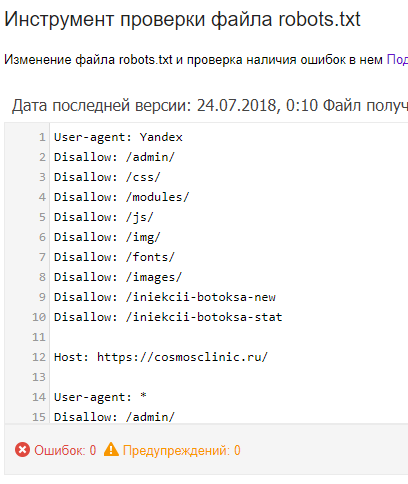

В результате не должно быть ошибок и предупреждений и файл должен быть Доступен для роботов:

Если файл robots.txt настроен правильно, это значительно ускорит процесс индексации вашего сайта.

Правильный Robots.txt для WordPress

Загрузка…Оригинал статьи в блоге Дениса Биштейнова https://seogio.ru/robots-txt-dlya-wordpress/

Ниже привожу короткий и расширенный вариант. Короткий не включает отдельные блоки для Google и Яндекса. Расширенный уже менее актуален, т.к. теперь нет принципиальных особенностей между двумя крупными поисковиками: обеим системам нужно индексировать файлы скриптов и изображений, обе не поддерживают директиву Host. Тем не менее, если в этом мире снова что-то изменится, либо вам потребуется все-таки как-то по-отдельному управлять индексацией файлов на сайте Яндексом и Гугл, сохраню в этой статье и второй вариант.

Еще раз обращаю внимание, что это базовый файл robots.txt. В каждом конкретном случае нужно смотреть реальный сайт и по-необходимости вносить корректировки. Поручайте это дело опытным специалистам!

Короткий вариант (оптимальный)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc. php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru

php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ruРасширенный вариант (отдельные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

Disallow: /*attachment*

Disallow: /cart # для WooCommerce

Disallow: /checkout # для WooCommerce

Disallow: *?filter* # для WooCommerce

Disallow: *?add-to-cart* # для WooCommerce

Clean-param: add-to-cart # для WooCommerce

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest. xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru

xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru В примере я не добавляю правило Crawl-Delay, т.к. в большинстве случаев эта директива не нужна. Однако если у вас крупный нагруженный ресурс, то использование этой директивы поможет снизить нагрузку на сайт со стороны роботов Яндекса, Mail.Ru, Bing, Yahoo и других (Google не учитывает).

Однако если у вас крупный нагруженный ресурс, то использование этой директивы поможет снизить нагрузку на сайт со стороны роботов Яндекса, Mail.Ru, Bing, Yahoo и других (Google не учитывает).

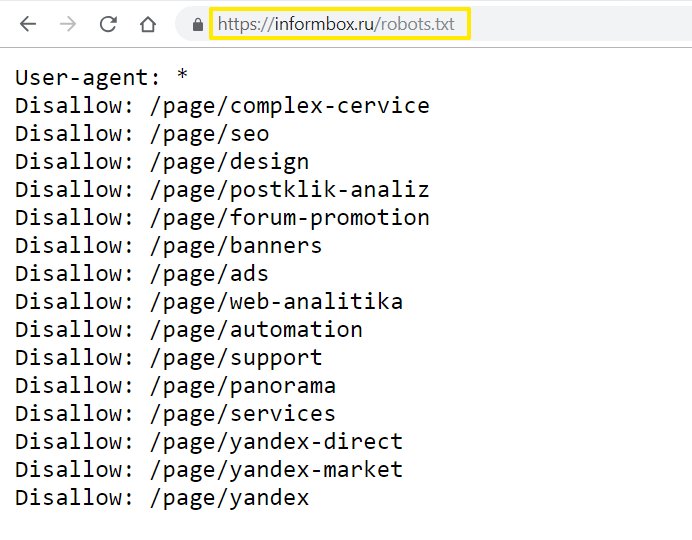

Ошибочные рекомендации

- Использовать правила только для User-agent: *

Для многих поисковых систем не требуется индексация JS и CSS для улучшения ранжирования, кроме того, для менее значимых роботов вы можете настроить большее значение Crawl-Delay и снизить за их счет нагрузку на ваш сайт. - Прописывание Sitemap после каждого User-agent

Это делать не нужно. Один sitemap должен быть указан один раз в любом месте файла robots.txt - Закрыть папки wp-content, wp-includes, cache, plugins, themes

Это устаревшие требования. Для Яндекса и Google лучше будет их вообще не закрывать. Или закрывать «по умному», как это описано выше. - Закрывать страницы тегов и категорий

Если ваш сайт действительно имеет такую структуру, что на этих страницах контент дублируется и в них нет особой ценности, то лучше закрыть. Однако нередко продвижение ресурса осуществляется в том числе за счет страниц категорий и тегирования. В этом случае можно потерять часть трафика - Закрывать от индексации страницы пагинации /page/

Это делать не нужно. Для таких страниц настраивается тегrel="canonical", таким образом, такие страницы тоже посещаются роботом и на них учитываются расположенные товары/статьи, а также учитывается внутренняя ссылочная масса. - Прописать Crawl-Delay

Модное правило. Однако его нужно указывать только тогда, когда действительно есть необходимость ограничить посещение роботами вашего сайта. Если сайт небольшой и посещения не создают значительной нагрузки на сервер, то ограничивать время «чтобы было» будет не самой разумной затеей. - Ляпы

Некоторые правила я могу отнести только к категории «блогер не подумал». Например:

Например: Disallow: /20— по такому правилу не только закроете все архивы, но и заодно все статьи о 20 способах или 200 советах, как сделать мир лучше.

Спорные рекомендации

- Комментарии

Некоторые ребята советуют закрывать от индексирования комментарииDisallow: /commentsиDisallow: */comment-*. - Открыть папку uploads только для Googlebot-Image и YandexImages

User-agent: Googlebot-Image

Allow: /wp-content/uploads/

User-agent: YandexImages

Allow: /wp-content/uploads/

Совет достаточно сомнительный, т.к. для ранжирования страницы необходима информация о том, какие изображения и файлы размещены на ней.

UPD: Нашёл статью Prevent robots crawling “add-to-cart” links on WooCommerce (Не давайте роботам обходить ссылки WooCommerce “добавить в корзину”) в которой наглядно показывается результат закрытия ссылок с параметром ?add-to-cart=.

Но Яндекс всё равно продолжает индексировать эти ссылки. Нашёл в справке Яндекса, как можно их закрывать — через директиву Clean-param (https://yandex.ru/support/webmaster/robot-workings/clean-param.html).

Поэтому добавил в robots.txt эту директиву.

Поделиться

Поделиться

Отправить

Вотсапнуть

Твитнуть

Правильный файл robots.txt для WordPress 2020: настройка

Автор Анита Арико На чтение 15 мин. Просмотров 711 Опубликовано

Чтобы нужные страницы сайта попадали в индекс поисковых систем, важно правильно настроить файл robots.txt. Этот документ дает рекомендации поисковым роботам, какие страницы обрабатывать, а какие — нет: например, от индексации можно закрыть панель управления сайтом или страницы, которые находятся в разработке. Рассказываем, как правильно настроить robots. txt, если ваш сайт сделан на WordPress.

txt, если ваш сайт сделан на WordPress.

Чтобы понять, какие страницы есть на сайте, поисковики «напускают» на него роботов: они сканируют сайт и передают перечень страниц в поисковую систему. robots.txt — это текстовый файл, в котором содержатся указания о том, какие страницы можно, а какие нельзя сканировать роботам.

Обычно на сайте есть страницы, которые не должны попадать в выдачу: например, это может быть административная панель, личные страницы пользователей или временные страницы сайта. Кроме этого, у поисковых роботов есть определенный лимит сканирования страниц (кроулинговый бюджет) — за раз они могут обработать только ограниченное их количество.

Проведем аналогию: представим сайт в виде города, а страницы в виде домов. По дорогам между домов ездят роботы и записывают информацию о каждом доме (индексируют страницы и добавляют в базу). Роботы получают ограниченное количество топлива в день — например, 10 литров на объезд города в день. Это топливо — кроулинговый бюджет, который выделяют поисковые системы на обработку сайта.

На маленьких проектах, 500-1000 страниц, кроулинговый бюджет не сказывается критично, но на интернет-магазинах, маркетплейсах, больших сервисах могут возникнут проблемы. Если они спроектированы неверно, то робот может месяцами ездить по одному кварталу (сканировать одни и те же страницы), но не заезжать в отдаленные районы. Чем больше проект, тем больший кроулинговый бюджет выделяют поисковики, но это не поможет, если дороги сделаны неудобно и вместо прямой дороги в 1 км нужно делать крюк в 15 км.

Правильный robots.txt помогает решить часть этих проблем.

Разные поисковые системы по-разному обрабатывают robots.txt: например, Google может включить в индекс даже ту страницу, которая запрещена в этом файле, если найдет ссылку на такую страницу на страницах сайта. Яндекс же относится к robots.txt как к руководству к действию — если страница запрещена для индексации в файле, она не будет включена в результаты поиска, но с момента запрета может пройти до двух недель до исключения из индекса. Таким образом, правильная настройка robots.txt в 99% случаев помогает сделать так, чтобы в индекс попадали только те страницы, которые вы хотите видеть в результатах поиска.

Таким образом, правильная настройка robots.txt в 99% случаев помогает сделать так, чтобы в индекс попадали только те страницы, которые вы хотите видеть в результатах поиска.

Кроме этого, robots.txt может содержать технические сведения о сайте: например, главное зеркало, местоположение sitemap.xml или параметры URL-адресов, передача которых не влияет на содержимое страницы.

Файл robots.txt рекомендует роботам поисковых систем, как правильно обрабатывать страницы сайта, чтобы они попали в выдачу.

Где находится файл robots.txt?По умолчанию в WordPress нет файла robots.txt. При установке WordPress создает виртуальный файл robots.txt с таким содержимым:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpТакая настройка говорит поисковым роботам следующее:

User-agent: * — для любых поисковых роботов

Disallow: /wp-admin/ — запретить обрабатывать /wp-admin/

Allow: /wp-admin/admin-ajax.php — разрешить обрабатывать элементы сайта, которые загружаются через AJAX

Этот файл не получится найти в папках WordPress — он работает, но физически его не существует. Поэтому, чтобы настроить robots.txt, сначала нужно его создать.

Robots.txt должен находиться в корневой папке (mysite.ru/robots.txt), чтобы роботы любых поисковых систем могли его найти.

Как редактировать и загружать robots.txtЕсть несколько способов создать файл robots.txt — либо сделать его вручную в текстовом редакторе и разместить в корневом каталоге (папка самого верхнего уровня на сервере), либо воспользоваться специальными плагинами для настройки файла.

Как создать robots.txt в БлокнотеСамый простой способ создать файл robots.txt — написать его в блокноте и загрузить на сервер в корневой каталог.

Лучше не использовать стандартное приложение — воспользуйтесь специальными редакторы текста, например, Notepad++ или Sublime Text, которые поддерживают сохранение файла в конкретной кодировке. Дело в том, что поисковые роботы, например, Яндекс и Google, читают только файлы в UTF-8 с определенными переносами строк — стандартный Блокнот Windows может добавлять ненужные символы или использовать неподдерживаемые переносы.

Дело в том, что поисковые роботы, например, Яндекс и Google, читают только файлы в UTF-8 с определенными переносами строк — стандартный Блокнот Windows может добавлять ненужные символы или использовать неподдерживаемые переносы.

Говорят, что это давно не так, но чтобы быть уверенным на 100%, используйте специализированные приложения.

Рассмотрим создание robots.txt на примере Sublime Text. Откройте редактор и создайте новый файл. Внесите туда нужные настройки, например:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://mysite.ru/sitemap.xmlГде mysite.ru — домен вашего сайта.

После того, как вы записали настройки, выберите в меню File ⟶ Save with Encoding… ⟶ UTF-8 (или Файл ⟶ Сохранить с кодировкой… ⟶ UTF-8).

Назовите файл “robots.txt” (обязательно с маленькой буквы).

Файл готов к загрузке.

Загрузить robots.txt через FTPДля того, чтобы загрузить созданный robots.txt на сервер через FTP, нужно для начала включить доступ через FTP в настройках хостинга.

После этого скопируйте настройки доступа по FTP: сервер, порт, IP-адрес, логин и пароль (не совпадают с логином и паролем для доступа на хостинг, будьте внимательны!).

Чтобы загрузить файл robots.txt вы можете воспользоваться специальным файловым менеджером, например, FileZilla или WinSCP, или же сделать это просто в стандартном Проводнике Windows. Введите в поле поиска “ftp://адрес_FTP_сервера”.

После этого Проводник попросит вас ввести логин и пароль.

Введите данные, которые вы получили от хостинг-провайдера на странице настроек доступа FTP. После этого в Проводнике откроются файлы и папки, расположенные на сервере. Скопируйте файл robots.txt в корневую папку. Готово.

Загрузить или создать robots.txt на хостингеЕсли у вас уже есть готовый файл robots. txt, вы можете просто загрузить его на хостинг. Зайдите в файловый менеджер панели управления вашим хостингом, нажмите на кнопку «Загрузить» и следуйте инструкциям (подробности можно узнать в поддержке у вашего хостера.

Многие хостинги позволяют создавать текстовые файлы прямо в панели управления хостингом. Для этого нажмите на кнопку «Создать файл» и назовите его “robots.txt” (с маленькой буквы).

После этого откройте его во встроенном текстовом редакторе хостера. Если вам предложит выбрать кодировку для открытия файла — выбирайте UTF-8.

Добавьте нужные директивы и сохраните изменения.

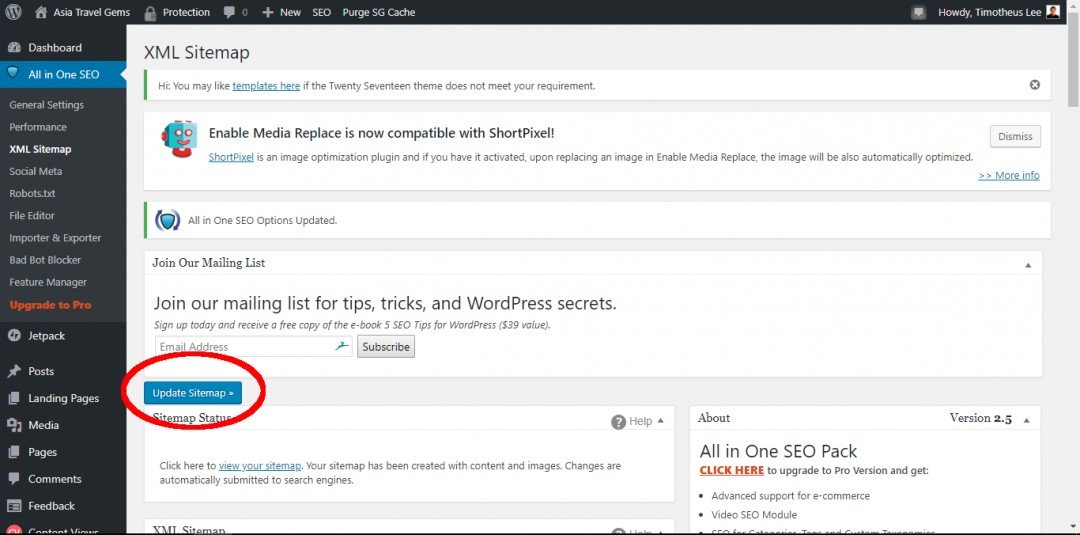

Плагины для редактирования robots.txtГораздо проще внести нужные директивы в robots.txt с помощью специальных плагинов для редактирования прямо из панели управления WordPress. Самые популярные из них — ClearfyPro, Yoast SEO и All in One SEO Pack.

Clearfy ProЭтот плагин отлично подходит для начинающих: даже если вы ничего не понимаете в SEO, Clearfy сам создаст правильный и валидный файл robots.txt. Кроме этого, плагин предлагает пошаговую настройку самых важных для поисковой оптимизации функций, так что на первых этапах развития сайта этого будет достаточно.

Чтобы настроить robots.txt, в панели управления WordPress перейдите в пункт Настройки ⟶ Clearfy ⟶ SEO.

Переключите «Создайте правильный robots.txt» в положение «Вкл». Clearfy отобразит правильные настройки файла robots.txt. Вы можете дополнить эти настройки, например, запретив поисковым роботам индексировать папку /wp-admin/.

После внесения настроек нажмите на кнопку «Сохранить» в верхнем правом углу.

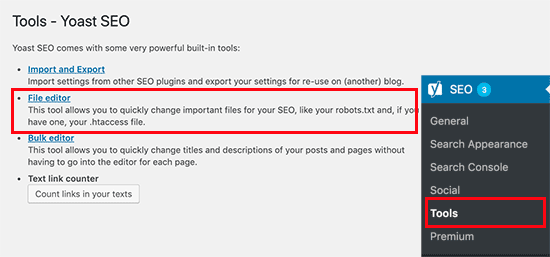

Yoast SEOПлагин Yoast SEO хорош тем, что в нем есть много настроек для поисковой оптимизации: он напоминает использовать ключевые слова на странице, помогает настроить шаблоны мета-тегов и предлагает использовать мета-теги Open Graph для социальных сетей.

С его помощью можно отредактировать и robots.txt.

Для этого зайдите в раздел Yoast SEO ⟶ Инструменты ⟶ Редактор файлов.

Здесь вы сможете отредактировать robots.txt и сохранить его, не заходя на хостинг. По умолчанию Yoast SEO не предлагает никаких настроек для файла, так что его придется прописать вручную.

После изменений нажмите на кнопку «Сохранить изменения в robots.txt».

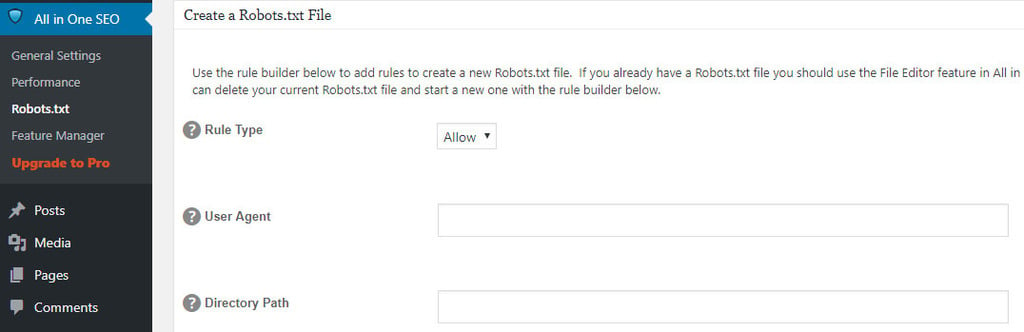

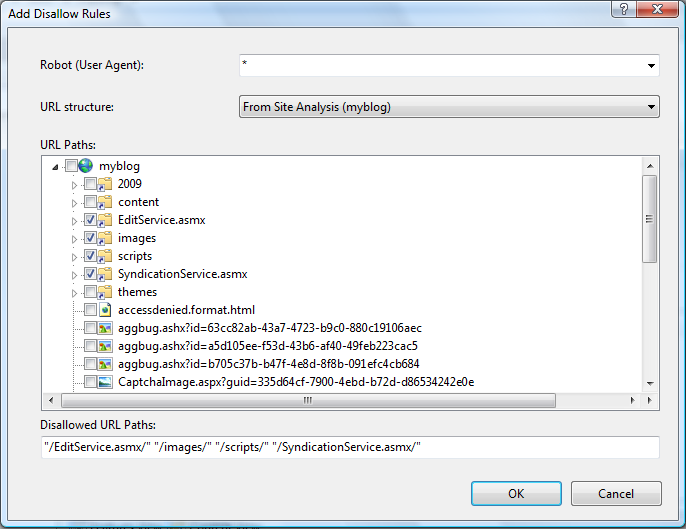

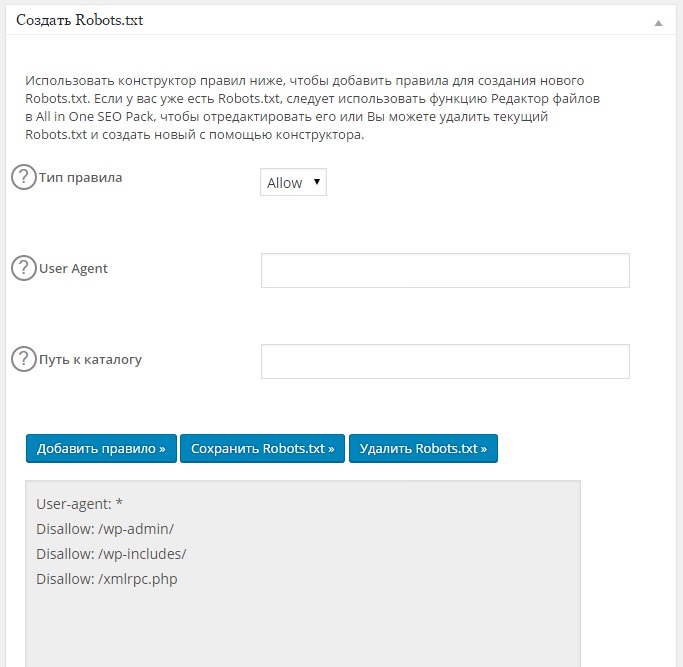

All in One SEO PackЕще один мощный плагин для управления SEO на WordPress. Чтобы отредактировать robots.txt через All in One SEO Pack, сначала придется активировать специальный модуль. Для этого перейдите на страницу плагина в раздел «Модули» и нажмите «Активировать» на модуле «robots.txt».

После подключения модуля перейдите на его страницу. С помощью него можно разрешать или запрещать для обработки конкретные страницы и группы страниц для разных поисковых роботов, не прописывая директивы вручную.

Правильный и актуальный robots.txt в 2020 годуДля того, чтобы создать правильный файл robots.txt, нужно знать, что означает каждая из директив в файле, записать их в правильном порядке и проверить файл на валидность.

Что означают указания в файле robots.txt?User-agent — поисковой роботВ строке User-agent указывается, для каких роботов написаны следующие за этой строкой указания. Например, если вы хотите запретить индексацию сайта для поисковых роботов Bing, но разрешить для Google и Яндекс, это будет выглядеть примерно так:

| User-agent: Googlebot Disallow: User-agent: Yandex User-agent: Bingbot | Для робота Google Запретить: ничего Для робота Яндекс Для робота Bing |

На практике необходимость разграничивать указания для разных поисковых роботов встречается довольно редко. Гораздо чаще robots.txt пишут для всех роботов сразу. Это указывается через звездочку:

Гораздо чаще robots.txt пишут для всех роботов сразу. Это указывается через звездочку:

User-agent: *У поисковых систем есть и специальные роботы — например, бот YandexImages обходит изображения, чтобы выдавать их в поиске Яндекса по картинкам, а Googlebot-News собирает информацию для выдаче в Google Новостях. Полные списки ботов можно найти в справке поисковых систем — введите в поиск «поисковые роботы [название ПС]».

DisallowЭта директива сообщает поисковым роботам, что страница или целый список страниц запрещены для обхода. Важно понимать, что указание в robots.txt не гарантирует, что страница не попадет в выдачу — если ссылка на запрещенную в файле страницу встречается на разрешенных страницах сайта, поисковик все равно может включить его в индекс.

Если вы хотите разрешить поисковым роботам обрабатывать все страницы сайта, оставьте это указание пустым.

User-agent: *

Disallow:Если вам нужно запретить для индексации несколько страниц или директорий, указывайте каждую из них отдельно:

User-agent: *

Disallow: /wp-admin/

Disallow: /dev/

Disallow: /index2.htmlЭто указание разрешает ботам поисковиков сканировать определенные страницы. Обычно это используют, когда нужно закрыть целую директорию, но разрешить обрабатывать часть страниц.

User-agent: *

Disallow: /wp-admin/

Disallow: /dev/

Allow: /dev/index.phpБольшинство поисковых систем обрабатывают в первую очередь более точные правила (например, с указанием конкретных страниц), а затем — более широкие. Например:

User-agent: *

Disallow: /wp-admin/

Disallow: /dev/

Allow: /dev/index.phpТакой файл robots.txt укажет роботам, что не нужно сканировать все страницы из папки «catalog», кроме «best-offers. html».

html».

Указание host говорит поисковым роботам, какое из зеркал сайта является главным. Например, если сайт работает через защищенный протокол https, в robots.txt стоит это указать:

User-agent: *

Disallow: /wp-admin/

Host: https://mysite.ruЭта директива уже устарела, и сегодня ее использовать не нужно. Если она есть в вашем файле сейчас, лучше ее удалить — есть мнение, что она может негативно сказываться на продвижении.

SitemapЭтот атрибут — еще один способ указать поисковым роботам, где находится карта сайта. Она нужна для того, чтобы поисковик смог добраться до любой страницы сайта в один клик вне зависимости от сложности его структуры.

User-agent: *

Disallow: /wp-admin/

Host: https://mysite.ru

Sitemap: https://mysite.ru/sitemap.xmlТакой параметр помогает установить задержку для обработки сайта поисковыми роботами. Это может быть полезно, если сайт расположен на слабом сервере и вы не хотите, чтобы боты перегружали его запросами: передайте в crawl-delay время, которое должно проходить между запросами роботов. Время передается в секундах.

User-agent: *

Disallow: /wp-admin/

Host: https://mysite.ru

Sitemap: https://mysite.ru/sitemap.xml

Crawl-delay: 10На самом деле современные поисковые роботы и так делают небольшую задержку между запросами, так что прописывать это явно стоит только в том случае, если сервер очень слабый.

Clean-paramЭта настройка пригодится, чтобы скрыть из поиска страницы, в адресе которых есть параметры, не влияющие на ее содержание. Звучит сложно, так что объясняем на примере.

Допустим, на сайте есть категория «Смартфоны» и она расположена по адресу mysite.ru/catalog/smartphones.

У категории есть фильтры, которые передаются с помощью GET-запроса. Предположим, пользователь отметил в фильтре «Производитель: Apple, Samsung». Адрес страницы поменялся на

Предположим, пользователь отметил в фильтре «Производитель: Apple, Samsung». Адрес страницы поменялся на

mysite.ru/catalog/smartphones/?manufacturer=apple&manufacturer=samsung,

где ?manufacturer=apple&manufacturer=samsung — параметры, которые влияют на содержимое страницы. Логично, что такие страницы можно и нужно выводить в поиске — эту страницу со включенным фильтром можно продвигать по запросу вроде «смартфоны эппл и самсунг».

А теперь представим, что пользователь перешел в категорию «Смартфоны» по ссылке, которую вы оставили во ВКонтакте, добавив к ней UTM-метки, чтобы отследить, эффективно ли работает ваша группа.

mysite.ru/catalog/smartphones/?utm_source=vk&utm_medium=post&utm_campaign=sale

В такой ссылке параметры ?utm_source=vk&utm_medium=post&utm_campaign=sale не влияют на содержимое страницы — mysite.ru/catalog/smartphones/ и mysite.ru/catalog/smartphones/?utm_source=vk&utm_medium=post&utm_campaign=sale будут выглядеть одинаково.

Чтобы помочь поисковым роботам понять, на основании каких параметров содержимое меняется, а какие не влияют на контент страницы, и используется настройка Clean-param.

User-agent: *

Disallow: /wp-admin/

Host: https://mysite.ru

Sitemap: https://mysite.ru/sitemap.xml

Clean-param: utm_campaign /

Clean-param: utm_medium /

Clean-param: utm_source /С помощью такой директивы вы укажете поисковым роботам, что при обработке страниц для поисковой выдачи нужно удалять из ссылок такие параметры, как utm_campaign, utm_medium и utm_source.

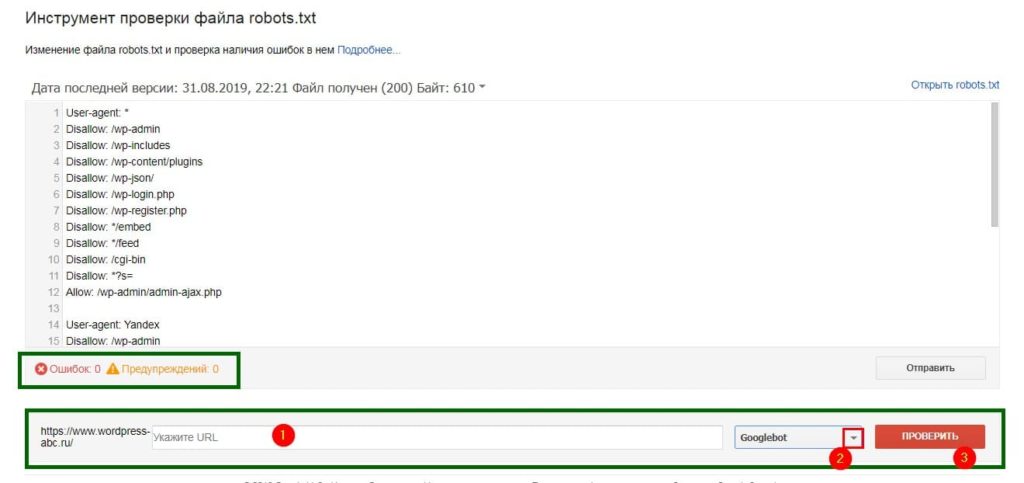

Как проверить robots.txtДля того, чтобы проверить валидность robots.txt, можно использовать инструменты вебмастера поисковых систем. Инструмент проверки robots. txt есть у Google в Search Console — для его использования понадобится авторизация в Google и подтверждение прав на сайт, для которого проверяется файл.

txt есть у Google в Search Console — для его использования понадобится авторизация в Google и подтверждение прав на сайт, для которого проверяется файл.

Похожий инструмент для проверки robots.txt есть и у Яндекса, и он даже удобнее, потому что не требует авторизации.

Эти приложения помогают понять, как поисковый робот видит файл: если какие-то из директив прописаны в нем неверно, инструмент проверки их проигнорирует либо предупредит о них.

Чего стоит избегать при настройке robots.txt?Будьте внимательны: хоть robots.txt непосредственно и не влияет на то, окажется ли ваш сайт в выдаче, этот файл помогает избежать попадания в индекс тех страниц, которые должны быть скрыты от пользователей. Все, что робот не сможет интерпретировать, он проигнорирует.

Вот несколько частых ошибок, которые можно допустить при настройке.

Не указан User-AgentИли указан после директивы, например:

Disallow: /wp-admin/

User-agent: *Такую директиву робот прочитает так:

Disallow: /wp-admin/— так, это не мне, не читаю

User-agent: * — а это мне… Дальше ничего? Отлично, обработаю все страницы!

Любые указания к поисковым роботам должны начинаться с директивы User-agent: название_бота.

User-agent: GoogleBot

Disallow: /wp-admin/

User-agent: Yandex

Disallow: /wp-admin/Или для всех сразу:

User-agent: *

Disallow: /wp-admin/Если вы укажете в директиве Disallow сразу несколько директорий, неизвестно, как робот это прочтет.

User-agent: *

Disallow: /wp-admin/ /catalog/ /temp/ /user/ — “/wp-admin/catalog/temp/user/”? “/catalog/ /user”? “??????”?По своему разумению он может обработать такую конструкцию как угодно. Чтобы этого не случилось, каждую новую директиву начинайте с нового Disallow:

Чтобы этого не случилось, каждую новую директиву начинайте с нового Disallow:

User-agent: *

Disallow: /wp-admin/

Disallow: /catalog/

Disallow: /temp/

Disallow: /user/Поисковые роботы смогут прочитать только файл с названием “robots.txt”. “Robots.txt”, “ROBOTS.TXT” или “R0b0t.txt” они просто проигнорируют.

Резюме- robots.txt — файл с рекомендациями, как обрабатывать страницы сайта, для поисковых роботов.

- В WordPress по умолчанию нет robots.txt, но есть виртуальный файл, который запрещает ботам сканировать страницы панели управления.

- Создать robots.txt можно в блокноте и загрузить его на хостинг в корневой каталог.

- Файл robots.txt должен быть создан в кодировке UTF-8.

- Проще создать robots.txt с помощью плагинов для WordPress — Clearfy Pro, Yoast SEO, All in One SEO Pack или других SEO-плагинов.

- С помощью robots.txt можно создать директивы для разных поисковых роботов, сообщить о главном зеркале сайта, передать адрес sitemap.xml или указать параметры URL-адресов, которые не влияют на содержимое страницы.

- Проверить валидность robots.txt можно с помощью инструментов от Google и Яндекс.

- Все директивы файла robots.txt, которые робот не сможет интерпретировать, он проигнорирует.

Правильный файл robots.txt для WordPress

👍 Научим создавать сайты на WordPress бесплатно за 19 уроков. Подробнее →robots.txt является файлом, специально предназначенным для поисковых систем. В нем указывается, какие части сайта нужно выдавать в поиске, а какие нет. Важность robots.txt неоценима, так как он позволяет нацелить поисковую систему на попадание нужного контента сайта в выдаче результатов. Например, при запросе в Гугле “купить стиральную машину” конечному покупателю незачем попадать на страницу администрирования магазина. В этом случае несомненно важно будет пользователю перейти сразу в раздел “Стиральные машины”.

Как добавить robots.txt на сайт?

Если Вы используете плагин Clearfy Pro – просто выставьте галочку напротив Создать правильный robots.txt в разделе SEO на странице настроек плагина. Ничего вставлять из этой статьи Вам не нужно, все реализовано в плагине.

Добавить файл можно несколькими способами. Наиболее удобный для пользователя – по FTP. Для этого необходимо создать сам файл robots.txt. Затем, воспользовавшись одним из FTP-клиентов (например, FileZilla), загрузить robots.txt в корневую папку сайта (рядом с файлами wp-config.php, wp-settings.php) Следует отметить, что перед загрузкой файла нужно узнать у Вашей хостинг-компании IP-адрес, за которым закреплен Ваш сайт, имя FTP-пользователя и пароль.

После успешной загрузки robots.txt, перейдя по адресу http://sitename.com/robots.txt, Вы сможете посмотреть актуальное состояние файла.

Важным является тот факт, что, изменив файл robots.txt, вы не сразу заметите результаты. Для этого может понадобится от одного до нескольких месяцев (это зависит от поисковой системы). Правильным вариантом является составление корректного файла уже на стадии разработки сайта.

Пример корректного robots.txt

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /*? Disallow: /?s= Allow: /*.css Allow: /*.js Host: sitename.com

** Вместо sitename.com следует указать название Вашего сайта

Плагины для robots.txt

Для облегчения создания robots.txt в WordPress существуют специальные плагины. Некоторые из них: WordPress Robots.txt File, DL Robots.txt, Yoast SEO.

Рассмотрим создание файла robots.txt на примере одного из самых мощных SEO-плагинов Yoast SEO.

После установки и активации плагина необходимо в админ-панели выбрать пункт SEO->Консоль. На вкладке Возможности перейти в раздел Дополнительные настройки страницы, передвинуть ползунок в состояние Включено и сохранить изменения. В админ-панели появятся несколько дополнительных пунктов. Далее необходимо перейти по пункту SEO->Инструменты, где выбрать Редактор файлов. Далее на странице редактора необходимо нажать на кнопку Создать файл robots.txt, в редакторе вставить вышеописанный код и нажать Сохранить изменения в robots.txt.

В админ-панели появятся несколько дополнительных пунктов. Далее необходимо перейти по пункту SEO->Инструменты, где выбрать Редактор файлов. Далее на странице редактора необходимо нажать на кнопку Создать файл robots.txt, в редакторе вставить вышеописанный код и нажать Сохранить изменения в robots.txt.

Нажмите, пожалуйста, на одну из кнопок, чтобы узнать понравилась статья или нет.

Мне нравится1Не нравится1Если Вам понравилась статья — поделитесь с друзьями

Исправление в файле Robots.txt для WordPress

Вроде уже давно поставил точку на изысканиях правильного Robots.txt для WordPress. Лишний контент убран, сайт хорошо индексируется, но вот недавно заметил одну неприятную вещь — Яндекс не загружает картинки из папки /wp-content/uploads/. С Гуглом все в порядке, он периодически добавляет новые изображения, а Яндекс, даже при ручном добавлении не хочет включать их в индекс. Для многих это возможно и не имеет значения, но на моем блоге много фотографий и отказыватся от дополнительного трафика с Яндекс.Картинок не хочется. Что ж, попробуем решить эту проблему и получить правильный файл Robots.txt для блогов на WordPress.

Приведу пример файла Robots.txt, который до недавнего времени стоял на моих сайтах:

User-agent: *

Disallow: /xmlrpc.php

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/

Disallow: /tag/

Disallow: /?s=

Disallow: /trackback/

Disallow: /feed/

Disallow: /comments/

Disallow: */trackback/

Disallow: */feed/

Disallow: */comments/

Allow: /wp-content/uploads/Sitemap: http://xela.ru/sitemap.xml

На первый взгляд все грамотно, но обратите внимание на выделенные красным строки. Самое обидное, что когда разбирался в синтаксисе Robots.txt вообще, сам же и написал, что Яндекс выполняет ту директиву, которая выше. Иными словами последнюю строку робот поисковика проигнорирует и картинки будут закрыты от индексации.

Есть три пути, как решить эту проблему. Можно перенести разрешающую строку выше запрещающей. При этом мы нарушаем правила написания файла, впрочем они не являются строгими и скорее всего такой вариант пройдет. Второй вариант — сделать дополнительную секцию для Яндекса. Мне он не понравился из-за громоздкости. Вполне понятно, что чем больше файл, тем вероятнее в нем ошибка. Да и хочется универсального решения.

После некоторого раздумия я просто решил удалить строку Disallow: /wp-content/. Собственно в это папке не находится какой-то тайной информации, так пусть она будет открыта вся. Если в поисковиках вдруг всплывут ненужные файлы, то всегда можно спрятать их прописав запрещение, скажем, на папку плагинов или темы.

Мой итоговый вариант получился следующим:

User-agent: *

Disallow: /xmlrpc.php

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /tag/

Disallow: /?s=

Disallow: /trackback/

Disallow: /feed/

Disallow: /comments/

Disallow: */trackback/

Disallow: */feed/

Disallow: */comments/

Disallow: */?

Allow: /wp-content/uploads/Sitemap: http://xela.ru/sitemap.xml

Внимательные увидят еще одну добавленную строку. Одно время в Яндексе вылезли странные ссылки на мой сайт следующего вида:

http://www.xela.ru/2009/12/nastrojka-servera-apache-na-vps/?utm_source=feedburner&utm_medium=feed&utm_campaign=Feed:+xelaru+(Xela.ru+Блог+о+фотографии,+программировании+и+seo)

Я так и не смог разобраться откуда они попадают в индекс. Судя по вот этой части «utm_source=feedburner», они появляются после перехода с RSS-подписки. При этом страница ничем не отличается от обычной со ссылкой до знака вопроса. Поэтому, чтобы в Яндексе не было ненужных дублей, я просто закрыл подобные страницы дополнительной директивой.

Файл вверху действующий, так что можете смело использовать его у себя, нужно только заменить путь к сайту в sitemap.

ТОП4 способа как создать Robots txt для WordPress

👍 Научим создавать сайты на WordPress бесплатно за 19 уроков. Подробнее →Хотите, чтобы поисковые системы корректно индексировали страницы и разделы вашего блога? Отличное решение — сделать правильный файл Robots txt для WordPress. Разберемся как и что в нем прописать.

Для чего нужен Robots.txt?

Он предназначен для поисковых систем, их роботов и правильной индексации. Директивы файла указывают, какие разделы сайта нужно выдавать в поиске, а какие скрыть. Это позволяет нацелить поисковик на попадание нужного контента в выдаче. Например, если человек в Google введет «как отремонтировать холодильник», то ему нужно показать инструкцию по ремонту, а не страницу регистрации или информацию о сайте.

Результат поисковой выдачи после изменений robots.txt вы заметите не сразу. Может пройти от недели до нескольких месяцев. Правильно будет его создать уже во время разработки сайта.

Где лежит Robots?

Это обычный текстовый файл, который располагается в корневой папке сайта и доступен по адресу

https://site.com/robots.txt

По умолчанию Роботс не создается. Его нужно создавать вручную или использовать инструменты, которые делают это автоматически. Разберем их ниже.

Не могу найти этот файл

Если по указанной выше ссылке файл доступен онлайн, но в корне сайта его нет, то это означает, что он создан виртуально. Для поисковой системы нет разницы. Главное, чтобы его содержимое можно было получить по адресу https://site.com/robots.txt.

Из чего состоит robots.txt

Имеет 4 основных директивы:

- User-agent — задает правила для поисковых роботов.

- Disalow — запрещает доступ.

- Allow — разрешает.

- Sitemap — полный путь (URL-адрес) XML-карты.

Пример стандартного robots.txt для ВордПресс

Вариаций этого файла много. На каждом сайте он может отличаться.

Вот пример рабочего Роботс. Посмотрим что означает каждая его строка и для чего нужна.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /license.txt

Disallow: /readme.html

Disallow: /trackback/

Disallow: /comments/feed/

Disallow: /*?replytocom

Disallow: */feed

Disallow: */rss

Disallow: /author/

Disallow: /?

Disallow: /*?

Disallow: /?s=

Disallow: *&s=

Disallow: /search

Disallow: *?attachment_id=

Allow: /*.css

Allow: /*.js

Allow: /wp-content/uploads/

Allow: /wp-content/themes/

Allow: /wp-content/plugins/

Sitemap: https://site.com/sitemap_index.xml

Первая строка говорит, что ссылки сайта могут обходить все поисковые роботы.

Строки с Disallow запрещают индексировать служебные папки и файлы, кэшированные страницы, страницы авторизации и регистрации, RSS (Feed), страницы авторов, поиска и вложений.

Директивы с Allow наоборот разрешают добавлять в индекс поисковиков скрипты, стили, файлы загрузок, тем и плагинов.

Последняя строка указывает на адрес карты XML.

По этому примеру вы можете составить свой Роботс, который будет «заточен» под ваш ресурс.

Идеального содержимого этого файла для всех сайтов не существует. Его всегда нужно формировать под конкретный ресурс.

Как создать правильный robots.txt для сайта

Есть несколько способов.

Вручную

Это можно сделать обычным ручным способом. Например, в Блокноте (если локальный сайт) или через FTP-клиент (на сервере хостинга).

Также это можно сделать с помощью ВП-плагинов. Разберем лучшие.

Clearfy Pro

Виртуальный файл поможет создать премиум-плагин Clearfy Pro, который имеет целый набор функций для SEO и оптимизации сайта.

- Установите и активируйте расширение.

- Откройте админ-раздел Clearfy Pro.

- Перейдите на вкладку SEO.

- Активируйте опцию Создать правильный robots.txt.

- Заполните содержимое директивами.

- Нажмите кнопку Сохранить изменения.

Всегда можно отредактировать содержимое Robots. Просто измените/дополните его нужным содержимым и сохраните изменения.

Активировать промокод на 15%

Yoast SEO

Этот мощный СЕО-модуль для WP также корректно решит задачу.

- Откройте SEO > Инструменты.

- Кликните по Редактор файлов.

- Если этого файла в корне сайта нет, нажмите Создать файл robots.txt.

- Если существует, то откроется редактор, в котором можно вносить правки.

- Если изменили Роботс, кликните по кнопке ниже.

All in One SEO Pack

В этом популярном для поисковой оптимизации решении тоже есть инструменты чтобы создать/отредактировать Robots.

- После активации перейдите All in One SEO > Модули.

- Из списка выберите одноименное название модуля и нажмите Activate.

- Откройте All in One SEO > Robots.txt.

- С помощью полей добавьте директивы.

Настройка для интернет-магазинов на основе WooCommerce

Для WordPress-ресурсов с использованием этого расширения есть свои директивы. Просто добавьте их к своим.

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Disallow: /my-account/Как оптимизировать ваш WordPress Robots.txt для SEO

Файл robots.txt является очень мощным инструментом, когда вы работаете над SEO раскруткой сайта, но с ним нужно обращаться осторожно. Это позволяет запретить поисковым системам доступ к различным файлам и папкам, но зачастую это не то, что вы хотите делать в наши дни. За прошедшие годы Google особенно сильно изменил способ сканирования интернета, поэтому часто то, что раньше было лучшей практикой несколько лет назад, больше не работает. В этом посте описывается текущая лучшая практика для вашего файла WordPress robots.txt и объясняется, почему вы должны его принять.

За прошедшие годы Google особенно сильно изменил способ сканирования интернета, поэтому часто то, что раньше было лучшей практикой несколько лет назад, больше не работает. В этом посте описывается текущая лучшая практика для вашего файла WordPress robots.txt и объясняется, почему вы должны его принять.

Недавно один из наших читателей спросил нас о том, как оптимизировать файл robots.txt для улучшения SEO. Файл Robots.txt рассказывает поисковым системам, как сканировать ваш сайт, что делает его невероятно мощным инструментом SEO. В этой статье мы покажем вам, как создать идеальный файл robots.txt для SEO.

Что такое файл robots.txt?

Robots.txt — это текстовый файл, который владельцы веб-сайтов могут создать, чтобы сообщить поисковым роботам, как сканировать и индексировать страницы на своем сайте.

Обычно он хранится в корневом каталоге, также известном как основная папка вашего сайта. Базовый формат файла robots.txt выглядит следующим образом:User-agent: [user-agent name]Disallow: [URL string not to be crawled]

User-agent: [user-agent name]Allow: [URL string to be crawled]Sitemap: [URL of your XML Sitemap]

Вы можете иметь несколько строк инструкций, чтобы разрешить или запретить определенные URL-адреса и добавить несколько файлов Sitemap. Если вы не запретите URL-адрес, то поисковые роботы предполагают, что им разрешено сканировать его.

Вот как может выглядеть файл примера robots.txt:

User-Agent: *

Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xml

В приведенном выше примере robots.txt мы разрешили поисковым системам сканировать и индексировать файлы в нашей папке загрузок WordPress.

После этого мы запретили поисковым роботам сканировать и индексировать плагины и папки администратора WordPress.

Наконец, мы предоставили URL нашего сайта XML.

Вам нужен файл Robots.txt для вашего сайта WordPress?

Если у вас нет файла robots.txt, поисковые системы все равно будут сканировать и индексировать ваш сайт. Однако вы не сможете указать поисковым системам, какие страницы или папки им не следует сканировать.

Это не окажет большого влияния, когда вы впервые начинаете вести блоги, так как у вас мало контента.

Однако, поскольку ваш сайт растет и у вас стает больше контента, вы, вероятно, захотите лучше контролировать то, как ваш сайт сканируется и индексируется.

Вот почему.

Поисковые боты имеют квоту сканирования для каждого веб-сайта.

Это означает, что они сканируют определенное количество страниц во время сеанса сканирования. Если они не завершат сканирование всех страниц вашего сайта, они вернутся и возобновят сканирование в следующем сеансе.

Это может замедлить скорость индексации вашего сайта.

Это можно исправить, запретив поисковым роботам сканировать ненужные страницы, такие как страницы администратора WordPress, файлы плагинов и папки тем.

Запрещая ненужные страницы, вы сохраняете квоту на сканирование. Это помогает поисковым системам сканировать еще больше страниц на вашем сайте и индексировать их как можно быстрее.

Еще одна веская причина использовать файл robots.txt, когда вы хотите, чтобы поисковые системы не индексировали пост или страницу на вашем сайте.

Это не самый безопасный способ скрыть контент от широкой публики, но он поможет вам предотвратить его появление в результатах поиска.

Как должен выглядеть идеальный файл Robots.txt?

Многие популярные блоги используют очень простой файл robots.txt. Их содержание может варьироваться в зависимости от потребностей конкретного сайта:User-agent: *Disallow:Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www. example.com/page-sitemap.xml

example.com/page-sitemap.xml

Этот файл robots.txt позволяет всем ботам индексировать весь контент и предоставляет им ссылку на XML-карты сайта .

Для сайтов WordPress мы рекомендуем следующие правила в файле robots.txt:User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http:

Это говорит поисковым роботам индексировать все изображения и файлы WordPress. Он запрещает поисковым роботам индексировать файлы плагинов WordPress, область администрирования WordPress, файл readme для WordPress и партнерские ссылки.

Добавляя файлы sitemaps в файл robots.txt, роботы Google упрощают поиск всех страниц на вашем сайте.

Теперь, когда вы знаете, как выглядит идеальный файл robots.txt, давайте посмотрим, как вы можете создать файл robots.txt в WordPress.

Как создать файл Robots.txt в WordPress?

Есть два способа создать файл robots.txt в WordPress. Вы можете выбрать метод, который лучше всего подходит для вас.

Метод 1: Редактирование файла Robots.txt с помощью Yoast SEO

Если вы используете плагин Yoast SEO для раскрутки сайта, он поставляется с генератором файлов robots.txt.

Вы можете использовать его для создания и редактирования файла robots.txt прямо из вашей админ-панели WordPress.

Просто зайдите на страницу SEO »Инструменты в вашей админке WordPress и нажмите на ссылку« Редактор файлов ».

На следующей странице, Yoast SEO-страница покажет ваш существующий файл robots.txt.

Если у вас нет файла robots.txt, Yoast SEO создаст для вас файл robots.txt.

По умолчанию генератор файлов robots.txt Yoast SEO добавляет следующие правила в ваш файл robots.txt:User-agent: *Disallow: /

Это важно , что вы удалите этот текст , потому что все это блокирует поисковые системы от сканирования Вашего веб — сайта.

После удаления строк по умолчанию вы можете добавить свои собственные правила robots.txt. Мы рекомендуем использовать идеальный формат robots.txt, которым мы поделились выше.

Когда вы закончите, не забудьте нажать кнопку «Сохранить файл robots.txt», чтобы сохранить изменения.

Способ 2. Редактирование файла Robots.txt вручную с использованием FTP

Для этого метода вам понадобится FTP-клиент для редактирования файла robots.txt. Просто подключитесь к своей учетной записи хостинга WordPress с помощью FTP-клиента.

Оказавшись внутри, вы сможете увидеть файл robots.txt в корневой папке вашего сайта.

Если вы его не видите, скорее всего, у вас нет файла robots.txt. В этом случае вы можете просто создать его.

Robots.txt — это простой текстовый файл, который означает, что вы можете загрузить его на свой компьютер и отредактировать его с помощью любого текстового редактора, такого как Блокнот или TextEdit.

После сохранения изменений вы можете загрузить их обратно в корневую папку вашего сайта.

Как проверить ваш файл Robots.txt?

После того, как вы создали свой файл robots.txt, всегда полезно проверить его с помощью инструмента тестирования robots.txt.

Существует множество инструментов для тестирования robots.txt, но мы рекомендуем использовать один из них в консоли поиска Google .

Просто войдите в свою учетную запись консоли поиска Google, а затем переключитесь на старый веб-сайт консоли поиска Google.

Это приведет вас к старому интерфейсу консоли поиска Google. Отсюда вам нужно запустить средство тестирования robots.txt, расположенное в меню «Сканирование».

Инструмент автоматически загрузит файл robots.txt вашего веб-сайта и выделит ошибки и предупреждения, если они были найдены.

В заключение

Целью оптимизации файла robots.txt является предотвращение сканирования поисковыми системами страниц, которые не являются общедоступными. Например, страницы в папке wp-plugins или страницы в папке администратора WordPress.

Например, страницы в папке wp-plugins или страницы в папке администратора WordPress.

Распространенный миф среди SEO-экспертов заключается в том, что блокировка категорий, тегов и страниц WordPress повышает скорость сканирования и приводит к ускорению индексации и повышению рейтинга.

Это неправда. Это также противоречит правилам Google для веб-мастеров.

Мы рекомендуем вам следовать приведенному выше формату robots.txt, чтобы создать файл robots.txt для вашего сайта.

Мы надеемся, что эта статья помогла вам узнать, как оптимизировать файл WordPress robots.txt для SEO раскрутки сайта.

WordPress Robots txt — где разместить и как оптимизировать

Глубокое понимание WordPress robots.txt будет иметь большое значение для улучшения SEO вашего сайта. Из этого руководства вы узнаете, что такое robot.txt, и, самое главное, научитесь его использовать.

В основном, robot.txt создан для роботов, которые, например, представляют собой программное обеспечение , которое просматривает веб-страницы и индексирует их для результатов поиска .

Он позволяет владельцам веб-сайтов запрещать поисковым роботам сканировать определенные страницы или контент на своем веб-сайте. Неправильное использование robot.txt может испортить SEO вашего сайта.

Таким образом, его следует использовать с осторожностью. Но не волнуйтесь, все, что вам нужно узнать по этой теме, описано в этом руководстве.

Содержимое:

Что такое файл WordPress Robots.txt?

Обычно содержимое файла robots.txt выглядит следующим образом:

Пользовательский агент: *

Запретить: / wp-admin /

Разрешить: / wp-admin / admin-ajax.php

Disallow в этом случае сообщает поисковым роботам: «Эй, вам не разрешено сканировать папку wp-admin». И Позвольте, ну вы угадали.

Каждый день в Интернете публикуются тысячи новых веб-сайтов. Чтобы облегчить поиск этих веб-сайтов, Google и другие поисковые системы индексируют каждый веб-сайт.

Принимая во внимание огромный объем работы, Google полагается на своих поисковых ботов, чтобы выполнить свою работу быстро.

Когда поисковый робот приземляется на ваш сайт, он сначала изучает карту сайта в формате XML, чтобы узнать все содержащиеся в ней страницы.

Затем бот переходит к сканированию и индексированию не только страниц веб-сайта, но и его содержимого, включая папку JS и CSS. Если это веб-сайт WordPress, бот также просканирует папку wp-admin .

Вы точно не хотите, чтобы это произошло, и единственный способ остановить их — это дать им указание не делать этого в роботах .txt файл.

Хотя создание файла robots.txt не является обязательным, так как поисковые роботы все равно будут сканировать ваш веб-сайт, независимо от того, есть он у вас или нет, его наличие дает множество преимуществ.

Преимущества создания оптимизированного txt-файла роботов

Основная причина создания файла robots.txt — предотвратить сканирование роботами поисковых систем определенного содержания вашего веб-сайта.

Например, вы не хотите, чтобы пользователи имели доступ к теме и папке администратора, файлам плагинов и странице категорий вашего веб-сайта.

Кроме того, — оптимизированный файл robots.txt, помогающий сохранить так называемую квоту сканирования. Квота сканирования — это максимально допустимое количество страниц, которые поисковые роботы веб-сайта могут сканировать за раз.

Вы хотите, чтобы сканировались только полезные страницы, иначе ваша квота на сканирование будет потрачена впустую. Это значительно улучшит SEO вашего сайта.

В-третьих, файл robots.txt с хорошим сценарием может помочь вам минимизировать активность поисковых роботов, включая плохих ботов , вокруг вашего веб-сайта. Таким образом, скорость загрузки вашего сайта значительно улучшится.

Таким образом, скорость загрузки вашего сайта значительно улучшится.

Где находится файл Robots.txt?

По умолчанию файл robots.txt создается и сохраняется в корневом каталоге вашего веб-сайта всякий раз, когда вы устанавливаете веб-сайт WordPress. Чтобы просмотреть его, откройте свой веб-сайт в браузере и добавьте в конце «/robots.txt». Например:

https://mywebsite.com/robots.txt

Вот как выглядит наш в Fixrunner:

WordPress по умолчанию robots.txt является виртуальным, поэтому к нему нельзя получить доступ или отредактировать. Чтобы получить к нему доступ или отредактировать, вам нужно будет создать его — и есть много способов сделать это. Посмотрим на некоторые из них!

Как создать файл Robots.txt в WordPress

Создание файла robots.txt в WordPress — несложный процесс. Вы можете сделать это вручную или использовать плагины WordPress. Здесь мы увидим оба процесса, а плагин, который мы собираемся использовать, — это Yoast SEO.

Использование плагина Yoast SEO

ПлагинYoast SEO умеет создавать роботов.txt для WordPress на лету. Конечно, когда дело доходит до SEO для WordPress, он делает гораздо больше.

Прежде всего, установите и активируйте плагин, если у вас его еще нет.

После того, как Yoast будет запущен на своем веб-сайте, перейдите в SEO >> Инструменты

Затем щелкните ссылку Редактор файлов на панели инструментов Yoast.

Вы попадете на страницу, где можете создать файл robots.txt. Нажмите кнопку Create .

Вы попадете в редактор, где сможете добавлять и редактировать правила в файле robots.txt вашего WordPress.

Добавьте новые правила в редактор файлов и сохраните изменения. Не волнуйтесь, мы скоро покажем вам правила, которые нужно добавить.

Добавление Robots.txt вручную через FTP в WordPress Этот метод довольно прост, и его может сделать каждый. Для начала запустите Блокнот — или любой ваш любимый редактор, если это не текстовый процессор, как Microsoft Word — на вашем компьютере.

Для начала запустите Блокнот — или любой ваш любимый редактор, если это не текстовый процессор, как Microsoft Word — на вашем компьютере.

Для начала добавьте следующие правила в только что созданный файл.

Пользовательский агент: *

Запретить: / wp-admin /

Разрешить: /wp-admin/admin-ajax.php

Сохраните файл как robots.txt. Что вы хотите сделать дальше, так это загрузить его на свой веб-сайт через программу FTP, такую как FileZilla.

Прежде всего, установите соединение с вашим сайтом в FileZilla. Затем перейдите в папку public_html .В эту папку загрузите только что созданный файл robots.txt.

После завершения загрузки все готово.

Добавление правилПо сути, поисковым ботам можно дать всего две инструкции: Разрешить и Запретить. Allow предоставляет им доступ к папке, а Disallow делает наоборот.

Чтобы разрешить доступ к папке, добавьте:

Пользовательский агент: *

Разрешить: / wp-content / uploads /

Звездочка (*) сообщает поисковым роботам: «Эй, это правило применимо ко всем».

Чтобы заблокировать доступ к папке, используйте следующее правило

Запретить: / wp-content / plugins /

В этом случае мы запрещаем поисковым роботам доступ к папке плагинов.

Вам решать, какое правило наиболее применимо к вашему веб-сайту. Например, если у вас есть форум, вы можете решить заблокировать поисковые роботы на своей странице форума с помощью следующего правила:

Запретить: / forum /

Как показывает практика, чем меньше правил, тем лучше.Для выполнения работы достаточно следующего правила:

Пользовательский агент: *

Разрешить: / wp-content / uploads /

Запретить: / wp-content / plugins /

Запретить: / wp-admin /

Как проверить созданный файл Robots.

txt в консоли поиска Google

txt в консоли поиска GoogleТеперь, когда вы создали файл robots.txt в WordPress, вам нужно убедиться, что он работает должным образом. И нет лучшего способа сделать это, кроме использования robots.txt тестер.

Google Search Console имеет подходящий инструмент для этой цели. Итак, обо всем по порядку, войдите в свою учетную запись Google Console. Вы всегда можете создать учетную запись, если у вас ее нет.

В консоли поиска Google прокрутите вниз и нажмите Перейти к старой версии.

Как только вы перейдете в старую версию, перейдите к Crawl >> robots.txt tester.

В текстовом редакторе вставьте правила, которые вы добавили в robots.txt, наконец, нажмите Test.

Если это подтвердится, то все готово!

Заключение

Поисковые боты временами могут быть непослушными, и единственный способ проверить их действия на вашем веб-сайте — использовать robots.txt . Даже в этом случае некоторые боты по-прежнему будут полностью игнорировать любые изложенные вами правила — вам просто нужно с этим справиться.

Хотя это правда, что WordPress автоматически создает для вас файл robots.txt при установке, создание его для себя — хорошая идея. Хорошо оптимизированный файл robots.txt не позволит поисковым роботам нанести вред вашему сайту.

Если вы нашли эту статью полезной, поделитесь ею. Для получения дополнительных руководств по WordPress следите за нашим блогом WordPress.

Дополнительные ресурсы:

Прочитайте больше полезных статей:WordPress Robots.txt — Как создать и оптимизировать для SEO

Что такое robots.txt? Как создать файл robots.txt? Зачем нужно создавать файл robots.txt? Оптимизирует роботов сайта.txt поможет улучшить ваш поисковый рейтинг?

Мы расскажем обо всем этом и многом другом в этой подробной статье о robots.txt!

Вы когда-нибудь хотели запретить поисковым системам сканировать определенный файл? Хотите, чтобы поисковые системы не сканировали определенную папку на вашем веб-сайте?

Здесь на помощь приходит файл robots. txt. Это простой текстовый файл, который сообщает поисковым системам, где и где не сканировать при индексировании вашего веб-сайта.

txt. Это простой текстовый файл, который сообщает поисковым системам, где и где не сканировать при индексировании вашего веб-сайта.

Хорошая новость в том, что вам не нужен технический опыт, чтобы раскрыть всю мощь роботов.текст.

Robots.txt — это простой текстовый файл, создание которого занимает секунды. Это также один из самых простых файлов, которые можно испортить. Всего один неуместный символ, и вы испортили SEO всего своего сайта и не позволите поисковым системам получить доступ к вашему сайту.

При работе над поисковой оптимизацией веб-сайта важную роль играет файл robots.txt. Хотя он позволяет запретить поисковым системам доступ к различным файлам и папкам, часто это не лучший способ оптимизации вашего сайта.

В этой статье мы объясним, как использовать robots.txt при оптимизации вашего сайта. Мы также покажем вам, как его создать, и поделимся некоторыми плагинами, которые нам нравятся, которые могут сделать за вас тяжелую работу.

Что такое Robots.txt?

Robots.txt — это простой текстовый файл, который сообщает роботам поисковых систем, какие страницы вашего сайта сканировать. Он также сообщает роботам, какие страницы не сканировать.

Прежде чем мы углубимся в эту статью, важно понять, как работает поисковая система.

Поисковые системы выполняют три основные функции — сканирование, индексирование и ранжирование.

(Источник: Moz.com)

Поисковые системы начинают с отправки своих поисковых роботов, также называемых пауками или ботами, через Интернет. Эти боты представляют собой интеллектуальное программное обеспечение, которое перемещается по всей сети в поисках новых ссылок, страниц и веб-сайтов. Этот процесс сканирования сети называется сканирование .

Как только боты обнаруживают ваш веб-сайт, ваши страницы упорядочиваются в удобную структуру данных. Этот процесс называется индексация .

И, наконец, все сводится к рейтингу . Где поисковая система предоставляет своим пользователям самую лучшую и наиболее релевантную информацию на основе их поисковых запросов.

Где поисковая система предоставляет своим пользователям самую лучшую и наиболее релевантную информацию на основе их поисковых запросов.

Как выглядит Robots.txt?

Допустим, поисковая система собирается посетить ваш сайт. Прежде чем сканировать сайт, он сначала проверит robots.txt на предмет инструкций.

Например, предположим, что робот поисковой системы собирается просканировать наш сайт WPAstra и получить доступ к нашему файлу robots.txt, доступному по адресу https://wpastra.com/robots.txt.

Пока мы обсуждаем эту тему, вы можете получить доступ к файлу robots.txt для любого веб-сайта, введя «/robots.txt» после имени домена.

ОК. Возвращение на правильный путь.

Это типичный формат файла robots.txt.

И прежде чем вы подумаете, что это слишком технический вопрос, есть хорошая новость: это все, что касается файла robots.txt. Ну, почти.

Давайте разберем каждый элемент, упомянутый в файле.

Первый — User-agent: * .

Звездочка после User-agent указывает, что файл применяется ко всем роботам поисковых систем, которые посещают сайт.

У каждой поисковой системы есть собственный пользовательский агент, который просматривает Интернет. Например, Google использует Googlebot для индексации содержания вашего веб-сайта в поисковой системе Google.

Некоторые из других пользовательских агентов, используемых популярными поисковыми системами:

- Google: Googlebot

- Googlebot News: Googlebot-News

- Googlebot Изображения: Googlebot-Image

- Googlebot Video: Googlebot-Video

- Bing: Bingbot

- Yahoo: Slurp Bot

- Duck30Duckider:

- Duck30Duckider

- Яндекс: ЯндексБот

- Exalead: ExaBot

- Amazon’s Alexa: ia_archiver

Таких юзер-агентов сотни.

Вы можете установить собственные инструкции для каждого пользовательского агента. Например, если вы хотите установить конкретные инструкции для робота Googlebot, то первая строка вашего файла robots. txt будет иметь вид

txt будет иметь вид

Пользовательский агент: Googlebot

Вы назначаете директивы всем пользовательским агентам, используя звездочку (*) рядом с User-agent.

Допустим, вы хотите заблокировать сканирование вашего сайта всеми ботами, кроме робота Google. Ваш файл robots.txt будет иметь следующий вид:

Агент пользователя: *

Запретить: /

Пользовательский агент: Googlebot

Разрешить: / Косая черта (/) после Disallow указывает боту не индексировать никакие страницы на сайте.И хотя вы назначили директиву, которая будет применяться ко всем ботам поисковых систем, вы также явно разрешили роботу Googlebot индексировать ваш веб-сайт, добавив « Allow: / ».

Точно так же вы можете добавить директивы для любого количества пользовательских агентов.

Напомним, что вернемся к нашему примеру с Astra robots.txt, т. Е.

Агент пользователя: *

Запретить: / wp-admin /

Разрешить: /wp-admin/admin-ajax.php Для всех роботов поисковых систем задана директива: ничего не сканировать в папке « / wp-admin / », но следовать « admin-ajax».php ’в той же папке.

Просто, правда?

Что такое краулинговый бюджет?

Добавляя косую черту после Disallow , вы запрещаете роботу посещать какие-либо страницы сайта.

Итак, следующий очевидный вопрос: зачем кому-то мешать роботам сканировать и индексировать ваш сайт? В конце концов, когда вы работаете над поисковой оптимизацией сайта, вы хотите, чтобы поисковые системы сканировали ваш сайт, чтобы помочь вам в рейтинге.

Именно поэтому вам следует подумать об оптимизации ваших роботов.txt файл.

Есть идеи, сколько страниц у вас на сайте? От реальных страниц до тестовых страниц, страниц с дублированным контентом, страниц благодарности и т. Д. Мы полагаем, что много.

Когда бот сканирует ваш сайт, он просканирует каждую страницу. А если у вас несколько страниц, боту поисковой системы потребуется время, чтобы их просканировать.

А если у вас несколько страниц, боту поисковой системы потребуется время, чтобы их просканировать.

(Источник: Seo Hacker)

Знаете ли вы, что это может негативно повлиять на рейтинг вашего сайта?

И это связано с бюджетом сканирования бота поисковой системы .’

ОК. Что такое краулинговый бюджет?

Бюджет сканирования — это количество URL-адресов, которые поисковый бот может сканировать за сеанс. Каждому сайту будет выделен определенный бюджет сканирования. И вам нужно убедиться, что краулинговый бюджет расходуется наилучшим образом для вашего сайта.

Если на вашем веб-сайте несколько страниц, вам определенно нужно, чтобы бот сначала сканировал ваши самые ценные страницы. Таким образом, необходимо явно указать это в вашем файле robots.txt.

Ознакомьтесь с ресурсами, доступными в Google, чтобы узнать, что означает краулинговый бюджет для робота Googlebot.

Как создать файл Robots.txt в WordPress?

Теперь, когда мы рассмотрели, что такое файл robots.txt и насколько он важен, давайте создадим его в WordPress.

У вас есть два способа создать файл robots.txt в WordPress. Один использует плагин WordPress, а другой — вручную загружает файл в корневую папку вашего сайта.

Метод 1: Создание роботов.txt с использованием плагина Yoast SEO

Чтобы помочь вам оптимизировать свой сайт WordPress, вы можете использовать плагины SEO. Большинство этих плагинов имеют собственный генератор файлов robots.txt.

В этом разделе мы создадим его с помощью плагина Yoast SEO. Используя плагин, вы можете легко создать файл robots.txt из своей панели управления WordPress.

Шаг 1. Установите плагин

Зайдите в Плагины> Добавить новый . Затем найдите, установите и активируйте плагин Yoast SEO, если у вас его еще нет.

Шаг 2. Создайте файл robots.txt

После активации плагина перейдите в Yoast SEO> Инструменты и нажмите Редактор файлов .

Поскольку мы создаем файл впервые, нажмите Создать файл robots.txt .

Вы заметите файл, созданный с некоторыми директивами по умолчанию.

По умолчанию генератор файлов robots.txt Yoast SEO добавляет следующие директивы:

Агент пользователя: *

Запретить: / wp-admin /

Разрешить: / wp-admin / admin-ajax.php

При желании вы можете добавить другие директивы в robots.txt. Когда вы закончите, нажмите Сохранить изменения в robots.txt .

Вперед, введите свое доменное имя, а затем « /robots.txt ». Если вы обнаружите, что в браузере отображаются директивы по умолчанию, как показано на изображении ниже, вы успешно создали файл robots.txt.

Мы также рекомендуем добавить URL-адрес карты сайта в файл robots.txt.

Например, если URL карты сайта вашего веб-сайта https: // yourdomain.ru / sitemap.xml, а затем рассмотрите возможность включения файла Sitemap : https://yourdomain.com/sitemap.xml в файл robots.txt.

Другой пример: вы хотите создать директиву, запрещающую боту сканировать все изображения на вашем веб-сайте. Допустим, мы хотим ограничить это только роботом GoogleBot.

В таком случае наш robots.txt будет иметь следующий вид:

Пользовательский агент: Googlebot

Запретить: / uploads /

Пользовательский агент: *

Разрешить: / uploads /

И на всякий случай, если вам интересно, как узнать имя папки с изображениями, просто щелкните правой кнопкой мыши любое изображение на своем веб-сайте, выберите «Открыть в новой вкладке» и запишите URL-адрес в браузере.Вуаля!

Метод 2. Создание файла Robots.txt вручную с помощью FTP

Следующий метод — создать файл robots.txt на вашем локальном компьютере и загрузить его в корневую папку вашего сайта WordPress.

Вам также потребуется доступ к вашему хостингу WordPress с помощью FTP-клиента, такого как Filezilla. Учетные данные, необходимые для входа, будут доступны в панели управления хостингом, если у вас их еще нет.

Учетные данные, необходимые для входа, будут доступны в панели управления хостингом, если у вас их еще нет.

Помните, что файл robots.txt должен быть загружен в корневую папку вашего веб-сайта.То есть его не должно быть ни в каком подкаталоге.

Итак, после входа в систему с помощью FTP-клиента вы сможете увидеть, существует ли файл robots.txt в корневой папке вашего веб-сайта.

Если файл существует, просто щелкните файл правой кнопкой мыши и выберите параметр редактирования.

Внесите изменения и нажмите «Сохранить».

Если файл не существует, вам нужно его создать. Вы можете создать его с помощью простого текстового редактора, такого как Блокнот, и добавить директивы в файл.

Например, включите следующие директивы,

Агент пользователя: *

Запретить: / wp-admin /

Разрешить: /wp-admin/admin-ajax.php … и сохраните файл как robots.txt.

Теперь, используя свой FTP-клиент, нажмите « File Upload » и загрузите файл в корневую папку веб-сайта.