Алгоритмы поиска Google 2022 — хронология

Мы уже рассказывали о том, как работают фильтры «Яндекс» и фильтры Google. Но кроме фильтров, в ранжировании участвуют и алгоритмы поисковых систем. Сегодня рассмотрим основные алгоритмы, которые не дают сайтам подняться в выдаче: как они работают и что нужно сделать, чтобы улучшить позиции.

Читайте также:

Действующие фильтры Google: проявление, диагностика и устранение причин

Как работают алгоритмы Google

В отличие от фильтров, алгоритмы не исключают страницы из выдачи, а снижают их позицию. Например, если сначала страница была на 5 месте, то с выходом нового алгоритма она попадает на 25-30 место и дальше. Поисковая система начала выпускать обновления алгоритмов ранжирования в 2003 году. Тогда вышел «Бостон» — первое официальное изменение ранжирования сайтов. Позже часть алгоритмов была отменена, а некоторые работают и до сих пор.

Позже часть алгоритмов была отменена, а некоторые работают и до сих пор.

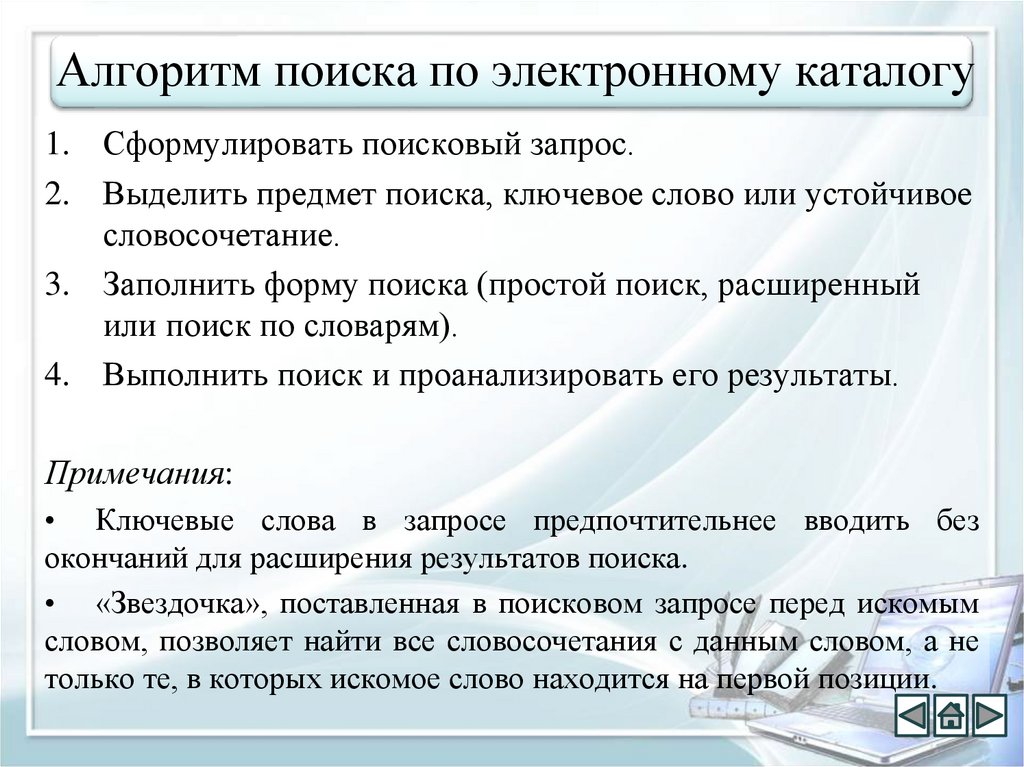

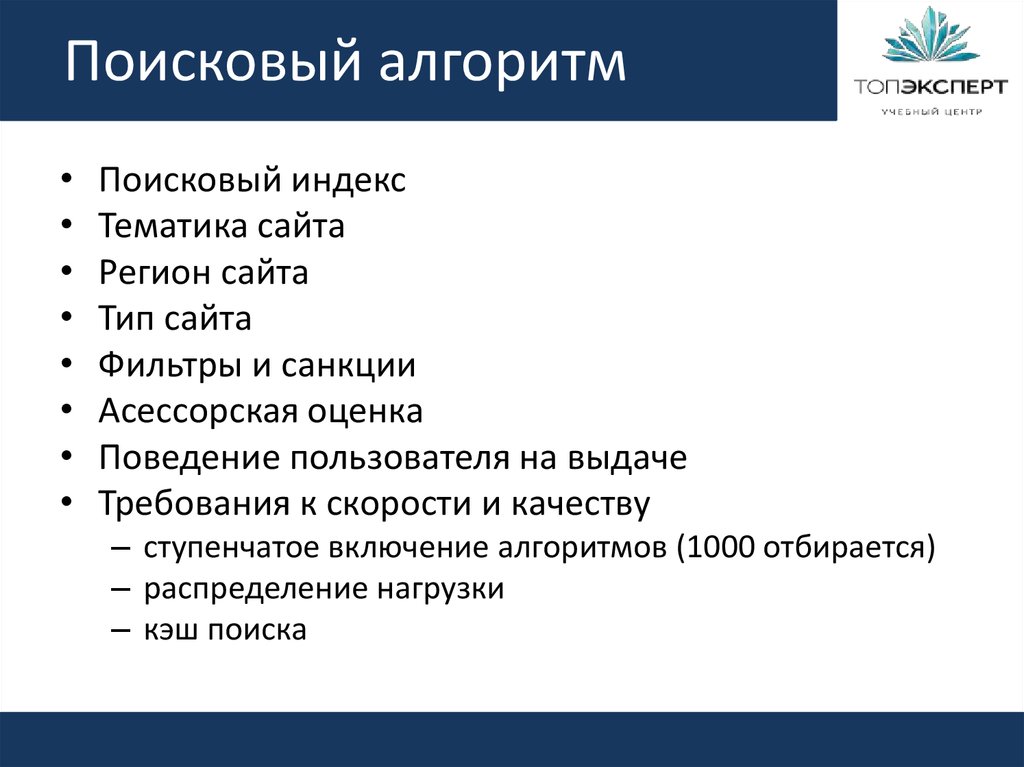

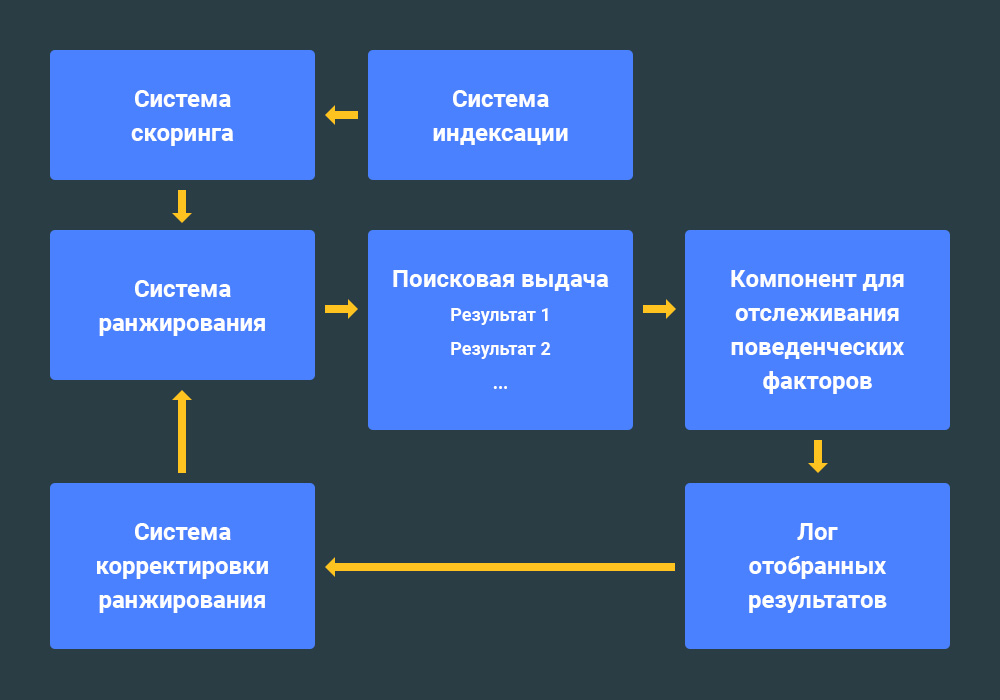

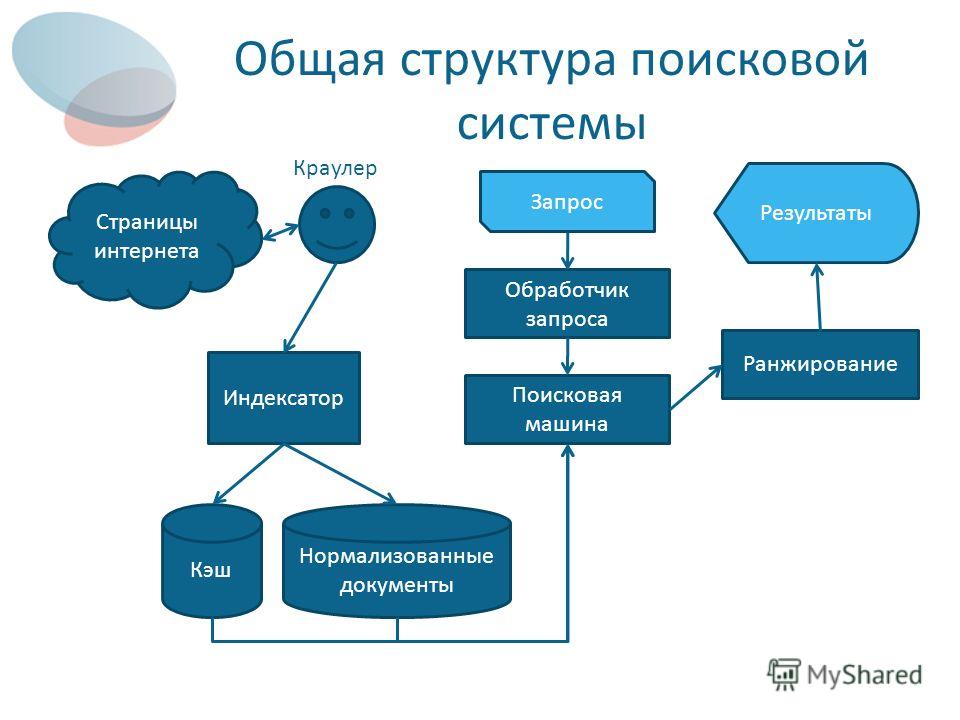

Принцип работы алгоритмов достаточно прост: сначала система сканирует и индексирует страницы, а затем отображает их в выдаче, учитывая персонализацию и релевантность. Поисковая система выделяет несколько ключевых факторов, от которых зависит результат поиска:

- анализ слов и выражений, проверка орфографии, подбор синонимов;

- подбор подходящих страниц с экспертным контентом;

- ранжирование релевантных страниц — от более качественных к менее качественным;

- показ наиболее подходящих результатов — формирование топа выдачи;

- персонализация — анализ геолокации, социальных факторов, предыдущих запросов.

Интересный факт. Система Google хранит данные об интересах пользователей. Она формирует список тем на основании запросов и их контекста. Проверить свой портрет можно в сервисе «Настройка рекламных предпочтений».

Система Google хранит данные об интересах пользователей. Она формирует список тем на основании запросов и их контекста. Проверить свой портрет можно в сервисе «Настройка рекламных предпочтений».

Какие алгоритмы использует Google в ранжировании сайтов

Рассмотрим существующие алгоритмы ранжирования — все они влияют на выдачу, делая ее персонализированной и полностью отвечающей запросам пользователей.

Алгоритм Google YMYL (Your money — your life, E-A-T)

- Год выпуска: 2018.

- Что отслеживает: размещение экспертных материалов.

Этот алгоритм ориентирован на сайты с информацией, которая может повлиять на физическое или финансовое благополучие. Это следующие тематики:

- медицина;

- юридические услуги;

- финансовые операции;

- покупки;

- официальные источники информации;

-

безопасность.

Контент, размещенный на таких сайтах, должен составляться на основании трех главных принципов: авторитетность, экспертность, добросовестность. Алгоритм направлен на устранение из выдачи тех сайтов, которые публикуют некачественную и недостоверную информацию, использование которой несет риски для жизни и благополучия. С его введением из индекса начали выпадать статьи с малополезными SEO-текстами, которые не проходят экспертизу перед публикацией.

Что такое SEO-статья и как правильно писать SEO-тексты

За что можно получить ограничения:

- отсутствие авторства статей;

- нет экспертности в контенте;

- неактуальное содержимое;

- отсутствие документов, подтверждающих экспертность — дипломов, сертификатов, лицензий;

-

недостаточно качественные страницы.

Асессоры — специально обученные люди, которые помогают нейросети определять сайты с экспертным контентом. Стоит заранее позаботиться о том, чтобы заранее предоставить информацию о подтверждении экспертности.

Как привести сайт в соответствие алгоритму YMYL:

| Нарушение | Проверка и устранение | Профилактика |

| Отсутствие авторства | Проверить все публикации на указание авторов статей, обозначить их экспертность, дать ссылки на их социальные сети | Сразу формировать карточки экспертов и использовать их при публикации материала |

| Неактуальное содержимое | Регулярно обновлять и дополнять статьи, если появилась новая информация по теме публикации | При создании контента проверять актуальность информации |

| Отсутствие подтверждающих документов | Пройти по карточкам экспертов, проверить блоки «О нас» на наличие сертификатов и разрешающих документов | Добавлять документы и лицензии при создании сайта |

Hummingbird (Колибри)

-

Год выпуска: 2013.

- Что отслеживает: соответствие ключевых фраз интенту пользователя.

«Колибри» — это часть алгоритма, которая помогает улучшить выдачу информативного контента. Она оценивает естественность вхождения ключевых фраз, находит перекосы по плотности текста, проверяет использование LSI (синонимов, подсветок и подсказок из выдачи). Если контент не соответствует теме, позиции сайта снизятся, а страницы могут получить пометку о малоценности.

Как привести сайт в соответствие алгоритму «Колибри»:

| Нарушение | Проверка и устранение | Профилактика |

| Неестественный текст, который трудно читается |

Проанализировать контент на естественность. При необходимости заменить на контент с естественностью более 80% При необходимости заменить на контент с естественностью более 80%

|

Проверять весь размещаемый контент на естественность. При сборе семантики использовать не только ключи, но и синонимы, подсветки, слова из правой колонки. |

Pigeon (Голубь)

- Год выпуска: 2014.

- Что отслеживает: оптимизация местного поиска.

Этот алгоритм помогает региональным сайтам быть выше в выдаче, чем не имеющим географической привязки. Один из первых фильтров, который улучшил показатели ресурсов в выдаче, а не пессимизировал их. Изначально он использовался только в пределах США, затем начал применяться в отношении всех англоязычных ресурсов. Сейчас применяется в отношении всех сайтов, где есть региональность.

Как использовать:

- заполнить карточку организации в Google Мой Бизнес;

- сделать региональные контакты на сайте: городской номер, почтовый адрес;

- использование локального контента — местное портфолио, отзывы;

-

использовать местные ссылки.

Читайте также:

Продвижение англоязычных сайтов

HTTPS

- Год выпуска: 2014.

- Что отслеживает: наличие SSL-сертификата на сайте.

В анонсе от 6 августа 2014 года представители Google официально объявили, что будут отдавать приоритет в выдаче тем сайтам, которые используют защищенное соединение. Это нужно не только ресурсам, которые собирают и передают личные данные — через формы обратной связи, телефоны и личный кабинет. Сайт, у которого нет SSL-сертификата, может получить отметку о том, что он может быть потенциально опасным, а это снизит количество переходов на ресурс.

Пример отметки о небезопасности сайта

Этот алгоритм не только искусственно снижает позиции сайта в выдаче — наличие окна из примера выше негативно влияет на поведенческие факторы. Пользователи просто закрывают вкладку и сразу возвращаются к поиску.

Пользователи просто закрывают вкладку и сразу возвращаются к поиску.

Как привести сайт в соответствие HTTPS:

| Нарушение | Проверка и устранение | Профилактика |

| Отсутствие SSL-сертификата | Проверить наличие через SSL-чекер | Подключать сертификат сразу, как только сайт выходит в индексацию |

Продвижение сайта в ТОП-10

- Оплата по дням нахождения в ТОП

- Подбираем запросы, которые приводят реальных покупателей!

Mobilegeddon (Mobile-Friendly)

-

Год выпуска: 2015.

- Что отслеживает: адаптивность мобильной версии сайта.

С распространением мобильных устройств Google начал понижать в выдаче те сайты, у которых нет адаптированной мобильной версии. Здесь владельцы часто пытаются сэкономить на адаптивности, потому что нужно оптимизировать контент, а потому запускают отдельную мобильную версию сайта.

Такой подход не приветствуется ПС: придется делать дубли контента, а еще эти два сайта будут ранжироваться как отдельные. Поэтому сейчас лучше сразу адаптировать контент и проверять его отображение на мобильных устройствах.

Как привести сайт в соответствие алгоритма «Mobilegeddon»:

| Нарушение | Проверка и устранение | Профилактика |

| Отсутствие адаптивной версии | Оценка отображения мобильной версии — либо через консоль браузера или через GSC | Сразу давать задание программисту на верстку адаптивной версии сайта |

Читайте также:

Мобильные версии сайтов 2022: интересные тенденции и неожиданные выводы

RankBrain

-

Год выпуска: 2015.

- Что отслеживает: соответствие контента запросу пользователя.

Этот алгоритм направлен на определение того, что имел в виду пользователь, если по запросу это не очевидно. Он оценивает качество контента на сайте и его соответствие. Под действием алгоритма сайт тоже теряет позиции в выдаче, а страницы могут быть отмечены как малоценные.

Как привести сайт в соответствие алгоритму «RankBrain»:

| Нарушение | Проверка и устранение | Профилактика |

| Недостаточная глубина раскрытия тем на сайте | Привлекать экспертов для проверки полноты и достоверности информации |

Привлекать экспертов к написанию статей до публикации. В текстах освещать темы наиболее полно и информативно В текстах освещать темы наиболее полно и информативно

|

BERT

- Год выпуска: 2019.

- Что отслеживает: естественный язык в контенте и работа с контекстом сайта.

Это усовершенствованный аналог Rank Brain. Алгоритм затронул порядка 10 % сайтов. Он учится понимать язык так, как его понимают люди.

Представители Google назвали это обновление одним из самых масштабных за 5 лет. С его помощью ПС учится более глубоко понимать контекст запроса и соответствие контента на сайте.

Possum/Hawk

- Год выпуска: 2016/2017.

- Что отслеживает: спам в локальной выдаче.

В 2016 году Google начал исключать спам в локальной выдаче: он убирал из выдачи клоны компаний, а также пессимизировал расположенные в одном месте идентичные бизнесы.

Но возникла проблема: из индекса начали вылетать сайты организаций, которые располагаются по одному адресу. Тогда представители ПС анонсировали дополнение — Hawk, оно смягчило действие «Опоссума». В выдачу вернулись сайты организаций, расположенных по одному адресу.

Как использовать:

- Максимально полно заполнить карточку организации в Google Мой Бизнес: адрес, телефоны, сайт, фотографии.

Строго говоря, это не нарушение, а просто часть алгоритма, которая помогает лучше ранжироваться по заданному региону.

Fred (Maccabees)

- Год выпуска: 2017.

- Что отслеживает: обилие рекламы, некачественные ссылки, аффилиат-сайты.

«Фред» — масштабное обновление алгоритма Google, которое затронуло сайты с большим количеством рекламы, аффилиат-сайты, а также ресурсы с обилием некачественных ссылок. В результате наложения снижаются позиции сразу всего сайта.

В результате наложения снижаются позиции сразу всего сайта.

Читайте также:

Внешняя оптимизация сайта: как продвигать сайт с помощью сторонних ресурсов

Как привести сайт в соответствие алгоритму «Fred»:

| Нарушение | Проверка и устранение | Профилактика |

| Много рекламы | Проверить наличие рекламных блоков | Уменьшить объемы и агрессивность рекламных объявлений |

| Аффилированность сайтов | Провести проверку на аффилированность и попробовать продавать партнерские товары у себя, без перенаправления на другие сайты | Заключить договор с партнерами и продавать их товары у себя |

| Много некачественных ссылок с сайта | Проверить ссылки через Screaming Frog и удалить ненужные | Не использовать больше 5 ссылок на странице |

Speed Update (Время загрузки)

-

Год выпуска: 2018.

- Что отслеживает: скорость загрузки страниц.

Оптимизированные страницы начинают получать более высокие позиции в выдаче, чем страницы с большим объемом контента на странице. Долгая скорость загрузки сказывается на поведенческих факторах, и сайт начинает проседать по качеству.

Как привести сайт в соответствие алгоритму «Speed Update»:

| Нарушение | Проверка и устранение | Профилактика |

| Долгая загрузка страниц |

С помощью инструмента Google Page Speed Insights проверить скорость загрузки и устранить основные причины: удалить неиспользуемые фрагменты кода, подключить использование кеша, оптимизировать изображения, etc.

|

Проверять скорость загрузки сразу |

Sandbox и DomainAge

Ограничение индексации для молодых доменов. Официально этот алгоритм не подтвержден представителями Google, но все же многие SEO-специалисты отмечали, что в первые полгода домен получает меньше трафика, чем дальше.

Бороться с «Песочницей» не стоит — лучше потратить это время на совершенствование контента, чтобы в дальнейшем получить более высокие позиции в выдаче.

Что проверить, чтобы не попасть под алгоритмы Google

- Экспертность контента: наличие авторства, ссылок на соцсети авторов.

- Актуальность текущей семантики.

- Наличие слов из правой колонки и синонимов в семантике.

-

Региональность сайта — если продвигаетесь не в рамках всей страны.

- Наличие SSL-сертификата.

- Адаптивность мобильной версии.

- Полное заполнение карточки организации в Google Мой бизнес.

- Наличие и объем рекламных блоков на сайте.

- Аффилированность сайта.

- Качество ссылок на внешние ресурсы.

- Скорость загрузки страницы.

- Возраст домена.

Присоединяйтесь к нашему Telegram-каналу!

- Теперь Вы можете читать последние новости из мира интернет-маркетинга в мессенджере Telegram на своём мобильном телефоне.

- Для этого вам необходимо подписаться на наш канал.

Что такое поисковая система — определение, принцип работы алгоритмов Яндекс и Google

В статье разберем особенности процесса: как работает поисковая система, на каких принципах работы держатся алгоритмы ранжирования поисковика, как устроена выдача Яндекс и Google и для чего нужны все эти возможности в интернете.

- Общие принципы обработки информации

- Spider

- Crawler

- Indexer

- Database

- Search Engine Results Engine

- Web server

- Принципы работы поисковой системы

- Сбор данных

- Индексация

- Обработка информации

- Ранжирование

- Основные характеристики поисковых систем

- Полнота

- Точность

- Актуальность

- Скорость поиска

- Наглядность

- Принцип работы поисковых систем

- Яндекс

- Заключение

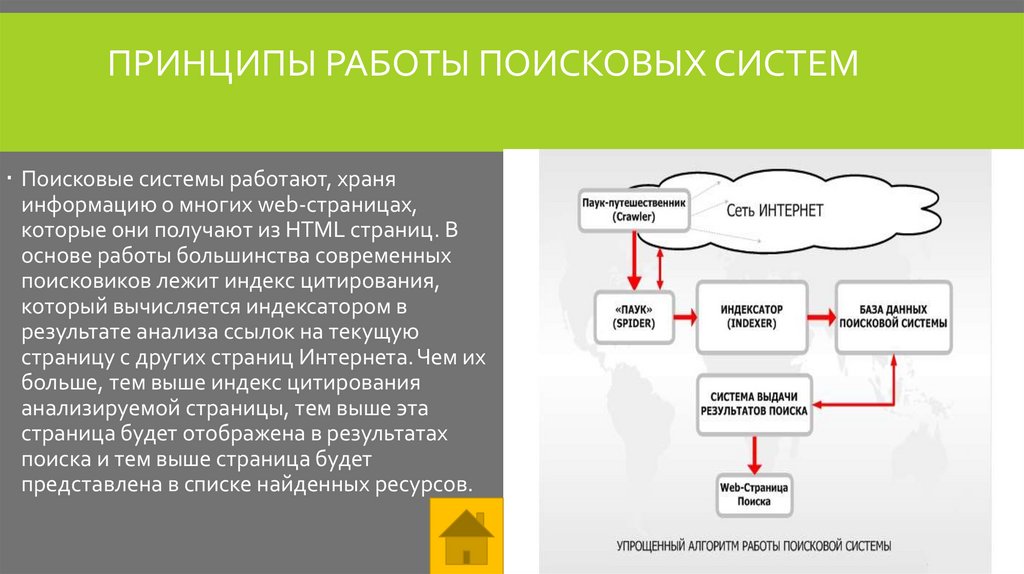

Общие принципы обработки информации

Несмотря на кажущуюся простоту – «запрос-ответ», для формирования топа и его релевантности любой сервис производит сложный процесс взаимодействия различных составляющих.

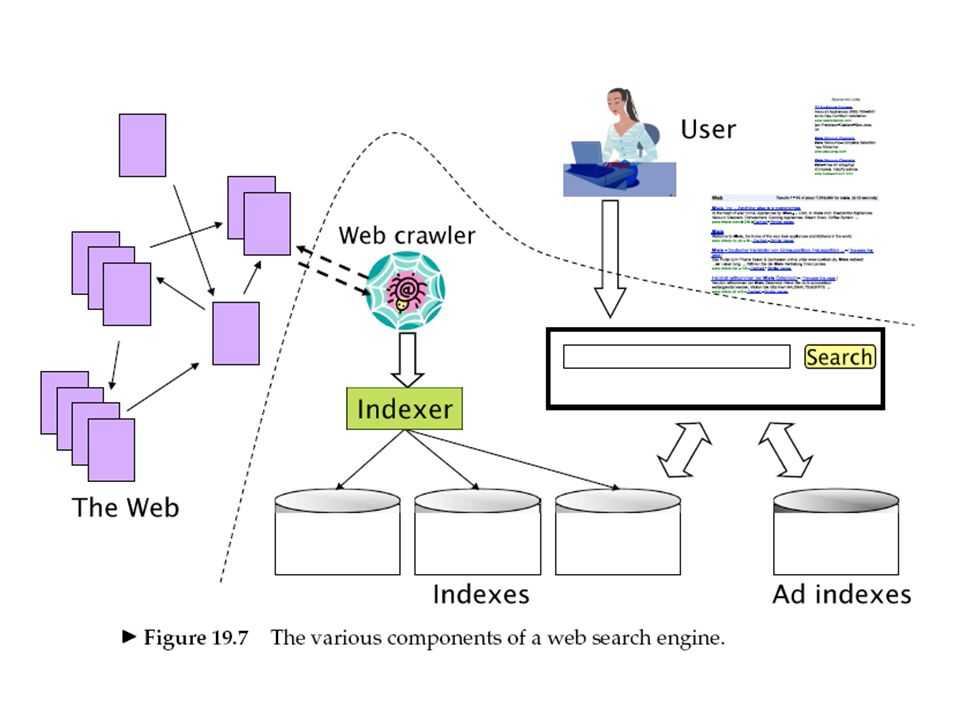

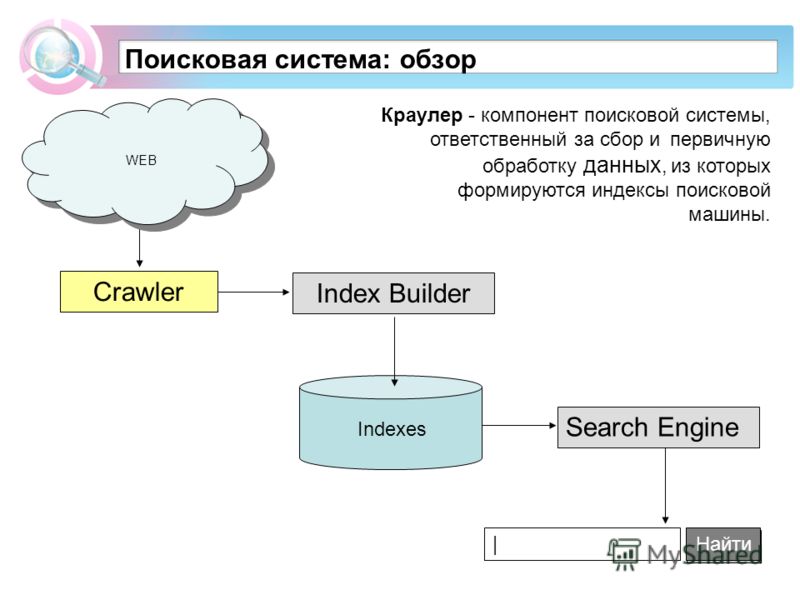

Spider

Он же «паук», который просматривает домены и дублирует содержимое на выделенные сервера, то есть «обходит паутину» для дальнейшего анализа вспомогательными программами. Он работает только с исходным кодом ресурса и документами формата html.

Crawler

Проверяет все ссылки на сайте, что дает возможность составить древо, и находит точные адреса, которые будут отображаться в поисковой выдаче. Важно учитывать, что битые ссылки сильно осложняют работу программы и впустую расходуют краулинговый бюджет.

Indexer

Алгоритм, который суммирует информацию от двух предыдущих и делит проиндексированные страницы по html-тегам, тем самым создавая список данных.

Database

На основе индексации разделяет полученные данные на две самостоятельные базы:

- Сведения, благодаря которым формируется рейтинг и определяется лист ключевиков, на которые поисковик будет выдавать ссылки.

- Древо со всей метаинформацией. Оно будет применяться для последующих индексаций.

Для того чтобы заново не проходить предыдущие этапы выполняется только сверка структуры, что дает возможность понять, происходили ли какие-либо правки на ресурсе.

Для того чтобы заново не проходить предыдущие этапы выполняется только сверка структуры, что дает возможность понять, происходили ли какие-либо правки на ресурсе.

Search Engine Results Engine

Программа, определяющая финальное ранжирование и релевантность выдачи при получении определенного запроса. Она определяет, какие из них будут показаны и в топ-10, и в топ-100.

Web server

Сервер, на котором располагается сайт поисковика. Непосредственно с ним взаимодействует пользователь, вводя свой вопрос и получая информацию.

Коммерческий трафик

от 35 600 ₽ Страница услуги

Продвижение по коммерческому трафику от студии SEMANTICA – привлечение целевых пользователей из систем Яндекс и Google. Мы работаем над внутренними и внешними факторами ранжирования и видимостью сайта в поисковиках. Вы получаете рост посещаемости и высокий охват среди своих потенциальных клиентов.

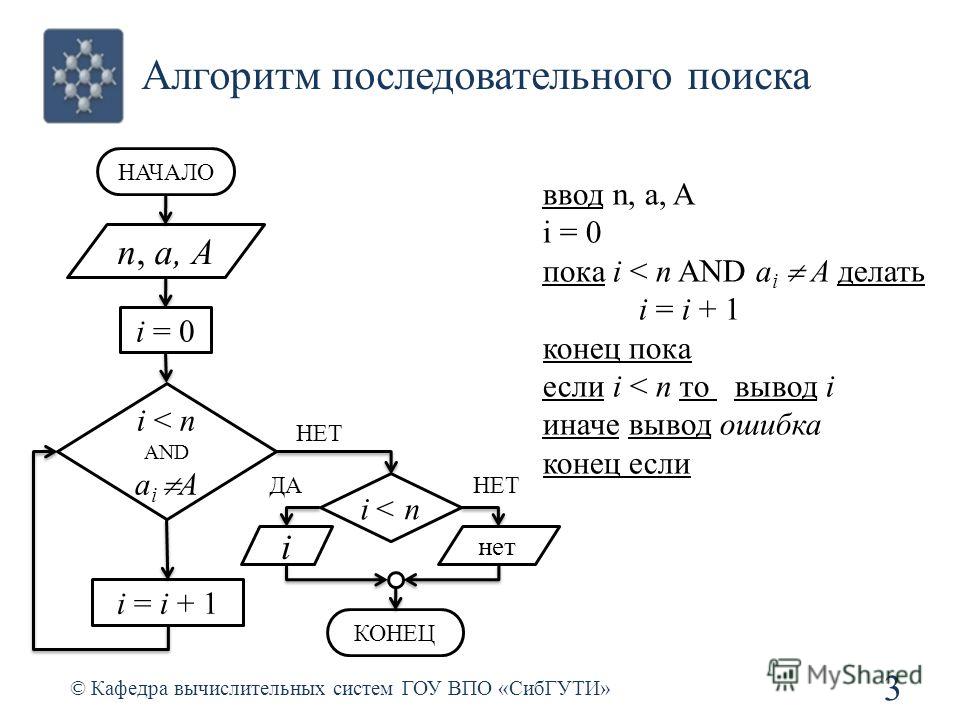

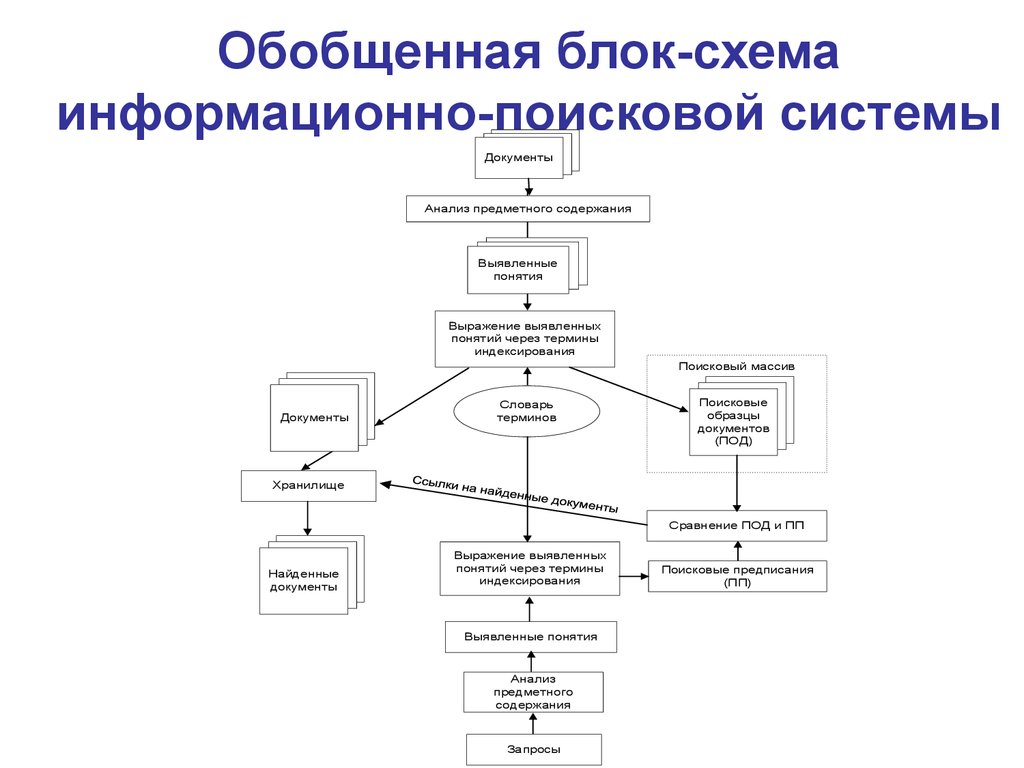

Принципы работы поисковой системы

Основными этапами формирования базы данных являются индексация и ранжирование. Чтобы человек получал максимально точный ответ на свой вопрос, алгоритмы Яндекса и Гугла сегодня активно используют методы машинного обучения. Благодаря способам противопоставления двух различных результатов и настройке схемы обработки, робот понимает, какая страница будет наиболее полезной. Это делает возможным вывод релевантности или рейтинга, который есть у каждого сайта после обхода поисковиком. Чем этот показатель выше, тем выше позиция ресурса в выдаче. Этот процесс также делится на несколько подпроцессов.

Чтобы человек получал максимально точный ответ на свой вопрос, алгоритмы Яндекса и Гугла сегодня активно используют методы машинного обучения. Благодаря способам противопоставления двух различных результатов и настройке схемы обработки, робот понимает, какая страница будет наиболее полезной. Это делает возможным вывод релевантности или рейтинга, который есть у каждого сайта после обхода поисковиком. Чем этот показатель выше, тем выше позиция ресурса в выдаче. Этот процесс также делится на несколько подпроцессов.

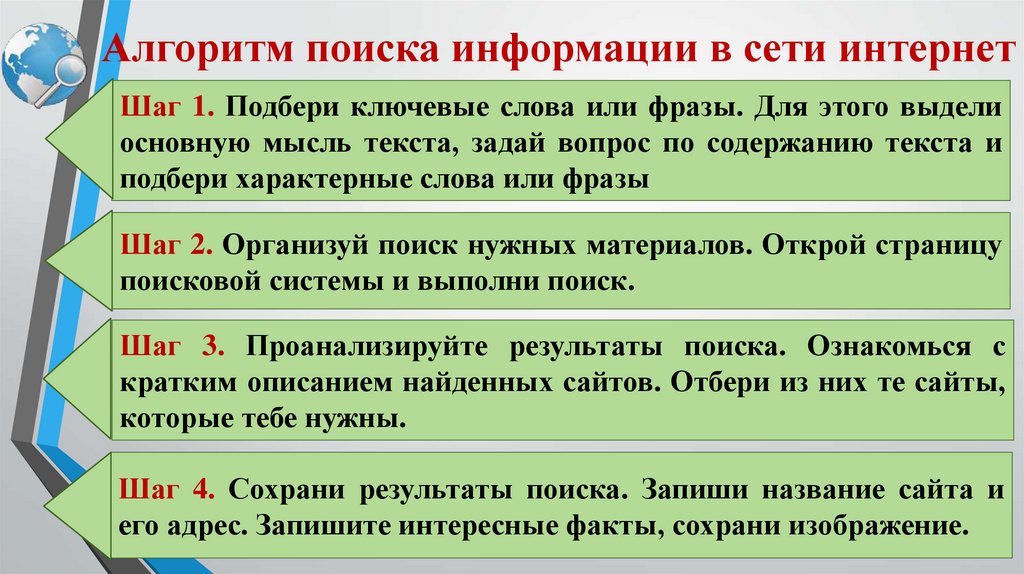

Сбор данных

Как только появляется необходимость обхода, начинается автоматический анализ с использованием программ Spider и Crawler, которые собирают сведения и систематизируют их.

Индексация

Производится регулярно с определенными интервалами. После нее ресурс попадает в базу поисковика. По окончании этого действия формируется файл индекса, который в дальнейшем применяется для оперативного нахождения конкретного материала на странице.

Обработка информации

При поступлении запроса от пользователя производится его анализ и выделение ключевых слов, поиск которых проходит по файлам индекса. На основе этого определяются все результаты, похожие на изначальный.

На основе этого определяются все результаты, похожие на изначальный.

Ранжирование

Из полученных результатов формируется список от наибольшего к наименьшему совпадению. Также на этом этапе происходит вычисление релевантности для отображения.

В зависимости от используемой ПС, принцип отбора может варьироваться, но основные факторы таковы:

- соответствие текста интенту;

- оптимизация;

- авторитетность домена;

- цитируемость;

- похожий контент.

Что такое DDoS атака и как от нее защититься?

Что называется DDoS-атакой ДДоС атака — это вид киберпреступления, при котором на сайт поступает колоссальное количество трафика, нарушающее его работу и ограничивающее доступ к нему обычным пользователям. О них впервые заговорили в 1999 году, когда сайты крупных западных компаний подверглись массовым нападениям. Одна из самых известных и масштабных произошла в 2020 году и нацелена была на Amazon Web Services (AWS). Пиковый объем трафика составил 2,3 Тбит/с, несмотря на то, что DDoS атака на сайт была смягчена AWS Shield — сервисом…

Пиковый объем трафика составил 2,3 Тбит/с, несмотря на то, что DDoS атака на сайт была смягчена AWS Shield — сервисом…

Основные характеристики поисковых систем

С точки зрения рядового пользователя самая важная функция – получить ответ на вопрос. Но на самом деле у поисковика есть и другие важные критерии оценки контента.

Полнота

Условное соотношение числа ресурсов с прямым ответом на изначальный запрос от общего их количества в выдаче. Чем выше этот показатель, тем полнее анализ сервисом своих баз данных.

Точность

Более конкретный показатель, который дает возможность показывать в топе не просто ресурсы с прямым вхождением ключа, но и понимание, что именно хочет увидеть пользователь. Так, например, вводя «купить машину», человек не хочет увидеть сайты, где автолюбители делятся впечатлениями от совершенных сделок. Ему интересны страницы салонов, который занимаются продажей авто.

Актуальность

Как видно из названия, определяется тем, насколько актуальными будут полученные сведения, то есть сколько времени прошло с их размещения. Для большинства ПС этот период может составлять до трех месяцев, а для релевантных доменов два-три дня.

Для большинства ПС этот период может составлять до трех месяцев, а для релевантных доменов два-три дня.

Скорость поиска

Формируется из временного показателя, который требуется сервису для формирования списка поисковой выдачи, после получения запроса. Он напрямую зависит от вычислительных мощностей оборудования, которое используется для обработки данных, но также может меняться исходя из общего объема получаемой информации. Из-за чего его часто называют «стрессоустойчивость» или «готовность к нагрузкам». Для больших поисковиков скорость обработки может достигать ста миллионов в секунду.

Наглядность

Клиентская оценка, которая формируется на основании того, насколько точные сведения попадают в топ 10. Так как не увидев прямого ответа на первой странице, как правило, принимается решение воспользоваться другим сервисом.

Продвижение блога

от 46 200 ₽ Страница услуги

Продвижение блога от студии SEMANTICA — увеличение потока пользователей на сайт и повышение экспертности бренда в глазах целевой аудитории. Мы создаем востребованный контент, отвечающий на запросы потенциальных клиентов, оптимизируем статьи и настраиваем коммерческие триггеры. Вы получаете ощутимый прирост переходов в каталог товаров и услуг из блогового раздела.

Мы создаем востребованный контент, отвечающий на запросы потенциальных клиентов, оптимизируем статьи и настраиваем коммерческие триггеры. Вы получаете ощутимый прирост переходов в каталог товаров и услуг из блогового раздела.

Принцип работы поисковых систем

Самыми популярными для продвижения в Российском сегменте являются Гугл и Yandex. Далее разберемся, что учитывается при ранжировании в этих ПС.

Данные получаются из различных типов контента, например, тексты статей, музыка, видео, карты и справочники.

В этом процессе можно выделить три основных этапа:

- Сканирование. Роботы производят сбор сведений со страниц и файлов. За каждый тип информации отвечает отдельный бот. Для сканирования применяется Googlebot, для ранжирования PageRank, мобильная версия проверяется Mobile, а Image предназначен для поиска изображений. Также в процессе определяются дубли. Для упрощения работы краулерам, необходимо, чтобы у ресурса была карта-сайта (Sitemap).

- Индексирование. После сбора происходит обработка полученных данных.

- Показ результатов в ответ на запрос.

Помимо перечисленного, на место домена в SERP влияет еще и следующие факторы:

- E-A-T;

Введен, дабы избежать распространения фейков из источников, на первый взгляд, кажущихся авторитетными. Применяется к статьям на медицинские и научные тематики, которые могут напрямую повлиять на жизнь и здоровье людей. Теперь весь контент, претендующий на звание экспертного, обязан соответствовать трем основным требованиям: компетентность, авторитет, достоверность. Это значит, что такого рода информация должна быть написана от лица специалистов в области, имеющих официальное подтверждение в виде дипломов и сертификатов.

- опыт пользователя;

Результат взаимодействия человека с сайтом. Складывается из удобного дизайна, времени ожидания, адаптивности под различные виды устройств.

- Mobile-Friendly;

Сюда относятся такие показатели как: ширина контента на экране смартфона, размер шрифта и расположение интерактивных элементов.

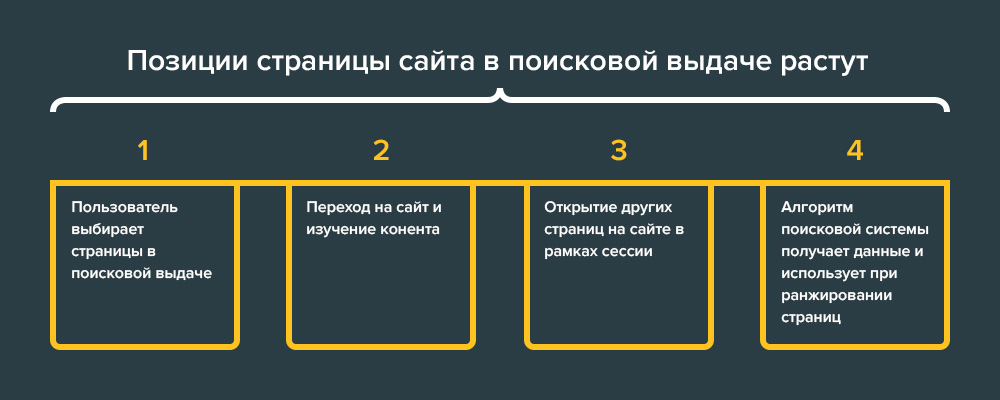

- ПФ;

Поведенческие факторы – это взаимосвязь действий пользователя с характеристиками сайта. Сюда относятся взаимодействия со страницей, отказы, глубина просмотра.

- скорость загрузки.

Сейчас один из главных показателей у Гугла, определяющий качество ресурса. Оптимальное время должно составлять не более 2-х секунд, вне зависимости от устройства. Недавно сюда добавился такой пункт как Core Web Vitals. CWV демонстрирует, насколько в целом домен оптимизирован для взаимодействия, а не только как быстро он открывается.

Яндекс

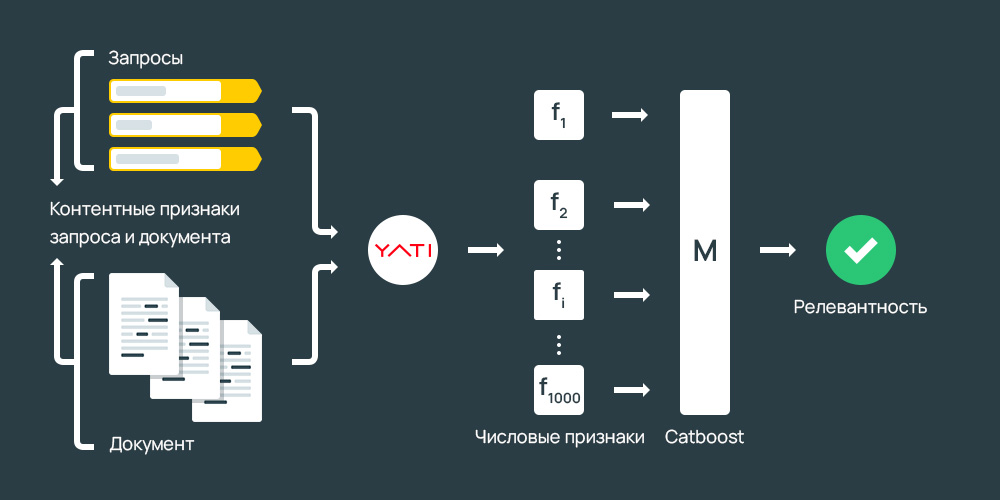

За релевантную выдачу здесь отвечает алгоритм YATI. Он достаточно молодой, так как был запущен только в 2020 году. Принцип его работы базируется на машинном обучении, а основной его задачей было улучшение ответов и голосового поиска.

С ним пришли и новые требования к ресурсам, желающих занять свое место в SERP:

- Больше внимания рекомендуется удалить «длиннохвостым» и низкочастотным запросам, а также использованию синонимов.

Это поможет давать более точные ответы на поставленные вопросы.

Это поможет давать более точные ответы на поставленные вопросы. - Высокое качество контента. Малоинформативные и мусорные страницы будут удаляться.

- Представление материалов в формате лонгридов.

- Естественность ПФ. Yandex блокирует домены, замеченные в накрутке поведенческих факторов. Чтобы в этому не прибегать, найдите, чем заинтересовать свою целевую аудиторию.

Доступность сайта: что такое и как проверить

В этой статье расскажем, как проверить доступность сайта и на что обратить внимание. Почему важно отслеживать изменения и доступность сайтов Отслеживание работы сайта — такой же важный аспект в продвижении, как и его оптимизация. Если ваш сайт долго загружается, при подключении возникает ошибка безопасности или домен сайта становится недоступен, онлайн-продаж и заявок с сайта ждать не стоит. Когда сайт недоступен для пользователей, он недоступен и для поисковых ботов. Боты не проиндексируют сайт, если сервер недоступен или срок действия домена или…

Заключение

Сегодня мы получили определение, что такое алгоритмы поисковых систем, какое они имеют значение и зачем нужно применяться различные способы оптимизации для попадания в ТОП.

Что вам нужно знать

Алгоритмы поисковых систем меняются почти постоянно. Но ваши планы цифрового маркетинга не должны этого делать.Здесь вы найдете:

- Как работают алгоритмы поисковых систем

- Почему обновления почти невозможно предсказать

- Способы подготовки к изменениям алгоритмов поисковых систем

- Почему контент-маркетинг по-прежнему безраздельно

В Алгоритм поисковой системы похож на ракетостроение: мы знаем, что он важен, но большинство из нас точно не знают, как он работает.

Каждый год Google выпускает множество обновлений (часто практически без предупреждения), которым удается изменить игровое поле для маркетологов в больших и малых направлениях.

Но даже профессионалам, годами работающим в платном поиске, разобраться в алгоритме поисковой системы может быть непросто. Знание основ позволяет быстро реагировать на новые изменения или заранее подготовить к ним свою кампанию.

Когда вы поймете, как эти алгоритмы могут повлиять на вашу маркетинговую тактику, вы сможете предпринять шаги, чтобы они не сорвали ваши планы.

Что такое алгоритм поисковой системы?Алгоритм поисковой системы представляет собой набор формул, определяющих качество и релевантность конкретного объявления или веб-страницы запросу пользователя.

Сообщается, что Google меняет свой алгоритм сотни раз в год . Хорошие новости: только серьезные изменения (или обновления) могут существенно повлиять на кампании SEM.

Одна из самых больших ошибок маркетологов заключается в том, что они сосредотачивают все свои усилия на лихорадочной адаптации кампании к этим формулам вместо того, чтобы смотреть на картину в целом.

Google использует более 200 факторов ранжирования, определяя, какие результаты показывать и в каком порядке. (Изображение: Unsplash)

Как работают алгоритмы поисковых систем? Поисковые системы делают пользовательский опыт главным приоритетом. Google удалось стать самой популярной поисковой системой на планете за счет создания сложных алгоритмов, которые улучшают процесс поиска, используя изощренные тактики, которые предоставляют пользователям информацию, которую они ищут.

Google удалось стать самой популярной поисковой системой на планете за счет создания сложных алгоритмов, которые улучшают процесс поиска, используя изощренные тактики, которые предоставляют пользователям информацию, которую они ищут.

Алгоритм работает со всеми видами деталей для контекста, от очевидных подсказок, таких как воспринимаемое качество контента, до истории спама владельца веб-сайта.

Всего Google использует более 200 факторов ранжирования при определении того, какие результаты показывать и в каком порядке.

Однако независимо от того, насколько хорошо вы к ним приспосабливаетесь, каждое новое обновление способно подтолкнуть вас к цели. Хотя обновления могут быть в основном сосредоточены на органическом поиске, они могут иметь не столь очевидные (но очень болезненные) последствия для платного поиска.

Например, ваши объявления могут перестать появляться в ответ на большую часть запросов вашей целевой аудитории просто потому, что целевая страница, на которую они ведут, недостаточно конкретна.

Не все обновления одинаковы.

Практически невозможно отслеживать все обновления, которые предлагает Google, и при этом иметь время, чтобы сосредоточиться на своей маркетинговой стратегии.

- Крупные обновления : Эти обновления выпускаются нечасто и часто решают определенную проблему с алгоритмом поиска. Например, недавнее обновление Core Web Vitals решает проблемы, связанные с взаимодействием пользователей с веб-страницами. Поисковые системы обычно выпускают их один или два раза в год.

- Общие обновления: Обновления в этой категории ориентированы на страницы низкого качества. Обычно они регулируют важность нескольких факторов ранжирования. Например, они могут решить, что скорость загрузки страницы теперь важнее, чем общее количество обратных ссылок. Эти обновления обычно происходят раз в 4-5 месяцев.

- Небольшое обновление s: эти обновления обычно не вносят значительных видимых изменений в производительность и аналитику вашего сайта.

Часто это незначительные изменения, которые улучшают работу поисковика и не влияют на рейтинг высококачественных веб-сайтов. Незначительные обновления могут быть реализованы ежедневно или еженедельно.

Часто это незначительные изменения, которые улучшают работу поисковика и не влияют на рейтинг высококачественных веб-сайтов. Незначительные обновления могут быть реализованы ежедневно или еженедельно.

В основном, крупные и масштабные обновления заслуживают внимания. Однако лишь немногие из них достаточно сильны, чтобы оказать существенное влияние на ваш рейтинг.

Обновление BERTВ 2019 году Google выпустила крупное обновление алгоритма, получившее название BERT . Цель этого обновления заключалась в том, чтобы улучшить перевод поисковой системой запросов на естественном разговорном языке, чтобы улучшить понимание контекста.

Это заставило маркетологов уделять больше внимания намерениям пользователей, чем раньше. До BERT, если вам нужно было сосредоточиться на отдельных ключевых словах в поисковой фразе, полные фразы стали гораздо важнее после обновления.

Например, запрос «приготовление овощей самостоятельно» не должен просто давать список советов по приготовлению овощей. В нем также должны быть даны советы по приготовлению овощей, которые вы вырастили и собрали самостоятельно. В свою очередь, платная реклама должна была стать гораздо более конкретной, ориентированной на намерения аудитории, чтобы оставаться релевантной поисковым запросам.

В нем также должны быть даны советы по приготовлению овощей, которые вы вырастили и собрали самостоятельно. В свою очередь, платная реклама должна была стать гораздо более конкретной, ориентированной на намерения аудитории, чтобы оставаться релевантной поисковым запросам.

С каждым новым обновлением Google алгоритмы поисковых систем работают над тем, чтобы стать более полезными для пользователя. К сожалению для цифровых маркетологов, предсказать конкретные изменения практически невозможно.

Понимая общее намерение улучшить опыт поисковика, можно скорректировать свою стратегию SEM, чтобы она не страдала при вступлении в силу новых обновлений.

Обновление MUMВ мае 2021 года Google анонсировала обновление многозадачной унифицированной модели или MUM. Этот ИИ предназначен для анализа контента так же, как это делает человек. Google называет MUM мощной эволюцией алгоритма BERT.

Цель MUM — обрабатывать сложные поисковые запросы, которые не могут быть удовлетворены коротким фрагментом. Чтобы получить ответы на эти типы запросов, пользователю необходимо выполнить в среднем восемь поисковых запросов.

Чтобы получить ответы на эти типы запросов, пользователю необходимо выполнить в среднем восемь поисковых запросов.

Чтобы решить эту проблему, MUM работает, чтобы прогнозировать эти поиски и предоставлять ответы на первой странице результатов поисковой системы (SERP).

При корректировке стратегии SEM для MUM целесообразно сосредоточиться на:

- Высококачественной системе внутренних ссылок

- Использование структурированных данных

- Работа над прогнозированием сложных запросов на пути покупателя, чтобы вы могли дать ответы

- Создание многоуровневого контента и его разделение на фрагменты, удобные для фрагментов

Совет от профессионалов: Если вы сосредоточены на пользовательском опыте (как и должно быть), то эти обновления не должны иметь серьезного негативного влияния. Однако, если вы видите, что ваш рейтинг падает, вот как справиться с .

Алгоритмы поисковых систем представляют собой сложную систему, помогающую пользователям находить наилучшие ответы на свои запросы. (Изображение: Unsplash)

Как предотвратить негативные последствия обновлений алгоритмовОбновления поисковых систем могут быть такими же непредсказуемыми, как и погода. Единственное, что вы можете знать наверняка, это то, что они произойдёт .

Когда это происходит, рейтинг многих веб-сайтов и объявлений может снижаться, даже если это изменение носит временный характер. К счастью, есть способы оставаться готовыми, когда появляются обновления.

1. Сосредоточьтесь на качестве целевой страницыДаже когда выходят обновления, трудно сразу понять, как они повлияют на связь между платным и обычным поиском.

Но всегда ясно одно: высококачественный контент на целевых страницах, скорее всего, положительно повлияет на коэффициент конверсии, независимо от изменений алгоритма.

Всего несколько лет назад целевые страницы не были так важны для платного поиска, потому что они не играли большой роли в процессе кликов по объявлениям. Сегодня, когда Google уделяет особое внимание релевантности и точности поиска, качество целевой страницы является неотъемлемым фактором, особенно при определении таких вещей, как ваш показатель качества .

Сегодня, когда Google уделяет особое внимание релевантности и точности поиска, качество целевой страницы является неотъемлемым фактором, особенно при определении таких вещей, как ваш показатель качества .

Поисковые системы уделяют пристальное внимание качеству целевой страницы и релевантности ключевых слов, и вряд ли это изменится. Теперь Google даже отслеживает, как часто пользователь возвращается на страницу поиска после посещения целевой страницы, пытаясь понять, удовлетворен ли он результатом поиска.

Чтобы быть в курсе обновлений, крайне важно поддерживать качество и актуальность как целевых, так и связанных страниц.

2. Не полагайтесь исключительно на ключевые слова Общая тенденция обновлений алгоритма Google заключается в том, чтобы перейти от чрезмерного внимания к ключевым словам к более длинным фразам и нюансам. Конечно, ключевые слова по-прежнему являются неотъемлемой частью SEM. Но построение вашей стратегии исключительно вокруг них может помешать вам увидеть общую картину или создать всестороннюю программу.

Вместо того, чтобы сосредоточиться только на ключевом слове, вы также должны учитывать намерение и релевантность. Посмотрите, как вы можете лучше всего ответить на вопросы, которые задает ваша аудитория. Обращая внимание на то, когда, как и о чем они спрашивают, вы сможете разработать релевантную рекламу и контент целевой страницы, удовлетворяя меняющиеся алгоритмы поисковых систем.

Это может помочь сосредоточиться на пути покупателя, а не только на отдельных ключевых словах, которые пользователи вводят при запуске поиска.

Например, у Google другое представление о релевантности при внедрении MUM. Теперь он оценивает, как ваш контент или целевая страница вписывается в контекст темы. Это включает в себя соответствующие обратные ссылки, внутренние ссылки для кластеров контента и правильную разметку Schema.

3. Ищите предупреждения об обновлениях В некоторых случаях поисковые системы будут предлагать предварительное уведомление о предстоящем обновлении алгоритма. Еще в апреле 2020 года Google объявил об изменении алгоритма 2021 года, в соответствии с которым Core Web Vitals будет использоваться в качестве факторов ранжирования.

Еще в апреле 2020 года Google объявил об изменении алгоритма 2021 года, в соответствии с которым Core Web Vitals будет использоваться в качестве факторов ранжирования.

Это дало маркетологам больше года, чтобы ознакомиться с этими новыми факторами и внести соответствующие коррективы. Поскольку Google не всегда сообщает подробности об обновлениях, разумно обратить внимание, когда они появятся.

4. Сохраняйте спокойствие и корректируйте свой контентКогда поисковые системы меняют свои алгоритмы, это может вызвать хаос у маркетологов. Корректировать стратегии и вносить быстрые изменения, чтобы обуздать значительные изменения рейтинга или нерегулярные отчеты, часто бывает безумием. Но иногда эти действия могут еще больше навредить вашей кампании.

Помните, что все, что вы можете сделать, это внести соответствующие улучшения и следовать последним рекомендациям. Если вы используете Google Analytics, отметив, когда произошло обновление алгоритма, вы сможете объяснить любые необычные результаты при извлечении отчетов или опросе клиентов.

Если вы обнаружите, что недавнее обновление алгоритма поисковой системы повредило вашему рейтингу, постарайтесь не паниковать и не начинать лихорадочно вносить коррективы.

Скорее всего, наилучшие результаты будут получены, если вы потратите время на изучение того, на что нацелено новое обновление, чтобы вы могли проверить, почему ваш веб-сайт не соответствует этим требованиям.

Скорее всего, вам нужно всего лишь сделать несколько простых настроек, чтобы вернуться в игру.

Совет: Если сайт другой компании начинает опережать вас после обновления алгоритма, вы можете запустить анализ конкурентов , чтобы выяснить, почему это может быть.

Вывод Алгоритмы поисковых систем представляют собой сложную систему, помогающую пользователям находить наилучшие ответы на свои запросы. Чтобы улучшить пользовательский опыт, поисковые системы регулярно меняют свои алгоритмы. Но изучение работы алгоритмов не так важно, как понимание того, чего хочет ваша целевая аудитория.

Но изучение работы алгоритмов не так важно, как понимание того, чего хочет ваша целевая аудитория.

Улучшая качество и релевантность содержимого целевой страницы, изучая вопросы, которые задает ваша аудитория, вы можете работать над тем, чтобы свести к минимуму свою зависимость от изменений алгоритма и в некоторой степени контролировать, насколько сильно они влияют на ваши инициативы.

Эта статья была обновлена и первоначально опубликована в ноябре 2020 года.

Все, что вам нужно знать

Часто я концентрируюсь на определенных стратегиях для выполнения определенных функций.

Как написать привлекательный текст, чтобы он занимал верхние позиции в голосовом поиске?

Какие структурированные данные позволяют легко выигрывать?

Такие вещи.

Эти важные вопросы часто освещаются здесь, в Search Engine Journal, в очень полезных статьях.

Но важно не только понимать, какие тактики могут помочь вам в ранжировании. Вам нужно понять , как работает .

Понимание структуры, в которой функционирует стратегия, имеет первостепенное значение для понимания не только того, почему эта стратегия работает, но и того, как и чего она пытается достичь.

Ранее мы обсуждали, как поисковые системы сканируют и индексируют информацию.

В этой главе рассматриваются основы работы алгоритмов поиска.

Что такое алгоритм? РецептЕсли вы спросите Google, что такое алгоритм, вы обнаружите, что сам движок (и почти все остальные) определяет его как «процесс или набор правил, которым необходимо следовать при вычислениях или других операциях по решению проблем». , особенно с помощью компьютера».

Если вы берете что-то из этого определения, очень важно понять, чем оно не является в нашем контексте.

Алгоритм не формула.

Чтобы осознать разницу, почему она важна и что делает каждая из них, давайте на мгновение представим еду, которую я мог бы поставить на свою обеденную тарелку сегодня вечером.

Возьмем мое любимое блюдо:

- Ростбиф

- Хрен

- Йоркширский пудинг

- Зеленая фасоль

- Картофельное пюре

- Соус

(Правильно, мы, канадцы, едим больше, чем путин и кленовый сироп, хотя и то, и другое потрясающе, хотя, вероятно, не вместе.)

Ростбиф должен быть приправлен и идеально приготовлен.

Приправа в сочетании с жареным мясом может служить примером формулы – сколько каждого ингредиента необходимо для производства продукта.

Второй используемой формулой будет количество времени и температура, в течение которой должно быть приготовлено жаркое, учитывая его вес. То же самое будет происходить для каждого элемента в списке.

На самом базовом уровне у нас было бы 12 формул (6 элементов x 2 — одна для измерений, а другая для времени и продолжительности приготовления в зависимости от объема), составляющих алгоритм, заданный для создания одного из любимых блюд Дэйва.

Мы даже не включаем различные формулы и алгоритмы, необходимые для производства самих ингредиентов, таких как разведение коровы или выращивание картофеля.

Давайте добавим еще одну формулу — формулу для расчета количества различных продуктов, которые я хотел бы иметь на своей тарелке.

Итак, теперь у нас есть алгоритм для выполнения этой очень важной задачи. Фантастика!

Теперь нам просто нужно персонализировать этот алгоритм, чтобы остальная часть моей семьи тоже наслаждалась едой.

Мы должны учитывать, что каждый человек индивидуален и может хотеть разное количество каждого ингредиента и разные приправы.

Итак, добавляем формулу для каждого человека. Хорошо.

Алгоритм алгоритмовЧто, черт возьми, общего у алгоритма поиска и обеденного стола?

Гораздо больше, чем вы думаете.

Давайте посмотрим на и несколько основных характеристик веб-сайта для сравнения. («Немного» означает далеко не все. Например, даже не близко.)

- URL-адреса

- Содержание

- Внутренние ссылки

- Внешние ссылки

- Изображения

- Скорость

Как мы видели с нашим алгоритмом обеда, каждая из этих областей далее делится с использованием разных формул и, по сути, разных подалгоритмов.

Было бы лучше, если бы мы думали об этом не как о алгоритме , а как о алгоритмах .

Также важно помнить, что, несмотря на множество алгоритмов и бесчисленное количество формул, алгоритм .

Его работа заключается в том, чтобы определить, как эти другие взвешиваются для получения окончательных результатов, которые мы видим в поисковой выдаче.

Таким образом, вполне законно признать, что существует какой-то тип алгоритма наверху — так сказать, один алгоритм, который управляет ими всеми — но всегда признают, что существует бесчисленное множество других алгоритмов, и, как правило, они алгоритмы, о которых мы думаем, когда рассматриваем их влияние на результаты поиска.

Теперь вернемся к нашей аналогии.

У нас есть множество различных характеристик веб-сайта, оцениваемого так же, как у нас есть ряд продуктов питания, которые должны оказаться на нашей обеденной тарелке.

Чтобы получить желаемый результат, мы должны иметь большое количество формул и подалгоритмов для создания каждого элемента на пластине и мастер-алгоритм для определения количества и размещения каждого элемента.

Знакомо?

Когда мы думаем об «алгоритме Google», на самом деле мы имеем в виду огромный набор алгоритмов и формул, каждый из которых предназначен для выполнения одной конкретной функции и собран вместе с помощью ведущего или, осмелюсь сказать, «ядра». Алгоритм размещения результатов.

Итак, у нас есть:

- Такие алгоритмы, как Panda, помогают Google оценивать, фильтровать, наказывать и награждать контент на основе определенных характеристик, и этот алгоритм, вероятно, включает в себя множество других алгоритмов.

- Алгоритм Penguin для оценки ссылок и устранения там спама. Но этот алгоритм, безусловно, требует данных от других ранее существовавших алгоритмов, которые отвечают за оценку ссылок, и, вероятно, некоторых новых алгоритмов, которым поручено понять общие характеристики ссылочного спама, чтобы более крупный алгоритм Penguin мог выполнять свою работу.

- Алгоритмы для конкретных задач.

- Алгоритмы организации.

- Алгоритмы, отвечающие за сбор всех данных и размещение их в контексте, который дает желаемый результат, поисковую выдачу, которую пользователи сочтут полезной.

Вот и все. Так работают алгоритмы поиска.

Почему алгоритмы поиска используют сущностиОдной из областей поиска, которая в последнее время привлекает достаточное внимание, хотя и недооценивается, является идея сущностей.

Для контекста объект определяется Google как:

«Вещь или концепция, которая является единственной, уникальной, четко определенной и различимой».

Итак, в нашей аналогии с ужином есть я. Я сущность.

Каждый член моей семьи тоже самодостаточен. На самом деле, моя семейная ячейка представляет собой самостоятельную сущность.

Таким образом, жаркое и каждый ингредиент, входящий в него, также являются самостоятельными объектами.

Таков же йоркширский пудинг и мука, которая пошла на его приготовление.

Google видит мир как совокупность сущностей. И вот почему:

За обеденным столом у меня четыре отдельных сущности, у которых состояние «ест» и множество потребляемых сущностей.

Классификация нас всех таким образом имеет много преимуществ для Google по сравнению с простой оценкой нашей деятельности как набора слов.

Каждое едящее существо теперь может назначать ему сущности, которые находятся на его тарелке (ростбиф, хрен, стручковая фасоль, картофельное пюре, йоркширский пудинг, но не соус для сущности xyz1234567890).

Google использует этот тип классификации для оценки веб-сайта.

Думайте о каждой сущности, сидящей за столом, как о странице.

Глобальная сущность, которая представляет всех нас (давайте назовем эту сущность «Дэвис»), будет посвящена «ужину с ростбифом», но каждая отдельная сущность, представляющая отдельного человека (или страницу в нашей аналогии), отличается.

Таким образом, Google может легко классифицировать и оценивать взаимосвязь веб-сайтов и мира в целом.

По сути, поисковые системы не обязаны оценивать только один веб-сайт — они должны ранжировать их все.

Сущность «Дэвис» говорит об «ужине с ростбифом», но сущность по соседству (назовем эту сущность «Робинсоны») говорит о «жарком».

Теперь, если внешнее лицо, известное как «Халявщик», хочет определить, где поесть, варианты могут быть ранжированы по «Халявщику» на основе его предпочтений или запроса.

В чем (на мой взгляд) реальная ценность сущностей заключается в том, что происходит на следующий день. У нас есть остатки.

Обрабатывая объект «ростбиф» с помощью другой формулы и добавляя объекты хлеб, сыр и лук, мы имеем:

Как алгоритмы поиска используют сущностиХорошо, может показаться неочевидным, насколько это важно для понимания алгоритмов поиска и того, как сущности работают таким образом.

Понимая, какую очевидную ценность имеет видение Google содержания веб-сайта в целом, вы можете спросить, почему для Google важно понимать, что мой ростбиф и соус из говядины связаны между собой и фактически взяты из одной и той же основной сущности. .

Вместо этого давайте рассмотрим, как Google понимает, что веб-страница посвящена ростбифу. Давайте также рассмотрим, что на него ссылается другая страница, и эта страница посвящена соусу из говядины.

В этом сценарии невероятно важно, чтобы Google знал, что ростбиф и дип из говядины готовятся из одной и той же основной сущности.

Они могут назначить релевантность этой ссылке на основе связности этих объектов.

До того, как идея сущностей вошла в поиск, поисковым системам приходилось присваивать релевантность на основе близости слов, плотности и других элементов, которые легко неверно интерпретировать и которыми легко манипулировать.

Сущностями гораздо труднее манипулировать.

Либо страница посвящена объекту, либо нет.

Просматривая веб-страницы и отображая распространенные способы связи сущностей, поисковые системы могут предсказать, какие отношения должны иметь наибольший вес.

Итак, как работают алгоритмы поиска?Итак, мы рассмотрели много вопросов, и вы, вероятно, проголодались. Вы хотите, чтобы некоторые вынос.

Значение контекста Важно понимать, как работают алгоритмы, чтобы применять контекст к тому, что вы испытываете/читаете.

Когда вы слышите об обновлении алгоритма, важно знать, что то, что обновляется, скорее всего, является маленьким кусочком очень большой головоломки.

Знание этого помогает интерпретировать, какие аспекты сайта или мира корректируются в обновлении и как эта корректировка вписывается в общую задачу движка.

Сущности очень важныКроме того, крайне важно понимать, что сущности:

- Сегодня играют огромную роль в поисковых алгоритмах.

- Имеют собственные алгоритмы.

- Со временем будет играть все более важную роль.

Знание этого поможет вам понять не только, какой контент является ценным (насколько близки те объекты, о которых вы пишете?), но и какие ссылки, скорее всего, будут оценены более благоприятно.

И это только пара преимуществ.

Все зависит от намерения пользователя Алгоритмы поиска работают как большой набор других алгоритмов и формул, каждая из которых имеет свою цель и задачу для получения результатов, которые удовлетворит пользователя.