Влияние сайтов на одном IP на позиции

Приоритет: Низкий

Содержание:

IP-адрес сайта – это сетевой номер сайта, который равен IP-адресу сервера, на который он загружен. Любой сайт в интернете имеет свой IP и если на Вашем имеются «вредные соседи», то стоит рассмотреть возможность переезда сайта на другой хостинг, так как это может влиять на позиции.

Кто такие «вредные соседи»?

Вредные соседи — это некачественные сайты, которые распологаются на одном IP с Вашим. Например:

- Сайты с тематикой для взрослых;

- Сайты, зараженные вирусами;

- Заблокированные сайты на законодательном уровне;

- Спамные ресурсы;

- Сайты, находящиеся под фильтрами поисковых систем.

Какие параметры хостинга влияют на SEO?

- Uptime – показатель, отражающий в процентах время бесперебойной работы сайта от общего времени.

- Время ответа сервера – параметр, отвечающий за скорость загрузки страниц на сайте. Хорошим показателем считается ответ, не превышающий 200 мс.

- Местоположение сервера. Если хостинг находится достаточно далеко от пользователя, то это может повлиять на время загрузки страниц. Желательно, чтобы сервер располагался в том же регионе, где и продвигается сайт.

Как проверить сайты на одном IP с нашим?

Перед проверкой, необходимо узнать IP-адрес Вашего сайта. Сделать это можно с помощью сервиса 2ip.ru.

1. Для этого перейдите по ссылке, введите доменное имя сайта в поле ниже и нажмите «Проверить»:

2. По окончанию проверки в поле на картинке будет отражен IP-адрес сайта:

Скопируйте его в буфер обмена и переходите к следующему шагу.

3. Далее необходимо перейти в сервис «Сайты на одном IP», вставить IP-адрес, ввести капчу и нажать «Поиск»:

4. В поле ниже появятся все сайты, которые находятся на одном IP с Вашим:

В поле ниже появятся все сайты, которые находятся на одном IP с Вашим:

Спасибо, что дочитали до конца. Переходите к следующей инструкции.

Выделенный IP-адрес — подключить в Москве

В бизнесе выделенный IP-адрес играет важную роль в обеспечении безопасности данных, положительно влияет на скорость передачи информации, открывает новые возможности в маркетинговых исследованиях. Собственный идентификатор активно применяют компании для создания защищенного соединения при работах с финансовыми инструментами, почтовыми программами и белыми веб-ресурсами. Это необходимое условие для доступа на некоторые сайты.

Подключить выделенный IP-адрес

Чем отличается выделенный IP-адрес от тех, которые предоставляются автоматически провайдером? На сервере одновременно размещаются сотни сайтов с одинаковым идентификатором. «Черные» операции по продвижению, рассылке спама владельцами других сайтов негативно отражаются на всех остальных ресурсах, размещенных на площадке. Это приводит к их блокировке, исключению из лидирующих позиций в поисковой выдаче, внесению в черный список. Подобные действия отрицательно влияют на имидж компании, косвенно сказываются на материальной прибыли.

Это приводит к их блокировке, исключению из лидирующих позиций в поисковой выдаче, внесению в черный список. Подобные действия отрицательно влияют на имидж компании, косвенно сказываются на материальной прибыли.

Чтобы избежать подобных проблем, необходимо подключить выделенный IP-адрес. Это надежный канал для выхода в интернет из любой точки мира. Его использование повышает качество соединения без покупки дополнительного оборудования. Если организации важно сохранить стабильную работу сайта в любых условиях, следует приобрести личный IP-адрес.

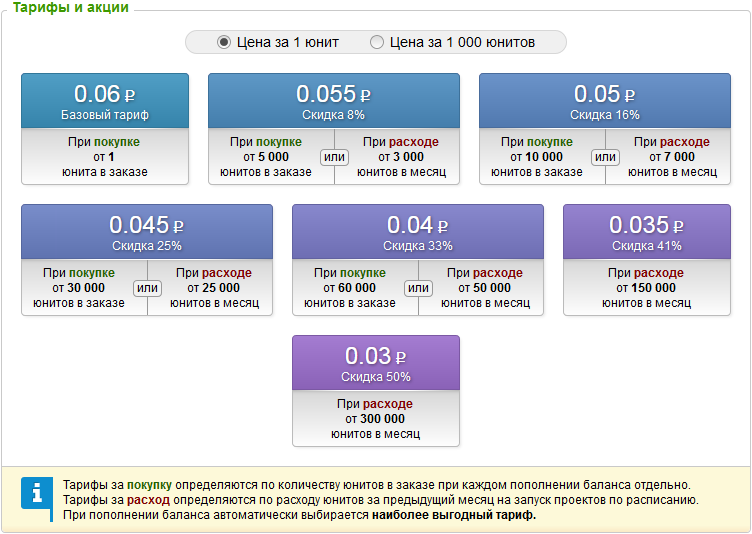

Выделенный IP-адрес стоимость

Выделенный IP-адрес – выбор организаций, стремящихся обеспечить защищённость и продуктивность корпоративной сети. Он благоприятно сказывается на скорости передачи объемной информации, за счет шифрования исключает перехват паролей и других данных злоумышленниками и минимизирует вероятность доступа к конфиденциальным сведениям посторонних лиц. Это положительно отражается на общей эффективности работы фирмы.

Преимущества использования выделенного IP-адреса:

- доступ к любому мировому web-ресурсу;

- низкая вероятность перехвата паролей;

- защищенный канал передачи информации, шифрование исходящих и входящих сообщений;

- полный контроль над веб-ресурсом, настройка и запуск с любого компьютера, ограничение доступа на сайт определенным пользователям.

Выделенный IP-адрес, стоимость которого можно узнать у менеджера компании «Теледисконт», стоит приобрести организациям, на ресурсах которых реализуются важные бизнес-процессы, происходит регулярный обмен объемными файлами. Это поможет избежать сбоев в системе и утечки информации, обозначить права доступа для разных пользователей, обеспечить высокую скорость соединения.

Купить выделенный IP-адрес

Увеличение эффективности бизнес-процессов и продуктивности функционирования сети, высокий уровень безопасности соединения – ключевые причины популярности услуги «выделенный IP-адрес». Она успешно помогает решать широкий спектр задач.

Примеры использования выделенного IP-адреса:

- Подключение к интернету в любой точке мира, передача конфиденциальных данных сотрудникам. Использование общественной сети Wi-FI для обозначенных целей создает высокий риск перехвата рабочей информации злоумышленниками. IP-адрес – идентификатор личности, необходимый для авторизации администратора, модератора и других участников при подключении к базам данных.

- Создание собственной локальной сети с высокой скоростью отправки файлов и надежным шифрованием.

- Запуск сайта с собственного компьютера.

- Выделенный IP-адрес необходим для функционирования файлообменников и FTP-сервера, доступа к некоторым ресурсам.

- Мероприятия и анализ результатов в области маркетинга. Приобретение выделенного IP-адреса в этой сфере получило широкое распространение. Специалисты могут использовать разные почтовые сервисы для рассылки информационных и рекламных сообщений подписчикам, не беспокоясь о негативной репутации; оценивать продвижение и поисковые позиции сайта в другой стране и городе, меняя IP-адрес.

Купить выделенный IP-адрес можно в компании «Теледисконт». Для консультации и оформления заявки свяжитесь с менеджером по телефону.

что это значит, зачем нужен сбор

В комплекс интернет-раскрутки сайта входит, в том числе, анализ эффективности продвижения. Съем позиций сайта — это фиксирование положения веб-ресурса в поисковой выдаче по популярным ключевым словам или фразам на момент проведения анализа. Оценка текущих результатов выдачи позволяет определить, насколько эффективна выбранная рекламная стратегия, что нужно поменять или откорректировать. Оптимизация необходима для снижения рекламных затрат на раскрутку бренда или компании в Интернете.

Что такое съем позиций веб-сайта

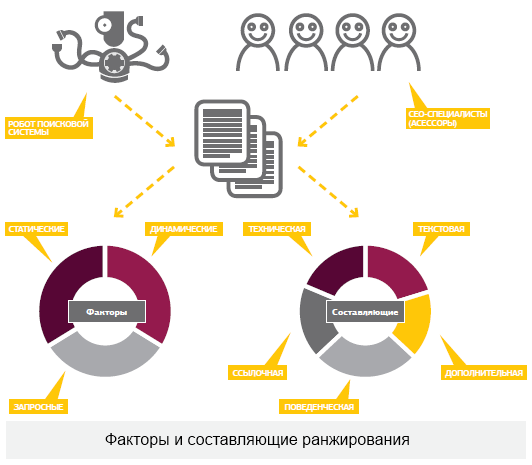

Съем позиций сайта простыми словами — это вычисление текущего положения онлайн-ресурса по ключевым запросам. Позиции (место в результате поисковой выдачи) определяются роботами поисковых систем на основании многих параметров для различных ключевых фраз, которые вводят пользователи в строку поиска для нахождения нужного товара или услуги.

Какие параметры учитывают ПС при формировании позиций онлайн-ресурса

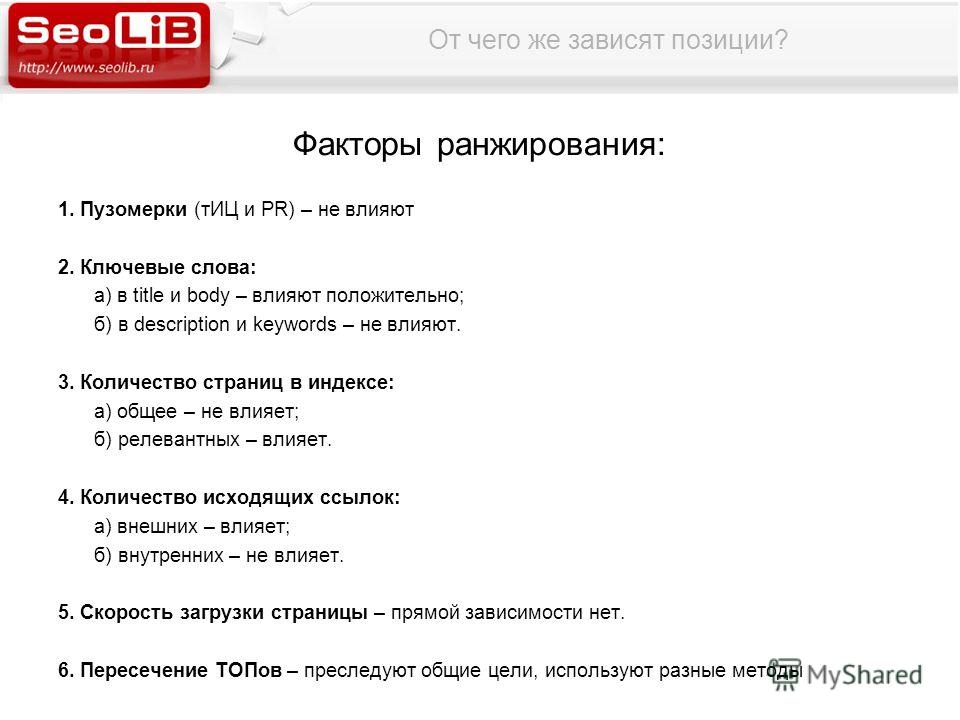

Поисковые системы Яндекс и Google постоянно обновляют алгоритмы ранжирования — оценки качества веб-сайтов, интернет-магазинов, лендингов и других ресурсов.

Для того чтобы предоставить пользователю наиболее релевантные результаты, роботы поисковых систем оценивают сотни различных характеристик. В Табл. 1 приведены основные факторы, которые влияют на рейтинг сайтов.

Табл. 1. Влияние различных параметров на позиции сайта в органическом поиске

| Параметр ранжирования, влияющий на позиции сайта | Характеристики | Рекомендации по применению |

| Контент | Текстовые блоки с описанием продукции, новости, полезные статьи по тематике. Изображения товаров, фотографии, инфографика. Видеоматериалы по профилю | Нужно наполнять веб-сайт полезным и уникальным контентом. Чем точнее содержимое отвечает на запрос пользователя, тем выше поднимется ресурс в выдаче по данному ключу. Актуальность и экспертность контента напрямую влияет на положительный рейтинг страницы по запросам, вписанным в текст Чем точнее содержимое отвечает на запрос пользователя, тем выше поднимется ресурс в выдаче по данному ключу. Актуальность и экспертность контента напрямую влияет на положительный рейтинг страницы по запросам, вписанным в текст |

| Ссылочная масса | Внешние ссылки с других ресурсов. Внутренние ссылки, используемые для перелинковки между страницами веб-ресурса | При закупке ссылок с сайтов-доноров нужно следить за их качеством. Качественный донор — это сайт с похожей тематикой, высокой посещаемостью и релевантным наполнением. Внутренние ссылки расставляются без переспама. Наращивать внутреннюю и внешнюю ссылочную массу нужно постепенно |

| Поведенческие факторы | Это параметры, которые отображают поведение пользователя на ресурсе. К данной категории относится глубина просмотра (сколько страниц пролистано), время нахождения на сайте, повторные посещения и пр. | Для улучшения поведенческих факторов, влияющих на позиции веб-сайтов, необходимо при разработке сайта продумывать удобную и понятную структуру, ненавязчивый дизайн, подбирать читабельные шрифты. |

| Возраст ресурса | Время существования веб-сайта | Многие вновь созданные ресурсы попадают под фильтры поисковых систем. Они индексируются, но не появляются в поисковой выдаче. После проверки на релевантность и отсутствие запрещенных способов продвижения сайт начинает появляться в результатах выдачи |

| Адаптация под разные устройства | Корректное отображение веб-ресурса на разных устройствах — компьютере, мобильном телефоне, планшете | Наличие мобильной версии в настоящее время очень влияет на рейтинг сайта в поисковых системах. Больше половины пользователей, которые ищут товары в интернет-магазинах, оформляют покупки через мобильное устройство |

Зачем нужно мониторить позиции веб-сайта

Есть ряд причин делать регулярный съем (определение) позиций сайта:

- Анализ эффективности выбранных маркетинговых каналов и инструментов интернет-продвижения.

Если позиции сайта высокие — значит, рекламная стратегия выбрана верно. При низких позициях ресурса нужно разбираться, что именно служит причиной неудовлетворительного результата. Это может быть низкокачественный контент (неуникальные тексты, переспам ключевыми фразами, нечитабельная структура и пр.), неудобная структура ресурса, слишком яркий и непонятный дизайн и пр.

Если позиции сайта высокие — значит, рекламная стратегия выбрана верно. При низких позициях ресурса нужно разбираться, что именно служит причиной неудовлетворительного результата. Это может быть низкокачественный контент (неуникальные тексты, переспам ключевыми фразами, нечитабельная структура и пр.), неудобная структура ресурса, слишком яркий и непонятный дизайн и пр.

- Эффективность продвижения конкурентов. Проводить анализ конкурентов полезно, хотя бы потому, что можно изучить, благодаря чему конкурентный сайт находится на высоких позициях в поисковой выдаче. Делая анализ успешных конкурентов, можно подсмотреть, на какие тематики написаны тексты, как используется ссылочная масса, как организована структура и пр.

Проводя развернутый анализ позиций своего сайта и конкурентных ресурсов, можно найти слабые места и устранить их. Улучшая характеристики, влияющие на позиции веб-сайта, можно значительно увеличить выручку от продаж, снизить расходы на SEO и другую интернет-рекламу.

Инструментарий проверки позиций онлайн-ресурса

Проверка позиции сайта в поисковых системах Google и Яндекс делается регулярно. Ее можно проводить раз в неделю и реже — в зависимости от стратегических целей и задач компании.

С помощью каких инструментов можно проверить позиции сайта:

- SEO-сервисы. Это бесплатные или платные ресурсы, которые осуществляют съем позиций веб-сайтов.

- Специальные онлайн-агрегаторы. Такие платформы не только проводят мониторинг позиций веб-ресурсов, но и предлагают услуги по оптимизации.

Ручная проверка позиций

Некоторые владельцы веб-сайтов проверяют позиции своих ресурсов вручную, вбивая в поисковик ключевые запросы и занося их в таблицу. Данный способ является бесплатным, но требует больших временных затрат и не отличается высокой точностью результатов. Низкая точность обусловлена тем, что поисковые системы учитывают множество дополнительных факторов, в том числе историю запросов, которые делались с вашего рабочего компьютера. Приемлемую точность результатов можно получить, включив в своем браузере режим «инкогнито». Вручную можно проверить небольшое количество ключевых фраз.

Функции автоматизированных сервисов по снятию позиций веб-сайтов

Эффективный онлайн-сервис по снятию позиций сайтов должен выполнять такие основные функции:

- Поддержка крупных поисковых сетей.

- Возможности автоматического мониторинга онлайн-ресурсов.

- Наличие опции гео-позиционирования (при необходимости — анализа эффективности рекламы по разным регионам).

- Выгрузка развернутых отчетов по текущим позициям онлайн-ресурса.

- Сбор статистических данных по периодам, хранение статистической и аналитической информации.

- Возможность анализа конкурентов, сравнения позиций по ключевым запросам и пр.

Проверка позиций сайтов с помощью RUSH ANALYTICS

Для проверки позиций веб-сайта рекомендуется применять RUSH ANALYTICS. Это удобный и эффективный сервис поисковой аналитики, который предоставляет широкий спектр услуг для достижения целей комплексного онлайн-продвижения сайтов, интернет-магазинов, лендингов.

Проверить позиции сайта конкурента или собственного ресурса можно, перейдя по ссылке

https://www.rush-analytics.ru/land/proverka-pozicij-sajta-v-poiskovyh-sistemah

С помощью этого инструмента можно выполнить такие задачи:

- Съем позиций в Яндексе, Гугле, других поисковых системах. Можно использовать неограниченное количество запросов и ключевых слов, группируя их по определенным характеристикам. Локальный мониторинг дает возможность снимать позиции в разных странах и регионах, на разных языках.

- Проверка сайта конкурента. Через платформу можно бесплатно проверить до 10 конкурентных веб-ресурсов. Анализ конкурентов позволяет оценить свои сильные и слабые стороны, возможности и риски, и выстроить стратегию расширения деятельности компании в своем сегменте. Конкурентный анализ также необходим при выходе на новые рынки.

- Получать развернутые отчеты с удобной визуализацией. Такой вид отчетности наглядно показывает тенденции роста или спада позиций.

На основе статистических и аналитических данных можно разработать план по оптимизации онлайн-продвижения и роста по основным ключам.

На основе статистических и аналитических данных можно разработать план по оптимизации онлайн-продвижения и роста по основным ключам.

Преимущества сервиса RUSH ANALYTICS

Сервис поисковой аналитики предоставляет пользователям множество возможностей. Для выполнения задач по оптимизации предоставляются детальные и понятные руководства к действию. Можно также задать вопросы консультантам системы в удобном онлайн-режиме. Функции и возможности сервиса сведены в Табл. 2.

Табл. 2. Возможности сервиса RUSH ANALYTICS

| Функции | Возможности |

| Съем позиций в разных поисковых системах | Работает с поисковыми системами Яндекс, Гугл. Без ограничений регионов |

| Адаптация под разные устройства | Выполняется проверка текущих позиций веб-ресурса с мобильного устройства, с персонального компьютера |

| Неограниченное количество запросов | Можно ставить задачи, в которые входит до 100 000 ключевых слов. Есть возможность добавления поисковых запросов Есть возможность добавления поисковых запросов |

| Анализ сниппетов | Есть возможность мониторить сниппеты. Сниппет можно мониторить по месту в выдаче, релевантности поисковому запросу, внешней привлекательности этого блока текста |

| Детальные отчеты | Отчет формируется в развернутом виде в файле Excel |

| Сортировка данных | Есть удобные фильтры для сортировки обрабатываемой информации |

| Универсальность анализа | Сервис подходит для анализа позиций сайтов с кириллическим доменным именем |

Как проверить сайт через RUSH ANALYTICS — алгоритм работы

- Создание задачи. Добавление запросов, групп, URL в задачу.

- Разбивка запросов на группы.

- Используйте руководство по работе в веб-интерфейсе.

- Подбирайте необходимые модули с учетом задач продвижения.

- Получайте регулярные отчеты по позициям, сформированные под индивидуальные настройки проекта.

Создание задачи с добавлением запросов и URL

На этом этапе создается новая задача. Указывается название задачи (по имени сайта или бренда). Прописывается URL сайта. Для сбора информации о позициях выбирается опция «Точный URL веб-сайта». На этом этапе есть возможность подключить аналитические сервисы поисковиков Яндекс и Гугл.

Разбивка запросов на группы

Для анализа эффективности продвижения отдельных страниц рекомендуется разбивка ключевых запросов на группы. Классификация выполняется по определенным параметрам — товарным категориям и подкатегориям, типам страниц, популярности (высокочастотные, среднечастотные, низкочастотные) и пр. Кластеризация (группировка) по определенным признакам дает более точное представление о том, почему позиции по тому или иному запросу растут или падают.

Руководство по работе в онлайн-интерфейсе

Платформа дает широкие функциональные возможности для анализа онлайн-ресурсов. Описание функциональных возможностей и алгоритмов работы можно найти в веб-интерфейсе задачи.

Какие возможности дает этот функционал:

- Редактирование поставленной задачи. Эта опция включает возможность изменения названия задачи, анализируемого урл-адреса сайта, корректировки периодов съема позиций, перечня ключевых запросов, конкурентных онлайн-ресурсов, которые нужно отслеживать.

- Просмотр собранных данных. Графики показывают источники (поисковые системы) и период сбора данных, позиции (ТОП) по всем или отдельно выбранным ключевым фразам. Отображается регион, сортировка по группам (если выбрана такая опция). По конкретным ключевым запросам можно отследить целевые URL-адреса. Важным параметром является возможность увидеть объем трафика (количество посетителей), которые зашли по выбранному поисковому запросу.

- Возможность выбрать разные типы визуализации данных. Можно выбрать панели с разными форматами отображения данных. Основные виды: По умолчанию, История позиций, История URLов, История сниппетов.

- Возможность сортировки информации по URL, ключевым словам, частотности, группам, дате, позициям.

- Доступ по гостевой ссылке. Скопировав гостевую ссылку, можно отправить ее другому пользователю. Это удобная опция для SEO-специалистов, которые ведут несколько проектов для своих клиентов. Гость сможет просматривать отчеты по съему позиций веб-сайта, даже не регистрируясь на аналитической платформе RUSH ANALYTICS.

- Удобный просмотр позиций. Видимость запросов показывается в графиках для конкретного поискового запроса или группы запросов. График можно построить с отображением даты оценки, региона, поисковой системы, настраивая видимость данных по своему усмотрению.

- Конкурентный анализ. Модуль дает возможность проверять позиции конкурентных сайтов, мониторить видимость процента ключевых слов ТОПе (первая тройка, пятерка, десятка). Таким образом можно отслеживать лидеров своей ниши по отчетам, сформированным в виде гистограмм.

- Получение развернутых отчетов. Можно сформировать упрощенный отчет, в котором показываются дата сбора информации, ключевые слова, группы запросов, адреса анализируемых веб-сайтов.

В полный отчет включаются графики задач, история URL, история сниппетов и позиций.

Съем позиций сайта необходим для отслеживания эффективности интернет-раскрутки. На выход в ТОП по основным ключевым запросам влияет множество внешних и внутренних факторов, активность конкурентов и интересы целевых групп. Поэтому нужно постоянно мониторить свои позиции и корректировать рекламные кампании с учетом текущей ситуации в своей нише.

Почему упали позиции сайта. Сайт на последних позициях.

Вы обнаружили, что у вашего сайта низкие позиции. Может быть две разных ситуации: у сайта просто низкие позиции и никогда не были высокими, или у сайта упали позиции.

Если у вас просто низкие позиции и вы никогда не продвигали сайт, то скорей всего всё справедливо, надо просто заняться продвижением.

А вот если у вас не получается продвинуться или были хорошие позиции и упали, то очевидно, надо разбираться в чем причина. Надеюсь моя статья вам поможет.

На позиции влияют разные факторы, которые мы будем по порядку проверять.

Определяем тип проблемы

Рассмотрим разные ситуации снижения позиций:

- Несколько запросов потеряли позиции. Вероятные проблемы:

- Фильтр за переоптимизацию

- Текстовая релевантность

- Недостаток ссылок

- Все запросы с документа потеряли позиции. Вероятные проблемы:

- Фильтр на документ

- Изменился тип выдачи

- Технические проблемы

- Весь сайт потерял позиции. Вероятные проблемы:

- Санкции ко всему сайту

- Технические проблемы

- Поведенческие и коммерческие факторы

Поднимаем историю действий

Первым делом надо посмотреть, что последнее время делали со страницей: меняли тексты, выкладывали фотографии, удалили или добавили информацию. Если что-то менялось и сайт упал в позициях после этого, то причина вероятно в изменениях.

Что могло поменяться вместе с контентом? Навскидку:

- Мог увеличиться показатель отказов, т.к. новый контент не устраивает пользователей (цены например).

- Мог измениться тип страницы, была информационная, стала коммерческая (например, появились цены и кнопка заказать).

- Изменилась текстовая релевантность, если добавили много нового текста.

- Можно получить фильтр за переоптимизацию, если перестарались с текстами.

Если же ничего не меняли, предположений нет, то диагностируем по порядку.

Проверка санкций и фильтров

Первым делом проверяем наличие нарушений, санкций и проблем безопасности в кабинетах вебмастеров Яндекс и Google. В случае серьезных нарушений, там будет соответствующее сообщение и позиции действительно могут резко упасть.

Кабинет Яндекс.Вебмастер — диагностика сайтаКабинет Google Search Console — проблемы безопасностиТакже, можно проверить конкретную страницу:

Проверка отдельной страницыПроверяем последние апдейты в ПС

Дальше смотрим, не было ли недавно серьезных изменений в поисковой выдаче. Если они были, то вероятней всего изменился алгоритм и формула ранжирования, поэтому позиции сайта снизились. В таком случае, если никаких других проблем нет, надо будет заново делать анализ ТОП и корректировать документ (или добывать ссылки).

В таком случае, если никаких других проблем нет, надо будет заново делать анализ ТОП и корректировать документ (или добывать ссылки).

Апдейты можно посмотреть:

Анализатор апдейтов AnalyzeThisНа сервисе AnalyzeThis вообще много всяких анализаторов поисковых систем, полезно к изучению. А в отчете по апдейтам можно посмотреть изменения выдачи по конкретным словам, по которым работает анализатор.

ПиксельТулс самый красивый анализатор и что удобно, позволяет выбирать тематику запросов, для точной диагностики. Например, вы можете обнаружить что во всей тематике меняется поисковая выдача, старые сайты теряют позиции, а на первые места выходят другие.

Анализатор апдейтов PixelToolsРучная проверка изменений в ТОП-10

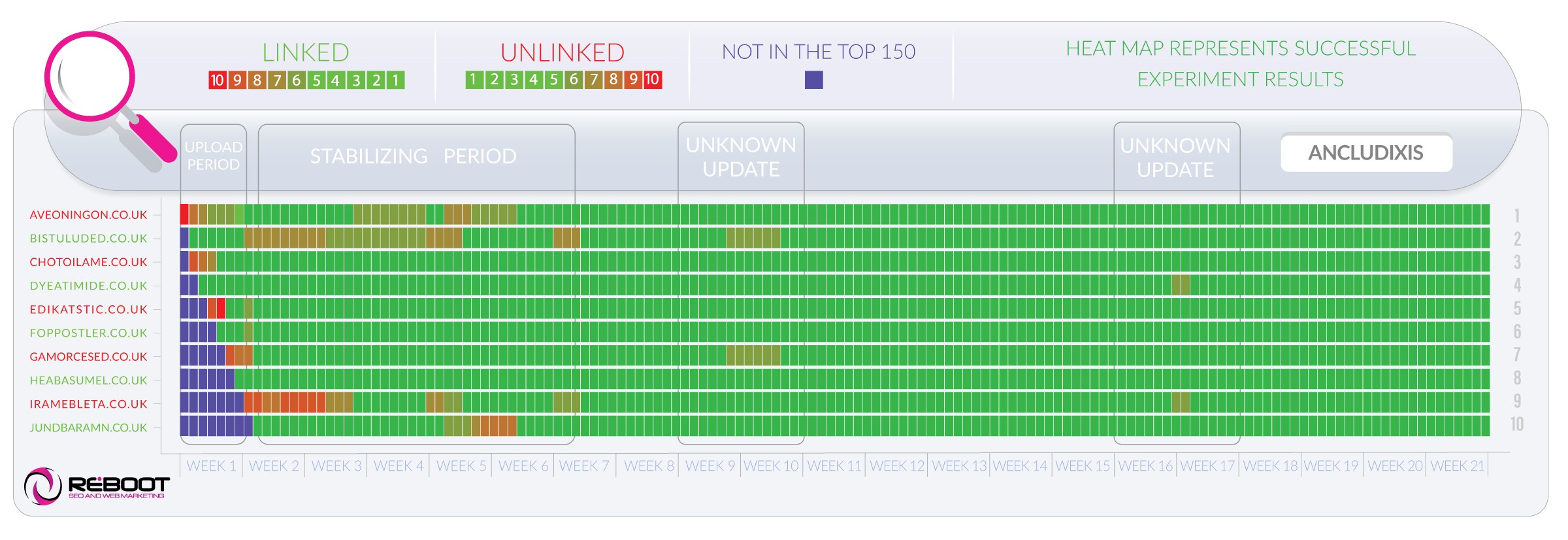

Не зависимо от того был апдейт или нет, надо посмотреть как изменилась поисковая выдача по конкретным запросам. В большинстве сервисов проверок позиций есть история выдачи, а особенно здорово, если можно смотреть не конкретный запрос, а по группе.

Это может выглядеть так:

Видно изменение позиции в программе AllSubmitterИли вот так:

История позиций в сервисе SeRankingЕсли вы не отслеживали позиции, то есть сервисы, которые могут показать историю по популярным запросам, например Megaindex

История выдачи по запросу в MegaindexТут мы отмечаем степень изменения выдачи и проверяем какие сайты резко поднялись, у каких позиции резко упали. Сильно упали позиции только по нашему сайту или пострадал весь ТОП-10.

Сильно упали позиции только по нашему сайту или пострадал весь ТОП-10.

Очевидно, если упал только наш сайт, значит проблема у нас. Если сильно изменилась поисковая выдача, то вероятно изменился алгоритм или интент запроса.

Проверка типа документа и типа выдачи

Поисковые запросы бывают разных видов и еще у запросов есть интент — потребность или задача, которую хочет решить пользователь.

Поисковая выдача соответствует интенту запроса. Если пользователи вводят запрос чтобы купить, то в ТОП-10 магазины, если скачать — то сайты, где можно скачать. Если почитать, то статьи.

Поведение пользователей дает сигнал о том, какая должна быть выдача. Поисковик измеряет качество выдачи и корректирует ее. Если оказалось, что у запроса другой интент, например был информационный, стал коммерческий, поисковая выдача поменяется.

Пример. Был у меня клиент — медцентр. Долго мы стояли в ТОП-5 по запросам связанным с УЗИ разных органов. Но в какой-то момент Яндекс стал выдавать вместо сайтов клиник сайты агрегаторов услуг. Всё, ничего сделать было нельзя, просто отказались от этой группы запросов (при этом разместились в этих агрегаторах).

С интентом разобрались. Еще влияет тип страницы или сайта. Например пользователь задает название товара, а в выдаче стоят только страницы категорий. В таком случае товарную страницу не продвинуть и наоборот. Или в ТОП-10 одни интернет-магазины, значит сайт услуг не продвинуть.

Еще влияет наполнение страницы, другими словами из каких-элементов она состоит. Может быть в поиске у всех подробные таблицы с ценами, а у вас текст. Значит надо тоже делать таблицу с ценами. Может быть надо добавить галерею, может быть видео, блок вопрос-ответ, калькулятор, больше подзаголовков и т.п..

Быстро проанализировать необходимый тип документа можно с помощью классификатора запросов:

Инструмент классификации запросов от MegaindexНа скриншоте видим, что почти все запросы информационные (доля коммерческих сайтов 0%), значит нет смысла продвигать по ним категории интернет-магазина.

Не привязывайтесь к каким-то определенным характеристикам, лучше анализировать абстрактно. Смотрите, если все в ТОП-10 предлагают одно и тоже, а вы пытаетесь продвинуть другое, то скорей всего ничего не получится. Потому-что люди ищут именно то, что и стоит на первых позициях (алгоритм это понял и так поставил).

Проверка текстовой релевантности

Проверяем, что текст страницы релевантен поисковому запросу. Причем нас интересует не просто плотность ключевых фраз, хотя она тоже важна, но соответствие этой плотности сайтам в ТОП-10.

Поэтому сначала анализируем отдельно страницу, чтобы убедится, что она оптимизирована под запрос, а потом в сравнении с ТОП-10. К сожалению, пока не знаю удобного инструмента, который позволил бы хорошо делать всё вместе.

Анализ плотности ключевых слов

Уточнение. Если анализировать сайты в ТОП-10, то не будет такого, что у них прям у всех одинаковая правильная плотностью ключевых слов (и набор тематических слов, если вспомнить про LSI). В зависимости от типа запроса, текстовая релеватность вообще может быть не определяющим фактором (например для ВЧ запроса намного важней поведенческие факторы).

Проверить плотностью ключевых слов можно с помощью сервисов https://istio.com/ или https://text.ru/:

Проверка текста на istio.comЯ обычно пользуюсь расширением для Chrome — SEO Quake, там кроме прочих инструментов отличный анализатор плотности ключевых слов, в котором можно посмотреть статистику не только по словам, но и по словосочетаниям. Также видно вхождения слов в важные зоны документа (title, description, h2).

Анализ текста в SeoQuakeХотя, вот еще в сервисе Istio классная функция «карта», выделяет размером наиболее повторяющиеся слова, сразу видно SEO-оптимизацию

Карта слов в сервисе IstioПроанализировали текст, смотрим чтобы не было переспама, но при этом по плотности должно быть понятно, что текст отвечает на запрос.

Текстовый анализ ТОПа

Дальше, анализируем ТОП-10, смотрим какая плотность ключевых слов там, а также наиболее часто встречаемые фразы на странице (задающие тематику). Сравниваем со своей страницей и делаем выводы.

Можно было бы делать всё вручную, то есть каждую страницу брать и проверять в каком-нибудь инструменте, но к счастью есть инструменты облегчающие работу.

Анализ текста в MegaindexЭто бесплатный инструмент, более продвинутые аналоги есть почти во всех комплексных сервисах SEO.

Делаем выводы, корректируем явные проблемы. По любому стоит дописать текст, если не хватает тематических слов и по ним есть, что написать.

Однако повторюсь, что сайт может стоять в ТОП-10 не только из-за текстовых характеристик, есть еще ссылки, поведение пользователей.

Сбой релевантной страницы

Иногда причина плохой позиции может быть в том, что изменилась релевантная страница внутри сайта. При этом новая релевантная страница проигрывает по другим факторам конкурентам в ТОП-10 и не может там стоять.

Клиенту допустимо не знать, какие именно страницы стоят по запросам, они больше обращают внимание на позиции. SEO-шник должен всегда контролировать какие страницы стоят в выдаче и особое внимание уделять фразам, по которым релевантные страницы поменялись.

Вот реальный пример, когда сбилась релевантная страница по запросу, сайт вылетел из ТОП-10, а потом после корректировки, вернулся на место.

Смена релевантной страницы привела к падению позиции сайта.Что делать если нестабильна релевантная страница:

- Убедится, что на сайте действительно есть подходящая страница. Бывает позиция скачет, потому что поисковик никак не определится какая именно страница. Иногда надо просто взять и сделать подходящую страницу.

- Проверить на фильтр за переоптимизацию. Если фильтр есть, то снимать.

- Уменьшить плотность ключевых слов на ненужной странице

- Увеличить плотностью ключевых слов на нужной

- Поставить анкорную ссылку с ключевым словом с ненужной на нужную.

Кстати, наложение фильтра за переоптимизацию — очень частая причина смена релевантной страницы.

Проверка на переспам и переоптимизацию

Если в кабинетах вебмастеров нет никаких предупреждений и нарушений, то еще не факт, что нет фильтра или санкций. Фильтр за переспам и переоптимизацию накладывается не заметно. Главным признаком будет, если сайт упал на 20-50 позиций.

Чаще всего фильтр накладывается по конкретным ключевым фразам, по которым SEO-оптимизатор перестарался. Поэтому самый просто метод диагностики — это чуть-чуть изменить запрос и проверить позиции. Если позиция заметная выше, значит наверняка фильтр.

Такой метод определения используется в сервисе be1.ru

Проверка на переспам в сервисе BE1Можно предположить, что наложен фильтр за переспам, если в группе запросов сильно упали только некоторые запросы. Если же провалились все, то скорей всего фильтр за переоптимизацию.

Другой метод проверки, это сверять позиции своего сайта и конкурентов по запросу вида «запрос (site:vashsite.ru | site:konkurent.ru)«. Если при сравнении с конкурентом сайт выше, а просто по запросу ниже, то вероятно есть фильтр. По такому принципу можно проверить в сервисе https://arsenkin.ru/tools/filter/

Это всё касалось Яндекса. В Гугл просто обваливается трафик и позиции по странице, а предполагать приходится интуитивно. Если есть шансы, что текст переспамлен или некачественный, то лучше полностью переписать.

Проверка технических проблем

Даже если сайт работает и страница лично у вас открывается, нельзя исключать влияние технических проблем, они тоже могут быть причиной плохих позиций и в Яндекс и в Google.

В первую очередь надо проверить сохраненную версию страницу в Яндекс и Google, убедится что содержимое совпадает с тем, что на сайте.

Затем можно выполнить аудит страницы с помощью каких-нибудь сервисов, например Be1 или PR-CY

Анализ страницы в Be1Проверьте скорость загрузки в Page Speed Insights от Google, посмотрите рекомендации:

Обычно с технической точки зрения

Проверка коммерческих факторов

Если давно не меняли сайт, то может оказаться, что в ТОП-10 поменялся набор коммерческих факторов. Суть в том, что для каждой тематики и типа сайтов есть определенный набор элементов на сайте, которые пользователи привыкли видеть. Поисковик понимает, как это проанализировать.

И вот, например в ТОП-10 вышли страницы, на которых есть интерактивная карта проезда, а у вас нет, поэтому позиции снизились. Это реальный пример, я выводил страницу в ТОП-10 просто добавив карту проезда и текст «как добраться» на странице услуги.

Как проанализировать коммерческие по ТОПу я написал в конце статьи про коммерческие факторы ранжирования сайтов.

Часть таблицы по анализу на коммерческие факторы.Проверка поведенческих факторов

Поведение пользователей тоже может влиять на позиции и чем больше частота запроса, тем это влияние выше. Нам надо проанализировать CTR на поиске и показатель отказов у себя на сайте.

С помощью Яндекс Метрики можно посмотреть как менялся показать отказов по странице. Если показатель отказов вырос, значит контент страницы перестал удовлетворять потребностям пользователя. Скорей всего позиции постепенно снизились. Нужно смотреть по стоящим в ТОП-10 сайтам, что теперь интересно пользователям.

График показатель отказов по страницеА с помощью кабинетов вебмастеров можно изучить информацию по кликабельности страницы (или запроса) в поисковой выдаче. Если какие-то страницы сильно выделяются на фоне остальных в худшую сторону, то скорей всего сниппет вашей страницы в результатах поиске не привлекает пользователей.

Проверка ссылочных факторов

Ну и наконец, надо проверить достаточно ли ссылочной массы у нашей страницы по сравнению с конкурентами (и качество этих ссылок). Это самая маловероятная причина резкого снижения позиций, что вдруг стало не хватать ссылочного веса.

В первую очередь смотрим общую ссылочную массу по сравнению с конкурентами. Если у нас средние показатели, то проверяем уже ссылки постранично.

Самый быстрый способ проверить страницы в ТОП на ссылки, это инструмент от Мегаиндекс «Анализ ссылок по ТОП»

Важно не только количество, но и анкоры ссылок. Сервис позволяет всё это посмотреть.

Анализ анкоров ссылокЕсли ссылок достаточно, анкор лист выглядит разумным, то надо рассмотреть следующие угрозы:

- Ссылки стоят, но они низкого качества. Донор превратился в линкопомойку и его ссылки стали вредить. Тогда нужно постараться снять ссылки (в Гугл можно отклонить в кабинете вебмастера)

- Переспам в анкор-листе. Возможно, слишком много ссылок с прямым вхождением ключа. Тогда тоже нужно либо снимать ссылки, либо попробовать разбавить анкор лист.

С ссылками нужно быть поаккуратней. Учитывая, что они играют далеко не главную роль в продвижении, никому не рекомендую испытывать границы переспама или проверять сколько можно безопасно купить ссылок на страницу. Работаем точечно, добавляем по 1-2 ссылки в месяц на страницу максимум, а по возможности стараемся работать без них.

Заключение

Низкие позиции — это обычно недостаток релевантности или нехватка какого-то фактора.

Если позиции просели, то сначала исключаем наложение санкций, а затем проверяем по порядку возможные факторы и вы наверняка сможете выдвинуть гипотезы, которые стоит проверить.

Анализ сайта, всё о сайте лучшие сервисы для изучения и аудита сайта.

Насколько сайт популярен? Одинаково ли он выглядит на разных устройствах и в разных браузерах? Хорошо ли SEO-оптимизирован ресурс? Как узнать всё о сайте? Это частые вопросы владельцев веб-ресурсов.

Информация о сайте ― это несекретные данные. Для анализа сайта можно использовать десятки сервисов, которые ответят на все вопросы, связанные с аудитом сайта. Некоторые из них мы рассмотрим в статье.

Для чего может понадобится узнать всё о сайте:

- Для аудита своего сайта, чтобы увидеть слабые места веб-ресурса. Страница может плохо отображаться на мобильных устройствах, долго загружаться или содержать битые ссылки. Лучше решить эти проблемы раньше, чем это заметят пользователи и поисковые системы.

- Для изучения конкурентов. Конкуренция в интернете растёт, и нужно постоянно следить за своими соперниками, ведь чем они сильнее, тем ваш сайт ниже в поисковой выдаче. Возможно, ресурсу не хватает SEO-оптимизации или есть проблема с контентом. Это можно будет узнать в сравнении с конкурентами.

- Для анализа сайта при его покупке. Необязательно делать сайт с нуля. Можно приобрести готовый ресурс со схожей тематикой у другого владельца. Чтобы не купить сайт с плохой репутацией, перед покупкой нужно провести небольшой анализ сайта. На репутацию может влиять некачественный контент, плагиат, плохая SEO-оптимизация, навязчивая реклама.

- Для заказа рекламы. Реклама ― это эффективный метод продвижения любого ресурса. Однако важно, чтобы она располагалась на популярных и качественных сайтах.

Посещаемость сайта

Посещаемость показывает, насколько сайт отвечает потребностям целевой аудитории. Также посещаемость важна при выборе платформы для рекламы. Чем популярнее ресурс, тем целесообразнее размещать на нём рекламу.

Если вы владелец веб-ресурса, то проверить посещаемость можно с помощью сервисов Яндекс.Метрика и Google Аналитика.

Яндекс.Метрика

Google Аналитика

- 1. Зарегистрируйтесь на сервисе и прикрепите к нему свой сайт.

-

2.

Перейдите во вкладку Сводка. Здесь вы увидите количество новых пользователе и общее число посетителей:

- 1. Зарегистрируйтесь на сервисе и прикрепите свой сайт к нему.

-

2.

Перейдите во вкладку Аудитория. Здесь можно не только посмотреть общее количество посетителей, но и увидеть количество активных пользователей, а также длительность их контакта с сайтом:

Если вас интересует посещаемость не вашего сайта, то можно воспользоваться программами SimilarWeb, и SEMrush.

Эти сервисы сотрудничают с браузерами, что позволяет им получать данные о посетителях сайта. Однако эти данные только приблизительные. Точные цифры может знать только администратор. Для оценки со стороны этого достаточно, так как погрешность небольшая.

Посещаемость сайта важна для SEO-анализа, поэтому этот показатель входит во многие отчёты сервисов для анализа на SEO-оптимизацию. Если вас интересует не только посещаемость, используйте один из сервисов, описанных ниже.

Лучшие инструменты для анализа SEO

SEO ― совокупность работ, которая направлена на повышение позиций сайта в поисковой выдаче. Чем выше сайт в выдаче поиска, тем чаще его видят пользователи и тем больше шансов привлечь потребителей на сайт.

Так же как и при изучении посещаемости, выбор сервисов для анализа зависит от того, чей сайт вы изучаете. Если вы хотите проанализировать свой сайт, то самыми популярными сервисами являются Яндекс.Вебмастер и Google Search Console. Если ваш ресурс создан на REG.Site, настроить базовое SEO-продвижение поможет статья Как настроить SEO-продвижение сайта, созданного в REG.Site.

Проанализировать сторонний ресурс помогут другие сервисы. Ниже мы дадим небольшой обзор самых популярных сервисов для SEO-анализа.

XTOOL

XTOOL позволяет быстро сделать комплексный SEO-анализ сайта. С его помощью можно узнать:

✔ возраст сайта,

✔ рейтинг веб-ресурса в поисковых системах,

✔ наличие санкций на сайт,

✔ количество внутренних и внешних ссылок,

✔ показатели PR, ИКС, ТИЦ,

✔ траст.

SBUP.com

По сравнению с XTOOL SBUP.com имеет более широкий функционал. Кроме стандартных SEO-параметров (возраст, PR, ИКС и ТИЦ-показатели, ключевые слова, внутренние и внешние ссылки), он показывает:

✔ IP-адрес,

✔ тип и ПО сервера,

✔ наличие вирусов,

✔ скорость ресурса,

✔ определяет примерную цену.

PR-CY

PR-CY.RU ― один из самых популярных бесплатных сервисов для анализа SEO. Введите интересующий вас домен и сервис покажет вам:

✔ важные изменения, которые происходили на сайте, например изменения в файле robots.txt,

✔ ИКС, PR, позиция в Яндекс и Google,

✔ вирусы и санкции,

✔ посещаемость,

✔ рейтинг в Alexa.

В платной версии можно получить ещё больше информации:

✔ географию аудитории,

✔ источники трафика,

✔ трафик в социальных сетях,

✔ поведение пользователей (количество отказов, время на сайте, количество посещенных страниц).

CY-PR.com

CY-PR.com ― ещё один бесплатный сервис для SEO-анализа. Регистрироваться не нужно, просто введите доменное имя и нажмите Анализировать:

Он будет полезен для анализа своего сайта и для анализа конкурентов. Кроме стандартных критериев оценки, CY-PR.COM предлагает:

✔ измерение скорости работы сайта,

✔ данные из WHOIS,

✔ проверяет ошибки в кэшировании и CSS,

✔ проверяет оптимизацию для мобильных устройств и планшетов.

СайтРепорт

На saitreport.ru можно бесплатно проверить 25 страниц портала. Для использования ресурса нужна регистрация. Сервис позволяет провести технический аудит (тип и ПО сервера, наличие вирусов на сайте, скорость ресурса и т. д.), выдаёт данные о количестве страниц портала, среднем времени загрузки, наличии sitemap и robots.txt. Также можно проверить данные о контекстной рекламе, объёме поискового трафика в месяц, числе запросов в Яндекс и Google, обратных ссылках и анкорах. Есть возможность узнать количество упоминаний в СМИ и в социальных сетях. Программа оценивает корректность тегов и оригинальность контента. Можно настроить автоматическую проверку, и раз в день, неделю или месяц сервис будет отправлять результат анализа на вашу электронную почту.

Пиксель Тулс

Пиксель Тулс поможет узнать практически всё о сайте. Он простой в использовании, в бесплатной версии достаточно много инструментов для SEO-анализа. Сервис:

✔ проверяет тексты на уникальность и вхождение ключевых слов,

✔ проверяет позиции в Google и Яндекс,

✔ показывает количество переходов из социальных сетей,

✔ анализирует количество рекламных объявлений в выдаче Яндекса,

✔ рассчитывает KPI,

✔ анализирует ссылочную массу,

✔ анализирует скорость загрузки контента.

В платной версии можно получить ещё больше возможностей, таких как анализ XML-карты, проверка поведенческих факторов пользователей, анализ SEO-тегов для списка URL и др. Можно настроить автоматический аудит.

Как выглядит сайт на мобильных устройствах

Посмотреть, как будет выглядеть сайт на самых распространённых смартфонах и планшетах можно на bluetree.ai.

Введите URL-адрес и нажмите Идти:

img src=«https://img.reg.ru/faq/2021021514_analiz_saita_4.png» loading=«lazy» alt=«=1100×494 „Анализ SEO 2“ itemprop=„contentUrl“ />

Готово, вы можете выбрать любое устройство и посмотреть, как на нём отображается страница.

Совместимость с другими браузерами

Пользователи могут заходить на сайт не только с разных устройств, но и с разных браузеров. Важно, чтобы он одинаково отображался на всех платформах. Чтобы проверить отображение в разных браузерах, можно использовать Browserling. Можно посмотреть, как выглядит сайт на Internet Explorer, Chrome, Safari, Opera и Firefox.

Нарушение авторских прав

Если вы планируете купить уже использованный домен или весь сайт, обратите внимание на его репутацию. Один из способов узнать прошлое веб-ресурса ― найти жалобы на нарушение авторских прав. Если сайт активно использовал плагиат, то его рейтинг в поисковых системах явно низкий и покупать такой домен невыгодно. Проверить количество жалоб на сайт поможет Lumen. Введите доменное имя и нажмите Идти:

Перед вами появится список всех жалоб, которые получал сайт за всё время его существования.

Скорость сайта

Скорость загрузки сайта ― это важный элемент, за которым нужно следить. Пользователи не любят долго ждать загрузку страницы. Поисковые системы об этом знают и размещают медленные страницы ниже в поисковой выдаче.

Сервис PageSpeed Insights от Google не только покажет скорость загрузки, но и подскажет, какие проблемы нужно устранить, чтобы сайт стал загружаться быстрее.

Битая ссылка — это гиперссылка с ошибкой в URL-адресе. Из-за этого пользователь не может увидеть нужную ему информацию.

Они могут появиться, если:

- старые страницы или документы были удалены,

- была изменена ссылка на стороннем сайте,

- ссылка была написана с ошибкой,

- произошли изменения в структуре сайта. Например, страница была перенесена в другой раздел и поменяла свой URL, а старые ссылки на страницу остались неизменными.

Проверить сайт на наличие битых ссылок можно вручную. Для этого нужно переходить во все существующие страницы на веб-ресурсе, нажимать на все ссылки и смотреть, на какие страницы они перенаправляют. Это долго и неудобно, поэтому этот процесс лучше автоматизировать с помощью Badlinks.

Делятся ли ссылками на сайт в социальных сетях

Популярный сайт должен быть не только интересен пользователям, но и побуждать посетителей делиться контентом страницы с другими. С помощью muckrack.com можно узнать, сколько раз и какие пользователи поделились конкретным URL-адресом.

В этой статье мы разобрали лучшие онлайн-сервисы, которые помогут сделать сайт лучше или выбрать хороший веб-ресурс для покупки. Чтобы узнать всё о сайте, используйте несколько сервисов и сравнивайте результаты. Так вы сможете максимально точно определить слабые места ресурса.

Помогла ли вам статья? 1

раз уже

помогла

Пример SEO Аудита Сайта — Plerdy

В этой статье пойдет речь о том, что такое поисковая оптимизация и SEO-аудит сайта. Вы узнаете, что это за процедуры и как они влияют на продвижение сайта: сначала поговорим о важности оптимизации, после разберем теоретическую часть и закрепим материал готовым отчетом о проверке сайта. Информация про SEO-анализ сайта будет полезна всем пользователям, которые заинтересованы в развитии своего бизнеса и готовы использовать для этого все современные способы.

Команда Plerdy подготовила для Вас новый бесплатный вебинар — «SEO-аудит сайта на примере Google & Apple сайтов». Видеозапись Вы можете посмотреть в этом видео. Присоединяйтесь к тем, кто уже успел посмотреть этот вебинар.

Содержание:

В чем важность SEO и SEO-аудита

Вообразим человека, решившего открыть первоклассную таверну с минимальными ценами, широким ассортиментом и бесплатным стриптизом. По мнению предпринимателя всего перечисленного достаточно, чтобы построить успешный бизнес, быстро набрать клиентскую базу и начать зарабатывать. Но все не так. Если о таверне никто ничего не узнаете, то на стабильную прибыль рассчитывать сложно.

Таверна о которой никто ничего не знает.

Неизвестная таверна будет перебиваться случайными заработками, потратит много времени на раскрутку и весь период просадки предпринимателю придется выживать за счет собственного капитала. Если денег не хватит, то через пару месяцев бизнес закроется и таверна за копейки будет выставлена на аукцион по банкротству.

Неизвестная таверна — это место без клиентов и прибыли.

Исправляем ситуацию: фотографируем таверну, описываем ее несколькими короткими предложениями и помещаем это объявление на первую полосу местной популярной газеты. Параллельно задействуем и другие рекламные способы, которые позволяют как можно большему количеству пользователей побыстрее узнать о новом заведении.

Размещаем информацию о новой таверне на обложке местной газеты.

Когда информация о таверне попадет в правильные источники, то практически сразу можно рассчитывать на первых клиентов. Дальше все будет зависеть от предпринимателя: если он создаст душевную атмосферу и построить весь сервис вокруг посетителей, то таверна быстро станет посещаемым местом. После высокая посещаемость конвертируется в прибыльный бизнес, который можно расширять и совершенствовать. В противном случае даже лучшая реклама окажется бесполезной.

Узнаваемая таверна — это место довольных и постоянных клиентов.

А теперь представьте, что вместо таверны мы запускаем сайт. В этом случае для привлечения посетителей будет использоваться не реклама в газетах, а поисковая оптимизация. Поисковая оптимизация — это комплексный процесс, позволяющий перенести сайт на высокие позиции в Google, Яндекс и других поисковых системах: SEO-оптимизация → рост посещаемости → увеличение продаж.

По усредненным данным около 80% интернет-сайтов никогда не открываются только из-за того, что находятся за пределами первых десяти страниц поисковой выдачи:

- На первое место приходится около 32% кликов.

- На второе — 15%.

- На третье — 10%.

- С четвертого по девятое — 20%.

- Уже на десятое место отводится не более 3% кликов.

- Одиннадцатое и все последующие места суммарно дают не более 20%.

- На двадцать первое место выпадает менее 1% кликов — это всего лишь третья страница поисковой выдачи.

- Начиная с четвертой страницы процент кликабельности настолько низок, что все пользовательские переходы можно считать случайными.

Поэтому если хотите конкурентный сайт — без поисковой оптимизации и SEO-аудит не обойтись. Поисковая оптимизация позволит вывести сайт в ТОП-10, а SEO аудит поможет там закрепится несмотря на меняющиеся условия и действия конкурентов.

Теория

После изучения теоретической части вы будете знать, что такое хорошая поисковая оптимизация, как взаимосвязаны SEO и маркетинг, зачем заниматься

юзабилити-тестированием и как проводить аудит оптимизированного сайта.

Перед началом стоит сразу упомянуть о существующих методах оптимизации:

- Белое SEO — это все разрешенные приемы, которые позволяют продвигать сайт и бороться с конкурентами. Именно о таком SEO мы говорим в данной статье.

- Серое SEO — это методы, которые прямо не запрещаются, но из-за которых сайт в любой момент может попасть под санкции. Если сайт попадает под санкции, то он исключается из поисковой выдачи и теряет трафик.

- Черное SEO — это запрещенные методы, внедрение которых обещает быстрое попадание в ТОП-10. Обычно черное SEO направлено на обход поисковых алгоритмов и на временное поднятие SEO рейтинга сайта. Когда проблема обнаруживается — набранные позиции сбрасываются и сайт рискует попасть в поисковый бан. Если сайт попадает в бан, то он исключается из поисковых систем и для исправления ситуации нужно переносить контент на новый сайт.

Мы не знаем, кто и зачем практикует запрещенные методы SEO-продвижения. Мы лишь предупреждаем, что их использование не поможет получить долгосрочный результат.

С белым SEO тоже не все просто: поисковый алгоритмы постоянно менются и обновляют свои требования. Из-за этого все сегодняшние рекомендации могут потерять актуальность уже через год. Поэтому если вы планируете надолго закрепиться в ТОП-10, то важно постоянно интересоваться темой, откликаться на тренды или нанять для этого специалистов. Другого легкого способа не существует.

Белое SEO — это единственный способ правильной оптимизации сайта. Все остальное зло.

Также важно сразу разобраться, чем современные методы поисковой оптимизации отличаются от поисковой оптимизации прошлого:

| SEO-оптимизация 1.0 | SEO-оптимизация 2.0 |

| Смысл поисковой оптимизации сводился к тому, чтобы накачать сайт как можно большим количеством ключевых запросов и за счет этого продвинуться в рейтинге. То есть поисковая оптимизация проводилась только для того, чтобы сайт как можно быстрее попал в ТОП-10 Яндекса и Гугла | Используется поисковая оптимизация цифрового маркетинга — сайт продвигается в рейтинге по ограниченному количеству ключевых запросов, которые направлены на привлечение релевантного органического трафика. То есть поисковая оптимизация проводится для того, чтобы увеличивать продажи и развивать бизнес |

| Практически весь контент создавался для поисковых роботов, поэтому большинство запросов оставались неудовлетворенными. Сайты с избыточными SEO-текстами сохраняли высокий рейтинг до тех пор, пока поисковые системы не закрыли этот пробел и стали ориентироваться на пользователей | Контент создается для пользователей и направлен на то, чтобы как можно полнее удовлетворить информационные потребности аудитории. При этом оптимизация под поисковые роботы сохраняется, но носит второстепенный характер и при высоком интересе может полностью игнорироваться |

| Поскольку контент затачивался под поисковых роботов, отпадала потребность в его структурировании, регулярном обновлении и использовании полезной информации. Если сайт оказывалась на нужных позициях, то никаких дальнейших шагов по его развитие не принималось | Поскольку все тексты пишутся для людей, то в них должна присутствовать структура и полезный материал. При этом важно, чтобы контент производился на постоянной основе и дополнялся изображениями или видео. Даже если сайт находится на нужных позициях, то важно сотрудничать с маркетологами, изучать новые потребности аудитории и быстро закрывать эти новые потребности через обновленный контент |

| Для продвижения использовалось большое количество внешней ссылочной массы от некачественных доноров — ссылки размещались на всех площадках, способных привлечь хоть какое-то количество трафика | Продвижение за счет ссылочной массы осталось, однако сейчас сделан упор только на качественные площадки, способных генерировать целевой трафик — то есть ссылки оставляются только там, где есть реальная аудитория. Для этого проводится аудит внешний ссылочной массы, позволяющий удалить бесполезные ссылки и поставить вместо них полезных доноров, обнаруженных у ближайших конкурентов |

| Рост поведенческих факторов обеспечивался за счет публикации подставных отзывов, кликов и статей. SEO-специалисты проводили исследования, находили новые пробелы в работе поисковых алгоритмов и применяли эти пробелы для продвижения. Если внедрить эти советы по поисковой оптимизации сейчас, то сайт гарантированно не попадет в ТОП и рискует навсегда вылететь из поисковой выдачи | Накрутка поведенческих факторов бесполезна, поскольку ключевым показателем SEO-стратегии становится ROI — условный показатель, оценивающий насколько выгодно владельцу сайта заниматься поисковой оптимизацией. Если сайт продвигается и приносит доход, то ROI и SEO-стратегия считается оправданной и наоборот. На смену накрутке и поиску уязвимости приходит глубокая проработка семантики проекта, затрагивающая поисковые подсказки, информационные, микро и низкочастотные запросы. Сюда жа добавляются различные виды юзабилити-тестирования, делающие сайте простым и удобным для пользователя |

| Если нет серьезных технических проблем, то опубликованная ссылочная масса и переизбыток ключевых запросов позволят сайту не потерять место в общем рейтинге | Увеличивает роль технического аудита: недостаточно просто исправить базовые проблемы и надеяться на внешние ссылки. Нужно прорабатывать множество мелких делателей, которые по отдельности мало заметны, но вместе дают результат. Также ценится использование автоматизированных систем, способных в круглосуточном режиме мониторить основные показатели сайта. Например, если какая-то страница вылетет из индексов поисковых систем, то вы об этом сразу узнаете и сможете принять меры |

| Используется простая поисковая оптимизация, которая внедряется обособленно и никак не влияет на рост продаж или повышение других конверсионных показателей сайта | Вместе с SEO-оптимизацией ведется работа над повышением конверсионных показателей сайта. Ключевая задача заключается в том, чтобы с помощью уже имеющегося трафика добиться от пользователей совершения как можно большего количества нужных целевых действий: больше заявок, покупок, звонков |

| Продвижение через социальные сети проводилось только в том случае, если это помогало лучше продвигать сайт | В обязательном порядке для продвижения используются как стратегии поисковых систем, так и популярные социальные сети |

Если подвести итог и выделить что-то одно, то главное отличие современной SEO-стратегии заключается в ROI — двигаясь в ТОП сайт должен приносить больше прибыли. Если поисковая оптимизация не приводит к лучшим финансовым результатам, то владельцу интернет-проекта стоит выделить бюджет на другие методы продвижения или сменить SEO-агентство. Теперь вы знаете, для чего используется SEO и на основе этих данных можно переходить к подробностям. Далее вы узнаете, как оптимизировать сайт для SEO и на что смотреть в отчете веб-аналитики.

Что такое SEO-оптимизация и почему ее нельзя сравнивать с контекстной рекламой

SEO-оптимизация — это комплекс действий, которые позволяют повысить рейтинг сайта по запрашиваемым ключевым словам в различных поисковых системах: N-е место в общем каталоге сайтов → ТОП-10 → ТОП-3 → ТОП-1. Если ввести в адресную строку любой запрос и дать команду «Найти», то перед первым местом в выдаче отобразится блок с контекстной рекламой — это сайты конкурентов, которые заплатили деньги за то, чтобы без SEO-оптимизации отобрать часть вашего трафика.

Здесь у многих владельцев сайтов возникают вопросы по поводу того, стоит ли заниматься SEO-продвижением, если нужный результат быстрее получить через контекстную рекламу. Однозначного ответа мы не знаем, поскольку все зависит от ситуации: если вы определились с тематикой и планируете работать в выбранном направлении не менее десяти лет, то стоит выбирать SEO. Если же вы только тестируете нишу, то удобней использовать контекстную рекламу. В любом случае метод продвижения всегда должен подбираться под поставленную задачу:

| SEO-оптимизация | Контекстная реклама |

| В ТОП-10 никогда не попадет некачественный сайт, контент которого не может ответить на прямые пользовательские запросы. Более того, даже хорошо спроектированный сайт с обновляемым контентом не всегда получится вывести в лидеры. Все из-за того, что поисковое продвижение — это сложный процесс, требующий постоянных усилий | Продвигаться с помощью контекстной рекламы может практически любой сайт, которые не заниматься никакой противозаконной деятельностью. Для этого достаточно настроить и оплатить нужное количество рекламных объявлений |

| Если ниша не слишком перенасыщена, то на попадание в ТОП-10 в среднем уходит 2-4 месяца. Если же в нише сильная конкуренция, то средний срок продвижения растягивается до 6-12 месяцев. В некоторых случаях на первый результат можно рассчитывать спустя несколько лет — здесь все зависит исключительно от уровня конкурентов | Всю процедуру можно провести за один день |

| Если инвестировать ресурсы в SEO-продвижение, то сайт сможете занимать высокие позиции одновременно во всех существующих поисковых системах. Отсюда же будет идти органический трафик, за который не нужно никому доплачивать | Если купить рекламу только в Яндекс Директ, то на первых позициях сайт будет показываться только в Яндексе. Чтобы развиваться в других поисковых системах, нужно заниматься SEO-оптимизацией или приобретать рекламу в нужных поисковиках |

| Если на какое-то время вы перестанете развивать сайт, то даже при смене поисковых алгоритмов и активных действиях конкурентов часть трафика сохранится. Сайт будет удерживаться за счет уже проделанной работы и не затеряется в каталоге выдачи | Все рекламные объявления исчезнут сразу после того, как вы не внесете оплату за их размещение. В этом случае если на сайте не проводились работы по поисковой оптимизации, то он рискует провалиться в каталоге выдачи и потерять весь трафик |

Владельцы новых сайтов часто совмещают контекстную рекламу и поисковое продвижение — такой подход называется SEM или маркетинговое определение SEO. Работает это по такой схеме: сначала почти всю посещаемость обеспечивает реклама → после срабатывает оптимизация и весь трафик достается бесплатно → контекстная реклама убирается → высвободившиеся деньги направляются в бизнес или на продвижение сайта по новым поисковым запросам. Все упирается в задачу.

Основные составляющие SEO-оптимизации сайта

Чтобы определить основные составляющие поисковой оптимизации, нам нужно понять алгоритм, по которому выстраивается SEO-ранжирование сайтов:

- Роботы поисковых систем регулярно обходят интернет, сохраняя у себя информацию обо всех существующих сайтах.

- На основе собранных данных каждому сайту присваивается значение, которое можно сравнить с предметным указателем в книге. Разница в том, что у пользователей есть возможность находить нужные сайты не только по названию, но и по внутреннему содержимому — контенту.

- Далее происходит ранжирование сайтов. Для этого используются сложные формулы, которые постоянно обновляется, состоят из сотни параметров и не дублируются в других поисковых системах.

- Проранжированные сайты ежедневно изучаются поисковыми роботами на предмет поведенческих факторов — здесь анализируется информация о том, как пользователи работают с сайтом: куда смотрят, что пропускают и из-за чего покидают ресурс.

- Когда на каком-то проранжированном сайте роботы наблюдают положительную динамику поведенческих факторов — сайт набирает позиции и поднимается в поисковой выдаче. Если же динамика поведенческих факторов снижается — сайт теряет позиции и опускается в рейтинге.

Если опираться на описанный алгоритм, то качество поисковой оптимизации зависит от контента и юзабилити:

| Контент | Юзабилити |

| На сайте должна размещаться уникальная информация, которая содержит полезные сведения и полностью отвечает на введенный запрос. Сейчас принято создавать длинные публикации, требующие внимательного изучения и подробно раскрывающие тему. Приветствуется видео, аудио и графика — чем больше времени пользователь проведет на сайте, тем более ценным этот сайт будет оценен со стороны поисковых систем. Это означает, что при следующем аналогичном запросе такой сайт укрепить свои позиции и может закрепиться в лидерах выдачи | Сайт не должен содержать вирусов и отображаться в виде простой одностраничной картинки (флэша). Также на сайте не должно быть поврежденных элементов, неработающих ссылок и других подобных проблем. Если что-то не будет работать, то даже при качественном контенте сайт получит низкую SEO оценку. Также важно, чтобы пользователю было удобно ориентироваться и он мог легко найти нужную информацию — подробней об этом читайте в статье «Что такое тестирование юзабилити сайта и как его проводить?» |

Чтобы оценивать качество контента и юзабилити, необходимо регулярно проверять сайт по основным конверсионным показателям: если цифры возрастают, то SEO-оптимизация проводится правильно. Подробней об этом читайте в статье «Что такое оптимизация конверсии сайта и как она влияет на увеличение продаж».

Общее руководство по внедрению SEO-стратегии

В этом разделе будут представлены основные этапы поисковой оптимизации любого веб-сайта. Во время изучения материала имейте в виду, что эти этапы могут меняться в зависимости от проекта, конкуренции, аудитории и прочих деталей.

Сделайте аудит текущих позиций сайта. Оптимально, когда стратегия поисковой оптимизации составляется до запуска сайта. В этом случае SEO-специалист помогает сэкономить время, избежать необязательных проблем и сохранить бюджет:

- Вначале отбираются приоритетные тематики, по которым можно продвигать сайт. После по каждой тематике проводится анализ сезонности и оценивается влияние других факторов на качество поискового трафика. Крупным интернет-магазинам этот пункт помогает составить долгосрочную стратегию продвижения по всем категориям товаров, а у других сайтов появляется возможность сделать прогноз трафика после внедрения SEO-стратегии.

- Прорабатывается структура сайта. Это один из самых объемных видов работ, поскольку здесь заранее нужно просчитать, как в удобном порядке опубликовать большое количество материала. Здесь же необходимо помнить о том, что после реализации запланированной SEO-стратегии может понадобится новый материал, который также нужно гармонично вписать в сайт. Ситуация усложняется, когда владелец ресурса уже согласовал структуру и она не соответствует требуемому плану поисковой оптимизации.

- Разрабатывается семантическое ядро. Здесь специалист проводит детальное исследование пользовательских запросов и готовит подборку ключевых слов.

- Готовится техническое задание для публикации первых SEO-текстов на сайте.

- Проводится SEO-анализ и исправляются мелкие технические детали. Этот этап позволяет выявить недоработки первых текстов и сделать так, чтобы в будущем на сайте появлялся правильно оптимизированный SEO-контент.

Если сайт уже запущен, то первичный алгоритм SEO-специалиста будет другим:

- Проводится анализ рейтинга сайта по его исходным позициям. Вначале идет проверка ключевых слов по высоко-, средне- и низкочастотным запросам. Далее изучаются конкуренты: проверяется их тематика, ссылочный профиль, структура и основные посадочные страницы. После основная тематика сайта сопоставляется с данными поисковой выдачи — здесь исследуется пользовательский спрос и оценивается фактор сезонности. Когда отчет об анализе сайта сформирован, SEO-специалист может разработать подходящую стратегию продвижения и просчитать бюджет на ее реализацию.

- Корректируется структура и исправляются критические ошибки проекта.

- Проводится анализ ключевых слов сайта и разрабатывается новое семантическое ядро.

- В соответствии с обновленным семантическим ядром корректируются уже опубликованные SEO-тексты и готовится техзадание для следующих публикаций.

- Проводится разъяснительная беседа со штатными копирайтерами и всеми сотрудниками, которые готовят контент для сайта. После этой беседы каждый автор должен понять, какая польза от поисковой оптимизации и каким стандартам должен соответствовать каждый текст. Чтобы быстро получить нужный эффект — достаточно оформить общий чек-лист, где в краткой форме перечислить все озвученные требования по SEO-копирайтингу.

Чем раньше на сайте появится SEO-стратегия оптимизации, тем быстрее появится первый результат и бесплатный органический трафика из поиска. Точных сроков здесь нет, поскольку все зависит от сложности проекта, от его технического состояния и от скорости, с которой программисты смогут внедрять предложенные рекомендации.

- Проведите аудит внутренней оптимизации. Пересмотрите существующие адреса страниц и сделайте так, чтобы у каждой ссылки был читаемый вид. С помощью фильтров пропишите правила добавления новых URL-адресов, тегов и прочих видимых ссылок. Удалите дублирующие страницы, добавьте карту сайта, проверьте скорость загрузки основных страниц и время ответа сервера. По мере необходимости настройте мультиязычность, пагинацию, добавьте микроразметку отзывов и дополнительную информацию на все страницы с карточками товаров.

- Настройте внутреннюю перелинковку. Грамотно организованные внутренние ссылки связывают все содержимое сайта в одну логическую цепочку, упрощают навигацию и помогают продвигать основные страницы — чем больше ссылок идет на какую-то страницу, тем более значимой она становится для поисковых систем.

- Организуйте контентную SEO-оптимизацию. Пересмотрите тексты в основных разделах и страницах сайтах. Убедитесь в отсутствии переспама ключевых слов и проследите за тем, чтобы каждая статья была написана понятным языком. Проставьте подписи ко всем изображениям, схемам и видео. Оцените верстку и проверьте заголовки Н1-Н6. Проверьте метатеги тайтл и дескрипшн: убедитесь в их наличии и при необходимости установите плагин для их автоматической генерации.

- Настройте индексацию. В корневой системе сайта должны находится файлы robots.txt и sitemap.XML, которые помогут сэкономить краулинговый бюджет. Файл robots.txt показывает поисковому роботу те страницы, которые нужно индексировать и оставить нетронутыми. Файл sitemap.XML помогает лучше ориентироваться в структуре сайта. Краулинговый бюджет определяет максимальное количество страниц, которые робот может охватить за одно посещение сайта. Если краулинговый бюджет наполняется мусорными страницами, то часть оптимизированных страниц могут не попадают в поиск. В итоге из-за ненастроенной индексации поисковые роботы добавят в каталог множество служебных страниц, превысят краулинговый бюджет и затормозят продвижение сайта.

- Выполните аудит юзабилити. Оцените дизайн, цветовую гамму, шрифты, навигацию, качество изображений, структуру текстов, логику меню и прочие элементы, отвечающие за удобство сайта. Отдельно проверьте сайта на совместимость с мобильными устройствами — в 2020 году более 60% трафика идет со смартфоном и только 20% сайтов под них адаптированы. Важно все сделать так, чтобы у пользователей не возникало потребности возвращаться в поиск и искать информацию на другом ресурсе. Подробно вопросы юзабилити-тестирования мы разбирали в статье «Что такое тестирование юзабилити сайта и как его проводить?». В этой же публикации вы сможете посмотреть примеры тестирования юзабилити и познакомиться с инструментами исследования UX.

- Проведите отчет и настройте внешнюю оптимизацию. Подберите проверенные площадки с реальной аудиторией, которая позволит продвигать сайт путем наращивания качественной ссылочной массы: больше тематических площадок → больше кликов со стороны заинтересованной аудитории → большая значимость сайта в глазах поисковых роботов → более быстрое поисковое продвижение.

- Установите конверсионные показатели. На этом этапе привлекаются дополнительные специалисты и устанавливаются дополнительные метрики, оценивающие качество поискового продвижения:

| Попадание сайта в ТОП-3 | Попадание сайта в ТОП-3 |

| ↓ | ↓ |

| Увеличение заказов | Увеличение заказов |

| ↓ | ↓ |

| Рост прибыли | Уменьшение прибыли |

| ↓ | ↓ |

| Внедрение SEO-стратегии увеличило конверсию продаж — сайт развивается правильно и нужно придерживаться плана | SEO-стратегия снизила конверсию продаж — сайт развивается неправильно, поэтому нужно искать ошибку или менять план |

Помимо конверсии продаж существует множество других показателей, способных проверить эффективность сайта и качество запланированных целевых действий. Если интересно — смотрите статью «Что такое оптимизация конверсии сайта и как она влияет на увеличение продаж».

- Выполните поэтапную постраничную оптимизацию. Постраничная оптимизация — это вынужденная процедура, которую придется проводить каждый раз, когда произойдут существенные изменения в алгоритмах поисковых систем. Например, если Яндекс перестанет индексировать статьи без видео, то вам придется вручную отредактировать каждый опубликованный текст и добавить в него тематический ролик. Если этого не сделать, то сайт быстро потеряет набранные позиции и уступит место более оптимизированным ресурсам. Чтобы этого не допустить — важно проводить регулярный аудит. Он поможет не терять трафик, исправить текущие ошибки и своевременно узнавать о новых правилах поисковой индексации.

Как проводить SEO-аудит сайта

Аудит сайта — это многоэтапная проверка, которую рекомендовано проводить хотя бы один раз каждые 1-3 месяца. Аудит решает сразу целый комплекс задач:

- Можно устранить очевидные технические проблемы.

- Получить дополнительные рекомендации для проведения постраничной оптимизации.

- Улучшить коммерческие и поведенческие факторы.

- Проработать ссылочную массу: удалить нерабочие ссылки, отказаться от спамных доноров и найти качественные рекламные площадки.

- Расширить семантическое ядро: внедрить новые разделы, подготовить новую семантику, дополнить сайт текстами и полезным функционалом.

Ниже опубликован алгоритм комплексного аудита, состоящий из шести условных этапов. Все эти этапы носят рекомендательный характер и могут внедряться только по желанию владельца сайта. Хотите развиваться — пробуйте все. Если нет времени — сразу переходите к техническому аудиту. Техническая проверка позволит обнаружить ключевые проблемы и на какое-то время сохранит сайту его исходные позиции.

Этап №1. Проанализируйте спрос и конкурентов. Изучаем географию пользователей, определяем средний возраст аудитории и вычисляем те устройства, с которых чаще всего выполняется вход на сайт. Оцениваем удобство пользования сайтом. Анализируем интересы аудитории и проверяем, чтобы эти интересы соответствовали тематики сайта. Расширяем семантику: собираем неиспользованные запросы из готовые семантического ядра, ищем новые ключевые слова через Google AdWords,Wordstat или любой другой планировщик ключей. Получаем отчет и на основе собранных данных создаем дополнительные разделы, посадочные страницы и публикации.

Вручную или через специальные сервисы составляем список конкурентов и собираем информацию о возрасте сайта, количеству проиндексированных страниц и количеству обратных ссылок. Соотносим собранные параметры с количеством органического трафика и ранжируем сайты в порядке от большего к меньшему. Особое внимание обращаем на лидеров: смотрим типовые страницы, изучаем интересный функционал, контент и пробуем понять, за счёт чего эти сайты удерживают пользователей. Все интересные решения тестируем на собственном сайте. Лучшие оставляем.

Этап №2. Проведите технический аудит сайта и получите отчет. Технический аудит — это та часть проверки, под которой чаще всего подразумевают SEO-аудит сайта. Здесь нужно проверить индексацию страниц, убрать дубли, оценить состояние технических файлов и убедиться в безопасности сайта. Вот общая схема проверки:

- Сначала проанализируйте все отчеты о рейтинге веб-страниц в панели вебмастеров Яндекса, Гугла, Bing и других используемых поисковых системах. Обращайте внимание на ошибки и способы их исправления.

- Проверьте индексацию страниц. Здесь посмотрите на код ответа сервера, на наличие битых ссылок, на необходимость использования редиректа и на адреса внешних ссылок. Зафиксируйте ошибки, переведите этот анализ страниц в форму отчета и передайте файл разработчикам.

- Отдельно изучите страницы, которые не проиндексировались в Яндексе, в Гугле или в обоих системах сразу. Чаще всего это происходит из-за проблем с файлом robot.txt или из-за того, страница не релевантна и не отвечает на введенный пользовательский запрос. Иногда страница попадает под поисковые санкции и закрывается для показа — в каждом случае нужен индивидуальный анализ, который позволит определить настоящую проблему.

- Проверьте сайт на наличие дублей, неполных дублей и зеркал. Дубли — это точные копии какой-то из страниц сайта, которые в поисковой выдачи отображаются под разными URL-адресами. Неполные дубли — это фрагменты контента, которые полностью повторяются на разных страницах сайта. Зеркала — это сайты с разными адресами и полностью одинаковым наполнением. Дубли удаляем, делаем редирект или пробуем закрыть любым другим способом. Неполные дубли удаляем или дорабатываем, чтобы продублированный контент стал уникальным. Сайты-зеркала склеиваем. Если с описанной проблемой ничего не делать, то поисковая система может неправильно определить релевантность страниц и сайт будет плохо индексироваться — в выдачу попадут те страницы, которые негативно повлияют на поведенческий фактор и снизят общий рейтинг ресурса.

- Вручную или с помощью валидаторов проверьте служебный файл robots.txt. В файле должны быть закрыты только те страниц, которые не должны попадать под наблюдение поисковых роботов.

- Проверьте файл Sitemap. Обратите внимание на корректность постановки дат, атрибутов и приоритетов. Посмотрите, чтобы путь к Sitemap был указан в файле robots.txt и отображались только те страницы, которые нуждаются в индексации. Прогоните файл Sitemap через валидатор и убедитесь в отсутствие других системных ошибок.

- Проверьте скорость работы сайта. Здесь нужно протестировать как главную страницу, так и основные разделы сайта. Проверенные страницы рассортируйте по времени загрузки и определите самые медленные страницы. Пересмотрите выбранные страницы и найдите причину их долгой загрузки. Если нужны сервисы — посмотрите статью «10 лучших сервисов для определения скорости работы сайта».

- Оцените верстку сайта. Для этого необходимо проверить сайт в различных браузерах, на различных разрешениях экрана и на различных устройствах. После общей проверки нужно вручную пройтись по всем типовым страницам и убедиться в работоспособности всех элементов.

- Проверьте удобство использования сайта мобильными пользователями. Здесь нужно использовать валидаторы, которые покажут корректность отображения всех страниц сайтах на разных устройствах и разных операционных систем. После программного теста эти же действия желательно повторить вручную.

- Проанализируйте микроразметку. Для этого просканируйте сайт через валидатор, выделите страницы с микроразметкой и исправьте ошибки.

- Введите название сайта или компании в поисковую систему и убедитесь в отсутствии негативных отзывов. Если отрицательные отзывы есть, то на них нужно реагировать: можно дать аргументированный ответ, договориться об удалении комментария или принять любые другие меры. В случае бездействия могут снизиться основные конверсионные показатели.

- Проверьте сайт на наличие вирусов и на присутствие в различных спам-базах.

- Проверьте IP-адреса соседних сайтов — если кто-то занимается мошенничеством, то лучше подобрать новый IP-адрес.

- Убедитесь в использовании качественных внешних ссылок.

- Проанализируйте поведенческие факторы и убедитесь, что никто из команды не занимается накруткой этого показателя.

В конце технического аудита вбейте в поиск свои контактные данные и убедитесь в том, что они не используются на чужих ресурсах. Если используются — срочно принимайте меры по их удалению: начните с телефонного звонка или письменного обращения. Если не помогает — обращайтесь к юристам и готовьтесь к суду.

Этап №3. Выполните анализ постраничной оптимизации. Перечислим основные параметры, которые нужно проверить для каждой страницы:

- Проанализируйте URL-адреса. Их рекомендовано составлять на транслите, делать не слишком длинными, наполнять интентами и ключевыми словами. В промежуток между словами лучше вставлять дефис вместо пробела. Также нужно следить за переспамом: если в названии домена используется определенный ключ, то это же ключ не стоит использовать в URL-адресе.

- Проверьте тайтл и дескрипшн. Тайтл должен ограничиваться 60 символами, должен содержать ключевые слова, интенты и быть привлекательным для клика. Дескрипшн должен состоять из коротких информативных предложений (до 155 символов), которые содержат ключевые запросы и дополняют тайтл.