Проверить сайт на уникальность на antiplag.ru

Специальное приложение на сайте antiplag.ru помогает всем пользователям начиная от учащихся высших учебных заведений до владельцев веб-ресурсов, проверить сайт на уникальность. Сегодня анализ контента сайта является обязательным для всех веб-ресурсов, статей и научных работ. Высокий процент уникальности контента – это гарантия того, что он не был украден с какого-либо сайта или у определенного автора. Учитывайте, работа может считаться оригинальной лишь после проверки на плагиат.

По этой причине предлагаем вам набор услуг сервиса antiplag.ru, который позволяет провести детальный анализ страницы сайта онлайн и определить процент оригинальности текста. Для чего еще необходимо проводить анализ контента сайта?

Анализ страницы сайта позволяет увидеть все недоработки и погрешности исполнителя (рерайтера, копирайтера или веб-мастера). С помощью антиплагиат-сервиса вы можете вовремя их исправить и улучшить индексацию своего веб-ресурса.

Что это дает и зачем нужен анализ контента сайта? Очень низкий или, наоборот, высокий процент плотности ключей, способен спровоцировать поисковую систему к наложению фильтров. А после такого решительного шага в поисковой выдаче ваш веб-ресурс показываться не будет. Анализ контента сайта онлайн проверяет странички оперативно, детально и показывает: общую информацию и сведения о заголовке, размер статьи, количество символов и процент релевантности ключевых слов.

Один из главных показателей качества сайта – это уникальные тексты. Но увлекательного контента недостаточно, правильно должна быть создана вся структура сайта с помощью текстов. Интересные статьи исключительно на главной странице тоже не повысят рейтинг веб-ресурса, если на остальных страницах будут размещены некачественно выполненные работы. Чтобы ваш веб-ресурс функционировал на 100% и занял высокие позиции в поиске, необходимо проверить сайт на уникальность полностью и уделить должное внимание каждой детали. Тогда вероятность успеха гораздо выше!

Чтобы ваш веб-ресурс функционировал на 100% и занял высокие позиции в поиске, необходимо проверить сайт на уникальность полностью и уделить должное внимание каждой детали. Тогда вероятность успеха гораздо выше!

Если вы являетесь счастливым обладателем собственного сайта, то будете стараться разместить на ресурсе только необычные тексты. Напишите статью самостоятельно или поручите копирайтеру, но после в любом случае необходимо проверить сайт на уникальность контента. Нелишним будет проверить сайт на уникальность с уже размещенными текстами. Это позволит удостовериться в том, что вы не нарушили авторское право других ресурсов и не подвергнетесь за это фильтру или низкому ранжированию в поисковой системе.

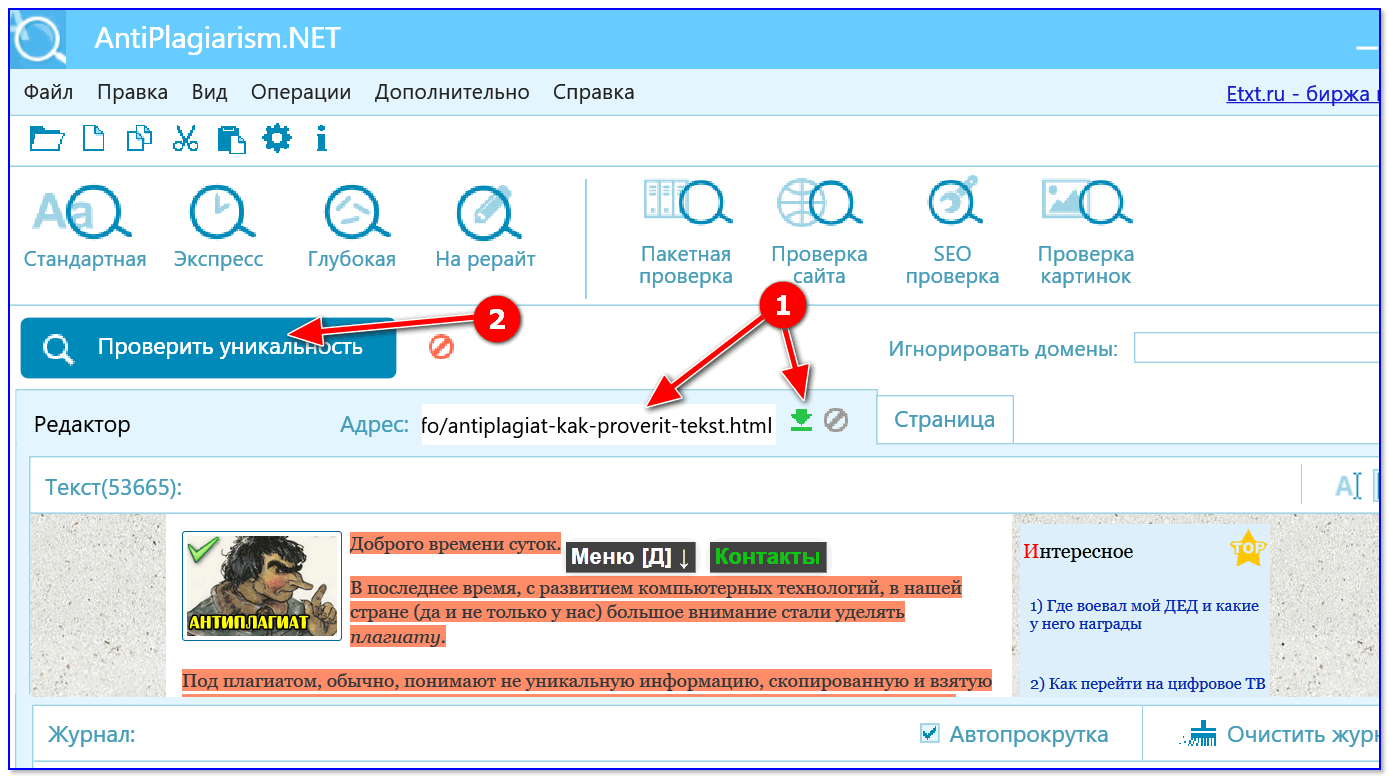

Если появилась необходимость полностью проверить сайт на уникальность контента, воспользуйтесь пакетной проверкой antiplag.ru. Так, вы сможете своевременно исправить погрешности или маленькие недоработки незамедлительно!

Загрузите файл для повышения

Выберите файл

Узнай

стоимость своей работы!

Укажите тип работыДипломная работаЧасть дипломной работыДиплом МВАОтчёт по практикеКурсовая теорияКурсовая с практикойРефератЭссеЗадачиКонтрольная работаВопросы к экзаменуТестСопроводительные материалы к дипломуРеферат для аспирантурыБизнес-планЧертежиПрезентация в PowerPointПоиск информацииДругое

СрокСдачиЯнварьФевральМартАпрельМайИюньИюльАвгустСентябрьОктябрьНоябрьДекабрь

Где и как проверить текст на антиплагиат? Средства проверки уникальности текста

Изучить контент на уникальность в интернете можно несколькими способами:

- специальными программами;

- онлайн-сервисами;

- через поисковики.

Последний вариант чаще всего используется «с противоположной стороны»: для поиска цитат, книг, при указании формулировок афоризмов. Этот метод не подходит для текстов. Почему? Потому что при анализе статьи хотелось бы видеть не только наличие аналогичных текстов, но и процент неуникальных фраз и фраз, которые испортили статистику, а так же обороты, способы исправления и некоторую дополнительную информацию.

Это все поисковик не предоставляет. Потому оптимизаторы, веб-мастера, копирайтера, владельцы сайтов обращаются к онлайн-сервисами, программам, созданными специально для проверки контента на уникальность.

Зачем все это надо?

Неповторимость и актуальность контента стали не просто причинами ранжирования. Методы семантического анализа от главных поисковых систем шагнули очень далеко. Принципиально понимать, что обычной уникальности сегодня мало для того, чтоб поисковику понравился ваш контент. Базируясь на моделях LSI, Google и Yandex непрерывно улучшают способы оценки релевантности текста по тому либо другому запросу.

Что такое плагиат?

Дублированный контент с точки зрения поисковой системы плагиат — наверное расположение уже знакомого ей контента на ином ресурсе. Вроде бы все достаточно элементарно, однако тут принципиально обратить внимание на некоторое количество факторов:

1. Первоисточником (автор) считается тот веб-ресурс, в каком месте поисковый робот в первый раз нашел контент. Часто сайты, которые скопировали контент с вашего ресурса, могут проиндексироваться быстрее и конкретно он станет считаться первоисточником. Наверное достаточно известная проблема для интернет магазинов с выгрузкой продуктов партнерам в реальном времени — почти все ваши странички будут проиндексированы позднее, нежели на партнерских ресурсах и плагиатором для станет как раз ваш сайт.

2. Ничего ужасного в том, что контент с вашего интернет-сайта скопировали нет, если поисковая система будет считать ваш ресурс первоисточником.

3. Поисковики легко могут распознать некачественный рерайт, а сервисы для проверки текстов на уникальности далеко не идеальны.

Методы для уникализации текстов

Сейчас в интернете имеется немало бесплатных и коммерческих сервисов для проверки контента. Рабочий процесс всех инструментов для определения плагиата включают в себя использование шингловых либо корреляционных алгоритмов. Данные способы различаются принципами работы:

Шингловые методы выявляют совпадения текстовых фрагментов. В процессе проверочных действий из текста удаляются все стоп-слова. Дальше оставшийся использованный материал разбивается на шинглы. Ведется отбор фраз для поисковиков. На основании приобретенных предложений происходит сопоставление с информацией в вебе. После некоторого периода сверки юзер узнает уникальность текста. Финальный результат проверочных действий еще содержит неуникальные фразы и гиперссылки на странички с ними. На основании полученных данных копирайтер имеет возможность изменить исходник и повысить процент уникальности.

Финальный результат проверочных действий еще содержит неуникальные фразы и гиперссылки на странички с ними. На основании полученных данных копирайтер имеет возможность изменить исходник и повысить процент уникальности.

Корреляционные (нешингловые) методы проводят проверку уникальность статей иным методом. Они выявляют не однотипные предложения и сочетания слов, а сходство значения. Данные методы еще жестче, так как сравнивают использованные материалы полностью, а никак не фрагментарно.

Процедура написания уникального текста

Процесс уникализации текста достаточно трудозатратный процесс, легче написать новый контент с нуля, нежели уникализировать готовый.

Но если вы все же будете уникализировать уже написанный контент, то необходимо его элементарно прочесть и переработать собственными словами. А позже проверить сервисами на уникальность и исправить те проблемы где неуникальные предложения.

Можете следовать таким советам:

- уменьшить использование технических терминов и спец слов;

- исключайте цитаты, известные фразы, нормативные документы;

- можно заменять цифры на буквенные значения.

Однако в данном случае контент становится наиболее водянистым и малосодержательным. А это плохо.

Теперь рассмотрим, как составить уникальный контент для интернет-сайта с нуля. Для начала взглянем ТОП 10 конкурентов, смотрим какой контент они делают, позже на основе них составляем план статей.

Далее по плану просто раскрываем каждый пункт, прибавляем свой стиль. Получается не просто еще одна статья, а со своим стилей и подачей.

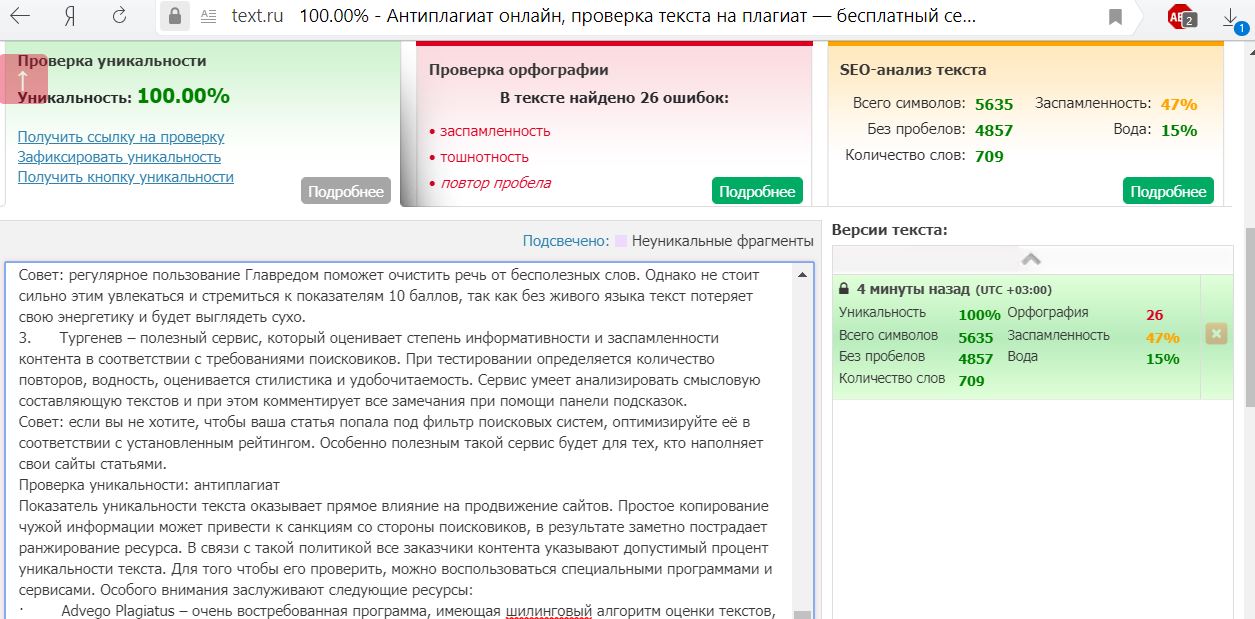

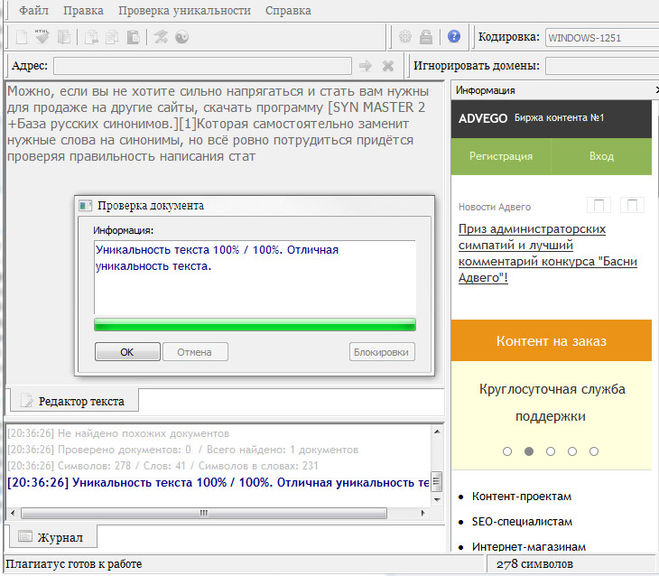

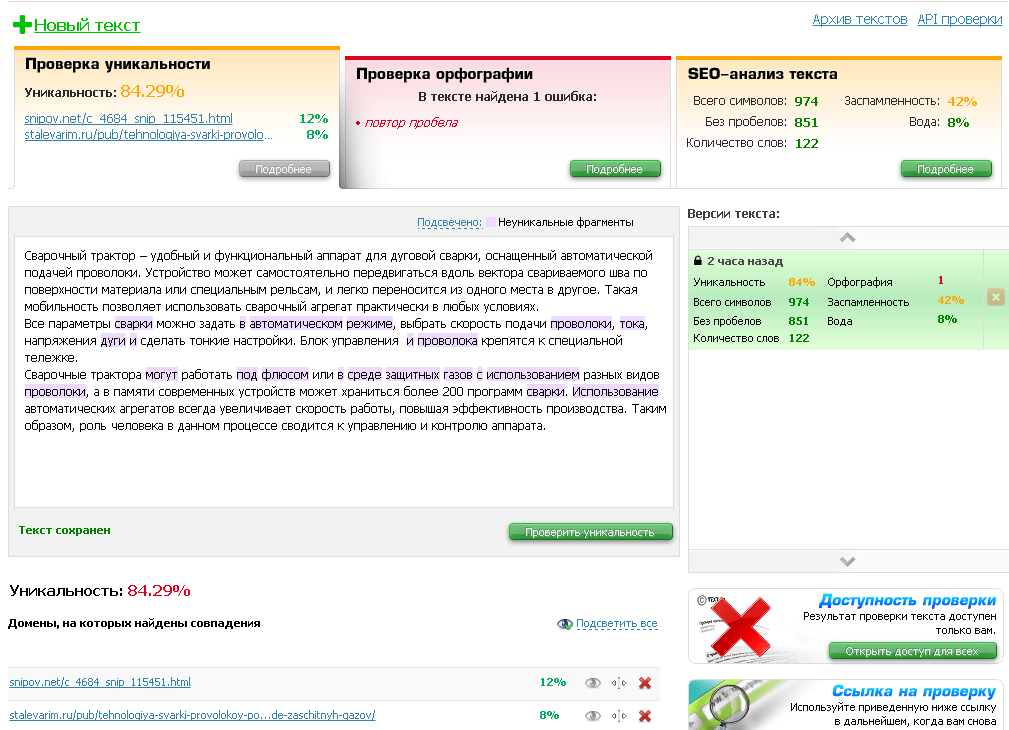

После написания текста ее нужно проверить на уникальность. Сейчас есть множество как платных, так и бесплатных сервисов. Вы с легкостью выберете подходящее решение с помощью нашего рейтинга, где собраны все самые лучшие сервисы для проверки текстов на уникальность и не только. Вы сможете отфильтровывать и скорректировать сервисы подходящие под ваши критерии, и почитать отзывы от других юзеров.

Как проверить наличие дублирующегося контента во время SEO-аудита

Различные типы проблем с контентом могут досаждать сайту — от проблем с контентом на основе URL-адресов до физического дублированного контента, фактически реплицируемого со страницы на страницу без многих изменений.

Как будто этого было недостаточно, у вас есть другие проблемы с дублированием контента, связанные с WordPress, такие как дублирование контента на страницах продуктов и страницах категорий.

Выявление проблем с дублированием контента является важной частью вашего SEO-аудита.

Вот что вам нужно проверить и как это сделать.

Быстрое выявление проблем с дублированием контента на вашем сайте

Как проверить

Использование инструмента Siteliner.com (разработанного Copyscape) может помочь быстро выявить проблемы с дублированием контента на вашем сайте.

Наглядное представление, показывающее, какие страницы имеют процент совпадений и какие страницы соответствуют другим страницам.

Определите, какие страницы вашего сайта дублировались в Интернете

Как проверить

- Используйте Copyscape, чтобы проверить и увидеть, какие страницы вашего сайта были продублированы в Интернете. Copyscape считается одним из стандартных инструментов аудита в кругах SEO.

Этот инструмент может помочь вам идентифицировать дублированный контент по всему сайту, используя функцию частного индекса их премиум-сервиса.

Этот инструмент может помочь вам идентифицировать дублированный контент по всему сайту, используя функцию частного индекса их премиум-сервиса. - Чтобы охватить все ваши базы, проверьте индекс Google на предмет плагиата содержимого вашего сайта со всего Интернета. Выберите часть текста, которую хотите проверить, и просто скопируйте/вставьте ее в строку поиска Google. Это должно помочь вам определить случаи кражи.

Проверка URL-адресов на наличие повторяющегося содержимого

Выявление повторяющегося содержимого не ограничивается только текстовым содержимым страницы.

Проверка URL-адресов, ведущих к дублирующемуся контенту, также может выявить проблемы, вызывающие большие затруднения у Google при сканировании вашего сайта.

Проверьте и исследуйте следующее:

- Каковы последние обновления содержимого.

- Количество обновлений контента.

- Историческая тенденция обновлений страниц.

Как проверить

В Screaming Frog прокрутите до упора вправо, и вы найдете столбец «Последнее изменение». Это может помочь вам:

Это может помочь вам:

- Определить последние обновления контента и масштабы обновлений контента на сайте.

- Разработать исторические тенденции обновлений страниц.

Если вы одержимы своими конкурентами, вы можете ежемесячно сканировать их и хранить эти данные под рукой, чтобы определить, что они делают.

Было бы довольно легко анализировать и обновлять эти данные в таблице Excel, а также определять исторические тенденции, если вы хотите увидеть, что делают конкуренты с точки зрения разработки своего контента.

Это может оказаться бесценной информацией.

Что проверять

- Синдицированный контент.

- Полезный дополнительный контент.

Понимание того, как контент сегментируется на сайте или каким-либо образом синдицируется, полезно для разделения исходного контента на сайте от синдицированного контента на сайте, особенно когда синдицированный контент является важной функцией сайта.

Этот прием особенно полезен для выявления неполноценного контента и создания пользовательских фильтров для поиска полезного дополнительного контента.

Известность ключевого слова

Приведенный выше прием для создания настраиваемых фильтров также может помочь вам определить известность ключевого слова, когда ключевое слово появляется в первых 100 словах содержимого страницы.

Ключевое слово в тегах h2, h3, h4

В Screaming Frog щелкните вкладку h2 и посмотрите на теги h2, h3 и h4.

Кроме того, вы также можете нажать на вкладку h3. Кроме того, вы можете настроить собственный фильтр для определения тегов h4 на сайте.

Что проверять

- Порядок слов в ключевом слове.

- Грамматика и правописание.

- Уровень чтения.

Выявление проблем с грамматикой и орфографией на вашем сайте во время аудита сайта не является идеальным и может быть болезненным, но сделать это до публикации контента — это хороший шаг к тому, чтобы убедиться, что ваш сайт работает стабильно.

Если вы не являетесь профессиональным писателем, используйте приложение Hemingway для редактирования и написания своего контента.

Это может помочь выявить основные проблемы перед публикацией.

Количество исходящих ссылок

Количество исходящих ссылок на странице может влиять на производительность страницы.

SEO-специалисты уже давно считают лучшим правилом не превышать 100 ссылок на страницу.

В то время как Google заявил, что требование ограничения исходящих ссылок до 100 ссылок на страницу было удалено, есть противоречивые заявления.

Джон Мюллер заявил, что исходящие ссылки не являются фактором ранжирования. Что он?

Полезно посмотреть тематические исследования, проведенные другими, чтобы найти ответы:

RebootOnline.com провел исследование, которое противоречит этому:

«Результаты очевидны.

Исходящие релевантные ссылки на авторитетные сайты учитываются в алгоритмах и положительно влияют на ранжирование».

Контекст важен, потому что 100 исходящих ссылок на странице могут быть чем угодно: от 100 навигационных ссылок до 100 ссылок, собранных исключительно для фермы ссылок.

Идея состоит в том, чтобы проверить качество этих ссылок, а также их количество.

Если вы видите что-то странное с количеством ссылок, это заслуживает дальнейшего изучения как их качества, так и количества.

Если вы хотите выполнить проверку бонуса, вы всегда можете проверить это в Screaming Frog, хотя обычно это больше не требуется.

Как проверить

В Screaming Frog после того, как вы определите страницу, на которую хотите проверить исходящие ссылки, щелкните URL-адрес в главном окне, затем щелкните вкладку Исходящие ссылки.

Кроме того, вы можете нажать Массовый экспорт > Все исходящие ссылки , если вам нужен более быстрый способ определения исходящих ссылок для всего сайта.

Количество внутренних ссылок, указывающих на страницу

Чтобы определить количество внутренних ссылок, указывающих на страницу, щелкните URL-адрес в главном окне Screaming Frog, затем щелкните вкладку «Внутренние ссылки».

Вы также можете щелкнуть Массовый экспорт > Все входящие ссылки , чтобы определить входящие ссылки для всего сайта на все страницы сайта.

Качество внутренних ссылок, указывающих на страницу

Используя экспортированный документ Excel из шага, когда мы массово экспортировали ссылки, легче судить о качестве внутренних ссылок, указывающих на каждую страницу сайта:

Неисправен Ссылки

Выявление неработающих ссылок в ходе SEO-аудита может помочь вам найти страницы, которые отображаются в Google как неработающие, и даст вам возможность исправить их до того, как они станут серьезными проблемами.

Как проверить

После того, как Screaming Frog завершит сканирование вашего сайта, щелкните вкладку «Внутренние», выберите «HTML» в раскрывающемся меню «Фильтр:» и отсортируйте страницы по коду состояния.

Это упорядочит страницы в порядке убывания, чтобы вы могли видеть все страницы с ошибками перед живыми страницами 200 OK.

В этой проверке мы хотим определить все 400 ошибок, 500 ошибок и другие ошибки страницы.

Для некоторых ссылок, в зависимости от их контекста, безопасно игнорировать 400 ошибок и позволить им выпасть из индекса Google, особенно если это было давно и вы не нашли их в индексе Google.

Но если они являются проиндексированными и были проиндексированы какое-то время, вы, вероятно, захотите перенаправить их по правильному адресу.

Партнерские ссылки

Если целью вашего аудита является выявление и удаление партнерских ссылок с веб-сайта с большим количеством партнеров, то следующий совет является хорошим путем.

Как проверить

Партнерские ссылки, как правило, имеют общий реферер или часть их URL-адреса, которые идентифицируются на многих различных веб-сайтах.

Использование пользовательского фильтра может помочь вам найти эти ссылки.

Кроме того, используя условное форматирование в Excel, вы можете отфильтровать партнерские ссылки и определить, где они находятся в массовом экспорте из Screaming Frog.

Длина URL-адреса

Чтобы идентифицировать URL-адреса длиной более 115 символов в Screaming Frog, щелкните вкладку URL-адрес, щелкните Фильтр, затем щелкните Более 115 символов.

Это даст вам все URL-адреса на сайте, которые содержат более 115 символов, и может помочь вам выявить проблемы со слишком длинными URL-адресами.

Категория страниц

Для общего обзора категорий страниц полезно определить главные страницы сайта с помощью раздела структуры сайта Screaming Frog, расположенного в крайнем правом углу инструмента паука.

Как проверить

Используя вкладку структуры сайта, вы можете определить самые популярные URL-адреса на сайте, а также категории, к которым они относятся. Кроме того, вы можете определить проблемы со временем отклика страницы на вкладке времени отклика.

Авторы изображений

Избранное изображение: Пауло Бобита

Все скриншоты сделаны автором

Категория Маркетинговая аналитика SEO

Демистификация &qout;штрафа за дублирование контента&qout; | Центральный блог Google Search

Пятница, 12 сентября 2008 г.

Дублированный контент. Просто в этом что-то есть. Мы держать письмо о это, и люди продолжают спрашивать об этом. В частности, я до сих пор слышу, как многие веб-мастера беспокоятся о том, могут ли они «штраф за дублирование контента».

Давайте покончим с этим раз и навсегда, ребята: не существует такого понятия, как «дублированный контент». наказание.» По крайней мере, не в том смысле, в каком большинство людей имеют в виду, когда говорят это.

Есть некоторые штрафы, связанные с идеей наличия того же контента, что и другой. сайт — например, если вы копируете контент с других сайтов и повторно публикуете его, или если вы повторно публикуете контент без добавления какой-либо дополнительной ценности. Эта тактика четко очерчена (и обескураженный) в нашем Руководство для веб-мастеров:

- Не создавайте несколько страниц, поддоменов или доменов с существенной дублированный контент.

- Избегайте… «стандартных» подходов, таких как партнерские программы с

мало или совсем нет оригинального контента.

- Если ваш сайт участвует в партнерская программа, убедитесь что ваш сайт повышает ценность. Предоставляйте уникальный и релевантный контент, который дает пользователям повод сначала посетите ваш сайт.

(Обратите внимание, что, хотя копирование контента от других не рекомендуется, другая история; проверить этот пост если вы беспокоитесь о том, что вас поцарапают.)

Но большинство владельцев сайтов, которые, как я слышал, беспокоятся о дублирующемся содержании, не говорят о очистке или

доменные фермы; они говорят о таких вещах, как наличие нескольких URL-адресов в одном домене, которые указывают

к тому же содержанию. Нравиться www.example.com/skates.asp?color=black&brand=riedell и www.example.com/skates.asp?brand=riedell&color=black . Наличие такого типа

дублирование контента на вашем сайте потенциально может повлиять на производительность вашего сайта, но это не

вызывают штрафы. Из нашей статьи о

дублированный контент:

Из нашей статьи о

дублированный контент:

Дублирование контента на сайте не является основанием для принятия мер на этом сайте, за исключением случаев, когда цель дублированного контента состоит в том, чтобы ввести в заблуждение и манипулировать результатами поисковых систем. Если ваш сайт страдает от проблем с дублированием контента, и вы не следуете совету, указанному выше, мы делаем хорошая работа по выбору версии контента для отображения в результатах поиска.

Этот тип незлонамеренного дублирования довольно распространен, тем более что многие CMS не обрабатывают это хорошо по умолчанию. Поэтому, когда люди говорят, что такой тип дублированного контента может повлиять на ваш сайт, это не потому, что вас могут оштрафовать; это просто из-за того, что сеть сайты и поисковые системы работают.

Большинство поисковых систем стремятся к определенному уровню разнообразия; они хотят показать вам десять разных

результаты на странице результатов поиска, а не десять разных URL-адресов с одинаковым содержанием. К этому

В конце концов, Google пытается отфильтровать повторяющиеся документы, чтобы пользователи не ощущали избыточности. Ты

можно найти подробности в

этот пост в блоге, который

состояния:

К этому

В конце концов, Google пытается отфильтровать повторяющиеся документы, чтобы пользователи не ощущали избыточности. Ты

можно найти подробности в

этот пост в блоге, который

состояния:

- Когда мы обнаруживаем повторяющийся контент, например, из-за вариаций, вызванных параметрами URL, мы группируем повторяющиеся URL-адреса в один кластер.

- Мы выбираем то, что, по нашему мнению, является «лучшим» URL-адресом для представления кластера в результатах поиска.

- Затем мы консолидируем свойства URL-адресов в кластере, такие как популярность ссылок, в репрезентативный URL.

Вот как это может повлиять на вас как на веб-мастера:

- На шаге 2 представление Google о том, что такое «лучший» URL, может не совпадать с вашим представлением. Если вы

хотят иметь контроль над тем,

www.example.com/skates.asp?color=black&brand=riedellилиwww.отображается в нашем поиске результаты, вы можете принять меры, чтобы смягчить дублирование. Одним из способов сообщить нам, какой URL вы предпочитаете, является включение предпочтительного URL в ваш Карта сайта. example.com/skates.asp?brand=riedell&color=black

example.com/skates.asp?brand=riedell&color=black - На шаге 3, если мы не сможем обнаружить все дубликаты определенной страницы, мы не будем способны объединить все свои свойства. Это может ослабить силу этого контента. сигналы ранжирования, разделив их на несколько URL-адресов.

В большинстве случаев Google хорошо справляется с таким типом дублирования. Однако вы также можете

хотите рассмотреть контент, который дублируется между доменами. В частности, решение о строительстве

сайт, цель которого по своей сути включает дублирование контента, — это то, о чем вы должны подумать дважды

о том, будет ли ваша бизнес-модель опираться на поисковый трафик, если вы не можете добавить много

дополнительная ценность для пользователей. Например, мы иногда слышим от партнеров Amazon.com, что

с трудом ранжируется для контента, который исходит исключительно от Amazon. Это потому что Гугл

хочет остановить их от попыток продать

Все какают?

Нет; это потому что как, черт возьми, они собираются превзойти Amazon , если они предоставляют

точно такой же список? Amazon имеет большой авторитет в онлайн-бизнесе (скорее всего, более

типичный партнерский сайт Amazon), и средний пользователь поиска Google, вероятно, хочет, чтобы

исходная информация на Amazon, если только партнерский сайт не добавил значительное количество

дополнительная ценность.

Например, мы иногда слышим от партнеров Amazon.com, что

с трудом ранжируется для контента, который исходит исключительно от Amazon. Это потому что Гугл

хочет остановить их от попыток продать

Все какают?

Нет; это потому что как, черт возьми, они собираются превзойти Amazon , если они предоставляют

точно такой же список? Amazon имеет большой авторитет в онлайн-бизнесе (скорее всего, более

типичный партнерский сайт Amazon), и средний пользователь поиска Google, вероятно, хочет, чтобы

исходная информация на Amazon, если только партнерский сайт не добавил значительное количество

дополнительная ценность.

Наконец, рассмотрите влияние дублирования на пропускную способность вашего сайта. Дублированный

контент может привести к неэффективному сканированию: когда робот Googlebot обнаруживает десять URL-адресов на вашем сайте, он

сканировать каждый из этих URL-адресов до того, как он узнает, содержат ли они один и тот же контент (и, следовательно, до

мы можем сгруппировать их, как описано выше). Чем больше времени и ресурсов робот Googlebot тратит на сканирование

дублировать контент по нескольким URL-адресам, тем меньше времени у него есть, чтобы добраться до остальной части вашего контента.

Чем больше времени и ресурсов робот Googlebot тратит на сканирование

дублировать контент по нескольким URL-адресам, тем меньше времени у него есть, чтобы добраться до остальной части вашего контента.

Подводя итог: наличие дублированного контента может по-разному повлиять на ваш сайт; но если у вас нет дублируют намеренно, маловероятно, что одним из этих способов будет наказание. Это означает что:

- Обычно вам не нужно подавать запрос на пересмотр, когда вы невинно убираете дублированный контент.

- Если вы являетесь веб-мастером со смекалкой от начального до среднего, вам, вероятно, не нужно помещать слишком много энергии, чтобы беспокоиться о дублирующемся содержании, поскольку у большинства поисковых систем есть способы справиться с этим.

- Вы можете помочь своим коллегам-веб-мастерам, не поддерживая миф о штрафах за дублированный контент!

Средства правовой защиты от дублированного контента полностью находятся под вашим контролем.