Падение позиций сайта в Яндексе

Падение позиций сайта, отключение персонального поиска и общие проблемы с выдачей Яндекса. Многие начинающие вебмастера, воспринимают некоторые ситуации связанные с поисковой выдачей, близко к сердцу. В большинстве случаев тревога напрасна, необходимо просто подождать некоторое время. Давайте рассмотрим наиболее частые некритичные проблемы, а затем обратим внимание на действительно тревожные симптомы.

Содержание статьи:

Частые проблемы связанные с выдачей Яндекса

У многих начинающих специалистов, постоянно возникают вопросы: почему позиции сайта резко просели? Почему в разных браузерах разная выдача? и т.д. Многие считают — что дело именно в их сайте, но на самом деле, поисковики также совершают ошибки.

Рассмотрим некоторые ситуации:

- Запрос был в ТОП 10, а через день вылетел за ТОП 50.

Решение: В большинстве случаев — это ошибка на стороне Яндекса. Отправляется письмо в службу поддержки, и запрос появляется в ТОП 10 через 1-2 недели. - Запрос был на хорошей позиции, но просел и в выдаче появились московские сайты и сайты других регионов.

Решение: В большинстве случаев — это ошибка на стороне Яндекса. Поломалась региональная выдача. Запрос появляется в ТОП 10 через 1-2 недели. - Сайт резко просел по всем позициям. Возможно у сайта пропала региональная привязка.

Решение: В большинстве случаев — это ошибка на стороне Яндекса. Регион восстанавливается через сервис Яндекс. Вебмастер. Позиции улучшатся через 1-2 недели. - Посещаемость сайта долго держится на стабильном уровне — 60-100 посетителей в сутки, но сегодня Метрика показывает 0 посетителей.

Решение: В большинстве случаев — это ошибка на стороне Яндекс, сервис Яндекс Метрика сломался. - В отчете запрос занимает 8-9 позицию, а при проверке клиентом в день сдачи отчета, 11-12 позицию.

Решение: Яндекс и Google — это динамические поисковые системы, поэтому выдача может поменяться в любой момент. Очень часто Яндекс подмешивает в выдачу спектральную примесь — видео материалы, твиты, wiki-статьи, которые могут отодвинуть наш запрос вниз. - В одном браузере запрос в ТОП 10, в другом же он находится на второй странице выдаче.

Решение: Почистить кэш браузера и отключить персональный поиск.

Позиции сайта в поисковой выдачи значительно просели, страницы выпали из выдачи ПС и прочее.

Многие должны понимать, что нарушения на сайте, могут привести к серьезным последствиям. В некоторых случаях, проблема может быть фатальной и непоправимой. Давайте рассмотрим проблемы, которые могут, действительно серьезно повлиять на авторитетность сайта в глазах поисковых систем.

Позиции сайта резко упали за пределы ТОП 100, но некоторые страницы остались в ТОП 50. Упала общая посещаемость.

Ответ: Скорее всего, сайт находится под фильтром. В большинстве случаев это фильтр — Не уникальный контент, спам, избыток рекламы. Проверьте Яндекс Вебмастер на наличие предупреждений. Если сайт действительно под фильтром, обратитесь в поддержку за минимальной консультацией.

- После этого, необходимо проанализировать страницы, которые упали за 100-ю позицию — на наличие спама в тексте (переизбыток: ключей, выделений, и прочего).

- Далее на уникальность, которая должна быть не менее 94%, а лучше все 100%.

- Обратите внимание — количество рекламных блоков на странице, не должно быть больше 4-х, особенно если сайт молодой.

- Также следует проверить сайт на дубли страниц, в некоторых случаях и на скопированный материал с сайта (возможно злоумышленник использует Ваш контент).

Исключение из поиска страниц сайта, значительное снижение индексации сайта. Возможно в поиске осталась главная страница.

Ответ: Достаточно сложно определить, почему поисковая система исключила страницы сайта из выдачи. Этой ситуации могут способствовать множество причин.

- Дорвей — страницы сайта перенаправляют посетителей на другой сайт. В этом случае следует незамедлительно удалить все перенаправления на сторонние ресурсы. Проверить проект на вирусы и аспекты взлома, при необходимости сменить пароли доступа. После этого следует обратиться в поддержку ПС с просьбой проверить исправления. Затем ждать.

- Клоакинг — обман ПС и пользователей, предоставление ложной информации обеим сторонам. Постарайтесь создавать контент для людей, это наиболее перспективный метод продвижения. Который способен влиять даже на ранжирование сайта в поисковой системе. Страница должна представлять единый контент, для обеих сторон!

- Скрытый текст — текст с мелким шрифтом на странице (содержащий продвигаемые запросы). Достаточно изменить шрифт на тот, который хорошо воспринимается глазом. Убрать фрагменты текста, которые перенасыщены ключевыми словами. Отправить сайт на переиндексацию и ждать результатов.

- Партнерские программы — большое количество рекламных баннеров сторонних сайтов на странице. Рекламирование услуг, товаров, объявлений и прочего. Такие сайты воспринимаются поисковыми системами как низкокачественные. В этом случае следует провести чистку сайта и избавиться от назойливой рекламы других сайтов. Зарабатывать можно легальным способом, размещая рекламные объявления ПС.

ТИЦ и PR упали до 0 — пропали страницы из поиска, Trast сайта снизился до минимума.

Такие данные могут говорить, только о фатальных нарушениях на сайте. Поисковые системы безжалостно поступают с сайтами, которые нарушают большинство существующих правил. Сайт постепенно исчезнет из выдачи, возможно останется главная страница. В этом случае я могу порекомендовать — начать все заново.

При этом следует учитывать прошлый опыт и не совершать ошибки, которые могут привести к краху вашего труда.

- Читайте статьи по этой теме:

Насколько полезным был этот пост?

Нажмите на звезду, чтобы оценить пост!

ОтправитьСредний рейтинг / 5. Подсчет голосов:

Я сожалею, что этот пост не был полезен для вас!

Давайте улучшим этот пост!

Расскажите, как я могу улучшить этот пост?Отправить отзыв

Спасибо за ваш отзыв!

nicola.top

Упали позиции в Яндекс почему и что делать

Поисковая система Яндекс лидирует в русскоязычном сегменте поиска. Среднее соотношение трафика который дает Ya на сайт вебмастера достигает 80%, поэтому правильное позиционирование сайта для поисковика является ключевым моментом в продвижении сайта. Первая позиция в поисковой выдаче по запросу, очевидная и достижимая цель. Необходимо и достаточно делать полезный и удобный сайт для пользователя, следовать рекомендациям сервиса, отслеживать метрики и вовремя на них реагировать.

Повышаем позиции

После публикации контента у вебмастера появляется вопрос, как поднять позиции сайта в Яндексе, что надо сделать для того, что бы он полюбил мой сайт и давал трафик. Основная задача вебмастера, планомерная и последовательная работа над сайтом, улучшение контента. Сайт должен отвечать на запрос пользователя, после прочтения статьи посетитель удовлетворяет свою потребность и более не уходит в поисковую выдачу (останавливается на вашем сайте).

Не нужно упускать из вида и технические показатели текстов на сайте. Поисковая система это робот и работает она по определенным алгоритмам. Анализируя Топ поисковой системы можно предположительно вывести параметры текстов, оптимальных для отдельно взятого запроса. Можно проанализировать его руками по всем запросам, а можно воспользоваться сервисом подготовки ТЗ что поможет повысить позиции сайта в пс.

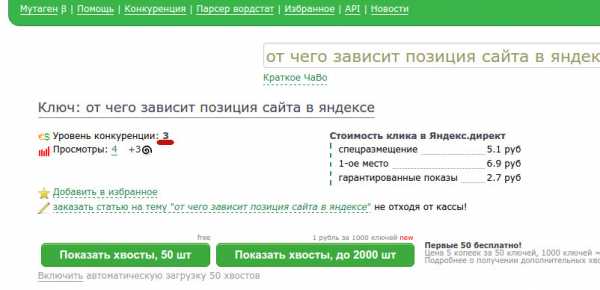

Как попасть на первую позицию по запросу в выдаче Яндекса:

- Собрать семантическое ядро с конкуренцией по мутаген ниже 25 (для первой позиции меньше 5)

- Правильно разгруппировать семантическое ядро на группы (статьи)

- Сделать качественную структуру сайта, понятную пользователю (удобная навигация)

- Подготовить ТЗ основанные на данных из поисковой выдачи

- Написать статьи полностью раскрывающие темы запросов

- Красиво оформить, добавить картинки и видео для удержания внимания пользователя на странице

- Планомерно добавлять новые статьи на сайт,

- Анализируя метрики (количество отказов, глубину просмотра, веб-визор) вносить правки для улучшения показателей

От чего зависит позиция сайта в поисковике:

- Конкуренция запроса, проверяем в Мутаген (чем ближе к 25 тем больше конкуренция и тяжелее поднять позицию в Яндекс)

- Качество контента относительно конкурентов (+ к поведенческим факторам, далее ПФ)

- Удобство пользования сайтом, интуитивно понятная навигация (+ к ПФ)

- Наличие дополнительного функционала на сайте (увеличивает время просмотра + к ПФ)

- Стабильность ответа сервера

- Время получения контента пользователем не более 2 секунд (идеально до секунды)

Поисковая система очень хорошо научилась определять, нравиться сайт пользователю или нет. Все сайты в Яндексе проходят несколько стадий тестирования качества контента и соответствия (релевантности) страницы запросу. Первый и ключевой фактор это ПФ (количество отказов, глубина просмотра, время на сайте).

Как повысить позиции и не попасть под фильтр !

- Не заниматься искуственными накрутками (покупать ПФ, покупать плохие ссылки, спамить ключами)

- Делать полезный качественный сайт с высокими ПФ

Как поднять позицию запроса в топ 3 (рекомендация): необходимо первыми выписать статьи (группы) со средней частотой по мутаген меньше или равной 3. Благодаря низкой конкуренции ПС начнет давать первых посетителей. Обязательно установив метрику на сайт, отслеживаем показатели ПФ. Если надо то, дорабатываем сайт и поднимаем качество контента. Поднять позиции в поиске можно только планомерной работой над сайтом учитывая поведенческие факторы пользователя.

Падают позиции, почему

Постепенно, учитывая ПФ на сайте, система будет давать больше трафика, подмешивать сайт в ТОП выдачи для тестов. Оценивая качество и удобство подачи контента поисковик будет повышать или уменьшать траст сайта (оценка качества площадки в пс). Если со временем (от полугода от индексации статьи) падают позиции запросов, велика вероятность что они теряют траст из за плохих ПФ (можно сказать, в яндексе упал траст и следом упали позиции сайта в яндекс).

Если вы видите, что просели позиции в ПС по конкретным запросам, обратите внимание на поведение посетителей. Закупите рекламу на этот запрос и посмотрите, что надо улучшить на странице, что доработать. Для этого воспользуйтесь функцией метрики Вебвизор.

Часто по началу веб-мастер замечает странное поведение запросов они: то в топ10, то тут же за топ 100. Сразу возникает вопрос, почему скачут позиции в яндекс, что не так с моим сайтом. Надо понимать, скачки обусловлены тестированием качества сайта путем подмешивания его, по некоторым запросам, в топ выдачи. Поэтому если упали позиции в яндексе смотрите на поведение пользователей, отследите ПФ и вам станет понятно почему сайт теряет позиции в поиске и какие из них требуют доработки.

Учитывайте конкуренцию, со временем конкуренция запросов меняется, то что несколько лет назад не имело аналогов, сегодня выдача полностью забита качественными проектами. Периодически (

Это вам будет интересно:

Поисковые системы наращивают свою интеллектуальную мощь, усложняют алгоритмы и используют машинное обучение для улучшения своей выдачи перед конкурентами. Вебмастера постоянно отслеживают тенденции и меняют свои стратегии, но есть и базовые алгоритмы, рассмотрим один из них. читать далее… Проверка позиций в поисковой системе Яндекса необходимая процедура, для анализа качества продвижения сайта в русскоговорящем сегменте. Наблюдая за поведением ключей в поисковой выдаче, веб-мастер сможет вовремя внести коррективы в стратегию продвижения читать далее… Почему определение позиций сайта так важно для успешного продвижения. Как приступить к определению позиции сайта в ПС яндекс и вовремя принимать меры для корректировки стратегии продвижения читать далее… После выкладки статей на сайт, по прошествии времени, надо выявить кандидатов на доработку. Точечная работа над улучшением статей, один из ключевых этапов работы над улучшением сайта. Выявляем кандидатов на доработку, подробная инструкция. читать далее…tzmonster.pro

Что делать, если сайт просел в Яндексе

Позиции сайта резко просели? Упало количество показов на поиске? Еще вчера ваш сайт был в ТОП-10, а сегодня его нет даже в ТОП-50. Бывает и такое, что все достигнутые результаты рухнули за 1 день. Но найти причины в большинстве случаев достаточно просто. В данной статье мы расскажем о том, как быстро выяснить причину падения и как это исправить.

1. Изменение алгоритмов ранжирования

Несколько раз в год поисковые системы обновляют алгоритмы ранжирования, изменяя те или иные параметры оценки сайтов. Поэтому в seo часто бывает так, что вчера это работало в плюс, а сегодня приносит только вред.

Как проверить:

А) Читаем блоги для вебмастеров от поисковых систем. Возможно, что о грядущем обновлении алгоритмов было оповещено заранее.

Б) Парсим тематические блоги по seo. Довольно часто именно там пользователи сообщают об изменениях в работе поисковых роботов. Доверять 100% такому источнику нельзя, но прислушиваться нужно.

2. Ручные санкции

Асессор (специалист, который оценивает результаты органической выдачи, сделанной роботом) компании Яндекс вручную проверил ваш ресурс и вынес вердикт, что сайт не удовлетворяет критерием “хорошего сайта”, следственно, сильное проседание по всем позициям.

Как проверить:

А) Подать заявку на платное добавление Яндекс.Каталог. Таким образом, представители Яндекса сами подскажут вам в ответном письме – что не так с вашим сайтом.

3. Ошибки внутренней оптимизации

В процессе развития проекта можно не заметить целый ряд ошибок, которые в последующем негативно повлияют на весь сайт в целом. К таким ошибкам относятся: дубликаты страниц, серверные ошибки (404 страница, зеркало сайта и т.д.), переспам в тексте или мета-тегах.

Как проверить:

А) Проанализировать страницы, которые уже есть в выдаче на наличие дубликатов.

Cтатья: как найти дубли страниц сайта

Б) Сопоставить количество вхождений ключевых фраз на страницах собственного сайта с конкурентами.

4. Неточность поискового робота

Поисковый бот — не идеальная машина. В редких случаях он неверно оценивает сайта, накладывая автоматические фильтры. То есть, вам просто не повезло.

Как проверить:

А) Написать письмо в Яндекс.Вебмастер. Пройдите по ссылке – обратная связь и выберите подходящий раздел. В течение 3-5 рабочих дней сотрудники Яндекса обязательно ответят на почту, привязанную к данному кабинету вебмастера.

5. Поведенческая статистика

Характерно для сайтов, которые вошли в ТОП-10 и находились там 2-4 месяца, а потом вылетели на 10-30 позиций по многим ВЧ запросам. За несколько месяцев поисковый робот накапливает статистику о поведении пользователей на сайте, а затем соотносит их с конкурентами по данным запросам. И если ваш сайт демонстрирует низкие поведенческие показатели, то возможно понижение сайта произошло за счет плохого ПФ.

Как проверить:

А) Отслеживать даты апдейтов Якорь поведенческих факторов в Яндексе. Они происходят раз в несколько месяцев. Сопоставляйте даты падения сайта и даты апдейта ПФ.

Рекомендация seo-специалистам — делать проверку по всем вышеуказанным параметрам, тогда велика вероятность того, что причина падения будет найдена и устранена. Главное во всём этом – уметь добиваться “нужного ответа”, как от сотрудников, так и от сервисов Яндекса.

Рекомендуем изучить:

Как провести аудит сайта

Как сделать перелинковку на сайте

seo-impulse.ru

как избежать просадки трафика из-за ПФ, что делать с упавшими позициями?

Чуть больше месяца назад я опубликовал статью с первыми выводами об апдейте Яндекса, после которого многие статейные сайты потеряли значительную часть трафика и дохода. Сегодня расскажу о завершающем этапе исследования и о том, что все это значит для практики.

Какие новые данные появились за месяц?

Во-первых, увеличилась выборка проблемных проектов. Многие владельцы инфосайтов после предыдущего поста написали мне и предложили новые проекты для анализа. Они пригодились для перепроверки сделанных в первой части исследования выводов.

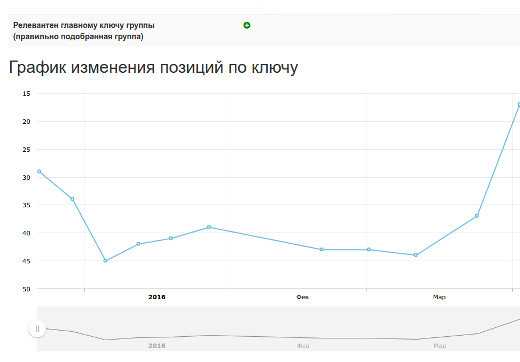

Особенно меня интересовало, правильно ли предположение о том, что позиции и трафик падают на уровне хоста. Напомню, что было всего 4 проекта, где удалось посмотреть достоверную динамику трафика на молодых документах. Сейчас добавилось еще три. Графики везде выглядят похоже, примерно так:

Поэтому первоначальные выводы остаются в силе.

Поэтому первоначальные выводы остаются в силе.

Во-вторых, ряд пострадавших 30 января проектов были задеты еще одним апдейтом — в самом конце февраля. В большинстве случаев трафик частично вернулся. Типичный пример:

Важно отметить, что проблемы с мобильным трафиком наблюдается далеко не на всех пострадавших в январе. Поэтому считать вторую просадку прямым продолжением первой («раскатыванием» алгоритма на мобильные) — нельзя.

Рабочая гипотеза: почему дело именно в поведенческих факторах?

Многие скептически восприняли мой вывод о том, что причина просадки — слабые поведенческие факторы. Скептицизм — это прекрасно! См. мой давний пост на эту тему. Однако адекватную альтернативу своей гипотезе из обсуждений выловить не удалось.

Наиболее внятные аргументы против роли поведенческих:

- Можно найти сайт с хорошими ПФ, который тоже попал под раздачу.

- Яндекс не станет считать кликстрим (историю действий пользователя) ради того, чтобы забанить сколько-то статейников, это слишком дорого для такой мелкой задачи.

По первому пункту есть два контраргумента:

- Хорошие ПФ или нет — знает только Яндекс. Часто приходится слышать формальные критерии типа «отказов должно быть не больше 20%» или «глубина просмотра от 3 — это отлично». Конечно же, они имеют очень косвенное отношение к реальным ПФ. Об этом ниже.

- Пока мне никто не показал сайт с высокой лояльностью новых посетителей с поисковых систем, который просел 30 января. Если покажут (желательно не один, а десяток, чтобы было похоже на выборку) — с удовольствием изучу и без проблем признаю что был не прав.

По второму все еще проще. Достоверно известно, что Яндекс накапливает и хранит данные о пользовательском поведении по некоммерческим запросам. Иначе он бы не смог реализовать алгоритмы Палех и Королев. Цитирую:

Например, одна из моделей предсказывала, останется ли пользователь на сайте или уйдет. Другая – насколько долго он задержится на сайте. Как оказалось, можно заметно улучшить результаты, если оптимизировать такую целевую метрику, которая свидетельствует о том, что пользователь нашёл то, что ему было нужно.

https://habrahabr.ru/company/yandex/blog/314222/

То есть: Яндекс вряд ли ставил целью порезать трафик у неугодных сайтов (в выдаче всплыли очень похожие проекты). Но накоплением и анализом пользовательских данных яндексоиды занимаются давно, а применяют их для самых разных задач.

Все дело в обилии рекламы, тизерах и офферах внутри статьи?

Самая популярная гипотеза в обсуждениях — идея, что пострадали сайты, злоупотреблявшие рекламой. Мысль абсолютно логичная, ее подкрепляют разные факты:

- Почти одновременно с апдейтом популярные браузеры начали блокировать навязчивую рекламу.

- В Яндекс.Толоке есть задания на определение зарекламленности сайтов.

Многие проекты в моей выборке действительно монетизируются весьма агрессивно. Но есть и проекты, размещающие только скромный контекст (причем в первом экране он занимает меньше трети площади). А еще есть сайты, снявшие почти всю рекламу сразу после просадки (то есть полтора месяца назад) — но посещаемость до сих пор не вернулась. Поэтому непохоже, что мы имеем дело с бинарным признаком (есть «плохая реклама/нет плохой рекламы»).

А вот если предположить, что сайты просели из-за ПФ, то все встает на свои места. И тут нет никакого противоречия с гипотезой о роли рекламы. Смотрите:

- Много рекламных блоков — труднее доступ к контенту, пользователи в среднем менее лояльны и активны.

- Постепенно у Яндекса накапливается статистика взаимодействия посетителей с сайтом.

- Хлоп — и подкрутили алгоритм, который (например) придает статистике ПФ больший вес, чем раньше. Зарекламленные сайты (и не только они) попадали в выдаче.

- Расстроенный владелец снял все тизеры и ждет, когда вернутся позиции. А они не возвращаются — потому что накопленные данные по-прежнему играют против него. Новая же статистика собирается медленно (трафик-то упал!).

Разбираться в этих нюансах я стал не только из академического интереса. Для практики нам нужен объективный измеримый критерий. Если мы будем считать, что реклама влияет напрямую, то как понять, что у нас на сайте слишком много рекламы? Или слишком мало (и можно добавить еще, увеличив заработок)? На глазок?

Кстати, не всегда реклама раздражает пользователей. Она может быть и полезной: прочитал статью, разобрался с особенностями товара или услуги — и можно сразу кликнуть по релевантному предложению, не тратя время на переход обратно в выдачу.

Даже если не было всех веских свидетельств в пользу роли ПФ, я бы стал изучать их в поисках рабочего критерия для определения степени зарекламленности. Потому что первично именно впечатление людей от сайта, их удовлетворенность содержимым, включая рекламу. Вряд ли этот базовый принцип поменяется в ближайшие годы.

Ну вот, с идеологией покончили, переходим к статистике.

Чем отличаются сайты, на которых упал трафик от тех, кто не пострадал?

Сразу хочу расстроить любителей простых подходов типа «глубина просмотра больше трех». Вполне очевидно, что «правильная» глубина/показатель отказов/время на сайте сильно варьируются в зависимости от ниши и конкретной информационной потребности пользователя. Когда мне надо найти номер такси, я провожу на хорошем сайте 5 секунд, а на плохом, где этот номер прячут — 30. Хорошую профессиональную статью читаю 15 минут, плохую — 10 секунд. Понимаете разницу?

Поэтому было бы совсем наивно ждать от выборок просевших и устоявших сайтов (то и другое — сборная солянка из разных тематик) не только статистически значимых, но и полезных различий по базовым поведенческим метрикам. Однако для очистки совести я все-таки посчитал медианные значения по выборкам:

| Просевшие | С нормальной динамикой |

|---|---|

| 6,5% отказов | 12% отказов |

| 1.16 глубина просмотра | 2,08 глубина просмотра |

| 75 секунд длительность визита | 135 секунд длительность визита |

Данные различаются, это очевидно. Но что с ними делать? Не стараться же увеличить в два раза показатель отказов? Как-то это немного странно, правда? Табличка нам ничего не дает, только еще больше запутывает.

Что нужно, чтобы получить более полезные данные? Да просто брать показатели, которые можно сравнивать. Различие между которыми что-то нам скажет о реальных посетителях сайта. И такие показатели есть.

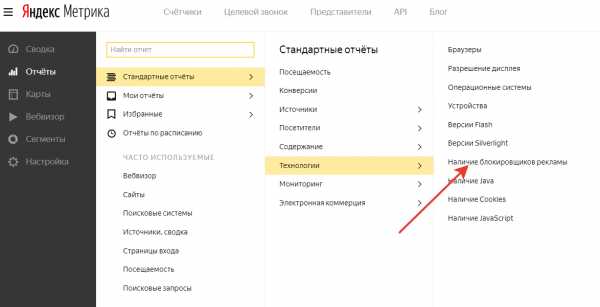

Отчет «Блокировщики рекламы» в Яндекс.Метрике

Посмотрите на сравнение поведенческих метрик для пользователей с включенной и отключенной блокировкой рекламы по одному из пострадавших сайтов:

С блокировщиком отказов в два раза меньше! Какое самое простое объяснение? Правильно: без рекламы сайт нравится людям значительно больше.

Это был единичный пример. Как обстоят дела по всей выборке? А вот как:

Разница в базовых поведенческих метриках у пострадавших сайтов ощутимо выше, чем у проектов со стабильным трафиком.

Например, показатель отказов на «нормальных» сайтах для пользователей с блокировщиком ниже всего на 0,1% (медиана). Пострадавшие проекты демонстрируют разницу в 0,25%. Тоже совсем немного, так ведь? Но если брать в выборку только сайты с относительно большим объемом трафика, для которого было определено наличие блокировщика, или взять статистику за более длительный период, разница стремительно растет, доходя до 2-4% (см. ниже объяснение, почему так происходит).

Аналогично для длительности визита. На нормальных сайтах — различия в продолжительности сессий измеряются долями секунды. На пострадавших медианная разница — 16 секунд (не в пользу версии без блокировщика).

Дополнительная проверка с использованием технологий Яндекса

Выявленные различия совсем не означают, что Яндекс ориентируется именно на них. Это только часть общей картины, которая есть у поисковой системы. Для практики же нам важно другое — может ли сравнение сегментов по блокировщикам рекламы стать полезным сигналом для работы над сайтом?

Отвлеченный пример для понимания. Анализ крови дает массу информации о состоянии здоровья. Показатели в нем — это полезный сигнал о проблемах с организмом. Но лечат обычно не для подгонки анализов под идеальные показатели, а чтобы привести в норму тот или иной орган.

Как можно проверить, насколько полезным будет изучение отчета по блокировщикам для коррекции стратегии? Следите за руками:

- Берем данные о поведенческих метриках по сегментам «блокировщик есть» и «блокировщика нет».

- Обучаем на их основе классификатор сайтов (просадка есть/просадки нет).

- Тестируем его на специально отложенной части выборки.

- Если модель справляется лучше, чем константный алгоритм, значит, наш набор данных содержит необходимую информацию и эти данные можно использовать.

Я решил, что будет правильным для изучения алгоритма Яндекса воспользоваться инструментами самого Яндекса — молодой, но перспективной библиотекой машинного обучения Catboost.

Основной проблемой тут стала сильная несбалансированность выборки: у меня сколько угодно примеров нормальных сайтов со стабильным трафиком и меньше сотни проблемных проектов (очень неплохая выборка для SEO-исследования, но совершенно недостаточно для адекватного классификатора). К счастью, в методах Catboost есть встроенные параметры для борьбы с несбалансированной выборкой, очень удобно.

Нельзя было выделить для тестовой выборки сколько-нибудь приличное число объектов, не обедняя обучающую. Поэтому корректно подсчитать точность и полноту не получилось. Однако и без них очевидно, что модель работает не вхолостую. Я сделал 3 захода: оставлял в тестовой выборке 95 нормальных и 5 пострадавших сайтов и обучал бинарный классификатор на оставшихся примерах.

Результаты такие:

- Во всех случаях алгоритм корректно определил все 95 сайтов со стабильным трафиком.

- Не было ни одного ложного срабатывания, то есть ситуации, когда «здоровый» сайт был определен как проблемный.

- В первом тесте не было найдено 2 пострадавших сайта из 5, во втором — 3, в третьем снова 2.

Итоги не позволяют использовать алгоритм в боевых условиях (велик шанс пропустить проблему), но он явно справляется гораздо лучше чем константный. То есть изначальная гипотеза подтвердилась — в наборе данных есть необходимая нам информация! Или ее часть, как минимум.

Конечно, можно было заморочиться с настоящей кросс-валидацией и тонким подбором параметров. Но лично у меня полно других дел. На главный вопрос ответ я получил, другого же от модели и не требовалось.

Практические рекомендации

Подчеркну важный момент. Не надо привязываться к конкретным цифрам. Я специально не стал публиковать полные данные, полученные из сравнения статистики (чтобы не получилось как в прошлый раз с Баден-Баденом). Важна именно разница между тем, как люди воспринимают две версии сайта — с рекламой и без. Если разница существенна — значит реклама мешает. Если разницы нет — не мешают.

Особенно важно это понимать, так как отчет по блокировщикам несовершенен.

- Сумма визитов с блокировщиком и без блокировщика обычно значительно меньше, чем общий объем визитов. Определить наличие/отсутствие Adblock удается далеко не всегда.

- Поведенческие метрики в отчете по блокировщикам сильно отличаются от средних по сайту. Как правило, глубина просмотра для визитов, где удалось определить наличие/отсутствие блокировщика выше. Думаю, чем больше страниц просмотрел посетитель, тем проще Метрике разобраться с технологиями его браузера.

- В конце концов, блокировщики устраняют далеко не всю рекламу и считать, что люди с Adblock видят «чистый» сайт мы можем лишь условно.

Все остальное — просто и очевидно.

Как понять, что сайту грозит понижение в выдаче из-за рекламы?

Если вы владелец сайта, который монетизируется по рекламной модели, имеет смысл регулярно изучать отчет по блокировщикам:

Не забудьте выбрать довольно длительный период для отчета, чтобы он был более статистически достоверным (конечно, если меняли дизайн или размещение рекламных блоков, то начало периода должно быть не раньше даты изменений). Стоит также указать фильтр «Тип источника — поисковые системы», может оказаться полезной и сегментация по устройствам.

Не забывайте, однако, что каждый дополнительный сегмент уменьшает объем выборки пользователей, для которых рассчитываются показатели. По моему опыту, для выборок менее 5000 визитов различия очень часто стираются.

Если разница в поведенческих метриках ощутима, то ваш сайт в зоне риска. Если вы видите, что разница сильно выросла по сравнению, например, с прошлым месяцем — то пора что-то поменять.

Если большой разницы нет и вы хотите добавить еще рекламы — добавьте ее сначала на часть страниц и отследите, не изменятся ли на них поведение пользователей без блокировщиков.

Что делать, если сайт уже просел?

Очевидно — постараться нарастить «хорошую» статистику по пользовательскому поведению для всего сайта. Действовать нужно комплексно:

- Снизить количество рекламы.

- Проработать контент на собирающих трафик страницах так, чтобы он лучше соответствовал пользовательским интересам (в том числе тем, что не подразумевались при создании статьи). Опять же берем нашу любимую Метрику, смотрим поисковые запросы, по которым приходят/приходили люди на конкретную статью, ищем темы, плохо раскрытые в контенте. Для облегчения процесса используем инструмент дооптимизации важных страниц. Обратите внимание на кейс оживления заброшенного сайта с помощью сервиса (см. ближе к концу, где приводится статистика по изменению доли отказов).

- Проработать подборки публикаций так, чтобы облегчить пользователю их восприятие, сделать страницы категорий более логичными и структурированными.

- Добавить новые качественные материалы по темам, для которых в нише нет адекватного контента (везде будут плохие ПФ, а у нас — хорошие).

- Доработать страницы с максимальным количеством отказов и наибольшей разницей в поведении для пользователей с блокировщиком и без.

Разумеется, нужно оценивать рентабельность всех этих действий. Если сайт не имеет мало-мальски приличной структуры, то его переработка может обойтись дороже, чем создание нового проекта.

Как узнать больше об улучшении ПФ и эффективной монетизации статейников?

Предвижу много вопросов к этим рекомендациям. Однако подробное руководство по улучшению ПФ на статейниках и их монетизации с максимальным доходом и минимальным риском тянет еще на одну здоровенную статью (и 10 — 15 часов работы). В принципе я готов ее написать, хотя тема мне уже немного надоела. Поэтому для начала хочу понять, насколько вообще это интересно читателям, имеет ли смысл тратить время.

Сделаем так. Если вас интересует инструкция:

- Поделитесь ссылкой в соцсети, блоге или Telegram-канале на этот пост.

- Пришлите мне адрес записи со ссылкой через Google-форму.

- Оставьте там же свой e-mail.

Если наберется 100 или больше желающих — я напишу руководство и разошлю его по указанным ящикам. А потом, спустя 2-3 месяца — опубликую в основной рассылке блога.

В заключение

Главные выводы:

- Падение посещаемости на статейниках после апдейта 30 января связано с поведенческими факторами, в первую очередь с негативной реакцией пользователей на обилие рекламы. Это подтверждается динамикой трафика на проектах, снявших рекламу, значительными различиями в ПФ по выборкам, классификатором на основе Catboost.

- Полезный критерий для анализа поведения — отчет по блокировщикам рекламы. Разница даже в базовых метриках может быть весьма информативной. Конечно, никто не запрещает использовать и более сложные показатели, например, долю «длинных кликов» или показатели конверсии. Изучение различий в поведении между пользователями с блокировщиком и без него стоит использовать в процессе принятия решений о размещении рекламных блоков.

- Для возврата посещаемости требуется комплексная работа, направленная на улучшение ПФ. Весьма вероятно, что просто снять часть рекламы будет недостаточно. Хотя бы потому, что то же самое сделают и пострадавшие конкуренты.

P.S. Большое спасибо всем, кто давал сайты на анализ! Они весьма помогли. Если буду писать руководство — обязательно вышлю его вам (делиться ссылкой необязательно).

Также планирую написать пост с краткими замечаниями и советами по предоставленным проектам — без указания url, только с id Метрики (по ней вы сможете понять что это ваш сайт — а другие нет). Рассылать советы в переписке было бы слишком долго, да и некоторые проблемы сходны, так что все разом описать гораздо удобнее. Если не хотите, чтобы сайт попал в такой обзор — просто удалите мой доступ к нему.

UPDATE 17.03.2018

Получаю много комментариев со скриншотами отчета по блокировщикам, где показатели не вписываются в описанную картину. Кажется, тут есть глобальное недопонимание. Объясняю еще раз, по пунктам:

- Разница в поведенческих метриках в отчете по блокировщикам выявлена на достаточно значительной выборке. Это типичная, медианная картина. Но вовсе не факт, что на вашем конкретном сайте она будет такой же. По статистике курилщики живут меньше. Но кто-то курит с пятого класса и бодрячок в 90 лет.

- Отчет по блокировщикам несовершенен. Это не святой Грааль, а дополнительный способ посмотреть на свой проект, узнать о нем что-то новое. У кого-то он сработает, у кого-то нет. Ждете 1-2 универсальные циферки, которые дадут ответ по любой проблеме? У меня для вас плохие новости: на дворе 2018-й год.

- Я считаю, что обвал трафика произошел из за низких ПФ, одной из причин которых может являться реклама. Ее влияние мы часто можем отследить в статистике. Остальные факторы — не можем. Хорошо, что есть хоть что-то.

Наконец, прежде чем делать любые выводы с отчетом по блокировщикам:

- Задайте сегмент по одному типу устройств. Если у вас смешаны в кучу десктопы и мобильные — толку от отчета не будет.

- Задайте сегмент по источнику трафика. Нас интересует поисковый трафик.

- Задайте сегмент по новизне посетителя. Старые пользователи могли привыкнуть к рекламе.

- Убедитесь, что набирается хотя бы 5000 визитов с блокировщиками.

В противном случае у вас будет не статистика, а информационный шум.

Поделиться

Твитнуть

Поделиться

Отправить

alexeytrudov.com

Что такое поисковая оптимизация — Онлайн-курсы Яндекса

1. Немного теории

Многие компании заинтересованы в том, чтобы их сайт занимал высокие позиции в результатах поиска. Это помогает привлечь клиентов, а значит, увеличить продажи.

Поэтому владельцы сайтов часто используют поисковую оптимизацию — комплекс мер, позволяющих улучшить представление сайта в поиске.

Есть разные подходы к оптимизации. Можно делать сайт более информативным, интересным и удобным, и тогда он заслуженно займёт хорошее место в поиске. Другой подход (назовём его «псевдооптимизацией») состоит в том, чтобы искусственно поднять сайт в результатах поиска — влияя на параметры, которые используются при ранжировании. Таким образом можно ненадолго обмануть поисковую систему, но потом всё вернётся на круги своя: формула ранжирования постоянно совершенствуется и завышенные («накрученные») параметры теряют силу.

Чтобы ваш сайт естественным путём, без накруток занял достойное место в поиске, руководствуйтесь следующими рекомендациями:

- Создавайте сайты с оригинальным контентом или сервисом. Рекламы не должно быть слишком много: она не представляет особой ценности для пользователей.

- Тщательно продумывайте дизайн: он должен помогать людям решить задачу — например, найти информацию или купить товар.

- Ставьте только те ссылки, которые будут полезны пользователям вашего ресурса.

- Будьте честны. Не приводите людей на сайт по запросам, на которые у него нет хорошего ответа.

- Думайте о пользователях, а не о поисковых системах. Не тратьте силы на создание контента, страниц и элементов, предназначенных только для поисковиков.

Честная поисковая оптимизация — это трудоёмкий процесс, он требует понимания интересов пользователей, креативности, опыта и знаний. Но в конечном счете он выгоднее псевдооптимизации, которая даёт кратковременный или даже обратный эффект. Сайты, которые пытаются улучшить свои позиции обманным путём, могут быть исключены из поисковой базы или понижены в ранжировании. Об этом говорится в п. 3.7 Лицензии на использование поисковой системы Яндекса.

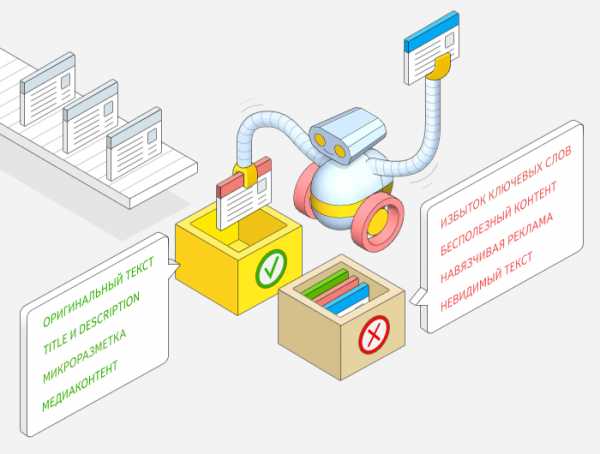

Вот список основных приёмов, которые Яндекс относит к «псевдооптимизации»:

- Использование текстов, содержащих избыточное, неестественное количество ключевых слов, что делает текст трудным для восприятия.

- Размещение вторичного, малополезного контента или информации о товарах и услугах, предоставляемых партнёрскими сайтами.

- Размещение ссылок, которые бесполезны для посетителей и нужны только для улучшения позиции в поиске.

- Размещение невидимого или слабовидимого текста с ключевыми словами.

- Имитация действий пользователей, которых якобы заинтересовал сайт.

- Использование шокирующей или раздражающей рекламы, мешающей просматривать основной контент сайта.

В этом списке приведены далеко не все методы псевдооптимизации. Более полную информацию о них читайте в документе «Чем отличается качественный сайт от некачественного».

yandex.ru