Почему позиции сайта падают в Гугле (Google)?

Вопрос объективности оценки сайта поисковиками актуален для каждого владельца интернет-ресурса, независимо от планов на монетизацию. Вообще обидно – ты сделал сайт для людей, а зловредный Google выдает его на 100500-й странице выдачи, куда естественно «не долистает» ни один адекватный человек. Проблема эта является животрепещущей и глобальной в условиях динамичности среды интернет-пространства, потому что сайты постоянно растут и падают. Чтобы зафиксироваться на высоком месте в выдаче, мало просто достичь его – необходимо ПОСТОЯННО работать и совершенствовать ресурс по требованиям капризного Гугла.

В ходе работы с сайтами наших клиентов специалисты студии F1 выделили основные причины падения в выдаче, проблемы, способы решения и просто интересные мысли на этот счет. Их много, а потому, не придумав ничего лучшего, мы просто создали один большой список, который полезно прочесть каждому, кто делает или продвигает сайты и добавили внизу популярные вопросы/ответы.

Навигация по странице

- Понижение выдачи и падение трафика

- Для новичков

- Ручные меры

- Проверка sitemap

- Изменения на сайте

- Meta noindex

- Заражение вирусом

- Дешевый хостинг

- Закрытие в robots

- Качество ссылочной массы

- Наращивание ссылочного

- Дубли контента

- Адаптированный дизайн

- Лишний скролл страницы

- Скорость загрузки

- Валидация кода

- Переспам ключей

- Ошибки в разметке

- География и персонализация

- Теги alt у картинок

- ЧПУ (SEF)

- Дубли страниц

- Язык сайта (hrefang)

- Пользовательские факторы

- Ворованный контент

- Дорвейность (перенаправление)

- Навязчивая реклама

Популярные вопросы:

- Сайт полностью пропал из Гугла — что делать?

- Сколько нужно времени для того, чтобы восстановить мои позиции?

- Если структура была сломана, но теперь все исправлено, как сообщить об этом в Гугл?

- Почему моя позиция в выдаче Яндекса высокая, а в Гугл – низкая?

- Почему с такими же ошибками мои конкуренты выше в выдаче?

- Что надо, чтобы быть в ТОПе всегда?

- Почему не видна моя страница в ВК (Фейсбуке, ЖЖ и т.д.)?

- Как связаться с техподдержкой Google, если у меня есть вопросы по ранжированию сайта?

- Что такое ручные меры?

- Почему мне не приходит ответ о пересмотре исправлений после ручных мер?

- Как посмотреть PR сайта?

Итак, начнем!

- Понижение выдачи и падение трафика – коллинеарные явления. Естественно, что из-за того, что ресурс существенно снизился в выдаче, на него попадет меньшее количество пользователей. И наоборот – если пользователи перестанут к вам заходить, трафик упадет и «порядковый номер» тоже. Поэтому необходимо повышать качество контента, юзабилити, использовать другие приемы для поддержания интереса со стороны потенциальной аудитории.

- Пока не залезли далеко в дебри, сразу оговоримся, наш материал не для тех, кто вчера сделал сайт и сетует над его отсутствием в топовой выдаче. Для новичков есть универсальный алгоритм:

- Проверьте, зарегистрировались ли вы в Search Console;

- Подготовлена ли карта сайта;

- Загружена ли карта сайта в Search Console;

- Наберитесь терпения и ждите (нужно месяца 2-3 не меньше)! Потом можно начинать паниковать.

- Если вы считаете, что причины для паники есть, в первую очередь удостоверьтесь, что к вашему сайту не применили «ручные меры». То есть Гугл не все делает автоматически, некоторые санкции к интернет-ресурсам применяют живые люди. Как правило, это связано с нарушением (или подозрением в нарушении) авторских прав. Итак, если кто-то решил, что вы посягнули на его контент, бренд или другую «собственность», он подает заявку в Гугл, и тот без суда и следствия банит сайт, наблюдая за развитием событий. А события могут развиваться по двум сценариям. 1) Вы ищете того, кто на вас пожаловался, и просите отозвать жалобу, 2) Вы никого не ищете и просто делаете новый сайт. Итак, если жалоба будет отозвана, вас разбанят. Проверить, не поданы ли на ваш сайт жалобы можно на Lumen. Обратная сторона – если у вас увели дорогой сердцу уникальный контент, вы так же можете подать жалобу в Гугл, и ждать пока воришка приползет на коленях.

- Проверьте сколько страниц подано в соответствии с картой сайта (sitemap), и сколько фактически проиндексировано. Если эти показатели значительно отличаются, значить, проблема падения в выдаче связана с ошибками индексирования. В первую очередь важно проверить, насколько корректно сгенерирована карта сайта, в каком формате она отправлена (в частности не допускается текстовый формат или вид HTML-страницы), влезают ли размеры файла sitemap в обозначенный лимит.

- Любые изменения на сайте могут привести к временному падению позиций. Независимо от того, идет ли речь об изменении текстового контента или о глобальной перестройке sitemap, поисковик отреагирует на это снижением рейтинга. Только в первом случае через 7-10 дней показатели могут самостоятельно вернуться на прежний уровень, а во втором – вам грозят длительные проблемы. Поэтому изменять карту, а тем более удалять из нее страницы без крайней необходимости не рекомендуется.

- Посетитель на найдет страницу, в заголовке которой обозначено meta noindex. Это может случиться по разным причинам, в частности из-за неосторожного обращения с настройками хостинга и CMS.

- Возможная причина закрытия страниц для пользователей – заражение вирусом. Будучи авторитетной поисковой системой, Гугл старается защитить лояльных к себе пользователей от переноса «заразы», поэтому ограничивает возможности развития эпидемии. Заподозрить неладное система может, в том числе по наличию стороннего кода, направляющему пользователей на сторонние ресурсы (социальные сети, баннеры рекламы и т.д.).

- Объем трафика, и как следствие рейтинг в выдаче, может упасть из-за того, что хостинг ограничил доступ к ресурсу, например, по «географическим» соображениям или на основании UserAgent. Особенно часто этим грешат бесплатные или откровенно дешевые хостинги.

- Еще одна причина – необдуманное скрытие содержимого с помощью robots.txt. Если вы будете «прятать» от пользователя все, что кажется вам недостойным его внимания, с большой вероятностью многие полезные страницы станут недоступными для поисковика. Как вариант – используйте возможности robots.txt только в крайнем случае, все остальные вопросы решайте с помощью канонических ссылок.

- Прежде чем активно наполнять ресурс входящей ссылочной массой, необходимо осознать, что повысить авторитет вашего сайта смогут только качественные ссылки, а те, которые продаются на биржах по «три копейки за ведро», с большой вероятностью возымеют обратный эффект. Решение проблемы: используйте анализаторы качества ссылочной массы, например, Ahrefs, SEMRush и другие. Не обязательно работать только с одним, в некоторых случаях большую эффективность демонстрирует сочетание сервисов.

- Не уходя далеко от темы входящих ссылок, напомним, что их полное отсутствие не менее негативно сказывается на выдаче, чем ситуация, описанная в пункте 10. Количество ссылок должно увеличиваться по мере роста и развития ресурса. Лучше если они будут размещены на тематических площадках.

- Если на разных страницах сайта поисковик находит одинаковую или очень похожую информацию, ему это не понравится. За подобное можно схлопотать не только автоматический бан, но и ручные санкции. Будьте креативными, мы уверены, что вам есть, чем поделиться с посетителем ресурса без откровенного дублирования инфы.

- До сих пор нет адаптации под мобильную версию? Не ждите ничего хорошего, Гугл активно борется за то, чтобы каждому посетителю было комфортно находить информацию, независимо от того, с какого устройства он это делает. Сразу оговоримся, два сайта – нормальный и «телефонный» — не вариант. Правильное решение – использование адаптивной верстки.

- Чисто интуитивная находка – требовательный Google не любит, если страница начинается с большого изображения, из-за которого необходимо скролить страницу, чтобы добраться до текстового контента. Независимо от того, идет ли речь о рекламном банере или вы просто «украсили» сайт таким неординарным образом, ранжирование будет сопровождаться проблемами.

- «Тяжелый», длительно открывающийся сайт при прочих равных условиях ранжируется хуже. Если это про вас, рекомендуем начать с оптимизации графического контента. Также можно пересмотреть степень ресурсообеспечения хостинга.

- Не забывайте проверять код валидатором. Любые синтаксические ошибки и отличия от кодировки UTF-8 приводят к негативным последствиям – ресурс тормозит при открытии, некорректно отображается в окне браузера и теряет позиции выдачи.

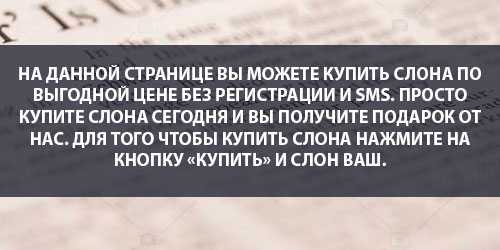

- Следите за количеством и частотой употребления ключевых слов. Ушли в прошлое времена, когда действовал принцип – чем больше, тем лучше. Сейчас ключевики и ссылки должны быть аккуратно помещены в текст, чтобы читающий не спотыкался о них в каждом предложении. На счет ссылок: учитывайте, что шаблоны WordPress могут самостоятельно включать спам-код, существенно увеличивая число ссылок по сравнению с тем, сколько запланировано веб-мастером.

- Ошибки в разметке – увесистый минус в карму сайта. Если вы используете шаблоны WordPress, не забывайте проверять структуризацию данных.

- Нередко начинающие веб-мастера неправильно проверяют позиции своего сайта, и впадают в панику от «падения» выдачи. Важно понимать, что на результат, который выдает ранжировщик, влияет географическое положение, а также условия персонализации запроса. Если вы пытаетесь определить позицию сайта с чужого компьютера в другом городе – результат не будет объективным.

- Большое количество картинок – прерогатива интернет-магазинов, владельцы которых стремятся максимально информативно визуализировать товар. При этом выдача сайта может быть низкой из-за отсутствия тегов alt, а также из-за несоответствия названия файлов с картинками их тематическому содержанию.

- Наше мнение о ЧеловекоПонятных Урлах таково – руководствуйтесь здравым смыслом. Старайтесь, чтобы при транслитерации русского слова оно не выглядело криво, косо или даже неприлично. Слова в УРЛ разбиваем строго дефисом, а не нижним подчеркиванием.

- Если вы запутаете ранжировщика наличием множественных поддоменов, готовьтесь к пессимистичному сценарию. В данном случае необходим обязательный редирект вспомогательных страниц (как правило, с www) на основные (без www). Страницы robots.txt – не перенаправлять!

- Не показывайте поисковику страницы с машинным переводом! Четко придерживайтесь правил и способом использования hrefang.

- В своем стремлении, как можно сильнее угодить требовательному ранжировщику многие веб-мастера добиваются совершенно противоположного эффекта. Основная идея заключается в том, что нужно стараться угодить пользователю, а не системе. Заметив это, система оценит ваши старания работать «для людей» и повысит рейтинг выдачи. Что нужно делать в рамках каждодневной работы: неустанно мониторить ошибки в консоли, исправлять их, продвигать ресурс на тематических площадках, добиваясь получения естественных ссылок, следить за спамом и т.д. Помните, чем выше оценит ваш сайт пользователь, тем лояльнее будет поисковик, определяя ваше место в выдаче.

- Ранжировщик может счесть содержимое на сайте неинформативным. И речь не идет о глупых текстах с ошибками или другими последствиями дешевого копирайта, скорее всего бот выявил нарушение авторских прав. Встречный вопрос: но почему открыто и прямо не назвать сайтостроителя вором? Не желая нарваться на кучу обоснованных и не обоснованных исков, Гугл предпочитает уклончивую формулировку – «неинформативно»!

- Если пользователь ищет «котенка Сфинкса», а его посредством тизерной рекламы и переадресации отправляют на сайт про установку биологических септиков, согласитесь – это досадная потеря времени, которая, кстати сказать, бесит не только пользователя, но и ранжировщика. Что грозит веб-мастеру, использующему сторонний код? – ручные меры!

- Если на сайте основной контент частично или полностью «загораживается» баннером с предложением скачать приложение (даже подходящее по тематике), ранжировщику это не понравится, о чем вы узнаете, проверяя рейтинг выдачи.

Вопросы:

- Сайт полностью пропал из Гугла — что делать?!

Первое, на что необходимо обратить внимание — это санкции. Если в Google Search Console нет никаких сообщений системы безопастности по сайту, значит всё впорядке. После этого главную страницу сайта и несколько второстепенных советуем проверить через валидатор файла robots.txt в Google. Если страницы доступны для индексации, то этот пункт можно отмахнуть в сторону. Остается только одно — сайт в Вебмастере Гугл был поставлен полностью на удаление случайно вами или кем то кто работал с сайтом до этого. Проверьте это на существующей версии? а так же постарайтесь добавить все версии сайта в вебмастер тоже (с www и без, с https и без). Посмотрите не удалялись ли там какие страницы. Команду на удаление и блокировку страниц можно отклонить и тогда сайт за сутки залетит обратно в индекс! - Сколько нужно ранжировщику для того, чтобы восстановить мои позиции?

Точного ответа нет, и не может быть, так как факторов, влияющих на сам процесс и его скорость – великое множество. Если речь идет о примененных ручных мерах, то их могут снять через 2-5 недель после принятия вашей заявки. Однако в этом случае не стоит рассчитывать на автоматическое поднятие позиции, потребуется серьезная работа со структурой и наполнения ресурса. - Если структура была сломана, но теперь все исправлено, как сообщить об этом в Гугл?

Сделайте повторную отправку sitemap. Откорректируйте If-Modified-Since, если изменения касались страниц. В индекс отправляйте не только главную, но и связанные с ней. Далее сидим и ждем результатов индексирования, чтобы понять, насколько хорошо вы все исправили. - А почему моя позиция в выдаче Яндекса высокая, а в Гугл – низкая?

Потому что Гугл – это не Яндекс. Это совершенно разные комплексы программ и проверочных сервисов, разные подходы и философии. Если Гугл показывает наличие ошибки, найдите ее и справьте, без сравнения с тем, что думает на этот счет Яндекс. - А почему с такими же ошибками мои конкуренты выше в выдаче?

Это может казаться вам жизненной несправедливостью, но все гораздо проще – бот-ранжировщик мог пропустить какие-то ошибки, или… простить, например, из-за большого количества естественных ссылок нередко закрываются глаза на незначительный переспам или контент, далекий от 100% уникальности. - Что надо, чтобы быть в ТОПе всегда?

Во-первых, важно понять причинно-следственную связь: популярный (качественный, интересный) сайт поднимается в ТОП, а не ТОП делает сайт популярным. Во-вторых, если у вас удобный сайт и 100 честно ведущих на него ссылок, а у вашего конкурента невменяемый ресурс с 100500 купленных ссылок, то, скорее всего, Гугл ранжирует его выше вашего. Вместо того чтобы сетовать на тотальную жизненную несправедливость, есть смысл заняться наращиванием качественной ссылочной массы. - Почему не видна моя страница в ВК (Фейсбуке, ЖЖ и т.д.)?

Это может случиться по разным причинам, но скорее всего они останутся для вас тайной. И не надо воспринимать все «на свой счет»: параллельно с вашей страницей на подобных площадках существуют сотни некачественных или откровенно вредоносных страниц. Попадая под бан, они могут ненароком утянуть с собой тех, кто находится рядом – то есть ни в чем не повинные ВК страницы. Хотите узнать об этом больше в администрации площадки? Желание понятное, но в большинстве случаев неосуществимое – администраторы не дают подобных разъяснений. Просто сделайте собственный сайт, и вы будете точно знать, что взлеты или падения в выдаче – эта ваша личная «заслуга», а не чье-то влияние. - Как связаться с техподдержкой Google, если у меня есть вопросы по ранжированию сайта?

Никак! Независимо от того какой масштабности, срочности и важности ваши вопросы, напрямую связи с Гуглом не существует. Есть форум Google, куда вы можете написать свой вопрос. Если авторитетным форумчанам он покажется интересным и значимым, его передадут для рассмотрения в Гугл, а ответ будет освещен пользователям России или даже мира. Если же они сочтут ее несложной или ничтожно значимой – ответа и разъяснения не будет. - Что такое ручные меры?

Это неприятная ситуация, когда специалист из Google сочтет ваш сайт подозрительным или недобросовестным или малоинформативным или еще каким-то, и понизит выдачу. Неприятность ситуации заключается в том, что доказать что вы не осел – можно, но займет это весьма продолжительное время. Алгоритм снятия ручных мер таков: вы читаете комментарий к ручным мерам, пытаясь понять, за что именно вас линчуют. Это не всегда удается с первого раза, так как Google славится расплывчатостью формулировок, стремясь минимизировать количество судебных исков. Далее исправляете то, что не понравилось специалисту из Гугл, и отправляете на пересмотр, который продлится порядка 2-12 недель. Если в не все до конца исправлено или вы не учли смежные моменты, вам снова придет оповещение о ручных мерах. И снова вы будете переделывать, отправлять и ждать ответа. Вывод: так как повлиять на процесс нельзя никак, единственное, чем можно облегчить свою участь – сразу корректно выполнять исправления, чтобы прошло с первого пересмотра. - Почему мне не приходит ответ о пересмотре исправлений после ручных мер?

Как вариант – вы используете архаичный браузер Internet Explorer. Немедленно перейдите на Google Chrome! - Как посмотреть PR сайта?

Никак! Начиная с 6.12.2013г открытая информация о PR не обновляется и тулбар фактически закрыт. Поэтому: не верьте всевозможным «специалистам» или сервисам, обещающим вам показать динамику PR.

Если вы столкнулись с проблемой, которую не смогли решить с помощью этой статьи — напишите нам комментарий с описанием проблемы и мы постараемся вам помочь!

Хочешь стать экспертом в SEO?

Пройди курсы от SEO Интеллект

ПодробнееПонравилось? Репост!

studiof1.ru

Сайт просел в Google? Как проанализировать причины

«Я больше не вижу свой сайт в ТОП-10 по запросу «элитные квартиры в москве». Что случилось с моими позициями?»

«Почему упал трафик? Я больше не вижу свой сайт в Google! Что происходит?»

«Почему мой сайт в Google упал со 2 места на 6?»

Спросите любого, кто работает в сфере SЕО больше нескольких лет, скорее всего, этот человек получал подобное письмо от клиента. Google обновляет свои поисковые алгоритмы множество раз за год, возможно, небольшие постепенные изменения происходят каждый день. Например, в далеком феврале 2012 года он ввел 40 обновлений всего за 1 месяц. Не стоит забывать и о рандомных колебаниях на самой странице выдачи, они происходят постоянно: сегодня ты первый, а через несколько дней падаешь на десяток позиций, и твоя прибыль снижается.

Если вы попали в такую ситуацию, определите, что пошло не так, и корректно объясните своему клиенту/начальнику, как собираетесь справляться с этой ситуацией.

Подразумеваем, что у вас уже есть набор инструментов для отслеживания статистики сайта. Если нет, вам нужно начать делать это прямо сейчас, иначе вы просто не сможете удержаться на плаву.

Причин падения позиций может быть несколько. Во-первых, нужно определить, насколько плоха ситуация. Компания Mondovo разработала что-то вроде «Матрицы падения позиций». Эта матрица дает оценку событиям в зависимости от количества ключевых запросов, по которым просели позиции, и среднего падения по позициям в выдаче. Матрица представлена снизу:

Матрица падения позиций будет полезна, если вы отслеживаете как минимум 100 ключевых запросов, и у вас прослеживается глобальное проседание сайта. Прежде чем начать анализ позиций, определите правильный сегмент:

- Спокойная зона – когда у вас незначительно просели несколько ключевых запросов. Обычно в этой зоне не стоит паниковать, так как это могут быть ежедневные колебания выдачи, которые происходят в глобальном масштабе.

- Тревожная зона – у вас просело множество запросов, но при этом падение позиций минимальное. Такая ситуация посерьезнее, вам нужно насторожиться и не терять бдительности, чтобы не упустить момент, когда ситуация ухудшится.

- Беспокойная зона – несколько основных запросов выпали из индекса или значительно упали в выдаче. В этой зоне вы теряете ключевой трафик от потенциальных клиентов. Немедленный анализ необходим, чтобы быстро оценить ситуацию.

- Катастрофическая зона – большое количество запросов, которые либо вообще выпали из индекса, либо упали в среднем на 10+ позиций. В этом случае что-то точно пошло не так. Необходимы немедленный анализ и действия по восстановлению.

Теперь, когда вы определили, к какому из 4 сегментов относится ваша ситуация, давайте углубимся в анализ и рассмотрим адекватные причины падения позиций.

Спокойная зона

Возможные причины:

1. Качели Google

Поисковые системы постоянно улучшают свои алгоритмы, особенно в наши дни, когда Google экспериментирует с позициями в режиме реального времени, так что позиции одного сайта могут прыгать в течение дня.

Как исправить?

Никак. Пока падение незначительное, это могут быть рандомные колебания, и со временем вы снова увидите себя в ТОПе. Пока падение не вызвало постоянного снижения органического трафика, можно об этом особо не беспокоиться. Продолжайте свою работу по SЕО в обычном режиме, и все вернется в норму.

2. Вас сместил новый конкурент

Падение в выдаче на 1-2 позиции может быть вызвано появлением нового конкурента.

Как исправить?

Проверьте, какие изменения на странице конкурента проводились недавно. Вы можете сделать это с помощью архива его сайта на Archive.org и сравнить с текущей версией. Также вы можете провести сравнительный анализ двух версий, чтобы определить разницу.

Отдельно можно проверить недавние бэклинки, которые сайт мог получить с других ресурсов – эти ссылки/упоминания могли повлиять на позиции.

Чтобы проанализировать бэклинки, можно использовать инструмент «Анализ качества ссылок» в SEOlib.

Тревожная зона

Возможные причины:

1. Вы потеряли ссылки

Если вы потеряли позиции по многим запросам, есть вероятность, что у вас мог снизиться авторитет сайта.

2. Новый конкурент сместил вас

Причины и стратегия идентичны тем, что описаны в Спокойной зоне.

3. Вы проводили какие-то изменения в структуре в последнее время

Обычно это последняя причина, на которую люди обращают внимание, но она очень вероятна. Вам нужно провести аудит всего сайта, чтобы исправить очевидные проблемы, переоценить любые изменения контента, которые проводились недавно, удостовериться в том, что у вас оптимизированы все внутренние ссылки, и в конце проверить, не напортачили ли вы с тегом rel=canonical.

4. Ваш контент устарел

Если вы заметили, что множество запросов находятся на страницах со статьями или информационным контентом, и их посещаемость снизилась в последнее время, есть вероятность, что Google предпочел более свежие статьи. Это может быть звоночек, чтобы время от времени обновлять старые статьи с хорошими позициями, возможно, даже скрыть дату в постах.

Google показывает дату в некоторых сниппетах. Представьте вашу статью 2009 года и статью конкурента 2015 года – пользователь скорее кликнет на более свежую статью. Google может заметить понижение CTR и опустить сайт в выдаче.

5. Скорость сайта

Google сделал опыт пользователя приоритетным, поэтому решил принимать во внимание скорость сайта при определении позиций.

Проверяйте скорость сайта с помощью Google PageSpeed.

Беспокойная зона

Возможные причины:

1. Потеря ссылок на конкретные страницы, которые просели в выдаче

Если вы потеряли позиции по конкретным страницам сайта, первое, о чем стоит подумать, не потеряли ли вы бэклинки на эти страницы. Потеря в качестве бэклинков может означать снижение качества сигнала ранжирования, что может привести к потере позиций в рейтинге.

2. После обновления алгоритма Google может отдавать предпочтение другим сайтам по этому запросу.

Google может обновить свой алгоритм и определить, что для этой тематики требуются более информативные или свежие страницы, более разнообразный контент в плане изображений/видео/новостей или более «транзакционная» страница.

Некоторые страницы могли упасть именно по этим причинам. Вы можете определить это, понаблюдав за ТОП-10 сайтов, позиции которых сильно изменились по этим запросам. Если это так, вы увидите, что не только ваш сайт был «наказан». Если дело в этом, вам нужно переоценить стратегию продвижения по этим запросам или нацелиться на новые запросы.

Чтобы следить за ТОПами по вашим запросам, используйте «Мониторинг ТОПов».

3. Дублирование контента

Дублирование контента на сайте может быть причиной снижения позиций, поэтому этот вариант тоже стоит проверить.

4. Нерабочие ссылки на страницу

Проверьте внутренние ссылки на страницы, которые упали в позициях, возможно, вы упустили из вида нерабочую ссылку. Наличие таких ссылок может быть сигналом для поисковой системы, так как негативно влияет на опыт пользователя.

5. Устарелый контент.

Катастрофическая зона

Возможные причины:

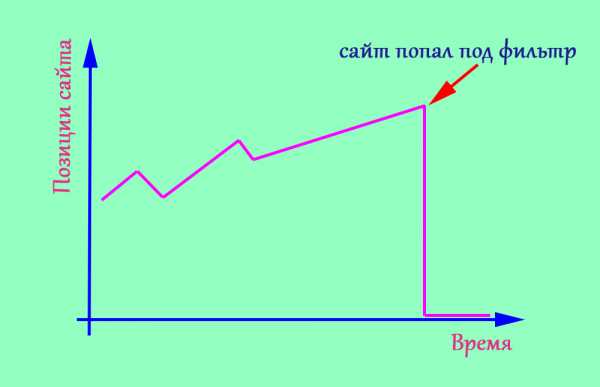

1. Проверьте, не попали ли вы под фильтр Google

Есть два типа фильтров: побочный эффект от обновления алгоритма и фильтр, который команда Google вручную накладывает за нарушение их правил.

Если вы попали под ручные санкции, Google известит вас в Search Console. Если же никакого предупреждения нет, нужно сделать следующее:

— Проверьте, не было ли резкого проседания позиций.

Если было резкое падение органического трафика, то, скорее всего, вы пострадали от очередных обновлений алгоритма.

— Проверьте, находится ли сайт в индексе Google

Пропишите в поисковой строке Google «site:домен.com», если вы видите всего несколько страниц или не видите их вообще, вы имеете дело с фильтром или проблемами индексации.

— Проверьте, были ли недавно обновления алгоритма (история алгоритмов на Moz).

Если проводились какие-то глобальные обновления, и они совпадают с датой, когда упали ваши позиции, это еще один признак попадания под фильтр.

Проверить, не наложен ли фильтр на сайт, можно также с помощью бесплатного инструмента «Диагностика санкций».

2. Проверьте robots.txt и теги meta robots

Возможно, вы ошибочно закрыли ваш сайт или его ключевые страницы от поисковиков, неправильно настроив robots.txt или поставив не в то место тег “noindex”. Такие случаи бывают редко, но никогда нельзя быть уверенным. К тому же, это самые легкий способ исправить ситуацию (так что вы будете молиться, чтобы причина была именно в этом ;)).

Иногда самая простая ошибка может вызвать наибольший ущерб.

3. Вы изменили структуру контента, чтобы добавить больше рекламы

Обновление Google Panda обесценило сайты, которые препятствуют получению информации пользователями. Если вы изменили структуру контента, чтобы показать больше рекламы, и ее размещение может повлиять на опыт пользователя, это может негативно отразиться на ваших позициях в выдаче. Стоит убедиться, что вы не идете на компромисс с удобством пользователя ради монетизации сайта.

4. Вы полагались на сеть ссылок

Вы сознательно построили сеть искусственных ссылок из личных блогов, каталогов и т.д. или имела место массовая генерация ссылок? Велика вероятность, что Google/Bing пронюхал об этом и обесценил эти ресурсы.

На этом матрица и возможные варианты, которые находятся внутри каждого сегмента, завершаются.

Надеемся, что вы сможете определить, почему просели позиции вашего сайта или вашего клиента и составить список актуальных действий. Ваша следующая задача – донести плохие новости вашему клиенту и при этом не утратить его доверие.

Оригинал статьи на английском

Если Вам нужна помощь в лечении сайта от фильтра Google, обращайтесь в SiteClinic.

blog.seolib.ru

9 популярных ошибок любого сайта. Или почему не растут позиции.

Поисковая оптимизация – большая работа над множеством различных факторов. Дизайн, техническая составляющая, контент. Даже незначительные на первый взгляд детали очень важны для продвижения. О самых частых ошибках в дизайне сайта мы уже говорили. Сегодня разберем 9 фатальных SEO ошибок, способных «угробить» любой сайт.

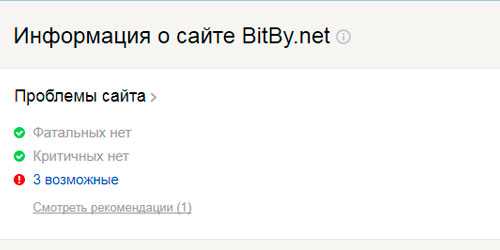

Как минимум, раз в неделю рекомендую заглядывать в вебмастера Яндекс и Google для проверки наличия санкций. В Яндексе это можно сделать в разделе Диагностика → Безопасность и нарушения. В Google – Поисковый трафик → Меры, принятые вручную.

Как показывает наша практика, чаще всего владельцы сайтов даже не догадываются о наложенных ограничениях. Недавний пример из нашей работы:

Большое количество чужих текстов на сайте и открытые исходящие ссылки. Результат на скриншоте.

До снятия всех ограничений дальнейшего смысла заниматься продвижением нет. Исправляем все ошибки, сообщаем поисковой системе и ждем снятия санкций.

Мы постоянно говорим о том, как важны тексты. Контент – это то, зачем пользователи заходят на сайты. Неуникальный и неинтересный контент никому не нужен. Поисковые системы занижают подобные ресурсы в выдаче, а клиенты устали читать одни и те же шаблонные тексты на сотне сайтов. Пруф того, что за контент можно вылететь с хороших позиций, тут.

Проверяйте уникальность текстов перед размещением на text.ru.

Как писать тексты, на какие страницы и в целом, о контенте, много написано в нашем блоге. Вот хорошая подборка статей от нашего копирайтера Дарьи.

Основа SEO-продвижения – правильно подобранные ключевые слова. Это очень важный фактор в оценке релевантности вашего сайта поисковому запросу.

Чаще всего мы сталкиваемся с двумя ошибками. Полное отсутствие ключевых слов в тегах:

Тег Title должен быть заполнен в виде связного предложения с включением ключевых слов.

Либо переспам ключами в заголовках:

Важно найти золотую середину. Теги должны быть полезными не только для поисковых роботов, но и для обычных людей. Не забывайте об информативности. Как правильно писать теги title, description и заголовки h2, хорошо рассказывает наш копирайтер Екатерина в своей статье.

C января 2017 года браузер Google Chrome (начиная с 56 версии) начал помечать все HTTP-сайты, содержащие любые формы, передающие личные данные пользователей (email, пароли, данные кредитных карт и т.п.) как «небезопасные». Также наличие SSL сертификата является небольшим импульсом в ранжировании в Google.

Всем интернет-магазинам в первую очередь следует перейти на протокол https. При этом очень важно соблюсти правильный алгоритм действий.

Самая частая ошибка – просто настроить 301-редирект со старой версии http на https после покупки SSL-сертификата. Владельцы сайтов забывают о файле robots.txt, директиве Host, настройке вебмастеров. Сайт с http выпадает из индекса, новый сайт на https еще не проиндексирован. Все позиции моментально улетают в трубу.

В нашем Блоге есть подробная инструкция, как правильно перенести сайт с http на https. Если останутся вопросы, пишите нам, обязательно поможем.

Текстовый файл, размещенный на сайте и предназначенный для роботов поисковых систем. В этом файле следует указать параметры индексирования своего сайта для поисковых роботов.

Иногда файл robots.txt отсутствует вовсе.

Свежий пример из нашей работы. Интернет-магазин станков, работы проводились в рамках услуги поисковое продвижение сайта. Сайт был полностью открыт для индексации поисковым роботам и вовсе не имел файл robots.txt.

Настроили ему robots, теперь все в порядке:

Что конкретно мы сделали?

Закрыли от индексации админ панель сайта, служебные страницы 404 и 403, страницу поиска, корзину. Указали адрес карты сайта, настроили директиву Host.

Вместе с остальными работами по оптимизации это помогло достичь следующих результатов:

Еще одна серьезная ошибка – сайт полностью закрыт от индексации. За это отвечают директивы Disallow и Allow, которые запрещают или разрешают индексирование разделов, отдельных страниц сайта или файлов соответственно. Для проверки файла у поисковых систем есть специальные инструменты: Яндекс и Google.

Проверьте, что у вашего сайта имеется файл robots.txt и заполнен он корректно. От индексации следует закрывать все служебные страницы, страницы поиска и фильтров. Страницы дублей, регистрации, авторизации. Корзину и страницу оформления заказа для интернет-магазинов. Подробнее о robots.txt.

Дублированный контент или просто дубли – это страницы на вашем сайте, которые полностью (четкие дубли) или частично (нечеткие дубли) совпадают друг с другом, но каждая из них имеет свой URL.

Одна страница может иметь как один, так и несколько дублей:

Поисковые роботы отрицательно относятся к дублированному контенту и могут понизить позиции в выдаче из-за отсутствия уникальности, а следовательно, и полезности для клиента. Нет смысла читать одно и то же на разных страницах сайта.

Может измениться релевантная страница. Робот может выбрать для выдачи дублированную страницу, если посчитает ее содержание более релевантным запросу. Сайт потеряет позиции и просядет в выдаче. В 90% случаев дубли мешают продвижению, и после их устранения позиции сайта улучшаются.

Как найти и убрать дубли на сайте, рассказываем в данной статье.

Зеркалами считаются сайты, являющиеся полными копиями друг друга, доступные по разным адресам. Все зеркала сайта важно склеить через 301 редирект.

Показатели тИЦ, вес внешних ссылок не должны растекаться, а они будут, т.к. поисковики считают разными ресурсами сайты, расположенные по разным адресам. Возможна подмена релевантной страницы в поисковой выдаче, дублирование контента. 100% мешает росту сайта в выдаче.

Сайт не должен открываться по разным адресам, с www и без www, просто site.ru и site.ru/index.php, по http и https и т.д.:

Чек-лист для проверки:

- Сайт должен быть доступен только по одному протоколу http или https.

- Выбрано главное зеркало сайта, с www или без www, указано в Вебмастере.

- Настроен 301 редирект со всех зеркал.

- Главная страница сайта доступна по одному адресу, без /index.php, /index.html и т.п.

100% Must-have для всех сайтов в 2017 году. Сегодня рост мобильного трафика опережает компьютерный. Число пользователей, использующих смартфоны для совершения покупок, в мире растет с каждым днем. Алгоритмы поисковых систем учитывают адаптивность при ранжировании сайта в мобильной выдаче.

Google уже с 2015 года использует алгоритм Google mobile-friendly.

Яндекс год назад запустил алгоритм Владивосток.

Если ваш сайт все еще не адаптирован под мобильные устройства – каждый день вы теряете до половины своих клиентов. Подробнее о том, зачем нужна оптимизация.

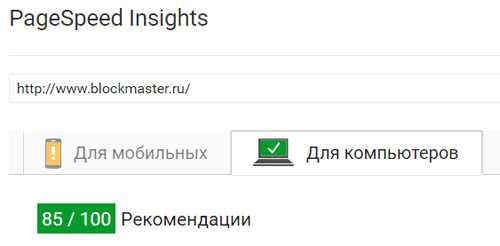

Тут все просто. Пользователям не нравятся медленные сайты. Поисковые системы так же отдают предпочтение быстрым, оптимизированным сайтам. Проверить скорость загрузки своего сайта можно с помощью инструмента Google. Красный – медленно, важно срочно увеличивать скорость, желтый – нормально, но можно оптимизировать, зеленый – отлично.

Разберем на конкретном примере

Помните, в начале статьи мы упоминали интернет-магазин станков. Что мы исправили из фатальных ошибок:

- Неуникальный контент

Написали хороший продающий, уникальный текст на главную страницу сайта.

До проведения работ:

После оптимизации:

- Ошибки оптимизации

Скорректировали теги title и description, заголовки h2.

До проведения работ:

После оптимизации:

- Отсутствие файла robots.txt

Создали и настроили файл robots.txt. Сейчас сайт правильно индексируется поисковыми системами. До этого, как писали выше, данного файла не было на сайте вовсе.

- Наличие не склеенных зеркал

Склеили зеркала сайта. Сайт был доступен по двум адресам с www и без.

- Некорректный ответ сервера для несуществующих страниц

Создали отдельную страницу 404 и настроили правильный ответ сервера для несуществующих страниц.

До выполнения работ несуществующие страницы через 302 редирект перенаправляли пользователя на главную страницу сайта.

Результаты:

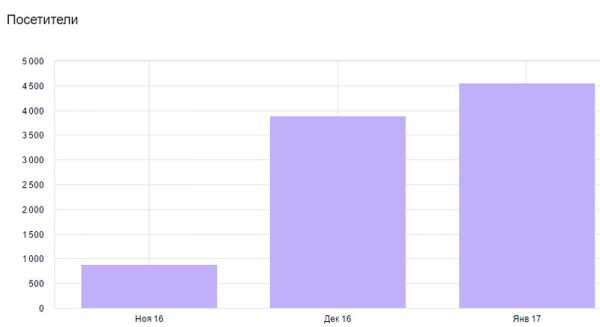

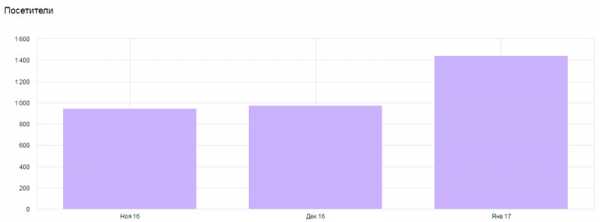

Положительная динамика роста посещаемости из поисковых систем:

Трафик из Google вырос в два раза:

Результат за 3 месяца:

+8 запросов у Яндекса, +6 у Google в топ-5

+19 запросов у Яндекса, +9 у Google в топ-10

+25 запросов у Яндекса, +11 у Google в топ-20

+14 запросов у Яндекса, +4 у Google в топ-50

Посмотреть позиции до и после »

Хотите так же? Проверьте, может данные ошибки есть и на вашем сайте. Если нет времени и желания разбираться, заказывайте поисковое продвижение у нас, с радостью поможем.

1ps.ru

8 основных причин проседания позиций сайта

8 типичных причин падения позиций в поисковой выдаче

Если Вас заинтересовала тема этой статьи, значит для Вашего веб-ресурса является актуальной проблема падения позиций в поисковиках.

Поэтому не будем долго разглагольствовать о том, как неожиданно может случаться проседание позиций сайта и какие неприятности это доставляет.

Лучше перейдем сразу к делу и рассмотрим самые частые ситуации, которые помогут Вам понять, почему падают позиции сайта в Вашем конкретном случае и как это можно исправить.

Почему сайт теряет позиции в поиске

- Ухудшение качества контента довольно часто становится причиной падения позиций в Яндексе и Google. Поэтому если Вы вдруг решили сэкономить на копирайтере и начали публиковать дешевые, неактуальные, неуникальные, плохоотрерайченные тексты не стоит удивляться, почему упали позиции сайта. Поисковики всегда следят за тем, чтобы их пользователям был доступен только самый качественный контент.

- Прекращение наращивания ссылочной массы (особенно резкое) может стать причиной не только падения позиций в поисковиках, но также и наложения санкций с их стороны. Резкие падения (как и взрывы) всегда говорят об искусственном формировании ссылочного профиля, с чем неустанно пытаются бороться поисковые системы.

- Глобальные изменения на веб-сайте почти всегда приводят к падению позиций в Google и других поисковиках.

Переделка структуры, смена дизайна, изменение адресов страничек, неумелое обновление контента, влекущее за собой переоптимизацию ключевыми словами – это лишь некоторые из частых ошибок, совершаемых веб-мастерами, которые пытаются понять, почему упали позиции сайта.

- Влияние хостинга является далеко не последней причиной, по которой падают позиции веб-сайтов. Если Ваш веб-ресурс «раздувается в размерах» или внедряются новые «утяжеляющие» скрипты, может настать момент, когда доселе безотказно работающий сервер перестанет справляться с увеличивающейся нагрузкой. За этим нужно следить и вовремя «переезжать» на более мощный современный хостинг.

- Внедрение новых и изменения в старых алгоритмах ранжирования постоянно становятся причиной, по которой наблюдается падение позиций в Яндексе и Google.

- Перерывы или полное прекращение продвижения в социальных сетях неизбежно вызывает падение позиций в поисковиках, если раньше этот вид активности велся постоянно. Ведь таким образом уменьшается не только количество трафика из соц. сетей, но и социальных сигналов, которые учитываются при ранжировании.

- Естественное вытеснение конкурентами случается постоянно. Поэтому иногда вместо поисков причины, почему сайт теряет позиции, нужно проводить анализ конкурентов и следить, чтобы Вы всегда были на шаг впереди в плане работы над веб-сайтом.

- Попадание под фильтры поисковых систем по одной из многочисленных причин может повлечь за собой проседание позиций сайта, а иногда и на полное исчезновение его из индекса. Чаще всего это случается из-за использования неодобренных поисковиками методов продвижения (в основном черное, но иногда и серое SEO).

Что делать после определения причины проседания позиций сайта

Если с помощью вышеприведенного списка Вам удалось достоверно определить, почему упали позиции сайта, следующим логичным шагом будет устранение причин, из-за которых это произошло.

Иногда падение позиций в Google и других поисковиках можно остановить и повернуть вспять самому, если причина была явной и не слишком серьезной:

- улучшить качество контента;

- продолжить регулярно закупать ссылки должного уровня качества;

- вернуть старый удобный дизайн, вместо нового, который не оценили посетители и т. д.

Но случаются ситуации, когда без сторонней помощи опытных SEO-оптимизаторов не обойтись. Поэтому если устранить причину самостоятельно не получается или Вы так и не смогли выяснить, почему сайт теряет позиции, можете обратиться за помощью к нам и мы Вам обязательно поможем!

seo-akademiya.com

У вашего сайта проблемы с Google? / Habr

Цель этой публикации — объяснить веб-мастерам основные причины по которым их сайты может, мягко говоря, недолюбливать Google. Также предлагается система диагностики попал ли сайт под санкции Google или нет.Мой сайт под фильтром Google? Как узнать под каким? Просел сайт в выдаче, в чём причина? Падают позиции и нет посещаемости, в чём дело?

Именно с таким названием вы увидите темы на большинстве известных SEO-форумах и на Справочном форуме для веб-мастеров Google.

Сразу отметим, что вместо слова «фильтры» в таких ситуациях уместнее употреблять слово «алгоритмы».

На самом деле причина проблем с сайтом может быть не связана с мерами воздействия Google.

Техническая сторона

1. Для начала проверьте нет ли проблем с хостингом.

2. Затем проверьте присутствует ли в исходном коде этот мета-тег.

/>

Как показал опыт общения с веб-мастерами на Справочном форуме Google, наличие в коде этого мета-тега — типичная ошибка для сайтов на WordPress. Почему именно на WordPress, сложно сказать, но таковы результаты наблюдений. Вероятно, веб-мастера иногда забывают снять указатель в настройках темы, запрещающий сканирование сайта поисковыми системами. Второй вариант — этот мета-тег появился в результате взлома сайта.

3. Проверьте, правильно ли настроен основной домен сайта.

4. Проверьте ваш robots.txt, не закрыли ли вы там чего лишнего.

«Matt Cutts» позвонит?

Если ничего из вышеуказанного не является причиной проблем с сайтом, тогда нужно копать в сторону Google.

Есть только три канала связи по которым можно точно узнать у Google, попал ваш сайт в немилость (под санкции) или нет. Первый и самый простой — проверить обе (все) версии сайта в Google Search Console на предмет наличия мер, принятых вручную (раздел “Поисковый трафик”). Второй — обратиться на Справочный форум для веб-мастеров Google. За каждым справочным форумом закреплён сотрудник Google. В русскоязычном форуме для веб-мастеров это Андрей Липатцев и Екатерина Черткова. При обращении на форум не нужно в названии темы писать что-то наподобие — «Андрей Липатцев, помоги». Дело в том, что сотрудник Google отвечает на форуме при наличии у него для этого времени или если Ведущие участники не могут предложить однозначное решение (уведомляют об этом сотрудника Google). Третий канал — написать в Сообщество Google для веб-мастеров. Там тоже часто отвечает на вопросы пользователей сотрудник Google Андрей Липатцев.

Если в Search Console вы обнаружили сообщение о мерах, внимательно его прочитайте и следуйте описанным инструкциям.

Практика показывает, что в 75 процентах случаев меры применяются за ссылочный и анкорный спам, 10 процентов за неинформативное и бесполезное содержание (обычно как дополнение к абузам за нарушение авторских прав), 10 процентов — за маскировку и скрытую переадресацию — например за вап-клик, и 5 процентов за прочие нарушения Рекомендаций для веб-мастеров.

Если сообщение о мерах в Search Console отсутствует, но трафик и позиции сайта резко падают или, не дай Господь, сайт вовсе исключили из индекса, значит, тут самая вероятная причина — воздействие одного из алгоритмов Google.

Основные алгоритмы Google

Основных алгоритмов, о которых известно вебмастерам и которые влияют на ранжирование, четыре:

Page Layout Algorithm — наказывает сайты за чрезмерное количество рекламы.

Категорически не следует перегружать верхнюю часть веб-страницы рекламными объявлениями. Шквал рекламы не должен обрушиваться на пользователей, приходящих на ваш сайт.[1]

Pirate Algorithm — пессимизирует сайты за нарушение авторских прав (DMCA). У Google есть и специальная форма, через которую правообладатель может подать жалобу. На практике встречались случаи, когда из-за жалобы правообладателя на незаконное использование изображений была удалена из индекса главная страница сайта. Вся информация о таких нарушениях («абузах») в итоге собирается в Lumen (ранее в Chilling Effects).

Google Penguin — Пингвин наверно один из самых известных в среде веб-мастеров алгоритм. Он призван бороться со всеми случаями и видами спама в интернет.

Google Panda — алгоритм, получивший своё название от фамилии одного из инженеров Google — Panda Navneet. Google Panda является алгоритмом изменения результатов ранжирования поиска Google, который впервые был выпущен в феврале 2011 года. Изменения направлены на понижение ранга некачественных сайтов или бесполезного контента, и возврат в верхнюю часть результатов поиска высококачественных сайтов.[2]

Дополнительно рекомендуем изучить:

Амит Сингхал. Дополнительные рекомендации по созданию сайтов с качественным содержанием.

На самом деле таких алгоритмов значительно больше, чем четыре. О многих из них, например о Payday Loan Algorithm, вебмастерам мало что известно или практически ничего не известно.

Способы диагностики воздействия алгоритмов

Информацию о том, воздействует ли на сайт тот или иной алгоритм знают наверняка только сотрудники Google. Естественно, с веб-мастерами они этим не делятся.

Что касается поисковых алгоритмов, здесь мы, обычно, не можем дать какого-либо конкретного совета.

Джон Мюллер (John Mueller)[3]

Таким образом, мы (вебмастера) можем только предполагать пессимизирован ли сайт алгоритмами Google или нет. Есть несколько маркеров по которым можно предположить какой именно алгоритм воздействует на сайт и за что.

Самый лучший показатель качества сайта — это трафик.

Мария Моева[4]

Следовательно первый и основной маркер — резкое падение трафика, позиций в поисковой выдаче. Это говорит о том, что в глазах Google ваш сайт резко потерял в качестве. Вам нужно установить причину.

Если сайт увешан рекламой как новогодняя ёлка — не исключено воздействие алгоритма Page Layout. Тут нужно учесть такой нюанс:

Начиная с сегодняшнего дня [2 нояб. 2015 г. — прим. авт.], страницы с межстраничной рекламой установки приложений, скрывающей существенный объём контента при переходе со страниц результатов поиска, перестанут считаться приспособленными для мобильных устройств. Вместо полностраничных межстраничных объявлений мы рекомендуем веб-мастерам использовать более удобные для пользователей форматы, такие, как баннеры для установки приложений.

Андрей Липатцев

Введите в строку поиска оператор site:domain.com, нажмите клавишу Enter. Добавте в конце ссылки в браузере &start=990 и снова нажмите клавишу Enter. Просмотрите с конца выборочно пять страниц результатов выдачи. Если вы увидите сообщение «В ответ на жалобу, полученную на основании US Digital Millennium Copyright Act (Закона США о защите авторских прав в цифровую эпоху), мы удалили несколько результатов…» — это означает, что правообладатель подал на вас жалобу. Чем больше жалоб, тем выше вероятность попасть под воздействие Pirate Algorithm.

Второй маркер — диагностика спама.

Проанализируйте ваш домен сервисом Ahrefs. Обратите внимание на резкие пиковые скачки прироста dofollow-ссылок.

Даты появления ссылок также могут быть использованы для обнаружения «спама». Обычно, «законопослушный» документ (страница) привлекает обратные ссылки медленно. Большой (пиковый) рост количества обратных ссылок может указывать на то, что страница является источником популярной новости, или сигнализировать о попытке поискового спама.[5]

Несмотря на то что официально Google это не подтверждает, следует прислушаться к мнению основателя Cognitiveseo Развана Гаврилас (Razvan Gavrilas) и Варени Вячеслава о том, что если в структуре ссылочного профиля доля dofollow-ссылок меньше 10 процентов — это может свидетельствовать о его неестественном (спамном) формировании.

Обратите внимание на структуру анкоров ваших обратных ссылок. По нашему мнению, анкоры с долей более 15 процентов в общем количестве могут быть квалифицированы как спам.

Избыточное количество ключевых слов в контенте и в мета-тегах тоже указывает на спам.

Третий маркер — качество контента.

Автоматически сгенерированный текст, текст о том «как налить стакан воды», отсутствие своего полезного и информативного основного контента — может быть причиной пессимизации сайта.

Лучший способ увидеть, избежал ли сайт воздействия алгоритма, — отслеживать органический трафик с помощью аналитики, обращая внимание на большие перепады. Затем следует проверить, подтвердили ли специалисты Google обновления. [6]

Проверить воздействует ли на сайт алгоритм Panda или Penguin можно при помощи онлайн-инструментов или проанализировать самостоятельно.

Google Penguin Checker Tool — показывает динамику органического трафика используя данные SEMrush и апдейты алгоритма Penguin.

Website Penalty Indicator — это более функциональный онлайн-инструмент. Он тоже использует данные SEMrush, но показывает кроме обновлений Пингвина обновления еще нескольких важных алгоритмов, в том числе Google Panda.

Хотелось бы объяснить, как мы собираем свои данные. У нас есть база данных из 106 миллионов самых популярных ключевых слов, распределенных по 26 региональным базам. Когда мы обновляем ключевое слово, мы ищем его в Google и делаем снимок первых двух страниц выдачи.

Таким образом, если в SEMrush нет информации о трафике, это значит, что домен не появлялся в выдаче на первых двух страницах для тех ключевых слов, которые содержатся в нашей базе. Обычно все-таки оценочный трафик согласно SEMrush меньше трафика в Google Analytics.

Elizaveta Lavrienko, SEMrush Customer Support Specialist

Если вы хотите воспользоваться онлайн-инструментом, то лучше выбрать такой, который берет данные из Google Analytics.

Barracuda — бесплатный сервис, использующий данные из Google Analytics и показывает динамику трафика между обновлениями Google Panda и Google Penguin.

Что касается инструмента Диагностика санкций от SEOlib, то к сожалению в нем последнее время не обновляется информация о последних апдейтах алгоритмов Google.

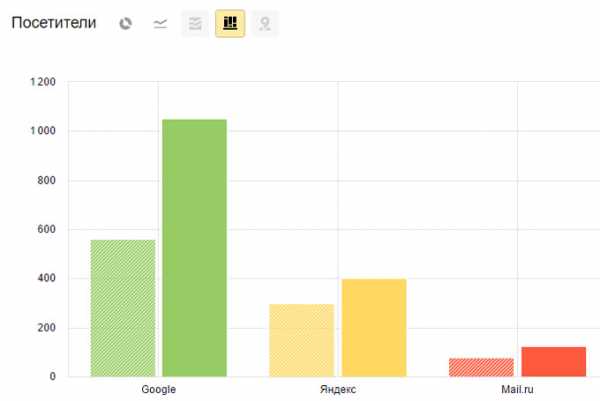

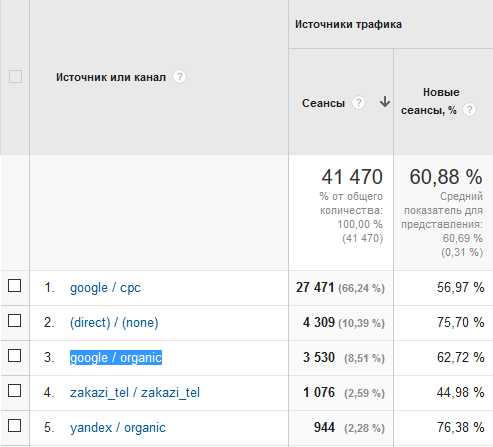

Для самостоятельного анализа войдите в Google Analytics — Источники трафика — Весь трафик — Источник/Канал. Тут нужно обратить внимание какое место в списке занимает «google / organic». Обычно это первая или вторая позиция.

Как мы видим у этого сайта органический трафик с Google лишь третий, а Яндекс и вовсе пятый.

Поставьте отметку напротив «google / organic» и нажмите на кнопку «Показать на диаграмме». Сопоставьте периоды резкого снижения органического трафика с Google с подтвержденными датами обновлений алгоритмов Google.

Надеемся, что эта статья поможет вам быстро разобраться действуют ли в отношении вашего сайта какие-то санкции или нет.

Источники информации

[1]searchengines.ru «Мэтт Каттс на Pubcon Las Vegas 2013: чего ждать вебмастерам от Google в ближайшее время».

[2]Google Panda. Статья из Википедии.

[3]searchengines.ru «Google не даёт советы тем, чьи сайты пострадали от алгоритмических санкций».

[4]Видеовстреча с веб-мастерами — 18.06.15 — Рекомендации по обеспечению качества (50-я минута).

[5]Document scoring based on document inception date. United States Patent Application 20070094254. Kind Code A1. Cutts; Matt; et al. April 26, 2007.

[6]searchengines.ru «Google «Панда» 4.2: вопросы и ответы».

habr.com

Просел трафик из Google. Предположительно, из-за размещения рекламы Google Adsence на сайте. Как вернуть прежние позиции?

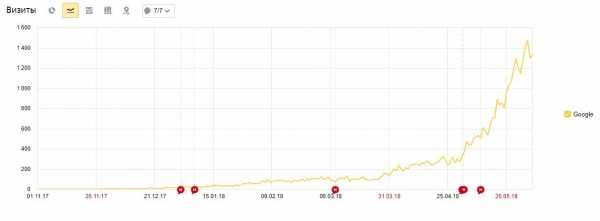

Здравствуйте. Имеется информационный сайт медицинской тематики. Возраст сайта — примерно 1 год. Проект продолжает развиваться, периодически появляются новые статьи (2-3 в неделю). Ссылки не покупались. С момента запуска сайта наблюдался планомерный рост трафика из ПС Google (как видно на первом графике).

Все это время сайт монетизировался с помощью Рекламной Сети Яндекс. В статье было размещено 4 рекламных блока и блок в сайдбаре. Средний размер статьи — 10 тыс. символов.

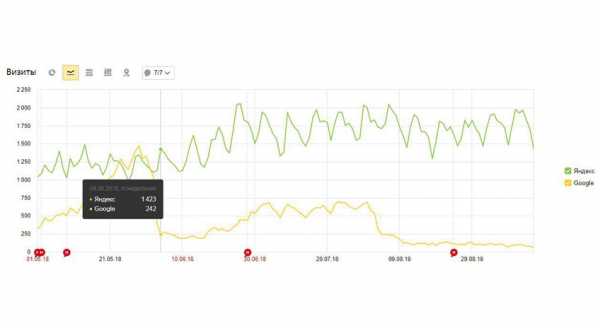

В определенный момент решил попробовать Google Adsence. Оставил в статье только 1 блок Яндекса и включил показ автоматизированных объявлений от Google. Спустя 5 дней трафик из Google начал резко падать, со стороны Яндекса реакции никакой не было (см. второй график).

Т.к. больше никаких изменений не вносилось, то логично предположить, что причина санкций — размещение кода Google Adsence. Этот убрал, вернул прежние блоки Яндекса. Спустя какое-то время трафик стал возвращаться.

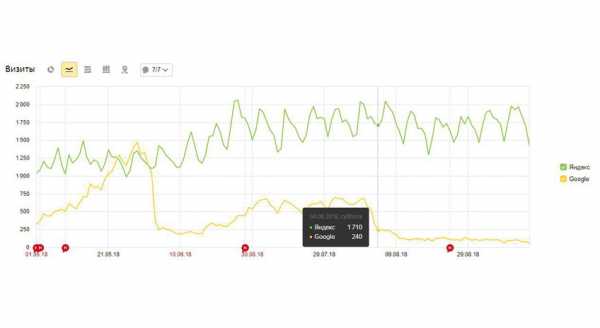

На этом я не остановился и решил попробовать рекламу от Google еще раз. На этот раз сделал все с большей осторожностью: в настройках автоматизированных блоков оставил только оверлей-блоки на мобильных устройствах. От Яндекса оставил 3 блока на статью. Спустя 4-5 дней трафик из Google просел до минимума (график №3).

Код Adsence убрал окончательно. Трафик не возвращается. В кабинете вебмастера никаких мер вручную принято не было. Страницы из индекса Google не удалились, просто были отброшены на 10-30 позиций в выдаче. Поведенческие метрики никак не изменялись с включением/выключением рекламы от Google.

Собственно вопрос: как вернуть трафик? Подскажите, в какую сторону копать и есть ли мысли, почему сайт попал под санкции?

toster.ru

причины, решение › Блог Интернет Технологий

Продвигая клиентские сайты часто сталкиваешься со следующей ситуацией: после определенного времени работы над сайтом год-полтора, клиент говорит, что необходимые показатели достигнуты и поэтому SEO-продвижение пока приостанавливаем. Спустя некоторое время сайт вполне естественным образом начинает проседать по видимости в поисковых системах и трафике соответственно. Из-за чего складывается подобная ситуация, попробую разобраться в статье.

1. Плохое качество контента, который публикуется на сайте. Эта ситуация часто становится основной причиной, из-за которой сайты теряются в рейтингах поисковых запросов. Если вы начали экономить на статьях и снизили оплату копирайтерам, то стоит ждать, что они не будут столь интересными и актуальными как раньше. При составлении технического задания копирайтеру SEO-специалист собирает поисковые запросы, по которым статья будет продвигаться, указывает необходимый объем статьи (на основе анализа страниц конкурентов, которые находятся в ТОПе), собирает LSI-слова и описывает структуру статьи, другими словами что в ней обязательно должно быть. Зачастую владельцы сайтов, после прекращения работы по SEO-продвижению просто заказывают статьи на биржах копирайтинга (а еще хуже покупают готовые) не задумываясь о том, как необходимо правильно это делать. Последний, наиболее значимый алгорит предназначеный бороться с переоптимизацией контента от компании Яндекс — Баден-Баден.

2. Если вы резко перестали наращивать ссылочную массу, то будьте готовы не только к тому, что сайт упадет с былой позиции, но и, возможно, к всевозможным санкциям со стороны поисковых систем. Это происходит из-за того, что резкий спад наращивания говорит об искусственной раскрутке сайта, а популярные поисковики ведут активную борьбу с этим. Как правило в свою стратегию по продвижению я закладываю закупку небольшого количества ссылок, однако, они максимально качественные, естественные и наращивание происходит на постоянной основе.

3. Если в недавнем времени были проведены ощутимые изменения, то это вполне может привести к падению позиций в ведущих поисковых системах. Что это значит? Все очень просто, если на вашем ресурсе были проведены работы по изменению дизайна, адресов, сомнительное появление контента, переоптимизированного ключевиками — это лишь самая малая доля причин, с которыми сталкиваются разработчики сайтов да определенном этапе. Зачастую клиенты меняют URL адреса страниц не задумываясь о том, чтобы элементарно сделать 301-редирект со старого адреса на новый.

4. Особую роль в нашем вопросе играет и хостинг. Если созданный вами сайт разрастается, и в него вшиваются новые тяжелые скрипты, то очевидно, что долго сервер не сможет справляться с той нагрузкой, которую требует дать сайт. В таком случае следует тщательно следить за развитием своего проекта, вовремя менять провайдера и тариф, к которому вы подключились ранее. Лично я, выбираю хостинг от beGet уже на протяжении 5 лет.

5. Всевозможные изменения в алгоритмах, будь то вставка новых или манипуляции со старыми — из-за такой работы часто наблюдается спад в ТОПе Google и Яндекса. Следите за последними новостями поисковых систем на тематических сайтах и форумах. Будьте в тренде, товарищи

6. Если ранее вы активно продвигали свой ресурс в социальных сетях, создавали тематические посевы в группах и вели какую-либо деятельность, то после её прекращения стоит ожидать, что не будет происходит продвижения в результатах поиска, а придется наблюдать лишь за скачками вниз. Отказываясь от продвижения через социальные сети, вы прекращаете получать социальные сигналы на свой ресурс.

7. Конкуренция. Этот фактор часто становится основной причиной возникновения такой сложности. На любом рынке иногда происходит вытеснение другими компаниями, в нашем случае, сайтами. Чтобы избежать такого развития событий необходимо тщательно следить за деятельностью своих коллег, стараясь опережать их на несколько шагов. А также не забывайте следить за показателями сайта, не давайте слабину, иначе, конкуренция подавит вас.

8. Если ваш сайт перестал соответствовать требованиям предъявляемыми поисковыми системами, то это может грозить либо небольшим падением с прежнего положения, либо же полным исчезновением из индекса Яндекса и Google. В основном причиной такого расклада является некачественное продвижение сайта, это значит, что, если для продвижения вы использовали черный или серый SEO, то стоит ожидать плачевных ответов от поисковиков. Обращайте особое внимание на панели Яндекс.Вебмастер и Google Search Console — обрабатывайте все ошибки и предупреждения.

Если вы нашли и выявили причины, по которым происходят проблемы с сайтом, то следует действовать дальше, либо же обратиться к профессионалам.

Если причина была не такой серьезной, то вернуть прежнее положение может оказаться достаточно просто и самостоятельно. Потребуется лишь улучшить контент на ресурсе, регулярно поставлять ссылочную массу и совершить правильный переход на новую структуру сайта.

Если Вы самостоятельно не можете определить причину падения позиций сайта в результатах поиска Google и Яндекс, либо не знаете, почему трафик на сайт не растет — то Вы всегда можете обратиться ко мне за консультацией. Связаться со мной можно здесь. С уважением, Vasilenko Ivan!bitby.net