🚀 Самостоятельный аудит сайта, часть 2.1 — SEO-аудит

Как проверить оптимизацию сайта — обновленный материал из серии о самостоятельном аудите.

Продолжаем серию материалов об аудите сайта своими руками. В этом посте — SEO-аудит страницы, в предыдущей статье мы разбирали, как проверить технические параметры. Пока писали статью, поняли, что в один пост все не уместится, поэтому здесь продолжение про аудит контента.

В статье:

- Доступность сайта для индексации, robots, sitemap

- Канонические URL

- Архитектура сайта и уровень вложенности страниц

- Внутренние ссылки

- Внешние ссылки

- SSL-сертификат

- Пагинация в каталоге

Доступность сайта для индексации, корректность Robots.txt и Sitemap

Страницы сайта, за исключением служебных, должны быть доступны роботам для сканирования и индексации. Закрыть от поисковых ботов нужно дубли, панель администратора, корзину, другие технические файлы, которые не должны быть в выдаче.

Файл robots.txt

Прописать доступы можно в файле robots.txt — это текстовый файл с указаниями по индексированию для роботов. Файл robots.txt использует систему директив — правил, задаваемых поисковому роботу.

«User-agent:» — основная директива robots.txt. Используется для конкретизации поискового робота, которому будут даваться указания. Например, User-agent: Googlebot — все команды, следующие после этой директивы, будут касаться исключительно индексирующего робота Google;

После основной директивы «User-agent:» следуют конкретные команды:

- «Disallow:» — директива запрета индексации в robots.txt.

- «Allow:» — директива разрешения индексации. На практике «Allow:» используется редко, поскольку поисковый бот применяет ее автоматически.

- «Sitemap:» указывает индексирующему роботу путь к файлу Карты сайта. Помогает проиндексировать Карту, чтобы страницы сайта быстрее попали в поисковую выдачу.

Полезное по теме:

Как правильно составить robots.txt

Сгенерировать файл robots.txt для вашего сайта можно с помощью сервиса PR-CY.

Как проверить правильность robots.txt:

- название файла — «robots.txt» и только такое;

- файл находится в корневом каталоге — https://site.com/robots.txt;

- файл robots.txt один единственный;

- формат — .txt;

- вес — до 32 КБ;

- кодировка файла — UTF-8;

- доступен, отдает HTTP-код 200 ОК;

- каждый префикс URL на отдельной строке;

- состоит только из латиницы, кириллические ссылки сконвертированы в Punycode.

Боты относятся к файлу, как к рекомендациям: запрещенная вами страница может попасть в индекс, если на нее ведет ссылка с доступной боту страницы, по которой он может перейти.Если вы не хотите, чтобы страница попала в выдачу Google, закройте доступ к ней паролем или «nofollow».

Файл sitemap.

xml

xmlФайл sitemap.xml, то есть Карта сайта, помогает роботам сканировать проект. Файл сообщает роботам поисковых систем:

- какие страницы сайта нужно индексировать;

- как часто обновляется информация на страницах;

- какие страницы наиболее важны для индексации.

В файле нужно собрать список страниц, которые должны быть в индексе. Закрытые для ботов, неканонические, неактуальные, удаленные URL в Карту добавлять не нужно.

Поисковый робот может не найти некоторые страницы или неверно определить их важность. Проблемными обычно становятся динамически создаваемые страницы или страницы, к которым ведет длинная цепочка ссылок. Файл Sitemap решает эти проблемы.

Полезное по теме:

Как составить Карту сайта правильно

Как проверить правильность файла sitemap.xml:

- не больше 50 тыс URL в одной Карте;

- размер до 50 Мб в несжатом виде;

- формат — XML;

- находится на том же домене, что и сайт;

- состоит из латиницы с цифрами;

- отдает 200 ОК;

- все данные в кодировке UTF-8;

- ссылки с одинаковым синтаксисом;

- в файле нет URL идентификаторов сессий;

- только канонические URL;

- данные не конфликтуют с содержимым robots.

txt, в Карте нет закрытых в robots.txt страниц.

txt, в Карте нет закрытых в robots.txt страниц.

Проверить на ошибки готовый файл Sitemaps.xml можно анализатором Яндекса. Ответы на часто задаваемые вопросы о Sitemap.xml на официальном сайте.

Проверьте, сколько страниц проиндексировали поисковые системы. Вы можете узнать примерное количество страниц в индексе с помощью оператора site:, добавьте после двоеточия адрес сайта. Сравните это количество с общим количеством страниц, которое есть на вашем сайте в открытом доступе для поисковых ботов. Эта информация должна быть у вас на стадии сборки Карты сайта. Либо ее можно узнать, к примеру, после сканирования Screaming Frog, Xenu’s Link Sleuth, другими сервисами.

Значительные различия в количестве страниц могут говорить о проблемах. Если в выдаче далеко не все страницы, возможно, боты не могут их обработать, потому что некоторые разделы для них закрыты, или сайт получил санкции от поисковика. Проверьте уведомления в Консоли и Вебмастере. Если страниц в индексе больше, чем должно быть на самом деле, возможно, движок генерирует дубли, которые и попали в выдачу.

Канонические URL

Бывают ситуации, когда по разным URL открываются одинаковые или минимально различающиеся страницы. К примеру, почему это может быть:

- материал входит сразу в несколько категорий;

- варианты товара с минимальными отличиями доступны по разным адресам;

- у каталога с примененными фильтрами разные URL;

- CMS некорректно настроена.

Страницы могут быть идентичными за исключением расцветки товара. Этого различия недостаточно, чтобы они считались уникальными. Поисковики решат, что это дубли, и могут наложить санкции и понизить контент в выдаче.

Вы можете выбрать самый популярный вариант в качестве канонической, то есть основной версии страницы. Другие цвета будут по-прежнему доступны пользователям, но вес с внешних ссылок на них будет перенаправляться на канонический URL-адрес.

Это нужно для того, чтобы:

- ссылочный вес корректно передавался на нужную версию сайта;

- контент, доступный по нескольким URL, индексировался и ранжировался правильно;

- поисковики не наложили санкции из-за дублей.

Используйте link rel = «canonical». Атрибут link указывает поисковому роботу основную версию документа. Чтобы указать поисковику каноническую страницу, нужно в код каждого дубля добавить между тегами строку:

<link rel="canonical" href="http://site.ru/statya1">

http://site.ru/statya1 — URL страницы, который должен быть основным. Обязательно указывайте полный адрес с http:// и доменом.

Почитать по теме:

Все о rel canonical: как правильно указать и какие ошибки обычно допускают

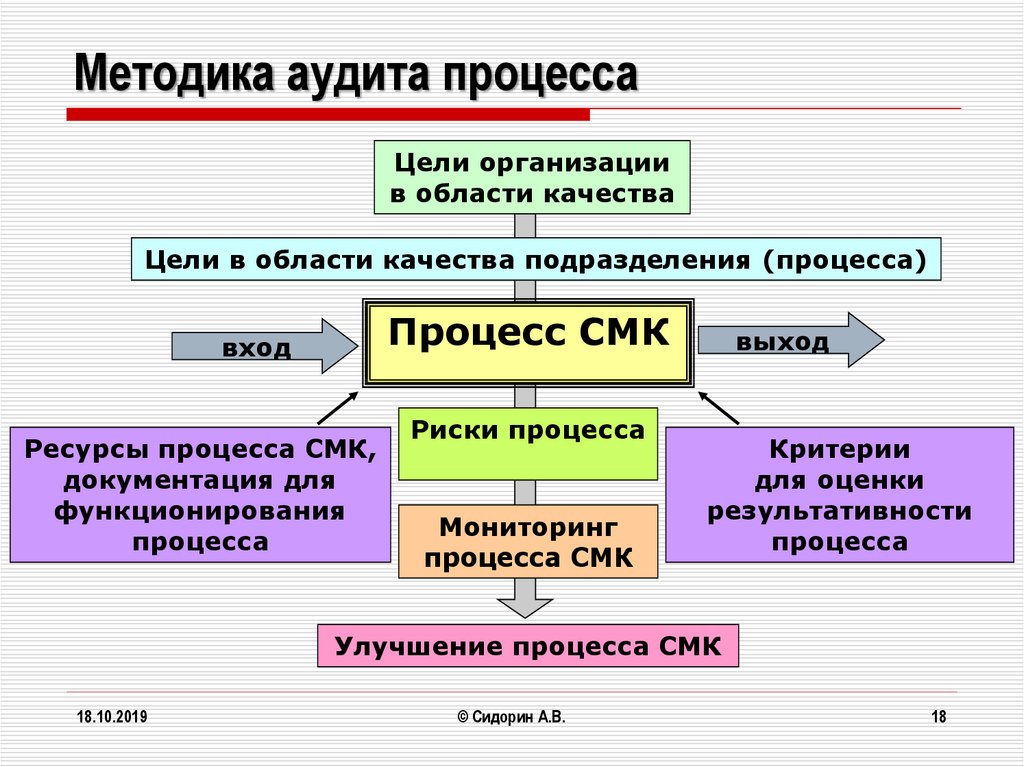

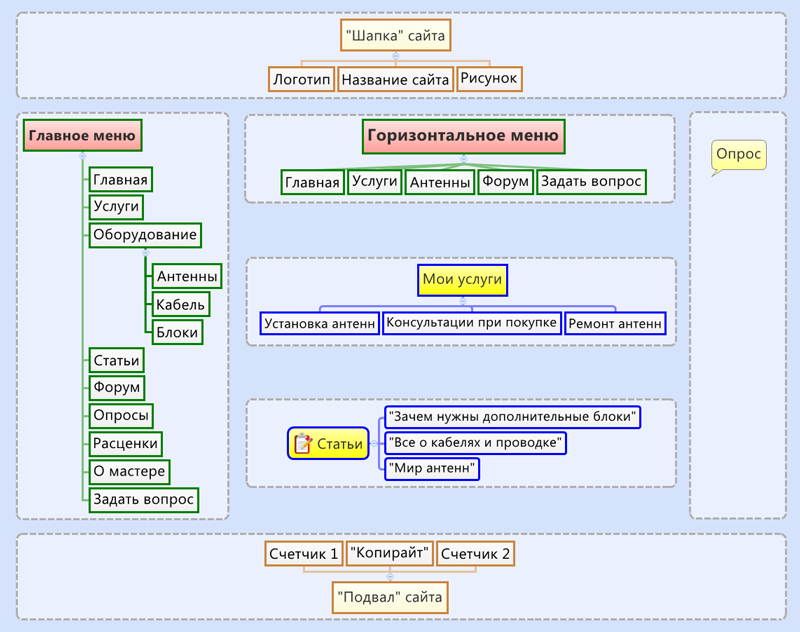

Архитектура сайта и уровень вложенности страниц

Логичная архитектура не даст пользователям заблудиться на сайте, а поисковикам поможет быстрее проиндексировать все страницы. Каждая страница должна участвовать в перелинковке — ссылочной системе сайта. На сайте не нужны:

- «висячие узлы» — страницы, которые сами ни на кого не ссылаются;

- «страницы-сироты» — они лежат в структуре сайта, но на них не ведет ни одна ссылка.

Такие страницы редко встречаются, только если на самописных сайтах без CMS, если веб-мастер ошибется при ручной перелинковке. Когда CMS генерирует страницы, они связаны логикой навигации.

Увидеть структуру сайта в наглядном отображении можно с помощью сервисов для визуализации — Crawl Maps у Sitebulb Website Crawler и WebSite Auditor.

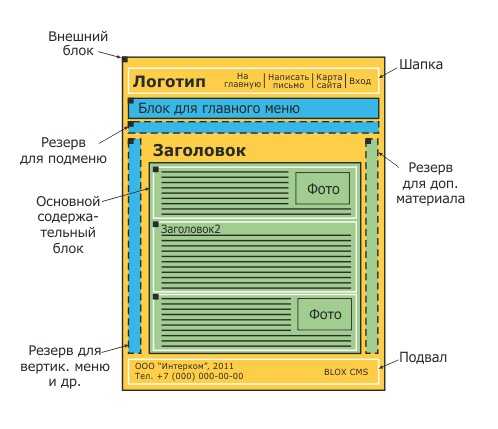

Crawl Maps в SitebulbПодробно об архитектуре сайта в статье

Уровень вложенности (УВ) – показатель положения страницы в общей структуре сайта. Определяется по минимальному количеству переходов, которые нужно сделать, чтобы с главной страницы попасть на целевую.

Главная страница сайта всегда имеет УВ 1. Все остальные страницы, на которые можно попасть с главной за один клик, имеют УВ 2, за два клика — УВ 3, и так далее.

Рекомендуем сделать так, чтобы все самые важные страницы были расположены в одном клике от главной, а остальные в 3-4 кликах.

Высокий уровень вложенности влечет несколько проблем:

Чем дальше страница от главной, тем меньший ссылочный вес она получает.

Высокая вложенность может негативно повлиять на конверсию. Пользователю может надоесть много раз переходить по ссылкам в поисках нужной страницы, особенно, если он смотрит с мобильного.

Существует мнение о том, что страницы с высокой вложенностью медленнее индексируются поисковыми роботами или не индексируются вовсе. В любом случае, это не проблема при наличии Карты сайта.

Проблему с высоким УВ можно решить HTML-картой сайта, так делают крупные ресурсы:

- Создается страница с картой, на которой размещаются ссылки на все остальные существующие страницы.

- Ссылка на эту страницу размещается на главной. В итоге все страницы сайта будут иметь УВ не более 3.

HTML карту сайта также можно использовать для поиска нужных страниц. Однако, с точки зрения юзабилити, грамотно организованное меню на главной будет предпочтительнее.

Однако, с точки зрения юзабилити, грамотно организованное меню на главной будет предпочтительнее.

Итак, что нужно проверить:

- уровень вложенности важных страниц не должен быть больше 3-4;

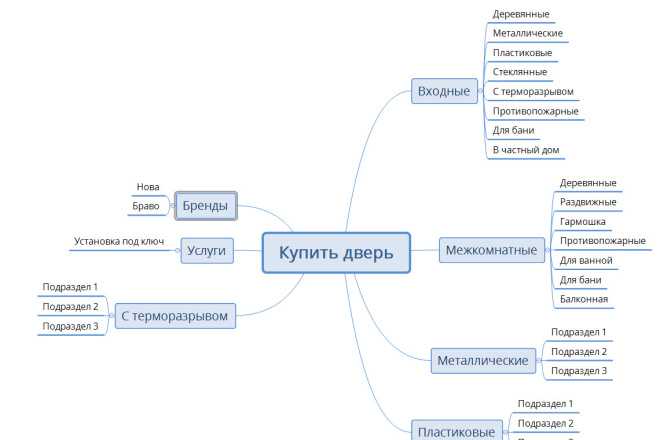

- группы, которые вы сформировали в процессе кластеризации семантического ядра, должны найти все отражение в структуре сайта

- перелинковка затрагивает все страницы сайта, они связаны между собой по тематикам;

- навигация на сайте отражает все нужные пользователям разделы, в ней легко ориентироваться;

- страница с HTML-картой, если вы все-таки решили ее сделать, доступна для пользователей и поисковых ботов.

Внутренними называются ссылки, которые направляют с одной страницы домена на другую страницу того же домена.

Какая роль у внутренних ссылок:

Помочь поисковым роботам находить и индексировать страницы.

Робот поисковой системы изучает страницу A, видит ссылки на страницы B и E и индексирует их.

Распределить ссылочный вес между разными по значимости страницами.

Чем ближе к главной находится страница, тем важнее она считается. Страницы, на которые ссылается главная, получают больше всего ссылочного веса. Дальше они распределяют вес по страницам, на которые ссылаются сами.Организовать навигацию.

С помощью ссылок аудитория ориентируется на сайте.Задержать пользователя на сайте.

Разберем, какие ссылки нужно проверить.

«Хлебные крошки» — элемент навигации по сайту в виде пути от главной страницы до страницы, на которой находится пользователь. Ссылки участвуют в перелинковке и помогают пользователям вернуться на предыдущие уровни каталога.

Ссылки участвуют в перелинковке и помогают пользователям вернуться на предыдущие уровни каталога.

Проверьте корректность отображения цепочки: она начинается с главной, включает в себя промежуточные разделы и заканчивается текущей страницей. Последняя должна быть не кликабельной, чтобы не получилась циклическая ссылка.

Используйте «хлебные крошки» только если на вашем сайте много контента, который размещен в иерархическом порядке, и не в качестве единственного способа навигации.

Как добавить на сайт «хлебные крошки»

Циклические ссылки — те, которые ссылаются на страницу, на которой и расположены. Поисковый бот перейдет по такой ссылке и окажется на исходной странице. Они бесполезны для пользователей и могут навредить сайту, если их много: бот может счесть их использование попыткой манипуляции, если у них будут спамные анкоры..

Сквозные ссылки — проходят через весь сайт, обычно находятся в шапке и футере. Если они состоят из ключей или отправляют на сторонние сайты, поисковики могут посчитать их спамом. Но сквозные ссылки с естественными анкорами не вредны, они тоже участвуют в перелинковке и передают небольшую часть веса.

Если они состоят из ключей или отправляют на сторонние сайты, поисковики могут посчитать их спамом. Но сквозные ссылки с естественными анкорами не вредны, они тоже участвуют в перелинковке и передают небольшую часть веса.

Дубли ссылок на одной странице — поисковики учитывают только верхнюю из одинаковых ссылок, так что в дублях нет смысла, если это не обосновано контекстом.

Глубокие ссылки (диплинки) — ссылка не на всю страницу, а на конкретную часть контента, например, на нужный абзац. Такие ссылки должны помочь непопулярным статьям и объемным материалам, в которых информация только частично соответствует пользовательскому запросу.

Кольцевая перелинковка — часто метод применяют в блогах, это выглядит как блок «Материалы по теме» или «Читать еще» со ссылками на другие статьи, подходящие по теме, причем так, чтобы все статьи по этой теме получили ссылки.

Битые ссылки ведут на документ, которого не существует, поэтому  Причиной может быть то, что страницу удалили, перенесли так, что она поменяла URL, скрыли от пользователей и поисковиков. Как их найти и как лучше исправить.

Причиной может быть то, что страницу удалили, перенесли так, что она поменяла URL, скрыли от пользователей и поисковиков. Как их найти и как лучше исправить.

Контролируйте количество ссылок, чтобы распределять ссылочный вес. Он будет делиться между всеми страницами, на которые ведут ссылки. На продвигаемые страницы количество входящих ссылок должно быть больше, чем исходящих, так они получат больший вес.

Не собирайте много ссылок в одном месте, распределяйте их по контенту равномерно — 1 ссылка на 1000 символов.

Комбинируйте анкоры. Анкор — текст ссылки, который заключен внутри HTML тега< a >. В тексте анкоров можно использовать ключевые слова, релевантные целевой странице, нейтральные слова «читать здесь», «тут», ставить безанкорные ссылки в виде URL.

- Анкорная ссылка: Используйте наш сервис для анализа сайта.

- Безанкорная ссылка: Попробуйте генератор анкоров —

Не ссылайтесь на одну и ту же страницу с помощью одинаковых анкоров. Поисковики могут склеить такие ссылки, и смысл в их размещении потеряется.

Подробно по теме:

Перелинковка — как работать с внутренними ссылками на сайте

Увидеть список внутренних и внешних ссылок на конкретной странице можно бесплатно в нашем инструменте pr-cy.ru/link_extractor. Он соберет все ссылки, покажет текстовое окружение, URL и определит nofollow.

Фрагмент проверкиЭто ссылки, которые ведут на сторонний сайт. Внешние ссылки рассматриваются поисковиками как рекомендация полезного контента. Чем чаще другие качественные ресурсы ссылаются на сайт и чем больше веса передают эти ссылки, тем лучше для продвижения сайта.

Проанализируйте ссылочный профиль вашего сайта:

общее количество ссылок в сравнении с конкурентами;

динамику — плавный или стихийный прирост новых ссылок;

какие ресурсы ставят на него ссылки: качество доноров, которые ссылаются на ваш сайт.

их авторитетность, репутацию, совпадения по тематике, позиции;

их авторитетность, репутацию, совпадения по тематике, позиции;с каких страниц они это делают;

на какие страницы вашего сайта чаще ссылаются;

соотношение анкорных и безанкорных ссылок, SEO- и естественных анкоров;

ссылка dofollow или nofollow.

Для анализа ссылочного профиля сайта используйте сервис для онлайн-аудита. Он отобразит соотношение анкоров, покажет количество ссылок и соберет в табличку свежие:

Фрагмент результатов проверкиУвеличение ссылочной массы помогает наращивать трафик, продвигать сайт среди целевой аудитории с помощью тематических запросов, а еще находить дополнительные сегменты целевой аудитории. Например, на сайте интернет-магазина по продаже товаров, сопутствующих вашему, или в разделе торговой площадки с аналогичными вашему товарами.

Подробнее о внешних ссылках в материалах на нашем сайте: раз, два.

SSL-сертификат

SSL, Secure Sockets Layer — это протокол, который дает возможность установить защищенное соединение между интернет-ресурсом и браузером. SSL не дает сторонним образом вмешаться в соединение – перехватить данные, подделать или изменить.

Происходит это путем шифрования данных с использованием двух типов ключей – приватного и публичного. Скрытый приватный ключ хранится на сервере, а публичный предоставляется пользователю, который заходит на сайт. Соответствие приватного и публичного ключей обеспечивает посетителю безопасность использования сайта, на котором установлен SSL-сертификат.

Сертификат особенно важен для сайтов, которые используют персональные данные пользователей и подразумевают онлайн-оплату товаров или услуг.

SSL-сертификат позволяет использовать защищенный HTTPS-протокол. По заявлению Google,он влияет на рост позиций в выдаче, а также повышает уровень доверия посетителей к сайту. Пользователи увидят предупреждение в браузере:

Сайт с использованием протокола HTTPСайт с HTTPSТри основных вида SSL-сертификатов:

Сертификат доверенного центра сертификации

Этот сертификат означает, что компания, которая использует сертификат предоставила центру сертификации свои полные данные – юридический адрес, контактные данные, ИНН, КПП, платежные реквизиты и прочие данные.

Сертификат недоверенного центра сертификации

Такие сертификаты выдают неизвестные центры сертификации и не гарантируют полной безопасности. Современные браузеры предупреждают пользователей, что на сайте установлен недоверенный сертификат и ресурс может использовать данные пользователя в своих целях.Самосозданный сертификат

Этот сертификат может сделать любой владелец ресурса. Браузер не пустит пользователя без его согласия на сайт с таким сертификатом.

Разумеется, советуем только первый вариант. Проверьте, отображается ли сертификат в браузере. При вводе любой версии сайта пользователя должно перенаправлять на главное зеркало с безопасным сертификатом.

Руководство о том, как установить SSL-сертификат и перейти на HTTPS правильно

Проверить SSL сертификат можно с помощью нашего бесплатного инструмента.

Пагинация — способ вывести на страницу ограниченное количество элементов — товаров, статей, каких-то других элементов. К примеру, в каталоге в разделе 100 диванов, но на страницы они выводятся по 20 штук.

К примеру, в каталоге в разделе 100 диванов, но на страницы они выводятся по 20 штук.

С 2019 года rel = prev/next, которые раньше использовали для настройки, не работают ни в Яндексе, ни в Google. Есть разные актуальные способы настроить пагинацию в зависимости от того, как будет удобнее пользователям смотреть подборку.

Проверьте правильность настройки. Если вы выбрали постраничную пагинацию, как на примере:

Разделение каталога по страницамУ вас получится первая страница https://site.com/catalog/koltsa/, вторая https://site.com/catalog/koltsa/?page=2 и так далее. На всех страницах, начиная с первой, нужно прописать rel = canonical с указанием на первую страницу.

Запрещать индексацию страниц тегом noindex не нужно, они должны быть доступны поисковым ботам.

Если вы выбрали создание общей страницы со всеми товарами, то она получится самой сильной, и ее нужно указать канонической для остальных страниц каталога.

Выгодный вариант, потому что каноничной будет самая сильная страница с большинством ключей.

При динамической или бесконечной прокрутке товары автоматически подгружаются, как только пользователь долистает до низа страницы или кликнет на кнопку «Еще».

Не очень удачный вариант, поскольку сложнее настроить так, чтобы поисковая система увидела весь контент.

Подробнее обо всех вариантах и проверке корректности настройки рассказали в статье — как сделать пагинацию на сайте

Облегчите сбор информации и поиск ошибок на сайте — используйте автоматическую проверку в нашем сервисе.

В продолжении материала о самостоятельном SEO-аудите сайта разберем оптимизацию контента. Дополняйте материал в комментариях! Мы явно не могли разобрать в одной статье все, что касается SEO-аудита, так что будем рады вашим рекомендациям.

на что обратить внимание и какие инструменты использовать — CMS Magazine

Я расскажу о том, для чего нужен seo аудит сайта, какие задачи решает, какие проблемы призван исправить и, собственно, самое важное — как все это решить и сделать самостоятельно!

Аудит сайта: для чего нужен и какие задачи решает?Изначально я планировал написать чисто о техническом аудите сайтов, а потом вспомнил, какие трудности я каждый раз испытываю, договариваясь с очередным заказчиком о проведении аудита. Что будет входить в аудит, какие рекомендации и касательно чего? Если даже мне самому сложно определиться в этом вопросе, даже не представляю, чего будет стоить это вам.

Что будет входить в аудит, какие рекомендации и касательно чего? Если даже мне самому сложно определиться в этом вопросе, даже не представляю, чего будет стоить это вам.

Для кого-то технический аудит — это результат работы какого-нибудь автоматического сервиса для проведения экспресс аудита, где в результате мы узнаем, какой тИЦ у сайта, сколько страниц проиндексировано в Яндексе и Гугле, в каких каталогах сайт находится, сколько на него обратных ссылок, увидим тошноту главной страницы и ее title. И что? Зачем нам эта информация? Для чего нам знать, сколько страниц в индексе, если понятия не имеем, что это за страницы? Зачем нам количество обратных ссылок без понимания природы их происхождения? Зачем нам знать тошноту текста главной страницы, если ее title просто «Главная»?

По моему мнению, именно на такие вопросы и должен ответить аудит. Вопросы, ответы на которые нельзя автоматизировать, ответы, которые требуют углубленного изучения сайта и его бэкграунда.

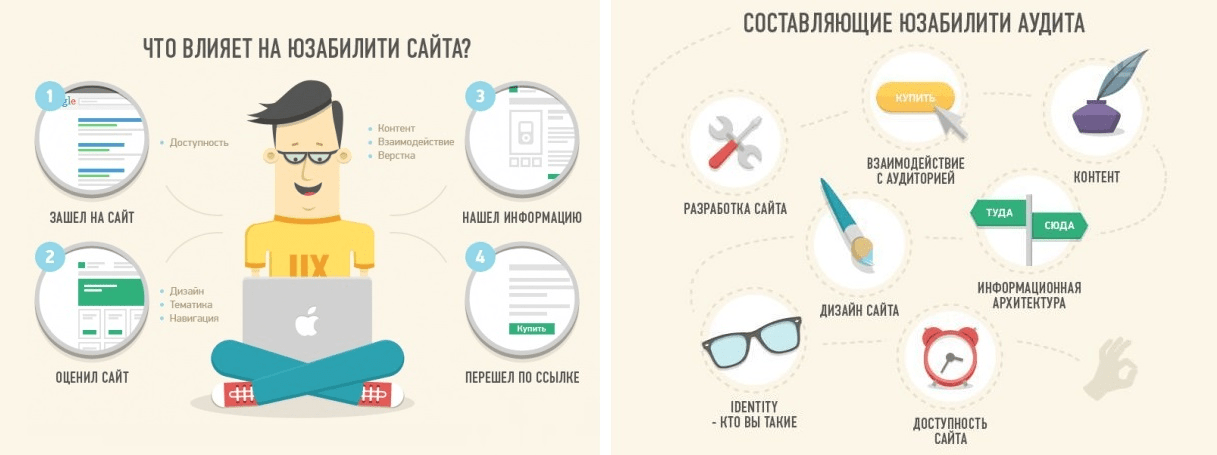

Не менее сложно определить границы, где заканчивается техническая часть, а где начинается юзабилити или маркетинговая составляющая. Отсутствие кнопки «заказать в 1 клик» на карточке товара — это техническая недоработка или проблема с юзабилити? А сложности при оформлении заказа в интернет-магазине: слишком большая форма для заполнения или ссылка из письма о подтверждении заказа, ведущая на любую страницу, кроме сообщения об успешном оформлении…

Отсутствие кнопки «заказать в 1 клик» на карточке товара — это техническая недоработка или проблема с юзабилити? А сложности при оформлении заказа в интернет-магазине: слишком большая форма для заполнения или ссылка из письма о подтверждении заказа, ведущая на любую страницу, кроме сообщения об успешном оформлении…

Я могу перечислять бесконечно! Сколько там у меня за плечами аудитов за мою практику… 200… 300, может, 500? И все они были комплексные, потому что нельзя просто так взять и пройти мимо очевидной ошибки, следуя формальностям, мол, это не относится к технической части.

Итак, примерное понимание, для чего нужен технический аудит у вас уже должно быть. Постараюсь формализовать список задач, которые должен решать аудит:

-

Технические моменты: 404 ошибки и битые ссылки; дубликаты страниц и повторы title; настройка метатегов; использование заголовков на страницах; чистота и корректность кода страниц; соответствие базовым требованиям поисковых систем;

-

Индексация сайта: какие страницы на сайте доступны для индексации, а какие по факту в индексе; нет ли проблем с метатегами, отвечающими за индексацию;

-

Скорость загрузки сайта и отдельных страниц, выявление причин медленной работы сайта;

-

Работоспособность сайта и его составляющих;

-

Функционал сайта, соответствие его требованиям и алгоритмам поисковых систем для определённых тематик и типов запросов.

Как видите, фронт работ колоссальный. Разобраться со всем этим, если вы не специалист, будет сложно, а для кого-то и невозможно.

А если говорить о стоимости услуг, то первые 3 пункта будут стоить 20 000р., т.к. максимально поддаются автоматизации, а все время работы занимает перечисление, описание и объяснение где, что и как надо сделать. Все пять пунктов, скажем, могут стоить уже 50 000р. И может быть, эти три дополнительных пункта выльются всего в 1-2 листа рекомендаций, но за ними стоит серьёзная работа. Сколько по-вашему может стоить сообщение о том, что форма заявки на вашем сайте не работает? Или кнопка продолжить в корзине постоянно перебрасывает пользователя на первый шаг и не продолжает оформление заказа? И вопрос тут в другом — а какие убытки вы понесете! Бесценно. И ситуации эти реальны, они из моей практики. (Возвращаясь к ценам, скажу, что это мои расценки, а у каких-нибудь московских seo-компаний все будет в 3-5 раз дороже, а у средненького фрилансера в 2 раза дешевле.Инструменты, необходимые для проведения полноценного аудитаРешать вам.)

Панель вебмастера Яндекса

Как только вы создаете сайт, либо берете клиентский сайт на продвижение, первое, что надо сделать — получить (создать) доступ в панель Яндекс.Вебмастер и Яндекс.Метрику. Это не требует никаких специальных знаний. Потом зайдите в раздел уведомлений в панели Вебмастера.

Нет времени объяснять, просто смотрите:

Важно ли это? Очень важно!

Панель вебмастера Яндекса обрела новую жизнь, когда ее обновили до версии 2.0. В разделе диагностики сообщают о критических и возможных проблемах и выдают рекомендации. В разделе безопасность сообщают о вирусах и вредоносном коде, в нарушениях — о наложенных фильтрах (например, если вы перестарались со ссылками и получили Минусинск).

Следующий важный раздел — Индексирование — где можно посмотреть, какие страницы проиндексированы, какие участвуют в поиске, а какие отдают ошибки.

Отдельное спасибо за то, что все данные из панели можно выгружать в виде архива, где, по их словам, содержится исчерпывающая информация. Жалко, что с этими данными нельзя взаимодействовать, например, отметить проблемы с несуществующими или запрещенными к индексации страницами, как решенные, чтобы пропали из статистики, как это сделано в Google Search Console. Но с другой стороны, забот меньше, не так ли? 🙂

Что еще стоит обязательно сделать в панели вебмастера Яндекса:

-

Добавить файлы sitemap.xml;

-

В разделе Переезд сайта указать основное зеркало;

-

В разделе «Региональность» указать регион, либо убедиться, что указан нужный регион;

-

Выбрать регистр сайта. Просто для красоты, либо в надежде, что это немного увеличит CTR на выдаче;

-

В Быстрых ссылках провести ревизию, чтобы показывались только самые важные ссылки в нужном порядке.

Об изменениях в быстрых ссылках приходят сообщения в «Уведомления»;

Об изменениях в быстрых ссылках приходят сообщения в «Уведомления»; -

Все остальное уже по ситуации и в зависимости от требований.

Обычно я договариваюсь с заказчиком, что все настройки в панели произвожу сам, потому что описывать, что и как сделать, намного дольше, чем все настроить самостоятельно.

Google Search Console (Панель для веб-мастеров)

Добавить сайт в панель Гугла — это такое же необходимое действие. Здесь есть раздел с важными сообщениями, где хранятся рекомендации для сайтов и сообщения об ошибках:

Сайт плохо индексируется? 404 ошибки? Вам сообщат!

Немного раздражает, что для указания главного зеркала сайта (Шестеренка в правом верхнем углу — Настройки сайта — Основной домен), необходимо все зеркала добавить и подтвердить в панели и только потом для зеркал указывать основной сайт. Потом все эти зеркала для всех сайтов будут в общем списке болтаться. Бесит!

Бесит!

Следующий важный раздел: Вид в поиске — Оптимизация HTML. Стоит обратить особое внимание на пункт «Повторяющиеся заголовки (теги title)». Дубликаты title говорят о серьёзны недочетах. Основных причин несколько: у вас некорректно формируются title, у вас есть дубликаты страниц, не закрыты от индексации «лишние» страницы.

Раздел «Меры, принятые вручную» — здесь по аналогии с Яндексом (на самом деле, это у Яндекса по аналогии с Гуглом) показываются примененные к сайту фильтры. Не все, а как следует из названия, а только наложенные вручную: фильтр за переоптимизацию и фильтр за ссылочный спам.

Сканирование — Ошибки сканирования — здесь вы найдете ошибки внутри сайта, связанные с недоступностью страниц, которые либо удалены, либо сервер вовремя не ответили или выдал ошибку. Таблицу можно выгрузить в архив, но исчерпывающих данных вы все равно не получите. Не знаю почему, но Гугл зажал полный список и отдает только часть. Зато решенные проблемы можно отметить, и они тут же пропадут из статистики.

Вообще в панели Гугла больше вопросов, чем ответов: зачем нам просто циферки, когда гораздо важнее знать, что за ними скрывается? В карте сайта проиндексировано 1000 страниц из 10000, и что дальше? Какие это страницы, почему не индексируются? Не понятно. Гугл очень скуп на информацию для веб-мастеров. Единственное, что можно выгрузить полностью — это беклинки.

Раньше я часто заходил в Серч Консоль, но с появлением Вебмастера 2.0 Яндекса я делаю это все реже и реже.

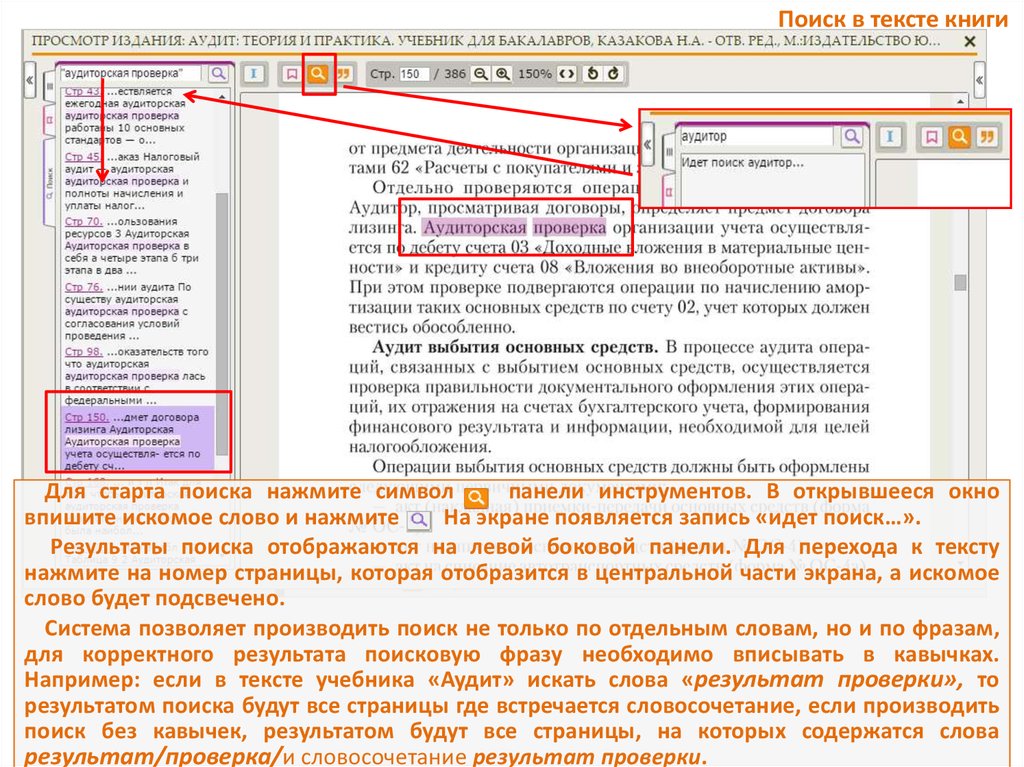

Программа ComparseR

Думаю, почти все вы, дорогие читатели, знаете мою программу. Программа немного платная, но можно скачать демо-версию и посмотреть дополнительную информацию на промо-сайте (правда, он не обновлялся с 2014 года, но программа обновляется регулярно). Программа разрабатывалась под требования и нужды моей веб-студии. Она позволяет быстро и эффективно находить на сайтах технические ошибки: битые ссылки, страницы имеющие проблемы с индексацией (некорректный мета robots или canonical), дубликаты title и страницы с пустым тегом, дубли заголовки h2, внешние ссылки по типам и еще много чего. Большую часть из перечисленного умеют делать и аналоги, но у Компарсера есть уникальная функция — парсинг поисковых систем и сравнение индекса со структурой сайта.

Большую часть из перечисленного умеют делать и аналоги, но у Компарсера есть уникальная функция — парсинг поисковых систем и сравнение индекса со структурой сайта.

Далее я буду рассказывать о самых распространенных ошибках на сайтах. Их легко найти, работая с comparser’ом, но вы можете использовать любую другую программу для поиска этих проблем на своем сайте, но я рекомендую скачать хотя бы демо-версию.

Заголовок title и его оптимизацияTitle по праву считается самым сильным тегом во внутренней оптимизации, соответственно, ошибки с ним считаются одними из самых грубых. Это очень частая проблема: более 90% всех сайтов, что приходят ко мне на аудит или продвижение, имеют проблемы с дубликатами. Причин много, но среди самых распространенных:

-

Дублирование на страницах листингов в интернет магазинах (постраничная навигация, когда товаров в категории очень много). Это решается добавлением приставки «- страница XX» в title, простановкой тега rel=»canonical» с указанием на первую страницу, либо, проще всего, закрытием страниц /*/page, *?page= и т.

п. в robots.txt. Страницы пагинации часто дублируют title первой страницы не только в интернет-магазинах, но и на других типах сайтов.

п. в robots.txt. Страницы пагинации часто дублируют title первой страницы не только в интернет-магазинах, но и на других типах сайтов. -

Сортировки — бич любого каталога. Хотите отсортировать товары по цене, наличию или просто расположить витрину не списком, а плиткой — пожалуйста. Куча дублей — пожалуйста! Я всегда рекомендую делать сортировки при помощи технологии AJAX, чтобы сортировка товара происходила без перезагрузки страницы и без перехода на другой url. Иногда это сложно реализовать, потому альтернативой послужит использование rel=»canonical«, либо совсем простой способ — закрыть параметры сортировки в robots.txt.

-

На сайтах с однотипными товарами возникает много дублей. Например, шины, где для одной модели кроме типоразмеров существуют такие характеристики, как максимальная масса нагрузки или максимальная скорость. Для платьев одного дизайнера и одной модели может быть разный размер, цвет, артикул.

Для штор может быть уровень затенения, ширина и длинна шторы. В title по умолчанию добавляется название товара из базы, а в результате куча дублей и вместо всех карточек товара нормально ранжируется только одна, предпочтение которой отдал поисковый робот. Как поисковик смотрит? Одинаковый title, ага. Одинаковый description, ага. Одинаковое название на странице, ага. Значит это дубль, надо выбрать только одну уникальную карточку товара. Решается добавлением уникальных параметров товара в title.

Для штор может быть уровень затенения, ширина и длинна шторы. В title по умолчанию добавляется название товара из базы, а в результате куча дублей и вместо всех карточек товара нормально ранжируется только одна, предпочтение которой отдал поисковый робот. Как поисковик смотрит? Одинаковый title, ага. Одинаковый description, ага. Одинаковое название на странице, ага. Значит это дубль, надо выбрать только одну уникальную карточку товара. Решается добавлением уникальных параметров товара в title. -

В интернет-магазинах часто применяются индексируемые фильтры. Например, по бренду или другой какой-то характеристике. И без должного внимания страницам фильтров присваивается title от родительской категории. А ведь такие индексируемые seo фильтры — это кладезь низкочастотного трафика: фильтры легко масштабировать, настраивать по шаблону, и пусть даже каждая страница принесет по одному посетителю в месяц, благодаря их количеству счет идет на тысячи потенциальных покупателей.

-

Некоторые движки уже насколько изучены (Битрикс, который чаще всего встречается среди наших клиентов), что даже не надо никакой программы, чтобы предположить, где скрываются проблемы. Практика показывает, когда программисты сдают сайт, за настройками для seo никто не следит. Вообще-то они и не должны, ведь разработчики отвечают за продакшн: чтобы выглядело хорошо и работало без проблем. Поэтому прежде чем принимать работу, проконсультируйтесь

со своим лечащим врачомс seo-специалистом, чтобы устранить недочеты на старте.

Как вы могли заметить, большая часть примеров взята от интернет-магазинов — это мой любимый тип сайтов, я очень люблю большие порталы с десятками и сотнями тысяч страниц. Чем больше, чем лучше, тем более классный результат можно показать, исправив допущенные ошибки. Мне очень хочется рассказать о сайтах наших клиентов, но все мое время занимает работа над этими сайтами.Заголовок h2 и нецелевое использование заголовковХотя один большой и подробный кейс я все же опубликовал, когда еще работал «наемником» — кейс о сайте по аренде недвижимости. Мне удалось добиться увеличения посещаемости с поиска в 20 раз за 8 месяцев работы. Конечно, это не только исправление ошибок, а долгая и кропотливая работа по изучению ниши и пользовательского спроса, но без идеальной технической базы я бы не смог это совершить!

Еще одним сильным элементом внутренней оптимизации страниц является заголовок h2 — это основной заголовок страницы, который предназначен для посетителей. Распоряжаться этим заголовком уже многие научились и даже до верстальщиков донесли, что основной заголовок страницы должен быть обернут в h2. Поисковые роботы придают значение содержимому заголовка, поэтому нельзя пренебрегать и использованием ключевых слов в нем.

Ошибки тем не менее допускают нередко. Согласно канонам, главный заголовок должен быть один на странице. И точка! Но некоторые верстают в h2 логотип и/или название сайта в шапке — это очень частое явление. Использовать главный заголовок повторно при верстке текста на странице тоже неверно, ведь для этого и придумали h3, h4, h5, h5 и h6 (я рекомендую ограничиться использованием только h3 и h4).

И точка! Но некоторые верстают в h2 логотип и/или название сайта в шапке — это очень частое явление. Использовать главный заголовок повторно при верстке текста на странице тоже неверно, ведь для этого и придумали h3, h4, h5, h5 и h6 (я рекомендую ограничиться использованием только h3 и h4).

Пример нецелевого использования я привел выше — обернуть логотип в заголовок. Часто при верстке макета заголовки блоков в сайдбаре верстаются заголовками. Это неправильно, заголовки не должны использоваться в сквозных элементах при оформлении дизайна. Заголовки надо использовать только для самого основного контента страницы, иначе они теряют свою эффективность.

Меня часто спрашивают, как формировать заголовки title и h2 и как использовать в них ключевые слова, можно ли прописывать одни и те же запросы в этих заголовках. Как выбрать оптимальную длину и что делать если хочется продвинуть много запросов на одну страницу. Однажды мне надоело отвечать, и я написал подробное руководство по оптимизации заголовков title и h2.404 ошибки и битые ссылки

Не буду объяснять, почему наличие ошибок внутри сайта плохо. Их надо просто взять и исправить. Они могут появляться по разным причинам: на сайте удаляются неактуальные публикации, при верстке текста контент-менеджер неправильно скопировал ссылки, при смене структуры url не сделали редиректы и внутренние ссылки умерли. Это случается со всеми, поэтому сканировать сайт надо периодически.

При обходе сайта Компарсер формирует сводку по всем кодам ответа сервера, зеленым отмечено, где все окей, желтым — предупреждение, красным — ошибка.

Нажимаем на интересующую строку, выведется список битых ссылок, а также источник (страница, с которой стоит злосчастная битая ссылка.)

Среди вебмастеров самая известная программа для поиска битых ссылок на сайте — Xenu’s Link Sleuth. Программу нельзя назвать удобной или красивой, самая популярная она лишь благодаря своей бесплатности. По заявлению на официальной странице она работает в Windows 10 несмотря на то, что последнее обновление программы датировано 2010 годом.301 и 302 редиректыСам не проверял, я ей не пользуюсь.

Редиректы это и не хорошо и не плохо. Но только в том случае, если вы знаете, как и для чего их надо использовать. Поэтому в программе редиректы помечены желтым цветом — значит надо обратить внимание.

301 редирект — это постоянный редирект, который говорит поисковому роботу, что страница переехала на новый адрес. Навсегда. А значит старый адрес надо забыть и ассоциировать его с новым. При склейке адресов передаются свойства старой страницы. Входящие ссылки, траст и т.д. 301 редирект используется при переезде сайта с одного домена на другой, при смене структуры формирования адресов на сайте, а также для уничтожения дублей страниц.

302 редирект — это временный редирект, который говорит поисковику, что страница лишь временно сменила адрес, и что ее нельзя выкидывать из индекса. 302 редирект на практике используется редко, гораздо чаще он встречается как ошибка, когда должен был использоваться 301 редирект, но по невнимательности программисты поставили 302 редирект (в веб-серверах под управлением *nix систем команда для редиректа по умолчанию использует 302 редирект, если отдельно не указано использование 301 редиректа). Так что, скорее всего, 302 редирект вам не нужен.

Так что, скорее всего, 302 редирект вам не нужен.

Любые редиректы внутри сайта использовать не следует, надо, чтобы все ссылки были прямые и вели сразу на конечную цель. Редирект нужен для того, чтобы не потерять внешние ссылки и связи, ведь на внешних источниках мы не можем вручную исправить ссылки.

Никого не удивлю, сказав, что я уже написал огромный пост-руководство о том, зачем нужны редиректы, как их правильно использовать и прописывать. Подробно разобраны частые случаи, а в довесок еще 750 комментариев обсуждений и разбора частных случаев от читателей.Исходящие ссылки — что с ними делать?

Многие переживают из-за внешних ссылок на сторонние сайты. Типа вес страниц «утекает», поисковики могут хуже относиться к сайтам с множеством внешних ссылок и т.д. На счет внешних ссылок должны переживать только те, кто занимается продажей ссылок в биржах, потому что могут не пройти по фильтрам. А поисковики относятся негативно только к продажным и нетематическим ссылкам, а если ссылки ведут на авторитетный сайт или документ, который дополняет написанное на странице, — так за что тут наказывать?

Для совсем уж одержимых (таких как я), чтобы все было идеально и красиво, могу посоветовать просканировать все внешние ссылки с сайта и закрыть их в nofollow, а все битые ссылки на внешние сайты либо удалить, либо исправить. Вот типичная карта внешних ссылок на инфосайте от года и старше:

Вот типичная карта внешних ссылок на инфосайте от года и старше:

Обращаю ваше внимание на то, что несколько лет назад принцип действия атрибута nofollow для ссылок изменился. Раньше использование этого атрибута пресекало «утекание» веса со страницы по ссылке, а теперь все иначе — вес все равно утекает, но не достигает той страницы, на которую ведет ссылка, то есть попросту испаряется. Таким образом атрибут nofollow лишь говорит поисковому роботу, что ссылку не надо учитывать, передавать по ней вес и page rank.

Для тех, кого пугает сама мысль, что с сайта куда-то «утекает» какой-то вес, тоже есть решение — скрывать ссылки при помощи скриптов. Можно сделать так, чтобы сама html конструкция ссылки на странице отсутствовала, и роботы ссылку не видели, при этом для пользователя эта ссылка будет видна и будет активна.

Google PageSpeed Insights

Очень полезный и простой инструмент, который покажет вам две важные вещи: удобство для пользователей мобильных устройств и скорость загрузки сайта с оценкой по 100-бальной шкале. Я сразу оговорюсь, что к 100 баллам стремиться совсем не обязательно, потому что они труднодостижимы и в погоне за ними вы можете просто испортить сайт. 70-80 баллов будет достаточно, а вот меньше 50 — это повод для тревоги!

Я сразу оговорюсь, что к 100 баллам стремиться совсем не обязательно, потому что они труднодостижимы и в погоне за ними вы можете просто испортить сайт. 70-80 баллов будет достаточно, а вот меньше 50 — это повод для тревоги!

Про мобильную версию или адаптивную верстку для мобильных пользователей я молчу, тут и ежу понятно, что надо брать и делать.

Если ваш сайт находится в красной зоне (ниже 50 балов), я вам советую обратить внимание на 2 самых важных пункта, исправление которых повысит и баллы, и увеличит быстродействие сайта для реальных посетителей: «Используйте кеш браузера», «Включите сжатие». Разверните эти пункты и увидите перечень адресов, если там есть ресурсы с вашего домена, значит надо исправлять. Обычно это решается корректной настройкой движка сайт, установкой модуля, либо добавлением нескольких строк в .htaccess. Если вы мало что поняли из сказанного, попросите программиста, он вам за пару часов все сделает.

Кстати, почему достижение 100 баллов является задачей нетривиальной? Потому что среди ресурсов, требующих оптимизации, есть счетчики Метрики и Гугл Аналитики, сторонние JS, особенно скрипты соцсетей, необходимые для отображения виджетов или кнопок.Индексация сайта: изучение и настройкаИногда исправить это просто невозможно, а главное, что и быстродействия не добавит (современные скрипты подгружаются асинхронно)!

Выше мы говорили о том, как заставить страницы лучше ранжироваться, но не затронули вопрос, как заставить страницы лучше индексироваться. А ведь индексация идет прежде, чем ранжирование, соответственно, нет смысла оптимизировать непроиндесированную страницу.

Проблемы с индексацией встречаются чаще всего на больших сайтах: чем больше сайт, тем больше проблем. Сейчас расскажу про настройку сайта для хорошей индексации.

Настройки индексирования внутри сайтаПервое, что нужно сделать — это запретить для индексации все технические страницы, которые не представляют интереса для поисковиков и не предназначены для привлечения трафика. Лучше всего запрещать страницы от индексации при помощи метатега robots, вместо файла robots.txt. Google, не смотря на запреты в robots. txt, все равно добавляет страницы в индекс, но их содержимое не ранжирует. Однажды я уже подробно описывал, как и почему это происходит.

txt, все равно добавляет страницы в индекс, но их содержимое не ранжирует. Однажды я уже подробно описывал, как и почему это происходит.

Так же стоит исключить очень похожие страницы и дубли (об этом мы уже говорили выше). Если на сайте есть одинаковые или похожие страницы, поисковым роботам будет сложно определить нужную релевантную страницу, а мы не будем понимать, куда приземляются посетители, наши ожидания не совпадут с реальностью и это, поверьте, большая проблема. Бывает, что поисковикам неохота выбирать правильную страницу из набора похожих и они предпочтут вообще не ранжировать ваш сайт, а отдать предпочтение другим сайтам, где такой проблемы нет.

Есть такой термин — каннибализация — негативное влияние использования одних и тех же ключевых слов на разных документах сайта. Вы заставляете поисковые системы выбирать, но что еще хуже, вы запутываете посетителя и теряете контроль над его поведением на сайте, ухудшаете поведенческие факторы и сами не знаете, какую страницу продвигать. Золотое правило — под один ключевой запрос (группу схожих ключевых запросов) должна быть только одна единственная релевантная страница. Если на вашем сайте есть такая проблема, используйте редирект на приоритетную страницу, либо пропишите canonical.

Золотое правило — под один ключевой запрос (группу схожих ключевых запросов) должна быть только одна единственная релевантная страница. Если на вашем сайте есть такая проблема, используйте редирект на приоритетную страницу, либо пропишите canonical.

Кроме закрытия ненужных страниц важно не ссылаться на эти самые ненужные страницы. На сайте не должно быть внутренних ссылок на закрытые страницы, потому что поисковики будут все равно на них рваться. Для фанатов «веса» страниц стоит сказать, что из-за таких ссылок утекает вес сайта в никуда — голактеко опасносте, господа! В противном случае статистика сайта в панелях вебмастера будет замусориваться отчетами о страницах, запрещенных к индексации. Лично меня эта статистика угнетает, мешает изучать реально существующие проблемы, и я постоянно думаю, что что-то пошло не так.

Слышали что-нибудь про «краулинговый бюджет»? Это некий отведенный поисковыми роботами лимит страниц для вашего сайта, которые робот обойдет и возможно добавит в индекс. И чем больше ненужных страниц встретится на пути, тем меньше полезных страниц будет проиндексировано. Нередки случаи, когда на сайте страниц много, а находится в индексе в десятки, сотни, а то и тысячи раз меньше страниц. Иногда большим сайтам не хватает этого самого бюджета, а иногда до страниц банально очень сложно добраться. Обязательно создайте xml и html карту сайта, настройте сервер, чтобы он максимально быстро отвечал за запросы.

И чем больше ненужных страниц встретится на пути, тем меньше полезных страниц будет проиндексировано. Нередки случаи, когда на сайте страниц много, а находится в индексе в десятки, сотни, а то и тысячи раз меньше страниц. Иногда большим сайтам не хватает этого самого бюджета, а иногда до страниц банально очень сложно добраться. Обязательно создайте xml и html карту сайта, настройте сервер, чтобы он максимально быстро отвечал за запросы.

И не забывайте про перелинковку, но такую, чтобы была полезна посетителям. Для информационных сайтов это может быть блок ссылок на публикации из той же категории. Ссылки на публикации по теме из тела статьи — аля Википедия. Для интернет-магазинов прекрасно работают блоки ссылок на похожие по характеристикам товары и ссылки на сопутствующие товары. Все это принесет пользу не только посетителям вашего сайта, но и позволит поисковикам лучше и быстрее индексировать полезные страницы.

Для своих инфосайтов я эффективно применял кольцевую перелинковку — это когда одна публикация имеет блок ссылок на 5 предыдущих публикаций сайта, и так по кругу.Изучение поискового индекса сайтаКаждая публикация ссылается на соседние, в итоге все публикации на сайте получают одинаковое количество внутренних ссылок, никто не остается обделенным.

Эта методика прекрасно себя показала, и мне удалось добиться 100% индексации на своих сайтах. Для CMS DLE, которую я использовал, был написан специальный модуль кольцевой перелинковки LinkEnso (позже был выпущен LinkEnso PRO — платная версия с расширенным функционалом), который стал настоящим хитом: десятки тысяч скачиваний и сотни покупок, и это при том, что модуль валяется на каждом углу бесплатно.

Технология реально рабочая, я масштабировал ее на коммерческие сайты, и это дало эффект, так что берите на вооружение!

Когда я только думал над созданием программы ComparseR, ключевой особенностью я видел возможность парсить индекс поисковой системы и сравнивать с тем, что есть на сайте. Ценность заключалась в том, чтобы найти непроиндексированные страницы и пакетно загнать их в аддурилку. Но до меня быстро дошло — ценность в том, чтобы найти то, что на сайте отсутствует.

Но до меня быстро дошло — ценность в том, чтобы найти то, что на сайте отсутствует.

Понимаете, о чем я? Вот к примеру, на ваш сайт залили дорвей, как вы об этом узнаете? На него не оставят внутренних ссылок, он никак не будет связан с вашей CMS и никак не повлияет на работу сайта. Бывают случаи, когда злоумышленники берут и копируют частично дизайн вашего сайта вместе со счётчиками для страничек на своем дорвее. Дорвей выстреливает и на него начинает идти трафик. В Метрике вы увидите всплеск посещаемости по совершено невообразимый для вас запросам (почему-то такое часто возникает на Битриксе, я несколько раз становился свидетелем «взрыва» посещаемости на клиентских сайтах именно на Битриксе). Но что если счетчик не скопировали, сколько времени пройдет пока вы заметите? Вы заметите это когда ваш сайт погибнет вместе с дорвеем. Дорвеи горят ярко и живут недолго, они состоят из большого количества страниц, каждая из которых заточена под один поисковый запрос и сильно переоптимизирована. Если размер вашего сайта сильно меньше, чем размер дорвея, когда поисковик начнет «выпиливать» дорвей, ваш сайт уйдет на дно вместе с ним, как незначительная небольшая его часть.

Если размер вашего сайта сильно меньше, чем размер дорвея, когда поисковик начнет «выпиливать» дорвей, ваш сайт уйдет на дно вместе с ним, как незначительная небольшая его часть.

Чтобы вовремя заметить беду, надо периодически парсить поисковый индекс вашего сайта. С этой задачей прекрасно справляется Компарсер — показать все, что скрыто:

Страницы, которые нашлись на сайте, но отсутствуют в индексе, надо заставить проиндексироваться. Раньше, когда была старая версия Яндекс.Вебмастера, существовала аддурилка — туда можно было поштучно отправлять любые адреса и они становились в очередь на индексацию. Вручную это делать было нереально (вставлять адрес, вводить капчу), но Компарсер это автоматизировал. Только вот лавочку прикрыли, аддурилку Яндекс убрал. Теперь единственным вариантом заставить страницы индексироваться — это те приемы, о которых я рассказывал в предыдущем блоке.

В Гугле лавочку с добавлением страниц не закрыли, но защитили — раньше там была классическая рекапча, которую индусы щелкали на раз, теперь там стоит новомодная штуковина, заставляющая сопоставлять картинки по смыслу, если вас заподозрили в «роботизме». В итоге автоматическое добавление страниц на индексацию обломилось везде 🙁

В итоге автоматическое добавление страниц на индексацию обломилось везде 🙁

Все непросто — это когда найдены страницы в индексе поиска, а на сайте при обходе почему-то не обнаружены. Надо понять, что это за страницы и почему они не найдены при обходе сайта:

-

Удаленные страницы, 404 Not Found. Бывает, что товары из магазинов пропадают, записи снимаются с публикации. Соответственно, на сайте этих страниц уже нет, и ссылок на них тоже. А в индексе эти страницы могут остаться и выдавать ошибку. Надо взять список этих страниц и закинуть в инструмент пакетного удаления из индекса. Это еще работает для Яндекса и Гугла.

-

Страницы товаров, запрятанные далеко в каталоге. Если в интернет-магазине много товаров, а в категориях присутствует постраничка, которая закрыта от индексации, чтобы избежать дублирования, может случиться так, что до многих товаров невозможно добраться. И добраться не может не только программа-краулер, но и поисковые роботы, так что такие страницы из индекса со временем выпадут, а нам этого не надо.

Разберитесь с перелинковкой.

Разберитесь с перелинковкой. -

Дубли! Откуда они могут взяться? Параметры! Вы ведете контекстную рекламу и используете utm-метки, люди переходят по ссылкам с этими метками, и они индексируются. У вас на сайте есть партнерская программа, в которой любой партнер подставив в url страницы в конце параметр ?PartnerId=123 привлекает рефералов. Параметры могут взяться из самых неожиданных мест, а вы можете об этом и не знать. Страницы с параметрами полностью дублируют аналогичные страницы без параметров, но индексируются наравне с ними и являются дублями, портя карму вашему сайту и отдельным страницам. Такие дубли надо решать при помощи rel=»canonical«.

-

Дорвеи. Я про них уже говорил, но теперь покажу, как это выглядит. Краны, подъемники, вакансии компаниии… А потом бах — простата, виза в польшу, атанасян, бацзы! Что? О_о

В данном примере дорвей уже удалили, но в индексе он еще болтается:

Все это барахло: несуществующие страницы, ошибки и прочее надо удалять с сайта, закрывать от индексации и пакетно удалять из индекса. Благо, такая возможность есть, автоматизация реализована, а лавочку пока не прикрыли.

Благо, такая возможность есть, автоматизация реализована, а лавочку пока не прикрыли.

Я уже упоминал, что в новой панели вебмастера Яндекса сделали возможность выгрузить любые данные архивом для изучения. Компарсер мы научили выкачивать архив, забирать оттуда проиндексированные страницы и добавлять в таблицу. Таким образом можно обойти ограничение поисковой выдачи на 1000 результатов и получить 100% точный результат индексации сайта. Это облегчает задачу многократно, а вот в Гугле есть проблемы, там не только в панели вебмастера скудные данные, но и в выдаче — получить все проиндексированные страницы невозможно, даже если их совсем небольшое количество. Зато наличие и разнообразие проблемных страниц в индексе, даже закрытых от индексации, компенсирует этот недостаток.

MegaIndex.com

MegaIndex.com (обратите внимание: .com, а не .ru) прекрасный инструмент для внешнего аудита любого сайта. Внутренний аудит сайта он не делает, ошибки внутри не покажет, но зато покажет видимость сайта по запросам, какие ссылки на него ведут, делается ли контекстная реклама и по каким объявлениям, и еще много-много-много всяких полезных штучек. Сервис развивается, там появляются новые инструменты, некоторые из которых уникальны в своем роде и недоступны даже в других платных сервисах. И это, не поверите, — все совершенно бесплатно.

Сервис развивается, там появляются новые инструменты, некоторые из которых уникальны в своем роде и недоступны даже в других платных сервисах. И это, не поверите, — все совершенно бесплатно.

Когда приходит сайт на аудит или продвижение, я пользуюсь следующими возможностями:

-

Общая информация — тут и правда общая информация: видимость сайта в органике, видимость в контексте, количество внешних ссылок, источники трафика, ключевые слова и т.д. Важный момент! Данные по трафику и источникам не корректны для регионов, для Москвы и еще десятка городов все четко, а для Краснодара и городов поменьше все плохо. Количество трафика даже для Москвы нельзя считать достоверным в абсолютных значениях, а вот в относительных вполне. То есть, если на вашем сайте показывается 100 переходов с поиска, и 50 с контекста, это может быть далеко от реальности, тоже относится и к конкурентам. Но если сравнивать данные относительно, то все почти совпадает.

-

Внешние ссылки.

Сами знаете, со ссылками шутки плохи последнее время, надо быть очень внимательным. Об этом я совсем недавно писал и говорил подробно. Поэтому лучше сразу понять, покупаются ли ссылки на сайт, с какими анкорами, есть ли риск наложения фильтра. А заодно посмотреть, как ведут себя конкуренты, и можно ли продвинуть сайт в конкретной тематике без ссылок.

Сами знаете, со ссылками шутки плохи последнее время, надо быть очень внимательным. Об этом я совсем недавно писал и говорил подробно. Поэтому лучше сразу понять, покупаются ли ссылки на сайт, с какими анкорами, есть ли риск наложения фильтра. А заодно посмотреть, как ведут себя конкуренты, и можно ли продвинуть сайт в конкретной тематике без ссылок. -

Анализ сниппетов. Этот инструмент мне нравится тем, что на одной странице можно быстро посмотреть, какие сниппеты для разных страниц и запросов показываются на выдаче. К техническим моментам это не относится (ну, разве что, вместо описания показывается какая-нибудь белиберда), но по части CTR на поиске очень даже полезно!

-

Исходящие ссылки. Некая быстрая альтернатива сканированию сайта программой. Если сайт проиндексирован сервисом, то можно изучить исходящие ссылки, куда они ведут, спамные ли они, точно ли они размещены по доброй воле или это происки злоумышленников.

По Мегаиндексу можно вообще отдельный пост написать, каким инструментом и для чего пользоваться. Но это уже не для аудита, а для аналитики и будущего продвижения — определить основных конкурентов, узнать по каким запросам они продвигаются и находятся в топе, какими ссылками закупаются и т.д.

Спасибо вам за внимание, друзья!

До встречи!

Как провести SEO аудит сайта — инструкция

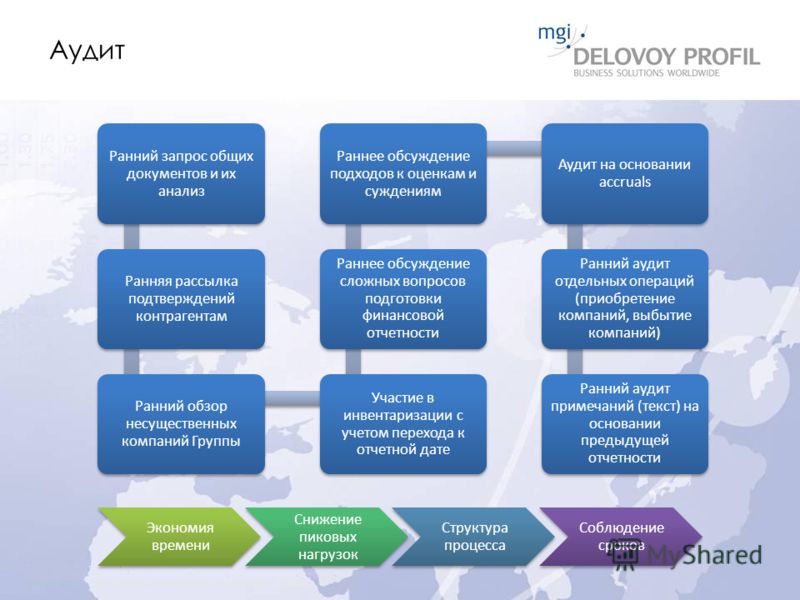

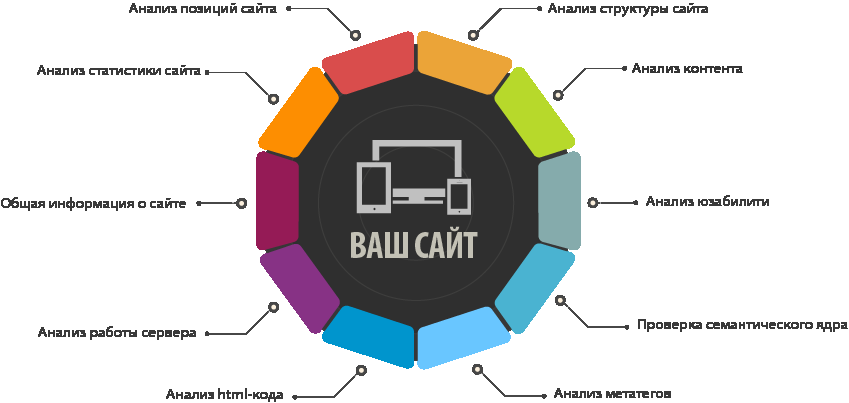

SEO-аудит сайта — это комплекс мер, позволяющий выявить ошибки сайта, которые необходимо устранить для лучшего продвижения сайта, или же, наоборот, убедиться в том, что с вашим сайтом все хорошо.

SEO аудит сайта включает в себя:

- Анализ данных из Яндекс.Вебмастер, Google Search Console

- Технический аудит сайта

- Аудит содержания

Анализ данных из Яндекс.Вебмастер, Google Search Console

Google Search Console и Яндекс.Вебмастер – это инструменты, которые помогут понять как поисковые системы относятся к сайту.

Яндекс.

ВебмастерСтраницы в поиске

ВебмастерСтраницы в поискеИндексирование → Страницы в поиске

В нем находится информация о страницах, которые участвуют или же не участвуют в поиске Яндекса.

С помощью информации из данного раздела вы сможете:

- следить за изменением количества страниц в поисковой выдаче Яндекса и за соотношением числа добавленных и исключенных страниц;

- получать информацию о дате последнего посещения сайта роботом и обновления поисковой выдачи;

- выяснить причину исключения страницы из результатов поиска.

Индексирование → Структура сайта

Здесь показаны разделы сайта, которые содержат не менее 10 страниц и составляют более 1% от общего числа страниц, загруженных в базу Поиска. Разделы представлены в виде дерева в соответствии со структурой URL сайта. По каждому разделу сайта доступна информация о количестве страниц, которые были загружены роботом Яндекса и участвуют в поиске.

Представленные данные помогут определить, что робот загружает именно те разделы сайта, которые вы считаете интересными для пользователей.

Статистика обходаИндексирование → Статистика обхода

Индексирующий робот Яндекса регулярно обходит страницы сайтов и загружает их в поисковую базу. При этом робот может загрузить не все нужные вам страницы из-за их недоступности.

На данной странице можно узнать, какие страницы вашего сайта обходит робот и выявить адреса страниц, которые робот не смог загрузить из-за недоступности сервера, на котором находится сайт, или из-за ошибок в содержимом самих страниц.

РегиональностьИнформация о сайте → Региональность

Яндекс уделяет большое внимание учету региональности в результатах поиска. Вводя в поисковую строку геозависимый запрос, пользователь предпочитает увидеть ответы из своего региона, а не из других городов.

Соответственно, для того, чтобы ваш сайт ранжировался в нужном вам регионе (городе, области и т. д.) необходимо это указать.

д.) необходимо это указать.

Для начала надо понимать какой у вас тип сайта: информационный или предлагающий услуги, товары — и на основании этого зависит нужно ли вам указывать региональность сайта.

Информационный общей тематики. В данном случае региональность не обязательна.

Информационный сайт региональной тематики (например, региональный портал). Необходимо указать региональность. Выполнить следующие шаги:

- Убедитесь, что на сайте правильно размещены контактная информация и данные о региональной принадлежности.

- Укажите предпочтительный регион в интерфейсе Яндекс.Вебмастера (если не был указан).

Сайт, предлагающий услуги или товары. Также необходимо указать региональность. Выполнить следующие шаги:

- Убедитесь, что на сайте правильно размещены контактная информация и данные о региональной принадлежности.

- Укажите предпочтительный регион в интерфейсе Яндекс.Вебмастера (если не был указан).

.jpg)

- Добавьте сайт в Яндекс.Справочник (если не был добавлен ранее).

Основываясь на информации выше, вы сможете понять правильно ли у вас указан региональность сайта и нужна ли он вообще.

Безопасность и нарушенияДиагностика → Безопасность и нарушения

В данном разделе отображаются нарушения и угрозы, найденные на сайте.

Проверяем на наличие. Если раздел пуст — все ок.

Google Search Console

ЭффективностьОтчет об эффективности содержит различные показатели, связанные с эффективностью сайта в результатах поиска Google (частоте нахождения по запросам, средней позиции, CTR и т. д.), а также сведения по специальным функциям (например, расширенным результатам). Этот отчет позволит:

- выяснить, как поисковый трафик меняется со временем, откуда приходят посетители и по каким запросам показывается ваш сайт;

- узнать, у каких страниц наибольший и наименьший CTR в результатах Google Поиска.

В данном разделе отображаются страницы с ошибками, страницы с предупреждениями и исключенные страницы.

Если ваши нужные страницы относятся к одной из вышеперечисленных категорий, то необходимо провести повторную проверку, т.к. иногда данные могут быть неактуальными. Если же опасения подтвердились, то необходимо применить соответствующие меры.

Меры, принятые вручнуюПроблемы безопасности

На данные отчеты обращаем внимание в первую очередь. Если у вас есть проблемы с этими пунктами, то, вероятнее всего, они являются (или будут являться) первопричиной низких позиций и упадки трафика.

Технический аудит

Он состоит из проверки технической стороны сайта: дубли страниц, дубли мета-тегов, валидация html-кода, анализ скорости загрузки страниц, адаптивность для мобильных устройств и т.д

Проверка на наличие ссылок с неверными кодами ответа сервера

В идеале все страницы сайта должны отдавать 200 код ответа сервера. Для полноценного анализа лучше использовать приложение Screaming Frog SEO Spider или Netpeak Spider.

Для полноценного анализа лучше использовать приложение Screaming Frog SEO Spider или Netpeak Spider.

Данные инструменты позволяют выявить страницы сайта с 3хх, 4хх и 5хх кодами ответа сервера.

- 3хх. Зачастую это ссылки с 301 и 302 кодами ответа сервера. Их необходимо исправить на прямые, если это сделано непреднамеренно.

То есть, к примеру раньше у вас была страница /auto/, но вы создали новую — /cars/ и со страницы /auto/ вы настроили 301 редирект на страницу /cars/.

Но на сайте у вас до сих пор стоят ссылки на старую страницу /auto/. Переходя по этой ссылке робота и пользователя сервер перенаправляет на новую страницу (/cars/).

Заменив старую ссылку на новую мы избавимся от ненужного 301 редиректа, что в свою очередь благотворно влияет на краулинговый бюджет и сокращает время ожидания пользователя. - 4хх. В основном это страницы с 404 и 403 кодами ответа сервера. 404 — говорят, что страница не существует. 403 — доступ запрещен.

Необходимо проверить к нужным ли страницам запрещен доступ и для нужных ли страниц сервер отдает 404.

404 исправляем путем удаления ссылок с сайта. - 5хх. Ошибки, возникшие по вине сервера. Стоит изучить код ответа сервера и принять меры.

HTTPS-протокол

Если вы храните, обрабатываете персональные данные, то необходимо позаботиться о приобретении и установке SSL-сертификата.

Соответственно, надо все страницы перевести на защищенный протокол с помощью 301 редиректа.

Дубли страниц

Склейка

Смотрим доступен ли сайт с www и без www — должна открываться одна и та же страница в обоих случаях. Если этого не происходит, то необходимо настроить 301 редирект.

Дубли мета-тегов

В первую очередь необходимо выявить страницы с одинаковыми title. Это можно сделать с помощью инструментов: Netpeak Spider и Screaming Frog SEO Spider.

Вводите адрес сайта и запускаете анализ. Далее смотрите отчет по дублям title.

Если страницы с одинаковыми title являются дублями (контент идентичен), то необходимо настроить 301 редирект, либо canonical.

Если же контент отличается, то необходимо уникализировать title этих страниц. Например, на одной странице у вас представлены автокресла, а на другой — коляски, при этом title у них одинаковый, пусть будет: “Интернет-магазин Блублу”. Title должен отражать суть страницы. Тогда пусть title будут выглядеть следующим образом:

- Купить коляски в интернет-магазине Блублу

- Автокресла — купить в интернет-магазине Блублу

404 страница

Если пользователь попал на несуществующую страницу, то необходимо это отображать путем информирования и возможностью вернуться на главную или на другую страницу из меню.

В мета-тегах и h2 должна быть соответствующая информация.

Страница должна отдавать 404 код ответа сервера. Проверить можно здесь.

robots.txt

Необходимо убедиться:

- в наличии данного файла в корне сайта.

Должен открываться по адресу: site.ru/robots.txt

Должен открываться по адресу: site.ru/robots.txt - в корректном заполнении. Валидатор есть в панели Яндекс.Вебмастер (Инструменты → Анализ robots.txt)

- что нужные страницы доступны к индексации. Добавьте в валидатор несколько типовых страниц и нажмите “Проверить”.

Если страница не заблокирована в robots.txt, то увидите зеленую галочку.

Если страница заблокирована, то увидите красное правило, которое блокирует данную страницу. - что ненужные страницы запрещены к индексации. Обычно такими являются сервисные страницы: корзина, сравнение, вход, регистрация и т.д.

- что есть ссылка на карту сайта — sitemap.xml

Примечание. robots.txt не является строгим правилом, поэтому некоторые страницы, заблокированные в нем, могут все равно участвовать в поиске.

Если вы хотите строго запретить добавлять в индекс определенные страницы, то необходимо разместить на них мета-тег robots — <meta name=”robots” content=”noindex”>, либо с помощью http-заголовка X-Robots-Tag со значением noindex или none.

Sitemap.xml

- Проверить наличие файла. Если файла нет — создать. Если присутствует, то проверяем какие страницы находятся в нем.

- Обязательно должны присутствовать все страницы, которые являются важными.

- Проверить коды ответа страниц. Должны быть только страницы с 200 кодом ответа сервера

- Проверить файл с помощью валидатора в Яндекс.Вебмастере (Инструменты → Анализ файлов Sitemap)

Оптимизация для мобильных устройств (Mobile-friendly)

Доля пользователей, посещающих сайты с мобильных устройств, уже выше, чем доля посетителей с десктопов. Поэтому необходимо убедиться, что ваш сайт оптимизирован под мобильные устройства.

Инструмент Mobile-friendly

Проверяем несколько типовых страниц и смотрим на результат.

Если будут какие-либо ошибки, то инструмент укажет на них и даст рекомендации по их устранению.

Удобство для мобильных

В Google Search Console есть отчет “Удобство для мобильных”.

Если присутствуют ошибки, то увидите их в соответствующем столбце.

Кликнув на отчет, внутри найдете анкор “Подробнее”, при клике на который вы попадете на страницу с рекомендациями устранения соответствующей проблемы.

Доступность ресурсов сайта для поисковых роботов

При загрузке страницы у робота Google могут возникнуть сложности с обработкой ресурсов сайта.

Для того, чтобы убедиться, что ваш сайт корректно обрабатывается краулером Google необходимо провести следующие тесты:

Инструмент Mobile-friendly

Чтобы увидеть заблокированные ресурсы необходимо нажать на кнопку “Подробнее” (см. скриншот)

Основная причина недоступности ресурсов это их блокировка в файле robots.txt. Скорректируйте данный файл, основываясь на информации полученной из отчета.

Проверка URL в Google Search Console

Для проверки URL необходимо открыть отчет “Проверка URL”, добавить адрес интересующей страницы и запустить проверку.

После проверки в правом верхнем углу необходимо нажать на кнопку “Проверить на сайте”. После этого вы сможете увидеть заблокированные ресурсы.

Нажмите на “Изучить проверенную страницу”. В правой стороне экрана появится блок с тремя вкладками: HTML, Скриншот, Подробнее.

Переходим на вкладку “Подробнее” и смотрим с загрузкой каких ресурсов возникают трудности.

Так же, как и в пункте выше, основная проблема — это блокировка ресурсов в robots.txt. Корректируем данный файл с учетом полученной информации.

Валидность HTML-кода

С помощью данной процедуры можно узнать соответствует ли код ваших страниц общепринятым стандартам. Если да, то поисковые роботы без труда смогут понять что из себя представляем ваш сайт.

Если нет — необходимо исправить ошибки.

Проверку лучше производить с помощью сервиса Markup Validation Service.

Скорость загрузки сайта

Используем инструмент Google Pagespeed Insights.

Проверяется скорость загрузки для мобильных устройствах и для десктопов. Результаты содержатся на соответствующих вкладках.

Результаты содержатся на соответствующих вкладках.

Следуя рекомендациям, необходимо улучшить показатели скорости загрузки минимум до оранжевой зоны, в идеале — до зеленой.

Примечание. Частая проблема низкой скорости загрузки в неоптимизированных изображениях. Если вы столкнулись с аналогичной проблемой, то необходимо оптимизировать все изображения сайта с помощью рекомендуемого сервиса.

Аудит содержания

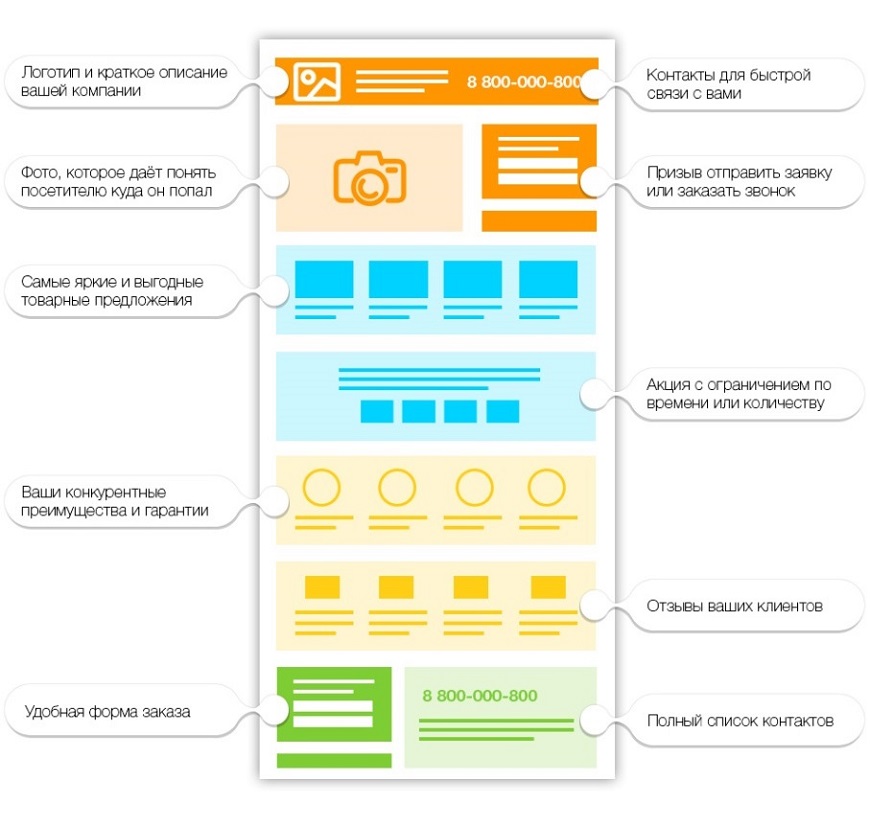

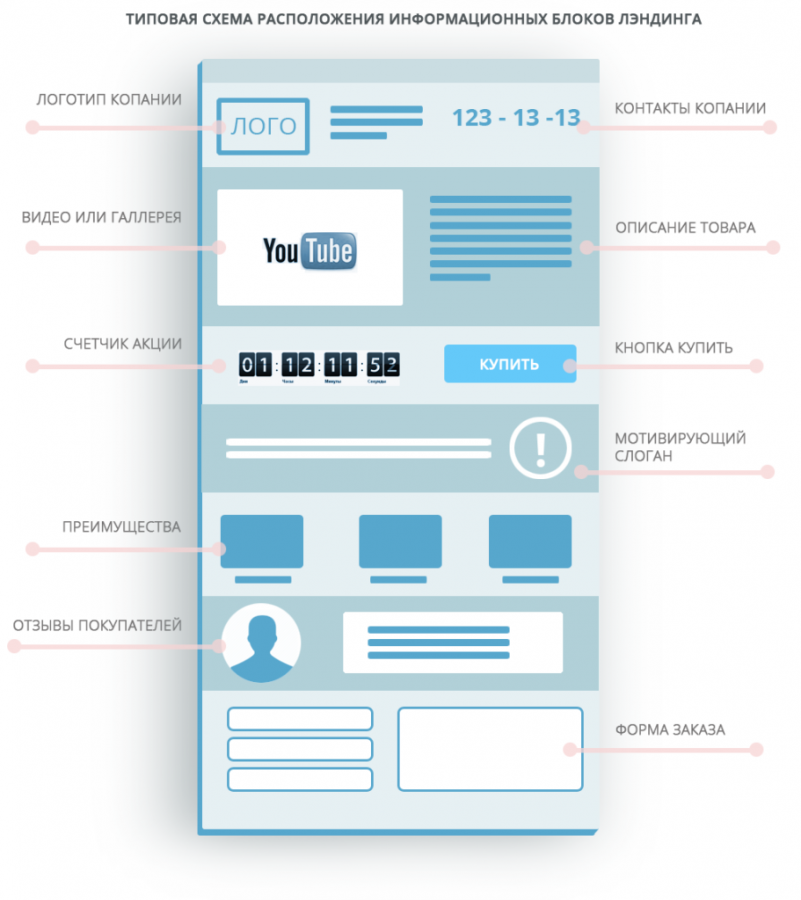

Данный пункт подразумевает проверку сайта на наличие необходимых блоков/элементов, а также сравнение с конкурентами.

Рассмотрим на примере:

Интернет-магазин

Необходимо удостовериться, что вы предоставляете всю необходимую информацию пользователям. Такой информацией могут быть:

- карточки товаров с изображениями

- цены

- возможности сортировки и фильтрации по параметрам

- характеристики, описание и свойства товара

- информация о доставке и способов оплаты товара

!Всегда анализируйте ТОП по нужным вам запросам. Смотрите конкурентов. Обращайте внимание на их контент: какие страницы и фишки у них есть, какой тип контента публикуется. Прикидывайте это на свой сайт, делайте выводы. Не надо все копировать.

Смотрите конкурентов. Обращайте внимание на их контент: какие страницы и фишки у них есть, какой тип контента публикуется. Прикидывайте это на свой сайт, делайте выводы. Не надо все копировать.

Сайт, предоставляющий услуги

Например, на вашем сайте представлены услуги по производству стеклянных перегородок для душа. Скорее всего пользователям будет полезно следующее:

- текст с описанием процесса и преимуществами

- возможные варианты изготовления

- указание цены

- возможные варианты фурнитуры

- возможный выбор цветов фурнитуры

- возможность оставить заявку или заказать звонок

- примеры работ

!Не забываем смотреть ТОП и анализировать конкурентов.

Неважно какой у вас сайт (коммерческий, информационный и т.д.), старайтесь делать его максимально удобным и отзывчивым для пользователей. Чем удобнее он будет, тем лучше будут поведенческие характеристики сайта. Поведенческие характеристики, в свою очередь, являются одним из факторов ранжирования.

Также не стоит забывать и про поисковые системы. Ведь если поисковые роботы не смогут понять, что находится на вашем сайте, то и ранжироваться высоко он не будет.

Итог: это не все параметры для анализа. Но для проведения самостоятельного SEO анализа сайта и выявления базовых ошибок оптимизации сайта этого будет достаточно.

Как провести аудит вашего веб-сайта: руководство для начинающих SEO

Доктор пришел, и пришло время для осмотра.

SEO-проверка, то есть.

Независимо от того, насколько хорошо оптимизирован ваш веб-сайт, все равно могут возникнуть проблемы, требующие решения.

Это могут быть технические проблемы SEO, низкая скорость страницы, дублированный контент, неработающие ссылки или что-то еще, что может помешать вашему сайту получить весь трафик (и конверсии), которого он заслуживает.

Проведение аудита сайта — это первый шаг к выявлению возможных проблем с сайтом.

Вот почему вам следует регулярно проводить аудит своего сайта и как правильно проводить комплексный аудит сайта.

Содержание

Зачем нужен аудит сайта

Аудит сайта проводится для выявления широкого спектра проблем с сайтом. Он определяет, полностью ли ваш веб-сайт оптимизирован для трафика поисковых систем, содержит ли битые файлы или ссылки, быстро ли загружается, удобен для пользователя и содержит ли он первоклассный контент.

Проведение регулярных аудитов сайта очень важно, потому что даже если ваш сайт по-прежнему генерирует трафик, вы хотите быть уверены, что он полностью раскрывает свой потенциал. Если не решить эти проблемы, это может привести к остановке или даже снижению трафика или снижению конверсий.

Поисковая оптимизация — это непрерывная работа, включающая постоянную проверку и оптимизацию вашего веб-сайта. Добавьте регулярные аудиты сайта в свой процесс, чтобы убедиться, что ваш сайт (или сайт вашего клиента) всегда настроен для успеха SEO.

Как вы проводите аудит сайта?

Проведение аудита сайта вручную требует много работы. Даже для опытных SEO-специалистов проведение аудита сайта — непростая задача, особенно для старых и крупных веб-сайтов. Когда вы получаете доступ к тысячам, десяткам тысяч или сотням тысяч страниц и ресурсов на веб-сайте, инструмент аудита становится абсолютно необходимым, хотя для эффективного аудита по-прежнему должен существовать ручной элемент.

Даже для опытных SEO-специалистов проведение аудита сайта — непростая задача, особенно для старых и крупных веб-сайтов. Когда вы получаете доступ к тысячам, десяткам тысяч или сотням тысяч страниц и ресурсов на веб-сайте, инструмент аудита становится абсолютно необходимым, хотя для эффективного аудита по-прежнему должен существовать ручной элемент.

К счастью, существует несколько инструментов SEO, которые еще больше упрощают аудит веб-сайтов.

1. Выберите средство аудита веб-сайта

У нас есть собственный инструмент аудита веб-сайта, но с тех пор, как мы только начали, появилось множество инструментов. У Ahrefs есть своя версия, у SEM Rush есть свой собственный аудитор, а также существуют еще несколько узкоспециализированных инструментов, таких как Screaming Frog и Sitebulb, которые предоставляют исключительно услуги аудита.

Все эти инструменты являются премиальными (платными) инструментами SEO, но имеют лучшую репутацию за то, что они полны, точны, просты в использовании и всеобъемлющи. Важно помнить, что разница между бесплатным инструментом аудита сайта и платной версией огромна с точки зрения возможностей и надежности.

Важно помнить, что разница между бесплатным инструментом аудита сайта и платной версией огромна с точки зрения возможностей и надежности.

Эти инструменты аудита сайта позволяют:

- Сканировать ваш сайт на наличие технических проблем

- Выявлять проблемы SEO на странице и за ее пределами дублированный контент

- Оценка ошибок страниц, проблем со скоростью загрузки страниц и страниц, заблокированных robots.txt

- Создание контрольного списка проблем для устранения

Использование инструмента SEO (или нескольких) — лучший способ определить любые проблемы с веб-сайтом и генерировать отчет о проблемах, которые необходимо исправить.

Мы рекомендуем подписаться на бесплатную пробную версию каждого из инструментов, чтобы определить, какая платформа лучше всего подходит для вас.

2. Запустите URL-адрес вашего веб-сайта с помощью инструмента аудита сайта

После того, как вы выбрали премиальный инструмент SEO, у вас будет возможность ввести URL-адрес вашего веб-сайта в аудитор сайта.

Аудитор сайта просканирует ваш сайт, чтобы создать исчерпывающий отчет обо всех проблемах с сайтом. Каждый инструмент немного отличается в том, как они отображают результаты.

Например, Raven Tools Site Auditor создаст надежный контрольный список проблем веб-сайта в порядке приоритета и перечислит количество проблем в каждой категории.

Это позволяет легко определить, что нужно исправить, и отмечать элементы по ходу дела.

Получив этот отчет, вы можете просмотреть проблемы по категориям.

Ниже мы разбили каждую основную категорию потенциальных проблем с веб-сайтом и то, на что следует обратить внимание при аудите вашего сайта.

3. Поиск технических ошибок

Когда большинство людей слышат «SEO-аудит», на ум обычно приходят технические проблемы.

Все эти проблемы могут повлиять на SEO, но даже если вы не уделяете SEO приоритетное внимание своему веб-сайту, исправление технических проблем все равно поможет вашему сайту работать более плавно и будет более удобным для пользователей.

Вот почему ВСЕМ владельцам веб-сайтов важно регулярно проводить аудит.

Ваш инструмент аудита сайта создаст список технических ошибок, которые необходимо исправить на вашем сайте. Среди них могут быть:

- Ошибки сканирования: Они появляются, когда инструмент идентифицирует страницы, которые не могут быть просканированы ботами поисковых систем. ://» или «https://») и является ли ваш сайт безопасным для доступа пользователей

- Статус карты сайта XML: Ваша карта сайта XML — это, по сути, карта для сканеров поисковых систем. Это определяет, правильно ли отформатирована ваша карта сайта, включает ли она все обновленные страницы и т. д.

- Время загрузки сайта и страниц: Узнайте, быстро (или медленно) загружаются ваш сайт и страницы. Низкая скорость загрузки может затруднить взаимодействие с пользователем

- Удобство для мобильных устройств: Доступен ли ваш веб-сайт с мобильных устройств? Есть ли какие-либо глюки или проблемы с доступностью?

- Неработающие изображения: Убедитесь, что все изображения правильно отображаются на вашем веб-сайте и не содержат неработающих ссылок.

страницы, которые вы НЕ хотите индексировать, не индексируются)

страницы, которые вы НЕ хотите индексировать, не индексируются) - Неработающие ссылки: Обнаружение «неработающих» внутренних или внешних ссылок (т. е. недоступных для пользователей или страницы, на которую они указывают, больше не существует)

Большинство этих технических проблем легко исправить либо на самостоятельно или с помощью эксперта по SEO или веб-разработчика.

Даже удаление нескольких из этих ошибок из вашего списка может значительно улучшить присутствие вашего веб-сайта в Интернете и сделать его более удобным для пользователей.