Использование файла robots.txt — Вебмастер. Справка

Robots.txt — это текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем.

Яндекс поддерживает стандарт исключений для роботов (Robots Exclusion Protocol) с расширенными возможностями.

При очередном обходе сайта робот Яндекса загружает файл robots.txt. Если при последнем обращении к файлу, страница или раздел сайта запрещены, робот не проиндексирует их.

- Требования к файлу robots.txt

- Рекомендации по наполнению файла

- Использование кириллицы

- Как создать robots.txt

- Вопросы и ответы

Роботы Яндекса корректно обрабатывают robots.txt, если:

Размер файла не превышает 500 КБ.

Это TXT-файл с названием robots — robots.txt.

Файл размещен в корневом каталоге сайта.

Файл доступен для роботов — сервер, на котором размещен сайт, отвечает HTTP-кодом со статусом 200 OK.

Если файл не соответствует требованиям, сайт считается открытым для индексирования.

Яндекс поддерживает редирект с файла robots.txt, расположенного на одном сайте, на файл, который расположен на другом сайте. В этом случае учитываются директивы в файле, на который происходит перенаправление. Такой редирект может быть удобен при переезде сайта.

Яндекс поддерживает следующие директивы:

| Директива | Что делает |

|---|---|

| User-agent * | Указывает на робота, для которого действуют перечисленные в robots.txt правила. |

| Disallow | Запрещает индексирование разделов или отдельных страниц сайта. |

| Sitemap | Указывает путь к файлу Sitemap, который размещен на сайте. |

| Clean-param | Указывает роботу, что URL страницы содержит параметры (например, UTM-метки), которые не нужно учитывать при индексировании. |

| Allow | Разрешает индексирование разделов или отдельных страниц сайта. |

| Crawl-delay | Задает роботу минимальный период времени (в секундах) между окончанием загрузки одной страницы и началом загрузки следующей. Рекомендуем вместо директивы использовать настройку скорости обхода в Яндекс Вебмастере. |

* Обязательная директива.

Наиболее часто вам могут понадобиться директивы Disallow, Sitemap и Clean-param. Например:

User-agent: * #указывает, для каких роботов установлены директивы Disallow: /bin/ # запрещает ссылки из "Корзины с товарами". Disallow: /search/ # запрещает ссылки страниц встроенного на сайте поиска Disallow: /admin/ # запрещает ссылки из панели администратора Sitemap: http://example.com/sitemap # указывает роботу на файл Sitemap для сайта Clean-param: ref /some_dir/get_book.pl

Роботы других поисковых систем и сервисов могут иначе интерпретировать директивы.

Примечание. Робот учитывает регистр в написании подстрок (имя или путь до файла, имя робота) и не учитывает регистр в названиях директив.

Использование кириллицы запрещено в файле robots.txt и HTTP-заголовках сервера.

Для указания имен доменов используйте Punycode. Адреса страниц указывайте в кодировке, соответствующей кодировке текущей структуры сайта.

Пример файла robots.txt:

#Неверно: User-agent: Yandex Disallow: /корзина Sitemap: сайт.рф/sitemap.xml #Верно: User-agent: Yandex Disallow: /%D0%BA%D0%BE%D1%80%D0%B7%D0%B8%D0%BD%D0%B0 Sitemap: http://xn--80aswg.xn--p1ai/sitemap.xml

В текстовом редакторе создайте файл с именем robots.

txt и укажите в нем нужные вам директивы.

txt и укажите в нем нужные вам директивы.Проверьте файл в Вебмастере.

Положите файл в корневую директорию вашего сайта.

Пример файла. Данный файл разрешает индексирование всего сайта для всех поисковых систем.

Сайт или отдельные страницы запрещены в файле robots.txt, но продолжают отображаться в поиске

Как правило, после установки запрета на индексирование каким-либо способом исключение страниц из поиска происходит в течение двух недель. Вы можете ускорить этот процесс.

В Вебмастере на странице «Диагностика сайта» возникает ошибка «Сервер отвечает редиректом на запрос /robots.txt»

Чтобы файл robots.txt учитывался роботом, он должен находиться в корневом каталоге сайта и отвечать кодом HTTP 200. Индексирующий робот не поддерживает использование файлов, расположенных на других сайтах.

Чтобы проверить доступность файла robots.txt для робота, проверьте ответ сервера.

Если ваш robots.txt выполняет перенаправление на другой файл robots.txt (например, при переезде сайта), Яндекс учитывает robots.txt, на который происходит перенаправление. Убедитесь, что в этом файле указаны верные директивы. Чтобы проверить файл, добавьте сайт, который является целью перенаправления, в Вебмастер и подтвердите права на управление сайтом.

Директива Clean-param — Вебмастер. Справка

Используйте директиву Clean-param, если адреса страниц сайта содержат GET-параметры (например, идентификаторы сессий, пользователей) или метки (например, UTM), которые не влияют на их содержимое.

Примечание. Иногда для закрытия таких страниц используется директива Disallow. Рекомендуем использовать Clean-param, так как эта директива позволяет передавать основному URL или сайту некоторые накопленные показатели.

Обучающее видео. Как использовать директиву Clean-param. Посмотреть видео |

Заполняйте директиву Clean-param максимально полно и поддерживайте ее актуальность. Новый параметр, не влияющий на контент страницы, может привести к появлению страниц-дублей, которые не должны попасть в поиск. Из-за большого количества таких страниц робот медленнее обходит сайт. А значит, важные изменения дольше не попадут в результаты поиска.

Робот Яндекса, используя эту директиву, не будет многократно перезагружать дублирующуюся информацию. Таким образом, увеличится эффективность обхода вашего сайта, снизится нагрузка на сервер.

Например, на сайте есть страницы:

www.example.com/some_dir/get_book.pl?ref=site_1&book_id=123 www.example.com/some_dir/get_book.pl?ref=site_2&book_id=123 www.example.com/some_dir/get_book.pl?ref=site_3&book_id=123

Параметр ref используется только для того, чтобы отследить с какого ресурса был сделан запрос и не меняет содержимое, по всем трем адресам будет показана одна и та же страница с книгой book_id=123. Тогда, если указать директиву следующим образом:

Тогда, если указать директиву следующим образом:

User-agent: Yandex Disallow: Clean-param: ref /some_dir/get_book.pl

Робот Яндекса сведет все адреса страницы к одному:

www.example.com/some_dir/get_book.pl?book_id=123

Если на сайте доступна такая страница, именно она будет участвовать в результатах поиска.

Чтобы директива применялась к параметрам на страницах по любому адресу, не указывайте адрес:

User-agent: Yandex Disallow: Clean-param: utm

Совет. Директива Clean-Param является межсекционной, поэтому может быть указана в любом месте файла. Если вы указываете другие директивы именно для робота Яндекса, перечислите все предназначенные для него правила в одной секции. При этом строка

Clean-param: p0[&p1&p2&..&pn] [path]

В первом поле через символ & перечисляются параметры, которые роботу не нужно учитывать. Во втором поле указывается префикс пути страниц, для которых нужно применить правило.

Префикс может содержать регулярное выражение в формате, аналогичном файлу robots.txt, но с некоторыми ограничениями: можно использовать только символы A-Za-z0-9.-/*_. При этом символ * трактуется так же, как в файле robots.txt: в конец префикса всегда неявно дописывается символ *. Например:

Clean-param: s /forum/showthread.php

означает, что параметр s будет считаться незначащим для всех URL, которые начинаются с /forum/showthread.php. Второе поле указывать необязательно, в этом случае правило будет применяться для всех страниц сайта.

Регистр учитывается. Действует ограничение на длину правила — 500 символов. Например:

Clean-param: abc /forum/showthread.php Clean-param: sid&sort /forum/*.php Clean-param: someTrash&otherTrash

#для адресов вида: www.example1.com/forum/showthread.php?s=681498b9648949605&t=8243 www.example1.com/forum/showthread.php?s=1e71c4427317a117a&t=8243 #robots.txt будет содержать: User-agent: Yandex Disallow: Clean-param: s /forum/showthread.php

#для адресов вида: www.example2.com/index.php?page=1&sid=2564126ebdec301c607e5df www.example2.com/index.php?page=1&sid=974017dcd170d6c4a5d76ae #robots.txt будет содержать: User-agent: Yandex Disallow: Clean-param: sid /index.php

#если таких параметров несколько: www.example1.com/forum_old/showthread.php?s=681498605&t=8243&ref=1311 www.example1.com/forum_new/showthread.php?s=1e71c417a&t=8243&ref=9896 #robots.txt будет содержать: User-agent: Yandex Disallow: Clean-param: s&ref /forum*/showthread.php

#если параметр используется в нескольких скриптах: www.example1.com/forum/showthread.php?s=681498b9648949605&t=8243 www.example1.com/forum/index.php?s=1e71c4427317a117a&t=8243 #robots.txt будет содержать: User-agent: Yandex Disallow: Clean-param: s /forum/index.php Clean-param: s /forum/showthread.php

Robots.txt — инструкция для SEO

24213 222

| SEO | – Читать 12 минут |

Прочитать позже

ЧЕК-ЛИСТ: ТЕХНИЧЕСКАЯ ЧАСТЬ — ROBOTS.TXT

Ильхом Чакканбаев

Автор блога Seopulses.ru

Файл robots.txt — это текстовый файл, в котором содержаться инструкции для поисковых роботов, в частности каким роботам и какие страницы допускается сканировать, а какие нет. В данной статье рассмотрим, где можно найти robots.txt, как его редактировать и какие правила по его использовать в SEO-продвижении.

Содержание

1. Зачем robots.txt нужен на сайте

2. Где можно найти файл robots.txt и как его создать или редактировать

3. Как создать и редактировать robots.txt

Как создать и редактировать robots.txt

4. Инструкция по работе с robots.txt

5. Синтаксис в robots.txt

6. Директивы в Robots.txt

— Disallow

— Allow

— Sitemap

— Clean-param

— Crawl-delay

7. Как проверить работу файла robots.txt

— В Яндекс.Вебмастер

— В Google Search Console

Заключение

Зачем robots.txt нужен на сайте

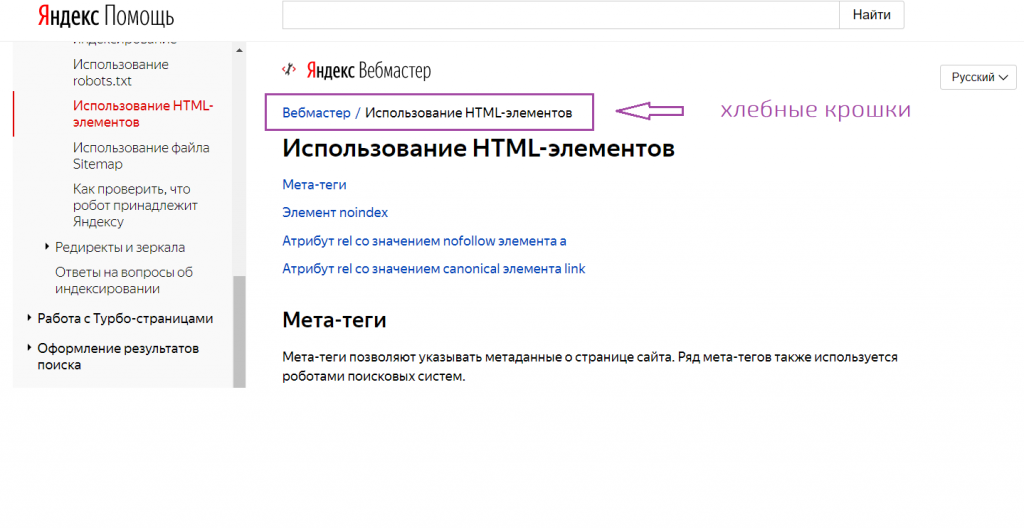

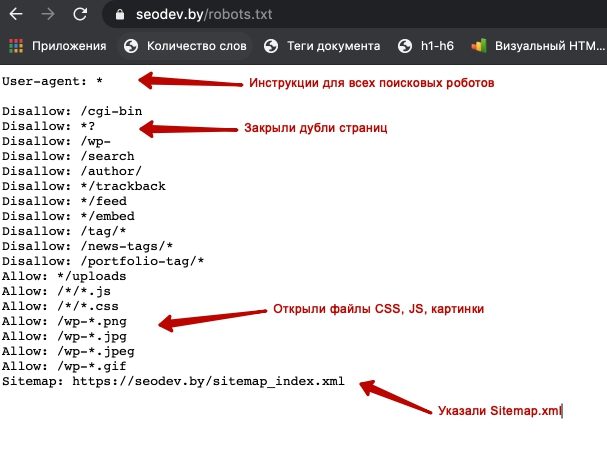

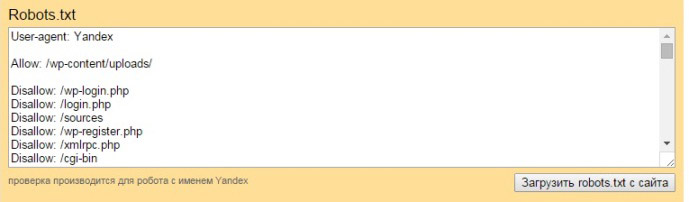

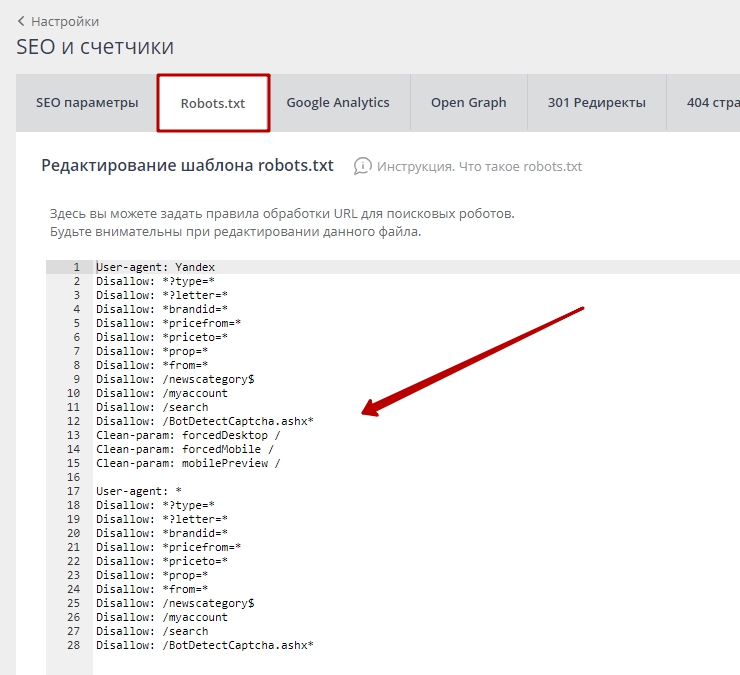

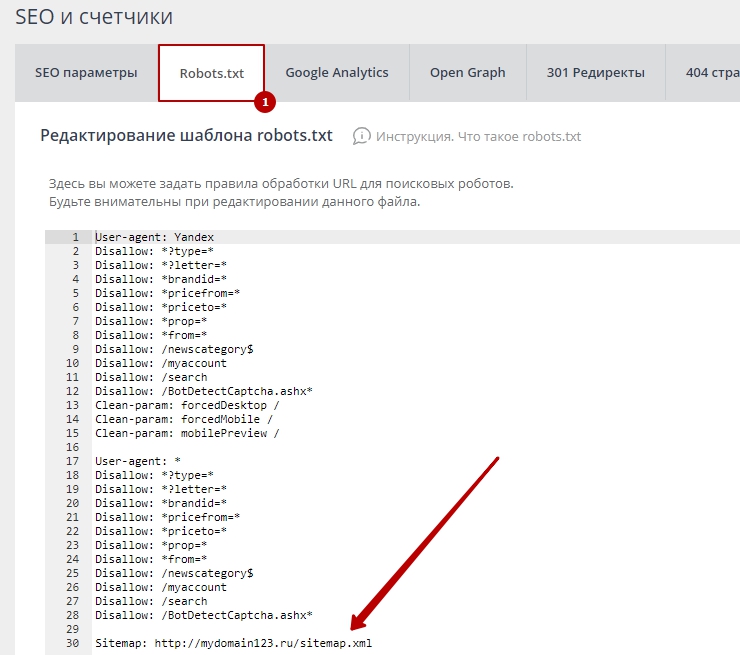

Командами robots.txt называются директивы, которые разрешают либо запрещают сканировать отдельные участки веб-ресурса. С помощью файла вы можете разрешать или ограничивать сканирование поисковыми роботами вашего веб-ресурса или его отдельных страниц, чем можете повлиять на позиции сайта. Пример того, как именно директивы будут работать для сайта:

На картинке видно, что доступ к определенным папкам, а иногда и отдельным файлам, не допускает к сканированию поисковыми роботами. Директивы в файле носят рекомендательный характер и могут быть проигнорированы поисковым роботом, но как правило, они учитывают данное указание. Техническая поддержка также предупреждает вебмастеров, что иногда требуются альтернативные методы для запрета индексирования:

Техническая поддержка также предупреждает вебмастеров, что иногда требуются альтернативные методы для запрета индексирования:

Какие страницы нужно закрыть от индексации

| Читать |

Где можно найти файл robots.txt и как его создать или редактировать

Чтобы проверить файл robots.txt сайта, следует добавить к домену «/robots.txt», примеры:

https://seopulses.ru/robots.txt

https://serpstat.com/robots.txt

https://netpeak.net/robots.txt

Как провести анализ индексации сайта

| Читать |

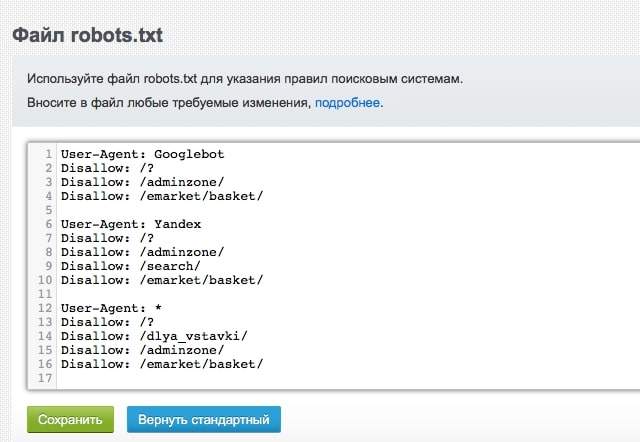

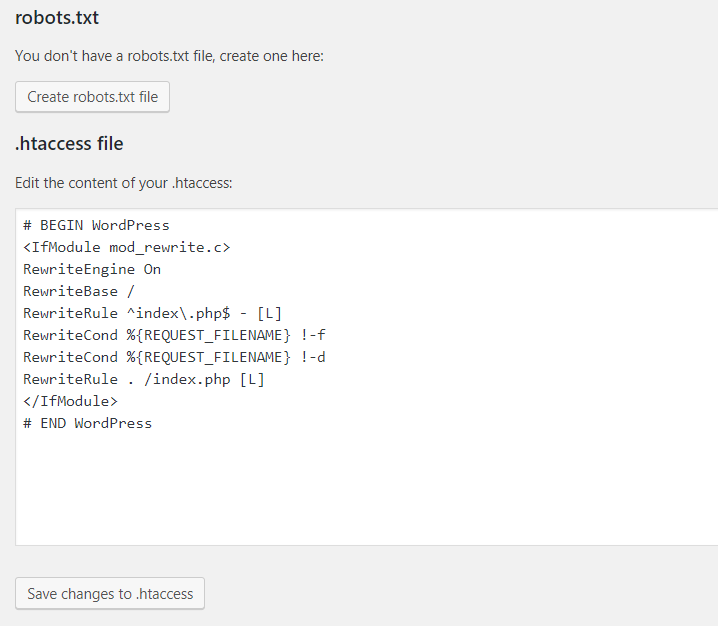

Как создать и редактировать robots.txt

Вручную

Данный файл всегда можно найти, подключившись к FTP сайта или в файлом редакторе хостинг-провайдера в корневой папке сайта (как правило, public_html):

Далее открываем сам файл и можно его редактировать.

Если его нет, то достаточно создать новый файл.

После вводим название документа и сохраняем.

Через модули/дополнения/плагины

Чтобы управлять данный файлом прямо в административной панели сайта следует установить дополнительный модуль:

Для 1С-Битрикс;

WordPress;

Для Opencart;

Webasyst.

Самые распространенные SEO-ошибки на сайте: инфографика

| Читать |

Инструкция по работе с robots.txt

В первую очередь записывается User-Agent, указывая на то, к какому роботу идет обращение, например:

User-agent: Yandex — для обращения к поисковому роботу Яндекса;

User-agent: Googlebot — в случае с краулером Google;

User-agent: YandexImages — при работе с ботом Яндекс.Картинок.

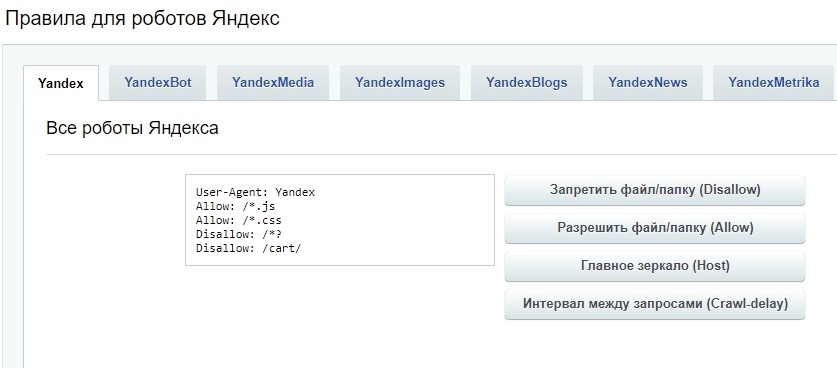

Обращения в robots.txt для Яндекса:

Чтобы обозначить обращение для поисковых роботов данной системы применяют такие значения:

Yandex Bot — основной робот, который будет индексировать ваш ресурс;

Yandex Media — робот, который специализируется на сканировании мультимедийной информации;

Yandex Images — индексатор для Яндекс. Картинок;

Картинок;

Yandex Direct — робот, который сканирует страницы веб-площадок, имеющих отношение к рекламе в Яндексе;

Yandex Blogs — робот для поиска в блогах и форумах, который индексирует комментарии в постах;

Yandex News — бот собирающий данные по Яндекс Новостям;

Yandex Pagechecker — робот, который обращается к странице с целью валидировать микроразметку.

Обращения в robots.txt для Google:

Имена используемые для краулеров от Google:

Googlebot — краулер, индексирующий страницы веб-сайта;

Googlebot Image — сканирует изображения и картинки;

Googlebot Video — сканирует всю видео информацию;

AdsBot Google — анализирует качество размещенной рекламы на страницах для компьютеров;

AdsBot Google Mobile — анализирует качество рекламы мобильных версий сайта;

Googlebot News — оценивает страницы для использования в Google Новости;

AdsBot Google Mobile Apps — расценивает качество рекламы для приложений на андроиде, аналогично AdsBot.

Полный список роботов Яндекс и Google.

Синтаксис в robots.txt

В первую очередь записывается User-Agent, указывая на то, к какому роботу идет обращение, например:

# — отвечает за комментирование;

* — указывает на любую последовательность символов после этого знака. По умолчанию указывается при любого правила в файле;

$ — отменяет действие *, указывая на то что на этом элементе необходимо остановиться.

Почему сайт не индексируется или

как проверить индексацию сайта в Google и Яндекс

| Читать |

Директивы в Robots.txt

Disallow

Disallow запрещает индексацию отдельной страницы или группы (в том числе всего сайта). Чаще всего используется для того, чтобы скрыть технические страницы, динамические или временные страницы.

Пример #1

# Полностью закрывает весь сайт от индексации

User-agent: *

Disallow: /

Пример #2

# Блокирует для скачивания все страницы раздела /category1/, например, /category1/page1/ или caterogy1/page2/

Disallow: /category1/

Пример #3

# Блокирует для скачивания страницу раздела /category2/

User-agent: *

Disallow: /category2/$

Пример #4

# Дает возможность сканировать весь сайт просто оставив поле пустым

User-agent: *

Disallow:

Важно! Следует понимать, что регистр при использовании правил имеет значение, например, Disallow: /Category1/ не запрещает посещение страницы /category1/.

Директива Allow указывает на то, что роботу можно сканировать содержимое страницы/раздела, как правило, используется, когда в полностью закрытом разделе, нужно дать доступ к определенному документу.

Пример #1

# Дает возможность роботу скачать файл site.ru//feed/turbo/ несмотря на то, что скрыт раздел site.ru/feed/.

Disallow: */feed/*

Allow: /feed/turbo/

Пример #2

# разрешает скачивание файла doc.xml

Allow: /doc.xml

Sitemap

Директива Sitemap указывает на карту сайта, которая используется в SEO для вывода списка URL, которые нужно проиндексировать в первую очередь.

Важно понимать, что в отличие от стандартных директив у нее есть особенности в записи:

Следует указывать полный URL, когда относительный адрес использовать запрещено;

На нее не распространяются остальные правила в файле robots. txt;

txt;

XML-карта сайта должна иметь в URL-адресе домен сайта.

Пример

Sitemap.xml или карта сайта: как создать и настроить для Google и Яндекс

| Читать |

Clean-param

Используется когда нужно указать Яндексу (в Google она не работает), что страница с GET-параметрами (например, site.ru?param1=2¶m2=3) и метками (в том числе utm) не влияющие на содержимое сайта, не должна быть проиндексирована.

Пример #1

#для адресов вида:

www.example1.com/forum/showthread.php?s=681498b9648949605&t=8243

www.example1.com/forum/showthread.php?s=1e71c4427317a117a&t=8243

#robots.txt будет содержать:

User-agent: Yandex

Disallow:

Clean-param: s /forum/showthread.php

Пример #2

#для адресов вида:

www.example2.com/index.php?page=1&sid=2564126ebdec301c607e5df

www. example2.com/index.php?page=1&sid=974017dcd170d6c4a5d76ae

example2.com/index.php?page=1&sid=974017dcd170d6c4a5d76ae

#robots.txt будет содержать:

User-agent: Yandex

Disallow:

Clean-param: sid /index.php

Подробнее о данной директиве можно прочитать здесь.

Crawl-delay

Важно! Данная директива не поддерживается в Яндексе с 22 февраля 2019 года и в Google 1 сентября 2019 года, но работает с другими роботами. Настройки скорости скачивания можно найти в Яндекс.Вебмастер и Google Search Console.

Crawl-delay указывает временной интервал в секундах, в течение которого роботу разрешается делать только 1 сканирование. Как правило, необходима лишь в случаях, когда у сайта наблюдается большая нагрузка из-за сканирования.

Пример

# Допускает скачивание страницы лишь раз в 3 секунды

Crawl-delay: 3

Хотите узнать, как использовать Serpstat для поиска ошибок на сайте?

Заказывайте бесплатную персональную демонстрацию сервиса, и наши специалисты вам все расскажут! 😉

| Оставить заявку! |

| Узнать подробнее! |

Как проверить работу файла robots. txt

txt

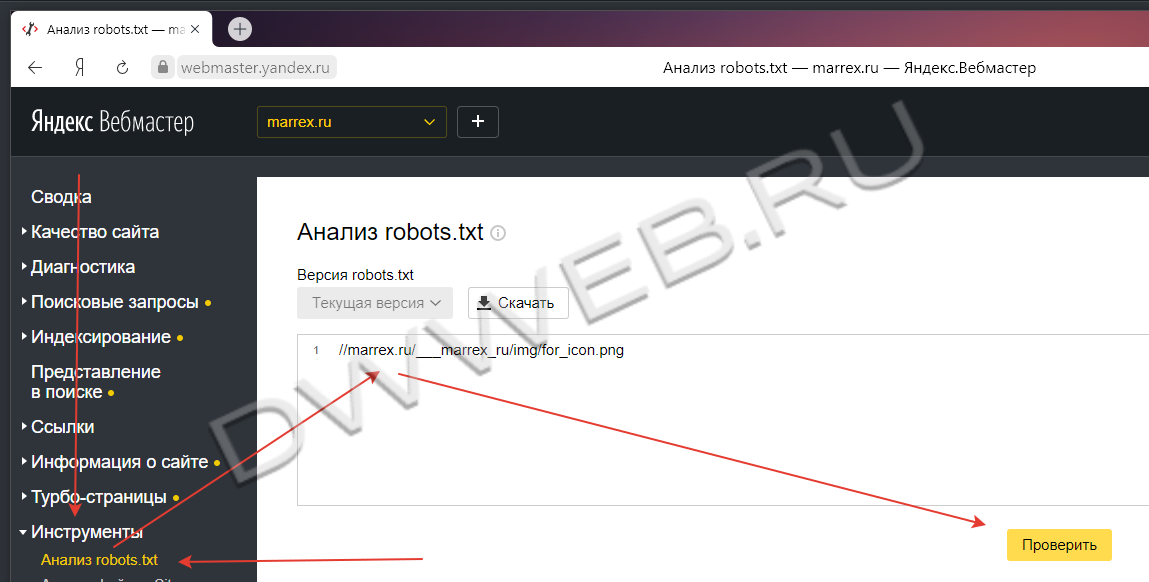

В Яндекс.Вебмастер

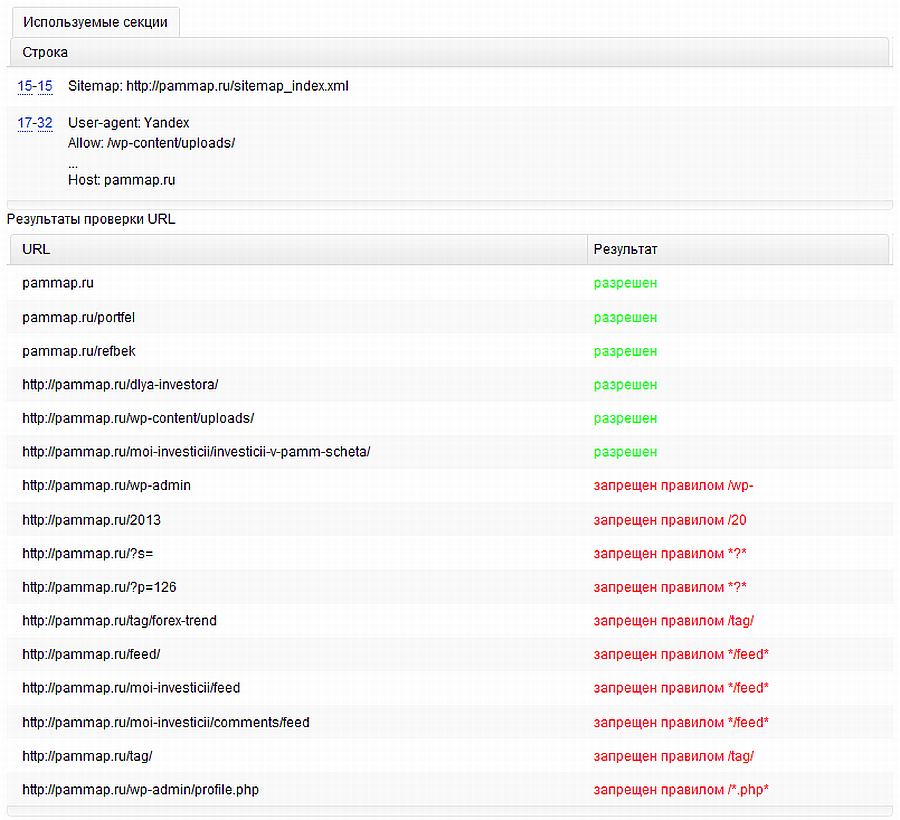

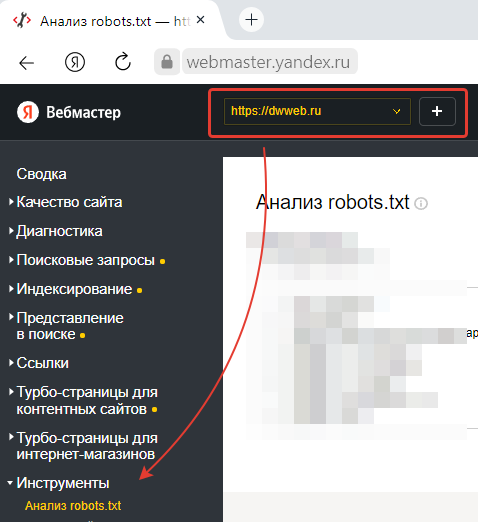

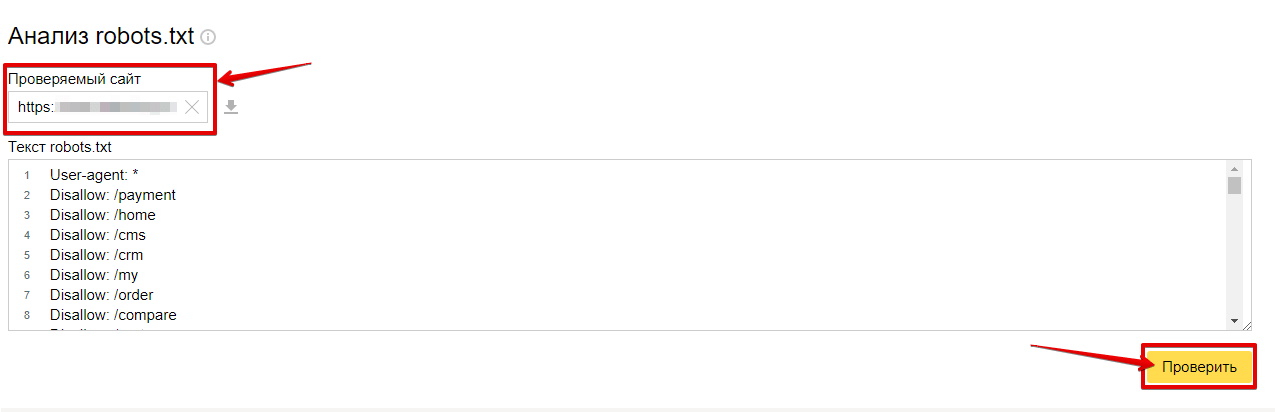

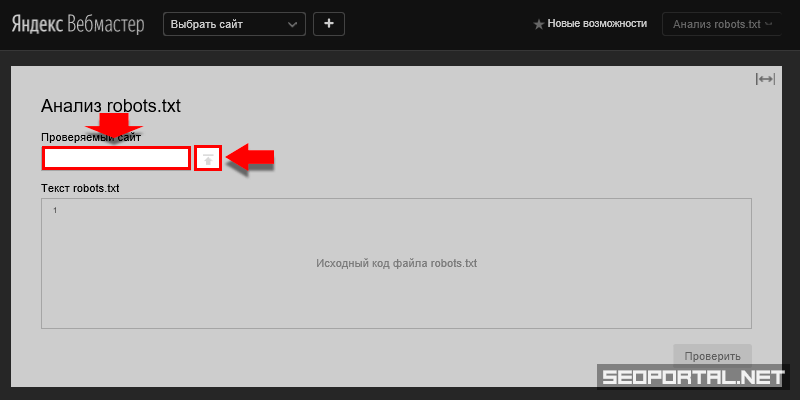

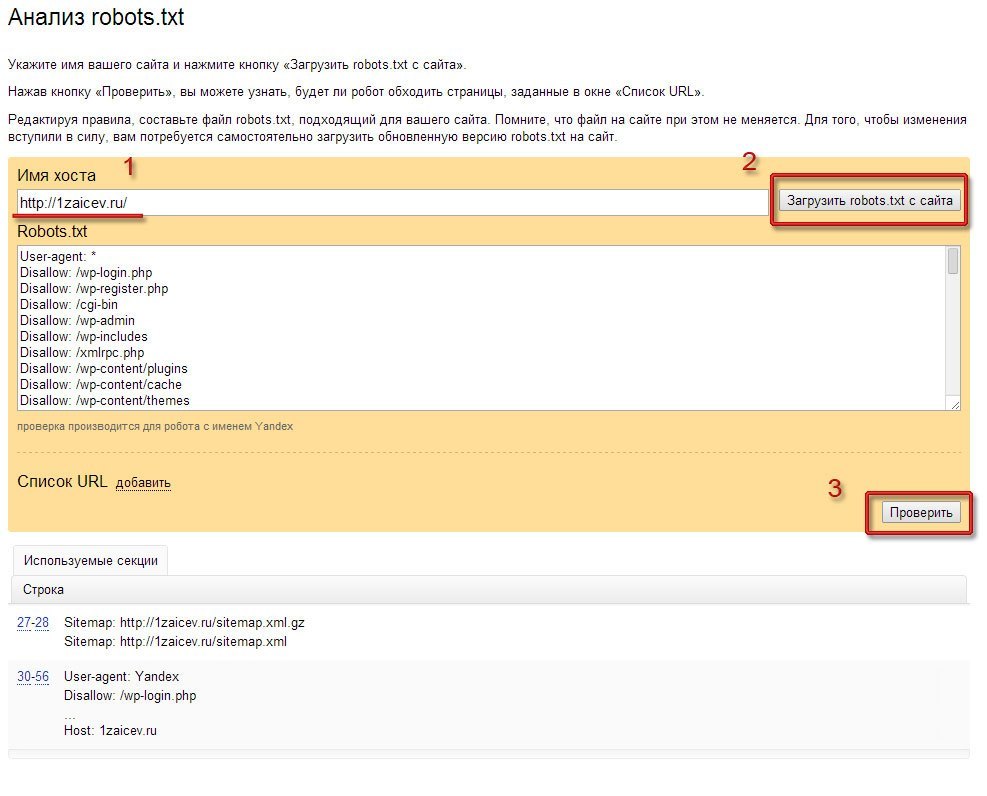

В Яндекс.Вебмастер в разделе «Инструменты→ Анализ robots.txt» можно увидеть используемый поисковиком свод правил и наличие ошибок в нем.

Также можно скачать другие версии файла или просто ознакомиться с ними.

Чуть ниже имеется инструмент, который дает возможно проверить сразу до 100 URL на возможность сканирования.

В нашем случае мы проверяем эти правила.

Как видим из примера все работает нормально.

Также если воспользоваться сервисом «Проверка ответа сервера» от Яндекса также будет указано, запрещен ли для сканирования документ при попытке обратиться к нему.

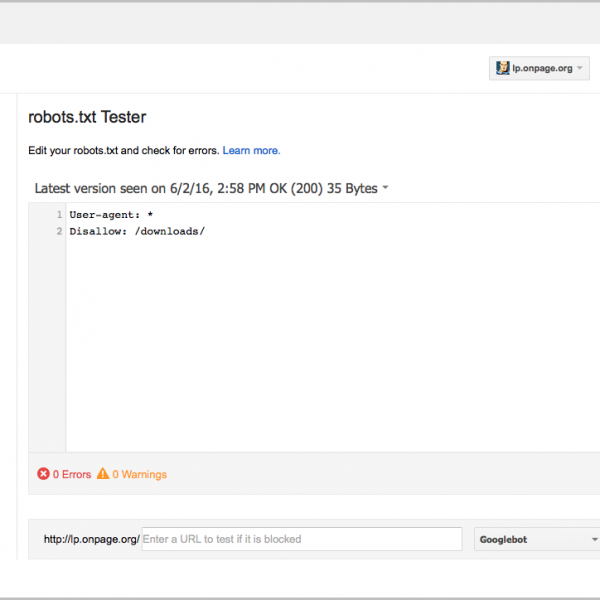

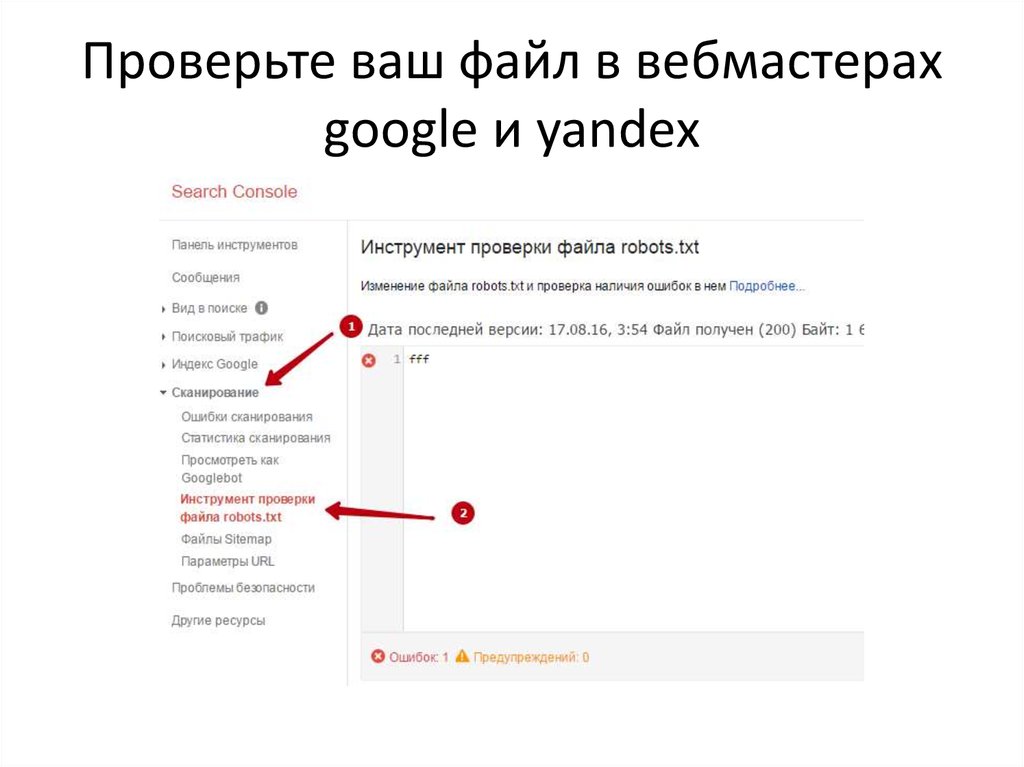

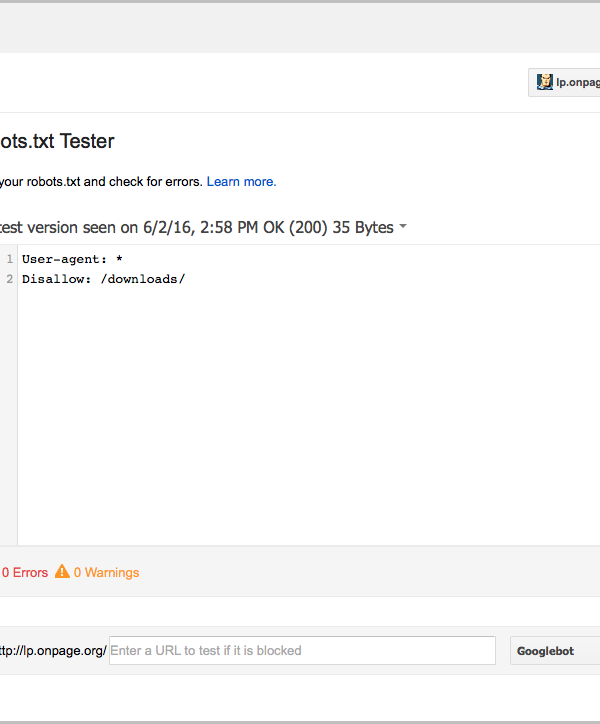

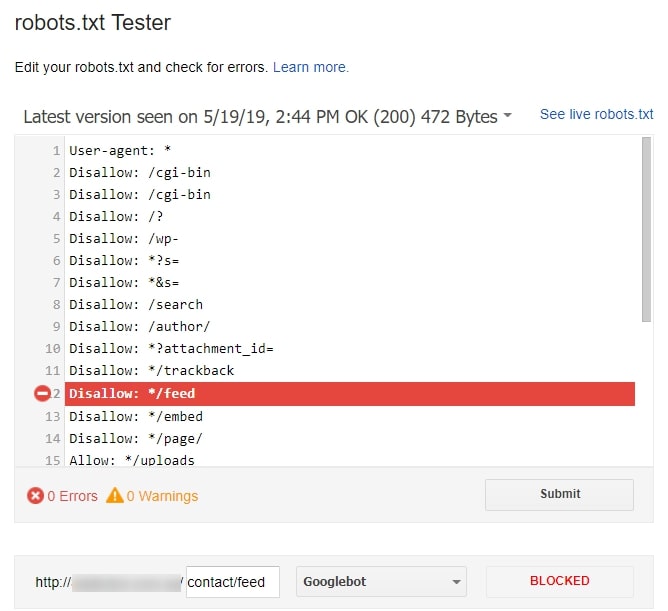

В Google Search Console

В случае с Google можно воспользоваться инструментом проверки Robots.txt, где потребуется в первую очередь выбрать нужный сайт.

Важно! Ресурсы-домены в этом случае выбирать нельзя.

Теперь мы видим:

Сам файл;

Кнопку, открывающую его;

Симулятор для проверки сканирования.

Если в симуляторе ввести заблокированный URL, то можно увидеть правило, запрещающее сделать это и уведомление «Недоступен».

Однако, если ввести заблокированный URL в страницу поиска в новой Google Search Console (или запросить ее индексирование), то можно увидеть, что страница заблокирована в файле robots.txt.

Заключение

Robots.txt необходим для ограничения сканирования определенных страниц вашего сайта, которые не нужно включать в индекс, так как они носят технический характер. Для создания такого документа можно воспользоваться Блокнотом или Notepad++.

Пропишите к каким поисковым роботам вы обращаетесь и дайте им команду, как описано выше.

Далее, проверьте его правильность через встроенные инструменты Google и Яндекс. Если не возникает ошибок, сохраните файл в корневую папку и еще раз проверьте его доступность, перейдя по ссылке http://yoursiteadress.com/robots.txt. Активная ссылка говорит о том, что все сделано правильно.

Помните, что директивы носят рекомендательный характер, а для того чтобы полностью запретить индексирование страницы нужно воспользоваться другими методами.

«Список задач» — готовый to-do лист, который поможет вести учет

о выполнении работ по конкретному проекту. Инструмент содержит готовые шаблоны с обширным списком параметров по развитию проекта, к которым также можно добавлять собственные пункты.

| Начать работу со «Списком задач» |

Сэкономьте время на изучении Serpstat

Хотите получить персональную демонстрацию сервиса, тестовый период или эффективные кейсы использования Serpstat?

Оставьте заявку и мы свяжемся с вами 😉

Оцените статью по 5-бальной шкале

4.71 из 5 на основе 13 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

SEO

Анатолий Бондаренко

Основные ошибки в оптимизации сайта и как их выявить

SEO

Ilkhom Chakkanbaev

Идеальная оптимизация страницы сайта: наглядное руководство [Инфографика]

SEO

Анастасия Кочеткова

Краулинговый или рендеринговый бюджет: не вместо, а вместе

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

Что такое файл robots.txt? – iSEO

Файл robots.txt («роботс тэ-экс-тэ») – текстовый файл, который представляет собой основной способ управления сканированием и индексацией сайта поисковыми системами. Размещается строго в корневой папке сайта. Имя файла должно быть прописано в нижнем регистре.

Зачем нужен robots.txt?

Поисковый робот, попадая на сайт обращается к файлу robots.txt, чтобы получить информацию о том, какие разделы и страницы сайта нужно игнорировать, а также информацию о расположении XML-карты сайта и другие параметры.

Данный файл позволяет убрать из поиска дубли страниц и служебные страницы, на которые не должны попадать посетители из поисковых систем. Помогает улучшить позиции сайта в поиске и комфортность для посетителей в использовании сайта.

Помогает улучшить позиции сайта в поиске и комфортность для посетителей в использовании сайта.

Для создания robots.txt достаточно воспользоваться любым текстовым редактором. Его необходимо заполнить в соответствии с определенными правилами (о них расскажем далее) и загрузить в корневой каталог сайта.

Если файла robots.txt на сайте нет или он пустой – поисковые системы могут пытаться сканировать и индексировать весь сайт.

Основные директивы в robots.txt

Комментарии

В файле robots.txt можно оставлять комментарии – они будут игнорироваться поисковыми системами. Комментарии помогают структурировать файл, указывать какие-то важные пометки и т. п. Строка с комментарием должна начинаться с символа решетки – #.

Пример:

# Это комментарий

User-agent

Указывает для какого робота предназначены следующие за ней инструкции. Файл robots.txt может состоять из нескольких блоков инструкций, каждая из которых предназначена для определенной поисковой системы. Каждый блок начинается с директивы User-agent и состоит из следующих за ней инструкций. Каждая инструкция – с новой строки.

Каждый блок начинается с директивы User-agent и состоит из следующих за ней инструкций. Каждая инструкция – с новой строки.

Наименования роботов для User-agent можно найти, например, в справке поисковых систем. В Рунете чаще всего используются три:

- * – указывает, что следующие инструкции предназначены для всех роботов. Если робот не найдет в файле robots.txt секции конкретно для него, то будет учитывать эту секцию.

- Yandex – робот Яндекса.

- Googlebot – робот Google.

Примеры:

# Секция для всех роботов, которая разрешает индексировать весь сайт User-agent: * Disallow: # Секция для Google, которая запрещает индексировать папку /secret/ User-agent: Googlebot Disallow: /secret/

Disallow и Allow

Основные директивы, которые указывают, что можно и что нельзя индексировать:

- Disallow – запрещает индексацию

- Allow – разрешает

Поскольку, изначальная стандартная функция robots. txt это именно запрещать индексацию, то чаще используются директивы Disallow. Директива Allow появилась позднее и её могут поддерживать не все поисковые системы. Но Яндекс и Google – поддерживают.

txt это именно запрещать индексацию, то чаще используются директивы Disallow. Директива Allow появилась позднее и её могут поддерживать не все поисковые системы. Но Яндекс и Google – поддерживают.

Директива Allow применяется если вам нужно разрешить к индексированию что-то, что было запрещено директивами Disallow. Например, если какая-то папка запрещена к индексированию, но определенный файл/страницу в ней нужно разрешить.

В каждой из директив указывается префикс URL (т. е. начало адреса страницы), для которого должно применяться это правило. Также есть специальные символы:

- * – любая последовательность символов (в том числе, пустая). В конце инструкций ставить этот символ не нужно, т. к. по умолчанию директивы интерпретируются так, что как будто он там уже есть.

- $ – конец строки. Отменяет подразумеваемый символ * на конце строки.

Если в файле используются одновременно директивы Allow и Disallow, то приоритет будет иметь та, префикс URL у которой длиннее. Правила применяются по возрастанию длины префикса.

Правила применяются по возрастанию длины префикса.

Пример:

# Секция для Яндекса, которая запрещает индексировать папку /secret/ # но разрешает индексировать страницу /secret/not-really/ # при этом не разрешает индексировать всё остальное в папке /secret/not-really/ User-agent: Yandex Disallow: /secret/ Allow: /secret/not-really/$ # Секция для всех роботов, которая запрещает индексировать весь сайт User-agent: * Disallow: / # Секция для Google, которому можно индексировать только страницы с параметрами в URL User-agent: Googlebot Disallow: / Allow: /*?*=

Clean-param

Директива, которую поддерживает Яндекс. Используется для указания параметров в URL, которые следует игнорировать (т. е. считать страницы с такими параметрами одной и той же страницей).

Синтаксис:

Clean-param: param1[¶m2¶m3&..¶mN] [path]

Где param1…paramN это список параметров, разделенных символом &, а [path] это опциональный префикс URL для которого нужно применять это правило (по аналогии с Allow/Disallow).

Директив может быть несколько. Длина правила – не более 500 символов.

Пример:

# Разрешить Яндексу индексировать всё # кроме страниц с параметром session_id в папке /catalog/ User-agent: Yandex Disallow: Clean-param: session_id /catalog/

Sitemap

Указывает на расположение XML-карт сайта. Таких директив может быть несколько.

Директива Sitemap является межсекционной – не важно в каком блоке User-agent или месте файла она будет указана. Все роботы будут учитывать все директивы Sitemap в вашем файле robots.txt.

Пример:

Sitemap: https://www.site.ru/sitemap_index.xml

Host

Межсекционная директива для указания основного хоста. Раньше поддерживалась Яндексом. Теперь поддерживается только роботом поиска Mail.ru. Ее наличие в файле не является какой-то ошибкой, но и пользы от нее немного, т. к. доля органического трафика с поиска Mail.ru обычно очень низкая (порядка 1%)..png)

Пример:

Host: https://www.site.ru

Crawl-delay

Устаревшая директива, которая использовалась для указания задержки между обращениями робота к сайту. Теперь управлять нагрузкой робота на сайте можно в Яндекс Вебмастере и Google Search Console. Директиву Crawl-delay не поддерживает ни Яндекс, ни Google.

Что еще важно знать про robots.txt

- Регистр букв имеет значение. Папки /aaa/ и /AAA/ это разные папки и для них нужны разные директивы.

- Кириллица – не поддерживается. Как она не поддерживается в URL и в названиях доменов. В файле robots.txt кириллические папки/файлы и названия доменов должны быть указаны в закодированном виде.

- Google считает, что файл robots.txt управляет сканированием, а не индексацией. На практике это значит, что если какие-то страницы сайта Google уже нашел и проиндексировал (например, на них были ссылки с других сайтов), то запрет их индексации в robots.

txt не поможет исключить их из индекса. Для этого нужно применять метатег robots на самой странице. При этом, чтобы Google это тег увидел и учёл – страница не должна быть закрыта в robots.txt. Звучит это довольно абсурдно, но работает именно так, к сожалению.

txt не поможет исключить их из индекса. Для этого нужно применять метатег robots на самой странице. При этом, чтобы Google это тег увидел и учёл – страница не должна быть закрыта в robots.txt. Звучит это довольно абсурдно, но работает именно так, к сожалению. - Прежде чем залить файл на «боевой» домен – проверьте его правильность с помощью соответствующих инструментов в Яндекс Вебмастере и Google Search Console.

Подробнее о файле robots.txt в справке поисковых систем:

- https://yandex.ru/support/webmaster/controlling-robot/robots-txt.html

- https://developers.google.com/search/docs/advanced/robots/intro?hl=ru

Что такое robots.txt и зачем вообще нужен индексный файл

Файл robots.txt вместе с xml-картой несёт, пожалуй, самую важную информацию о ресурсе: он показывает роботам поисковых систем, как именно «читать» сайт, какие страницы важны, а какие следует пропустить. Еще robots.txt — первая страница, на которую стоит смотреть, если на сайт внезапно упал трафик.

Что за роботс ти экс ти?

Файл robots.txt или индексный файл — обычный текстовый документ в кодировке UTF-8, действует для протоколов http, https, а также FTP. Файл дает поисковым роботам рекомендации: какие страницы/файлы стоит сканировать. Если файл будет содержать символы не в UTF-8, а в другой кодировке, поисковые роботы могут неправильно их обработать. Правила, перечисленные в файле robots.txt, действительны только в отношении того хоста, протокола и номера порта, где размещен файл.

Файл должен располагаться в корневом каталоге в виде обычного текстового документа и быть доступен по адресу: https://site.com.ua/robots.txt.

В других файлах принято ставить отметку ВОМ (Byte Order Mark). Это Юникод-символ, который используется для определения последовательности в байтах при считывании информации. Его кодовый символ — U+FEFF. В начале файла robots.txt отметка последовательности байтов игнорируется.

Google установил ограничение по размеру файла robots. txt — он не должен весить больше 500 Кб.

txt — он не должен весить больше 500 Кб.

Ладно, если вам интересны сугубо технические подробности, файл robots.txt представляет собой описание в форме Бэкуса-Наура (BNF). При этом используются правила RFC 822.

При обработке правил в файле robots.txt поисковые роботы получают одну из трех инструкций:

- частичный доступ: доступно сканирование отдельных элементов сайта;

- полный доступ: сканировать можно все;

- полный запрет: робот ничего не может сканировать.

При сканировании файла robots.txt роботы получают такие ответы:

- 2xx — сканирование прошло удачно;

- 3xx — поисковый робот следует по переадресации до тех пор, пока не получит другой ответ. Чаще всего есть пять попыток, чтобы робот получил ответ, отличный от ответа 3xx, затем регистрируется ошибка 404;

- 4xx — поисковый робот считает, что можно сканировать все содержимое сайта;

- 5xx — оцениваются как временные ошибки сервера, сканирование полностью запрещается.

Робот будет обращаться к файлу до тех пор, пока не получит другой ответ.Поисковый робот Google может определить, корректно или некорректно настроена отдача ответов отсутствующих страниц сайта, то есть, если вместо 404 ошибки страница отдает ответ 5xx, в этом случае страница будет обрабатываться с кодом ответа 404.

Робот будет обращаться к файлу до тех пор, пока не получит другой ответ.Поисковый робот Google может определить, корректно или некорректно настроена отдача ответов отсутствующих страниц сайта, то есть, если вместо 404 ошибки страница отдает ответ 5xx, в этом случае страница будет обрабатываться с кодом ответа 404.

Пока что неизвестно, как обрабатывается файл robots.txt, который недоступен из-за проблем сервера с выходом в интернет.

Зачем нужен файл robots.txt

Например, иногда роботам не стоит посещать:

- страницы с личной информацией пользователей на сайте;

- страницы с разнообразными формами отправки информации;

- сайты-зеркала;

- страницы с результатами поиска.

Важно: даже если страница находится в файле robots.txt, существует вероятность, что она появится в выдаче, если на неё была найдена ссылка внутри сайта или где-то на внешнем ресурсе.

Так роботы поисковых систем видят сайт с файлом robots. txt и без него:

txt и без него:

Без robots.txt та информация, которая должна быть скрыта от посторонних глаз, может попасть в выдачу, а из-за этого пострадаете и вы, и сайт.

Так робот поисковых систем видит файл robots.txt:

Google обнаружил файл robots.txt на сайте и нашел правила, по которым следует сканировать страницы сайта

Как создать файл robots.txt

С помощью блокнота, Notepad, Sublime, либо любого другого текстового редактора.

В содержании файла должны быть прописаны инструкция User-agent и правило Disallow, к тому же есть еще несколько второстепенных правил.

User-agent — визитка для роботов

User-agent — правило о том, каким роботам необходимо просмотреть инструкции, описанные в файле robots.txt. На данный момент известно 302 поисковых робота. Чтобы не прописывать всех по отдельности, стоит использовать запись:

Она говорит о том, что мы указываем правила в robots.txt для всех поисковых роботов.

Для Google главным роботом является Googlebot. Если мы хотим учесть только его, запись в файле будет такой:

Если мы хотим учесть только его, запись в файле будет такой:

В этом случае все остальные роботы будут сканировать контент на основании своих директив по обработке пустого файла robots.txt.

Для Yandex главным роботом является… Yandex:

Другие специальные роботы:

- Mediapartners-Google — для сервиса AdSense;

- AdsBot-Google — для проверки качества целевой страницы;

- YandexImages — индексатор Яндекс.Картинок;

- Googlebot-Image — для картинок;

- YandexMetrika — робот Яндекс.Метрики;

- YandexMedia — робот, индексирующий мультимедийные данные;

- YaDirectFetcher — робот Яндекс.Директа;

- Googlebot-Video — для видео;

- Googlebot-Mobile — для мобильной версии;

- YandexDirectDyn — робот генерации динамических баннеров;

- YandexBlogs — робот поиск по блогам, индексирующий посты и комментарии;

- YandexMarket— робот Яндекс.Маркета;

- YandexNews — робот Яндекс.

Новостей;

Новостей; - YandexDirect — скачивает информацию о контенте сайтов-партнеров Рекламной сети, чтобы уточнить их тематику для подбора релевантной рекламы;

- YandexPagechecker — валидатор микроразметки;

- YandexCalendar — робот Яндекс.Календаря.

Disallow — расставляем «кирпичи»

Disallow дает рекомендацию, какую именно информацию не стоит сканировать.

Такая запись открывает для сканирования весь сайт:

А эта запись говорит о том, что абсолютно весь контент на сайте запрещен для сканирования:

Ее стоит использовать, если сайт находится в процессе доработок, и вы не хотите, чтобы он в нынешнем состоянии засветился в выдаче.

Важно снять это правило, как только сайт будет готов к тому, чтобы его увидели пользователи. К сожалению, об этом забывают многие вебмастера.

Пример. Как прописать правило Disallow, чтобы дать инструкции роботам не просматривать содержимое папки /papka/:

Чтобы роботы не сканировали конкретный URL:

Чтобы роботы не сканировали конкретный файл:

Чтобы роботы не сканировали все файлы определенного разрешения на сайте:

Данная строка запрещает индексировать все файлы с расширением . gif

gif

Allow — направляем роботов

Allow разрешает сканировать какой-либо файл/директиву/страницу. Допустим, необходимо, чтобы роботы могли посмотреть только страницы, которые начинались бы с /catalog, а весь остальной контент закрыть. В этом случае прописывается следующая комбинация:

Правила Allow и Disallow сортируются по длине префикса URL (от меньшего к большему) и применяются последовательно. Если для страницы подходит несколько правил, робот выбирает последнее правило в отсортированном списке.

Host — выбираем зеркало сайта

Host — одно из обязательных для robots.txt правил, оно сообщает роботу Яндекса, какое из зеркал сайта стоит учитывать для индексации.

Зеркало сайта — точная или почти точная копия сайта, доступная по разным адресам.

Робот не будет путаться при нахождении зеркал сайта и поймет, что главное зеркало указано в файле robots.txt. Адрес сайта указывается без приставки «https://», но если сайт работает на HTTPS, приставку «https://» указать нужно.

Как необходимо прописать это правило:

Пример файла robots.txt, если сайт работает на протоколе HTTPS:

Sitemap — медицинская карта сайта

Sitemap сообщает роботам, что все URL сайта, обязательные для индексации, находятся по адресу https://site.ua/sitemap.xml. При каждом обходе робот будет смотреть, какие изменения вносились в этот файл, и быстро освежать информацию о сайте в базах данных поисковой системы.

Инструкция должна быть грамотно вписана в файл:

Crawl-delay — секундомер для слабых серверов

Crawl-delay — параметр, с помощью которого можно задать период, через который будут загружаться страницы сайта. Данное правило актуально, если у вас слабый сервер. В таком случае возможны большие задержки при обращении поисковых роботов к страницам сайта. Этот параметр измеряется в секундах.

Clean-param — охотник за дублирующимся контентом

Clean-param помогает бороться с get-параметрами для избежания дублирования контента, который может быть доступен по разным динамическим адресам (со знаками вопроса). Такие адреса появляются, если на сайте есть различные сортировки, id сессии и так далее.

Такие адреса появляются, если на сайте есть различные сортировки, id сессии и так далее.

Допустим, страница доступна по адресам:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

В таком случае файл robots.txt будет выглядеть так:

Здесь ref указывает, откуда идет ссылка, поэтому она записывается в самом начале, а уже потом указывается остальная часть адреса.

Но прежде чем перейти к эталонному файлу, необходимо еще узнать о некоторых знаках, которые применяются при написании файла robots.txt.

Символы в robots.txt

Основные символы файла — «/, *, $, #».

С помощью слэша «/» мы показываем, что хотим закрыть от обнаружения роботами. Например, если стоит один слеш в правиле Disallow, мы запрещаем сканировать весь сайт. С помощью двух знаков слэш можно запретить сканирование какой-либо отдельной директории, например: /catalog/.

Такая запись говорит, что мы запрещаем сканировать все содержимое папки catalog, но если мы напишем /catalog, запретим все ссылки на сайте, которые будут начинаться на /catalog.

Звездочка «*» означает любую последовательность символов в файле. Она ставится после каждого правила.

Эта запись говорит, что все роботы не должны индексировать любые файлы с расширением .gif в папке /catalog/

Знак доллара «$» ограничивает действия знака звездочки. Если необходимо запретить все содержимое папки catalog, но при этом нельзя запретить урлы, которые содержат /catalog, запись в индексном файле будет такой:

Решетка «#» используется для комментариев, которые вебмастер оставляет для себя или других вебмастеров. Робот не будет их учитывать при сканировании сайта.

Например:

Как выглядит идеальный robots.txt

Такой файл robots.txt можно разместить почти на любом сайте:

Файл открывает содержимое сайта для индексирования, прописан хост и указана карта сайта, которая позволит поисковым системам всегда видеть адреса, которые должны быть проиндексированы. Отдельно прописаны правила для Яндекса, так как не все роботы понимают инструкцию Host.

Отдельно прописаны правила для Яндекса, так как не все роботы понимают инструкцию Host.

Но не спешите копировать содержимое файл к себе — для каждого сайта должны быть прописаны уникальные правила, которые зависит от типа сайта и CMS. поэтому тут стоит вспомнить все правила при заполнении файла robots.txt.

Как проверить файл robots.txt

Если хотите узнать, правильно ли заполнили файл robots.txt, проверьте его в инструментах вебмастеров Google и Яндекс. Просто введите исходный код файла robots.txt в форму по ссылке и укажите проверяемый сайт.

Как не нужно заполнять файл robots.txt

Часто при заполнении индексного файла допускаются досадные ошибки, причем они связаны с обычной невнимательностью или спешкой. Чуть ниже — чарт ошибок, которые я встречала на практике.

1. Перепутанные инструкции:

Правильный вариант:

2. Запись нескольких папок/директорий в одной инструкции Disallow:

Такая запись может запутать поисковых роботов, они могут не понять, что именно им не следует индексировать: то ли первую папку, то ли последнюю, — поэтому нужно писать каждое правило отдельно.

3. Сам файл должен называться только robots.txt, а не Robots.txt, ROBOTS.TXT или как-то иначе.

4. Нельзя оставлять пустым правило User-agent — нужно сказать, какой робот должен учитывать прописанные в файле правила.

5. Лишние знаки в файле (слэши, звездочки).

6. Добавление в файл страниц, которых не должно быть в индексе.

Нестандартное применение robots.txt

Кроме прямых функций индексный файл может стать площадкой для творчества и способом найти новых сотрудников.

Вот сайт, в котором robots.txt сам является маленьким сайтом с рабочими элементами и даже рекламным блоком.

Хотите что-то поинтереснее? Ловите ссылку на robots.txt со встроенной игрой и музыкальным сопровождением.

Многие бренды используют robots.txt, чтобы еще раз заявить о себе:

В качестве площадки для поиска специалистов файл используют в основном SEO-агентства. А кто же еще может узнать о его существовании? 🙂

А у Google есть специальный файл humans. txt, чтобы вы не допускали мысли о дискриминации специалистов из кожи и мяса.

txt, чтобы вы не допускали мысли о дискриминации специалистов из кожи и мяса.

Когда у вебмастера появляется достаточно свободного времени, он часто тратит его на модернизацию robots.txt:

Хотите, чтобы все страницы вашего сайта заходили в индекс быстро? Мы выберем для вас оптимальную стратегию SEO-продвижения:

Хочу быстро найти клиентов онлайн

Выводы

С помощью Robots.txt вы сможете задавать инструкции поисковым роботам, рекламировать себя, свой бренд, искать специалистов. Это большое поле для экспериментов. Главное, помните о грамотном заполнении файла и типичных ошибках.

Правила, они же директивы, они же инструкции файла robots.txt:

- User-agent — правило о том, каким роботам необходимо просмотреть инструкции, описанные в robots.txt.

- Disallow дает рекомендацию, какую именно информацию не стоит сканировать.

- Sitemap сообщает роботам, что все URL сайта, обязательные для индексации, находятся по адресу https://site.

ua/sitemap.xml.

ua/sitemap.xml. - Crawl-delay — параметр, с помощью которого можно задать период, через который будут загружаться страницы сайта.

- Host сообщает роботу Яндекса, какое из зеркал сайта стоит учитывать для индексации.

- Allow разрешает сканировать какой-либо файл/директиву/страницу.

- Clean-param помогает бороться с get-параметрами для избежания дублирования контента.

Знаки при составлении robots.txt:

- Знак доллара «$» ограничивает действия знака звездочки.

- С помощью слэша «/» мы показываем, что хотим закрыть от обнаружения роботами.

- Звездочка «*» означает любую последовательность символов в файле. Она ставится после каждого правила.

- Решетка «#» используется, чтобы обозначить комментарии, которые пишет вебмастер для себя или других вебмастеров.

Используйте индексный файл с умом — и сайт всегда будет в выдаче.

правильный пример на WordPress для Яндекса и Google

Всем привет! Сегодня я бы хотел Вам рассказать про файл robots. txt. Да, про него очень много чего написано в интернете, но, если честно, я сам очень долгое время не мог понять, как же создать правильный robots.txt. В итоге я сделал один и он стоит на всех моих блогах. Проблем с индексацией сайта я не замечаю, robots.txt работает просто великолепно.

txt. Да, про него очень много чего написано в интернете, но, если честно, я сам очень долгое время не мог понять, как же создать правильный robots.txt. В итоге я сделал один и он стоит на всех моих блогах. Проблем с индексацией сайта я не замечаю, robots.txt работает просто великолепно.

Robots.txt для WordPress

А зачем, собственно говоря, нужен robots.txt? Ответ все тот же – продвижение сайта в поисковых системах. То есть составление robots.txt – это одно из частей поисковой оптимизации сайта (кстати, очень скоро будет урок, который будет посвящен всей внутренней оптимизации сайта на WordPress. Поэтому не забудьте подписаться на RSS, чтобы не пропустить интересные материалы.).

Одна из функций данного файла – запрет индексации ненужных страниц сайта. Также в нем задается адрес карты сайта sitemap.xml и прописывается главное зеркало сайта (сайт с www или без www).

Примечание: для поисковых систем один и тот же сайт с www и без www совсем абсолютно разные сайты.

Но, поняв, что содержимое этих сайтов одинаковое, поисковики “склеивают” их. Поэтому важно прописать главное зеркало сайта в robots.txt. Чтобы узнать, какое главное (с www или без www), просто наберите адрес своего сайта в браузере, к примеру, с www, если Вас автоматически перебросит на тот же сайт без www, значит главное зеркало Вашего сайта без www. Надеюсь правильно объяснил.

Было:

Стало (после перехода на сайт, www автоматически удалились, и сайт стал без www):

Так вот, этот заветный, по-моему, правильный robots.txt для WordPress Вы можете увидеть ниже.

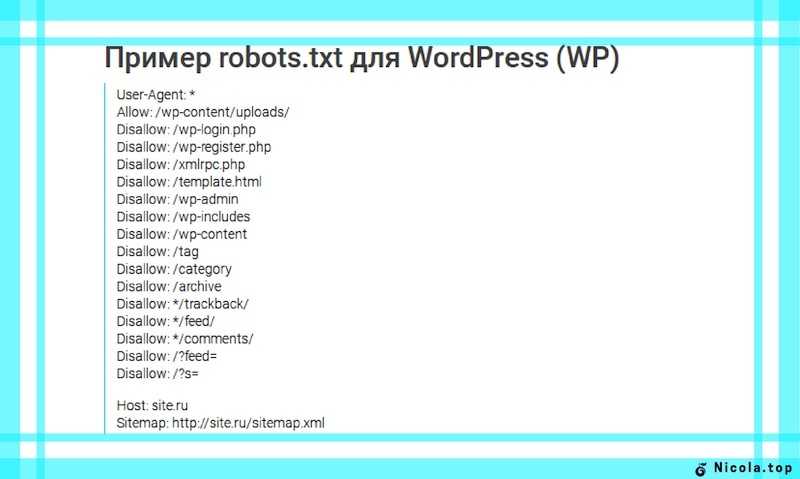

Правильный Robots.txt для WordPress

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: wpnew. ru

ru

Sitemap: https://wpnew.ru/sitemap.xml.gz

Sitemap: https://wpnew.ru/sitemap.xml

Все что дано выше, Вам нужно скопировать в текстовой документ с расширением .txt, то есть, чтобы название файла было robots.txt. Данный текстовой документ Вы можете создать, к примеру, с помощью программы Notepad++. Только, не забудьте, пожалуйста, изменить в последних трех строчках адрес wpnew.ru на адрес своего сайта. Файл robots.txt должен располагаться в корне блога, то есть в той же папке, где находятся папки wp-content, wp-admin и др. .

Те, кому же лень создавать данный текстовой файл, можете просто скачать robots.txt и также там подкорректировать 3 строчки.

Хочу отметить, что в техническими частями, о которых речь пойдет ниже, себя сильно загружать не нужно. Привожу их для “знаний”, так сказать общего кругозора, чтобы знали, что и зачем нужно.

Итак, строка:

User-agent

задает правила для какого-то поисковика: к примеру “*” (звездочкой) отмечено, что правила для всех поисковиков, а то, что ниже

User-agent: Yandex

означает, что данные правила только для Яндекса.

Disallow

Здесь же Вы “засовываете” разделы, которые НЕ нужно индексировать поисковикам. К примеру, на странице https://wpnew.ru/tag/seo у меня идет дубль статей (повторение) с обычными статьями, а дублирование страниц отрицательно сказывается на поисковом продвижении, поэтому, крайне желательно, данные секторы нужно закрыть от индексации, что мы и делаем с помощью этого правила:

Disallow: /tag

Так вот, в том robots.txt, который дан выше, от индексации закрыты почти все ненужные разделы сайта на WordPress, то есть просто оставьте все как есть.

Host

Здесь мы задаем главное зеркало сайта, о котором я рассказывал чуть выше.

Sitemap

В последних двух строчках мы задаем адрес до двух карт сайта, созданные с помощью плагина Google XML Sitemaps.

Возможные проблемы

Если у Вас на блоге не стоит ЧПУ (именно так у меня происходит с тем сайтом, которого я занимаюсь продвижением), то с тем robots.txt, который дан выше, могут быть проблемы. Напомню, что без ЧПУ ссылки на сайте на посты выглядят примерно следующим образом:

А вот из-за этой строчки в robots. txt, у меня перестали индексироваться посты сайта:

txt, у меня перестали индексироваться посты сайта:

Disallow: /*?*

Как видите, эта самая строка в robots.txt запрещает индексирование статей, что естественно нам нисколько не нужно. Чтобы исправить это, просто нужно удалить эти 2 строчки (в правилах для всех поисковиков и для Яндекса) и окончательный правильный robots.txt для WordPress сайта без ЧПУ будет выглядеть следующим образом:

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

Host: wpnew. ru

ru

Sitemap: https://wpnew.ru/sitemap.xml.gz

Sitemap: https://wpnew.ru/sitemap.xml

Анализ robots.txt

Чтобы проверить, правильно ли мы составили файл robots.txt я рекомендую Вам воспользоваться сервисом Яндекс Вебмастер (как регистрироваться в данном сервисе я рассказывал тут).

Заходим в раздел Настройки индексирования –> Анализ robots.txt:

Уже там нажимаете на кнопку “Загрузить robots.txt с сайта”, а затем нажимаете на кнопку “Проверить”:

Если Вы увидите примерно следующее сообщение, значит у Вас правильный robots.txt для Яндекса:

Также Вы можете в “Список URL” добавить адрес любой статьи сайта, чтобы проверить не запрещает ли robots.txt индексирование данной страницы:

Как видите, никакого запрета на индексирование страницы со стороны robots.txt мы не видим, значит все в порядке :).

Надеюсь больше вопросов, типа: как составить robots.txt или как сделать правильным данный файл у Вас не возникнет. В этом уроке я постарался показать Вам правильный пример robots.txt:

В этом уроке я постарался показать Вам правильный пример robots.txt:

Вы можете посмотреть другие варианты, как еще можно составлять robots.txt.

До скорой встречи!

P.s. Совсем недавно я добавил блог в Яндекс Каталог, что же интересного произошло? 🙂

Анализ robots txt yandex

Поисковые роботы — краулеры начинают знакомство с сайтом с чтения файла robots.txt. В нем содержится вся важная для них информация. Владельцы сайтов должны создавать и периодически просматривать файл robots.txt. От корректности его работы зависит скорость индексации страниц и место в результатах поиска.

Не является обязательным элементом сайта, но его наличие желательно, т.к. используется владельцами сайтов для управления поисковыми роботами. Установить разные уровни доступа к сайту, запрет на индексацию всего сайта, отдельных страниц, разделов или файлов. Для ресурсов с высокой посещаемостью ограничьте время индексации и запретите доступ роботам, не относящимся к основным поисковым системам. Это снизит нагрузку на сервер.

Это снизит нагрузку на сервер.

Создание. Создайте файл в текстовом редакторе, таком как Блокнот или аналогичный. Убедитесь, что размер файла не превышает 32 КБ. Выберите для файла кодировку ASCII или UTF-8. Обратите внимание, что файл должен быть уникальным. Если сайт создан на CMS, то он будет сгенерирован автоматически.

Поместите созданный файл в корневой каталог сайта рядом с основным файлом index.html. Для этого используйте FTP-доступ. Если сайт сделан на CMS, то файл обрабатывается через административную панель. Когда файл создан и работает правильно, он доступен в браузере.

При отсутствии файла robots.txt поисковые роботы собирают всю информацию, относящуюся к сайту. Не удивляйтесь, увидев в результатах поиска пустые страницы или служебную информацию. Определите, какие разделы сайта будут доступны пользователям, а остальные закройте от индексации.

Экспертиза. Периодически проверяйте, все ли работает правильно. Если краулер не получает ответа 200 OK, то он автоматически предполагает, что файл не существует, а сайт полностью открыт для индексации. Коды ошибок следующие:

Коды ошибок следующие:

3xx — перенаправить ответы. Робот перенаправляется на другую страницу или на главную. Создавайте до пяти редиректов на одной странице. Если их больше, робот пометит такую страницу как ошибку 404. То же самое относится и к редиректам, основанным на принципе бесконечного цикла;

4xx — ответы об ошибках сайта. Если сканер получает ошибку 400 из файла robots.txt, он делает вывод, что файл не существует и все содержимое доступно. Это также относится к ошибкам 401 и 403;

5xx — ответы об ошибках сервера. Искатель будет «стучать», пока не получит ответ, отличный от 500-го.

Правила создания

Начнем с приветствия. Каждый файл должен начинаться с приветствия агента пользователя. С его помощью поисковые системы будут определять уровень открытости.

| Код | Значение |

| Агент пользователя: * | Доступно всем |

| Агент пользователя: Яндекс | Доступен роботу Яндекса |

| Агент пользователя: Googlebot | Доступно роботу Googlebot |

Агент пользователя: Mail. ru ru | Доступен роботу Mail.ru |

Добавьте отдельные директивы для роботов. При необходимости добавьте директивы для специализированных поисковых ботов Яндекса.

Однако в этом случае директивы * и Яндекс учитываться не будут.

У Google есть свои боты:

Сначала запрещаем, потом разрешаем. Действовать двумя директивами: Allow — разрешаю, Disallow — запрещаю. Обязательно включите директиву disallow, даже если доступ разрешен ко всему сайту. Эта директива является обязательной. Если он отсутствует, сканер может неправильно прочитать остальную информацию. Если на сайте нет контента с ограниченным доступом, оставьте директиву пустой.

Работа с разными уровнями. В файле можно указать настройки на четырех уровнях: сайт, страница, папка и тип контента. Допустим, вы хотите скрыть изображения от индексации. Это можно сделать на уровне:

- папки — запретить: /images/

- тип содержимого — запретить: /*.

jpg

jpg

Группировать директивы в блоки и разделять их пустой строкой. Не записывайте все правила в одну строку. Используйте отдельное правило для каждой страницы, краулера, папки и т.д. Также не путайте инструкции: пишите бота в юзер-агенте, а не в директиве allow/disallow.

| Не | Да |

| Запретить: Яндекс | Агент пользователя: Яндекс disallow: / |

| Запретить: /css/ /images/ | Запретить: /css/ Запретить: /images/ |

С учетом регистра. Введите имя файла строчными буквами. Яндекс в пояснительной документации указывает, что регистр для его ботов не важен, но Google просит учитывать регистр. Также возможно, что имена файлов и папок чувствительны к регистру.

Укажите редирект 301 на главное зеркало сайта . Раньше для этого использовалась директива Host, но с марта 2018 года она больше не нужна. Если он уже есть в файле robots.txt, удалите его или оставьте на свое усмотрение; роботы игнорируют эту директиву.

Если он уже есть в файле robots.txt, удалите его или оставьте на свое усмотрение; роботы игнорируют эту директиву.

Чтобы указать главное зеркало, поставьте 301 редирект на каждую страницу сайта. Если редиректа нет, поисковик самостоятельно определит, какое зеркало считать основным. Чтобы исправить зеркало сайта, просто введите переадресацию 301 страницы и подождите несколько дней.

Написать директиву Sitemap (карта сайта). Файлы sitemap.xml и robots.txt дополняют друг друга. Проверить, чтобы:

- файлы не противоречили друг другу; Из обоих файлов исключена

- страница; В обоих файлах разрешена

- страница.

При анализе содержимого robots.txt обратите внимание, включена ли карта сайта в одноименную директиву. Пишется так: Карта сайта: www.yoursite.ru/sitemap.xml

Укажите комментарии с помощью символа #. Все, что пишется после этого, игнорируется сканером.

Проверка файлов

Анализ robots. txt с помощью инструментов разработчика: Яндекс.Вебмастер и Google Robots Testing Tool. Обратите внимание, что Яндекс и Google проверяют только соответствие файла их собственным требованиям. Если файл корректен для яндекса, это не значит, что он корректен для роботов гугла, так что проверяйте в обеих системах.

txt с помощью инструментов разработчика: Яндекс.Вебмастер и Google Robots Testing Tool. Обратите внимание, что Яндекс и Google проверяют только соответствие файла их собственным требованиям. Если файл корректен для яндекса, это не значит, что он корректен для роботов гугла, так что проверяйте в обеих системах.

Если вы обнаружите ошибки и исправите файл robots.txt, поисковые роботы не смогут мгновенно прочитать изменения. Обычно повторное сканирование страницы происходит раз в день, но часто занимает гораздо больше времени. Через неделю проверьте файл, чтобы убедиться, что поисковые системы используют новую версию.

Регистрация в Яндекс.Вебмастере

Сначала подтвердите права на сайт. После этого он появится в панели Вебмастера. Введите название сайта в поле и нажмите проверить. Результат проверки будет доступен ниже.

Дополнительно проверьте отдельные страницы. Для этого введите адреса страниц и нажмите «проверить».

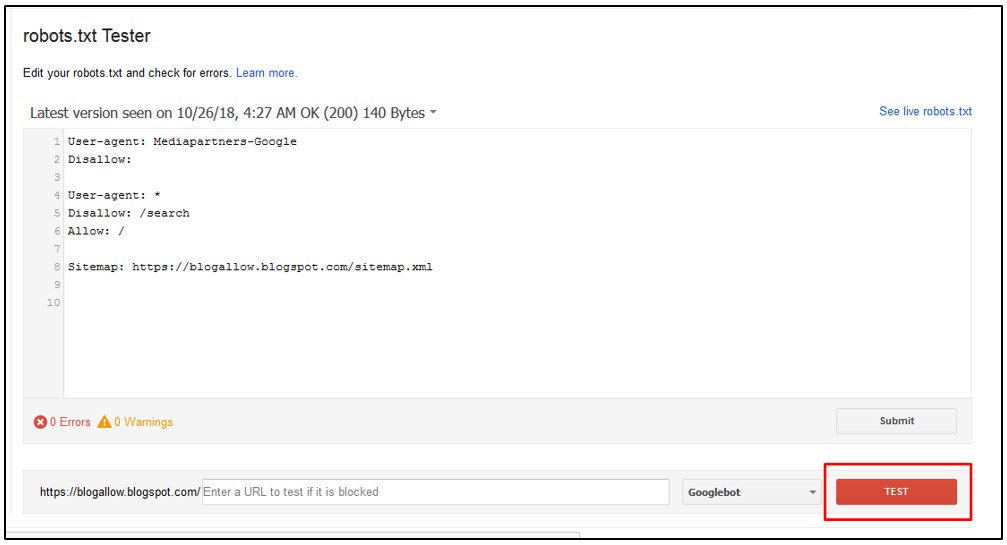

Тестирование в Google Robots Testing Tool

Позволяет проверить и отредактировать файл в административной панели. Выдает сообщение о логических и синтаксических ошибках. Исправьте текст файла прямо в редакторе Google. Но обратите внимание, что изменения не сохраняются автоматически. После исправления robots.txt скопируйте код из веб-редактора и создайте новый файл с помощью блокнота или другого текстового редактора. Затем загрузите его на сервер в корневой каталог.

Выдает сообщение о логических и синтаксических ошибках. Исправьте текст файла прямо в редакторе Google. Но обратите внимание, что изменения не сохраняются автоматически. После исправления robots.txt скопируйте код из веб-редактора и создайте новый файл с помощью блокнота или другого текстового редактора. Затем загрузите его на сервер в корневой каталог.

Запомнить

Файл robots.txt помогает поисковым роботам индексировать сайт. Закрывайте сайт на время разработки, в остальное время — весь сайт или его часть должны быть открыты. Правильно работающий файл должен возвращать ответ 200.

Файл создан в обычном текстовом редакторе. Во многих CMS в административной панели предусмотрено создание файла. Убедитесь, что размер не превышает 32 КБ. Поместите его в корневой каталог сайта.

Заполнить файл по правилам. Начните с кода «User-agent:». Пишите правила блоками, разделяя их пустой строкой. Следуйте принятому синтаксису.

Разрешить или запретить индексирование для всех или выбранных поисковых роботов. Для этого укажите название поискового робота или поставьте значок *, что означает «для всех».

Для этого укажите название поискового робота или поставьте значок *, что означает «для всех».

Работа с разными уровнями доступа: сайт, страница, папка или тип файла.

Включить в файл указание на главное зеркало с помощью постраничной переадресации 301 и карту сайта с помощью директивы sitemap.

Используйте инструменты разработчика для анализа файла robots.txt. Это Яндекс.Вебмастер и Google Robots Testing Tools. Сначала подтвердите права на сайт, потом проверяйте. В гугле сразу отредактируйте файл в веб-редакторе и уберите ошибки. Отредактированные файлы не сохраняются автоматически. Загрузите их на сервер вместо оригинального файла robots.txt. Через неделю проверьте, используют ли поисковые системы новую версию.

Материал подготовила Светлана Сирвида-Льоренте.

Каждый день в Интернете появляются решения той или иной проблемы. Нет денег на дизайнера? Используйте один из тысяч бесплатных шаблонов. Не хотите нанимать SEO-специалиста? Воспользуйтесь услугами какого-нибудь известного бесплатного сервиса, сами прочитайте пару статей.

Уже давно нет необходимости писать тот же robots.txt с нуля. Кстати, это специальный файл, который есть практически на любом сайте, и в нем содержатся инструкции для поисковых роботов. Синтаксис команды очень прост, но на создание собственного файла все равно потребуется время. Лучше посмотреть на другом сайте. Здесь есть несколько предостережений:

Сайт должен быть на том же движке, что и ваш. В принципе, сегодня в интернете очень много сервисов, где можно узнать название cms практически любого веб-ресурса.

Это должен быть более-менее успешный сайт, хорошо работающий с поисковым трафиком. Это означает, что файл robots.txt в порядке.

Итак, чтобы просмотреть этот файл, вам нужно набрать в адресной строке: domain-name.zone/robots.txt

Все невероятно просто, правда? Если адрес не найден, значит такого файла нет на сайте, либо доступ к нему закрыт. Но в большинстве случаев вы увидите перед собой содержимое файла:

В принципе, даже не особо разбирающийся в коде человек быстро поймет, что тут писать. Команда allow разрешает что-либо индексировать, а команда disallow запрещает это. User-agent — это указание поисковых роботов, которым адресованы инструкции. Это необходимо, когда вам нужно указать команды для конкретной поисковой системы.

Команда allow разрешает что-либо индексировать, а команда disallow запрещает это. User-agent — это указание поисковых роботов, которым адресованы инструкции. Это необходимо, когда вам нужно указать команды для конкретной поисковой системы.

Что делать дальше?

Скопируйте все и измените для своего сайта. Как изменить? Я уже говорил, что движки сайтов должны совпадать, иначе менять что-либо бессмысленно — нужно переписывать абсолютно все.

Итак, вам нужно будет пройтись по строкам и определить, какие из них присутствуют на вашем сайте, а какие нет. На скриншоте выше вы видите пример файла robots.txt для сайта wordpress, а в отдельной директории находится форум. Выход? Если у вас нет форума, все эти строчки надо удалить, так как таких разделов и страниц у вас просто нет, зачем тогда их закрывать?

Простейший robots.txt может выглядеть так:

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content Разрешить: /wp-content/uploads/

Агент пользователя: * Запретить: /wp-admin Запретить: /wp-includes Запретить: /wp-content Разрешить: /wp-content/uploads/ |

Все вы, наверное, знаете стандартную структуру папок в wordpress, если хоть раз устанавливали этот движок. Это папки wp-admin, wp-content и wp-includes. Обычно все 3 закрыты от индексации, т.к. содержат чисто технические файлы, необходимые для работы движка, плагинов и шаблонов.

Это папки wp-admin, wp-content и wp-includes. Обычно все 3 закрыты от индексации, т.к. содержат чисто технические файлы, необходимые для работы движка, плагинов и шаблонов.

Открыт каталог загрузки, так как он содержит изображения, и они обычно индексируются.

В общем надо пройтись по скопированному robots.txt и посмотреть, что на самом деле написано у вас на сайте, а что нет. Самому, конечно, будет сложно определить. Могу только сказать, что если что-то не удалять, то ничего страшного, просто будет лишняя строка, что не навредит (потому что раздела нет).

Действительно ли настройка robots.txt так важна?

Конечно, вы должны иметь этот файл и хотя бы закрывать через него основные каталоги. Но так ли уж важно его составить? Как показывает практика, нет. Я лично вижу сайты на одних и тех же движках с совершенно разными robots.txt, которые одинаково успешно продвигаются в поисковых системах О.

Я не спорю, что можно сделать какую-то ошибку. Например, закройте изображения или оставьте ненужную директорию открытой, но ничего сверхстрашного не произойдет. Во-первых, потому что поисковые системы сегодня умнее и могут игнорировать некоторые инструкции из файла. Во-вторых, про настройку robots.txt написаны сотни статей, и из них можно кое-что понять.

Например, закройте изображения или оставьте ненужную директорию открытой, но ничего сверхстрашного не произойдет. Во-первых, потому что поисковые системы сегодня умнее и могут игнорировать некоторые инструкции из файла. Во-вторых, про настройку robots.txt написаны сотни статей, и из них можно кое-что понять.

Я видел файлы, в которых было 6-7 строк, запрещающих индексацию пары каталогов. Еще я видел файлы с сотней-двумя строками кода, где было закрыто все, что можно было. Оба сайта работали хорошо.

В wordpress есть так называемые дубликаты. Это плохо. Многие борются с этим, закрывая такие дубликаты, как это:

Disallow: /wp-feed Disallow: */trackback Disallow: */feed Disallow: /tag/ Disallow: /archive/

Disallow: /wp-feed Здесь надо бороться иначе. Например, с помощью редиректов или плагинов, которые уничтожат дубликаты. Впрочем, это тема для отдельной статьи. Где находится robots.txt? Этот файл всегда находится в корне сайта, поэтому мы можем получить к нему доступ, введя адрес сайта и имя файла через косую черту. В общем, сегодня мы рассмотрели вопрос, как посмотреть содержимое файла robots.txt, скопировать его и изменить под свои нужды. Также в ближайшее время напишу еще 1-2 статьи по настройке, т.к. в этой статье мы не все осветили. Кстати, много информации по продвижению сайтов-блогов вы также можете найти у нас. И на этом я прощаюсь с вами. |

Правильно составленный файл robots.txt помогает корректно проиндексировать сайт и устраняет дублированный контент, обнаруженный в любой CMS. Я знаю, что многих авторов просто пугает необходимость лазить куда-то в корневые папки блога и что-то менять в «служебных» файлах. Но этот ложный страх необходимо преодолеть. Поверьте мне, ваш блог не рухнет, даже если вы поместите свой собственный портрет в robots.txt (т.е. испортите его!). Но, любые выгодные изменения повысят его статус в глазах поисковых систем.

Что такое файл robots.txt

Не буду претендовать на звание эксперта, мучая вас терминами.

Просто поделюсь своим довольно простым пониманием функций этого файла:

Просто поделюсь своим довольно простым пониманием функций этого файла:robots.txt — это инструкция, дорожная карта для поисковых роботов, посещающих наш блог с проверкой. Нам просто нужно сказать им, какой контент является, так сказать, услугой, а какой является наиболее ценным контентом, к которому читатели стремятся (или должны стремиться) нам. И именно эта часть контента должна индексироваться и попадать в результаты поиска!

А что будет, если нам наплевать на такие инструкции? Все индексируется. А так как пути алгоритмов поисковых систем практически неисповедимы, анонс статьи, открывающейся по адресу архива, может показаться более актуальным для Яндекса или Google, чем полный текст статьи, находящейся по другому адресу. И посетитель, заглянув в блог, увидит совсем не то, что он хотел и что хотелось бы вам: не поста, а списки всех статей месяца… Итог ясен — скорее всего, он оставлять.

Хотя есть примеры сайтов, которые вообще не имеют робота, но занимают приличные позиции в поисковой выдаче, но это конечно исключение, а не правило.

Из чего состоит файл robots.txt

А вот переписыванием заниматься не хочу. Есть вполне понятные пояснения из первых рук — например, в разделе помощи Яндекса. Я настоятельно рекомендую прочитать их не один раз. Но я постараюсь помочь вам преодолеть первое оцепенение перед обилием терминов, описав общую структуру файла robots.txt.

В самом верху в начале robots.txt заявляем для кого пишем инструкцию:

User agent: Яндекс

Конечно у каждого уважающего себя поисковика есть куча роботов — именных и безымянный. Пока вы не освоите мастерство robots.txt, лучше всего делать вещи простыми и обобщаемыми. Поэтому предлагаю отдать должное Яндексу, а всех остальных объединить, прописав общее правило:

User-Agent: * — это все, любые, роботы

Также указываем основное зеркало сайта — адрес, который будет участвовать в поиске. Это особенно верно, если у вас есть несколько зеркал. Вы также можете указать некоторые другие параметры. Но самое главное для нас, все-таки, это возможность закрыть служебные части блога от индексации.

Вот примеры запрета индексации:

Запретить: /cgi-bin* — файлы скриптов;

Запретить: /wp-admin* — административная консоль;

Запретить: /wp-includes* — служебные папки;

Запретить: /wp-content/plugins* — служебные папки;

Запретить: /wp-content/cache* — служебные папки;

Запретить: /wp-content/themes* — служебные папки;

Запретить: */feed

Запретить: /comments* — комментарии;

Запретить: */comments

Запретить: /*/?replytocom=* — ответы на комментарии

Запретить: /tag/* — теги

Запретить: /archive/* — архивы

Запретить: /category/* — категории

Как создать свой файл robots.txt

Самый простой и очевидный способ — найти пример готового файла robots.txt в каком-нибудь блоге и торжественно переписать его под себя. Хорошо, если при этом авторы не забудут заменить адрес блога примера на адрес своего детища.

Роботы любого сайта доступны по адресу:

https://website/robots.

txt

Я сделал то же самое и не считаю себя вправе отговаривать вас. Единственное, что я прошу, это: разберись что написано в скопированном файле robots.txt! Воспользуйтесь помощью Яндекса, любых других источников информации — расшифруйте все строки. Тогда вы наверняка увидите, что какие-то правила не подходят для вашего блога, а каких-то правил, наоборот, не хватает.

Теперь посмотрим, как проверить правильность и эффективность нашего файла robots.txt.

Поскольку все, что связано с файлом robots.txt, поначалу может показаться слишком туманным и даже опасным, хочу показать вам простой и понятный инструмент для его проверки. Это очевидный способ помочь вам не только проверить, но и подтвердить ваш robots.txt, заполнить его всеми необходимыми инструкциями и убедиться, что роботы поисковых систем понимают, что вы от них хотите.

Проверка файла robots.txt в Яндексе

Яндекс Вебмастер позволяет узнать отношение поискового робота этой системы к нашему творению. Для этого, очевидно, нужно открыть информацию, относящуюся к блогу и:

Для этого, очевидно, нужно открыть информацию, относящуюся к блогу и:

- перейти на вкладку Сервис->Анализ robots.txt

- нажать кнопку «загрузить» и будем надеяться, что вы разместили robots. txt куда нужно и робот его найдет 🙂 (если не найдет, проверьте, где находится ваш файл: он должен быть в корне блога, где папки wp -admin, wp- include и т.д., а ниже отдельные файлы — среди них должен быть robots.txt)

- нажмите «Проверить».

Но самая важная информация находится в соседней вкладке — «Используемые разделы»! Ведь на самом деле нам важно, чтобы робот понимал основную часть информации — а все остальное пропускал:

На примере мы видим, что Яндекс понимает все, что касается его робота (строки с 1 по 15 и 32) — это здорово!

Проверка файла robots.txt в Google

У Google также есть инструмент проверки, который покажет нам, как эта поисковая система видит (или не видит) наш robots.txt:

- Инструменты Google для веб-мастеров (где ваш блог также должен быть зарегистрирован) имеют собственную службу для проверки файла robots.

txt. Он находится на вкладке «Сканирование».

txt. Он находится на вкладке «Сканирование». - Найдя файл, система анализирует его и выводит информацию об ошибках. Все просто.

На что следует обратить внимание при анализе файла robots.txt

Мы не зря рассмотрели инструменты анализа от двух важнейших поисковых систем — Яндекс и Google. Ведь нам нужно сделать так, чтобы каждый из них прочитал рекомендации, данные нами в robots.txt.

В приведенных здесь примерах видно, что Яндекс понимает инструкции, которые мы оставили его роботу, и игнорирует все остальные (хотя везде написано одно и то же, только директива User-agent: другая:)))

Важно понимать, что любые изменения в robots.txt необходимо вносить непосредственно в файл, находящийся в корневой папке вашего блога. То есть вам нужно открыть его в любом блокноте, чтобы переписать, удалить, добавить любые строки. Затем нужно сохранить его обратно в корень сайта и перепроверить реакцию на изменения в поисковых системах.

Нетрудно понять, что в нем написано, что нужно добавить. А заниматься продвижением блога без правильной настройки файла robots.txt (так, как вам нужно!) — усложните себе задачу.

А заниматься продвижением блога без правильной настройки файла robots.txt (так, как вам нужно!) — усложните себе задачу.

Карта сайта значительно упрощает индексацию вашего блога. Карта сайта должна быть обязательной для каждого сайта и блога. Но также на каждом сайте и блоге должен быть файл robots. текст . Файл robots.txt содержит набор инструкций для поисковых роботов. Можно сказать — правила поведения поисковых роботов на вашем блоге. А также этот файл содержит путь к карте сайта вашего блога. И, действительно, при правильно составленном файле robots.txt поисковый робот не тратит драгоценное время на поиск карты сайта и индексацию ненужных файлов.

Что такое файл robots.txt?

robots.txt — этот текстовый файл, может быть создан в обычном «блокноте» расположенном в корне вашего блога с инструкциями для поисковых роботов.

Эти инструкции не позволяют поисковым роботам случайным образом индексировать все файлы вашего бога и нацелены на индексирование именно тех страниц, которые должны быть в поисковой выдаче.

С помощью данного файла вы можете отключить индексацию файлов движка WordPress. Или, скажем, секретный раздел вашего блога. Вы можете указать путь к карте вашего блога и главному зеркалу вашего блога. Под этим я подразумеваю ваше доменное имя с www и без www.

Индексация сайта с помощью и без robots.txt

На этом снимке экрана хорошо видно, как файл robots.txt запрещает индексацию определенных папок на сайте. Без файла роботу доступно все на вашем сайте.

Основные директивы robots.txt

Чтобы понять инструкции, содержащиеся в файле robots.txt, вам необходимо понять основные команды (директивы).

user-agent — эта команда указывает доступ роботов к вашему сайту. Используя эту директиву, вы можете создавать инструкции индивидуально для каждого робота.

User-agent: Яндекс — правила для робота Яндекса

User-agent: * — правила для всех роботов

Запретить и разрешить — директивы запрета и разрешения. С помощью директивы Disallow индексирование запрещается, а с помощью Allow разрешается.

Пример бана:

User-agent: *

Disallow: / — запрет всему сайту.

Агент пользователя: Яндекс

Запретить: /admin — запрещает роботу Яндекса доступ к страницам в папке администратора.

Пример разрешения:

User-agent: *

Разрешить: /photo

Запретить: / — запрет на весь сайт, кроме страниц, расположенных в папке фото.

Внимание! директива Disallow: без параметра разрешает все, а директива Allow: без параметра все запрещает. И директивы Allow без Disallow быть не должно.

Карта сайта — указывает путь к карте сайта в формате xml.

Карта сайта: https://site/sitemap.xml.gz

Карта сайта: https://site/sitemap.xml

Хост — директива определяет главное зеркало вашего блога. Считается, что эта директива прописана только для роботов Яндекса. Эту директиву следует разместить в самом конце файла robots.txt.

Агент пользователя: Яндекс

Запретить: /wp-includes

хост: сайт

Внимание! адрес главного зеркала указывается без указания протокола передачи гипертекста (http://).

Как создать robots.txt

Теперь, когда мы ознакомились с основными командами файла robots.txt, мы можем приступить к созданию нашего файла. Чтобы создать собственный файл robots.txt со своими настройками, вам нужно знать структуру своего блога.

Мы рассмотрим создание стандартного (универсального) файла robots.txt для блога WordPress. Вы всегда можете добавить в него свои настройки.

Итак, приступим. Нам понадобится обычный «блокнот», который есть в каждой операционной системе Windows. Или TextEdit на MacOS.

Откройте новый документ и вставьте в него следующие команды:

Агент пользователя: * Запретить: Карта сайта: https://site/sitemap.xml.gz Карта сайта: https://site/sitemap.xml Агент пользователя: Яндекс Запретить: /wp-login.php Запретить: /wp-register .php Запретить: /cgi-bin Запретить: /wp-admin Запретить: /wp-includes Запретить: /xmlrpc.php Запретить: /wp-content/plugins Запретить : /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-content/languages Disallow: /category/*/* Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow : /tag/ Disallow: /feed/ Disallow: */*/feed/ */ Disallow: */feed Disallow: */*/feed Disallow: /?feed= Disallow: /*?* Disallow: /?s= Host : сайт

Не забудьте заменить параметры директив Sitemap и Host на свои.

Важно! при написании команд допускается только один пробел. Между директивой и параметром. Ни в коем случае не делайте пробелы после параметра или где угодно.

Пример : Disallow:/feed/