Плагин wordpress robots.txt установка и настройка – info-effect.ru

Здравствуйте !

Сегодня я покажу вам и расскажу как пользоваться файлом robots.txt. Что это такое ? файл robots.txt позволит вам скрывать от индексации некоторые разделы или отдельные страницы вашего сайта, чтобы они не попадали в поиск Google и Yandex. Для чего это нужно ? поисковые системы индексируют всё содержимое вашего сайта без разбора, поэтому если вы хотите скрыть какую-либо конфиденциальную информацию,

например личные данные ваших пользователей, переписка, счета и т.д., то вам нужно будет самостоятельно добавить адреса страниц с данными в файл robots.txt. Что ещё можно сделать с помощью файла robots.txt ? если у вашего сайта есть зеркала, то в их файлах robots.txt можно указать на главный сайт, чтобы индексировался только он.

Видео о файле robots.txt

Настраивать файл robots.txt

Чтобы попасть на страницу настроек плагина, перейдите по вкладке: DL Robots.txt. Данная вкладка появится у вас в меню админ-панели wordpress, после того как вы установите и активируете плагин.

На странице настройки файла robots.txt, вы можете прочитать и посмотреть видео о том, что такое файл robots.txt. Так же здесь можно проверить файл, нажав на вкладку – Robots.txt, если файл откроется в браузере значит всё нормально.

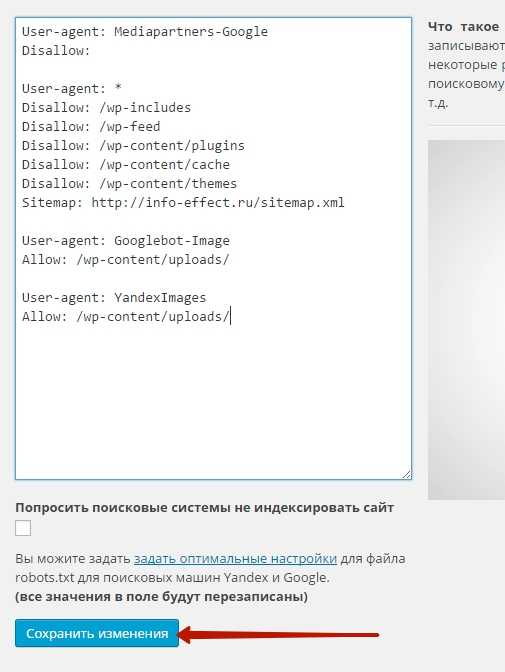

Если на вашем сайте нет файла robots.txt, значит сейчас мы добавим его в специальное окно, которое находится на странице настроек плагина. Итак, конечно же создавать файл robots.txt необходимо исходя из предпочтений каждого отдельного сайта, но я вам предложу готовый вид файла, который подойдёт любому сайту на wordpress. В случае чего вы сможете с лёгкостью добавить в файл свои дополнения.

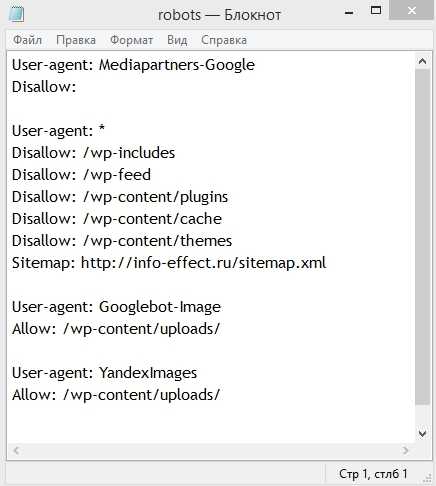

Вот как выглядит файл robots.txt для моего сайта.

Сейчас я объясню вам, что всё это значит.

В общем, если не вдаваться в подробности, то я запретил поисковикам индексировать: темы и плагины wordpress, кэш сайта, то есть дубликаты страниц, feed – это rss лента с записями. Теперь объясню зачем это делать, этим самым мы облегчаем работу поискового робота, чтобы он не индексировал лишний груз сайта, темы, плагины, кэш, фид, всё это можно не индексировать, в поиске вся эта информация просто не нужна.

Так же в файле указано – разрешить поисковикам индексировать все загруженные медиафайлы на вашем сайте. Такой файл robots.txt подойдёт любому сайту на wordpress.

Смотрите, к примеру вы хотите не индексировать ещё какую-либо отдельную страницу или запись на вашем сайте, тогда файл будет выглядеть следующим образом:

Поняли да, то есть добавляете только название страницы из её ссылки и впереди ставите флэш /, а для записи, название записи.html и впереди флэш /.

Итак, скачать готовый файл robots.txt можно – Здесь ! Только Внимание ! ! ! укажите свой адрес сайта вместо моего.

После того как вы скачаете файл, у вас будет два варианта:

- Загрузить файл в свою корневую директорию на хостинге. (в этом случае плагин можно не устанавливать)

- Скопировать содержание файла и вставить в специальное окно на странице настройки плагина DL Robots.txt

На этом у меня всё, если у вас остались вопросы по данной статье, то обязательно напишите мне в Обратную связь, либо оставьте комментарий к данной записи. Я всем отвечу ! Кстати, а вы проверяли файл robots.txt в Яндекс вебмастер ?

Удачи вам и до новых встреч !

Правильный Robots.txt для WordPress

Наверное, только ленивый не писал про то, как должен выглядеть правильный Robots.txt для Вордпресс. Я попробую объяснить, почему многие старые способы больше не работают.

Прежде напомню, на дворе 2017-й год — прогресс не стоит на месте, технологии развиваются. Кто давно в теме — знают, что поисковые системы за последнее десятилетие сильно эволюционировали. Поисковые алгоритмы стали более сложными. Сложными стали и факторы ранжирования, их количество существенно увеличилось. Естественно, всё это не могло не отразиться на методах поисковой оптимизации сайтов и отрасли в целом.

Robots.txt — это текстовый файл, находящийся в корневой директории сайта, в котором записываются специальные инструкции для поисковых роботов, разработан Мартином Костером и принят в качестве стандарта 30 июня 1994 года.

Robots.txt — мощное оружие SEO-оптимизации, грамотная настройка которого может существенно помочь в индексации.

В то же время, кривая настройка robots.txt может нанести проекту огромный вред. Рассуждать о правильности того или иного примера robots.txt можно бесконечно долго. Предлагаю остановиться на фактах.

Еще недавно Google был настолько примитивен, что видел сайты лишь в виде HTML-кода. В прошлом году, с приходом алгоритма Panda 4

Это изменение коснулось и Вордпресс.

На многих сайтах используются старые приёмы, которые блокируют индексацию системной директории /wp-includes/, в которой часто хранятся JS-библиотеки и стили, необходимые для работы сайта. А это значит, Google увидит сайт уже не таким, каким его видят посетители.

Получается, что старая практика больше не работает.

На многих Вордпресс-сайтах закрывалась от индексации и другая системная директория /wp-admin/. Что правильно, по-сути. Но если на сайте используется асинхронная загрузка страниц (AJAX), это может блокировать загрузку внутренних страниц. Потому что

Директорию /wp-admin/ можно оставить закрытой от индексации, но тогда необходимо отдельно разрешить индексацию admin-ajax.php.

Allow: /wp-admin/admin-ajax.php

Если в вашем Вордпресс используется один из старых способов оформления robots.txt, нужно обязательно проверить какие конкретно директории скрываются от индексации и удалить все запреты, блокирующие загрузку страниц.

Для проверки рекомендую использовать Google Search Console, в котором необходимо предварительно зарегистрироваться, добавить проверяемый сайт и подтвердить права на него. Это делается очень просто.

Как проверить Robots.txt

Проверить robots.txt на ошибки можно с помощью инструмента проверки файла robots.txt — именно так и называется этот инструмент в разделе «Сканирование» Google для веб-мастеров.

Кстати, проверить robots.txt на ошибки можно и в Яндекс Вебмастере. Но в Google Search Console все равно нужно зарегистрироваться, потому что только там можно проверить видимость сайта поисковыми пауками Гугла. Конкретно это делается в разделе «Сканирование» с помощью инструмента «Просмотреть как Googlebot».

Если сайт выглядит таким же как и в браузере, значит все в порядке, robots.txt ничего не блокирует. Если же имеются какие-то отличия, что-то не отображается или сайт не виден вообще, значит придется выяснить, где происходит блокировка и ликвидировать её.

Как же должен выглядеть правильный Robots.txt для Вордпресс

Я все больше убеждаюсь, что лучше делать сразу минимальный robots.txt и закрывать только /wp-admin/. Естественно, открыв admin-ajax.php, если есть AJAX-запросы. И обязательно указываем Host и Sitemap.

Мой robots.txt чаще всего выглядит так:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Host: https://danilin.biz Sitemap: https://danilin.biz/sitemap.xml

В заключение

Создать универсальный правильный robots.txt для всех сайтов на Вордпресс невозможно.

На каждом сайте работает конкретная тема, набор плагинов и типов данных (CPT), которые генерируют свой уникальный пул URL.

Robots.txt часто корректируется уже в процессе эксплуатации сайта. Для этого осуществляется постоянный мониторинг индекса сайта. И если в него попадают какие-то ненужные страницы, они исключаются. Например, в индекс иногда попадают страницы с параметрами

Их можно исключить.

Disallow: /?p= Disallow: /?s=

Иногда даже попадают фиды, которые тоже можно закрыть.

Disallow: */feed

Вообще, задачи по исключению страниц из индекса правильнее решать на уровне кода, закрывая страницы от сканирования с помощью метатега «noindex».

Для Яндекса инструкции в robots.txt и метатег «noindex» работают одинаково — страница удаляется из индекса. А вот для Гугла robots.txt — это запрет на индексирование, а метатег «noindex» — запрет на сканирование. И если, допустим, страница заблокирована в robots.txt, поисковый робот может просто не обнаружить метатег «noindex» на этой странице, и она останется в индексе. Об этом прямо написано в Справке Search Console.

Как видим, Robots.txt может быть очень опасен для сайта.

Бездумные действия с этим файлом могут привести к печальным последствиям. Не спешите с помощью него закрывать все подряд директории. Пользуйтесь плагином Yoast SEO — он позволяет настроить правильные запреты с помощью метатегов.

Подпишитесь на мой телеграм и первыми получайте новые материалы, в том числе которых нет на сайте.

danilin.biz

Где находится файл robots.txt в wordpress, где лежит и как найти

Если вы посетили эту страницу тогда вас интересует где находится файл robots.txt в WordPress. С данной проблемой обычно сталкиваются чайники в WordPress. После прочтения короткой статьи вы выясните все что вам нужно знать.

По большому счету я могу написать просто «Файл расположен в корневой директории сайта». Увы этот ответ удовлетворит лишь часть посетителей, не все знают о «корнях» и тому подобном. По этому давайте все разберем, как в первый раз.

Как проверить существует ли файл robots.txt

Сперва проверим есть ли нужный файл вообще, для этого вписываем в строке браузера адрес-сайта.ru/robots.txt, если документ откроется, и вы увидите текст на английском, примерно такого рода:

Значит все в порядке, файл существует, в противном случае, скорее всего, отсутствует, или находиться не там где нужно, его потребуется создать.

Давайте для начала определимся как вам удобно работать с файлами сайта. Для этого существует несколько способов. Первый не очень удобный, но зато более привычен для любителей Windows — это программа на вашем хостинге, с помощью которой вы создаете и удаляете файлы и папки своего сайта. Выглядеть это все дело должно примерно так:

В папке WWW/ВАШ-САЙТ должны быть папки wp-includes, wp-content, wp-admin ниже них расположен нужный вам файл роботс. Один способ разобрали, можно идти к следующему.

Если вы умеете пользоваться FTP, тогда заходим в соответствующую программу на вашем компьютере и переходим на ваш сайт, проходим тот же путь по папкам что в примере выше и находим необходимый документ.

Файл robots.txt в WordPress должен лежать именно в той же папке, что и wp-includes, wp-content, wp-admin. Не ищите его в других местах, его либо там нет либо он там валяется без толку, роботы его не найдут.

Создать правильное руководство для поисковых систем поможет эта статья.

yrokiwp.ru

Virtual Robots.txt — Плагин для WordPress

Virtual Robots.txt is an easy (i.e. automated) solution to creating and managing a robots.txt file for your site. Instead of mucking about with FTP, files, permissions ..etc, just upload and activate the plugin and you’re done.

By default, the Virtual Robots.txt plugin allows access to the parts of WordPress that good bots like Google need to access. Other parts are blocked.

If the plugin detects an existing XML sitemap file, a reference to it will be automatically added to your robots.txt file.

- Upload pc-robotstxt folder to the

/wp-content/plugins/directory - Активируйте плагин используя меню ‘Плагины’ в WordPress.

- Once you have the plugin installed and activated, you’ll see a new Robots.txt menu link under the Settings menu. Click that menu link to see the plugin settings page. From there you can edit the contents of your robots.txt file.

- Will it conflict with an existing robots.txt file?

If a physical robots.txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.

- Will this work for sub-folder installations of WordPress?

Out of the box, no. Because WordPress is in a sub-folder, it won’t «know» when someone is requesting the robots.txt file which must be at the root of the site.

- Does this plugin modify individual posts, pages, or categories?

No it doesn’t.

- Why does the default plugin block certain files and folders?

By default, the virtual robots.txt is set to block WordPress files and folders that don’t need to be accessed by search engines. Of course, if you disagree with the defaults, you can easily change them.

Works great and easy to use and customise. It already set by default the directories that need to be left out of Search Engines scanning/indexing… Very happy with it!

What I saw wasn’t what I got. The XML sitemap wasn’t included in the robots.txt file, even thought this was described as a feature that should work out of the box. In addition to that, upon installing this plugin, it blocked certain directories without asking. Lastly, it inserts a line at the top of the file, promoting the plugin. That should be an optional feature that users are empowered to turn off. All in all, it offers the functionality, but falls short and disappoints in other areas.

I thought this would be simple. Sure sounds simple. But after I saved your suggested text to my brand new «virtual robots.txt», I clicked the link where it says «You can preview your robots.txt file here (opens a new window). If your robots.txt file doesn’t match what is shown below, you may have a physical file that is being displayed instead.» That new window shows text that is indeed different from the plugin’s. So I understand that to mean there’s a physical robots.txt file on my server. So which one is actually going to be used? Your FAQ offers this: Q: Will it conflict with any existing robots.txt file? A: If a physical robots.txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict. If a physical file exists, WP won’t process ANY request for one? This SOUNDS like WP will ignore BOTH the physical file AND your virtual one. In which case, what’s the point? Might as well not have one, it seems to me. When I manually go to mydomain.com/robots.txt, I see what’s in the physical file, not what the plugin saved. So… is it working? I don’t know! Should I delete the physical file and assume the virtual one will work? I don’t know! Should I delete this plugin and edit the physical file manually? Most likely. 2 stars instead of 1 because I appreciate getting the suggested lines to include in my file.

I like the fact that it’s so clean. Thanks for building it!

Awesome, a simple solution to a common issue (site content managers who want to hide certain pages from Google search results). Just a little note: in my case, the existing Sitemap created by the plugin «Google (XML) Sitemaps Generator» by Arne Brachhold wasn’t detected.

Посмотреть все 8 отзывов«Virtual Robots.txt» — проект с открытым исходным кодом. В развитие плагина внесли свой вклад следующие участники:

Участники1.9

- Fix for PHP 7. Thanks to SharmPRO.

1.8

- Undoing last fixes as they had unintended side-effects.

1.7

- Further fixes to issue with newlines being removed. Thanks to FAMC for reporting and for providing the code fix.

- After upgrading, visit and re-save your settings and confirm they look correct.

1.6

- Fixed bug where newlines were being removed. Thanks to FAMC for reporting.

1.5

- Fixed bug where plugin assumed robots.txt would be at http when it may reside at https. Thanks to jeffmcneill for reporting.

1.4

- Fixed bug for link to robots.txt that didn’t adjust for sub-folder installations of WordPress.

- Updated default robots.txt directives to match latest practices for WordPress.

- Plugin development and support transferred to Marios Alexandrou.

1.3

- Now uses do_robots hook and checks for is_robots() in plugin action.

1.2

- Added support for existing sitemap.xml.gz file.

1.1

- Added link to settings page, option to delete settings.

1.0

- Первая версия.

ru.wordpress.org

Multisite Robots.txt Manager — Плагин для WordPress

A Robots.txt Manager Plugin for WordPress Multisite Networks. Quickly and easily manage all robots.txt files on a WordPress Multisite Website Network.

!!! Network Enabled Multisite Installs Only !!!

This Plugin Was Created For Multisite Networks > Network Activations Only!

For Support & Bugs

Please contact us directly if you need assistance or have found a bug. The WordPress Support forum does not notify us of new support tickets, no idea why, so contact us directly.

View, Report Bugs, Contribute!

Visit this Plugin on Github! Clone/fork yourself a copy, report a bug or submit a ticket & pull request!

Features:

- Network wide robots.txt file, shared across all sites.

- Append extra robots.txt file data per-website Admin.

- Create unique robots.txt files for each network Website.

- Manage all Websites from Network Administration Area.

- Manage a single Website through the Website Settings Admins.

- Auto-generated Sitemap URL’s, Upload Path & Theme Path.

- Mass update the all Websites on the Network in a single click.

- Quickly publish preset robots.txt files across the Network.

- Scan and clean old robots.txt file plugin data to clear out conflicts.

Quick Info:

- The default «Network Wide» robots.txt file is NOT a live robots.txt file.

- If you deactivate the plugin, no options are removed but the plugins robots.txt file(s) are no longer displayed.

If you delete this plugin, all options and settings will be removed from the database, for all Websites.

Get The Plugin: Download > Install > Network Activate

- Network Access: Network Admin > Settings Tab > MS Robots.txt Link

- Website Access: Website Admin > Settings Tab > MS Robots.txt Link

Make It Work:

- Network Admin: Select either either with «Publish the network robots.txt file to all network websites» or «Publish the network robots.txt file to network websites you are a member of» then click the «update settings» button to publish the robots.txt files.

- Website Admin: Modify the appended robots.txt file (or create a website unique robots.txt file) then click the «update website rules» button to publish your changes.

Arbitrary section

Understanding the Default Settings

When you first enter the plugin admin via the Network Admin, the displayed robots.txt file is the default «network only» copy.

The Network Append Marker

The marker {APPEND_WEBSITE_ROBOTSTXT} within the Network Robots.txt File is replaced by Website unique robots.txt file append rules. Use the marker in your customized Network robots.txt files to automatically append the Website robots.txt file rules when the Network is updated.

Robots.txt Files within Directories

This plugin WILL render robots.txt files within directories — however,

Search Engine Spiders only read robots.txt files found within the root directory of a Website. Spiders do not read robots.txt files within directories, such as: domain.com/PATH-or-FOLDER/robots.txt is NOT a valid location.

From Google: «The robots.txt file must be in the top-level directory of the host…..Crawlers will not check for robots.txt files in sub-directories.»

Testing Robots.txt Files

- Use Google’s Webmaster Tools to Validate your Robots.txt Files…. with Google at least.:

Log into your Google Account and access the Log into your Webmaster Tools feature. Select a Website or Add a Website….

On the Webmaster Tools Home page, click the site you want.

- Under Health, click Blocked URLs.

- If it is not already selected, click the Test robots.txt tab.

- Copy the content of your robots.txt file, and paste it into the first box.

- In the URLs box, list the site to test against.

- In the User-agents list, select the user-agents you want.

- https://developers.google.com/webmasters/control-crawl-index/docs/robots_txt

New Website Added to Network

- If all Websites use the saved Network default robots.txt file, click the «update setting» button to copy the default robots.txt file over to any new Websites you have.

- Per Site: Then click the «update website rules» button to copy the default robots.txt file to this Website.

Disabling

- Disable a Website: Within the website plugin admin, for each unique website, scroll down and click the «Disable the saved robots.txt file…» checkbox then click the submit button. This will disable the robots.txt file the Website only, making the WordPress default robots.txt file display.

- Disable Across Network: Within the network plugin admin, scroll down and click the «Disable saved robots.txt files…» checkbox, then click the submit button.

= Presets

- This feature allows you to quickly duplicate premade robots.txt files and a sitemap structure url to the default network robots.txt file. This action does not publish the robots.txt files to the network.

Recommended Sitemap Plugins

- Google XML Sitemaps: https://wordpress.org/extend/plugins/google-sitemap-generator/

- Better WordPress Google XML Sitemaps: https://wordpress.org/extend/plugins/bwp-google-xml-sitemaps/

- Search For Others: https://wordpress.org/extend/plugins/search.php?q=multisite+sitemap

For «real» Multisite HOST Networks, use the WordPress plugin: BWP Google XML Sitemaps — This plugin will list each Websites Sitemap URL’s in the Root Network Website’s robots.txt file.

Network Admin — All Features Shown

Network Admin — Preset Robots.txt File Loaded & Published

Network Admin — Cleaner Tab

Website Admin — All Features Shown

Website Admin — Robots.txt File Using Append Rules

Website Admin — Custom Robots.txt File In Use

Install through the WordPress Admin

- It is recommended that you use the built in WordPress installer to install plugins.

- Multisite Networks: Network Admin > Plugins Menu > Add New Button

- In the Search box, enter: robots.txt

- Find the Plugin «Multisite Robots.txt Manager»

- Click Install Now and proceed through the plugin setup process.

- Activate / Network Activate the plugin when asked.

- If you have returned to the Plugin Admin, locate the «Multisite Robots.txt Manager» Plugin and click the Activate link.

Upload and Install

- If uploading, upload the /multisite-robotstxt-manager/ folder to /wp-content/plugins/ directory for your Worpdress install.

- Then open the WordPress Network Admin:

- Multisite Networks: Network Admin > Plugins Menu

- Locate the «Multisite Robots.txt Manager» Plugin in your listing of plugins. (sort by Inactive)

- Click the Activate link to start the plugin.

- Q) Can the plugin update all Websites at once?

A) Yes.

- Q) Does this plugin work on Non-Multisite Installs?

A) No, your install MUST be Multisite/Network enabled.

- Q) Does this plugin work on WordPress.COM (free hosted) Websites?

A) No.

- Q) Can I activate this plugin within a Websites wp-admin?

A) No, only within the Network Admin.

- Q) Do I have to access each Website to manage the robots.txt file?

A) No, the Main Admin Area for the MS Robots.txt Manager is located within the Network Admin.

- Q) Can I add my own robots.txt file?

A) Yes.

- Q) Can every Website have a different robots.txt file?

A) Yes.

Typically, each Website uses the Network robots.txt file as the ‘base’ robots.txt file. Websites can then inject unique robots.txt file rules into the Network robots.txt file.

However, within the Admin Area for each website, scroll down and click the «Disable the network robots.txt file…» checkbox. Allowing you to fully customize the robots.txt file.

You can also: Disable the «network robots.txt file,» allowing you to manually add your own robots.txt file to each Network Website.

You can also: Save/publish a blank robots.txt file from the network admin.- Q) Does this plugin add Sitemap links to the robots.txt file?

A) Yes.

- Q) Can I add multiple or custom sitemap urls?

A) Yes.

- Q) Does this plugin add the Sitemap URL to the robots.txt file?

A) Yes & No.

No, the Free Plugin only generates the Sitemap URL, you must manually add to the robots.txt file.

Yes, the Pro Plugin automatically adds the Sitemap URL to robots.txt files for you.

- Q) Does this plugin add the Theme Path to the robots.txt file?

A) Yes & No.

No, the Free Plugin only generates the Theme Path, you must manually add to the robots.txt file.

Yes, the Pro Plugin automatically adds the Theme Path to robots.txt files for you.

- Q) Does this plugin add the Upload Path to the robots.txt file?

A) Yes & No.

No, the Free Plugin only generates the Upload Path, you must manually add to the robots.txt file.

Yes, the Pro Plugin automatically adds the Upload Path to robots.txt files for you.

- Q) Does the robots.txt file render for non-root domains / Websites with a path?

A) Yes, however…. Search Engine Spiders do not read robots.txt files within a directory, robots.txt files for non-mapped domains are for for error checking purposes only.

- Q) I run a real Multisite Network, all Sites are in a Path, don’t they need a robots.txt file?

A) From what I understand, no…. The root / network Website will contain the only robots.txt file.

- Q) My robots.txt files are 404 — file not found, what’s wrong?

A) The issue is due to an option called «rewrite rules» missing the robots.txt entry.

Visit the Network Admin for the plugin, then click the Cleaner tab. If the Rewrite Rule an error message and a unique button will appear allowing you scan and update the rule for all Websites.

- Q) The incorrect robots.txt file is displaying, what’s wrong?

A) Typically this issue is due to either an a different robots.txt file plugin is active or that plugins robots.txt file data was never deleted when the plugin was removed.

Visit the Network Admin for the plugin, then click the Cleaner tab. Click the «scan for old data» button to check for left over plugin data by other robots.txt file plugins.

- Q) Can I use other robots.txt file plugins with the MS Robots.txt Manager Plugin?

A) No, multiple plugins will cause display issues with the robots.txt files.

- Q) Can I use other Sitemap Plugins to add more Sitemap URL’s to the robots.txt files?

A) Yes, however they typically only work for the default WordPress robots.txt file.

- Q) Does the plugin remove the settings when it is disabled or deleted?

A) No! However you can disable the plugin and delete settings within the plugin admin area.

Great multisite plugin for robots.txt

This plugin is two versions and two months out-of-date. A more recent stable version, 1.0.14, released and tested for WordPress version 4.8.3, is available on GitHub. Curiously, the documentation on GitHub for this plugin even recommends installing the plugin thru WordPress.org.

Cool, but I want to add Host directive for ever site of multisite system.

Посмотреть все 13 отзывов«Multisite Robots.txt Manager» — проект с открытым исходным кодом. В развитие плагина внесли свой вклад следующие участники:

Участники2.1.0

- Released: 2019-10-06

- Changelog: https://github.com/ChrisWinters/multisite-robotstxt-manager/blob/master/CHANGELOG.md#210

ru.wordpress.org