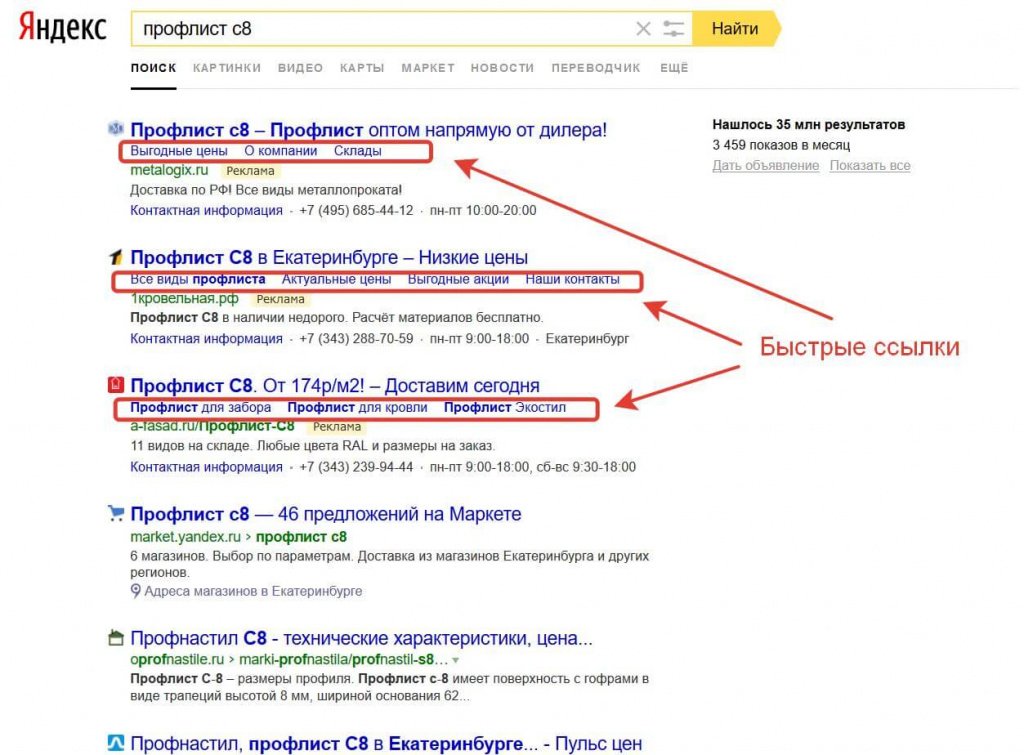

10 основных причин, по которым страница сайта может не находиться в индексе поисковых систем Яндекс или Google

Причина номер 1. Новая страница или новый сайт

Первая причина, это то, что поисковые роботы еще просто не нашли новую страницу вашего сайта. В зависимости от того, какой ваш сайт, переобход страниц может занимать от нескольких минут до нескольких недель.

Чтобы узнать, находится ли в индексе страница Вам необходимо воспользоваться сервисами вебмастера Яндекс или Google Search Console.

В Яндекс.Вебмастере это раздел «Индексирование» — «Проверить статус URL». Если робот обошел и проиндексировал страницу, вы увидите уведомление «Страница обходится роботом и находится в поиске».

Если робот о странице еще не знает, вы увидите сообщение «Страница неизвестна роботу».

В новой версии Google Search Console вам нужен инструмент «Проверка URL». Если робот обошел и проиндексировал страницу, вы увидите уведомление «URL есть в индексе Google».

Если робот на странице еще не был, вы увидите сообщение «URL нет в индексе Google».

Причина номер 2. Страница или сайт закрыты от индексации в файле robots.txt

Существует специальный файл robots.txt, который позволяет указать роботам на то, какие страницы сайта должны быть в индексе поисковых систем, а какие страницы не должны быть включены.

Соответственно, если в файле прописаны запрещающие правила, в индексе поисковых систем данную страницу вы не найдете.

Как проверить, закрыта ли страница в robots. txt?

txt?

В Яндекс.Вебмастере: заходим в «Инструменты — Анализ файла robots.txt». В окно «Разрешены ли URL» вносим адреса страниц, которые мы хотим проверить. После того, как мы нажмем на кнопку «Проверить», внизу появится список введенных адресов и их статус: разрешены они для индексации или нет. Если нет, будет указано, какое из правил запрещает обход для робота.

В Google похожий инструмент находится на вкладке «Сканирование — Инструмент проверки файла robots.txt».

Важно! На данный момент эта вкладка находится в старой версии вебмастера!

Причина номер 3. Указан запрет в User-Agent

Указан запрет в User-Agent

У поисковых систем есть свои требования к тому, как должен строиться файл robots.txt. И начинается он с приветствия. Приветствие может быть обращено к роботу яндекс, либо гугл, либо к обеим поисковым системам.

Часто для Яндекс и Google делают отдельные секции в файле robots.txt. А потом забывают вносить правки в эти секции. Из-за этого роботы потом некорректно начинают индексировать сайт.

Проверяем наличие проблемы также, как и в предыдущем случае. Главное — это делать в вебмастере Яндекс, и в вебмастере Google.

Причина номер 4. Запрет на индексацию страниц указан в мета-теге robots.

Суть этого мета-тега такая же, как и у файла robots.txt, только если страница закрыта в robots.txt она все равно может быть проиндексирована поисковыми системами. Но если на странице используется noindex или none, страница не будет добавлена в индекс.

1. Проверить использование данного мета-тега на странице можно в коде (сочетание клавиш Ctrl+U)

2. С помощью дополнения для браузера, например seo meta

3. С помощью вебмастеров.

Причина номер 5. Некорректно настроенный атрибут rel=canonical.

Каноникал — это еще один атрибут, помогающий управлять индексацией страниц.

Если rel каноникал настроен на другую страницу, то вы говорите поисковому роботу о том, что она схожа с другой станицей и первую страницу не нужно добавлять в индекс поисковых систем.

Проверить использование данного атрибута можно также в исходном коде, с помощью дополнения для браузера — rds бар или seo meta.

Также это можно увидеть в вебмастере Яндекс («Страницы в поиске»- «Исключенные страницы». Проверять необходимо статус «неканонические»).

Причина номер 6. Проблемы с ответом сервера

Для того, чтобы страница индексировалась, ее код ответа сервера должен быть 200 ОК. Если страница отдает ответ сервера 404 или 301, в индекс поисковых систем данная страница не попадет.

Проверять код ответа лучше всего с помощью вебмастеров, они показывают наиболее точные данные. А вот визуальной проверкой лучше не ограничиваться, так как бывают случаи, когда страницы выглядят корректно, но код ответа сервера не 200.

А вот визуальной проверкой лучше не ограничиваться, так как бывают случаи, когда страницы выглядят корректно, но код ответа сервера не 200.

Причина номер 7. Проблемы с хостингом или сервером

Представьте, вы приходите в магазин, а он не работает. Потом снова приходите в магазин, но он все равно не работает. Какова вероятность того, что вы вернетесь туда? Вероятнее всего очень маленькая.

Тоже самое происходит и с поисковыми системами. Если он приходит на ваш сайт, а он не работает, то робот просто исключает страницы из индекса и не показывает их пользователям.

Правильно, зачем пользователей приводить на неработающий сайт.

Для того, чтобы отследить есть ли проблема, необходимо в вебмастерах проверять статус страниц. Если встречаются ошибки сервера 5хх (500, 503), а также если вам приходят уведомления из Яндекс.Метрики о том, что сайт не работает, необходимо решать данную проблему.

Если встречаются ошибки сервера 5хх (500, 503), а также если вам приходят уведомления из Яндекс.Метрики о том, что сайт не работает, необходимо решать данную проблему.

Причина номер 8. Проблемы со скоростью загрузки страниц

Скорость загрузки — важный показатель качества современного сайта. Если ваши страницы долго долго загружаются, роботы поисковых систем исключать такие страницы из индекса.

Кроме того, скорость загрузки страниц — является фактором ранжирования в поисковых системах. Поэтому, если у вас с этим есть проблемы, срочно это исправляйте!

Как проверить? Начните с инструмента PageSpeed Insights от Google. Дополнительно можете использовать сервисы Google Аналитика и Яндекс.Метрика.

Совет! Важно проверять скорость загрузки для нескольких типов страниц и не останавливаться выполнив только одну проверку, т.е. выполнять данные работы периодически.

Причина номер 9. Проблема с уникальностью и полезностью контента

Поисковики уделяют большое внимание качеству контента, поэтому, если на странице расположен не полезный контент, либо же дублирующийся с другими страницами, такие страницы не добавляются в индекс поисковых систем.

Как проверить, есть ли на сайте такие страницы — нужно зайти в вебмастер.

В Яндексе — это отчет «Страницы в поиске» — «Исключенные страницы». Проверять нужно статусы «Дубль» и «Недостаточно качественная».

В Google Search Console — это отчет «Покрытие» — «Страница является копией. Канонический вариант не выбран пользователем».

Канонический вариант не выбран пользователем».

Причина номер 10. Проблемы с AJAX

Если ваш сайт выполнен на технологии AJAX очень важно правильно выполнить требования поисковых систем, для того чтобы поисковые роботы смогли проиндексировать страницы вашего сайта.

Таким образом для каждой отдельной страницы должна быть своя HTML-версия.

И напоследок, дадим вам несколько советов, как ускорить индексацию:

- отправляйте страницы на переобход с помощью вебмастеров

- используйте файл sitemap.xml

- используйте новейшие возможности, которые предоставляют вам поисковики. Например, Яндекс Метрике появилась возможность связать Яндекс Вебмастер и Яндекс Метрику, для того чтобы отправлять страницы на переиндексацию.

Также смотрите наш видеоролик https://youtu.be/HF-2dd4luQY с помощью которого вы сможете найти ошибки у себя на сайте и запланировать работы по их исправлению.

Если вы хотите продвинуть свой сайт в ТОП поисковой выдачи, тогда записывайтесь на курс по SEO-продвижению

|

|

Статью подготовила

Полина Зарубицкая, ведущий спикер Webcom Academy. |

Поделиться с друзьями:

Как ускорить индексацию сайта в Яндексе: инструкция

Последнее обновление: 01 марта 2023 года

12598

Время прочтения: 9 минут

Тэги: SEO

О чем статья?

- Как часто Яндекс робот заходит на сайт?

- В чем заключаются основные проблемы с индексацией в Яндексе

- Как решить проблемы с индексацией сайта

- Как ускорить индексацию страниц

- Выводы

Для кого эта статья?

- Для маркетологов;

- Для SEO-специалистов;

-

Для владельцев бизнеса.

Индексация сайта простыми словами – это обход страниц сайта краулером, он же спайдер или поисковый робот. Он оценивает их качество и, если оно соответствует требованиям поисковика, отправляет адрес в базу данных. Когда пользователь вводит релевантный запрос в строку поиска, URL может быть извлечен из базы, проранжирован и показан в поисковой выдаче. Таким образом, индексация – основа для поискового продвижения страниц и сайтов в топ выдачи. Ниже проанализировали, как часто поисковый робот индексирует сайт, что мешает страницам попадать в индекс и как с ними работать, чтобы это исправить.

Как часто Яндекс робот заходит на сайт?

Своевременная индексация важна для разных ниш бизнеса: например, чем раньше страница окажется в поисковой выдаче e-commerce сайтов, тем скорее на нее могут прийти покупатели. В случае с инфопроектами задержка индексации может привести к тому, что контент на странице устареет либо будет уже опубликован конкурентами.

Практика показывает, что на частоту индексации сайта влияют следующие факторы:

-

Техническое состояние сайта. Чем лучше будет настроена индексация ресурса, тем большее количество страниц сможет обойти поисковый робот.

-

Насколько часто вы обновляете контент. Чем реже появляются новые публикации, тем реже краулеры будут заходить на сайт. Если обновления происходят чаще, бот будет заходить чаще.

Даты первого или последующего визита робота заранее никем не уточняется. Зато пользователям доступна статистика и история обходов. Проверить, когда и как часто робот делал обход страниц на вашем сайте, можно в Яндекс Вебмастере. В разделе «Индексирование» кликните на отчет «Статистика обхода». При необходимости переключите график на режим «История обхода».

Отчет «История обхода» отображает даты, страницы обхода и код ответа

Обратите внимание: у краулера есть лимиты. За один раз он обходит ограниченное количество страниц – это так называемый краулинговый бюджет сайта. Он формируется индивидуально для ресурса, но точные цифры бюджета неизвестны. Как правило, у небольших сайтов краулинговый бюджет включает в себя до 10 или 50 тысяч страниц – тут мнения оптимизаторов разнятся. Данного лимита достаточно, чтобы индексировать все новые страницы. А вот на больших ресурсах возникают проблемы: им необходимо самостоятельно указывать роботу на приоритетные для индексации адреса и закрывать малозначимые, чтобы не тратить краулинговый бюджет.

За один раз он обходит ограниченное количество страниц – это так называемый краулинговый бюджет сайта. Он формируется индивидуально для ресурса, но точные цифры бюджета неизвестны. Как правило, у небольших сайтов краулинговый бюджет включает в себя до 10 или 50 тысяч страниц – тут мнения оптимизаторов разнятся. Данного лимита достаточно, чтобы индексировать все новые страницы. А вот на больших ресурсах возникают проблемы: им необходимо самостоятельно указывать роботу на приоритетные для индексации адреса и закрывать малозначимые, чтобы не тратить краулинговый бюджет.

В чем заключаются основные проблемы с индексацией в Яндексе

Практика показывает, что основных проблем при индексации три.

-

Нужные страницы не попадают в индекс. Это происходит, например, если их индексация запрещена в HTML-коде, файле Robots.txt или HTTP-заголовком X-Robots-Tag для данной страницы на сервере. Как это проверить – объясняем ниже.

-

В индекс попадает большое количестве технических и малозначимых страниц, например, страниц поиска по сайту, страниц с get-параметрами и подобных.

-

Индексация сайта происходит, но очень долго. Возможно, вы крайне редко обновляете контент, у ресурса мало посетителей, поэтому бот месяцами не заглядывает на домен. Часто оказывается, что на ресурсе много ошибок, некачественный контент, поэтому он не попадает в базу данных.

Мнение эксперта

Анастасия Курдюкова, руководитель группы оптимизаторов «Ашманов и партнеры»:

«Чаще всего причина в наличии большого количества технических ошибок – например, 301 редиректов, дублей страниц, страниц с различными параметрами в url. Тратя ресурсы на индексацию малокачественных страниц, роботы не доходят до нужных».

Исправить ошибки в индексации сайта можно в рамках работ по SEO-продвижению. Учитывайте, что эти работы могут затронуть и контент, и структуру сайта, и бизнес-процессы компании. Если вы хотите понять как происходит индексация сайта в Google, аналогичный аудит следует провести в Google Search Console.

Как решить проблемы с индексацией сайта

Перечислим примеры конкретных работ, которые следует проводить в рамках SEO-продвижения сайта, чтобы страницы сайта индексировались и попадали в поиск быстрее.

Для начала рекомендуем провести аудит, который выявит технические и прочие ошибки, мешающие быстрой индексации сайта поисковиками. По его итогам вы получите рекомендации о том, что исправить и внедрить на сайте, как повысить его качество и успешно пройти индексацию. Ниже приводим примеры рекомендаций из наших аудитов

-

Проверьте файл Robots.txt и Sitemap.xml

-

Исправьте ошибки в ответах сервера

-

Проработайте внутренние ссылки

-

Проверьте глубину вложенности

-

Повышайте качество контента

-

Устраните дубли

1.

Проверьте файлы и директивы, которые указывают краулеру на приоритетные страницы

Проверьте файлы и директивы, которые указывают краулеру на приоритетные страницыЕсли он есть, проверьте на ошибки и запреты индексации в Вебмастере в разделе «Инструменты» –> «Анализ robots.txt».

Мнение эксперта

Анастасия Курдюкова, руководитель группы оптимизаторов «Ашманов и партнеры»:

«Запрет в Robots.txt можно проверить в Вебмастере с помощью инструмента «Анализ robots.txt». Вы можете указать любой URL и посмотреть, разрешена ли индексация страницы, и если нет, то какое правило мешает».

На скриншоте ниже показали, как выглядят результаты анализа. В пункте «Используемые секции» странице присвоена директива Disallow, то есть индексация запрещена. Соответственно, ниже в списке «Разрешены ли URL?» ее нет.

Инструмент показывает строки Robots.txt, которые относятся к введенному URL

Если перейти на список ошибок, вы увидите их перечень и сможете просмотреть подробнее проблемные строки, как показано на следующем скриншоте.

Показаны все строки, где есть ошибки, и указан тип ошибки

-

Создайте или проверьте файл Sitemap.xml. Для робота это дорожная карта, которая показывает, где что на сайте находится, какие страницы надо индексировать в первую очередь. С помощью такой карты сайта вы можете сообщать краулеру о новых страницах, попадание которых в поиск для вас приоритетно. Чтобы не делать это вручную каждый раз, настройте плагин для автоматической генерации динамического Sitemap.xml. В этом случае файл будет регулярно обновляться с заданной периодичностью (например, 1 раз в сутки). Не забудьте в Robots.txt внести путь к Sitemap.xml. Проверить корректность карты можно опять-таки в Яндекс Вебмастере при помощи инструмента «Анализ файлов Sitemap».

-

Если не индексируется конкретная страница, проверьте наличие HTTP-заголовка X-Robots-Tag для данной страницы на сервере. Узнать о нем можно опять-таки в Вебмастере с помощью инструмента «Проверка ответа сервера».

Если на сервере стоит блокировка индексации, ответ будет следующим:

Если на сервере стоит блокировка индексации, ответ будет следующим:

HTTP/1.1 200 OK

Date: Tue, 25 May 2010 21:42:43 GMT

X-Robots-Tag: noindex

2. Исправьте ошибки в ответах сервера

Если на сайте многие страницы отдают поисковому роботу код 404 («страница не существует»), Яндекс не только не индексирует их, но и в принципе сочтет сайт некачественным. Если это нужные страницы, то верните их в доступ, наполните контентом, либо настройте редирект 301. В противном случае удалите внутренние, а лучше и внешние ссылки, по которым краулер попадает на несуществующие адреса. Иногда ответ 404 получается из-за ошибки в написании URL (например, со слешем в конце или без него). Полностью избавиться от ответа 404, как правило, не получается, но минимизировать его необходимо.

Ответ сервера 302 («страница временно перемещена») также понижает шансы на корректную индексацию сайта. Яндекс бот по этому редиректу переходит на новую страницу, но не индексирует ее, так как в базе остается старый адрес. Поэтому настраивайте редирект 301 («страница перемещена навсегда»), тогда URL в базе обновится и робот перестанет заходить на старый.

Яндекс бот по этому редиректу переходит на новую страницу, но не индексирует ее, так как в базе остается старый адрес. Поэтому настраивайте редирект 301 («страница перемещена навсегда»), тогда URL в базе обновится и робот перестанет заходить на старый.

Какие коды краулер получает от сервера, можно увидеть в Вебмастере в разделе «Индексирование» –> «Статистика обхода».

История ответов сервера в отчете «Статистика обхода» по датам

Отдельные страницы можно протестировать инструментом Вебмастера «Проверка ответа сервера». Например, на скриншоте выше первый списке документ отдает код 404. Перейдя по нему, мы увидели, что страница отключена администратором. Исправив ошибку, в «Статистике обхода» сразу результат не увидели, потому что робот еще не заходил по адресу. Использовали инструмент «Проверка ответа сервера».

Проверив, видим код и время ответа сервера, кодировку, размер страницы

Как видите, теперь сервер дает правильный ответ 200, и когда краулер вновь зайдет на страницу, он добавит ее в индекс.

3. Проработайте внутренние и внешние ссылки

Роботы Яндекса чаще заходят на страницы, на которые ссылаются другие ресурсы. Мотивируйте Яндекс бота зайти на новую страницу, сделав перелинковку с уже проиндексированных адресов с хорошей посещаемостью. Выбирайте контент и особенно якоря, которые релевантны той странице, куда перенаправляет вас ссылка. Можно использовать следующие приемы:

-

Используйте все возможности получить обратные ссылки с качественных релевантных ресурсов, которые хорошо ранжируются. Покупая ссылки, тщательно относитесь к качеству доноров.

-

Мотивируйте пользователей делиться вашим контентом в социальных сетях, блогах, тематических форумах.

-

Предлагайте владельцам релевантных качественных сайтов создать для них контент, дизайн в обмен на обратную ссылку.

-

Одна из наиболее посещаемых страниц на сайте – главная.

Сделайте там блок «новости» или «новинки» и публикуйте внутренние ссылки на новые статьи или товары с кратким анонсом.

Сделайте там блок «новости» или «новинки» и публикуйте внутренние ссылки на новые статьи или товары с кратким анонсом.

-

В интернет-магазинах используйте подборки «Похожие/Рекомендованные товары», «С этим товаром покупают», которые позволяют в карточки товаров добавлять релевантные ссылки.

-

По такому же принципу в популярных статьях или других посещаемых разделах создайте блоки «Новые публикации», «Читать по теме» и подобные им разделы, которые позволяют включать.

4. Проверьте глубину вложенности

На страницы, расположенные дальше трех-четырех кликов в глубину от главной, робот доходит очень долго. Может и вообще не дойти до них, так как считает приоритетной главную страницу: чем ближе к ней – тем важнее. Структурируйте сайт так, чтобы страницы, которые должны приносить трафик и конвертировать его, находились на втором-третьем уровнях вложенности.

5. Повышайте качество контента

Рерайт, в котором мало экспертизы и уникальности, считается в Яндекс и Google, низкокачественным. Поэтому робот их проиндексирует, посчитает малоценными и исключит их поиска: они не попадут ни в Яндекс Поиск, ни в Google Search.

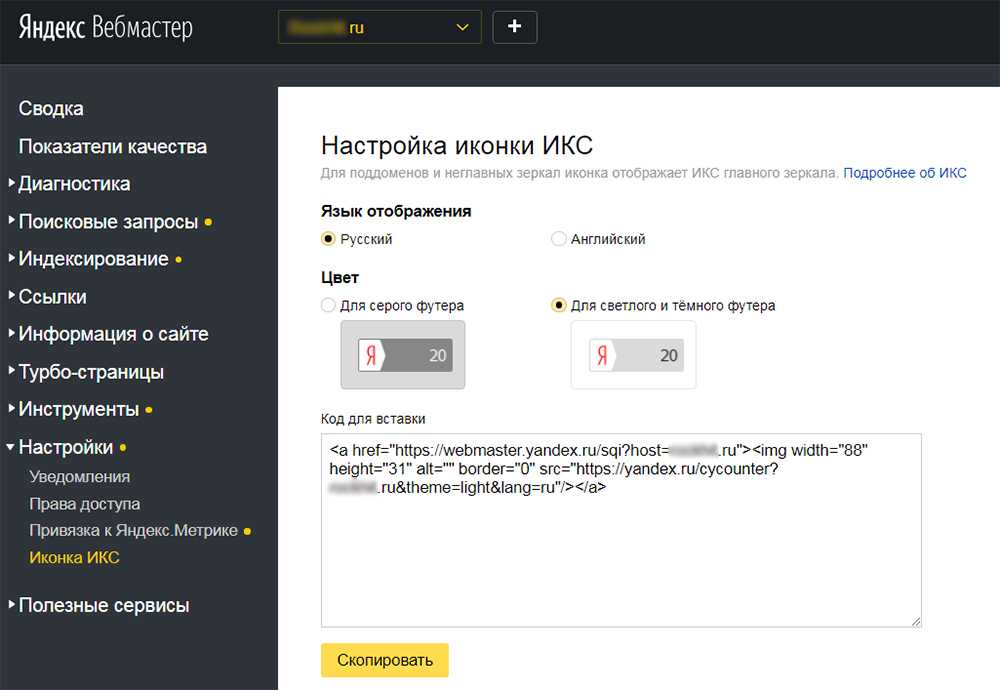

Общую оценку качества вашего сайта можно увидеть в Вебмастере в меню «Качество сайта» –> отчет «Показатель качества». Здесь есть так называемый ИКС (индекс качества сайта), который отражает востребованность сайта пользователями. Ниже Яндекс дает рекомендации по его повышению:

Контент страниц – весь, не только текстовый – должен соответствовать двум метрикам качества, которые использует поисковая система.

-

Проксима — метрика качества страниц. Она учитывает релевантность страницы запросу, закрытие потребности пользователя на данном ресурсе, авторитетность и экспертность контента, другие критерии.

-

Профицит — метрика полезности выдачи: успешно ли пользователи решают свои задачу на сайте.

Как сделать старые и новые страницы соответствующими этим критериям? В целом следует делать их полезными для пользователя и показывать экспертизу бренда.

Например, в интернет-магазине карточки товара должны содержать подробное описание, фотографии продукта с разные сторон, при необходимости – фото 3D, видео, инструкцию в графическом или видеоформате. В статьях привлекайте авторов-специалистов в своей области, цитируйте экспертов, давайте профессиональные оценки, которые не могут предложить конкуренты.

Обновляйте ассортимент и информацию регулярно, хотя бы 1-2 раза в неделю. В отсутствие новостей и новинок актуализируйте информацию на уже проиндексированных страницах. На них следует настроить теги заголовков Last-Modified и If-Modified-Since, тогда после внесения изменений робот заново их обойдет.

Такой контент будет вызывать доверие у пользователей и поисковых систем, и краулер охотнее будет индексировать новые страницы.

6. Устраните дубли

Одинаковое содержание или URL страниц, дубли метаданных в тегах Title, h2, Description для Яндекса – сигналы о некачественном сайте, который не стремится помочь пользователю оперативно решить его проблему.

На крупных ресурсах дубли появляются довольно часто из-за большого количества страниц. URL дублируются с WWW в начале и без него, со слешем / в конце и без него. Также повторы возникают из-за создания страниц с комментариями, пагинации. Часто используют одинаковое описание для товаров, различающихся лишь цветом, размером и т.п., но расположенных в разных карточках. Все эти повторы надо устранять.

Как их выявить?

-

Повторяющиеся метатеги можно найти, зайдя в Вебмастере в меню «Индексирование» в отчет «Заголовки и описания». Чтобы избавиться от них, прописывайте вручную оригинальные Title, h2, Description для приоритетных страниц и настройте автоматическую генерацию метаданных через плагин для остальных.

-

Дублированные страницы можно увидеть через «Индексирование» –> «Страницы в поиске» –> «Исключенные». Перед вами появится наглядный график. Нажмите значок «Статус и URL» и выберите «Статус», «Удалено: Дубль».

Выявление дублей в Яндекс Вебмастере

Для избавления от дублей в индексации следует настроить редирект 301 либо назначить основную страницу через атрибут rel=»canonical».

Если робот счел две страницы дублями из-за контента, необходимо уникализировать контент: измените текст, добавьте возможность комментирования, отзывы и так далее. Имейте в виду, что Яндекс сравнивает текст, и, например, только замена фотографий или добавление видео на страницу не решит проблему дублирования.

Можно также закрывать от индексации системные файлы, результаты поисков, архивы – все адреса, которые не будут конвертировать трафик, приходящий из поиска.

Мнение эксперта

Анастасия Курдюкова, руководитель группы оптимизаторов «Ашманов и партнеры»:

«Не стоит закрывать на сайте важные для пользователя блоки и важную информацию, особенно меню. Раньше подобное рекомендовали, потому что служебная информация, повторяющаяся на всех страницах сайта, якобы снижает уникальность. На самом деле здесь только два решения. Первое: если страницы действительно признаны дублями, то нужно от них избавляться. Второе: если страницы признаны дублями, но на самом деле такими не являются, то нужно по возможности уникализировать контент».

Как ускорить индексацию страниц

Итак, вы провели необходимые работы и подготовили сайт или отдельные его страницы к индексированию. Какими методами можно ускорить процесс?

-

Отправьте обновленные страницы в Яндекс на переобход

-

Отправьте страницы на переиндексацию при помощи протокола IndexNow

-

Включите инструмент «Обход по счетчикам»

-

Получите внешние ссылки с трастовых ресурсов

1.

Отправьте обновленные страницы в Яндекс на переобход

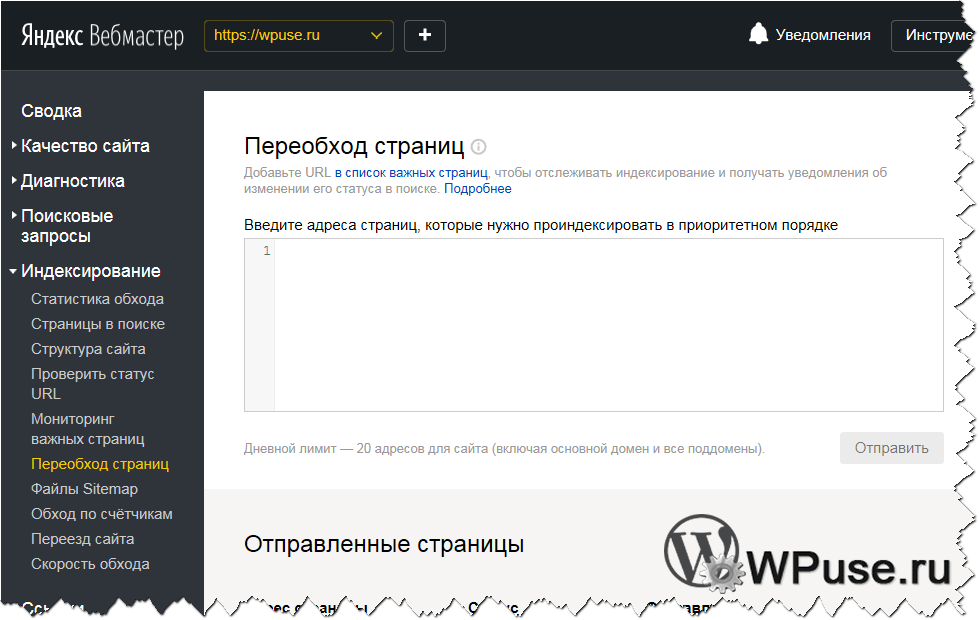

Отправьте обновленные страницы в Яндекс на переобходИспользуйте инструмент Вебмастер «Переобход страниц», который находится в меню «Индексирование». Правда, здесь есть лимит на количество адресов в сутки. Если сайт большой и изменено много страниц, придется использовать инструмент несколько раз по мере внесения изменений.

Мнение эксперта

Анастасия Курдюкова, руководитель группы оптимизаторов «Ашманов и партнеры»:

«Через этот инструмент можно отправить на переобход только конкретные страницы сайта. Учитывайте, что дневной лимит на переобход увеличивается в зависимости от размеров сайта».

Вставьте в поле URL, на которые робот должен зайти, и кликните «Отправить». Если все в порядке, информация в поисковой базе обновится в течение двух недель, в противном случае Вебмастер сообщит об ошибке.

2. Отправьте страницы на переиндексацию при помощи протокола IndexNow

IndexNow – это независимый инструмент, который с помощью API сообщает об изменениях на сайте напрямую в Яндекс без привлечения собственного краулера поисковика. Правда, индексация сайта через сторонний протокол не гарантирована, предупреждает Яндекс в своей справке. Практика показала, что есть смысл использовать IndexNow для отправки новых страниц, так как лимиты у него выше, чем у Переобхода Вебмастера –10000 страниц в день.

Правда, индексация сайта через сторонний протокол не гарантирована, предупреждает Яндекс в своей справке. Практика показала, что есть смысл использовать IndexNow для отправки новых страниц, так как лимиты у него выше, чем у Переобхода Вебмастера –10000 страниц в день.

3. Включите инструмент «Обход по счетчикам»

Включите инструмент«Обход по счётчикам», который позволяет роботу Яндекса узнавать о новых страницах вашего сайта из данных Метрики. Счетчик сообщает краулеру о появлении новых страниц даже если они не включены в Sitemap.xml и не указаны в Robots.txt. Создайте счётчик и привяжите его к сайту в Вебмастере. Для этого в меню «Индексирование» перейдите в «Обход по счетчикам» и выполните пошаговую инструкцию.

Как настроить счетчик Метрики, чтобы ускорить индексирование

Учтите, что данный метод не работает с индексацией Турбо-страниц, так как их обходит другой робот.

4. Получите внешние ссылки с трастовых ресурсов

Создайте профиль компании в Яндекс Бизнесе, отметьте ее на Яндекс Картах и не забывайте регулярно актуализировать информацию. Публикуйте анонсы со ссылками на новые статьи и товары в ваших страничках в соцсетях.

Публикуйте анонсы со ссылками на новые статьи и товары в ваших страничках в соцсетях.

Затем попробуйте договориться с вебмастерами релевантных ресурсов, которые давно проиндексированы и имеют хороший ИКС, о размещении ссылок на ваш сайт. Могут подойти сервисы вопросов и ответов, справочные порталы, форумы, СМИ, блоги.

Аутрич должен выглядеть естественно и не спамно. Самое главное – сайты, разместившие вашу ссылку, должны пользоваться доверием Яндекса. Выбирайте площадки для размещения из топа выдачи по релевантным запросам, по которым вы не будете с ними конкурировать.

Выводы

-

Индексация сайта и страниц в Яндексе – не быстрый процесс. Его скорость зависит от технического состояния сайта, частоты обновления контента на сайте, поведенческих факторов и качества контента.

-

Если индексирование задерживается, надо проверить, не закрыт ли ваш ресурс или отдельные URL от индексирования.

-

Проверьте технические ошибки на страницах и качество оптимизации. Используйте инструменты Яндекс Вебмастера для аудита ошибок.

-

После исправления проблем сообщите поисковой системе о необходимости переиндексировать страницы при помощи Вебмастера, Яндекс Метрики или стороннего протокола.

-

Нарабатывайте внешние ссылки с авторитетных площадок, чтобы выглядеть трастово для поискового робота.

Продвижение сайта статьями

#SEO

СтатьяЧто из англоязычного SEO можно применять в Рунете?

#SEO

СтатьяЮзабилити-тестирование сайта: цели, этапы, ошибки

#SEO

Анастасия Курдюкова

Руководитель группы оптимизаторов • Эксперт

Опытный специалист по SEO-оптимизации, работает в продвижении более 6 лет. Спикер конференций и вебинаров для клиентов компании.

Спикер конференций и вебинаров для клиентов компании.

Татьяна Минина

Редактор блога

Профессиональный журналист, копирайтер, член Союза Журналистов России. Сфера профессиональных интересов: digital-маркетинг, журналистика, SEO, здоровый образ жизни.

Теги: SEO

Справочник по ошибкам индексирования — веб-мастер. Справка

- Ошибки загрузки

- Ошибки обработки

Список ошибок, которые выдает робот Яндекса, если ему не удается загрузить документ с вашего сайта.

| Ошибка | Описание |

|---|---|

| Ошибка соединения | 90 028 Соединение прервано при попытке загрузить документ. После нескольких попыток загрузка была остановлена.|

| Превышен предельный размер текста | Документ слишком длинный, попробуйте разбить его на части. |

| Документ заблокирован от индексации в robots.txt | Документ не проиндексирован, поскольку вы или другой администратор заблокировали его от сканирования в robots.txt. |

| Неверный адрес документа | Адрес документа не соответствует стандарту HTTP. |

| Формат документа не поддерживается | Сервер не указывает формат документа или указывает его неправильно, либо указанный формат не поддерживается Яндексом. |

| Ошибка DNS | Ошибка DNS. IP-адрес хоста не может быть определен по его имени. |

| Код состояния HTTP не соответствует стандарту | Сервер возвращает код состояния, не соответствующий стандарту HTTP. |

| Недопустимый HTTP-заголовок | HTTP-заголовок не соответствует стандарту (включая расширение от Яндекса). |

| Не удалось подключиться к серверу | Не удалось подключиться к серверу. |

| Недопустимая длина сообщения | Длина сообщения не указана или указана неправильно. |

| Неверная кодировка | Заголовок Transfer-Encoding установлен неправильно или кодировка неизвестна. |

| Неверный объем переданных данных | Длина передаваемых данных не соответствует указанной. Передача данных завершается до или продолжается после получения указанного объема данных. |

| Превышена максимальная длина заголовка HTTP | Превышен предел длины заголовков HTTP. Это может быть вызвано попыткой передать слишком много файлов cookie. |

| Превышена максимальная длина URL-адреса | Длина URL-адреса превышает ограничение. |

Список ошибок, возвращаемых роботами в случае успешной загрузки документа, но невозможности дальнейшей обработки.

| Ошибка | Описание |

|---|---|

Документ содержит метатег noindex | Документ не проиндексирован, поскольку он содержит метатег noindex . |

| Неверная кодировка | Документ содержит символы, не соответствующие заявленной кодировке. |

| Документ является журналом сервера | Документ распознан как журнал сервера. Если это страница, созданная для посетителей веб-сайта, попробуйте изменить ее так, чтобы она не была похожа на журнал сервера. |

| Недопустимый формат документа | Робот обнаружил, что документ не соответствует заявленному формату (HTML, PDF, DOC, RTF, SWF, XLS, PPT). |

| Кодировка не распознана | Кодировка документа не распознана. Возможно, документ не содержит текста или содержит текст в разных кодировках. |

| Язык не поддерживается | Язык документа не распознан или не поддерживается. Для получения подробной информации обо всех поддерживаемых языках перейдите в соответствующий раздел справки. |

| Документ не содержит текста | Сервер возвращает пустой документ. |

| Слишком много ссылок | Количество ссылок на странице превышает лимит. |

| Ошибка извлечения | Произошла ошибка при распаковке потока данных GZIP или DEFLATE с сервера. |

| Пустой ответ сервера | Сервер вернул ответ нулевой длины. Свяжитесь с администратором хостинг-сервера. |

| Документ неканонический | Элемент link в коде документа содержит атрибут rel , для которого задано значение canonical и он указывает на другой (канонический) документ. Канонический документ был проиндексирован вместо текущего документа. |

Если страницы доступны для робота и отправлены на переиндексацию, но не появляются в поиске более двух недель, заполните форму ниже:

Возможные проблемы — Вебмастер.

Справка

СправкаВ этом разделе собраны решения распространенных проблем категории «Возможные проблемы», которые выявляются при устранении неполадок с сайтом в Яндекс.Вебмастере. Проблемы этой категории могут повлиять на качество и скорость индексации сайта.

Совет. Настройте уведомления о результатах мониторинга сайта.

- Файл robots.txt не найден

- Обнаружены ошибки в файле robots.txt

- В настоящее время бот-индексатор не использует файлы Sitemap

- Обнаружены ошибки в файлах Sitemap

- Отсутствует элемент title и метатег description

- Страницы имеют одинаковые названия и описания

- Файл favicon недоступен для робота

Робот-индексатор несколько раз запрашивает файл robots.txt раз в сутки и обновляет информацию о нем в своей базе данных. Если робот не может загрузить файл, в Яндекс.Вебмастере появляется предупреждение.

В сервисе проверьте наличие файла robots. txt. Если файл по-прежнему недоступен, добавьте его. Если вы не можете сделать это самостоятельно, обратитесь к своему хостинг-провайдеру или регистратору доменных имен. После добавления файла данные в Яндекс.Вебмастере обновятся в течение нескольких дней.

txt. Если файл по-прежнему недоступен, добавьте его. Если вы не можете сделать это самостоятельно, обратитесь к своему хостинг-провайдеру или регистратору доменных имен. После добавления файла данные в Яндекс.Вебмастере обновятся в течение нескольких дней.

Проверьте файл robots.txt вашего сайта. Чтобы исправить ошибки, смотрите описания директив.

Файл Sitemap это вспомогательный инструмент для индексации сайта. Позволяет регулярно информировать робота о появлении новых страниц на сайте. Это предупреждение появляется, если робот не использует файлы Sitemap для сайта.

Чтобы робот начал использовать созданный файл, добавьте его в Яндекс.Вебмастер и подождите, пока робот обработает файл. Это может занять до двух недель. После этого предупреждение исчезнет.

Проверьте файл Sitemap вашего сайта. Проверка может обнаружить ошибку «Неизвестный тег». Это означает, что файл содержит элементы, которые не поддерживаются Яндексом. Неподдерживаемые элементы игнорируются роботом при обработке Sitemap, но данные из поддерживаемых элементов все равно учитываются. Вам не нужно изменять содержимое файла. Узнайте больше о поддерживаемых элементах Sitemap.

Вам не нужно изменять содержимое файла. Узнайте больше о поддерживаемых элементах Sitemap.

Элемент заголовка и метатег описания используются для создания хорошего описания сайта в результатах поиска. Дополнительные сведения см. в разделе Отображение названия и описания сайта в результатах поиска.

Если один или оба этих элемента отсутствуют на вашем сайте, добавьте их в HTML-код страниц и сохраните изменения. Если элементы уже добавлены, подождите, пока робот пересканирует страницы. Сообщение об ошибке исчезнет после переиндексации. Узнать больше

Эта проблема возникает, если заголовок или описание дублируются на многих страницах сайта. Элемент заголовка и метатег описания должны быть информативными и привлекательными и отражать содержание страницы. Это поможет пользователям найти результаты поиска, которые они ищут.

Посмотрите примеры страниц с повторяющимися названиями или описаниями, которые Яндекс.Вебмастер обнаружил при обходе сайта роботом. Чтобы их исправить, следуйте рекомендациям для:

Чтобы их исправить, следуйте рекомендациям для:

Создание титровального элемента.

Создание метатега описания.

Проблема перестанет отображаться, когда робот узнает об изменениях на сайте. Чтобы это произошло быстрее, отправьте наиболее важные страницы на переиндексацию или настройте сканирование страниц с тегом Яндекс.Метрики.

Если эта проблема отображается для вашего сайта, это означает, что Небольшое изображение отображается во сниппете в результатах поиска Яндекса, рядом с адресом сайта в адресной строке браузера и рядом с названием сайта в Избранном или Закладки в веб-браузере.»}}»> не отображаются в результатах поиска. В Яндекс.Вебмастере перейдите на страницу Устранение неполадок → Диагностика сайта (блок Возможные проблемы) и найдите причину, по которой робот не смог загрузить файл, далее следуйте инструкции:

| Ошибка | Решение |

|---|---|

| Файл отвечает HTTP-кодом, отличным от 200 OK 9 0027 | Проверьте ответ сервера. |