Как создать и настроить robots.txt для WordPress

Что такое robots.txt

Robots.txt — это текстовый файл, который добавляется на сайт и используется для разрешения или запрета индексации страниц веб-ресурса роботами поисковых систем. Robots.txt содержит инструкции, которые говорят поисковым роботам, какие страницы или разделы сайта показывать в результатах поиска, а какие нет.

Для чего нужен robots.txt

Robots.txt нужен для настройки индексации страниц и разделов веб-ресурсов. С его помощью можно улучшить SEO-оптимизацию сайта и улучшить распределение трафика. Важно отметить, что файл robots.txt не является инструментом безопасности и не может полностью скрыть конфиденциальные данные, размещенные на сайте.

Файл robots.txt выполняет следующие задачи:

- Говорит поисковым роботам, какие страницы сайта должны быть проиндексированы, а какие нет: так robots.txt регулирует восприятие сайта поисковыми системами.

- Скрывает конфиденциальную информацию, расположенную на сайте, из поисковых индексов.

Например, данные платежных карт или личная информация могут быть скрыты с помощью правильной настройки robots.txt.

Например, данные платежных карт или личная информация могут быть скрыты с помощью правильной настройки robots.txt. - Защищает сервер и ресурсы сайта от ботов, которые могут сканировать его в поисках уязвимостей в защите.

- Увеличивает скорость загрузки сайта. Если некоторые страницы вашего сайта не нуждаются в индексации, заблокируйте их с помощью robots.txt – это уменьшит размер сайта и количество запросов к серверу, что, в свою очередь, ускорит загрузку страниц.

- Улучшает SEO-оптимизацию сайта. С помощью настройки robots.txt вы можете указать наиболее важные страницы для индексации и отображения в результатах поиска.

Где расположен robots.txt на сайте с CMS WordPress

На сайте с CMS WordPress файл robots.txt находится в корневой директории сайта. Если адрес вашего сайта https://example.ru, то файл robots.txt будет находится по адресу https://example.ru/robots.txt.

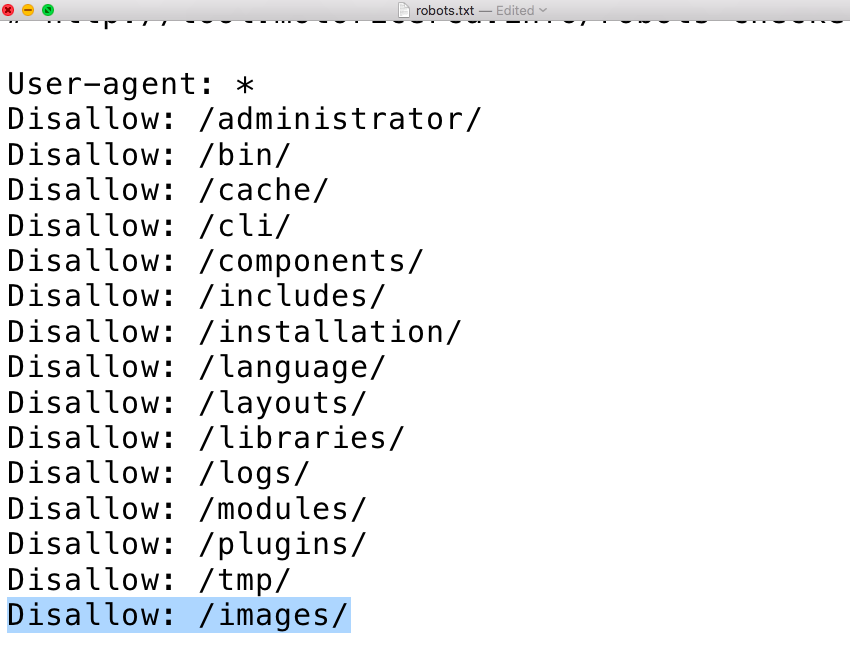

При наличии файла robots.txt на сайте вы увидите набор правил индексации:

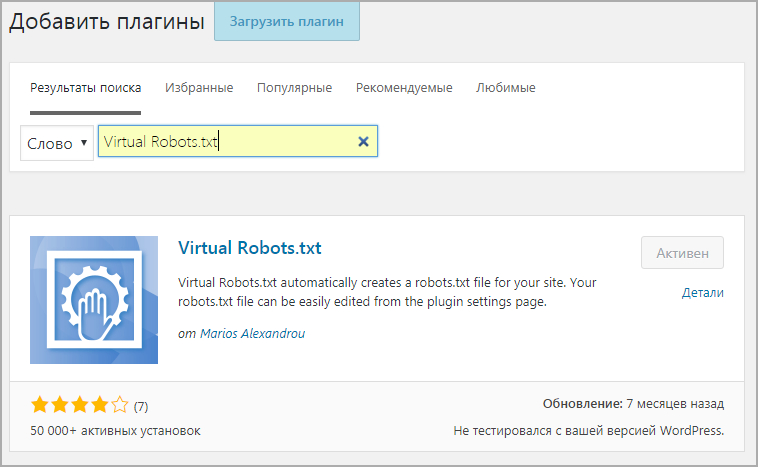

Чтобы создать или изменить содержание файла robots. txt используйте любой текстовый редактор (например, Emacs, Блокнот, TextEdit) или плагин, разработанный для управления robots.txt (например, WordPress Robots.txt File, All in One SEO Pack или Yoast SEO). Если вы работаете со стандартной конфигурацией WordPress, файл robots.txt будет автоматически создан при установке CMS. Если вы использовали специальную настройку для блокировки поисковых роботов, то файл мог быть изменен или удален.

txt используйте любой текстовый редактор (например, Emacs, Блокнот, TextEdit) или плагин, разработанный для управления robots.txt (например, WordPress Robots.txt File, All in One SEO Pack или Yoast SEO). Если вы работаете со стандартной конфигурацией WordPress, файл robots.txt будет автоматически создан при установке CMS. Если вы использовали специальную настройку для блокировки поисковых роботов, то файл мог быть изменен или удален.

Для высокой скорости работы вашего сайта на WordPress выбирайте оптимизированный хостинг для CMS. Требования к хостингу с поддержкой WordPress уже учтены, сама система управления сайтом предустановлена на каждом тарифе, что позволяет сразу же приступить к работе над сайтом.

Как создать файл robots.txt

Создание robots.txt вручную

Если у вас нет готового файла robots.txt и вы хотите его создать вручную, используйте любой текстовый редактор, например, Блокнот.

- Откройте текстовый редактор.

- Напишите название вашего сайта и описание его содержимого.

- Затем добавьте инструкции для поисковых роботов. Вы можете использовать следующий код, чтобы запретить индексацию раздела новостей за 2022 год роботами Яндекса:

User-agent: Yandex

Disallow: /news/news2022

- Сохраните файл с именем robots.txt.

- Загрузите файл robots.txt на сервер. Вы можете загрузить его через FTP-клиент или при помощи консоли управления хостингом.

Создание robots.txt с помощью плагина

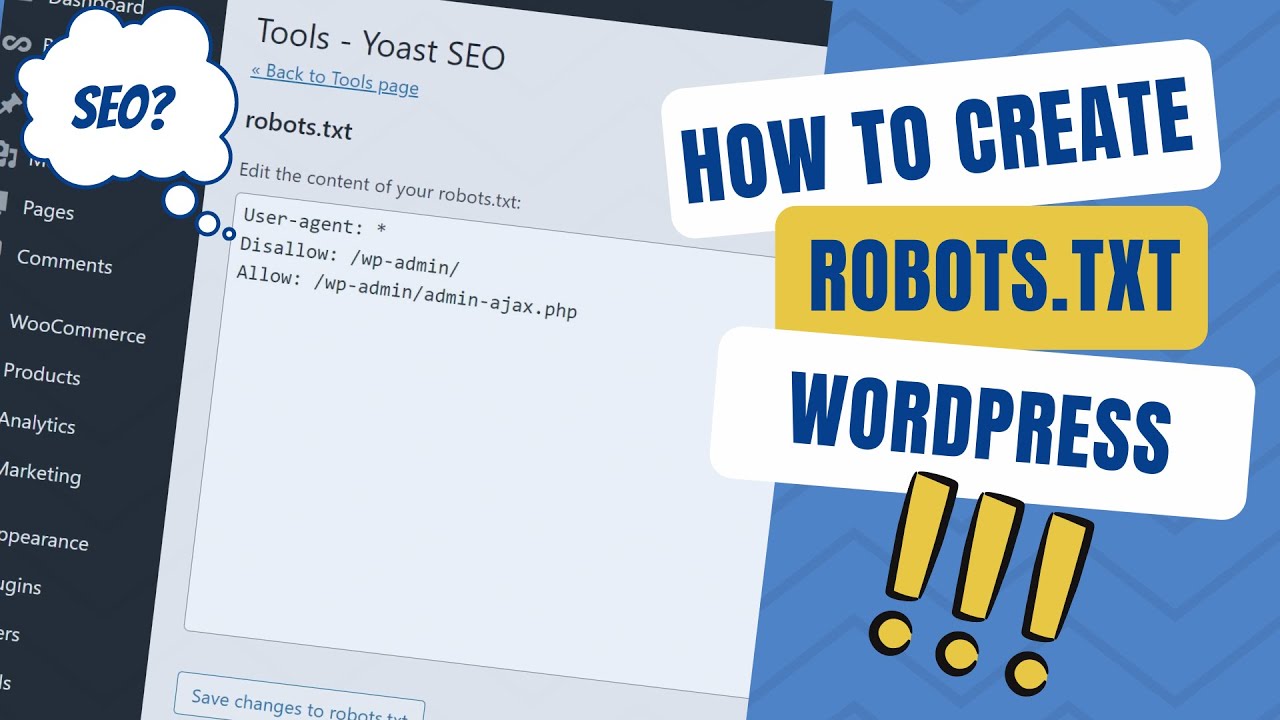

Вы можете использовать различные плагины для создания robots.txt, например, плагин Yoast SEO или Better Robots.txt. Так как Yoast SEO является популярным плагином у веб-разработчиков покажем на его примере как создавать файл robots.txt.

С помощью плагина Yoast SEO создавать и управлять файлом robots.txt можно прямо из интерфейса WordPress. Плагин является одним из наиболее востребованным – его установили более 5 миллионов раз. Для создания robots.txt с помощью Yoast SEO следуйте инструкции:

- Установите и активируйте плагин Yoast SEO на WordPress.

- В боковой панели CMS выберите раздел SEO и перейдите на страницу Файлы и выберите вкладку robots.txt.

- Укажите инструкции для поисковых роботов, которые будут обозначать, какие страницы нужно индексировать, а какие нет. Сделать это можно автоматически с помощью плагина или вручную, добавив готовые инструкции.

- Нажмите Сохранить, чтобы применить внесенные в файл изменения.

После создания файла robots.txt через плагин Yoast SEO он будет автоматически сохранен на вашем сервере и использоваться для управления поведением поисковых роботов.

Пример robots.txt

Приведем некоторые примеры, которые помогут вам настроить файл robots.txt:

- Запретить индексацию всего сайта:

User-agent: *

Disallow: /

- Запретить индексацию конкретных страниц:

User-agent: *

Disallow: /page1. html

html

Disallow: /page2.html

- Запретить индексацию конкретного каталога:

User-agent: *

Disallow: /catalog/

- Запретить индексацию любых файлов с расширением PDF:

User-agent: *

Disallow: /*.pdf$

- Разрешить индексацию всего сайта, кроме конкретной папки:

User-agent: *

Disallow: /unwanted-directory/

- Запретить индексацию страниц, содержащих конфиденциальную информацию:

User-agent: *

Disallow: /secure-page/

Disallow: /login/

Disallow: /account/

Рекомендации по настройки robots.txt в WordPress

При настройке файла robots.txt на сайте WordPress соблюдайте рекомендации ниже, чтобы оказать положительное влияние на SEO-оптимизацию вашего сайта.

- Определите, какие страницы вашего сайта не требуют индексации поисковыми роботами. Например, это может быть страница авторизации, корзина или любые другие страницы, которые не являются информативными или по другим причинам не должны быть доступны для поисковой индексации.

- Не разрешайте доступ к важным каталогам или файлам, которые можно скрыть от поисковых роботов.

- Проверьте правильность настройки файла robots.txt с помощью специальных инструментов (о них будет рассказано ниже).

- Обновляйте файл robots.txt, если вы добавили или удалили страницы или каталоги на сайте.

- Не блокируйте доступ к картам сайта (sitemap.xml), так как это может привести к ухудшению SEO-рейтинга вашего сайта.

Правильная настройка robots.txt может увеличить скорость загрузки сайта за счет блокирования малозначительных страниц. Если вы не уверены в правильности своих настроек, лучше обратиться к профессионалам и получить консультацию по настройке файла robots.txt для вашего сайта. В RU-CENTER вы можете воспользоваться услугой Администрирование по запросу.

Инструмент проверки файла robots.txt

Предлагается несколько инструментов для проверки корректности файла robots.txt. Они помогают выявить ошибки, которые могут стать причиной неправильной работы поисковых роботов на сайте. Такие сервисы также предоставляют рекомендации по исправлению выявленных проблем, что позволяет улучшить индексацию сайта. Рассмотрим самые популярные из них: Яндекс.Вебмастер и Google Console.

Такие сервисы также предоставляют рекомендации по исправлению выявленных проблем, что позволяет улучшить индексацию сайта. Рассмотрим самые популярные из них: Яндекс.Вебмастер и Google Console.

- Анализ robots.txt в Яндекс Вебмастер

Проверка robots.txt в Яндекс Вебмастере – бесплатный инструмент, который помогает владельцам сайтов проводить анализ в поисковой системе Яндекс.

Чтобы проанализировать работу файла robots.txt с помощью сервиса от Яндекс, зарегистрируйте свой сайт в Яндекс Вебмастер и выполните следующие действия:

- Откройте раздел Инструменты и выберите меню Анализ robots.txt

- В поле Проверить URL введите адрес своего сайта и нажмите Проверить.

- После завершения проверки вы получите данные в виде таблицы, где будет отображен список разделов файла robots.txt и их настройки. Там же вы найдете сколько страниц было заблокировано с помощью инструкций Disallow.

В Яндекс Вебмастер предусмотрены возможности фильтрации списка разделов и настройки сортировки результатов. При обнаружении ошибок в настройках файла robots.txt, сервис предложит рекомендации по их устранению.

- Анализ robots.txt в Google Console

С помощью Google Console вы можете бесплатно провести анализ и выполнить настройки своего сайта в поисковой системе Google.

Если у вас еще нет аккаунта в Google Console, зарегистрируйтесь. Далее выполните несложные шаги:

- Перейдите в раздел Crawling и выберите пункт robots.txt Tester.

- В поле Test a robots.txt file введите адрес своего сайта и нажмите Test.

- Дождитесь завершения проверки.

Итоги анализа файла robots.txt будут представлены в виде таблицы, где вы увидите разделы файла robots.txt и их настройки. Здесь же будет размещена информация о том, сколько страниц было заблокировано с помощью инструкций Disallow. Вы можете выполнить фильтрацию или сортировку полученных данных.

Вы можете выполнить фильтрацию или сортировку полученных данных.

Кроме указанных выше инструментов вы можете использовать другие сервисы по проверке файла robots.txt:

- SEO SiteCheckup – платный сервис с множеством встроенных инструментов для работы с SEO-оптимизацией. SEO SiteCheckup предоставляет удобную проверку файла robots.txt на ошибки и предлагает рекомендации по его настройке.

- Robotto – бесплатный инструмент, который предоставляет детализированный отчет по файлу robots.txt. Он находит ошибки и предлагает рекомендации по их устранению.

- Ryte – еще один платный инструмент, который позволяет проверить файл robots.txt и узнать, сколько страниц было заблокировано с использованием инструкций Disallow.

Заключение

Перед созданием файла robots.txt составьте список страниц сайта, которые требуют индексации и список из страниц, которые не должны быть просканированы поисковыми роботами. Следите за корректностью синтаксиса и структуры файла, чтобы избежать ошибок в его работе.

С помощью специальных инструментов, таких как Google Console и Яндекс Вебмастер, проверяйте и оптимизируйте настройки файла robots.txt, чтобы обеспечить более эффективную индексацию сайта поисковыми системами.

Как написать robots.txt для wordpress – Вопросы Timeweb Community

- Вопросы

- Маркетплейс

1087

1 ответ

Как правильно написать robots.txt для wordpress?

Администрирование Серверы WordPress

Похожие вопросы

Дмитрий23

Word Press не работает в режиме PHP fpm

Помогите советом. После переноса сайта на виртуальный сервер сайт начал работать только с обработчиком php CGI. В режиме fast CGI появляется ошибка 403, а при переключении в php fpm всё работает быстро и отлично, но при этом не отображаются фотографии,…

После переноса сайта на виртуальный сервер сайт начал работать только с обработчиком php CGI. В режиме fast CGI появляется ошибка 403, а при переключении в php fpm всё работает быстро и отлично, но при этом не отображаются фотографии,…

Администрирование

Обсудить Inkognito246

Выбор сервера для дома

Всем добрейшего дня! Дошел до потребности в создании домашнего сервера для файлопомойки, ибо хранить все на одном компе уже не возможно, места для дисков давно кончались. Все присматривался к покупке БУ компа. залить туда openmediavault и радоваться…

Администрирование

2 ответа Александр Бирюков487

Ошибка при установке плагина WordPress

Здравствуйте! При установке плагина вылазает ошибка «Установка не удалась: Загрузка не удалась. Unauthorized» но после перезагрузке плагин оказывается установлен. В чём может быть проблема?

Unauthorized» но после перезагрузке плагин оказывается установлен. В чём может быть проблема?

CMS

5 ответовВаш баланс 10 ТК

1 ТК = 1 ₽

О том, как заработать и потратить Таймкарму, читайте в этой статье

Чтобы потратить Таймкарму, зарегистрируйтесь на нашем сайте

Зарегистрироваться

С помощью соцсетейЗабыли пароль?

Запомнить меня

У меня нет аккаунта Зарегистрироваться

Инструкции по восстановлению пароля высланы на Ваш адрес электронной почты.

Вернуться ко входу

Пожалуйста, укажите email вашего аккаунта

Вернуться ко входу

Войти в Комьюнити

ВК Yandex Google

Регистрация в Комьюнити

ВК Yandex Google

Восстановление пароля

Robots.

txt для WordPress: Настройка WordPress Robots.txt

txt для WordPress: Настройка WordPress Robots.txtСледование передовым методам поисковой оптимизации (SEO) имеет первостепенное значение, если вы хотите, чтобы ваш сайт занимал высокие позиции в результатах поиска и привлекал более квалифицированный трафик на ваши страницы. Несмотря на то, что в вашем списке есть десятки пунктов, вы не должны забывать об одном — создании файла robots.txt для WordPress. Но что такое файл robots.txt?

У нас есть ответ! На этой странице мы ответим на такие вопросы, как:

- Что такое файл robots.txt WordPress?

- Зачем мне нужен файл robots.txt для моего сайта WordPress?

- Как редактировать файл robots.txt с помощью WordPress?

- Как проверить файл robots.txt?

Продолжайте читать, чтобы узнать больше!

Что такое файл robots.txt WordPress?

WordPress robots.txt — это файл, который владельцы веб-сайтов создают, чтобы сообщить поисковым системам, как сканировать и индексировать их сайт. Он предоставляет поисковым системам, таким как Google, руководство по сканированию и индексированию, чтобы гарантировать, что наиболее ценные страницы будут проиндексированы и появятся в результатах поиска.

Он предоставляет поисковым системам, таким как Google, руководство по сканированию и индексированию, чтобы гарантировать, что наиболее ценные страницы будут проиндексированы и появятся в результатах поиска.

Зачем мне нужен файл robots.txt для WordPress?

Robots.txt для WordPress имеет решающее значение, поскольку он сообщает поисковым системам, какие страницы или папки им не следует сканировать. Чтобы ваш сайт отображался в результатах поиска, Google должен сканировать ваши страницы и индексировать их.

Если вы хотите, чтобы поисковые роботы эффективно сканировали ваш сайт, вы должны указать им свой файл robots.txt. WordPress robots.txt не блокирует поисковые роботы от индексации определенных страниц на вашем сайте — для этого необходимо использовать метатег noindex. Однако этот файл помогает отвлечь поисковых роботов от этих страниц и сосредоточиться на более важных страницах, которые необходимо проиндексировать, таких как страницы ваших продуктов, страницы услуг или сообщения с контентом.

Использование файла robots.txt для WordPress также помогает предотвратить замедление работы сайта этими ботами. Без этого файла боты могут перегружать ваш сайт, пытаясь сканировать разные страницы, что в конечном итоге может привести к медленной загрузке. Учитывая, что медленно загружаемые сайты обходятся предприятиям в 2,6 миллиарда долларов в год, вы не хотите рисковать.

В целом, использование файла robots.txt для WordPress полезно для того, чтобы помочь вашему бизнесу повысить рейтинг наиболее важных страниц в результатах поиска, не замедляя при этом работу вашего сайта.

Как редактировать robots.txt с помощью WordPress

Теперь, когда вы знаете, почему файл robots.txt имеет решающее значение для отображения вашего сайта в результатах поиска, вы готовы принять меры, чтобы помочь вашему сайту сканироваться и индексироваться. Существует два подхода к созданию файла robots.txt. Вы можете использовать плагин WordPress robots.txt или сделать это вручную.

Плагин robots.txt для WordPress №1: All-in-One SEO

Первый вариант создания файла robots.txt — это All-in-One SEO или AIOSEO.

Этот подключаемый модуль поставляется с генератором файлов robots.txt, который можно использовать для создания и редактирования файлов robots.txt. Чтобы отредактировать файл robots.txt с помощью этого плагина, выполните следующие действия:

- Войдите в панель управления WordPress

- Нажмите на Все в одном SEO

- Нажмите Диспетчер функций

- Прокрутите вниз до Редактор файлов и нажмите Активировать

- Вернуться в меню All in One SEO

- Нажмите вкладка текст

- Нажмите Редактировать

С этого момента вы можете ввести файл robots.txt WordPress, а затем сохранить изменения, чтобы они вступили в силу на вашем сайте!

Плагин WordPress robots.

txt № 2: Yoast SEO

txt № 2: Yoast SEOЕще один плагин WordPress robots.txt, который вы можете использовать, — это Yoast SEO. Yoast SEO позволяет вам создавать и редактировать файл robots.txt на вашем веб-сайте. Чтобы использовать этот плагин для редактирования вашего файла, выполните следующие действия:

- Перейдите к своему Панель инструментов WordPress

- Нажмите на SEO

- Нажмите Инструменты

- Нажмите Редактор файлов

- Редактировать файл robots.txt

После редактирования файла robots.txt вы можете добавить свой текст и сохранить его, чтобы он начал действовать.

WordPress robots.txt. manual option

Когда вы научитесь редактировать robots.txt с помощью WordPress, вы обнаружите, что можете вводить файл вручную вместо использования плагина. Для этого вам понадобится протокол передачи файлов (FTP), такой как FileZilla.

Чтобы создать файл robots. txt для WordPress таким образом, выполните следующие действия:

txt для WordPress таким образом, выполните следующие действия:

- Откройте текстовый редактор (например, Блокнот)

- Введите кодировку, которую хотите использовать

- Сохранить файл как текстовый файл типа

- Подключите свой сайт к FTP

- Перейти к общедоступной папке HTML

- Загрузите файл txt с вашего компьютера на сервер

Как протестировать файл robots.txt в WordPress

Теперь, когда вы знаете, как редактировать файл robots.txt в WordPress, вы можете добавить собственные правила и периметры для сканирования вашего сайта. Добавив файл robots.txt, вы хотите убедиться, что он работает и что поисковые системы могут сканировать ваш сайт. Вы можете протестировать файл robots.txt для WordPress с помощью Google Search Console.

Google Search Console предлагает инструмент для проверки robots.txt, который поможет вам проверить, может ли Google сканировать ваш сайт. Вот как это можно проверить:

- Откройте инструмент txt tester

- Прокрутите код robots.

txt, чтобы найти выделенные синтаксические предупреждения и логические ошибки

txt, чтобы найти выделенные синтаксические предупреждения и логические ошибки - Введите URL-адрес страницы вашего сайта в текстовое поле под .

- Выберите пользовательский агент , который вы хотите имитировать, в раскрывающемся списке

- Нажмите кнопку Проверка

После того, как вы нажмете кнопку «Тест», появится сообщение «ПРИНЯТО» или «БЛОКИРОВАНО». Это уведомление сообщит вам, может ли Google сканировать вашу страницу или нет. Как правило, вы хотите видеть «ПРИНЯТО», если только вы не тестируете URL-адрес страницы, которую Google не должен сканировать и индексировать. Если какой-либо URL-адрес отображается как «БЛОКИРОВАННЫЙ», который вы не хотите блокировать, вам придется вернуться в файл robots.txt, внести изменения, сохранить их и попробовать снова протестировать URL-адрес.

Нужна помощь в редактировании файла robots.txt для WordPress?

Добавив файл robots. txt для WordPress, вы поможете Google более эффективно сканировать и индексировать ваш сайт, чтобы самые ценные страницы отображались в результатах поиска.

txt для WordPress, вы поможете Google более эффективно сканировать и индексировать ваш сайт, чтобы самые ценные страницы отображались в результатах поиска.

Но если вы не знаете, как добавлять, редактировать и тестировать файл robots.txt WordPress, вам может помочь WebFX. В нашей команде более 500 специалистов по маркетингу, которые знают, как оптимизировать файлы robots.txt. Мы не только можем помочь вам с этим, но и внедрить другие передовые методы SEO, от интеграции ключевых слов до создания контента.

Если вы готовы начать, свяжитесь с нами онлайн или позвоните нам сегодня по телефону 888-601-5359 , чтобы поговорить со стратегом о наших SEO-услугах WordPress!

WordPress Robots.txt и описание метадиректив роботов

Линдси Хэлси

Линдси Хэлси — соучредитель компании Pathfinder SEO. У нее более 10 лет опыта работы в области SEO с малым и крупным бизнесом. Линдси уделяет особое внимание обучению владельцев сайтов, фрилансеров и агентств тому, как найти их в Google с помощью пошагового подхода к SEO. Оставайтесь на связи в Твиттере — @linds_halsey.

Оставайтесь на связи в Твиттере — @linds_halsey.

Что такое файл robots.txt?

Прежде чем поисковые системы просканируют ваш веб-сайт, они проверяют инструкции в файле robots.txt. Robots.txt — очень мощный файл, поэтому будьте осторожны при его обновлении. Дважды проверьте, действительно ли вы сообщаете о своих намеченных целях.

Вы можете просмотреть файл robots.txt на странице www.mywebsite.com/robots.txt.

WordPress и Robots.txt

Разрабатываемые веб-сайты WordPress обычно используют файл robots.txt, чтобы запретить поисковым роботам индексировать веб-сайт. Код выглядит так:

User-agent: *

Disallow: /

«User-agent:», за которым следует звездочка, адресует все поисковые роботы. «Запретить:», за которым следует косая черта, указывает сканерам не индексировать никакие страницы на веб-сайте.

Чтобы обновить файл robots.txt, перейдите к настройкам чтения на своем веб-сайте WordPress. Когда вы будете готовы к тому, что поисковые системы и люди будут посещать ваш сайт, перейдите в «Настройки» > «Чтение» в меню слева и снимите флажок «Запретить поисковым системам индексировать этот сайт».

Тогда ваш файл robots.txt будет выглядеть так:

User-Agent: *

Disallow:

Мы рекомендуем очень чистый файл robots.txt, так как помимо его страниц поисковые системы также любят сканировать JavaScript вашего сайта. , CSS и Ajax.

Должен ли я добавить свою XML-карту сайта в файл robots.txt?

Вместо добавления XML-карты сайта в файл robots.txt отправьте ее непосредственно в консоль поиска Google и инструменты Bing для веб-мастеров.

Как обновить файл robots.txt в WordPress?

Самый простой способ обновить файл robots.txt в WordPress — плагин Yoast SEO.

- Войдите на свой сайт WordPress.

- В левой панели навигации выберите Yoast > Инструменты и щелкните Редактор файлов.

- Обновите файл robots.txt.

Что такое метадирективы robots?

Метадирективы роботов содержат четкие подробные инструкции о том, как поисковые системы должны сканировать и индексировать содержимое отдельной страницы.

Наиболее распространенные значения содержимого:

- Nofollow — не переходить по ссылкам в содержании страницы.

- Follow — переходите по ссылкам в содержании страницы.

- Noindex — Не индексировать страницу.

- Index – Проиндексируйте страницу, пожалуйста.

Если вы хотите исключить страницу из результатов поиска, но хотите, чтобы поисковые роботы переходили по ссылкам на этой странице, используйте:

Как добавить метадирективу robots в WordPress?

Yoast SEO упрощает обновление метадиректив роботов на уровне типа контента и таксономии.

- Войдите на свой веб-сайт WordPress и перейдите к плагину Yoast SEO в левой панели навигации.

- Выберите вид поиска.

- Чтобы изменить мета-директиву типа контента, переместите ползунок с «Да» на «Нет» в разделе «Показывать [тип контента] в результатах поиска?» раздел.

Например, данные платежных карт или личная информация могут быть скрыты с помощью правильной настройки robots.txt.

Например, данные платежных карт или личная информация могут быть скрыты с помощью правильной настройки robots.txt.