ТОП4 способа как создать Robots txt для WordPress

Хотите, чтобы поисковые системы корректно индексировали страницы и разделы вашего блога? Отличное решение — сделать правильный файл Robots txt для WordPress. Разберемся как и что в нем прописать.

Содержание

- Для чего нужен Robots.txt?

- Где лежит Robots?

- Не могу найти этот файл

- Из чего состоит robots.txt

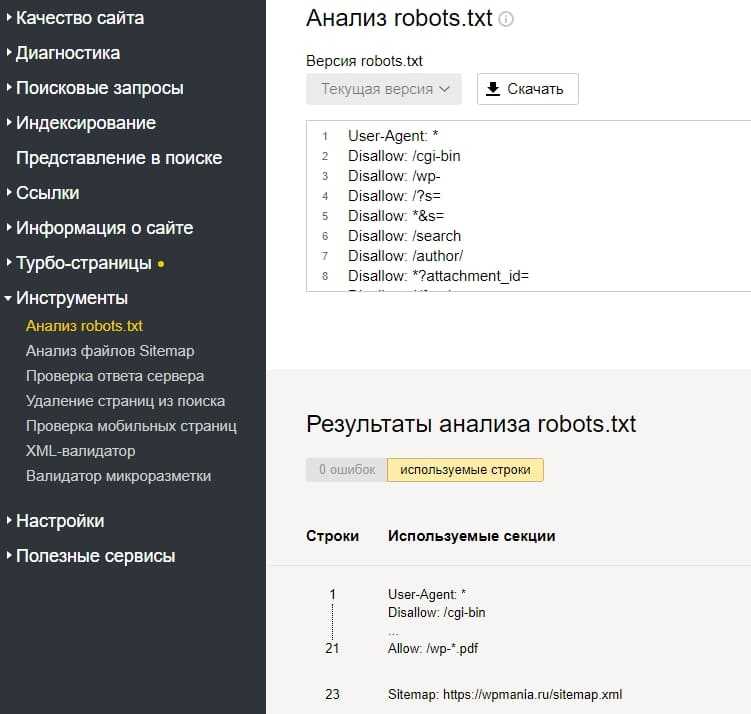

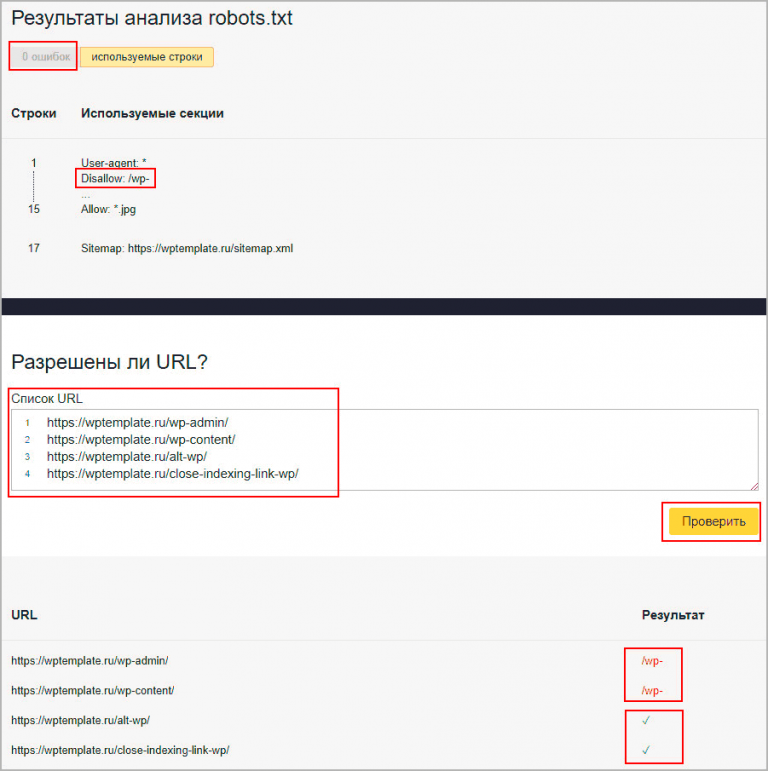

- Пример стандартного robots.txt для ВордПресс

- Как создать правильный robots.txt для сайта

- Вручную

- Clearfy Pro

- Yoast SEO

- All in One SEO Pack

- Настройка для интернет-магазинов на основе WooCommerce

Для чего нужен Robots.txt?

Он предназначен для поисковых систем, их роботов и правильной индексации. Директивы файла указывают, какие разделы сайта нужно выдавать в поиске, а какие скрыть. Это позволяет нацелить поисковик на попадание нужного контента в выдаче. Например, если человек в Google введет «как отремонтировать холодильник», то ему нужно показать инструкцию по ремонту, а не страницу регистрации или информацию о сайте.

Результат поисковой выдачи после изменений robots.txt вы заметите не сразу. Может пройти от недели до нескольких месяцев. Правильно будет его создать уже во время разработки сайта.

Где лежит Robots?

Это обычный текстовый файл, который располагается в корневой папке сайта и доступен по адресу

https://site.com/robots.txt

По умолчанию Роботс не создается. Его нужно создавать вручную или использовать инструменты, которые делают это автоматически. Разберем их ниже.

Не могу найти этот файл

Если по указанной выше ссылке файл доступен онлайн, но в корне сайта его нет, то это означает, что он создан виртуально. Для поисковой системы нет разницы. Главное, чтобы его содержимое можно было получить по адресу https://site.com/robots.txt.

Из чего состоит robots.txt

Имеет 4 основных директивы:

- User-agent — задает правила для поисковых роботов.

- Disalow — запрещает доступ.

- Allow — разрешает.

- Sitemap — полный путь (URL-адрес) XML-карты.

Пример стандартного robots.txt для ВордПресс

Вариаций этого файла много. На каждом сайте он может отличаться.

Вот пример рабочего Роботс. Посмотрим что означает каждая его строка и для чего нужна.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /license.txt

Disallow: /readme.html

Disallow: /trackback/

Disallow: /comments/feed/

Disallow: /*?replytocom

Disallow: */feed

Disallow: */rss

Disallow: /author/

Disallow: /?

Disallow: /*?

Disallow: /?s=

Disallow: *&s=

Disallow: /search

Disallow: *?attachment_id=

Allow: /*.css

Allow: /*.js

Allow: /wp-content/uploads/

Allow: /wp-content/themes/

Allow: /wp-content/plugins/

Sitemap: https://site. com/sitemap_index.xml

com/sitemap_index.xml

Первая строка говорит, что ссылки сайта могут обходить все поисковые роботы.

Строки с Disallow запрещают индексировать служебные папки и файлы, кэшированные страницы, страницы авторизации и регистрации, RSS (Feed), страницы авторов, поиска и вложений.

Директивы с Allow наоборот разрешают добавлять в индекс поисковиков скрипты, стили, файлы загрузок, тем и плагинов.

Последняя строка указывает на адрес карты XML.

По этому примеру вы можете составить свой Роботс, который будет «заточен» под ваш ресурс.

Идеального содержимого этого файла для всех сайтов не существует. Его всегда нужно формировать под конкретный ресурс.

Как создать правильный robots.txt для сайта

Есть несколько способов.

Вручную

Это можно сделать обычным ручным способом. Например, в Блокноте (если локальный сайт) или через FTP-клиент (на сервере хостинга).

Если вы не доверяете сторонним решениям и хотите все сделать самостоятельно, то наиболее подходящий вариант — создать файл в любом текстовом редакторе и скопировать его на сайт по FTP-протоколу.

Для передачи данных на хостинг можно воспользоваться довольно удобным FTP-клиентом FileZilla. Отметим, что файл robots.txt должен быть скопирован в корневой каталог вашего сайта (рядом с файлами wp-config.php, wp-settings.php).

После того, как файл будет создан и скопирован на хостинг, Вы, перейдя по адресу site.ru/robots.txt, сможете посмотреть его содержимое.

Также это можно сделать с помощью ВП-плагинов. Разберем лучшие.

Clearfy Pro

Виртуальный файл поможет создать премиум-плагин Clearfy Pro, который имеет целый набор функций для SEO и оптимизации сайта.

- Установите и активируйте расширение.

- Откройте админ-раздел Clearfy Pro.

- Перейдите на вкладку SEO.

- Активируйте опцию Создать правильный robots.txt.

- Заполните содержимое директивами.

- Нажмите кнопку Сохранить изменения.

Всегда можно отредактировать содержимое Robots. Просто измените/дополните его нужным содержимым и сохраните изменения.

Активировать промокод на 15%

Yoast SEO

Этот мощный СЕО-модуль для WP также корректно решит задачу.

- Откройте SEO > Инструменты.

- Кликните по Редактор файлов.

- Если этого файла в корне сайта нет, нажмите Создать файл robots.txt.

- Если существует, то откроется редактор, в котором можно вносить правки.

- Если изменили Роботс, кликните по кнопке ниже.

All in One SEO Pack

В этом популярном для поисковой оптимизации решении тоже есть инструменты чтобы создать/отредактировать Robots.

- После активации перейдите All in One SEO > Модули.

- Из списка выберите одноименное название модуля и нажмите Activate.

- Откройте All in One SEO > Robots.txt.

- С помощью полей добавьте директивы.

Настройка для интернет-магазинов на основе WooCommerce

Для WordPress-ресурсов с использованием этого расширения есть свои директивы. Просто добавьте их к своим.

Disallow: /cart/ Disallow: /checkout/ Disallow: /*add-to-cart=* Disallow: /my-account/

Файл robots.txt предназначен указания поисковым системам (роботам ПС), что на сайте можно выводить в поиске, а что нет. Поэтому от его корректного заполнения напрямую зависит трафик на вашем сайте.

Robots.txt для WordPress

Очищая свои файлы во время последнего редизайна, я понял, что прошло уже несколько лет когда я смотрел файл robots.txt. Я думаю что это не плохо, но когда все изменения структуры сайта и контента проходят через файл robots.txt — его надо смотреть чаще.

Robots.txt за 30 секунд

Во-первых, директива disallow запрещает доступ к определенным частям вашего сайта. А директива allow — разрешает доступ поисковых пауков к определенным файлам и директориям. Поэтому, в основном они используются для того, чтобы поисковые системы (Яндекс, Гугл) могли знать что индексировать а что не при посещении вашего сайта. Вы можете задать специфику индексации в Яндексе и Гугле, а также прописать карту сайта. Robots.txt — простой текстовый файл, но он обладает значительными полномочиями. И мы можем использовать его чтобы получить большое преимущество.

Robots.txt и WordPress

Сайт под управлением WordPress, где вы показываете роботам поисковых систем какие посты и страницы вашего сайта сканировать и индексировать, но не само ядро WP — файлы и каталоги. Также, вы можете быть спокойными что фиды (feeds) и трекбеки (trackbacks) не будут учитываться в результатах поиска. Это также хорошая практика, чтобы объявить здесь карту сайта. Вот хорошая отправная точка для вашей следующей сессии WP на основе robots.

Некоторые испытанные и надежные правила были удалены из robots.txt, чтобы удовлетворить новые требования Google, что все JavaScript и CSS файлы не блокируются:

Ко мне часто поступают вопросы про хостинг, которым я пользуюсь и поэтому решил указать хостинг в статье https://sprinthost.ru. Вы можете попробовать попользоваться хостингом 30 дней бесплатно. Чтобы понять, как будет работать Ваш сайт на этом хостинге просто перенести свой сайт (в этом поможет поддержка хостинга бесплатно) и и таким образом сможете понять подходит хостинг Вам или нет. На этом хостинге находятся сайты с 20 000 тысяч посещаемость и сайты чувствуют себя отлично. Рекомендую! Да, если делать оплату на 1 год то получаете скидку 25%. И что мне нравится — тех. поддержка всегда помогает в технических вопросах, за что им спасибо. Как Вы понимаете не всегда проходит всё гладко и нет желания, чтобы сайт не был доступен тем самым страдал трафик и доход.

Disallow: /wp-content/ Disallow: /wp-includes/

Это не может быть необходимым, разрешая доступ Гуглу и другим поисковикам к включающим в себя папки, которые содержат некоторые JS и CSS файлы, так что лучше перестраховаться. Видимо, Google настолько непреклонный в этом новом требовании, что он на самом деле наказывает сайты за их не соблюдение. Плохие новости для сотен тысяч владельцев сайтов, которые имеют более важные дела, чем идти в ногу с постоянными изменениями в Google. Обратите внимание, что это все-таки хорошо, чтобы заблокировать /wp-content/ и /wp-includes/ для других ботов — на момент написания этой статьи только Google требует доступ ко всем JS и CSS файлам.

Видимо, Google настолько непреклонный в этом новом требовании, что он на самом деле наказывает сайты за их не соблюдение. Плохие новости для сотен тысяч владельцев сайтов, которые имеют более важные дела, чем идти в ногу с постоянными изменениями в Google. Обратите внимание, что это все-таки хорошо, чтобы заблокировать /wp-content/ и /wp-includes/ для других ботов — на момент написания этой статьи только Google требует доступ ко всем JS и CSS файлам.

Тем не менее, вот новые и улучшенные правила robots.txt для WordPress:

User-agent: * Disallow: /wp-admin/ Disallow: /trackback/ Disallow: /xmlrpc.php Disallow: /feed/ Sitemap: https://zacompom.ru/sitemap.xml

Это технология «включай и работай», что вы можете настроить, чтобы соответствовать конкретной структуре сайта, а также в качестве собственной стратегии SEO. Чтобы использовать этот код для вашего сайта на WordPress, просто скопируйте и вставьте в пустой файл с именем robots.txt, расположенный в корневом каталоге сайта, например:

https://zacompom.ru/robots.txt

Если посмотреть на содержимое файла robots.txt для сайта zacompom.ru, вы заметите некоторые дополнительные директивы для роботов поисковых систем, которые используются, чтобы запретить доступ к индексированию некоторых плохих ботов. Давайте посмотрим:

User-agent: * Disallow: /wp-admin/ Disallow: /trackback/ Disallow: /xmlrpc.php Disallow: /blackhole/ Disallow: /mint/ Disallow: /feed/ Allow: /tag/mint/ Allow: /tag/feed/ Sitemap: https://zacompom.ru/sitemap.xml

Поисковые пауки не будут заходить в папку /wp-admin/, потому что это им запрещено. А также еще и в trackback, xmlrpc, и feed — они тоже закрыты для них. Затем я добавляю несколько разрешающих директив Allow, чтобы разблокировать доступ к определенным URL-адресам, которые в противном случае запрещены существующими правилами. Я также прописываю местоположение файла sitemap, просто чтобы сделать его доступным по этому адресу.

Ранее в robots.txt

Как я уже упоминал, мой первый файл robots. txt, был без изменений в течение нескольких лет (которые просто исчезли в мгновение ока), но они были достаточно эффективны, особенно совместимым с таким пауком как Googlebot. К сожалению, он содержит язык, что лишь немногие из более крупных поисковых систем его понимают (и, следовательно, подчиняются):

txt, был без изменений в течение нескольких лет (которые просто исчезли в мгновение ока), но они были достаточно эффективны, особенно совместимым с таким пауком как Googlebot. К сожалению, он содержит язык, что лишь немногие из более крупных поисковых систем его понимают (и, следовательно, подчиняются):

User-agent: * Disallow: /mint/ Disallow: /labs/ Disallow: /*/wp-* Disallow: /*/feed/* Disallow: /*/*?s=* Disallow: /*/*.js$ Disallow: /*/*.inc$ Disallow: /transfer/ Disallow: /*/cgi-bin/* Disallow: /*/blackhole/* Disallow: /*/trackback/* Disallow: /*/xmlrpc.php Allow: /*/20*/wp-* Allow: /press/feed/$ Allow: /press/tag/feed/$ Allow: /*/wp-content/online/* Sitemap: https://zacompom.ru/sitemap.xml User-agent: ia_archiver

Видимо, специальный символ в конце (знак доллара $) не распознается роботами, хотя как мне кажется Google понимает его.

Эти структуры может будут поддерживаться в будущем, но сейчас включать их впереди всех нет никаких оснований. Как в примерах приведенных выше, на основе сопоставления с шаблоном можно использовать без подстановочных знаков и знаков доллара ($) позволяет всех совместимых ботов понять Ваши предпочтения.

Юрич:

Занимаюсь созданием сайтов на WordPress более 6 лет. Ранее работал в нескольких веб-студиях и решил делиться своим опытом на данном сайте. Пишите комментарии, буду рад общению.

Шаблон файла Robots.txt для WordPress

Шаблон robots.txt для WordPress

Подробная инструкция

При неправильной настройке, сайт будет терять львиную долю трафика из-за неправильного индексирования, чего вам естественно не надо. Более ответственно подходите к настройке Robots.txt. ведь от этого зависит будет ли ваш сайт пробиваться топ или нет.

В этой статье я расскажу о том, как правильно настроить Robots.txt для WordPress. Помимо этого, поделюсь с вами вариантами, которые лично использую на своих проектах.

Время на чтение 2 минуты

522

0

Содержание

Robots.txt, что это такое? Подробнее о Clean-param Базовый вид Robots.txt для WP Вам будет интересно Расширенная версия Robots.txt. для WP Заключение

Robots.txt, что это такое?

Как говорилось выше, это ничто иное как текстовый файл с прописанными в нем правилами для поисковых систем. Обратите внимание, стандартный Robots.txt для WordPress выглядит именно так:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Вот в таком виде, плагин Yoast SEO создает файл. Многие пользователи ошибочно полагают, что этого вполне достаточно, возможно в каких-то случаях это работает. Но, мое мнение таково: если хочешь хороших показателей роста, стандартные приемы стоит забыть. Если ты со мной согласен, и считаешь что необходима детальная проработка файла, давай глубже разбираться в вопросе. Для начала, мы разберемся в основных директивах:

Но, мое мнение таково: если хочешь хороших показателей роста, стандартные приемы стоит забыть. Если ты со мной согласен, и считаешь что необходима детальная проработка файла, давай глубже разбираться в вопросе. Для начала, мы разберемся в основных директивах:

Как вы успели заметить, сложного здесь ничего нет.

| Директива | Значение | Пояснение |

|---|---|---|

| User-agent: | Yandex, Googlebot и т.д. | Указываем к какому работу обращаемся |

| Disallow: | Относительная ссылка | Выписываем ссылки, которые будут игнорироваться |

| Allow: | Относительная ссылка | Выписываем ссылки, которые будут проиндексированы |

| Sitemap: | Абсолютная ссылка | Указываем ссылки на XML-карту сайта. Если их не прописать в файле, то в дальнейшем придется добавлять карту в ручную через Яндекс.Вебмастер |

| Crawl-delay: | Время в секундах | Указываем таймаут между посещениями роботов. Это необходимо в тех Это необходимо в тех |

Как вы успели заметить, сложного здесь ничего нет.

Подробнее о Clean-param

Как правило, параметры используются в динамических сайтах. Проблема в том, что они могут дублироваться и передавать поисковым системам лишнюю информацию. Во избежании этого, как раз и прописывается директива Clean-param в Robots.txt.

Рассмотрим такой пример: site.ru/statia?uid=32 — site.ru/statia — это ссылка, а все что находится после знака “?” является параметром. В данном случае, uid=32 является динамическим параметром, это значит что он может принимать другое значения.

Например, uid=33, uid=34 и так далее. Закрываем индексацию, ведь этот параметр может меняться до бесконечности. Приводим директиву вот в такой вид:

Clean-param: uid /statia # все параметры uid для statia будут закрыты

Базовый вид Robots.txt для WP

Буквально на днях, я стал обладателем плагина Clearfy Pro, в котором есть огромное разнообразие функций. Сейчас мы рассмотрим одну из них, а именно, функции для создания идеального файла Robots.txt. На сколько же он идеален? Все очень просто, я не знаю! Нет однозначного ответа на этот вопрос.

Сейчас мы рассмотрим одну из них, а именно, функции для создания идеального файла Robots.txt. На сколько же он идеален? Все очень просто, я не знаю! Нет однозначного ответа на этот вопрос.

Люди делятся на два лагеря, одни делают более короткую версию, в которой прописывают правила для всех роботов сразу, другие же расписывают правила для каждого поисковика в отдельности.

Что из этого правильно а что нет, ответа также нет. Вы можете поделиться своими мыслями в комментариях. А сейчас, я вам дам для ознакомления базовую версию Robots.txt. для WordPress, которую я немного подредактировал. Я указал директиву Sitemap и удалил директиву Host.

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /xmlrpc.php

Disallow: /readme.html

Disallow: /*?

Disallow: /?s=

Allow: /*.css

Allow: /*.js

Sitemap: https://site.

ru/sitemap.xml

Не возьмусь утверждать, что это самый лучший вариант. Но, он однозначно лучше того, что предлагает нам Yoast SEO.

Вам будет интересно

Расширенная версия Robots.txt. для WP

Для вас наверняка не будет откровением то, что все сайты на WP имеют единую структуру. Этот факт, позволяет специалистам разрабатывать наиболее оптимальные варианты robots.

Я, не стал исключением. За долго подбирал для себя тот вид роботса, который мог бы полностью меня удовлетворить. И сейчас я хочу с вами им поделиться.

User-agent: * # Для всех поисковых систем, кроме Яндекса и Гугла

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.

php

Disallow: *utm=

Disallow: *openstat=

Disallow: /tag/ # Закрываем метки

Disallow: /readme.html # Закрываем бесполезный мануал по установке WordPress (лежит в корне)

Disallow: *?replytocom

Allow: */uploads

User-agent: GoogleBot # Для Гугла

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: *utm=

Disallow: *openstat=

Disallow: /tag/ # Закрываем метки

Disallow: /readme.html

Disallow: *?replytocom

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.

php

User-agent: Yandex # Для Яндекса

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: /tag/ # Закрываем метки

Disallow: /readme.html

Disallow: *?replytocom

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign

Clean-Param: openstat

Sitemap: https://site.com/sitemap_index.xml # Карта сайта, меняем site.com на нужный адрес.

Ранее, в Robots.txt. использовалась директива Host, которая указывала на главное зеркало сайта. Сейчас в этом нет нужды, так как это делается при помощи редиректа.

Сейчас в этом нет нужды, так как это делается при помощи редиректа.

Sitemap с протоколом https указывается по причине того, что большая часть сайтов использует защищенное соединение. Если у вас нет SSL, просто измените протокол на http.

Хочу заострить ваше внимание на том, что я закрываю теги, ведь они создают огромное количество дублей, что плохо сказывается на SEO. В том случае, если вы хотите их открыть, тогда вам необходимо удалить строку disallow: /tag/ из файла.

Заключение

Собственно, вы наглядно познакомились с тем, как выглядит Robots.txt. “здорового человека” для WP. Берите в пользование и ни в чем себе не отказывайте.

P.S. данный вариант подходит для стандартных информационных сайтов. В иных случаях, вам придется индивидуально прорабатывать файл.

Оцените статью

- 5

- 4

- 3

- 2

- 1

5

Нам очень важно знать ваше мнение,

чтобы писать о том что вам интересно.

Robots.txt в WordPress для SEO

Contents

Многие менеджеры веб-сайтов уделяют большое внимание поисковой оптимизации (SEO) из-за того, как работают поисковые системы. Поисковые системы отправляют ботов, известных как сканеры, для индексации веб-сайтов и передачи даты поисковой системе. На большинстве веб-сайтов есть возможность включить инструкции для этих поисковых роботов в текстовый файл, такой как Robots.txt в WordPress . Файл robots.txt предоставляет сканеру карту сайта и список любых разделов, которые не требуют индексации. Например, пустые страницы, поскольку они могут негативно повлиять на результаты обычного поиска. В следующем тексте вы узнаете все, что вам нужно знать о robots.txt в качестве администратора WordPress, SEO-менеджера или оператора сайта.

Использование файла Robots.

txt в WordPress

txt в WordPressБоты, которых поисковые системы регулярно отправляют на веб-сайты для поиска нового контента, известны под несколькими именами; сканеры, пауки или поисковые роботы. Включение файла robots.txt необходимо, потому что это один из немногих способов взаимодействия с этими ботами. Внедрение хорошо написанного файла robots.txt позволит вам указать ботам, где они должны индексировать в первую очередь. Это также поможет вам проинструктировать их об областях вашего сайта, которые не требуют индексации. Поскольку каждая поисковая система использует своих собственных ботов, вы можете дать конкретные инструкции каждой отдельной поисковой системе, если хотите. Это означает, что поисковые роботы из Google, Yahoo, Bing и других могут вести себя по-разному в соответствии с вашими инструкциями.

Местоположение robots.txt в WordPress

WordPress автоматически создает виртуальный файл robots.txt при первом создании веб-сайта. Кроме того, он добавляется к нему каждый раз, когда вы добавляете страницу или контент на свой сайт. Тем не менее, большинство администраторов WP и SEO-менеджеров сочтут свои собственные дополнения robots.txt очень полезными. Если вы создадите и добавите файл robots.txt в корневой каталог вашего сайта WordPress, он будет иметь приоритет над автоматически сгенерированным из WordPress. Чтобы проверить, использует ли ваш сайт файл robots.txt, просто добавьте /robots.txt в конец URL-адреса и нажмите клавишу ввода. Если на вашем сайте уже используется файл robots.txt, вы увидите инструкции, которые ваш сайт предоставляет ботам, пытающимся проиндексировать его для поисковых систем.

Тем не менее, большинство администраторов WP и SEO-менеджеров сочтут свои собственные дополнения robots.txt очень полезными. Если вы создадите и добавите файл robots.txt в корневой каталог вашего сайта WordPress, он будет иметь приоритет над автоматически сгенерированным из WordPress. Чтобы проверить, использует ли ваш сайт файл robots.txt, просто добавьте /robots.txt в конец URL-адреса и нажмите клавишу ввода. Если на вашем сайте уже используется файл robots.txt, вы увидите инструкции, которые ваш сайт предоставляет ботам, пытающимся проиндексировать его для поисковых систем.

Как редактировать файл robots.txt

Файл robots.txt очень легко редактировать с помощью любого текстового редактора. Если ваш текстовый редактор позволяет сохранить файл в формате .txt, вы можете использовать его для создания или внесения изменений в файл robots.txt. После того, как вы закончите редактирование файла robots.txt, вам нужно будет загрузить его в корневой каталог вашего сайта, перезаписав предыдущий. Открыв текстовый редактор, вы можете добавить любые строки и команды для поисковых роботов, которые будут полезны для вашего сайта. При изучении того, как работают файлы robots.txt, лучше всего использовать User-agent: он позволяет сканерам узнать, что инструкции предназначены для всех ботов поисковых систем.

Открыв текстовый редактор, вы можете добавить любые строки и команды для поисковых роботов, которые будут полезны для вашего сайта. При изучении того, как работают файлы robots.txt, лучше всего использовать User-agent: он позволяет сканерам узнать, что инструкции предназначены для всех ботов поисковых систем.

Robots.txt Команды

Сканеры поисковых систем прочитают ваш файл robots.txt и, таким образом, должны быть написаны строками кода. Ниже вы можете найти наиболее распространенные команды robots.txt для вашего файла.

- Вы должны начать свой .txt файл со строки User-agent: так как эта команда информирует бота о том, что вы даете ему инструкции.

- После User-agent: вы должны либо перечислить каждого бота по отдельности, либо использовать звездочку *, чтобы включить сразу всех ботов-сканеров.

- Разрешить: это команда, которая сообщает боту, где ему разрешено индексировать. Однако каждая страница автоматически разрешена.

Поэтому имеет больше смысла использовать другие команды, чтобы указывать ботам, куда идти.

Поэтому имеет больше смысла использовать другие команды, чтобы указывать ботам, куда идти.

- Запретить: Это очень удобная команда. Вы можете использовать эту команду, чтобы запретить ботам индексировать выбранные вами страницы.

- Карта сайта: эта команда предоставляет ботам местоположение вашей карты сайта для их использования.

Вы можете использовать эти команды для направления поисковых роботов по вашему веб-сайту. Следовательно, это поможет вам занять более высокое место на страницах результатов поисковых систем (SERP). Когда сканеры читают файл в соответствии со стандартным протоколом исключения роботов (REP), они читают файл построчно. Они также чувствительны к верхнему и нижнему регистру. Эта чувствительность к регистру является причиной того, что вы должны сохранять имя файла robots.txt полностью в нижнем регистре. Каждая строка файла .txt должна содержать только одну команду. Кроме того, команда allow имеет приоритет над командой disallow. Таким образом, вы можете запретить весь каталог, а затем использовать команду allow, чтобы бот проиндексировал одну страницу или подкаталог запрещенного пути к файлу.

Таким образом, вы можете запретить весь каталог, а затем использовать команду allow, чтобы бот проиндексировал одну страницу или подкаталог запрещенного пути к файлу.

Как оптимизировать Robots.txt в WordPress

Можно редактировать автоматически созданный файл robots.txt, который находится в файле wp-functions.php. Для редактирования этого файла вы можете использовать Notepad++. К сожалению, каждый раз, когда WordPress получает обновление, ваши изменения снова перезаписываются настройками по умолчанию. Вы можете сэкономить время, создав собственный файл robots.txt и сохранив его в корневом каталоге вашего домена. После того, как вы установили файл robots.txt в свой корневой каталог, он всегда имеет приоритет над автоматически созданным WordPress.

Файл robots.txt жизненно важен для управления поведением поисковых систем при сканировании и индексировании вашего сайта. При слишком сильном ограничении важный контент может не ранжироваться и вообще не отображаться в поисковой выдаче. И наоборот, если вы недостаточно ограничите сканеры, контент может быть проиндексирован более одного раза и понизит ваш рейтинг. Для WordPress также доступно множество плагинов, которые могут помочь вам создать файл через серверную часть WordPress.

И наоборот, если вы недостаточно ограничите сканеры, контент может быть проиндексирован более одного раза и понизит ваш рейтинг. Для WordPress также доступно множество плагинов, которые могут помочь вам создать файл через серверную часть WordPress.

Плагины WordPress

Вот два самых популярных плагина для файла robots.txt и других областей SEO.

Yoast SEO

Этот плагин поможет вам создать и отредактировать файл robots.txt в меню инструментов. Yoast — один из самых популярных и надежных плагинов для WordPress. У него есть функции, которые помогут повысить рейтинг вашего сайта в поисковой выдаче. Он может помочь вам в создании SEO-дружественного контента или помочь вам написать файлы robots.txt. Yoast SEO очень удобен для пользователя, и, поскольку он широко используется, есть много мест, где можно спросить совета о плагине у других пользователей.

Все в одном SEO

ПОСЛЕДНИЕ ПОСТЫ

Высокий рейтинг в результатах поиска необходим, если вы являетесь владельцем онлайн-бизнеса, веб-сайта или блога и хотите показать свое присутствие в Интернете. Вы…

Вы…

Поздравляем с 27 сентября, Международным днем SEO! Поздравляем всех SEO-специалистов с Днем SEO-специалистов, которые занимаются SEO (поисковая оптимизация), ens…

All in one SEO — это еще один плагин, который поможет вам в вашем путешествии по SEO. Ему доверяют более двух миллионов веб-сайтов, и он может помочь вам во всех аспектах SEO. Универсальный SEO-плагин имеет множество разнообразных функций, которые весьма полезны для улучшения SEO вашего сайта и повышения эффективности файла robots.txt.

Заключение

В общем, файл robots.txt легко найти и отредактировать в WordPress. Существует также множество плагинов, которые могут сделать это за вас, предоставляя при этом доступ к целому ряду других преимуществ SEO для вашего сайта. Надеюсь, вы узнали как о расположении robots.txt в WordPress, так и немного о поисковых роботах и поисковых роботах. Спасибо за чтение.

Часто задаваемые вопросы

Как запретить ботам индексировать мой сайт WordPress?

Вы можете запретить всем ботам индексировать ваш сайт с помощью следующих команд:

User-agent:*

Disallow: /

Эти строки предотвратят индексацию любой части вашего сайта любым поисковым роботом. Запретите ли вы определенные страницы или весь сайт, зависит от вас.

На каждом ли веб-сайте используется файл robots.txt?

Нет, не все сайты используют файл robots.txt для взаимодействия с поисковыми ботами. Однако, если у вас нет файла robots.txt, боты будут индексировать все, что может негативно повлиять на ваш рейтинг в органической поисковой системе.

Как файл robots.txt помогает поисковой оптимизации?

Использование файла robots. txt может значительно улучшить SEO вашего сайта, поскольку он позволяет скрыть любой раздел вашего сайта, который еще не оптимизирован для поисковых систем, тем самым повышая ваш рейтинг в органическом поиске. SEO жизненно важно для вашего сайта, чтобы его было легче найти с помощью поисковых систем, откуда генерируется подавляющее большинство всего веб-трафика.

txt может значительно улучшить SEO вашего сайта, поскольку он позволяет скрыть любой раздел вашего сайта, который еще не оптимизирован для поисковых систем, тем самым повышая ваш рейтинг в органическом поиске. SEO жизненно важно для вашего сайта, чтобы его было легче найти с помощью поисковых систем, откуда генерируется подавляющее большинство всего веб-трафика.

Нужно ли использовать файл robots.txt?

Вам не обязательно использовать файл robots.txt на своем сайте. Но есть очевидные преимущества использования этого файла для взаимодействия со сканерами и повышения индексации в поисковых системах.

Почему поисковые системы используют сканеры?

Поисковые системы используют сканеры для индексации веб-сайтов, потому что во всемирной паутине так много веб-сайтов, и им нужен способ упорядочивать их, когда пользователь что-то ищет. Индексируя ваш сайт, поисковая система получает файл, сообщающий ей об информации, содержащейся на вашем сайте, которую она использует для отображения вашего сайта пользователям, ищущим эту информацию.

Как оптимизировать ваш WordPress Robots.txt для SEO

В этом блоге мы узнаем несколько советов о том, как вы можете улучшить SEO вашего сайта, оптимизировав файл robts.txt.

На самом деле, файл Robots.txt играет важную роль с точки зрения SEO, потому что он сообщает поисковым системам, как можно сканировать ваш сайт. Именно по этой причине файлы Robot.txt считаются одним из самых мощных инструментов SEO.

Позже вы также узнаете, как строить и оптимизировать WordPress Robots.txt для SEO.

Что вы подразумеваете под файлом robots.txt?

Текстовый файл, созданный владельцами веб-сайтов, чтобы сообщить роботам поисковых систем о том, как они могут сканировать свой веб-сайт и индексировать страницы, известен как Robots.txt

На самом деле этот файл хранится в корневом каталоге. Этот каталог также называется основной папкой вашего сайта. Ниже указан формат файла robots.txt

Агент пользователя: [имя агента пользователя] Запретить: [строка URL не должна сканироваться] Агент пользователя: [имя агента пользователя] Разрешить: [строка URL для сканирования] Карта сайта: [URL вашего файла Sitemap в формате XML]

Чтобы разрешить или запретить определенные URL-адреса, у вас могут быть разные строки инструкций. Кроме того, вы также можете добавлять различные карты сайта. Боты поисковых систем будут считать, что им разрешено сканировать страницы, если разрешен URL-адрес.

Кроме того, вы также можете добавлять различные карты сайта. Боты поисковых систем будут считать, что им разрешено сканировать страницы, если разрешен URL-адрес.

Пример robots.txt приведен ниже

User-Agent: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Карта сайта: https://example.com/sitemap_index.xml

В приведенном выше примере мы разрешили сканировать страницы поисковым системам и получать индексные файлы в папке загрузок WordPress.

После этого мы запретили поисковым ботам сканировать и индексировать папки и плагины администратора WordPress.

Наконец, мы упомянули URL-адрес XML-карты сайта.

Требуется ли для вашего веб-сайта WordPress файл Robots.txt?

Поисковая система начнет сканировать и индексировать ваши страницы, даже если у вас нет текстового файла, например Robots.txt. Но, к сожалению, вы не можете сообщить своей поисковой системе, какую именно папку или страницу она должна сканировать.

Если вы только что создали веб-сайт или блог с меньшим количеством контента, это не принесет прибыли или не окажет никакого влияния.

Однако, как только вы настроите свой веб-сайт с большим количеством контента и он начнет расти, вам потребуется контроль над просканированными и проиндексированными страницами вашего веб-сайта.

Первая причина указана ниже

Для каждого веб-сайта у поисковых роботов есть квота сканирования.

Это явно означает, что во время сеанса обхода будет просканировано определенное количество страниц. Предположим, что сканирование на вашем веб-сайте осталось незавершенным, тогда оно вернется еще раз и возобновит сканирование в другом сеансе.

Из-за этого скорость индексации вашего сайта будет критической.

Вы можете решить эту проблему, запретив поисковым роботам сканировать такие страницы, которые не нужны. Некоторые неважные страницы могут включать в себя файлы плагинов, страницы администрирования WordPress и папки тем.

Квоту сканирования можно сохранить, запретив сканирование нежелательных страниц. Этот шаг будет более полезным, поскольку поисковые системы теперь будут сканировать страницы веб-сайта и смогут проиндексировать их как можно скорее.

Еще одна причина, по которой вам следует использовать и оптимизировать файл WordPress Robots.txt, приведена ниже.

Если вам нужно запретить поисковым системам индексировать страницы или сообщения на вашем сайте, вы можете использовать этот файл.

На самом деле, это один из самых неправильных способов скрыть содержимое вашего веб-сайта от широкой публики, но он окажется лучшей поддержкой для защиты их от появления в результатах поиска.

Как появляется файл robots.txt?

Очень простой файл robots.txt используется большинством популярных блогов. Контент может отличаться от требований конкретного веб-сайта.

Агент пользователя: * Запретить: Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml Файл robots.txt разрешает всем ботам индексировать любой контент и предлагать ссылки на веб-сайт карты сайта в формате XML. В файлах robots.txt упоминаются следующие правила, которым необходимо следовать. Пользовательский агент: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Запретить: /readme.html Запретить: /см./ Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml

Это укажет боту индексировать все файлы и изображения WordPress. Это не позволит поисковым ботам индексировать область администрирования WordPress, файлы плагинов WordPress, партнерские ссылки и файл readme WordPress.

В файлы robots.txt можно добавить карты сайта, которые помогут роботам Google распознавать все страницы вашего сайта.

Теперь вы знаете, как выглядит файл robots.txt, теперь мы узнаем, как можно создать файл robots.txt в WordPress.

Как в WordPress создать файл robots.

txt?

txt?Существует множество способов создать файл robots.txt в WordPress. Некоторые из лучших методов перечислены ниже, вы можете выбрать любой из них, который лучше всего подходит для вас.

Метод 1: Использование All-in-One SEO, изменение файла Robots.txt

All-in-One SEO — это самый известный плагин WordPress для SEO на рынке, который используется более чем на 1 миллионе веб-сайтов.

Плагин All in One SEO очень прост в использовании и поэтому предлагает генератор файлов robotx.txt. Также полезно оптимизировать WordPress Robots.txt

Если вы еще не интегрировали этот SEO-плагин, сначала установите и активируйте его с панели инструментов WordPress. Бесплатная версия также доступна для начинающих пользователей, чтобы они могли использовать ее функции, не вкладывая денег.

После активации плагина вы можете начать использовать его для создания или изменения файла robots.txt непосредственно из области администрирования WordPress.

Чтобы использовать

- Перейти на All-in-One SEO

- Теперь, чтобы отредактировать файл robots.

txt, нажмите на инструменты

txt, нажмите на инструменты - Теперь, нажав «включить пользовательский файл robots.txt», вы включите параметр редактирования

- В WordPress вы также можете создать собственный файл robots.txt с помощью этого переключателя.

- Теперь ваш существующий файл robots.txt будет отображаться плагином All in One SEO в разделе «Предварительный просмотр robots.txt». Это можно просмотреть в нижней части веб-экрана.

WordPress, правило по умолчанию, которое было добавлено, будет отображаться в этой версии

Правила по умолчанию, которые появляются, предлагают вашей поисковой системе, что им не нужно сканировать основные файлы WordPress, предлагают ссылку на веб-сайт карты сайта XML и разрешить ботам индексировать весь его контент.

Чтобы улучшить файл robots.txt для SEO, можно добавить новые собственные правила.

Добавить пользовательский агент в поле «Пользовательский агент», чтобы добавить правило. Правило будет применяться ко всем пользовательским агентам с помощью файла *.

Теперь выберите, хотите ли вы разрешить или запретить поисковой системе сканировать страницы.

Теперь добавьте путь к каталогу, имя файла в поле «Путь к каталогу».

К вашему файлу robots.txt правило будет применено автоматически. Нажмите кнопку «Добавить правило», чтобы добавить новое правило.

Если вы не создали идеальный формат robotx.txt, мы предлагаем вам добавить новые правила.

Пользовательские правила, добавленные вами, будут выглядеть так:

Чтобы сохранить изменения, не забудьте нажать «сохранить изменения»

Способ 2: Измените файл Robots.txt вручную с помощью FTP Другой способ оптимизации WordPress Robots.txt — использовать функции FTP-клиентов, чтобы начать изменение файла robots.txt

. Вам просто нужно подключиться к своей учетной записи хостинга WordPress с помощью FTP-клиента

После входа в корневую папку сайта вы сможете просмотреть файл robots.txt.

Если вы не можете его найти, значит у вас нет файла robots. txt

txt

В такой ситуации вам необходимо создать файл robot.txt.

Как упоминалось ранее, файл robots.txt обычно представляет собой простой текстовый файл, который можно загрузить на свой компьютер. Однако вы даже можете изменить его с помощью простого текстового редактора, такого как TextEdit, Блокнот или WordPad.

После внесения всех изменений пришло время их сохранить. Вы можете загрузить этот файл в корневую папку вашего сайта.

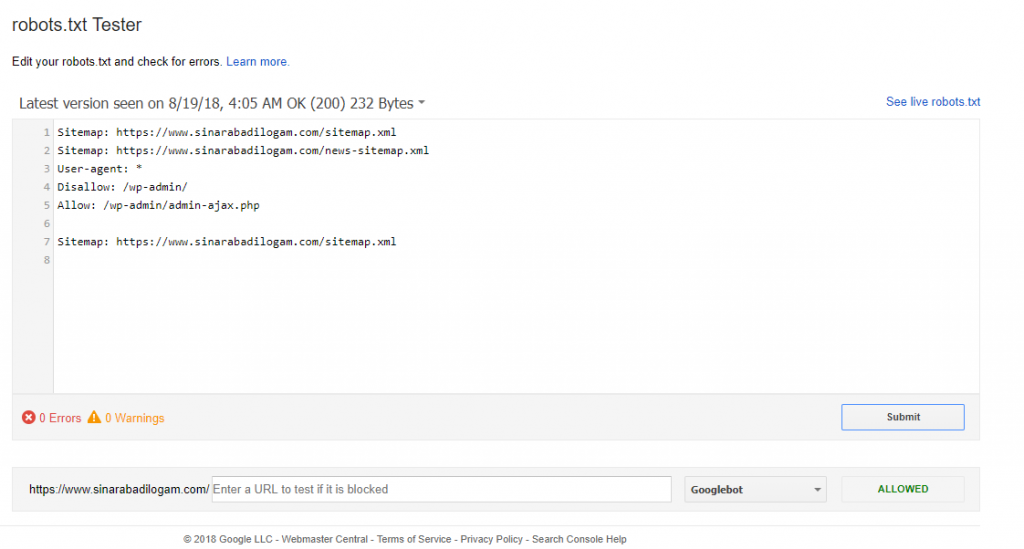

Как выполнить тестирование файла Robots.txt?

Вы можете выполнить тестирование с помощью инструмента для тестирования robots.txt.

В Интернете вы найдете множество инструментов для тестирования robots.txt. Одним из лучших является Google Search Console.

Для работы с этим инструментом сначала необходимо иметь веб-сайт, подключенный к поисковой консоли Google. После этого вы можете начать использовать его функции.

Из выпадающего списка вам просто нужно выбрать свою собственность.

Однако он автоматически выберет файл robots. txt вашего веб-сайта и выделит все предупреждения и ошибки. Это один из лучших инструментов, который поможет вам очень легко оптимизировать файл WordPress Robots.txt.

txt вашего веб-сайта и выделит все предупреждения и ошибки. Это один из лучших инструментов, который поможет вам очень легко оптимизировать файл WordPress Robots.txt.

Заключение:

Основной девиз оптимизации этого файла robots.txt — защитить страницы от сканирования страниц. Например, страницы в папке администратора WordPress или страницы в папке wp-plugin.

Самый распространенный миф заключается в том, что вы можете улучшить скорость сканирования, ускорить его индексацию и получить более высокий рейтинг, заблокировав категорию WordPress, страницы достижения и теги.

Но это не сработает, так как в соответствии с рекомендациями Google для веб-мастеров что-то пойдет не так.

Мы настоятельно рекомендуем вам прочитать и принять во внимание все пункты, упомянутые выше.

Мы надеемся, что этот блог поможет вам создать файл robots.txt в правильном формате для вашего веб-сайта. И это поможет вам оптимизировать WordPress Robots. txt.

txt.

О Шри Сообщения

Шри делится с нашими зрителями интересными темами WordPress, плагинами и другими новостями, связанными с WordPress. Он также время от времени публикует избранные интервью разработчиков WordPress.

Просмотреть все сообщения Шри Сообщения | Веб-сайт

Robots.txt — Видеоруководство по WordPress

Из курса: Техническое SEO для WordPress

Роботы.txt

“

— [Инструктор] На правильно настроенном веб-сайте должен быть файл robots.txt. И этот файл действительно важен, потому что он создает набор инструкций, которые используют поисковые роботы, когда они заходят на ваш сайт. И в этих инструкциях указано, что сканер должен сканировать, а что нет. По сути, он запрещает или разрешает определенное поведение. Чтобы показать вам файл robots.txt для Salt and Simple, я просто перейду по адресу saltandsimple.com/robots.txt. Все файлы robots.txt находятся в одном и том же месте назначения, и все они чувствительны к регистру, поэтому в файле robots. Вот файл robots.txt для Salt и Simple, и это набор директив по умолчанию, который предоставляет WordPress. Здесь говорится, что пользовательский агент, то есть часть программного обеспечения, которое сканирует веб-сайт, является звездочкой, что означает, что все пользовательские агенты должны следовать приведенной ниже директиве. И директива говорит, что вам не разрешено сканировать папку wp-admin. И это папка, которую мы используем для входа в систему и администрирования всего, что мы делаем в WordPress, поэтому имеет смысл, что мы не хотим, чтобы сканеры просматривали все эти URL-адреса. Однако в нем говорится, что вам разрешено посещать один конкретный URL-адрес в этой папке, admin-ajax.

И в этих инструкциях указано, что сканер должен сканировать, а что нет. По сути, он запрещает или разрешает определенное поведение. Чтобы показать вам файл robots.txt для Salt and Simple, я просто перейду по адресу saltandsimple.com/robots.txt. Все файлы robots.txt находятся в одном и том же месте назначения, и все они чувствительны к регистру, поэтому в файле robots. Вот файл robots.txt для Salt и Simple, и это набор директив по умолчанию, который предоставляет WordPress. Здесь говорится, что пользовательский агент, то есть часть программного обеспечения, которое сканирует веб-сайт, является звездочкой, что означает, что все пользовательские агенты должны следовать приведенной ниже директиве. И директива говорит, что вам не разрешено сканировать папку wp-admin. И это папка, которую мы используем для входа в систему и администрирования всего, что мы делаем в WordPress, поэтому имеет смысл, что мы не хотим, чтобы сканеры просматривали все эти URL-адреса. Однако в нем говорится, что вам разрешено посещать один конкретный URL-адрес в этой папке, admin-ajax. Теперь важно знать, что запрет страниц или подкаталогов не является функцией безопасности, это не помешает людям получить доступ к этому контенту. Это просто говорит роботам не тратить время на его сканирование. И это действительно важно, потому что у конкретного поискового робота, скажем, у Google, есть квота, выделенное время, которое он собирается посвятить сканированию вашего веб-сайта. И как только это время истекло, это сделано, и он уходит. Таким образом, если краулер тратит время на посещение контента, который никогда не будет иметь отношения к тому, что ищут люди, это контент, на который вы никогда не собираетесь направлять трафик, нет смысла заставлять Google или любой другой краулер посещать этот контент. содержание. Именно поэтому мы используем файл robots.txt. Мы используем его для предоставления директив, инструкций, которым должен следовать сканер. Теперь вы также заметите, что в файле robots.txt мы предоставляем карту сайта, и эта карта сайта будет содержать список всех страниц, которые веб-сайт хочет просканировать.

Теперь важно знать, что запрет страниц или подкаталогов не является функцией безопасности, это не помешает людям получить доступ к этому контенту. Это просто говорит роботам не тратить время на его сканирование. И это действительно важно, потому что у конкретного поискового робота, скажем, у Google, есть квота, выделенное время, которое он собирается посвятить сканированию вашего веб-сайта. И как только это время истекло, это сделано, и он уходит. Таким образом, если краулер тратит время на посещение контента, который никогда не будет иметь отношения к тому, что ищут люди, это контент, на который вы никогда не собираетесь направлять трафик, нет смысла заставлять Google или любой другой краулер посещать этот контент. содержание. Именно поэтому мы используем файл robots.txt. Мы используем его для предоставления директив, инструкций, которым должен следовать сканер. Теперь вы также заметите, что в файле robots.txt мы предоставляем карту сайта, и эта карта сайта будет содержать список всех страниц, которые веб-сайт хочет просканировать. Давайте подробнее рассмотрим некоторые примеры файлов robots.txt и рассмотрим их вместе. Итак, я здесь, в текстовом редакторе Sublime, и создал несколько примеров директив robots.txt. Итак, для начала у вас всегда будет пользовательский агент: а затем пользовательский агент, которым вы управляете. Вы можете определить конкретный пользовательский агент, такой как Googlebot, msnbot и т. д., и если вы просто выполните поиск в Google для пользовательских агентов, вы найдете большое количество доступных агентов. Теперь, когда вы конкретно разговариваете с конкретным пользовательским агентом, вы, вероятно, уже знаете, почему и что вы там делаете. Для многих крупных сайтов они будут предоставлять разные директивы сканерам, выполняющим сканирование для показа рекламы, а не, скажем, Google, и именно здесь вы часто захотите провести различие между двумя пользовательскими агентами. Вы хотите, чтобы Google имел доступ ко всему контенту, имеющему отношение к ним, но ваши рекламные объявления могут показываться на каждом фрагменте контента, и вы хотите, чтобы у поискового робота был неограниченный доступ к определенным областям веб-сайта.

Давайте подробнее рассмотрим некоторые примеры файлов robots.txt и рассмотрим их вместе. Итак, я здесь, в текстовом редакторе Sublime, и создал несколько примеров директив robots.txt. Итак, для начала у вас всегда будет пользовательский агент: а затем пользовательский агент, которым вы управляете. Вы можете определить конкретный пользовательский агент, такой как Googlebot, msnbot и т. д., и если вы просто выполните поиск в Google для пользовательских агентов, вы найдете большое количество доступных агентов. Теперь, когда вы конкретно разговариваете с конкретным пользовательским агентом, вы, вероятно, уже знаете, почему и что вы там делаете. Для многих крупных сайтов они будут предоставлять разные директивы сканерам, выполняющим сканирование для показа рекламы, а не, скажем, Google, и именно здесь вы часто захотите провести различие между двумя пользовательскими агентами. Вы хотите, чтобы Google имел доступ ко всему контенту, имеющему отношение к ним, но ваши рекламные объявления могут показываться на каждом фрагменте контента, и вы хотите, чтобы у поискового робота был неограниченный доступ к определенным областям веб-сайта. Итак, у нас есть Disallow, а затем строка, которую вы не хотите сканировать. По умолчанию все, что не находится в списке запрещенных, разрешено, поэтому нам не нужно явно вызывать разрешение. Итак, вот пример, строки с пятой по седьмую, это то, что вы увидите, если заблокируете все поисковые роботы для всего контента, и эта проблема возникает довольно часто. Если вы обнаружите, что ваш сайт не индексируется Google, вам нужно проверить, содержит ли ваш файл robots.txt эту директиву. Это говорит о том, что вы не хотите, чтобы что-либо сканировалось. Вы, вероятно, видите это на веб-сайтах разработки, поэтому, если у вас есть staging.yoursite.com, вы запретите сканирование. И если этот файл robots.txt случайно будет реплицирован на ваш рабочий сайт, у вас возникнут проблемы. Еще один очень распространенный способ использования файла robots.txt «из коробки» — просто предоставить каждому пользовательскому агенту возможность сканировать весь сайт, а запретить оставить пустым. Вы укажете местоположение на своей карте сайта с помощью Sitemap:, а затем URL-адрес этой карты сайта, как правило, /sitemap.

Итак, у нас есть Disallow, а затем строка, которую вы не хотите сканировать. По умолчанию все, что не находится в списке запрещенных, разрешено, поэтому нам не нужно явно вызывать разрешение. Итак, вот пример, строки с пятой по седьмую, это то, что вы увидите, если заблокируете все поисковые роботы для всего контента, и эта проблема возникает довольно часто. Если вы обнаружите, что ваш сайт не индексируется Google, вам нужно проверить, содержит ли ваш файл robots.txt эту директиву. Это говорит о том, что вы не хотите, чтобы что-либо сканировалось. Вы, вероятно, видите это на веб-сайтах разработки, поэтому, если у вас есть staging.yoursite.com, вы запретите сканирование. И если этот файл robots.txt случайно будет реплицирован на ваш рабочий сайт, у вас возникнут проблемы. Еще один очень распространенный способ использования файла robots.txt «из коробки» — просто предоставить каждому пользовательскому агенту возможность сканировать весь сайт, а запретить оставить пустым. Вы укажете местоположение на своей карте сайта с помощью Sitemap:, а затем URL-адрес этой карты сайта, как правило, /sitemap. xml. Теперь важно сохранить чувствительность к регистру и пробел после двоеточия. Теперь одна из самых распространенных ошибок, с которыми я сталкиваюсь при просмотре файла robots.txt, заключается в предоставлении нескольких директив пользовательскому агенту одновременно. Итак, предположим, что у нас были директивы для msnbot и Googlebot, и они были идентичными директивами, поэтому мы просто складываем пользовательские агенты, User Agent A, User Agent B, Disallow path, Disallow path3. На самом деле это может создать некоторые сценарии, которые запутают сканер. Возможно, мы хотели, чтобы пользовательский агент B запрещал только path3, а пользовательский агент A — только path. В этом случае может быть, что пользовательский агент A запрещает только оба, или пользовательский агент B запрещает оба, или ряд других способов, которые могут быть неправильно интерпретированы. Видите ли, сканеры не всегда самые умные, они следуют очень элементарному набору правил. Таким образом, лучший способ справиться с этим — всегда разговаривать с одним пользовательским агентом за раз.

xml. Теперь важно сохранить чувствительность к регистру и пробел после двоеточия. Теперь одна из самых распространенных ошибок, с которыми я сталкиваюсь при просмотре файла robots.txt, заключается в предоставлении нескольких директив пользовательскому агенту одновременно. Итак, предположим, что у нас были директивы для msnbot и Googlebot, и они были идентичными директивами, поэтому мы просто складываем пользовательские агенты, User Agent A, User Agent B, Disallow path, Disallow path3. На самом деле это может создать некоторые сценарии, которые запутают сканер. Возможно, мы хотели, чтобы пользовательский агент B запрещал только path3, а пользовательский агент A — только path. В этом случае может быть, что пользовательский агент A запрещает только оба, или пользовательский агент B запрещает оба, или ряд других способов, которые могут быть неправильно интерпретированы. Видите ли, сканеры не всегда самые умные, они следуют очень элементарному набору правил. Таким образом, лучший способ справиться с этим — всегда разговаривать с одним пользовательским агентом за раз.