Профилирование кода на C/С++ в *nix-системах / Хабр

Отличный обзорный доклад конференции HighLoad++ 2016 о том, как надо проводить профилирование программного кода. О типичных ошибках, происходящих при измерениях. И, конечно, об инструментах:

— gettimeofday

— strace, ltrace, truss

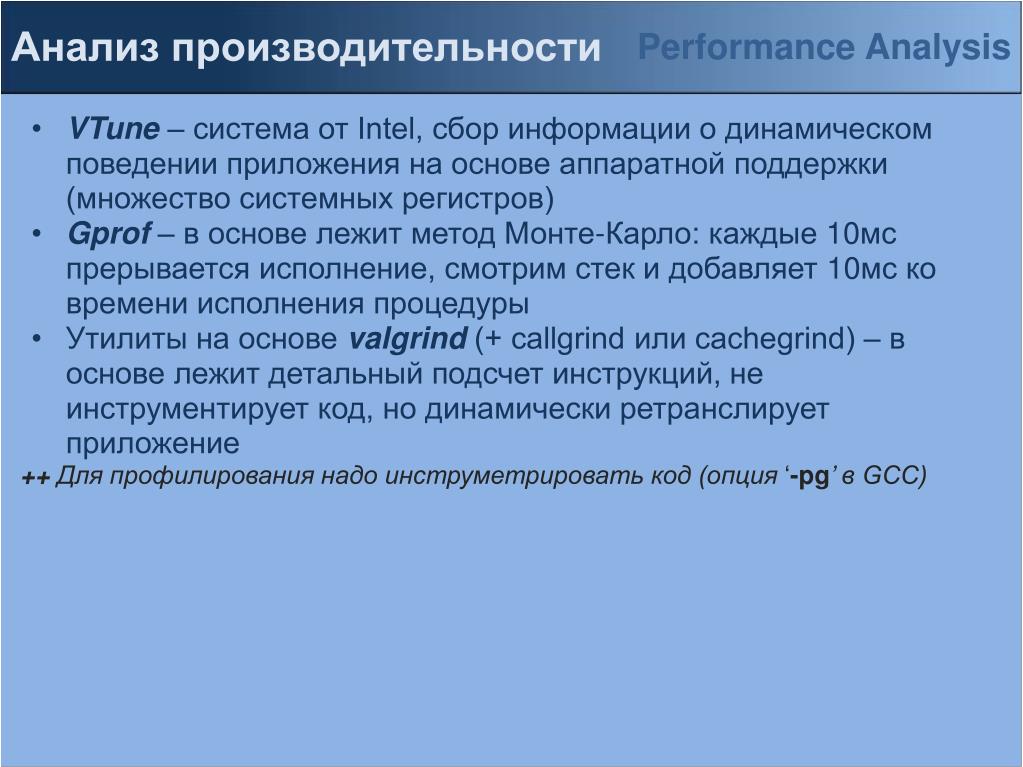

— gprof

— gdb / lldb

— perf

— pmcstat

— SystemTap

— DTrace

— HeapTrack

— BPF / bcc

В начале у меня будет не слишком техническая часть, о том, как не надо делать benchmark’и.

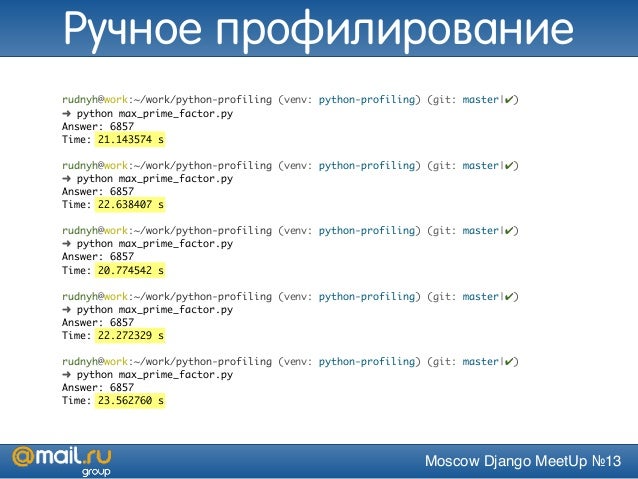

Я наблюдаю, что люди часто делают типичные ошибки, когда делают benchmark’и. И вот первая из них…

Если вы не знаете, то у всех докладчиков HighLoad++ проходит суровый коучинг, многократный, по разным векторам. Один коучинг обязательный, остальные — опциональные. Опциональный коучинг — это как побороть боязнь сцены, например. То есть очень суровый подход к организации всего этого дела.И когда я подавал доклад на HighLoad++, организаторы предложили убрать всю эту техническую часть и добавить больше кулстори, красивых скриншотов и так далее. А те, кому интересно, как это запустить, какие команды набрать, могут обратиться к документации — и вот поэтому — ссылка на мой бложик, потому что все там есть. Если вас интересует, к примеру, как SystemTap сложно собирается на Linux, то открываем ссылку на блог и там будет прямо все. А в этом докладе будет скорее такой обзор, чтобы вы представляли, какие инструменты вообще есть, что они дают и когда какой использовать.

В начале у меня будет не слишком техническая часть, о том, как не надо делать benchmark’и.

Я наблюдаю, что люди часто делают типичные ошибки, когда делают benchmark’и.

- Во-первых, это неповторяемость. Когда вы открываете какой-нибудь бложик, и там такая классная статья, что мы «померяли что-то, получили такие красивые графики, и наше решение, которое стоит так, делает это в 500 раз быстрее».

При этом не приводится никаких данных для повторения этого эксперимента, никаких скриптов и ничего. Ну, это хреновый benchmark, и нужно это сразу страницу закрыть. Если вы не можете его повторить, как можно ему верить?

При этом не приводится никаких данных для повторения этого эксперимента, никаких скриптов и ничего. Ну, это хреновый benchmark, и нужно это сразу страницу закрыть. Если вы не можете его повторить, как можно ему верить?

Вы должны хотя бы примерно такие же результаты мочь воспроизвести.

- Вы измеряете не то, что думаете. Типичный пример: мы хотим померить, как у нас жесткий диск работает. Мы весело набираем dd if что-нибудь куда-нибудь. Пишем в диск и меряем, а как быстро он, собственно, пишет. Кто-нибудь из зала может сказать, почему это не измерение скорости диска?

Правильно — потому что на самом деле вы померяли скорость, с которой у вас кэш файловой системы работает. Как это обойти — это тоже интереснаяпроблема.

- Взятие среднего. Это меня всегда бесило на наших митингах, и я вижу в первом ряду слушателя, который меня понимает. Нам нужно понимать, как быстро мы отвечаем пользователю на запросы — давайте построим график среднего времени ответа.

- Кто будет бенчмаркать бенчмарки? Это такая проблема. Например, вы написали клевый тест, который меряет, сколько ответов в секунду генерит ваше приложение. Померили, получили, скажем, 4000 запросов в секунду. Думаете: «Как-то маловато, надо оптимайзить». Проблема в том, что ваш benchmark однопоточный. А под реальной нагрузкой ваше приложение работает в сотнях, в тысячи потоков. И, собственно, вы не учли, что ваш собственный benchmark — это bottleneck в данном случае. Это нужно понимать.

- Отсутствие анализа. Это когда вы померяли, говорите: «Что-то тупит, надо все отрефачить, все переписать». То есть нужно понимать, почему оно тупит.

- Игнорирование ошибок. Опять же, вернемся к примеру с вашим бенчмарком. Допустим, это не ваш benchmark, это A/B, и вы его натравили на свой сервис, померили, получили 5 млн. запросов в секунду и радуетесь: «У нас все очень быстро». Но вы не посмотрели, что все это ответы 404, например. То есть нужно ошибки тоже высчитывать.

- Неправильные настройки. В моей сфере, в базах данных, это частая проблема, потому что настройки Postgres по умолчанию предполагают, что вы пытаетесь запустить его на микроволновке. Сейчас сервера мощные, поэтому все настройки по умолчанию надо очень сильно менять. Побольше шарить buffers, побольше work_mem. И понимать, что эти настройки делают. Если вы видите бенчмарк, даже с данными, на которых тестировалось, и даже со скриптами, но там сказано, что «мы тестировали с настройками по умолчанию» — по умолчанию MongoDB и Postgres — все, можно закрывать.

- Нетипичная нагрузка. У вас 90% времени что-то читает, 10% что-то пишет, а вы решили: напишем benchmark, который фифти/фифти — и так, и так делает. Зачем такое тестировать? То есть вы что-то соптимизируете, просто это вам в продакте не сильно поможет.

- Маркетинг и подгон. Тут у меня есть небольшая кулстори. Я достоверно знаю, что были лет …дцать назад такие производители железа, которые знали бенчмарки, по которым некий журнал тестирует компьютеры. Они свое железо собирали так, чтобы на этих бенчмарках выглядело хорошо. В результате все очень здорово продавалось. Это первый способ подгона.

То есть нужно понимать, что это существует, это не иллюзорная вещь.

- Ну, и другие свойства. Близкий мне пример: Oracle против Postgres — что быстрее? Может быть, Oracle быстрее в 10 раз, но он и стоит как не в себя. Это надо тоже учитывать. А, может, и нет — я не бенчмаркал Oracle ни разу и вообще его никогда не видел, если честно.

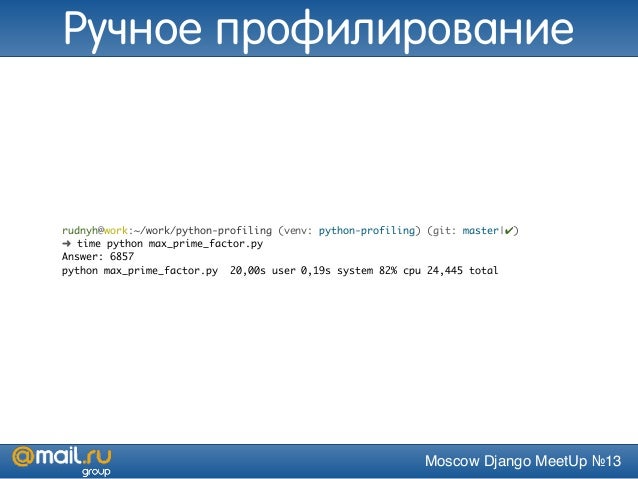

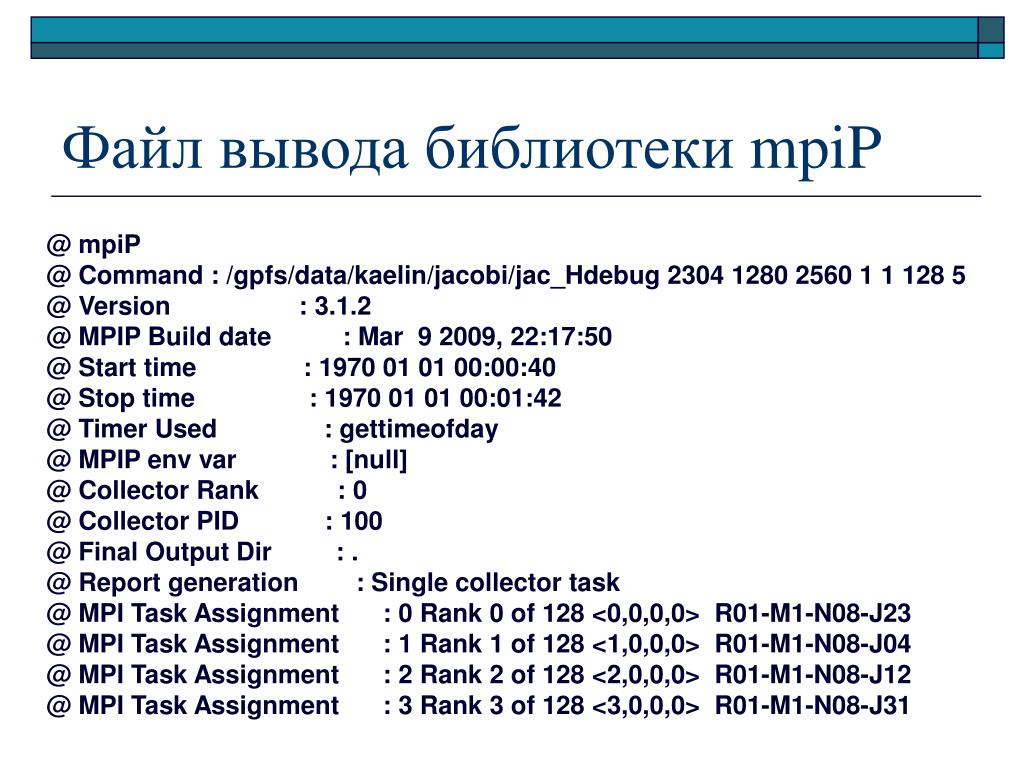

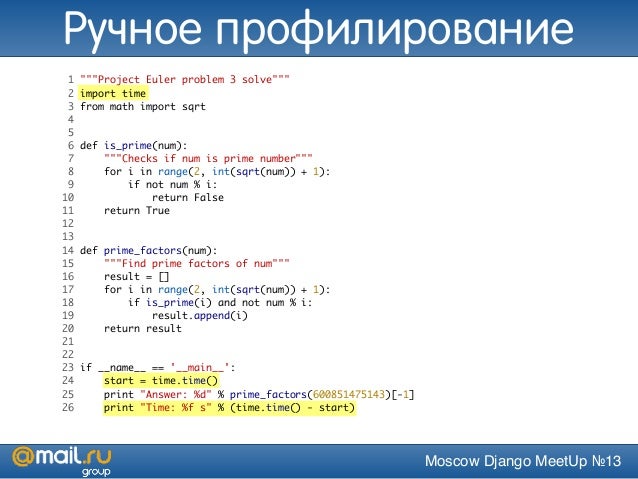

Для создания полноты картины начну с того, как не надо бенчмаркать код. Самый простой способ — gettimeofday(). Дедовский метод, когда у нас есть кусочек кода, мы хотим узнать, насколько он быстрый или медленный — мы померили время в начале, выполнили код, померили время в конце, посчитали дельту и сделали вывод, что код выполняется столько времени.

На самом деле не самый идиотский способ, он удобен, например, когда у вас этот код  По сути, у вас есть страница в ядре, которая мапится в адресное пространство всех процессов, и ваш gettimeofday() превращается в обращение к оперативной памяти, никакого syscall’а не происходит.

По сути, у вас есть страница в ядре, которая мапится в адресное пространство всех процессов, и ваш gettimeofday() превращается в обращение к оперативной памяти, никакого syscall’а не происходит.

Не стоит его использовать, несмотря на то, что он дешевый, если вы делаете что-то со спинлоками. Потому что спинлоки сами по себе довольно быстро работают. То есть то, что вы меряете, должно хотя бы миллисекунды выполняться, иначе у вас погрешность будет на уровне измерений.

Инструменты, такие как strace, ltrace, truss — прикольные инструменты, у них есть флажок -с, который показывает, сколько времени у вас какие syscall’ы выполнялись. Ну, ltrace измеряет библиотечные процедуры, а strace — syscall’ы, но тоже, в принципе, могут быть удобны где-то в каких-то задачах. Не могу сказать, что я этим часто пользуюсь.

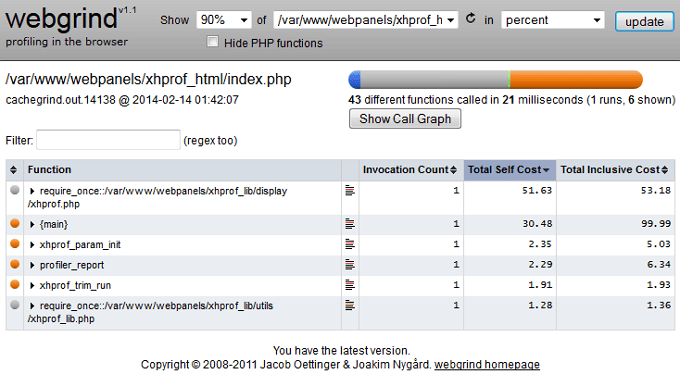

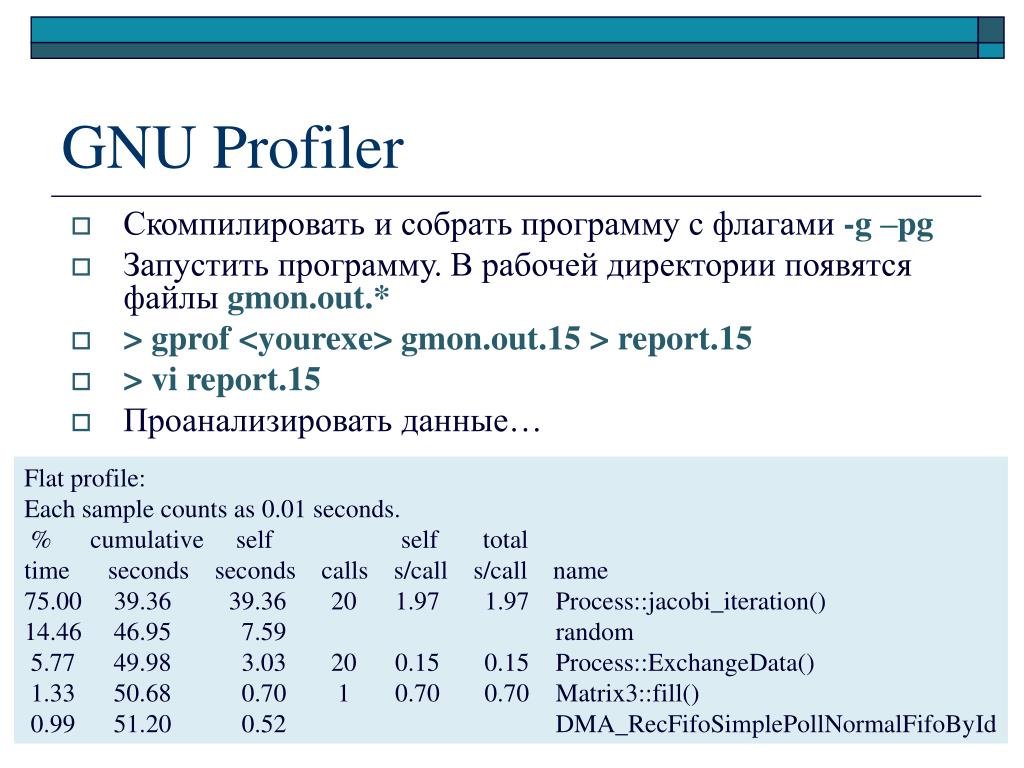

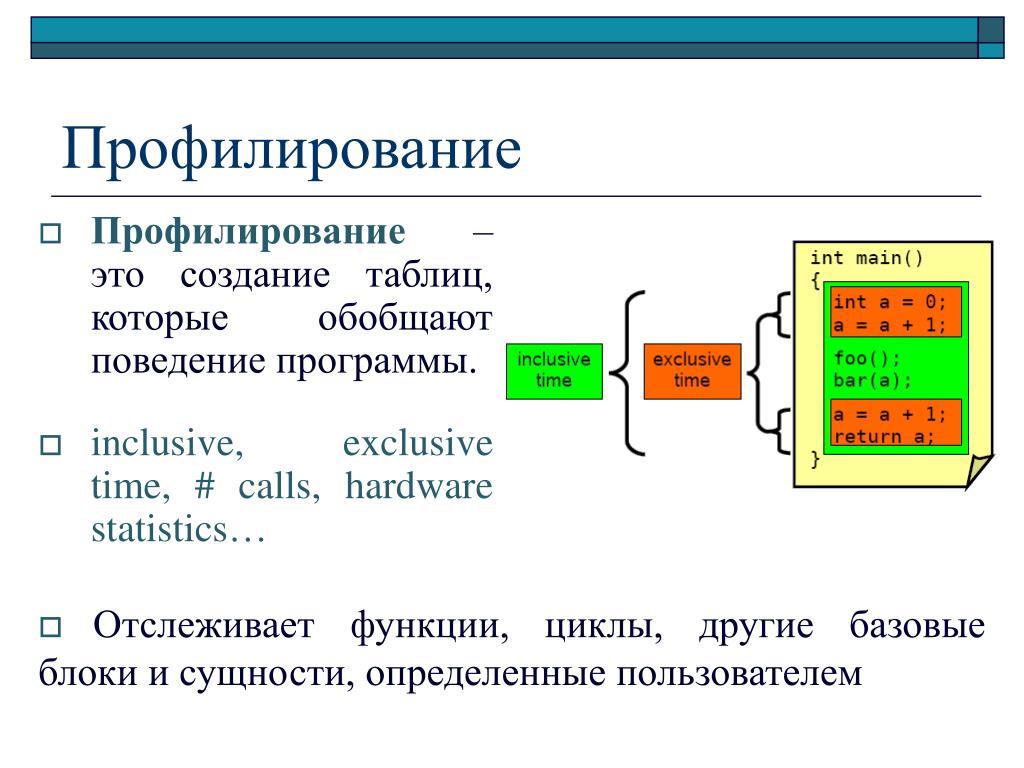

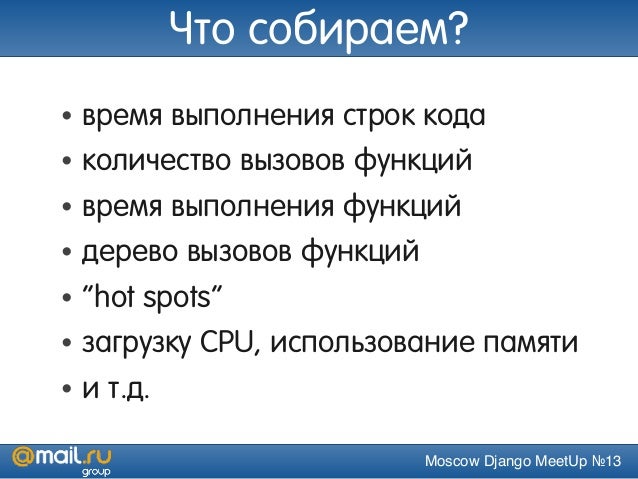

Gprof, есть такой прикольный инструмент, на слайде приводится пример его текстового отчета. Тоже понятно — вот у нас есть процедуры в программе, вот столько раз они были вызваны, столько времени это в процентах выполнялось.

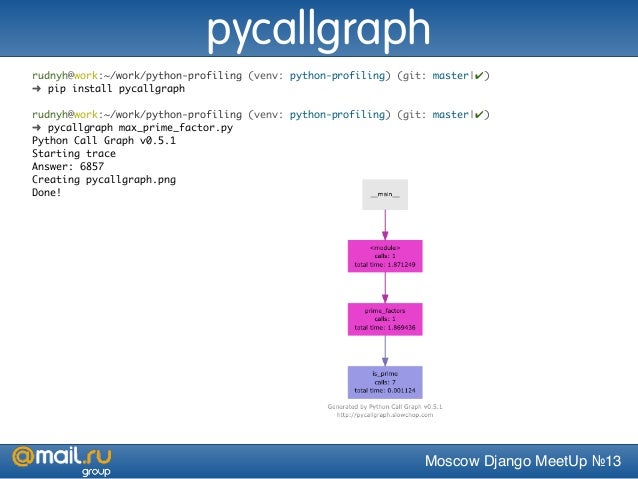

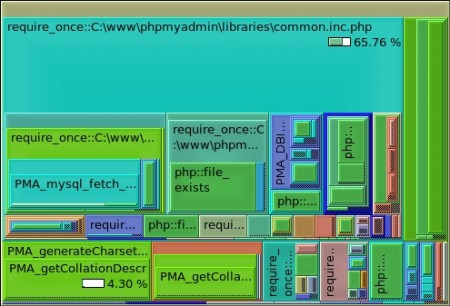

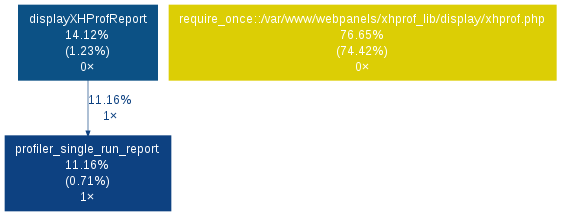

С помощью gprof еще можно генерировать такие картинки:

Это, скорее, пример того, как не надо делать. Запомните эту картинку, здесь 6 квадратиков. Обратите внимание, как много места они занимают, тут имена процедур, над стрелками все время что-то написано, ничего не понятно — очень много места занимает. Мы увидим намного более наглядные отчеты, чем этот. Но, в принципе, красивая картинка, можно начальству показать, понтануться.

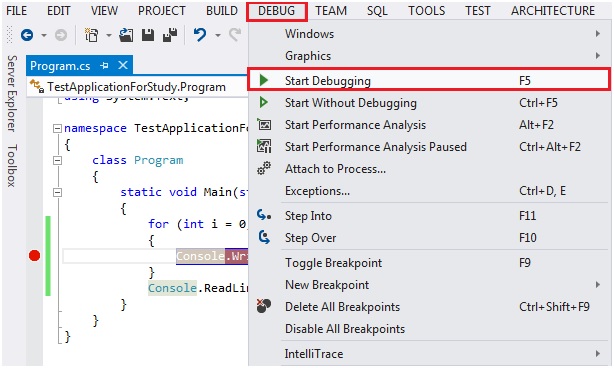

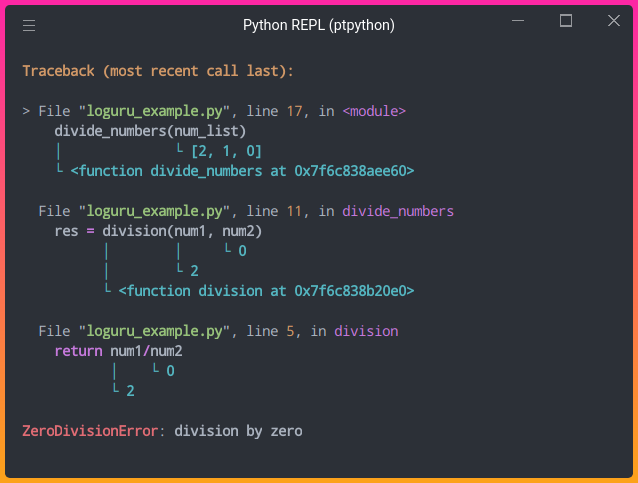

Отладчики. На самом деле, это уже пример инструментов, которые приходится использовать на практике при профайлинге, потому что у них есть клевые свойства выполнять команды batch’ем и можно написать в этот набор batch-команд (bt) получение бэктрейса. Это очень удобно при отладке lock contention, когда у вас происходит борьба за локи.

http://habr.ru/p/310372/

Здесь у меня есть небольшая кулстори. Это, по-моему, был самый первый патч, который я написал для Postgres. Или второй, не помню. У Postgres есть своя реализация хэш-таблиц, сильно заточенных под задачи Postgres. И она, в том числе, может быть создана с такими флагами, чтобы использоваться разными процессами. Пришел клиент с проблемой, что «вот у меня на таких-то запросах, в такой-то схеме все тупит, помогите». Интересно, что сначала с помощью приема с бэктрейсом это выглядело так, что вы запускаете gdb 10 раз, в 5 случаях у вас бэктрейс висит на взятии лока, а еще в половине случаев — на чем-то другом, то есть явно у вас процесс часто висит на локе, что-то не так.

Или второй, не помню. У Postgres есть своя реализация хэш-таблиц, сильно заточенных под задачи Postgres. И она, в том числе, может быть создана с такими флагами, чтобы использоваться разными процессами. Пришел клиент с проблемой, что «вот у меня на таких-то запросах, в такой-то схеме все тупит, помогите». Интересно, что сначала с помощью приема с бэктрейсом это выглядело так, что вы запускаете gdb 10 раз, в 5 случаях у вас бэктрейс висит на взятии лока, а еще в половине случаев — на чем-то другом, то есть явно у вас процесс часто висит на локе, что-то не так.

Кстати, мы выложили в открытый доступ видеозаписи последних пяти лет конференции разработчиков высоконагруженных систем HighLoad++. Смотрите, изучайте, делитесь и подписывайтесь на канал YouTube.

По бэктрейсу удалось найти, что это за код такой, который то берет, то освобождает лок. Это долгая история, можете по ссылке прочитать статью на Хабре. Там же есть ссылка на обсуждение в hackers, где есть технические детали.

На слайде выше — кусочек кода, между взятием и освобождением лока, он в свою очередь там проваливался куда-то в dynahash, где крутился на взятии спинлока. Это удалось с помощью отладчиков найти, исправить, предложить патч. И тот спинлок, который в dynahash (это хэш-табличка в Postgres), превратили в 8 или 16 спинлоков, которые при определенных условиях берутся разные. Удалось его пошардить и это уже есть в 9.6.

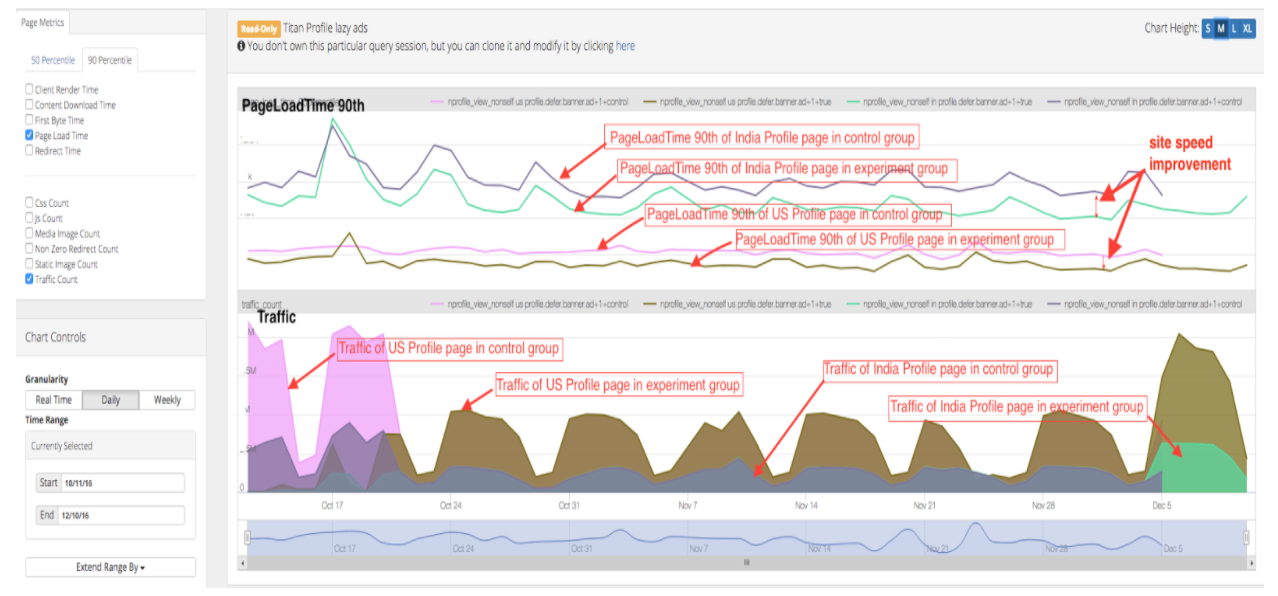

Perf — замечательный инструмент, потому что perf top показывает топ процедур. В данном случае в указанном процессе, сколько времени они выполняются. Вверху мы видим 30%, 20% и мы видим ResourceOwner — это неспроста в именах процедур, потому что следующая кулстори тоже про реальный патч.

Пришел клиент, сказал: «У меня такие запросы и такая схема. Все тупит. Что делать?». Начали отладку. А у него энтерпрайзное приложение, у него есть таблицы, тысяча дочерних таблиц (в Postgres, если кто не знает, есть наследование таблиц). И с помошью perf top мы видим, что в ResourceOwner все тупит. ResourceOwner — это такой объект (насколько слово объект применимо для языка С), который хранит в себе разные ресурсы, файлы, шареную память и что-то еще. И он написан в предположении, что обычно мы ресурсы выделяем и кладем в массив, а освобождаем в обратном порядке. Поэтому при удалении ресурсов, он начинает их искать с конца. Размер массива он знает, ну, в смысле — у него есть индекс последнего элемента. Оказалось, что это условие выполняется не всегда и ему приходится во все стороны искать по этому массиву, поэтому он тупит. Патч заключается в том, что при определенном количестве ресурсов (около 16 или число порядка этого) этот массив превращается в хэш-таблицу. Когда вы конфликт разрешаете, вы по хэшу пришли в заданный индекс массива, а потом идете в одну из сторон.

ResourceOwner — это такой объект (насколько слово объект применимо для языка С), который хранит в себе разные ресурсы, файлы, шареную память и что-то еще. И он написан в предположении, что обычно мы ресурсы выделяем и кладем в массив, а освобождаем в обратном порядке. Поэтому при удалении ресурсов, он начинает их искать с конца. Размер массива он знает, ну, в смысле — у него есть индекс последнего элемента. Оказалось, что это условие выполняется не всегда и ему приходится во все стороны искать по этому массиву, поэтому он тупит. Патч заключается в том, что при определенном количестве ресурсов (около 16 или число порядка этого) этот массив превращается в хэш-таблицу. Когда вы конфликт разрешаете, вы по хэшу пришли в заданный индекс массива, а потом идете в одну из сторон.

Кстати, если кого-то интересует вопрос, кому в третьем тысячелетии приходится писать свои хэш-таблицы, то вот я сижу и в двух патчах пишу свои хэш-таблицы, потому что не подходят нам стандартные реализации. Это тоже уже есть в 9. 6, там ResourceOwner не тупит, если у вас партицированная сильно таблица. В смысле, он все еще тупит, но слабее.

6, там ResourceOwner не тупит, если у вас партицированная сильно таблица. В смысле, он все еще тупит, но слабее.

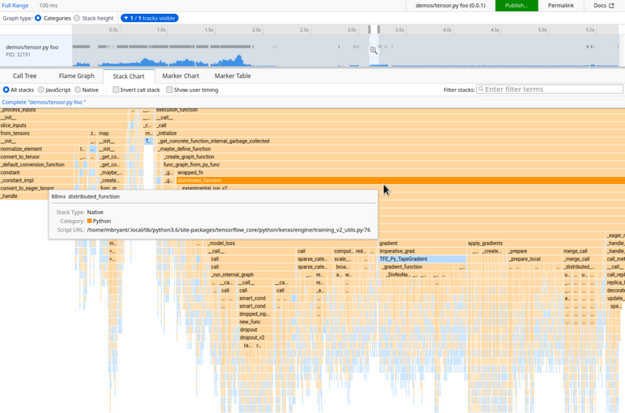

С помощью perf можно строить такие красивые картинки, они называются флеймграфы. Это читается снизу вверх. Внизу у нас есть процедура, потом — пропорционально тому, сколько времени где она проводит и в свою очередь вызывает — у нас поделено на другие процедуры. Потом вверх идем, у нас так же пропорционально делится, сколько времени она где проводит. И далее вверх. Это очень наглядно, но может быть непривычно, если вы первый раз такое видите. На самом деле, это очень наглядный отчет, намного нагляднее примера с графом, который Gprof строит. Обратите внимание, как экономно используется место, на слайдах это нельзя показать, но во все это можно кликать. И у него есть подсказка, которая показывает проценты.

Вот увеличенный кусок, это где-то из середины часть:

Собственно это, наверное, все. Мы этим часто пользуемся. На предыдущей работе мы таким же образом анализировали логи. Там была другая история — был АК-кластер, распределенное приложение, и мы по логам строили такие вещи, пытаясь понять, где же у нас тормозит код. Логи, разумеется, нужно было со всех бэкендов агрегировать. В общем, удобная штука, всем рекомендую.

Там была другая история — был АК-кластер, распределенное приложение, и мы по логам строили такие вещи, пытаясь понять, где же у нас тормозит код. Логи, разумеется, нужно было со всех бэкендов агрегировать. В общем, удобная штука, всем рекомендую.

Это Брендон Грегг. Он изобрел flame graphs и чуть ли не сам perf. Наверное, он не совсем один писал, но существенно в него вложился. Также он известен в видео на YouTube, где он орет на жесткие диски в дата-центре, и у него увеличивается latency при обращении к этим дискам — замечательное видео. Если кому интересно, это реальная тема, правда, с SSD работает это или нет — не знаю.

Недавно было похожая история, про то, как во время пожарных учений в банке вырубило весь дата-центр, потому что слишком громко свистели трубы, которые подают газ, который тушит огонь. То есть вибрация воздуха вырубила все диски.

К Брендону мы еще вернемся, потому что он знает все про профайлинг и очень много в это все вложил, сейчас он этим занимается в Netflix.

http://eax.me/freebsd-pmcstat/

Pmcstat — это инструмент исключительно под FreeBSD. Когда я делал эти слайды, я думал что ни у кого не будет FreeBSD, поэтому здесь нет особых подробностей про pmcstat, т.к. остальным это не очень интересно. Но краткое содержание такое, что с его помощью можно делать все то же самое, что с помощью perf. Он также делает top, тоже строит flame graphs и он ничем не хуже, просто команды другие. Кому интересно, вот ссылка на конкретную статью.

Переходим к более серьезным инструментам. SystemTap. Выше до этого был профайлинг CPU, где что-то тормозит, а SystemTap позволяет делать еще больше — вы можете посмотреть буквально на все, что угодно, в ядре, померить, сколько у вас пакетов по сети уходит, обращение к диску померить и все что угодно, ограничено только вашей фантазией. SystemTap позволяет писать вот такие скрипты, в данном случае трейсится вызов ip_rcv, то есть получение какого-то iP пакета.

Плюсы и минусы. Главных минусов 2. Во-первых, это не какой-то официальный инструмент для Linux, это чуваки из Red Hat запилили в основном для себя, для отладки своего кода, как я это понимаю. Его очень неудобно устанавливать, нужно скачивать пакет с отладочными символами ядра, потом его устанавливать, потом очень долго компилить сам SystemTap, он тоже так не просто компилируется, нужны версии. Но в конечном счете оно начинает работать. Второй недостаток — то, что вам нужно хорошо понимать базу того, что вы хотите проанализировать, потрейсить. Не все знают наизусть ядро Linux. Но если вы хорошо знаете свой код, вы можете это использовать.

Во-первых, это не какой-то официальный инструмент для Linux, это чуваки из Red Hat запилили в основном для себя, для отладки своего кода, как я это понимаю. Его очень неудобно устанавливать, нужно скачивать пакет с отладочными символами ядра, потом его устанавливать, потом очень долго компилить сам SystemTap, он тоже так не просто компилируется, нужны версии. Но в конечном счете оно начинает работать. Второй недостаток — то, что вам нужно хорошо понимать базу того, что вы хотите проанализировать, потрейсить. Не все знают наизусть ядро Linux. Но если вы хорошо знаете свой код, вы можете это использовать.

Есть интересное свойство — код транслируется в С, потом это компилируется в модуль ядра, который подгружается и собирает всю статистику, все трейсит. При этом вы можете не бояться делить на ноль, разыменовывать указатели неправильные. Если это написать в скриптовом языке, это не приведет к крэшу ядра, оно просто аккуратно свернет лапки и выгрузится, но ваше ядро продолжит работать.

Есть автоматический вывод типов. Правда, там всего два или три типа, зато они автоматически выводятся.

Лично мне страшно было бы использовать это в продакшне, потому что он не производит впечатления стабильного инструмента. Один тот факт — у вас скрипт секунд 10 компилируется и загружается, а что в это время будет там тормозить, не тормозить, не очень понятно. Я бы не рискнул, но, может, вы смелее.

DTrace — это тоже прикольный инструмент, не только для FreeBSD, в Linux тоже есть, все хорошо. Он похож на SystemTap, в этом примере мы трейсим системный вызов poll, притом для процессов, которые называются postgres. Здесь трейсится, с какими аргументами он вызывается и что возвращается.

Плюсы и минусы. Во-первых, он, в отличие от SystemTap, прямо есть в системе из коробки, ничего не надо устанавливать, компилировать. Есть во FreeBSD, в Mac OS. Для Linux он тоже есть, если вы каким-то образом используете Oracle Linux. Кроме того, есть проект dtrace4linux на GitHub, он компилируется, работает, я проверял. В принципе, можно пользоваться.

В принципе, можно пользоваться.

В отличие от SystemTap, DTrace не страшно использовать в продакшне — заходите на ваш Mac в боевом окружении и трейсите все, что угодно. По моим субъективным ощущениям, DTrace больше для админов, потому что у вас в ядре есть куча пробов на все что угодно, вам не нужно знать кодовую базу, вы просто говорите: «Хочу собрать статистику по IP-пакетам — сколько пришло, сколько ушло». Кстати, есть наборы готовых утилит, вам не нужно обязательно скриптами все самим писать. DTrace Toolkit называется.

А SystemTap скорее не для админов, а для разработчиков: «Я знаю код ядра, я хочу вот в этом месте потрейсить, без написания какого-то кода, не патча его».

До сих пор мы говорили про профайлинг в плане использования ЦПУ, но еще частая проблема — это «а что, если у меня отжирается много памяти?». Лично мне нравится инструмент HeapTrack, если вы когда-нибудь использовали Valgrind Massif, то он такой же, только быстрый, но с ограничением — работает только на Linux.

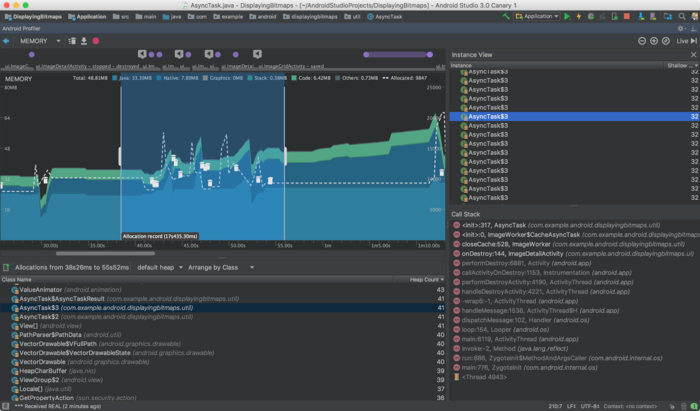

Здесь (на слайде выше) пример текстового отчета, найдено место, которое отъедает больше всего памяти, есть конкретные номера строк, имена файлов с исходниками и так далее.

Кроме того, он может строить вот такие красивые отчеты в инструменте Massif Visualizer. В нем можно все открывать, это все в динамике. Там память росла, потом достигла своего пика, потом она начала падать, освобождаться, выделяться, справа есть трейсы. Все очень наглядно и красиво.

Плюсы и минусы. Он быстрый, в отличие от Valgrind. Может цепляться к запущенным процессам, можно запускать под ним процессы. Красивые отчеты. Он умеет находить мемори лики. Немного криво их находит, если у вас стандартная библиотека языка выделила 16 кБ под какие-то свои внутренние нужды и потом их не освободила, потому что «ну, зачем?», он скажет, что это мемори лик. Но, в принципе, довольно полезный инструмент, несмотря на все это.

Можно построить гистограмму, что у меня кусочки размером в 8 байт выделяются больше всего, а кусочки памяти размером 32 байта выделяются чуть реже. Такая красивая гистограмма получается.

Такая красивая гистограмма получается.

Про стек он ничего не знает, если вам нужен стек или нужно что-то за пределами Linux, то используйте Valgrind. Я Linux’оид, поэтому ничего не знаю про Valgrind.

Есть такая тема в Linux, называется BPF, изначально это был Berkeley Packet Filter и, как можно догадаться по названию, имеет отношение к Berkeley и какой-то там фильтрации пакетов, но BPF он где-то в 2.6 ветку приземлил в свое время. Но в результате его доработали и, по сути, он превратился, не без помощи уже упомянутого Брендона Грегга, в DTrace в Linux.

Он позволяет делать абсолютно все то же самое. Недавно у Брендона был пост в блоге, где он пишет, что в ядро 4.9, которое сейчас все еще релиз-кандидат, но скоро будет, туда приземлились окончательно изменения в BPF. Больших, крупных изменений не будет, может, они что-то зарефачат, может, немного поправят, но чтобы активно добавлять — такого уже не будет.

Bcc — это набор утилит, который использует BPF для профайлинга разных мест ядра. На картинке это все названия утилит. Вы фактически любое место в ядре можете потрейсить, попрофайлить в ядре.

На картинке это все названия утилит. Вы фактически любое место в ядре можете потрейсить, попрофайлить в ядре.

Недостаток у BPF в том, что у него нет еще своего скриптового языка, как есть у DTrace, SystemTap, но в этом направлении уже есть наработки. В частности, парни из Red Hat подключились, они взяли свой SystemTap и сделали его сборку для BPF. То есть используется язык SystemTap, но работает оно на BPF. Оно пока какое-то ограниченное, вообще не поддерживает строковый тип, но они работают над этим.

Суть в том, что BPF — это, похоже, наше далекое светлое будущее, и он является наибольшим общим знаменателем, к которому в итоге пришли все компании, потому что там были какие-то скрипты у Facebook, был SystemTap у Red Hat, потому что им нужно было для разработки что-то такое трейсить. Они свою задачу решили и им больше ничего не надо. А BPF — это то, что должно в результате решать нужды всех, и оно уже прямо в ядре из коробки готовое и, похоже, в итоге все к этому придут и через пару лет наступит большое счастье.

Главный вопрос, который будоражит умы миллионов: «Хорошо, много инструментов, что и когда использовать?». Что лично я использую. Отладчики. Если вы подозреваете lock contention, его легко довольно заподозрить, вы в perf top не будете видеть, что кто-то жрет большое количество времени, наверное, оно висит в локах. Perf, если вы думаете, что уперлись в СPU, это в обычном htop видно — вот процесс, он жрет много СPU. Pmcstat, если у вас FreeBSD, SystemTap, мне кажется, бесполезный инструмент по той причине, что есть perf — он удобнее. Имеется в виду в контексте именно профайлинга, то есть профайлить я могу perf’ом, а для трейсировки SystemTap он ничего, он только не про профайлинг.

DTrace — это, если вы сидите под Mac, то он — ваше все, потому что он умеет все.

HeapTrack для памяти, Vagrant Massif — если вы на Linux, и BPF — это светлое будущее, но сейчас я бы не стал ставить 4. 9 в продакт, но, может, вы смелее, опять же.

Хочу порекомендовать книги с соавторством Брендона Грегга.

Первая — Systems Performance: Enterprise and the Cloud — потрясающая книга, ее обязательно нужно читать всем поголовно. Это одна из лучших книг, которую я читал и которая связана с программированием. Она взорвала мозг мне, потом шрапнелью задела мозги коллег, в общем, просто прочитайте.

Вторая книга про DTrace — тоже книга Брендона Грегга в соавторстве с парнем, который я не знаю, чем примечателен. Ее я не читал, полистал, это такой большой сборник рецептов про DTrace. Там дается команда, и что она делает, примеры скриптов. И так на тысячу страниц. Мне кажется, это не очень интересное чтиво, но если вы сильно интересуетесь DTrace, вечером полистать вредно не будет.

Куча онлайн-ресурсов:

- Это ссылка на мой бложик;

- http://www.brendangregg.com/blog/index.html — блог Брендона Грегга — подписаться обязательно, он там постит умопомрачительные вещи.

- http://dtrace.org/blogs/ — блог DTrace я тоже читаю, там есть интересные статьи.

- Дальше. https://sourceware.org/systemtap/ — сайт SystemTap’а.

- FreeBSD в wiki — https://wiki.freebsd.org/DTrace

- И в handbook’е можно прочитать про DTrace. Даже если вы пользуетесь Mac, все равно полистайте handbook, там есть хорошие примеры — https://www.freebsd.org/doc/handbook/dtrace.html

- И в конце мануал Intel — http://www.intel.com/content/www/us/en/processors/architectures-software-developer-manuals.html. Там можно почитать, собственно, на чем паразитирует perf, что такое РMC, прямо в процессорах есть инструкции, которые позволяют все это мерить.

У меня все.

Этот доклад — расшифровка одного из лучших выступлений на конференции разработчиков высоконагруженных систем HighLoad++. До конференции HighLoad++ 2017 осталось меньше месяца.У нас уже готова Программа конференции, сейчас активно формируется расписание.

В этом году доклады по тегу «Правильные ручки«:

- Хочу всё сжать / Андрей Аксенов

- Защищаемость от DDoS на этапе проектирования системы / Рамиль Хантимиров

- Чем заняться вечером, если я знаю, сколько будет ++i + ++i / Андрей Бородин

- Как развивать библиотеку компонентов, не ломая её / Артур Удалов

Также некоторые из этих материалов используются нами в обучающем онлайн-курсе по разработке высоконагруженных систем HighLoad.

Guide — это цепочка специально подобранных писем, статей, материалов, видео. Уже сейчас в нашем учебнике более 30 уникальных материалов. Подключайтесь!

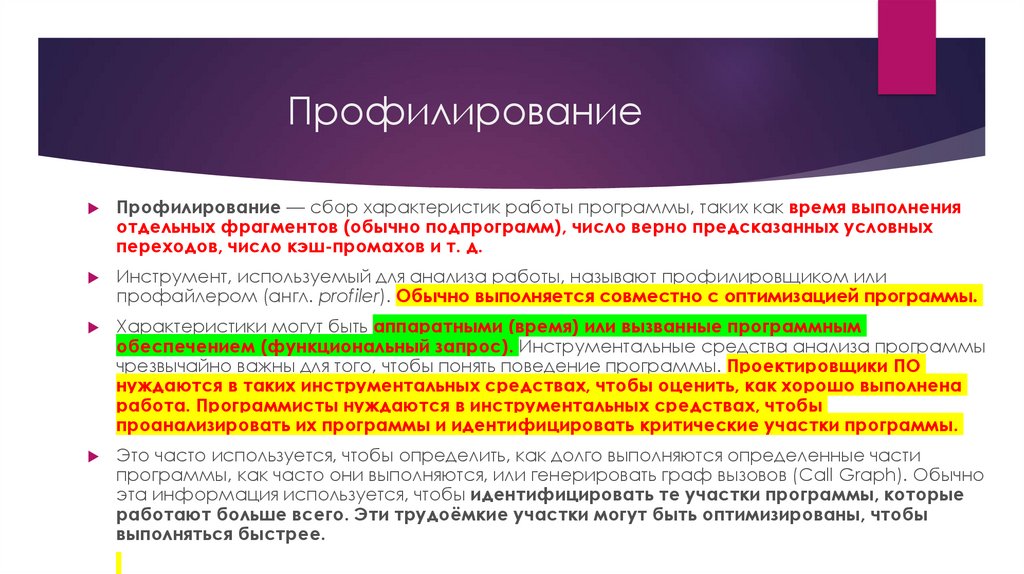

Профилирование кода — Как найти слабое звено?

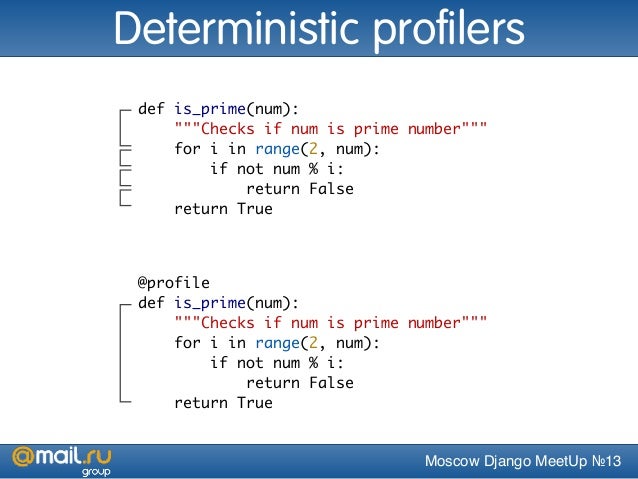

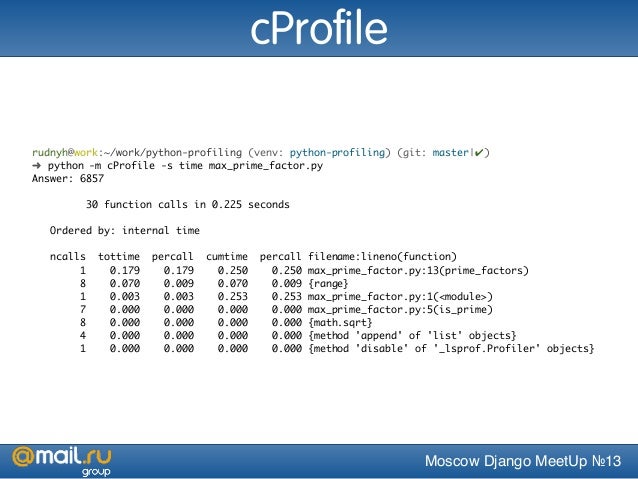

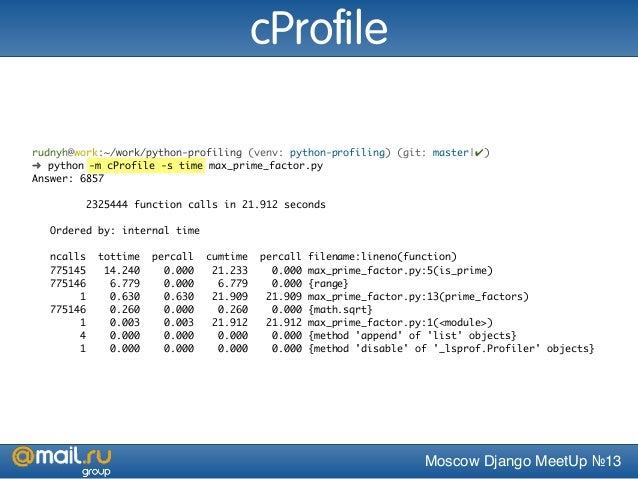

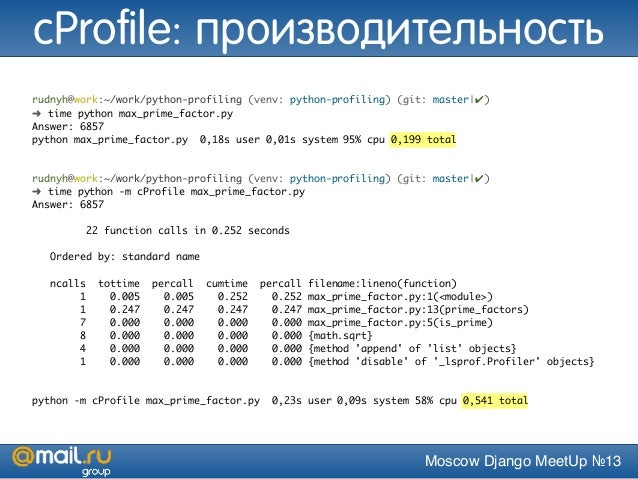

Профилирование кода это попытка найти узкие места в вашем коде. Профилирование может найти самые долго выполняющиеся части вашего кода. Найдя их, вы можете оптимизировать эти части удобным вам способом. Python содержит три встроенных профайлера: cProfile, profile и hotshot. В соответствии с документацией Python, hotshot «не поддерживается, и может быть удален из Python». Модуль profile это в корне своем модуль Python, но добавляет много чего сверху в профилированные программы. Поэтому мы сфокусируемся на cProfile, который содержит интерфейс, который имитирует модуль profile.

Профилирование кода при помощи cProfile

Профилирование кода с cProfile это достаточно просто. Все что вам нужно сделать, это импортировать модуль и вызвать его функцию run. Давайте посмотрим на простой пример:

Все что вам нужно сделать, это импортировать модуль и вызвать его функцию run. Давайте посмотрим на простой пример:

Python

import hashlib import cProfile cProfile.run(«hashlib.md5(b’abcdefghijkl’).digest()»)

import hashlib import cProfile

cProfile.run(«hashlib.md5(b’abcdefghijkl’).digest()») |

Здесь мы импортировали модуль hashlib и использовали cProfile для профилирования того, что создал хеш MD5. Первая строка показывает, что в ней 4 вызова функций. Следующая строка говорит нам, в каком порядке результаты выдачи. Здесь есть несколько столбцов.

- ncalls – это количество совершенных вызовов;

- tottime – это все время, потраченное в данной функции;

- percall – ссылается на коэффициент tottime, деленный на ncalls;

- cumtime – совокупное время, потраченное как в данной функции, так и наследуемых функциях.

Это работает также и с рекурсивными функциями!

Это работает также и с рекурсивными функциями! - Второй столбец percall – это коэффициент cumtime деленный на примитивные вызовы;

- filename:lineno(function) предоставляет соответствующие данные о каждой функции.

Примитивный вызов – это вызов, который не был совершен при помощи рекурсии. Это очень интересный пример, так как здесь нет очевидных узких мест. Давайте создадим часть кода с узкими местами, и посмотрим, обнаружит ли их профайлер.

Python

# -*- coding: utf-8 -*- import time def fast(): print(«Я быстрая функция») def slow(): time.sleep(3) print(«Я очень медленная функция») def medium(): time.sleep(0.5) print(«Я средняя функция…») def main(): fast() slow() medium() if __name__ == ‘__main__’: main()

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 | # -*- coding: utf-8 -*- import time

def fast(): print(«Я быстрая функция»)

def slow(): time. print(«Я очень медленная функция»)

def medium(): time.sleep(0.5) print(«Я средняя функция…»)

def main(): fast() slow() medium()

if __name__ == ‘__main__’: main() |

Сохраняем программу как ptest.py. В этом примере мы создали четыре функции. Первые три работают с разными темпами. Быстрая функция запустится с нормальной скоростью, средняя функция потратит примерно полсекунды на запуск, медленная функция потратит примерно три секунды для запуска. Главная функция вызывает остальные три. Давайте запустим cProfile в этой маленькой глупой программе:

Python

import cProfile import ptest cProfile.run(‘ptest.main()’)

import cProfile import ptest

cProfile.run(‘ptest. |

На этот раз мы видим, что у программы ушло 3.5 секунды на запуск. Если вы изучите результаты, то увидите, что cProfile выявил медленную функцию, которая тратит 3 секунды на запуск. Это и есть самая «слабая» часть основной функции. Обычно, когда вы обнаруживаете такие места, вы можете попытаться найти самый быстрый способ выполнения вашего кода, или прийти к выводу, что такая задержка приемлема. В этом примере, мы знаем, что лучший способ ускорить функцию, то убрать вызов time.sleep, или, по крайней мере, снизить продолжительность сна. Вы можете также вызвать cProfile в командной строке, вместо применения в интерпретаторе. Как это сделать:

python -m cProfile ptest.py

python -m cProfile ptest.py |

Есть вопросы по Python?

На нашем форуме вы можете задать любой вопрос и получить ответ от всего нашего сообщества!

Python Форум Помощи

Telegram Чат & Канал

Вступите в наш дружный чат по Python и начните общение с единомышленниками! Станьте частью большого сообщества!

Паблик VK

Одно из самых больших сообществ по Python в социальной сети ВК. Видео уроки и книги для вас!

Видео уроки и книги для вас!

Подписаться

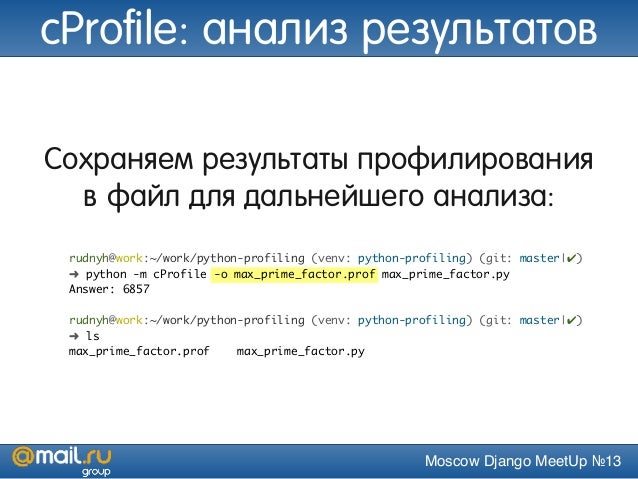

Таким образом, будет запущен cProfile в вашем скрипте по аналогии с тем, как мы делали это ранее. Но что если вам нужно сохранить выдачу профайлера? Что-ж, это очень просто с cProfile! Все что вам нужно, это передать ему команду –o, за которой следует название (или путь) файла выдачи. Вот пример:

python -m cProfile -o output.txt ptest.py

python -m cProfile -o output.txt ptest.py |

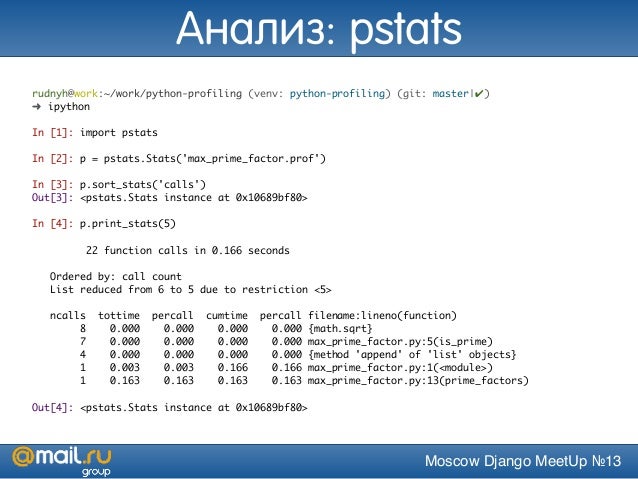

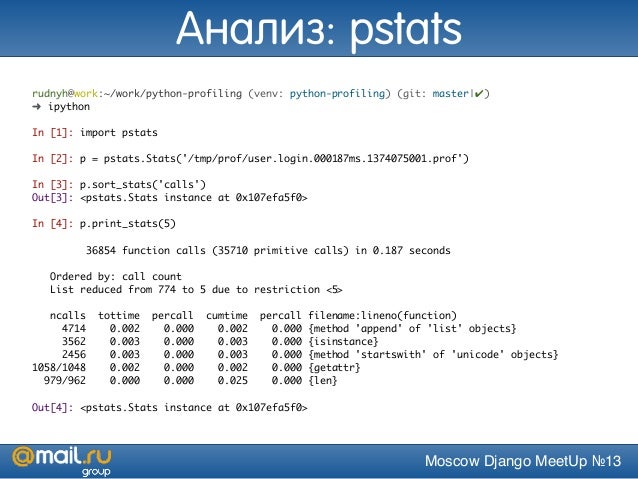

К сожалению, выдаваемый файл едва ли можно назвать читаемым. Если вы хотите прочесть файл, тогда вам нужно использовать модуль Python pstats. Вы можете использовать pstats для форматирования выдачи разными способами. Вот небольшой код, который показывает, как получить выдачу, по аналогии с тем, как мы делали это раньше:

Python

import pstats

p = pstats. Stats(«output.txt»)

p.strip_dirs().sort_stats(-1).print_stats()

Stats(«output.txt»)

p.strip_dirs().sort_stats(-1).print_stats()

import pstats p = pstats.Stats(«output.txt»)

p.strip_dirs().sort_stats(-1).print_stats() |

Вызов strip_dirs вырезает все пути к модулям из вывода, пока вызов sort_stats делает сортировку, которая нужна нам для виденья картины. Существует множества очень интересных примеров в документации cProfile, которые наглядно демонстрируют различные пути извлечения информации с использованием модуля pstats.

Выясняем скорость загрузки сайтов

Давайте немного развлечемся. Сделаем небольшой марафон и узнаем какой сайт быстрее всех откроется из нашей программы. Узнать больше насчет производительности requests можно узнать в данной статье.

Python

# -*- coding: utf-8 -*-

import requests

import cProfile

def facebook():

requests.get(‘https://facebook. com’)

def google():

requests.get(‘https://google.com’)

def twitter():

requests.get(‘https://twitter.com’)

def vk():

requests.get(‘https://vk.com’)

def main():

facebook()

google()

twitter()

vk()

cProfile.run(‘main()’)

com’)

def google():

requests.get(‘https://google.com’)

def twitter():

requests.get(‘https://twitter.com’)

def vk():

requests.get(‘https://vk.com’)

def main():

facebook()

google()

twitter()

vk()

cProfile.run(‘main()’)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 | # -*- coding: utf-8 -*- import requests import cProfile

def facebook(): requests.get(‘https://facebook.com’)

def google(): requests.get(‘https://google.com’) def twitter(): requests.get(‘https://twitter.com’) def vk(): requests.get(‘https://vk.com’)

def main(): facebook() google() twitter() vk() cProfile. |

Результат

Python

python3 site_speed_test.py 61356 function calls (61000 primitive calls) in 2.683 seconds ncalls tottime percall cumtime percall filename:lineno(function) 1 0.000 0.000 0.743 0.743 ptest.py:10(google) 1 0.001 0.001 0.521 0.521 ptest.py:14(twitter) 1 0.000 0.000 0.876 0.876 ptest.py:18(vk) 1 0.000 0.000 2.683 2.683 ptest.py:22(main) 1 0.002 0.002 0.543 0.543 ptest.py:6(facebook)

1 2 3 4 5 6 7 8 9 10 11 | python3 site_speed_test.py

61356 function calls (61000 primitive calls) in 2.683 seconds

ncalls tottime percall cumtime percall filename:lineno(function)

1 0.000 0.000 0.743 0.743 ptest.py:10(google) 1 0.001 0.001 0.521 0.521 ptest.py:14(twitter) 1 0. 1 0.000 0.000 2.683 2.683 ptest.py:22(main) 1 0.002 0.002 0.543 0.543 ptest.py:6(facebook) |

Мы получим большой список результатов, давайте найдем только наши функции. Запуск всех сайтов выполнился в 2.68 секунды. Быстрее всех открылся Twitter, самый медленный стал VK. Это конечно не идеальный тест скорости, но наша задача была выполнена. Мы выясняли скорость открытия сайтов используя cProfile.

Подведем итоги

С этого момента вы должны знать, как использовать модуль cProfile для диагностики того, что делает ваш код таким медленным. Вы также можете взглянуть на модуль Python timeit. Он позволяет вам отсчитывать маленькие части вашего кода, если вы не хотите иметь дела со сложностями, которые может повлечь за собой профилирование. Также существует несколько других сторонних модулей, которые также хороши в профилировании как проекты line_profiler и memory_profiler.

Vasile Buldumac

Являюсь администратором нескольких порталов по обучению языков программирования Python, Golang и Kotlin. В составе небольшой команды единомышленников, мы занимаемся популяризацией языков программирования на русскоязычную аудиторию. Большая часть статей была адаптирована нами на русский язык и распространяется бесплатно.

E-mail: [email protected]

Образование

Universitatea Tehnică a Moldovei (utm.md)

- 2014 — 2018 Технический Университет Молдовы, ИТ-Инженер. Тема дипломной работы «Автоматизация покупки и продажи криптовалюты используя технический анализ»

- 2018 — 2020 Технический Университет Молдовы, Магистр, Магистерская диссертация «Идентификация человека в киберпространстве по фотографии лица»

Профилировщики Python | Python 3

- /

- Переводы документации /

- Документация Python 3.8.8 /

- Стандартная библиотека Python /

- Отладка и профилирование /

- Профилировщики Python

Знакомство с профилировщиками

cProfile и profile предоставляют детерминированное профилирование программ Python. Профиль — это множество статистических данных,

описывающих, как часто и как долго выполняются различные части программы. Эту

статистику можно форматировать в отчёты через модуль

Профиль — это множество статистических данных,

описывающих, как часто и как долго выполняются различные части программы. Эту

статистику можно форматировать в отчёты через модуль pstats.

Стандартная библиотека Python предоставляет две разные реализации одного и того же интерфейса профилирования:

cProfileрекомендуется большинству пользователей; это C расширение с разумными накладными расходами, что делает его подходящим для профилирования долго работающих программ. Основан наlsprof, предоставленным Бреттом Розеном и Тедом Чоттером.profile, чистый Python модуль, интерфейс которого имитируетcProfile, но который значительно увеличивает нагрузку на профилированные программы. Если вы пытаетесь каким-то образом расширить профилировщик, с этим модулем задача может быть проще. Первоначально разработан и написан Джимом Роскиндом.

Примечание

Модули профилировщика предназначены для предоставления профиля выполнения

для данной программы, а не для целей бенчмаркинга (для этого есть timeit для получения достаточно точных результатов). В частности, это

относится к сравнению кода Python с кодом C: профилировщики вносят накладные

расходы для кода Python, но не для функций уровня C, поэтому код C кажется

более быстрым, чем любой Python код.

В частности, это

относится к сравнению кода Python с кодом C: профилировщики вносят накладные

расходы для кода Python, но не для функций уровня C, поэтому код C кажется

более быстрым, чем любой Python код.

Быстрое руководство пользователя

Данный раздел предназначен для пользователей, которые «не хотят читать руководство». Оно предоставляет очень краткий обзор и позволяет пользователю быстро выполнить профилирование существующего приложения.

Чтобы профилировать функцию, которая принимает один аргумент, вы можете сделать:

import cProfile

import re

cProfile.run('re.compile("foo|bar")')

(Используйте profile вместо cProfile, если последний недоступен в

вашей системе.)

Приведённое выше действие будет запускать re.compile() и печатать

результаты профиля, как показано ниже:

197 function calls (192 primitive calls) in 0.002 seconds

Ordered by: standard name

ncalls tottime percall cumtime percall filename:lineno(function)

1 0. 000 0.000 0.001 0.001 <string>:1(<module>)

1 0.000 0.000 0.001 0.001 re.py:212(compile)

1 0.000 0.000 0.001 0.001 re.py:268(_compile)

1 0.000 0.000 0.000 0.000 sre_compile.py:172(_compile_charset)

1 0.000 0.000 0.000 0.000 sre_compile.py:201(_optimize_charset)

4 0.000 0.000 0.000 0.000 sre_compile.py:25(_identityfunction)

3/1 0.000 0.000 0.000 0.000 sre_compile.py:33(_compile)

000 0.000 0.001 0.001 <string>:1(<module>)

1 0.000 0.000 0.001 0.001 re.py:212(compile)

1 0.000 0.000 0.001 0.001 re.py:268(_compile)

1 0.000 0.000 0.000 0.000 sre_compile.py:172(_compile_charset)

1 0.000 0.000 0.000 0.000 sre_compile.py:201(_optimize_charset)

4 0.000 0.000 0.000 0.000 sre_compile.py:25(_identityfunction)

3/1 0.000 0.000 0.000 0.000 sre_compile.py:33(_compile)

В первой строке указано, что было отслежено 197 вызовов. Из данных вызовов 192

были примитивными, что означает, что вызов не был вызван рекурсией.

Следующая строка: Ordered by: standard name указывает, что текстовая строка

в крайнем правом столбце использовалась для сортировки вывода. Заголовки

столбцов включают:

- ncalls

- на количество вызовов.

- tottime

- за общее время, проведенное в данной функции (без учета времени, проведенного в вызовы подфункций)

- percall

- представляет собой частное

tottime, делённое наncalls - cumtime

- это совокупное время, затраченное на эту и все подфункции (с момента вызова

до выхода).

Данный рисунок точен даже для рекурсивных функций.

Данный рисунок точен даже для рекурсивных функций. - percall

- является частным

cumtime, разделённым на примитивные вызовы - filename:lineno(function)

- предоставляет соответствующие данные каждой функции

Когда в первом столбце два числа (например, 3/1), это означает, что функция

рекурсивна. Второе значение — это количество примитивных вызовов, а первое —

общее количество вызовов. Обратите внимание, что когда функция не рекурсивна,

данные два значения совпадают, и печатается только одна цифра.

Вместо того, чтобы печатать выходные данные в конце выполнения профиля, вы

можете сохранить результаты в файл, указав имя файла для функции run():

import cProfile

import re

cProfile.run('re.compile("foo|bar")', 'restats')

Класс pstats.Stats считывает результаты профиля из файла и форматирует

их различными способами.

Файлы cProfile и profile также можно вызывать как сценарий для

профилирования другого сценария. Например:

Например:

python -m cProfile [-o output_file] [-s sort_order] (-m module | myscript.py)

-o записывает результаты профиля в файл, а не в стандартный вывод

-s указывает одно из значений сортировки sort_stats() для сортировки вывода. Это применимо только в том случае, если -o не

поставляется.

-m указывает, что профилируется модуль, а не сценарий.

Добавлено в версии 3.7: Добавлен параметр

-mвcProfile.Добавлено в версии 3.8: Добавлен параметр

-mвprofile.

Класс Stats модуля pstats имеет множество методов для

обработки и печати данных, сохранённых в файле результатов профиля:

import pstats

from pstats import SortKey

p = pstats.Stats('restats')

p.strip_dirs().sort_stats(-1).print_stats()

Метод strip_dirs() удалил посторонний путь из всех имён

модулей. Метод

Метод sort_stats() отсортировал все записи в

соответствии со стандартной строкой модуля/строки/имени, которая печатается.

Метод print_stats() распечатывает всю статистику. Вы можете

попробовать следующие вызовы сортировки:

p.sort_stats(SortKey.NAME) p.print_stats()

Первый вызов фактически отсортирует список по имени функции, а второй вызов распечатает статистику. Ниже приведены некоторые интересные вызовы для экспериментов:

p.sort_stats(SortKey.CUMULATIVE).print_stats(10)

Это сортирует профиль по совокупному времени в функции, а затем печатает только десять наиболее значимых строк. Если вы хотите понять, какие алгоритмы требуют времени, вы бы использовали приведенную выше строку.

Если бы вы хотели увидеть, какие функции часто зацикливаются и занимают много времени, то выполните

p.sort_stats(SortKey.TIME).print_stats(10)

для сортировки по времени, затраченному на каждую функцию, а затем распечатать

статистику для первых десяти функций.

Вы также можете выполнить

p.sort_stats(SortKey.FILENAME).print_stats('__init__')

Это отсортирует всю статистику по имени файла, а затем распечатает статистику

только для методов инициализации класса (поскольку в них они пишутся с __init__). В качестве последнего примера вы можете

p.sort_stats(SortKey.TIME, SortKey.CUMULATIVE).print_stats(.5, 'init')

Эта строка сортирует статистику по первичному ключу времени и вторичному ключу

совокупного времени, а затем выводит часть статистики. Чтобы быть конкретным,

список сначала отбраковывается до 50% (re: .5) от его исходного размера,

затем сохраняются только строки, содержащие init, и данный под-подсписок

печатается.

Если вам интересно, какие функции называются вышеперечисленными функциями, вы

можете сейчас (p все ещё сортируется по последнему критерию) сделать:

p.print_callers(.5, 'init')

и вы получить список вызывающих для каждой из перечисленных функций.

Если вам нужна дополнительная функциональность, вам придется прочитать руководство или угадать, что делают следующие функции:

p.print_callees()

p.add('restats')

Модуль pstats, вызываемый как сценарий, представляет собой браузер

статистики для чтения и изучения дампов профилей. Он имеет простой линейный

интерфейс (реализованный с использованием cmd) и интерактивную справку.

Оба модуля profile и cProfile предоставляют следующие функции:

-

profile.run(command, filename=None, sort=-1) Данная функция принимает один аргумент, который можно передать функции

exec(), и необязательное имя файла. Во всех случаях эта процедура выполняется:exec(command, __main__.__dict__, __main__.__dict__)

и собирает статистику профилирования от выполнения. Если имя файла отсутствует, данная функция автоматически создаёт экземпляр

Statsи печатает простой отчёт о профилировании. Если

указано значение сортировки, оно передаётся этому экземпляру

Если

указано значение сортировки, оно передаётся этому экземпляру Statsдля управления сортировкой результатов.

-

profile.runctx(command, globals, locals, filename=None, sort=-1) Данная функция похожа на

run(), но с добавленными аргументами для предоставления словарей глобальных и локальных переменных для строки command. Эта функция выполняетexec(command, globals, locals)

и собирает статистику профилирования, как в функции

run()выше.

- class

profile.Profile(timer=None, timeunit=0.0, subcalls=True, builtins=True) Данный класс обычно используется только в том случае, если требуется более точное управление профилированием, чем то, что обеспечивает функция

cProfile.run().Пользовательский таймер может быть предоставлен для измерения времени выполнения кода с помощью аргумента timer.

Это должна быть функция,

которая возвращает одно число, представляющее текущее время. Если число

является целым числом, timeunit задаёт множитель, определяющий

продолжительность каждой единицы времени. Например, если таймер возвращает

время в тысячах секунд, единицей времени будет

Это должна быть функция,

которая возвращает одно число, представляющее текущее время. Если число

является целым числом, timeunit задаёт множитель, определяющий

продолжительность каждой единицы времени. Например, если таймер возвращает

время в тысячах секунд, единицей времени будет .001.Непосредственное использование класса

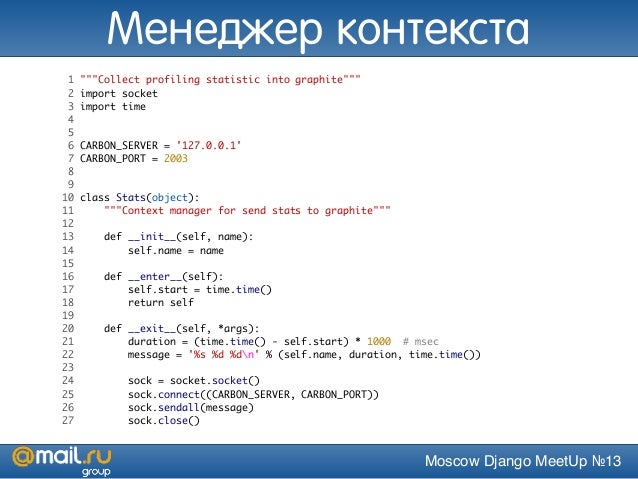

Profileпозволяет форматировать результаты профиля без записи данных профиля в файл:import cProfile, pstats, io from pstats import SortKey pr = cProfile.Profile() pr.enable() # ... сделать что-нибудь ... pr.disable() s = io.StringIO() sortby = SortKey.CUMULATIVE ps = pstats.Stats(pr, stream=s).sort_stats(sortby) ps.print_stats() print(s.getvalue())

Класс

Profileтакже можно использовать в качестве менеджера контекста (поддерживается только в модулеcProfile, см. Типы менеджера контекста):import cProfile with cProfile.Profile() as pr: # ... сделать что-нибудь ... pr. print_stats()

print_stats()

Изменено в версии 3.8: Добавлена поддержка контекстного менеджера.

-

enable() Начать собирать данные профилирования. Только в

cProfile.

-

disable() Прекратить сбор данных профилирования. Только в

cProfile.

-

create_stats() Прекратить сбор данных профилирования и записать результаты внутри как текущий профиль.

-

print_stats(sort=-1) Создать объект

Statsна основе текущего профиля и распечатать результаты в стандартный вывод.

-

dump_stats(filename) Записать результаты текущего профиля в filename.

-

run(cmd) Профилировать cmd через

exec().

-

runctx(cmd, globals, locals) Профилировать cmd через

exec()с указанным глобальным и локальным окружением.

-

runcall(func, *args, **kwargs) Профилирование

func(*args, **kwargs)

-

Обратите внимание, что профилирование будет работать только в том случае, если

вызванная команда/функция действительно возвращает значение. Если интерпретатор

завершается (например, через вызов sys.exit() во время выполнения

вызванной команды/функции), результаты профилирования не будут напечатаны.

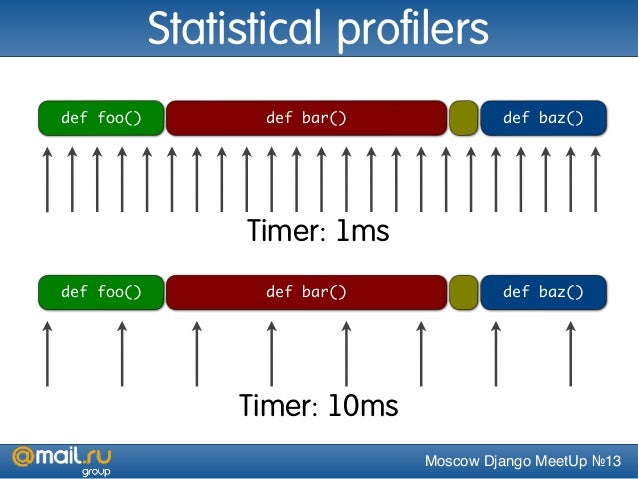

Что такое детерминированное профилирование

Детерминированное профилирование предназначено для отражения того

факта, что все события вызова функции, возврата функции и исключение отслеживаются, и

устанавливаются точные временные интервалы между этими событиями (в течение

которых выполняется код пользователя). Напротив, статистическое профилирование (который не выполняется этим модулем) случайным образом выбирает действующий

указатель инструкции и определяет, где тратится время. Последний метод

традиционно требует меньших накладных расходов (поскольку код не требует

инструментальной обработки), но даёт лишь относительные указания на то, на что

тратится время.

Последний метод

традиционно требует меньших накладных расходов (поскольку код не требует

инструментальной обработки), но даёт лишь относительные указания на то, на что

тратится время.

В Python, поскольку во время выполнения активен интерпретатор, наличие инструментированного кода не требуется для выполнения детерминированного профилирования. Python автоматически предоставляет хук (необязательный обратный вызов) для каждого события. Кроме того, интерпретируемый характер Python имеет тенденцию увеличивать нагрузку на выполнение, поэтому детерминированное профилирование имеет тенденцию добавлять только небольшие накладные расходы на обработку в типичных приложениях. В результате детерминистическое профилирование не так уж и дорого, но при этом предоставляет обширную статистику времени выполнения Python программы.

Статистика подсчёта вызовов может использоваться для выявления ошибок в коде

(неожиданные подсчёты) и выявления возможных встроенных точек расширения

(большое количество вызовов). Внутреннюю статистику времени можно использовать

для выявления «горячих циклов», которые следует тщательно оптимизировать.

Накопленную статистику по времени следует использовать для выявления ошибок

высокого уровня при выборе алгоритмов. Обратите внимание, что необычная

обработка совокупного времени в этом профилировщике позволяет напрямую

сравнивать статистику рекурсивных реализаций алгоритмов с итеративными

реализациями.

Внутреннюю статистику времени можно использовать

для выявления «горячих циклов», которые следует тщательно оптимизировать.

Накопленную статистику по времени следует использовать для выявления ошибок

высокого уровня при выборе алгоритмов. Обратите внимание, что необычная

обработка совокупного времени в этом профилировщике позволяет напрямую

сравнивать статистику рекурсивных реализаций алгоритмов с итеративными

реализациями.

Ограничения

Одно ограничение связано с точностью информации о времени. Существует фундаментальная проблема с детерминированными профилировщиками, связанная с точностью. Наиболее очевидным ограничением является то, что базовые «часы» тикают только со скоростью (обычно) около 0.001 секунды. Следовательно, никакие измерения не будут более точными, чем базовые часы. Если будет проведено достаточно измерений, то «ошибка» будет иметь тенденцию к усреднению. К сожалению, удаление этой первой ошибки вызывает второй источник ошибки.

Вторая проблема заключается в том, что «требуется некоторое время» с момента

отправки события до вызова профилировщика, чтобы получить время на самом деле получает состояние часов. Точно так же существует определённая задержка при

выходе из обработчика событий профилировщика с момента, когда значение часов

было получено (и затем убрано), до тех пор, пока код пользователя снова не

будет выполнен. В результате функции, которые вызываются много раз или вызывают

много функций, обычно накапливают эту ошибку. Ошибка, которая накапливается

таким образом, обычно меньше точности часов (менее одного тактового импульса),

но она накапливается и становится очень значительной.

Точно так же существует определённая задержка при

выходе из обработчика событий профилировщика с момента, когда значение часов

было получено (и затем убрано), до тех пор, пока код пользователя снова не

будет выполнен. В результате функции, которые вызываются много раз или вызывают

много функций, обычно накапливают эту ошибку. Ошибка, которая накапливается

таким образом, обычно меньше точности часов (менее одного тактового импульса),

но она накапливается и становится очень значительной.

Проблема более серьезна с profile, чем с cProfile с меньшими

накладными расходами. По этой причине profile предоставляет средства

калибровки для данной платформы, чтобы эта ошибка могла быть вероятностно (в

среднем) устранена. После того, как профайлер откалиброван, он будет более

точным (в смысле наименьших квадратов), но иногда будет давать отрицательные

числа (когда количество вызовов исключительно мало, и боги вероятности работают

против вас :-). ) Не пугайтесь отрицательных цифр в профиле. Они должны

появиться только в том случае, если вы откалибровали свой профилировщик,

и результаты на самом деле лучше, чем без калибровки.

Они должны

появиться только в том случае, если вы откалибровали свой профилировщик,

и результаты на самом деле лучше, чем без калибровки.

Калибровка

Профилировщик модуля profile вычитает константу из времени обработки

каждого события, чтобы компенсировать накладные расходы на вызов функции

времени и сохранение результатов. По умолчанию константа равна 0. Для получения

лучшей константы для данной платформы можно использовать следующий код

(см. Ограничения).

import profile

pr = profile.Profile()

for i in range(5):

print(pr.calibrate(10000))

Код выполняет количество вызовов Python, заданное аргументом, напрямую и

снова под профилировщиком, измеряя время для обоих. Затем он вычисляет скрытые

служебные данные для каждого события профилировщика и возвращает его в виде

числа с плавающей запятой. Например, на процессоре Intel Core i5 с тактовой

частотой 1,8 ГГц под управлением Mac OS X и использовании в качестве таймера

Python time.process_time() магическое число составляет около 4,04e-6.

Цель этого действия — получить достаточно последовательный результат. Если ваш компьютер работает очень быстро или ваша функция таймера имеет низкое разрешение, вам, возможно, придется пройти 100000 или даже 1000000, чтобы получить стабильные результаты.

Когда у вас есть последовательный ответ, вы можете использовать его тремя способами:

import profile # 1. Применить вычисленное смещение ко всем экземплярам Profile, созданным ниже. profile.Profile.bias = your_computed_bias # 2. Применить вычисленное смещение к конкретному экземпляру Profile. pr = profile.Profile() pr.bias = your_computed_bias # 3. Указать вычисленное смещение в конструкторе экземпляра. pr = profile.Profile(bias=your_computed_bias)

Если у вас есть выбор, вам лучше выбрать меньшую константу, и тогда ваши результаты будут «реже» отображаться как отрицательные в статистике профиля.

Использование пользовательского таймера

Если вы хотите изменить способ определения текущего времени (например,

принудительно использовать время настенных часов или прошедшее время процесса),

передайте нужную функцию синхронизации конструктору класса Profile:

pr = profile.Profile(your_time_func)

Полученный профилировщик вызовет your_time_func. В зависимости от того,

используете ли вы profile.Profile или cProfile.Profile,

возвращаемое значение your_time_func будет интерпретироваться по-разному:

profile.Profileyour_time_funcдолжен возвращать один номер или список номеров, чьи sum — это текущее время (например, то, что возвращаетos.times()). Если функция возвращает одно число времени или список возвращаемых чисел длины 2, то вы получить особо быструю версию диспетчеризации рутина.Имейте в виду, что вы должны откалибровать класс профилировщика для выбранной вами функции таймера (см. Калибровка). Для большинства машин таймер, возвращающий одиночное целочисленное значение, обеспечит наилучшие результаты с точки зрения низких накладных расходов при профилировании. (

os.times()— симпатичная, т. к. она возвращает кортеж значений с плавающей запятой). Если вы хотите заменить лучший таймер самым

чистым способом, создайте класс и задайте метод отправки замены, который лучше

всего обрабатывает ваш вызов таймера, вместе с соответствующей константой

калибровки.

Если вы хотите заменить лучший таймер самым

чистым способом, создайте класс и задайте метод отправки замены, который лучше

всего обрабатывает ваш вызов таймера, вместе с соответствующей константой

калибровки.cProfile.Profileyour_time_funcдолжен возвращать одно число. Если он возвращает целые числа, вы также можете вызвать конструктор класса с указанием второго аргумента реальная продолжительность одной единицы времени. Например, еслиyour_integer_time_funcвозвращает время в тысячах секунд вы должны построить экземплярProfileследующим образом:pr = cProfile.Profile(your_integer_time_func, 0.001)

Поскольку класс

cProfile.Profileне может быть откалиброван, пользовательские функции таймера следует использовать с осторожностью, и они должны работать как можно быстрее. Для достижения наилучших результатов с пользовательским таймером может потребоваться жестко закодировать его в исходном коде C внутреннего модуля_lsprof.

Python 3.3 добавляет несколько новых функций в time, которые можно

использовать для точного измерения времени процесса или настенных часов.

Например, см. time.perf_counter().

« предыдущий | следующий »

Общие сведения о профилировании — .NET Framework

- Статья

- Чтение занимает 9 мин

Профилировщик — это инструмент, который наблюдает за выполнением другого приложения. Профилировщик среды CLR — это библиотека DLL, содержащая функции, которые получают сообщения из среды CLR и отправляют сообщения в среду CLR с помощью API профилирования. Библиотека DLL профилировщика загружается средой CLR во время выполнения.

Традиционные средства профилирования основное внимание уделяют измерению выполнения приложения. То есть они измеряют время, затраченное на каждую функцию, или использование памяти приложением за период времени. API профилирования предназначен для более широкого класса диагностических средств, таких как служебные программы с покрытием кода и расширенные средства отладки. Сфера их применения — вся диагностика в природе. API профилирования не только измеряет, но также наблюдает за выполнением приложения. По этой причине API профилирования никогда не должен использоваться самим приложением, и выполнение приложения не должно ни зависеть от профилировщика, ни подвергаться его влиянию.

Для профилирования приложения среды CLR требуется дополнительная поддержка по сравнению с профилированием стандартно скомпилированного машинного кода. Это объясняется тем, что в среде CLR вводятся такие понятия, как домены приложений, сборка мусора, обработка управляемых исключений, JIT-компиляция кода (преобразование кода MSIL в машинный код) и другие аналогичные возможности. Механизмы традиционного профилирования не могут обнаруживать эти возможности или предоставлять полезные сведения о них. API профилирования эффективно предоставляет эти отсутствующие сведения с минимальным влиянием на производительность среды CLR и профилируемого приложения.

Механизмы традиционного профилирования не могут обнаруживать эти возможности или предоставлять полезные сведения о них. API профилирования эффективно предоставляет эти отсутствующие сведения с минимальным влиянием на производительность среды CLR и профилируемого приложения.

JIT-компиляция во время выполнения обеспечивает прекрасные возможности для профилирования. API профилирования позволяет профилировщику вносить изменения потока кода MSIL в памяти для подпрограммы перед ее JIT-компиляцией. Таким образом, профилировщик может динамически добавлять код инструментирования в определенные подпрограммы, требующие более глубокого анализа. Хотя такой подход возможен в обычных сценариях, его гораздо проще реализовать для среды CLR с помощью API профилирования.

API профилирования

Как правило, API профилирования используется для написания профилировщика кода, который является программой, отслеживающей выполнение управляемого приложения.

API профилирования используется библиотекой DLL профилировщика, которая загружается в один процесс с профилируемым приложением. библиотека DLL профилировщика реализует интерфейс обратного вызова (ICorProfilerCallback в платформа .NET Framework версии 1,0 и 1,1, ICorProfilerCallback2 в версии 2,0 и более поздних). Среда CLR вызывает методы этого интерфейса для уведомления профилировщика о событиях в процессе профилирования. Профилировщик может выполнить обратный вызов в среду выполнения, используя методы в интерфейсах ICorProfilerInfo и ICorProfilerInfo2 для получения сведений о состоянии профилированного приложения.

библиотека DLL профилировщика реализует интерфейс обратного вызова (ICorProfilerCallback в платформа .NET Framework версии 1,0 и 1,1, ICorProfilerCallback2 в версии 2,0 и более поздних). Среда CLR вызывает методы этого интерфейса для уведомления профилировщика о событиях в процессе профилирования. Профилировщик может выполнить обратный вызов в среду выполнения, используя методы в интерфейсах ICorProfilerInfo и ICorProfilerInfo2 для получения сведений о состоянии профилированного приложения.

Примечание

В одном процессе с профилируемым приложением должна запускаться только часть решения профилировщика, отвечающая за сбор данных. Весь анализ пользовательского интерфейса и данных должен выполняться в отдельном процессе.

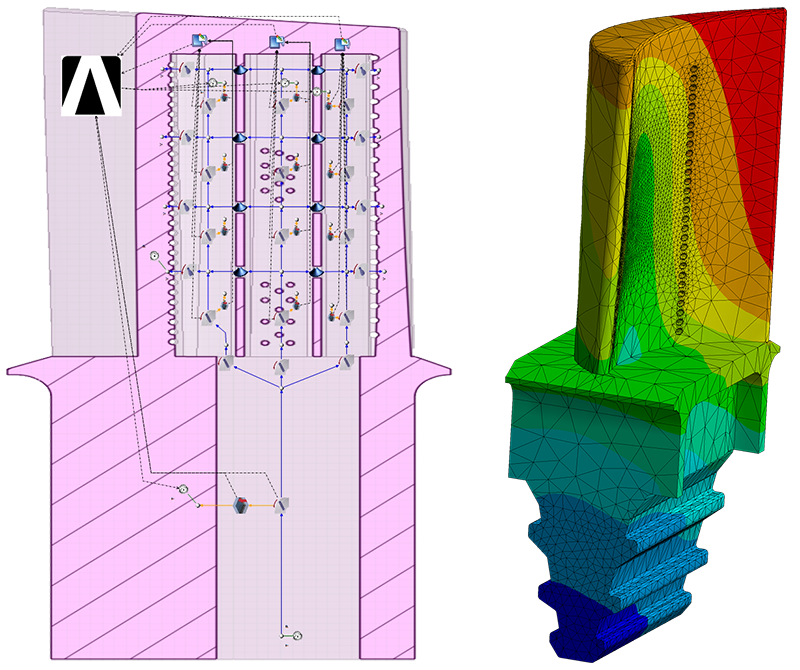

На следующем рисунке показано, как библиотека DLL профилировщика взаимодействует с профилируемым приложением и средой CLR.

Интерфейсы уведомлений

ICorProfilerCallback и ICorProfilerCallback2 могут считаться интерфейсами уведомления. Эти интерфейсы состоят из таких методов, как класслоадстартед, класслоадфинишеди JITCompilationStarted. Каждый раз, когда среда CLR загружает или выгружает класс, компилирует функцию и т. д., она вызывает соответствующий метод в интерфейсе

Каждый раз, когда среда CLR загружает или выгружает класс, компилирует функцию и т. д., она вызывает соответствующий метод в интерфейсе ICorProfilerCallback или ICorProfilerCallback2 профилировщика.

Например, профилировщик может измерять производительность кода с помощью двух функций уведомления: FunctionEnter2 и FunctionLeave2. Он просто устанавливает метки времени для каждого уведомления, собирает результаты и выводит список, в котором указывается, на какие функции было затрачено больше ресурсов ЦП или физического времени во время выполнения приложения.

Интерфейсы для извлечения сведений

Другими основными интерфейсами, участвующими в профилировании, являются ICorProfilerInfo и ICorProfilerInfo2. Профилировщик вызывает эти интерфейсы по мере необходимости для получения дополнительных сведений, помогающих выполнить анализ. Например, всякий раз, когда среда CLR вызывает функцию FunctionEnter2 , она предоставляет идентификатор функции. Профилировщик может получить дополнительные сведения об этой функции, вызвав метод ICorProfilerInfo2:: GetFunctionInfo2 , чтобы обнаружить родительский класс функции, его имя и т. д.

д.

Поддерживаемые компоненты

API профилирования предоставляет сведения о различных событиях и действиях, которые происходят в среде CLR. Эти сведения можно использовать для мониторинга внутренней работы процессов и анализа производительности приложения .NET Framework.

API профилирования извлекает сведения о следующих действиях и событиях, происходящих в среде CLR.

События запуска и завершения работы среды CLR.

События создания и завершения работы домена приложения.

События загрузки и выгрузки сборки.

События загрузки и выгрузки модуля.

События создания и удаления таблицы VTable COM.

События JIT-компиляции и пошагового выполнения кода.

События загрузки и выгрузки класса.

События создания и удаления потока.

События входа и выхода функции.

Исключения.

Переходы между выполнением управляемого и неуправляемого кода.

Переходы между различными контекстами среды выполнения.

Сведения о приостановках среды выполнения.

Сведения о действиях сборки мусора и кучи в памяти времени выполнения.

API профилирования можно вызывать из любого (неуправляемого) языка, совместимого с COM.

Этот API является эффективным с точки зрения потребления ресурсов ЦП и памяти. Профилирование не влечет за собой изменения профилируемого приложения, которые могут привести к недостоверным результатам.

API профилирования полезен для профилировщиков как с выборкой, так и без выборки. Профилировщик с выборкой проверяет профиль по регулярным тактовым импульсам, скажем, через 5 миллисекунд. Профилировщик без выборки уведомляется о событии синхронно с потоком, вызвавшим событие.

Неподдерживаемые функциональные возможности

API профилирования не поддерживает следующие функциональные возможности.

Неуправляемый код, который необходимо профилировать с помощью стандартных методов Win32.

Однако профилировщик среды CLR включает события переходов для определения границ между управляемым и неуправляемым кодом.

Однако профилировщик среды CLR включает события переходов для определения границ между управляемым и неуправляемым кодом.Самоизменяющиеся приложения, которые изменяют собственный код приложения, которые изменяют собственный код, например в целях аспектно-ориентированного программирования.

Проверка привязок, поскольку API профилирования не предоставляет эти сведения. Среда CLR предоставляет существенную поддержку для проверки границ всего управляемого кода.

Удаленное профилирование, которое не поддерживается по следующим причинам.

Удаленное профилирование увеличивает время выполнения. При использовании интерфейсов профилирования необходимо минимизировать время выполнения, чтобы оно не слишком сильно сказывалось на результатах профилирования. Это особенно важно при мониторинге производительности. Тем не менее удаленное профилирование не является ограничением при использовании интерфейсов профилирования для мониторинга использования памяти или для получения сведений времени выполнения о кадрах стека, объектах и т.

п.

п.Профилировщик кода среды CLR должен зарегистрировать один или несколько интерфейсов обратного вызова в среде выполнения на локальном компьютере, на котором выполняется профилируемое приложение. Это ограничивает возможность создания удаленного профилировщика кода.

Потоки уведомлений

В большинстве случаев поток, который создает событие, также выполняет уведомления. Такие уведомления (например, FunctionEnter и FunctionLeave) не требуют явного указания. Кроме того, профилировщик может использовать локальное хранилище потока для хранения и обновления своих блоков анализа вместо индексирования этих блоков в глобальном хранилище на основе ThreadID затронутого потока.

Обратите внимание, что эти обратные вызовы не сериализуются. Пользователи должны защищать свой код, путем создания потокобезопасных структур данных и путем блокировки кода профилировщика в тех случаях, когда необходимо предотвратить параллельный доступ из нескольких потоков. Таким образом, в некоторых случаях можно получить необычную последовательность обратных вызовов. Например, предположим, что управляемое приложение порождает два потока, выполняющие идентичный код. В этом случае можно получить событие ICorProfilerCallback:: JITCompilationStarted для некоторой функции из одного потока и обратный вызов из другого потока перед получением обратного вызова ICorProfilerCallback:: JITCompilationFinished . В этом случае пользователь получит обратный вызов

Таким образом, в некоторых случаях можно получить необычную последовательность обратных вызовов. Например, предположим, что управляемое приложение порождает два потока, выполняющие идентичный код. В этом случае можно получить событие ICorProfilerCallback:: JITCompilationStarted для некоторой функции из одного потока и обратный вызов из другого потока перед получением обратного вызова ICorProfilerCallback:: JITCompilationFinished . В этом случае пользователь получит обратный вызов FunctionEnter для функции, которая могла быть не полностью JIT-скомпилирована.

Безопасность

Библиотека DLL профилировщика — это неуправляемая библиотека DLL, которая выполняется в рамках подсистемы выполнения среды CLR. В результате на код в библиотеке DLL профилировщика DLL не налагаются ограничения управления доступом для управляемого кода. Для библиотеки DLL профилировщика действуют только ограничения, накладываемые операционной системой на пользователя, запускающего профилируемое приложение.

Разработчики профилировщика должны принять соответствующие меры предосторожности, чтобы избежать проблем, связанных с безопасностью. Например, во время установки библиотека DLL профилировщика должна добавляться в список управления доступом (ACL), чтобы злоумышленник не мог изменить ее.

Объединение управляемого и неуправляемого кода в коде профилировщика

Неправильно написанный профилировщик может вызвать циклические ссылки на себя, что приводит к непредсказуемому поведению.

Обзор API профилирования среды CLR может создать впечатление, что можно написать профилировщик, содержащий управляемые и неуправляемые компоненты, которые вызывают друг друга посредством COM-взаимодействия или непрямых вызовов.

Хотя это возможно с точки зрения проектирования, API профилирования не поддерживает управляемые компоненты. Профилировщик среды CLR должен быть полностью неуправляемым. Попытки объединить управляемый и неуправляемый код в профилировщике среды CLR могут привести к нарушениям прав доступа, сбоям программы или взаимоблокировкам. Управляемые компоненты профилировщика будут возвращать события обратно их неуправляемым компонентам, что будет затем вызывать управляемые компоненты снова, и таким образом будут создаваться циклические ссылки.

Управляемые компоненты профилировщика будут возвращать события обратно их неуправляемым компонентам, что будет затем вызывать управляемые компоненты снова, и таким образом будут создаваться циклические ссылки.

Единственное место, где профилировщик CLR может безопасно вызывать управляемый код, это текст MSIL в теле метода. Рекомендуемым методом изменения тела MSIL является использование методов JIT-компиляции в интерфейсе ICorProfilerCallback4 .

Кроме того, для изменения MSIL можно использовать старые методы инструментирования. Перед завершением JIT-компиляции функции профилировщик может вставить управляемые вызовы в текст MSIL метода, а затем выполнить JIT-компиляцию (см. метод ICorProfilerInfo:: GetILFunctionBody ). Этот способ можно успешно использовать для выборочного инструментирования управляемого кода или для сбора статистики и данных производительности касательно JIT.

Кроме того, профилировщик кода может вставлять собственные обработчики в текст MSIL любой управляемой функции, которая вызывает неуправляемый код. Этот способ можно использовать для инструментирования и покрытия. Например, профилировщик кода может вставить обработчики инструментирования после каждого блока MSIL для обеспечения выполнения блока. Изменение текста MSIL метода следует выполнять очень аккуратно и принимать во внимание множество факторов.

Этот способ можно использовать для инструментирования и покрытия. Например, профилировщик кода может вставить обработчики инструментирования после каждого блока MSIL для обеспечения выполнения блока. Изменение текста MSIL метода следует выполнять очень аккуратно и принимать во внимание множество факторов.

Профилирование неуправляемого кода

API профилирования среды CLR предоставляет минимальную поддержку профилирования неуправляемого кода. Предоставляются следующие функциональные возможности.

Перечисление цепочек стека. Эта возможность позволяет профилировщику кода определить границу между управляемым и неуправляемым кодом.

Определение, соответствует ли цепочка стека управляемому коду или машинному коду.

В .NET Framework версий 1.0 и 1.1 эти методы доступны через внутрипроцессное подмножество API отладки среды CLR. Они определяются в файле CorDebug.idl.

в платформа .NET Framework 2,0 и более поздних версиях для этой функции можно использовать метод ICorProfilerInfo2::D остаккснапшот .

Использование модели COM

Хотя интерфейсы профилирования определяются как COM-интерфейсы, среда CLR в действительности не инициализирует модель COM для использования этих интерфейсов. Причина заключается в том, чтобы не задавать модель потоков с помощью функции CoInitialize , прежде чем управляемое приложение сможет указать требуемую потоковую модель. Аналогично, сам профилировщик не должен вызывать CoInitialize, поскольку он может выбрать потоковую модель, несовместимую с профилируемым приложением, что может привести к сбою приложения.

Стеки вызовов

API профилирования предоставляет два способа получения стеков вызова: метод моментальных снимков стека, который позволяет реже выполнять сбор стеков вызовов, и метод теневого стека, который отслеживает стек вызовов в каждый момент времени.

Моментальный снимок стека

Моментальный снимок стека — это трассировка стека потока в момент времени. API профилирования поддерживает трассировку управляемых функций в стеке, но оставляет трассировку неуправляемых функций собственному обходчику стека профилировщика.

дополнительные сведения о программировании профилировщика для прохода по управляемым стекам см. в описании метода ICorProfilerInfo2::D остаккснапшот в этом наборе документации и в стеке профилировщика в платформа .NET Framework 2,0: основы и за пределами.

Теневой стек

Слишком частое использование метода моментального снимка может быстро создавать проблемы производительности. Если вы хотите часто получать трассировки стека, профилировщик должен создать теневой стек с помощью обратных вызовов исключений FunctionEnter2, FunctionLeave2, FunctionTailcall2и ICorProfilerCallback2 . Теневой стек всегда является текущим, и его можно быстро скопировать в хранилище каждый раз, когда требуется моментальный снимок стека.

Теневой стек может получать аргументы функций, возвращать значения и сведения об универсальных экземплярах. Эти сведения доступны только посредством теневого стека и могут быть получены, когда управление передается в функцию. Однако эти сведения могут оказаться недоступны позднее, во время выполнения функции.

Обратные вызовы и глубина стека вызовов

Обратные вызовы профилировщика могут осуществляться в условиях очень ограниченного стека, и переполнение стека в обратном вызове профилировщика приведет к немедленному завершению выполнения процесса. В ответ на обратные вызовы профилировщик должен гарантированно использовать минимально возможный стек. Если профилировщик предназначен для использования в процессах, устойчивых к переполнению стека, сам профилировщик должен также избегать активации переполнения стека.

| Заголовок | Описание |

|---|---|

| Установка профилирующей среды | В этом разделе объясняется, как можно инициализировать профилировщик, установить уведомления о событиях и профилировать службу Windows. |

| Профилирующие интерфейсы | В этом разделе описываются неуправляемые интерфейсы, которые использует API профилирования. |

| Глобальные статические функции профилирования | В этом разделе описываются неуправляемые глобальные статистические функции, которые использует API профилирования. |

| Перечисления профилирования | В этом разделе описываются неуправляемые перечисления, которые использует API профилирования. |

| Структуры профилирования | В этом разделе описываются неуправляемые структуры, которые использует API профилирования. |

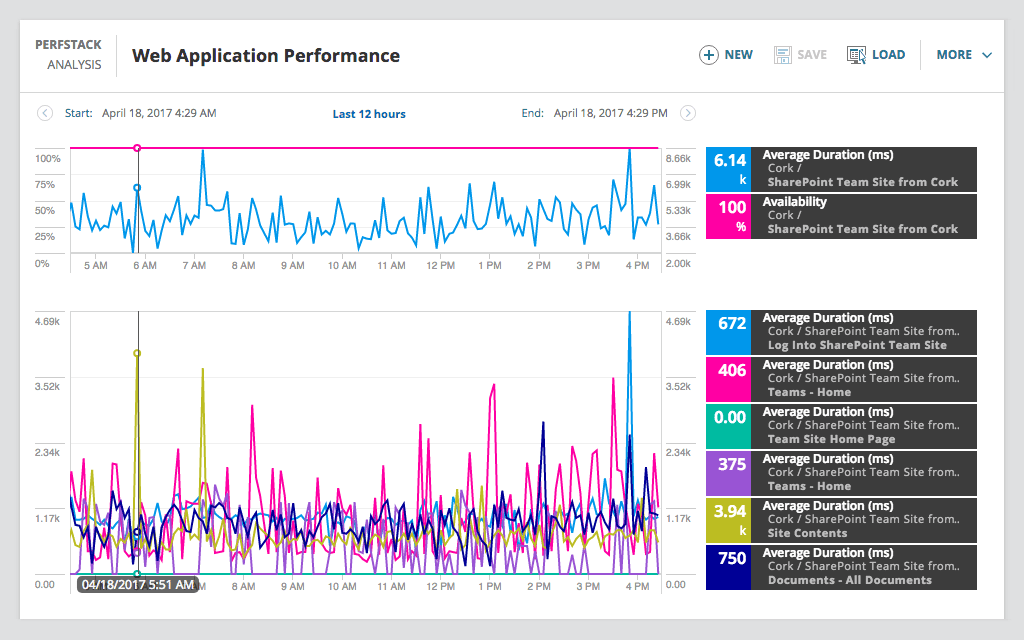

Введение в профилирование приложений Java в IDE NetBeans

Среда IDE предоставляет ряд внутренних параметров, позволяющих настраивать профилирования в соответствии с вашими требованиями. Например, можно уменьшить дополнительный расход ресурсов на профилирование за счет уменьшения объема созданной информации. Однако ознакомление со множеством доступных параметров может занять некоторое время. Для большинства приложений параметров по умолчанию, указанных для задач профилирования, достаточно для большинства ситуаций.

При профилировании проекта используется диалоговое окно «Выбор задачи профилирования» для выбора задачи в соответствии с необходимо информацией профилирования. В следующей таблице описываются задачи профилирования и результаты, получаемые в результате выполнения задачи.

В следующей таблице описываются задачи профилирования и результаты, получаемые в результате выполнения задачи.

| Задача профилирования | Результаты |

|---|---|

Наблюдение за приложением | Выберите для получения высокоуровневой информации о свойствах целевой JVM, включая активность потоков и распределение памяти. |

Анализ производительности ЦП | Выберите для получения подробных данных о производительности приложения, включая время выполнения методов и число вызовов метода. |

Анализ использования памяти | Выберите для получения подробной информации о выделении объектов и сборке мусора. |

Диалоговое окно «Выбор задачи профилирования» — основной интерфейс для выполнения задач профилирования. После выбора задачи можно изменить ее параметры для точной настройки получаемых результатов. Для каждой задачи профилирования также можно создать и сохранить пользовательские задачи профилирования на основе данной задачи. При создании пользовательской задачи профилирования она будет указана в диалоговом окне «Выбрать задачу профилирования», что позволяет позже просто найти и выполнить пользовательские параметры. При создании пользовательской задачи профилирования можно изменить дополнительные параметры профилирования, нажав кнопку Дополнительные параметры в диалоговом окне «Выбрать задачу профилирования».

При создании пользовательской задачи профилирования она будет указана в диалоговом окне «Выбрать задачу профилирования», что позволяет позже просто найти и выполнить пользовательские параметры. При создании пользовательской задачи профилирования можно изменить дополнительные параметры профилирования, нажав кнопку Дополнительные параметры в диалоговом окне «Выбрать задачу профилирования».

Наблюдение за приложением