что это значит, как ускорить процесс

Получи нашу книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Подпишись на рассылку и получи книгу в подарок!

Индексация сайта — это процесс поиска, сбора, обработки и добавления сведений о сайте в базу данных поисковых систем.

Больше видео на нашем канале — изучайте интернет-маркетинг с SEMANTICA

Индексация сайта значит, что робот поисковой системы посещает ресурс и его страницы, изучает контент и заносит его в базу данных.Впоследствии эта информация выдается по ключевым запросам. То есть, пользователи сети вводят в строку поиска запрос и получают на него ответ в виде списка проиндексированных страниц.

Если говорить простым языком, получится приблизительно так: весь интернет — это огромная библиотека.

Сегодня боты собирают и анализируют информацию по нескольким параметрам (ошибки, уникальность, полезность, доступность и проч.) прежде, чем внести ее в индекс поисковой системы.

Алгоритмы работы поисковых роботов постоянно обновляются и становятся все сложнее. Базы данных содержат огромное количество информации, несмотря на это поиск нужных сведений не занимает много времени. Это и есть пример качественной индексации.

Если сайт не прошел индексацию, то информация до пользователей может и не дойти.

Как индексирует сайты Гугл и Яндекс

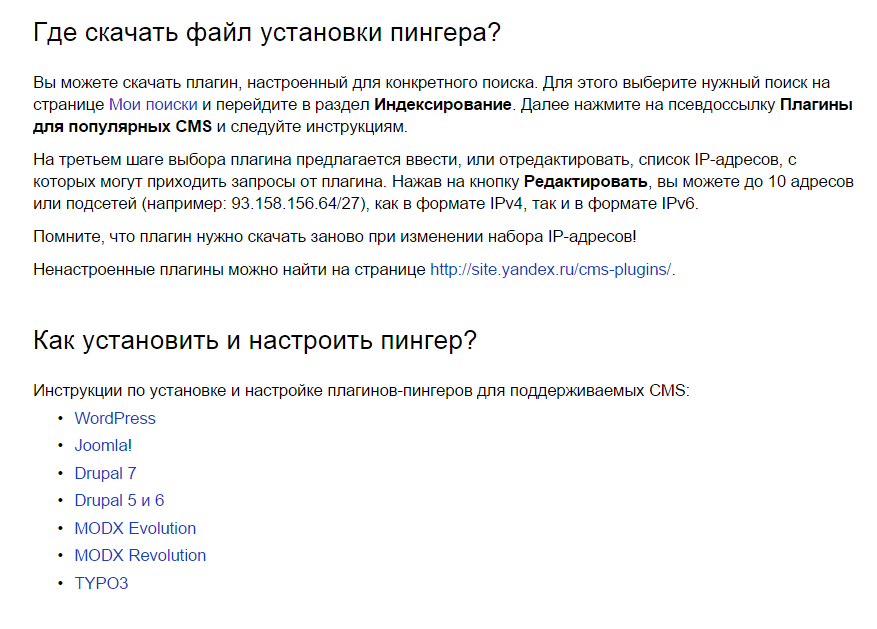

Яндекс и Гугл, пожалуй, самые популярные поисковики в России. Чтобы поисковые системы проиндексировали сайт, о нем нужно сообщить. Сделать это можно двумя способами:

- Добавить сайт на индексацию при помощи ссылок на других ресурсах в интернете — этот способ считается оптимальным, так как страницы, найденные таким путем, робот считает полезными и их индексирование проходит быстрее, от 12 часов до двух недель.

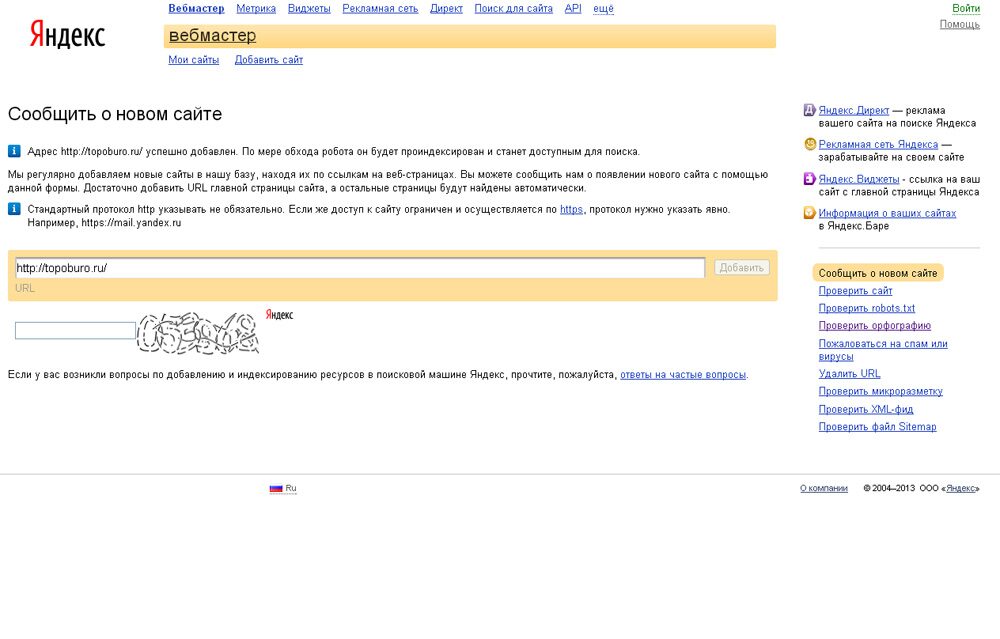

- Отправить сайт на индексацию путем заполнения специальной формы поисковой системы вручную с использованием сервисов Яндекс.Вебмастер, Google Webmaster Tools, Bing Webmaster Tools и др.

Второй способ медленнее, сайт встает в очередь и индексируется в течение двух недель или больше.

В среднем, новые сайты и страницы проходят индексацию за 1–2 недели.

Считается, что Гугл индексирует сайты быстрее. Это происходит потому, что поисковая система Google индексирует все страницы — и полезные, и неполезные. Однако в ранжирование попадает только качественный контент.

Яндекс работает медленнее, но индексирует полезные материалы и сразу исключает из поиска все мусорные страницы.

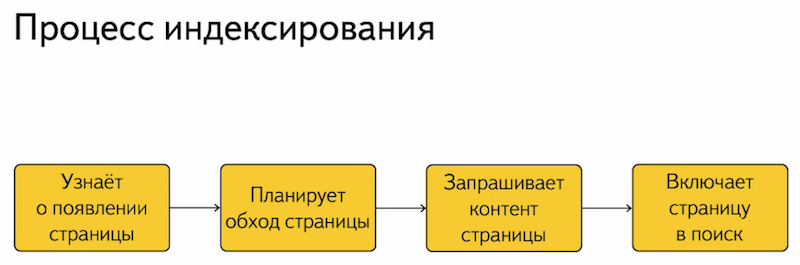

Индексирование сайта происходит так:

- поисковый робот находит портал и изучает его содержимое;

- полученная информация заносится в базу данных;

- примерно через две недели материал, успешно прошедший индексацию, появится в выдаче по запросу.

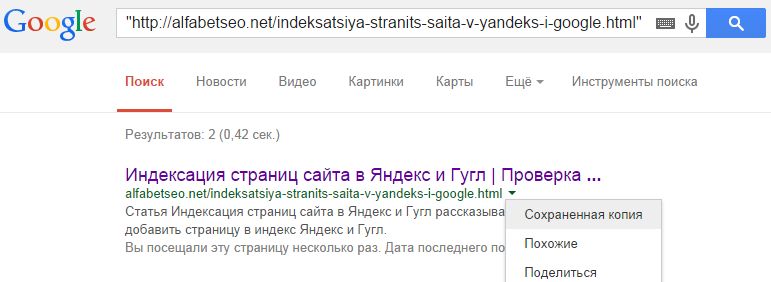

Есть 3 способа проверки индексации сайта и его страниц в Гугл и Яндексе:

- при помощи инструментов для вебмастеров — google.

com/webmasters или webmaster.yandex.ru;

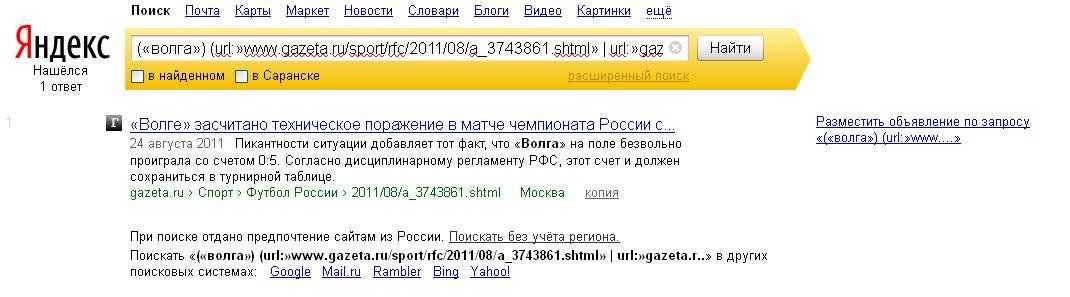

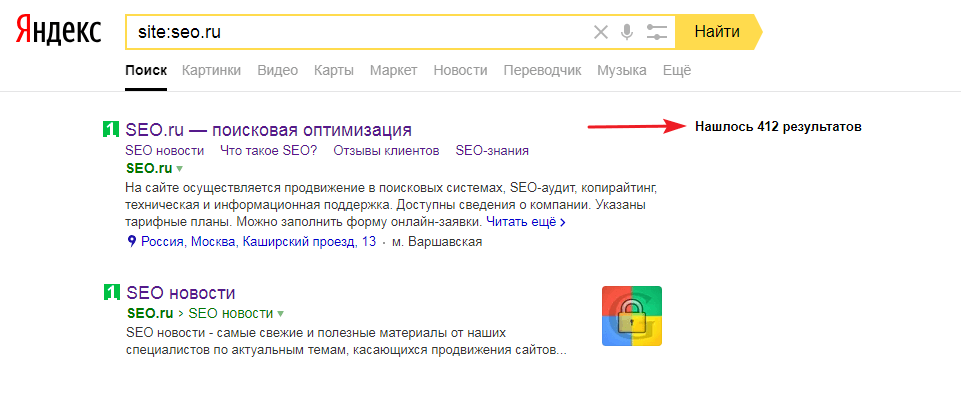

com/webmasters или webmaster.yandex.ru; - при помощи ввода специальных команд в поисковую строку, команда для Яндекс будет выглядеть так: host: имя сайта+домен первого уровня; а для Гугл — site: имя сайта+домен;

- с помощью специальных автоматических сервисов.

Проверяем индексацию

Это можно сделать используя:

- операторы поисковых систем — смотрим в справке ;

- услуги специальных сервисов, например rds бар;

- Яндекс вебмастер;

- Google вебмастер.

Как ускорить индексацию сайта

От того, насколько быстро роботы проведут индексирование, зависит скорость появления нового материала в поисковой выдаче, тем быстрее на сайт придет целевая аудитория.

Для ускорения индексации поисковыми системами нужно соблюсти несколько рекомендаций.

- Добавить сайт в поисковую систему.

- Регулярно наполнять проект уникальным и полезным контентом.

- Навигация по сайту должна быть удобной, доступ на страницы не длиннее, чем в 3 клика от главной.

- Размещать ресурс на быстром и надежном хостинге.

- Правильно настроить robots.txt: устранить ненужные запреты, закрыть от индексации служебные страницы.

- Проверить на наличие ошибок, количество ключевых слов.

- Сделать внутреннюю перелинковку (ссылки на другие страницы).

- Разместить ссылки на статьи в социальных сетях, социальных закладках.

- Создать карту сайта, можно даже две, — для посетителей и для роботов.

Как закрыть сайт от индексации

Закрыть сайт от индексации — запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Обычно это делается для того, чтобы скрыть от публичного доступа секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и т. п.

Сделать это можно несколькими способами:

- При помощи robots.txt можно запретить индексацию сайта или страницы. Для этого в корне веб-сайта создается текстовый документ, в котором прописываются правила для роботов поисковых систем.

Эти правила состоят из двух частей: первая часть (User-agent) указывает на адресата, а вторая (Disallow) запрещает индексацию какого-либо объекта.

Эти правила состоят из двух частей: первая часть (User-agent) указывает на адресата, а вторая (Disallow) запрещает индексацию какого-либо объекта.

Например, запрет индексации всего сайта для всех поисковых ботов выглядит так:

User-agent: *

Disallow: /

- При помощи мета-тега robots, что считается наиболее правильным для закрытия одной страницы от индексирования. При помощи тегов noindex и nofollow можно запретить роботам любых поисковых систем индексировать сайт, страницу или часть текста.

Запись для запрета индексации всего документа будет выглядеть так:

<meta name=»robots» content=»noindex, nofollow»/>

Можно создать запрет для конкретного робота:

<meta name=»googlebot» content=»noindex, nofollow»/>

На что влияет индексация при продвижении

Благодаря индексации сайты попадают в поисковую систему. Чем чаще обновляется контент, тем быстрее это происходит, так как боты чаще приходят на сайт. Это приводит к более высокой позиции при выдаче на запрос.

Это приводит к более высокой позиции при выдаче на запрос.

Индексация сайта в поисковых системах дает приток посетителей и способствует развитию проекта.

Кроме контента, роботы оценивают посещаемость и поведение посетителей. На основании этих факторов они делают выводы о полезности ресурса, чаще посещают сайт, что поднимает на более высокую позицию в поисковой выдаче. Следовательно, трафик снова увеличивается.

Индексация — это важный процесс для продвижения проектов. Чтобы индексирование прошло успешно, поисковые роботы должны убедиться в полезности информации.

Алгоритмы, по которым работают поисковые машины, постоянно меняются и усложняются. Цель индексации — внесение информации в базу данных поисковых систем.

Что такое индексация — самый полный гайд

Часто происходит путаница в терминологии: под индексацией иногда подразумевают сканирование сайта или совокупность и сканирования и индексации. В этом нет большой ошибки, часто путаницу вносят сами мануалы поисковых систем. Иногда в текстах Яндекса и Гугла можно увидеть использование термина индексация в разных контекстах, например:

Иногда в текстах Яндекса и Гугла можно увидеть использование термина индексация в разных контекстах, например:

Индексация сайта простыми словами

Так что же такое индексация: если кратко, то индексация (или индексирование, indexing) — один из процессов работы поисковых систем по построению поисковой базы в результате которого содержимое страниц попадает в индекс поисковой системы.

Для большей ясности приведу терминологию, а потом опишу все процессы.

Терминология

Планировщик (Scheduler) — программа, которая выстраивает маршрут обхода интернета роботами исходя из характеристик страниц, таких как частота обновления документов, востребованность этих страниц, цитируемость.

Crawler, Spider (Паук) Googlebot, YandexBot. Робот, ответственный за обход и скачивание страниц из интернета в порядке очередности, который задается планировщиком. Подразделяются на:

- Основной робот, обходящий контент в порядке общей очереди.

- Быстрый робот (быстроробот или быстробот). Робот, который использует свежий индекс, на основе группы заданных хабовых страниц с важной, часто обновляемой информацией, например, с новостями популярных СМИ.

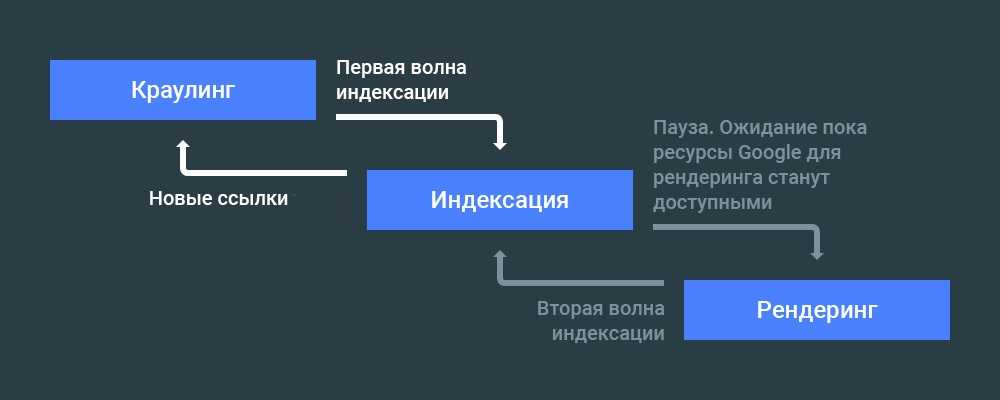

Сканирование (Crawling) — процесс загрузки страниц краулером в результате чего они попадают в хранилище, в виде сохраненных копий.

Краулинговый спрос: это то, как часто и в каком объеме робот бы хотел сканировать конкретные страницы.

Краулинговый лимит: ограничения скорости сканирования на стороне сайта, связанные с производительностью сайта или заданным вручную ограничением.

Краулинговый бюджет — это совокупность краулингового спроса и доступной скорости сканирования сайта (краулингового лимита). Простыми словами — это то сколько робот хочет и может скачать страниц.

Сохраненная копия — необработанная копия документа на момент последнего сканирования.

Поисковый индекс — информация со страниц, приведенная в удобный для работы поисковых алгоритмов формат. Список всех терминов и словопозиций где и на каких страницах они упоминаются. Информация хранится в базе в виде инвертированного индекса. Схематический пример:

Список всех терминов и словопозиций где и на каких страницах они упоминаются. Информация хранится в базе в виде инвертированного индекса. Схематический пример:

Индексация — процесс загрузки, анализа содержимого документа документа с последующим включением в поисковый индекс.

Поисковая база — это совокупность поискового индекса, сохраненных страниц и служебной информации о документах, таких как заголовки, типы и кодировка документов, коды ответов страниц, мета теги и др.

Как происходит сканирование сайта

Так как ресурсы поисковых систем не безграничны, планировщик составляет очередь обхода страниц, исходя критериев их полезности, востребованности, популярности и др. Каждый сайт получает свой краулинговый бюджет исходя из скоростных характеристик сайта и таких критериев как:

- Доля полезных/мусорных страниц на сайте, дубликаты

- Спамные и малополезные страницы

- Наличие бесконечной генерации страниц, например, некорректной фасетной навигации

- Популярность страниц

- Насколько актуальные версии страниц сайта, содержащиеся в поисковой базе

Робот в постоянном режиме скачивает страницы и помещает их в хранилище, заменяя старые версии. Мы можем увидеть их в виде сохраненных копий. Далее уже происходит индексация страниц.

Мы можем увидеть их в виде сохраненных копий. Далее уже происходит индексация страниц.

Как проходит индексация сайта

Индексацию можно условно разбить на следующие процессы:

- Загрузка и разбор страницы по элементам: текст, мета-теги, микроразметка, изображения, видео и другой контент и служебные данные.

- Анализ страницы по определенным параметрам, например: разрешена ли она к индексации, сканированию, является ли неглавной копией другой страницы, содержит ли страница малополезный, спамный контент и др.

- Если страница успешно прошла все проверки, она добавляется в индекс.

Как проходит индексация сайта в Яндексе

Все описанное в предыдущем пункте справедливо и для Яндекса и для Google. Какие есть особенности индексации у Яндекса?

У Google обновление поисковой базы — непрерывный процесс. В Яндексе обновление происходит во время Апдейтов, примерно раз в три дня. О том что произошло обновление можно узнать по уведомлениям в Яндекс. Вебмастере

Вебмастере

Как проверить индексацию

Есть разные способы для проверки статуса индексации сайтов и отдельных его страниц:

- Вебмастер Яндекса

- Панель Google Search Console

- API панели для вебмастеров Yandex/Google

- SEO-сервисы, например Rush Analytics

- Плагины и расширения для браузеров

- Поисковые операторы ПС

- GA/Метрика

- Серверные логи

Выбор сервиса зависит от поисковой системы, а также задачи: узнать сколько страниц всего в индексе, получить список проиндексированных страниц или проверить статус индексации конкретной страницы или списка страниц. Подробнее расписано ниже.

Как узнать сколько страниц проиндексировано на сайте

Расширения для браузера

Быстрые способы проверить статус индексации сайта — расширения и букмарклеты для браузера, например RDS-бар

Сервисы для анализа сайтов

Так же можно проверить с помощью сервисов, таких как pr-cy. ru

ru

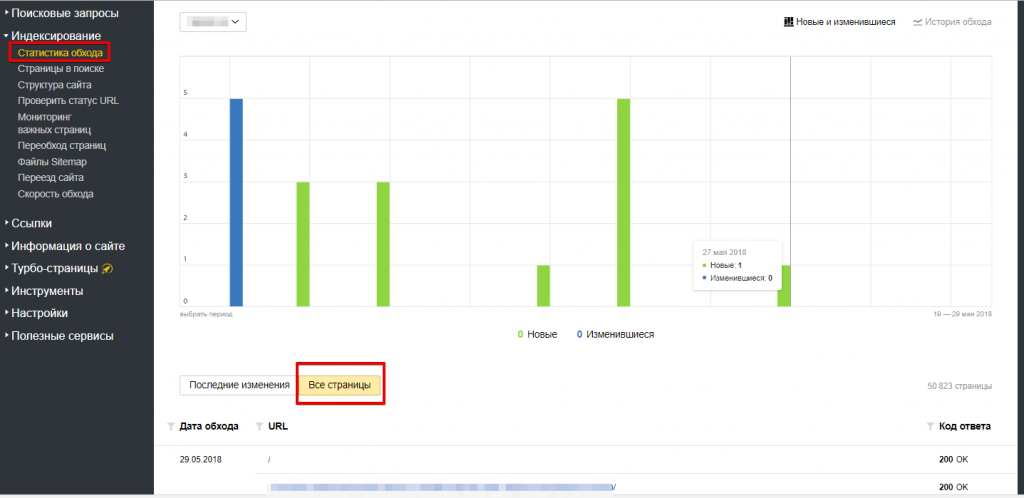

Яндекс.Вебмастер и Google Search Console

Если есть доступы к панелям вебмастеров, можно получить количество проиндексированных страниц в панелях вебмастеров:

Яндекс Вебмастер — http://webmaster.yandex.ru

Google Search Console — https://search.google.com/search-console/

С помощью специализированных программ для SEO, например Allsubmitter, Netpeak Checker.

Это может понадобиться когда нужна пакетная проверка параметров чужих сайтов.

Пример проверки числа проиндексированных страниц в Netpeak Checker.

Проверка индексации сайтов в Яндекс:

Проверка индексации сайтов в Google:

Пример проверки индексации сайтов в Яндекс и Google в Allsubmitter.

Как выгрузить список проиндексированных страниц сайта в Яндексе и Google

Яндекс Вебмастер: Отчет индексирование -> Страницы в поиске -> Все страницы

Внизу страницы ссылки на скачивание файла — cуществует ограничение в 50 000 страниц.

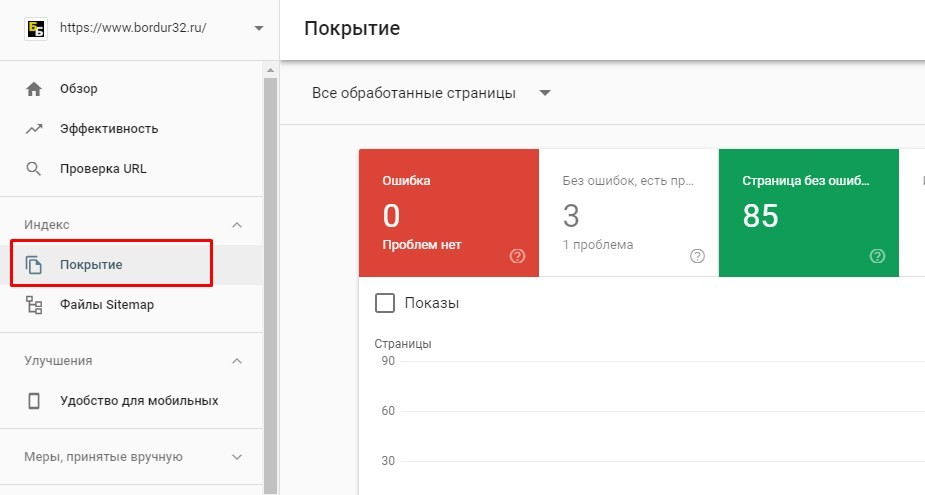

Google Search Console: в отчете Покрытие — выбираем нужные типы страниц

Переходим в нужный отчет и скачиваем список страниц в удобном формате. Google отдает только 1 000 страниц.

Поисковые операторы Яндекса

Запрос для поиска страниц в пределах одного домена — url:www.site.ru/* | url:site.ru/* | url:site.ru | url:www.site.ru.

Запрос для поиска с учетом всех поддоменов — site:site.ru

Список операторов и инструкцию по работе с ними можно посмотреть в справке Яндекса.

Ограничение: можно получить только 1000 результатов. Нужны специальные инструменты чтобы скопировать список страниц SERP: расширения браузера, букмарклеты или программы для парсинга выдачи.

Поисковые операторы Google

Запрос для поиска страниц в пределах одного сайта — site:site.ru

Получение списка страниц входа из систем веб-аналитики

Списки страниц входа из органики Яндекса в системах аналитики Яндекс. Метрика и Google.Analytics. Страницы по которым идут переходы с органической выдачи с большой вероятностью индексируются, но для точности рекомендуется проверять индексацию собранных страниц — индекс не статичен и страницы могут выпадать из индекса.

Метрика и Google.Analytics. Страницы по которым идут переходы с органической выдачи с большой вероятностью индексируются, но для точности рекомендуется проверять индексацию собранных страниц — индекс не статичен и страницы могут выпадать из индекса.

Список страниц по которым сайт показывается в выдаче в Яндекс.Вебмастере

Для выгрузки большого списка страниц из Яндекс.Вебмастера потребуется специальный скрипт.

Плагин для API Google Webmasters: Google Search Analytics for Sheets

Отображает страницы по которым были показы сайта в выдаче.

Преимущества выгрузки списка страниц через API в том что можно получить десятки тысяч страниц, которые с большой вероятностью проиндексированы, в отличие от веб-интерфейса где установлено ограничение по выгрузкам в 1000 страниц.

Серверные логи сайта

Получить список страниц которые посещает робот можно из логов, например с помощью программы SEO Log File Analyser от создателей Screaming Frog.

Как проверить индексацию конкретной страницы в Яндексе и Google

Сервис Яндекс.Вебмастер:

Проверка с помощью оператора: пример запроса url:https://site.com/page/

Сервис Google Search Console: инструмент “Покрытие”

Нужно ввести в указанной на скрине строке поиска URL-адрес своего сайта и откроется отчет о статусе страницы.

Проверка с помощью оператора: пример запроса site:https://habr.com/ru/news/t/468361/

После отмены оператора info остался оператор site, но он выдает не всегда точные данные, можно сократить список результатов с помощью указания уникального текста проверяемой страницы.

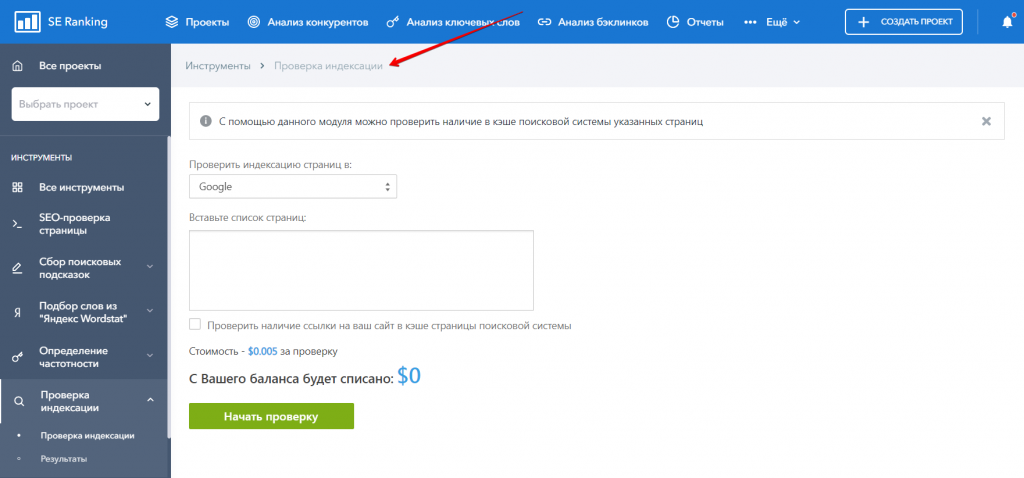

Как массово проверить индексацию списка страниц

Для проверки можно использовать SEO-сервисы, например Rush Analytics.

Это позволяет массово проверить индексацию до десятков-сотен тысяч страниц

Как проверить разрешена индексация/сканирование страницы в Robots.

txt

txtВ Яндексе

Проверить доступна ли роботам страница или содержит запрет можно через. Инструменты -> Анализ robots.txt

В Google

Инструмент проверки файла robots.txt

Важно: если файл robots.txt отдает 404 ошибку, боты считают что разрешено сканирование всего сайта без ограничений. Если файл отдает ошибку 5хх, то Googlebot считает это полным запретом на сканирование сайта, но если ошибка отдается более 30 дней — считает что разрешено сканировать весь сайт без ограничений. Яндекс любые серверные ошибки считает отсутствием файла robots.txt и отсутствием ограничений на обход и индексацию сайта.

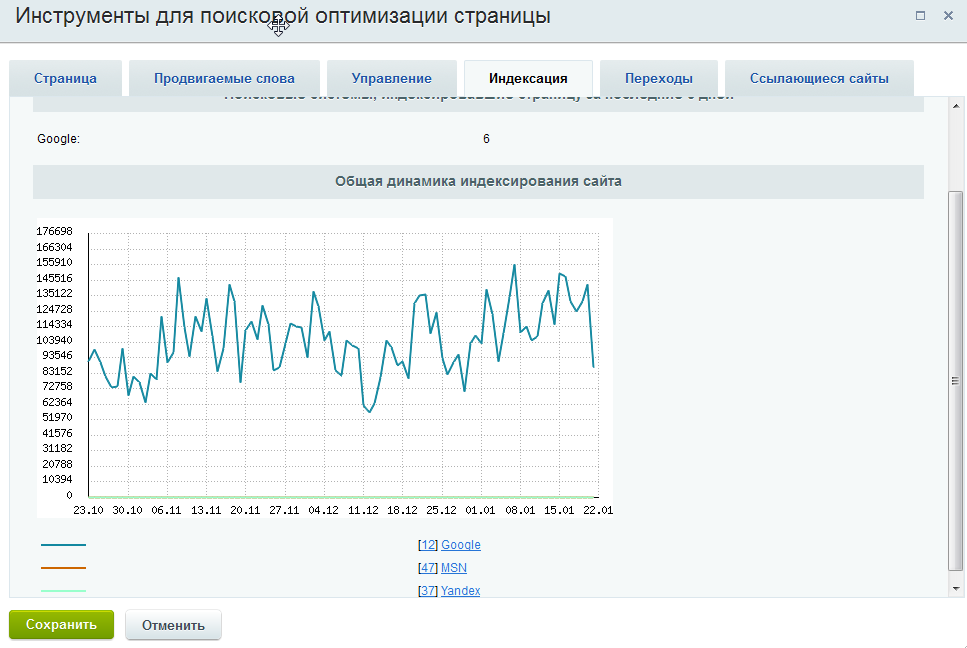

Как узнать динамику числа проиндексированных страниц

С помощью специализированных сервисов, например: https://be1.ru/

С помощью Яндекс Вебмастера: в разделе Индексирование -> Страницы в поиске.

С помощью Google Search Console: в отчете Покрытие.

Почему число проиндексированных страниц может отличаться в разных сервисах?

Нужно понимать что проиндексированные страницы и страницы в поиске это разные сущности. Не все проиндексированные страницы будут включены в поиск и не все страницы в поиске будут показываться через операторы поиска — операторы лишь выводят результаты пустого поиск по сайту а не список всех страниц. Но этого в большинстве случаев достаточно чтобы оценить порядок числа проиндексированных страниц сайта.

Запрет индексации страниц

Запрет индексации с помощью Meta Noindex/X-Robots-Tag

Для гарантированного исключения попадания страниц в индекс можно использовать атрибут Noindex Мета Тега Robots или HTTP-заголовка X-Robots-Tag. Подробнее про этот атрибут можно прочитать тут.

Важно: Использование запрета индексации в через Meta/X-Robots-Tag Noindex вместе с запретом в Robots.txt

При добавлении директивы Noindex в мета-тег Robots и http-заголовок X-Robots-Tag, чтобы ее прочитать, робот должен просканировать страницу, поэтому она должна быть разрешена в файле Robots.![]() txt. Следовательно для точечного запрета индексации страниц иногда требуется снять запрет в robots.txt или добавить директиву Allow, чтобы робот смог переобойти эти страницы.

txt. Следовательно для точечного запрета индексации страниц иногда требуется снять запрет в robots.txt или добавить директиву Allow, чтобы робот смог переобойти эти страницы.

Несмотря на вышеописанное, запрет в robots.txt в большинстве случаев все таки приведет к тому, что страницы не будут индексироваться, но его нельзя использовать для закрытия персональных данных или страниц с конфиденциальной информацией.

Как запретить индексацию страницы в robots.txt

Стоит сразу упомянуть что запрет в robots.txt не является надежным методом закрытия страниц от индексации.

В файле robots.txt указываются основные директивы для запрета или разрешения обхода/индексации отдельных страниц или разделов сайта.

Важно: Многие ошибочно считают что директива Disallow в Robots.txt служит для запрета индексации страниц, это не совсем так. Основная цель файла Robots.txt — управление трафиком поисковых роботов на сайте, а не индексацией / переиндексацией и разные поисковые системы по разному интерпретируют запрет.

Многие вебмастера не понимают почему после запрета страницы в robots.txt она продолжает находиться в индексе и приносить трафик. Запрет посещения и обновления страницы роботом не означает, что он обязан удалить уже присутствующую в индексе страницу. К тому же для индексации не всегда обязательно физически сканировать страницу, информацию о ней можно собирать из различных источников, например, из анкоров входящих ссылок.

Почему заблокированные в robots.txt страницы отображаются в выдаче?

В Яндексе и Google различается механизм обработки директив файла Robots.txt. Для Google директива Disallow в robots.txt запрещает лишь обход страниц, но не их индексацию из-за чего часто появляются страницы со статусом:

Для запрета индексации в Google через файл Robots.txt ранее использовалась незадокументированная директива Noindex в Robots.txt, но с сентября 2019 года Google перестал поддерживать ее.

На данный момент для надежного запрета индексации страниц в Google рекомендуется использовать атрибут Noindex Мета Тега Robots и HTTP-заголовка X-Robots-Tag.

Яндекс же, наоборот, воспринимает запрет в Robots.txt Disallow: как сигнал к запрету и сканирования и индексирования сайта и после добавления директивы Disallow: страницы будут удалены из индекса.

Использование атрибута canonical для запрета индексации дубликатов

Для консолидации дубликатов или похожих страниц страниц используется атрибут canonical, который указывает поисковикам по какому адресу рекомендуется индексировать страницу. Носит рекомендательный нестрогий характер.

Два типа использования:

- Тег <link> с атрибутом rel=»canonical»

- HTTP-заголовок rel=canonical

Использование директивы clean-param для удаления из индекса

Директива clean-param файла Robot.txt используется только Яндексом. Указывает незначащие параметры, которые будут по возможности вырезаться из URL-адресов при обходе сайта. Страницы, запрещенные в Clean-Param будут исключены из индекса. Yandex» search_bot

Yandex» search_bot

Запрет сканирования, индексации с помощью кодов ответа сервера 3хх/4хх

Чтобы гарантированно запретить роботам скачивать страницы, можно отдавать ботам при сканировании страниц коды:

- 301 редирект: особенно подходит для запрета дубликатов и склейки их с основными страницами;

- 403 Forbidden: доступ запрещен;

- 404 Not Found: не найдено;

- 410 Gone: удалено;

Удаление страниц из индекса

Удаление страниц или каталогов через Search Console

Инструмент не запрещает страницы к индексации или сканированию — он лишь временно скрывает страницы из поисковой выдачи. Рекомендуется использовать только для экстренного удаления страниц, случайно попавших в выдачу, после этого уже физически удалить их или запретить сканирование/индексацию.

Ускоренное удаление из индекса страниц в Яндексе

На сайт должны быть подтверждены права. Можно удалить только страницы, которые недоступны для робота: запрещенные в robots. txt или отдавать код 3хх, 4хх.

txt или отдавать код 3хх, 4хх.

Для удаления из индекса Яндекса страниц чужого сайта можно воспользоваться формой — https://webmaster.yandex.ru/tools/del-url/.

Требования к URL-адресам такие же: запрет в robots.txt или коды ответа 301, 403, 404, 410 и т.п.

Как добавить страницы в индекс Яндекса или Google

Роботы постоянно ходят по ссылкам на сайтах. Для ускорения добавления существуют инструменты:

- Sitemap.xml. Добавьте и регулярно обновляйте актуальный список страниц в сайтмапах сайта.

- В Яндексе: инструменты -> переобход страниц

- В Google: Проверка URL -> Запросить индексирование

Как проверить обход / сканирование сайта поисковыми системами

Яндекс:

Общее количество загруженных (просканированных) Яндексом страниц можно увидеть на главной странице вебмастера.

Динамику обхода страниц можно увидеть на странице Индексирование -> Статистика обхода.

Google: отчет: статистика сканирования сайта.

Также можно проверить обход сайта всеми поисковыми роботами с помощью анализа серверных логов сайта (Access logs). Например, через программу SEO Log File Analyser.

Как часто происходит индексация сайта

Поисковые боты постоянно равномерно загружают страницы сайта, далее выкладывая их в обновленный индекс: Google обновляет индекс в постоянном режиме, Яндекс во время апдейтов поисковой базы, примерно раз в три дня.

Частота сканирования и переиндексации каждого отдельного сайта различается, и зависит от факторов:

- объем контента/страниц сайта

- краулинговый спрос поисковой системы для текущего сайта

- настройки скорости сканирования в вебмастерах

- скорость работы сайта

Как улучшить и ускорить индексацию сайта

Рекомендации для увеличения охвата страниц индексом поисковых систем:

- качественный уникальный контент, востребованный пользователями

- все основные страницы должны быть в валидных сайтмапах sitemap.

xml

xml - оптимизация вложенности страниц

- оптимизация краулингового спроса/бюджета

- хорошая скорость сайта

- закрывать лишние страницы, чтобы не тратить на них ресурсы роботов

- внутренняя перелинковка

- создание ротарора на сайте (Ловец ботов)

Как ограничить скорость сканирования сайта

Обычно если требуется ограничить нагрузку, которую создают роботы, то у сайта большие проблемы и это негативно скажется на его индексации. Боты стараются быть “хорошими” юзерами и сканируют сайт равномерно, стараясь не перегружать сервера.

То что сайт от этого испытывает проблемы с нагрузкой, в 90% случаев может быть сигналом к смене хостинга/сервера или оптимизации производительности CMS. Но в случае крайней необходимости все таки можно задать рекомендуемую скорость сканирования сайта.

Для ограничения скорости обхода сайта можно воспользоваться инструментами Яндекс.Вебмастер и Google

Яндекс:

Google:

В старой версии консоли можно было временно ограничить максимальную скорость сканирования сайта

В обновленной консоли такой возможности нет, но можно отправить сообщение о проблеме с активностью GoogleBot’а на сайте — https://www. google.com/webmasters/tools/googlebot-report

google.com/webmasters/tools/googlebot-report

Как провести анализ индексации сайта

23421 52

| How-to | – Читать 11 минут |

Прочитать позже

ЧЕК-ЛИСТ: АНАЛИТИКА

Инструкцию одобрил SEO Classifieds Specialist в Inweb

Виктор Саркисов

От индексирования сайта зависит его дальнейшее продвижение. Если вы создадите более тысячи качественных и уникальных страниц, но они будут не проиндексированы, никакого результата вы не получите. Для этого необходим анализ индексации сайта, о котором мы расскажем в статье. Также рассмотрим, как быстро проиндексировать сайт.

Содержание:

- Что такое индексация сайта

- Зачем проводить анализ индексации сайта

- Google Console & Яндекс.Вебмастер

- Сколько нужно времени для индексации сайта

- Как проверять индексацию сайта самостоятельно?

- Как проверить полученную из Google Search Console информацию

- Плагины и букмарклеты

- Вспомогательные сервисы для проверки на индексацию

- Заключение

- FAQ

Что такое индексация сайта

Индексация сайта — процесс, при котором бот поисковой системы добавляет сведения о ресурсе в базу данных поисковика для последующего поиска информации на сайтах, которые были проиндексированы. В процессе индексации поисковые боты сканируют и обрабатывают текстовые данные, картинки, видео, документы, аудио. Индексацией можно управлять с помощью определенных директив в файле robots.txt и тегов на веб-страницах, при желании можно закрывать доступ роботам к некоторым страницам, разделам или всему сайту.

В процессе индексации поисковые боты сканируют и обрабатывают текстовые данные, картинки, видео, документы, аудио. Индексацией можно управлять с помощью определенных директив в файле robots.txt и тегов на веб-страницах, при желании можно закрывать доступ роботам к некоторым страницам, разделам или всему сайту.

Благодаря индексации пользователям доступен поиск всей необходимой информации в интернете, а владельцы ресурсов могут продвигать свои проекты в поисковых системах.

Зачем проводить анализ индексации сайта

Проверка индексации страниц необходима, чтобы вебмастер был в курсе, как роботы сканируют сайт, не возникают ли при этом ошибки. Если сайт плохо индексируется у него будет низкая посещаемость, вследствие которой он не будет приносить прибыль. У интернет-магазина не будет достаточного количества продаж, а информационные проекты не заинтересуют рекламодателей. Чтобы опередить конкурентов в выдаче, важно обеспечить наличие всех необходимых страниц в выдаче поисковых систем.

Мониторинг количества страниц в поиске проводится постоянно. Увеличение количества страниц в поиске помогает сайту ранжироваться по большему количеству запросов и улучшает позиции в выдаче.

Google Console & Яндекс.Вебмастер

Индексация сайта в поисковых системах проводится отдельно для каждого поисковика. Поэтому анализировать ее тоже нужно по отдельности.

Основной инструмент, в котором можно отправить запрос на добавление страницы в поисковый индекс Google — Search Console. Для поиска Яндекс — Яндекс.Вебмастер. С их помощью вы повлияете на сканирование страниц, например, отправив страницу на повторное сканирование после устранения ошибки. Выглядит интерфейс Search Console так:

Проверка статуса индексирования в Search Console

Интерфейс Яндекс.Вебмастер:

Проверка индексации страниц в Яндекс.Вебмастере

Сколько нужно времени для индексации сайта

Отправить запрос на индексацию сайта в Google можно в Search Console. Для этого укажите адрес XML-карты сайта в разделе Sitemap. Должно пройти определенное время перед тем, как все страницы нового сайта окажутся в индексе, ориентировочно несколько месяцев.

Для этого укажите адрес XML-карты сайта в разделе Sitemap. Должно пройти определенное время перед тем, как все страницы нового сайта окажутся в индексе, ориентировочно несколько месяцев.

При отправке отдельной страницы в индекс с помощью инструмента «Проверка URL» Search Console индексация может произойти как через несколько минут, так и через несколько недель. В отдельных случаях Google может вообще не проиндексировать страницу, посчитав ее недостаточно качественной, неуникальной или дублирующей ранее размещенную на сайте информацию. В этом случае отправлять запрос на повторное индексирование страницы без ее предварительного изменения и улучшения не имеет смысла.

Индексация сайта Яндексом занимает примерно такие же сроки, как и Гуглом. Добавить ссылку на XML-карту сайта можно В Яндекс.Вебмастере в разделе «Индексирование», выбрав «Файлы Sitemap».

Как проверять индексацию сайта самостоятельно?

Добавьте сайт в панель и подтвердите права доступа удобным способом.

Мониторьте индексирование через путь: Индекс Google > Статус индексирования.

Выполните такие же действия для Яндекс.Вебмастера. Путь для просмотра: Индексирование > Страницы в поиске.

В расширенных данных вы получите информацию о заблокированных к индексации страницах файлом robots.txt. Учитывая нововведения, которые произошли в Search Console, стоит отметить, что вы увидите страницы, которые были проиндексированы несмотря на запрет в robots.txt.

Важно: Распространенная ошибка заключается в блокировке индексации через директивы robots.txt. Если вы заметили, что сайт не индексируется, начните поиск проблемы отсюда, возможно, роботы не могут его проиндексировать.

Ресурс в разделе Технической поддержки официально объявляет, что информация может «частично соответствовать» виду в поиске. Подробное объяснение здесь. Причины следующие:

Информация по статусу индексирования от Google

Важно: Все сообщения об ошибках индексации вы получаете на той же площадке. Также они дублируются письмом на вашу почту. Все обнаруженные ошибки нужно устранить и отправить страницы на переиндексацию.

Также они дублируются письмом на вашу почту. Все обнаруженные ошибки нужно устранить и отправить страницы на переиндексацию.

Как проверить полученную из Google Search Console информацию

Проверьте полученную информацию просто и быстро при помощи операторов:

Оператор Site

В поиске вы увидите такую картину:

Пример проверки индексации страниц с помощью оператора Site в Google

«Результатов примерно…» — это и есть количество проиндексированных страниц в поиске. Для Яндекса ситуация схожая:

Пример проверки индексации страниц с помощью оператора Site в Яндекс

Операторы Яндекса подробно описаны в Яндекс.Помощи.

Также можно быстро узнать видимость домена с помощью Serpstat. Показатель видимости учитывает количество фраз, по которым ранжируется домен, и их частотность.

Плагины и букмарклеты

В некоторых онлайн сервисах также предлагается массовая проверка индексации сразу в нескольких поисковых системах. Проверки могут быть платными и бесплатными.

Проверки могут быть платными и бесплатными.

Для экономии времени вебмастерам удобнее работать со встроенными плагинами, например, RDS bar, который бесплатно устанавливается через магазин и работает прямо в панели Google Chrome.

Информация об индексации сайта в плагине RDS bar

Одним кликом по иконке в браузере вы откроете базовую информацию по сайту. В том числе по количеству страниц в индексе.

Вспомогательные сервисы для проверки на индексацию

Воспользуйтесь готовыми инструментами, которые проводят анализ сайта. Например, в Аудите сайта Serpstat можно проверить, сколько страниц не проиндексировано и наличие технических ошибок на сайте.

Нажмите на кнопку ниже и создайте проект для сайта ↓

Перед началом сканирования введите необходимые настройки: название домена, количество страниц, скорость сканирования, тип сканирования и т.д.:

Выбор проекта для аудита

Установка лимита сканирования страниц

После окончания сканирования в Суммарном отчете на графике можно проверить, какое количество из указанного в настроках перед запуском аудита страниц не проиндексировано:

Информация о количестве непроиндексированных страниц в отчете

Хотите узнать, как с помощью Serpstat найти и исправить технические ошибки на сайте?

Оставьте заявку и наши специалисты проконсультируют вас по продвижению вашего проекта, поделятся учебными материалами и инсайтами рынка!

| Заказать бесплатную консультацию |

Подойдет и комплексный аудит сайта от saitreport поможет посмотреть количество проиндексированных страниц бесплатно:

Проверка индексации в Saitreport

Или используйте другие удобные для вас помощники: a. pr-cy, sitechecker.

pr-cy, sitechecker.

Проверка индексации в сервисе a.pr-cy.ru

Каждый SEO анализатор в 80% случаев включает информацию об индексировании сайта. Анализаторы генерируют готовые отчеты, что освободит вас от ручного управления. Ряд инструментов работает под задачи SEO и позволяет добавлять разные сайты/компании для мониторинга, чтобы все информация была в одном месте.

Для получения информации по каждой странице воспользуйтесь Netpeak Checker. Выгрузите все URL, а Netpeak Checker проверит индексацию страниц вашего сайта. Это займет время, но результат будет точным и полным.

Заключение

Способы проверки индексации сайта:

- с помощью Google Search Console & Яндекс.Вебмастер;

- с помощью операторов;

- с помощью плагинов и букмарклетов;

- с помощью вспомогательных сервисов.

Отслеживайте индексирование сайта регулярно и вносите информацию в отчет. Подобные таблицы делайте вручную или используйте готовые отчеты в вспомогательных сервисах. Примеры и ссылки указаны выше. Совмещайте несколько инструментов для большей точности информации.

Подобные таблицы делайте вручную или используйте готовые отчеты в вспомогательных сервисах. Примеры и ссылки указаны выше. Совмещайте несколько инструментов для большей точности информации.

Зачем это нужно? Чтобы держать руку на пульсе. Если страницы уникальны и качественны, но долгое время не индексируются, пора искать проблему. Регулярно собирайте информацию о соотношении проиндексированных страниц и динамике их индексации, отслеживайте тренды. Такой подход даст вам возможность вовремя внести изменения в стратегию продвижения.

Как узнать количество страниц на сайте?

Узнать количество страниц на ресурсе можно с помощью анализа файла sitemap.xml. Его в большинстве случаев можно просмотреть по адресу site.com/sitemap.xml. Приблизительное количество страниц сайта можно также узнать с помощью оператора site:, добавив к нему адрес ресурса и отправив данный поисковый запрос в Яндексе или Google.

Как проверить статус индексирования?

Проверить индексацию страниц в Google можно в разделе «Индекс» → «Покрытие» Google Search Console. Проверку индексации сайта в Яндексе проводят в Яндекс.Вебмастере. Помимо этого, можно использовать оператор Site или плагин RDS bar.

Проверку индексации сайта в Яндексе проводят в Яндекс.Вебмастере. Помимо этого, можно использовать оператор Site или плагин RDS bar.

Как ускорить индексацию страниц сайта?

Отдельные страницы можно отправить на переиндексацию с помощью Search Console и Яндекс.Вебмастер. Также важно, чтобы были корректно настроены XML-карта сайта, robots.txt, правильно прописаны теги на веб-страницах. На индексацию положительно влияет регулярное добавление качественного уникального контента, ускорение загрузки страниц, внутренняя перелинковка и другие факторы.

Как запретить индексацию сайта?

Чтобы запретить индексацию сайта, можно добавить соответствующую директиву в файл robots.txt: User-agent: * Disallow: / Если проект на WordPress, можно отметить в настройках: «Попросить поисковые системы не индексировать сайт», тогда директива, запрещающая индексацию, добавится в robots.txt автоматически.

Задавайте вопросы в комментариях или пишите в техподдержку. 🙂 А также вступайте в чат любителей Серпстатить и подписывайтесь на наш канал в Telegram.

🙂 А также вступайте в чат любителей Серпстатить и подписывайтесь на наш канал в Telegram.

Сэкономьте время на изучении Serpstat

Хотите получить персональную демонстрацию сервиса, тестовый период или эффективные кейсы использования Serpstat?

Оставьте заявку и мы свяжемся с вами 😉

Оцените статью по 5-бальной шкале

3.92 из 5 на основе 12 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

How-to

Анастасия Сотула

Как проверить IP-адрес сайта на спам

How-to

Анастасия Сотула

Как определить возраст сайта: как узнать когда создан сайт

How-to

Анастасия Сотула

Как собрать семантическое ядро для сайта: 4 метода

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

Что такое индексирование в поисковых системах и как оно работает?

Сэм Марсден

SEO и контент-менеджер

Давайте поделимся

Что происходит, когда поисковая система завершает сканирование страницы? Давайте рассмотрим процесс индексации, который поисковые системы используют для хранения информации о веб-страницах, что позволяет им быстро выдавать релевантные высококачественные результаты.

Зачем нужна индексация поисковыми системами?

Помните дни до Интернета, когда вам приходилось обращаться к энциклопедии, чтобы узнать о мире и копаться в Желтых страницах, чтобы найти сантехника? Даже на заре Интернета, до появления поисковых систем, нам приходилось искать информацию в каталогах. Какой трудоемкий процесс. Откуда у нас хватило терпения?

Какой трудоемкий процесс. Откуда у нас хватило терпения?

Поисковые системы произвели революцию в поиске информации, поскольку пользователи ожидают почти мгновенных ответов на свои поисковые запросы.

Что такое индексация поисковыми системами?

Индексирование — это процесс, с помощью которого поисковые системы упорядочивают информацию перед поиском, чтобы обеспечить сверхбыстрые ответы на запросы.

Поиск на отдельных страницах по ключевым словам и темам будет очень медленным процессом для поисковых систем, чтобы определить релевантную информацию. Вместо этого поисковые системы (включая Google) используют инвертированный индекс, также известный как обратный индекс.

Что такое инвертированный индекс?

Инвертированный индекс — это система, в которой база данных текстовых элементов составляется вместе с указателями на документы, содержащие эти элементы. Затем поисковые системы используют процесс, называемый токенизацией, чтобы сократить слова до их основного значения, тем самым уменьшая количество ресурсов, необходимых для хранения и извлечения данных. Это гораздо более быстрый подход, чем перечисление всех известных документов по всем релевантным ключевым словам и символам.

Это гораздо более быстрый подход, чем перечисление всех известных документов по всем релевантным ключевым словам и символам.

Пример инвертированной индексации

Ниже приведен очень простой пример, иллюстрирующий концепцию инвертированной индексации. В примере видно, что каждое ключевое слово (или токен) связано со строкой документов, в которых этот элемент был идентифицирован.

| Ключевое слово | Путь к документу 1 | Путь документа 2 | Путь документа 3 |

| SEO | example.com/seo-tips | moz.com | … |

| HTTPS | deepcrawl.co.uk/https-скорость | example.com/https-future | … |

В этом примере используются URL-адреса, но это могут быть идентификаторы документов, в зависимости от структуры поисковой системы.

Кэшированная версия страницы

Помимо индексации страниц, поисковые системы также могут хранить сильно сжатую текстовую версию документа, включая все HTML и метаданные.

Кэшированный документ — это последний снимок страницы, просмотренный поисковой системой.

Доступ к кэшированной версии страницы можно получить (в Google), щелкнув маленькую зеленую стрелку рядом с URL-адресом каждого результата поиска и выбрав вариант кэширования. Кроме того, вы можете использовать оператор поиска Google «cache:» для просмотра кешированной версии страницы.

Bing предлагает те же возможности для просмотра кешированной версии страницы с помощью зеленой стрелки вниз рядом с каждым результатом поиска, но в настоящее время не поддерживает оператор поиска «кэш:».

Что такое PageRank?

«PageRank» — это алгоритм Google, названный в честь соучредителя Google Ларри Пейджа (да, действительно!) Это значение для каждой страницы, рассчитанное путем подсчета количества ссылок, указывающих на страницу, чтобы определить ее значение относительно любой другой страницы в Интернете. Значение, передаваемое каждой отдельной ссылкой, основано на количестве и значении ссылок, указывающих на страницу со ссылкой.

PageRank — это лишь один из многих сигналов, используемых в большом алгоритме ранжирования Google.

Приблизительные значения PageRank изначально были предоставлены Google, но они больше не являются общедоступными.

Хотя PageRank является термином Google, все коммерческие поисковые системы рассчитывают и используют эквивалентную метрику ссылочного веса. Некоторые SEO-инструменты пытаются дать оценку PageRank, используя собственную логику и расчеты. Например, Page Authority в инструментах Moz, TrustFlow в Majestic или рейтинг URL в Ahrefs. У Lumar есть метрика под названием DeepRank для измерения ценности страниц на основе внутренних ссылок на веб-сайте.

Как PageRank проходит через страницы

Страницы передают PageRank или ссылочный вес другим страницам через ссылки. Когда страница ссылается на контент в другом месте, это рассматривается как вотум уверенности и доверия, поскольку контент, на который ссылаются, рекомендуется как актуальный и полезный для пользователей. Количество этих ссылок — и мера того, насколько авторитетным является ссылающийся веб-сайт — определяет относительный PageRank страницы, на которую ссылаются.

Количество этих ссылок — и мера того, насколько авторитетным является ссылающийся веб-сайт — определяет относительный PageRank страницы, на которую ссылаются.

PageRank поровну распределяется между всеми обнаруженными ссылками на странице. Например, если на вашей странице пять ссылок, каждая ссылка будет передавать 20% PageRank страницы через каждую ссылку на целевые страницы. Ссылки с атрибутом rel=»nofollow» не проходят PageRank.

Важность обратных ссылок

Обратные ссылки являются краеугольным камнем того, как поисковые системы понимают важность страницы. Было проведено множество исследований и тестов, чтобы определить корреляцию между обратными ссылками и рейтингом.

Исследование обратных ссылок, проведенное Moz, показывает, что в результатах 50 самых популярных поисковых запросов Google (около 15 000 результатов поиска) 99,2% из них содержали как минимум 1 внешнюю обратную ссылку. Кроме того, SEO-специалисты постоянно оценивают обратные ссылки как один из наиболее важных факторов ранжирования в опросах.

Далее: Отличия поисковых систем

Сэм Марсден

SEO и контент-менеджер

Сэм Марсден — бывший менеджер Lumar по поисковой оптимизации и контенту, а в настоящее время — руководитель отдела SEO в Busuu. Сэм регулярно выступает на маркетинговых конференциях, таких как SMX и BrightonSEO, и является автором отраслевых изданий, таких как Search Engine Journal и State of Digital.

Какие страницы показывать в результатах поиска Google • Yoast

Вероятно, вы хотите, чтобы Google и другие поисковые системы показывали большую часть вашего контента в результатах поиска. Но на большинстве веб-сайтов также есть несколько страниц или сообщений, которые не нужно отображать в этих результатах поиска. Так как же указать Google, какие страницы показывать, а какие нет? Здесь в игру вступает настройка страницы на noindex. В этом посте мы расскажем больше об индексации и о том, как Yoast SEO может помочь вам контролировать, какие страницы будут отображаться в результатах поиска.

Давайте начнем с краткого объяснения индексации. Прежде чем поисковая система, такая как Google, сможет ранжировать страницу или сообщение и показать их в результатах поиска, она должна их проиндексировать. Даже до этого сканер должен обнаружить фрагмент контента, прежде чем он сможет оценить, является ли он ценным дополнением к его индексу. Один из способов, с помощью которого сканеры обнаруживают страницы, — это сканирование XML-карты сайта веб-сайта. После того, как страница будет проиндексирована, поисковая система поймет ее содержание и сможет ранжировать этот фрагмент контента, если он лучше всего соответствует поисковому запросу пользователя.

Какие страницы показывать в результатах поиска?

Определить, что нужно индексировать поисковым роботам, а что нет, бывает трудно понять, и легко сделать ошибку. Вы не будете первым, кто по незнанию установит для всего сообщения тип noindex, что сделает его недоступным для поисковых систем. Мы долго и упорно думали об этом и значительно упростили этот процесс для вас в Yoast SEO. Теперь все сводится к тому, чтобы задать вам простой вопрос: Вы хотите, чтобы страница x отображалась в поисковых системах 9?0136 ?

Теперь все сводится к тому, чтобы задать вам простой вопрос: Вы хотите, чтобы страница x отображалась в поисковых системах 9?0136 ?

Индивидуальные настройки, позволяющие сделать ваш контент доступным для индексации, можно найти в соответствующих разделах Yoast SEO. В WordPress вы найдете настройки для сообщений и страниц в части «Типы контента» на вкладке «Внешний вид в поиске». Таксономии, такие как ваша категория и страницы тегов, можно найти на вкладке «Таксономии» в Yoast SEO. В Shopify вы можете найти эти настройки для каждого типа страницы на вкладке «Настройки» Yoast SEO для Shopify.

Ответив Да на вопрос «Показывать сообщения в результатах поиска» в настройках сообщений, вы гарантируете, что ваши сообщения будут отображаться в XML-карте сайта и, следовательно, в результатах поиска. Если вы хотите что-то исключить, скажем, вы хотите исключить страницы своих категорий, вы можете переключить переключатель в положение «Нет». Таким образом, таксономия или тип сообщения не будут отображаться в XML-карте сайта. Из-за этого он не будет отображаться в результатах поиска. Всякий раз, когда вы устанавливаете что-то здесь, чтобы не отображаться в поисковых системах, оно не будет индексироваться и не будет включено в карту сайта XML.

Таким образом, таксономия или тип сообщения не будут отображаться в XML-карте сайта. Из-за этого он не будет отображаться в результатах поиска. Всякий раз, когда вы устанавливаете что-то здесь, чтобы не отображаться в поисковых системах, оно не будет индексироваться и не будет включено в карту сайта XML.

Подробнее: Почему Google неправильно индексирует мой контент? »

Исключить отдельные сообщения

Если вы действительно не хотите, чтобы конкретный URL отображался в результатах поиска, вам нужно добавить noindex, следуйте тегу . Отсутствие его в вашей XML-карте сайта автоматически не означает, что Google не будет индексировать URL-адрес. Если Google может найти его по ссылкам, Google может проиндексировать URL-адрес.

Вы также можете исключить отдельные сообщения из карт сайта XML с помощью боковой панели Yoast SEO в редакторе сообщений. Или, если вы находитесь на Shopify, вы можете исключить отдельные продукты с помощью боковой панели Yoast SEO. Перейдите на вкладку «Дополнительно» и выберите «Нет» в ответ на вопрос «Разрешить поисковым системам показывать это сообщение в результатах поиска?».

Перейдите на вкладку «Дополнительно» и выберите «Нет» в ответ на вопрос «Разрешить поисковым системам показывать это сообщение в результатах поиска?».

Просмотр вашей XML-карты сайта

Когда вы используете Yoast SEO на WordPress, наш плагин автоматически создает полную XML-карту сайта для вашего веб-сайта. Облегчение для поисковых систем обнаружения всех страниц, которые вы хотите, чтобы они открыли. Вы можете проверить свою карту сайта, чтобы увидеть, отображается ли контент, который вы хотите включить, в карту сайта XML. Пока вы там, вы также должны проверить, не отображается ли в нем контент, который вы хотите исключить из карты сайта.

Вы можете найти свою XML-карту сайта в Yoast SEO, выбрав «Основные» > «Функции» > «XML-карты сайта» > ? (нажмите на вопросительный знак). Здесь вы можете нажать «Просмотреть XML-карту сайта», и вы перейдете к XML-карте сайта вашего сайта.

Мы устранили большую путаницу, связанную с индексированием контента и XML-карт сайта, упростив вещи в Yoast SEO. Но, самое главное, теперь намного проще сказать поисковым системам, что вы хотели бы и не хотели, чтобы они показывали в результатах поиска.

Подробнее о XML-картах сайта

XML-карты сайта — это своего рода карта сокровищ для роботов поисковых систем. Они сканируют их, чтобы обнаружить новый или обновленный контент на вашем сайте. Карта сайта полезна каждому сайту, поэтому Yoast SEO автоматически создает для вас надежную карту сайта в формате XML. Ваш рейтинг не поднимется, если вы добавите его, но это поможет поисковым роботам намного легче находить ваш контент. Нужна дополнительная информация об использовании XML-карт сайта на вашем сайте? Тогда у нас есть для вас дополнительная информация:

- Что такое XML-карта сайта и зачем она нужна?

- Смысл и бессмыслица XML-карты сайта

- Yoast SEO XML карта сайта для разработчиков

Эдвин Тунен

Эдвин — специалист по стратегическому контенту. Прежде чем присоединиться к Yoast, он годами оттачивал свое мастерство в ведущем нидерландском журнале о веб-дизайне.

Прежде чем присоединиться к Yoast, он годами оттачивал свое мастерство в ведущем нидерландском журнале о веб-дизайне.

Станьте профессионалом Yoast SEO

Далее!

Сказка о двух поисковиках

Messy SEO — это колонка, посвященная рутинным, необработанным задачам, связанным с аудитом, планированием и оптимизацией веб-сайтов, на примере нового домена MarTech.

В этом выпуске «Беспорядок SEO» подробно описан мой процесс работы с нашей командой по анализу шаблонов индексации для страниц MarTech. В Части 6 мы обсудили необходимость создания основных страниц, чтобы установить лучшую иерархию сайта и рейтинг для наших наиболее актуальных тем.

СВЯЗАННЫЕ : Google позволяет вам сообщить о проблеме с индексацией

У MarTech.org было много проблем с индексацией с момента его создания в прошлом году. Наиболее актуальным в последнее время является то, что Google, похоже, отдает приоритет устаревшему контенту в поисковой выдаче, а это означает, что многие из (теперь перенаправленных) URL-адресов Marketing Land и MarTech Today все еще заполняют индекс. В результате большинство наиболее эффективных страниц MarTech не имеют отношения к нашему бренду в том виде, в каком он существует сегодня.

В результате большинство наиболее эффективных страниц MarTech не имеют отношения к нашему бренду в том виде, в каком он существует сегодня.

Один из способов решения этой проблемы — создание основных страниц, сосредоточенных на основных отраслевых темах, которые мы освещаем в MarTech. Это поможет нам установить иерархию соответствующих тем.

На протяжении всего этого процесса мы в первую очередь сосредоточились на индексации Google, пренебрегая тем, как другие поисковые системы обрабатывают наш контент. Итак, мы решили сравнить данные MarTech, Marketing Land и MarTech Today от Google с данными от Microsoft Bing — и расхождения оказались красноречивыми.

С момента миграции в индексацию MarTech было внесено много изменений, в первую очередь проблемы с изменением названия. К счастью, они были в основном решены, но есть и другие проблемы, которые мы обнаружили при сравнении контента, проиндексированного в Google, и в Bing.

Индексация Google

Несмотря на множество затянувшихся проблем с индексацией, за последний год Google внесла некоторые коррективы в индексацию MarTech. Поисковая система удалила практически все наши повторяющиеся URL-адреса после того, как мы настроили переадресацию, а также была удалена значительная часть страниц Marketing Land и MarTech Today. Однако недавно мы заметили некоторые интересные тенденции производительности и индексации.

Поисковая система удалила практически все наши повторяющиеся URL-адреса после того, как мы настроили переадресацию, а также была удалена значительная часть страниц Marketing Land и MarTech Today. Однако недавно мы заметили некоторые интересные тенденции производительности и индексации.

Производительность . Большинство популярных страниц за последние три месяца с точки зрения взаимодействия — это устаревшие страницы, которые практически не имеют отношения к нашему бренду MarTech. Помимо главной страницы, страницы «Что такое MarTech» и страницы нашей платформы CDP, основные URL-адреса в значительной степени не имеют отношения к нашей целевой аудитории.

| Стр. Position | |||

| / | 5 | 13778 | 25.34 |

| /content-marketing-done-right-8-examples-can-learn/ | 529481 | 7429 | 30.13 |

| /топ-10-платежных-процессинговых-компаний-мир/ | 717026 | 7259 | 32. 48 48 |

| /what-is-martech/ | 278783 | 6773 | 11.33 |

| /8-companies-social-media-right-marketers-can-learn/ | 251427 | 5087 | 48,91 |

| / Martech-Landscape-Customer-Data-Platform / | 369856 | 3882 | 23.16 |

| / 100-QUESTON | 77152 | 3580 | 27,66 |

| /10-ступенчатые целевые и-точковые-кастолеты-поэффективны / | 170443 | 3353 | 20,48 |

Конечно, эти статьи существуют уже много лет, укрепляя авторитет в доменах Marketing Land и MarTech Today. Но после почти года существования MarTech странно, что так много старых, менее актуальных страниц находятся в верхней части наших списков производительности, особенно с учетом того, что с тех пор наша команда опубликовала так много хорошего контента.

Проиндексированные страницы . Google имеет около 29 000 URL-адресов MarTech в своем индексе. Большинство из них — релевантные ссылки, которые мы разместили в наших картах сайта. Однако в категории «Проиндексировано, не отправлено в карту сайта» более 7000 URL-адресов. Многие из этих URL-адресов не имеют отношения к делу — некоторые из них имеют параметры, которые выглядят либо как код отслеживания, либо, в некоторых случаях, как спам.

Google имеет около 29 000 URL-адресов MarTech в своем индексе. Большинство из них — релевантные ссылки, которые мы разместили в наших картах сайта. Однако в категории «Проиндексировано, не отправлено в карту сайта» более 7000 URL-адресов. Многие из этих URL-адресов не имеют отношения к делу — некоторые из них имеют параметры, которые выглядят либо как код отслеживания, либо, в некоторых случаях, как спам.

Распространенность параметров URL неудивительна, но непонятно, почему Google включает так много из них в индекс. Однако более тревожной тенденцией является количество URL-адресов Marketing Land и MarTech Today, которые также все еще находятся в индексе Google.

URL-адреса Marketing Land в Google. URL-адреса MarTech Today в Google.Мы знаем, что существует множество URL-адресов Marketing Land и MarTech Today в Интернете, как в наших старых материалах, так и на других веб-сайтах. Но странно видеть так много все еще в индексе Google.

Получайте ежедневный информационный бюллетень, на который полагаются поисковые маркетологи.

Индексация Bing

Индексация Bing говорит о другом. Хотя все еще есть много нерелевантных частей контента, они гораздо менее заметны в поисковой выдаче.

Производительность . Самые эффективные страницы MarTech в Bing выглядят примерно так же, как и в Google. Домашняя страница, страница «Что такое MarTech» и устаревшие страницы все еще на месте, но мы также обнаружили одну из наших последних новостных статей. Важность этой статьи для нашей индустрии, несомненно, помогла вывести ее на передний план, но странно, что Google не относился к ней так же.

| Страница | Впечатления | Клики | Ср. Position |

| / | 1.2k | 119 | 4.75 |

| /10-steps-target-connect-potential-customers-effectively/ | 586 | 27 | 5. 99 99 |

| / 100 вопросов, которые вы должны задать при разработке веб-сайта/ | 231 | 17 | 4,96 |

| /что-большая-идея-3-основы-успешный-цифровой-творческий/0039 | 408 | 14 | 5,36 |

| / What-IS-Martech / | 613 | 14 | 5.04 |

| / | 5.04 | ||

| /. | 11 | 7.51 | |

| /5-рол. -аналитика-в-2023/ | 40 | 8 | 3,55 |

Цифры этой новой статьи обнадеживают, но, как и результаты в Google, наши более релевантные тематические страницы не работают хорошо.

Проиндексированные страницы . Bing проиндексировал меньше наших страниц MarTech (примерно 17 000 URL-адресов), что неудивительно, учитывая, насколько он меньше, чем Google. Однако после анализа этих URL-адресов мы обнаружили, что соотношение релевантного и нерелевантного контента намного ниже. Мы не видим большого количества проиндексированных URL-адресов с параметрами.

Мы не видим большого количества проиндексированных URL-адресов с параметрами.

Самая очевидная разница между двумя поисковыми системами заключается в том, что они индексируют страницы нашего старого домена. Хотя Google по-прежнему сохраняет более 2000 URL-адресов из Marketing Land и MarTech Today, в индексе Bing осталось только 143 из этих URL-адресов.

URL-адреса Marketing Land в Bing.MarTech Today URL-адреса в Bing.Да, изначально таких страниц в Bing было меньше, но несоответствие все еще шокирует.

Несоответствие между индексацией Google и Bing

Кажется, что из двух поисковых систем Bing лучше справляется со сканированием наших старых URL-адресов и соответствующим образом корректирует свой индекс. В этом есть смысл — в Bing проиндексировано меньше страниц, поэтому поисковой системе нужно меньше очищать.

Но почему Google хранит так много старых URL-адресов? Одно из возможных объяснений заключается в том, что он просто еще не просканировал все старые URL-адреса. Это будет означать, что он не нашел 301 редиректы, которые мы установили, полагая, что старые сайты все еще живы.

Это будет означать, что он не нашел 301 редиректы, которые мы установили, полагая, что старые сайты все еще живы.

Однако это кажется маловероятным, поскольку мы перенесли сайт почти год назад. У Google было достаточно времени, чтобы просканировать наши страницы. Тем не менее, мы по-прежнему открыты для этой возможности.

Другим объяснением может быть структурная проблема на сайте MarTech, которая каким-то образом сообщает Google, что старые домены все еще действуют. В настоящее время мы проводим несколько глубоких технических проверок, чтобы определить, так ли это. Пока мы не узнаем больше, мы будем продолжать создавать хороший контент и делать все возможное, чтобы он занимал более высокое место, чем менее релевантные страницы.

Вы заметили расхождения в индексации между Google и Bing? Как вы решаете проблему? Напишите мне по адресу [email protected] с темой «Беспорядочное SEO, часть 7», чтобы сообщить мне об этом.

Больше грязного SEO

Узнайте больше о нашем новом тематическом исследовании SEO для домена MarTech.