Что такое индексация — самый полный гайд

Часто происходит путаница в терминологии: под индексацией иногда подразумевают сканирование сайта или совокупность и сканирования и индексации. В этом нет большой ошибки, часто путаницу вносят сами мануалы поисковых систем. Иногда в текстах Яндекса и Гугла можно увидеть использование термина индексация в разных контекстах, например:

Индексация сайта простыми словами

Так что же такое индексация: если кратко, то индексация (или индексирование, indexing) — один из процессов работы поисковых систем по построению поисковой базы в результате которого содержимое страниц попадает в индекс поисковой системы.

Для большей ясности приведу терминологию, а потом опишу все процессы.

Терминология

Планировщик (Scheduler) — программа, которая выстраивает маршрут обхода интернета роботами исходя из характеристик страниц, таких как частота обновления документов, востребованность этих страниц, цитируемость.

Crawler, Spider (Паук) Googlebot, YandexBot. Робот, ответственный за обход и скачивание страниц из интернета в порядке очередности, который задается планировщиком. Подразделяются на:

- Основной робот, обходящий контент в порядке общей очереди.

- Быстрый робот (быстроробот или быстробот). Робот, который использует свежий индекс, на основе группы заданных хабовых страниц с важной, часто обновляемой информацией, например, с новостями популярных СМИ.

Сканирование (Crawling) — процесс загрузки страниц краулером в результате чего они попадают в хранилище, в виде сохраненных копий.

Краулинговый спрос: это то, как часто и в каком объеме робот бы хотел сканировать конкретные страницы.

Краулинговый лимит: ограничения скорости сканирования на стороне сайта, связанные с производительностью сайта или заданным вручную ограничением.

Краулинговый бюджет — это совокупность краулингового спроса и доступной скорости сканирования сайта (краулингового лимита). Простыми словами — это то сколько робот хочет и может скачать страниц.

Простыми словами — это то сколько робот хочет и может скачать страниц.

Сохраненная копия — необработанная копия документа на момент последнего сканирования.

Поисковый индекс — информация со страниц, приведенная в удобный для работы поисковых алгоритмов формат. Список всех терминов и словопозиций где и на каких страницах они упоминаются. Информация хранится в базе в виде инвертированного индекса. Схематический пример:

Индексация — процесс загрузки, анализа содержимого документа документа с последующим включением в поисковый индекс.

Поисковая база — это совокупность поискового индекса, сохраненных страниц и служебной информации о документах, таких как заголовки, типы и кодировка документов, коды ответов страниц, мета теги и др.

Как происходит сканирование сайта

Так как ресурсы поисковых систем не безграничны, планировщик составляет очередь обхода страниц, исходя критериев их полезности, востребованности, популярности и др. Каждый сайт получает свой краулинговый бюджет исходя из скоростных характеристик сайта и таких критериев как:

Каждый сайт получает свой краулинговый бюджет исходя из скоростных характеристик сайта и таких критериев как:

- Доля полезных/мусорных страниц на сайте, дубликаты

- Спамные и малополезные страницы

- Наличие бесконечной генерации страниц, например, некорректной фасетной навигации

- Популярность страниц

- Насколько актуальные версии страниц сайта, содержащиеся в поисковой базе

Робот в постоянном режиме скачивает страницы и помещает их в хранилище, заменяя старые версии. Мы можем увидеть их в виде сохраненных копий. Далее уже происходит индексация страниц.

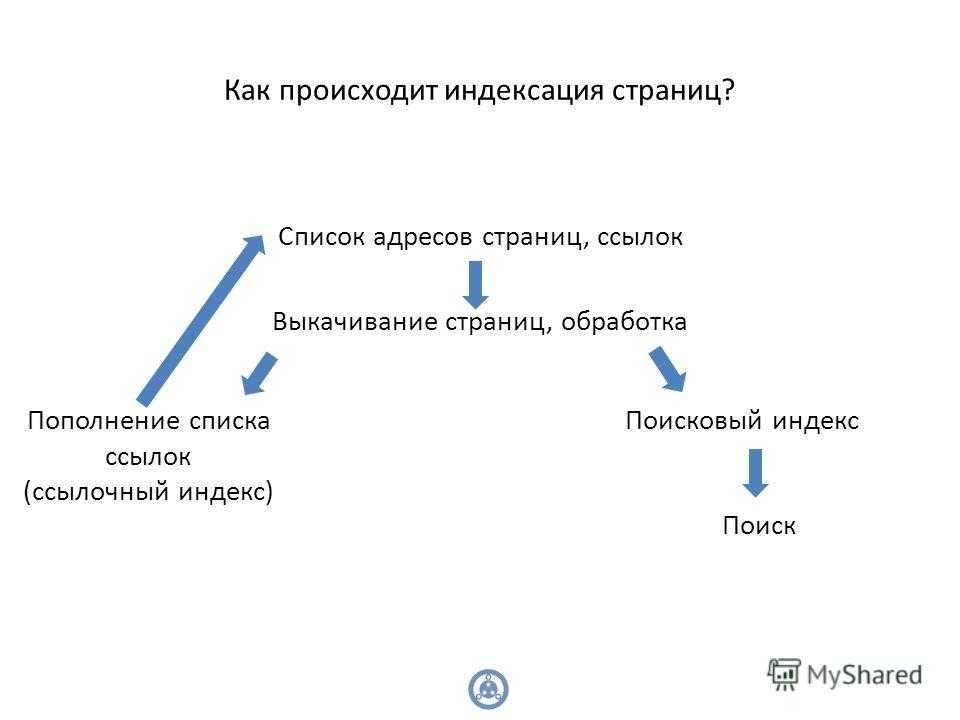

Как проходит индексация сайта

Индексацию можно условно разбить на следующие процессы:

- Загрузка и разбор страницы по элементам: текст, мета-теги, микроразметка, изображения, видео и другой контент и служебные данные.

- Анализ страницы по определенным параметрам, например: разрешена ли она к индексации, сканированию, является ли неглавной копией другой страницы, содержит ли страница малополезный, спамный контент и др.

- Если страница успешно прошла все проверки, она добавляется в индекс.

Как проходит индексация сайта в Яндексе

Все описанное в предыдущем пункте справедливо и для Яндекса и для Google. Какие есть особенности индексации у Яндекса?

У Google обновление поисковой базы — непрерывный процесс. В Яндексе обновление происходит во время Апдейтов, примерно раз в три дня. О том что произошло обновление можно узнать по уведомлениям в Яндекс.Вебмастере

Как проверить индексацию

Есть разные способы для проверки статуса индексации сайтов и отдельных его страниц:

- Вебмастер Яндекса

- Панель Google Search Console

- API панели для вебмастеров Yandex/Google

- SEO-сервисы, например Rush Analytics

- Плагины и расширения для браузеров

- Поисковые операторы ПС

- GA/Метрика

- Серверные логи

Выбор сервиса зависит от поисковой системы, а также задачи: узнать сколько страниц всего в индексе, получить список проиндексированных страниц или проверить статус индексации конкретной страницы или списка страниц. Подробнее расписано ниже.

Подробнее расписано ниже.

Как узнать сколько страниц проиндексировано на сайте

Расширения для браузера

Быстрые способы проверить статус индексации сайта — расширения и букмарклеты для браузера, например RDS-бар

Сервисы для анализа сайтов

Так же можно проверить с помощью сервисов, таких как pr-cy.ru

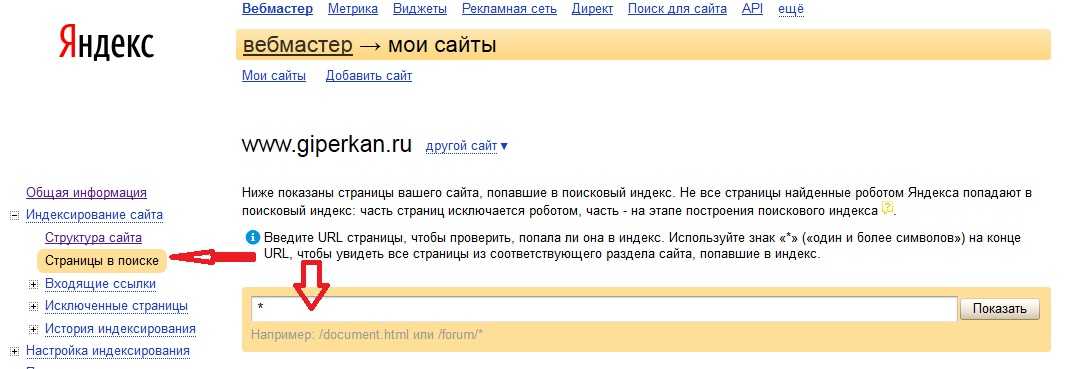

Яндекс.Вебмастер и Google Search Console

Если есть доступы к панелям вебмастеров, можно получить количество проиндексированных страниц в панелях вебмастеров:

Яндекс Вебмастер — http://webmaster.yandex.ru

Google Search Console — https://search.google.com/search-console/

С помощью специализированных программ для SEO, например Allsubmitter, Netpeak Checker.

Это может понадобиться когда нужна пакетная проверка параметров чужих сайтов.

Пример проверки числа проиндексированных страниц в Netpeak Checker.

Проверка индексации сайтов в Яндекс:

Проверка индексации сайтов в Google:

Пример проверки индексации сайтов в Яндекс и Google в Allsubmitter.

Как выгрузить список проиндексированных страниц сайта в Яндексе и Google

Яндекс Вебмастер: Отчет индексирование -> Страницы в поиске -> Все страницы

Внизу страницы ссылки на скачивание файла — cуществует ограничение в 50 000 страниц.

Google Search Console: в отчете Покрытие — выбираем нужные типы страниц

Переходим в нужный отчет и скачиваем список страниц в удобном формате. Google отдает только 1 000 страниц.

Поисковые операторы Яндекса

Запрос для поиска страниц в пределах одного домена — url:www.site.ru/* | url:site.ru/* | url:site.ru | url:www.site.ru.

Запрос для поиска с учетом всех поддоменов — site:site.ru

Список операторов и инструкцию по работе с ними можно посмотреть в справке Яндекса.

Ограничение: можно получить только 1000 результатов. Нужны специальные инструменты чтобы скопировать список страниц SERP: расширения браузера, букмарклеты или программы для парсинга выдачи.

Поисковые операторы Google

Запрос для поиска страниц в пределах одного сайта — site:site.ru

Получение списка страниц входа из систем веб-аналитики

Списки страниц входа из органики Яндекса в системах аналитики Яндекс.Метрика и Google.Analytics. Страницы по которым идут переходы с органической выдачи с большой вероятностью индексируются, но для точности рекомендуется проверять индексацию собранных страниц — индекс не статичен и страницы могут выпадать из индекса.

Список страниц по которым сайт показывается в выдаче в Яндекс.Вебмастере

Для выгрузки большого списка страниц из Яндекс.Вебмастера потребуется специальный скрипт.

Плагин для API Google Webmasters: Google Search Analytics for Sheets

Отображает страницы по которым были показы сайта в выдаче.

Преимущества выгрузки списка страниц через API в том что можно получить десятки тысяч страниц, которые с большой вероятностью проиндексированы, в отличие от веб-интерфейса где установлено ограничение по выгрузкам в 1000 страниц.

Серверные логи сайта

Получить список страниц которые посещает робот можно из логов, например с помощью программы SEO Log File Analyser от создателей Screaming Frog.

Как проверить индексацию конкретной страницы в Яндексе и Google

Сервис Яндекс.Вебмастер: Индексирование -> Проверить статус URL

Проверка с помощью оператора: пример запроса url:https://site.com/page/

Сервис Google Search Console: инструмент “Покрытие”

Нужно ввести в указанной на скрине строке поиска URL-адрес своего сайта и откроется отчет о статусе страницы.

Проверка с помощью оператора: пример запроса site:https://habr.com/ru/news/t/468361/

После отмены оператора info остался оператор site, но он выдает не всегда точные данные, можно сократить список результатов с помощью указания уникального текста проверяемой страницы.

Как массово проверить индексацию списка страниц

Для проверки можно использовать SEO-сервисы, например Rush Analytics.

Это позволяет массово проверить индексацию до десятков-сотен тысяч страниц

Как проверить разрешена индексация/сканирование страницы в Robots.txt

В Яндексе

Проверить доступна ли роботам страница или содержит запрет можно через. Инструменты -> Анализ robots.txt

В Google

Инструмент проверки файла robots.txt

Важно: если файл robots.txt отдает 404 ошибку, боты считают что разрешено сканирование всего сайта без ограничений. Если файл отдает ошибку 5хх, то Googlebot считает это полным запретом на сканирование сайта, но если ошибка отдается более 30 дней — считает что разрешено сканировать весь сайт без ограничений. Яндекс любые серверные ошибки считает отсутствием файла robots.txt и отсутствием ограничений на обход и индексацию сайта.

Как узнать динамику числа проиндексированных страниц

С помощью специализированных сервисов, например: https://be1.ru/

С помощью Яндекс Вебмастера: в разделе Индексирование -> Страницы в поиске.

С помощью Google Search Console: в отчете Покрытие.

Почему число проиндексированных страниц может отличаться в разных сервисах?

Нужно понимать что проиндексированные страницы и страницы в поиске это разные сущности. Не все проиндексированные страницы будут включены в поиск и не все страницы в поиске будут показываться через операторы поиска — операторы лишь выводят результаты пустого поиск по сайту а не список всех страниц. Но этого в большинстве случаев достаточно чтобы оценить порядок числа проиндексированных страниц сайта.

Запрет индексации страниц

Запрет индексации с помощью Meta Noindex/X-Robots-Tag

Для гарантированного исключения попадания страниц в индекс можно использовать атрибут Noindex Мета Тега Robots или HTTP-заголовка X-Robots-Tag. Подробнее про этот атрибут можно прочитать тут.

Важно: Использование запрета индексации в через Meta/X-Robots-Tag Noindex вместе с запретом в Robots. txt

txt

При добавлении директивы Noindex в мета-тег Robots и http-заголовок X-Robots-Tag, чтобы ее прочитать, робот должен просканировать страницу, поэтому она должна быть разрешена в файле Robots.txt. Следовательно для точечного запрета индексации страниц иногда требуется снять запрет в robots.txt или добавить директиву Allow, чтобы робот смог переобойти эти страницы.

Несмотря на вышеописанное, запрет в robots.txt в большинстве случаев все таки приведет к тому, что страницы не будут индексироваться, но его нельзя использовать для закрытия персональных данных или страниц с конфиденциальной информацией.

Как запретить индексацию страницы в robots.txt

Стоит сразу упомянуть что запрет в robots.txt не является надежным методом закрытия страниц от индексации.

В файле robots.txt указываются основные директивы для запрета или разрешения обхода/индексации отдельных страниц или разделов сайта.

Важно: Многие ошибочно считают что директива Disallow в Robots. txt служит для запрета индексации страниц, это не совсем так. Основная цель файла Robots.txt — управление трафиком поисковых роботов на сайте, а не индексацией / переиндексацией и разные поисковые системы по разному интерпретируют запрет.

txt служит для запрета индексации страниц, это не совсем так. Основная цель файла Robots.txt — управление трафиком поисковых роботов на сайте, а не индексацией / переиндексацией и разные поисковые системы по разному интерпретируют запрет.

Многие вебмастера не понимают почему после запрета страницы в robots.txt она продолжает находиться в индексе и приносить трафик. Запрет посещения и обновления страницы роботом не означает, что он обязан удалить уже присутствующую в индексе страницу. К тому же для индексации не всегда обязательно физически сканировать страницу, информацию о ней можно собирать из различных источников, например, из анкоров входящих ссылок.

Почему заблокированные в robots.txt страницы отображаются в выдаче?

В Яндексе и Google различается механизм обработки директив файла Robots.txt. Для Google директива Disallow в robots.txt запрещает лишь обход страниц, но не их индексацию из-за чего часто появляются страницы со статусом:

Для запрета индексации в Google через файл Robots. txt ранее использовалась незадокументированная директива Noindex в Robots.txt, но с сентября 2019 года Google перестал поддерживать ее.

txt ранее использовалась незадокументированная директива Noindex в Robots.txt, но с сентября 2019 года Google перестал поддерживать ее.

На данный момент для надежного запрета индексации страниц в Google рекомендуется использовать атрибут Noindex Мета Тега Robots и HTTP-заголовка X-Robots-Tag.

Яндекс же, наоборот, воспринимает запрет в Robots.txt Disallow: как сигнал к запрету и сканирования и индексирования сайта и после добавления директивы Disallow: страницы будут удалены из индекса.

Использование атрибута canonical для запрета индексации дубликатов

Для консолидации дубликатов или похожих страниц страниц используется атрибут canonical, который указывает поисковикам по какому адресу рекомендуется индексировать страницу. Носит рекомендательный нестрогий характер.

Два типа использования:

- Тег <link> с атрибутом rel=»canonical»

- HTTP-заголовок rel=canonical

Использование директивы clean-param для удаления из индекса

Директива clean-param файла Robot. Yandex» search_bot

Yandex» search_bot

Запрет сканирования, индексации с помощью кодов ответа сервера 3хх/4хх

Чтобы гарантированно запретить роботам скачивать страницы, можно отдавать ботам при сканировании страниц коды:

- 301 редирект: особенно подходит для запрета дубликатов и склейки их с основными страницами;

- 403 Forbidden: доступ запрещен;

- 404 Not Found: не найдено;

- 410 Gone: удалено;

Удаление страниц из индекса

Удаление страниц или каталогов через Search Console

Инструмент не запрещает страницы к индексации или сканированию — он лишь временно скрывает страницы из поисковой выдачи. Рекомендуется использовать только для экстренного удаления страниц, случайно попавших в выдачу, после этого уже физически удалить их или запретить сканирование/индексацию.

Ускоренное удаление из индекса страниц в Яндексе

На сайт должны быть подтверждены права. Можно удалить только страницы, которые недоступны для робота: запрещенные в robots. txt или отдавать код 3хх, 4хх.

txt или отдавать код 3хх, 4хх.

Для удаления из индекса Яндекса страниц чужого сайта можно воспользоваться формой — https://webmaster.yandex.ru/tools/del-url/.

Требования к URL-адресам такие же: запрет в robots.txt или коды ответа 301, 403, 404, 410 и т.п.

Как добавить страницы в индекс Яндекса или Google

Роботы постоянно ходят по ссылкам на сайтах. Для ускорения добавления существуют инструменты:

- Sitemap.xml. Добавьте и регулярно обновляйте актуальный список страниц в сайтмапах сайта.

- В Яндексе: инструменты -> переобход страниц

- В Google: Проверка URL -> Запросить индексирование

Как проверить обход / сканирование сайта поисковыми системами

Яндекс:

Общее количество загруженных (просканированных) Яндексом страниц можно увидеть на главной странице вебмастера.

Динамику обхода страниц можно увидеть на странице Индексирование -> Статистика обхода.

Google: отчет: статистика сканирования сайта.

Также можно проверить обход сайта всеми поисковыми роботами с помощью анализа серверных логов сайта (Access logs). Например, через программу SEO Log File Analyser.

Как часто происходит индексация сайта

Поисковые боты постоянно равномерно загружают страницы сайта, далее выкладывая их в обновленный индекс: Google обновляет индекс в постоянном режиме, Яндекс во время апдейтов поисковой базы, примерно раз в три дня.

Частота сканирования и переиндексации каждого отдельного сайта различается, и зависит от факторов:

- объем контента/страниц сайта

- краулинговый спрос поисковой системы для текущего сайта

- настройки скорости сканирования в вебмастерах

- скорость работы сайта

Как улучшить и ускорить индексацию сайта

Рекомендации для увеличения охвата страниц индексом поисковых систем:

- качественный уникальный контент, востребованный пользователями

- все основные страницы должны быть в валидных сайтмапах sitemap.

xml

xml - оптимизация вложенности страниц

- оптимизация краулингового спроса/бюджета

- хорошая скорость сайта

- закрывать лишние страницы, чтобы не тратить на них ресурсы роботов

- внутренняя перелинковка

- создание ротарора на сайте (Ловец ботов)

Как ограничить скорость сканирования сайта

Обычно если требуется ограничить нагрузку, которую создают роботы, то у сайта большие проблемы и это негативно скажется на его индексации. Боты стараются быть “хорошими” юзерами и сканируют сайт равномерно, стараясь не перегружать сервера.

То что сайт от этого испытывает проблемы с нагрузкой, в 90% случаев может быть сигналом к смене хостинга/сервера или оптимизации производительности CMS. Но в случае крайней необходимости все таки можно задать рекомендуемую скорость сканирования сайта.

Для ограничения скорости обхода сайта можно воспользоваться инструментами Яндекс.Вебмастер и Google

Яндекс:

Google:

В старой версии консоли можно было временно ограничить максимальную скорость сканирования сайта

В обновленной консоли такой возможности нет, но можно отправить сообщение о проблеме с активностью GoogleBot’а на сайте — https://www. google.com/webmasters/tools/googlebot-report

google.com/webmasters/tools/googlebot-report

Как проходит индексация страниц сайта в Google и Яндекс

Оглавление

- Индексация молодых сайтов

- Как ускорить индексацию сайта

- Как проверить индексацию

- Возможности поисковых роботов

- Особенности индексации страниц в Яндекс

- Особенности индексации страниц в Google

Особенности индексации страниц сайта в Google и Яндекс

Когда создаешь сайт, всегда хочется, чтобы он выдавался поисковиками в ТОП-е выдачи. Но чтобы получить хоть какую-то позицию в поиске или, например, запустить контекстную рекламу, нужно, чтобы сайт прошел индексацию поисковых систем. И от ваших действий зависит, придется вам ждать несколько недель или несколько дней.

Индексация молодых сайтов

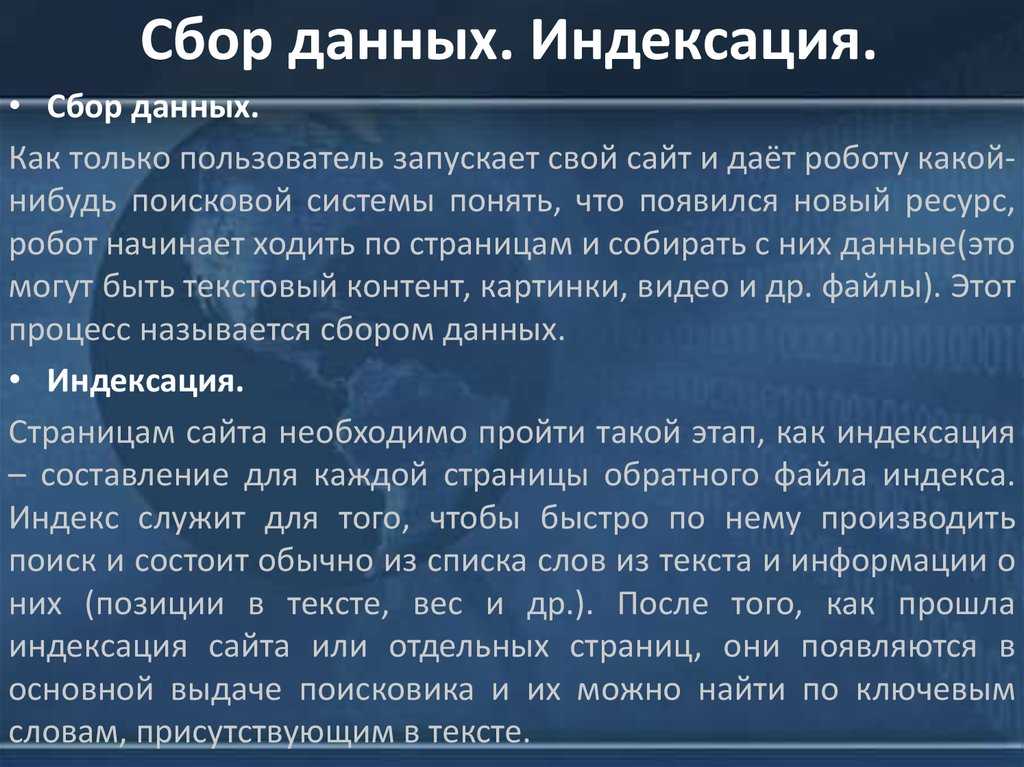

Индексация — ключевое событие в жизни любого сайта. Под этим термином подразумевается процесс сбора информации о веб-страницах и размещенном на них контенте. Этим занимаются специальные роботы поисковиков.

Как только они проиндексируют веб-ресурс, он тут же заносится в базу данных поисковой системы. Это значит, что спустя некоторое время он вместе с другими сайтами будет показываться по запросам в Google и Яндекс.

Как ускорить индексацию сайта

Посещаемые порталы и блоги проверяются роботами поисковиков каждые несколько часов.

Однако новым сайтам придется ждать робота долго – от двух недель. К счастью, на скорость этого процесса можно повлиять.

- Первым делом нужно зарегистрироваться в сервисах Яндекс.Вебмастер и Google Search Console. На сайт следует добавить следующие файлы:

- Карту сайта. По сути, это перечень ссылок, отображающий основные разделы вашего сайта, его структуру. Создается он в формате html или xml. Для поисковых роботов лучше создавать карту во втором формате – файлы формата xml считываются всеми поисковыми системами. Также формат позволяет расставить приоритет ссылок для ускорения индексации.

- Robots.txt.

Этот документ похож на sitemap, поскольку тоже состоит из ссылок. Ключевое отличие в том, что robots.txt ограничивает поискового робота – не все страницы сайта можно индексировать. Например, формы заявки, где пользователь оставляет личную информацию. Обратите внимание, что этот текстовый файл должен быть создан в кодировке UTF-8, иначе роботы могут неправильно его прочесть.

Этот документ похож на sitemap, поскольку тоже состоит из ссылок. Ключевое отличие в том, что robots.txt ограничивает поискового робота – не все страницы сайта можно индексировать. Например, формы заявки, где пользователь оставляет личную информацию. Обратите внимание, что этот текстовый файл должен быть создан в кодировке UTF-8, иначе роботы могут неправильно его прочесть. - Если ссылки на ваш сайт будут размещаться на страницах популярных и уже известных поисковикам платформ, индексация пройдет гораздо быстрее. Возможно, вам не придется ждать и суток.

- Также ссылки можно оставлять на форумах и страницах социальных сетей. Метод не настолько эффективен, как предыдущий, но все же увеличит шансы на ускоренную индексацию.

Заложим фундамент успешного брендаПолучить констультацию

Как проверить индексацию

Существует три основных способа.

- Проверить индексацию в аккаунтах Яндекс.Вебмастер и Google Search Console. В первом сервисе ищем вкладку «Индексирование сайта», во втором – «Индекс Google».

- С помощью операторов. Это команды, которые вводятся в поисковую строку. Для Яндекса – host:ваш сайт, для Google – site:ваш сайт.

- С помощью сторонних сервисов. Например, xseo, rascruty.ru, seogadget.ru

Возможности поисковых роботов

Теперь подробнее рассмотрим, как поисковые роботы собирают информацию.

Наивно думать, что о предстоящей индексации можно позаботиться потом, главное, создать страницу. Про поисковых роботов нужно помнить с самого начала, когда вы разрабатываете структуру сайта, заполняете его контентом, ключевыми словами.

Дело в том, что современные поисковые роботы научились оценивать содержимое с точки зрения его пользы и удобства для людей. Оценивают все: скорость загрузки страницы, грамотность текстов, «вес» страницы, то есть внешние и внутренние ссылки и активность перехода по этим ссылкам. Сюда же относится оценка уникальности и информативности контента, поведенческие факторы вроде показателей отказов. Все критерии назвать невозможно. По некоторым данным, роботы Google оценивают сайт по двумстам параметрам.

По некоторым данным, роботы Google оценивают сайт по двумстам параметрам.

Тем не менее, индексации не стоит бояться, ведь она создана для того, чтобы качественные страницы быстрее находили своего пользователя.

Особенности индексации страниц в Яндекс

В отличие от универсального Google, которым пользуются во всем мире, Яндекс существует в рунете и ориентирован на Россию и страны СНГ. Примечательно, но в начале 2000-х велись переговоры с Google о покупке отечественной площадки. В итоге, компания отказалась от поглощения.

Итак, каковы же особенности индексации в Яндекс?

- Сам процесс проходит примерно так: робот находит ваш ресурс, анализирует его контент и заносит сведения в базу данных. Через две недели сайт попадает в выдачу.

- Главным критерием при поиске в Яндекс является привязка к региону пользователя. Если это прижилось в России, то в других странах это помешало Яндексу завоевать рынок: там принято ориентироваться на язык и местоположение человека.

- Яндекс индексирует медленнее, чем Google. Однако он жестко отсекает некачественные материалы, предлагая пользователю максимально полезные страницы.

Особенности индексации страниц в Google

Очевидным преимуществом Google является его огромная база данных, самая крупная в мире среди поисковиков. Также в компании хорошо поработали над скоростью загрузки системы, в результате чего поисковик практически мгновенно выдает страницы по запросам. И так же быстро индексирует новые сайты. В связи с этим есть свои особенности:

- Google настолько быстро индексирует страницы, что в поиск могут попасть еще недоработанные ресурсы. Дело в том, что страница попадает в выдачу сразу после оценки роботами.

- Для Google важен показатель отказов. Поскольку раньше поисковые алгоритмы были проще, то и материалы в Интернете писались для роботов, человеку они не приносили заметной пользы, их было невозможно читать.

Только показатель отказов давал понять, насколько привлекательным контент был для пользователя. Поэтому современную индексацию поисковика можно описать как отсеивание некачественных сайтов.

Только показатель отказов давал понять, насколько привлекательным контент был для пользователя. Поэтому современную индексацию поисковика можно описать как отсеивание некачественных сайтов. - Также ключевыми факторами для успешной индексации становятся мета-теги title и description, удобная внутренняя перелинковка, простая структура сайта, качественное содержание.

- С недавнего времени Google стал отдавать предпочтение мобильным устройствам, поэтому для него важно, как веб-страницы отображаются в мобильной версии.

Чтобы улучшать позиции вашего ресурса, в дальнейшем нужно регулярно пополнять его страницы новыми материалами. Роботы будут снова индексировать ваш обновленный сайт и продвигать его в топ, если новые тексты будут написаны грамотно и качественно. Узнайте какая контекстная реклама была в топе-2019.

Итак, помните, что при создании сайта надо изначально учитывать его будущую индексацию. Пишите грамотные тексты, создавайте простую и понятную структуру.

В конце концов, посмотрите на страницу глазами обычного пользователя. Все ли ему будет понятно? Будет ли ему полезна ваша информация? Захочет ли он воспользоваться вашими услугами? Если вы создадите сайт под потребности пользователя, роботы это оценят.

Индексирование веб-страниц | Codehouse

Существуют миллиарды веб-страниц. И у каждого есть своя работа, будь то вдохновлять, продвигать, продавать, советовать, все они должны быть перечислены (индексированы) поисковыми системами, чтобы они могли появляться в результатах поиска.

Как найти веб-страницы?

Веб-страницы обнаруживаются путем индексации. Индексирование — это процесс посещения поисковыми системами и анализа новых и обновленных веб-страниц перед добавлением их в свой индекс (базу данных) веб-страниц. Индексацию можно выполнить тремя способами:

- Пусть работают сканеры

- Отправить карту сайта (в формате XML)

- Запрос индексации вручную

Системы управления контентом часто настроены на индексирование недавно опубликованных страниц по умолчанию. Но что, если, например, целевая страница, доступная только избранной группе получателей, не требуется индексировать поисковыми системами? то есть не быть видимым на страницах результатов поисковой системы (SERP).

Но что, если, например, целевая страница, доступная только избранной группе получателей, не требуется индексировать поисковыми системами? то есть не быть видимым на страницах результатов поисковой системы (SERP).

Если разработчик вашего веб-сайта добавил на страницу Директиву о роботах, управляемых контентом, чтобы редакторы контента могли контролировать, как страница индексируется, то достаточно просто установить для страницы значение

Однако, если для редакторов контента нет поля «Директива о роботах», то для назначения директивы может потребоваться поговорить с вашей командой разработчиков, которая обновит файл robots.txt.

Нравится эта статья? Подпишитесь на нашу рассылку новостей

Подпишитесь

Почему важны проиндексированные веб-страницы

Индексация URL-адресов необходима для того, чтобы их могли найти поисковые системы и впоследствии найти потенциальные клиенты, заинтересованные в вашем продукте или услуге.

Если веб-страницы не предназначены для индексации, они не будут найдены и, следовательно, не будут ранжироваться.

Рейтинг URL-адреса и авторитет домена не являются статическими. Помимо зависимости от постоянной оптимизации, в игру вступают и другие факторы. Например:

- Как часто публикуется контент

- Насколько авторитетен и актуален контент

- Внутренняя связь

- Внешние ссылки (обратные ссылки)

- Конкурирующие страницы

- Поведение пользователя при просмотре ссылки в поисковой выдаче

Поисковые системы работают постоянно. Индексация сайта никогда не прекращается. Поисковые роботы периодически возвращаются на веб-сайты, чтобы проверить наличие обновлений и оценить их рейтинг. Вот почему важно убедиться, что ваши веб-страницы созданы для достижения наилучших результатов ранжирования.

В Codehouse все сборки нашего веб-сайта включают директиву о роботах, которая позволяет редакторам контента назначать следующее:

- ИНДЕКС / ПОДПИСАТЬСЯ: Индексировать страницу/Перейти по ее ссылкам

- ИНДЕКС / NOFOLLOW : Индексировать страницу/Не переходить по ссылкам

- NOINDEX / FOLLOW: Не индексировать страницу/Переходить по ее ссылкам

- NOINDEX/NOFOLLOW: Не индексировать страницу/Не переходить по ее ссылкам

Работа с Codehouse

Наша опытная команда специалистов по цифровым технологиям и сертифицированные эксперты Google помогут вашему бизнесу максимально эффективно использовать стратегию контент-маркетинга. Свяжитесь с нами, чтобы узнать больше.

Свяжитесь с нами, чтобы узнать больше.

Знаете ли вы, что действие Universal Analytics прекращается в июле 2023 года? Начните переход и подготовьтесь к переходу на GA4.

Поговорите с нашими экспертами.

Какие страницы показывать в результатах поиска Google • Yoast

Вероятно, вы хотите, чтобы Google и другие поисковые системы отображали большую часть вашего контента в результатах поиска. Но на большинстве веб-сайтов также есть несколько страниц или сообщений, которые не нужно отображать в этих результатах поиска. Так как же указать Google, какие страницы показывать, а какие нет? Здесь в игру вступает настройка страницы на noindex. В этом посте мы расскажем больше об индексации и о том, как Yoast SEO может помочь вам контролировать, какие страницы будут отображаться в результатах поиска.

Начнем с краткого объяснения индексации. Прежде чем поисковая система, такая как Google, сможет ранжировать страницу или сообщение и показать их в результатах поиска, она должна их проиндексировать. Еще до этого сканер должен обнаружить фрагмент контента, прежде чем оценивать, является ли он ценным дополнением к его индексу. Один из способов, с помощью которого сканер обнаруживает страницы, — сканирование XML-карты сайта веб-сайта. После того, как страница будет проиндексирована, поисковая система поймет ее содержание и сможет ранжировать этот фрагмент контента, если он лучше всего соответствует поисковому запросу пользователя.

Еще до этого сканер должен обнаружить фрагмент контента, прежде чем оценивать, является ли он ценным дополнением к его индексу. Один из способов, с помощью которого сканер обнаруживает страницы, — сканирование XML-карты сайта веб-сайта. После того, как страница будет проиндексирована, поисковая система поймет ее содержание и сможет ранжировать этот фрагмент контента, если он лучше всего соответствует поисковому запросу пользователя.

Какие страницы показывать в результатах поиска?

Определить, что следует или не следует индексировать поисковым роботам, бывает трудно понять, и легко сделать ошибку. Вы не будете первым, кто по незнанию установит для всего сообщения тип noindex, что сделает его недоступным для поисковых систем. Мы долго и упорно думали об этом и значительно упростили этот процесс для вас в Yoast SEO. Теперь все сводится к тому, чтобы задать простой вопрос: Вы хотите, чтобы страница x отображалась в поисковых системах 9?0020 ?

Yoast SEO упрощает определение того, что отображается в результатах поиска.

Индивидуальные настройки, позволяющие сделать ваш контент доступным для индексации, можно найти в соответствующих разделах Yoast SEO. В Shopify и WordPress вы можете найти эти настройки в разделах «Типы контента», «Категории» и «Теги» на вкладке «Настройки» Yoast SEO.

Ответив Да на вопрос «Показывать сообщения в результатах поиска» в настройках сообщений, вы гарантируете, что ваши сообщения будут отображаться в XML-карте сайта и, следовательно, в результатах поиска. Если вы хотите что-то исключить, скажем, вы хотите исключить страницы своих категорий, вы можете переключить переключатель в положение «Нет». Таким образом, таксономия или тип записи не будут отображаться в XML-карте сайта. Из-за этого он не будет отображаться в результатах поиска. Всякий раз, когда вы устанавливаете что-то здесь, чтобы не отображаться в поисковых системах, оно не будет индексироваться и не будет включено в карту сайта XML.

Подробнее: Почему Google неправильно индексирует мой контент? »

Исключить отдельные сообщения

Если вы действительно не хотите, чтобы какой-либо конкретный URL отображался в результатах поиска, вам нужно добавить тег noindex, следуйте тегу . Отсутствие его в вашей XML-карте сайта автоматически не означает, что Google не будет индексировать URL-адрес. Если Google может найти его по ссылкам, Google может проиндексировать URL-адрес.

Отсутствие его в вашей XML-карте сайта автоматически не означает, что Google не будет индексировать URL-адрес. Если Google может найти его по ссылкам, Google может проиндексировать URL-адрес.

Вы также можете исключить отдельные сообщения из карт сайта XML с помощью боковой панели Yoast SEO в редакторе сообщений. Или, если вы находитесь на Shopify, вы можете исключить отдельные продукты с помощью боковой панели Yoast SEO. Перейдите на вкладку «Дополнительно» и выберите «Нет» в ответ на вопрос «Разрешить поисковым системам показывать это сообщение в результатах поиска?».

Вы можете определить для каждого поста, должно ли что-то отображаться в результатах поискаПросмотр вашей XML-карты сайта

Когда вы используете Yoast SEO на WordPress, наш плагин автоматически создает полную XML-карту сайта для вашего веб-сайта. Облегчение для поисковых систем обнаружения всех страниц, которые вы хотите, чтобы они открыли. Вы можете проверить свою карту сайта, чтобы увидеть, отображается ли контент, который вы хотите включить, в карту сайта XML. Находясь там, вы должны проверить, не отображается ли контент, который вы хотите исключить из карты сайта.

Находясь там, вы должны проверить, не отображается ли контент, который вы хотите исключить из карты сайта.

Вы можете найти XML-карту сайта в Yoast SEO, выбрав «Основные» > «Функции сайта» > «API» > «XML-карты сайта». Вы можете нажать «Просмотреть карту сайта XML», чтобы перейти к карте сайта XML вашего сайта.

Проверьте свою XML-карту сайта, чтобы убедиться, что все в порядке.Мы устранили большую часть путаницы, связанной с индексированием контента и XML-карт сайта, упростив вещи в Yoast SEO. Но, самое главное, теперь намного проще сказать поисковым системам, что вы хотели бы и не хотели, чтобы они показывали в результатах поиска.

Подробнее о XML-картах сайта

XML-карты сайта — это своего рода карта сокровищ для роботов поисковых систем. Они сканируют их, чтобы обнаружить новый или обновленный контент на вашем сайте. Карта сайта полезна каждому сайту, поэтому Yoast SEO автоматически создает для вас надежную карту сайта в формате XML. Ваш рейтинг не поднимется, если вы добавите его, но это поможет поисковым роботам намного легче находить ваш контент.