WordPress Robots.txt optimization (+ XML Sitemap) – Website traffic, SEO & ranking Booster — Плагин для WordPress

Better Robots.txt создает WordPress виртуальный robots.txt, который помогает вам повысить SEO вашего сайта (возможности индексации, рейтинг в Google и т.

С помощью Better Robots.txt вы можете определить, каким поисковым системам разрешено сканировать ваш сайт (или нет), указать четкие инструкции о том, что им разрешено делать (или нет), а также определить задержку сканирования (чтобы защитить ваш хостинг-сервер от агрессивных действий). скребки). Better Robots.txt также дает вам полный контроль над содержимым WordPress robots.txt через поле пользовательских настроек.

Уменьшите экологический след вашего сайта и выбросы парниковых газов (CO2), свойственные его существованию в Интернете.

Краткий обзор:

ПОДДЕРЖИВАЕТСЯ НА 7 ЯЗЫКАХ

Плагины Better Robots.

А вы знали…

- Файл robots.txt — это простой текстовый файл, размещаемый на вашем веб-сервере, который сообщает сканерам (например, Googlebot), должны ли они обращаться к файлу.

- Файл robots.txt контролирует, как пауки поисковых систем видят и взаимодействуют с вашими веб-страницами;

- Этот файл и боты, с которыми они взаимодействуют, являются фундаментальной частью работы поисковых систем;

- Первое, что искатель поисковой системы просматривает, когда он посещает страницу, — это файл robots.txt;

Robots.txt является источником SEO-сока, ожидающего разблокировки. Попробуйте лучше Robots.txt!

О версии Pro (дополнительные функции):

1. Увеличьте свой контент в поисковых системах с помощью своей карты сайта!

Убедитесь, что ваши страницы, статьи и продукты, даже самые последние, принимаются во внимание поисковыми системами!

Плагин Better Robots. txt был создан для работы с плагином Yoast SEO (вероятно, лучший плагин SEO для веб-сайтов WordPress). Он обнаружит, используете ли вы в настоящее время Yoast SEO и активирована ли функция карты сайта. Если это так, то он автоматически добавит инструкции в файл Robots.txt с просьбой ботов / сканеров прочитать вашу карту сайта и проверить, не вносили ли вы последние изменения в свой веб-сайт (чтобы поисковые системы могли сканировать новый доступный контент).

txt был создан для работы с плагином Yoast SEO (вероятно, лучший плагин SEO для веб-сайтов WordPress). Он обнаружит, используете ли вы в настоящее время Yoast SEO и активирована ли функция карты сайта. Если это так, то он автоматически добавит инструкции в файл Robots.txt с просьбой ботов / сканеров прочитать вашу карту сайта и проверить, не вносили ли вы последние изменения в свой веб-сайт (чтобы поисковые системы могли сканировать новый доступный контент).

Если вы хотите добавить свою собственную карту сайта (или если вы используете другой плагин SEO), то вам просто нужно скопировать и вставить URL-адрес вашего файла Sitemap, и Better Robots.txt добавит его в ваш WordPress Robots.txt.

2. Защитите свои данные и контент

Блокируйте плохих ботов со сбоев на вашем сайте и коммерциализации ваших данных.

Плагин Better Robots.txt помогает вам блокировать сканирование и удаление самых популярных вредоносных ботов.

Когда дело доходит до вещей, просматривающих ваш сайт, есть хорошие и плохие боты. Хорошие боты, такие как бот Google, сканируют ваш сайт, чтобы проиндексировать его для поисковых систем. Другие просматривают ваш сайт по более гнусным причинам, таким как удаление вашего контента (текст, цена и т. Д.) Для повторной публикации, загрузки целых архивов вашего сайта или извлечения ваших изображений. Сообщалось, что некоторые боты даже закрывали целые сайты из-за интенсивного использования широкополосного доступа.

Хорошие боты, такие как бот Google, сканируют ваш сайт, чтобы проиндексировать его для поисковых систем. Другие просматривают ваш сайт по более гнусным причинам, таким как удаление вашего контента (текст, цена и т. Д.) Для повторной публикации, загрузки целых архивов вашего сайта или извлечения ваших изображений. Сообщалось, что некоторые боты даже закрывали целые сайты из-за интенсивного использования широкополосного доступа.

Плагин Better Robots.txt защищает ваш сайт от пауков / скребков, определенных Distil Networks как плохие боты.

3. Скрыть и защитить свои обратные ссылки

Не позволяйте конкурентам определять ваши выгодные обратные ссылки.

Обратные ссылки, также называемые «входящими ссылками» или «входящими ссылками», создаются, когда один сайт ссылается на другой. Ссылка на внешний сайт называется обратной ссылкой. Обратные ссылки особенно ценны для SEO, потому что они представляют «вотум доверия» от одного сайта к другому. По сути, обратные ссылки на ваш сайт являются сигналом для поисковых систем, что другие ручаются за ваш контент.

Если многие сайты ссылаются на одну и ту же веб-страницу или веб-сайт, поисковые системы могут сделать вывод, что на контент стоит ссылаться, и, следовательно, также стоит показывать его в поисковой выдаче. Таким образом, получение этих обратных ссылок оказывает положительное влияние на рейтинг сайта или видимость поиска. В отрасли SEM специалисты часто определяют, откуда берутся эти обратные ссылки (конкуренты), чтобы выделить лучшие из них и создать высококачественные обратные ссылки для своих клиентов.

Учитывая, что создание очень выгодных обратных ссылок для компании занимает много времени (время + энергия + бюджет), позволяя вашим конкурентам легко идентифицировать и дублировать их, это чистая потеря эффективности.

Better Robots.txt поможет вам блокировать все поисковые роботы (aHref, Majestic, Semrush), чтобы ваши обратные ссылки были необнаружимыми.

4. Избегайте обратных ссылок спама

Боты, заполняющие формы комментариев вашего сайта, которые сообщают вам «отличную статью», «любят информацию», «надеются, что вы сможете более подробно остановиться на этой теме», или даже предоставят персонализированные комментарии, в том числе имя автора легион. Спам-боты со временем становятся все более умными, и, к сожалению, спам-комментарии в комментариях действительно могут повредить вашему профилю обратных ссылок. Better Robots.txt поможет вам избежать индексации этих комментариев поисковыми системами.

Спам-боты со временем становятся все более умными, и, к сожалению, спам-комментарии в комментариях действительно могут повредить вашему профилю обратных ссылок. Better Robots.txt поможет вам избежать индексации этих комментариев поисковыми системами.

5. Инструменты Seo

При улучшении нашего плагина мы добавили ссылки на ярлыки к двум очень важным инструментам (если вас интересует ваш рейтинг в поисковых системах): Google Search Console & Bing Webmaster Tool. Если вы еще не используете их, вы можете теперь управлять индексацией своего сайта, оптимизируя свой robots.txt! Также был добавлен прямой доступ к инструменту массового пинга, который позволяет пинговать ваши ссылки в более чем 70 поисковых системах.

Мы также создали 4 ссылки для быстрого доступа к лучшим онлайн-инструментам SEO, которые доступны непосредственно на Better Robots.txt SEO PRO. Таким образом, когда вы захотите, теперь вы сможете проверить эффективность загрузки своего сайта, проанализировать свой показатель SEO, определить свой текущий рейтинг по поисковой выдаче с ключевыми словами и трафиком и даже просканировать весь сайт на наличие неработающих ссылок (404, 503 ошибки, …), Прямо из плагина.

6. Будьте уникальным

Мы подумали, что могли бы добавить немного оригинальности в Better Robots.txt, добавив функцию, позволяющую «настроить» ваш WordPress robots.txt с вашей собственной уникальной «подписью». Большинство крупных компаний в мире персонализировали свои robots.txt добавив пословицы (https://www.yelp.com/robots.txt), слоганы (https://www.youtube.com/robots.txt) или даже рисунки ((https://store.nike.com/robots.txt — внизу). И почему не ты тоже? Вот почему мы выделили определенную область на странице настроек, где вы можете написать или нарисовать все, что хотите (действительно), не влияя на эффективность вашего robots.txt.

7. Запретить роботам сканировать бесполезные ссылки WooCommerce

Мы добавили уникальную функцию, позволяющую блокировать определенные ссылки («add-to-cart», «orderby», «fllter», корзина, аккаунт, оформление заказа и т. Д.) Для поисковых систем. Большинство из этих ссылок требуют много ресурсов ЦП, памяти и пропускной способности (на хост-сервере), потому что они не кэшируются и / или создают «бесконечные» циклы сканирования (пока они бесполезны).

8. Избегайте ловушек на гусеничном ходу:

«Ловушки сканеров» — это структурная проблема на веб-сайте, из-за которой сканеры находят практически бесконечное количество нерелевантных URL-адресов. Теоретически, сканеры могут застрять в одной части веб-сайта и никогда не заканчивать сканирование этих нерелевантных URL-адресов. Better Robots.txt помогает предотвратить ловушки гусеничных устройств, которые снижают бюджет сканирования и вызывают дублирование контента.

9. Инструменты для взлома роста

Сегодня самые быстрорастущие компании, такие как Amazon, Airbnb и Facebook, добились прорывного роста, объединив свои команды в высокоскоростной процесс тестирования / обучения. Мы говорим о взломе роста. Хакерство роста — это процесс быстрого экспериментирования и реализации маркетинговых и рекламных стратегий, которые ориентированы исключительно на эффективный и быстрый рост бизнеса.

10. Robots.txt Post Meta Box для ручных исключений

Этот почтовый мета-бокс позволяет установить «вручную», должна ли страница быть видимой (или нет) в поисковых системах, внедрив специальное правило «disallow» + «noindex» в ваш WordPress robots.txt. Почему это актив для вашего рейтинга в поисковых системах? Просто потому, что некоторые страницы не предназначены для сканирования / индексации. Страницы с благодарностью, целевые страницы, страницы, содержащие исключительно формы, полезны для посетителей, но не для сканеров, и вам не нужно, чтобы они были видны в поисковых системах. Кроме того, некоторые страницы, содержащие динамические календари (для онлайн-бронирования), НИКОГДА не должны быть доступны сканерам, поскольку они имеют тенденцию заманивать их в бесконечные циклы сканирования, что напрямую влияет на ваш бюджет сканирования (и ваш рейтинг).

11. Ads.txt & App-ads.txt crawlability

Ads.txt & App-ads.txt crawlability

In order to ensure that ads.txt & app-ads.txt can be crawled by search engines, Better Robots.txt plugin makes sure they are by default allowed in Robots.txt file no matter your configuration. For your information, Authorized Digital Sellers for Web, or ads.txt, is an IAB initiative to improve transparency in programmatic advertising. You can create your own ads.txt files to identify who is authorized to sell your inventory. The files are publicly available and crawlable by exchanges, Supply-Side Platforms (SSP), and other buyers and third-party vendors. Authorized Sellers for Apps, or app-ads.txt, is an extension to the Authorized Digital Sellers standard. It expands compatibility to support ads shown in mobile apps.

Еще больше, как всегда…

Правильный файл robots.txt для wordpress за 5 минут

Что такое Robots.txt и зачем он нужен

Robots.txt — это файл с инструкциями и директивами для роботов поисковых систем, который создан в текстовом формате. Он указывает на то, какие папки и страницы сайта можно индексировать, а какие нет. Рекомендуется к использованию всеми поисковыми системами для улучшения индексирования ресурса.

Он указывает на то, какие папки и страницы сайта можно индексировать, а какие нет. Рекомендуется к использованию всеми поисковыми системами для улучшения индексирования ресурса.

При каждом сканировании сайта, поисковые роботы обращаются первым делом к Robots. Поэтому можно назвать файл одним из важных факторов ранжирования при продвижении. Большую роль играет то, что Robots не только запрещает и разрешает сканирование страниц, но и содержит ссылку на файл Sitemap. Он в свою очередь сообщает поисковым роботам структуру сайта со ссылками на имеющиеся страницы ресурса.

Благодаря файлу вы можете:

- убрать дубли страниц;

- закрыть неуникальный контент;

- обозначить главное зеркало сайта;

- задать частоту и скорость загрузки страницы роботами;

- скрыть служебные папки.

Правильное заполнение директив показывает поисковым системам, что вы следите за чистотой на сайте. При некорректно созданном файле, ваш сайт вообще может выпасть из поиска, поэтому первым делом seo-специалист проверяет Robots. txt.

txt.

Где находится robots.txt WordPress

Расположение файла может быть разным. Для того, чтобы узнать, есть ли он на сайте в принципе, можно добавить к адресу главной страницы /robots.txt.

В WordPress, как и во многих других CMS, файл находится в корневой папке, поэтому даже если вам открылись директивы выше, редактировать их можно только из файлов на хостинге. Для этого нужно войти в корневую папку сайта.

При отсутствии Robots.txt, создайте его заново.

Как создать файл robots.txt для WordPress

Чтобы создать правильный robots вручную, нужно понимать значение директив и команд. Начать следует с создания документа txt:

- Откройте блокнот на рабочем столе.

- Нажмите “Сохранить”.

- Дайте название сохраняемому файлу robots (не нужно давать свои названия, это стандартное исключение).

- Не меняйте расширение txt.

- Сохраните.

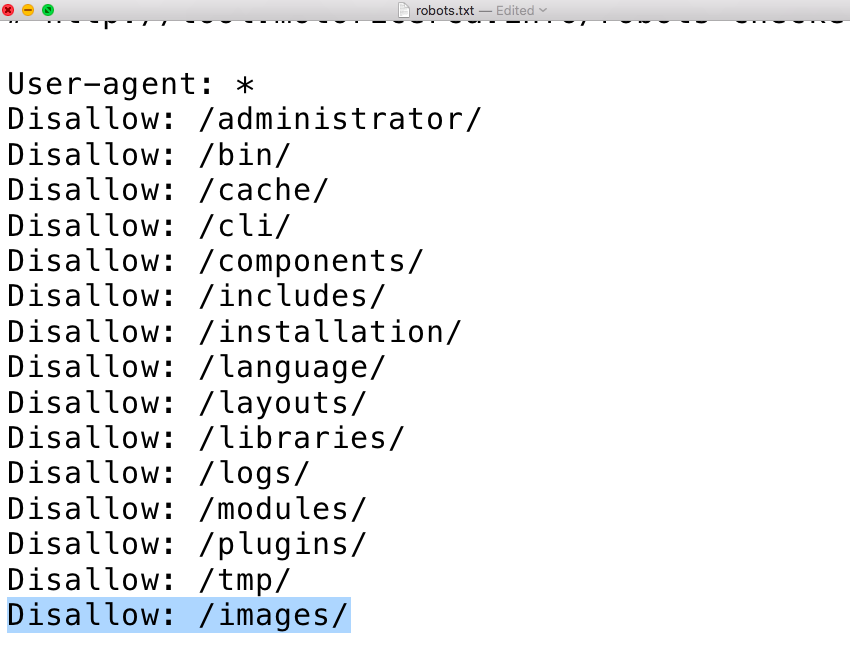

Мы сохранили пустой документ, поэтому далее вам нужно разобраться в значении директив:

- Allow — разрешает сканирование;

- User-agent — указывает для какой поисковой системы составлены директивы;

- Disallow — запрещает сканирование;

- Sitemap — путь с адресом карты сайта;

- Host — главное зеркало;

- Crawl-delay — ограничение времени сканирования;

- Clean-param — убирает дублирующийся контент с других линков.

Считается, что последние три команды уже устарели, но как показывает практика, в работе сайта бывают различные нюансы, поэтому будет не лишним в некоторых случаях прописать эти команды. Поисковые системы всё равно учтут их значения.

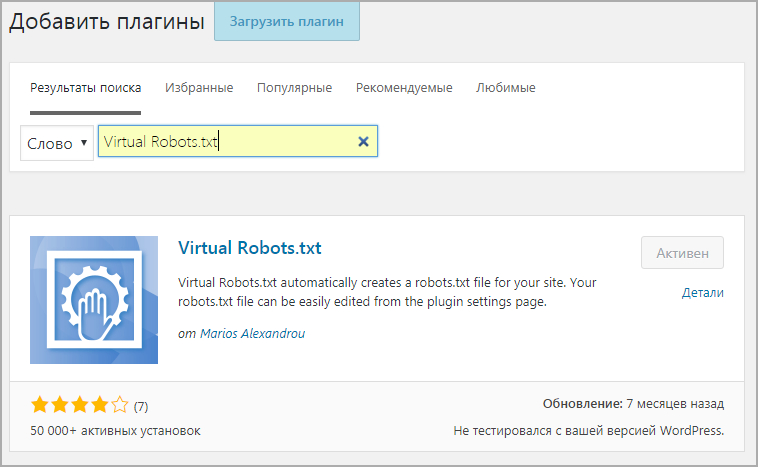

После того, как вы внесли нужные вам директивы, сохраните файл и перезалейте его в корень WordPress. Также вы можете создать robots.txt с помощью плагина. Скачайте Yoast SEO, AIOSEO или любой другой плагин, установите его. Войдите во вкладку Инструменты — Редакторы файлов — Создать файл robots.txt — Сохранить изменения. В этом случае файл будет создан с минимальным количеством директив автоматом.

Как редактировать robots.txt на WordPress?

Редактирование может осуществляться через FTP, плагин.

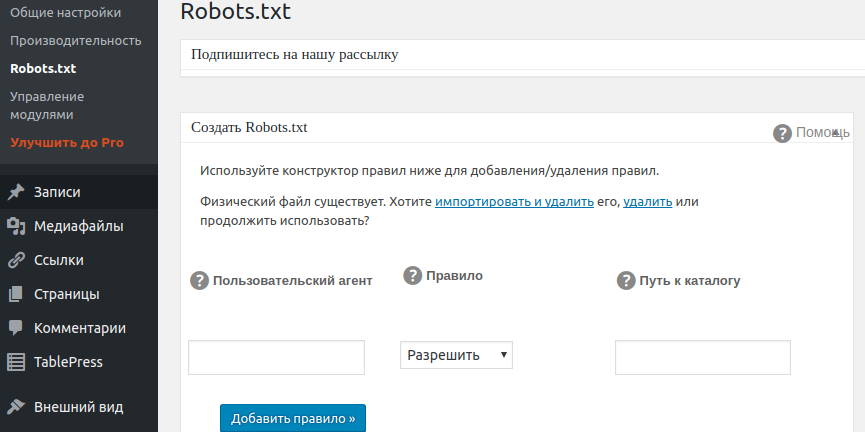

Редактирование через плагин AIOSEO

Войдите в меню плагина — Инструменты — Редактор Robots.txt.

Если вы уже настроили ранее файл robots.txt, то импортируйте его в плагин. Если вы хотите создать новый, тогда система оповещения предупредить вас о наличии уже созданного файла. Его придется либо импортировать, либо удалить. Иногда стоит проигнорировать уведомления и оставить старый роботс до создания нового корректного файла.

Его придется либо импортировать, либо удалить. Иногда стоит проигнорировать уведомления и оставить старый роботс до создания нового корректного файла.

После входа в редактор Robots.txt плагина AIOSEO, перетяните галочку Custom Robots.txt на включение.

Перед вами откроется предварительный просмотр, где вы сможете вносить свои изменения. Плагин уже создаст базовый файл с закрытыми папками админки, темы и прочей информацией, которая не будет полезна людям.

AIOSEO содержит конструктор правил, поэтому путем выбора страниц вы можете легко задать нужные правила сканирования.

Также вы можете добавить новое правила для другой поисковой системы.

Сохраняйте изменения и проверяйте правильность созданного файла.

Редактирование через FTP

FTP позволяет управлять сайтом через удаленный веб-сервер. Благодаря ему можно вносить изменения в любые файлы сайта не имея физического доступа к серверу. Самыми частыми FTP-клиентами считаются FileZilla, Free FTP, Cyberduck, WinSCP.

Настройте FTP для доступа к учетной записи хостинга. Войдите в панель и найдите папку под названием Robots.txt. Можно создать новый файл и перезалить его, либо редактировать уже имеющийся.

Стандартный Robots.txt для WordPress

По умолчанию роботс выглядит так:

Должны быть закрыты административная часть сайта, за исключением admin-ajax.php, которая относится к данной директиве. К сожалению даже для базового Robots.txt на сегодня этого мало, поэтому рекомендуется также закрыть доступ к таким директивам и параметрам как:

- /xmlrpc.php;

- /wp-json;

- author;

- customize_autosaved;

- p&preview;

- s;

- customize_theme.

Базовый файл лучше разделить для двух поисковых систем Гугл и Яндекс, либо для всех поисковых систем User-agent: *, и отдельно для Яндекса User-agent: Yandex.

Строка Disallow: /*? указывает на запрет сканирования UTM-меток, CRM, коллтрекинг и т.д. При копировании кода с нашей страницы не забудьте изменить путь Sitemap.

Расширенный Robots.txt для WordPress

Поскольку WordPress использует кастомную авторизацию, следует закрыть в Robots.txt страницы входа, регистрации и восстановления данных:

- Disallow: /login

- Disallow: /register

- Disallow: /reset-password

Регулярно следите за выдачей и страницами в Яндекс.Вебмастер. Лишние и ненужные страницы нужно убирать из поисковой выдачи, чтобы у роботов было больше шансов просканировать полезные страницы. В связи с этим следует запретить:

- страницы пагинации;

- записи;

- рубрики;

- архивы;

- комментарии к записям;

- скрипты;

- стили.

Директива clean-param

Clean-param прописывается только для Яндекс роботов, поскольку Гуглом она не учитывается. Данная директива сообщает роботам об одинаковых урлах, но с разными динамическими параметрами. Такое часто встречается у тех, кто пользуется контекстной рекламой, сортировкой товаров и т.д. Задача Clean-param в роботс — объяснить поисковым роботам Яндекс, что на сайте есть GET-параметры, что позволит не индексировать и не учитывать дубли страниц.

Чтобы настроить директиву clean-param в Robots.txt для WordPress откройте ее через FTP или плагин (там же где и отредактировать сам файл роботс). Директива может быть прописана в любом месте, но помните что регистр букв играет большую роль. Если вам надо обозначить несколько параметров, то используйте амбассадором &.

Проверка работы файла robots.txt

После того, как вы создали файл robots.txt, загрузили его и убедились в его отображении, следует проверить его доступность с точки зрения поисковиков. Сделать это можно и Яндекс.Вебмастере и Google Search Console. Проверим работу файла robots.txt в Яндекс.Вебмастере:

- Авторизуйтесь;

- Выберите нужный сайт;

- Инструменты;

- Анализ robots.txt.

Перед вами откроется окошко с уже имеющимся файлом или загрузите свой. Нажмите кнопку “Проверить”. Также проверить правильность robots.txt можно перейдя по ссылке https://webmaster.yandex.ru/tools/server-response/. Здесь можно вставить фрагмент кода или ссылку на файл.

Если все директивы отдают ответом 200 ОК, то все работает корректно. При наличии ошибок, они будут подсвечиваться красным.

Как оптимизировать файл robots.txt в WordPress?

В этой статье подробно рассказывается, как оптимизировать файл robots.txt WordPress.

Что такое файл robots.txt?

Файл robots.txt используется для информирования роботов поисковых систем о том, как сканировать ваши веб-страницы, чтобы они могли захватывать ваш контент вместе со ссылками, которые, в свою очередь, помогут посетителям найти ваш сайт.

Вы также можете использовать роботов, чтобы указать, какие страницы роботы поисковых систем НЕ должны сканировать, и вообще запретить определенным роботам сканировать ваш сайт.

Где я могу найти свой файл Robots?

Ваш файл WordPress robots.txt можно найти в файлах вашего веб-сайта после того, как вы подключитесь к своему сайту через FTP.

Оттуда вы можете вручную отредактировать свой файл, чтобы указать, какие роботы могут сканировать ваши страницы, а также страницы, которые они должны и не должны сканировать. Подробности о том, как это сделать, можно увидеть в разделе ниже.

Как добавить/оптимизировать файл Robots?

Вы можете оптимизировать файл Robots с помощью плагина или через FTP , оба из которых описаны ниже.

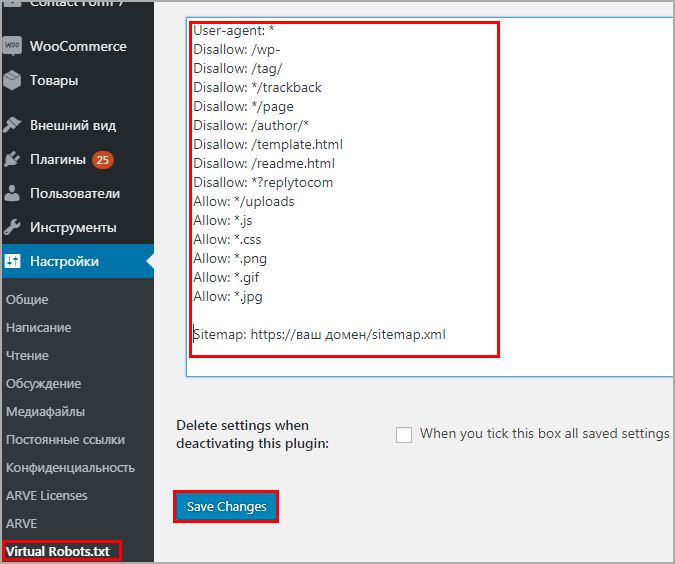

Через плагин

Если вы не особенно разбираетесь в технологиях, вы можете установить плагин в WordPress, чтобы разрешить роботов. Для этого просто следуйте приведенным ниже инструкциям:

Шаг 1 из 4

Начните с установки и активации плагина All In One SEO .

Шаг 2 из 4

Оттуда наведите курсор на Все в одном SEO в меню слева и выберите Инструменты в появившемся меню.

Шаг 3 из 4

На следующей странице появится редактор Robots.txt. Просто переключите параметр Enable Custom Robots.txt , чтобы включить роботов.

Шаг 4 из 4

Здесь вы можете добавить свои собственные правила, введя значения в предоставленные текстовые поля:

- Агент пользователя: , на каких ботов вы хотите настроить таргетинг. Если вы хотите настроить таргетинг на ВСЕХ ботов, просто введите *

- Правило: установите, хотите ли вы разрешить или запретить правило

- Путь к каталогу: укажите, где должно быть установлено ваше правило по Сохранить изменения .

Через FTP

Шаг 1 из 4

Начните с открытия FileZilla.

Шаг 2 из 4

Введите данные FTP в соответствующие поля и нажмите Быстроразъемное соединение .

Шаг 3 из 4

Щелкните правой кнопкой мыши файл robots.txt и выберите View/Edit .

Шаг 4 из 4

Откроется файл Блокнота, в котором вы сможете начать добавлять/редактировать свои правила.

- User Agent: на каких ботов вы хотите ориентироваться. Если вы хотите настроить таргетинг на ВСЕХ ботов, просто введите *

- Disallow: какие страницы на вашем сайте вы хотите, чтобы роботы избегали

Обязательно сохраните файл Блокнота после внесения любых изменений.

Что такое файл robots.txt?

Файл robots.txt — это директива для сканеров поисковых систем относительно того, к каким URL-адресам на вашем сайте они могут получить доступ.

Файл robots.txt используется главным образом для управления бюджетом сканирования и предотвращения перегрузки сервера запросами.

Как robots.txt влияет на разные типы файлов? Однако он не защищает веб-страницу от Google. Для этого заблокируйте индексацию с помощью noindex или защитите страницу паролем.

Однако он не защищает веб-страницу от Google. Для этого заблокируйте индексацию с помощью noindex или защитите страницу паролем.1. Веб-страницы

Файл robots.txt для веб-страниц (PDF, HTML или другие немедийные форматы, читаемые Google) может предотвратить перегрузку вашего сервера запросами сканера. Кроме того, файл robots.txt может предотвратить сканирование неважных или похожих страниц на вашем сайте.

Однако не рекомендуется использовать файл robots.txt для скрытия ваших страниц из результатов поиска Google. Если дополнительные страницы указывают на описательный текст на вашей странице, Google все равно может проиндексировать URL-адрес, не посещая страницу. Заблокируйте свою страницу из результатов поиска с помощью noindex или защиты паролем.

Обратите внимание: если вы заблокируете свою веб-страницу с помощью файла robots.txt, ее URL-адрес все равно может отображаться в результатах поиска.

Однако результат не будет содержать описания, а мультимедийные файлы, такие как файлы видео и изображений, PDF-файлы и другие файлы, отличные от HTML, будут проигнорированы.

Однако результат не будет содержать описания, а мультимедийные файлы, такие как файлы видео и изображений, PDF-файлы и другие файлы, отличные от HTML, будут проигнорированы.Тем не менее, пользователи или другие страницы могут ссылаться на ваши медиафайлы с других страниц. Если вы видите результаты поиска для своей страницы, исправьте это, удалив запись robots.txt, блокирующую страницу. Чтобы полностью скрыть страницу из Поиска, воспользуйтесь другим способом.

2. Файлы ресурсов

Если вы считаете, что ваши страницы загружены файлами ресурсов, такими как неважные сценарии, изображения или файлы стилей, файл robots.txt может их заблокировать. Тем не менее, убедитесь, что блокировка этих страниц не будет существенно затронута потерей. Например, не блокируйте их, если их отсутствие затруднит понимание страницы поисковым роботом Google; в противном случае Google не будет адекватно анализировать страницы, зависящие от этих ресурсов.

Каковы ограничения блокировки файла robots.