что такое центр обработки данных, параметры дата-центров

Когда речь заходит о качестве облачных услуг, на ум сразу приходят такие параметры облака как система виртуализации, аппаратная часть, состоящая из серверов, СХД и сетевого оборудования, а также система управления виртуальной инфраструктурой. Эти параметры действительно важны, так как от них зависит скорость работы, надежность и различные возможности облачных сервисов.

Но, как и в случае любых технических решений, одну из ключевых ролей в облаке играет непрерывность предоставления услуг, которая в большой степени зависит от работы различных инженерных систем, таких, например, как электроснабжение и кондиционирование. Для этого создаются дата-центры, или как их еще называют – Центры Обработки Данных.

Такие ЦОДы являются помещениями, в которых созданы идеальные условия для работы различного оборудования и деятельность которых направлена на обеспечения непрерывности его работы. В данной статье мы подробно рассмотрим, что такое дата-центры и чем они отличаются друг от друга.

Чем ЦОД отличается от обычного серверного помещения

Для начала давайте разберемся, чем ЦОД отличается от обычной серверной, которая присутствует практически в каждой компании в том или ином виде. По сути, два этих помещения обеспечивают одну и ту же функцию – позволяют разместить оборудование для его эксплуатации и обслуживания. При этом в таких помещениях должны быть, как минимум реализованы комфортные температурные условия и бесперебойная подача электроэнергии. Вот тут и кроется основное различие.

Другими словами, ЦОД – это большая серверная, оснащенная множеством инструментов для того чтобы размещенное оборудование работало стабильно и без перерыва.

В ЦОДе – все инженерные системы зарезервированы и обладают мощностью позволяющей работать оборудованию даже при возникновении локального «блэкаута». Также, в отличие от обычной серверной, здесь реализованы дополнительные системы, обеспечивающие ограничение физического доступа к оборудованию и приняты меры безопасности на случай чрезвычайных ситуаций. Помимо этого, в дата-центре ведется непрерывный мониторинг систем, позволяющий предотвратить нештатные ситуации или оперативно отреагировать них.

Помимо этого, в дата-центре ведется непрерывный мониторинг систем, позволяющий предотвратить нештатные ситуации или оперативно отреагировать них.

Основные параметры дата-центра

При постройке дата-центра учитывается огромное количество нюансов, от обеспечения прокладки кабелей и расстояния между стойками оборудования до систем пожаротушения и контроля доступа. От качества реализации каждой из них, зависит то насколько надежным, удобным и безопасным будет эксплуатация размещенного оборудования. Разумеется, есть основные инженерные системы, которым уделяется основное внимание. Давайте рассмотрим их подробнее.

Электроснабжение

Первой и основной задачей любого дата-центра является обеспечение непрерывной подачи электроэнергии. Обычно данный параметр имеет две ступени реализации. Первая – это наличие источников бесперебойного питания и стабилизации напряжения. Это позволяет обезопасить оборудование от скачков напряжения и его кратковременного отключения. Вторая ступень – это наличие внешнего генератора питания, который включается чаще всего в ручном или полуавтоматическом режиме и позволяет продолжать работу даже при длительном отсутствии основного электропитания.

Вторая ступень – это наличие внешнего генератора питания, который включается чаще всего в ручном или полуавтоматическом режиме и позволяет продолжать работу даже при длительном отсутствии основного электропитания.

Кондиционирование

При работе, оборудование выделяет огромное количество тепла, и для того чтобы избежать перегрева серверов, необходимо обеспечить постоянную прохладную температуру в помещениях где они установлены. Для этого в дата-центрах используются промышленные системы кондиционирования и вентиляции.

Система контроля доступа

Физическая безопасность в дата-центрах должна быть реализована на высоком уровне, чтобы избежать получение доступа к оборудованию третьими лицами. Поэтому во многих ЦОДах очень применяются очень жесткие правила, вплоть до одноразовых паролей и электронных контрольно пропускных систем.

Система пожарной безопасности

Независимо от принятых мер предосторожности, невозможно на сто процентов защитить оборудование от чрезвычайных ситуаций, таких как пожар. На всей площади дата-центра (не только в помещениях с оборудованием) реализуется и чаще всего дублируется система пожаротушения, чаще всего основанная на газовом методе тушения. Это позволяет сократить повреждения оборудования при возникновении пожара.

На всей площади дата-центра (не только в помещениях с оборудованием) реализуется и чаще всего дублируется система пожаротушения, чаще всего основанная на газовом методе тушения. Это позволяет сократить повреждения оборудования при возникновении пожара.

Передача данных

Предоставление услуг размещения оборудования в ЦОДе, предполагает удаленное использование вычислительных ресурсов. Поэтому сетевая доступность является, также, важным параметром работы дата-центра. Обеспечивается такая доступность наличием сетей нескольких, независимых друг от друга операторов связи, а также резервированием сетевых каналов.

Мониторинг

В дата-центре большинство процессов, связанных с работой инженерных систем, автоматизировано. Несмотря на это в любом ЦОДе ведется постоянный мониторинг работы этих систем для того чтобы предотвратить нештатные ситуации.

Стоит отметить, что каждая из этих систем является жизненно важной для работы дата-центра. Но, их реализация, в зависимости от уровня ЦОДа, может быть абсолютно разной, также как и примененная схема резервирования.

Системы резервирования дата-центров

Любая система в дата-центре несмотря на высокое качество реализации, может выйти из строя, вследствие отказа какого то критичного компонента. Для того чтобы избежать этого, в ЦОДе может быть применена схема резервирования, которая в ряде случаев поможет избежать остановок в работе. При описании таких схем используется буква «N», что означает «необходимость».

Давайте рассмотрим их подробнее:

- N. Такое обозначение говорит об отсутствии какого либо резервирования. Это значит, что все компоненты системы необходимы для ее работы и при выходе из строя одного из них она перестанет функционировать.

- N+1. Данное обозначение подразумевает наличие одного дублирующего компонента, который вступит в работу при выходе из строя одного из критичных элементов.

- 2N. Такая схема резервирования означает, что в системе одновременно работают два равнозначных компонента. Каждый из них работает в половину своей мощности, и в случае отказа одного из них, второй сможет взять всю нагрузку на себя.

- 2N+1. Это по сути совмещение схем 2N и N+1. Другими словами, помимо параллельно работающих компонентов, которые делят между собой нагрузку, существует еще один, находящийся в отключенном состоянии. Применение такой схемы уже позволяет проводить работы по ремонту и обслуживанию систем без их остановки.

- 2(N+1). Такое решение означает применение двух схем резервирования, каждая из которых также зарезервирована. Говоря простым языком, при выходе из строя одной системы, вторая не просто продолжит работу, а еще и сохранит отказоустойчивость.

Классификация надежности дата-центров

Примененные схемы резервирования в совокупности с качеством реализации инженерных и других систем, обеспечивают определенный уровень доступности оборудования. Существует классификация надежности дата-центров, разработанная организацией Uptime Institute, которая является признанной во всем мире. Данная организация выдает сертификаты соответствия классу надежности, ЦОДам прошедшим аудит. Стоит отметить что дата-центр может быть построен на 99% в соответствии с требованиями того или иного класса надежности, но при этом сертификат он получить не сможет.

Стоит отметить что дата-центр может быть построен на 99% в соответствии с требованиями того или иного класса надежности, но при этом сертификат он получить не сможет.

Перейдем к самой классификации:

- TIER-I — базовый уровень доступности. ЦОДы соответствующие данному классу построены на базе схему резервирования N, и устарели несколько десятилетий назад. Однако при правильной реализации всех систем, уровень доступности оборудования в дата-центре такого класса, составляет 99,671%, или 30 часов простоя в год.

- TIER-II — этот класс надежности означает, что в дата-центре, помимо достойного уровня реализации инженерных систем, также применена схема резервирования N+1. В случае соответствия этому классу, для проведения ремонта вышедших из строя компонентов системы все рано придется останавливать. Уровень доступности оборудования в этом случае составляет 99, 749%, это 22 часа простоя в год.

- TIER-III — данный класс надежности означает, что для проведения ремонта или обслуживания внутренних систем ЦОДа, не потребуется его остановка.

Чаще всего схема резервирования, примененная в дата-центрах такого уровня это 2N. Доступность оборудования в данном случае составляет 99,98%, или около полутора часов простоя в год.

Чаще всего схема резервирования, примененная в дата-центрах такого уровня это 2N. Доступность оборудования в данном случае составляет 99,98%, или около полутора часов простоя в год. - TIER-IV — все системы внутри таких ЦОДов зарезервированы дважды, что означает применение схемы 2(N+1). Уровень доступности оборудования в данном случае соответствует показателю 99,95%, другими словами, сервер расположенный в дата-центре такого уровня надежности, может быть недоступен в год на протяжении примерно 0,8 часов.

Заключение

В данной статье мы кратко ознакомили вас с тем, что такое Центр Обработки Данных и как он устроен внутри. В предыдущих статьях мы упоминали, что ЦОД является одним из тех моментов, на которые стоит обратить внимание при выборе облачного провайдера. И хотя перед тем как размещать свое оборудование в том или ином ЦОДе, поставщики облачных услуг проводят доскональную проверку его надежности, никогда не будет лишним поинтересоваться дата-центром в котором будут размещены ваши сервисы.

как обеспечить ЦОДу 10 лет аптайма / Хабр

Современный дата-центр – комплексный организм, состоящий из множества инженерных подсистем, сетевой и ИТ-инфраструктуры. В ЦОДе слишком много переменных и вариантов их взаимодействия, поэтому риски сбоев очень высоки. Тем не менее, вся бизнес-модель дата-центров строится на постоянной доступности ИТ-систем. Как обеспечить 10 лет безаварийной работы такого объекта – рассказываем на примере нашей площадки в Петербурге.

Покой всем только снится

Общее количество сбоев в работе центров обработки данных продолжает расти, однако количество аварий сегодня отстает от скорости ввода в эксплуатацию новых мощностей. Это значит, что в расчете на один ЦОД в последнее время происходит меньше инцидентов – об этом говорит статистика Uptime Institute.

В 2020 году только 6% респондентов исследования Uptime заявили, что их дата-центры столкнулись с серьезными сбоями, по сравнению с 11% годом ранее.

Но успокаиваться рано: число серьезных аварий сокращается, однако размер экономического ущерба от них заметно увеличился. Это связано с постоянно растущей зависимостью организаций от ИТ.

По данным Gartner, средняя стоимость простоя ИТ-систем для бизнеса в 2021 году составляет $5600 в минуту. Поскольку существует множество различий в специфике и масштабе предприятий, потери из-за аварий дата-центров сегодня могут варьироваться в диапазоне от $140 000 до $540 000 в час.

На системы электропитания дата-центров приходится наибольшее количество серьезных инфраструктурных инцидентов, ИБП и автоматические переключатели (ATS) чаще всего становятся их основной причиной (22%).

Появляются новые риски. Например, увеличилось количество сбоев в работе программного обеспечения, отвечающего за координацию работы подсистем дата-центров или за их мониторинг.

Также в отчете Uptime человеческий фактор по-прежнему указывается в качестве одной из главных причин перебоев в работе ЦОДов. В долгосрочной перспективе автоматизация должна сократить количество отказов инженерных систем, которые происходят из-за ошибок сотрудников.

В долгосрочной перспективе автоматизация должна сократить количество отказов инженерных систем, которые происходят из-за ошибок сотрудников.

Из этого не следует, что уменьшение количества человеческих ошибок достигается за счет сокращения людей в ЦОДах. Скорее, речь идет о ведущей роли повышения квалификации специалистов в сочетании с грамотным управлением.

Баланс людей, машин и процессов

На фоне опубликованной отраслевой статистики 10 лет бесперебойной работы инженерных и ИТ-систем ЦОД Linxdatacenter в Петербурге, зарегистрированные в сентябре 2021 года, выглядят результатом, о котором хочется рассказать подробнее.

Оптимальный подход к эффективному управлению работой современного дата-центра заключается в балансе между автоматизацией процессов и оптимизацией операционного управления.

Площадка Linxdatacenter в Санкт-Петербурге последовательно наращивает компетенции в плане организации работы штата и повышения его квалификации.

Отдельно стоит выделить сертификацию по стандарту Uptime Institute Management & Operations Stamp of Approval. Можно сказать, что работа по обеспечению соответствия требованиям M&O помогла нам переосмыслить подход к управлению дата-центром и во многом позволила обеспечить круглую дату.

Стандарт M&O – результат 20-летнего опыта разбора специалистами Uptime Institute более 6000 кейсов по отказам дата-центров по всему миру. Анализ этих данных показал, что 75% всех инцидентов и аварий так или иначе обусловлены ошибками и небрежностью в работе персонала.

Эта картина складывается из комплекса конкретных операционных ошибок и неверных управленческих решений при комплектовании штата, выстраивании процессов обслуживания оборудования и обучения специалистов.

Чтобы оценить, насколько процессы в конкретном ЦОДе соответствуют идеалу, Uptime разработал методику измерения эффективности сотрудников. Она основана на трех принципах – проактивность, практичность и информированность. Эффективное управление дата-центром достигается при соблюдении сотрудниками всех трех.

Процессы по управлению ЦОДом оцениваются по пяти категориям в соответствии со значимостью вклада в общую статистику отказов: кадровые ресурсы и организация штата (максимум 35 баллов), техническое обслуживание (30), обучение штата (20), планирование, координация и управление (10), условия труда (5).

Апгрейд организации работы сотрудников дата-центра через обучение, прописывание инструкций, своевременное регламентное обслуживание и тренинги действий в чрезвычайных ситуациях, сокращает количество отказов в ЦОДе в 3 раза.

На сегодня в активе ЦОДа Linxdatacenter в Санкт-Петербурге – три аттестации по M&O. Первый аудит Uptime Institute с оценкой квалификации персонала и процессов эксплуатации оборудования прошел в 2018 году.

По его итогам дата-центр набрал 84 балла из 100 возможных. Второй раунд в 2020 году позволил нам достичь оценки в 95,1 балла. В 2021 в ходе третьего аудита мы взяли 96.

Прогресс в 12 баллов за три года – результат постоянной работы над ошибками, множества эпизодов критического анализа и разбора собственных подходов к выполнению ряда рабочих процедур, а также готовности отказываться от привычных паттернов работы в целях повышения операционной надежности площадки.

Не стоит думать, что мы сразу знали «как надо», понимали, в каком направлении двигаться, и владели секретными методиками достижения искомого результата.

Большой объем набитых шишек и моментов озарения «как же мы это сразу не догадались» присутствовал в полном объеме.

Правильное электропитание

В основе всего – решение задач эффективного энергообеспечения площадки.

Всего 15 миллисекунд перебоя питания современного дата-центра достаточно, чтобы бизнес-процессы компаний-клиентов были нарушены с ощутимыми для конечного пользователя последствиями. Для понимания: 1 миллисекунда (мс) — это одна тысячная доле секунды. 5 мс – время, необходимое пчеле для одного взмаха крыла.

Для понимания: 1 миллисекунда (мс) — это одна тысячная доле секунды. 5 мс – время, необходимое пчеле для одного взмаха крыла.

Сбой в питании ведет к перезагрузке серверов, перезапуску операционных систем и прикладного софта, что чревато полной остановкой всех пользовательских систем и сервисов.

Защититься от этого можно. Для этого надо отказаться от централизованного поставщика электричества. Если ЦОД потребляет более 1 МВт, и есть строгие требования к непрерывности ИТ-процессов клиентов (например, в ЦОДе стоит процессинговый центр крупного банка) – имеет смысл подумать о своем независимом электричестве.

ЦОД Linxdatacenter в Санкт-Петербурге автономен: его потребности в электричестве обеспечиваются газо-поршневой электростанцией на 12 МВт. Если подача газа по каким-то причинам будет прекращена, есть ИБП, мощностей которых хватит на 40 минут бесперебойной работы ЦОДа.

За это время можно запустить дизель-генераторы (ДГУ), которые на имеющимся запасе топлива обеспечат еще минимум 72 часа автономной работы. Параллельно в действие вступят контракты с поставщиками топлива, которые обязаны привезти оговоренные объемы в ЦОД в течение 4 часов.

Параллельно в действие вступят контракты с поставщиками топлива, которые обязаны привезти оговоренные объемы в ЦОД в течение 4 часов.

Эта схема обеспечения дата-центра электричеством лежит в основе его высокого уровня отказоустойчивости. Однако даже при полной энергонезависимости существует множество факторов, способных «положить» ЦОД полностью или частично.

Сотрудники клиента неправильно подключили оборудование в стойке? Короткое замыкание, сбой. Специалисты не проконтролировали емкость аккумуляторов ИБП? При аварийной ситуации бесшовного переключения на резервную схему питания не произойдет. Кто-то не проверил объемы заправки топлива в баки ДГУ? Оно закончится в самый неподходящий момент, и ЦОД встанет.

Выход? Профилактика и тренинг персонала, а также мониторинг работы всех систем и подсистем площадки. Нужно проводить регулярное плановое переключение на резервную схему питания ЦОДа, а также отрабатывать сценарии различных сбоев и аварийных ситуаций, оттачивая взаимодействие сотрудников до автоматизма для минимизации возможных последствий.

Любая схема резервирования инженерных систем дата-центра работает только при условии регулярной отработки внештатных ситуаций, постоянного подтверждения квалификации персонала и контрактам с надежными поставщиками услуг, наличия комплектующих и расходных материалов.

Мы развили концепцию превентивных работ до максимума: ввели процедуру анализа качества поставляемого топлива и проводим профилактический уход за дизель-генераторными установками.

Казалось бы, рутинная операция – уборка ДГУ. Где там можно найти пространство для оптимизации? Однако выяснилось, что своевременное удаление грязи и пыли серьезно откладывает ранний абразивный износ движущихся частей ДГУ.

В сочетании с регулярным осмотром и проверкой узлов это позволяет найти – и сделать это вовремя – трещины на изоляции на перемычке аккумуляторов, ослабление клемм на низковольтном генераторе, разболтанные хомуты на турбинах, протечки в фильтрах (риск утечки масла в процессе работы) и т.д.

Банальное поддержание установок в чистоте и простой уход (даже без фанатизма, а просто на регулярной основе) позволяет практически исключить риски того, что в ответственный момент случится отказ, и ДГУ не запустится.

Экзамен на зрелость

Второй фактор высокого аптайма: работа со штатом сотрудников инженерных служб, в основе которой лежит система аттестации и тренинги. Без надлежащего количества квалифицированных сотрудников и правильной организации труда у ЦОДа не будет ресурсов для успешного функционирования.

Обеспечить себя такими сотрудниками можно через качественный подбор персонала и разработку программы обслуживания инженерных систем. Такая программа состоит из профилактического обслуживания (PM), политики уборки, системы управления техническим обслуживанием (MMS) для отслеживания работ, а также соглашения об уровне обслуживания (SLA).

M&O предлагает в качестве решения комплексную программу обучения персонала, формализованную и опирающуюся на отдельный блок документации.

Такой подход обеспечивает согласованность эксплуатации и технического обслуживания инфраструктуры ЦОД. Цитируя стандарт: «Весь персонал должен понимать политики, процедуры и уникальные требования к работе в ЦОД, чтобы избежать незапланированных простоев и реагировать на ожидаемые события».

Отсюда берет начало наша система аттестации. Помимо M&O она базируется на стандарте ISO 22301 «Security and resilience – Business continuity management systems» («Безопасность и устойчивость – Системы управления операционной непрерывностью бизнеса»). Другой источник вдохновения – собственный опыт, он отражен в нашей документации по процедурам аварийной эксплуатации (EOP – Emergency Operations Procedures).

Прохождение аттестации на знание инструкций, сценариев реагирования на чрезвычайные и штатные ситуации, распределение ролей и зон ответственности между участниками дежурной смены и др. – обязанность всех работников ЦОДа.

Мы неоднократно убеждались, что любые методики контроля качества приносят результат, если они формализованы и применяются на регулярной основе – это еще одна причина ввода обязательной аттестации.

Сейчас аттестацию работника проводит комиссия в составе не менее трех человек в рамках опросников и тестов. Общее количество вопросов – 60-70, во время аттестации случайным образом выбираются 15. Около 80% вопросов касаются непосредственно профессии, остальные 20% – смежных областей знаний и компетенций. По итогам выносится заключение об уровне соответствия сотрудника занимаемой должности.

Около 80% вопросов касаются непосредственно профессии, остальные 20% – смежных областей знаний и компетенций. По итогам выносится заключение об уровне соответствия сотрудника занимаемой должности.

Например, после одного из аудитов Uptime выяснилось, что чек-листы для оперативных групп хоть и были очень подробными, однако в них не было полей для отметки выполненных шагов в рамках процедуры. Получили рекомендацию добавить необходимые поля. Небольшое и очевидное улучшение значительно повысило качество контроля за профилактическим обслуживанием.

Также всю библиотеку существующих у нас инструкций Uptime порекомендовал объединить в рамках матрицы или блок-схемы ответственных и подотчетных лиц — для наглядности и информированного выполнения процессов, связанных с эксплуатацией, поддержкой и обеспечением безопасности.

Всевидящее око мониторинга

Система мониторинга работы инженерных систем в ЦОДе (BMS, Building Monitoring System) – завершающий и критически важный компонент обеспечения аптайма. Он напрямую влияет на скорость реакции персонала на аварийные ситуации. Сегодня мы используем BMS-систему, кастомизированную в собственном облаке, разработанную специально под требования наших специалистов.

Он напрямую влияет на скорость реакции персонала на аварийные ситуации. Сегодня мы используем BMS-систему, кастомизированную в собственном облаке, разработанную специально под требования наших специалистов.

Доступ к ней обеспечивается через веб-браузер из любой точки, без обязательного присутствия инженера на территории ЦОДа. Интерфейс системы анимирован так, чтобы динамика функционирования инфраструктуры была наглядна для дежурных инженеров.

Также в BMS-решении обеспечивается поддержка формул для обсчета работы виртуальных датчиков в инженерных системах – например, для оптимального распределения электрических мощностей по стойкам с оборудованием.

Система обеспечивает доступ к базе данных SQL с возможностью брать из нее нужные данные о работе оборудования – а именно, все записи о мониторинге 2 тысяч устройств и виртуальных датчиков, генерирующих примерно 20 тыс. переменных.

Еще одна «фишка» нашей BMS-системы: на одной странице представлены все основные параметры ЦОДа, чтобы с одного взгляда на экран оценит состояние основных систем, так называемый формат One page.

Это таблица, сверстанная под формат вертикально расположенного экрана смартфона. Расположение ячеек в таблице повторяет архитектуру ЦОДа (физическую или логическую). Последовательность отражает зрительные ассоциации персонала дата-центра, что упрощает поиск нужной информации.

Система поддерживает мобильность сотрудников. Помимо контроля мониторинга в помещении дежурной смены, инженеры делают обходы, выполняют текущую работу вне «дежурки» и, благодаря оптимизированному под мобильный экран главному экрану BMS, не теряют контроль за происходящим в машзалах.

Качество контроля повышается благодаря функциональности рабочих чатов. Они ускоряют рабочие процессы, позволяя привязать переписку дежурных инженеров к BMS. Например, приложение MS Teams позволяет вести внутреннюю переписку и получать на телефон все сообщения из BMS в виде всплывающих Push-уведомлений, что избавляет дежурного от необходимости постоянно смотреть в экран телефона.

Здесь не все прошло гладко: мы недооценили объем изменений, которые потребовалось внести в базовую версию новой BMS, и не уложились в сроки. Критической проблемой это не стало, так как мы подстраховались и работали на старой системе.

Критической проблемой это не стало, так как мы подстраховались и работали на старой системе.

Также потребовалось несколько этапов испытаний, чтобы отладить алгоритм резервирования виртуальных машин и каналов связи. Изначально сбои были и на стороне системы BMS, и в ходе настройки виртуальных машин и сети. Эта отладка тоже заняла время.

Итоговое решение оказалось сложнее для редактирования конечным пользователем, более требовательным в эксплуатации. Ранее карта представляла собой подложку (графический файл) и значки, изменить или переместить которые не составляло труда. Сейчас это сложный графический интерфейс с анимацией, его редактирование требует от инженеров определенных навыков.

Мелочей нет – постоянное развитие

Это довольно общий взгляд на те составляющие, которые позволяют обеспечивать 100%-ный uptime ЦОДа и рассчитывать на повторение безаварийной декады.

Пожалуй, самый главный фактор на этом пути – желание и способность постоянно находить возможности для улучшения работы ЦОДа, копаться в мелочах, просчитывая сценарии апгрейда по не самым очевидным направлениям.

Именно такое отношение к задаче позволило нам в свое время обнаружить проблемы с контролем уровня давления и «подпора» воздуха в серверных помещениях и наладить его оптимальные показатели. Мы также обнаружили и устранили причину загрязнения воздуха в машзалах.

На пути к 100%-ному уровню аптайма нет мелочей и нет остановок – это постоянное совершенствование, например, через ввод в эксплуатацию нового энергооборудования или создание безопасных условий труда технического персонала через внедрение в практику системы LOTO.

Центр обработки данных | Глоссарий VMware

Main Menu

Контроль над многооблачными средами

73% компаний используют 2 публичных облака или более. Многооблачные среды ускоряют цифровую трансформацию, но при этом создают сложность и риски.

Многооблачные среды обычно сложные

91% руководителей ищут способ повысить «согласованность своих публичных облачных сред».

Приложения нужно модернизировать

68% разработчиков хотят расширить использование современных платформ, API-интерфейсов и служб приложений.

Удаленная работа — это новая норма

72% сотрудников компаний работают в нетрадиционных средах.

Нисходящий подход к безопасности

Риск, связанный с безопасностью, данными и проблемами конфиденциальности, остается главной проблемой многооблачных сред.

КАК VMWARE МОЖЕТ ПОМОЧЬ

Сервисы VMware Cross-Cloud™ позволяют компаниям реализовать потенциал безопасной и устойчивой многооблачной среды.

КРОСС-ОБЛАЧНЫЕ СЕРВИСЫ

Main Menu

Обзор многооблачной среды

Ускоренная модернизация облаков

Ускорьте модернизацию приложений с многооблачной платформой Kubernetes для согласованного создания и использования ПО.

Ускорение производства

Обеспечьте быстрое и безопасное создание и развертывание в любом публичном облаке или в локальном кластере Kubernetes.

Упрощение процессов Kubernetes

Создавайте и используйте безопасную многооблачную инфраструктуру контейнеров с возможностью масштабирования.

Помощь экспертов

Реализуйте потенциал путем модернизации имеющихся приложений и разработки инновационных продуктов.

Платформа приложений

Обеспечьте создание, защиту, администрирование и бесперебойную работу приложений с помощью рекомендаций VMware и решений по модернизации ПО.

Жизненный цикл контейнеров: 11 способов защиты

Рекомендации от команд DevSecOps по методологии современных приложений.

Решения и продуктыВСЕ ПРОДУКТЫ

ВСЕ РЕШЕНИЯ

Main Menu

Обзор многооблачной среды

Потенциал любого облака и согласованность одного

Ускорьте переход к облаку благодаря корпоративной инфраструктуре, эксплуатации на базе нескольких облаков и современной платформе приложений как за пределами периметра, так и в любом облаке.

Подключайтесь и обеспечивайте стабильную работу

Сокращайте время реализации преимуществ, снижайте расходы и повышайте безопасность, модернизируя инфраструктуру общедоступных и частных облаков.

Расширение цифровых возможностей

Безопасно, надежно и оптимально подключайте приложения в облаке и на периметре, чтобы использовать уникальные возможности.

Облачная и граничная инфраструктура

Используйте приложения в нужном масштабе благодаря согласованной инфраструктуре в публичных облаках, ЦОД и на границе.

Исследование VMware: многооблачные стратегии

Узнайте, почему многооблачные стратегии очень важны для достижения успеха.

Решения и продуктыОблачная инфраструктура

Граница

ВСЕ ПРОДУКТЫ

ВСЕ РЕШЕНИЯ

Main Menu

Обзор многооблачной среды

Многооблачные среды и Anywhere Workspace

Обеспечьте продуктивность распределенных сотрудников благодаря безопасному доступу к приложениям с любого устройства.

Удобство работы сотрудников

Предоставьте сотрудникам возможность выбора устройств, а также гибкие, согласованные и благоприятные условия работы.

Защита распределенной среды

Упростите переход к модели нулевого доверия с помощью ситуационного анализа и подключенных контрольных точек.

Автоматизация рабочей области

Контролируйте результаты с помощью интеллектуальных средств управления соответствием, процессами и производительностью.

Распределенная рабочая область

Обеспечьте сотрудникам удобство работы в любой точке и в любое время.

Удаленная работа перестала быть вопросом выбора

Начните процесс трансформации в распределенную организацию.

Решения и продуктыВСЕ ПРОДУКТЫ

ВСЕ РЕШЕНИЯ

Main Menu

Обзор многооблачной среды

Сеть и безопасность облачных сред

Общая система безопасности VMware обеспечивает полную визуализацию и эффективную работу: ваши приложения и данные будут защищены в любой среде.

Защита и подключение нагрузок

Наши инструменты обеспечивают согласованную защиту и подключение к сети для приложений, пользователей и организаций.

Защита API: новые устройства

Ускорение работы приложений, централизованное администрирование, защита и подключение кластеров в любой среде.

Готовность к будущему

Встроенные средства аналитики угроз в отношении пользователей, устройств и сетей улучшают защиту в динамичной среде.

Безопасность и сеть

Предоставляйте средства защиты и сеть как распределенные сервисы для пользователей, приложений, устройств и рабочих нагрузок в любом облаке.

Защита многооблачных сред

Обнаружение уникальных свойств вредоносного ПО и предупреждение атак.

Решения и продукты

Безопасность

ВСЕ ПРОДУКТЫ

ВСЕ РЕШЕНИЯ

Main Menu

Обзор многооблачной среды

Консультанты по переходу

Партнеры — доверенные консультанты по переходу к многооблачной среде, обеспечивающие внедрение цифровых инноваций под контролем компании.

Работа с партнером VMware

Партнеры используют свой опыт и технологии VMware, чтобы предоставлять нашим общим заказчикам уникальные преимущества.

Станьте нашим партнером

Вместе с партнерами VMware создает новую многооблачную экосистему, которая станет важной платформой для заказчиков.

Партнеры

Вместе с тысячами партнеров по всему миру мы помогаем заказчикам масштабировать бизнес, внедрять инновации и трансформировать клиентский опыт.

Сотрудничество с партнерами для успеха заказчиков

Узнайте, как мы помогаем компаниям перейти к многооблачной среде.

Решения

- Topics

- VMware Glossary

- Content

- ЦОД

Ellipsis

ЦОД

Отдел продаж

Современные компании используют компьютеры практически во всех аспектах ведения бизнеса: для коммуникации, хранения информации, бухгалтерских процессов и повседневных бизнес-задач. Центр обработки данных (ЦОД) — это централизованное физическое расположение, в котором размещаются корпоративные компьютеры, сеть, хранилища и другое ИТ-оборудование для поддержки бизнес-процессов. Компьютеры в ЦОД содержат или поддерживают важные бизнес-приложения, службы и данные.

Центр обработки данных (ЦОД) — это централизованное физическое расположение, в котором размещаются корпоративные компьютеры, сеть, хранилища и другое ИТ-оборудование для поддержки бизнес-процессов. Компьютеры в ЦОД содержат или поддерживают важные бизнес-приложения, службы и данные.

ЦОД могут быть любого размера: от небольшого шкафа до отдельного кабинета или помещения. Некоторым компаниям, в ЦОД которых размещается много ИТ-оборудования, могут понадобиться несколько ЦОД. Кроме того, компании могут арендовать серверы и привлекать сторонних специалистов по обслуживанию ЦОД.

ЦОД может выходить за рамки физического пространства благодаря использованию частного или публичного облаков, что дает возможность ускорить процессы или увеличить ресурсы хранилища. Для виртуализированного ЦОД могут использоваться серверы в удаленных расположениях, когда необходимо выполнять более ресурсоемкие рабочие нагрузки.

В ходе занятия по NSX for vSphere вы получите практические навыки всего за 30 минут без необходимости в установке ПО.

Бесплатное занятие

- Процессы в ЦОД

- Безопасность ЦОД

- Решения для ЦОД

Требования к современному ЦОД

В ЦОД размещается большое количество дорогого ИТ-оборудования, поэтому для них действуют особые требования к безопасности и электропитанию.

- Достаточно мощный и надежный источник питания. Оборудование в ЦОД часто использует большое количество электроэнергии, которую обеспечивает источник, защищенный от сбоев благодаря мгновенно доступному резервному блоку питания. Виртуализированные или программно-определяемые ЦОД более эффективны и требуют намного меньше электроэнергии, чем традиционные.

- Охлаждение. Все источники питания и оборудование в ЦОД вырабатывают много тепла, поэтому часто для их оптимальной эксплуатации необходимо охлаждающее оборудование.

Вода может повредить компьютеры, поэтому для защиты оборудования от пожара в ЦОД нельзя использовать спринклерные системы пожаротушения. Вместо них в ЦОД можно использовать химические противопожарные системы, которые ликвидируют пожар, не повреждая электронное оборудование.

Вода может повредить компьютеры, поэтому для защиты оборудования от пожара в ЦОД нельзя использовать спринклерные системы пожаротушения. Вместо них в ЦОД можно использовать химические противопожарные системы, которые ликвидируют пожар, не повреждая электронное оборудование. - Средства обеспечения физической и виртуальной безопасности. Безопасность — важный аспект для любого ЦОД, поскольку в нем размещены критически важные бизнес-приложения и данные. Нарушение безопасности, при котором конфиденциальные данные заказчиков или компании становятся доступными посторонним, может привести к значительным убыткам, а в худшем случае — разрушить репутацию бренда и остановить бизнес-деятельность компании. Необходимо обеспечить безопасность физической и виртуальной сред, чтобы гарантировать защиту ЦОД и не подвергать компании риску утечки данных. Нужно защитить ЦОД от кражи данных с помощью средств обеспечения физической безопасности, таких как замки, системы видеонаблюдения и ограничение доступа.

Безопасность виртуальной среды можно обеспечить с помощью ПО для защиты сетей и приложений.

Безопасность виртуальной среды можно обеспечить с помощью ПО для защиты сетей и приложений.

Многоуровневый ЦОД

В ЦОД может быть несколько уровней с разной степенью безопасности, задержки и отказоустойчивости. Многоуровневые ЦОД обеспечивают иерархическое хранение данных: файлы и данные для приложений, к которым чаще всего обращаются пользователи или для которых требуется гарантировать очень высокую производительность, могут размещаться на одном уровне, а редко используемые данные — на другом. В моделях «хранилище как услуга» на базе публичного облака уровни с более низкой задержкой, как правило, стоят дороже, чем уровни с более высокой.

Уровень с самой низкой задержкой и самым быстрым доступом обычно располагается ближе всего к пользователям, чтобы им было удобно регулярно взаимодействовать с ним. Самый быстрый уровень — это уровень 0. Хранилище уровня 0 часто используют организации из таких сфер, как финансовые услуги или медицинские исследования. Такие компании с помощью высокопроизводительных вычислений выполняют анализ больших данных. Уровни хранилища с более низкой производительностью можно использовать для хранения резервных копий основного уровня или данных, к которым обращаются реже. Архивные данные могут размещаться на самом низком и экономичном уровне хранилища, где задержка не является серьезной проблемой.

Такие компании с помощью высокопроизводительных вычислений выполняют анализ больших данных. Уровни хранилища с более низкой производительностью можно использовать для хранения резервных копий основного уровня или данных, к которым обращаются реже. Архивные данные могут размещаться на самом низком и экономичном уровне хранилища, где задержка не является серьезной проблемой.

Виртуализация ЦОД

Физические ЦОД ограничены в пространстве и зависимы от оборудования. Однако серверы можно виртуализировать: в этом случае вычислительная мощность и память отделяются от оборудования в виртуальной машине. Благодаря виртуализации ЦОД администраторы могут создать инфраструктуру виртуального ЦОД на базе удаленных серверов, чтобы разделить рабочие нагрузки и хранилище. Для виртуального ЦОД требуются меньше оборудования, электроэнергии и площади, чем для традиционного физического ЦОД. Кроме того, виртуальный ЦОД может получить доступ к публичному или частному облаку, если потребуется больше ресурсов хранения или вычислительных ресурсов. Виртуальные ЦОД также называют программно-определяемыми, поскольку все услуги, которые они предлагают (в том числе связанные с сетью и хранилищем), предоставляются программным образом, а не на базе оборудования.

Виртуальные ЦОД также называют программно-определяемыми, поскольку все услуги, которые они предлагают (в том числе связанные с сетью и хранилищем), предоставляются программным образом, а не на базе оборудования.

Поставщики облачных услуг могут предоставлять виртуализированные ЦОД как услугу: они отвечают за администрирование и обеспечение всех основных процессов компании, сети и хранилища. Эти поставщики предоставляют виртуальные сети, хранилища и серверы одновременно нескольким компаниям, распределяя ресурсы хранения и обработку рабочих нагрузок между серверами по мере необходимости. Организация также может создать частное облако на базе части своей инфраструктуры для этих же целей или использовать сочетание частного и публичного облаков, которое называют гибридной облачной средой. Виртуальный ЦОД можно использовать параллельно с имеющимся физическим ЦОД. Кроме того, компании могут использовать оборудование современного ЦОД, чтобы создать полностью виртуальный ЦОД. Гиперконвергентная инфраструктура (HCI) интегрирует вычислительные ресурсы, хранилище и сетевое оборудование с ПО для виртуализации и оптимизирует их работу в виде единой системы. С помощью HCI все возможности ЦОД реализуются на уровне ПО, тесно интегрированного с оборудованием. Такой программный подход обеспечивает автоматизацию задач и процессов хранения, для которых в прошлом приходилось вручную настраивать серверное оборудование.

С помощью HCI все возможности ЦОД реализуются на уровне ПО, тесно интегрированного с оборудованием. Такой программный подход обеспечивает автоматизацию задач и процессов хранения, для которых в прошлом приходилось вручную настраивать серверное оборудование.

Трансформация ЦОД

Современные компании ищут способы реализации потенциала новых технологий IoT, которые дадут им возможность узнать больше о заказчиках и улучшить взаимодействие с ними. Сбор и анализ данных, которые поддерживают этот тип исследований и оптимизируют качество обслуживания заказчиков, повышают требования к ЦОД. Виртуализация, HCI и облако трансформируют центры обработки данных, повышая их гибкость и ускоряя реагирование на изменения рабочих нагрузок в режиме реального времени, а также обеспечивая управление большими объемами данных. Создание и обслуживание программно-определяемых ЦОД могут обойтись намного дешевле, чем развертывание и поддержка физических ЦОД. Использование инфраструктуры виртуального ЦОД, особенно в сочетании с частным или публичным облаком, помогает компаниям снизить расходы на физическую инфраструктуру, занимаемую площадь и электроснабжение. Кроме того, виртуализированные ЦОД предоставляют компаниям более широкий выбор оборудования, поскольку облачные платформы модели «инфраструктура как услуга» (IaaS) реализуются на базе различного оборудования. Благодаря планам многоуровневого хранения стоимость услуг публичного облака снижается. По мере расширения Интернета вещей и значительного роста объемов данных, создаваемых каждый день, масштабируемость и вычислительная мощность виртуальных ЦОД будут играть все более важную роль.

Кроме того, виртуализированные ЦОД предоставляют компаниям более широкий выбор оборудования, поскольку облачные платформы модели «инфраструктура как услуга» (IaaS) реализуются на базе различного оборудования. Благодаря планам многоуровневого хранения стоимость услуг публичного облака снижается. По мере расширения Интернета вещей и значительного роста объемов данных, создаваемых каждый день, масштабируемость и вычислительная мощность виртуальных ЦОД будут играть все более важную роль.

Продукты, решения и ресурсы VMware, связанные с ЦОД

Решения для модернизации ЦОД

Цифровая трансформация, которая происходит в настоящее время, приводит к стремительным и кардинальным изменениям в организациях и их моделях работы. Чтобы соответствовать современным требованиям, необходимо преобразовать и ИТ-отдел.

Виртуализация ЦОД и облачная инфраструктура

Начните переход к облаку с виртуализации серверов. Перейдите к полностью виртуализированной архитектуре программно-определяемого ЦОД в удобном для вас темпе.

Программно-определяемый ЦОД — основа успешной цифровой трансформации

Внедряйте инновации в любых облаках, используя программно-определяемую цифровую платформу VMware.

Защита сети с помощью микросегментации

VMware NSX Data Center помогает реализовать модель безопасности «нулевого доверия» для приложений в средах частных и публичных облаков.

Приложения нового поколения

Внедряйте инновации и обеспечьте адаптивность за счет выполнения современных приложений на базе решений VMware.

Виртуализация ЦОД и управление облаком

Управляйте виртуализированными ЦОД и гибридными облачными средами, чтобы обеспечить самый высокий уровень производительности и соответствие нормативным требованиям.

Резервный ЦОД — что такое резервный центр обработки данных и как это работает.

12 июля 2022

Экспертный материал

Сергей Бондаренко | Руководитель технического отдела

Современный мир невозможно представить без центров обработки данных (далее ЦОД). Это специально спроектированное здание или помещение с высокоэффективными системами кондиционирования, пожаротушения и бесперебойного питания, в котором одновременно работает множество компьютеров, подключённых к высокоскоростной сети. Именно эти компьютеры обеспечивают работу большинства популярных высокотехнологичных сервисов, к которым мы привыкли: сервисы для заказа такси, социальные сети, большинство сайтов, онлайн игры, облачные хранилища и т.д.

Это специально спроектированное здание или помещение с высокоэффективными системами кондиционирования, пожаротушения и бесперебойного питания, в котором одновременно работает множество компьютеров, подключённых к высокоскоростной сети. Именно эти компьютеры обеспечивают работу большинства популярных высокотехнологичных сервисов, к которым мы привыкли: сервисы для заказа такси, социальные сети, большинство сайтов, онлайн игры, облачные хранилища и т.д.

Если работа ЦОДа будет нарушена, то сервисы, которые на нём функционируют, также станут недоступны. Потеря доступа к социальной сети вызовет бурю недовольства среди пользователей, но вряд ли приведёт к серьёзным последствиям, а выход из строя ЦОДа, обеспечивающего регулирование светофоров в городе, подвергнет смертельной опасности всех участников дорожного движения. Поэтому современные дата-центры отличаются очень высоким уровнем отказоустойчивости.

С точки зрения владельца бизнеса, отказ ЦОДа, на который возложены ключевые бизнес-процессы, всегда означает потерю денег, будь то недополученная прибыль, затраты на восстановление работоспособности сервисов, или штрафы за неисполнение обязательств перед заказчиками. Чем выше потенциальные убытки, тем важнее обеспечить беспрерывность работы ИТ-инфраструктуры.

Чем выше потенциальные убытки, тем важнее обеспечить беспрерывность работы ИТ-инфраструктуры.

Что такое резервный ЦОД

Крупные современные ЦОДы очень надёжны. Уровень отказоустойчивости TIER III обеспечивает простой не более 1 часа 36 минут в год и позволяет производить частичный ремонт оборудования без остановки работы сервисов. Однако чреда стечений роковых обстоятельств может вывести из строя даже самые надёжные инженерные решения.

Для обеспечения отказоустойчивости информационных систем существует резервный центр обработки данных (РЦОД). Это запасная площадка с такими же компьютерами, высокоскоростной сетью и инженерными системами, которая находится в нескольких десятках или даже сотнях километров от основного ЦОДа. На неё копируется виртуальная ИТ-инфраструктура компании, а также с определённой периодичностью реплицируются новые данные с основного дата-центра. При возникновении аварийной ситуации ИТ-инфраструктура частично или полностью продолжает функционировать на оборудовании РЦОДа, обеспечивая непрерывность работы сервисов.

О том, что такое отказоустойчивость ИТ-инфраструктуры, мы писали в статье.

Режимы работы РЦОДа

Резервные дата-центры могут работать в двух режимах: Warm DataCenter (активный/пассивный) или Hot DataCenter (активный/активный).

Основная разница заключается в скорости переключения на резервную инфраструктуру после аварии, а также в версии последней резервной копии данных.

Hot DataCenter подразумевает, что резервная и основная площадки работают параллельно, а репликация данных происходит синхронно. При отказе основной площадки переключение на резервный ЦОД происходит почти незаметно для пользователей. Такой режим работы резервного дата-центра обеспечивает минимальную потерю данных (Recovery Point Objective) и минимальное время восстановления (Recovery Time Objective). Однако поддержание работы Hot DataCenter стоит дороже, поэтому его лучше использовать только для критически важной части ИТ-инфраструктуры, которая должна быть всегда доступна.

Кроме того, Hot DataCenter позволяет распределить нагрузку между площадками даже при штатном режиме работы. Например, в зависимости от местоположения пользователи могут автоматически подключаться к ближайшему доступному ЦОДу, благодаря чему сервисы будут доступны с минимальной задержкой.

Warm DataCenter копирует данные асинхронно, то есть с определённой периодичностью – раз в день, неделю или с другим интервалом. Такой РЦОД позволяет быстро восстановить работоспособность необходимых сервисов, но часть информации за период между аварией и датой последней резервной копии будет утрачена. Режим Warm DataCenter стоит меньше и подойдёт для резервирования тех сервисов, которые не требуют минимальных показателей RPO и RTO.

Катастрофоустойчивый ЦОД

Катастрофоустойчивость – это способность сохранять работоспособность в условиях экстремальных природных катаклизмов или техногенных аварий. Ураган, взрыв, масштабный пожар или наводнение способны уничтожить здание и основного, и резервного ЦОДа, если они находятся примерно в одном регионе, даже на расстоянии нескольких десятков километров. Поэтому для обеспечения катастрофоустойчивости используют географически распределённые дата-центры, которые находятся на расстоянии сотен или тысяч километров друг от друга. Чем дальше, тем лучше.

Поэтому для обеспечения катастрофоустойчивости используют географически распределённые дата-центры, которые находятся на расстоянии сотен или тысяч километров друг от друга. Чем дальше, тем лучше.

При этом благодаря высокоскоростному соединению обе площадки образуют единый кластер, в котором можно свободно перемещать виртуальные машины и использовать общее дисковое пространство. Катастрофоустойчивые дата-центры обеспечивают непрерывное функционирование ИТ-инфраструктуры даже при полном уничтожении одного из ЦОДов.

Облачные вычисления и виртуализация

Современные способы построения ИТ-инфраструктуры основаны на использовании облачных вычислений и виртуализации. Именно благодаря такому подходу можно добиться высоких показателей катастрофоустойчивости и отказоустойчивости с использованием РЦОД.

Облачная инфраструктура (или облака) – это совокупность вычислительных ресурсов, которую можно гибко адаптировать под нужды компании.

Облака стали возможны благодаря технологии виртуализации.

Виртуализация позволяет на одном физическом сервере разместить несколько операционных систем. Один мощный хост-компьютер распределяет память, ядра процессора и дисковое пространство на несколько сервисов. Например, вместо того, чтобы условные DHCP-сервер, контроллер домена, Сервер 1С, Exchange-сервер работали на отдельных «железках», их можно запустить на одном физическом хосте, но на разных виртуальных машинах.

У технологии виртуализации много преимуществ перед старым подходом «один хост – один сервер», где операционные системы работали на выделенных физических машинах.

-

Виртуализация повышает отказоустойчивость. Чем больше отдельных хостов, тем выше вероятность, что что-то сломается. Благодаря виртуализации можно создать отказоустойчивый кластер из нескольких гипервизоров. Тогда при выходе из строя одного из физических хостов, виртуальные машины автоматически мигрируют на рабочий гипервизор в кластере.

Такой «переезд» занимает минимум времени и не требует вмешательства системного администратора.

Такой «переезд» занимает минимум времени и не требует вмешательства системного администратора.

-

Виртуализация экономически выгоднее. Во-первых, обслуживать парк из множества отдельных физических серверов дороже. Они потребляют больше электричества, занимают больше места, требуют больший резерв запасных частей и выделяют больше тепла. Во-вторых, если на одном хосте работает лишь один сервис, то большая часть вычислительной мощности будет попросту не задействована. Технология виртуализации позволяет загрузить оборудование вплоть до 80%.

Облака бывают трёх типов: частные, гибридные и публичные.

Построением частных облаков обычно занимаются крупные компании с внушительным бюджетом ИТ-подразделения. Они закупают собственное оборудование, лицензии, содержат штат квалифицированных сотрудников, строят и поддерживают инженерные системы.

Публичные облака строят облачные провайдеры – специализированные компании, которые продают в разном виде вычислительные ресурсы своей облачной инфраструктуры другим компаниям.

Гибридные облака – одновременное использование публичного и частного облака. Например, компания может построить свою ИТ-инфраструктуру в публичном облаке, но ту часть, к которой предъявляются повышенные требования безопасности, оставить в частном облаке.

Резервный ЦОД, как услуга

Сегодня все больше компаний используют публичные облака, прибегая к услугам облачных провайдеров. Одной из таких услуг является резервный дата-центр или DRaaS (Disaster Recovery as a Service).

Аварийное восстановление инфраструктуры (DRaaS)

Подробнее

Облачный провайдер предоставляет в аренду часть вычислительных мощностей своего оборудования, на которое полностью или частично копируется ИТ-инфраструктура заказчика. Если собственное оборудование заказчика выйдет из строя, то работу можно будет продолжить, переключившись на РЦОД облачного провайдера в считанные минуты. Для большинства компаний услуга резервного ЦОДа экономически выгоднее и надёжнее организации собственного резервного data-center по следующим причинам:

-

отсутствие капитальных затрат;

-

отсутствие затрат на продление лицензий и обновление дорогостоящего оборудования;

-

нет необходимости платить за утилизацию устаревшего оборудования;

-

не нужно нанимать дополнительных квалифицированных сотрудников, знающих, как построить и поддерживать сложную ИТ-инфраструктуру;

-

дата-центры облачных провайдеров соответствуют всем стандартам кибербезопасности;

-

облачные провайдеры используют качественное оборудование и надёжные инженерные системы;

-

публичные облака обладают большим запасом вычислительных мощностей, которые заказчик может подключить в кратчайший срок;

-

облачный провайдер гарантирует, что ИТ-инфраструктура заказчика не будет простаивать дольше времени, оговоренного в SLA (соглашение об уровне сервиса).

Один из ведущих российских облачных провайдеров, предоставляющих услугу резервного ЦОДа, — компания CorpSoft24. Резервное копирование ИТ-инфраструктуры заказчика происходит на геораспределённые катастрофоустойчивые ЦОДы уровня TIER III в РФ и Германии. В случае возникновения аварии, специалисты CorpSoft24 запустят виртуальные серверы заказчика за 15 минут, а также обеспечат минимальную потерю данных (RPO от 5 минут). Когда работоспособность основного дата-центра будет восстановлена, заказчик может вернуться на собственное оборудование. В состав услуги DRaaS от компании CorpSoft24 также входит разработка и тестирование плана восстановления (DRP). Disaster Recovery Plan необходим, чтобы не терять драгоценное время при наступлении аварийной ситуации, и действовать в соответствии со спланированным алгоритмом. Подробнее о DRP вы можете узнать по ссылке.

К сожалению, многие компании недооценивают риски, возникающие в случае отказа их собственных серверов. Нередко понимание важности резервирования ИТ-инфраструктуры приходит уже после случившейся аварии, понесённых убытков и испорченной репутации. Услуга резервного ЦОДа от компании CorpSoft24 поможет сохранить деньги и заработать имидж надёжной компании.

Нередко понимание важности резервирования ИТ-инфраструктуры приходит уже после случившейся аварии, понесённых убытков и испорченной репутации. Услуга резервного ЦОДа от компании CorpSoft24 поможет сохранить деньги и заработать имидж надёжной компании.

Получить доступ к виртуальной инфраструктуре Corpsoft24

Подробнее

Центр обработки данных | это… Что такое Центр обработки данных?

ТолкованиеПеревод

- Центр обработки данных

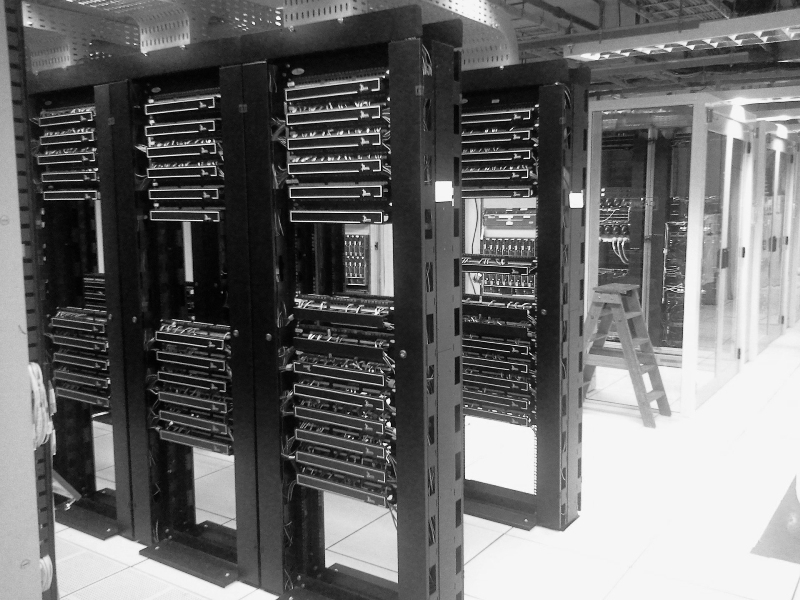

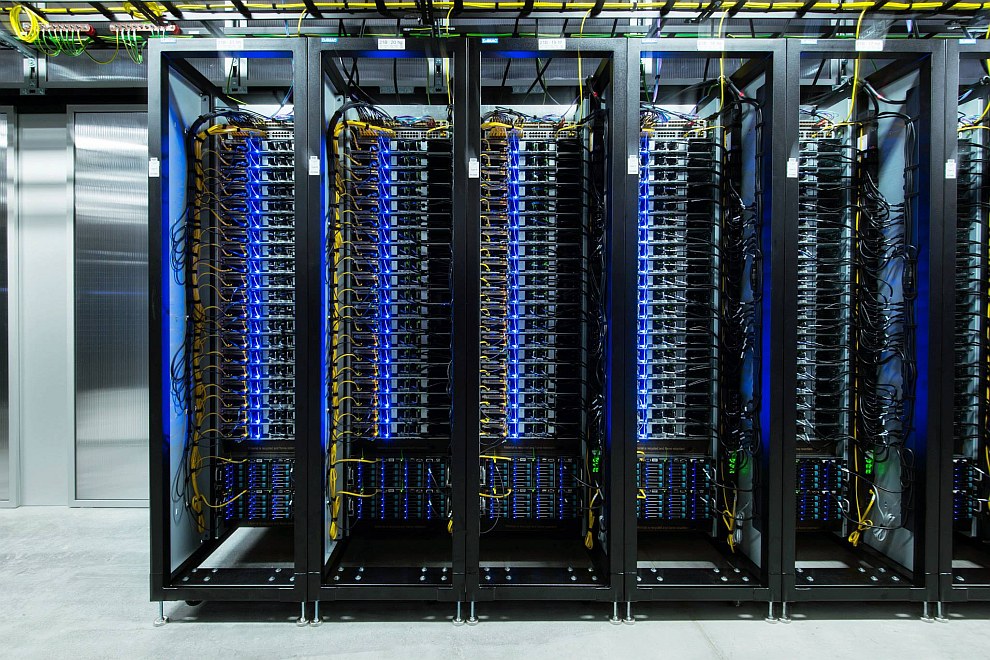

Серверная стойка фонда Wikimedia

Дата-центр (от англ. data center) — специализированное здание (площадка) для размещения серверного и коммуникационного оборудования и подключения к каналам сети Интернет. Дата-центры подключены к различным узлам связи (каналам). Именно качество и ширина каналов влияют на уровень предоставляемых услуг, так как основным критерием оценки качества работы любого дата-центра является время доступности сервера (англ.

центр хранения и обработки данных (ЦХОД) либо центр обработки данных (ЦОД).

центр хранения и обработки данных (ЦХОД) либо центр обработки данных (ЦОД).Содержание

- 1 Типы дата-центров

- 2 Структура и описание дата-центра

- 3 Услуги дата-центров

- 4 Сетевая инфраструктура

- 5 Примечания

- 6 Ссылки

- 7 См. также

Типы дата-центров

Все дата-центры можно условно разделить на несколько типов:

- Крупные дата-центры имеют свое здание, специально сконструированное для обеспечения наилучших условий размещения. Обычно они имеют свои каналы связи, к которым подключают серверы.

- Средние дата-центры обычно арендуют площадку определенного размера и каналы определенной ширины (ширина канала измеряется его пропускной способностью в Mbps).

- Мелкие дата-центры размещаются в неприспособленных помещениях. В общих случаях используется оборудование плохого качества, а также предоставляется самый минимум услуг.

Структура и описание дата-центра

Типичный дата-центр состоит из информационной инфраструктуры, включающей в себя серверное оборудование и обеспечивающей основные функции дата-центра — обработку и хранение информации; телекоммуникационной инфраструктуры обеспечивающей взаимосвязь элементов датацентра, а также передачу данных между датацентром и пользователями; инженерной инфраструктуры обеспечивающей нормальное функционирование основных систем датацентра. Инженерная инфраструктура включает в себя прецизионное кондиционирование для поддержание температуры и уровня влажности в заданных параметрах; бесперебойное и гарантированное электроснабжение обеспечивает автономную работу дата-центра в случаях отключения центральных источников электроэнергии, а также повышают качество электропитания; охранно-пожарная сигнализация и система газового пожаротушения; системы управления и контроля доступом.

Некоторые дата-центры предлагают клиентам дополнительные услуги по использованию оборудования по автоматическому уходу от различных видов атак.

Команды квалифицированных специалистов круглосуточно производят мониторинг всех серверов. Необходимо отметить, что услуги датацентров сильно отличаются в цене и количестве услуг. Для обеспечения сохранности данных используются резервные системы копирования. Для предотвращения кражи данных, в дата-центрах используются различные системы ограничения физического доступа, системы видеонаблюдения. В корпоративных (ведомственных) дата-центрах обычно сосредоточено большинство серверов соответствующей организации. Оборудование крепится в специализированных стойках. Как правило, в дата-центр принимают для размещения лишь оборудование в стоечном исполнении, то есть, в корпусах стандартных размеров, приспособленных для крепления в стойку. Компьютеры в корпусах настольного исполнения не удобны для дата-центров и размещаются в них редко. Датацентр представляет собой комнату, этаж или целое здание, обычно расположенные в пределах или в непосредственной близости от узла связи или точки присутствия какого-либо одного или нескольких операторов.

Команды квалифицированных специалистов круглосуточно производят мониторинг всех серверов. Необходимо отметить, что услуги датацентров сильно отличаются в цене и количестве услуг. Для обеспечения сохранности данных используются резервные системы копирования. Для предотвращения кражи данных, в дата-центрах используются различные системы ограничения физического доступа, системы видеонаблюдения. В корпоративных (ведомственных) дата-центрах обычно сосредоточено большинство серверов соответствующей организации. Оборудование крепится в специализированных стойках. Как правило, в дата-центр принимают для размещения лишь оборудование в стоечном исполнении, то есть, в корпусах стандартных размеров, приспособленных для крепления в стойку. Компьютеры в корпусах настольного исполнения не удобны для дата-центров и размещаются в них редко. Датацентр представляет собой комнату, этаж или целое здание, обычно расположенные в пределах или в непосредственной близости от узла связи или точки присутствия какого-либо одного или нескольких операторов. Системы электропитания, вентиляции и пожаротушения дата-центра отличаются повышенной надёжностью и резервированием. Разумеется, должна быть предусмотрена физическая защита и особый режим допуска в технологические помещения. В ряде стран имеются специальные стандарты на оборудование помещений датацентров. В России пока такого стандарта нет, дата-центры оснащаются согласно требованиям для сооружений связи. Существует американский (ANSI) стандарт TIA-942[1], несущий в себе рекомендации по созданию дата-центров, и делящий дата-центры на типы по степени надежности. Фактически, TIA-942 воспринимается во всем мире как единый стандарт для дата-центров.

Системы электропитания, вентиляции и пожаротушения дата-центра отличаются повышенной надёжностью и резервированием. Разумеется, должна быть предусмотрена физическая защита и особый режим допуска в технологические помещения. В ряде стран имеются специальные стандарты на оборудование помещений датацентров. В России пока такого стандарта нет, дата-центры оснащаются согласно требованиям для сооружений связи. Существует американский (ANSI) стандарт TIA-942[1], несущий в себе рекомендации по созданию дата-центров, и делящий дата-центры на типы по степени надежности. Фактически, TIA-942 воспринимается во всем мире как единый стандарт для дата-центров.Услуги дата-центров

- Виртуальный хостинг. Предоставление лимитированной части дискового места, процессорного времени, оперативной памяти клиенту для использования. Крупные датацентры обычно не предоставляют подобную массовую услугу из-за необходимости обеспечения техническо-консультационной поддержки. При использовании виртуального хостинга один физический сервер делится между множеством клиентов (сотни или тысячи).

Каждому клиенту не гарантируется какое-либо выделение ресурса, но строго лимитируется максимальное. Клиенты не могут в большей степени конфигурировать сервер. Виртуальный хостинг имеет два основных преимущества: малую стоимость и легкость управления сайтами. По этим причинам виртуальный хостинг в основном используют частные лица.

Каждому клиенту не гарантируется какое-либо выделение ресурса, но строго лимитируется максимальное. Клиенты не могут в большей степени конфигурировать сервер. Виртуальный хостинг имеет два основных преимущества: малую стоимость и легкость управления сайтами. По этим причинам виртуальный хостинг в основном используют частные лица. - VDS)-хостинг — Предоставление гарантированной и лимитированной части сервера (части всех ресурсов). Важная особенность данного вида хостинга — разделение сервера на несколько виртуальных независимых серверов реализуемых программным способом.

- хостинг — Аренда сервера (Dedicated). Дата-центр предоставляет клиенту в аренду сервер в различной конфигурации. Крупные дата-центры в основном специализируются именно на подобных типах услуг. В зависимости от страны расположения дата-центра имеются различные ограничения на трафик.

- Размещение сервера (Colocation). Размещение сервера клиента на площадке дата-центра за определенную плату. Стоимость зависит от энергопотребления и тепловыделения размещаемого оборудования, пропускной способности подключаемого к оборудованию канала передачи данных, а также размера и веса стойки.

- Выделенная зона (Dedicated area). В некоторых случаях владельцы дата-центра выделяют часть технологических площадей для специальных клиентов, как правило, финансовых компаний, имеющих строгие внутренние нормы безопасности. В этом случае дата-центр предоставляет некую выделенную зону, обеспеченную каналами связи, электроснабжением, холодоснабжением и системами безопасности, а клиент сам создает свой ЦОД внутри этого пространства.

Сетевая инфраструктура

Сегодня коммуникации дата центра чаще всего базируются на сетях с использованием IP протокола. Дата центр содержит ряд роутеров и свитчей, которые управляют трафиком между серверами и внешним миром. Для надежности дата-центр иногда подключен к интернету с помощью множества разных внешних каналов от разных ISP.

Некоторые серверы в дата-центре служат для работы базовых интернет и интранет служб, которые используются внутри организации: почтовые сервера, прокси, DNS и т. п.

Сетевой уровень безопасности поддерживают: межсетевые экраны, IDS-системы и т.

д. Также используются системы мониторинга трафика и некоторых приложений.

д. Также используются системы мониторинга трафика и некоторых приложений.Примечания

- ↑ http://www.datadome.ru/images/3.pdf

Ссылки

- Описание и фотографии одного из дата-центров компании Яндекс

- Экскурсия по датацентру SafeData (Москва)

- Правила оказания телематических услуг связи

- Project Blackbox(рус.), SUN.com(англ.)

- Статья — Телекоммуникационные шкафы в ЦОД и в СКС

- Подборка статей по тематике коммерческих дата-центров

- Коллекция полезных нормативов по строительству и эксплуатации дата-центров

- Аналитическая статья — российские системные интеграторы, строящие Центры Обработки Данных (ЦОД)

- Лист дата-центров Москвы и Санкт-Петербурга.

- Лист российских топ-игроков бизнеса коммерческих дата-центров

См. также

- Серверная комната

Wikimedia Foundation. 2010.

Нужно решить контрольную?

- Центр образования № 1927 (Москва)

- Центр образования №556

Полезное

Центр обработки данных (ЦОД, дата-центр)

Центр обработки данных — это сложный комплекс, включающий в себя вычислительные мощности, элементы ИТ — инфраструктуры, строительных и инженерных систем, основными функциями которого являются – хранение, обработка и передача информации. В ЦОД на относительно небольшой площади сосредоточены мощные вычислительные ресурсы: сервера и системы хранения данных (СХД), осуществляющие хранение и обработку информации; сетевое оборудование, отвечающее за обмен данными внутри ЦОД, а также за связь с внешними потребителями; инженерные системы, системы безопасности, системы диспетчеризации и мониторинга, обеспечивающие эффективную работу и защиту сосредоточенного в ЦОД вычислительного центра.

В ЦОД на относительно небольшой площади сосредоточены мощные вычислительные ресурсы: сервера и системы хранения данных (СХД), осуществляющие хранение и обработку информации; сетевое оборудование, отвечающее за обмен данными внутри ЦОД, а также за связь с внешними потребителями; инженерные системы, системы безопасности, системы диспетчеризации и мониторинга, обеспечивающие эффективную работу и защиту сосредоточенного в ЦОД вычислительного центра.

ЦОД могут быть коммерческими, предназначенные в основном для предоставления услуг co-location (аренды стойко-мест, серверного оборудования), а также корпоративными, созданными для поддержки внутренней информационной среды компании-заказчика.

«СОНЕТ» специализируется на создании корпоративных Центров обработки данных для крупных и средних компаний регионального значения. Наша компания является широкопрофильным системным интегратором и с этой точки зрения делать такой сложный комплексный проект как ЦОД именно с нами заказчику проще и удобнее. Мы располагаем всеми необходимыми ресурсами для создания таких решений: специалистами с высокой квалификацией как в области ИТ, так и в проектировании инженерных систем, опытом реализации сложных проектов, специфическим монтажным оборудованием. Важно учитывать и то обстоятельство, что компания обладает статусами и сертификатами ведущих производителей решений и систем, использующихся в ЦОД, что дает гарантию профессионального проектирования и монтажа всех составляющих центра.

Мы располагаем всеми необходимыми ресурсами для создания таких решений: специалистами с высокой квалификацией как в области ИТ, так и в проектировании инженерных систем, опытом реализации сложных проектов, специфическим монтажным оборудованием. Важно учитывать и то обстоятельство, что компания обладает статусами и сертификатами ведущих производителей решений и систем, использующихся в ЦОД, что дает гарантию профессионального проектирования и монтажа всех составляющих центра.

ДЛЯ ЧЕГО ПРЕДПРИЯТИЮ ЦОД?

Очевидно, что сейчас работа современного, конкурентно способного предприятия невозможна без использования информационных систем, которые поддерживают жизненно важные процессы. Зачастую неполадки в работе, простой таких систем, их недостаточная производительность может привести к финансовым убыткам, потере корпоративной информации, нанести серьезный урон имиджу компании, лояльности клиентов и партнеров. Кроме того, вопросы непрерывного функционирования информационной среды особенно остро встают перед растущими, динамично развивающимися компаниями. Ведь в условиях роста неизбежно возникают проблемы увеличения объема и ценности информации, роста ущерба при нарушении работоспособности информационных систем.

Ведь в условиях роста неизбежно возникают проблемы увеличения объема и ценности информации, роста ущерба при нарушении работоспособности информационных систем.

Для предприятий, где вопросы обеспечения надежности функционирования информационных систем являются критически важными необходимо создание правильно спроектированного и построенного силами профессионального системного интегратора корпоративного центра обработки данных (ЦОД). Это гарантия обеспечения непрерывной работы всех информационных систем компании, а также надежный фундамент внедрения новых ИТ-разработок.

Наиболее востребованными IT-технологии всегда были на предприятиях, где работа информационных систем является наиболее критической для бизнеса. К таким компаниям в первую очередь относятся государственные структуры, банки и телекоммуникационные компании. Эти предприятия можно назвать зрелыми, с точки зрения уровня развития IT, пользователями со сложившейся культурой, подходами и пониманием места информационных технологий в бизнес-процессах компании или организации. Для таких компаний характерны уже созданные крупные ЦОДы, оснащенные самым современным оборудованием и программным обеспечением. В таких ЦОДах всегда есть потребности расширения, повышения надежности, минимизации энергозатрат на функционирование ЦОД, затрат на обслуживание, сервис.

Для таких компаний характерны уже созданные крупные ЦОДы, оснащенные самым современным оборудованием и программным обеспечением. В таких ЦОДах всегда есть потребности расширения, повышения надежности, минимизации энергозатрат на функционирование ЦОД, затрат на обслуживание, сервис.

Сегодня мы можем наблюдать, как руководство компаний из других отраслей проявляет все больший интерес к автоматизации, внедрению IT – технологий в бизнесе. Все более «ИТ-жадными» становятся промышленные предприятия, розничные торговые сети, страховые компании. Именно здесь наблюдается наибольший интерес к IT, в частности к ЦОДам. Для таких компаний характерно решение следующих задач: где лучше разместить свой центр обработки данных, какие программные средства наиболее полно смогут решить задачи, какова оптимальная аппаратная платформа для работы необходимых приложений.

Таким образом, критичность информационных технологий для бизнеса осознают игроки все большего числа сегментов рынка, IT глубже проникают в экономику предприятий. Изменяется отношение к IT со стороны ТОП-менеджмента: многие руководители видят в информационных технологиях не просто еще одно конкурентное преимущество – а основу роста и развития бизнеса.

Изменяется отношение к IT со стороны ТОП-менеджмента: многие руководители видят в информационных технологиях не просто еще одно конкурентное преимущество – а основу роста и развития бизнеса.

ОСНОВНЫЕ ТРЕБОВАНИЯ К ЦОД

Так как от работы ЦОД зависит надежность всей информационной системы, уровень услуг, предоставляемых компанией своим клиентам, производительность труда сотрудников создаваемого на предприятии компоративному ЦОД предъявляются следующие требования:

- Обеспечение непрерывности функционирования всех информационных систем

- Высокая производительность обработки и передачи данных

- Доступность данных и приложений

- Надежность хранения данных, высокая емкость хранения

- Отказоустойчивость

- Катастрофоустойчивость

- Высокая степень масштабируемости всех систем ЦОД (с учетом 5-10 лет активного развития компании)

Необходимо отметить, что все больше Заказчики обращают внимание на фактор минимизации совокупной стоимости владения системой, складывающейся из затрат на энергопотребление, обслуживание, сервис.

ИЗ ЧЕГО СОСТОИТ ЦОД?

СОСТАВ ИНЖЕНЕРНЫХ СИСТЕМ ЦОД

ИТ-инфраструктура

- Высоконадежное серверное оборудование

- Системы хранения данных

- Системы резервного копирования и восстановления данных

- Инфраструктурное и прикладное ПО

- Система передачи даных ЦОД

Инженерные системы

- Системы общего, гарантированного и бесперебойного электропитания

- Система вентиляции и кондиционирования

- Защитное заземление

- Общестроительные решения помещений

Системы безопасности:

- Информационная безопасность

- Видеонаблюдение

- Система контроля управления доступом (СКУД)

- Системы сигнализации и оповещения

- Система противопожарной безопасности и пожаротушения

Системы мониторинга, управления и диспетчеризации ЦОД

- Оповещение об аварийных событиях

- Учет потребления ресурсов

- Протоколирование событий

ИТ-ИНФРАСТРУКТУРА ЦОД

ИТ-инфраструктура – это вычислительные мощности ЦОД, ее можно назвать сердцем ЦОД, именно она отвечает за производительность, доступность данных и приложений, быстроту передачи данных, их хранение. В состав ИТ-инфраструктуры входят:

В состав ИТ-инфраструктуры входят:

- Серверное оборудование

- Система хранения данных

- Система передачи данных ЦОД

Построение современной ИТ-инфраструктуры сейчас невозможно без использования блэйд-серверов в качестве ядра ИТ-инфраструктуры, а также применения технологий виртуализации, значительно повышающую эффективность серверов. С точки зрения экономической целесообразности, масштабируемости, производительности эти технологии можно назвать настоящим прорывом. Сейчас это направление активно развивается, лидеры мирового рынка серверного оборудования и программного обеспечения постоянно предлагают новые разработки в этом направлении.

Применение данных технологий при построении ИТ-инфраструктуры позволяет:

- уменьшить стоимость владения (эксплуатации) ИТ-инфраструктуры, включая затраты на электричество, расходы на сервис, обслуживание;

- увеличить эффективность использования существующих мощностей оборудования;

- обеспечить повышенную доступность приложений;

- прогнозировать и планировать расширение ИТ-инфраструктуры.

ИНЖЕНЕРНЫЕ СИСТЕМЫ ЦОД

Для поддержки работы высокопроизводительного, дорогостоящего оборудования, составляющего ИТ-инфраструктуру, в ЦОД необходимо создать комплекс инженерных систем.

СИСТЕМА ЭЛЕКТРОСНАБЖЕНИЯ

Прежде всего, это, конечно, система электроснабжения ЦОД: гарантированного и бесперебойного электропитания. Работа этих систем является критически важной для функционирования ЦОД – ведь непредвиденные перебои электроснабжения в городских электросетях, скачки напряжения могут привести к выходу из строя оборудования, остановке работы жизненно важных процессов в компании. Длительное же отключение электропитания может привести к тому, что не будет работать ни связь, ни телекоммуникации, ни охранные системы.

СИСТЕМА КОНДИЦИОНИРОВАНИЯ

Другая, не менее значимая система поддержки функционирования работы ИТ-инфраструктуры в ЦОД – это резервная, отказоустойчивая система кондиционирования, ведь перегрев – одна из наиболее распространенных причин остановки работы серверов.

В ЦОД для построения систем климат-контроля используются промышленные прецизионные кондиционеры, чаще всего с функцией горячего резервирования. Также сейчас актуальным стало использование в таких кондиционерах функции «free-cooling», применение которой дает экономию энергопотребления до 30%.

СИСТЕМЫ БЕЗОПАСНОСТИ ЦОД

Центр обработки данных – это стратегическое место в любой компании, где находится дорогостоящее оборудование, консолидирована корпоративная информация – важнейший актив современного предприятия. Очевидно, что в ЦОД необходимо обеспечение контроля, регламентированного доступа лиц. В данном решении были применены интегрированные системы: видеонаблюдения, СКУД, противопожарной безопасности.

Информационная безопасность: антивирусная защита, спам-фильтр, защита от вторжений.

СИСТЕМЫ МОНИТОРИНГА, УПРАВЛЕНИЯ И ДИСПЕТЧЕРИЗАЦИИ ЦОД

Важным компонентом ЦОД является система диспетчеризации и мониторинга, позволяющая создать в ЦОД централизованный мониторинг параметров систем и их состояний: напряжения электропитания, температуры в стойках, температуры воздуха и т. д. В данной системе важную часть занимает подсистема оповещения и прогнозирования отказов оборудования, критических ситуаций в ЦОДе. Современные системы диспетчеризации позволяют организовать информирование обслуживающего персонала посредством всех доступных интерфейсов связи: e-mail, sms, автоматический дозвон до заданной группы абонентов. Все это снижает риски возникновения аварийных ситуаций, а также время на восстановление работоспособности систем. Кроме того, система диспетчеризации позволяет наладить учет энергопотребления, затрат на вентиляцию и кондиционирование, что ведет к экономии и снижению совокупной стоимости владения системой.

д. В данной системе важную часть занимает подсистема оповещения и прогнозирования отказов оборудования, критических ситуаций в ЦОДе. Современные системы диспетчеризации позволяют организовать информирование обслуживающего персонала посредством всех доступных интерфейсов связи: e-mail, sms, автоматический дозвон до заданной группы абонентов. Все это снижает риски возникновения аварийных ситуаций, а также время на восстановление работоспособности систем. Кроме того, система диспетчеризации позволяет наладить учет энергопотребления, затрат на вентиляцию и кондиционирование, что ведет к экономии и снижению совокупной стоимости владения системой.

Dude Определение и значение — Merriam-Webster

1 из 2

ˈdüd

Также ˈdyüd

1

: Человек, чрезвычайно поправный в платье и манере : Денди

2

: Городской ДИЛЕР НЕПРАВИЛЬНО С ЖИЗНЬ НА ДАМА (см. Надпись. 3б)

Надпись. 3б)

особенно : житель Востока на Западе

3

неофициальный : парень, парень